随机算法比较

RFID技术中常见的防碰撞算法解析

RFID技术中常见的防碰撞算法解析RFID(Radio Frequency Identification)技术是一种利用无线电波进行非接触式自动识别的技术,广泛应用于物流、供应链管理、仓储管理等领域。

在RFID系统中,防碰撞算法是解决多个标签同时被读取时发生的碰撞问题的关键。

一、RFID技术的基本原理RFID系统由读写器和标签组成。

读写器通过无线电波向标签发送信号,标签接收到信号后进行解码,并将存储的信息发送回读写器。

RFID标签分为主动式标签和被动式标签两种。

主动式标签内置电池,可以主动发送信号;被动式标签则依靠读写器发送的信号供电。

二、RFID系统中的碰撞问题在RFID系统中,当多个标签同时进入读写器的工作范围内时,它们可能会同时响应读写器的信号,导致信号碰撞。

碰撞问题会导致读写器无法准确识别标签,从而降低系统的可靠性和效率。

三、防碰撞算法的分类为了解决RFID系统中的碰撞问题,研究人员提出了多种防碰撞算法。

根据不同的原理和实现方式,这些算法可以分为以下几类:1. 随机算法随机算法是最简单的防碰撞算法之一。

它通过在读写器发送的信号中添加随机延迟来避免碰撞。

每个标签在接收到读写器信号后,随机选择一个延迟时间后再发送响应信号。

这样可以降低多个标签同时发送信号的概率,减少碰撞的发生。

然而,随机算法的效率较低,可能会导致系统的响应时间延长。

2. 二进制分割算法二进制分割算法是一种基于二进制编码的防碰撞算法。

它将标签的ID按照二进制编码进行分割,每次只处理一位二进制数。

读写器发送的信号中包含一个查询指令,标签根据自身ID的某一位和查询指令进行比较,如果相同则发送响应信号,如果不同则保持沉默。

通过逐位比较,最终可以确定每个标签的ID。

二进制分割算法具有较高的效率和可靠性,但对标签ID的编码方式有一定要求。

3. 动态算法动态算法是一种基于动态时间分配的防碰撞算法。

它通过读写器和标签之间的协调来避免碰撞。

读写器会发送一个时间窗口,标签根据自身ID的某一位和时间窗口进行比较,如果相同则发送响应信号,如果不同则保持沉默。

详解各种随机算法

详解各种随机算法之前将的算法都是确定的,即对于相同的输⼊总对应着相同的输出。

但实际中也常常⽤到不确定的算法,⽐如随机数⽣成算法,算法的结果是不确定的,我们称这种算法为(随机)概率算法,分为如下四类:1、数值概率算法⽤于数值问题的求解,通常是近似解2、蒙特卡洛算法Monte Carlo能得到问题的⼀个解,但不⼀定是正确解,正确的概率依赖于算法运⾏的时间,算法所⽤的时间越多,正确的概率也越⾼。

求问题的准确解;3、拉斯维加斯算法 Las Vegas不断调⽤随机算法求解,直到求得正确解或调⽤次数达到某个阈值。

所以,如果能得到解,⼀定是正确解。

4、舍伍德算法 Sherwood利⽤随机算法改造已有算法,使得算法的性能尽量与输⼊数据⽆关,即平滑算法的性能。

它总能求得问题的⼀个解,且求得的解总是正确的。

随机数概述计算机产⽣的随机数都是伪随机数,通过线性同余法得到。

⽅法:产⽣随机序列d称为种⼦;m取值越⼤越好;m,b互质,常取b为质数;案例伪随机数在实际编程中,我们使⽤rand()函数来产⽣随机数,rand()函数返回0到⼀个最⼤值之间的⼀个随机数。

#include#include#include//产⽣[0,100)的随机数void GenerateRandomNumber(){for(int i=0;i10;i++){printf('%-4d',rand()%100);//产⽣[0,m)的随机数}printf('\n');}int main(){GenerateRandomNumber();return 0;}运⾏代码,输出:41 67 34 0 69 24 78 58 62 64如果我们重复运⾏代码就会发现,每次的输出结果都是这个序列。

这就是因为rand产⽣的随机序列是伪随机序列。

解决⽅法是:使⽤当前的时间作为随机种⼦。

时间作为随机种⼦在GenerateRandomNumber()函数开头加⼊下⾯⼀条语句。

Logistic回归与随机森林机器学习算法的比较研究

Logistic回归与随机森林机器学习算法的比较研究随着机器学习技术的不断发展,各种算法也层出不穷。

在二分类问题中,Logistic回归和随机森林是两种常用的机器学习算法。

本文将比较这两种算法的优缺点,并分析在不同场景中的应用。

一、Logistic回归Logistic回归是一种线性回归的变体,适用于处理二分类问题。

该算法通过对二类数据进行回归分析来确定分类边界。

在该算法中,数据被分为两类,其中一类标记为1,另一类标记为0。

我们将数据放入一个函数中,这个函数被称为Logistic函数,其输出值范围在0到1之间。

在Logistic回归中,我们利用最大似然估计(Maximum Likelihood Estimation)来计算系数。

系数的值可以用于确定分类边界,并将新数据分类为一个类别或另一个类别。

Logistic回归的优点有:1.看似简单,但是非常强大。

对于线性可分的数据,最多只有一个分类边界,因此Logistic回归可以解决一些复杂的问题。

2.算法具有通用性,在实际应用中广泛使用。

3.适用于对数据进行解释和分析,因为可以计算出每个变量的系数,并且可以量化变量对模型的贡献度。

Logistic回归的缺点有:1.该算法对有噪声的数据敏感,容易过拟合。

这个问题可以通过引入正则化项来解决。

2.该算法只能生效于线性可分数据集上,对于非线性数据集表现不佳。

二、随机森林随机森林是一种基于决策树的集成学习方法,也适用于二分类问题。

随机森林算法建立了多个决策树,并通过投票的方式选择最佳判断结果。

通常,随机森林通过从训练集中的所有特征中选择部分特征和随机样本来给每个树提供随机变化。

该算法会生成多个决策树,投票机制被用于最终预测。

如果一个特征在许多树上被选择,那么这个特征就是重要特征。

随机森林的优点有:1.随机森林能够处理高维数据,这些数据难以被传统算法所应用。

2.随机森林在处理有噪音和缺失值的数据时表现好。

3.随机森林论文中有一种特殊的功能,即它可以测量每个特征的重要性,并根据重要性进行自动优化。

随机数算法

随机数算法简介随机数在计算机科学和信息安全领域扮演着重要角色。

随机数算法用于生成一系列看似随机的数字,这些数字在统计上是均匀分布、不可预测的。

本文将介绍几种常见的随机数算法,包括伪随机数算法和真随机数算法,以及它们的优缺点和应用场景。

伪随机数算法伪随机数算法是一种基于确定性计算的生成随机数的方法。

通过一个初始种子(seed),该算法按照一定规则生成一系列数字。

由于算法的确定性,相同的初始种子将产生相同的随机数序列。

线性同余法线性同余法是最常见的伪随机数生成算法之一。

它通过以下公式计算随机数:X(n+1) = (a × X(n) + c) mod m其中,X(n)表示当前的随机数,X(n+1)表示下一个随机数,a、c、m是事先确定的常数。

这个算法的优点是简单、高效,也易于实现。

然而,如果选择的参数不当,可能产生周期较短或重复的随机数序列。

梅森旋转算法梅森旋转算法是一类伪随机数算法的统称,它们使用一个巨大的状态空间来生成随机数。

最著名的梅森旋转算法是梅森旋转发生器(Mersenne Twister)。

梅森旋转算法的优点是周期非常长,产生的随机数序列质量较高。

它的缺点是占用内存较大,生成随机数的速度相对较慢。

真随机数算法真随机数算法是通过物理过程来生成随机数,例如电子噪声、放射性衰变等。

相比于伪随机数算法,真随机数算法具有更高的随机性和不可预测性。

硬件随机数生成器硬件随机数生成器是一种基于物理过程的真随机数生成器。

它利用物理设备(如热噪声源、放射性衰变)产生的不可预测的随机事件来生成随机数。

由于依赖于硬件设备,硬件随机数生成器通常安全性较高,但成本也较高。

环境噪声环境噪声是通过采集环境中的噪声信号来生成随机数。

这些噪声信号可以是来自于温度、湿度、大气压力等方面的变化。

环境噪声具有很高的随机性,可以被用作真随机数的来源。

由于环境噪声易于采集和获取,这种方法相对来说比硬件随机数生成器更容易实现。

random算法原理

random算法原理

随机算法(Random Algorithm)是一种通过随机数来产生结果的算法。

它的主要原理是依据随机数生成器来做出随机性的决策。

随机数生成器是一种能够在一定范围内生成不确定、不可预测的随机数的工具。

这种方法被广泛应用于许多领域,如密码学、游戏设计、计算机图形等。

随机算法的强大之处在于其能够快速、有效地生成需要的随机结果,避免出现结果的局限性和规律性。

例如,随机算法应用于游戏中的随机地图生成,每个游戏场景的地图都可以根据不同的概率分布生成不同的随机地图,使得游戏的体验更为多样化。

在计算机编程中,随机算法的应用也非常普遍,例如生成随机密码、随机数列、模拟随机事件等。

虽然随机算法在处理随机问题方面非常强大,但它也存在一些弱点,例如可能会出现重复结果,也可能出现异常结果。

因此,在使用随机算法时,需要根据具体的应用场景进行综合考虑,选择合适的随机算法和参数设置,以获得更好的结果。

随机性优化算法有效性定量对比评价方法

随机性优化算法有效性定量对比评价方法李鹏飞;石正军【摘要】To compare effectiveness of different stochastic optimization algorithms quantitatively, a method is proposed, which is based on statistical analysis of multiple independent results of those algorithms solving a set of typical test samples. Probability quantifying the relative superiority of effectiveness of two algorithms is conducted. Using this method, effec-tiveness comparison of different stochastic optimization algorithms is easy to make. Further, this method is implemented on two patterns of standard Particle Swarm Optimization(PSO)algorithm, in which the global best particle’s information is updated synchronously as well as asynchronously. As a result, a relatively effective pattern of standard PSO algorithm solving unconstrained single-objective optimization problems is advised.%针对随机性优化算法寻优结果不可重复的特点,为该类优化算法提供了一种定量对比评价算法有效性的方法。

随机化的算法和其在求解问题中的优越性

随机化的算法和其在求解问题中的优越性随机化算法作为一种新颖的算法思维逐渐受到了越来越多的关注和研究。

一方面,随机化算法为求解复杂问题提供了全新的思路和方法,另一方面则为计算机理论和实践的发展注入了全新的动力。

在本文中,我们将探讨随机化算法的基本概念和其在求解问题中的卓越优势。

一、随机化算法的基本概念1. 定义随机化算法是指在计算过程中使用随机数的算法,即对某一问题的求解过程中,涉及到随机化,其结果可以不确定。

随机化算法采用一些随机因素,如随机数,使得算法的输出不仅仅取决于输入数据,而且也取决于随机因素。

随机化算法分为两种:随机化算法和近似算法。

2. 随机化算法的特点随机化算法相比于传统算法,其最大的特点就是在执行的过程中使用了随机数。

因此,随机化算法的输出结果不仅仅取决于输入,还取决于随机数生成器的状态。

同时,随机化算法也没有固定的算法执行时间。

3. 随机化算法的应用随机化算法在许多领域中都得到了广泛的应用,例如图论、计算几何、组合数学、网络流、最优化等。

二、随机化算法在求解问题中的优越性1. 随机化算法比传统算法更加高效随机化算法在求解问题中的效率往往更高,因为其过程中不需要像传统算法那样考虑所有可能的情况。

相反,随机化算法只是根据规律或者概率去确定哪一个具体的方案,或者说只考虑已经生成的随机数所能够做出的决策。

因此,当问题非常复杂时,随机化算法往往更能够使执行时间得到精简。

2. 随机化算法在求解问题中比传统算法更灵活随机化算法不受传统算法的固定规则和约束所限制。

随机化算法的输出结果可能是不确定的,但是由于使用了随机数,这些不确定的结果也有可能是最优解。

这些不确定的结果通常与某些特定问题的数据和输入有关,因此我们可以根据随机化算法的特性来寻找最优的解,达到更灵活和高效的目的。

3. 随机化算法通常比传统算法更易于实现有很多问题不容易使用传统的算法进行求解,而随机化算法往往更容易实现。

一个显著的例子就是生命游戏的规则:非常简单,但不是很容易得出这样规则的结果。

随机算法比较

对比舍伍德算法、拉斯维加斯算法、蒙特卡洛算法的适用范围以及它们的优缺点。

一、舍伍德算法:•特点舍伍德算法总能求得问题的一个解,且所求得的解总是正确的。

当一个确定性算法在最坏情况下的计算复杂性与其在平均惜况下的计算复杂性有较大的差别时,可在这个确定性算法中引入随机性将它改造成一个舍伍徳算法,消除或减少问题的好坏实例间的这种差别。

舍伍德算法的精髓不是避免算法的最坏悄形行为,而是设法消除这种最坏悄形行为与特定实例之间的关联性。

舍伍德算法不会从整体上或平均的改善问题求解的时间复杂度,但可以对一些特别耗时的特定输入改善至较适中的时间复杂度。

设A是一个确定性算法,当它的输入实例为x时所需的计算时间记为tA(x)o设Xn是算法A的输入规模为n的实例的全体,则当问题的输入规模为n时,算法A 所需的平均时间为_ 艺© O)“小卞厂这显然不能排除存在xGXn使得tA(x)»tA(n)的可能性。

希望获得一个概率算法B,使得对问题的输入规模为n的每一个实例均有心⑴二几何+心)这就是舍伍德算法设计的基本思想。

当s(n)与tA(n)相比可忽略时,舍伍德算法可获得很好的平均性能。

•适用范围:1.快速排序算法2.线性时间选择算法上述两算法选择合适的划分基准,舍伍德算法随机地选择一个数组元素作为划分基准,这样既能保证算法的线性时间平均性能,乂避免了计算拟中位数的麻烦。

3.搜索有序表利用数组的小标的索引性质,可以设讣一个随机化搜索算法,以改进算法的搜索时间复朵性。

即随机抽取数组元素若干次,从较近搜索元素x的位置开始做顺序搜索。

4.跳跃表在跳跃表中随机增加附加指针,以及在该结点处应随机增加指针。

二、拉斯维加斯算法:•特点:拉斯维加斯算法不会得到不正确的解。

一旦用拉斯维加斯算法找到一个解,这个解就一定是正确解。

与蒙特卡罗算法类似,拉斯维加斯算法找到正确解的概率随着它所用的计算时间的增加而提高。

但对所求解的问题,用同一个拉斯维加斯算法反复求解多次,可以使得求解失效的概率任意小。

各种分布的随机数生成算法

各型分布随机数的产生算法随机序列主要用概率密度函数(PDF〃Probability Density Function)来描述。

一、均匀分布U(a,b)⎧1x∈[a,b]⎪ PDF为f(x)=⎨b−a⎪0〃其他⎩生成算法:x=a+(b−a)u〃式中u为[0,1]区间均匀分布的随机数(下同)。

二、指数分布e(β)x⎧1⎪exp(−x∈[0,∞)βPDF为f(x)=⎨β⎪0〃其他⎩生成算法:x=−βln(1−u)或x=−βln(u)。

由于(1−u)与u同为[0,1]均匀分布〃所以可用u 替换(1−u)。

下面凡涉及到(1−u)的地方均可用u替换。

三、瑞利分布R(µ)⎧xx2exp[−x≥0⎪回波振幅的PDF为f(x)=⎨µ2 2µ2⎪0〃其他⎩生成算法:x=−2µ2ln(1−u)。

四、韦布尔分布Weibull(α,β)xα⎧−αα−1⎪αβxexp[−(]x∈(0,∞)βPDF为f(x)=⎨⎪0〃其他⎩生成算法:x=β[−ln(1−u)]1/α五、高斯(正态)分布N(µ,σ2)⎧1(x−µ)2exp[−]x∈ℜ2PDF为f(x)=⎨2πσ 2σ⎪0〃其他⎩生成算法:1〄y=−2lnu1sin(2πu2)生成标准正态分布N(0,1)〃式中u1和u2是相互独立的[0,1]区间均匀分布的随机序列。

2〄x=µ+σy产生N(µ,σ2)分布随机序列。

六、对数正态分布Ln(µ,σ2)⎧1(lnx−µ)2exp[−x>0PDF为f(x)=⎨2πσx 2σ2⎪0〃其他⎩生成算法:1〄产生高斯随机序列y=N(µ,σ2)。

2〄由于y=g(x)=lnx〃所以x=g−1(y)=exp(y)。

七、斯威林(Swerling)分布7.1 SwerlingⅠ、Ⅱ型7.1.1 截面积起伏σ⎧1−exp[σ≥0⎪σ0截面积的PDF为f(σ)=⎨σ0〃【指数分布e(σ0)】⎪0〃其他⎩生成算法:σ=−σ0ln(1−u)。

随机数的方法

随机数的方法随机数是计算机领域中常用的一种方法,用于产生一组随机的数值。

在一些需要随机性的计算中,比如密码学、概率统计、物理模拟等,随机数的作用不可忽视。

下面将介绍几种常用的随机数产生方法。

一、线性同余法线性同余法是最简单、最基础的随机数产生算法。

它的计算原理是利用某个数不断地乘以一个常数并加上另一个常数,然后对一个大数取余数,得到的余数就是一个伪随机数。

该算法的公式为:X(n+1) = (aX(n)+c) mod m其中,X(n)为第n个随机数,a、c、m为常数。

为了避免过多的线性相关性,常数的选择至关重要。

二、拉斐特——罗森费尔德算法拉斐特——罗森费尔德算法又称真随机数发生器,它是一种基于物理过程的随机数生成方法。

它的原理是利用光电效应或微波辐射产生的电信号的微小变化,作为随机因素,产生随机数。

该算法生成的随机数既真实又不可预测,但是需要一些特殊的硬件设备才能实现。

三、梅森旋转算法梅森旋转算法是一种用于产生高质量随机数的算法。

它的原理是利用一个大型的循环移位寄存器,每次进行大量的移位运算以增加随机性。

该算法的随机性非常好,并且产生的随机数周期很长,但是它需要更多的时间和计算资源来实现。

四、高斯分布高斯分布是一种常见的概率分布,也是一种常用的随机数生成方法。

它的原理是根据正态分布函数的概率密度函数来产生符合该函数的随机数。

通过该方法生成的随机数呈现出逼近正态分布的性质,适用于需要模拟实际情况的概率统计问题。

总之,随机数发生算法有很多种,我们需要根据实际需要选择合适的算法。

在实际应用中,需要考虑到随机数的质量、随机性、周期性等方面问题。

支持向量机与随机森林的比较与选择

支持向量机与随机森林的比较与选择支持向量机(Support Vector Machine,SVM)和随机森林(Random Forest)是机器学习领域中常用的两种分类算法。

它们都有着各自的优势和适用场景,下面将对它们进行比较与选择。

首先,我们来看支持向量机。

支持向量机是一种二分类模型,通过寻找一个超平面来将不同类别的样本分开。

它的核心思想是找到一个最优的超平面,使得离该超平面最近的样本点到该超平面的距离最大化。

这个最优超平面由少数支持向量决定,因此具有较好的鲁棒性和泛化能力。

支持向量机在处理高维数据和非线性问题时表现出色,可以通过核函数将低维特征映射到高维空间,从而更好地进行分类。

然而,支持向量机也存在一些不足之处。

首先,支持向量机对于大规模数据集的处理速度较慢,因为它需要计算每个样本点与超平面的距离。

其次,支持向量机对于噪声和异常值比较敏感,可能会影响分类效果。

此外,支持向量机的参数调优相对复杂,需要选择合适的核函数和正则化参数。

接下来,我们来看随机森林。

随机森林是一种基于决策树的集成学习方法,通过构建多个决策树来进行分类或回归。

随机森林的核心思想是通过随机抽取样本和特征,构建多棵决策树,并最终通过投票或平均来确定最终的分类结果。

随机森林具有较好的鲁棒性和泛化能力,能够处理高维数据和非线性问题。

此外,随机森林对于缺失值和异常值的处理较好,不需要进行数据预处理。

然而,随机森林也存在一些不足之处。

首先,随机森林对于高维稀疏数据的处理效果较差,可能会导致过拟合。

其次,随机森林在处理类别不平衡的数据集时可能会出现偏差。

此外,随机森林的模型解释性较差,无法提供明确的特征重要性排序。

在选择支持向量机和随机森林时,我们需要根据具体的问题和数据特点进行权衡。

如果数据集较小、特征维度较高、需要处理非线性问题或对模型的解释性要求较高,可以选择支持向量机。

如果数据集较大、需要处理噪声和异常值、不需要进行数据预处理或对模型的解释性要求较低,可以选择随机森林。

讨论随机算法和优化方法

讨论随机算法和优化方法随机算法和优化方法是数学、计算机科学以及应用科学中非常重要的概念,它们有着广泛的应用,尤其是在今天数据驱动的时代中。

随机算法和优化方法在工程、经济、金融等领域都有着广泛的应用。

此篇文章将会详细论述这两个概念,同时讨论它们的适用范围和比较。

一、随机算法随机算法是一种根据随机性质进行计算的算法。

其核心思想在于通过随机抽样来解决原问题。

随机算法通常用于解决NP问题,其运行时间一般为多项式时间。

1.1 随机算法的应用随机算法广泛应用于多个领域,如商业、金融、天文学、物理学、计算机科学等。

在商业和金融领域中,随机算法主要用于模拟金融市场的波动、风险评估等方面;在天文学和物理学领域,随机算法主要用于星系、等离子体等的模拟和计算;在计算机科学领域中,随机算法常常用于NP问题的解决。

1.2 随机算法的优点与传统算法相比,随机算法具有以下几个优点:(1)简单易用:随机算法不需要求解具体的数学表达式,只需要进行随机抽样即可,因此其应用范围广泛。

(2)效率高:随机算法可以在多项式时间内解决NP问题,相比于其他算法更加高效。

(3)容错性好:随机算法可以通过多次运行来避免出现极端情况,因此具有较好的容错性。

1.3 随机算法的局限性尽管随机算法有着广泛的应用和诸多优点,但是它也存在一定的局限性:(1)难以精确计算:由于随机算法依赖于随机抽样,因此其结果具有随机性,难以精确计算。

(2)误差较大:随机算法的结果受到随机性的影响,因此其误差可能较大,需要多次运行才能得到较为准确的结果。

(3)不适用于线性问题:随机算法适用于NP问题,在线性问题上其表现可能不如其他算法,需要选取适当的算法。

二、优化方法优化方法是一种通过系统的方法来优化某个参数的方法。

其核心思想在于将一个参数最优化,以达到更优的效果。

优化方法通常采用数学模型和算法来求解最优化问题。

2.1 优化方法的应用优化方法广泛应用于多个领域,如工业、交通、环境、能源等。

三种模式匹配算法的比较和分析

三种模式匹配算法作业要求:分别用KMP、MonteCarlo、LasVegs算法编制三个程序,随机生成不小于5000对长度不等的01串(三个程序使用相同的串),然后统计算法的执行时间和MonteCarlo算法的出错比率,并根据运行结果对三种算法进行深入的比较。

1、算法思路KMP算法的主要特点是指向主串的指针不需要回溯,只向右移动,即模式串在与主串失配时,并不回溯主串的指针与模式串重新匹配,而是根据已经得到的匹配信息将模式串尽可能远的向右滑动一段。

滑动距离的大小取决于模式串的失效函数next, next[k](0<=k<=m-1)的值表示当模式串在下标为k的字符处与主串失配时应该向右移动到下标为next[k]的字符处再与主串重新匹配。

算法首先要求模式串的失效函数next,然后再根据next的值进行模式匹配,在最坏情况下的时间复杂度为O(m*n),m为模式串的长度,n为主串的长度,当如果模式串中有较多相同的字符时,时间复杂度一般可达到O(m+n)。

MonteCarlo随机算法主要是通过比较模式串和主串中与模式串等长的串的“指纹”来匹配的,若两者指纹相等,则可以认为在概率意义下两者是相等的,算法中要求用到一个随机产生的素数作模运算,该素数的选取直接影响了算法的准确率,算法的时间复杂度为O(m+n)。

但有一定的出错率,即选取主串中比较串的指纹与模式串相等时但比较串与模式串并不相等,理论上这种情况出现的概率为1/n,只与主串的长度有关,与模式串的长度无关,但实际上只要选取素数合适出错率比1/n要小的多。

LasVegas算法是对MonteCarlo算法的改进,当模式串的指纹与主串中的比较串相等时,此时并不直接返回匹配的位置,而是判断两个字符串是否真的相等,相等则返回,否则继续匹配。

所以,该算法总能得到正确的位置,但算法的执行时间稍微比MonteCarlo算法要长一点(判断字符串是否相等的耗费),时间复杂度的期望值不超过O(m+n)。

均匀随机数的产生算法

均匀随机数的产生算法下面将介绍几种常见的均匀随机数产生算法:1. 线性同余法算法(Linear congruential generator, LCG):线性同余法算法是最常见的随机数产生算法之一、它的基本原理是通过以下递推公式得到随机数:Xn+1 = (a * Xn + c) mod m其中,Xn是当前的随机数,Xn+1是下一个随机数,a、c、m是常数,通常选择合适的a、c、m可以产生具有良好均匀性的随机数序列。

2. 递推式产生器(Recursive generator):递推式产生器是一种基于数学递推公式的随机数产生算法。

其基本原理是通过递推公式不断更新随机数的值,从而产生一系列随机数。

递推式产生器的一个常见例子是Fibonacci递推式:Xn+2 = (Xn+1 + Xn) mod m其中,Xn是当前的随机数,Xn+2是下一个随机数。

3. 平方取中法(Middle-square method):平方取中法是一种简单的随机数产生算法。

它的基本原理是通过将当前的随机数平方并取中间的几位数字作为下一个随机数。

具体步骤如下:-将当前的随机数平方,得到一个更大的数。

-取平方结果的中间几位作为下一个随机数。

-若需要较大的随机数,再次对下一个随机数进行平方取中操作。

4. 梅森旋转算法(Mersenne Twister):梅森旋转算法是一种基于梅森素数(Mersenne prime)的随机数产生算法。

它具有周期长、随机性好等特点,广泛应用于模拟、统计等领域。

该算法基于以下递归公式生成随机数:Xn=Xn-M^(Xn-M+1,u)其中,Xn是当前的随机数,Xn-M和Xn-M+1是前面两个随机数,u是一系列位操作(如或运算、异或运算等)。

通过选择不同的Xn-M和Xn-M+1,可以生成不同的随机数序列。

混合线性同余法是一种多元随机数产生算法。

它的基本原理是将多个线性同余法的结果进行线性组合,从而产生更高质量的随机数。

《随机算法介绍》课件

随机算法实现原理

通过随机性和概率性来解决问题,使用随机数 进行决策和选择。

随机算法的分析

1 时间复杂度

随机算法的运行时间可能取决于随机数生成的效率。

2 空间复杂度

随机算法可能需要额外的存储空间来保存随机数序列。

3 准确性分析

随机算法的解可能会有一定的误差,需要进行准确性分析。

随机算法的发展趋势

基于GPU的随法介绍》PPT课件。在这个课件中,我们将介绍随机算法 的定义、分类、应用、优点和不足,以及实现、分析和发展趋势。让我们一 起探索随机算法在计算机科学中的意义和未来展望。

什么是随机算法?

定义随机算法

随机算法是一种使用随机数或概率来解决问题的计算方法。

与传统算法的区别

统计学

随机抽样和模拟是统计学中 常用的方法。

生物学

随机算法在基因组学和进化 论中起着重要作用。

随机算法的优点和不足

1 优点

2 不足

随机算法可以在复杂问题中找到近似解, 并能够快速处理大规模数据。

随机算法可能会产生不确定性和不可预测 性,在某些情况下无法提供确定解。

随机算法的实现

随机数生成方法

使用伪随机数发生器生成随机数序列。

随机算法在一定的概率范围内给出近似解,而传统算法则给出确定性解。

随机算法的分类

Monto Carlo算法

通过生成随机样本来估计问题的解。

Randomized算法

使用随机性进行问题求解的通用方法。

Las Vegas算法

随机地选择解决方案并检验其正确性。

随机算法的应用

计算机科学

随机算法在图形处理、优化 和密码学等领域有广泛应用。

借助图形处理器的并行计算能力加速随机算法 的运行。

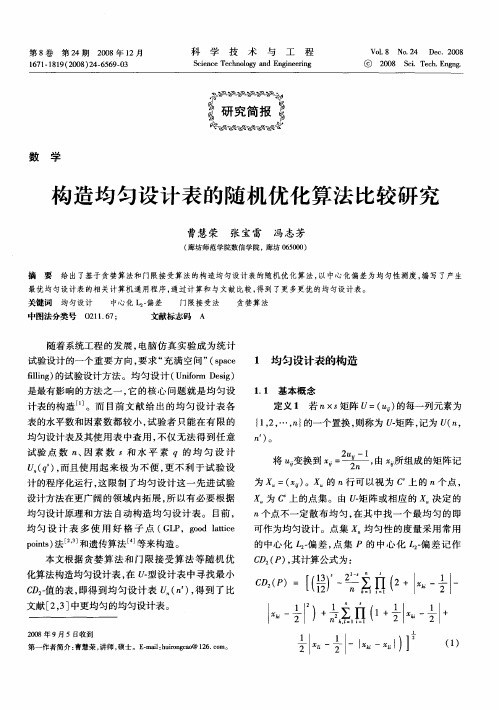

构造均匀设计表的随机优化算法比较研究

最优 均匀设 计表 的相 关计算机 通用程序 , 通过 计算和与文献 比较 , 到 了更多更优 的均匀设 计表。 得

关键词 均匀设 计

中图法分类号

O 1.7 2 I6 ;

文献标志码

A

随着 系统工 程 的 发 展 , 电脑仿 真 实验 成 为 统 计 试验设 计 的一个 重 要 方 向 , 求 “ 要 充满 空 问 ” sae (pc

n×s 中具 有最 小 的 C 值 。将 记 为 U n) X D一 ( 。

1 2 生成 均匀设计 表 的优 化算 法 . 下面 使 用 门 限 接 受 算 法 ( hehl c et g T rso A cpi d n A gr h T 和贪 婪算 法 ( re yAgrh 构 l i m,A) ot G ed l i m) ot 造 均匀设计 表 , 成 的 均 匀 设 计 表 更 加 均 匀 , 量 生 质 更 高 。产 生均匀设 计表 的随机优 化算 法如下 :

均 匀设计 表 及其使 用 表 中查 用 , 仅 无 法 得 到 任 意 不 试 验 点 数 、因 素 数 s和 水 平 素 的 均 匀 设 计

定义 1 若 1× 矩阵 U=( ) 2 s 的每一列元素为

{ ,, , } 12 … 1 的一个 置换 , 2 则称 为 矩 阵 , 为 U( , 记 2 1

Se6 否则 , S p ; t , p 转 t 2 e

化算法构造均匀设计表 , 在 型设计表中寻找最小 C D一 值的表 , 即得到均匀设计 表 ( ) 得 到 了比 ,

文献[ ,] 23 中更均匀 的均匀设计表。

20 0 8年 9月 5日收到

c 2P D ( )=

一 抖 I 丢) ( 1 一l % I+ % + 一 n + 1

权重随机算法

权重随机算法1. 介绍1.1 定义权重随机算法是一种用于在多个选项中按照权重进行随机选择的算法。

每个选项都有一个权重值,权重越高,被选择的概率就越大。

权重随机算法广泛应用于各种领域,比如负载均衡、广告投放、推荐系统等。

1.2 背景在很多场景下,我们需要根据一定的规则从多个选项中选择一个。

例如,一个在线商城的首页需要展示不同商品的推荐位,我们需要根据商品的热度、销量等指标来决定每个商品出现的概率。

又例如,一个广告平台需要根据广告主的出价和投放的策略来决定广告的曝光次数。

为了实现以上需求,我们就需要使用权重随机算法来进行选择。

2. 常见的权重随机算法2.1 简单随机算法简单随机算法是最基础的权重随机算法。

它的思想很简单,就是根据权重值来计算每个选项的概率,然后用一个随机数来选择。

具体的步骤如下:1.计算每个选项的概率,概率的计算公式为:选项的权重值 / 所有选项的权重值之和。

2.生成一个0到1之间的随机数。

3.遍历每个选项的概率,判断当前随机数落在哪个区间内,选择对应的选项。

这种算法简单易懂,实现也比较容易,但是它的效率比较低。

当选项的数量很大时,需要计算大量的概率值,而且每次选择都需要遍历所有的选项。

在实际应用中,我们往往需要更高效的选择算法。

2.2 加权随机算法加权随机算法是对简单随机算法的改进。

它通过将所有的选项按照权重值构建一个加权的线段,然后通过线段上的随机点来选择选项。

具体的步骤如下:1.计算每个选项的概率,概率的计算公式同样是:选项的权重值 / 所有选项的权重值之和。

2.将每个选项的概率转换成线段的长度,构建一个加权的线段。

3.生成一个0到1之间的随机数,在加权线段上选择对应的点。

4.根据选择的点判断落在哪个区间内,选择对应的选项。

加权随机算法相比于简单随机算法,在计算概率时只需遍历一次选项,并且选择时只需一次比较,所以效率要高一些。

但是当选项的数量很大时,构建加权线段的开销仍然比较大。

自适应光学系统几种随机并行优化控制算法比较

校正相 位 ; r 一 ( ) “ r 是 残余 相位 ; 一 { Y 为 () r+ () r z, )

正 交 于光轴 的平 面 中的 向量 ; r 和 U r 都 是 连 续 函 ( ) () 数; J为系 统 性 能 指标 ; H一 { U , ,。)为 控 制 变 U ,。… U 形镜 3 2个 驱动 器的 电压 向量 。

Fi 1 B o k d a r m fAO y t m g. l c ig a o s se

图 1 系 统 工作 原理 图

系统 性 能指标 ; 如此 迭 代进 行 , 至满 足 系统对 指标 的要求 为 止 。 迭代 的过 程则 是在 参数 空 间 中寻 找最 佳 电压 直

光学 应用 领域 的扩展 , 如在 大气 光通 信等 没 有信 标光 的应 用场 景 , 以及 存 在强 闪烁现 象 的大气 长程 传 输应 用场

景 中 , 于波前 传感 器 的常规 自适 应 光学 控 制技术 的应 用 受到 限制 。近年 来 , 于 系统性 能指 标 直接 优化 的 自 基 基 适 应 光学控 制 技术 , 由于其硬 件 实现 上 的简单 性及 对 闪烁 等复 杂 环境条 件 的适应 性 , 越来 越受 到 自适 应光 学研

探索。

1 仿 真 模 型

图 1为采用 随 机并 行优 化 控制 算法 的 自适 应光 学 系统 工作 原理 图 。 由 3 2单元 变 形镜 、 源 、 像 系统 、 光 成 性 能指 标分 析模 块及 优 化 算 法 模 块 组 成 。图 1中各 符号

意义 如下 : () 原始 畸变 波 前 ; () r是 u r 是变 形 镜 引人 的

随 机并 行 优 化 控 制 算 法 是 该 技 术 成 功 实 现 的关 键 。 以 3 单 元 变 形 镜 为 校 正 器 , 于 多 种 随 机 并 行 优 化 算 法 建 2 基

随机森林算法复杂度计算

随机森林算法复杂度计算

随机森林算法的复杂度主要取决于几个关键因素:决策树的数量、特征的数量、树的结构复杂度以及数据集的大小。

下面是一个简化的复杂度分析:

决策树数量(T):随机森林包含多棵决策树,假设我们有 T 棵树。

对于每棵树,我们进行一次划分,所以复杂度为O(T)。

特征数量(D):随机森林中的每棵树在每次划分时,都要从D 个特征中选择一个最佳特征。

因此,复杂度为 O(D)。

树的结构复杂度:一棵决策树的复杂度取决于它的深度和叶节点的数量。

假设树的最大深度为 M,那么训练一颗决策树的复杂度大约为 O(2^M)。

但是,由于我们有很多树,平均复杂度可能会低很多。

数据集大小(N):随机森林需要 N 个样本进行训练。

在每个节点进行划分时,需要计算 N 个样本的类别标签。

因此,复杂度为 O(N)。

综合以上因素,我们可以得出随机森林算法的整体复杂度大致为:O(T * N * D),其中 T 是决策树的数量,N 是数据集的大小,D 是特征的数量。

ChatGPT的随机采样算法与重要性采样算法的比较

ChatGPT的随机采样算法与重要性采样算法的比较ChatGPT是一种通过人工智能技术生成文本的模型,已经在各个领域展示出惊人的语言生成能力。

然而,为了生成高质量的文本,ChatGPT借助了一种叫做采样的算法,从潜在的各种可能性中选择下一个单词。

在ChatGPT的采样算法中,随机采样和重要性采样是两种常见的方法。

本文将对这两种算法进行比较,并分析它们在ChatGPT中的应用与优缺点。

随机采样算法是ChatGPT中常用的一种方法,它通过从概率分布中随机选择下一个单词来生成文本。

这种方法相对简单且易于实现,它不需要对概率分布进行复杂的计算,而是简单地根据每个候选单词的概率分布进行采样。

但是,随机采样算法容易导致一些问题,例如重复使用高频词、生成不准确或无意义的句子等。

这是因为在随机采样算法中,每个单词都有一定的概率被选中,即使其中一些单词可能是非常罕见的或不合适的。

因此,虽然随机采样算法简单快速,但生成的结果往往难以控制和优化。

为了解决随机采样算法的问题,ChatGPT引入了重要性采样算法。

重要性采样算法根据每个候选单词的概率权重,在生成文本时更加注重高频词,从而减少无意义的句子生成。

具体而言,ChatGPT通过计算每个候选单词的概率权重,根据概率权重对单词进行采样。

这样做的好处是,能够更好地控制生成的文本质量,并避免过多地使用高频词。

重要性采样算法在生成有逻辑、流畅且准确的文本方面表现出色,使ChatGPT在语言生成方面取得了更好的效果。

然而,重要性采样算法并非没有缺点。

首先,计算概率权重需要耗费大量的计算资源,使得生成过程变得更加缓慢。

此外,重要性采样算法对概率权重的计算需要依赖于模型自身的训练数据,如果训练数据不充分或不准确,那么生成文本的质量也会受到影响。

因此,在实际应用中,需要权衡计算成本和生成效果,选择适合的采样算法。

从上述比较可以看出,随机采样算法和重要性采样算法都有各自的优缺点。

随机采样算法简单快速,但生成的文本质量难以控制;而重要性采样算法能够生成高质量的文本,但计算成本较高。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

问题:

对比舍伍德算法、拉斯维加斯算法、蒙特卡洛算法的适用范围以及它们的优缺点。

一、舍伍德算法:

● 特点

舍伍德算法总能求得问题的一个解,且所求得的解总是正确的。

当一个确定性算法在最坏情况下的计算复杂性与其在平均情况下的计算复杂性有较大的差别时,可在这个确定性算法中引入随机性将它改造成一个舍伍德算法,消除或减少问题的好坏实例间的这种差别。

舍伍德算法的精髓不是避免算法的最坏情形行为,而是设法消除这种最坏情形行为与特定实例之间的关联性。

舍伍德算法不会从整体上或平均的改善问题求解的时间复杂度,但可以对一些特别耗时的特定输入改善至较适中的时间复杂度。

设A 是一个确定性算法,当它的输入实例为x 时所需的计算时间记为tA(x)。

设Xn 是算法A 的输入规模为n 的实例的全体,则当问题的输入规模为n 时,算法A 所需的平均时间为

这显然不能排除存在x ∈Xn 使得 tA(x)>>tA(n)的可能性。

希望获得一个概率算法B ,使得对问题的输入规模为n 的每一个实例均有 这就是舍伍德算法设计的基本思想。

当s(n)与tA(n)相比可忽略时,舍伍德算法可获得很好的平均性能。

● 适用范围:

1. 快速排序算法

2. 线性时间选择算法

上述两算法选择合适的划分基准,舍伍德算法随机地选择一个数组元素作为划分基准,这样既能保证算法的线性时间平均性能,又避免了计算拟中位数的麻烦。

()()n A

x X A n

T x T n X ∈=∑()()()

A B T x T n s n =+

3.搜索有序表

利用数组的小标的索引性质,可以设计一个随机化搜索算法,以改进算法的搜索时间复杂性。

即随机抽取数组元素若干次,从较近搜索元素x的位置开始做顺序搜索。

4.跳跃表

在跳跃表中随机增加附加指针,以及在该结点处应随机增加指针。

二、拉斯维加斯算法:

●特点:

拉斯维加斯算法不会得到不正确的解。

一旦用拉斯维加斯算法找到一个解,这个解就一定是正确解。

与蒙特卡罗算法类似,拉斯维加斯算法找到正确解的概率随着它所用的计算时间的增加而提高。

但对所求解的问题,用同一个拉斯维加斯算法反复求解多次,可以使得求解失效的概率任意小。

拉斯维加斯算法能显著改进算法的有效性。

甚至于对某些迄今为止找不到有效算法的问题,也能得到满意的结果。

拉斯维加斯算法的一个显著特征是它所做出的随机性决策有可能导致算法找不到所需的解。

因此通常用一个bool型函数来表示拉斯维加斯型算法。

当算法找到一个解时返回true,否则返回false。

拉斯维加斯算法的典型调用形式为bool success=LV(x,y);其中x是输入参数;当success的值为true时,y返回问题的解。

当success的值为false时,算法未能找到问题的解。

此时可以对同一实例再次独立的调用相同的算法。

●适用范围:

1.n后问题

在棋盘上相继的各行中随机地放置皇后,并且注意使新放置的皇后与已放置的皇后互不攻击,直至n个皇后均已经相容地放置好,或已没有下一个皇后的可放置位置为止。

2.整数因子分解

3.字符串匹配

基于哈希计算的字符串匹配算法是拉斯维加斯型概率算法,母串的子串与模式串的哈希值相等时并不能保证匹配成功,而需要用朴素的方式进行验证

三、蒙特卡罗算法:

● 特点:

蒙特卡罗算法总能得到问题的答案,但偶尔会产生不正确的答案。

有时并不能判断给出的答案是否正确。

不存在任何近似解答。

重复运行算法使得产生不正确解的概率任意小。

在实际应用中,我们常会遇到一些问题,不论是采用确定性的算法亦或者是随机算法都无法保证每次都能得到正确的解。

蒙特卡罗算法则在一般情况下可以保证对问题的所有实例都以高概率给出正确的解,但是通常无法判断一个具体解是否正确。

设p 是实数,且121<<p 。

如果一个蒙特卡罗算法对于问题的任意实例得到正确解的概率不小于p ,则称该蒙特卡罗算法是p 正确的。

且称21-p 是该算法的优势。

如果对同一实例,蒙特卡罗算法不会给出两个不同的正确答案,则称该蒙特卡罗算法是一致的。

对于一致的p 正确的蒙特卡罗算法,要提高获得正确解的概率,只要执行该算法若干次,并选择出频次最高的解即可。

● 适用范围:

1.

主元素问题 2.

素数测试 3.

二次探测 4.

费马定理。