机器翻译评测大纲

评价机器翻译的自动评价指标研究

评价机器翻译的自动评价指标研究机器翻译自动评价指标是机器翻译领域中非常重要的研究方向之一。

机器翻译的目标是将一种语言翻译成另一种语言,这是一项非常困难的任务,因为语言是非常复杂的。

机器翻译自动评价指标可以帮助我们评估机器翻译的质量,进一步改进机器翻译的算法。

在这篇文章中,我们将评价机器翻译的自动评价指标研究。

1. 机器翻译的自动评价指标简介机器翻译的自动评价指标可以帮助我们评估机器翻译的质量。

常见的自动评价指标包括BLEU、NIST、TER、WER等。

BLEU是一种广泛使用的自动评价指标,它基于n-gram匹配来度量译文与参考译文之间的相似性。

NIST评价指标是一种基于n-gram的指标,它与BLEU指标相似,但是使用了不同的权重。

TER评价指标是一种编辑距离的度量,它计算译文与参考译文之间的编辑距离。

WER评价指标是一种字级别的编辑距离度量,它计算译文与参考译文之间的错误率。

2. BLEU指标BLEU指标是一种基于n-gram的度量方法,它通过计算参考译文和机器翻译之间的n-gram匹配来评估翻译的质量。

BLEU指标的计算方法如下:其中,Pn是n-gram的精度,BP是基于翻译长度的惩罚因子。

BLEU指标的优势在于它简单易用,而且针对不同的n-gram可以得到不同的结果。

但是,它也存在一些缺陷,比如不能够处理稀有词和长句子,而且它假设越长的n-gram匹配越重要。

3. NIST指标NIST指标是一种基于n-gram的评价指标,它与BLEU指标类似,但是使用了不同的权重。

NIST指标的计算方法如下:其中,NISTn是n-gram的精度,w(n)是权重因子。

NIST指标的优势在于它可以根据语料库的不同自适应调整权重因子,而且它考虑了n-gram出现的频率。

但是,它也存在一些问题,比如它对于稀有词和长句子的处理能力不够。

4. TER指标TER指标是一种编辑距离的度量方法,它计算机器翻译和参考译文之间的编辑距离。

te-btbc标准

te-btbc标准TE-BTBC标准(简体中文版)引言:TE-BTBC(Translation Evaluation - Chinese)标准是一种用于评估翻译质量的标准,其目的是提高翻译质量,促进翻译行业的发展。

本标准针对简体中文翻译进行评估,旨在客观、全面地评估翻译的准确性、流畅性、语气和文化适应度等方面,以帮助翻译人员提升翻译技巧和水平。

一、准确性准确性是翻译的基本要求,指翻译的内容必须忠实于原文,精确传达原文的意思。

评估翻译准确性时,需要考虑以下几个方面:1.语法准确性:翻译使用正确的语法结构和词语搭配,符合汉语的语法规则。

2.词汇准确性:翻译使用准确的词汇,能够准确表达原文的意思,避免歧义和误导。

3.句意准确性:翻译传达出与原文相同的句意,不改变原文的思想和观点。

二、流畅性流畅性是指翻译的表达方式自然流畅、易于理解。

评估翻译流畅性时,需要考虑以下几个方面:1.语言风格:翻译符合汉语的表达习惯和文化特点,采用恰当的语言风格和表达方式。

2.句子结构:翻译采用简明扼要的句子结构,避免冗长和复杂,保持整体逻辑和语义的连贯性。

3.文章结构:翻译能够合理划分段落,使文章逻辑清晰,段落间过渡自然。

三、语气语气是指翻译所传递的情感色彩和表达方式。

评估语气时,需要考虑以下几个方面:1.文体:翻译能够准确把握原文的文体特点,如正式、口语化、幽默等,保持一致。

2.称呼和尊称:翻译能够恰当使用适当的称呼和尊称,以传达原文中的社交和文化差异。

3.情感表达:翻译能够传达出原文中的情感色彩,如喜悦、悲伤、愤怒等,使读者能够感同身受。

四、文化适应度文化适应度是指翻译在传达原文意思的同时,能够符合目标语言的文化背景和习惯。

评估文化适应度时,需要考虑以下几个方面:1.文化障碍:翻译要注意克服源语言和目标语言之间的文化障碍,调整翻译表达方式以适应目标语言读者的习惯和理解水平。

2.文化特色:翻译能够充分体现原文的文化特色和情感色彩,传递原文中的文化信息和价值观念。

bleu评价指标

bleu评价指标BLEU评价指标1. 介绍随着机器翻译技术的不断发展,人们对于如何有效地评价机器翻译质量的问题变得越来越重要。

BLEU(Bilingual Evaluation Understudy)评价指标是其中一种经典的机器翻译评价方法,它于2002年由Kishore Papineni等人提出。

2. BLEU的计算方法BLEU的计算方法主要是通过比较机器翻译输出与人工翻译结果之间的相似度来评价机器翻译的质量,同时也可以根据不同的处理方式进行一些加权处理。

其计算公式如下:BLEU = BP * exp(sum(wi * log(pi)))其中,BP是一个叫做“brevity penalty”的因子,用来惩罚机器翻译结果长度超过参考翻译结果的情况,防止机器翻译通过生成大量无效的词来提高分数。

在计算BP时,设N为机器翻译结果的单词数,M为参考翻译结果中最接近N的句子的单词数,具体计算公式为:if N>M:BP=1else:BP = exp(1-M/N)wi和pi分别是权值因子和precision值,表示对机器翻译输出和参考翻译结果每个n-gram的匹配程度进行计算,具体计算公式如下:wi = 1/npi = 这些n-gram在机器翻译输出中出现的次数之和 / 这些n-gram在所有参考翻译结果中出现的次数之和其中,n-gram可以是1-gram,2-gram等,表示机器翻译输出和参考翻译结果中每个连续n个单词的组合。

3. BLEU的优点和缺点BLEU评价指标具有较高的效率和可测度性,可以实现对机器翻译输出质量的快速评价,并且具有一定的随时间演变性质。

同时,BLEU也是一种相对较为公正的评价方式,不会受到任何主观性和个人情况的影响。

但同时,BLEU也有其缺点。

因为BLEU主要是针对n-gram和准确率进行评价,因此它无法很好地评价机器翻译输出的全局语义和上下文连贯性等方面。

在评价长文本或者涉及词汇多样性较高的语料时,BLEU的评价方式也可能会存在一定的不足。

ISCAS机器翻译和系统融合评测系统16页PPT

n=7

w i 权重,利用开发集训练

12

测试

使用提供的10个单位提交的17个系统的翻译 结果(没有使用系统U14的结果)

ID BLEU4 NIST5 GTM mWER mPER ICT ISCAS 0.2509 8.1013 0.7196 0.7154 0.5005 0.3336 最好结果 0.2944 7.7501 0.7319 0.6761 0.4972 0.3920

3

系统流程

平行语料

全部小写化

训练

预处理 GIZA++

数词识别

双向词对齐

与替换

短语抽取 5个概率

4元 语言模型

Beam 搜索 解码

4

3元大小写敏感 语言模型

后处理

数词翻译 替换

翻译输出

特征

短语翻译概率 p(e | f ) 词汇化概率 lex(e | f ) 反向短语翻译概率 p( f | e) 反向词汇化概率 lex( f | e) 短语惩罚概率(2.718) 词语惩罚(目标语言句子长度) 目标语言模型,4元

5

Байду номын сангаас

预处理和后处理

中文语料中的英文和英文语料全部小写 中文全角字符转换为半角

– ABC123→ ABC123

Stanford Chinese Word Segmenter分词 数字单独处理

6

训练语料

来源 厦门大学英汉电影字幕平行语料库

数据提供 单位

厦门大学

数据文件 类型

电影

句对数目 (约)

中英句子级对齐双语语料库

动化所

合计

综合

30万 82万

7 短语数量:1600万

gpt评测标准

GPT评测标准随着人工智能技术的不断发展,自然语言处理领域也取得了显著的进步。

GPT(Generative Pre-trained Transformer)作为一种先进的自然语言处理模型,在文本生成、问答系统、机器翻译、情感分析以及文本摘要等方面都展现出了强大的能力。

为了全面评估GPT的性能,本文将从以下五个方面提出评测标准。

一、文本生成在文本生成方面,我们需要考察GPT生成文本的连贯性、逻辑性和可读性。

连贯性是指生成的文本在内容上应保持逻辑上的连贯,句子之间的衔接自然;逻辑性要求文本中的信息组织合理,符合常识和事实;可读性则要求生成的文本易于理解,避免出现语法错误和语义不清晰的情况。

同时,我们还应对GPT 在不同领域的文本生成能力进行评测,包括但不限于文学创作、科技文章、新闻报道等。

二、问答系统在问答系统方面,我们需要考察GPT对问题的理解能力、推理能力和答案生成能力。

理解能力要求GPT能够准确理解问题的含义和关键信息;推理能力要求GPT能够根据问题提供的信息和常识知识进行逻辑推理,找到正确的答案;答案生成能力要求GPT能够清晰、准确地回答问题。

同时,我们还需要考虑问答系统的多轮交互能力,以及在不同领域和场景下的应用效果。

三、机器翻译在机器翻译方面,我们需要考察GPT的翻译准确性、流畅性和多语言支持能力。

翻译准确性要求GPT能够准确地将源语言翻译成目标语言,避免出现语义上的偏差;流畅性要求GPT的翻译结果在语法和表达上流畅自然,符合目标语言的习惯;多语言支持能力则要求GPT能够支持多种语言的翻译,满足不同用户的需求。

此外,我们还需要对GPT在不同领域的翻译效果进行评测,如医学、法律、科技等。

四、情感分析在情感分析方面,我们需要考察GPT对文本情感倾向的识别能力、情感极性判断能力和情感强度判断能力。

识别能力要求GPT能够准确识别文本中的情感倾向,如积极、消极、中立等;情感极性判断能力要求GPT能够判断文本的情感极性,如正面或负面;情感强度判断能力则要求GPT能够判断文本情感的强度,如强烈、温和等。

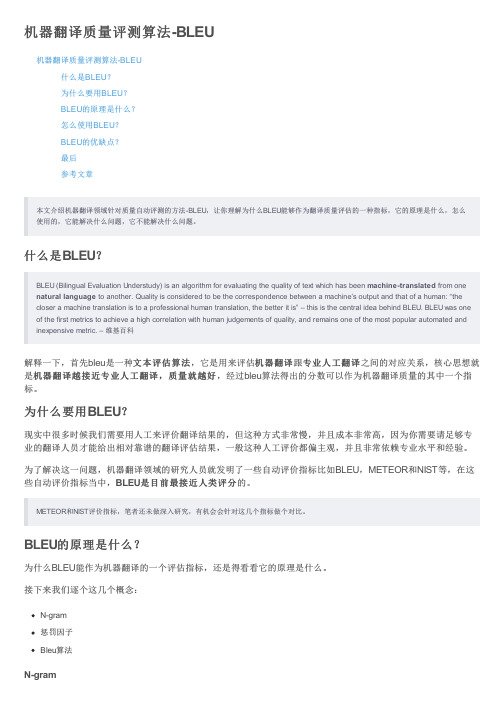

机器翻译质量评测算法-BLEU

机器翻译质量评测算法-BLEU机器翻译质量评测算法-BLEU什么是BLEU?为什么要用BLEU?BLEU的原理是什么?怎么使用BLEU?BLEU的优缺点?最后参考文章本文介绍机器翻译领域针对质量自动评测的方法-BLEU,让你理解为什么BLEU能够作为翻译质量评估的一种指标,它的原理是什么,怎么使用的,它能解决什么问题,它不能解决什么问题。

什么是BLEU?BLEU (Bilingual Evaluation Understudy) is an algorithm for evaluating the quality of text which has been machine-translated from one natural language to another. Quality is considered to be the correspondence between a machine’s output and that of a human: “the closer a machine translation is to a professional human translation, the better it is” – this is the central idea behind BLEU. BLEU was one of the first metrics to achieve a high correlation with human judgements of quality, and remains one of the most popular automated and inexpensive metric. – 维基百科机器翻译跟专业人工翻译专业人工翻译之间的对应关系,核心思想就文本评估算法,它是用来评估机器翻译解释一下,首先bleu是一种文本评估算法机器翻译越接近专业人工翻译,质量就越好,经过bleu算法得出的分数可以作为机器翻译质量的其中一个指是机器翻译越接近专业人工翻译,质量就越好标。

人工智能机器翻译算法效果评估

人工智能机器翻译算法效果评估人工智能(Artificial Intelligence,AI)的快速发展使机器翻译成为现实,并在许多领域带来了重大影响。

然而,机器翻译的质量在很大程度上取决于其中采用的算法。

因此,准确评估人工智能机器翻译算法的质量和效果对于提升翻译质量和进一步发展机器翻译技术至关重要。

一、算法评估标准为了评估人工智能机器翻译算法的效果,需要确定一些评估标准。

常用的评估指标包括:BLEU分数、METEOR分数、TER分数、PER分数等。

这些评估指标旨在对翻译结果与参考翻译进行比对,获取翻译质量的度量。

1.1 BLEU分数BLEU(Bilingual Evaluation Understudy)是一种衡量机器翻译质量的指标。

它通过计算机翻译结果与参考翻译之间的n-gram重叠率来评估翻译质量。

BLEU分数的取值范围在0到1之间,分数越高表示翻译质量越好。

1.2 METEOR分数METEOR(Metric for Evaluation of Translation with Explicit ORdering)是另一种常用的机器翻译评估指标。

METEOR分数结合了精确匹配、包含和临近匹配等不同的匹配方式,从而更全面地评估翻译质量。

1.3 TER分数TER(Translation Edit Rate)是一种度量机器翻译错误率的指标。

它通过参考翻译和机器翻译结果之间的编辑距离来评估翻译质量。

TER分数越低表示翻译质量越好。

1.4 PER分数PER(Position-independent Edit Rate)是一种与位置无关的编辑距离度量。

与TER类似,PER分数也用于评估机器翻译质量,越接近0表示翻译质量越好。

二、效果评估方法为了准确评估人工智能机器翻译算法的效果,需要进行以下步骤:2.1 数据准备为了评估机器翻译算法的效果,需要准备一个包含源语言文本和对应参考翻译的数据集。

数据集的大小和多样性对于评估结果的准确性和实用性至关重要。

BLEU分数AI自动翻译的评测标准

BLEU分数AI自动翻译的评测标准BLEU分数:AI自动翻译的评测标准自动翻译是人工智能领域中一个重要的研究方向,其目标是通过机器翻译来实现不同语言间的交流与理解。

在评估机器翻译系统的性能时,我们需要一套客观、准确的评测标准,以便对不同系统的翻译结果进行比较和分析。

BLEU(Bilingual Evaluation Understudy)分数就是其中之一。

BLEU分数是一种用于评估机器翻译结果与参考翻译之间相似度的评测指标,它主要通过计算n-gram重叠的精确率来得出一个综合的分数。

在计算BLEU分数时,我们需要考虑翻译结果的精确性、流畅性和上下文一致性等方面。

在计算BLEU分数时,我们首先要收集若干个人工生成的参考翻译,这些参考翻译应当代表标准的、人工生成的翻译结果。

然后,我们需要将机器翻译系统生成的结果与这些参考翻译进行比较,从而得出BLEU分数。

BLEU分数的计算主要分为两个步骤:翻译片段的匹配计算和文本片段的加权计算。

在翻译片段的匹配计算中,我们首先将机器翻译结果和参考翻译进行n-gram的切分,然后统计机器翻译结果中与参考翻译相匹配的n-gram的数量,最后计算精确率。

在文本片段的加权计算中,我们对不同n-gram的精确率进行加权,以避免短文本的翻译结果得分过高的问题。

BLEU分数的取值范围在0到1之间,越接近1表示机器翻译结果与参考翻译的相似度越高。

通常来说,BLEU分数大于0.4被认为是相对良好的翻译结果,而大于0.6则被认为是较为优秀的翻译结果。

虽然BLEU分数在机器翻译评估中起到了重要的作用,但它也有一些限制。

首先,BLEU分数无法完全捕捉翻译结果的质量,因为它主要基于n-gram匹配,而不考虑句子结构、语法和语义等因素。

其次,BLEU分数对于长短不一的句子会有一定的偏差,过长或过短的句子可能得到较低的分数。

此外,在翻译结果中出现罕见的词汇或短语时,BLEU分数也会较低,因为这些翻译结果无法与参考翻译完全匹配。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

机器翻译评测大纲一、评测对象本次评测的对象包括:汉-英、英-汉、汉-日、日-汉机器翻译系统中的核心技术。

二、评测内容本次评测组织两种语料的评测,一种是篇章语料,一种是对话语料。

领域是面向奥运的相关领域,包括体育赛事、天气预报、交通住宿、旅游餐饮等。

本次评测的评测指标包括译文质量和翻译速度。

三、评测方法1. 评测方式本次评测为现场评测。

采用的是以人工评测为主,人工评测和自动评测相结合的方式。

人工评测方式是:由评测组织单位将各个评测单位提交的评测结果汇总在一起,然后用计算机随机打乱译文句子的排列顺序。

再将所有译文句子提交给多位专家进行人工评测。

将专家评测的结果汇总,用计算机还原成原来的排列顺序,分别计算出各个评测单位的总得分。

2.评测步骤∙在评测单位统一提供的评测环境上安装被测系统∙评测单位给出评测数据∙被测单位运行系统,提交评测结果∙评测单位运行自动评测程序,得出自动评测结果∙评测单位事后进行人工评测∙公布评测结果3.评测标准(1)自动评测标准机器翻译的自动评测目前比较成熟的标准有BLEU标准、NIST标准等。

本次评测采用NIST标准。

具体评测标准见附件。

(2)人工评测标准本次评测按0 - 6个等级层次打分,最后采用百分制换算评测结果。

总的可理解率=(T1*20%+T2*40%+T3*60%+T4*80%+T5*90%+T6*100%)/ 总句数其中:Ti为被评为第i等级的句数。

(3)翻译速度评测标准由主持评测的工作人员现场记录翻译时间,各系统自动显示从第一个句子翻译开始到所有句子翻译完毕所用的时间(不计系统初始化所用时间,只记开始翻译到所有句子翻译完毕所用时间)。

4. 输入输出文件格式下面以汉英机器翻译为例,说明输入输出文件格式。

其中p标签为段落标记,s标签为句子标记。

输入文件中每个s标签内部为一个句子。

输出文件中每个s 标签与输入文件中的s标签一一对应。

由于一个源语言句子可能翻译成一个或多个目标语言句子,所以输出文件中每个s标签内部可以有不只一个句子。

Lang 为语言代码,汉语用“zh”表示,英语用“en”表示,日语用“ja”表示。

汉语、英语、日语的输入和输出文件统一采用GBK编码。

(1)输入文件格式:<DOC docid="机器翻译" lang=”zh”><p><s id=1> 玻利维亚举行总统与国会选举</s></p><p><s id=2> (法新社玻利维亚拉巴斯电)玻利维亚今天举行总统与国会选举,投票率比预期更高,选民希望选出的新领导阶层能够振兴经济,改善人民的生活水准,抑制这个南美洲最贫穷国家的劳工骚动。

</s></p><p><s id=3> 投票所于下午四时(台北时间七月一日清晨四时)关闭,选务人员说,选举结果将于两小时之后开始发布。

</s></p><p><s id=4> 稍早,玻利维亚总统与参与选举的候选人援引巴西赢得世足赛冠军为例,鼓励民众踊跃投票,虽然联邦法律规定,凡达投票年龄的玻利维亚人都必须投票。

</s></p><p><s id=5> 任期即将届满的玻利维亚总统吉洛卡说:「巴西队在横滨以二比0击败德国队,我们玻利维亚人必须击败那些不出来投票的人。

」</s></p><p><s id=6> 全国执勤的三万名军人与警察奉命投票日必须禁止卖酒,也禁止群众聚会,但随着邻国巴西赢得第五次世足赛冠军的消息上午传抵此间,玻利维亚人同样欣喜若狂,集体狂欢,军警根本无法执行上述禁令。

</s></p><p><s id=7> 美洲国家组织派遣五十名观察员监督玻利维亚恢复民主统治以来的第五次大选。

</s><s id=8> 政府官员说,边界已经关闭以防止选举舞弊。

</s></p></DOC>(2)输出文件格式:<DOC docid="机器翻译" lang=”en” site="单位名称"><p><s id=1> Bolivia Holds Presidential and Parliament Elections </s></p><p><s id=2> (AFP, La Paz, Bolivia) Bolivia held its presidential and parliament elections today. With a higher than expected turn-out rate, voters hope the newly elected leadership can revitalize the economy, improve the people's living standards and control the labor unrest in this poorest country in South America. </s></p><p><s id=3> The polling stations closed at 4 p.m. (4 a.m. on July 1, Taipei time). The polling staff said that the results of the elections will be released within two hours.</s></p><p><s id=4> Earlier, the Bolivian president and candidates in the elections, citing Brazil's championship at the World Cup soccer tournament, encouraged the public to actively participate in the elections even though every Bolivian who has reached the voting age is required by the federal law to vote. </s></p><p><s id=5> The Bolivian President Quiroga, whose term soon expires, said: "The Brazilian team defeated the German team 2-0 in Yokohama; we the Bolivians must defeat those who do not come out to vote." </s></p><p><s id=6> 30,000 soldiers and police on duty nationwide were ordered to ban sales of alcoholic drinks and mass gatherings on the election day. Yet, as the news of the neighboring Brazil winning the fifth championship at World Cup soccer tournament reached here this morning, Bolivians were equally overjoyed and indulged themselves in revelry, making the ban practically unenforceable by the soldiers and police. </s> </p><p><s id=7> The Organization of American States has sent 50 observers to monitor the fifth general election since Bolivia restored its democratic rule. </s><s id=8> Government officials said that the border has been closed so as to prevent any election frauds. </s></p></DOC>四、评测环境本次评测环境包括:操作系统为Windows2000,硬件配置不低于:P4 1GHz,256M内存,40G IDE硬盘。

附录机器翻译的自动评测方法1. BLEU 评测方法简介BLEU 是由IBM 首先提出的方法。

这是一种基于N-Gram 的自动评测方法,它通过对译文跟参考译文进行N-Gram 的比较综合而得出译文的好坏的评价分数。

这种基于N-Gram 共现的统计方法中,一元词的共现代表了翻译的忠实度,它表征了原文里面有多少单词被翻译了过来;而二元以上的共现词汇代表了目标语言的流利程度,阶数高的N 元词的匹配度越高,系统译文的可读性就越好。

其基本计算公式为)log exp(1∑=⋅=Nn n n p w BP Score其中, p n = 被测译文中与参考答案匹配的ngram 总数/ 被测译文中ngram 总数 BP = 长度惩罚因子Lref = 与被测句子长度最接近的答案长度;Lsys = 被评测句子的长度;N = 最大ngram 长度;W n = ngram 的权重;2. NIST 评测方法简介NIST 在BLEU 标准基础上提出的一个改进方案,称为NIST 评测标准。

NIST 方法采用各阶N-Gram 的算术平均而不是几何平均,使得总体评价结果更偏重于忠实度,而且也不至于因为某一阶N-Gram 的匹配率为零导致总体评价为零。

另外,NIST 考虑到每一个N-Gram 在多个参考译文中出现的次数不同能够表现出该词的重要性,因此根据其在多个参考译文中出现的次数而给每一个N-Gram 赋予一个权值。