多元线性回归 matlab中求解

第八讲MATLAB中多元线性回归

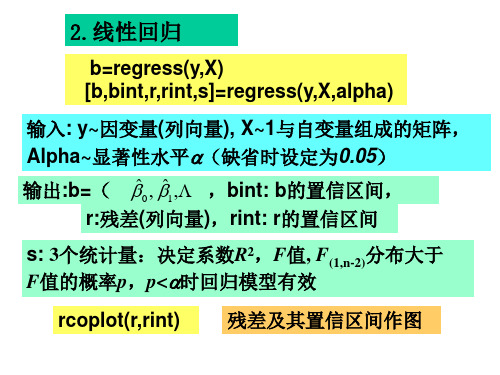

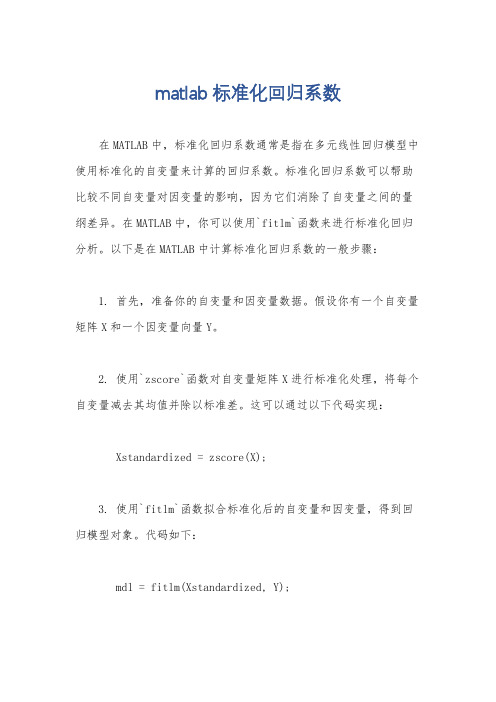

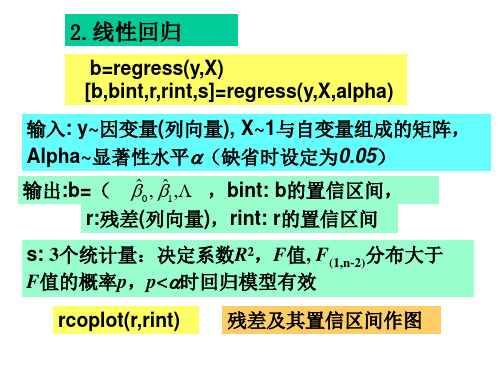

b=regress(y,X) [b,bint,r,rint,s]=regress(y,X,alpha) 输入: 因变量 列向量), 因变量(列向量 与自变量组成的矩阵, 输入 y~因变量 列向量 X~1与自变量组成的矩阵, 与自变量组成的矩阵 Alpha~显著性水平α(缺省时设定为 缺省时设定为0.05) 显著性水平 ) 输出:b=( β 0 , β1 , ( ), ),bint: b的置信区间, 输出 的置信区间, r:残差 列向量 ,rint: r的置信区间 残差(列向量 残差 列向量), 的 s: 3个统计量:决定系数 2,F值, F(1,n-2)分布大于 个统计量: 个统计量 决定系数R 值 F值的概率 ,p<α时回归模型有效 值的概率p, 回归模型有效 值的概率 rcoplot(r,rint) 残差及其置信区间作图 残差及其置信区间作图 及其

回归 模型

序 号 1 2 3 … 10 血 压 144 215 138 … 154

血压与年龄、体重指数、 例3: 血压与年龄、体重指数、吸烟习惯

年 龄 39 47 45 … 56 体重 指数 24.2 31.1 22.6 … 19.3 吸烟 习惯 0 1 0 … 0 序 号 21 22 23 … 30 血 压 136 142 120 … 175 年 龄 36 50 39 … 69 体重 指数 25.0 26.2 23.5 … 27.4 吸烟 习惯 0 1 0 … 1

β0 β1 β2 β3

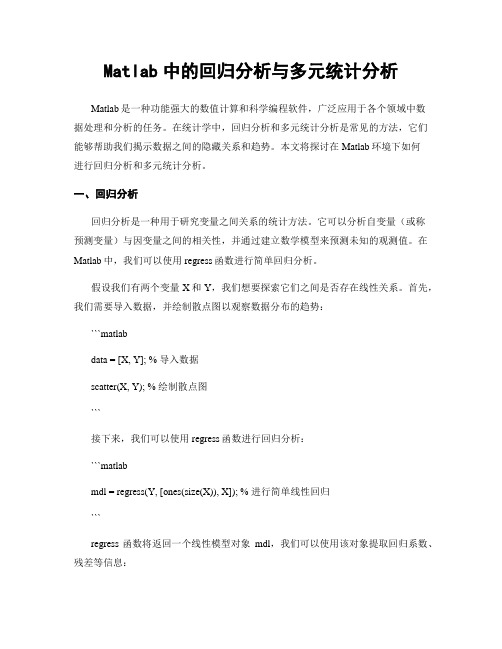

R2= 0.8462 F= 44.0087 p<0.0001 s2 =53.6604

这时置信区间不包含零点, 统计量增大 统计量增大, 这时置信区间不包含零点,F统计量增大,可决系 数从0.6855增大到 增大到0.8462 ,我们得到回归模型为: 我们得到回归模型为: 数从 增大到

Matlab实现多元的回归实例

Matlab 实现多元回归实例(一)一般多元回归一般在生产实践和科学研究中,人们得到了参数(),,n x x x =⋅⋅⋅1和因变量y 的数据,需要求出关系式()y f x =,这时就可以用到回归分析的方法。

如果只考虑f 是线性函数的情形,当自变量只有一个时,即,(),,n x x x =⋅⋅⋅1中n =1时,称为一元线性回归,当自变量有多个时,即,(),,n x x x =⋅⋅⋅1中n ≥2时,称为多元线性回归。

进行线性回归时,有4个基本假定: ① 因变量与自变量之间存在线性关系; ② 残差是独立的; ③ 残差满足方差奇性; ④ 残差满足正态分布。

在Matlab 软件包中有一个做一般多元回归分析的命令regeress ,调用格式如下:[b, bint, r, rint, stats] = regress(y,X,alpha) 或者[b, bint, r, rint, stats] = regress(y,X) 此时,默认alpha = 0.05. 这里,y 是一个1n ⨯的列向量,X 是一个()1n m ⨯+的矩阵,其中第一列是全1向量(这一点对于回归来说很重要,这一个全1列向量对应回归方程的常数项),一般情况下,需要人工造一个全1列向量。

回归方程具有如下形式:011m m y x x λλλε=++⋅⋅⋅++其中,ε是残差。

在返回项[b,bint,r,rint,stats]中, ①01m b λλλ=⋅⋅⋅是回归方程的系数;②int b 是一个2m ⨯矩阵,它的第i 行表示i λ的(1-alpha)置信区间; ③r 是1n ⨯的残差列向量;④int r 是2n ⨯矩阵,它的第i 行表示第i 个残差i r 的(1-alpha)置信区间; 注释:残差与残差区间杠杆图,最好在0点线附近比较均匀的分布,而不呈现一定的规律性,如果是这样,就说明回归分析做得比较理想。

⑤ 一般的,stast 返回4个值:2R 值、F_检验值、阈值f ,与显著性概率相关的p 值(如果这个p 值不存在,则,只输出前3项)。

多元回归分析报告matlab

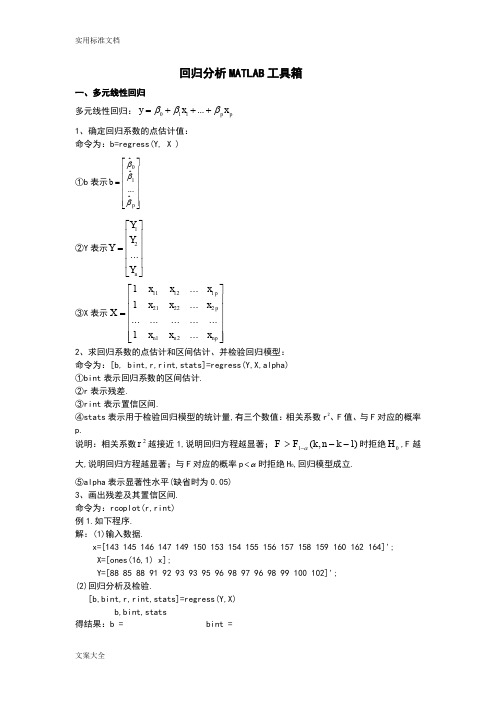

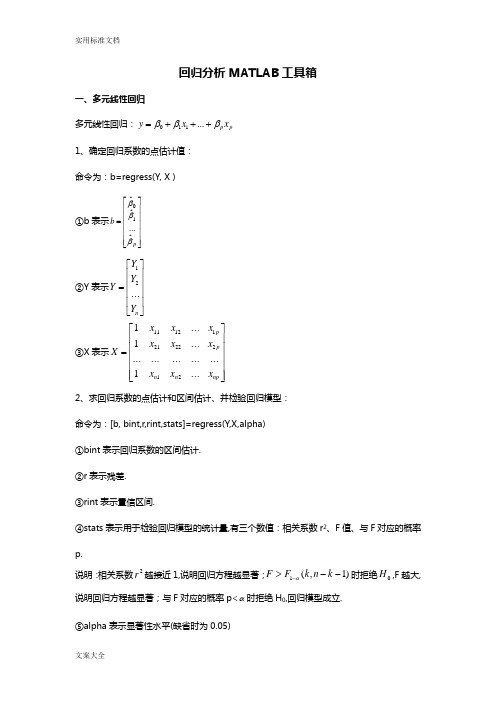

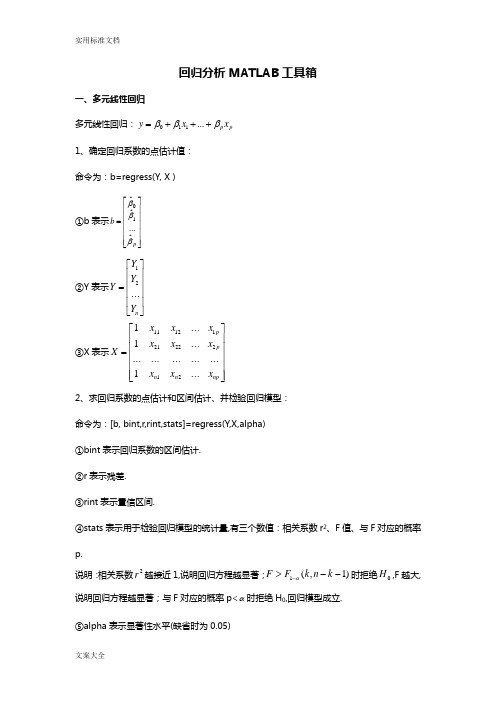

回归分析MATLAB 工具箱一、多元线性回归多元线性回归:p p x x y βββ+++=...110 1、确定回归系数的点估计值: 命令为:b=regress(Y, X ) ①b 表示⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=p b βββˆ...ˆˆ10②Y 表示⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n Y Y Y Y (2)1③X 表示⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=np n n p p x x x x x x x x x X ...1............ (1) (12)12222111211 2、求回归系数的点估计和区间估计、并检验回归模型:命令为:[b, bint,r,rint,stats]=regress(Y,X,alpha) ①bint 表示回归系数的区间估计. ②r 表示残差.③rint 表示置信区间.④stats 表示用于检验回归模型的统计量,有三个数值:相关系数r 2、F 值、与F 对应的概率p.说明:相关系数2r 越接近1,说明回归方程越显著;)1,(1-->-k n k F F α时拒绝0H ,F 越大,说明回归方程越显著;与F 对应的概率p α<时拒绝H 0,回归模型成立.⑤alpha 表示显著性水平(缺省时为0.05) 3、画出残差及其置信区间. 命令为:rcoplot(r,rint) 例1.如下程序. 解:(1)输入数据.x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]'; X=[ones(16,1) x];Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]'; (2)回归分析及检验.[b,bint,r,rint,stats]=regress(Y,X) b,bint,stats得结果:b = bint =-16.0730 -33.7071 1.5612 0.7194 0.6047 0.8340 stats =0.9282 180.9531 0.0000即7194.0ˆ,073.16ˆ10=-=ββ;0ˆβ的置信区间为[-33.7017,1.5612], 1ˆβ的置信区间为[0.6047,0.834]; r 2=0.9282, F=180.9531, p=0.0000,我们知道p<0.05就符合条件, 可知回归模型 y=-16.073+0.7194x 成立. (3)残差分析,作残差图. rcoplot(r,rint)从残差图可以看出,除第二个数据外,其余数据的残差离零点均较近,且残差的置信区间均包含零点,这说明回归模型 y=-16.073+0.7194x 能较好的符合原始数据,而第二个数据可视为异常点.(4)预测及作图.z=b(1)+b(2)*xplot(x,Y,'k+',x,z,'r')二、多项式回归(一)一元多项式回归.1、一元多项式回归:1121...+-++++=m m m m a x a x a x a y(1)确定多项式系数的命令:[p,S]=polyfit(x,y,m)说明:x=(x 1,x 2,…,x n ),y=(y 1,y 2,…,y n );p=(a 1,a 2,…,a m+1)是多项式y=a 1x m +a 2x m-1+…+a m x+a m+1的系数;S 是一个矩阵,用来估计预测误差. (2)一元多项式回归命令:polytool(x,y,m) 2、预测和预测误差估计.(1)Y=polyval(p,x)求polyfit 所得的回归多项式在x 处的预测值Y ;(2)[Y,DELTA]=polyconf(p,x,S,alpha)求polyfit 所得的回归多项式在x 处的预测值Y 及预测值的显著性为1-alpha 的置信区间Y ±DELTA ;alpha 缺省时为0.5.例1. 观测物体降落的距离s 与时间t 的关系,得到数据如下表,求s. (关于t 的回归方程2解法一:直接作二次多项式回归. t=1/30:1/30:14/30;s=[11.86 15.67 20.60 26.69 33.71 41.93 51.13 61.49 72.90 85.44 99.08 113.77 129.54 146.48];[p,S]=polyfit(t,s,2) 得回归模型为:1329.98896.652946.489ˆ2++=t t s解法二:化为多元线性回归. t=1/30:1/30:14/30;s=[11.86 15.67 20.60 26.69 33.71 41.93 51.13 61.49 72.90 85.44 99.08 113.77 129.54 146.48];T=[ones(14,1) t' (t.^2)'];[b,bint,r,rint,stats]=regress(s',T); b,stats得回归模型为:22946.4898896.651329.9ˆt t s++= 预测及作图:Y=polyconf(p,t,S)plot(t,s,'k+',t,Y,'r')(二)多元二项式回归多元二项式回归命令:rstool(x,y,’model ’, alpha)说明:x 表示n ⨯m 矩阵;Y 表示n 维列向量;alpha :显著性水平(缺省时为0.05);model 表示由下列4个模型中选择1个(用字符串输入,缺省时为线性模型):linear(线性):m m x x y βββ+++= 110purequadratic(纯二次):∑=++++=nj j jjm m x x x y 12110ββββinteraction(交叉):∑≤≠≤++++=mk j k j jkm m x x x x y 1110ββββquadratic(完全二次):∑≤≤++++=mk j k j jkm m x x x x y ,1110ββββ例1. 设某商品的需求量与消费者的平均收入、商品价格的统计数据如下,建立回归模型,预测平均收入为1000、价格为6时的商品需求量. 需求量 10075 80 70 50 65 90 100 110 60收入 1000 600 1200500 300 400 1300 1100 1300 300 价格 5 7 6 6 8 7 5 4 3 9解法一:选择纯二次模型,即2222211122110x x x x y βββββ++++=.直接用多元二项式回归:x1=[1000 600 1200 500 300 400 1300 1100 1300 300]; x2=[5 7 6 6 8 7 5 4 3 9];y=[100 75 80 70 50 65 90 100 110 60]'; x=[x1' x2'];rstool(x,y,'purequadratic')在左边图形下方的方框中输入1000,右边图形下方的方框中输入6,则画面左边的“Predicted Y ”下方的数据变为88.47981,即预测出平均收入为1000、价格为6时的商品需求量为88.4791.在画面左下方的下拉式菜单中选”all ”, 则beta 、rmse 和residuals 都传送到Matlab 工作区中.在Matlab 工作区中输入命令:beta, rmse 得结果:beta =110.5313 0.1464 -26.5709 -0.0001 1.8475 rmse =4.5362故回归模型为:2221218475.10001.05709.261464.05313.110x x x x y +--+=剩余标准差为4.5362, 说明此回归模型的显著性较好.解法二:将2222211122110x x x x y βββββ++++=化为多元线性回归:X=[ones(10,1) x1' x2' (x1.^2)' (x2.^2)'];[b,bint,r,rint,stats]=regress(y,X); b,stats结果为: b =110.5313 0.1464 -26.5709 -0.00011.8475 stats =0.9702 40.6656 0.0005三、非线性回归 1、非线性回归:(1)确定回归系数的命令:[beta,r,J]=nlinfit(x,y,’model ’, beta0)说明:beta 表示估计出的回归系数;r 表示残差;J 表示Jacobian 矩阵;x,y 表示输入数据x 、y 分别为矩阵和n 维列向量,对一元非线性回归,x 为n 维列向量;model 表示是事先用m-文件定义的非线性函数;beta0表示回归系数的初值.(2)非线性回归命令:nlintool(x,y,’model ’, beta0,alpha) 2、预测和预测误差估计:[Y,DELTA]=nlpredci(’model ’, x,beta,r,J)表示nlinfit 或nlintool 所得的回归函数在x 处的预测值Y 及预测值的显著性为1-alpha 的置信区间Y ±DELTA. 例1. 如下程序.解:(1)对将要拟合的非线性模型y=a x b e /,建立m-文件volum.m 如下:function yhat=volum(beta,x) yhat=beta(1)*exp(beta(2)./x); (2)输入数据: x=2:16;y=[6.42 8.20 9.58 9.5 9.7 10 9.93 9.99 10.49 10.59 10.60 10.80 10.60 10.90 10.76];beta0=[8 2]'; (3)求回归系数:[beta,r ,J]=nlinfit(x',y','volum',beta0); beta (4)运行结果:beta =11.6036 -1.0641 即得回归模型为:xey 10641.16036.11-=(5)预测及作图:[YY,delta]=nlpredci('volum',x',beta,r ,J); plot(x,y,'k+',x,YY,'r')四、逐步回归1、逐步回归的命令:stepwise(x,y,inmodel,alpha)说明:x 表示自变量数据,m n ⨯阶矩阵;y 表示因变量数据,1⨯n 阶矩阵;inmodel 表示矩阵的列数的指标,给出初始模型中包括的子集(缺省时设定为全部自变量);alpha 表示显著性水平(缺省时为0.5).2、运行stepwise 命令时产生三个图形窗口:Stepwise Plot,Stepwise Table,StepwiseHistory.在Stepwise Plot窗口,显示出各项的回归系数及其置信区间.(1)Stepwise Table窗口中列出了一个统计表,包括回归系数及其置信区间,以及模型的统计量剩余标准差(RMSE)、相关系数(R-square)、F值、与F对应的概率P.例1. 水泥凝固时放出的热量y与水泥中4种化学成分x1、x2、x3、 x4有关,今测得一组数据如下,试用逐步回归法确定一个线性模型.解:(1)数据输入:x1=[7 1 11 11 7 11 3 1 2 21 1 11 10]';x2=[26 29 56 31 52 55 71 31 54 47 40 66 68]';x3=[6 15 8 8 6 9 17 22 18 4 23 9 8]';x4=[60 52 20 47 33 22 6 44 22 26 34 12 12]';y=[78.5 74.3 104.3 87.6 95.9 109.2 102.7 72.5 93.1 115.9 83.8 113.3 109.4]';x=[x1 x2 x3 x4];(2)逐步回归.①先在初始模型中取全部自变量:stepwise(x,y)得图Stepwise Plot 和表Stepwise Table.图Stepwise Plot中四条直线都是虚线,说明模型的显著性不好.从表Stepwise Table中看出变量x3和x4的显著性最差.②在图Stepwise Plot中点击直线3和直线4,移去变量x3和x4.移去变量x3和x4后模型具有显著性虽然剩余标准差(RMSE)没有太大的变化,但是统计量F的值明显增大,因此新的回归模型更好.(3)对变量y和x1、x2作线性回归.X=[ones(13,1) x1 x2];b=regress(y,X)得结果:b =52.57731.46830.6623故最终模型为:y=52.5773+1.4683x1+0.6623x2或这种方法4元二次线性回归clc;clear;y=[1.84099 9.67 23.00 38.12 1.848794 6.22 12.22 19.72 1.848794 5.19 10.09 15.31 ];X1=[60.36558 59.5376 58.89861 58.74706 60.59389 60.36558 59.2 58.2 60.36558 59.97068 59.41918 58. X2=[26.1636 26.35804 26.82438 26.91521 25.90346 25.9636 27.19256 27.42153 26.1636 26.07212 26.5872 X3=[0.991227 0.994944 0.981322 0.98374 1.011865 0.991227 1.074772 1.107678 0.991227 0.917904 1.06043 X4=[59.37436 58.54265 57.91729 57.69332 59.58203 59.37436 57.76722 57.42355 59.37436 59.05278 58.3587format short gY=y'X11=[ones(1,length(y));X1;X2;X3;X4]'B1=regress(Y,X11)% 多元一次线性回归[m,n]=size(X11)X22=[];for i=2:nfor j=2:nif i<=jX22=([X22,X11(:,i).*X11(:,j)]);elsecontinueendendendX=[X11,X22];B2=regress(Y,X)% 多元二次线性回归[Y X*B2 Y-X*B2]plot(Y,X11*B1,'o',Y,X*B2,'*')hold on,line([min(y),max(y)],[min(y),max(y)]) axis([min(y) max(y) min(y) max(y)])legend('一次线性回归','二次线性回归')xlabel('实际值');ylabel('计算值')运行结果:Y =1.8419.672338.121.84886.2212.2219.721.84885.1910.0915.31X11 =1 60.366 26.164 0.99123 59.3741 59.538 26.358 0.99494 58.5431 58.899 26.824 0.98132 57.9171 58.747 26.915 0.98374 57.6931 60.594 25.903 1.0119 59.5821 60.366 25.964 0.99123 59.3741 59.2 27.193 1.0748 57.7671 58.2 27.422 1.1077 57.4241 60.366 26.164 0.99123 59.3741 59.971 26.072 0.9179 59.0531 59.419 26.587 1.0604 58.3591 58.891 27.061 1.1239 57.767B1 =1488.9-4.3582-9.6345-61.514-15.359m =12n =5B2 =3120.4-7129.2-622.23-362.71-105.061388.1120.25199.25379.58170.48-796.41ans =1.841 1.8449 -0.0039029.67 9.67 1.0058e-00923 23 1.397e-00938.12 38.12 3.539e-0101.8488 1.8488 1.6394e-0096.22 6.227.2643e-01012.22 12.22 2.6077e-01019.72 19.72 -2.0489e-0101.8488 1.8449 0.0039025.19 5.19 1.4529e-00910.09 10.09 1.0803e-00915.31 15.31 4.0978e-010由图形可以看出,多元二次线性回归效果非常好,即,相当于Y=3120.4*X1 -7129.2 *X2 + 0*X3+ 0*X4 -622.23*X1*X1 -362.71*X1*X2 -105.06*X1*X3 + 1388.1*X1*X4 +120.25*X2*X2+ 199.25 *X2*X3+ 379.58*X2*X4 + 170.48*X3*X3+ 0*X3*X4 -796.4。

多元回归程序MATLAB程序

盛年不重来,一日难再晨。

及时宜自勉,岁月不待人。

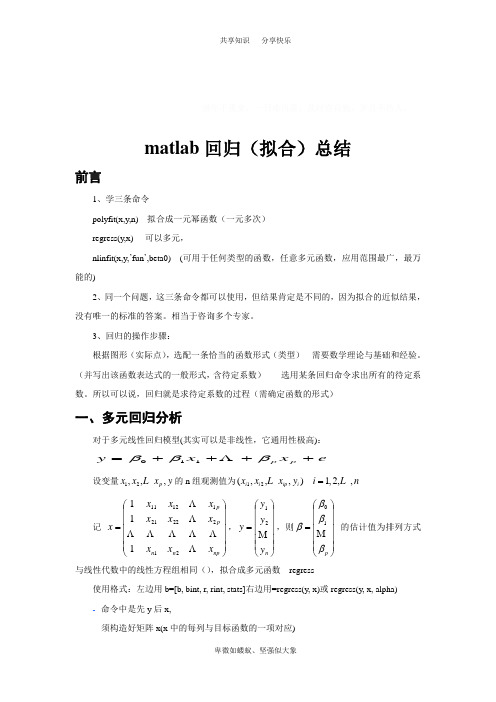

matlab 回归(拟合)总结前言1、学三条命令polyfit(x,y,n)---拟合成一元幂函数(一元多次) regress(y,x)----可以多元,nlinfit(x,y,’fun ’,beta0) (可用于任何类型的函数,任意多元函数,应用范围最广,最万能的)2、同一个问题,这三条命令都可以使用,但结果肯定是不同的,因为拟合的近似结果,没有唯一的标准的答案。

相当于咨询多个专家。

3、回归的操作步骤:根据图形(实际点),选配一条恰当的函数形式(类型)---需要数学理论与基础和经验。

(并写出该函数表达式的一般形式,含待定系数)------选用某条回归命令求出所有的待定系数。

所以可以说,回归就是求待定系数的过程(需确定函数的形式)一、多元回归分析对于多元线性回归模型(其实可以是非线性,它通用性极高):e x x y p p++++=βββΛ110设变量12,,,p x x x y L 的n 组观测值为12(,,,)1,2,,i i ip i x x x y i n =L L记 ⎪⎪⎪⎪⎪⎭⎫⎝⎛=np n n p p x x x x x x x x x x ΛΛΛΛΛΛΛΛ212222111211111,⎪⎪⎪⎪⎪⎭⎫⎝⎛=n y y y y M 21,则⎪⎪⎪⎪⎪⎭⎫ ⎝⎛=p ββββM 10 的估计值为排列方式与线性代数中的线性方程组相同(),拟合成多元函数---regress使用格式:左边用b=[b, bint, r, rint, stats]右边用=regress(y, x)或regress(y, x, alpha) ---命令中是先y 后x,---须构造好矩阵x(x 中的每列与目标函数的一项对应)---并且x 要在最前面额外添加全1列/对应于常数项 ---y 必须是列向量---结果是从常数项开始---与polyfit 的不同。

) 其中: b 为回归系数,β的估计值(第一个为常数项),bint 为回归系数的区间估计, r: 残差 ,rint: 残差的置信区间,stats: 用于检验回归模型的统计量,有四个数值:相关系数r2、F 值、与F 对应的概率p 和残差的方差(前两个越大越好,后两个越小越好),alpha: 显著性水平(缺省时为0.05,即置信水平为95%),(alpha 不影响b,只影响bint(区间估计)。

(完整版)Matlab线性回归(拟合)

Matlab 线性回归(拟合)对于多元线性回归模型:e x x y p p ++++=βββΛ110设变量12,,,p x x x y L 的n 组观测值为12(,,,)1,2,,i i ip i x x x y i n =L L .记 ⎪⎪⎪⎪⎪⎭⎫ ⎝⎛=np n n p p x x x x x x x x x x ΛΛΛΛΛΛΛΛ212222*********,⎪⎪⎪⎪⎪⎭⎫ ⎝⎛=n y y y y M 21,则⎪⎪⎪⎪⎪⎭⎫ ⎝⎛=p ββββM 10 的估计值为 y x x x b ')'(ˆ1-==β(11.2) 在Matlab 中,用regress 函数进行多元线性回归分析,应用方法如下:语法:b = regress(y, x)[b, bint, r, rint, stats] = regress(y, x)[b, bint, r, rint, stats] = regress(y, x, alpha)b = regress(y, x),得到的1+p 维列向量b 即为(11.2)式给出的回归系数β的估计值.[b, bint, r, rint, stats]=regress(y, x) 给出回归系数β的估计值b ,β的95%置信区间((1)2p +⨯向量)bint ,残差r 以及每个残差的95%置信区间(2⨯n 向量)rint ;向量stats 给出回归的R 2统计量和F 以及临界概率p 的值.如果i β的置信区间(bint 的第1i +行)不包含0,则在显著水平为α时拒绝0i β=的假设,认为变量i x 是显著的.[b, bint, r, rint, stats]=regress(y, x, alpha) 给出了bint 和rint 的100(1-alpha)%的置信区间.三次样条插值函数的MATLAB 程序matlab 的splinex = 0:10; y = sin(x); %插值点xx = 0:.25:10; %绘图点yy = spline(x,y,xx);plot(x,y,'o',xx,yy)非线性拟合非线性拟合可以用以下命令(同样适用于线形回归分析):1.beta = nlinfit(X,y,fun,beta0)X给定的自变量数据,Y给定的因变量数据,fun要拟合的函数模型(句柄函数或者内联函数形式),beta0函数模型中系数估计初值,beta返回拟合后的系数2.x = lsqcurvefit(fun,x0,xdata,ydata)fun要拟合的目标函数,x0目标函数中的系数估计初值,xdata自变量数据,ydata 函数值数据X拟合返回的系数(拟合结果)nlinfit格式:[beta,r,J]=nlinfit(x,y,’model’, beta0)Beta 估计出的回归系数r 残差J Jacobian矩阵x,y 输入数据x、y分别为n*m矩阵和n维列向量,对一元非线性回归,x为n维列向量。

多元回归分析报告matlab

回归分析MATLAB 工具箱一、多元线性回归多元线性回归:p p x x y βββ+++=...110 1、确定回归系数的点估计值: 命令为:b=regress(Y, X ) ①b 表示⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=p b βββˆ...ˆˆ10②Y 表示⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n Y Y Y Y (2)1③X 表示⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=np n n p p x x x x x x x x x X (1)............ (1) (12)12222111211 2、求回归系数的点估计和区间估计、并检验回归模型: 命令为:[b, bint,r,rint,stats]=regress(Y,X,alpha) ①bint 表示回归系数的区间估计. ②r 表示残差. ③rint 表示置信区间.④stats 表示用于检验回归模型的统计量,有三个数值:相关系数r 2、F 值、与F 对应的概率p.说明:相关系数2r 越接近1,说明回归方程越显著;)1,(1-->-k n k F F α时拒绝0H ,F 越大,说明回归方程越显著;与F 对应的概率p α<时拒绝H 0,回归模型成立. ⑤alpha 表示显著性水平(缺省时为0.05)3、画出残差及其置信区间. 命令为:rcoplot(r,rint) 例1.如下程序. 解:(1)输入数据.x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]'; X=[ones(16,1) x];Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]'; (2)回归分析及检验.[b,bint,r,rint,stats]=regress(Y,X) b,bint,stats得结果:b = bint =-16.0730 -33.7071 1.5612 0.7194 0.6047 0.8340 stats =0.9282 .9531 0.0000即7194.0ˆ,073.16ˆ10=-=ββ;0ˆβ的置信区间为[-33.7017,1.5612], 1ˆβ的置信区间为[0.6047,0.834]; r 2=0.9282, F=180.9531, p=0.0000,我们知道p<0.05就符合条件, 可知回归模型 y=-16.+0.7194x 成立. (3)残差分析,作残差图. rcoplot(r,rint)从残差图可以看出,除第二个数据外,其余数据的残差离零点均较近,且残差的置信区间均包含零点,这说明回归模型 y=-16.+0.7194x 能较好的符合原始数据,而第二个数据可视为异常点. (4)预测及作图.z=b(1)+b(2)*x plot(x,Y,'k+',x,z,'r')二、多项式回归 (一)一元多项式回归.1、一元多项式回归:1121...+-++++=m m m m a x a x a x a y (1)确定多项式系数的命令:[p,S]=polyfit(x,y,m)说明:x=(x 1,x 2,…,x n ),y=(y 1,y 2,…,y n );p=(a 1,a 2,…,a m+1)是多项式y=a 1x m +a 2x m-1+…+a m x+a m+1的系数;S 是一个矩阵,用来估计预测误差. (2)一元多项式回归命令:polytool(x,y,m) 2、预测和预测误差估计.(1)Y=polyval(p,x)求polyfit 所得的回归多项式在x 处的预测值Y ;(2)[Y,DELTA]=polyconf(p,x,S,alpha)求polyfit 所得的回归多项式在x 处的预测值Y 及预测值的显著性为1-alpha 的置信区间Y ±DELTA ;alpha 缺省时为0.5.例1. 观测物体降落的距离s 与时间t 的关系,得到数据如下表,求s. (关于t 的回归方程2ˆct bt a s++=)解法一:直接作二次多项式回归. t=1/30:1/30:14/30;s=[11.86 15.67 20.60 26.69 33.71 41.93 51.13 61.49 72.90 85.44 99.08 113.77 129.54 146.48]; [p,S]=polyfit(t,s,2) 得回归模型为:1329.98896.652946.489ˆ2++=t t s解法二:化为多元线性回归. t=1/30:1/30:14/30;s=[11.86 15.67 20.60 26.69 33.71 41.93 51.13 61.49 72.90 85.44 99.08 113.77 129.54 146.48];T=[ones(14,1) t' (t.^2)']; [b,bint,r,rint,stats]=regress(s',T);b,stats 得回归模型为:22946.4898896.651329.9ˆt t s++= 预测及作图: Y=polyconf(p,t,S) plot(t,s,'k+',t,Y,'r')(二)多元二项式回归多元二项式回归命令:rstool(x,y,’model ’, alpha)说明:x 表示n ⨯m 矩阵;Y 表示n 维列向量;alpha :显著性水平(缺省时为0.05);model 表示由下列4个模型中选择1个(用字符串输入,缺省时为线性模型):linear(线性):m m x x y βββ+++=Λ110purequadratic(纯二次):∑=++++=nj j jjm m x x x y 12110ββββΛinteraction(交叉):∑≤≠≤++++=mk j k j jkm m x x x x y 1110ββββΛquadratic(完全二次):∑≤≤++++=mk j k j jkm m x x x x y ,1110ββββΛ例1. 设某商品的需求量与消费者的平均收入、商品价格的统计数据如下,建立回归模型,预测平均收入为1000、价格为6时的商品需求量. 需求量 100 75 80 70 50 65 90 100 110 60 收入10006001200500300400130011001300300价格5766875439解法一:选择纯二次模型,即2222211122110x x x x y βββββ++++=.直接用多元二项式回归:x1=[1000 600 1200 500 300 400 1300 1100 1300 300]; x2=[5 7 6 6 8 7 5 4 3 9];y=[100 75 80 70 50 65 90 100 110 60]'; x=[x1' x2'];rstool(x,y,'purequadratic')在左边图形下方的方框中输入1000,右边图形下方的方框中输入6,则画面左边的“Predicted Y ”下方的数据变为88.47981,即预测出平均收入为1000、价格为6时的商品需求量为88.4791.在画面左下方的下拉式菜单中选”all ”, 则beta 、rmse 和residuals 都传送到Matlab 工作区中.在Matlab 工作区中输入命令:beta, rmse 得结果:beta = 110.5313 0.1464 -26.5709 -0.0001 1.8475 rmse = 4.5362故回归模型为:2221218475.10001.05709.261464.05313.110x x x x y +--+=剩余标准差为4.5362, 说明此回归模型的显著性较好.解法二:将2222211122110x x x x y βββββ++++=化为多元线性回归:X=[ones(10,1) x1' x2' (x1.^2)' (x2.^2)']; [b,bint,r,rint,stats]=regress(y,X); b,stats 结果为: b =110.5313 0.1464 -26.5709 -0.0001 1.8475 stats =0.9702 40.6656 0.0005三、非线性回归 1、非线性回归:(1)确定回归系数的命令:[beta,r,J]=nlinfit(x,y,’model ’, beta0)说明:beta 表示估计出的回归系数;r 表示残差;J 表示Jacobian 矩阵;x,y 表示输入数据x 、y 分别为矩阵和n 维列向量,对一元非线性回归,x 为n 维列向量;model 表示是事先用m-文件定义的非线性函数;beta0表示回归系数的初值. (2)非线性回归命令:nlintool(x,y,’model ’, beta0,alpha) 2、预测和预测误差估计:[Y,DELTA]=nlpredci(’model ’, x,beta,r,J)表示nlinfit 或nlintool 所得的回归函数在x 处的预测值Y 及预测值的显著性为1-alpha 的置信区间Y ±DELTA. 例1. 如下程序.解:(1)对将要拟合的非线性模型y=a x b e /,建立m-文件volum.m 如下: function yhat=volum(beta,x) yhat=beta(1)*exp(beta(2)./x); (2)输入数据: x=2:16;y=[6.42 8.20 9.58 9.5 9.7 10 9.93 9.99 10.49 10.59 10.60 10.80 10.60 10.90 10.76];beta0=[8 2]'; (3)求回归系数:[beta,r ,J]=nlinfit(x',y','volum',beta0); beta (4)运行结果:beta =11.6036 -1.0641 即得回归模型为:xey 10641.16036.11-=(5)预测及作图:[YY,delta]=nlpredci('volum',x',beta,r ,J);plot(x,y,'k+',x,YY,'r')四、逐步回归1、逐步回归的命令:stepwise(x,y,inmodel,alpha)n⨯阶矩阵;y表示因变量数据,1⨯n阶矩阵;inmodel表示矩说明:x表示自变量数据,m阵的列数的指标,给出初始模型中包括的子集(缺省时设定为全部自变量);alpha表示显著性水平(缺省时为0.5).2、运行stepwise命令时产生三个图形窗口:Stepwise Plot,Stepwise Table,Stepwise History.在Stepwise Plot窗口,显示出各项的回归系数及其置信区间.(1)Stepwise Table窗口中列出了一个统计表,包括回归系数及其置信区间,以及模型的统计量剩余标准差(RMSE)、相关系数(R-square)、F值、与F对应的概率P.例1. 水泥凝固时放出的热量y与水泥中4种化学成分x1、x2、x3、x4有关,今测得一组数据如下,试用逐步回归法确定一个线性模型.解:(1)数据输入:x1=[7 1 11 11 7 11 3 1 2 21 1 11 10]';x2=[26 29 56 31 52 55 71 31 54 47 40 66 68]';x3=[6 15 8 8 6 9 17 22 18 4 23 9 8]';x4=[60 52 20 47 33 22 6 44 22 26 34 12 12]';y=[78.5 74.3 104.3 87.6 95.9 109.2 102.7 72.5 93.1 115.9 83.8 113.3 109.4]'; x=[x1 x2 x3 x4];(2)逐步回归.①先在初始模型中取全部自变量:stepwise(x,y)得图Stepwise Plot 和表Stepwise Table.图Stepwise Plot中四条直线都是虚线,说明模型的显著性不好.从表Stepwise Table中看出变量x3和x4的显著性最差.②在图Stepwise Plot中点击直线3和直线4,移去变量x3和x4.移去变量x3和x4后模型具有显著性虽然剩余标准差(RMSE)没有太大的变化,但是统计量F的值明显增大,因此新的回归模型更好.(3)对变量y和x1、x2作线性回归.X=[ones(13,1) x1 x2];b=regress(y,X)得结果:b =52.57731.46830.6623故最终模型为:y=52.5773+1.4683x1+0.6623x2或这种方法4元二次线性回归clc;clear;y=[1.84099 9.67 23.00 38.12 1.848794 6.22 12.22 19.72 1.848794 5.19 10.09 15.31 ];X1=[60.36558 59.5376 58.89861 58.74706 60.59389 60.36558 59.2 58.2 60.36558 59.97068 59.41918 5 X2=[26.1636 26.35804 26.82438 26.91521 25.90346 25.9636 27.19256 27.42153 26.1636 26.07212 26.27.06063];X3=[0.991227 0.994944 0.981322 0.98374 1.011865 0.991227 1.074772 1.107678 0.991227 0.917904 1 1.1239];X4=[59.37436 58.54265 57.91729 57.69332 59.58203 59.37436 57.76722 57.42355 59.37436 59.05278 57.76687];format short gY=y'X11=[ones(1,length(y));X1;X2;X3;X4]'B1=regress(Y,X11)% 多元一次线性回归[m,n]=size(X11)X22=[];for i=2:nfor j=2:nif i<=jX22=([X22,X11(:,i).*X11(:,j)]);elsecontinueendendendX=[X11,X22];B2=regress(Y,X)% 多元二次线性回归[Y X*B2 Y-X*B2]plot(Y,X11*B1,'o',Y,X*B2,'*')hold on,line([min(y),max(y)],[min(y),max(y)]) axis([min(y) max(y) min(y) max(y)]) legend('一次线性回归','二次线性回归') xlabel('实际值');ylabel('计算值')运行结果:Y =1.8419.672338.121.84886.2212.2219.721.84885.1910.0915.31X11 =1 60.366 26.164 0.99123 59.3741 59.538 26.358 0.99494 58.5431 58.899 26.824 0.98132 57.9171 58.747 26.915 0.98374 57.6931 60.594 25.903 1.0119 59.5821 60.366 25.964 0.99123 59.3741 59.2 27.193 1.0748 57.7671 58.2 27.422 1.1077 57.4241 60.366 26.164 0.99123 59.3741 59.971 26.072 0.9179 59.1 59.419 26.587 1.0604 58.3591 58.891 27.061 1.1239 57.767 B1 =1488.9-4.3582-9.6345-61.514-15.359m =12n =5B2 =3120.4-7129.2-622.23-362.71-105.061388.1120.25.25379.58170.48-796.41ans =1.841 1.8449 -0.0039029.67 9.67 1.0058e-00923 23 1.397e-00938.12 38.12 3.539e-1.8488 1.8488 1.6394e-0096.22 6.227.2643e-12.22 12.22 2.6077e-19.72 19.72 -2.0489e-1.8488 1.8449 0.0039025.19 5.19 1.4529e-00910.09 10.09 1.0803e-00915.31 15.31 4.0978e-由图形可以看出,多元二次线性回归效果非常好,即,相当于Y=3120.4*X1 -7129.2 *X2 + 0*X3 + 0*X4 -622.23*X1*X1 -362.71*X1*X2 -105.06*X1*X3 + 1388 120.25*X2*X2+ .25 *X2*X3+ 379.58*X2*X4 + 170.48*X3*X3+ 0*X3*X4 -796.41*X4*X4。

多元回归分析报告matlab

回归分析MATLAB 工具箱一、多元线性回归多元线性回归:p p x x y βββ+++=...110 1、确定回归系数的点估计值: 命令为:b=regress(Y, X ) ①b 表示⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=p b βββˆ...ˆˆ10②Y 表示⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n Y Y Y Y (2)1③X 表示⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=np n n p p x x x x x x x x x X (1)............ (1) (12)12222111211 2、求回归系数的点估计和区间估计、并检验回归模型: 命令为:[b, bint,r,rint,stats]=regress(Y,X,alpha) ①bint 表示回归系数的区间估计. ②r 表示残差. ③rint 表示置信区间.④stats 表示用于检验回归模型的统计量,有三个数值:相关系数r 2、F 值、与F 对应的概率p.说明:相关系数2r 越接近1,说明回归方程越显著;)1,(1-->-k n k F F α时拒绝0H ,F 越大,说明回归方程越显著;与F 对应的概率p α<时拒绝H 0,回归模型成立. ⑤alpha 表示显著性水平(缺省时为0.05)3、画出残差及其置信区间. 命令为:rcoplot(r,rint) 例1.如下程序. 解:(1)输入数据.x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]'; X=[ones(16,1) x];Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]'; (2)回归分析及检验.[b,bint,r,rint,stats]=regress(Y,X) b,bint,stats得结果:b = bint =-16.0730 -33.7071 1.5612 0.7194 0.6047 0.8340 stats =0.9282 .9531 0.0000即7194.0ˆ,073.16ˆ10=-=ββ;0ˆβ的置信区间为[-33.7017,1.5612], 1ˆβ的置信区间为[0.6047,0.834]; r 2=0.9282, F=180.9531, p=0.0000,我们知道p<0.05就符合条件, 可知回归模型 y=-16.+0.7194x 成立. (3)残差分析,作残差图. rcoplot(r,rint)从残差图可以看出,除第二个数据外,其余数据的残差离零点均较近,且残差的置信区间均包含零点,这说明回归模型 y=-16.+0.7194x 能较好的符合原始数据,而第二个数据可视为异常点. (4)预测及作图.z=b(1)+b(2)*x plot(x,Y,'k+',x,z,'r')二、多项式回归 (一)一元多项式回归.1、一元多项式回归:1121...+-++++=m m m m a x a x a x a y (1)确定多项式系数的命令:[p,S]=polyfit(x,y,m)说明:x=(x 1,x 2,…,x n ),y=(y 1,y 2,…,y n );p=(a 1,a 2,…,a m+1)是多项式y=a 1x m +a 2x m-1+…+a m x+a m+1的系数;S 是一个矩阵,用来估计预测误差. (2)一元多项式回归命令:polytool(x,y,m) 2、预测和预测误差估计.(1)Y=polyval(p,x)求polyfit 所得的回归多项式在x 处的预测值Y ;(2)[Y,DELTA]=polyconf(p,x,S,alpha)求polyfit 所得的回归多项式在x 处的预测值Y 及预测值的显著性为1-alpha 的置信区间Y ±DELTA ;alpha 缺省时为0.5.例1. 观测物体降落的距离s 与时间t 的关系,得到数据如下表,求s. (关于t 的回归方程2ˆct bt a s++=)解法一:直接作二次多项式回归. t=1/30:1/30:14/30;s=[11.86 15.67 20.60 26.69 33.71 41.93 51.13 61.49 72.90 85.44 99.08 113.77 129.54 146.48]; [p,S]=polyfit(t,s,2) 得回归模型为:1329.98896.652946.489ˆ2++=t t s解法二:化为多元线性回归. t=1/30:1/30:14/30;s=[11.86 15.67 20.60 26.69 33.71 41.93 51.13 61.49 72.90 85.44 99.08 113.77 129.54 146.48];T=[ones(14,1) t' (t.^2)']; [b,bint,r,rint,stats]=regress(s',T);b,stats 得回归模型为:22946.4898896.651329.9ˆt t s++= 预测及作图: Y=polyconf(p,t,S) plot(t,s,'k+',t,Y,'r')(二)多元二项式回归多元二项式回归命令:rstool(x,y,’model ’, alpha)说明:x 表示n ⨯m 矩阵;Y 表示n 维列向量;alpha :显著性水平(缺省时为0.05);model 表示由下列4个模型中选择1个(用字符串输入,缺省时为线性模型):linear(线性):m m x x y βββ+++=Λ110purequadratic(纯二次):∑=++++=nj j jjm m x x x y 12110ββββΛinteraction(交叉):∑≤≠≤++++=mk j k j jkm m x x x x y 1110ββββΛquadratic(完全二次):∑≤≤++++=mk j k j jkm m x x x x y ,1110ββββΛ例1. 设某商品的需求量与消费者的平均收入、商品价格的统计数据如下,建立回归模型,预测平均收入为1000、价格为6时的商品需求量. 需求量 100 75 80 70 50 65 90 100 110 60 收入10006001200500300400130011001300300价格5766875439解法一:选择纯二次模型,即2222211122110x x x x y βββββ++++=.直接用多元二项式回归:x1=[1000 600 1200 500 300 400 1300 1100 1300 300]; x2=[5 7 6 6 8 7 5 4 3 9];y=[100 75 80 70 50 65 90 100 110 60]'; x=[x1' x2'];rstool(x,y,'purequadratic')在左边图形下方的方框中输入1000,右边图形下方的方框中输入6,则画面左边的“Predicted Y ”下方的数据变为88.47981,即预测出平均收入为1000、价格为6时的商品需求量为88.4791.在画面左下方的下拉式菜单中选”all ”, 则beta 、rmse 和residuals 都传送到Matlab 工作区中.在Matlab 工作区中输入命令:beta, rmse 得结果:beta = 110.5313 0.1464 -26.5709 -0.0001 1.8475 rmse = 4.5362故回归模型为:2221218475.10001.05709.261464.05313.110x x x x y +--+=剩余标准差为4.5362, 说明此回归模型的显著性较好.解法二:将2222211122110x x x x y βββββ++++=化为多元线性回归:X=[ones(10,1) x1' x2' (x1.^2)' (x2.^2)']; [b,bint,r,rint,stats]=regress(y,X); b,stats 结果为: b =110.5313 0.1464 -26.5709 -0.0001 1.8475 stats =0.9702 40.6656 0.0005三、非线性回归 1、非线性回归:(1)确定回归系数的命令:[beta,r,J]=nlinfit(x,y,’model ’, beta0)说明:beta 表示估计出的回归系数;r 表示残差;J 表示Jacobian 矩阵;x,y 表示输入数据x 、y 分别为矩阵和n 维列向量,对一元非线性回归,x 为n 维列向量;model 表示是事先用m-文件定义的非线性函数;beta0表示回归系数的初值. (2)非线性回归命令:nlintool(x,y,’model ’, beta0,alpha) 2、预测和预测误差估计:[Y,DELTA]=nlpredci(’model ’, x,beta,r,J)表示nlinfit 或nlintool 所得的回归函数在x 处的预测值Y 及预测值的显著性为1-alpha 的置信区间Y ±DELTA. 例1. 如下程序.解:(1)对将要拟合的非线性模型y=a x b e /,建立m-文件volum.m 如下: function yhat=volum(beta,x) yhat=beta(1)*exp(beta(2)./x); (2)输入数据: x=2:16;y=[6.42 8.20 9.58 9.5 9.7 10 9.93 9.99 10.49 10.59 10.60 10.80 10.60 10.90 10.76];beta0=[8 2]'; (3)求回归系数:[beta,r ,J]=nlinfit(x',y','volum',beta0); beta (4)运行结果:beta =11.6036 -1.0641 即得回归模型为:xey 10641.16036.11-=(5)预测及作图:[YY,delta]=nlpredci('volum',x',beta,r ,J);plot(x,y,'k+',x,YY,'r')四、逐步回归1、逐步回归的命令:stepwise(x,y,inmodel,alpha)n⨯阶矩阵;y表示因变量数据,1⨯n阶矩阵;inmodel表示矩说明:x表示自变量数据,m阵的列数的指标,给出初始模型中包括的子集(缺省时设定为全部自变量);alpha表示显著性水平(缺省时为0.5).2、运行stepwise命令时产生三个图形窗口:Stepwise Plot,Stepwise Table,Stepwise History.在Stepwise Plot窗口,显示出各项的回归系数及其置信区间.(1)Stepwise Table窗口中列出了一个统计表,包括回归系数及其置信区间,以及模型的统计量剩余标准差(RMSE)、相关系数(R-square)、F值、与F对应的概率P.例1. 水泥凝固时放出的热量y与水泥中4种化学成分x1、x2、x3、x4有关,今测得一组数据如下,试用逐步回归法确定一个线性模型.解:(1)数据输入:x1=[7 1 11 11 7 11 3 1 2 21 1 11 10]';x2=[26 29 56 31 52 55 71 31 54 47 40 66 68]';x3=[6 15 8 8 6 9 17 22 18 4 23 9 8]';x4=[60 52 20 47 33 22 6 44 22 26 34 12 12]';y=[78.5 74.3 104.3 87.6 95.9 109.2 102.7 72.5 93.1 115.9 83.8 113.3 109.4]'; x=[x1 x2 x3 x4];(2)逐步回归.①先在初始模型中取全部自变量:stepwise(x,y)得图Stepwise Plot 和表Stepwise Table.图Stepwise Plot中四条直线都是虚线,说明模型的显著性不好.从表Stepwise Table中看出变量x3和x4的显著性最差.②在图Stepwise Plot中点击直线3和直线4,移去变量x3和x4.移去变量x3和x4后模型具有显著性虽然剩余标准差(RMSE)没有太大的变化,但是统计量F的值明显增大,因此新的回归模型更好.(3)对变量y和x1、x2作线性回归.X=[ones(13,1) x1 x2];b=regress(y,X)得结果:b =52.57731.46830.6623故最终模型为:y=52.5773+1.4683x1+0.6623x2或这种方法4元二次线性回归clc;clear;y=[1.84099 9.67 23.00 38.12 1.848794 6.22 12.22 19.72 1.848794 5.19 10.09 15.31 ];X1=[60.36558 59.5376 58.89861 58.74706 60.59389 60.36558 59.2 58.2 60.36558 59.97068 59.41918 5 X2=[26.1636 26.35804 26.82438 26.91521 25.90346 25.9636 27.19256 27.42153 26.1636 26.07212 26.27.06063];X3=[0.991227 0.994944 0.981322 0.98374 1.011865 0.991227 1.074772 1.107678 0.991227 0.917904 1 1.1239];X4=[59.37436 58.54265 57.91729 57.69332 59.58203 59.37436 57.76722 57.42355 59.37436 59.05278 57.76687];format short gY=y'X11=[ones(1,length(y));X1;X2;X3;X4]'B1=regress(Y,X11)% 多元一次线性回归[m,n]=size(X11)X22=[];for i=2:nfor j=2:nif i<=jX22=([X22,X11(:,i).*X11(:,j)]);elsecontinueendendendX=[X11,X22];B2=regress(Y,X)% 多元二次线性回归[Y X*B2 Y-X*B2]plot(Y,X11*B1,'o',Y,X*B2,'*')hold on,line([min(y),max(y)],[min(y),max(y)]) axis([min(y) max(y) min(y) max(y)]) legend('一次线性回归','二次线性回归') xlabel('实际值');ylabel('计算值')运行结果:Y =1.8419.672338.121.84886.2212.2219.721.84885.1910.0915.31X11 =1 60.366 26.164 0.99123 59.3741 59.538 26.358 0.99494 58.5431 58.899 26.824 0.98132 57.9171 58.747 26.915 0.98374 57.6931 60.594 25.903 1.0119 59.5821 60.366 25.964 0.99123 59.3741 59.2 27.193 1.0748 57.7671 58.2 27.422 1.1077 57.4241 60.366 26.164 0.99123 59.3741 59.971 26.072 0.9179 59.1 59.419 26.587 1.0604 58.3591 58.891 27.061 1.1239 57.767 B1 =1488.9-4.3582-9.6345-61.514-15.359m =12n =5B2 =3120.4-7129.2-622.23-362.71-105.061388.1120.25.25379.58170.48-796.41ans =1.841 1.8449 -0.0039029.67 9.67 1.0058e-00923 23 1.397e-00938.12 38.12 3.539e-1.8488 1.8488 1.6394e-0096.22 6.227.2643e-12.22 12.22 2.6077e-19.72 19.72 -2.0489e-1.8488 1.8449 0.0039025.19 5.19 1.4529e-00910.09 10.09 1.0803e-00915.31 15.31 4.0978e-由图形可以看出,多元二次线性回归效果非常好,即,相当于Y=3120.4*X1 -7129.2 *X2 + 0*X3 + 0*X4 -622.23*X1*X1 -362.71*X1*X2 -105.06*X1*X3 + 1388 120.25*X2*X2+ .25 *X2*X3+ 379.58*X2*X4 + 170.48*X3*X3+ 0*X3*X4 -796.41*X4*X4。

Matlab多变量回归分析教程

本次(běn cì)教程的主要内容包含:一、多元(duō yuán)线性回归 2#多元(duō yuán)线性回归:regress二、多项式回归(huíguī) 3#一元(yī yuán)多项式:polyfit或者polytool 多元二项式:rstool或者rsmdemo三、非线性回归 4#非线性回归:nlinfit四、逐步回归 5#逐步回归:stepwise一、多元线性回归多元线性回归:1、b=regress(Y, X ) 确定回归系数的点估计值2、[b, bint,r,rint,stats]=regress(Y,X,alpha)求回归系数的点估计和区间估计、并检验回归模型①bint表示回归系数的区间估计.②r表示残差③rint表示置信区间④stats表示用于检验回归模型的统计量,有三个数值:相关系数r2、F值、与F对应的概率p说明:相关系数r2越接近1,说明回归方程越显著;时拒绝H0,F越大,说明回归方程越显著;与F对应的概率p<α时拒绝H0⑤alpha表示显著性水平(缺省时为0.05)3、rcoplot(r,rint)画出残差及其置信区间具体参见下面的实例演示4、实例演示,函数使用说明(1)输入数据1.>>x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]';2.>>X=[ones(16,1) x];3.>>Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]';复制代码(2)回归分析及检验1. >> [b,bint,r,rint,stats]=regress(Y,X)2.3. b =4.5. -16.07306. 0.71947.8.9.bint =10.11. -33.7071 1.561212. 0.6047 0.834013.14.15.r =16.17. 1.205618. -3.233119. -0.952420. 1.328221. 0.889522. 1.170223. -0.987924. 0.292725. 0.573426. 1.854027. 0.134728. -1.584729. -0.304030. -0.023431. -0.462132. 0.099233.34.35.rint =36.37. -1.2407 3.652038. -5.0622 -1.404039. -3.5894 1.684540. -1.2895 3.945941. -1.8519 3.630942. -1.5552 3.895543. -3.7713 1.795544. -2.5473 3.132845. -2.2471 3.393946. -0.7540 4.462147. -2.6814 2.950848. -4.2188 1.049449. -3.0710 2.463050. -2.7661 2.719351. -3.1133 2.189252. -2.4640 2.662453.54.55.stats =56.57. 0.9282 180.9531 0.0000 1.7437复制代码运行结果解读如下参数回归结果为,对应的置信区间分别为[-33.7017,1.5612]和[0.6047,0.8r2=0.9282(越接近于1,回归效果越显著),F=180.9531, p=0.0000,由p<0.05, 可知回归模型y=-16.073+0.7194x成立(3)残差分析作残差图1.rcoplot(r,rint)复制代码从残差图可以看出,除第二个数据外,其余数据的残差离零点均较近,且残差的置信区间均包含零这说明回归模型 y=-16.073+0.7194x能较好的符合原始数据,而第二个数据可视为异常点。

多元回归模型matlab

多元回归模型matlab

在 MATLAB 中,可以使用多种函数来拟合多元回归模型。

其中最常用的是“fitlm”函数。

下面是一个简单的例子:

假设我们有一组数据,包含两个自变量 x1 和 x2,以及一个因变量 y。

我们想要建立一个多元回归模型,来预测 y 值。

首先,我们需要将数据加载到 MATLAB 中,并创建一个线性回归模型对象:

```

data = readtable("data.csv"); % 加载数据

model = fitlm(data, "y ~ x1 + x2"); % 创建回归模型

```

在这个例子中,“data.csv”是包含数据的 CSV 文件,第一列是 y 值,第二列是 x1 值,第三列是 x2 值。

然后,我们使用“fitlm”函数来创建一个线性回归模型对象“model”,其中第一个参数是数据表,第二个参数是回归方程式,它指定了因变量和自变量之间的关系。

我们现在可以使用该模型对象进行预测。

matlab标准化回归系数

matlab标准化回归系数

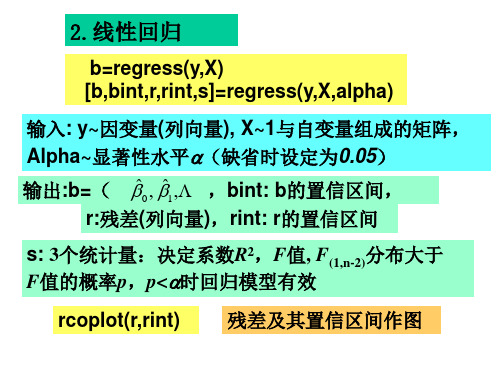

在MATLAB中,标准化回归系数通常是指在多元线性回归模型中使用标准化的自变量来计算的回归系数。

标准化回归系数可以帮助比较不同自变量对因变量的影响,因为它们消除了自变量之间的量纲差异。

在MATLAB中,你可以使用`fitlm`函数来进行标准化回归分析。

以下是在MATLAB中计算标准化回归系数的一般步骤:

1. 首先,准备你的自变量和因变量数据。

假设你有一个自变量矩阵X和一个因变量向量Y。

2. 使用`zscore`函数对自变量矩阵X进行标准化处理,将每个自变量减去其均值并除以标准差。

这可以通过以下代码实现:

Xstandardized = zscore(X);

3. 使用`fitlm`函数拟合标准化后的自变量和因变量,得到回归模型对象。

代码如下:

mdl = fitlm(Xstandardized, Y);

4. 最后,你可以使用`coefTest`函数来获取标准化回归系数的显著性检验结果,或者直接使用`mdl.Coefficients`属性来获取标准化回归系数的估计值和统计信息。

需要注意的是,以上步骤仅展示了在MATLAB中进行标准化回归分析的基本流程。

实际分析中,你可能还需要对模型进行诊断和验证,以确保回归模型的合理性和准确性。

希望这些信息能帮助你理解在MATLAB中进行标准化回归系数计算的基本方法。

MATLAB中多元线性回归

0 1 2 3

R2= 0.8462 F= 44.0087 p<0.0001 s2 =53.6604

这时置信区间不包含零点,F统计量增大,可决系 数从0.6855增大到0.8462 ,我们得到回归模型为:

ˆ 58 . 5101 0 . 4303 x 1 2 . 3449 x 2 10 . 3065 x 3 y

y与x1的散点图 线性回归模型

y与x2的散点图

y 0 1 x1 2 x 2 3 x 3

回归系数0, 1, 2, 3 由数据估计, 是随机误差

n=30;m=3; y=[144 215 138 145 162 142 170 124 158 154 162 150 140 110 128 130 135 114 116 124 136 142 120 120 160 158 144 130 125 175]; x1=[39 47 45 47 65 46 67 42 67 56 64 56 59 34 42 48 45 18 20 19 36 50 39 21 44 53 63 29 25 69]; x2=[24.2 31.1 22.6 24.0 25.9 25.1 29.5 19.7 27.2 19.3 28.0 25.8 27.3 20.1 21.7 22.2 27.4 18.8 22.6 21.5 25.0 26.2 23.5 20.3 27.1 28.6 28.3 22.0 25.3 27.4]; x3=[0 1 0 1 1 0 1 0 1 0 1 0 0 0 0 1 0 0 0 0 0 1 0 0 1 1 0 1 0 1];

n n

DW

t2

( e t e t 1 ) /

2

多元线性回归建模以及MATLAB和SPSS求解

图2时序残差图

万方数据

图6,与№的散点图

167

表4 ANOVA(b)方差分析

ModeI l

R删

Sum 0f Sau目瞄

627.631

Mmsq

df

F

si辱

删自 3 209.210 70 045

R%idII丑l 59.736

1h缸

687.366

20

2.987

23

图7 v与自的散点图

(二)利用sPss求回归方程:设回归方程为:穸邛。印M+

可以采用线性回归.M心B源程序: 看出这些点大致分布在一条直线旁边,有比较好的线性关系,

xI-[3.5 5.35.1 5.842矗06.8 5.5 3.1 7.24.5 4.9 80矗5 6.6 3.7

’【收稿日期】2007-07—12

·4[作者简介】陈永胜(197卜),男,吉林师范大学数学学院讲师,硕士,研究方向:拓扑动力系统。

·}+【基金项目】吉林省高等教育教学研究重点课题,课题名称《数学实验在数学教学中的理论研究与实践》。

166

万方数据

6.2 7.0404.5 5.9 5.64 8 3.9 J; xF[92018 33 3113 25 30 5 47 25¨23 35 3921 7 40 35 23 33

二、运用SPSS软件求解多元线性回归模型

-+·第27卷第嘲

V01.27 No.6

绥化学院学报

Jo哪al 0fSuihua Unive硌畸

2007年12月

Dec.2007

摘要:研究了在多元线性回归分析建模的过程中如何使用MAlL蛐:软件和sPss软件。包括:如何建立初步的数学模型

如何透过输出结果对模型进行分析和改进.回归模型的确定和应用。

Matlab中的回归分析与多元统计分析

Matlab中的回归分析与多元统计分析Matlab是一种功能强大的数值计算和科学编程软件,广泛应用于各个领域中数据处理和分析的任务。

在统计学中,回归分析和多元统计分析是常见的方法,它们能够帮助我们揭示数据之间的隐藏关系和趋势。

本文将探讨在Matlab环境下如何进行回归分析和多元统计分析。

一、回归分析回归分析是一种用于研究变量之间关系的统计方法。

它可以分析自变量(或称预测变量)与因变量之间的相关性,并通过建立数学模型来预测未知的观测值。

在Matlab中,我们可以使用regress函数进行简单回归分析。

假设我们有两个变量X和Y,我们想要探索它们之间是否存在线性关系。

首先,我们需要导入数据,并绘制散点图以观察数据分布的趋势:```matlabdata = [X, Y]; % 导入数据scatter(X, Y); % 绘制散点图```接下来,我们可以使用regress函数进行回归分析:```matlabmdl = regress(Y, [ones(size(X)), X]); % 进行简单线性回归```regress函数将返回一个线性模型对象mdl,我们可以使用该对象提取回归系数、残差等信息:```matlabcoef = mdl(1:end-1); % 提取回归系数residuals = mdl(end); % 提取残差```此外,我们还可以使用mdl对象进行预测:```matlaby_pred = [ones(size(X)), X] * coef; % 根据模型预测Y的值```二、多元统计分析多元统计分析是指研究多个变量之间关系的统计方法。

与简单回归分析不同,多元统计分析考虑了多个自变量对因变量的影响。

在Matlab中,我们可以使用fitlm函数进行多元线性回归分析。

假设我们有三个自变量X1、X2和X3,一个因变量Y,我们想要研究它们之间的关系。

首先,我们同样需要导入数据,并绘制散点图以观察数据分布:```matlabdata = [X1, X2, X3, Y]; % 导入数据scatter3(X1, X2, X3, Y); % 绘制散点图```接下来,我们可以使用fitlm函数进行多元线性回归分析:```matlabmdl = fitlm([X1, X2, X3], Y); % 进行多元线性回归```fitlm函数将返回一个线性模型对象mdl,我们可以使用该对象提取回归系数、残差等信息:```matlabcoef = mdl.Coefficients.Estimate; % 提取回归系数residuals = mdl.Residuals.Raw; % 提取残差```同样,我们可以使用mdl对象进行预测:```matlaby_pred = predict(mdl, [X1, X2, X3]); % 根据模型预测Y的值```除了多元线性回归,Matlab还提供了其他多元统计分析的方法,如主成分分析(PCA)和因子分析。

MATLAB 回归分析regress,nlinfit,stepwise函数

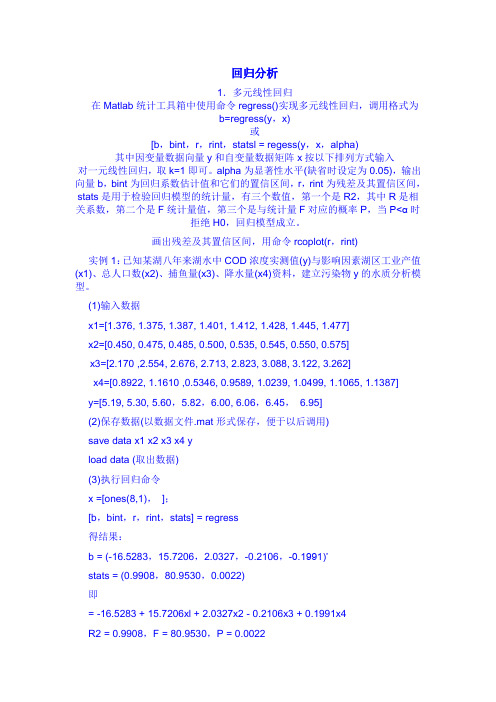

MATLAB 回归分析regress,nlinfit,stepwise函数matlab回归分析regress,nlinfit,stepwise函数回归分析1.多元线性重回在matlab统计工具箱中使用命令regress()实现多元线性回归,调用格式为b=regress(y,x)或[b,bint,r,rint,statsl=regess(y,x,alpha)其中因变量数据向量y和自变量数据矩阵x按以下排列方式输入对一元线性重回,挑k=1即可。

alpha为显著性水平(缺省时预设为0.05),输入向量b,bint为回归系数估计值和它们的置信区间,r,rint为残差及其置信区间,stats就是用作检验重回模型的统计数据量,存有三个数值,第一个就是r2,其中r就是相关系数,第二个就是f统计数据量值,第三个就是与统计数据量f对应的概率p,当p拒绝h0,回归模型成立。

图画出来残差及其置信区间,用命令rcoplot(r,rint)实例1:已知某湖八年来湖水中cod浓度实测值(y)与影响因素湖区工业产值(x1)、总人口数(x2)、捕鱼量(x3)、降水量(x4)资料,建立污染物y的水质分析模型。

(1)输出数据x1=[1.376,1.375,1.387,1.401,1.412,1.428,1.445,1.477]x2=[0.450,0.475,0.485,0.50 0,0.535,0.545,0.550,0.575]x3=[2.170,2.554,2.676,2.713,2.823,3.088,3.122,3.262]x4=[0.8922,1.1610,0.5346,0.9589,1.0239,1.0499,1.1065,1.1387]y=[5.19,5.30,5.60,5.82,6.00,6.06,6.45,6.95](2)留存数据(以数据文件.mat形式留存,易于以后调用)savedatax1x2x3x4yloaddata(抽出数据)(3)继续执行重回命令x=[ones(8,1),];[b,bint,r,rint,stats]=regress得结果:b=(-16.5283,15.7206,2.0327,-0.2106,-0.1991)’stats=(0.9908,80.9530,0.0022)即为=-16.5283+15.7206xl+2.0327x2-0.2106x3+0.1991x4r2=0.9908,f=80.9530,p=0.00222.非线性重回非线性回归可由命令nlinfit来实现,调用格式为[beta,r,j]=nlinfit(x,y,'model’,beta0)其中,输人数据x,y分别为n×m矩阵和n维列向量,对一元非线性回归,x为n维列向量model是事先用m-文件定义的非线性函数,beta0是回归系数的初值,beta是估计出的回归系数,r是残差,j是jacobian矩阵,它们是估计预测误差需要的数据。

MATLAB 回归分析regress,nlinfit,stepwise函数

回归分析1.多元线性回归在Matlab统计工具箱中使用命令regress()实现多元线性回归,调用格式为b=regress(y,x)或[b,bint,r,rint,statsl = regess(y,x,alpha)其中因变量数据向量y和自变量数据矩阵x按以下排列方式输入对一元线性回归,取k=1即可。

alpha为显著性水平(缺省时设定为0.05),输出向量b,bint为回归系数估计值和它们的置信区间,r,rint为残差及其置信区间,stats是用于检验回归模型的统计量,有三个数值,第一个是R2,其中R是相关系数,第二个是F统计量值,第三个是与统计量F对应的概率P,当P<α时拒绝H0,回归模型成立。

画出残差及其置信区间,用命令rcoplot(r,rint)实例1:已知某湖八年来湖水中COD浓度实测值(y)与影响因素湖区工业产值(x1)、总人口数(x2)、捕鱼量(x3)、降水量(x4)资料,建立污染物y的水质分析模型。

(1)输入数据x1=[1.376, 1.375, 1.387, 1.401, 1.412, 1.428, 1.445, 1.477]x2=[0.450, 0.475, 0.485, 0.500, 0.535, 0.545, 0.550, 0.575]x3=[2.170 ,2.554, 2.676, 2.713, 2.823, 3.088, 3.122, 3.262]x4=[0.8922, 1.1610 ,0.5346, 0.9589, 1.0239, 1.0499, 1.1065, 1.1387]y=[5.19, 5.30, 5.60,5.82,6.00, 6.06,6.45,6.95](2)保存数据(以数据文件.mat形式保存,便于以后调用)save data x1 x2 x3 x4 yload data (取出数据)(3)执行回归命令x =[ones(8,1),];[b,bint,r,rint,stats] = regress得结果:b = (-16.5283,15.7206,2.0327,-0.2106,-0.1991)’stats = (0.9908,80.9530,0.0022)即= -16.5283 + 15.7206xl + 2.0327x2 - 0.2106x3 + 0.1991x4R2 = 0.9908,F = 80.9530,P = 0.00222.非线性回归非线性回归可由命令nlinfit来实现,调用格式为[beta,r,j] = nlinfit(x,y,'model’,beta0)其中,输人数据x,y分别为n×m矩阵和n维列向量,对一元非线性回归,x 为n维列向量model是事先用m-文件定义的非线性函数,beta0是回归系数的初值,beta是估计出的回归系数,r是残差,j是Jacobian矩阵,它们是估计预测误差需要的数据。

利用MATLAB进行多元线性回归

n=30;m=3;

y=[144 215 138 145 162 142 170 124

158 154 162 150 140 110 128 130

135 114 116 124 136 142 120 120

160 158 144 130 125 175];

x1=[39 47 45 47 65 46 67 42

67

56 64 56

59

34

42

48

45 18 20 19 36 50 39 21

44

53

63

29

25

69];

x2=[24.2 31.1 22.6 24.0 25.9 25.1 29.5 19.7 27.2 19.3 28.0 25.8 27.3

20.1 21.7 22.2 27.4 18.8 22.6 21.5 25.0 26.2 23.5 20.3 27.1 28.6 28.3

yˆ 58.5101 0.4303 x1 2.3449 x2 10.3065 x3

通常,进行多元线性回归的步骤如下:

(1)做自变量与因变量的散点图,根据散点图的形 状决定是否可以进行线性回归;

(2)输入自变量与因变量;

(3)利用命令: [b,bint,r,rint,s]=regress(y,X,alpha),rcoplot(r,rint) 得到回归模型的系数以及异常点的情况;

剔除异常点 (第2点和第 10点)后

回归系数

0 1 2 3

R2= 0.8462

回归系数估计值 回归系数置信区间

58.5101

[29.9064 87.1138]

0.4303

[0.1273 0.7332]

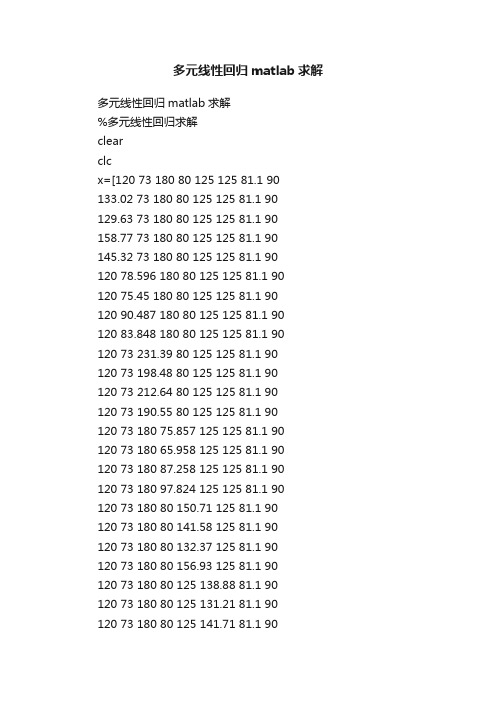

多元线性回归matlab求解

多元线性回归matlab求解多元线性回归matlab求解%多元线性回归求解clearclcx=[120 73 180 80 125 125 81.1 90 133.02 73 180 80 125 125 81.1 90 129.63 73 180 80 125 125 81.1 90 158.77 73 180 80 125 125 81.1 90 145.32 73 180 80 125 125 81.1 90120 78.596 180 80 125 125 81.1 90120 75.45 180 80 125 125 81.1 90120 90.487 180 80 125 125 81.1 90120 83.848 180 80 125 125 81.1 90120 73 231.39 80 125 125 81.1 90120 73 198.48 80 125 125 81.1 90120 73 212.64 80 125 125 81.1 90120 73 190.55 80 125 125 81.1 90120 73 180 75.857 125 125 81.1 90120 73 180 65.958 125 125 81.1 90120 73 180 87.258 125 125 81.1 90120 73 180 97.824 125 125 81.1 90120 73 180 80 150.71 125 81.1 90120 73 180 80 141.58 125 81.1 90120 73 180 80 132.37 125 81.1 90120 73 180 80 156.93 125 81.1 90120 73 180 80 125 138.88 81.1 90120 73 180 80 125 131.21 81.1 90120 73 180 80 125 141.71 81.1 90120 73 180 80 125 149.29 81.1 90120 73 180 80 125 125 60.582 90120 73 180 80 125 125 70.962 90120 73 180 80 125 125 64.854 90120 73 180 80 125 125 75.529 90120 73 180 80 125 125 81.1 104.84120 73 180 80 125 125 81.1 111.22120 73 180 80 125 125 81.1 98.092120 73 180 80 125 125 81.1 120.44];y=[164.78 140.87 -144.25 119.09 135.44 157.69 165.81 140.13 -145.14 118.63 135.37 160.76165.51 140.25 -144.92 118.7 135.33 159.98167.93 138.71 -146.91 117.72 135.41 166.81166.79 139.45 -145.92 118.13 135.41 163.64164.94 141.5 -143.84 118.43 136.72 157.22 164.8 141.13 -144.07 118.82 136.02 157.5 165.59 143.03 -143.16 117.24 139.66 156.59 165.21 142.28 -143.49 117.96 137.98 156.96 167.43 140.82 -152.26 129.58 132.04 153.6 165.71 140.82 -147.08 122.85 134.21 156.23 166.45 140.82 -149.33 125.75 133.28 155.09 165.23 140.85 -145.82 121.16 134.75 156.77 164.23 140.73 -144.18 119.12 135.57 157.2 163.04 140.34 -144.03 119.31 135.97 156.31 165.54 141.1 -144.32 118.84 135.06 158.26 166.88 141.4 -144.34 118.67 134.67 159.28 164.07 143.03 -140.97 118.75 133.75 158.83 164.27 142.29 -142.15 118.85 134.27 158.37 164.57 141.44 -143.3 119 134.88 158.01 163.89 143.61 -140.25 118.64 133.28 159.12 166.35 139.29 -144.2 119.1 136.33 157.59 165.54 140.14 -144.19 119.09 135.81 157.67 166.75 138.95 -144.17 119.15 136.55 157.59 167.69 138.07 -144.14 119.19 137.11 157.65 162.21 141.21 -144.13 116.03 135.5 154.26 163.54141 -144.16 117.56 135.44 155.93 162.7 141.14 -144.21 116.74 135.4 154.88 164.06 140.94 -144.18 118.24 135.4 156.68 164.66 142.27 -147.2 120.21 135.28 157.65 164.7 142.94 -148.45 120.68 135.16 157.63 164.67 141.56 -145.88 119.68 135.29 157.61 164.69 143.84 -150.34 121.34 135.12 157.64 ];[m,n]=size(x);X=[ones(m,1) x];[m1,n1]=size(X);[m2,n2]=size(y);for i=1:n2%b为参数,bint回归系数的区间估计,r为残差,%rint为置信区间,stats用于回归模型检验[b(:,i),bint,r,rint,stats(i,:)]=regress(y(:,i),X);[mm,nn]=size(b);for jj=1:m1temp=0;for ii=1:mmyy(jj,i)=temp+b(ii,i)*X(jj,ii);temp=yy(jj,i);endendxiangdui_wucha(1,i)=abs(abs(y(1,i))-abs(yy(1,i)))/abs(y(1,i));if n2~=1subplot(2,n2/2,i);rcoplot(r,rint)%残差分析,作出残差及其置信区间elsercoplot(r,rint)%残差分析,作出残差及其置信区间endenddisp('参数');b %参数计算disp('预测结果');yy%检验回归模型:相关系数r^2=stats(1,:)越接近1回归方程越显著%F=stats(2,:)值越大回归方程越显著、p=stats(3,:)<0.01时回归模型成立disp('回归模型检验:');format longstatsfor i=1:n2if (stats(i,4)<0.01)&(stats(i,1)>0.6)disp('回归方程显著-------模型成立');endendformat shortdisp('相对误差');xiangdui_wucha%第一行原始值与预测值的相对误差。

多元线性回归 matlab中求解

多元线性回归matlab中求解源代码:y=data(:,1);>> x=data(:,2:3);>> [b,bint,r,rint,stats]=regress(y,x)结果:b =1.603121.0280bint =0.6449 2.561214.4526 27.6034r =-16.24428.875417.58288.31557.6692-20.79900.15789.129821.1145-28.9567rint =-54.5200 22.0316-28.0267 45.7775-15.2745 50.4401-29.9540 46.5850-30.7374 46.0758-57.6551 16.0572-40.7942 41.1098-30.8252 49.0848-15.2155 57.4446-59.3228 1.4095stats =1.0148 742.1191 0.0000 322.5068分析结果:stats四个值说明:判决系数r^2,,F统计值,p值,误差方差y=a1*x(1)+a2*x(2);其中a1=1.6031,a2=21.0280,a1的置信区间【0.6449,2.5612】,a2的置信区间【14.45426,27.6043】,p小于0.05,说明显著效果很好,越小越好在spss中求解:线性规划matlab求解例1:c=[2;3;1]; mix z=2*x1+3*x2+x3 >> a=[1 4 2;3 2 0]; s.t 1.x1+4*x2+2*x3>=8; >> b=[8;6]; 2.3*x1+2*x2>=6;>> [x,y]=linprog(c,-a,-b,[],[],zeros(3,1) ) 3.x1>=0,x2>=0,x3>=0结果:x =0.80661.79000.0166 %最优解y =7.0000 %最优值例2:c=[2;3;-5]; max z=2*x1+3*x2-5*x3a=[-2,5,-1];b=-10; s.t 1.x1+x2+x3=7;aeq=[1,1,1]; 2.2*x1-5*x2+x3>=10;beq=7; 3.x1>=0,x2>=0,x3>=0%是求最大值而不是最小值,注意这里是"-c"而不是"c"x=linprog(-c,a,b,aeq,beq,zeros(3,1))value=c'*x结果:x =6.42860.57140.0000 %最优解value = 14.5714 %最优值例3.(整数规划)灰色预测clearsyms a b;c=[a b]';A=[89677,99215,109655,120333,135823,159878,182321,209407,246619,300670];B=cumsum(A); %原始数据累加n=length(A);for i=1:(n-1)C(i)=(B(i)+B(i+1))/2; %生成累加矩阵end% 计算待定参数的值D=A;D(1)=[];D=D' ;E=[-C;ones(1,n-1)];c=inv(E*E')*E*D;c=c' ;a=c(1);b=c(2);% 预测后续数据F=[];F(1)=A(1);for i=2:(n+10)F(i)=(A(1)-b/a)/exp(a*(i-1))+b/a ;endG=[];G(1)=A(1);for i=2:(n+10)G(i)=F(i)-F(i-1); %得到预测出来的数据endt1=1999:2008;t2=1999:2018;Gplot(t1,A,'o',t2,G)结果; 1.0e+006 *0.08970.08930.10340.11960.13850.16020.18540.21460.24830.28730.33250.38470.44520.51520.59620.68990.79840.92391.06911.2371。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

多元线性回归matlab中求解

源代码:

y=data(:,1);

>> x=data(:,2:3);

>> [b,bint,r,rint,stats]=regress(y,x)

结果:

b =1.6031

21.0280

bint =0.6449 2.5612

14.4526 27.6034

r =-16.2442

8.8754

17.5828

8.3155

7.6692

-20.7990

0.1578

9.1298

21.1145

-28.9567

rint =-54.5200 22.0316

-28.0267 45.7775

-15.2745 50.4401

-29.9540 46.5850

-30.7374 46.0758

-57.6551 16.0572

-40.7942 41.1098

-30.8252 49.0848

-15.2155 57.4446

-59.3228 1.4095

stats =1.0148 742.1191 0.0000 322.5068

分析结果:

stats四个值说明:判决系数r^2,,F统计值,p值,误差方差

y=a1*x(1)+a2*x(2);其中a1=1.6031,a2=21.0280,

a1的置信区间【0.6449,2.5612】,a2的置信区间【14.45426,27.6043】,p小于0.05,说明显著效果很好,越小越好

在spss中求解:

线性规划matlab求解

例1:c=[2;3;1]; mix z=2*x1+3*x2+x3 >> a=[1 4 2;3 2 0]; s.t 1.x1+4*x2+2*x3>=8; >> b=[8;6]; 2.3*x1+2*x2>=6;

>> [x,y]=linprog(c,-a,-b,[],[],zeros(3,1) ) 3.x1>=0,x2>=0,x3>=0结果:x =0.8066

1.7900

0.0166 %最优解

y =7.0000 %最优值

例2:c=[2;3;-5]; max z=2*x1+3*x2-5*x3

a=[-2,5,-1];b=-10; s.t 1.x1+x2+x3=7;

aeq=[1,1,1]; 2.2*x1-5*x2+x3>=10;

beq=7; 3.x1>=0,x2>=0,x3>=0

%是求最大值而不是最小值,注意这里是"-c"而不是"c"

x=linprog(-c,a,b,aeq,beq,zeros(3,1))

value=c'*x

结果:x =6.4286

0.5714

0.0000 %最优解

value = 14.5714 %最优值

例3.(整数规划)

灰色预测

clear

syms a b;

c=[a b]';

A=[89677,99215,109655,120333,135823,159878,182321,209407,246619,300670];

B=cumsum(A); %原始数据累加

n=length(A);

for i=1:(n-1)

C(i)=(B(i)+B(i+1))/2; %生成累加矩阵end

% 计算待定参数的值

D=A;D(1)=[];

D=D' ;

E=[-C;ones(1,n-1)];

c=inv(E*E')*E*D;

c=c' ;

a=c(1);b=c(2);

% 预测后续数据

F=[];F(1)=A(1);

for i=2:(n+10)

F(i)=(A(1)-b/a)/exp(a*(i-1))+b/a ;

end

G=[];G(1)=A(1);

for i=2:(n+10)

G(i)=F(i)-F(i-1); %得到预测出来的数据end

t1=1999:2008;

t2=1999:2018;

G

plot(t1,A,'o',t2,G)

结果; 1.0e+006 *

0.0897

0.0893

0.1034

0.1196

0.1385

0.1602

0.1854

0.2146

0.2483

0.2873

0.3325

0.3847

0.4452

0.5152

0.5962

0.6899

0.7984

0.9239

1.0691

1.2371。