一元线性模型的参数估计

第一课时 一元线性回归模型及其参数的最小二乘估计

解析 由题意得-x=3+4+4 5+6=4.5, -y=25+30+4 40+45=35. ∵回归直线方程^y=b^x+a^中b^=7,∴35=7×4.5+a^,解得a^=3.5, ∴^y=7x+3.5. ∴当 x=10 时,^y=7×10+3.5=73.5(万元). 答案 73.5

(2)列出下表,并用科学计算器进行有关计算.

i

1

2

3

4

5

xi

2

4

5

6

8

yi

30

40

60

50

70

xiyi

60

160

300

300

560

x2i

4

16

25

36

64

-x=5,-y=50,i=∑5 1x2i =145,i=∑5 1xiyi=1 380

5

∑xiyi-5-x

-

y

于是可得,b^=i=15

∑xi2-5-x 2

【训练2】 某车间为了规定工时定额,需要确定加工零件所花费的时间,为此做了四 次实验,得到的数据如下:

零件的个数x(个) 加工的时间y(h)

23 2.5 3

45 4 4.5

(1)已知零件个数与加工时间线性相关,求出y关于x的线性回归方程; (2)试预测加工10个零件需要多少时间?

4

解 (1)由表中数据,得∑xiyi=2×2.5+3×3+4×4+5×4.5=52.5, i=1

【迁移2】 (变条件,变设问)本例中近似方程不变,每小时生产有缺点的零件件数是 7,估计机器的转速. 解 因为 y=5710x-67,所以当 y=7 时,7=5710x-67,解得 x≈11,即估计机器的转速约为 11 转/秒.

一元线性回归模型参数的最小二乘法估计

8.2.1一元线性回归模型1.生活经验告诉我们,儿子的身高与父亲的身高相关.一般来说,父亲的身高较高时,儿子的身高通常也较高.为了进一步研究两者之间的关系,有人调查了14名男大学生的身高及其父亲的身高,得到的数据如表1所示.编号1234567891011121314父亲身高/cm 174 170 173 169 182 172 180 172 168 166 182 173 164 180 儿子身高/cm 176 176 170 170 185 176 178 174 170 168 178 172 165 182从图上看,散点大致分布在一条直线附近根据我们学过的整理数据的方法:相关系数r =0.886.父亲身高/cm180 175 170 165 160160 165 170 175180 185 190 ·· ·· · · · 儿子身高/cm· · · · ·185 1).问题1:可以得到什么结论?由散点图的分布趋势表明儿子的身高与父亲的身高线性相关,通过相关系数可知儿子的身高与父亲的身高正线性相关,且相关程度较高.2).问题2:是否可以用函数模型来刻画?不能,因为不符合函数的定义.这其中还受其它因素的影响.3).问题3:那么影响儿子身高的其他因素是什么?影响儿子身高的因素除父亲的身外,还有母亲的身高、生活的环境、饮食习惯、营养水平、体育锻炼等随机的因素,儿子身高是父亲身高的函数的原因是存在这些随机的因素.4).问题4: 你能否考虑到这些随机因素的作用,用类似于函数的表达式,表示儿子身高与父亲身高的关系吗?用x表示父亲身高,Y表示儿子的身高,用e表示各种其它随机因素影响之和,称e为随机误差, 由于儿子身高与父亲身高线性相关,所以Y=bx+a.考虑随机误差后,儿子的身高可以表示为:Y=bx+a+e由于随机误差表示大量已知和未知的各种影响之和,它们会相互抵消,为使问题简洁,可假设随机误差e的均值为0,方差为与父亲身高无关的定值 . 2σ2即E e D eσ:()0,().==我们称①式为Y 关于x 的一元线性回归模型,其中,Y 称为因变量或响应变量,x 称为自变量或解释变量 . a 称为截距参数,b 称为斜率参数;e 是Y 与bx+a 之间的随机误差.2,()0,().Y bx a e E e D e σ=++⎧⎨==⎩① 2、一元线性回归模型如果用x 表示父亲身高,Y 表示儿子的身高,e 表示随机误差.假定随机误差e 的均值为0,方差为与父亲身高无关的定值 ,则它们之间的关系可以表示为2σ4.问题5:你能结合具体实例解释产生模型①中随机误差项的原因吗?产生随机误差e的原因有:(1)除父亲身高外,其他可能影响儿子身高的因素,比如母亲身高、生活环境、饮食习惯和锻炼时间等.(2)在测量儿子身高时,由于测量工具、测量精度所产生的测量误差.(3)实际问题中,我们不知道儿子身高和父亲身高的相关关系是什么,可以利用一元线性回归模型来近似这种关系,这种近似关系也是产生随机误差e的原因.8.2.2一元线性回归模型参数的最小二乘法估计二、自主探究问题1.为了研究两个变量之间的相关关系, 我们建立了一元线性回归模型表达式 刻画的是变量Y 与变量x 之间的线性相关关系,其中参数a 和b 未知,我们如何通过样本数据估计参数a 和b?2,()0,().Y bx a e E e D e σ=++⎧⎨==⎩问题2.我们怎样寻找一条“最好”的直线,使得表示成对样本数据的这些散点在整体上与这条直线最“接近”?从成对样本数据出发,用数学的方法刻画“从整体上看,各散点与蓝色直线最接近”利用点到直线y=bx+a 的“距离”来刻画散点与该直线的接近程度,然后用所有“距离”之和刻画所有样本观测数据与该直线的接近程度.父亲身高/cm180 175 170 165 160160 165 170 175180 185 190 ·· ·· · · · 儿子身高/cm· · · · ·185 父亲身高/cm180 175 170 165 160160 165 170 175 180 185 190·· ·· · · · 儿子身高/cm· · · · ·185设满足一元线性回归模型的两个变量的n 对样本数据为(x 1,y 1),(x 2,y 2),…,(x n ,y n )父亲身高/cm180 175170165 160160165 170 175 180 185 190·· · · · · · 儿子身高/cm· ·· · · 185()()(1,2,3,,-).i i i i i i i i i i i y bx a e i n y bx a e e x y x bx a =++=⋅⋅⋅+=+由),得(显然越小,表示点,与点,的距离越小,()0,.i i i x y =即样本数据点离直线y=bx+a 的竖直距离越小,如上图特别地,当e 时,表示点在这条直线上1-)ni i i y bx a =+∑因此可用(来刻画各样本观测数据与直线y=bx+a 的整体接近程度.()iix y ,y=bx+a()i i x bx a +,·[]21(,)()ni i i Q a b y bx a ==-+∑残差平方和: 即求a ,b 的值,使Q ( a ,b )最小残差:实际值与估计值之间的差值,即 使Q 取得最小值,当且仅当b 的取值为121()()()nii i nii xx y y b xx ==--=-∑∑b.,ˆ,ˆ的最小二乘估计叫做求得a b a b(,).x y 经验回顾直线必经过的符号相同与相关系数r b ˆ最小二乘法我们将 称为Y 关于x 的经验回归方程,也称经验回归函数或经验回归公式,其图形称为经验回归直线,这种求经验回归方程的方法叫最小二乘法.ˆˆˆy bxa =+12111=i ni n22i ni n x x y y ˆb ,x x ˆˆa x y x y x xy b .i i i i i i ΣΣx )n ΣΣ(()()n ====⎧--⎪=⎪⎨-⎪⎪--=⎩-问题2:依据用最小二乘估计一元线性回归模型参数的公式,求出儿子身高Y 关于父亲身高x 的经验回归方程.儿子的身高不一定会是177cm ,这是因为还有其他影响儿子身高的因素,回归模型中的随机误差清楚地表达了这种影响,父亲的身高不能完全决定儿子的身高,不过,我们可以作出推测,当父亲的身高为176cm 时,儿子身高一般在177cm 左右.当x=176时, ,如果一位父亲身高为176cm,他儿子长大后身高一定能长到177cm 吗?为什么?177y ≈083928957ˆy .x .=+的意义?∧b残差的定义,e a bx Y ++=一元线性回归模型,,Y y 对于通过观测得响应到的数据称量为变观测值ˆ,y通过经验回归方程得到称为预报值的ˆ.ˆey y =-残观测值减去预报值称为即差判断模型拟合的效果:残差分析问题3:儿子身高与父亲身高的关系,运用残差分析所得的一元线性回归模型的有效性吗?残差图:作图时纵坐标为残差,横坐标可以选为样本编号,或身高数据或体重估计值等,这样作出的图形称为残差图.从上面的残差图可以看出,残差有正有负,残差点比较均匀地分布在横轴的两边,可以判断样本数据基本满足一元线性回归模型对于随机误差的假设.所以,通过观察残差图可以直观判断样本数据是否满足一元线性回归模型的假设,从而判断回归模型拟合的有效性.所以,只有图(4)满足一元线性回归模型对随机误差的假设图(1)显示残差与观测时间有线性关系,应将时间变量纳入模型; 图(2)显示残差与观测时间有非线性关系,应在模型中加入时间的非线性函数部分; 图(3)说明残差的方差不是一个常数,随观测时间变大而变大图(4)的残差比较均匀地集中在以横轴为对称轴的水平带状区域内.根据一元线性回归模型中对随机误差的假定,残差应是均值为0,方差为 的随机变量的观测值.2σ观察以下四幅残差图,你认为哪一个残差满足一元线性回归模型中对随机误差的假定?1.残差等于观测值减预测值2.残差的平方和越小越好;3.原始数据中的可疑数据往往是残差绝对值过大的数据;4. 对数据刻画效果比较好的残差图特征:残差点比较均匀的集中在水平带状区域内.归纳小结(残差图中带状越窄,精度越高)1.关于残差图的描述错误的是( )A.残差图的横坐标可以是样本编号B.残差图的横坐标也可以是解释变量或预报变量C.残差点分布的带状区域的宽度越窄相关指数越小D.残差点分布的带状区域的宽度越窄残差平方和越小C 三、巩固提升2.根据如下样本数据:得到的经验回归方程为 ,则( ) A. >0, >0B. >0, <0C. <0, >0D. <0, <0 x 2 3 4 5 6 Y42.5-0.5-2-3a $a $a $a$$b $b$b$b $$ybx a =+$ B3.某种产品的广告支出费用x(单位:万元)与销售额Y(单位:万元)的数据如表:已知Y 关于x 的经验回归方程为 =6.5x+17.5,则当广告支 出费用为5万元时,残差为________. x 2 4 5 6 8Y 30 40 60 50 70$y当x=5时, =6.5×5+17.5=50,表格中对应y=60,于是残差为60-50=10.$y10一元线性回归模型的应用例1.经验表明,对于同一树种,一般树的胸径(树的主干在地面以上1.3m处的直径)越大,树就越高.由于测量树高比测量胸径困难,因此研究人员希望由胸径预测树高.在研究树高与胸径之间的关系时,某林场收集了某种树的一些数据如下表所示,试根据这些数据建立树高关于胸径的经验回归方程.编号 1 2 3 4 5 6胸径/cm 18.1 20.1 22.2 24.4 26.0 28.3树高/m 18.8 19.2 21.0 21.0 22.1 22.1编号7 8 9 10 11 12胸径/cm 29.6 32.4 33.7 35.7 38.3 40.2树高/m 22.4 22.6 23.0 24.3 23.9 24.7dh· · ·· · · · · · · · · 解: 以胸径为横坐标,树高为纵坐标作散点图如下:散点大致分布在一条从左下角到右上角的直线附近,表明两个变量线性相关,并且是正相关,因此可以用一元线性回归模型刻画树高与胸径之间的关系.0.249314.84h d =+··· ·· · · · · · · · 用d 表示胸径,h 表示树高,根据据最小二乘法,计算可得经验回归方程为0.249314.84h d =+根据经验回归方程,由胸径的数据可以计算出树高的预测值(精确到0.1)以及相应的残差,如下表所示.编号胸径/cm 树高观测值/m 树高预测值/m 残差/m1 18.1 18.8 19.4 -0.62 20.1 19.2 19.9 -0.73 22.2 21.0 20.4 0.64 24.4 21.0 20.9 0.15 26.0 22.1 21.3 0.86 28.3 22.1 21.9 0.27 29.6 22.4 22.2 0.28 32.4 22.6 22.9 -0.39 33.7 23.0 23.2 -0.210 35.7 24.3 23.7 0.611 38.3 23.9 24.4 -0.512 40.2 24.7 24.9 -0.2以胸径为横坐标,残差为纵坐标,作残差图,得到下图.30252015-1.0-0.5 0.0 0.5 1.0· · · · · · · 残差/m· · · ·· 354045胸径/cm观察残差表和残差图,可以看到残差的绝对值最大是0.8,所有残差分布在以横轴为对称轴、宽度小于2的带状区域内 .可见经验回归方程较好地刻画了树高与胸径的关系,我们可以根据经验回归方程由胸径预测树高.编号1 2 3 4 5 6 7 8 年份 1896 1912 1921 1930 1936 1956 1960 1968 记录/s 11.8010.6010.4010.3010.2010.1010.009.95例2.人们常将男子短跑100m 的高水平运动员称为“百米飞人”.下表给出了1968年之前男子短跑100m 世界纪录产生的年份和世界纪录的数据.试依据这些成对数据,建立男子短跑100m 世界纪录关于纪录产生年份的经验回归方程以成对数据中的世界纪录产生年份为横坐标,世界纪录为纵坐标作散点图,得到下图在左图中,散点看上去大致分布在一条直线附近,似乎可用一元线性回归模型建立经验回归方程.将经验回归直线叠加到散点图,得到下图:76913031.4902033743.0ˆ1+-=t y用Y 表示男子短跑100m 的世界纪录,t 表示纪录产生的年份 ,利用一元线性回归模型来刻画世界纪录和世界纪录产生年份之间的关系 . 根据最小二乘法,由表中的数据得到经验回归方程为:从图中可以看到,经验回归方程较好地刻画了散点的变化趋势,请再仔细观察图形,你能看出其中存在的问题吗?你能对模型进行修改,以使其更好地反映散点的分布特征吗?仔细观察右图,可以发现散点更趋向于落在中间下凸且递减的某条曲线附近.回顾已有的函数知识,可以发现函数y=-lnx的图象具有类似的形状特征注意到100m短跑的第一个世界纪录产生于1896年, 因此可以认为散点是集中在曲线y=f(t)=c1+c2ln(t-1895)的周围,其中c1、c2为未知参数,且c2<0.y=f(t)=c1+c2ln(t-1895)这是一个非线性经验回归函数,如何利用成对数据估计参数c1、c2令x=ln(t-1895),则Y=c2x+c1对数据进行变化可得下表:编号 1 2 3 4 5 6 7 8 年份/t 1896 1912 1921 1930 1936 1956 1960 1968 x 0.00 2.83 3.26 3.56 3.71 4.11 4.17 4.29 记录/s 11.80 10.60 10.40 10.30 10.20 10.10 10.00 9.95将x=ln(t-1895)代入:得 8012653.114264398.0ˆ2+-=x y上图表明,经验回归方程对于成对数据具有非常好的拟合精度.将经验回归直线叠加到散点图,得到下图: 8012653.114264398.0ˆ2+-=x y8012653.11)1895ln(4264398.0ˆ2+--=t y经验回归方程为对于通过创纪录时间预报世界纪录的问题,我们建立了两个回归模型,得到了两个回归方程,你能判断哪个回归方程拟合的精度更好吗?8012653.114264398.0ˆ2+-=x y① 2ˆ0.4264398ln(1895)11.8012653y t =--+② 我们发现,散点图中各散点都非常靠近②的图象, 表明非线性经验回归方程②对于原始数据的拟合效果远远好于经验回归方程①.(1).直接观察法.在同一坐标系中画出成对数据散点图、非线性经验回归方程②的图象(蓝色)以及经验回归方程①的图象(红色).28212811ˆ,ˆQ Q (()0.004)0.669i i i i eu ===≈=≈∑∑8012653.114264398.0ˆ2+-=x y① 2ˆ0.4264398ln(1895)11.8012653yt =--+②(2).残差分析:残差平方和越小,模型拟合效果越好.Q 2明显小于Q 1,说明非线性回归方程的拟合效果 要优于线性回归方程.R 2越大,表示残差平方和越小,即模型的拟合效果越好 R 2越小,表示残差平方和越大,即模型的拟合效果越差. 21212ˆ()11()n i i nii i y y y y R ==-=-=--∑∑残差平方和。

§2.2 一元线性回归模型的参数估计

β 0 = Y β1 X

例2.2.1:在上述家庭可支配收入-消费支出例中,对 :在上述家庭可支配收入-消费支出例中, 于所抽出的一组样本数, 于所抽出的一组样本数,参数估计的计算可通过下面的 进行。 表2.2.1进行。 进行

表 2.2.1 数 计 计 参 估 的 算表

Xi

Yi

xi

1

的样本方差: 2 = σ 2 x 2 / n ( x x )2 ∑ i ∑ i β0 Sβ

0

β1 =

∑x y ∑x

i 2 i

i

5769300 = = 0.777 7425000

β 0 = Y β 0 X = 1567 0.777 × 2150 = 103.172

因此,由该样本估计的回归方程为:

Yi = 103.172 + 0.777 X i

三、最小二乘估计量的性质

(1)线性性,即它是否是另一随机变量的线性 )线性性, 函数; 函数; (2)无偏性,即它的均值或期望值是否等于总 )无偏性, 体的真实值; 体的真实值; (3)有效性,即它是否在所有线性无偏估计量 )有效性, 中具有最小方差。 中具有最小方差。

中,最小二乘估计量 β 0 、 β1 具有最小方差。

(2)证明最小方差性

β 1* 是其他估计方法得到的关于β1 的线性无偏估计量: 假设

β 1* = ∑ ci Yi

其中,ci=ki+di,di为不全为零的常数 则容易证明

var(β 1* ) ≥ var(β 1 )

同理,可证明β0 的最小二乘估计量 β 0 具有最的小方差

-973 1314090 1822500 947508 640000 352836 -929 975870 1102500 863784 1210000 407044 -445 334050 562500 198381 1960000 1258884 -412 185580 202500 170074 2890000 1334025 -159 23910 22500 25408 4000000 1982464 28 4140 22500 762 5290000 2544025 402 180720 202500 161283 6760000 3876961 511 382950 562500 260712 8410000 4318084 1018 1068480 1102500 1035510 10240000 6682225 963 1299510 1822500 926599 12250000 6400900 5769300 7425000 4590020 53650000 29157448

一元线性回归模型的参数估计法的误差分析

一元线性回归模型的参数估计法的误差分析

一元线性回归模型是当前最为常用的统计学模型之一,被广泛应用于商业分析、金融投资预测、互联网用户行为分析等不同的领域。

而参数估计是这些模型最基础也是最关键的一步,因此误差分析在此过程中也十分重要。

一元线性回归模型的参数估计误差通常主要由两部分组成:拟合误差和估计误差。

拟合误差指的是拟合的参数和真实参数的偏离度,表现为模型在训练数据上表现出来的表型;而估计误差则指的是训练数据和测试数据之间的表型差异,表现为模型在未知数据上表现的表型。

就拟合误差而言,大多数的参数估计方法都试图拟合数据,期望在训练数据上

得到最小的拟合误差,并且拟合模型的参数有可能不可以推广到未知数据上表现。

在模型参数估计这一过程中,光考虑拟合误差是不够的,必须要考虑到模型参数在未知数据上的表现,这也就要求我们在估计参数之前先进行泛化性能分析,以免使模型过拟合于给定数据,从而导致估计参数的推广能力变差。

同时,要有效的控制参数估计的误差,还要注意几项重要的考量:一是训练数

据的质量和数量;二是参数估计算法本身的问题,比如该算法是否属于正则化算法,假若使用的算法是正则化算法,则应当考虑使用正则化参数以控制模型的复杂度;另外,确定参数估计的衡量标准,比如前面提到的拟合误差和估计误差,或者准确率、召回等标准也要纳入考虑范围。

总而言之,一元线性回归模型的参数估计误差分析对于一个模型性能优劣有着

至关重要的作用。

在进行参数估计之前,需要考虑到拟合误差和估计误差,以及几个重要的因素,如训练数据的质量、数量、参数估计的衡量标准等。

此外,在估计参数的过程中,为了控制参数估计的误差,模型设置正则化参数也是必要的。

2.2 一元线性回归模型的参数估计

于是,Y的概率函数为

P(Yi ) = 1

− 1 2σ

2

ˆ ˆ (Yi − β 0 − β1 X i ) 2

σ 2π

e

(i=1,2,…n)

4/29/2012

14

因为Yi是相互独立的,所以的所有样本观测值的联 合概率,也即或然函数(likelihood function) 或然函数(likelihood function)为: 或然函数

§2.2 一元线性回归模型的参数估计

一、一元线性回归模型的基本假设 二、参数的普通最小二乘估计(OLS) 参数的普通最小二乘估计(OLS) 参数估计的最大或然法(ML) 三、参数估计的最大或然法(ML) * 四、最小二乘估计量的性质 五、参数估计量的概率分布及随机干扰项方差的估计

4/29/2012

1

640000 352836 1210000 407044 1960000 1258884 2890000 1334025 4000000 1982464 5290000 2544025 6760000 3876961 8410000 4318084 10240000 6682225 12250000 6400900 53650000 29157448

4/29/2012

-973 1314090 1822500 947508 -929 975870 1102500 863784 -445 334050 562500 198381 -412 185580 202500 170074 -159 23910 22500 25408 28 4140 22500 762 402 180720 202500 161283 511 382950 562500 260712 1018 1068480 1102500 1035510 963 1299510 1822500 926599 5769300 7425000 4590020

一元线性回归模型的参数估计

斜率(β1)

表示 x 每变化一个单位,y 平均变化的数量。

一元线性回归模型的假设

线性关系

因变量 y 和自变量 x 之间存在线性关系。

误差项独立

误差项 ε 之间相互独 立,且与 x 独立。

误差项的正态性

误差项 ε 的分布是正 态的。

误差项的无偏性

误差项 ε 的期望值为 0,即 E(ε) = 0。

有限的方差

回归分析的分类

一元回归分析

研究一个自变量和一个因变量之间的关系。

多元回归分析

研究多个自变量和一个因变量之间的关系。

线性回归模型

线性回归模型是一种常用的回归分析方法,它假设自变量和因变量之间存在线性关系,即可以用一条 直线来描述它们之间的关系。

在一元线性回归模型中,自变量和因变量之间的关系可以表示为一条直线,即 y = ax + b,其中 a 是斜 率,b 是截距。

确定样本数据

收集用于估计参数的样本数据。

构建估计量

根据模型和样本数据构建用于估计参数的统计量。

计算估计值

通过计算统计量的值得到参数的估计值。

评估估计质量

通过统计检验和图形方法评估估计的质量和可靠性。

05 模型的评估与检验

模型的拟合度评估

决定系数(R^2)

衡量模型解释变量变异程度的指标,值越接 近1表示模型拟合度越好。

数据整理

将数据整理成适合进行统计分析 的格式,如表格或图形,以便后 续分析。

建立一元线性回归模型

确定自变量和因变量

根据研究问题选择合适的自变量和因变量,确 保它们之间存在一定的关联性。

散点图分析

绘制散点图,观察自变量和因变量之间的关系, 初步判断是否适合建立一元线性回归模型。

一元线性回归模型的参数检验

模型拟合的质量检验

1

残差分析

通过分析模型的残差,可以评估模型对数据的拟合程度。较小的残差表示模型拟合较好。

2

参数的显著性检验

通过t检验或F检验,判断模型参数是否显著。显著的参数表示自变量对因变量的影响是真实 存在的解释程度。取值范围为0到1,越接近1表示模型拟合的越 好。

残差分析

残差分析是评估一元线性回归模型拟合质量的重要方法。通过分析残差的分 布、模式和异常值,可以判断模型是否可靠。

参数的显著性检验

在一元线性回归模型中,参数的显著性检验是判断自变量对因变量的影响是否显著的方法。常用的方法有t检 验和F检验。

t检验的基本原理

t检验是一种用于检验样本均值与总体均值之间差异的统计方法。在一元线性 回归模型中,用于检验参数估计值与真实值之间的差异。

一元线性回归模型的参数 检验

在统计学中,一元线性回归模型是一种用于描述两个变量之间线性关系的模 型。本节将介绍一元线性回归模型的参数检验方法。

什么是一元线性回归模型?

一元线性回归模型用于分析一个自变量与一个因变量之间的线性关系。它通 过拟合一个直线来描述这种关系,并根据模型参数进行推断和解释。

数据预处理

在进行一元线性回归之前,需要对数据进行预处理,包括数据清洗、缺失值 处理和异常值检测。通过这些步骤,可以确保模型建立在可靠的数据基础上。

拟合一元线性回归模型

通过最小化残差平方和来拟合一元线性回归模型。这可以通过最小二乘法来 实现,求解模型参数使得预测值与观测值的差异最小。

模型参数的估计

一元线性回归模型的参数估计使用普通最小二乘法。通过计算样本数据的协 方差和方差,可以得到模型参数的估计值。

一元线性回归模型的参数估计分析

整理得:

ˆ ˆ X )0 ( Y i 0 1 i ˆ ˆ X )X 0 ( Y i 0 1 i i

即:

ˆ ˆ Y n 0 1 Xi i 2 ˆ ˆ X iYi 0 X i 1 X i

• 对于给定的样本观测值,可以用无数条直线来 拟合。

ˆ的差,即残差e 越小越好 最好的直线应使Yi与Y i i

因ei可正可负,所以取ei2最小

ˆ ˆ X )2 即min( ei2 ) min (Yi 0 1 i

2.最小二乘估计量的推导

记 ˆ ˆ X )2 Q ei2 (Yi 0 1 i

根据微积分中多元函数求极值的方法,求Q关于 ˆ 和 ˆ 的一阶偏导并令其等于0得:

0 1

Q ˆ ˆ X )0 2 ( Y i 0 1 i ˆ 0 ˆ ˆ X )X 0 Q 2 (Y i 0 1 i i ˆ 1

1.为什么要作基本假定?

(1)只有具备一定的假定条件,所作出的估计才 具有较好的统计性质。

(2)模型中有随机扰动,估计的参数是随机变量, 只有对随机扰动的分布作出假定,才能确定所估计 参数的分布性质,也才可能进行假设检验和区间估 计。 2. 基本假定的内容

假定1:解释变量X 0 1 X i

假定3:等方差假定。Var(Yi ) 2

假定4:无自相关假定。Cov(Yi , Yj ) 0(i j)

假定5:正态性假定。Yi ~ N (0 1 X i , 2 )

三、参数的普通最小二乘估计(OLS)

1.OLS的基本思想

第二节 一元线性回归模型的参数估计

• • • • • • 一元线性回归模型的概念 一元线性回归模型的基本假定 参数的普通最小二乘估计 截距为零的一元线性回归模型的估计 最小二乘估计量的性质 参数估计量的概率分布

§2.1 线性模型的参数估计

第2章 线性回归模型§2.1 线性模型的参数估计2.1.1 线性模型的最小二乘估计一、一元线性回归模型的最小二乘估计(OLS ) 总体回归模型: 12i i i Y X ββε=++,1,...,i n = 被解释变量i Y ,解释变量i X ,随机误差项i ε的含义 参数12ββ和的含义样本回归模型: 12ˆˆi i iY X e ββ=++,1,...,i n = 残差:12ˆˆi i ie Y X ββ=-- 残差平方和: ()212ˆˆ2i i ie Y X ββ=--∑∑最小二乘法:()1212212ˆˆˆˆ,,ˆˆmin min 2i i i e Y X ββββββ=--∑∑()()121122ˆˆ2=0ˆˆˆ2=0ˆ2i i i2i i i i e Y X e Y X X ββββββ⎧∂=---⎪∂⎪⎨∂⎪=---⎪∂⎩∑∑∑∑ 正则方程:122ˆˆi i iii i n X Y X XX Y ββ⎡⎤⎡⎤⎡⎤=⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦⎣⎦∑∑∑∑∑ 最小二乘估计量:1222ˆˆˆi i i Y X X Y nXY X nX βββ⎧=-⎪-⎨=⎪-⎩∑∑ 二、多元线性回归模型的最小二乘估计(OLS )(一) 线性回归模型的矩阵形式12233...i i i K Ki i Y X X X ββββε=+++++, 1,...,i n =解释变量23,,...,i i Ki X X X参数12,,...,K βββ的含义,称2,...,K ββ为偏回归系数()2312233,,...,...i i i Ki i i K Ki E Y X X X X X X ββββ=++++K 维空间中K - 1维空间平面。

1122133111212223322212233...for 1...for 2.........for K K K K n n n n K n K Y X X X i Y X X X i Y X X X i nββββεββββεββββε=+++++==+++++==+++++=12111122222221...1 (1)...K K n n n n K K Y X X Y X X Y X X εβεβεβ⎡⎤⎡⎤⎡⎤⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥=+⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦⎣⎦⎣⎦记12111122222221...1...,,,.....................1...K K n nn K Kn Y X X Y X X Y X X εβεβεβ⎡⎤⎡⎤⎡⎤⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥≡≡≡≡⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦⎣⎦⎣⎦Y X βε,用粗体表示向量或矩阵,常规粗细表示标量。

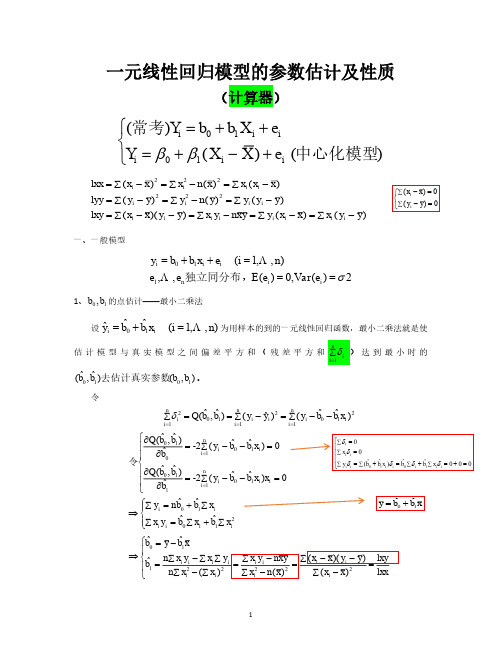

一元线性回归模型的参数估计及性质

(i 1, , n) 为用样本的到的一元线性回归函数,最小二乘法就是使

n i 1

估 计 模 型 与 真 实 模 型 之 间 偏 差 平 方 和 ( 残 差 平 方 和 i ) 达 到 最 小 时 的

ˆ ,b ˆ (b 0 1 )去估计真实参数(b0 , b1 ) 。

令

i 1

ˆ ,b ˆ ˆ ˆ ˆ i Q(b 0 1 ) ( yi yi ) ( yi b0 b1 xi )

2 2 2

i 1

ˆ b ˆ x b ˆ b ˆ x) ˆ i ) ( yi y ) ( y ˆ i y ) ( y i y ) (b i ( yi y 0 1 i 0 1 ˆ 2 ( x x ) 2 lyy (lxy ) lxx lyy (lxy ) ( yi y ) 2 b 1 i lxx (lxx ) 2 ˆ 2 (n 1) S 2 (n 1) S 2 b

②若 ei ~ N (0, 2 ) ,有

i

n 2

i 1

2

~ 2 (n 2)

③“残差” i 是随机误差的一种反应,如果在模型正确的前提下,“残差” i 应该是杂乱无章 没有规律性的,如果呈现出某种规律性,则可能是模型中某方面的假定与事实不符。

四、拟合优度——可决系数 R

2

(一般模型)

ˆ y b ˆ 也是 y 的线性组合。 ˆ x ,所以出 b ˆ 是 y 的线性组合,又 b 可以看出 b 0 0 1 i i 1

还有 ki

( xi x ) ( xi x ) ( xi x ) ( xi x ) xi 0 ; ki xi x 1. 2 2 2 i ( xi x ) ( xi x ) ( xi x ) ( xi x ) xi

一元线性回归模型的参数估计实验报告

一元线性回归模型的参数估计实验报告一、实验目的通过实验了解一元线性回归模型,理解线性回归模型的原理,掌握回归系数的计算方法和用途,并运用Excel对一组数据进行一元线性回归分析,并解释拟合结果。

二、实验原理1.一元线性回归模型一元线性回归模型是指只有一个自变量和一个因变量之间存在线性关系,数学为:`Y = β0 + β1X + ε`其中,Y表示因变量的数值,X表示自变量的数值,β0和β1分别是系数,ε表示误差项。

系数是待求的,误差项是不可观测和无法准确计算的。

2.回归系数的计算方法回归系数通常使用最小二乘法进行计算,最小二乘法是一种通过最小化误差平方和来拟合数据的方法。

具体计算方法如下:(1)计算X的平均值和Y的平均值;(2)计算X和Y的样本标准差;(3)计算X和Y的协方差以及相关系数;(4)计算回归系数β1和截距β0;三、实验步骤1.导入实验数据将实验数据导入Excel,并进行清理。

2.绘制散点图在Excel中绘制散点图,判断是否存在线性关系。

3.计算相关系数通过Excel的相关系数函数计算出X和Y的相关系数。

通过Excel的回归分析函数计算出回归方程。

5.分析结果分析回归方程的拟合程度以及回归系数的意义。

四、实验结果1.数据准备通过Excel的回归分析函数,计算出回归系数为β0=1.1145,β1=2.5085,回归方程为`Y=1.1145+2.5085X`,如下图所示:(1)拟合程度:相关系数为0.870492,说明自变量和因变量之间存在一定的线性关系,回归方程的拟合程度较好。

(2)回归系数的意义:截距为1.1145,表示当自变量为0时,因变量的值为1.1145;回归系数为2.5085,表示自变量增加1个单位,因变量会增加2.5085个单位。

一元线性回归模型的参数估计

(2.2.4) (2.2.5)

或

ˆ ˆ ΣYi = nβ 0 + β1ΣX i 2 ˆ ˆ ΣYi X i = β 0 ΣX i + β1ΣX i

但是,随机误差项的方差的估计量是不同的。 是不同的

解或然方程

∂ * n 1 ˆ ˆ L =− 2 + Σ(Yi − β 0 − β 1 X i ) 2 = 0 2 4 ∂σ µ 2σ µ 2σ µ

2 σ µ 的最大或然估计量为: 即可得到

1 ˆ ˆ ˆ2 σ µ = Σ(Yi − β 0 − β 1 X i ) 2 = n

于是, Yi 的概率函数为

P (Yi ) = 1

− 1 2σ µ

2

ˆ ˆ (Yi − β 0 − β1 X i ) 2

σ 2π

e

i=1,2,…,n

因为 Yi 是相互独立的, 所以 Y 的所有样本观测值的联合概率, 也即或然函数 或然函数(likelihood function)为: 或然函数

ˆ ˆ 2 L( β 0 , β1 ,σ µ ) = P(Y1 , Y2 ,⋅ ⋅ ⋅, Yn )

解得模型的参数估计量为:

ˆ ΣX i2 ΣYi − ΣX i ΣYi X i β 0 = nΣX i2 − (ΣX i ) 2 ˆ β 1 = nΣYi X i − ΣYi ΣX i nΣYi 2 − (ΣX i ) 2

可见,在满足一系列基本假设的情况下, 可见,在满足一系列基本假设的情况下,模型结构参 数的 最大或然估计量 与 普通最小二乘估计量 是相同 的。

一元线性回归模型的参数估计

散点图

某居民小区家庭收入(X)与消费支出(Y)

Y

1500

的散点图

1300

1100

900

Yˆ = aˆ + bˆX

700

500

X

600

1100

1600

2100

最小二乘准则

Y

.(Xi,Yi)

. Yˆ = aˆ + bˆX (X j ,Yˆj )

ei

. . (Xi,Yˆi)

0

. ej

(Xj,Yj)

X

min

参数估计计算表

Yi

xi

yi

3637 3919 4185 4331 4616 4998 5359 6030

37075

-1517.4 -961.4 -640.4 -375.4 53.6 479.6 1058.6 1902.6 ——

-997.4 -715.4 -449.4 -303.4 -18.4 363.6 724.6 1395.6 ——

X = X i = 46403 = 5800.375

n

8

Y = Yi = 37075 = 4634.375

n

8

根据表 2 合计栏的数据及以上关于 X 和Y 的计

算结果可得:

bˆ1 =

xi yi = 6198658.9 0.7083 xi2 8751239.9

bˆ0 = Y - bˆ1 X 525.8662

2.对回归系数(斜率)进行统计假设检验,信度为 0.05。

3.估计可决系数并进行统计假设检验,信度为 0.05。

4.若下一年度居民货币收入为 25.5 亿元,预测购买消费品

支出的金额及预测区间,信度为 0.05。

一元线性回归模型的参数估计实验报告

山西大学实验报告实验报告题目:计量经济学实验报告学院:专业:课程名称:计量经济学学号:学生姓名:教师名称:崔海燕上课时间:一、实验目的:掌握一元线性回归模型的参数估计方法以及对模型的检验和预测的方法。

二、实验原理:1、运用普通最小二乘法进行参数估计;2、对模型进行拟合优度的检验;3、对变量进行显著性检验;4、通过模型对数据进行预测。

三、实验步骤:(一)建立模型1、新建工作文件并保存打开Eviews软件,在主菜单栏点击File\new\workfile,输入start date 1978和end date 2006并点击确认,点击save键,输入文件名进行保存。

2输入并编辑数据在主菜单栏点击Quick键,选择empty\group新建空数据栏,先输入被解释变量名称y,表示中国居民总量消费,后输入解释变量x,表示可支配收入,最后对应各年分别输入数据。

点击name键进行命名,选择默认名称Group01,保存文件。

得到中国居民总量消费支出与收入资料:年份X Y19786678.83806.719797551.64273.219807944.24605.5198184385063.919829235.25482.4198310074.65983.21984115656745.7198511601.77729.2198613036.58210.9198714627.788401988157949560.5198915035.59085.5199016525.99450.9199118939.610375.8199222056.511815.3199325897.313004.7199428783.413944.2199531175.415467.9199633853.717092.5199735956.218080.6199838140.919364.119994027720989.3200042964.622863.92001 46385.4 24370.1 2002 51274 26243.2 2003 57408.1 28035 2004 64623.1 30306.2 2005 74580.4 33214.4 2006 85623.1 36811.2注:y 表示中国居民总量消费 x 表示可支配收入3、 画散点图,判断被解释变量与解释变量之间是否为线性关系在主菜单栏点击Quick\graph 出现对话框,输入 “x y ”,点击确定。

计量经济学【一元线性回归模型——参数估计】

ˆ0计量ˆ1 和

可以分别表示为被解释变量观测Y值i

的线

性组合(线性函数);

ˆ证1 明

如( X下i : X )(Yi (Xi X )2

Y

)

(Xi X) (Xi X )2

(Yi

Y

)

ki (Yi Y )

其中ki :

(Xi X) (Xi X )2

ki

对ki于引0 进的 ki (X容i 易X证) 明有k如i X下i 的1 特性k:i2

2

,

,

,

,

,

,

,

,

i

1,

2,

n

假设3:随机误差项在不同样本点之间是独立的,不

存

Cov(i , j ) 0,,,,,,,i j,,,,i, j 1, 2, n

在序列相关,即:

一、一元线性回归模型的基本假设

假设 4:随机误差项与解释变量之间不相关, 即:

Cov( Xi , i ) 0,,,,,,,,,,,i 1, 2, n

:待估

E(Y

总样体本回回归归函函数数形形式式::Yˆi

| Xi)

ˆ0

0 ˆ1X i

1X i

其 计

中 估

方

ˆ0 , ˆ1 法ˆ0,, ˆ1求

是ˆ00,,ˆ11 出

的估计值,我们需要找到一种参数 , 并0 ,且1 这 种 参 数 估 计 方 法 保 证 了 估

计值 数

与总体真值

尽可能地接近;这种参

i

根据微 小,

积

分中

ˆ0 , ˆ1

求

极

值

的

原

理

,

要

使 i

ei2

待定系数

一元线性回归模型的参数估计

记 Q ei2 (Yi ˆ0 ˆ1Xi )2

根据微积分中多元函数求极值的方法,求Q关于

ˆ0和ˆ1的一阶偏导并令其等于0得:

Q

ˆ0

2

(Yi ˆ0 ˆ1Xi ) 0

Q

ˆ1

2

(Yi ˆ0 ˆ1Xi )Xi 0

整理得:

即:

(Yi ˆ0 ˆ1Xi ) 0

(Yi ˆ0 ˆ1Xi )Xi 0

5.样本回归函数的离差形式

记

yˆi Yˆi Y

将ˆ0

Y

ˆ1X代入Yˆi

ˆ0

ˆ1

X

可得

i

Yˆi Y ˆ1X ˆ1Xi

整理得 Yˆi Y ˆ1(Xi X )

写成离差形式为:

yˆi ˆ1xi

6.注意几个概念的区别

随机误差项:被解释变量的观测值与它的条件期望 的差

残差:被解释变量的观测值与它的拟合值的差,是 随机误差项的估计值

第二节 一元线性回归模型的参数估计

• 一元线性回归模型的概念 • 一元线性回归模型的基本假定 • 参数的普通最小二乘估计 • 截距为零的一元线性回归模型的估计 • 最小二乘估计量的性质 • 参数估计量的概率分布

一、一元线性回归模型的概念

一元线性回归模型是最简单的计量经济学模型,在 模型中只有一个解释变量,其一般形式是:

3.Y的分布性质: 由于Yi 0 1Xi ui,ui的分布性质决定了Yi的分布

性质,对于ui的一些假定可以等价地表示为对Yi的一 些假定:

假定2:零均值假定。E(Yi ) 0 1Xi 假定3:等方差假定。Var(Yi ) 2

假定4:无自相关假定。Cov(Yi ,Yj ) 0(i j) 假定5:正态性假定。Yi ~ N (0 1Xi , 2 )

一元线性回归模型及参数估计

步骤:收集数据、建立模型、 计算参数、评估模型

优点:简单易行,适用于线 性回归模型

最大似然估计法

定义:最大似然 估计法是一种基 于概率的参数估 计方法,通过最 大化样本数据的 似然函数来估计

参数。

原理:利用已知 样本数据和概率 分布函数,计算 出样本数据出现 的概率,然后选 择使得概率最大 的参数值作为估

参数估计的性质

无偏性

定义:参数估计量是 无偏估计时,其期望 值等于参数的真实值。

性质:无偏性是线性 回归模型参数估计的 最基本性质之一,是 评价估计量优劣的重 要标准。

证明:可以通过数学 推导证明无偏性,具 体过程可以参考相关 教材或论文。

应用:在回归分析中, 无偏性可以保证估计 的参数具有最小误差, 从而提高预测的准确 性和可靠性。

计值。

优点:简单易行, 适用于多种分布 类型的数据,具

有一致性。

局限:对样本数 据的要求较高, 当样本数据量较 小或分布不均时, 估计结果可能不

准确。

最小绝对误差准则

定义:最小化预测值与实际值之间的绝对误差

优点:对异常值不敏感,能够更好地处理数据中的噪声和异常值

缺点:可能导致模型过于复杂,过拟合数据 应用场景:适用于预测连续变量,尤其是当因变量和自变量之间的关系是 非线性的情况

行处理。

处理方法:包括 删除不必要的自 变量、合并相关 性较高的自变量、 使用其他模型等

方法。

模型预测与决策应用

预测未来趋势

利用一元线性回 归模型预测未来 趋势

模型参数估计的 方法和步骤

预测结果的解读 与决策应用

模型预测的局限 性及改进方法

制定决策依据

利用回归方程进行 预测

ห้องสมุดไป่ตู้

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

– 参数估计与OLS估计相同。

• 由基本假设,写出两个总体矩条件

E ( i ) 0 Cov( X i , i ) E( X i i ) 0

• 相应的样本矩条件构成正规方程组

1 n 1 n

ˆ ˆ X 0 Y ˆ ˆ X 0 X Y

– 渐近有效性,即样本容量趋于无穷大时,是否它在 所有的一致估计量中具有最小的渐近方差。

2、高斯—马尔可夫定理(Gauss-Markov

4、“估计量”(estimator)和“估计值”

(estimate)的区别

• 如果给出的参数估计结果是由一个具体样本资料 计算出来的,它是一个“估计值”,或者“点估 计”,是参数估计量的一个具体数值;

• 如果把上式看成参数估计的一个表达式,那么, 则是Yi的函数,而Yi是随机变量,所以参数估计 也是随机变量,在这个角度上,称之为“估计 量”。

ˆ ˆ X )0 (Yi 0 1 i ˆ ˆ X )X 0 ( Y 0 1 i i i

• 该关于参数估计量的线性方程组称为正规方程 组(normal equations)。

3、参数估计量

• 求解正规方程组得到结构参数的普通最小二乘 估计量(ordinary least squares estimators) 及其离差形式:

ˆ X i2 Yi X i Yi X i 0 2 2 nX i (X i ) n Y X Y X i i i i ˆ 1 2 2 n X ( X ) i i

ˆ xi yi 1 2 x i ˆ Y ˆX 1 0

1 (2 ) n

n 2

1 2

e

ˆ ˆ X )2 ( Y i 0 1 i 2

Y的所有样 本观测值的 联合概率— 似然函数

L* ln(L) n ln( 2 ) 1 2

2

ˆ ˆ X )2 (Yi 0 1 i

对数似然 函数

ˆ ˆ X )2 0 ( Y i 0 1 i ˆ 0 ˆ ˆ X )2 0 (Yi 0 1 i ˆ 1

• 这三个准则也称作估计量的小样本性质。拥有 这类性质的估计量称为最佳线性无偏估计量 (best liner unbiased estimator, BLUE)。

• 当不满足小样本性质时,需进一步考察估计量 的大样本或渐近性质(asymptotic properties):

– 渐近无偏性,即样本容量趋于无穷大时,是否它的 均值序列趋于总体真值; – 一致性,即样本容量趋于无穷大时,它是否依概率 收敛于总体的真值;

i 0 1 i i i 0 1 i

• MM估计

四、最小二乘估计量的性质

1、概述

• 当模型参数估计出后,需考虑参数估计值的精 度,即是否能代表总体参数的真值,或者说需 考察参数估计量的统计性质。 • 准则:

– 线性性(linear),即它是否是另一随机变量的线性 函数; – 无偏性(unbiased),即它的均值或期望值是否等 于总体的真实值; – 有效性(efficient),即它是否在所有线性无偏估计 量中具有最小方差。

• ML必须已知随机项的分布。

2、估计步骤

ˆ ˆ X , ) Yi ~ N ( 0 1 i

2

Yi的分布

P (Yi )

1

1 2

2

e

ˆ ˆ X )2 ( Y i 0 1 i 2

Yi的概率函数

Hale Waihona Puke ˆ , ˆ , 2 ) P(Y , Y , , Y ) L( 0 1 1 2 n

1、最小二乘原理

• 根据被解释变量的所有观测值与估计值之差的 平方和最小的原则求得参数估计量。

ˆ ˆ X ))2 ˆ )2 (Y ( MinQ (Yi Y i i 0 1 i

1 1 n n

• 为什么取平方和?

2、正规方程组

Q 0 ˆ 0 Q 0 ˆ 1

• 但是,分布参数的估计结果不同。

2 e i

ˆ2 ML :

n

ˆ2 OLS :

2 e i

n2

4、例题

• ML估计

三、参数估计的矩法(MM)

• 矩估计的基本原理是用相应的样本矩来估计总体 矩。

– 对一元线性回归模型,在满足基本假设时,存在两个 总体矩条件。 – 相应的样本矩条件构成关于待估参数的正规方程组。 – 求解该方程组,得到参数估计。

ˆ X i2 Yi X i Yi X i 0 nX i2 (X i ) 2 ˆ nYi X i Yi X i 1 2 2 n X ( X ) i i

对数似然函 数极大化的 一阶条件

结构参数的 ML估计量

3、讨论

• 在满足一系列基本假设的情况下,模型结构参 数的最大似然估计量与普通最小二乘估计量是 相同的。

5、例题(采用Eviews进行OLS估计)

• 数据

• OLS估计

二、参数估计的最大似然法(ML)

1、最大似然法

• 最大似然法(Maximum Likelihood,ML),也 称最大或然法,是不同于最小二乘法的另一种 参数估计方法,是从最大或然原理出发发展起 来的其它估计方法的基础。

• 基本原理:当从模型总体随机抽取n组样本观 测值后,最合理的参数估计量应该使得从模型 中抽取该n组样本观测值的概率最大。

一元线性回归模型的参数估计

(Estimation of Simple Linear Regression

Model)

一、参数的普通最小二乘估计(OLS) 二、参数估计的最大或然法(ML) 三、参数估计的矩法(MM) 四、最小二乘估计量的性质 五、参数估计量的概率分布及随机干 扰项方差的估计

一、参数的普通最小二乘估计(OLS)