系统综合应用开发大作业

电磁波隐身技术的研究

电磁散射与隐身技术导论课程大作业报告学院:电子工程学院专业:电磁场与无线技术班级: 021061学号: 02106020姓名:赖贤军电子邮件: 92065436@日期: 2013 年 06 月成绩:指导教师:姜文电磁波隐身技术的研究隐形技术(stealth technology)俗称隐身技术,精确的术语应该是“低可探测技术”(low-observable technology)。

即通过研究利用各种不同的技术手法来改变己方目标的可探测性信息特征,最大程度地降低被对方探测系统发现的概率,使己方目标以及己方的武器装备不被敌方的探测系统发现和探测到。

1.隐身技术及其历史背景现代无线电技术和雷达探测系统的迅速发展极大地提高了战争中的搜索、跟踪目标的能力,传统的作战武器所受到的威胁愈来愈严重。

隐身技术作为提高武器系统生存、突防以及纵深打击能力的有效手段已经成为集陆、海、空、天、电、磁六维一体的立体化现代战争中最为重要、最为有效的突防战术技术手段并受到世界各国的高度重视。

隐身技术(又称目标特征信号控制技术)是通过控制武器系统的信号特征使其难以被发现、识别和跟踪打击的技术。

它是针对探测技术而言的,在兵器研制过程中设法降低其可探测性,使之不易被敌方发现、跟踪和攻击的专门技术。

简言之隐身就是使敌方的各种探测系统(如雷达等)发现不了我方的飞机,无法实施拦截和攻击。

早在第二次世界大战期间,美国便开始使用隐身技术以减少飞机被敌方雷达发现的概率。

当前电磁波隐身的研究重点是雷达隐身技术和红外隐身技术。

由于在未来战争中雷达仍将是探测目标的最可靠手段,因此隐身技术研究以目标的雷达特征信号控制为重点,同时展开红外、声、视频等其它特征信号控制的研究工作,最后向多功能、高性能的隐身方向发展。

2.隐身技术的工作原理隐身技术的主要就是反雷达探测。

雷达是一种利用无线电波发现目标并测定其他位置的装置。

雷达的问世使人类的探测技术和能力跨上了新的台阶,同时也向反探测技术提出了新的挑战。

管理信息系统参考作业答案

北京化工大学北方学院2010—-2011学年第二学期《管理信息系统(40学时)》期末考试大作业一、简答(每题5分,共20分)1.信息系统的生命周期包括哪几个阶段?其中系统开发阶段的三个主要任务及其内容是什么?管理信息系统建设的生命周期,可以分成系统规划、系统分析、系统设计、系统实施、系统运行与支持等几个阶段。

系统规划是管理信息系统建设的起始阶段。

这一阶段的主要任务是:根据组织的整体目标和发展战略,确定管理信息系统的发展战略,明确组织总的信息需求,制订管理信息系统建设总计划,其中包括确定拟建系统的总体目标、功能、大致规模和粗略估计所需资源。

根据需求的轻、重、缓、急程度及资源和应用环境的约束,把规划的系统建设内容分解成若干开发项目以分期分批进行系统开发。

并进行系统的初步调查和系统开发的可行性研究。

系统分析阶段的主要工作是根据系统规划阶段确定的拟建系统总体方案和开发项目的安排,对系统进行组织结构分析、业务流程分析、数据流程分析、处理功能分析,建立系统逻辑模型。

系统分析的主要任务是明确用户的信息需求,提出新系统的逻辑方案。

需要进行的工作有现行系统的详细调查及新系统逻辑模型的提出等。

系统设计的主要任务是根据新系统的逻辑方案进行软、硬件系统的设计,包括总体结构设计、输出设计、输入设计、处理过程设计、数据存储设计和计算机系统方案的选择等。

系统实施将设计的系统付诸实施,主要工作有应用程序编制或软件包的购置、计算机与通信设备的购置,系统的安装、调试与测试、新旧系统的转换及评估等。

系统运行与支持,每个系统开发项目完成后即投入应用,进入正常运行和支持阶段。

在此阶段,开发者和用户一道支持管理信息系统的运行.一般说来,这是系统生命周期中历时最久的阶段,也是管理信息系统实现其功能、发挥其效益的阶段。

分为4个阶段:产生、开发、运行、消亡1—产生阶段:即其概念阶段或需求阶段,这一阶段分为两个过程,一是概念的产生过程(根据企业经营管理的需要,提出建设信息系统的初步想法)二是需求分析过程(即对企业信息系统的需求进行深入调研和分析,并形成《需求规格说明书》)ﻫﻫ2- 开发阶段:ﻫ总体规划阶段:是系统开发的起始阶段,其基础是需求分析,指明信息系统在企业经营战略中的作用和地位,指导信息系统的开发,优化配置并利用各种资源,包括内部资源和外部资源,通过规划过程规范企业的业务课程。

综合课程设计大作业

综合课程设计大作业一、课程目标知识目标:1. 学生能掌握课程核心概念,如综合课程设计的要素、步骤与方法。

2. 学生能理解并描述本年级所学的相关学科知识在实际综合课程设计中的应用。

3. 学生能运用所学知识,分析并识别综合课程设计中的关键问题。

技能目标:1. 学生能运用综合课程设计的步骤,独立完成一份具有创意的课程设计大作业。

2. 学生能通过小组合作,有效沟通,展示课程设计成果,提升团队协作能力。

3. 学生能运用批判性思维,评价并改进自己的课程设计作品。

情感态度价值观目标:1. 学生对综合课程设计产生兴趣,培养主动探索和积极创新的意识。

2. 学生在课程设计过程中,树立合作、尊重、负责的态度,增强自信心。

3. 学生通过课程学习,认识到所学知识在实际生活中的应用价值,提升学习动力。

课程性质:本课程为综合实践活动课程,旨在培养学生的实践能力、创新能力和团队合作精神。

学生特点:学生具备一定的学科知识基础,具有较强的求知欲和动手操作能力,但可能缺乏系统性的综合课程设计经验。

教学要求:结合学生特点,注重实践性、创新性和合作性,引导学生在课程设计中主动探索、积极思考,实现知识、技能和情感态度价值观的全面发展。

通过分解课程目标为具体学习成果,为教学设计和评估提供明确依据。

二、教学内容1. 引入概念:综合课程设计的定义、意义及其在本学科中的应用。

- 教材章节:第一章 综合课程设计概述- 内容:综合课程设计的内涵、类型与价值。

2. 课程设计要素与步骤:- 教材章节:第二章 课程设计的基本要素与步骤- 内容:课程目标、教学内容、教学方法、评价方式;需求分析、目标设定、内容设计、实施与评价。

3. 实践操作:- 教材章节:第三章 课程设计的实践操作- 内容:小组合作进行课程设计,运用所学知识解决实际问题。

4. 创新思维与方法:- 教材章节:第四章 创新思维与课程设计- 内容:创新思维的培养,创新方法在课程设计中的应用。

5. 课程设计案例分析与评价:- 教材章节:第五章 课程设计案例分析与评价- 内容:分析优秀课程设计案例,学会评价和改进自己的作品。

《数据库基础》课程中的教学方法综合应用

浅析《数据库基础》课程中的教学方法综合应用摘要:在分析《数据库基础》课程传统教学方法不足及授课学生特点的基础上,探讨了如何将任务驱动教学法、互动教学法、启发式教学法、混合式教学法、案例教学法、项目教学法等多种教学方法综合应用到《数据库基础》课程的教学思路中。

实践证明该方法能够更好的激发学生自主学习的潜能,取得更好的教学效果。

关键词:数据库基础;课程教学;教学方法中图分类号:g642.0 文献标志码:a 文章编号:1674-9324(2013)09-0068-03一、引言随着国家及军队信息化发展步伐的不断加快,信息技术人才需求进一步增加,必须培养出既熟悉信息工程专业知识,又具有军事指挥能力的复合型军事人才。

数据库技术作为现代信息系统中的核心与基础,已经成为信息科学领域最为重要的应用技术之一。

目前很多高校已将数据库技术作为电子与信息学科相关专业的必修课或选修课。

对于军事指挥类的学生而言,其信息技术起点及个性均存在差异。

如何用50学时的课程,充分发掘学生潜力,掌握数据库技术基本理论原理,掌握一种商用数据库(oracle、sql server)的基本操作及二次开发方法,面临不小的挑战。

笔者将结合实践经验,探讨如何将多种教学方法融入到数据库基础课程教学中以提升教学效果的一些思路。

二、提升学生兴趣,激发学生自主学习潜能“知之者不如好之者,好之者不如乐之者。

”兴趣是最好的老师,是激发学生学习主动性的根本。

有了兴趣,学习就能保持良好的情绪和注意力,变被动为主动,变厌学为乐学;有了兴趣,学生就乐于钻研,乐于与教师交流、沟通,乐于与同学探讨,学习效果好,从而形成良性循环。

那么,该如何给学生一个良好的教学氛围,激发并保持其学习数据库的兴趣呢?1.由浅入深,引导并激发学生兴趣。

早在第一堂课上,我们就举出了丰富的数据库应用案例,包括航空订票系统、铁路订票系统、银行金融信息系统、学校学籍管理系统、食堂就餐刷卡系统等。

让学生了解到数据库技术已渗透到我们生活的方方面面。

管理信息系统参考作业答案

北京化工大学北方学院2010——2011学年第二学期《管理信息系统(40学时)》期末考试大作业一、简答(每题5分,共20分)1.信息系统的生命周期包括哪几个阶段?其中系统开发阶段的三个主要任务及其内容是什么?管理信息系统建设的生命周期,可以分成系统规划、系统分析、系统设计、系统实施、系统运行与支持等几个阶段。

系统规划是管理信息系统建设的起始阶段。

这一阶段的主要任务是:根据组织的整体目标和发展战略,确定管理信息系统的发展战略,明确组织总的信息需求,制订管理信息系统建设总计划,其中包括确定拟建系统的总体目标、功能、大致规模和粗略估计所需资源。

根据需求的轻、重、缓、急程度及资源和应用环境的约束,把规划的系统建设内容分解成若干开发项目以分期分批进行系统开发。

并进行系统的初步调查和系统开发的可行性研究。

系统分析阶段的主要工作是根据系统规划阶段确定的拟建系统总体方案和开发项目的安排,对系统进行组织结构分析、业务流程分析、数据流程分析、处理功能分析,建立系统逻辑模型。

系统分析的主要任务是明确用户的信息需求,提出新系统的逻辑方案。

需要进行的工作有现行系统的详细调查及新系统逻辑模型的提出等。

系统设计的主要任务是根据新系统的逻辑方案进行软、硬件系统的设计,包括总体结构设计、输出设计、输入设计、处理过程设计、数据存储设计和计算机系统方案的选择等。

系统实施将设计的系统付诸实施,主要工作有应用程序编制或软件包的购置、计算机与通信设备的购置,系统的安装、调试与测试、新旧系统的转换及评估等。

系统运行与支持,每个系统开发项目完成后即投入应用,进入正常运行和支持阶段。

在此阶段,开发者和用户一道支持管理信息系统的运行。

一般说来,这是系统生命周期中历时最久的阶段,也是管理信息系统实现其功能、发挥其效益的阶段。

分为4个阶段:产生、开发、运行、消亡1- 产生阶段:即其概念阶段或需求阶段,这一阶段分为两个过程,一是概念的产生过程(根据企业经营管理的需要,提出建设信息系统的初步想法)二是需求分析过程(即对企业信息系统的需求进行深入调研和分析,并形成《需求规格说明书》)2- 开发阶段:总体规划阶段:是系统开发的起始阶段,其基础是需求分析,指明信息系统在企业经营战略中的作用和地位,指导信息系统的开发,优化配置并利用各种资源,包括内部资源和外部资源,通过规划过程规范企业的业务课程。

ArcGIS应用大作业报告

ArcGIS应⽤⼤作业报告GIS软件应⽤⼤作业报告(2019 ——2020 学年第2学期)课程:GIS软件应⽤专业:地理信息科学班级:学⽣姓名:学号:指导教师:指导教师职称:完成时间:实验项⽬列表实验报告撰写及批改说明1.实验报告格式要求统⼀采⽤实验报告⽤纸。

实验报告中的计量单位、制图、制表、公式、缩略词、符号应符合国家的规定。

2.实验报告内容包括:1)实验项⽬名称;2)实验组号;3)组内其他成员姓名;4)⽬的要求;5)仪器⽤具:仪器名称及主要规格(如包括量程、分度值、精度等)、⽤具名称;6)实验原理:简单但要抓住要点,即要写出依据原理的公式名称、公式表达式、公式中各物理量的名称、公式成⽴的条件等;7)实验内容:具体内容因课程由各指导⽼师具体规定。

设计性实验由学⽣⾃主提出实验步骤或⽅案、结论等;8)数据表格:画出数据表格(写明物理量和单位);9)数据处理及结果(结论):按实验要求处理数据;10)讨论:对实验中存在的问题、进⼀步的想法等进⾏讨论。

3.学⽣按实验项⽬撰写实验报告,所有实验项⽬完成后,填写实验项⽬列表,并装订成册,由实验室保存。

4.指导教师按实验项⽬批改,填写成绩及教师评阅意见,并在实验项⽬列表中填写成绩,课程实验全部完成后,填写课程实验总成绩。

作业1:专题地图制图⼀、实验的⽬的与要求:掌握空间数据分级设⾊定量符号化⽅法。

及专题地图的注记,设置和出图。

⼆、实验内容:1.根据xls经纬度,建⽴臭氧站点变化趋势和臭氧显著性检验的定量分级设⾊符号化专题地图。

2.根据省会,河流,公路,铁路,⾏政区界5个数据要素类,制作华东地区专题图。

3.根据省会,河流,公路,铁路,⾏政区界5个数据要素类进⾏符号化和注记以及导出专题地图4.省会必须注记名称和名称拼⾳,河流必须注记名称,铁路必须注记名称,⾏政区界必须注记名称,同时考虑操作避免压盖问题,公路不⽤注记。

5.河流符号化为蓝⾊,省会⽤8号圆点表⽰,铁路使⽤铁路专⽤符号,公路使⽤公路专⽤符号,⾏政区界颜⾊不限,但应该便于识别图中⽂字和符号。

大作业要求

本课程以课程设计(大作业)方式考核要求一、课程设计目的:1.通过课堂讲解、课后自学和交流讨论,掌握一种常用工具软件的主要使用方法与操作技巧;2.在完成Delphi面向对象程序设计教学内容的学习之后,通过后续的管理信息系统设计实践环节,使学生进一步加深对所学知识的理解和认识;3.指导和促使学生通过各种途径对Delphi这类面向对象开发工具以及相关技术内容进行深入探究,增强自学能力及对所学知识的综合应用能力;4.提高学生的分析问题和解决问题、用户需求分析、系统设计与开发等方面的能力,掌握使用Delphi进行系统开发的一般步骤、方法和技巧;5.通过管理信息系统设计答辩环节,锻炼学生的语言表达能力和沟通能力。

二、课程设计要求:1.课程设计(大作业)包括:常用工具软件学习和管理信息系统设计两部分;2.常用工具软件由学生自己选择,最后每人上交一份学习总结;3.管理信息系统设计的具体题目为“高校人事管理系统”;原则上以2人为单位分组,完成设计任务;设计完毕后,每组必须上交软件设计相关资料;4.课程设计结束后必须上交的资料包括:1)纸质文档。

其内容包括以下几个方面:2)第 1 页共4 页三、1.每人学习一种常用工具软件,并独立完成一份学习总结;2.每组必须设计并实现一个功能较完整的基于关系数据库的高校人事管理信息系统,软件界面自行设计,要求美观友好,主要功能包括:1)用户管理功能:用户登录验证、权限设置、用户密码设置、增删用户等;2)数据维护功能:完成相关数据的添加、修改、删除等操作;a)部门信息维护b)教工基本信息维护c)教工就职信息维护d)教工离职信息维护e)教工退休信息维护f)教工工资信息维护g)绩效考核信息维护3)查询功能:能够按照特定条件和综合查询方式进行查询等;a)教工基本信息查询b)教工就职信息查询c)教工工资信息查询d)绩效考核信息查询4)报表功能及统计功能:功能将查询结果以报表形式进行打印预览、打印等;通过图形方式显示数据的统计结果(此项作为可选功能,不要求必须实现);3.建议使用目前主流的数据库产品(如:Access、MS SQL Server等)。

软件工程大作业简版范文

软件工程大作业软件工程大作业引言本文档旨在介绍软件工程大作业的相关背景和要求,并提供一个实施计划,以便顺利完成该作业。

本作业旨在培养学生的软件工程实践能力,通过团队合作完成一个软件项目,涵盖项目规划、需求分析、设计实现、和部署等各个阶段。

1. 背景软件工程是开发高质量软件的一门学科,涵盖了软件开发过程的各个方面,包括需求分析、系统设计、编码、和维护。

软件工程大作业是对学生所学知识的综合应用,旨在让学生在一个团队环境中体验软件开发的全过程。

2. 作业要求软件工程大作业要求学生以小组形式合作,完成一个软件项目的开发。

作业要求如下:每个小组由3-5名成员组成,每个小组自行确定项目主题。

小组需要进行项目规划,包括项目目标、范围和进度计划等等。

小组需进行需求分析,明确系统的功能和非功能需求。

小组需要进行系统设计,包括系统架构设计和数据库设计等。

小组需要进行编码和单元,并进行代码评审。

小组需要进行系统集成,确保各个模块正确集成。

小组需要进行系统验收,并准备系统发布的相关文档。

,小组需要进行项目和经验分享。

3. 实施计划为了顺利完成软件工程大作业,下面是一个建议的实施计划:阶段一:项目规划(1周)在这个阶段,小组成员应该共同确定项目主题,并进行项目规划。

项目规划需要明确项目的目标、范围和进度计划等,以便在后续阶段进行参考。

阶段二:需求分析(2周)在这个阶段,小组成员需要进行需求分析,明确系统的功能和非功能需求。

可以采用面谈、问卷调查等方法收集用户需求,并将其进行整理和归类。

阶段三:系统设计(2周)在这个阶段,小组成员需要进行系统设计,包括系统架构设计、数据库设计等。

可以采用UML工具绘制系统的结构图、类图等,确保系统的设计满足需求。

阶段四:编码和(3周)在这个阶段,小组成员需要进行编码和单元,并进行代码评审。

编码过程中要遵循代码规范,确保代码质量。

进行单元,及时发现和修复代码缺陷。

阶段五:系统集成和(2周)在这个阶段,小组成员需要将各个模块进行集成,并进行系统集成。

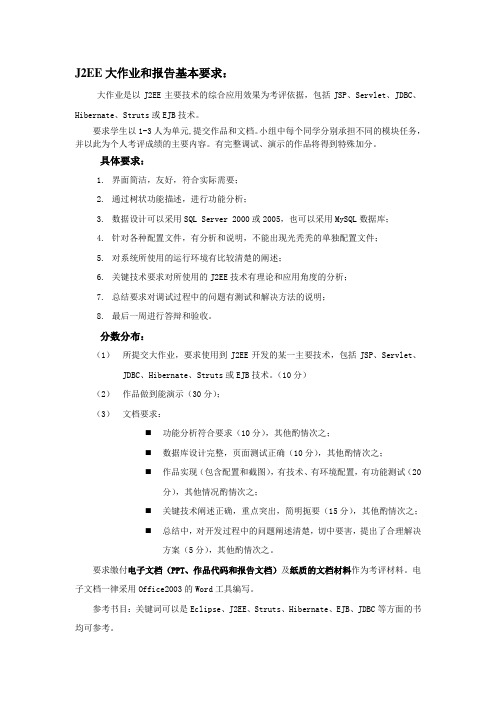

J2EE大作业和报告基本要求(1)

J2EE大作业和报告基本要求:大作业是以J2EE主要技术的综合应用效果为考评依据,包括JSP、Servlet、JDBC、Hibernate、Struts或EJB技术。

要求学生以1-3人为单元,提交作品和文档。

小组中每个同学分别承担不同的模块任务,并以此为个人考评成绩的主要内容。

有完整调试、演示的作品将得到特殊加分。

具体要求:1.界面简洁,友好,符合实际需要;2.通过树状功能描述,进行功能分析;3.数据设计可以采用SQL Server 2000或2005,也可以采用MySQL数据库;4.针对各种配置文件,有分析和说明,不能出现光秃秃的单独配置文件;5.对系统所使用的运行环境有比较清楚的阐述;6.关键技术要求对所使用的J2EE技术有理论和应用角度的分析;7.总结要求对调试过程中的问题有测试和解决方法的说明;8.最后一周进行答辩和验收。

分数分布:(1)所提交大作业,要求使用到J2EE开发的某一主要技术,包括JSP、Servlet、JDBC、Hibernate、Struts或EJB技术。

(10分)(2)作品做到能演示(30分);(3)文档要求:⏹功能分析符合要求(10分),其他酌情次之;⏹数据库设计完整,页面测试正确(10分),其他酌情次之;⏹作品实现(包含配置和截图),有技术、有环境配置,有功能测试(20分),其他情况酌情次之;⏹关键技术阐述正确,重点突出,简明扼要(15分),其他酌情次之;⏹总结中,对开发过程中的问题阐述清楚,切中要害,提出了合理解决方案(5分),其他酌情次之。

要求缴付电子文档(PPT、作品代码和报告文档)及纸质的文档材料作为考评材料。

电子文档一律采用Office2003的Word工具编写。

参考书目:关键词可以是Eclipse、J2EE、Struts、Hibernate、EJB、JDBC等方面的书均可参考。

青少年python编程课程体系四阶63节

青少年Python编程课程体系四阶63节1. 前言在当今数字化的时代,编程已经成为一种必备的技能。

而Python作为一种易学易用的编程语言,受到了越来越多青少年的青睐。

为了满足青少年对编程学习的需求,针对青少年的Python编程课程也应运而生。

本文将介绍一套完整的青少年Python编程课程体系,包含四阶共63节课程,帮助青少年系统地学习和掌握Python编程技能。

2. 第一阶段:基础入门(共16节课)1)课程一:Python编程入门- 介绍Python编程语言的基本概念和特点- 学习Python的基本语法和数据类型- 编写并执行简单的Python程序2)课程二:Python数据结构- 学习Python中常用的数据结构,如列表、元组、字典- 熟悉数据结构的操作和应用3)课程三:条件与循环- 掌握Python中的条件语句和循环语句- 学习如何利用条件和循环解决问题4)课程四:函数与模块- 理解函数的概念和作用- 学习如何定义和调用函数- 掌握使用模块扩展Python的功能5)课程五:文件操作- 学习如何读写文件- 掌握文件对象的操作方法- 编写文件操作相关的Python程序6)课程六:简单项目实践- 运用前面所学知识,完成简单的项目实践 - 提高学生的动手能力和解决问题的能力7)课程七:期末考核- 对第一阶段所学内容进行综合测试- 评估学生对Python基础知识的掌握情况3. 第二阶段:进阶深化(共18节课)1)课程一:面向对象编程- 理解面向对象编程的概念和特点- 学习如何定义类和对象- 掌握面向对象编程的基本方法2)课程二:异常处理- 学习如何捕获和处理程序中的异常- 掌握异常处理的基本方法- 提高程序的健壮性和稳定性3)课程三:GUI编程- 介绍图形用户界面(GUI)编程的基本概念 - 学习使用Python的Tkinter库进行GUI编程 - 编写简单的GUI应用程序4)课程四:网络编程- 了解网络编程的基本原理和方法- 学习使用Python进行网络编程- 编写简单的网络应用程序5)课程五:数据库操作- 掌握Python操作数据库的基本方法- 学习使用Python进行数据库的增删改查操作 - 编写简单的数据库应用程序6)课程六:高级项目实践- 运用前面所学知识,完成较为复杂的项目实践- 提高学生的综合应用能力和创新能力7)课程七:期末考核- 对第二阶段所学内容进行综合测试- 评估学生对Python进阶知识的掌握情况4. 第三阶段:实战项目开发(共16节课)1)课程一:Web开发基础- 介绍Web开发的基本概念和技术- 学习使用Python进行简单的Web开发2)课程二:数据分析与可视化- 掌握使用Python进行数据分析和可视化的基本方法 - 学习常用的数据分析和可视化工具3)课程三:机器学习入门- 了解机器学习的基本原理和常用算法- 学习使用Python进行简单的机器学习应用4)课程四:人工智能基础- 了解人工智能的基本概念和发展趋势- 学习使用Python进行简单的人工智能应用5)课程五:大作业策划- 研究并确定一项合适的大作业项目- 分析项目需求和可行性6)课程六:大作业开发- 学生分组进行大作业项目的开发- 老师指导和辅导学生进行大作业的实施7)课程七:期末答辩- 学生团队在课堂上进行大作业的答辩- 老师和同学们进行评审和点评5. 第四阶段:实践拓展(共13节课)1)课程一:互联网+创新创业- 介绍互联网+创新创业的基本理念和方法 - 激发学生的创新创业意识和能力2)课程二:移动应用开发- 介绍移动应用开发的基本知识和技能- 学习使用Python进行移动应用开发3)课程三:物联网技术- 了解物联网技术的基本原理和应用场景- 学习使用Python进行物联网应用的开发4)课程四:区块链技术- 介绍区块链技术的基本概念和发展趋势- 学习使用Python进行区块链应用的开发5)课程五:高级项目实践- 运用前面所学知识,完成高级的项目实践- 提高学生的综合应用能力和创新能力6)课程六:毕业设计策划- 学生自主确定毕业设计项目的方向和内容- 老师进行指导和审阅7)课程七:毕业设计答辩- 学生在学校进行毕业设计的答辩- 老师和同学们进行评审和点评6. 总结通过四阶63节的Python编程课程学习,青少年将能够系统地掌握Python编程的基础知识和进阶知识,具备较强的动手能力和创新能力,为将来的学习和工作奠定良好的基础。

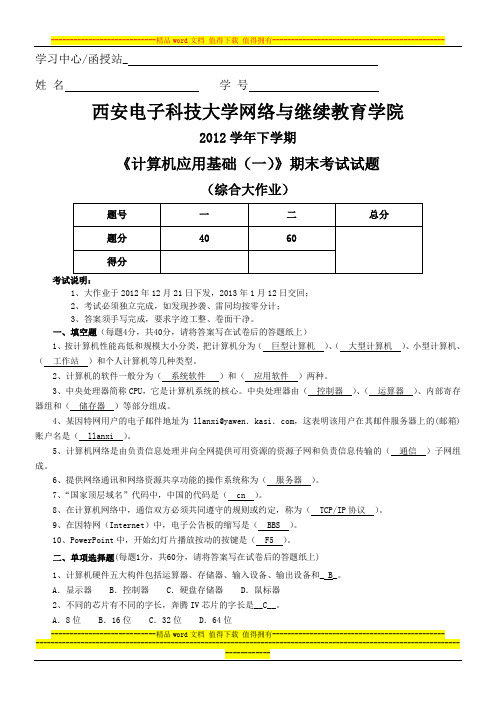

西安电子科技大学网络与继续教育学院《计算机应用基础(一)》考试试题及答案

学习中心/函授站_姓名学号西安电子科技大学网络与继续教育学院2012学年下学期《计算机应用基础(一)》期末考试试题(综合大作业)1、大作业于2012年12月21日下发,2013年1月12日交回;2、考试必须独立完成,如发现抄袭、雷同均按零分计;3、答案须手写完成,要求字迹工整、卷面干净。

一、填空题(每题4分,共40分,请将答案写在试卷后的答题纸上)1、按计算机性能高低和规模大小分类,把计算机分为(巨型计算机)、(大型计算机)、小型计算机、(工作站)和个人计算机等几种类型。

2、计算机的软件一般分为(系统软件)和(应用软件)两种。

3、中央处理器简称CPU,它是计算机系统的核心。

中央处理器由(控制器)、(运算器)、内部寄存器组和(储存器)等部分组成。

4、某因特网用户的电子邮件地址为llanxi@yawen.kasi.com,这表明该用户在其邮件服务器上的(邮箱)账户名是( llanxi )。

5、计算机网络是由负责信息处理并向全网提供可用资源的资源子网和负责信息传输的(通信)子网组成。

6、提供网络通讯和网络资源共享功能的操作系统称为(服务器)。

7、“国家顶层域名”代码中,中国的代码是( cn )。

8、在计算机网络中,通信双方必须共同遵守的规则或约定,称为( TCP/IP协议)。

9、在因特网(Internet)中,电子公告板的缩写是( BBS )。

10、PowerPoint中,开始幻灯片播放按动的按键是( F5 )。

二、单项选择题(每题1分,共60分,请将答案写在试卷后的答题纸上)1、计算机硬件五大构件包括运算器、存储器、输入设备、输出设备和_ B_。

A.显示器B.控制器C.硬盘存储器D.鼠标器2、不同的芯片有不同的字长,奔腾IV芯片的字长是__C__。

A.8位B.16位C.32位D.64位----------------------------精品word文档值得下载值得拥有----------------------------------------------3、计算机的通用性使其可求解不同的算术和逻辑运算,取决于它的_B__。

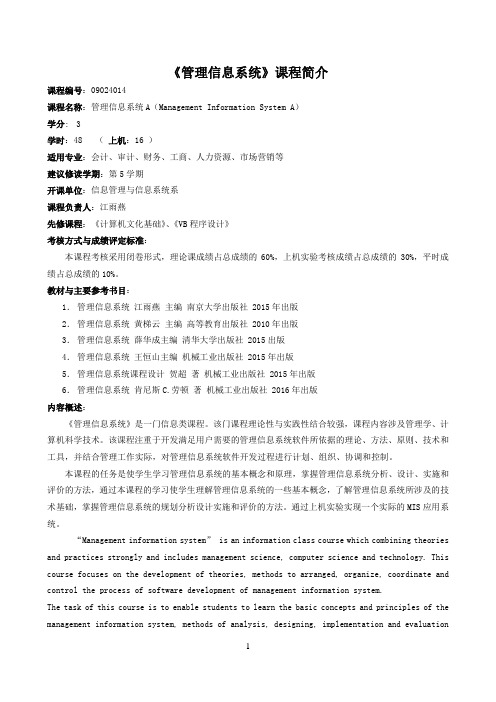

《管理信息系统》课程简介

《管理信息系统》课程简介课程编号:09024014课程名称:管理信息系统A(Management Information System A)学分:3学时:48 (上机:16 )适用专业:会计、审计、财务、工商、人力资源、市场营销等建议修读学期:第5学期开课单位:信息管理与信息系统系课程负责人:江雨燕先修课程:《计算机文化基础》、《VB程序设计》考核方式与成绩评定标准:本课程考核采用闭卷形式,理论课成绩占总成绩的60%,上机实验考核成绩占总成绩的30%,平时成绩占总成绩的10%。

教材与主要参考书目:1.管理信息系统江雨燕主编南京大学出版社 2015年出版2.管理信息系统黄梯云主编高等教育出版社 2010年出版3.管理信息系统薛华成主编清华大学出版社 2015出版4.管理信息系统王恒山主编机械工业出版社 2015年出版5.管理信息系统课程设计贺超著机械工业出版社 2015年出版6.管理信息系统肯尼斯C.劳顿著机械工业出版社 2016年出版内容概述:《管理信息系统》是一门信息类课程。

该门课程理论性与实践性结合较强,课程内容涉及管理学、计算机科学技术。

该课程注重于开发满足用户需要的管理信息系统软件所依据的理论、方法、原则、技术和工具,并结合管理工作实际,对管理信息系统软件开发过程进行计划、组织、协调和控制。

本课程的任务是使学生学习管理信息系统的基本概念和原理,掌握管理信息系统分析、设计、实施和评价的方法,通过本课程的学习使学生理解管理信息系统的一些基本概念,了解管理信息系统所涉及的技术基础,掌握管理信息系统的规划分析设计实施和评价的方法。

通过上机实验实现一个实际的MIS应用系统。

“Management information system” is an information class course which combining theories and practices strongly and includes management science, computer science and technology. This course focuses on the development of theories, methods to arranged, organize, coordinate and control the process of software development of management information system.The task of this course is to enable students to learn the basic concepts and principles of the management information system, methods of analysis, designing, implementation and evaluationof management information system and understand the basic concepts of management information systems, the based knowledge of management information system, to master the methods of planning, analysis, design, implementation and evaluation of management information system. Base on experiments to implement an actual management information application system.《管理信息系统》教学大纲课程编号:09024014课程名称:管理信息系统A/(Management Information System A)学分:3学时:48 (上机:16 )适用专业:会计、审计、财务、工商、人力资源、市场营销等建议修读学期:第5学期开课单位:信息管理与信息系统系课程负责人:江雨燕先修课程:《计算机文化基础》、《VB程序设计》一、课程性质、目的与任务《管理信息系统A》是一门信息类课程,是信息管理与信息系统、工业工程、物流工程、造价工程、会计、审计、财务、工商、人力资源、市场营销等专业的一门重要的专业基础课,是信息管理与信息系统专业必修的主干核心课。

《大学计算机基础》课程教学大纲

《大学计算机基础》教学大纲(自主学习课程)课程编号:13200901英文名称:Fundamentals of College Computer学分:1建议自主学习时间:80学时课程类别:必修授课对象:全校本科专业学生教学单位:工学院计算机科学技术学科修读学期:第1学期一、自主学习任务《大学计算机基础》是为大学一年级学生开设的一门自主学习课程。

课程的定位是计算机知识非零起点的大学一年级学生,通过自主学习,从应用计算机的角度来扩展学生的视野,掌握计算机的应用技能。

课程的任务是引导学生认识以计算机为核心的信息技术在信息化社会中的地位和作用;培养大学生的信息技术素养;初步具备利用计算机处理和解决问题的意识和能力,为将来应用计算机知识和技能来解决本专业的实际问题打下基础。

通过本课程的学习,使学生了解一定的计算机软硬件基础知识;熟练掌握Windows 7操作系统的基本操作;熟练使用办公软件Office 2010及实用工具处理日常事务;掌握通过网络获取信息、使用信息,以及与他人交流的方法和技能,了解信息化社会中的相关法律与道德规范。

由于它还是一门自主学习课程,通过实践,使学生认识、了解和初步掌握自主学习的方法和途径,为今后其他课程自主学习的开展奠定基础。

二、自主学习目标1.专业知识方面《大学计算机基础》课程,通过自主学习的方式,紧紧围绕以学生最需要的动手能力和应用能力为主线,采取任务驱动、案例引导和设置问题的方式,组织和设计学生的自主学习过程,着重培养学生解决实际问题的能力,要求学生在专业知识水平方面应该达到:(1)掌握计算机软件、硬件基础知识、计算机网络技术、Internet技术、信息检索与应用、信息安全技术。

(2)熟练掌握计算机Windows 7平台操作环境,熟练掌握办公软件Office 2010的基本操作,能够进行文档排版和处理、电子表格处理和数据分析,独立制作幻灯片演示文稿。

(3)了解多媒体技术和数据库技术,了解与本专业有关的计算机科学前沿的知识。

python大作业总结

python大作业总结

一、介绍

Python作为一门编程语言,在编程学习中非常重要,不仅被广泛用于web、移动应用等方面的开发,而且在数据挖掘、机器学习等领域也有着不可替代的地位。

本报告主要是针对有初步Python基础的同学,介绍Python大作业总结报告的一些要点,帮助同学们尽快掌握Python的基础知识,帮助同学们改进思维定势,从而提高Python编程能力。

二、Python大作业总结报告

1、完成的任务

在完成Python大作业之前,需要综合考虑项目需求、运行环境以及对程序运行的跟踪等,确保程序在实际应用中能够正确运行。

2、软件安装

在完成Python软件的安装后,可以设置不同版本的Python环境进行测试,以确保在不同系统上可以正确运行。

3、程序设计

准备好程序设计文档,并确保编译器可以正确识别程序中的标识符、类型等。

4、程序编写

使用Python编程语言编写程序,并按照程序设计文档的要求进行修改,确保程序的可读性和可维护性。

5、测试

对于刚编写的程序,必须对程序进行测试,确保在不同平台上都能正确运行,减少程序出现错误的几率。

6、代码优化

完成程序的编写与测试后,可以对程序的代码进行优化,减少程序的运行时间,提高程序的运行效率。

三、总结

总之,Python是一门新兴的编程语言,在编程任务的解决中起到非常重要的作用。

在完成Python大作业前,需要综合考虑项目需求、运行环境以及对程序运行的跟踪等,确保程序在实际应用中能够正确运行。

清华自动化大一c++大作业

清华自动化大一c++大作业清华自动化大一C++大作业我是一个清华大学自动化专业的大一学生,最近在学习C++编程语言。

作为课程的一部分,我们被要求完成一个大作业,我想和大家分享一下我的经历和成果。

我的大作业是一个简单的学生成绩管理系统。

这个系统可以帮助老师和学生记录和管理学生的成绩信息。

系统的主要功能包括添加学生信息、录入学生成绩、计算平均成绩以及显示学生成绩排名等。

在开始编写代码之前,我首先了解了C++的基本语法和一些常用的编程概念。

然后,我设计了一个学生类来表示每个学生的信息,包括姓名、学号和成绩等。

我还创建了一个成绩管理类来处理学生信息的录入和计算。

在代码的编写过程中,我遇到了一些挑战。

例如,如何在C++中处理字符和字符串,以及如何进行输入和输出。

我通过查阅教材和参考资料,逐步解决了这些问题。

我还利用C++提供的各种数据结构和算法来提高代码的效率和可读性。

在完成代码编写后,我进行了一系列的测试来验证系统的正确性和稳定性。

通过输入不同的学生信息和成绩,我确保系统能够正确地计算平均成绩并显示学生成绩排名。

我还进行了一些边界测试,以确保系统能够处理各种异常情况。

通过这个大作业,我学到了很多关于C++编程的知识和技巧。

我不仅学会了如何设计和实现一个简单的程序,还学会了如何解决编程中遇到的各种问题。

这对我今后的学习和发展将有很大的帮助。

总的来说,我对我的C++大作业感到非常满意。

我努力克服了各种困难,成功地完成了一个功能完善的学生成绩管理系统。

通过这个项目,我不仅提高了我的编程能力,还培养了我的解决问题的能力。

我相信这将对我的学习和未来的发展产生积极的影响。

基于SE—CDIO培养学生项目管理能力的新途径

基于SE—CDIO培养学生项目管理能力的新途径作者:康雁李彤来源:《计算机教育》2013年第13期摘要:基于软件学院工科学生特点,提出基于SE-CDIO进行培养学生项目管理能力的新途径,以认证考试为驱动,结合企业实际需求进行培养,帮助学生建立未来职场发展方向,培养学生的项目管理技能,提高学生管理项目的能力。

关键词:项目管理能力;认证考试;SE-CDIO;教学改革0 引言随着全球经济一体化步伐的加快、竞争的不断加剧和我国经济的持续快速发展,项目管理的重要性被越来越多的企业及组织所重视。

在大量的项目中,企业决策者意识到运用项目管理知识可以大大降低项目的盲目性,减少不必要的损失,因此那些拥有良好项目管理知识和实践经验的专业人员已成为各个公司追逐的对象。

针对软件业迅速发展以及软件工程项目管理人员供不应求的现状,我们在云南大学软件学院利用SE—CDIO软件人才培养体系对学生的项目管理能力培养进行了探索与实践,通过课程、实训和校企合作进行了知识、能力和素质的培养,使学生了解项目管理的发展前景,并有效地运用软件项目管理知识、工具和技术来管理项目,从而减少软件工程项目中因为管理方面的失误导致的损失。

1 SE-CDIO课程改革SE-CDIO人才培养体系能够灵活适应工程人才培养模式。

结合我国目前项目增多、规模变大的国情,该体系能有效提高学生的项目管理能力。

在航空领域最早使用CDIO方法之后,MIT将其用于机械制造领域,提出CDIOfConcelve构思、Design设计、Implement实现、Operate运作)工程教育模式。

SE-CDIO实现CDIO和软件生命周期的有机结合,其中SE-C是软件需求,SE-D是软件设计,SE-I是软件实现与测试,SE-O是“软件运用+产业化+市场营销”,让学生经历“理论一技术一生产一应用”的全过程。

该体系对软件工程专业创造型人才需要具备的知识、能力、素质结构以及具体目标进行了研究、探索和实践,已取得初步成效。

管理信息系统大作业

管理信息系统大作业管理信息系统(Management Information Systems,简称MIS)是一门研究提供给管理者使用的信息系统的学科。

它通过对信息技术的综合应用,为企业的管理者提供决策支持和信息资源。

本文档将介绍管理信息系统大作业的相关内容。

我们将探讨大作业的目标、任务分配、进展情况以及最终成果,并从技术和管理的角度进行讨论。

目标管理信息系统大作业的目标是让学生能够应用所学的管理信息系统理论和技术,解决实际的业务问题。

通过完成这个大作业,学生能够加深对管理信息系统的理解,培养解决问题、团队合作和项目管理的能力。

任务分配大作业的任务分配包括了以下几个方面: 1. 项目选择:每个小组自行选择一个实际的业务问题作为研究对象,确保问题具有一定的复杂性和挑战性。

2. 项目计划:确定项目的时间安排、工作任务以及资源需求等。

3. 数据收集和分析:收集相关数据,并进行数据清洗、整理和分析。

4. 系统设计和开发:根据业务需求,设计合适的管理信息系统,并进行开发和测试。

5. 系统实施和运行:将开发好的管理信息系统运行在实际的业务环境中,并验证其有效性。

6. 结果展示和:将项目结果进行展示,并从技术和管理角度进行和反思。

进展情况目前,大作业已经进行到了系统设计和开发的阶段。

各小组根据自己选择的业务问题,进行了系统设计和开发工作。

他们采用了敏捷开发的方法,将需求分解为不同的任务,并定期进行迭代和回顾。

整个开发过程中,大家充分发挥团队协作的优势,有效地完成了开发任务。

同时,其他小组也在进行数据收集和分析的工作。

他们通过调查问卷、访谈等方式收集、整理和分析了大量的数据。

这些数据将为系统的设计和开发提供支持,并帮助小组更好地理解业务问题。

最终成果在大作业的最终成果中,每个小组将呈现一个完整的管理信息系统,并将其运行在实际的业务环境中。

他们将通过报告和演示的方式,展示他们的系统的功能和效果,并详细说明系统的设计思路、开发过程和实施情况。

国家开放大学电大《计算机应用基础(本)》终结性考试试题答案(格式已排好)任务一

国家开放大学电大《计算机应用基础(本)》终结性考试试题答案(格式已排好)任务一国家开放大学学士学位论文样文国家开放大学学士学位论文题目:家用电器销售管理系统的设计与实现分部:XXXXXX学习中心:XXXXXX专业:法律事务入学时间:2006年3月1日学号:2141001401556姓名:XXX指导教师:XXX论文完成日期: 2019年10月学位论文原创性声明本人郑重声明:所呈交的学位论文,是本人在导师指导下,进行研究工作所取得的成果。

除文中已经注明引用的内容外,本学位论文的研究成果不包含任何他人创作的、已公开发表或者没有公开发表的作品的内容。

对本论文所涉及的研究工作做出贡献的其他个人和集体,均已在文中以明确方式标明。

本学位论文原创性声明的法律责任由本人承担。

作者签名:日期:年月日学位论文版权使用授权声明本人完全了解国家开放大学关于收集、保存、使用学位论文的规定,同意如下各项内容:按照学校要求提交学位论文的印刷本和电子版本;学校有权保存学位论文的印刷本和电子版,并采用影印、缩印、扫描、数字化或其它手段保存论文;学校有权提供目录检索以及提供本学位论文全文或者部分的阅览服务,以及出版学位论文;学校有权按有关规定向国家有关部门或者机构送交论文的复印件和电子版;在不以赢利为目的的前提下,学校可以适当复制论文的部分或全部内容用于学术活动。

作者签名:日期:年月日国家开放大学学士学位论文目录摘要 (2)一、引言 (3)(一)研究背景 (3)(二)研究意义 (3)(三)研究现状 (3)二、需求分析 (3)(一)需求分析 (3)(二)系统功能数据流分析 (3)1. 销售管理分析 (4)2. 采购管理分析 (4)三、系统设计 (4)(一)系统功能设计 (4)(二)数据库分析设计 (4)四、系统功能实现 (4)(一)销售管理功能实现 (4)(二)客户管理功能实现 (5)五、系统测试 (5)(一)单元测试 (5)(二)集成测试 (5)(三)测试结果的分析 (5)结束语 (7)致谢 (8)参考文献 (9)1家用电器销售管理系统的设计与实现摘要本电器销售管理系统使用Java2 Platform(Java EE) 结合数据库技术实现系统的框架搭建和具体的功能实现。

《信息处理技术员》综合作业要求及指导

说明:大作业包括Office综合应用和网络应用及信息安全方面的内容,共8道题目。

大作业在给定的题目中任选,学生应完成4道题目,其中实验作业1-1、1-2选1道,1-3、1-4选1道,1-5、1-6选1道,2-1、2-2选1道。

要求所有大作业在16周周六(6月11日)20:00之前必须全部完成并提交。

每次提交作业时,以“学号_姓名_作业名称_提高班”起名建一个文件夹(如511001121_张三_实验作业1-1_给定论文排版),并将与该次作业相关的结果文档(如Word文档、PPT、Excel电子表格、程序、影片、贺卡等)及实验报告放入其中,压缩后提交。

压缩文件名如:38010140_张三_实验作业1-1_给定论文排版.rar。

注意作业结果文件的名字要写清学号、姓名、作业名等。

如:511001121_张三_实验作业1-1_给定论文排版.doc、511001121_张三_实验作业1-1_给定论文排版_实验报告.doc等等。

学生可于课上上机实验时间或课余上机时间完成作业,作业中遇到的问题要及时与老师沟通。

下面是8道实验作业的具体要求。

附录1给出了实验报告的格式要求,附录2给出了部分实验的指导作为参考。

一、Office综合应用实验作业1-1 给定论文排版实验目的:掌握规定格式的论文排版方法;掌握Word文档基本编辑、高效排版、页面设置的方法。

实验内容:给出一个未编排格式的论文初稿和本科毕业论文格式,要求学生按照论文格式要求对文章进行排版。

实验要求:创建样式;完成给定文章的文字、段落格式编排;完成文中规定表格的制作和图文格式的混排;完成目录和图表目录的生成;插入页眉和页脚;进行页面设置。

参见附录2中实验一,按照要求撰写实验报告,注意回答实验思考题。

实验作业1-2 设计制作班报特刊实验目的:掌握通过互联网搜索、获取和利用信息的方法,并能够参考报纸或杂志设计与编辑小型报纸。

实验内容:设计并制作一份有关大学新生活的班报特刊。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2016-2017学年第一学期《系统综合应用开发》大作业课题名称:Hadoop集群搭建及MapReduce应用班级:13级软工数据库1班学号:123456姓名:123456成绩:2016年10月一、Hadoop集群的搭建与配置1、节点准备此部分主要描述节点的规划,包括IP的分配,NameNode和DataNode的配置。

1、设置IP修改/etc/sysconfig/network-scripts/ifcfg-eth0文件:DEVICE=eth0 --网卡名称BOOTPROTO=static --获取静态IPHW ADDR=00:E0:4C:F8:3B:CE --机器MAC地址 IPADDR=10.8.3.240 --IPNETMASK=255.255.255.0 --子网掩码 NETWORK=10.8.3.254 --默认网关 ONBOOT=yes2、设置hostname在所有机器的/etc/hosts 文件下添加:10.8.3.240 namenode10.8.3.246 datanode110.8.3.239 datanode210.8.3.249 datanode310.8.3.238 datanode410.8.3.251 datanode5注:为了使机器辨别到hostname,必须重启机器。

2、Java环境安装1.进入安装目录cd /home/magic/gshare/linux下构造java开发环境我的文件夹目录为:2.赋予权限sudo chmod u+x jdk-6u13-linux-i586.bin3、执行安装sudo ./jdk-6u13-linux-i586.bin,进行编译。

接着一直按回车键,直到出现选项:输入yes,按回车键。

就可以完成安装了。

3、SSH配置hadoop控制脚本依赖ssh来执行针对整个集群的操作,因此为了支持无缝工作,此部分主要描述SSH的配置。

1、配置SSH(1)在namenode下执行ssh-keygen -t rsa (2)在namenode下执行ssh-copy-id -i ~/.ssh/id_rsa.pub root@namenode ssh-copy-id -i ~/.ssh/id_rsa.pub root@datan ode1 ssh-copy-id -i ~/.ssh/id_rsa.pub root@datanode2 ssh-copy-id -i ~/.ssh/id_rsa.pub root@ datanode3 ssh-copy-id -i ~/.ssh/id_rsa.pub root@datanode4 ssh-copy-id -i ~/.ssh/id_rsa.pub r oot@datanode5遇到输入提示时,,如果不是询问密码,可直接按回车进入下一步。

执行完成后,实际上在namenode节点的~/.ssh目录下生成了三个文件: authorized_keys 、 id_rsa 、 id_rsa.pub,在datanode节点下分别生成了authorized_keys 文件,作为密钥实现无密码通信 (2)判断是否安装成功在namenode节点执行 ssh datanode1,如果没有询问密码就进入datanode1的命令行界面,证明安装成功,其他节点类似。

2、安装JDK(1)进入jdk-6u34-linux-i586-rpm.bin文件所在目录,执行以下命令进行安装: ./jdk-6u34-linux-i586-rpm.bin(2)安装完成后在/etc/profile 文件下加入JDK环境变量:#config javaexport JA VA_HOME=/usr/java/jdk1.6.0_34export CLASSPA TH=.:$JA V A_HOME/lib/tools.jar:$JA V A_HOME/lib/dt.jar export PATH=$J A V A_HOME/bin:$PA TH(3)使设置生效source /etc/profile4、Hadoop配置1)配置hadoop-env.sh 该"hadoop-env.sh"文件位于"/usr/hadoop/etc/hadoop"目录下。

vim /usr/hadoop/etc/hadoop/hadoop-env.sh 在文件的末尾添加下面内容。

# set java environment export JA VA_HOME=/usr/java/jdk1.8.0_05 2)配置yarn-env.sh 修改JA V A_HOME值export JA VA_HOME=/usr/java/jdk1.8.0_05 / 3)配置slaves文件添加以下内容:(为数据节点服务器相应的IP地址)192.168.1.3 192.168.1.4 并将原有的localhost行去掉。

4)配置core-site.xml文件修改Hadoop核心配置文件core-site.xml,这里配置的是HDFS的地址和端口号。

文件修改后的内容如下:<configuration> <property> <name>hadoop.tmp.dir</name> <value>/usr/hadoop/tmp</value> <description>A base for other temporary directories.</description> </property> <!--file system properties --> <property> <name>fs.defaultFS</name> <value>hdfs://192.168.1.2:9000</value> </property> </configuration> 备注:如没有配置hadoop.tmp.dir参数,此时系统默认的临时目录为:/tmp/hadoo-hadoop。

而这个目录在每次重启后都会被干掉,必须重新执行format 才行,否则会出错。

5)配置hdfs-site.xml文件文件修改后的内容如下:<configuration> <property> <name>node.secondary.http-address</name> <value>192.168.1.2:9001</value> </property> <property> <name>.dir</name><value>file:/usr/hadoop/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/usr/hadoop/dfs/data</value> </property> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.webhdfs.enabled</name> <value>true</value> </property> </configuration> 6)配置mapred-site.xml文件将mapred-queues.xml.template复制成mapred-site.xml文件,修改Hadoop中MapReduce的配置文件,配置的是JobTracker的地址和端口。

修改后的mapred-site.xml文件内容如下:<configuration> <property> <name></name> <value>yarn</value> </property> </configuration> 7)配置yarn-site.xml文件修改后该文件的内容如下:<configuration> <property> <name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value> </property><property><name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name><value>ort.apache.hadoop.mapred.ShuffleHandler</value> </property> <property> <name>yarn.resourcemanager.address</name> <value>192.168.1.2:8032</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name><value>192.168.1.2:8030</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name><value>192.168.1.2:8031</value> </property> <property> <name>yarn.resourcemanager.admin.address</name><value>192.168.1.2:8033</value> </property> <property> <name>yarn.resourcemanager.webapp.address</name><value>192.168.1.2:8088</value> </property> </configuration>5、Hadoop测试此部分主要对Hadoop进行测试。