深度学习基础介绍

深度学习基础知识

深度学习基础知识深度学习(Depth Learning)是机器学习的一个重要分支,旨在模仿人类大脑的工作方式,通过神经网络的构建和训练实现智能化的数据分析与决策。

在深度学习的背后,有一些基础知识需要我们掌握,才能更好地理解和应用深度学习技术。

一、神经网络的基本结构神经网络是深度学习的核心,它由多个神经元组成,每个神经元都有激活函数,能接收来自其他神经元的输入,并产生输出。

神经网络通常包括输入层、隐藏层和输出层,其中隐藏层可以有多个。

输入层接受外部数据输入,隐藏层负责对数据进行特征提取和转换,输出层产生最终的结果。

二、梯度下降算法梯度下降算法是深度学习中最基础且最常用的优化算法,用于调整神经网络中各个神经元之间的连接权重,以最小化损失函数。

在训练过程中,通过计算损失函数对权重的偏导数,不断地更新权重值,使得损失函数逐渐减小,模型的性能逐渐提升。

三、反向传播算法反向传播算法是神经网络中用于训练的关键算法,通过将误差从输出层倒推到隐藏层,逐层计算每个神经元的误差贡献,然后根据误差贡献来更新权重值。

反向传播算法的核心思想是链式法则,即将神经网络的输出误差按照权重逆向传播并进行计算。

四、卷积神经网络(CNN)卷积神经网络是一种主要用于图像处理和识别的深度学习模型。

它通过共享权重和局部感受野的方式,有效地提取图像中的特征。

卷积神经网络通常包括卷积层、池化层和全连接层。

其中卷积层用于提取图像中的局部特征,池化层用于降低特征的维度,全连接层用于输出最终的分类结果。

五、循环神经网络(RNN)循环神经网络是一种主要用于序列数据处理的深度学习模型。

它通过引入时间维度,并在每个时间步上传递隐藏状态,实现对序列数据的建模。

循环神经网络可以解决序列数据中的时序依赖问题,适用于音频识别、语言模型等任务。

六、生成对抗网络(GAN)生成对抗网络是一种通过让生成器和判别器相互博弈的方式,实现模型训练和生成样本的深度学习模型。

生成器负责生成与真实样本相似的假样本,判别器负责对真假样本进行分类。

深度学习基础(CNN详解以及训练过程1)

深度学习基础(CNN详解以及训练过程1)深度学习是⼀个框架,包含多个重要算法:Convolutional Neural Networks(CNN)卷积神经⽹络AutoEncoder⾃动编码器Sparse Coding稀疏编码Restricted Boltzmann Machine(RBM)限制波尔兹曼机Deep Belief Networks(DBN)深信度⽹络Recurrent neural Network(RNN)多层反馈循环神经⽹络神经⽹络对于不同问题(图像,语⾳,⽂本),需要选⽤不同⽹络模型⽐如CNN RESNET等才能达到更好效果。

今天来讲最基础的CNN⽹络。

可以不可以模仿⼈类⼤脑的这个特点,构造多层的神经⽹络,较低层的识别初级的图像特征,若⼲底层特征组成更上⼀层特征,最终通过多个层级的组合,最终在顶层做出分类呢?答案是肯定的,这也是许多深度学习算法(包括CNN)的灵感来源。

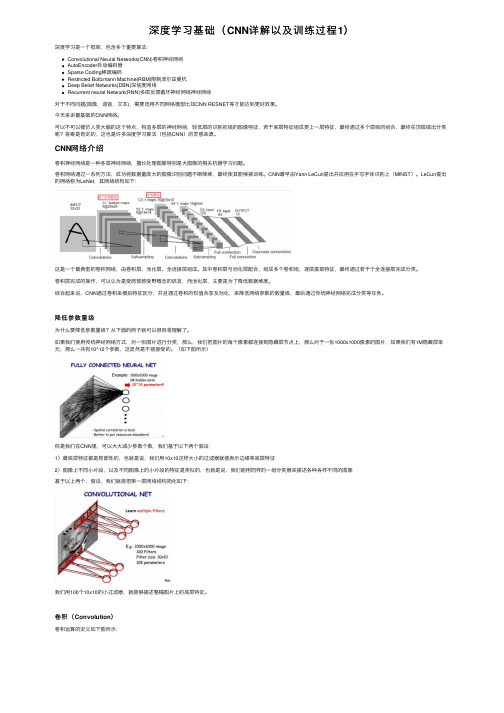

CNN⽹络介绍卷积神经⽹络是⼀种多层神经⽹络,擅长处理图像特别是⼤图像的相关机器学习问题。

卷积⽹络通过⼀系列⽅法,成功将数据量庞⼤的图像识别问题不断降维,最终使其能够被训练。

CNN最早由Yann LeCun提出并应⽤在⼿写字体识别上(MINST)。

LeCun提出的⽹络称为LeNet,其⽹络结构如下:这是⼀个最典型的卷积⽹络,由卷积层、池化层、全连接层组成。

其中卷积层与池化层配合,组成多个卷积组,逐层提取特征,最终通过若⼲个全连接层完成分类。

卷积层完成的操作,可以认为是受局部感受野概念的启发,⽽池化层,主要是为了降低数据维度。

综合起来说,CNN通过卷积来模拟特征区分,并且通过卷积的权值共享及池化,来降低⽹络参数的数量级,最后通过传统神经⽹络完成分类等任务。

降低参数量级为什么要降低参数量级?从下⾯的例⼦就可以很容易理解了。

如果我们使⽤传统神经⽹络⽅式,对⼀张图⽚进⾏分类,那么,我们把图⽚的每个像素都连接到隐藏层节点上,那么对于⼀张1000x1000像素的图⽚,如果我们有1M隐藏层单元,那么⼀共有10^12个参数,这显然是不能接受的。

深度学习教学大纲

深度学习教学大纲深度学习教学大纲深度学习作为人工智能领域的一个重要分支,已经在各个领域展现出了巨大的应用潜力。

为了培养更多的深度学习人才,许多高校和培训机构开始开设相关的课程。

本文将探讨一个完整的深度学习教学大纲,以帮助学习者系统地掌握这一领域的知识和技能。

第一部分:基础知识在深度学习的教学大纲中,首先需要介绍深度学习的基础知识。

这包括神经网络的基本概念和结构,以及常用的深度学习框架和工具。

学习者需要了解神经网络的基本组成部分,如神经元、层和权重,并且能够使用深度学习框架来构建和训练自己的神经网络模型。

第二部分:深度学习算法在深度学习教学大纲的第二部分,需要详细介绍深度学习的核心算法。

这包括卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)等。

学习者需要理解这些算法的原理和应用场景,并且能够使用相应的算法解决实际问题。

第三部分:深度学习应用深度学习的应用领域非常广泛,包括图像识别、语音识别、自然语言处理等。

在深度学习教学大纲的第三部分,需要介绍深度学习在不同领域的应用案例,并且引导学习者独立完成相关的实践项目。

通过实际应用的学习,学习者可以更好地理解深度学习的实际价值和应用方法。

第四部分:深度学习理论与研究深度学习作为一个不断发展的领域,其中的理论和研究也非常重要。

在深度学习教学大纲的第四部分,需要介绍深度学习的一些重要理论和研究方向,如梯度下降、优化算法和迁移学习等。

学习者需要了解这些理论的原理和应用,并且能够阅读和理解相关的研究论文。

第五部分:深度学习实践与项目在深度学习教学大纲的最后一部分,需要引导学习者进行深度学习的实践和项目。

学习者可以选择一个感兴趣的领域或问题,设计并实现一个深度学习模型来解决。

通过实践项目,学习者可以将前面学到的知识和技能应用到实际情境中,加深对深度学习的理解和掌握。

总结:深度学习教学大纲应该从基础知识开始,逐步深入,涵盖算法、应用、理论和实践等方面。

深度学习基础(PPT36页)

CNN的优点

参数减少与权值共享 如下图所示,如果我们有1000x1000(每个隐层神经元都连接图像的每一个像素点),就有 1 0 0 0 1 0 0 0 1 0 0 0 0 0 0 = 1 0 1 2个连接,也就是10^12个权值参数。

局部连接网络,每一个节点与上层节点同位置附近10x10的窗口相连接, 则1百万个隐层神经元就只有 16 0100 18 0,即10^8个参数。其权值连 接个数比原来减少了四个数量级。

深度学习可以通过学习一种深层非线性网络结构,实 现复杂函数逼近,表征输入数据分布式表示,并展现 了强大的从少数样本中集中学习数据及本质特征的能 力。

深度学习的实质

通过构建具有很多隐层的机器学习模型和海量的训练数 据,来学习更有用的特征,从而最终提升分类或预测的 准确性。因此,“深度模型”是手段,“特征学习”是 目的。

人脑的视觉机理

1981年的诺贝尔医学奖获得者 David Hubel和Torsten Wiesel发现了视觉系统的信息处理机制,他们发现了一 种被称为“方向选择性细胞的神经元细胞,当瞳孔发现 了眼前的物体的边缘,而且这个边缘指向某个方向时, 这种神经元细胞就会活跃。

由此可知人的视觉系统的信息处理是分级的,高 层的特征是低层特征的组合,从低层到高层的特征表示 越来越抽象,越来越能表现语义或者意图,抽象层面越 高,存在的可能猜测就越少,就越利于分类。

与神经网络的异同

深度学习与神经网络的异同

神经网络

深度学习

深度学习与神经网络的异同

相同点

二者均采用分层结构,系统包括输入层、隐层(多层)、 输出层组成的多层网络,只有相邻层节点之间有连接,同 一层以及跨层节点之间相互无连接,每一层可以看作是一 个logistic 回归模型。

计算机基础知识什么是深度学习

计算机基础知识什么是深度学习深度学习是一种机器学习的方法,它通过模拟人类大脑神经网络的结构和功能来实现对大规模数据进行有效学习和分析的能力。

与传统的机器学习方法相比,深度学习具有更强大的表达能力和自动特征提取的能力,能够从庞大的数据中发现更复杂、更抽象的规律和特征。

深度学习的基础是神经网络。

神经网络是由大量的神经元(或称为节点)组成的有向图,每个神经元都接收来自其他神经元的输入,并产生一个输出。

这些神经元按照层次结构排列,构成了一个深度的网络。

神经网络的深度决定了它的层数,而每一层神经元的数量决定了其宽度。

深度学习的特点就是使用了具有多个隐藏层的深层神经网络。

深度学习的训练过程可以简单描述为以下几个步骤:1. 数据准备:准备包含有标注信息的大规模数据集,通常需要对数据进行清洗和预处理,以便于网络的学习和训练。

2. 模型构建:选择适当的深度学习模型,根据任务需求设计网络的结构,并设置各层的参数。

3. 前向传播:将输入数据通过神经网络的各层进行计算和传递,逐层得到输出结果。

4. 反向传播:将计算得到的输出结果与真实标签进行比较,计算损失函数,然后沿着网络的反方向进行梯度下降,逐层更新网络参数,以减小损失函数的值。

5. 参数优化:通过反复迭代的训练过程,不断调整网络参数,使得模型的输出结果与真实标签更加接近,提高模型在新数据上的泛化能力。

6. 模型评估:使用验证集或测试集对训练好的模型进行评估性能,根据评估结果对模型进行调整和改进。

深度学习在各个领域都取得了显著的成果。

在计算机视觉领域,通过深度学习技术,可以实现图像分类、目标检测、人脸识别等任务。

在自然语言处理领域,可以通过深度学习技术实现语义理解、机器翻译、情感分析等任务。

此外,深度学习在推荐系统、语音识别、医学影像分析等领域也有广泛应用。

值得注意的是,深度学习需要大量的数据和计算资源来进行训练,特别是在大规模网络和复杂任务上。

同时,模型的设计和参数调整也需要经验和技巧。

公司深度学习面试题目(3篇)

第1篇一、基础知识与概念1. 什么是深度学习?- 深度学习是机器学习的一个子领域,它通过构建和训练深层神经网络模型来模拟人脑处理信息的方式,从而实现复杂模式识别和预测。

2. 什么是神经网络?- 神经网络是一种模仿人脑神经元连接方式的计算模型,由相互连接的神经元组成,通过调整连接权重来学习和存储信息。

3. 请简述神经网络的三个主要组成部分。

- 输入层、隐藏层和输出层。

4. 什么是激活函数?- 激活函数是神经网络中用于引入非线性特性的函数,它可以将线性组合的输出映射到非线性的范围,从而增加模型的表达能力。

5. 常见的激活函数有哪些?请分别说明其特点和适用场景。

- Sigmoid、Tanh、ReLU、Leaky ReLU、ELU等。

Sigmoid和Tanh适用于回归问题,ReLU和Leaky ReLU适用于分类问题。

6. 什么是梯度下降法?- 梯度下降法是一种优化算法,用于调整神经网络中连接权重,以最小化损失函数。

7. 什么是反向传播算法?- 反向传播算法是梯度下降法在神经网络中的应用,通过计算损失函数对网络权重的梯度,来更新网络权重。

8. 什么是过拟合和欠拟合?- 过拟合是指模型在训练数据上表现良好,但在未见数据上表现不佳,即模型对训练数据过于敏感。

欠拟合是指模型在训练数据上表现不佳,即模型对训练数据不够敏感。

二、模型架构与设计9. 什么是卷积神经网络(CNN)?- CNN是一种用于处理图像数据的神经网络,通过卷积层、池化层和全连接层来提取图像特征。

10. 请简述CNN的三个主要层及其作用。

- 卷积层:提取图像特征;池化层:降低特征的空间分辨率;全连接层:进行分类或回归。

11. 什么是循环神经网络(RNN)?- RNN是一种用于处理序列数据的神经网络,能够处理时序信息。

12. 请简述RNN的三个主要组成部分及其作用。

- 输入层:接收序列数据;隐藏层:存储序列信息;输出层:生成序列输出。

13. 什么是长短期记忆网络(LSTM)?- LSTM是一种特殊的RNN,能够学习长期依赖关系。

深度学习的基本原理和应用

深度学习的基本原理和应用一、深度学习的基本原理深度学习是一种通过模仿人脑神经网络的方式进行学习和处理数据的机器学习方法。

其基本的核心原理是通过多层次的神经网络,以及大量的数据进行训练,从而能够从数据中提取出特征信息并进行分类或预测。

1. 多层次神经网络深度学习的核心是多层次的神经网络,每一层神经元都能够接收前一层的输出信息,并将其转化为更为抽象的特征表示。

这些层次可以很深,甚至达到数十层,从而能够处理更为复杂的任务。

2. 特征提取深度学习的另一重要特点是自动特征提取。

在传统机器学习方法中,需要手动进行特征提取,而在深度学习中,神经网络会自动学习并提取数据的特征。

这样可以减少对人工特征提取的依赖,提高了数据处理的效率。

3. 数据训练深度学习需要大量的数据进行训练,这些数据分为训练数据、验证数据和测试数据。

通过反向传播算法,神经网络不断调整参数,使网络输出结果与实际结果更为接近。

二、深度学习的应用深度学习凭借其在图像处理、自然语言处理、语音识别等方面的优异表现,被广泛应用于各个领域。

1. 图像处理深度学习可以应用于图像分类和目标检测等任务。

例如,人脸识别、车辆识别等,深度学习能够对图像中的人脸或车辆进行自动识别分类。

2. 自然语言处理深度学习可以进行语言情感分类、文本分类、机器翻译等任务。

例如,深度学习可以应用于智能语音助手中,自动识别用户语音输入并转化为文字,再进行相关操作。

3. 语音识别深度学习可以应用于语音识别中,例如自动识别用户的语音输入、语音翻译等方面。

深度学习使用了不同类型的神经网络架构,如循环神经网络(RNN)和卷积神经网络(CNN),以提高语音识别的准确性。

三、深度学习的未来发展深度学习在人工智能领域中具有重要意义,其未来将继续发挥更为重要的作用。

随着深度学习技术的不断进步,其在图像处理、语音识别、自然语言处理等方面的应用领域将会不断扩大。

例如,深度学习可能支持更为智能化的医疗诊断、自动驾驶等系统的应用。

深度学习基础

深度学习基础一,滤波器与卷积核在只有一个通道的情况下,“卷积核”就相当于 “filter”,这两个概念是可以互换的。

但在一般情况下,它们是两个完全不同的概念。

每个 “filter” 实际上恰好是“卷积核”的一个集合,在当前层,每个通道都对应一个卷积核,且这个卷积核是独一无二的。

滤波器的数量,卷积核的shape。

二,卷积层和池化输出大小计算不管是TensorFlow、Keras、Caffe还是Pytorch,其卷积层和池化层的参数默认值可能有所不同,但是最终的卷积输出大小计算公式是一样的2.1,CNN中术语解释卷积层主要参数有下面这么几个:卷积核Kernal大小(在Tensorflow/keras中称为filter);填充Padding;滑动步长Stride;输出通道数Channels。

2.2,卷积输出大小计算1,图片经卷积Conv2D后输出大小计算公式如下:$\left \lfloor N = \frac{W-F+2P}{S}+1 \right \rfloor$,其中${\color{Red} \left \lfloor \right \rfloor}$"是向下取整符号,用于结果不是整数时进行向下取整。

输入图片大小W×W(默认输入尺寸为正方形)Filter大小F×F步长Spadding的像素数P输出特征图大小N×N2,反卷积(也叫转置卷积)keras-Conv2DTranspose(pytorch-ConvTranspose2d)得到的图片大小计算方式:反卷积的大小是由卷积核大小与滑动步长决定, $in$ 是输入大小, $k$ 是卷积核大小, $s$ 是滑动步长,padding的像素数 $p$, $out$ 是输出大小。

得到 $out = (in - 1) * s -2p + k$,还有另外一个写法:$W = (N - 1)*S - 2P + F$。

反卷积也称为转置卷积,一般主要用来还原feature map的尺寸大小,在cnn可视化,fcn中达到pixel classification,以及gan中从特征生成图像都需要用到反卷积的操作。

深度学习技术基础知识文档

深度学习技术基础知识文档第一章:深度学习概述1.1 什么是深度学习•深度学习是一种基于人工神经网络的机器学习方法,通过使用多层神经网络来实现复杂的数据处理和分析。

它可以学习数据的高级抽象特征和模式,实现对数据的精确识别和预测。

1.2 深度学习的核心原理•深度学习的核心原理包括:反向传播算法、激活函数、优化算法等。

这些原理使得深度学习网络可以学习数据的高级抽象特征和模式。

第二章:主要方法介绍2.1 卷积神经网络(CNN)•CNN是一种基于卷积和池化操作的神经网络,主要用于图像识别和分类。

它可以学习图像的局部特征和全局特征,实现对图像的精确识别和分类。

2.2 循环神经网络(RNN)•RNN是一种基于递归和循环连接的神经网络,主要用于序列数据的处理和分析。

它可以学习序列数据的时序特征和依赖关系,实现对序列数据的精确识别和预测。

2.3 长短时记忆网络(LSTM)•LSTM是一种基于门控循环单元的神经网络,主要用于序列数据的处理和分析。

它可以学习序列数据的长期依赖关系和时序特征,实现对序列数据的精确识别和预测。

第三章:应用领域3.1 自然语言处理(NLP)•NLP是人工智能的一个分支,主要研究如何使计算机理解和处理人类语言。

深度学习在NLP中的应用包括:文本分类、情感分析、机器翻译等。

3.2 计算机视觉(CV)•CV是人工智能的一个分支,主要研究如何使计算机理解和处理图像和视频。

深度学习在CV中的应用包括:图像识别、目标检测、图像生成等。

第四章:伦理考量4.1 数据隐私保护•数据隐私保护是深度学习应用中的一个重要伦理问题。

我们需要确保数据的隐私和安全,避免数据的滥用和泄露。

4.2 AI偏见和公平性•AI偏见和公平性是深度学习应用中的一个重要伦理问题。

我们需要确保AI系统的公平性和无偏见,避免AI系统的歧视和偏见。

第五章:结论•深度学习是一种强大的机器学习方法,可以实现对数据的精确识别和预测。

通过了解深度学习的核心原理和主要方法,我们可以更好地应用深度学习技术来解决实际问题。

深度学习与图像处理实战 第1章 深度学习基础

2006 年

2010 年

2012 年

2014 年

2016 年

2017 年

1.4 ห้องสมุดไป่ตู้度神经网络概述

1.4.1 VGGNet

VGGNet 是由英国牛津大学计算机视觉 组和 DeepMind 团队研究员一起研发的 深度卷积神经网络。它探索了卷积神经 网络的深度和其性能之间的关系,通过 反复地堆叠 3×3 的小型卷积核和 2×2 的最大池化层,成功地构建了 16~19 层的卷积神经网络。

条件的制约

深度学习的计算量非常大 对高性能硬件的依赖性较强 深度学习的模型复杂度很高

1.3 深度学习的历史

1.3.1 深度学习的起源

第 1 章 深度学习基础

5

1958 年 罗森布拉特正式提出了由两层神经元组成的神经网络,将其称为“感知机”。

➢ 感知机本质上是一种线性模型,可以对输入的训练集数据进行二分类,且能够在训 练集中自动更新权值。

第 1 章 深度学习基础

8

VGGNet 获得了 2014 年 ILSVRC 的 亚军和定位项目的冠军,在 ILSVRC 公开数据集上的错误率为 7.5%。到目 前为止,VGGNet 依然被用来提取图 像的特征。

1.4 深度神经网络概述

1.4.2 GoogLeNet

第 1 章 深度学习基础

9

GoogLeNet 是 Google 团队为了参加 2014 年的 ILSVRC 而精心准备的,是 2014 年 ILSVRC 的冠军。VGGNet 继承了 AlexNet 的一些框架结构,而 GoogLeNet 则做了更加大 胆的网络结构尝试,虽然其深度只有 22 层,但大小却比 AlexNet 和 VGGNet 小很多。 GoogLeNet 参数为 500 万个,AlexNet参数数量约是 GoogLeNet 的 12 倍,VGGNet 参 数数量又约是 AlexNet 的 3 倍,因此在内存或计算资源有限时,GoogLeNet 是比较好的选 择。从模型结果来看,GoogLeNet 的性能更加优越。

深度学习基础知识解读

深度学习基础知识解读第一章深度学习的背景和概念1.1 人工智能与机器学习的发展历程1.2 深度学习的定义和特点1.3 深度学习与传统机器学习的区别第二章神经网络及其基本原理2.1 人脑神经系统简介2.2 人工神经网络概述2.3 基本神经网络的结构和运行机制2.4 优化算法:梯度下降和反向传播第三章深度学习常用的网络结构3.1 卷积神经网络(CNN)3.1.1 卷积和池化层的原理3.1.2 LeNet-5网络结构解析3.1.3 AlexNet网络结构解析3.2 循环神经网络(RNN)3.2.1 循环单元(RNN unit)的原理3.2.2 长短时记忆网络(LSTM)的结构和应用 3.2.3 双向循环神经网络第四章深度学习的主要应用领域4.1 计算机视觉4.1.1 图像分类和目标检测4.1.2 图像分割和语义分割4.2 自然语言处理4.2.1 语言模型和文本生成4.2.2 机器翻译4.2.3 文本分类和情感分析4.3 语音识别和合成4.3.1 语音识别原理与技术4.3.2 语音合成原理与技术4.4 推荐系统4.4.1 基于内容的推荐4.4.2 协同过滤推荐4.4.3 深度学习在推荐系统中的应用第五章深度学习的训练和优化技巧5.1 数据预处理5.1.1 数据清洗和归一化处理5.1.2 数据增强技术5.2 正则化技术5.2.1 L1和L2正则化5.2.2 Dropout正则化5.2.3 批归一化(Batch Normalization) 5.3 学习率调整策略5.3.1 学习率衰减5.3.2 动量方法5.3.3 自适应学习算法(Adam)第六章深度学习的挑战和未来发展趋势6.1 深度学习存在的问题和挑战6.1.1 数据需求和标注困难6.1.2 模型的复杂性和计算资源要求6.2 深度学习的未来趋势6.2.1 模型压缩和轻量化网络6.2.2 自迁移学习和跨域学习6.2.3 强化学习和深度强化学习通过本文,我们深入解读了深度学习的基础知识。

深度学习面试基本知识

深度学习面试基本知识深度学习是机器学习的一个分支,它通过建立多层神经网络模型来模拟人类的神经系统,从而实现对数据的学习和分析。

在深度学习领域,掌握一些基本知识是进行面试的必备条件。

本文将介绍一些深度学习面试中常见的基本知识点。

1. 神经网络基础神经网络是深度学习的核心模型,它由多个神经元组成,每个神经元接收来自上一层神经元的输入,并将输入通过激活函数处理后传递给下一层神经元。

常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)和循环神经网络(Recurrent Neural Network)等。

在面试中,你可能需要了解以下几个与神经网络相关的知识点:1.1 激活函数激活函数是神经网络中的一种非线性函数,它的作用是引入非线性因素,增加网络的表示能力。

常见的激活函数有Sigmoid函数、ReLU函数和Tanh函数等。

你需要理解这些激活函数的定义、特点以及适用场景。

1.2 损失函数损失函数用于衡量神经网络输出与真实值之间的差异,是深度学习中的一个重要概念。

常见的损失函数有均方误差(Mean Squared Error)和交叉熵(Cross Entropy)等。

你需要了解这些损失函数的定义、优缺点以及适用场景。

1.3 反向传播算法反向传播算法是训练神经网络的核心算法,它通过计算损失函数对网络参数的导数,从而根据梯度下降的原理进行参数更新。

你需要了解反向传播算法的基本原理,包括链式法则和梯度计算方法。

2. 卷积神经网络(CNN)卷积神经网络是深度学习中用于处理图像和语音等二维数据的重要模型。

它通过卷积、池化和全连接等操作来提取输入数据的特征,并进行分类或回归预测。

在面试中,你可能需要了解以下几个与卷积神经网络相关的知识点:2.1 卷积层卷积层是卷积神经网络的核心组件,它通过滑动窗口的方式对输入数据进行卷积操作,从而提取特征信息。

你需要了解卷积层的基本原理、参数设置以及卷积核的作用。

软件开发中的深度学习介绍

软件开发中的深度学习介绍在当今科技发展的潮流中,深度学习已经成为了研究的热点,它不仅在图片、语音识别和自然语言处理等领域有广泛应用,同时在软件开发中也发挥着重要作用。

本文将为大家介绍深度学习的基本概念,以及如何将其应用于软件开发中。

一、什么是深度学习?深度学习是一种机器学习的方法,它采用了模拟人类大脑神经网络的思想,通过多层神经元联结,实现高效的数据处理和自动化的学习。

深度学习的核心就在于它的多层次结构,这些层次可以自动提取出数据中的重要特征,并进行分类和预测等任务。

二、深度学习在软件开发中的应用1. 自然语言处理深度学习在自然语言处理领域的应用相当广泛,可以用于文本分类、情感分析、机器翻译等任务。

通过训练深度神经网络,可以让计算机具备理解和处理自然语言的能力,大大提高了软件系统的智能化水平。

2. 图像处理随着数字化时代的到来,人们已经习惯了使用图像来表达信息。

深度学习在图像处理方面有着很好的应用。

例如,通过卷积神经网络提取图像的特征,可以实现自动识别物体、人脸识别、机器视觉等功能。

3. 人工智能深度学习是AI领域中最重要的技术之一,人工智能是崛起的大趋势,开发人员需要了解如何利用深度学习技术开发出更强大的AI系统。

利用深度学习提取数据中的特征,可以让计算机自主学习,从而实现更智能化的决策和任务处理。

三、如何学习深度学习?想要学习深度学习,应该掌握以下几点:1. 掌握机器学习和神经网络的基本概念,了解各种算法的原理和应用。

2. 学会使用TensorFlow、Keras、PyTorch等深度学习框架,了解各种框架的特点和使用方法。

3. 参加开源项目,实践深度学习技术,在实践中逐渐理解。

4. 学会根据数据训练深度学习模型,将其应用于实际项目中。

四、学习深度学习需要哪些基础?深度学习的学习需要较强的数学基础和计算机编程基础。

以下是学习深度学习需要具备的基础知识:1. 线性代数:线性代数是深度学习的基础,学习者需要掌握矩阵运算和线性方程组求解等知识。

深度学习的基础知识

深度学习的基础知识深度学习(Deep Learning)是一种基于人工神经网络的机器学习方法,它模拟人类大脑的结构和功能,通过多层次的非线性处理单元对数据进行特征提取和建模,从而实现对复杂问题的学习和推断。

深度学习在语音识别、图像识别、自然语言处理和推荐系统等领域取得了广泛的应用和突破,成为了当今人工智能领域的热点之一。

本文将从深度学习的基本原理、常见模型和应用实例等方面介绍深度学习的基础知识,帮助读者深入了解深度学习的相关内容。

一、深度学习的基本原理深度学习模型的核心是人工神经网络(Artificial Neural Networks,ANNs),它由大量的神经元(Neurons)和连接它们的权重(Weights)组成,每个神经元接收来自前一层神经元的输入,并对其进行加权和非线性变换后输出给下一层神经元。

整个网络通过多层次的非线性处理单元逐层组合,形成了深度结构,从而能够学习到更加复杂的特征和模式。

1.神经元的工作原理神经元是人工神经网络的基本组成单元,它模拟了生物神经元的工作原理。

每个神经元接收来自前一层神经元的多个输入信号,通过加权和非线性变换后输出给下一层神经元。

具体来说,神经元的输入经过加权和求和后,再经过一个激活函数(Activation Function)进行非线性变换,最终输出给下一层神经元。

常用的激活函数包括Sigmoid函数、ReLU函数和tanh函数等。

2.神经网络的训练人工神经网络通过学习来调整连接权重,使得网络能够适应输入数据的特征和模式。

网络的训练通常采用梯度下降法(Gradient Descent)。

具体来说,网络先进行前向传播,将输入数据通过每层神经元的加权和非线性变换后输出给输出层,然后计算输出层的预测值与真实标签值的误差,最后通过反向传播算法将误差逐层传递回去,调整每个神经元的权重。

3.深度学习的优化深度学习模型通常会面临的问题包括梯度消失和梯度爆炸等。

为了解决这些问题,人们提出了许多优化方法,如Batch Normalization、Dropout和Residual Network等。

深度学习技术的基础原理及实现方法

深度学习技术的基础原理及实现方法随着人工智能技术的不断发展,深度学习在计算机视觉、自然语言处理等领域中得到了广泛应用。

深度学习利用神经网络进行数据分析和学习,实现了一系列人类智能无法完成的任务。

本文将深入探讨深度学习技术的基础原理及实现方法,并探讨其在实际应用中的优势与不足。

一、深度学习的基础原理1.神经网络模型神经网络是深度学习的基础模型,其模仿人脑神经元工作方式。

神经网络由输入层、输出层和多个中间层构成。

每一层神经元都与下一层的神经元之间有连接。

每个神经元都有自己的权重和偏置,输入数据通过各层传递,最后计算输出。

2.反向传播算法神经网络训练的核心是反向传播算法,它是一种基于梯度下降的优化算法,通过反向传播误差信号对神经元的权重和偏置进行调整,减小误差。

反向传播算法是深度学习的基础算法,实现了对数据的自动学习和分类。

3.深度学习框架深度学习框架是使用深度学习技术进行建模和训练的工具,常见的深度学习框架有TensorFlow、PyTorch、Keras等。

深度学习框架提供了模型搭建、训练和评估等一揽子服务,方便开发者快速实现深度学习模型。

二、深度学习的实现方法1.卷积神经网络卷积神经网络是深度学习中应用最广泛的模型之一,主要用于图像识别和处理。

卷积神经网络的核心是卷积层和池化层,卷积层在提取图像特征的同时减少参数数量,池化层则对特征进行降维操作。

2.递归神经网络递归神经网络主要用于自然语言处理领域,如语言模型、翻译和文本生成等。

递归神经网络通过对句子中单词的依存关系进行建模,实现了对自然语言的理解和处理。

3.生成对抗网络生成对抗网络是一种用于生成虚拟数据的深度学习模型,可以生成高度逼真的图像、音频和视频等。

生成对抗网络由生成器和判别器两个部分组成,生成器试图生成逼真的样本数据,判别器则尝试区分真实的和生成的数据。

三、深度学习的优势与不足1.优势深度学习在诸多领域中取得了优秀的成果,如计算机视觉、自然语言处理等,其具有以下优势:(1) 更准确的预测和分类能力;(2) 可以自动提取和学习更复杂的特征;(3) 可以处理大规模数据;(4) 可以处理非线性问题。

深度学习课件-第2讲:深度学习基础

=

1

exp

2 2

1

− 2

2

−

2

由精度参数化(Parametrized by precision):

; , −1

=

exp

2

1

−

2

−

2

高斯分布

多元高斯分布

由协方差矩阵参数化(Parametrized by covariance

matrix):

1

exp

(2) det(σ)

摩尔-彭若斯广义逆

+

=

• 方程组解的情况包括:

― 仅有一个解:此时摩尔-彭若斯广义逆矩阵与逆矩阵相

同

― 无解:此时会给出解的最小误差 −

― 多个解:此时会给出范数最小的解

2

迹(Trace)

= ,

矩阵的迹的性质:

+ = +

自信息:

= −log ()

信息熵:

H = ~

= ~ log ()

KL散度:

∥ = ~

= ~ − ()

KL散度是不对称的

∗ = ∥

∗ = ∥

1979 – deep neocognitron, convolution, Fukushima

1987 – autoencoder, Ballard

1989 – convolutional neural networks (CNN), Lecun

1991 – deep recurrent neural networks (RNN), Schmidhuber

深度学习的基础知识

深度学习的基础知识深度学习是一种以人类神经系统为模型,通过多层神经网络进行自我训练以达到学习、分类、识别等目的的机器学习技术。

深度学习不仅在语音识别、自然语言处理、图像识别等领域具有广泛应用,而且在金融风险控制、医学影像处理、智能交通等领域也有很大的发展空间。

深度学习的基础知识包含以下几个方面:多层神经网络、反向传播算法、激活函数、损失函数、优化算法等。

1.多层神经网络(Multi-Layer Neural Network)多层神经网络是深度学习的基础,它是由多层神经元组成的神经网络,其层数一般指输入层、隐藏层和输出层。

输入层通常用来接收输入数据,隐藏层是处理中间信息的层,输出层是输出最终结果的层。

神经元是神经网络的基本单元,它接收逐层传入的信息,在进行加权和运算之后,产生输出,并对输出进行激活处理。

多层神经网络的训练一般采用反向传播算法,基于梯度下降的优化策略,不断调整每个神经元的权重和偏置值,使神经网络的输出结果逐渐接近实际结果。

2.反向传播算法(Back Propagation Algorithm)反向传播算法是多层神经网络进行训练时的一种常用方法。

它通过计算误差之间的链式关系,逐层反向传递误差,并根据误差来调整每个神经元的权重和偏置值,从而达到优化神经网络的目的。

反向传播算法的关键在于计算误差的梯度值,通过链式法则来求得每个神经元的误差贡献,然后根据梯度下降的方法,对每个神经元的权重和偏置值进行调整,从而使神经网络不断逼近实际结果。

3.激活函数(Activation Function)神经元的激活函数是指神经元接收到输入信号之后,生成输出信号的一种函数。

常用的激活函数包括sigmoid函数、ReLU函数、tanh 函数等等。

不同的激活函数有不同的特点,选择合适的激活函数可以有效地提高神经网络的效率和准确率。

Sigmoid函数是一种常用的激活函数,它可以将神经元的输出限制在0到1之间。

ReLU函数是近年来比较火热的激活函数,它可以有效克服神经网络梯度消失的问题,提高神经网络的训练速度和准确率。

深度学习的理论与实践

深度学习的理论与实践深度学习已成为人工智能领域的热门话题,它以其强大的数据处理和模式识别能力在各个领域中取得了重大的突破。

本文将深入探讨深度学习的理论基础以及其在实践中的应用。

一、深度学习的理论基础深度学习是一种模仿人类神经系统的机器学习方法,其核心是人工神经网络。

人工神经网络由多个模拟神经元组成,这些神经元通过学习权重和模式识别来进行信息处理。

深度学习的理论基础包括以下几个关键概念:1. 神经元和激活函数:神经元是人工神经网络的基本单元,它模拟了生物神经元的工作原理。

激活函数则用于决定神经元的输出结果,常用的激活函数包括Sigmoid函数、ReLU函数等。

2. 前馈神经网络:前馈神经网络是最简单的神经网络结构,它由输入层、隐藏层和输出层组成。

输入层接收外部输入,隐藏层进行信息处理,输出层输出结果。

3. 反向传播算法:反向传播算法是训练神经网络的关键算法,它通过计算神经网络中每个神经元的误差,并根据误差调整权重和偏置,从而最小化输出与真实值之间的差距。

4. 深度神经网络:深度神经网络是一种具有多个隐藏层的神经网络结构,它能够学习到更复杂的特征和模式。

深度学习通过堆叠多个隐藏层来构建深度神经网络,进而提高模型的性能。

二、深度学习的实践应用深度学习在各个领域中都有广泛的应用,下面介绍几个典型的实践应用案例:1. 图像识别:深度学习在图像识别领域取得了巨大的成功。

通过训练深度神经网络,可以实现高准确率的图像分类、目标检测和图像分割等任务。

例如,在人脸识别方面,深度学习技术已经可以实现与人类相媲美的准确率。

2. 自然语言处理:深度学习在自然语言处理中也有广泛的应用。

通过深度神经网络的语言模型和序列模型,可以实现机器翻译、文本生成、情感分析等任务。

例如,谷歌的神经机器翻译系统就是基于深度学习技术的。

3. 语音识别:深度学习在语音识别领域也有重要应用。

通过深度神经网络的声学模型和语言模型,可以提高语音识别系统的准确率和鲁棒性。

深度学习课件从零基础到熟练掌握(附PPT资料)

3

深度学习发展历程

深度学习的前身为神经网络,自20世纪50年代开始发展,近年来随着算法和硬件 的进步,深度学习取得了突破性进展。

深度学习应用

图像识别与物体检测

利用深度学习算法对图像进行分析,实现物 体检测、人脸识别、车牌识别等应用。

自然语言处理

针对文本数据进行分析和处理,包括语音识 别、机器翻译、情感分析等应用。

4

适用于研究和实验。

深度学习的老牌框架,C++实现, 支持多GPU并行计算和CPU实现,

适用于图像处理等领域。

深度学习案例

领域 图像识别 自然语言处理 金融预测 智能控制

应用 人脸识别 机器翻译 股票预测 机器人控制

案例 FaceNet GNMT Dr. Stoxx MuZero

总ቤተ መጻሕፍቲ ባይዱ及学习资料

1 深度学习的发展

从零基础到熟练掌握深度 学习

深度学习是人工智能的重要分支,本课程将带领你逐步掌握深度学习的核心 概念和算法,并帮助你在实际应用中取得突破性的进展。

深度学习概述

1

什么是深度学习?

深度学习是一种机器学习方法,通过深层神经网络模拟人脑神经元,从而识别、 分类、处理复杂的数据。

2

深度学习的优势

深度学习能够自动提取数据的特征,具有精度高、鲁棒性强、适应性强等优点, 在图像识别、自然语言处理、智能推荐等领域拥有广泛应用。

由Google开发的深度学习框架,支

Keras

2

持Python、Java等语言,具有易于 使用、高效灵活等特点。

基于TensorFlow等后端引擎的深度

学习框架,采用便于理解的API,

支持快速实现模型和调参。

3

深度学习理论基础

深度学习的理论基础2.1 深度学习原理深度学习,相对机器学习中的“浅层学习”方法,深度学习所需的神经元网络层数更多[16]。

传统的机器学习依靠人为提取样本单层特征,结果的特征缺乏可以进一步表达图像的构造; 而深度学习可以直接自动的从训练网络里提取所需要的结构特征,自动提取的特征解决了人工提取特征存在主管偏差的因素。

对于一个n 层网络S (1S ,…n S ),有输入是I ,得到输出是O ,即为:I =>1S =>2S =>…..=>n S => O ,如果O 和I 相等,即可认为I 经过网络处理后没有损失。

设a 处理得到b ,再对b 处理得到c ,得到:a 和c 的相关不会超过a 和c 的相关。

这表明网络不会增加数据,会损失数据。

如果结果相等,可以得到I 经过每一个神经元i S 都没有丢失,即所有i S 都是I 的等价。

对于深度学习网络,首先我们有大量的原始数据,即大量的I ,在本课题中为大量的眼底图像图像。

我们可以寻找一个n 层深度网络S ,调整网络结构后,输入I 等于输出O ,那么输入I 的结构即可以通过1S ,…,n S 来得到。

深度学习的核心方法为拥有多个层1S ,…, n S 的网络,即让1 i S 层的输入为i S 。

通过这种方法,就可以获得输入信息I 结构特征。

这就是深度学习的核心结构。

深度网络主要有3类,如图2.1所示。

图2.1 深度神经网络分类结构在本次课题中,主要用到前馈深度网络(FFDN),其中卷积神经网络(CNN) 在数字图像处理中有十分巨大的发展,将会运用到眼底图像的质量分类实验中。

2.2 前馈深度网络最传统有效的深度学习结构为深度前馈网络,即为前馈神经网络。

设计一个理想函数f 。

如一个深度前馈网络,)(x f y =可以将x 变换为输出y 。

一个前馈网络定义了);(θx f y =,通过迭代变量θ,获得与原始图像的参数误差最小的估算值。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2016/06

33

主要函数

其他的特殊层

Split 复制层

输入是1个blob,输出是多个blob。目的是将输入复制成多份,用于多重输出的情况

Flatten

Reshape Concat Slice Eltwise ArgMax

向量化层

改变输出格式层 合并层 切分层 eltment-wise操作层 求取前K个极大值层

2016/06

32

主要函数

卷积层

滤波器的个数num_output 滤波器的大小kernel_size / kernel_h / kernel_w 卷积的步长(默认为1)stride / stride_h / stride_w 两边补0的长度(默认为1)pad / pad_h / pad_w 分组系数(默认为1,不常用)group,如果大于1,我们限制卷积的连接操 作在一个子集内。如果我们根据图像的通道来分组,那么第i个输出分组 只能与第i个输入分组进行连接 滤波器权重和偏置量的初始值weight(bias)_filler::type 权重和偏置量的学习速率lr_mult: 学习率的系数,最终的学习率是这个 数乘以solver.prototxt配置文件中的base_lr。如果有两个lr_mult, 则第一 个表示权值的学习率,第二个表示偏置项的学习率。一般偏置项的学习 率是权值学习率的两倍 滤波器是否引入偏置量(默认为true) bias_term

2016/06

19

[1] Alexnet网络

网络基本结构

[1] 2012-NIPSImageNet Classification with Deep ConvolutionalNeural Networks

2016/06

20

Alexnet网络

网络细节解读[1]

Conv1

[1] /sunbaigui/article/details/39938097

[1] http://ouxinyu.github.io/Blogs/20151108001.html

2016/06

29

caffe的三层数据结构

blob是四维数组(n*k*h*w),n为batchsize的大小,k为channel的个 数,h为图像的高度,w为图像的宽度。blob中同时保存了数据和梯 度两部分内容,也定义了不修改数值和修改数值两种数据访问方法, 并使用Syncedem自动决定什么时候执行copy以提高效率。(datum可 看成是没有num维度的blob,datum为三维矩阵,c*h*w) layer共分成五大类层结构,每层的输入数据都来自于bottom,输 出数据为top,每层定义了三种操作,setup(layer初始化),forward 和backward。 net为由layer组成的有向无环图(DAG)。模型定义在.prototxt文件中, 训练好的模型在.binaryproto文件中,模型格式由caffe.proto定义。

为什么要使用多隐藏层的结构? 1、适合多层知识体系学习; 例:图像识别:边缘-几何形状-不变性特征-… 2、泛化能力更强; 3、隐藏层本质是一个特征探测器(feature detector); 学习数据的内在结构特征,不是映射关系;

2016/06

9

卷积神经网络(CNN)

网络的基本结构 激活函数(Activation Function)的选择 卷积层(Conv)的作用 池化层(Pooling)的作用 Softmax层的作用 网络的预处理

深度学习基础介绍

报告人:王松 报告时间:2016.06

2016/06

1

目录

一.从神经元到多层感知器(MLP) 二.卷积神经网络(CNN) 三.两种常见的网络结构 四.caffe工具基础介绍

2016/06

2

从神经元到多层感知器(MLP)

神经网络的基本结构 神经网络的大量参数 神经网络的强表现力

2016/06

27

caffe工具基础介绍

各文件夹基本作用 Caffe的三层数据结构 主要函数 代码运行

2016/06

28

各文件夹基本作用

Caffe的安装[1] /caffe-master/

cmake data docker docs examples include matlab models python scripts src tools 编译配置文件 存放下载的数据 程序封装方法 帮助文档 代码样例 caffe 实现的头文件 MATLAB接口文件 模型参数 Python接口文件 文档和数据用到的脚本 实现caffe的源文件 保存的源码用于生成二进制处理程序

2016/06

16

Softmax层的作用

二分类问题(logistic回归):

多分类问题即将二分类问题拓展; Softmax损失函数为交叉熵损失函数(Cross Entropy Error Function);

2016/06

17

[1] 网络的预处理

网络初始化

权重值——经验公式:0.01*rand(D)/sqrt(D); 偏置量——全置0;

[1] /chap4.html

2016/06

6

神经网络的强表现力

普适逼近原理(Universal approximation theorem):单隐藏层神经网 络可以逼近任意函数[1]

[1] /chap4.html

神经元个数

层级数+每层个数;神经元总数;

激活函数

Sigmoid;tanh;ReLu;

训 练

4.

神经元间连接权重

5.

神经元偏差项(bias)

2016/06

5

神经网络的强表现力

普适逼近原理(Universal approximation theorem):单隐藏层神经网 络可以逼近任意函数[1] ������ = −������ ������ ������ = ������������������������������������������ ������������ + ������

2016/06

13

卷积层的作用

概念来自于信号与系统,其数学表达类似于信号互相关(Crosscorrelation) ;

卷积运算也可为一种提取特征的滤波过程;

在图像领域常表现为模板(mask)运算;

2016/06

14

卷积层的作用

概念来自于信号与系统,其数学表达类似于信号互相关(Crosscorrelation) ;

输入是1个n*c*h*w的blob,输出为n*(c*h*w)*1*1的blob 输入是1个n*c*h*w的blob,输出依据reshape_param变成不同的四维矩阵格式 输入是多个blob,输出是1个blob,依据axis参数设定多个blob的合并规则

2016/06

7

神经网络的强表现力

普适逼近原理(Universal approximation theorem):单隐藏层神经网 络可以逼近任意函数[1]

[1] /chap4.html

2016/06

8

神经网络的强表现力

2016/06

10

网络的基本结构

前向网络; 隐藏层有三类:卷积层(conv),池化层(pooling),全连接层(fc); 输出层完成多分类任务,多为Softmax层; 网络训练算法:误差反向传播算法(BP);

2016/06

11

激活函数的选择

激活函数的作用

增加网络的非线性性,拓展了网络的表达能力; 使输出为连续值,便于网络训练;

2016/06

25

[1] fcn网络

网络基本架构

全连接层->卷积层 1000维向量->原图大小

[1] 2015-CVPR-Fully convolutional networks for semantic segmentation

2016/06

26

fcn网络

Deconv

简单上采样结果很差 可以看成引入了高层信息 局部信息有所丢失

卷积运算也可为一种提取特征的滤波过程;

在图像领域常表现为模板(mask)运算; 底层获得边缘信息,高层表达更鲁棒的特征[1g Convolution in Deep Learning

2016/06

15

池化层的作用

池化层常用最大池化(max-pooling),也有平均池化; 减少数据量,抑制过拟合,提高鲁棒性; Dropout(类似的正则化操作):随机丢弃部分数据,抑制过拟合;

数据预处理

数据归一化——简单缩放(彩色图像); 均值消减(灰度图像); 白化——使各维度分布一致,降低输入的冗余性;

[1] /wiki/index.php/UFLDL_Tutorial

2016/06

18

两种常见的网络结构

Alexnet网络 fcn网络

2016/06

30

主要函数

参考文献

http://yufeigan.github.io/2014/12/09/Caffe%E5%AD%A6%E4%B9%A0%E7% AC%94%E8%AE%B01%E5%AE%89%E8%A3%85%E4%BB%A5%E5%8F%8A%E4%BB%A3%E7%A0%8 1%E7%BB%93%E6%9E%84/ /doxygen/index.html /

2016/06

23

Alexnet网络

网络细节解读[1]

Fc6

[1] /sunbaigui/article/details/39938097

2016/06

24

Alexnet网络

网络细节解读[1]

Fc7

Fc8

[1] /sunbaigui/article/details/39938097