二元线性回归模型及参数估计

二元线性回归模型及参数估计

要估计二元线性回归模型 Yi = β0 + β1X1i + β2 X 2i + µi 中的 常用的方法仍然是普通最小二乘法 参数 β 0 、 β 1 、 β 2 ,常用的方法仍然是 普通最小二乘法 常用的方法仍然是 普通最小二乘法。

i=1 设根据给定一组样本数据( Y i, X 1i, X 2i), ,2 ,…, n , 设根据给定一组样本数据 采用普通最小二乘法估计得到的样本回归模型为

ˆ 差(即 ∆X j = SXj) ,则被解释变量 Y 变化β ∗ 个标准差(即 j

ˆ ∆Y = β ∗ SY ) 。 j

ˆ∗ ˆ∗ β1 =1.02, β2 = 0.24,则表示:解释变量 X1 变化 1 个 例如

标准差,将引起被解释变量 Y 变化 1.02 个标准差;解释变 量 X2 变化 1 个标准差,将引起被解释变量 Y 变化 0.24 个标 准差。因此,可以说,Y 对于 X1 变化的敏感程度远大于 Y 对于 X2 变化的敏感程度。

1.偏回归系数的估计 .

对于二元线性回归模型:

Yi = β 0 + β1X1i + β 2 X 2i + µi , i=1, 2, … , n

其中的参数 β 0 、 β 1 、 β 2 称为偏回归系数。

,

所谓偏回归系数, 所谓偏回归系数,是指多元线性回归模型中解释变量前 偏回归系数 的系数。其含义是:当其他解释变量保持不变时, 的系数。其含义是:当其他解释变量保持不变时,某一解释 变量变化一个单位而使被解释变量Y平均改变的数值, 变量变化一个单位而使被解释变量 平均改变的数值,即某一 平均改变的数值 解释变量对被解释变量Y的影响程度。 解释变量对被解释变量 的影响程度。 的影响程度

线性回归分析的基本原理

线性回归分析的基本原理线性回归分析是一种常用的统计分析方法,用于研究两个变量之间的线性关系。

它通过拟合一条直线来描述两个变量之间的关系,并利用这条直线进行预测和推断。

本文将介绍线性回归分析的基本原理,包括模型假设、参数估计、模型评估等内容。

一、模型假设线性回归分析的基本假设是:自变量和因变量之间存在线性关系,并且误差项服从正态分布。

具体来说,线性回归模型可以表示为:Y = β0 + β1X + ε其中,Y表示因变量,X表示自变量,β0和β1表示模型的参数,ε表示误差项。

线性回归模型假设误差项ε服从均值为0、方差为σ^2的正态分布。

二、参数估计线性回归模型的参数估计通常使用最小二乘法。

最小二乘法的基本思想是通过最小化观测值与模型预测值之间的差异来估计模型的参数。

具体来说,最小二乘法的目标是最小化残差平方和:min Σ(Yi - (β0 + β1Xi))^2通过对残差平方和进行求导,可以得到参数的估计值:β1 = Σ(Xi - X̄)(Yi - Ȳ) / Σ(Xi - X̄)^2β0 = Ȳ - β1X̄其中,Xi和Yi分别表示观测值的自变量和因变量,X̄和Ȳ分别表示自变量和因变量的均值。

三、模型评估线性回归模型的拟合程度可以通过多个指标进行评估,包括决定系数(R^2)、标准误差(SE)和F统计量等。

决定系数是用来衡量模型解释变量变异性的比例,其取值范围为0到1。

决定系数越接近1,说明模型对观测值的解释能力越强。

标准误差是用来衡量模型预测值与观测值之间的平均误差。

标准误差越小,说明模型的预测精度越高。

F统计量是用来检验模型的显著性。

F统计量的计算公式为:F = (SSR / k) / (SSE / (n - k - 1))其中,SSR表示回归平方和,SSE表示残差平方和,k表示模型的自由度,n表示观测值的个数。

F统计量的值越大,说明模型的显著性越高。

四、模型应用线性回归分析可以用于预测和推断。

通过拟合一条直线,可以根据自变量的取值来预测因变量的值。

多元线性回归模型参数估计

多元线性回归模型参数估计多元线性回归是一种用于建立自变量与因变量之间关系的统计模型。

它可以被视为一种预测模型,通过对多个自变量进行线性加权组合,来预测因变量的值。

多元线性回归模型的参数估计是指利用已知的数据,通过最小化误差的平方和来估计回归模型中未知参数的过程。

本文将介绍多元线性回归模型参数估计的基本原理和方法。

Y=β0+β1X1+β2X2+...+βpXp+ε其中,Y是因变量,X1、X2、..、Xp是自变量,β0、β1、β2、..、βp是回归系数,ε是残差项。

参数估计的目标是找到使得误差的平方和最小的回归系数。

最常用的方法是最小二乘法(Ordinary Least Squares, OLS)。

最小二乘法通过最小化残差的平方和来确定回归系数的值。

残差是观测值与回归模型预测值之间的差异。

为了进行最小二乘法参数估计,需要计算回归模型的预测值。

预测值可以表示为:Y^=β0+β1X1+β2X2+...+βpXp其中,Y^是因变量的预测值。

参数估计的目标可以表示为:argmin(∑(Y - Y^)²)通过对目标函数进行求导,可以得到参数的估计值:β=(X^TX)^-1X^TY其中,X是自变量的矩阵,Y是因变量的向量,^T表示矩阵的转置,^-1表示矩阵的逆。

然而,在实际应用中,数据往往存在噪声和异常值,这可能导致参数估计的不准确性。

为了解决这个问题,可以采用正则化方法,如岭回归(Ridge Regression)和LASSO回归(Least Absolute Shrinkage and Selection Operator Regression)。

这些方法通过在目标函数中引入正则化项,可以降低估计结果对噪声和异常值的敏感性。

岭回归通过在目标函数中引入L2范数,可以限制回归系数的幅度。

LASSO回归通过引入L1范数,可以使得一些回归系数等于零,从而实现变量选择。

这些正则化方法可以平衡模型的拟合能力与泛化能力,提高参数估计的准确性。

多元线性回归模型及其参数估计多元线性回归的显著性

多元线性回归模型及其参数估计多元线性回归的显著性Y=β0+β1X1+β2X2+...+βnXn+ε其中,Y表示因变量(被预测或解释的变量),X1,X2,...,Xn表示自变量(用于预测或解释因变量的变量),β0,β1,β2,...,βn表示模型的参数,ε表示误差项。

参数估计就是指通过样本数据来估计模型中的参数。

在多元线性回归中,常用的参数估计方法是最小二乘法。

最小二乘法的目标是最小化实际观测值与回归方程所预测值之间的残差平方和。

为了评估多元线性回归模型的显著性,可以进行假设检验。

最常用的假设检验是利用F检验来检验整个回归模型的显著性。

F检验的原假设是回归模型中所有自变量的系数都等于零,即H0:β1=β2=...=βn=0,备择假设是至少存在一个自变量的系数不等于零,即H1:β1≠β2≠...≠βn≠0。

F统计量的计算公式为:F=(SSR/k)/(SSE/(n-k-1))其中,SSR表示回归平方和,即实际观测值与回归方程所预测值之间的残差平方和,k表示自变量的个数,SSE表示误差平方和,即实际观测值与回归方程所预测值之间的残差平方和,n表示样本容量。

根据F统计量的分布特性,可以计算得出拒绝原假设的临界值,若计算出来的F统计量大于临界值,则可以拒绝原假设,认为回归模型是显著的,即至少存在一个自变量对因变量有显著影响。

除了整体的回归模型显著性检验,我们还可以进行各个自变量的显著性检验。

每一个自变量的显著性检验都是基于t检验。

t检验的原假设是自变量的系数等于零,即H0:βi=0,备择假设是自变量的系数不等于零,即H1:βi≠0。

t统计量的计算公式为:t = (βi - bi) / (SE(βi))其中,βi表示模型中第i个自变量的系数估计值,bi表示模型中第i个自变量的理论值(一般为零),SE(βi)表示第i个自变量的系数的标准误。

根据t统计量的分布特性,可以计算得出对应自由度和置信水平的临界值,若计算出来的t统计量的绝对值大于临界值,则可以拒绝原假设,认为该自变量是显著的,即对因变量有显著影响。

线性回归模型的参数估计

计算过程

牛顿-拉夫森方法首先计算误差函数的Hessian矩阵,然 后使用这个矩阵来构造一个线性方程组,求解该方程组可 以得到参数的更新值。

缺点

对初值敏感,且计算Hessian矩阵的开销较大。

2023

PART 03

线性回归模型的假设和限 制

REPORTING

线性关系假设

01

线性关系假设是线性回归模型的 核心,即因变量和自变量之间存 在一种线性关系,可以用一条直 线来描述。

2023

线性回归模型的参数 估计

https://

REPORTING

2023

目录

• 引言 • 参数估计的方法 • 线性回归模型的假设和限制 • 参数估计的步骤 • 参数估计的挑战与解决方案 • 参数估计的应用场景

2023

PART 01

引言

REPORTING

线性回归模型的定义

2023

THANKS

感谢观看

https://

REPORTING

最小二乘法

原理

最小二乘法是一种数学优化技术 ,通过最小化预测值与实际值之

间的平方误差来估计参数。

计算过程

最小二乘法通过构建一个误差 的平方和,然后找到使这个和 最小的参数值。

优点

计算简单,易于理解和实现。

缺点

对异常值敏感,且无法处理非 线性问题。

梯度下降法

原理

梯度下降法是一种迭代优化算法,通 过不断沿着误差函数的负梯度方向更 新参数,以最小化误差函数。

市场细分

通过分析消费者行为数据,利用线性回归模型对 市场进行细分,帮助企业更好地了解目标客户群 体。

价格预测

在商品定价方面,利用线性回归模型预测商品价 格变动趋势,为企业制定合理的定价策略提供依 据。

简单线性回归模型的公式和参数估计方法以及如何利用模型进行

简单线性回归模型的公式和参数估计方法以及如何利用模型进行数据预测一、简单线性回归模型的公式及含义在统计学中,线性回归模型是一种用来分析两个变量之间关系的方法。

简单线性回归模型特指只有一个自变量和一个因变量的情况。

下面我们将介绍简单线性回归模型的公式以及各个参数的含义。

假设我们有一个自变量X和一个因变量Y,简单线性回归模型可以表示为:Y = α + βX + ε其中,Y表示因变量,X表示自变量,α表示截距项(即当X等于0时,Y的值),β表示斜率(即X每增加1单位时,Y的增加量),ε表示误差项,它表示模型无法解释的随机项。

通过对观测数据进行拟合,我们可以估计出α和β的值,从而建立起自变量和因变量之间的关系。

二、参数的估计方法为了求得模型中的参数α和β,我们需要采用适当的估计方法。

最常用的方法是最小二乘法。

最小二乘法的核心思想是将观测数据与模型的预测值之间的误差最小化。

具体来说,对于给定的一组观测数据(Xi,Yi),我们可以计算出模型的预测值Yi_hat:Yi_hat = α + βXi然后,我们计算每个观测值的预测误差ei:ei = Yi - Yi_hat最小二乘法就是要找到一组参数α和β,使得所有观测值的预测误差平方和最小:min Σei^2 = min Σ(Yi - α - βXi)^2通过对误差平方和进行求导,并令偏导数为0,可以得到参数α和β的估计值。

三、利用模型进行数据预测一旦我们估计出了简单线性回归模型中的参数α和β,就可以利用这个模型对未来的数据进行预测。

假设我们有一个新的自变量的取值X_new,那么根据模型,我们可以用以下公式计算对应的因变量的预测值Y_new_hat:Y_new_hat = α + βX_new这样,我们就可以利用模型来进行数据的预测了。

四、总结简单线性回归模型是一种分析两个变量关系的有效方法。

在模型中,参数α表示截距项,β表示斜率,通过最小二乘法估计这些参数的值。

多元线性回归模型的参数估计

在最小二乘法基础上,对不同的观测值赋予不同的权重,以调整其 对回归参数估计的影响。

广义最小二乘法(GLS)

考虑自变量之间的相关性,通过转换自变量和因变量来消除自变量 之间的多重共线性影响。

03

参数估计的方法

普通最小二乘法

最小二乘法是一种常用的参数估计方法,通过最小化误差 平方和来估计参数。在多元线性回归模型中,普通最小二 乘法通过求解线性方程组来得到参数的估计值。

模型选择

选择多元线性回归模型作 为预测模型,以商品价格 和用户评价作为自变量, 销量作为因变量。

参数估计

使用最小二乘法进行参数 估计,通过最小化误差平 方和来求解回归系数。

模型检验

对模型进行假设检验,确 保满足线性回归的前提假 设。

结果解释与模型评估

结果解释

根据回归系数的大小和符号,解释各自变量对因变量 的影响程度和方向。

05

参数估计的实例分析

数据来源与预处理

数据来源

数据来源于某大型电商平台的销售数据,包括商 品价格、销量、用户评价等。

数据清洗

对原始数据进行清洗,去除异常值、缺失值和重 复值,确保数据质量。

数据转换

对连续变量进行离散化处理,对分类变量进行独 热编码,以便进行回归分析。

模型建立与参数估计

01

02

03

THANKS

感谢观看

04

参数估计的步骤

确定模型形式

确定自变量和因变

量

首先需要确定回归模型中的自变 量和因变量,通常因变量是研究 的响应变量,自变量是对响应变 量有影响的预测变量。

确定模型的形式

根据自变量和因变量的关系,选 择合适的回归模型形式,如线性 回归、多项式回归等。

线性回归模型的构建与分析

线性回归模型的构建与分析线性回归是统计学中一种常见的建模方法,用于研究自变量与因变量之间的线性关系。

在实际应用中,线性回归模型被广泛用于预测、分析和建模。

本文将介绍线性回归模型的构建与分析过程,包括数据准备、模型建立、参数估计、模型评估等内容。

一、数据准备在构建线性回归模型之前,首先需要准备数据集。

数据集应包括自变量(特征)和因变量(目标变量),并且需要保证数据的质量和完整性。

通常情况下,我们会对数据进行清洗、缺失值处理、特征选择等操作,以确保数据的可靠性和有效性。

二、模型建立线性回归模型的数学表达形式为:$$Y = \beta_0 + \beta_1X_1 + \beta_2X_2 + ... + \beta_nX_n +\varepsilon$$其中,$Y$为因变量,$\beta_0$为截距,$\beta_1, \beta_2, ...,\beta_n$为自变量的系数,$X_1, X_2, ..., X_n$为自变量,$\varepsilon$为误差项。

在建立模型时,需要根据实际问题选择合适的自变量,并利用最小二乘法等方法估计模型参数。

最小二乘法是一种常用的参数估计方法,通过最小化观测值与模型预测值之间的残差平方和来求解模型参数。

三、参数估计参数估计是线性回归模型中的关键步骤,它决定了模型的准确性和可靠性。

在参数估计过程中,我们需要计算各个自变量的系数$\beta_1, \beta_2, ..., \beta_n$,以及截距$\beta_0$。

这些参数的估计值将决定模型的形状和拟合程度。

通过最小二乘法可以求解出参数的闭式解,也可以利用梯度下降等迭代方法进行参数估计。

在实际应用中,通常会结合交叉验证等技术来选择最优的模型参数,以提高模型的泛化能力。

四、模型评估模型评估是判断线性回归模型好坏的重要标准。

常用的模型评估指标包括均方误差(Mean Squared Error,MSE)、决定系数(Coefficient of Determination,$R^2$)、残差分析等。

多元线性回归模型的参数估计

n 2

1 ቤተ መጻሕፍቲ ባይዱ

2

e

x x x ))2 ( yi ( 0 1 1i 2 2i k ki

1

n (2)

n 2

1

e

2

)(Y X) 2 (Y X

• 对数或然函数为

* L L nL ()

1 ' n L n (2 ) ( Y X )( Y X ) 2 2

1 T E ( NN ) E n

1

12 n E n 1

1 n n2

2 0

0 2I 2

标量符号 4、 (为了假设检验) ,随机扰动项服从正态分布

i ~ N(0, 2 )

i 1,2,, n

矩阵符号 4、向量 N 为一多维正态分布,即

N ~ N(0, 2 I )

二、多元线性回归模型的参数估计

1、普通最小二乘估计

• 普通最小二乘估计

随 机 抽 取 被 解 释 变 量 和 解 释 变 量 的 n 组 样 本 观 测 值 :

且x的秩1??kx?此时xxt也是满秩的标量符号2随机误差项具有零均值同方差及不序列相关0?ie?ni21??22?????iievarni21??0??jijiecov????ji?矩阵符号2innenet20???011???????????????????????nneeene?????????????????????????????nntenne??????11???????????21121nnne???????????i22200????????????????????标量符号3解释变量与随机项不相关0?ijixcov?ni21??矩阵符号30?nxet即011????????????????????????????????????ikiiiiikiiiiexexexxe????????标量符号4为了假设检验随机扰动项服从正态分布02??nini21??矩阵符号4向量n为一多维正态分布即02inn?二多元线性回归模型的参数估计11普通最小二乘估计?普通最小二乘估计随机抽取被解释变量和解释变量的n组样本观测值

二项式回归模型

二项式回归模型二项式回归模型是一种常用的统计学方法,用于分析两个变量之间的关系。

它是一种线性回归模型,适用于因变量为二元变量的情况。

在本文中,我们将介绍二项式回归模型的基本概念、应用场景、建模方法以及模型评估等方面的内容。

一、基本概念二项式回归模型是一种用于分析两个变量之间关系的统计学方法。

其中,因变量为二元变量,即只有两种取值,通常用0和1表示。

自变量可以是连续变量或分类变量。

二项式回归模型的目的是通过自变量来预测因变量的取值。

二、应用场景二项式回归模型在实际应用中有着广泛的应用场景。

例如,在医学研究中,可以使用二项式回归模型来分析某种疾病的发病率与年龄、性别、生活习惯等因素之间的关系;在市场营销中,可以使用二项式回归模型来预测某种产品的销售量与价格、广告投入、竞争对手等因素之间的关系。

三、建模方法建立二项式回归模型的方法与普通线性回归模型类似,主要包括以下几个步骤:1. 收集数据:收集自变量和因变量的数据,并进行数据清洗和预处理。

2. 确定自变量:根据实际情况,选择与因变量相关的自变量,并进行变量筛选和变量转换等操作。

3. 拟合模型:使用最大似然估计等方法,拟合二项式回归模型,并得到模型的参数估计值。

4. 模型诊断:对模型进行诊断,检验模型的拟合效果和假设检验等。

5. 模型预测:使用拟合好的模型,对新的自变量进行预测,并得到因变量的预测值。

四、模型评估在建立二项式回归模型时,需要对模型进行评估,以确定模型的拟合效果和预测能力。

常用的模型评估方法包括:1. 残差分析:通过分析模型的残差,来评估模型的拟合效果和误差分布情况。

2. 模型选择准则:使用AIC、BIC等模型选择准则,来选择最优的模型。

3. 假设检验:通过对模型参数进行假设检验,来评估模型的显著性和可靠性。

4. 预测准确度:通过对模型进行交叉验证等方法,来评估模型的预测准确度和泛化能力。

五、总结二项式回归模型是一种常用的统计学方法,适用于因变量为二元变量的情况。

线性回归模型的基本原理

线性回归模型的基本原理线性回归是一种常用的统计分析方法,用于建立自变量和因变量之间的线性关系模型。

它的基本原理是通过拟合一条直线或者超平面来描述自变量和因变量之间的关系,从而进行预测和分析。

一、线性回归模型的表示线性回归模型可以表示为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε其中,Y表示因变量,X1、X2、...、Xn表示自变量,β0、β1、β2、...、βn表示模型的系数,ε表示误差项。

二、模型参数的估计线性回归模型的参数估计是通过最小二乘法来实现的。

最小二乘法的目标是使得模型预测值与实际观测值之间的残差平方和最小化。

具体而言,我们需要求解模型参数β0、β1、β2、...、βn,使得残差平方和最小。

可以通过求解下面的正规方程组来得到参数的估计值:X'Xβ = X'Y其中,X是自变量矩阵,X'表示X的转置,Y是因变量向量,β是参数向量。

三、模型的评估在得到模型的参数估计值之后,我们需要对模型进行评估,以判断模型的拟合程度和预测能力。

常用的评估指标包括:1. 残差平方和(SSE):表示模型预测值与实际观测值之间的差异程度,SSE越小表示模型拟合程度越好。

2. 均方误差(MSE):是SSE除以样本量的平均值,用于衡量模型的预测能力。

3. 决定系数(R-squared):表示模型解释变量的方差比例,取值范围为0到1,越接近1表示模型的解释能力越强。

四、模型的应用线性回归模型广泛应用于各个领域,例如经济学、金融学、社会科学等。

它可以用于预测和分析各种现象和问题,如股票价格预测、销售量预测、房价预测等。

线性回归模型的优点是简单易懂,计算效率高,可以提供可解释性强的结果。

然而,线性回归模型也有一些限制,例如对于非线性关系的建模能力较弱,容易受到异常值的影响。

五、模型的改进为了克服线性回归模型的一些限制,研究者们提出了许多改进的方法,如岭回归、lasso回归、弹性网等。

多元线性回归模型的公式和参数估计方法以及如何进行统计推断和假设检验

多元线性回归模型的公式和参数估计方法以及如何进行统计推断和假设检验多元线性回归模型是一种常用的统计分析方法,它在研究多个自变量与一个因变量之间的关系时具有重要的应用价值。

本文将介绍多元线性回归模型的公式和参数估计方法,并讨论如何进行统计推断和假设检验。

一、多元线性回归模型的公式多元线性回归模型的一般形式如下:Y = β0 + β1X1 + β2X2 + ... + βkXk + ε其中,Y表示因变量,X1至Xk表示自变量,β0至βk表示模型的参数,ε表示误差项。

在多元线性回归模型中,我们希望通过样本数据对模型的参数进行估计,从而得到一个拟合度较好的回归方程。

常用的参数估计方法有最小二乘法。

二、参数估计方法:最小二乘法最小二乘法是一种常用的参数估计方法,通过最小化观测值与模型预测值之间的残差平方和来估计模型的参数。

参数估计的公式如下:β = (X^T*X)^(-1)*X^T*Y其中,β表示参数矩阵,X表示自变量的矩阵,Y表示因变量的矩阵。

三、统计推断和假设检验在进行多元线性回归分析时,我们经常需要对模型进行统计推断和假设检验,以验证模型的有效性和可靠性。

统计推断是通过对模型参数的估计,来对总体参数进行推断。

常用的统计推断方法包括置信区间和假设检验。

1. 置信区间:置信区间可以用来估计总体参数的范围,它是一个包含总体参数真值的区间。

2. 假设检验:假设检验用于检验总体参数的假设是否成立。

常见的假设检验方法有t检验和F检验。

在多元线性回归模型中,通常我们希望检验各个自变量对因变量的影响是否显著,以及模型整体的拟合程度是否良好。

对于各个自变量的影响,我们可以通过假设检验来判断相应参数的显著性。

通常使用的是t检验,检验自变量对应参数是否显著不等于零。

对于整体模型的拟合程度,可以使用F检验来判断模型的显著性。

F检验可以判断模型中的自变量是否存在显著的线性组合对因变量的影响。

在进行假设检验时,我们需要设定显著性水平,通常是α=0.05。

23多元线性回归模型的参数估计

23多元线性回归模型的参数估计多元线性回归是一种机器学习算法,用于预测因变量与多个自变量之间的关系。

其数学模型可表示为:y = β0 + β1*x1 + β2*x2 + ... + βn*xn + ε其中,y是因变量,x1, x2, ..., xn是自变量,β0, β1,β2, ..., βn为待估计的参数,ε为误差项。

参数估计是指通过样本数据,求解出最佳参数值的过程,常用的方法有最小二乘法。

最小二乘法的基本思想是使残差平方和最小化,即求解出使误差平方和最小的参数估计。

具体的参数估计方法有多种,下面介绍常用的两种方法:普通最小二乘法和梯度下降法。

1.普通最小二乘法:普通最小二乘法是最常用的参数估计方法,通过最小化残差平方和来估计参数。

其基本思想是求解出使误差平方和最小的参数估计。

数学上,可以通过最小化误差平方和的一阶导数为0来求解最佳参数估计。

2.梯度下降法:梯度下降法是一种优化算法,通过迭代的方式逐步更新参数值,使损失函数逐渐趋于最小值。

参数的更新是根据误差和参数的梯度进行的,即参数的更新方向是误差下降最快的方向。

模型参数估计的步骤如下:1.收集样本数据:收集包含自变量和因变量的样本数据。

2.设定初值:为模型中的参数设定初值。

3.定义损失函数:根据模型定义损失函数,即误差平方和。

4.选择优化算法:选择合适的优化算法进行参数估计,如最小二乘法或梯度下降法。

5.迭代计算:通过迭代计算的方式更新参数值,使误差逐渐减小。

6.收敛判断:判断模型是否已经收敛,即误差是否足够小。

7.输出参数估计值:当模型收敛后,输出最佳参数估计值。

总结:多元线性回归模型的参数估计是通过最小化误差平方和的方法求解最佳参数估计。

常用的方法有普通最小二乘法和梯度下降法。

参数估计的步骤包括收集样本数据、设定初值、定义损失函数、选择优化算法、迭代计算、收敛判断和输出参数估计值。

第四讲_(计量经济学第二章)

^ − ^ − ^ − β0 = Y − β1 X1 − β2 X2 ^ ( ∑ yi x1i )∑ x22i −( ∑ yi x2i )∑ x1i x2i 2 2 2 β1 = ∑ x1i ∑ x2 i −( ∑ x1i x2 i ) ^ ( y x ) x2 −( y x ) x x β 2 = ∑ i 2i 2∑ 1i 2 ∑ i 1i ∑2 1i 2i ∑ x1i ∑ x2 i −( ∑ x1i x2 i )

∑x1i x2i )x2i ]Y

= ∑k1iYi

∑ x12i −( ∑ yi x1i )∑ x1i x2i β2 = ∑ x2 x2 −( ∑ x x )2 1i 2 i 1i ∑ 2 i 2 ∑[(∑ x1i ) x2 i yi ]−∑[(∑ x1i x2 i ) x1i yi ] = 2 2 2 ∑ x1i ∑ x2 i −( ∑ x1i x2 i ) 2 [(∑ x1i ) x2 i −( ∑ x1i x2 i ) x1i ] = ∑{ ∑ x2 x2 −( ∑ x x )2 yi } 1i 2 i 1i ∑ 2 i

二元线性回归 模型参数的普 通最小二乘估 计。

1、将解简化: 、将解简化:

β1 =

=

∑[(

^

( ∑ yi x1i )

∑ ∑x1i x2i 2 2 2 ∑ x1i ∑x2i −( ∑ x1i x2i )

2 x2i −( ∑ yi x2i )

∑

2 x2i )x1i yi ]−∑[(

∑

(

x1i x2i )x2i yi ]

α

2

1 − α p{| T1 |< t } = 1 − α

^ ^

^ ^ 2 1 2 1

得置信区间: 得置信区间: ( β 1 − t α × S β , β 1 + t α × S β )

线性回归模型及其参数估计

线性回归模型及其参数估计线性回归模型是一种常用的统计分析方法,用于研究自变量和因变量之间的关系。

它的基本假设是,自变量和因变量之间存在线性关系,并且误差项服从正态分布。

在实际应用中,线性回归模型可以用于预测和解释因变量的变化。

一、线性回归模型的基本形式线性回归模型的基本形式可以表示为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε其中,Y表示因变量,X1、X2、...、Xn表示自变量,β0、β1、β2、...、βn表示模型的参数,ε表示误差项。

二、参数估计方法为了确定模型中的参数,需要通过样本数据进行估计。

常用的参数估计方法有最小二乘法和最大似然估计法。

1. 最小二乘法最小二乘法是一种常用的参数估计方法,它的基本思想是通过最小化观测值与估计值之间的差异来确定参数。

具体而言,最小二乘法通过最小化残差平方和来估计参数。

残差是指观测值与估计值之间的差异,残差平方和是所有残差平方的总和。

最小二乘法的优势在于它是一种无偏估计方法,即在大样本情况下,估计值的期望等于真实值。

2. 最大似然估计法最大似然估计法是一种基于概率统计的参数估计方法,它的基本思想是通过选择参数值,使得观测到的样本数据出现的概率最大化。

最大似然估计法的优势在于它是一种有效的估计方法,能够提供参数的置信区间和假设检验等统计推断。

三、线性回归模型的评估指标在应用线性回归模型时,需要评估模型的拟合程度和预测能力。

常用的评估指标有残差平方和、决定系数和均方根误差等。

1. 残差平方和残差平方和是评估模型拟合程度的指标,它表示观测值与估计值之间的差异的总和。

残差平方和越小,说明模型的拟合程度越好。

2. 决定系数决定系数是评估模型预测能力的指标,它表示因变量的变异程度中能够被自变量解释的比例。

决定系数的取值范围为0到1,越接近1表示模型的预测能力越好。

3. 均方根误差均方根误差是评估模型预测能力的指标,它表示观测值与估计值之间的差异的平均值的平方根。

二元线性回归模型和参数估计

ˆ0 Y ˆ1X1 ˆ2 X 2

ˆ1

(

y

i

x

1i

)(

x2

2i

)

(

y

i

x

2i

)(

x

1i

x

2i

)

(

x2

1i

)(

x2

2i

)

(

x

1i

x

2i

)2

ˆ2

(

yi x2i )( x12i ) ( yi x1i )( x1i x2i ) ( x12i )( x22i ) ( x1i x2i )2

其中, xi Xi X, yi Yi Y , X

设根据给定一组样本数据( Yi,X1i,X2i),i=1,2,…, n , 采用一般最小二乘法估计得到旳样本回归模型为

Yi ˆ0 ˆ1X1i ˆ2X2i ei ,则参数估计量 ˆ 0 、 ˆ1 、ˆ 2 应

该使 残差平方和

n

ei2

n (Yi

Yˆi )2

n (Yi

ˆ0 ˆ1X1i

ˆ2i X 2i )2

i1 i1

i 1

到达最小。

根据极值存在旳必要条件,应该有

ei2

ˆ0

2 (Yi

ˆ0

ˆ1X1i

ˆ2 X 2i ) 0

ei2

ˆ1

2 (Yi

ˆ0

ˆ1X1i

ˆ2 X 2i )X1i

0

ei2

ˆ2

2 (Yi

ˆ0

ˆ1X1i

ˆ2 X 2i )X 2i

0

用

ˆ

j

表示

Beta

系数,则

ˆ

j

ˆ j

S Xj SY

线性回归分析方法

线性回归分析方法线性回归是一种常用的统计分析方法,用于研究自变量与因变量之间的线性关系。

本文将介绍线性回归的基本原理、模型假设、参数估计方法以及结果解释等内容,帮助读者更好地理解和应用线性回归分析方法。

一、线性回归的基本原理线性回归假设自变量和因变量之间存在线性关系,通过拟合一个线性方程来描述这种关系。

假设我们有一个因变量Y和一个自变量X,线性回归模型可以表示为:Y = β0 + β1X + ε其中,β0是截距,β1是自变量的回归系数,ε是误差项,表示模型无法完全解释的因素。

线性回归的目标是找到最佳的回归系数,使得预测值与真实值之间的误差最小化。

二、线性回归的模型假设在线性回归分析中,有几个关键的假设前提需要满足:1. 线性关系假设:自变量和因变量之间的关系是线性的。

2. 独立性假设:观测样本之间是相互独立的,误差项之间也是独立的。

3. 同方差性假设:误差项具有相同的方差,即误差项的方差在不同的自变量取值下是恒定的。

4. 正态性假设:误差项服从正态分布。

如果以上假设不满足,可能会导致线性回归分析的结果不可靠。

三、线性回归的参数估计方法线性回归的参数估计方法通常使用最小二乘法(Ordinary Least Squares, OLS)来确定回归系数。

最小二乘法的思想是通过最小化观测值与估计值之间的残差平方和来拟合回归模型。

具体而言,我们可以通过以下步骤来估计回归系数:1. 计算自变量X和因变量Y的均值。

2. 计算自变量X和因变量Y与其均值的差。

3. 计算X与Y的差乘积的均值。

4. 计算X的差的平方的均值。

5. 计算回归系数β1和β0。

四、线性回归模型的结果解释线性回归模型的结果可以用来解释自变量对因变量的影响程度以及回归系数的显著性。

通常我们会关注以下几个指标:1. 回归系数:回归系数β1表示自变量X单位变化时,因变量Y的平均变化量。

回归系数β0表示当自变量X为零时,因变量Y的平均值。

2. R平方:R平方是衡量模型拟合优度的指标,它表示因变量Y的变异中有多少百分比可以由自变量X来解释。

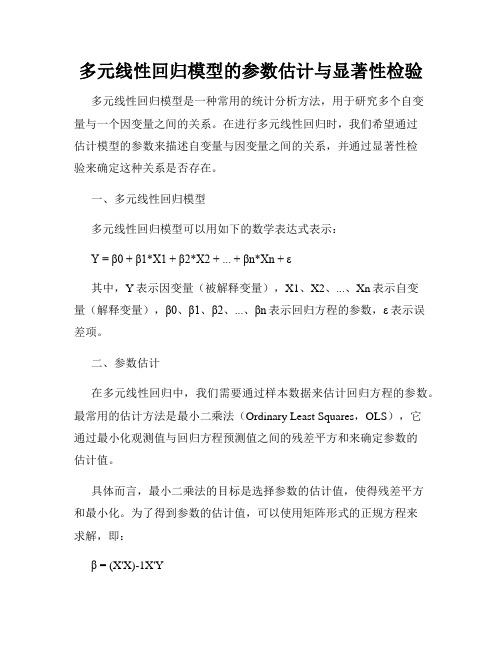

多元线性回归模型的参数估计与显著性检验

多元线性回归模型的参数估计与显著性检验多元线性回归模型是一种常用的统计分析方法,用于研究多个自变量与一个因变量之间的关系。

在进行多元线性回归时,我们希望通过估计模型的参数来描述自变量与因变量之间的关系,并通过显著性检验来确定这种关系是否存在。

一、多元线性回归模型多元线性回归模型可以用如下的数学表达式表示:Y = β0 + β1*X1 + β2*X2 + ... + βn*Xn + ε其中,Y表示因变量(被解释变量),X1、X2、...、Xn表示自变量(解释变量),β0、β1、β2、...、βn表示回归方程的参数,ε表示误差项。

二、参数估计在多元线性回归中,我们需要通过样本数据来估计回归方程的参数。

最常用的估计方法是最小二乘法(Ordinary Least Squares,OLS),它通过最小化观测值与回归方程预测值之间的残差平方和来确定参数的估计值。

具体而言,最小二乘法的目标是选择参数的估计值,使得残差平方和最小化。

为了得到参数的估计值,可以使用矩阵形式的正规方程来求解,即:β = (X'X)-1X'Y其中,β是参数的估计值,X是自变量矩阵,Y是因变量向量,X'表示X的转置,-1表示逆矩阵。

三、显著性检验在进行多元线性回归时,我们通常希望确定自变量与因变量之间的关系是否显著存在。

为了进行显著性检验,我们需要计算模型的显著性水平(p-value)。

常见的显著性检验方法包括F检验和t检验。

F检验用于判断整体回归模型的显著性,而t检验用于判断单个自变量对因变量的显著性影响。

F检验的假设为:H0:模型中所有自变量的系数均为零(即自变量对因变量没有显著影响)H1:模型中至少存在一个自变量的系数不为零在进行F检验时,我们计算模型的F统计量,然后与临界值进行比较。

若F统计量大于临界值,则拒绝原假设,认为回归模型显著。

而t检验的假设为:H0:自变量的系数为零(即自变量对因变量没有显著影响)H1:自变量的系数不为零在进行t检验时,我们计算各个自变量系数的t统计量,然后与临界值进行比较。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

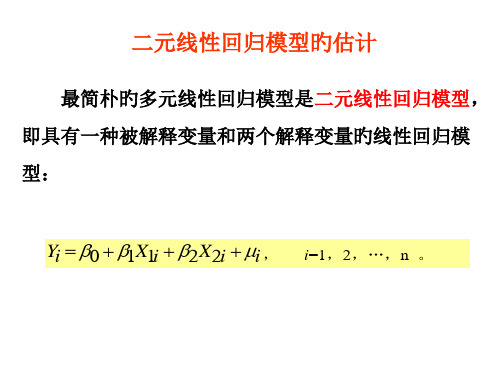

最简单的多元线性回归模型是二元线性回归模型, 即具有一个被解释变量和两个解释变量的线性回归模 型:

Yi 0 1X1i 2X2i i , i=1,2,…,n 。

一、二元线性回归模型的参数估计

1.偏回归系数的估计

对于二元线性回归模型:

Yi 0 1X1i 2X2i i ,i=1,2,…,n ,

x

2i

)2

偏回归系数 ˆ1 、ˆ2 的标准误差计算公式为:

Se(ˆ1) Var(ˆ1)

Se(ˆ2 ) Var(ˆ2 )

二、Beta系数和弹性系数

在多元回归分析中,需要说明各个解释变量 的相对重要性,或者比较被解释变量对各个解释 变量的敏感性。

然而,偏回归系数与变量的原有计量单 位有直接联系,计量单位不同,彼此不能直 接比较。 为此,需要引进Beta系数和弹性系数。

例如 1 1.78 ,2 0.45 ,则表示:在样本均值附近,X1 每 增加 1%,将使被解释变量 Y 增加 1.78%;而 X2 每增加 1%, 将使被解释变量 Y 增加 0.45%,所以,被解释变量 Y 对于解 释变量 X1 变化的敏感程度远大于对解释变量 X2 变化的敏感 程度。

1.Beta系数

Beta系数是由偏回归系数转换来的。

用

ˆ

j

表示

Beta

系数,则

ˆ

j

ˆ j

S Xj SY

ˆ j

x2ji yi2

其中

SXj

x2ji n 1

(X ji Xi)2 n 1

SY

yi2 n 1

(Yi Y )2 n 1

可见,Beta系数是用解释变量标准差(SXj)和被解释变 量标准差(SY)的比例对估计的偏回归系数进行调整后 得到的,其数值与变量的单位无关,因而可以直接比较, 用于说明多元回归模型中解释变量的相对重要性。

2.弹性系数

弹性系数是某一变量的相对变化引起另一变量的相对 变化的度量,即变量的变化率之比。

用 j 表示弹性系数,则

j

dY Y

dX j Xj

dY dX j

Xj Y

ˆ

j

Xj Y

平均弹性是指在样本均值附近的弹性,即

j

ˆ j

Xj Y

弹性系数与原解释变量的计量单位没有任何关系,因此 很适宜用来说明被解释变量对解释变量变化的敏感程度。

Y

变化ˆ

j

个标准差(即

Y

ˆ

j

SY

)。

例如 ˆ1 1.02,ˆ2 0.24 ,则表示:解释变量 X1 变化 1 个

标准差,将引起被解释变量 Y 变化 1.02 个标准差;解释变 量 X2 变化 1 个标准差,将引起被解释变量 Y 变化 0.24 个标 准差。因此,可以说,Y 对于 X1 变化的敏感程度远大于 Y 对于 X2 变化的敏感程度。

1 n

X

i

,Y

1 n

Yi

。

如果 X1 与 X2 之间存在线性关系,那么,上述计算ˆ1 、ˆ 2

的公式的分子、分母将变为 0,从而无法求解。

2.随机误差项i 的方差 2 的无偏估计 ˆ 2 ei2

n3

其中, ei2 的简捷计算公式为

ei2 yi2 ˆ1yix1i ˆ2yix2i

rYX 1 rYX 2 r X 1 X 2

(1

rY2X

2

)( 1

r

2 X

1

X

2

)

如果 rYX1X2 > rYX2X1 ,则表示被解释变量 Y 与解释变量 X1 之间的线性关系更密切,被解释变量 Y 对于解释变量 X1 的 变化更敏感;

如果 rYX1X2 < rYX2X1 ,则表示被解释变量 Y 与解释变量 X2 之间的线性关系更密切,被解释变量 Y 对于解释变量 X2 的 变化更敏感。

2i

)(

x

1i

x

2i

)

(

x2

1i

)(

x2

2i

)

(

x

1i

x

2i

)2

ˆ2

(

yi x2i )( x12i ) ( yi x1i )( x1i x2i ) ( x12i )( x22i ) ( x1i x2i )2

其中, xi Xi X , yi Yi Y ,X

3.偏回归系数ˆ1 、ˆ2 的方差和标准误差

偏回归系数 ˆ1 、ˆ2 的方差计算公式为:

Var(

ˆ1)

(

x12i

( x22i )ˆ 2

)( x22i ) (

x1i x2i

)2

Var(ˆ )

2

(

x2

1i

(

x2

1x2

2i

)

(

x

1i

3.偏相关系数

在二元线性回归分析中,也可以用偏相关系数来分析 被解释变量Y对于哪一个解释变量(X1和X2)的变化 更敏感。

偏相关系数:是指在控制或消除其他变量影响的情况 下,衡量多个变量中的某两个变量之间线性相关程度 的指标。

当 X2 保持不变时,Y 与 X1 之间的偏相关系数为

rYX 1 X 2

其中的参数 0 、 1 、 2 称为偏回归系数。

所谓偏回归系数,是指多元线性回归模型中解释变量前 的系数。其含义是:当其他解释变量保持不变时,某一解释 变量变化一个单位而使被解释变量Y平均改变的数值,即某一 解释变量对被解释变量Y的影响程度。

要估计二元线性回归模型 Yi 0 1X1i 2X2i i 中的 参数 0 、 1 、 2 ,常用的方法仍然是普通最小二乘法。

ˆ0

ˆ1X1i

ˆ2i

X 2i

)2

i1 i1

i 1

达到最小。

根据极值存在的必要条件,应该有

ei2

ˆ0

2 (Yi

ˆ0

ˆ1X1i

ˆ2 X 2i ) 0

ei2

ˆ1

2 (Yi

ˆ0

ˆ1X1i

ˆ2 X 2i )X1i

对于二元线性回归模型,可以按下列公式计算Beta系数:

ˆ1 ˆ1

x12i yi2

ˆ2 ˆ2

x22i yi2

由于 Y ˆ jX j ˆjSY ˆ jSXj

所以,Beta

系数ˆ

j

的含义是:若解释变量

Xj

变化

1

个标准

差(即X j SXj),则被解释变量

设根据给定一组样本数据( Yi,X1i,X2i),i=1,2,…, n , 采用普通最小二乘法估计得到的样本回归模型为

Yi ˆ0 ˆ1X1i ˆ2X2i ei ,则参数估计量 ˆ 0 、 ˆ1 、ˆ 2 应

该使 残差平方和

n

ei2

n (Yi

Yˆi )2

n (Yi

0

ei2

ˆ2

2 (Yi

ˆ0

ˆ1X1i

ˆ2 X 2i )X 2i

0

从而得到正规方程组

(Yi

ˆ0

ˆ1X1i

ˆ2 X 2i )

0

(Yi

ˆ0

ˆ1X1i

ˆ2 X 2i )X1i

0

(Yi ˆ0 ˆ1X1i ˆ2 X 2i )X 2i 0

ei 0 ei X 1i 0 ei X 2i 0

如果 X1 与 X2 之间不存在线性关系,那么,由上述正规方程

组可以解出ˆ0 、 ˆ1 、ˆ 2 :

ˆ0 Y ˆ1X1 ˆ2 X 2

ˆ1

(

y

i

x

1i

)(

x2

2i

)

(

y

i

x