SPSS软件的操作与应用第6讲 回归概念、回归系数

软件SPSS的回归分析功能-PPT课件

“残差”复选框组:

“模型拟合度”复选框:

“R方变化”复选框:

• 模型拟合过程中进入、退出的变量的列表,以及一些有关拟合优度的检 验:R,R2和调整的R2, 标准误及方差分析表。 • 显示模型拟合过程中R2、F值和p值的改变情况。 • 提供一些变量描述,如有效例数、均数、标准差等,同时还给出一个自 变量间的相关矩阵。

【选项】按钮

• 注意:选项按钮只需要在选择方法为逐步回归后,才需要打开

• “步进方法标准”单选钮组:设置纳入和排除标准,可按P值或F 值来设置。 • “在等式中包含常量”复选框:用于决定是否在模型中包括常数 项,默认选中。 • “缺失值”单选钮组:用于选择对缺失值的处理方式,可以是不 分析任一选入的变量有缺失值的记录(按列表排除个案)而无论 该缺失变量最终是否进入模型;不分析具体进入某变量时有缺失 值的记录(按对排除个案);将缺失值用该变量的均数代替(使 用均值替代)。

“描述性”复选框:

“部分相关和偏相关性”复选框:

• 显示自变量间的相关、部分相关和偏相关系数。

“共线性诊断”复选框:

• 给出一些用于共线性诊断的统计量,如特征根(Eigenvalues)、方差 膨胀因子(VIF)等。

以上各项在默认情况下只有“估计”和“模型拟合度”复选框被选中。

【绘制】按钮

step4:线性回归结果

【Anova】 (analysisofvariance方差分析)

• 此表是所用模型的检验结果,一个标准的方差分析表。 • Sig.(significant )值是回归关系的显著性系数,sig.是F值的实际显著 性概率即P值。当sig. <= 0.05的时候,说明回归关系具有统计学意义。 如果sig. > 0.05,说明二者之间用当前模型进行回归没有统计学意义, 应该换一个模型来进行回归。 • 由表可见所用的回归模型F统计量值=226.725 ,P值为0.000,因此我 们用的这个回归模型是有统计学意义的,可以继续看下面系数分别检验 的结果。 • 由于这里我们所用的回归模型只有一个自变量,因此模型的检验就等价 与系数的检验,在多元回归中这两者是不同的。

简单易懂的SPSS回归分析基础教程

简单易懂的SPSS回归分析基础教程章节一:SPSS回归分析基础概述SPSS(Statistical Package for the Social Sciences,社会科学统计软件包)回归分析是一种常用的统计方法,用于研究自变量对因变量的影响程度以及变量之间的关系。

本章将介绍SPSS回归分析的基本概念和目的,以及相关的统计指标。

SPSS回归分析的目的是建立一个数学模型,描述自变量与因变量之间的关系。

通过这个模型,我们可以预测因变量的变化,以及各个自变量对因变量的贡献程度。

回归分析包括简单回归分析和多元回归分析,本教程主要讲解简单回归分析。

在SPSS回归分析中,我们需要了解一些统计指标。

其中,相关系数(correlation coefficient)用于衡量自变量与因变量之间的线性关系强度。

回归系数(regression coefficient)描述自变量对因变量的影响程度,可用于建立回归方程。

残差(residual)表示实际观测值与回归模型预测值之间的差异。

下面我们将详细介绍SPSS回归分析的步骤。

章节二:数据准备和导入在进行SPSS回归分析之前,我们需要准备好数据集,并将数据导入SPSS软件。

首先,我们需要确定因变量和自变量的测量水平。

因变量可以是连续型数据,如身高、体重等,也可以是分类数据,如满意度水平等。

自变量可以是任何与因变量相关的变量,包括连续型、分类型或二元变量。

其次,我们需要收集足够的样本量,以获取准确和可靠的结果。

在选择样本时,应该遵循随机抽样的原则,以保证样本的代表性。

最后,我们将数据导入SPSS软件。

通过依次点击“File”、“Open”、“Data”,选择数据文件,并设置变量类型、名称和标签等信息。

完成数据导入后,我们就可以开始进行回归分析了。

章节三:简单回归分析步骤简单回归分析是一种研究一个自变量与一个因变量之间关系的方法。

下面将介绍简单回归分析的步骤。

第一步,我们需要确定自变量和因变量。

SPSS如何进行线性回归分析操作 精品

SPSS如何进行线性回归分析操作本节内容主要介绍如何确定并建立线性回归方程。

包括只有一个自变量的一元线性回归和和含有多个自变量的多元线性回归。

为了确保所建立的回归方程符合线性标准,在进行回归分析之前,我们往往需要对因变量与自变量进行线性检验。

也就是类似于相关分析一章中讲过的借助于散点图对变量间的关系进行粗略的线性检验,这里不再重复。

另外,通过散点图还可以发现数据中的奇异值,对散点图中表示的可能的奇异值需要认真检查这一数据的合理性。

一、一元线性回归分析用SPSS进行回归分析,实例操作如下:1.单击主菜单Analyze / Regression / Linear…,进入设置对话框如图7-9所示。

从左边变量表列中把因变量y选入到因变量(Dependent)框中,把自变量x选入到自变量(Independent)框中。

在方法即Method一项上请注意保持系统默认的选项Enter,选择该项表示要求系统在建立回归方程时把所选中的全部自变量都保留在方程中。

所以该方法可命名为强制进入法(在多元回归分析中再具体介绍这一选项的应用)。

具体如下图所示:2.请单击Statistics…按钮,可以选择需要输出的一些统计量。

如RegressionCoefficients(回归系数)中的Estimates,可以输出回归系数及相关统计量,包括回归系数B、标准误、标准化回归系数BETA、T值及显著性水平等。

Model fit 项可输出相关系数R,测定系数R2,调整系数、估计标准误及方差分析表。

上述两项为默认选项,请注意保持选中。

设置如图7-10所示。

设置完成后点击Continue返回主对话框。

回归方程建立后,除了需要对方程的显著性进行检验外,还需要检验所建立的方程是否违反回归分析的假定,为此需进行多项残差分析。

由于此部分内容较复杂而且理论性较强,所以不在此详细介绍,读者如有兴趣,可参阅有关资料。

3.用户在进行回归分析时,还可以选择是否输出方程常数。

《SPSS回归分析》ppt课件

.

-3.666

.002

从表中可知因变量与自变量的三次回归模型为: y=-166.430+0.029x-5.364E-7x2+5.022E-12x3

9.2 曲线估计

➢拟合效果图

从图形上看出其拟合效果非常好。

8.3 曲线估计

说明:

曲线估计是一个自变量与因变量的非线性回归过程,但 只能处理比较简单的模型。如果有多个自变量与因变量呈非 线性关系时,就需要用其他非线性模型对因变量进行拟合, SPSS 19中提供了“非线性”过程,由于涉及的模型很多,且 非线性回归分析中参数的估计通常是通过迭代方法获得的, 而且对初始值的设置也有较高的要求,如果初始值选择不合 适,即使指定的模型函数非常准确,也会导致迭代过程不收 敛,或者只得到一个局部最优值而不能得到整体最优值。

8.1 回归分析概述

(3)回归分析的一般步骤

第1步 确定回归方程中的因变量和自变量。 第2步 确定回归模型。 第3步 建立回归方程。 第4步 对回归方程进行各种检验。

➢拟合优度检验 ➢回归方程的显著性检验 ➢回归系数的显著性检验

第5步 利用回归方程进行预测。

主要内容

8.1 回归分析概述 8.2 线性回归分析 8.3 曲线估计 8.4 二元Logistic回归分析

8.3 曲线估计

(2) 统计原理

在曲线估计中,有很多的数学模型,选用哪一种形式的回 归方程才能最好地表示出一种曲线的关系往往不是一个简单的 问题,可以用数学方程来表示的各种曲线的数目几乎是没有限 量的。在可能的方程之间,以吻合度而论,也许存在着许多吻 合得同样好的曲线方程。因此,在对曲线的形式的选择上,对 采取什么形式需要有一定的理论,这些理论是由问题本质决定 的。

SPSS第六讲线性回归分析

1 1867.896 290.715

Sig . .000a

Res idual6829.963

1063

6.425

Total 8697.859

1064

a.Predictors: (Constant), Highest Year School Completed, Fat her b.D ep endent Variable: H ighest Year of School Comp leted

.026

.295

7.768

Highest Year School Complet ed, Mother .189

.031

.230

6.058

a. Dependent Variable: Highest Year of School Completed

Sig. .000 .000

.000

四、 多元线性回归分析(三元)

Highest Year School Completed, Mother, Highest Year School Completed,

a

Father

Variables Removed

Method

. Enter

a. All requ ested variables entered. b . Dep en d en t Variable: Hig hest Year o f Scho o l Co mpleted

Sig . .000

.000

线性回归方程:Y=0.668X+1.910 “X”的实际值每增加1个单位,“Y”实际值增 加0.668个单位,可进行实际预测具体值。

标准化线性回归方程:Y‘=0.463X’ “X”的标准值每增加1个单位,“Y”的标准值 相应地增加0.463个单位。(与非标准化方程等价,标准化后去掉了单位的影响、 去掉常数,没法进行实际预测具体值仅反应的是自变量对因变量的影响程度,好 处是在多个自变量的情况下,可进行影响程度比较。)

标准化的回归系数 spss

标准化的回归系数 spss在统计学中,回归系数是回归方程中自变量的系数,它表示因变量每单位变化时,自变量相应变化的程度。

在SPSS软件中,进行回归分析后,我们可以得到回归系数的估计值。

本文将介绍如何在SPSS中进行回归分析,并解释标准化的回归系数的含义和应用。

在SPSS中进行回归分析,首先需要导入数据,并选择“回归”分析。

在“回归”对话框中,将因变量和自变量添加到相应的框中。

在“统计”选项中,勾选“标准化系数”以获取标准化的回归系数。

点击“确定”后,SPSS将输出回归分析的结果,其中包括标准化的回归系数。

标准化的回归系数是指在进行回归分析时,对自变量和因变量进行标准化处理后得到的回归系数。

标准化处理可以消除不同变量之间的量纲影响,使得回归系数可以直接比较不同变量对因变量的影响程度。

标准化的回归系数的计算公式为,标准化系数=回归系数×(自变量标准差/因变量标准差)。

标准化的回归系数的绝对值表示自变量对因变量的影响程度,而正负号表示自变量对因变量的影响方向。

当标准化系数的绝对值越大时,自变量对因变量的影响越大;当标准化系数为正时,自变量和因变量呈正相关关系,为负时呈负相关关系。

标准化的回归系数在实际应用中具有重要意义。

首先,它可以帮助我们理解自变量对因变量的影响程度,从而进行变量的重要性排序。

其次,标准化系数可以用来比较不同变量对因变量的影响,找出对因变量影响最大的自变量。

此外,标准化系数还可以用来进行跨样本的比较,因为它消除了不同样本之间的量纲差异。

在解释回归分析的结果时,我们通常会关注标准化的回归系数。

通过解释标准化系数,我们可以清晰地说明自变量对因变量的影响程度和方向,从而为决策提供依据。

在学术研究和商业决策中,标准化的回归系数都扮演着重要的角色。

总之,标准化的回归系数是回归分析中的重要指标,它可以帮助我们理解自变量对因变量的影响程度和方向。

在SPSS中进行回归分析时,我们可以轻松获取标准化的回归系数,并通过解释它们来深入理解变量之间的关系。

SPSS课件第六章回归分析1

(2)方差膨胀因子(VIF) 方差膨胀因于(VIF)定义为 VIF=1/(l一Ri2 ),即它是 容许度的倒数。它的值越大,自变量之间存在共线性的 可能性越大。 (3)条件参数(Condition Index) 条件参数是在计算特征值时产生的一个统计量,其具体 含义尚不大清楚,但己经提出一些原则:其数值越大, 说明自变量之间的共线性的可能性越大;有些学者提议, 条件参数≥30时认为有共线性存在的可能性,但理论上 并没有得到证明。特征值(Eigenvalue)如果很小,就 应该怀疑共线性的存在。

2 2

ˆ ∑( yi−y) = R ∑( yi−y)

2

为了尽可能准确的反应模型的拟合度,SPSS输出中 的Adjusted R Square是消除了自变量个数影响的R2 的修正值。

(3)方差分析 )

体现因变量观测值与均值之间的差异的偏差平方和 SSt是由两个部分组成: 是由两个部分组成: SSt=SSr+SSe SSr:回归平方和,反应了自变量 的重要程度; 回归平方和,反应了自变量X的重要程度 的重要程度; SSe :残差平方和,它反应了实验误差以及其他意外 残差平方和, 因素对实验结果的影响。 因素对实验结果的影响。这两部分除以各自的自由度, 得到它们的均方。 统计量F=回归均方/残差均方。当 F值很大时,拒 绝接受b=0的假设。

一、线性回归

(一)一元线性回归方程

直线回归分析的任务就是根据若干个观测(xi,yi)i=1~n 找出描述两个变量x、y之间关系的直线回归方程y^=a+bx。 y^是变量y的估计值。求直线回归方程y^=a+bx,实际上是用 回归直线拟合散点图中的各观测点。常用的方法是最小二乘 法。也就是使该直线与各点的纵向垂直距离最小。即使实测 值y与回归直线y^之差的平方和Σ(y-y^)2达到最小。Σ(y-y^)2 也称为剩余(残差)平方和。因此求回归方程y^=a+bx的问 题,归根到底就是求Σ(y-y^)2取得最小值时a和b的问题。a称 为截距,b为回归直线的斜率,也称回归系数。

SPSS软件之回归分析

例如:研究消费者每年旅游支出Y 与年 收入X、受教育水平之间的关系。 其中受教育水平取值为1、2、3,分别表 示小学、中学、大学。这些取值就是哑 变量。

案例分析

研究消费者每年旅游支出Y (千元)与年收 入X(千元)、受教育水平(EDU)之间的 关系。原始数据中,受教育水平(EDU)取 值为1、2、3,分别表示小学、中学、大学。

线性回归的简介

多元线性回归是通过许多

预测源去预测一个结果,形成的 回归方程是:

多元线性回归最常用回归方法有两种: 1.进入回归法(Enter)

SPSS默认状态,将用户定义的本组的 所有自变量一次全部纳入回归

2.逐步回归法(Stepwise)

每次选择最好的一个自变量进入回归, 然后选择一个最不好的自变量删除。直 至模型外变量中已经选不出可纳入者, 同时模型内也选不出可删除者为止。

案例分析与操作

X X Y 1 2 1 0 5 0 2 5 7 0 3 0 6 0 y 7.188 x1 0.014 x2 111.692 4 0 6 0 5 0 8 0 6 5 7 0 7 0 5 0 8 0 4 0 9 0 3 0 1 0 9 0

第三部分

曲线拟合的回归分析

曲线拟合的概述 案例讲解

案例分析与操作

y 0.014 x 5.884 y 4.738ln x 14.353

y 3.335 0.033x (1.728e 5) x 2

第四部分

含虚拟自变量的回归分析

含虚拟自变量回归分析的概述 案例讲解

含虚拟自变量回归分析

我们在建立模型时,经常会在解释变量 中使用定性变量;我们把这类定性变量 称为虚拟(2)对回归效果进行评价 (3)对各回归系数进行显著性检验

SPSS软件的操作与应用第6讲 回归概念、回归系数

5

一、“回归”起源

Galton通过上述研究发现儿子的平均身高一般总是介于其父亲与其种 族的平均高度之间,即儿子的身高在总体上有一种“回归”到其所属种族高 度的趋势,这种现象称为回归现象,贯穿数据的直线称为回归线。

回归概念产生以后,被广泛应用于各个领域之中,并成为研究随机变量 与一个或多个自变量之间变动关系的一种统计分析技术。

16

三、线性回归

3. 线性回归方程的统计检验

回归系数的显著性检验 检验每个自变量与因变量之间的线性关系是否显著,能否保留在方程中

1.显著性检验H0假设是:回归系数与0无显著性差异。 2.检验t 统计量,SPSS自动计算统计量的观测值和对应的伴随概率。 3.如果伴随概率大于显著性水平ɑ= 0.05,接受H0假设,回归系数与0无显著 性差异。表明自变量x和因变量y之间线性关系不显著,回归方程无实际意义。 如果伴随概率小于显著性水平ɑ=0.05,拒绝H0假设,回归系数与0有显著性 差异。表明自变量x和因变量y之间有线性关系,回归方程有实际意义。

6

二、回归的基本概念

1. 回归分析的概念

回归分析就是研究一个或多个变量的变动对另一个变量的变动的影响程 度的方法。

2.

相关分析与回归分析的关系

相关分析是根据统计数据,通过计算分析变量之间关系的方向和紧密程 度,而不能说明变量之间相互关系的具体形式,无法从一个变量的变化 来推测另一个变量的变化情况。 回归分析能够确切说明变量之间相互关系的具体形式,可以通过一个相 关的数学表达式,从一个变量的变化来推测另一个变量的变化情况,使 估计和预测成为可能。

10

线性回归

11

三、线性回归

1. 线性回归的概念

spss标准化回归系数

spss标准化回归系数SPSS标准化回归系数。

标准化回归系数是回归分析中一个重要的统计指标,它能够帮助研究者理解自变量对因变量的影响程度,并且消除了不同变量量纲不同的影响,使得不同自变量之间可以进行比较。

在SPSS软件中,我们可以通过进行标准化回归来得到标准化回归系数,本文将介绍如何在SPSS中进行标准化回归分析,并解释标准化回归系数的含义和解释。

首先,打开SPSS软件并导入需要进行标准化回归分析的数据集。

在“分析”菜单中选择“回归”选项,然后在弹出的对话框中选择“线性”回归分析。

在“因变量”框中输入需要预测的因变量,然后将所有自变量添加到“自变量”框中。

接下来,点击“统计”按钮,在弹出的对话框中勾选“标准化系数”选项,然后点击“确定”进行分析。

得到标准化回归系数之后,我们需要对结果进行解释。

标准化回归系数表示的是因变量每变化一个标准差时,自变量的变化量。

标准化回归系数的绝对值大小反映了自变量对因变量的影响程度,而正负号则表示了自变量对因变量的正向或负向影响。

例如,如果某个自变量的标准化回归系数为0.5,那么当该自变量增加一个标准差时,因变量也会增加0.5个标准差。

在解释标准化回归系数时,需要注意到不同自变量之间的标准化回归系数是可以进行比较的。

绝对值较大的标准化回归系数表示该自变量对因变量的影响更大,而绝对值较小的标准化回归系数则表示影响较小。

通过比较不同自变量的标准化回归系数,可以得出它们对因变量的相对重要性,从而更好地理解自变量对因变量的影响。

此外,标准化回归系数还可以用来进行假设检验,判断自变量对因变量的影响是否显著。

在SPSS的回归结果中,标准化回归系数的t检验可以用来检验自变量的系数是否显著异于零。

如果t检验的p值小于显著性水平(通常取0.05),则可以拒绝原假设,即认为该自变量对因变量的影响是显著的。

总之,标准化回归系数是回归分析中一个重要的统计指标,它能够帮助研究者理解自变量对因变量的影响程度,并进行自变量之间的比较。

第六章SPSS运行回归与相关分析

ANOVAc Sum of Model Squares df 1 Regression 199.669 Residual 40.221 Total 239.889 2 Regression 213.041 Residual 26.848 Total 239.889 a. Predictors: (Constant), 株穗数X1 b. Predictors: (Constant), 株穗数X1, c. Dependent Variable: 产量Y Mean Square 199.669 3.094 106.521 2.237 F 64.536 Sig. .000a

Std. Error of the Estimate .2829

Coefficientsa Standardi zed Unstandardized Coefficie Coefficients nts Model B Std. Error Beta 1 (Constant) 1.304 .630 有效穗X 1.147 .189 .906 a. Dependent Variable: 产量Y

x2

例;测定15块高产小麦田块,得单株产 量(y,g)与每株穗数(x1,)、穗粒数 ( x2)、千粒重(x3,g)之间的关系如下 表。试作多元线性.4 13.9 10.2 10.8 8.1 10.6

x2 33.2 30.1 32.6 31.8 32.4 33.1 33.5 34.6

x3 34.1 34.9 39.2 35.1 32.0 37.2 36.5

y 12.7 12.4 19.3 9.2 6.4 10.6 11.3

y

x1 x2 x3

第一步:定义变量,建立数据文件。 第二步:从Analyze→Regression→Linear, 打开Linear对话框,在左边源变量栏选择y进 入Dependent栏,x1、x2、x3进入 Independent(S)栏。在Method栏中选择强迫引 入 回归(Enter),此项也是系统默认项。单 击OK按钮,得多元回归分析如下:

SPSS数据分析教程 ——回归分析课件

回归和相关分析

• 回归分析是在相关分析的基础上,确定了变量之间的相互影响关 系之后,准确的确定出这种关系的数量方法。因此,一般情况下, 相关分析要先于回归分析进行,确定出变量间的关系是线性还是 非线性,然后应用相关的回归分析方法。在应用回归分析之前, 散点图分析是常用的探索变量之间相关性的方法。

SPSS数据分析教程 ——回归分析

• Y = ¯0 +¯1 X +² • 其中变量X为预测变量,它是可以观测和控制的;Y为因变量或响应变量,

它为随机变量; ²为随机误差。 • 通常假设²~N(0,¾2),且假设与X无关。

SPSS数据分析教程 ——回归分析

回归模型的主要问题

• 进行一元线性回归主要讨论如下问题:

(1) 利用样本数据对参数¯0, ¯1和¾2,和进行点估计,得到经验回归方程 (2) 检验模型的拟合程度,验证Y与X之间的线性相关的确存在,而不是由

用回归方程预测

• 在一定范围内,对任意给定的预测变量取值,可以利用求得的拟 合回归方程进行预测。其预测值为:

ˆ0 ˆ0ˆ1x0PSS数据分析教程 ——回归分析

简单线性回归举例

• 一家计算机服务公司需要了解其用电话进行客户服务修复的计算 机零部件的个数和其电话用的时间的关系。经过相关分析,认为 二者之间有显著的线性关系。下面我们用线性回归找到这两个变 量之间的数量关系。

• F检验的 被拒绝,H 0并不能说明所有的自变量都对因变量Y有显著 影响,我们希望从回归方程中剔除那些统计上不显著的自变量, 重新建立更为简单的线性回归方程,这就需要对每个回归系数做 显著性检验。

• 即使所有的回归系数单独检验统计上都不显著,而F检验有可能 显著,这时我们不能够说模型不显著。这时候,尤其需要仔细对 数据进行分析,可能分析的数据有问题,譬如共线性等。

Spss线性回归分析讲稿ppt课件

察其与因变量之间是否具有线性关系。然后,

将自变量进行组合,生成若干自变量的子集,再

针对每一个自变量的子集生成回归分析报告。

比较调整后的R2值,挑选最优的自变量子集,

生成回归分析模型。

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

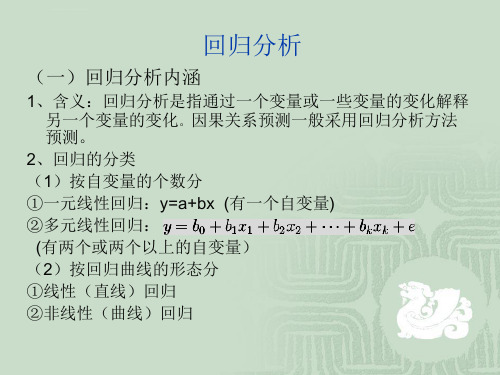

①一元线性回归:y=a+bx (有一个自变量)

②多元线性回归:

(有两个或两个以上的自变量)

(2)按回归曲线的形态分

①线性(直线)回归

②非线性(曲线)回归

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

回归分析

(二)回归分析的主要内容

即销售量的95%以上的变动都可以被该模型所解释,拟和优度较高。

表3

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

一元线性回归分析

表4给出了回归模型的方差分析表,可以看到,F统计量为

734.627,对应的p值为0,所以,拒绝模型整体不显著的

图1

奖金-销售量表

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

一元线性回归

以奖金-销售量表图1做回归分析

2、绘制散点图

打开数据文件,选择【图形】-【旧对话框】-【散点/点状】

图2

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

《SPSS数据分析教程》 ——回归分析..

本章学习目标

掌握线性回归分析的基本概念 掌握线性回归的前提条件并能进行验证 掌握线性回归分析结果的解释 掌握多重共线性的判别和处理 能用线性回归模型进行预测

回归分析的基本概念

什么是回归分析

回归分析是研究变量之间相关关系的一种统计方法 如果两个变量之间的Pearson相关系数绝对值较大, 从散点图看出变量间线性关系显著,那么下一步就是 应用回归分析的方法来找出变量之间的线性关系。 例如,房屋的价格和房屋的面积,地理位置,房龄和 房间的个数都有关系。又比如,香烟的销量和许多地 理和社会经济因素有关,像消费者的年龄,教育,收 入,香烟的价格等。

回归模型的显著性的F检验

总平方和SST反映因变量Y的波动程度或者不确 定性,在建立了Y对X的回归方程后,总平方和 SST分解成回归平方和SSR与参差平方和SSE两 部分。其中SSR是由回归方程确定的,SSE是不 能由自变量X解释的波动,是由X之外的未加控 制的因素引起的。这样,SST中能够由自变量 解释的部分为SSR,不能由自变量解释的部分 为SSE。这样回归平方和越大,回归的效果越 好,据此构造F检验统计量

回归术语

对于有一个响应变量的线性回归,当p=1时, 我们称为简单线性回归(Simple Linear Regression,或称为一元线性回归),当 p>2 时我们称为多元线性回归(Multiple Linear Regression)。

回归和相关分析

回归分析是在相关分析的基础上,确定了变量 之间的相互影响关系之后,准确的确定出这种 关系的数量方法。因此,一般情况下,相关分 析要先于回归分析进行,确定出变量间的关系 是线性还是非线性,然后应用相关的回归分析 方法。在应用回归分析之前,散点图分析是常 用的探索变量之间相关性的方法。

《2024年数据统计分析软件SPSS的应用(五)——相关分析与回归分析》范文

《数据统计分析软件SPSS的应用(五)——相关分析与回归分析》篇一数据统计分析软件SPSS的应用(五)——相关分析与回归分析一、引言在当今的大数据时代,数据统计分析成为了科学研究、市场调研、社会统计等众多领域的重要工具。

SPSS(Statistical Package for the Social Sciences)作为一款功能强大的数据统计分析软件,被广泛应用于各类数据分析中。

本文将重点介绍SPSS 中相关分析与回归分析的应用,以帮助读者更好地理解和掌握这两种分析方法。

二、相关分析1. 相关分析的概念与目的相关分析是研究两个或多个变量之间关系密切程度的一种统计方法。

其目的是通过计算相关系数,了解变量之间的线性关系强度和方向,为后续的回归分析提供依据。

2. SPSS中的相关分析操作步骤(1)导入数据:将数据导入SPSS软件中,建立数据文件。

(2)选择分析方法:在SPSS菜单中选择“分析”->“相关”->“双变量”,进行相关分析。

(3)设置变量:在弹出的对话框中,设置需要进行相关分析的变量。

(4)计算相关系数:点击“确定”后,SPSS将自动计算两个变量之间的相关系数,并显示在结果窗口中。

3. 相关分析的注意事项(1)选择合适的相关系数:根据研究目的和数据特点,选择合适的相关系数,如Pearson相关系数、Spearman相关系数等。

(2)控制混淆变量:在进行相关分析时,要控制可能影响结果的混淆变量,以提高分析的准确性。

三、回归分析1. 回归分析的概念与目的回归分析是研究一个或多个自变量与因变量之间关系的一种预测建模方法。

其目的是通过建立自变量和因变量之间的数学模型,预测因变量的值或探究自变量对因变量的影响程度。

2. SPSS中的回归分析操作步骤(1)导入数据:同相关分析一样,将数据导入SPSS软件中。

(2)选择分析方法:在SPSS菜单中选择“分析”->“回归”->“线性”,进行回归分析。

spss回归

spss回归SPSS回归介绍:SPSS(Statistical Package for the Social Sciences)是一种广泛使用的统计分析软件,被广泛应用于社会科学、生物科学、工程等领域。

回归分析是SPSS中最为常用的统计方法之一,用于研究因变量与一个或多个自变量之间的关系。

本文将详细介绍SPSS回归分析的基本概念、步骤和结果的解读。

一、回归分析的基本概念1.1 回归方程回归方程是用来描述因变量和自变量之间关系的数学模型。

简单线性回归方程可以表示为Y = a + bX,其中Y为因变量,X为自变量,a和b分别为截距项和斜率。

当存在多个自变量时,可以采用多元回归方程进行分析。

1.2 相关系数相关系数可以衡量因变量和自变量之间的关系强度和方向。

在SPSS 中,常用的相关系数有Pearson相关系数和Spearman秩相关系数。

Pearson相关系数适用于连续变量,而Spearman秩相关系数则适用于有序变量或非线性关系。

二、回归分析的步骤2.1 数据准备在进行回归分析之前,需要准备好所需的数据。

数据可以来自调查问卷、实验或其他收集方式。

在SPSS中,可以通过导入数据文件或手动输入数据来进行分析。

2.2 设计回归模型在设计回归模型时,需要确定自变量和因变量的关系类型。

如果自变量和因变量之间存在线性关系,则可以使用简单线性回归模型。

如果存在多个自变量,则需要使用多元回归模型。

2.3 进行回归分析在SPSS中,进行回归分析非常简单。

只需要选择分析菜单下的回归选项,然后将因变量和自变量选择到相应的字段中。

SPSS会自动计算回归方程和相关系数,并提供结果解读。

2.4 分析结果解读回归分析结果包括回归系数、显著性水平、拟合优度等指标。

回归系数表示自变量对因变量的影响程度,显著性水平表示回归模型的可靠性,拟合优度可以评估回归模型的拟合程度。

三、实例分析为了更好地理解SPSS回归分析的步骤和结果,下面将给出一个实例分析。

SPSS多元线性回归分析实例操作步骤

SPSS多元线性回归分析实例操作步骤SPSS(Statistical Package for the Social Sciences)是一种统计分析软件,广泛应用于社会科学研究领域。

其中,多元线性回归分析是SPSS中常用的一种统计方法,用于探讨多个自变量与一个因变量之间的关系。

本文将演示SPSS中进行多元线性回归分析的操作步骤,帮助读者了解和掌握该方法。

一、数据准备在进行多元线性回归分析之前,首先需要准备好数据。

数据应包含一个或多个因变量和多个自变量,以及相应的观测值。

这些数据可以通过调查问卷、实验设计、观察等方式获得。

确保数据的准确性和完整性对于获得可靠的分析结果至关重要。

二、打开SPSS软件并导入数据1. 启动SPSS软件,点击菜单栏中的“文件(File)”选项;2. 在下拉菜单中选择“打开(Open)”选项;3. 导航到保存数据的文件位置,并选择要导入的数据文件;4. 确保所选的文件类型与数据文件的格式相匹配,点击“打开”按钮;5. 数据文件将被导入到SPSS软件中,显示在数据编辑器窗口中。

三、创建多元线性回归模型1. 点击菜单栏中的“分析(Analyse)”选项;2. 在下拉菜单中选择“回归(Regression)”选项;3. 在弹出的子菜单中选择“线性(Linear)”选项;4. 在“因变量”框中,选中要作为因变量的变量;5. 在“自变量”框中,选中要作为自变量的变量;6. 点击“添加(Add)”按钮,将自变量添加到回归模型中;7. 可以通过“移除(Remove)”按钮来删除已添加的自变量;8. 点击“确定(OK)”按钮,创建多元线性回归模型。

四、进行多元线性回归分析1. 多元线性回归模型创建完成后,SPSS将自动进行回归分析并生成结果;2. 回归结果将显示在“回归系数”、“模型总结”和“模型拟合优度”等不同的输出表中;3. “回归系数”表显示各个自变量的回归系数、标准误差、显著性水平等信息;4. “模型总结”表提供模型中方程的相关统计信息,包括R方值、F 统计量等;5. “模型拟合优度”表显示模型的拟合优度指标,如调整后R方、残差平方和等;6. 可以通过菜单栏中的“图形(Graphs)”选项,绘制回归模型的拟合曲线图、残差图等。

简单介绍SPSS如何做回归和相关

02

SPSS回归分析

线性回归分析

定义:线性回 归分析是一种 通过建立数学 模型来描述因 变量和自变量 之间线性关系 的统计分析方

法。

目的:通过回 归分析,可以 确定因变量和 自变量之间的 关系强度,并 预测因变量的

未来值。

适用范围:适 用于因变量和 自变量之间存 在线性关系的

情况。

操作步骤:选 择自变量和因 变量,建立回 归模型,进行 模型拟合和检 验,解释结果 和预测未来。

YOUR LOGO

20XX.XX.XX

SPSS回归和相关分析的简单介 绍

XX,a click to unlimited possibilities

汇报人:XX

目 录

01 单 击 添 加 目 录 项 标 题 02 S P S S 回 归 分 析 03 S P S S 相 关 分 析

01

添加章节标题

THANK YOU

汇报人:XX

数据清洗和 建立回归模 模型评估和

整理

型

优化

解释结果和 预测

03

SPSS相关分析

描述性相关分析

参数相关分析

添加标题 添加标题 添加标题 添加标题

定义:参数相关分析是统计学中用于衡量两个或多个变量之间关联程度 的方法。

类型:包括Pearson相关系数、Spearman秩相关系数和Kendall秩相关 系数等。

非线性回归分析

定义:非线性回归分析是一种用于探索和描述因变量与自变量之间非线性关系的统计方法。

适用场景:当因变量与自变量之间的关系不是简单的线性关系时,可以使用非线性回归分 析。

模型形式:非线性回归分析的模型通常采用幂函数、指数函数、对数函数等形式。

参数估计:非线性回归分析的参数通常通过最小二乘法或最大似然估计等方法进行估计。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1 0 i 0

17

三、线性回归

4. 线性回归方程的统计检验 残差分析 残差是指由回归方程计算所得的预测值与实际样本值之间的差距。 残差分析是回归方程检验的重要组成部分,如果回归方程能够较 好地反映变量之间的变化规律,那么残差中不包含明显的规律性和趋 势性。 残差分析的主要内容

(1)残差均值为0的正态性分析 对应的残差有正负,但总体上应服从以0为均值的正态分布。可以通过 绘制标准化(或学生化)残差的累计概率图来分析。 (2)残差的独立性分析 回归方程要求前期和后期的残差数值之间不存在相关关系,即不存在自 相关。可以通过绘制残差的序列图、计算残差的自相关系数和DW(DurbinWatson)检验来分析

4.

回归分析的基本过程

确定自变量、因变量 确定回归模型 估计模型中的参数(建立回归方程) 对回归模型进行各种检验 模型应用(利用回归方程预测)

8

二、回归的基本概念

回归分析可以解决的问题

确定因变量与若干个自变量之间联系的定量表达式,即回归方程或数学模型 通过控制可控变量的数值,借助数学模型来预测或控制因变量的取值和精度 进行因素分析,从影响因变量变化的自变量中区分出重要因素和次要因素

相关分析是回归分析的基础和前提,回归分析是相关分析的深入和继续。

相 关 与 回 归

7

二、回归的基本概念

3. 回归分析的目的

根据已知的资料或数据,找出变量之间的关系表达式(找到回归线或回 归方程),用自变量的已知值去推测因变量的值或范围(进行预测),实际上 是研究因果关系。(例如: y 0 1 x )

13

三、线性回归的适用条件

• 线性趋势:即自变量与因变量的关系是线性的。 • 独立性:因变量Y的取值相互独立。反映在方程中即残差独立。 • 正态性:即自变量的任何一个线性组合,Y应该服从正态分布。反映 在方程中即残差Ei服从正态分布。 • 方差齐性:自变量的任何一个线性组合,Y的方差相同。

三、线性回归

表4

Model 1 Coefficientsa Standardized Coefficients Beta .916

(Constant) 房 评 价 产 估 值

Unstandardized Coefficients B Std. Error 895.020 535.833 1.351 .140

t 1.670 9.673

上节回顾 相关分析

描述变量之间的关系

二元变量分析 偏相关分析 距离相关分析

上节回顾

相关概念

相关分析就是描述两个或两个以上变量间关系密切程度的统计方 法,有效地揭示;相关系数——精准) 偏相关分析(固定某些变量,研究其它变量之间的关系) 距离相关分析

15

三、线性回归

3. 线性回归方程的统计检验

回归方程的显著性检验 检验因变量与所有的自变量之间的线性关系是否显著

y 0 1 x

1 0 1.显著性检验H0假设是:回归系数与0无显著性差异。 1 2 ... n 0

2.检验采用F统计量,SPSS自动计算统计量的观测值和对应的伴随概率。 3.如果伴随概率大于显著性水平ɑ= 0.05,接受H0假设,回归系数与0无显著 性差异。表明自变量x和因变量y之间线性关系不显著,回归方程无实际意义。 如果伴随概率小于等于显著性水平ɑ=0.05,拒绝H0假设,回归系数与0有显 著性差异。表明自变量x和因变量y之间有线性关系,回归方程有实际意义。

21

三、线性回归

5. SPSS操作及案例分析

结果分析: 从建立的散点图来看,自变量x和因变量y之间存在一定的线性关系,而且相 关程度较高。

22

三、线性回归

5. SPSS操作及案例分析

结果分析: (1) 变量进入/移出表(表1) Enter表示选定变量全部进入模型 (2) 模型综述表(表2) 相关系数R=0.916、判定系数R2=0.839、调整判定系数R2=0.830,说明变量之间 相关程度高,回归方程的拟合优度高。

表1

Model 1 Variables Entered/Removedb Variables Entered 房 评 产 a 估 价 值 Variables Removed . Method Enter

表2

Model 1 R .916a

Model Summary R Sq uare .839 Adjusted R Sq uare .830 Std. Error of the Estimate 936.42276

6

二、回归的基本概念

1. 回归分析的概念

回归分析就是研究一个或多个变量的变动对另一个变量的变动的影响程 度的方法。

2.

相关分析与回归分析的关系

相关分析是根据统计数据,通过计算分析变量之间关系的方向和紧密程 度,而不能说明变量之间相互关系的具体形式,无法从一个变量的变化 来推测另一个变量的变化情况。 回归分析能够确切说明变量之间相互关系的具体形式,可以通过一个相 关的数学表达式,从一个变量的变化来推测另一个变量的变化情况,使 估计和预测成为可能。

相 关

2

第6讲

回归分析

3

基本概念

4

一、“回归”起源

“回归”一词是英国生物学 家、统计学家高尔顿(F.Galton)在研 究父亲身高和其成年儿子身高关系时提 出的。 从大量父亲身高和其成年儿 子身高数据的散点图中,Galton发现 了一条贯穿其中的直线,它能描述父 亲身高和其成年儿子身高的关系,并 可以用于根据父亲身高预测其成年儿 子身高。

19

三、线性回归的步骤

1.做出散点图,观察变量间的趋势; 2.构建回归模型进行回归分析 3.回归方程检验; 4.残差分析; 5.多重共线性问题的判断处理。

1.求相关系数矩阵,系数在0.9以上的将会存在共线性问题,0.8以上可能会 有问题; 2.容忍度(Tolerance):指标越小,共线性可能越严重。如果小于0.1,可 认为共线性严重。

10

线性回归

11

三、线性回归

1. 线性回归的概念

线性函数是变量之间存在的各种关系中最简单的形式,具有这种关系的 回归叫做线性回归。 线性回归根据自变量多少分为一元线性回归和多元线性回归

12

三、线性回归

2. 线性回归的模型

下面以一元线性回归为例,解析线性回归模型。 y x x ... x 0 1 1 2 2 n n

16

三、线性回归

3. 线性回归方程的统计检验

回归系数的显著性检验 检验每个自变量与因变量之间的线性关系是否显著,能否保留在方程中

1.显著性检验H0假设是:回归系数与0无显著性差异。 2.检验t 统计量,SPSS自动计算统计量的观测值和对应的伴随概率。 3.如果伴随概率大于显著性水平ɑ= 0.05,接受H0假设,回归系数与0无显著 性差异。表明自变量x和因变量y之间线性关系不显著,回归方程无实际意义。 如果伴随概率小于显著性水平ɑ=0.05,拒绝H0假设,回归系数与0有显著性 差异。表明自变量x和因变量y之间有线性关系,回归方程有实际意义。

Sig . .112 .000

a. Dependent Variable: 销 价 售 格

24

三、线性回归

5. SPSS操作及案例分析 结果分析:

结论: 根据上述分析结果,可以得到回归方程,用该方程来进行分析和预测实际问题, 结果较为准确。

y 895.02 1.351x

举例:

x y 实际销售值 y-实际销售值 2780 4648.02 4850 -201.98 3950 6227.52 6200 27.52 7283 10727.07 11650 -922.93

一元线性回归的数学模型为: y 0 1 x 多元线性回归数学模型 在数学模型中 0、1 分别称为回归常数和回归系数, 称为随机误差。 从数学模型可以看出因变量y的变化由两部分组成 自变量x的变化所引起的y的线性变化,即 y 0 1 x 其他随机因素引起的y的变化,即 如果随机误差的期望为0,那么数学模型可以转化为: y 0 1 x 称为一元线性回归方程 从几何意义上讲,一元线性回归方程是一条直线, 即回归线。 从一元线性回归方程可以看出,一元线性回归分析是在不考虑随机因素条件下 进行分析的,所以是在比较理想状态下的分析

表3

Sum of Squares 82047704 15783976 97831680

ANOVAb df 1 18 19 Mean Square 82047703.55 876887.580 F 93.567 Sig . .000a

结果分析: (3) 方差分析表(表3) a. Predictors: (Constant), 房 评 价 产 估 值 b. Dependent Variable: 销 价 售 格 F检验统计量的观测值=93.567,伴随概率=0.000<0.05,拒绝零假设,说明自变 量x和因变量y之间线性关系显著,可以建立线性模型。 (4)模型系数表(表4) 常数项Constant=895.020,回归系数=1.351 ;回归系数的伴随概率=0.000,拒 绝零假设,说明自变量x和因变量y之间线性关系显著,可以建立线性模型。

5

一、“回归”起源

Galton通过上述研究发现儿子的平均身高一般总是介于其父亲与其种 族的平均高度之间,即儿子的身高在总体上有一种“回归”到其所属种族高 度的趋势,这种现象称为回归现象,贯穿数据的直线称为回归线。

回归概念产生以后,被广泛应用于各个领域之中,并成为研究随机变量 与一个或多个自变量之间变动关系的一种统计分析技术。

三、线性回归

5. SPSS操作及案例分析

例一:一元线性回归分析 一家地产公司调查了某城市的房地产销售价格与 房产的评估价值的数据,请用一元线性回归分析,能 否用房产的评估价值来预测房地产销售的价格。