颜色12个特征值数据新.m

矩阵的秩和非零特征值个数关系的进一步讨论

F u j i n a 3 6 3 0 0 0 , C h i n a ; 4 . C o l e g e o f Ma t h e ma i t c s nd a C o mp u t e r ci S e n c e , F u j i a n N o ma r l U n i v e r s i t y , F u z h o u , F u j i n a 3 5 0 0 0 7 , C h i n a )

P u t i n a U n i v e m t i y , P u t i a n , F u j i a n 3 5 1 1 0 0 , C h i n a ; 3 . ch S ol o f M a he t m a t i c s nd a S t a t i s i t c ,M s i n n n a N o r m l a U n i v e r s t i y , Z h a n g z h o u ,

、

c E x ] 表示复数域 C上的 n × 方阵、 一元多项式集合. Ⅳ为非负整数合. r ( A) 、 u ( A) 、 ma ( ) 、

.

( ) 和t r ( A) 分别表示矩阵 A 的秩 、 非零特征值的个数 、 最小多项式 、 特征多项式和迹. 约定 A 。 = E, 也

用 & 表示 k x k单位矩阵. Ⅳ( A) 为A x =0解空间 , 其维数为 d i m N( A) . 设s ( A)=r ( A) - u ( A)

s k = { A E C I s ( A) = } , k∈ N .

大学 数学与统计学院 , 福建 漳州 3 6 3 0 0 0 ; 4 . 福建 师范大学 数学与计算机科学学院, 福建 福州3 5 0 0 0 7 )

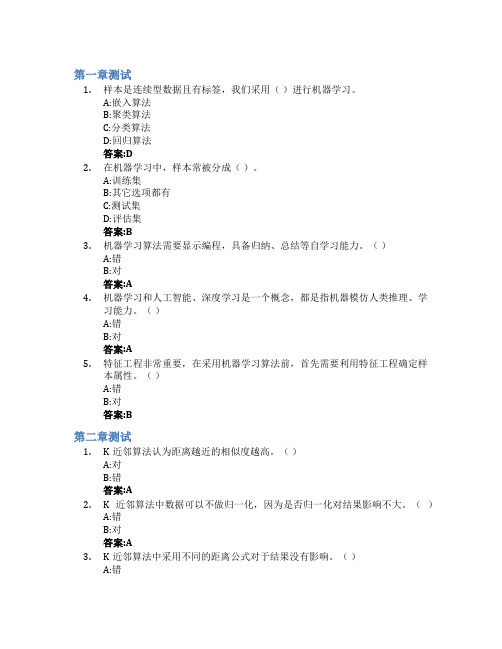

机器学习基础智慧树知到答案章节测试2023年太原理工大学

第一章测试1.样本是连续型数据且有标签,我们采用()进行机器学习。

A:嵌入算法B:聚类算法C:分类算法D:回归算法答案:D2.在机器学习中,样本常被分成()。

A:训练集B:其它选项都有C:测试集D:评估集答案:B3.机器学习算法需要显示编程,具备归纳、总结等自学习能力。

()A:错B:对答案:A4.机器学习和人工智能、深度学习是一个概念,都是指机器模仿人类推理、学习能力。

()A:错B:对答案:A5.特征工程非常重要,在采用机器学习算法前,首先需要利用特征工程确定样本属性。

()A:错B:对答案:B第二章测试1.K近邻算法认为距离越近的相似度越高。

()A:对B:错答案:A2.K近邻算法中数据可以不做归一化,因为是否归一化对结果影响不大。

()A:错B:对答案:A3.K近邻算法中采用不同的距离公式对于结果没有影响。

()A:错答案:A4.在上面图中,K=5,绿色样本的类别是()。

A:红色三角形B:蓝色正方形C:不能确定D:绿色圆形答案:B5.在K近邻算法中,K的选择是()?A:越大越好B:与样本有关C:其它都不正确D:越小越好答案:B第三章测试1.下列()中两个变量之间的关系是线性的。

A:猫的皮毛颜色和体重B:人的工作环境和健康状况C:重力和质量D:女儿的身高和父亲的体重答案:C2.下列说法不正确的是()。

A:线性回归模型也可以解决线性不可分的情况B:回归用于预测输入变量和输出变量之间的关系C:回归就是数据拟合D:回归分析就是研究两个事物的相关性答案:C3.从某大学随机选择8名女大学生,其身高x(cm)和体重y(kg)的回归方程是y=0.849x-85.712,则身高172cm的女大学生,预测体重为()。

A:60.316kgB:大于60.316kgC:小于60.316kgD:其它都不正确答案:Asso中采用的是L2正则化。

()A:错B:对答案:A5.线性回归中加入正则化可以降低过拟合。

()A:错答案:B第四章测试1.以下说法正确的是()。

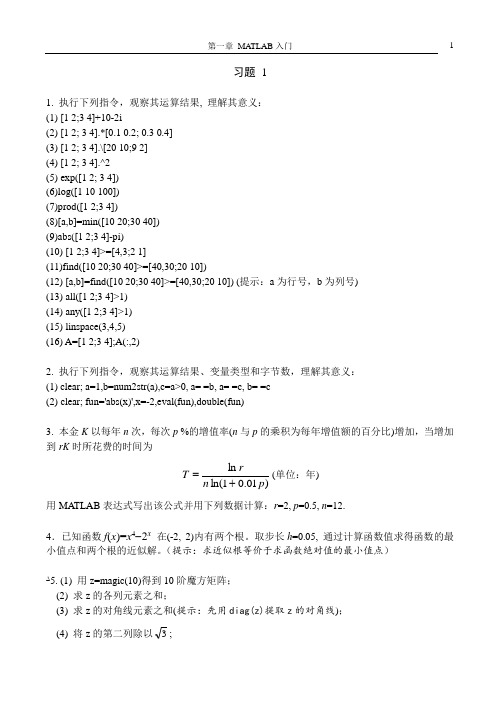

Matlab习题

习题 11. 执行下列指令,观察其运算结果, 理解其意义: (1) [1 2;3 4]+10-2i(2) [1 2; 3 4].*[0.1 0.2; 0.3 0.4] (3) [1 2; 3 4].\[20 10;9 2] (4) [1 2; 3 4].^2 (5) exp([1 2; 3 4]) (6)log([1 10 100]) (7)prod([1 2;3 4])(8)[a,b]=min([10 20;30 40]) (9)abs([1 2;3 4]-pi)(10) [1 2;3 4]>=[4,3;2 1](11)find([10 20;30 40]>=[40,30;20 10])(12) [a,b]=find([10 20;30 40]>=[40,30;20 10]) (提示:a 为行号,b 为列号) (13) all([1 2;3 4]>1) (14) any([1 2;3 4]>1) (15) linspace(3,4,5) (16) A=[1 2;3 4];A(:,2)2. 执行下列指令,观察其运算结果、变量类型和字节数,理解其意义: (1) clear; a=1,b=num2str(a),c=a>0, a= =b, a= =c, b= =c (2) clear; fun='abs(x)',x=-2,eval(fun),double(fun)3. 本金K 以每年n 次,每次p %的增值率(n 与p 的乘积为每年增值额的百分比)增加,当增加到rK 时所花费的时间为)01.01ln(ln p n rT +=(单位:年)用MA TLAB 表达式写出该公式并用下列数据计算:r =2, p =0.5, n =12.4.已知函数f (x )=x 4-2x 在(-2, 2)内有两个根。

取步长h =0.05, 通过计算函数值求得函数的最小值点和两个根的近似解。

统计学 第三章数据的特征值

一是各个变量值之间有差异; 二是各个变量值的权数有差异。 • 简单算术平均数是加权算术平均数在权数相等时的特例。

2021/7/3

14

算术平均数的性质 p75-76

• 1.各变量值与其算术平均数的离差之和

等于零,即

根据未分组数据计算四分位数时先对数据进行排序然后再确定四分位数所在的位置当四分位数的位置不在某一个具体数值时可根据四分位数的位置按比例分摊四分位数所在位置两侧变量值之差的数值

第三章 数据分布特征的描述

• 第一节 集中趋势——数值平均数 • 第二节 集中趋势——位置平均数 • 第三节 离中趋势的测度 • 第四节 偏度与峰度的 测度

时间:1999 2000 2001 2002 tn 产量:环y比0 发展速y度1 y1/yy20 y2/y1 yy33/y2 yn/yynn-1

定基发展速度 y1/y0 y2/y0 y3/y0 yn/y0

注意:环比发展速度的连乘积=相应的定基发展速度

增长速度= 发展速度-1

环比增长速度=环比发展速度-1 定基增长速度=定基发展速度-1

某年级83名女生身高资料

身高 人数

(CM) (人) 152 1 154 2 155 2 156 4 157 1 158 2 159 2 160 12 161 7 162 8 163 4

2021/7/3

身高 人数

(CM) (人) 164 3 165 8 166 5 167 3 168 7 169 1 170 5 171 2 172 3 174 1 总计 83

n Yn 1 Y0

(i 1,2,, n)

2021/7/3

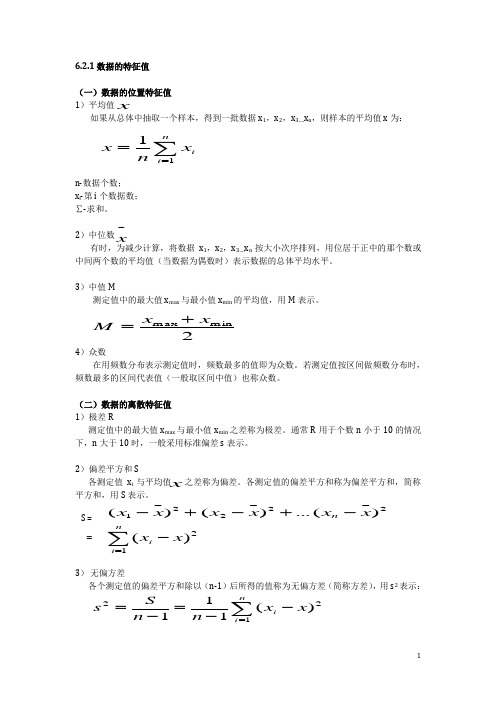

6.2.1数据的特征值

6.2.1数据的特征值(一)数据的位置特征值 1)平均值如果从总体中抽取一个样本,得到一批数据x 1,x 2,x 3….x n ,则样本的平均值x 为: n-数据个数;x i -第i 个数据数;∑-求和。

2)中位数有时,为减少计算,将数据x 1,x 2,x 3….x n 按大小次序排列,用位居于正中的那个数或中间两个数的平均值(当数据为偶数时)表示数据的总体平均水平。

3)中值M测定值中的最大值x max 与最小值x min 的平均值,用M 表示。

4)众数在用频数分布表示测定值时,频数最多的值即为众数。

若测定值按区间做频数分布时,频数最多的区间代表值(一般取区间中值)也称众数。

(二)数据的离散特征值1)极差R测定值中的最大值x max 与最小值x min 之差称为极差。

通常R 用于个数n 小于10的情况下,n 大于10时,一般采用标准偏差s 表示。

2)偏差平方和S 各测定值x i 与平均值 之差称为偏差。

各测定值的偏差平方和称为偏差平方和,简称平方和,用S 表示。

无偏方差各个测定值的偏差平方和除以(n-1)后所得的值称为无偏方差(简称方差),用s 2表示:∑==n i i x n x 1_1~x 2min max x x M +=_x _x ∑=--=-=n i i x x n n S s 12_2)(1112_2_22_1)(...)()(x x x x x x n -+-+-∑=-n i i x x 12_)(S ==标准偏差s方差s 2的平方根为标准偏差(简称标准差),用s 表示:(三)变异系数以上反映数据离散程度的特征值,只反映产品质量的绝对波动大小。

在工程实践中,测量较大的产品,绝对误差一般较大,反之亦然。

因此要考虑相对波动的大小,在统计技术上用变异系数CV 来表达:上式中σ和μ为总体均值和总体标准差,当过程在受控状态下,且样本容差较大时,可用样本标准差s 和样本均值 估计。

∑=--=-==n i i x x n n S s s 12_2)(111_x s CV ≈=μσ_x。

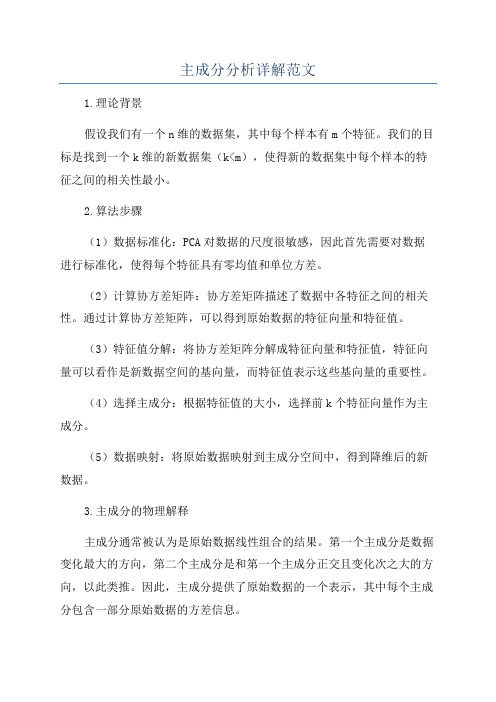

主成分分析详解范文

主成分分析详解范文1.理论背景假设我们有一个n维的数据集,其中每个样本有m个特征。

我们的目标是找到一个k维的新数据集(k<m),使得新的数据集中每个样本的特征之间的相关性最小。

2.算法步骤(1)数据标准化:PCA对数据的尺度很敏感,因此首先需要对数据进行标准化,使得每个特征具有零均值和单位方差。

(2)计算协方差矩阵:协方差矩阵描述了数据中各特征之间的相关性。

通过计算协方差矩阵,可以得到原始数据的特征向量和特征值。

(3)特征值分解:将协方差矩阵分解成特征向量和特征值,特征向量可以看作是新数据空间的基向量,而特征值表示这些基向量的重要性。

(4)选择主成分:根据特征值的大小,选择前k个特征向量作为主成分。

(5)数据映射:将原始数据映射到主成分空间中,得到降维后的新数据。

3.主成分的物理解释主成分通常被认为是原始数据线性组合的结果。

第一个主成分是数据变化最大的方向,第二个主成分是和第一个主成分正交且变化次之大的方向,以此类推。

因此,主成分提供了原始数据的一个表示,其中每个主成分包含一部分原始数据的方差信息。

4.特征值与解释方差特征值表示每个主成分的重要性。

较大的特征值对应较重要的主成分。

通过特征值的比例,我们可以了解这些主成分对数据方差的解释程度。

通常,我们选择特征值之和的一部分来解释原始数据方差的比例(例如,90%)。

这样可以帮助我们确定保留多少个主成分,以在保持数据信息的同时降低数据维度。

5.应用场景主成分分析在许多领域都有广泛的应用,包括数据预处理,模式识别,图像处理等。

例如,在图像压缩中,我们可以使用PCA将图像从RGB颜色空间转换为YCbCr颜色空间,然后把Cb和Cr分量降维,从而减少图像的存储空间。

总的来说,主成分分析是一种常用的降维算法,通过找到数据中的主要特征,可以帮助我们减少数据的维度,简化计算和分析的复杂性,并在保持数据信息的同时减少噪声和冗余。

同时,PCA的应用还涉及到数据可视化、数据压缩和模式识别等领域,具有广泛的实际应用价值。

一种改进的服饰图像HSV颜色特征提取方法

一种改进的服饰图像HSV 颜色特征提取方法陈双华苏州信息职业技术学院,江苏 苏州 215200摘要:在基于内容的图像检索技术中,颜色是关键的特征。

文章主要对B2B 网站的服饰图像颜色特征提取进行了研究。

在服饰颜色特征提取上,使用的是HSV 颜色空间,并且应用一种改进的HSV 主色加权的颜色特征提取方法,提高了图像特征提取的准确度和速度。

通过实验,取得了良好的提取效果,证明了改进的HSV 颜色特征提取方法适合于图像库。

关键词:HSV;颜色特征;服饰图像检索中图分类号:TP391.41作者简介:陈双华(1992—),女,江西萍乡人,硕士,苏州信息职业技术学院教师。

0 引言B2B 购物网站不断发展,为了能使买家准确而又快速地找到目标商品,B2B 网站通常都是以商品分类的方式以及用户主动输入关键字的商品检索方式,有些时候检索出来的并不是人们想要的商品。

本文的目的在于根据正在发展中的基于内容的图像检索技术(CBIR)[1],将它应用于服饰B2B 网站平台中,使得目前以关键字为主要检索方式的服饰商品查询方式更加丰富。

通过对服饰图像颜色特征提取技术的研究,替代主观和限制性强的关键字检索方式,并且对目前已经出现的服饰图像颜色特征提取技术进行改进,以更准确便利客观的方式使用户更好地对服饰商品进行检索。

1 颜色特征提取设计在CBIR 技术中,对于颜色的特征提取有着旋转以及平移不变性等优点,所以相对于其他特征来说颜色有着很高的利用价值。

在面向B2B 网站的服饰图像特征提取中,服饰图像的颜色特征非常丰富,所以利用它进行特征提取将会提高整体的准确性,得到更好的效果。

那么在对服饰颜色特征进行提取时,有以下几项工作要进行。

1.1 颜色模型选择在图像的表示中,主要有RGB、HSV 等模型,在这些模型中,RGB 是使用最广泛的。

虽然数字图像一般用RGB 颜色模型表示,但是RGB 不能在视觉上反映出颜色的差异,因此,需要选择其他的颜色模型来描述对颜色信息的视觉一致性,以此来减小量化时的误差。

特征值解法

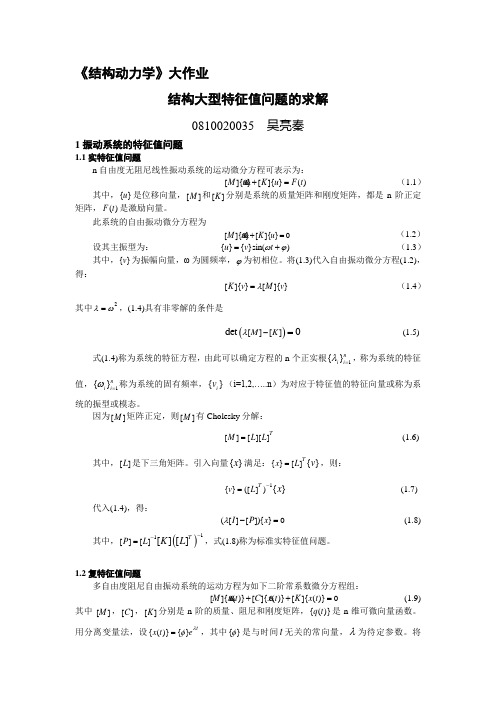

《结构动力学》大作业结构大型特征值问题的求解0810020035 吴亮秦1振动系统的特征值问题1.1实特征值问题n 自由度无阻尼线性振动系统的运动微分方程可表示为:[]{}[]{}()M u K u F t += (1.1)其中,{}u 是位移向量,[]M 和[]K 分别是系统的质量矩阵和刚度矩阵,都是n 阶正定矩阵,()F t 是激励向量。

此系统的自由振动微分方程为[]{}[]{}0M u K u += (1.2)设其主振型为: {}{}sin()u v t ωϕ=+ (1.3) 其中,{}v 为振幅向量,ω为圆频率,ϕ为初相位。

将(1.3)代入自由振动微分方程(1.2), 得:[]{}[]{}K v M v λ= (1.4) 其中2λω=,(1.4)具有非零解的条件是()[][]det 0M K λ-= (1.5)式(1.4)称为系统的特征方程,由此可以确定方程的n 个正实根1{}n i i λ=,称为系统的特征值,1{}n i i ω=称为系统的固有频率,{}i v (i=1,2,…..n )为对应于特征值的特征向量或称为系统的振型或模态。

因为[]M 矩阵正定,则[]M 有Cholesky 分解:[][][]TM L L = (1.6)其中,[]L 是下三角矩阵。

引入向量{}x 满足:{}[]{}Tx L v =,则:1{}([]){}T v L x -= (1.7) 代入(1.4),得:([][]){}0I P x λ-= (1.8)其中,()11[][][][]TP L K L --=,式(1.8)称为标准实特征值问题。

1.2复特征值问题多自由度阻尼自由振动系统的运动方程为如下二阶常系数微分方程组:[]{()}[]{()}[]{()}0 M x t C x t K x t ++= (1.9) 其中 []M ,[]C ,[]K 分别是n 阶的质量、阻尼和刚度矩阵,{()}q t 是n 维可微向量函数。

颜色特征提取

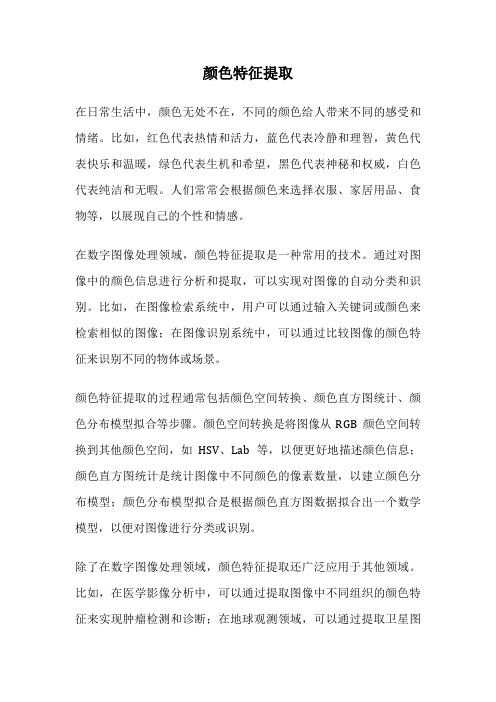

颜色特征提取

在日常生活中,颜色无处不在,不同的颜色给人带来不同的感受和情绪。

比如,红色代表热情和活力,蓝色代表冷静和理智,黄色代表快乐和温暖,绿色代表生机和希望,黑色代表神秘和权威,白色代表纯洁和无暇。

人们常常会根据颜色来选择衣服、家居用品、食物等,以展现自己的个性和情感。

在数字图像处理领域,颜色特征提取是一种常用的技术。

通过对图像中的颜色信息进行分析和提取,可以实现对图像的自动分类和识别。

比如,在图像检索系统中,用户可以通过输入关键词或颜色来检索相似的图像;在图像识别系统中,可以通过比较图像的颜色特征来识别不同的物体或场景。

颜色特征提取的过程通常包括颜色空间转换、颜色直方图统计、颜色分布模型拟合等步骤。

颜色空间转换是将图像从RGB颜色空间转换到其他颜色空间,如HSV、Lab等,以便更好地描述颜色信息;颜色直方图统计是统计图像中不同颜色的像素数量,以建立颜色分布模型;颜色分布模型拟合是根据颜色直方图数据拟合出一个数学模型,以便对图像进行分类或识别。

除了在数字图像处理领域,颜色特征提取还广泛应用于其他领域。

比如,在医学影像分析中,可以通过提取图像中不同组织的颜色特征来实现肿瘤检测和诊断;在地球观测领域,可以通过提取卫星图

像中的颜色特征来监测自然灾害和环境变化。

总的来说,颜色特征提取是一项重要的技术,它不仅可以帮助我们更好地理解和利用颜色在视觉感知中的作用,还可以为我们提供更多的信息和可能性。

希望通过不断的研究和应用,颜色特征提取技术能够更好地为人类社会和科学发展做出贡献。

特征值的一些结论

特征值的一些结论特征值是矩阵理论中的重要概念,它在多个领域中都有广泛的应用。

本文将从不同角度探讨特征值的一些结论。

一、特征值的定义和性质特征值是对于一个n阶方阵A而言,满足方程Ax=λx的非零向量x 所对应的常数λ。

特征值具有以下性质:1. 特征值是方阵A的本征性质。

它描述了矩阵A通过线性变换后的不变性。

2. 特征值的个数等于方阵的阶数n。

3. 特征值与特征向量是一一对应的,即每个特征值对应一个特征向量,且特征向量可以通过特征值方程Ax=λx求解。

二、特征值与矩阵的迹和行列式的关系1. 矩阵的特征值之和等于矩阵的迹。

迹是矩阵对角线上元素的和,记为tr(A)。

2. 矩阵的特征值之积等于矩阵的行列式。

行列式是矩阵的一个标量值,记为det(A)。

三、特征值与矩阵的相似性1. 相似矩阵具有相同的特征值。

如果矩阵B可以通过相似变换A=PBP^(-1)得到,那么A和B具有相同的特征值。

2. 相似矩阵的特征向量也相同,只是相差一个比例常数。

如果x是矩阵A的特征向量,那么对应于矩阵B的特征向量为P^(-1)x。

四、特征值与矩阵的对角化1. 可对角化矩阵具有n个线性无关的特征向量。

如果一个矩阵A可以通过相似变换得到对角矩阵D,即A=PDP^(-1),那么P的列向量就是A的n个线性无关的特征向量。

2. 对角化矩阵的对角元素就是特征值。

对角矩阵D的主对角线上的元素就是A的特征值。

五、特征值与矩阵的奇异值的关系1. 奇异值是矩阵的特征值平方根。

对于一个m×n的矩阵A,它的奇异值分解为A=UΣV^T,其中U和V是正交矩阵,Σ是一个对角矩阵,对角元素是矩阵A的奇异值的平方根。

2. 奇异值与特征值之间存在关系。

矩阵A的奇异值的平方等于A^TA的特征值,即Σ^2=U^TA^TAVΣ^2。

六、特征值的应用特征值在许多领域中都有广泛的应用,如图像处理、信号处理、机器学习等。

以下是一些具体的应用:1. 主成分分析(PCA):利用特征值分解可以对数据进行降维,提取出数据的主要特征。

计算机视觉用于猪肉新鲜度检测的颜色特征优化选取

计算机视觉用于猪肉新鲜度检测的颜色特征优化选取潘婧;钱建平;刘寿春;韩帅【摘要】在以计算机视觉为基础,并利用神经网络预测猪肉通脊新鲜度时,选择合适的颜色特征参数和神经网络模型是提高其预测准确性的关键之一.文中提出了一种猪肉新鲜度等级预测时颜色特征参数和神经网络优化选取的方法,利用图像处理的方法提取通脊表面的颜色特征参数,组合成RGB-HIS、RGB-L*a*b*、rgb-HIS、rgb-L*a * b*及HIS-L*a*b*五类特征参数组合,并利用BP(back propagation,BP)和SVM(support vector machine,SVM)神经网络构造各类新鲜度等级预测模型.结果表明:SVM和BP的平均预测准确率分别为91.11%和84.44%,且rgb-HIS特征参数组合的BP与SVM预测模型的预测准确率最高,分别为88.89%和95.56%.因此,提取通脊表面r、g、b、H、I、S均值作为颜色特征向量,且选择SVM神经网络来构造新鲜度预测模型可显著提高预测结果的准确性.【期刊名称】《食品与发酵工业》【年(卷),期】2016(042)006【总页数】6页(P153-158)【关键词】猪肉;新鲜度;颜色特征;BP;SVM;预测模型【作者】潘婧;钱建平;刘寿春;韩帅【作者单位】上海海洋大学信息学院,上海,201306;国家农业信息化工程技术研究中心,北京,100097;国家农业信息化工程技术研究中心,北京,100097;国家农业信息化工程技术研究中心,北京,100097;国家农业信息化工程技术研究中心,北京,100097【正文语种】中文肉品新鲜度是衡量其卫生质量的主要指标之一。

精确的肉品新鲜度评定方法,不仅可以预估其相应的货架期时间,也可确保食用者的饮食安全。

传统的新鲜度感官评价存在着主观性强、效率低等缺陷[1]。

然而,随着20世纪后期计算机硬件的飞速发展以及应用软件的不断更新,推动了计算机视觉技术在肉类新鲜度相关色泽评价的应用上不断发展与成熟,且近年来,相关学者研究表明,利用计算机视觉识别肉类新鲜度已达到可取代人工感官评价的程度[2]。

MATLAB习题及答案

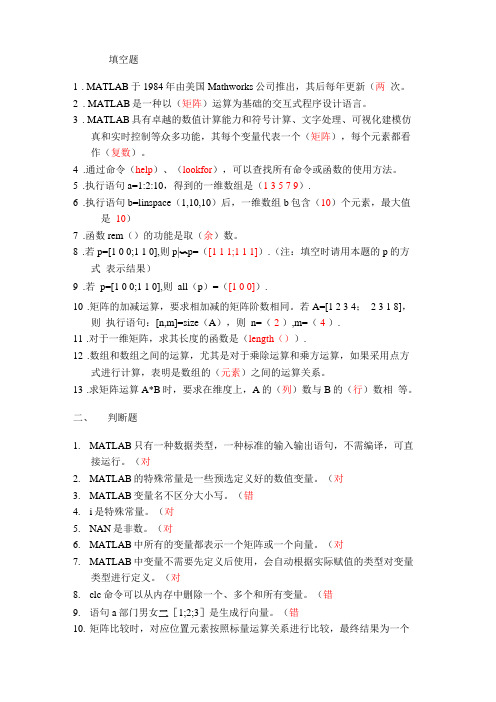

填空题1. MATLAB于1984年由美国Mathworks公司推出,其后每年更新(两次。

2. MATLAB是一种以(矩阵)运算为基础的交互式程序设计语言。

3. MATLAB具有卓越的数值计算能力和符号计算、文字处理、可视化建模仿真和实时控制等众多功能,其每个变量代表一个(矩阵),每个元素都看作(复数)。

4.通过命令(help)、(lookfor),可以查找所有命令或函数的使用方法。

5.执行语句a=1:2:10,得到的一维数组是(1 3 5 7 9).6.执行语句b=linspace(1,10,10)后,一维数组b包含(10)个元素,最大值是10)7.函数rem()的功能是取(余)数。

8.若p=[1 0 0;1 1 0],则p|〜p=([1 1 1;1 1 1]).(注:填空时请用本题的p的方式表示结果)9.若p=[1 0 0;1 1 0],则all(p)=([1 0 0]).10.矩阵的加减运算,要求相加减的矩阵阶数相同。

若A=[1 2 3 4;2 3 1 8],则执行语句:[n,m]=size(A),则n=(2 ),m=(4 ).11.对于一维矩阵,求其长度的函数是(length()).12.数组和数组之间的运算,尤其是对于乘除运算和乘方运算,如果采用点方式进行计算,表明是数组的(元素)之间的运算关系。

13.求矩阵运算A*B时,要求在维度上,A的(列)数与B的(行)数相等。

二、判断题1.MATLAB只有一种数据类型,一种标准的输入输出语句,不需编译,可直接运行。

(对2.MATLAB的特殊常量是一些预选定义好的数值变量。

(对3.MATLAB变量名不区分大小写。

(错4.i是特殊常量。

(对5.NAN是非数。

(对6.MATLAB中所有的变量都表示一个矩阵或一个向量。

(对7.MATLAB中变量不需要先定义后使用,会自动根据实际赋值的类型对变量类型进行定义。

(对8.clc命令可以从内存中删除一个、多个和所有变量。

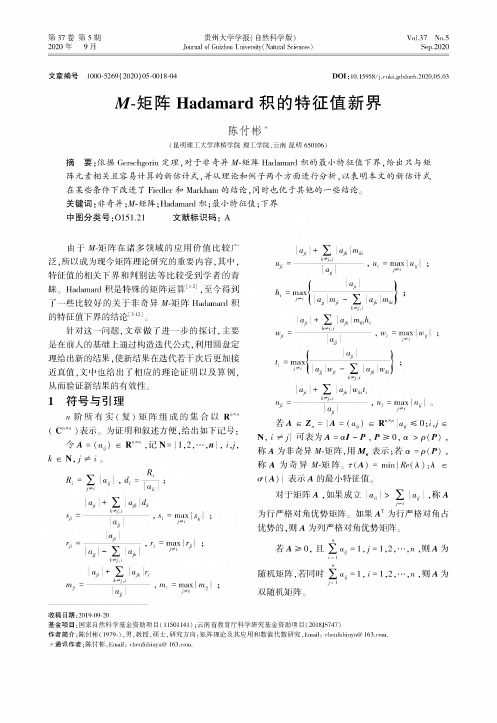

M-矩阵Hadamard积的特征值新界

第 37 卷 第 5 期2020 年 9 月贵州大学学报(自然科学版)Journal of Guizhou University(Natural Sciences)Vol.37 No.5Sep.2020文章编号 1000-5269( 2020) 05-0018-04DOI :10.15958/ki.gdxbzrb.2020.05.03M -矩阵Hadamard 积的特征值新界陈付彬"(昆明理工大学津桥学院理工学院,云南昆明650106)摘 要:依据Gerschgorin 定理,对于非奇异M-矩阵Hadamard 积的最小特征值下界,给出只与矩 阵元素相关且容易计算的新估计式,并从理论和例子两个方面进行分析,以表明本文的新估计式 在某些条件下改进了 Fiedler 和Markham 的结论,同时也优于其他的一些结论。

关键词:非奇异;M-矩阵;Hadamard 积;最小特征值;下界中图分类号:0151.21文献标识码:A由于M-矩阵在诸多领域的应用价值比较广泛,所以成为现今矩阵理论研究的重要内容,其中,特征值的相关下界和判别法等比较受到学者的青睐。

Hadamard 积是特殊的矩阵运算[1-2],至今得到了一些比较好的关于非奇异M-矩阵Hadamard 积 的特征值下界的结论[3-12]。

针对这一问题,文章做了进一步的探讨,主要是在前人的基础上通过构造迭代公式,利用圆盘定理给出新的结果,使新结果在迭代若干次后更加接 近真值,文中也给出了相应的理论证明以及算例,从而验证新结果的有效性。

1符号与引理n 阶所有实(复)矩阵组成的集合以R""(C "x ")表示。

为证明和叙述方便,给出如下记号:令 A =(切)e R "x ",记 N ={1,2,…,"I , i,i,k e N , j 丰 i 。

心=X a i,diR ia ua +X ajkd k十弓------,S i = m ax{ }ki,u ; = max { u ; -};M i Jmax kimax a ;i +X a ;km="” =a= {________ a 广鬻x{laJ^i-X|ajm (a +X akm ki h i兮=------k T^------------,叫=max {wj ;a J円=_ (________ a _______________|w =鬻x a W i - X a.w ki;a ;i + Xa k w ki t i"i =--------------------------- , "i = max {"ij 。

2025届山东省名校联盟新教材数学高三第一学期期末联考试题含解析

2025届山东省名校联盟新教材数学高三第一学期期末联考试题注意事项1.考试结束后,请将本试卷和答题卡一并交回.2.答题前,请务必将自己的姓名、准考证号用0.5毫米黑色墨水的签字笔填写在试卷及答题卡的规定位置. 3.请认真核对监考员在答题卡上所粘贴的条形码上的姓名、准考证号与本人是否相符.4.作答选择题,必须用2B 铅笔将答题卡上对应选项的方框涂满、涂黑;如需改动,请用橡皮擦干净后,再选涂其他答案.作答非选择题,必须用05毫米黑色墨水的签字笔在答题卡上的指定位置作答,在其他位置作答一律无效. 5.如需作图,须用2B 铅笔绘、写清楚,线条、符号等须加黑、加粗.一、选择题:本题共12小题,每小题5分,共60分。

在每小题给出的四个选项中,只有一项是符合题目要求的。

1.在三角形ABC 中,1a =,sin sin sin sin b c a bA AB C++=+-,求sin b A =( )A .2B .3C .12D .22.抛物线方程为24y x =,一直线与抛物线交于A B 、两点,其弦AB 的中点坐标为(1,1),则直线的方程为( ) A .210x y --=B .210x y +-=C .210x y -+=D .210x y ---=3.已知函数()f x 是奇函数,且22()'()ln(1)ln(1)1f x f x x x x -=+----,若对11[,]62x ∀∈,(1)(1)f ax f x +<-恒成立,则a 的取值范围是( ) A .(3,1)--B .(4,1)--C .(3,0)-D .(4,0)-4.已知直线1l :x my =(0m ≠)与抛物线C :24y x =交于O (坐标原点),A 两点,直线2l :x my m =+与抛物线C 交于B ,D 两点.若||3||BD OA =,则实数m 的值为( ) A .14B .15C .13D .185.已知集合{}{}2|1,|31x A x x B x ==<,则()RAB =( )A .{|0}x x <B .{|01}x xC .{|10}x x -<D .{|1}x x -6.在ABC ∆中,D 为AC 的中点,E 为AB 上靠近点B 的三等分点,且BD ,CE 相交于点P ,则AP =( ) A .2132AB AC + B .1124AB AC + C .1123AB AC + D .2133AB AC + 7.为得到函数πcos 23y x ⎛⎫=+⎪⎝⎭的图像,只需将函数sin 2y x =的图像( )A .向右平移5π6个长度单位 B .向右平移5π12个长度单位 C .向左平移5π6个长度单位D .向左平移5π12个长度单位8.如图,在中,点M 是边的中点,将沿着AM 翻折成,且点不在平面内,点是线段上一点.若二面角与二面角的平面角相等,则直线经过的( )A .重心B .垂心C .内心D .外心9.某几何体的三视图如图所示,则该几何体的体积为( )A .23B .13C .43D .5610.空间点到平面的距离定义如下:过空间一点作平面的垂线,这个点和垂足之间的距离叫做这个点到这个平面的距离.已知平面α,β,λ两两互相垂直,点A α∈,点A 到β,γ的距离都是3,点P 是α上的动点,满足P 到β的距离与P 到点A 的距离相等,则点P 的轨迹上的点到β的距离的最小值是( ) A .33B .3C 33-D .3211.已知集合{|4},{|2,}A x N y x B x x n n Z =∈=-==∈,则A B =( )A .[0,4]B .{0,2,4}C .{2,4}D .[2,4]12.已知函数f (x )=223,1ln ,1x x x x x ⎧--+≤⎨>⎩,若关于x 的方程f (x )=kx -12恰有4个不相等的实数根,则实数k 的取值范围是( ) A .1e 2⎛⎝ B .12e ⎡⎢⎣C .1,2e e ⎛⎤ ⎥ ⎝⎦D .1,2e e ⎛⎫⎪⎝⎭二、填空题:本题共4小题,每小题5分,共20分。

矩阵的秩与其非零特征值个数相等的条件

矩阵的秩与其非零特征值个数相等的条件张景晓【摘要】证明了n阶方阵A的秩r(A)与其非零特征值个数μ(A)之间的关系:r(A)≥μ(A).得出了矩阵A可逆和矩阵A可对角化是r(A)=μ(A)的两个充分条件;矩阵A没有形如xm(m2)的初等因子是r(A)=μ(A)的充分必要条件.%The relationship between the rank of matrix and its number of nonzero eigenvalue is proved,that is r(A)≥u(A).Following conclusion are educed,the two sufficient condition for r(A)=u(A) are that matrixA is invertible and matrix A is diagonalizable,the Necessary and Sufficient Conditions for r(A)=u(A) is that there is not the elementary factor whose form is xm(m≥2) in elementary factors of matrix A.【期刊名称】《德州学院学报》【年(卷),期】2012(028)004【总页数】4页(P5-8)【关键词】矩阵的秩;非零特征值个数;初等因子【作者】张景晓【作者单位】德州学院数学系,山东德州253023【正文语种】中文【中图分类】O151.21矩阵的秩r(A)和矩阵的非零特征值个数μ(A)都是矩阵相似意义下的不变量,也就是说矩阵的相似初等变换不改变r(A)和μ(A)的值;对于实对称矩阵A 来说r(A)和μ(A)也是合同意义下的不变量,即是说矩阵的合同变换不改变实对称矩阵A的秩r(A)和它的非零特征值个数μ(A),因此r(A)和μ(A)是方阵A的基本特征指标.满足条件r(A)=μ(A)的矩阵在数理统计、试验设计、多元统计分析、金融计量统计、经济统计分析等各种应用统计分析中都有其应用背景,因此讨论和研究矩阵的秩与其非零特征值个数相等的条件具有一定的应用价值.一个矩阵的秩r(A)未必同它的非零特征值个数μ(A)相同,事实上存在无穷多个矩阵,它们的秩与其非零特征值个数相等,如零矩阵、单位矩阵以及所有的对角矩阵和初等方阵等;也存在无穷多个矩阵它们的秩与其非零特征值个数不同,首先给出r(A)与μ(A)之间的关系定理.定理1 对于任意n阶方阵A,都有r(A)≥μ(A).证明当|A|≠0时,矩阵A可逆,从而r(A)=n.设λ1,λ2,…,λn是矩阵A的全部特征根,则|A|=λ1λ2…λn≠0,从而A有n个非零特征值,故μ(A)=n,所以r(A)≥μ(A)成立.当|A|=0时,r(A)=r<n,矩阵A的行向量组α1,α2,…,αn的秩是r,故该向量组中必有r个向量线性无关,不妨设前r个向量α1,α2,…,αr线性无关,则αr+1,αr+2,…,αn均可由α1,α2,…,αr线性表出,设αi=ki1α1+ki2α2+…+kirαr,i=r+1,r+2,…,n.则有将A的特征行列式的第j行(j=1,2,…,r)分别乘以-kij后加到第i行(i=r +1,r+2,…,n)上得其中是关于λ的r次多项式由此可知矩阵A至少有n-r个零特征值,从而A至多有r个非零特征值,因此有r(A)≥μ(A).定理2 若矩阵A可对角化,则r(A)=μ(A).证明由于A可对角化,故存在可逆阵T使得T-1 AT其中λ1,λ2,…,λn是矩阵A的全部特征根.由于矩阵T可逆,故A的秩与其非零特征值个数相等,从而r(A)=μ(A).推论1 若矩阵A的秩与它的非零特征值个数不相等,则矩阵A不可对角化.推论1是定理1的逆否命题,因此结论成立.推论2 形如和形如的n(n>1)阶非零方阵均不可对角化.证明由于A≠0,B≠0,故r(A)>0,r(B)>0,又显然矩阵A,B的特征值全为0,由推论1可知,A,B均不可对角化.推论3 实对称矩阵的秩与其非零特征值个数相同.证明由于实对称矩阵都可对角化,由定理1,结论得证.推论4 设矩阵A是m×n阶实矩阵,则有r(A)=μ(AAT)=μ(ATA),其中AT是矩阵A的转置矩阵.证明由于矩阵A是实矩阵,从而AAT和ATA均实对称,由推论3得:又因为r(A)=r(AAT)=r(ATA),所以r(A)=μ(AAT)=μ(ATA). 定理3 若矩阵A可逆,则r(A)=μ(A).定理3的证明见定理1的第一种情况.下面给出方阵A满足r(A)=μ(A)的充分必要条件.定理4 设A为n阶方阵,则r(A)=μ(A)的充要条件是A没有形如xm(m≥2)的初等因子.证明必要性,设r(A)=μ(A),且A有k个不同的特征值λ1,λ2,…,λk,它们的重数分别为:n1,n2,…,nk,则有n1+n2+…+nk=n,又设λ1,λ2,…,λk中前s个不为零,后t个是零,则A的非零特征值个数μ(A)=n1+n2+…+ns.设A的若当标准形是其中反证,若A有q个形如xm(m≥2)的初等因子:xm1,xm2,…,xmq其中mi≥2,i=1,2,…,q则在A的若当标准形中必有q个形如的若当块.由于r(Jj)=mj-1,因此这与r(A)=μ(A)的假设相矛盾,因此A没有形如xm(m≥2)的初等因子. 充分性:若矩阵A没有形如xm(m≥2)的初等因子,则在矩阵A的若当块中要么是主对角线元素全不为零的若当块,要么是一阶的零若当块,故有r(A)=r (J)=r(J1)+r(J2)+…+r(Jp)=n1+n2+…+ns=μ(A).【相关文献】[1]北京大学数学系几何与代数教研室前代数小组.高等代数[M].北京:高等教育出版社,2003.[2]丘维声.高等代数(上、下册)[M].北京:清华大学出版社,2010.[3]王萼芳.高等代数解题辅导[M].北京:高等教育出版社,2010.[4]李慧陵.高等代数[M].北京:高等教育出版社,2009.[5]于清江,包研科.用n阶方阵的迹判定其互异特征值的个数[J].大学数学,2006,(5). [6]Thomas W.Hungerford.Algbra[M].Winston:Holt,Rinehart,2003.。

已知一个特征值,求解特征向量的方法

已知一个特征值,求解特征向量的方法

求解特征向量是机器学习中一种重要的应用,从表达数据信息的角度出发,重

要的特征向量可以简化数据之间的复杂关系,从而帮助用户更好地理解相关的资料,适应世界的变化。

那么当我们已经知道一个特征值时,如何求解该特征向量呢?

首先,需要明确要解决的问题:获得序列中特征值对应的特征向量。

根据求解

特征向量的基本原理,就是需要定义一组特征向量Ψ(Ψ1,Ψ2,……,Ψm),

使得特征值符合如下的关系式:λ=Ψ*A*Ψ,其中,A是特征值与特征向量的关系表,λ表示已知的特征值,而Ψ表示未知的特征向量。

因此,可以先采用特定的算法,将λ代入到上述的表达式中,并采用变分原

理求得Ψ的取值。

由于A的未知参数十分多,因此需要进行线性组合,定义出一

个适合这一组特征向量的特殊表达式,在此基础上,通过构造合适的优化函数,进而利用梯度下降法或共轭梯度下降法,求解出满足Ψ*A*Ψ=λ的最佳特征向量。

求解特征向量可以显著提升机器学习中模型的准确性与泛化能力,这也是工程

实践中常用的一种技术。

不仅能够精准定位已有的特征,而且可以在机器学习的过程中发现新的特征,进一步提升模型的准确度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

a=[Ravg1,Gavg1,Bavg1,Rstd1,Gstd1,Bstd1,Havg1,Savg1,Iavg1,Hstd1,Sstd1,Istd1];

A=[A;a];

xlswrite('E:\新建文件夹\A\color颜色均值12个特征值.xls',A);

end

theta=acos(tmp1./(tmp2+eps));

H=theta;

H(B>G)=2*pi-H(B>G);

H=H/(2*pi);

H(S==0)=0;

hsi=cat(3,H,S,I);

Havg1=mean2(H); %红色分量均值

Savg1=mean2(S); %绿色分量均值

R=I(:,:,1); %红色分量

G=I(:,:,2); %绿色分量

B=I(:,:,3); %蓝色#43;B);

%计算S分量

tmp1=min(min(R,G),B);

tmp2=R+G+B;

tmp2(tmp2==0)=eps;

S=1-3.*tmp1./tmp2;

%计算H分量

tmp1=0.5*((R-G)+(R-B));

tmp2=sqrt((R-G).^2+(R-B).*(G-B));

R=double(R); G=double(G); B=double(B); %利用double()函数将变量类型转为double型

Ravg1=mean2(R); %红色分量均值

Gavg1=mean2(G); %绿色分量均值

clear all;clc;

A=[];

for i=1:52 %如果文件夹有7张图,可更改

ii=num2str(i);

I=imread(['E:\新建文件夹\A\',ii,'.jpg']); %读取当前文件夹,' '可以变成其他文件

Bavg1=mean2(B); %蓝色分量均值

Rstd1=std(std(R)); %红色分量的方差

Gstd1= std(std(G)); %绿色分量的方差

Bstd1=std(std(B)); %蓝色分量的方差

Iavg1=mean2(I); %蓝色分量均值

Hstd1=std(std(H)); %红色分量的方差

Sstd1= std(std(S)); %绿色分量的方差

Istd1=std(std(I)); %蓝色分量的方差