实验四-支持向量机教学文案

实验报告支持向量机

实验报告支持向量机实验报告支持向量机实验原理:支持向量机的原理和实现技术。

实验题目:对鸢尾花数据利用SVM技术进行分类预测。

实验要求:把鸢尾花数据分成训练集和测试集,然后针对样本SVM预测分类。

实验题目--分析报告:data(iris)> rm(list=ls())> gc()used (Mb) gc trigger (Mb) max used (Mb)Ncells 252143 13.5 608394 32.5 410515 22.0Vcells 528486 4.1 8388608 64.0 1606736 12.3> library(MASS)> data(iris)> library(e1071)> summary(iris)Sepal.Length Sepal.Width Petal.Length Petal.Width Min. :4.300 Min. :2.000 Min. :1.000 Min. :0.100 1st Qu.:5.100 1st Qu.:2.800 1st Qu.:1.600 1st Qu.:0.300 Median :5.800 Median :3.000 Median :4.350 Median :1.300 Mean :5.843 Mean :3.057 Mean :3.758 Mean :1.199 3rd Qu.:6.400 3rd Qu.:3.300 3rd Qu.:5.100 3rd Qu.:1.800 Max. :7.900 Max. :4.400 Max. :6.900 Max. :2.500 Speciessetosa :50versicolor:50virginica :50仅选择Petal.Length和Petal.Width这两个特征时> model <- svm( Petal.Length ~ Petal.Width, data = iris) > print(model)Call:svm(formula = Petal.Length ~ Petal.Width, data = iris) Parameters:SVM-Type: eps-regressionSVM-Kernel: radialcost: 1gamma: 1epsilon: 0.1Number of Support Vectors: 80> summary(model)Call:svm(formula = Petal.Length ~ Petal.Width, data = iris) Parameters:SVM-Type: eps-regressionSVM-Kernel: radialcost: 1gamma: 1epsilon: 0.1Number of Support Vectors: 80> svm(formula = Petal.Length ~ Petal.Width, data = iris)Call:svm(formula = Petal.Length ~ Petal.Width, data = iris) Parameters:SVM-Type: eps-regressionSVM-Kernel: radialcost: 1gamma: 1epsilon: 0.1Number of Support Vectors: 80> predict(model,iris)1 2 3 4 5 6 7 8 1.423837 1.423837 1.423837 1.423837 1.423837 1.616469 1.477096 1.423837 9 10 11 12 13 14 15 16 1.423837 1.456913 1.423837 1.423837 1.456913 1.456913 1.423837 1.616469 17 18 19 20 21 22 23 24 1.616469 1.477096 1.477096 1.477096 1.423837 1.616469 1.423837 1.834129 25 26 27 28 29 30 31 32 1.423837 1.423837 1.616469 1.423837 1.423837 1.423837 1.423837 1.616469 33 34 35 36 37 38 39 40 1.456913 1.423837 1.423837 1.423837 1.423837 1.456913 1.423837 1.423837 41 42 43 44 45 46 47 48 1.477096 1.477096 1.423837 2.115572 1.616469 1.477096 1.423837 1.423837 49 50 51 52 53 54 55 56 1.423837 1.423837 4.497139 4.675747 4.675747 4.293120 4.675747 4.293120 57 58 59 60 61 62 63 64 4.836986 3.477178 4.293120 4.497139 3.477178 4.6757473.4771784.497139 65 66 67 68 69 70 71 72 4.293120 4.4971394.675747 3.477178 4.675747 3.7845145.134367 4.29312073 74 75 76 77 78 79 80 4.675747 4.056829 4.293120 4.497139 4.497139 4.988183 4.675747 3.477178 81 82 83 84 85 86 87 88 3.784514 3.477178 4.056829 4.836986 4.675747 4.836986 4.675747 4.293120 89 90 91 92 93 94 95 96 4.293120 4.293120 4.056829 4.497139 4.056829 3.477178 4.293120 4.056829 97 98 99 100 101 102 103 104 4.293120 4.293120 3.784514 4.293120 5.752344 5.277177 5.540312 5.134367 105 106 107 108 109 110 111 112 5.646354 5.540312 4.988183 5.134367 5.134367 5.752344 5.414423 5.277177 113 114 115 116 117 118 119 120 5.540312 5.414423 5.760448 5.722808 5.134367 5.646354 5.722808 4.675747 121 122 123 124 125 126 127 128 5.722808 5.414423 5.414423 5.134367 5.540312 5.134367 5.134367 5.134367 129 130 131 132 133 134 135 136 5.5403124.8369865.277177 5.414423 5.646354 4.675747 4.4971395.722808 137 138 139 140 141 142 143 144 5.760448 5.1343675.134367 5.540312 5.760448 5.722808 5.277177 5.722808 145 146 147 148 149 1505.752344 5.722808 5.277177 5.414423 5.722808 5.134367分割数据集> set.seed(2)> test=sample(1:nrow(iris),100)> iris.train<-iris[-test,]> iris.test<-iris[test,]> dim(iris.train);dim(iris.test)[1] 50 5[1] 100 5> model <- svm(Petal.Length ~ Petal.Width, data = iris.train) > prediction <- predict(model, iris.test[,-1])> tab <- table(pred = prediction, true = iris.test[,1])> tabtruepred 4.3 4.4 4.6 4.8 4.9 5 5.1 5.2 5.4 5.5 5.6 5.7 5.8 5.9 61.47642618523351 0 1 2 2 1 4 2 2 2 1 0 0 1 0 01.51493452501901 1 0 0 1 2 0 0 1 0 0 0 0 0 0 01.53779430619952 0 0 0 1 0 1 2 0 0 0 0 1 0 0 01.69675064955348 0 0 0 0 0 1 1 0 3 0 0 0 0 0 01.94050318790796 0 0 0 0 0 0 1 0 0 0 0 0 0 0 02.24776679658417 0 0 0 0 0 1 0 0 0 0 0 0 0 0 03.59332505159476 0 0 0 0 1 1 0 0 0 1 0 1 0 0 13.85716957677727 0 0 0 0 0 0 1 0 0 1 1 0 0 0 04.07568831142215 0 0 0 0 0 0 0 0 0 1 0 1 1 0 04.25427922933862 0 0 0 0 0 0 0 0 0 0 2 2 0 0 04.40410985410782 0 0 0 0 0 0 0 1 0 0 0 0 0 0 04.53963900708948 0 0 0 0 0 0 0 0 1 0 1 0 0 1 24.67568885604792 0 0 0 0 0 0 0 0 0 0 0 0 0 0 14.82439822095048 0 0 0 0 1 0 0 0 0 0 0 0 0 0 04.99249624342828 0 0 0 0 0 0 0 0 0 0 0 0 0 0 05.1794222728005 0 0 0 0 0 0 0 0 0 0 0 0 2 0 05.37678640997714 0 0 0 0 0 0 0 0 0 0 1 0 0 0 05.56945420033049 0 0 0 0 0 0 0 0 0 0 0 0 0 0 05.73817028383457 0 0 0 0 0 0 0 0 0 0 0 0 0 0 05.86321818426491 0 0 0 0 0 0 0 0 0 0 0 0 0 0 05.92371940451556 0 0 0 0 0 0 0 0 0 0 0 0 0 0 05.92829837440344 0 0 0 0 0 0 0 0 0 0 0 0 1 0 0truepred 6.1 6.2 6.3 6.4 6.5 6.6 6.7 6.8 6.9 7.2 7.3 7.4 7.7 7.9 1.47642618523351 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1.51493452501901 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1.53779430619952 0 0 0 0 0 0 0 0 0 00 0 0 0 1.69675064955348 0 0 0 0 0 0 0 0 0 0 0 0 0 01.94050318790796 0 0 0 0 0 0 0 0 0 0 0 0 0 02.24776679658417 0 0 0 0 0 0 0 0 0 0 0 0 0 03.59332505159476 0 0 0 0 0 0 0 0 0 0 0 0 0 03.85716957677727 0 0 0 0 0 0 0 0 0 0 0 0 0 04.07568831142215 1 0 0 0 0 0 0 0 0 0 0 0 0 0 4.25427922933862 0 0 1 1 0 1 0 0 0 0 0 0 0 0 4.40410985410782 3 0 0 0 0 1 0 0 0 0 0 0 0 0 4.53963900708948 0 0 1 1 0 0 1 0 0 0 0 0 0 0 4.67568885604792 0 0 1 0 0 0 0 0 0 1 0 0 0 0 4.82439822095048 0 0 0 0 0 0 1 0 0 0 0 0 0 04.99249624342828 1 1 0 1 1 0 1 0 0 1 1 0 0 05.1794222728005 0 0 1 0 0 0 0 0 0 0 0 1 0 0 5.37678640997714 0 0 0 0 0 0 0 0 0 0 0 0 0 1 5.56945420033049 0 0 0 0 0 0 0 1 1 0 0 0 0 0 5.73817028383457 0 0 0 0 1 0 0 0 0 0 0 0 1 0 5.86321818426491 0 1 0 1 0 0 0 1 2 0 0 0 1 0 5.92371940451556 0 0 1 0 0 0 1 0 0 0 0 0 0 0 5.92829837440344 0 0 1 0 0 0 1 0 0 0 0 0 0 0 > classAgreement(tab)$`diag`[1] 0.02$kappa[1] -0.01554404$rand[1] 0.910101$crand[1] 0.05377635> tuned <- tune.svm(Petal.Length ~ Petal.Width, data = iris.train, gamma = 10^(-6:-1),+ cost = 10^(1:2))> summary(tuned)Parameter t uning of ‘svm’:- sampling method: 10-fold cross validation- best parameters:gamma cost0.1 10- best performance: 0.1490541- Detailed performance results:gamma cost error dispersion1 1e-06 10 3.4722488 2.20645412 1e-05 10 3.4280844 2.18027033 1e-04 10 3.0083324 1.93194504 1e-03 10 0.7356553 0.44327165 1e-02 10 0.1751669 0.13671456 1e-01 10 0.1490541 0.14017287 1e-06 100 3.4281316 2.18032978 1e-05 100 3.0082136 1.93187919 1e-04 100 0.7319696 0.441025710 1e-03 100 0.1789653 0.126634511 1e-02 100 0.1490979 0.133619912 1e-01 100 0.1613977 0.1530779。

机器学习SVM(支持向量机)实验报告

实验报告实验名称:机器学习:线性支持向量机算法实现学员: 张麻子学号: *********** 培养类型:硕士年级:专业:所属学院:计算机学院指导教员:****** 职称:副教授实验室:实验日期:ﻬ一、实验目得与要求实验目得:验证SVM(支持向量机)机器学习算法学习情况要求:自主完成。

二、实验内容与原理支持向量机(Support Vector Machine,SVM)得基本模型就是在特征空间上找到最佳得分离超平面使得训练集上正负样本间隔最大。

SVM就是用来解决二分类问题得有监督学习算法。

通过引入了核方法之后SVM也可以用来解决非线性问题。

但本次实验只针对线性二分类问题。

SVM算法分割原则:最小间距最大化,即找距离分割超平面最近得有效点距离超平面距离与最大。

对于线性问题:假设存在超平面可最优分割样本集为两类,则样本集到超平面距离为:需压求取:由于该问题为对偶问题,可变换为:可用拉格朗日乘数法求解。

但由于本实验中得数据集不可以完美得分为两类,即存在躁点。

可引入正则化参数C,用来调节模型得复杂度与训练误差。

作出对应得拉格朗日乘式:对应得KKT条件为:故得出需求解得对偶问题:本次实验使用python编译器,编写程序,数据集共有270个案例,挑选其中70%作为训练数据,剩下30%作为测试数据。

进行了两个实验,一个就是取C值为1,直接进行SVM训练;另外一个就是利用交叉验证方法,求取在前面情况下得最优C值.三、实验器材实验环境:windows7操作系统+python编译器。

四、实验数据(关键源码附后)实验数据:来自UCI机器学习数据库,以Heart Disease数据集为例。

五、操作方法与实验步骤1、选取C=1,训练比例7:3,利用python库sklearn下得SVM()函数进行训练,后对测试集进行测试;2、选取训练比例7:3,C=np、linspace(0、0001,1,30)}。

利用交叉验证方法求出C值得最优解。

“SVM支持向量机预测作业”教案讲义

Svc基本原理

如何找到最优的决策边界呢?

Logistic Sigmoid 损失函数

“不适定问题”

Svc基本原理 最优决策边界—泛化能力 1、能将训练样本划分 2、距离这两个类别的最近样本尽可能远

“泛化误差”

Svc基本原理 最优决策边界—泛化能力好 1、能将训练样本划分 2、距离这两个类别的最近样本尽可能远

波士顿房价预测

波士顿房价预测

惩罚系数C

波士顿房价预测

惩罚系数C 深度deep

波士顿房价预测

惩罚系数C gamma

波士顿房价预测

Thank you.

演讲结速,谢谢观赏!

PPT常用编辑图使用方法

1.取消组合

2.填充颜色

3.调整大小

选择您要用到的图标单击右键选择“ 取消组 合”

右键单击您要使用的图标选择“填充 ”,选 择任意 颜色

SVM支持向量机预测作业

(Suitable for teaching courseware and reports)

• SVM的基本原理 • 波士顿房价预测

Svm基本原理

• 支持向量机(Support Vector Machine,SVM) • 分类(Support Vector Classification,SVC)和回归(Support Vector Regression,SVR) • 线性可分(Hard Margin SVM)和非线性可分(Soft Margin SVM)

拖动控制框调整大小

商务

图标元素

商务

图标元素

商务

图标元素

商务in=2d

Svc基本原理

最优决策边界—泛化能力好 1、能将训练样本划分

《支持向量机SVM》课件

多分类SVM

总结词

多类分类支持向量机可以使用不同的核函数和策略来解决多 类分类问题。

详细描述

多类分类支持向量机可以使用不同的核函数和策略来解决多 类分类问题。常用的核函数有线性核、多项式核和RBF核等 。此外,一些集成学习技术也可以与多类分类SVM结合使用 ,以提高分类性能和鲁棒性。

03

SVM的训练与优化

细描述

对于非线性数据,线性不可分SVM通 过引入核函数来解决分类问题。核函 数可以将数据映射到更高维空间,使 得数据在更高维空间中线性可分。常 用的核函数有线性核、多项式核和径 向基函数(RBF)。

通过调整惩罚参数C和核函数参数, 可以控制模型的复杂度和过拟合程度 。

详细描述

多分类支持向量机可以通过两种策略进行扩展:一对一(OAO)和一对多(OAA)。 在OAO策略中,对于n个类别的多分类问题,需要构建n(n-1)/2个二分类器,每个二分 类器处理两个类别的分类问题。在OAA策略中,对于n个类别的多分类问题,需要构建

n个二分类器,每个二分类器处理一个类别与剩余类别之间的分类问题。

鲁棒性高

SVM对噪声和异常值具有 一定的鲁棒性,这使得它 在许多实际应用中表现良 好。

SVM的缺点

计算复杂度高

对于大规模数据集,SVM的训练时间可能会很长,因为其需要解决一 个二次规划问题。

对参数敏感

SVM的性能对参数的选择非常敏感,例如惩罚因子和核函数参数等, 需要仔细调整。

对非线性问题处理有限

SVM的优点

分类效果好

SVM在许多分类任务中表 现出了优秀的性能,尤其 在处理高维数据和解决非 线性问题上。

对异常值不敏感

SVM在训练过程中会寻找 一个最优超平面,使得该 平面的两侧的类别距离最 大化,这使得SVM对异常 值的影响较小。

支持向量机及相关向量机学习报告

SVM 以及RVM 学习报告一.支持向量机支持向量机是一种机器学习方法,以统计学习理论的VC 维理论和结构风险最小化原则为基础。

所以要首先理解VC 维和结构风险最小化原则这两个概念。

VC 维就是一种含有特殊含义的维数,可以联我们平时熟悉的二维平面,三维空间等等。

这种特殊含义就是,对于一个函数集,能够把一个含有h 个样本的样本集按照所有可能的h 2种形式分开而不能被h +12分开,那么样本的vc 维就是h 。

其中的指示函数的函数值取-1和1或者是0和1。

例如二维平面的线性函数集合,能够把平面上的三个点分成8种形式,这三个点相当于一个样本集的样本数,而不能够将平面上的4个点分成16种形式,而只能是14中形式。

结构风险包括两个方面,一个是经验风险,一个是置信风险。

之所以说是经验风险,是因为实际中学习样本是有限的,即使是根据大数定理,经验风险也是和期望风险有偏差的。

一般是,函数集的vc 维越大,经验风险就越小。

还有置信风险是与推广能力有关的,即是预测未来的的准确性。

函数集的vc 维越大,模型就越复杂,虽然很好地拟合了有限的样本,但是对预测未来的推广能力不强。

支持向量机使结风险最小化的方法是,保持经验风险不变,然后最小化置信风险。

这个的关键是最小化vc 维,那么怎样最小化vc 维对于一个超平面0(1)T w x b w -==,如果它对向量x 按如下方式分类: 则称之为-间隔分类超平面。

还有一个定理阐述了间隔与vc 维h 的关系,用公式可以表示为 这个公式说明,可以通过最大化分类超平面的分类间隔来间接地最小化vc 维h ,使vc 维h 最小。

支持向量机就是基于经验风险不变的基础上最大化分类间隔,从而使vc 维最小。

1,1,T T w b y w b ⎧-≥⎪=⎨--≤⎪⎩22min ,1R h d ⎛⎫⎡⎤≤+ ⎪⎢⎥⎣⎦⎝⎭支持向量机理论中,可分为线性支持向量机,广义线性支持向量机和非线性支持向量机,这三个应该是用来作分类的。

支持向量机实验报告

人工智能课程项目报告姓名: ******班级:**************目录一、实验背景 (1)二、实验目的 (1)三、实验原理 (1)3.1线性可分: (1)3.2线性不可分: (4)3.3坐标上升法: (7)3.4 SMO算法: (8)四、实验内容 (10)五、实验结果与分析 (12)5.1 实验环境与工具 (12)5.2 实验数据集与参数设置 (12)5.3 评估标准 (13)5.4 实验结果与分析 (13)一、实验背景本学期学习了高级人工智能课程,对人工智能的各方面知识有了新的认识和了解。

为了更好的深入学习人工智能的相关知识,决定以数据挖掘与机器学习的基础算法为研究对象,进行算法的研究与实现。

在数据挖掘的各种算法中,有一种分类算法的分类效果,在大多数情况下都非常的好,它就是支持向量机(SVM)算法。

这种算法的理论基础强,有着严格的推导论证,是研究和学习数据挖掘算法的很好的切入点。

二、实验目的对SVM算法进行研究与实现,掌握理论推导过程,培养严谨治学的科研态度。

三、实验原理支持向量机基本上是最好的有监督学习算法。

SVM由Vapnik首先提出(Boser,Guyon and Vapnik,1992;Cortes and Vapnik,1995;Vapnik, 1995,1998)。

它的主要思想是建立一个超平面作为决策曲面,使得正例和反例之间的隔离边缘被最大化。

SVM的优点:1.通用性(能够在各种函数集中构造函数)2.鲁棒性(不需要微调)3.有效性(在解决实际问题中属于最好的方法之一)4.计算简单(方法的实现只需要利用简单的优化技术)5.理论上完善(基于VC推广理论的框架)3.1线性可分:首先讨论线性可分的情况,线性不可分可以通过数学的手段变成近似线性可分。

基本模型:这里的裕量是几何间隔。

我们的目标是最大化几何间隔,但是看过一些关于SVM的论文的人一定记得什么优化的目标是要最小化||w||这样的说法,这是怎么回事呢?原因来自于对间隔和几何间隔的定义(数学基础):间隔:δ=y(wx+b)=|g(x)|几何间隔:||w||叫做向量w的范数,范数是对向量长度的一种度量。

支持向量机课件学习教案

1 w

min 1 w 2 (1) w,b 2

s.t. yi ((w xi ) b) 1,i 1,, n

第9页/共30页

第九页,共30页。

线性可分的支持(zhīchí)向量(分类

为求解问题(wèntí)(1),使用Lagrange乘子法将其转化为对偶问题(wèntí)。于是引入Lagrange函数:

所谓支持向量机,顾名思义,分为两个部分了解: 一,什么是支持向量(简单(jiǎndān)来说,就是支持或支撑平面上把两类类别划

分开来的超平面的向量点) 二,这里的“机(machine,机器)”便是一个算法。在机器学习领域,常把一

些算法看做是一个机器,如分类机(当然,也叫做分类器),而支持向量机本 身便是一种监督式学习的方法,它广泛的应用于统计分类以及回归分析中。

)机

L(w,b, )

1 2

w2

n

i ( yi ((w xi ) b) 1)

i 1

(2)

其中(qízh ōng) ,

称 为Lagr ange 乘子。

首先求Lagrange函数关于w,b的极小值。由极值条件有:

(1, 2 ,, n )T Rn

bL(w,b, ) 0, wL(w,b, ) 0

例子

a x12+b x22=1

(lìzi)

[w]1 z1+ [w]2z2 + [w]3 z3+ b =0

第16页/共30页

第十六页,共30页。

非线性分类(fēn lèi)

设训练集 T {(xi , yi ), i 1, l} ,其中 xi ([xi ]1,[xi ]2 )T , yi {1, 1} 假定可以用 ([x]1,[x]2 ) 平面上的二次曲线来划分:

python支持向量机实验

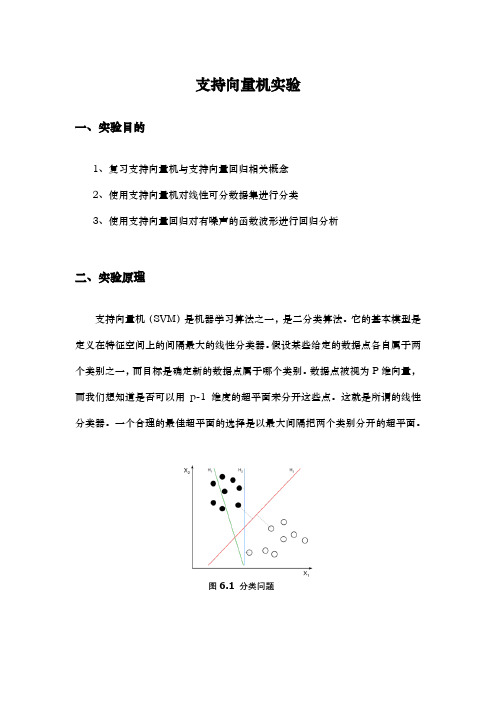

支持向量机实验一、实验目的1、复习支持向量机与支持向量回归相关概念2、使用支持向量机对线性可分数据集进行分类3、使用支持向量回归对有噪声的函数波形进行回归分析二、实验原理支持向量机(SVM)是机器学习算法之一,是二分类算法。

它的基本模型是定义在特征空间上的间隔最大的线性分类器。

假设某些给定的数据点各自属于两个类别之一,而目标是确定新的数据点属于哪个类别。

数据点被视为P维向量,而我们想知道是否可以用p-1维度的超平面来分开这些点。

这就是所谓的线性分类器。

一个合理的最佳超平面的选择是以最大间隔把两个类别分开的超平面。

图6.1 分类问题支持向量机的学习策略就是间隔最大化,可形式化为一个求解凸二次规划(convex quadratic programming)的问题,也等价于正则化的损失函数的最小化问题,从理论上说,训练得到的是全局最优解,支持向量机的学习算法是求解凸二次规划的最优化算法。

支持向量机学习方法包含构建由简至繁的模型:线性可分支持向量机(linear support vector machine in linearly separable case)、线性支持向量机(linear support vector machine)以及非线性支持向量机(non-linear support vector machine)。

简单模型是复杂模型的基础,也是复杂模型的特殊情况。

当训练数据线性可分时,通过硬间隔最大化(hard margin maximization),学习一个线性的分类器,即线性可分支持向量机,又称为硬间隔支持向量机;当训练数据近似线性可分时,通过软间隔最大化(soft margin maximization),也学习一个线性的分类器,即线性支持向量机,又称为软间隔支持向量机;当训练数据线性不可分时,通过使用核技巧(kernel trick)及软间隔最大化,学习非线性支持向量机。

给定一组训练样本集,如图,样本数据集是二维的,分散在平面上,需要找到一条直线将数据集分割开。

支持向量机原理与实验

支持向量机原理与实验支持向量机分类问题支持向量机是基于统计的学习理论和结构风险最小化)(SRM 原则的机器学习。

而)(SRM 原则是针对二值分类问题(两类的分类问题)提出的,因此,关于SVM 的基本问题是二值分类问题。

设有两类模式1C 和2C ,()()(){}N 21y ,y ,y ,N 21X X X T =是从模式1C 和2C 中抽样得到的训练集,其中M n R X ∈、{}1- ,1∈n y 。

若n X 属于1C 类,则对应有1=n y ;若n X 属于2C 类,则对应有1-=n y ;。

寻求M R 上的一个实函数()X g ,对于任给的未知模式,有⎩⎨⎧∈>∈>21C X 0X g C X 0X g ,)(,)( 或者 {}{}⎩⎨⎧∈-=∈=21C X 1X g C X 1X g ,)(sgn ,)(sgn式中()sgn 为符号函数,()X g 称为决策(分类)函数。

我们称解决上述问题的方法为“分类机”。

当()X g 为线性函数时,称为线性分类机;当()X g 为非线性函数时,称为非线性分类机。

对于这个二维问题,线性分类机的作用就是要在1C 和2C 之间寻找一条分类线l ,其表达式为()X g 。

我们已经熟知,在高维情况下()X g 是一个超平面。

对于线性可分的两类模式1C 和2C 而言,能够准确将其分开的直线不是唯一的。

假设有直线l 可以无误地将1C 和2C 两类模式分开,另有直线1l 和直线2l 与l 之间的间距为k , 1l 与2l 之间形成一个没有学习样本的带状区域,不妨称该带状区域为“边带)arg (in M ”,而l 是边带的中分线。

显然,最合理的分类线应该具有最宽的边带。

假设,已知分类线l 的法线矢量为0W ,则分类线的表达式为:0b X W X g 00=+⋅=)()(式中)(⋅表示矢量点积。

显然, ()X g 到原点距离为W b 。

对于给定的所有N 个学习样本(){}m1i i y X ,,()X g 应满足:()()2i i i 1i i i C X 1y 0X g C X 1y 0X g ∈-=<∈=> , ,或写成(){}(){}2i i i 1i i i C X 1X g y C X 1X g y ∈-==∈==sgn sgn直线1l 和直线2l 与分类线l 之间的间隔距离为k ,则这两条边界线的表达式分别为:kb X W l kb X W l 00200l -=+⋅=+⋅)(:)(:直线1l 和直线2l 之间的间距为k ⋅2,寻找最大带宽的问题,转化为在保证所有学习样本满足条件的前提下,寻找()g 使k 达到最大的问题了。

支持向量机PPT课件

给出。由 minw,b Φ(w,b;α) 得

ə Φ/ ə b=0 ⇒ ∑n i=1 αiyi=0 ə Φ/ ə w =0 ⇒ w=∑n i=1 αiyixi

.

16

于是得到对偶问题

这是一个二次规划 (QP) 问题

i的全局最大值总可以求得 W的计算

支持向量机

.

1

内容提要

§1 引言 §2 统计学习理论 §3 线性支持向量机 §4 非线性支持向量机 §5 支持向量回归 §6 支持向量聚类

.

2

§1 引言

一. SVM (Support Vector Machine)的历史

神经网络分类器,Bayes分类器等是基于大样本学习

的分类器。

Vapnik 等从1960年开始关于统计学习理论的研究。统 计学习理论是关于小样本的机器学习理论。

i ∊ {土1}

对于 (2-类) 分类, 建立一个函数:

f:Rn1 : 表示函数的参数

第1类

使得 f 能正确地分类未学习过的样本

.

第2类

6

二.期望风险与实验风险

期望风险最小化

Rf1 2yfxdP x,y

其中 x, y的联合概率 P(x, y) 是未知的

实验风险最小化

实验风险是由在训练集上测得的平均误差所确定的

.

40

软件

关于 SVM 的实现可以在下列网址找到 /software.html

SVMLight 是最早的 SVM 软件之一 SVM 的各种 Matlab toolbox 也是可利用的 LIBSVM 可以进行多类别分类 CSVM 用于SVM分类 rSVM 用于SVM回归 mySVM 用于SVM分类与回归 M-SVM 用于SVM多类别分类

支持向量机原理教学提纲

2.2拉格朗日对偶之等式约束

问题:

目标函数是f(w),通常解法是引入拉格朗日算子,这 里使用来表示β算子,得到拉格朗日公式为 :

L是等式约束的个数。然后分别对w和β求偏导,使得 偏导数等于0,然后解出w和β。

2.2拉格朗日对偶之不等式约束

问题:

利用拉格朗日公式变换:

的

最小值只与w和b有关。对w和b分别求偏导数。

2.3 最大间隔分类器

得到: 代入后,结果如下:

由于最后一项是0,因此简化为

2.3 最大间隔分类器

此时的拉格朗日函数只包含了变量。然而我们求出了 才能得到w和b。

接着是极大化的过程

2.3 最大间隔分类器

前面提到过对偶问题和原问题满足的几个条件,首先

支持向量机

2014-2-21

本讲主要内容

一. 支持向量机 二. 最大间隔分类器 三. 核函数 四.软间隔优化 五.支持向量机总结

一. SVM— warming up

1.1 SVM概念简介 1.2 超平面 1.3 logistic回归 1.4 形式化表示 1.5 函数间隔与几何间隔

1.2 超平面

超平面H是从n维空间到n-1维空间的一 个映射子空间。

设d是n维欧式空间R中的一个非零向量, a是实数,则R中满足条件dX=a的点X所 组成的集合称为R中的一张超平面。

1.3 logistic回归

Logistic 回归目的是从特征学习出一个 0/1 分类模型,而这个模型是将特性的线 性组合作为自变量,由于自变量的取值 范围是负无穷到正无穷。因此,使用 logistic 函数(或称作 sigmoid 函数)将 自变量映射到(0,1)上,映射后的值被认 为是属于 y=1 的概率。

机器学习基础篇:支持向量机(SVM)理论与实践

机器学习基础篇:支持向量机(SVM)理论与实践您想知道的人工智能干货,第一时间送达编译 | AI有道什么是支持向量机(SVM)?支持向量机(SVM) 是一种相对简单的监督机器学习算法,用于解决分类或回归问题。

它更适合分类,但有时对回归也非常有用。

SVM 算法的本质是在不同的数据类型之间找到一个超平面来创建边界。

在二维空间中,这个超平面是一条直线。

在SVM算法中,我们在N 维空间中绘制数据集中的每个数据项,其中 N 是数据中特征/属性的数量。

接下来,我们找到最佳的超平面来对不同类型的数据进行分类。

因此我们可以了解到SVM 本质上只能解决二分类的问题(即,在两个类之间进行选择)。

但是,如今有多种技术可用于解决多分类的问题。

支持向量机(SVM)解决多分类问题为了在多分类问题上使用SVM,我们可以为每一类数据创建一个二元分类器。

每个分类器的两个结果将是:•数据点属于该类或•数据点不属于该类或例如,在水果分类问题中,要进行多类分类,我们可以为每个水果创建一个二元分类器。

例如,“芒果”类,将有一个二元分类器来预测它是芒果还是不是芒果。

选择得分最高的分类器作为 SVM 的输出。

复杂的 SVM(非线性可分)SVM对线性可分数据进行分类有比较好的表现。

线性可分数据是任何可以绘制在图形中并且可以使用直线进行分类的数据。

我们使用带内核的SVM 来处理非线性可分的数据。

比如说,我们把一维非线性可分的数据可以转换为二维数据,该数据将将在二维上线性可分。

这是通过将每个一维数据点映射到相应的二维有序对来完成的。

因此,对于任何维度的任何非线性可分数据,我们可以将数据映射到更高的维度,然后使其变得线性可分。

这是一个非常强大和普遍的转变。

内核不是数据点之间相似性的度量。

核化 SVM 中的核函数告诉您,给定原始特征空间中的两个数据点,新变换的特征空间中的点之间的相似度是多少。

现有各种可用的内核函数,其中两个比较流行:Radial BasisFunction Kernel (RBF):变换后的特征空间中两点之间的相似度是向量与原始输入空间之间距离的指数衰减函数,如下所示。

支持向量机(SVM)的实现

模式识别课程大作业报告—-支持向量机(SVM)的实现姓名:学号:专业:任课教师:研究生导师:内容摘要支持向量机是一种十分经典的分类方法,它不仅是模式识别学科中的重要内容,而且在图像处理领域中得到了广泛应用。

现在,很多图像检索、图像分类算法的实现都以支持向量机为基础.本次大作业的内容以开源计算机视觉库OpenCV为基础,编程实现支持向量机分类器,并对标准数据集进行测试,分别计算出训练样本的识别率和测试样本的识别率。

本报告的组织结构主要分为3大部分。

第一部分简述了支持向量机的原理;第二部分介绍了如何利用OpenCV来实现支持向量机分类器;第三部分给出在标准数据集上的测试结果.一、支持向量机原理概述在高维空间中的分类问题实际上是寻找一个超平面,将两类样本分开,这个超平面就叫做分类面.两类样本中离分类面最近的样本到分类面的距离称为分类间隔。

最优超平面指的是分类间隔最大的超平面。

支持向量机实质上提供了一种利用最优超平面进行分类的方法.由最优分类面可以确定两个与其平行的边界超平面。

通过拉格朗日法求解最优分类面,最终可以得出结论:实际决定最优分类面位置的只是那些离分类面最近的样本。

这些样本就被称为支持向量,它们可能只是训练样本中很少的一部分。

支持向量如图1所示。

图1图1中,H是最优分类面,H1和H2别是两个边界超平面。

实心样本就是支持向量。

由于最优超平面完全是由这些支持向量决定的,所以这种方法被称作支持向量机(SVM).以上是线性可分的情况,对于线性不可分问题,可以在错分样本上增加一个惩罚因子来干预最优分类面的确定。

这样一来,最优分类面不仅由离分类面最近的样本决定,还要由错分的样本决定。

这种情况下的支持向量就由两部分组成:一部分是边界支持向量;另一部分是错分支持向量。

对于非线性的分类问题,可以通过特征变换将非线性问题转化为新空间中的线性问题。

但是这样做的代价是会造成样本维数增加,进而导致计算量急剧增加,这就是所谓的“维度灾难".为了避免高维空间中的计算,可以引入核函数的概念。

支持向量机算法应用实验目的及内容

支持向量机算法应用实验目的及内容

本实验旨在通过使用支持向量机算法,掌握其基本原理和应用方法,实现对分类和回归问题的解决。

具体内容包括:

1. 学习支持向量机算法的基本原理和优化方法;

2. 理解支持向量机算法在分类和回归问题中的应用;

3. 使用Python编程语言实现支持向量机算法,包括线性和非线性支持向量机;

4. 利用UCI数据集进行分类和回归实验,并通过可视化方式展示实验结果;

5. 分析实验结果,比较不同参数对实验效果的影响,探讨支持向量机算法在实际应用中的优缺点。

- 1 -。

实验四-支持向量机教学文案

实验四-支持向量机实验四:支持向量机班级姓名学号指导老师一.实验目的1.了解基有关支持向量机的基本原理2.能够使用支持向量机的代码解决分类与回归问题3.了解图像分类的基本原理二、实验的硬件、软件平台硬件:计算机软件:操作系统win10应用软件:Java三、实验原理四、1. LIBSVM 使用方法简介五、LibSVM是以源代码和可执行文件两种方式给出的。

如果是Windows系列操作系统,可以直接使用软件包提供的程序,也可以进行修改编译;如果是Unix类系统,必须自己编译。

六、LIBSVM 在给出源代码的同时还提供了Windows操作系统下的可执行文件,包括:进行支持向量机训练的svmtrain.exe;根据已获得的支持向量机模型对数据集进行预测的svmpredict.exe;以及对训练数据与测试数据进行简单缩放操作的svmscale.exe。

它们都可以直接在DOS 环境中使用。

如果下载的包中只有C++的源代码,则也可以自己在VC等软件上编译生成可执行文件。

七、八、2. LIBSVM 使用的一般步骤是:九、1)按照LIBSVM软件包所要求的格式准备数据集;十、2)对数据进行简单的缩放操作;十一、3)考虑选用RBF 核函数;十二、4)采用交叉验证选择最佳参数C与g ;十三、5)采用最佳参数C与g 对整个训练集进行训练获取支持向量机模型;十四、6)利用获取的模型进行测试与预测。

十五、十六、3. LIBSVM使用的数据格式十七、1)训练数据和检验数据文件格式如下:十八、<label> <index1>:<value1> <index2>:<value2> ...十九、其中<label> 是训练数据集的目标值,对于分类,它是标识某类的整数(支持多个类);对于回归,是任意实数。

<index> 是以1开始的整数,可以是不连续的;<value>为实数,也就是我们常说的自变量。

完美排版--基于Python实现的支持向量机课程设计

支持向量机(SVM)课程设计(基于Python实现)说明:本文档适用于一般本科和高年级专科本文档仅供学习者学习SVM参考,不建议直接用来交作业,否则失去了知识传播的意义。

目录使用python实现支持向量机(svm)实验手册 (3)1. 实验任务 (3)2. 背景知识 (3)1) 支持向量机(svm)原理 (3)2) 间隔最大化 (3)3) SMO算法 (3)4) SMO算法实现流程图: (4)3. 编程要求 (4)4. 解题思路 (4)1) 导入实现算法的包 (4)2) 读取文件数据函数实现 (4)3) 随机选择变量alpha函数实现 (5)4) 处理边界L,H的值的函数实现 (5)5) 简化版SMO算法实现 (6)6) 分类结果可视化函数实现 (9)7) 计算w的函数实现 (10)8) 主函数的实现 (11)5. 实验结果 (11)6. 讨论与分析 (11)使用python实现支持向量机(svm)实验手册1.实验任务1)理解支持向量机(svm)原理2)使用python自定义实现支持向量机(svm)2.背景知识1)支持向量机(svm)原理支持向量机(support vector machines)是一种二分类模型,它的目的是寻找一个超平面来对样本进行分割,分割的原则是间隔最大化,最终转化为一个凸二次规划问题来求解。

由简至繁的模型包括:当训练样本线性可分时,通过硬间隔最大化,学习一个线性可分支持向量机;当训练样本近似线性可分时,通过软间隔最大化,学习一个线性支持向量机;当训练样本线性不可分时,通过核技巧和软间隔最大化,学习一个非线性支持向量机;2)间隔最大化如果一个线性函数能够将样本分开,称这些数据样本是线性可分的。

那么什么是线性函数呢?其实很简单,在二维空间中就是一条直线,在三维空间中就是一个平面,以此类推,如果不考虑空间维数,这样的线性函数统称为超平面。

我们看一个简单的二维空间的例子,O代表正类,X代表负类,样本是线性可分的,但是很显然不只有这一条直线可以将样本分开,而是有无数条,我们所说的线性可分支持向量机就对应着能将数据正确划分并且间隔最大的直线。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验四-支持向量机

实验四:支持向量机

班级姓名学号指导老师

一.实验目的

1.了解基有关支持向量机的基本原理

2.能够使用支持向量机的代码解决分类与回归问题

3.了解图像分类的基本原理

二、实验的硬件、软件平台

硬件:计算机

软件:操作系统win10

应用软件:Java

三、实验原理

四、1. LIBSVM 使用方法简介

五、LibSVM是以源代码和可执行文件两种方式给出的。

如果是Windows系列操作系统,可以直接使用软件包提供的程序,也可以进行修改编译;如果是Unix类系统,必须自己编译。

六、LIBSVM 在给出源代码的同时还提供了Windows操作系统下的可执行文件,包括:进行支持向量机训练的svmtrain.exe;根据已获得的支持向量机模型对数据集进行预测的svmpredict.exe;以及对训练数据与测试数据进行简单缩放操作的svmscale.exe。

它们都可以直接在DOS 环境中使用。

如果下载的包中只有C++的源代码,则也可以自己在VC等软件上编译生成可执行文件。

七、

八、2. LIBSVM 使用的一般步骤是:

九、1)按照LIBSVM软件包所要求的格式准备数据集;

十、2)对数据进行简单的缩放操作;

十一、3)考虑选用RBF 核函数;

十二、4)采用交叉验证选择最佳参数C与g ;

十三、5)采用最佳参数C与g 对整个训练集进行训练获取支持向量机模型;

十四、6)利用获取的模型进行测试与预测。

十五、

十六、3. LIBSVM使用的数据格式

十七、1)训练数据和检验数据文件格式如下:

十八、<label> <index1>:<value1> <index2>:<value2> ...

十九、其中<label> 是训练数据集的目标值,对于分类,它是标识某类的整数(支持多个类);对于回归,是任意实数。

<index> 是以1开始的整数,可以是不连续的;<value>为实数,也就是我们常说的自变量。

检验数据文

件中的label只用于计算准确度或误差,如果它是未知的,只需用一个数填写这一栏,也可以空着不填。

二十、在程序包中,还包括有一个训练数据实例:heart_scale,方便参考数据文件格式以及练习使用软件。

可以编写小程序,将自己常用的数据格式转换成这种格式

二十一、

二十二、2)Svmtrain和Svmpredict的用法

二十三、LIBSVM软件提供的各种功能都是DOS命令执行方式。

我们主要用到两个程序,svmtrain(训练建模)和svmpredict(使用已有的模型进行预测),下面分别对这两个程序的使用方法、各参数的意义以及设置方法做一个简单介绍:

二十四、(1)Svmtrain的用法:

二十五、svmtrain [options] training_set_file [ model_file]

二十六、Options:可用的选项即表示的涵义如下

二十七、-s svm类型:SVM设置类型(默认0)

二十八、0 -- C-SVC

二十九、 1 --v-SVC

三十、 2 –一类SVM

三十一、 3 -- e -SVR

三十二、 4 -- v-SVR

三十三、-t 核函数类型:核函数设置类型(默认2)

三十四、0 –线性:u'v

三十五、 1 –多项式:(r*u'v + coef0)^degree

三十六、 2 –RBF函数:exp(-r|u-v|^2)

三十七、 3 –sigmoid:tanh(r*u'v + coef0)

三十八、-d degree:核函数中的degree设置(默认3)

三十九、-g 函数设置(默认1/ k)?r(gama):核函数中的

四十、-r coef0:核函数中的coef0设置(默认0)

四十一、?-c cost:设置C-SVC,-SVR的参数(默认1)?-SVR和

四十二、- SVR的参数(默认0.5)?-SVC,一类SVM和?-n nu:设置

四十三、-SVR?-p e:设置的值(默认0.1)?中损失函数

四十四、-m cachesize:设置cache内存大小,以MB为单位(默认40)

四十五、-e :设置允许的终止判据(默认0.001)?

四十六、-h shrinking:是否使用启发式,0或1(默认1)

四十七、-wi C(C-SVC中的C)(默认1)?weight:设置第几类的参数C为weight

四十八、-v n: n-fold交互检验模式

四十九、其中-g选项中的k是指输入数据中的属性数。

option -v 随机地将数据剖分为n部分并计算交互检验准确度和均方根误差。

以上这些参数设置可以按照SVM的类型和核函数所支持的参数进行任意组合,如果设置的参数在函数或SVM类型中没有也不会产生影响,程序不会接受该参数;如果应有的参数设置不正确,参数将采用默认值。

training_set_file是要进行训练的数据集;model_file是训练结束后产生的模型文件,文件中包括支持向量样本

数、支持向量样本以及lagrange系数等必须的参数;该参数如果不设置将采用默认的文件名,也可以设置成自己惯用的文件名。

五十、(2)Svmpredict的用法:

五十一、

svmpredict test_file model_file output_filemodel_file 是由svmtrain产生的模型文件;test_file是要进行预测的数据文件;Output_file是svmpredict的输出文件。

svm-predict没有其它的选项。

五十二、

四、实验内容及步骤

支持向量机算法训练分类器:

1.训练数据集:见文档“分类数据集.doc”,前150个数据作为训练数据,其他数据作为测试数据,数据中“+1”“-1”分别表示正负样本。

2.使用代码中的C-SVC算法和默认参数来训练“分类数据集.doc”中所有的数据(包括训练数据和测试数据),统计分类查准率。

3.在2的基础上使用k-折交叉验证思想来训练分类器并统计分类查准率。

... ...

4.使用2中的设置在训练数据的基础上学习分类器,将得到的分类器在测试数据上进行分类预测,统计查准率。

5.在4上尝试不同的C值(“-c”参数)来调节分类器的性能并绘制查准率曲线。

6.尝试不同的kernel函数(“-t”参数)来调节分类器的性能并绘制查准率曲线,对每种kernel函数尝试调节其参数值并评估查准率。

支持向量机算法训练回归方程:

(1).回归数据集:见文档“回归数据集.doc”,总共506个数据,数据中前13个属性作为输入,最后一个属性作为输出。

(2).使用代码中的epsilon-SVR算法和默认参数来训练“回归数据

集.doc”中所有的数据,统计回归方程在每个数据点输出的误差并进行误差分析。

(3).在2上尝试不同的epsilon值(“-p”参数)来调节epsilon-SVR 算法的性能。

五、思考题:

1.阐述k-折交叉验证的思想,比较1.2和1.3的性能。

答:k-折交叉验证(k-fold crossValidation)就是在机器学习中,将数据集A分为训练集(training set)B和测试集(test set)C,在样本量不充足的情况下,为了充分利用数据集对算法效果进行测试,将数据集A 随机分为k个包,每次将其中一个包作为测试集,剩下k-1个包作为训练集进行训练。

1.3比1.2的性能好。

2.在1.5中的C值代表的含义是什么?

答:C是惩罚系数,就是说你对误差的宽容度,这个值越高,说明你越不能容忍出现误差。

3.阐述kernel函数的作用和原理,在1.6中通过引入不同的

kernel函数对于算法性能的提升有影响吗?

答:核函数目的:把原坐标系里线性不可分的数据用Kernel投影到另一个空间,尽量使得数据在新的空间里线性可分。

1)核函数的引入避免了“维数灾难”,大大减小了计算量。

而输入空间的维数n对核函数矩阵无影响,因此,核函数方法可以有效处理高维输入。

2)无需知道非线性变换函数Φ的形式和参数.

3)核函数的形式和参数的变化会隐式地改变从输入空间到特征空间的映射,进而对特征空间的性质产生影响,最终改变各种核函数方法的性

能。

4)核函数方法可以和不同的算法相结合,形成多种不同的基于核函数技术的方法,且这两部分的设计可以单独进行,并可以为不同的应用选择不同的核函数和算法。

会产生影响。

4.阐述回归问题和分类问题的不同之处。

答:分类和回归的区别在于输出变量的类型。

回归问题和分类问题的本质一样,不同仅在于他们的输出的取值范围不同。

分类问题中,输出只允许取两个值;而在回归问题中,输出可取任意实数。

六、实验心得

此次实验虽然按部就班做完了。

不过最后还是掌握到有关支持向量机的基本原理,实践了支持向量机的代码解决分类与回归问题。

初步了解了图像分类的基本原理,颇有收获。