深度迁移度量学习

迁移学习在深度学习中的应用

迁移学习在深度学习中的应用深度学习作为一种机器学习的方法,已经在各个领域中取得了巨大的成功。

然而,训练一个强大的深度学习模型通常需要大量的标注数据和计算资源,这在现实世界中并不总是容易实现的。

迁移学习正是为了解决这个问题而发展起来的一种方法。

它允许我们利用一个领域中已经训练好的模型,来辅助解决另一个相关领域的问题。

本文将探讨迁移学习在深度学习中的应用,包括迁移学习的概念、在深度学习中的常见应用场景以及优势和挑战。

首先,我们需要了解什么是迁移学习。

迁移学习是一种机器学习的方法,它通过将已经学到的知识迁移到其他相关任务上,可以加速新任务的学习过程或提高其性能。

传统的机器学习方法通常在完全独立的数据集上训练模型,而迁移学习则允许在相关但不完全相同的任务上共享知识。

这样一来,我们就可以充分利用已经学到的特征和模式,从而在新任务上取得更好的效果。

迁移学习在深度学习中的应用非常广泛,以下是一些常见的应用场景。

首先,迁移学习可以用于解决数据稀缺的问题。

深度学习通常需要大量的标注数据来进行训练,然而在某些领域,标注数据往往非常有限。

通过迁移学习,我们可以利用一个数据量较大且相关的领域的模型来提取特征,然后将这些特征用于目标任务的训练。

这样可以显著减少训练数据的需求,同时还能提高模型的性能。

其次,迁移学习可以用于解决领域间分布差异的问题。

在现实世界中,不同领域的数据往往存在一定的分布差异,这给深度学习带来了挑战。

通过迁移学习,我们可以通过预训练好的模型来学习领域通用的特征表示,然后再通过微调的方式将模型适应到目标领域。

这样可以避免从头开始训练模型的麻烦,并且提高了模型在目标领域上的性能。

此外,迁移学习还可以用于解决多任务学习的问题。

在多任务学习中,我们需要同时训练模型来完成多个相关的任务。

通过迁移学习,我们可以利用已经训练好的模型来共享知识,从而提高多个任务的性能。

这种方式不仅可以减少训练时间和计算资源的需求,还可以通过任务间的相互学习来提高整体性能。

深度学习技术中的模型迁移性问题

深度学习技术中的模型迁移性问题深度学习技术的快速发展使得计算机视觉、自然语言处理等领域取得了显著的进展。

然而,深度学习模型在面对新的领域或任务时往往需要重新训练。

这种情况下,模型迁移性问题变得至关重要。

模型迁移性指的是在一个任务上训练的模型能否有效地迁移到另一个任务上。

本文将探讨深度学习技术中的模型迁移性问题,并介绍一些解决方案。

首先,我们需要了解模型迁移性问题的根本原因。

深度学习模型的迁移性问题主要由两个方面导致:任务域间的差异和数据集的不匹配。

任务域间的差异指的是不同任务之间的特征分布和潜在关系的差异。

数据集的不匹配则指的是训练集和测试集之间的分布差异。

这些差异使得在一个任务上训练的模型无法直接应用到另一个任务上,从而导致性能下降或失效。

为解决模型迁移性问题,研究人员提出了多种方法和技术。

其中一种方法是领域自适应。

领域自适应技术旨在通过学习一个通用的表示,使得模型能够在不同的任务和领域中共享知识。

这种方法的关键在于对抗性训练,通过最小化源领域和目标领域之间的差异来实现模型的迁移。

例如,生成对抗网络(GANs)可以用来生成与目标领域相似的样本,以缓解领域间的差异问题。

另一种解决模型迁移性问题的方法是迁移学习。

迁移学习通过在源任务上学习到的知识来帮助解决目标任务。

迁移学习分为三个主要策略:特征提取、模型调整和参数初始化。

特征提取策略将源任务上学习到的特征应用到目标任务中,以提高模型性能。

模型调整策略则通过微调模型的某些层或添加新的层来适应目标任务。

参数初始化策略则通过使用源任务上的参数作为初始化值来加快目标任务的训练过程。

除了以上提到的方法,还有一些其他技术也可用于解决模型迁移性问题。

例如,多任务学习是一种同时学习多个相关任务的方法,可以提高模型在新任务上的泛化能力。

领域对抗神经网络(DANN)是一种使用领域分类器来推动模型表示在源领域和目标领域之间的混淆,从而缓解模型迁移性问题。

尽管已经有了一些有效的方法用于解决深度学习技术中的模型迁移性问题,但这个问题仍然具有挑战性。

深度学习模型的迁移学习方法和技巧总结

深度学习模型的迁移学习方法和技巧总结在当前数据爆炸和计算能力的迅速发展下,深度学习已成为解决各类复杂问题的重要工具。

然而,深度学习模型的训练通常需要大量的数据和计算资源,因此,针对特定任务进行训练可能存在数据不足和计算复杂度高的问题。

这时,迁移学习(Transfer Learning)作为一种有效的方法和技巧,可以帮助解决这些问题。

迁移学习是利用已经训练过的模型或特征表示,将其迁移到新的任务上,从而提高新任务的性能。

下面将总结一些常见的深度学习模型的迁移学习方法和技巧。

1. 基于预训练模型的微调(Fine-tuning):这是迁移学习中最常见的方法之一。

首先,选择一个在大规模数据集上训练过的深度学习模型,如ImageNet数据集上的VGGNet、ResNet 或Inception等。

然后,将该模型的权重参数加载到新的任务中,并根据新任务的数据集进行微调,只更新部分网络层的参数。

通过这种方式,可以利用预训练模型所学习到的通用特征来提取新任务中的有效特征。

2. 特征提取与微调结合:除了简单的微调外,还可以通过在预训练模型上进行特征提取,并将提取到的特征作为输入,加上一些新的全连接层或其他分类器来训练新的任务。

这样可以更好地利用预训练模型所学到的特征,避免对整个模型进行微调时可能出现的梯度消失或梯度爆炸等问题。

3. 多任务学习(Multi-task Learning):在多个相关任务上共享一个深度学习模型,可以显著提高单个任务的性能。

通过将不同任务的数据集和标签进行整合,可以使模型学习到更加具有泛化能力的特征表示。

这种方法尤其适用于数据集较小的情况下,可以通过相互之间的信息共享来增强模型的表现。

4. 领域自适应(Domain Adaptation):当源域和目标域的数据分布不同的时候,传统的迁移学习方法可能会出现较大的性能差异。

为了解决这个问题,可以通过领域自适应方法来调整模型,使其在目标域上更好地适应。

深度学习模型的迁移学习技巧

深度学习模型的迁移学习技巧迁移学习是机器学习领域中一种重要的技巧,尤其在深度学习任务中具有广泛的应用。

它通过将已经训练好的模型的知识迁移到新的任务上,从而提高新任务的性能。

迁移学习不仅可以加快新模型的训练速度,还可以解决数据稀缺问题,改善模型的泛化能力。

本文将介绍一些深度学习模型的迁移学习技巧,帮助读者在实践中提高模型的性能。

一、迁移学习的概念与原理迁移学习是基于假设,即源领域和目标领域之间存在一些类别和特征的共享或相关性。

通过将源领域中的知识迁移到目标领域中,可以帮助目标领域的学习过程。

迁移学习主要分为两种类型:基于特征的迁移学习和基于模型的迁移学习。

基于特征的迁移学习将源领域的特征转移到目标领域,然后使用目标领域的标记数据训练模型。

基于模型的迁移学习则将源领域的模型直接应用于目标领域。

具体的迁移学习方法包括特征提取、领域自适应和多任务学习等。

二、特征提取特征提取是最常用的迁移学习方法之一。

现有的深度学习模型在底层已经学习到了一些通用的特征,这些特征具有很强的泛化能力。

我们可以将这些特征提取出来,并作为新模型的输入,从而加快新模型的训练速度和提高性能。

在进行特征提取时,我们通常可以使用已经训练好的模型,如VGG16、ResNet等。

这些模型可以直接下载并加载到我们的程序中。

然后,我们可以冻结模型的卷积层,只训练上层的全连接层或其他特定的层。

这样可以避免过拟合,并且可以利用底层模型学习到的特征。

通过这种方式,我们可以很容易地将深度学习模型迁移到新的任务中。

三、领域自适应领域自适应是一种解决源领域和目标领域分布不一致的迁移学习方法。

这种情况下,直接应用源领域的模型可能会导致性能下降。

领域自适应的目标是通过对源领域和目标领域进行适应性调整,使得模型在目标领域上表现更好。

领域自适应的方法有很多种,例如对抗训练和领域间相似性最大化。

对抗训练通过最小化源领域和目标领域之间的分布差异,来提高模型在目标领域上的性能。

迁移学习问题与方法研究共3篇

迁移学习问题与方法研究共3篇迁移学习问题与方法研究1迁移学习问题与方法研究近年来,人工智能领域发展迅速,深度学习技术被广泛应用于各个领域中,而迁移学习作为深度学习的一个分支,也受到了越来越多的关注。

迁移学习是指在源域上学习到的知识和技能迁移到目标域中,以加速学习过程、提升精度和泛化能力的一种机器学习技术。

因此,迁移学习技术已经成为了人工智能领域研究的热点之一,并且在更多实际应用任务中发挥着重要作用。

迁移学习中存在的问题在迁移学习中,由于源域和目标域之间存在差异,可能会出现一些问题。

这些问题主要包括以下几点:1. 分布偏移问题分布偏移是指源域和目标域之间在概率分布上存在差异或偏差,导致训练出的模型在目标域上的性能不佳。

该问题一般会导致训练出的模型的泛化能力不足,即不能很好的适应目标域的数据。

2. 语义差异问题源域和目标域之间可能存在语义差异,这种差异可能表现为两个域之间的数据类型的不同,或者是数据中的语义信息的不同。

例如,在人脸识别任务中,源域的数据可能来自于不同角度、不同表情的人脸图片,而目标域的数据可能只来自于某一种专门的角度或表情的人脸图片。

这种语义上的差异也会导致模型在目标域上的性能下降。

3. 迁移学习应用场景问题在迁移学习中,不适合所有的应用场景,例如涉及隐私数据的场景,由于各种原因,企业不愿意将数据暴露在外,而是将数据集合用全量数据方式发布。

迁移学习的方法为了解决上述问题,迁移学习中提出了一系列的方法。

1. 领域自适应方法领域自适应方法是迁移学习中比较常见的一种方法。

该方法通过训练源域和目标域数据的深度神经网络,从而使得特征空间在两个领域之间对齐,从而消除了分布偏移问题。

2. 深度度量学习方法深度度量学习方法是一种能够解决语义差异问题的方法。

该方法通过深度神经网络对目标域和源域之间的差异进行建模,并尝试找到两个域之间的映射关系。

这种方法不仅能够减少错误率,而且能够增强模型的泛化能力。

3. 对抗迁移学习方法对抗迁移学习方法是一种能够缓解数据隐私问题的方法。

深度学习中的迁移学习如何将已训练好的模型应用于新任务

深度学习中的迁移学习如何将已训练好的模型应用于新任务深度学习是一种基于神经网络的人工智能技术,它已经被广泛应用于图像识别、自然语言处理和语音识别等领域。

然而,深度学习所需要的数据量和计算资源很大,因此在实际应用中,往往需要一些技巧来提高模型的性能。

其中一种常用的技巧就是迁移学习,它可以将已经训练好的模型应用于新的任务,从而加速训练过程并提高模型的性能。

一、迁移学习的定义和分类迁移学习通常被定义为,利用已经学习到的知识来解决新问题的一种机器学习技术。

它可以将一个领域中已经训练好的模型应用于另一个领域中的问题,从而加速训练过程并提高模型的性能。

根据迁移学习的来源,它可以分为以下几类:1. 基于相同领域的迁移学习当新的任务和原来的任务在同一个领域中时,我们可以通过微调(fine-tuning)的方式来进行迁移学习。

微调是指,将已经训练好的模型的一部分或全部参数保持不变,只对新的任务进行调整。

2. 基于相似领域的迁移学习当新的任务和原来的任务在相似的领域中时,我们可以通过共享层(shared layers)的方式来进行迁移学习。

共享层是指,将已经训练好的模型的一部分层迁移到新的任务中,并在此基础上继续训练。

3. 基于不同领域的迁移学习当新的任务和原来的任务在不同的领域中时,我们可以通过预训练(pre-training)的方式来进行迁移学习。

预训练是指,在原来的任务中进行无监督学习,学习到数据的一些通用特征,然后将这些特征应用于新的任务中进行训练。

二、深度学习中的迁移学习应用深度学习中的迁移学习已经被广泛应用于各个领域。

下面列举几个实际应用的例子:1. 图像识别在图像识别任务中,基于相同领域的迁移学习是最常用的方法。

例如,我们可以将在大规模图像数据集上预训练的卷积神经网络模型应用于新的图像识别任务中。

这样可以节省训练时间并提高模型的准确率。

2. 自然语言处理在自然语言处理任务中,基于相似领域的迁移学习是比较常用的方法。

深度学习的迁移学习与增强学习

深度学习的迁移学习与增强学习深度学习是人工智能领域中一种备受关注的技术,它利用人工神经网络模拟人脑的学习过程,以从大规模数据中学习复杂的模式和关系。

而迁移学习和增强学习则是深度学习领域中的两个重要分支,它们是在不同的应用场景下对深度学习算法进行有效改进和优化的方法。

本文将重点讨论深度学习的迁移学习与增强学习及其在实际应用中的价值和挑战。

迁移学习是指在一个领域训练好的模型可以迁移到另一个相关领域并进行调整,以提高模型在目标领域的性能。

这种方式可以减少在新领域收集大量数据和重新训练模型的成本,同时还能够充分利用在源领域学到的知识和经验。

迁移学习在许多实际应用中都得到了广泛的应用,例如在图像识别、自然语言处理和推荐系统等领域。

通过迁移学习,我们可以将在一个领域中具有丰富经验和知识的模型应用到另一个领域,并取得更好的效果。

对于深度学习来说,迁移学习也是一种非常有效的方法。

深度学习模型通常需要大量的数据进行训练,但在实际应用中往往很难获得足够的数据。

通过迁移学习,我们可以利用在一个领域中训练好的深度学习模型,通过微调或调整参数的方式,在另一个领域中取得更好的效果。

这种方法不仅可以提高模型的泛化能力,还可以减少训练时间和成本,提高模型的效率和性能。

在深度学习的迁移学习中,一个核心问题是如何选择源领域和目标领域,以及如何设计有效的迁移学习策略。

源领域和目标领域之间的差异性越大,迁移学习的难度就越大。

因此,我们需要根据不同的应用场景和需求来选择合适的源领域和目标领域,并设计合理的迁移学习策略。

此外,还需要考虑模型的迁移能力和稳定性,以及如何在迁移学习过程中避免过拟合和数据泄露等问题。

增强学习是另一种重要的深度学习方法,它通过与环境交互来学习最优策略,以最大化长期奖励。

增强学习在许多领域中都有着广泛的应用,例如在机器人控制、游戏玩法和金融交易等领域。

通过增强学习,我们可以训练出自主学习和自适应的智能系统,使其具备更强的决策能力和适应能力。

深度学习模型的迁移学习教程与实践方法

深度学习模型的迁移学习教程与实践方法深度学习模型的迁移学习是一种通过利用已经在一个任务上训练好的模型,在不同的任务上进行重新训练和推断的方法。

它是目前在机器学习领域非常流行的研究方向之一,因为它能够大大减少重新训练模型所需的时间和资源,并且在训练数据稀缺的情况下仍能取得很好的效果。

在本文中,我们将介绍深度学习模型的迁移学习的基本概念、原理以及实践方法,并给出几个常见的迁移学习应用示例。

一、迁移学习的基本概念与原理迁移学习的基本思想是将在一个任务上学习到的知识迁移到另一个任务中。

这种迁移可以是基于特征的,也可以是基于模型的。

基于特征的迁移学习是指将预训练好的模型的中间层的特征表示作为新任务的输入,并在此基础上进行进一步的训练。

这样做的好处是可以避免从头训练整个模型,节省了时间和计算资源。

例如,在图像分类任务中,我们可以利用在大规模图像数据集上预训练好的卷积神经网络模型的特征表示,然后将这些特征输入到一个新的全连接网络中进行分类。

基于模型的迁移学习是指将预训练好的模型作为新任务的初始模型,并在此基础上进行微调。

微调是指在新任务的训练过程中,冻结模型的前几层(即保持其权重不变),只对后面几层进行训练。

这样做的好处是可以在保留预训练模型的知识的同时,加快对新任务的适应。

例如,在自然语言处理任务中,我们可以利用在大规模文本语料上预训练的语言模型作为初始模型,并在此基础上进行微调,以适应特定的文本分类任务。

二、迁移学习的实践方法在进行迁移学习之前,我们需要选择一个合适的预训练模型作为基础。

通常情况下,我们可以选择在大规模数据集上预训练好的模型,如ImageNet上的卷积神经网络模型或GPT模型。

这些预训练模型可以用于多种不同的任务。

在选择了预训练模型之后,我们需要根据新任务的特点来确定迁移学习的具体策略。

一般来说,我们可以选择进行特征提取、微调或联合训练。

特征提取是指将预训练模型的中间层的特征表示作为新任务的输入,并在此基础上训练一个新的分类器。

深度度量学习方法在迁移学习中的应用研究

深度度量学习方法在迁移学习中的应用研究引言随着深度学习在各个领域应用的广泛发展,迁移学习作为一种有效的学习方法受到了越来越多的关注。

传统的迁移学习方法通常是依靠手工设计的特征工程或简单的机器学习算法来进行知识的迁移,但这些方法往往面临着特征表达的限制和任务相关性的约束。

为了解决这些问题,研究者们引入了深度度量学习方法来进行迁移学习,从而实现更好的知识迁移效果。

本文将探讨深度度量学习方法在迁移学习中的应用研究,并介绍相关的理论模型和实验结果。

一、深度度量学习方法概述深度度量学习是一种通过深度神经网络学习数据的相似性或距离度量的方法。

其主要思想是通过学习一个映射函数,将输入数据映射到一个低维的特征空间,使得在这个特征空间中相似的样本距离更近,不相似的样本距离更远。

深度度量学习方法可以有效地提取数据的高层抽象特征,从而在许多任务上取得了显著的性能提升。

二、深度度量学习方法在迁移学习中的应用深度度量学习方法在迁移学习中的应用主要包括两个方面:一个是利用深度度量学习来进行源领域和目标领域之间的特征迁移,另一个是利用深度度量学习来进行领域间的样本迁移。

1. 特征迁移特征迁移是指通过将源领域的特征映射到目标领域的特征空间中,来实现源领域和目标领域之间的知识迁移。

传统的特征迁移方法通常是通过手工设计特征或使用简单的特征选择算法来进行。

然而,这些方法往往面临着特征表达的限制和任务相关性的约束。

深度度量学习方法可以通过学习一个共享的特征空间来实现更好的特征迁移效果。

例如,Siamese网络是一种常用的深度度量学习方法,它可以通过学习样本对之间的相似性来度量它们在特征空间中的距离。

这种方法可以将源领域和目标领域之间的特征进行映射,并通过比较它们的距离来进行知识的迁移。

2. 样本迁移样本迁移是指通过在源领域中学习一个深度度量模型,然后将其迁移到目标领域中,从而实现目标领域的样本分类。

这种方法可以有效地利用源领域中的标签信息来辅助目标领域的学习。

深度学习中的迁移学习与领域自适应

深度学习是近年来人工智能领域的热门话题,它通过模仿人类大脑的神经网络结构,实现了诸多令人惊叹的成果。

然而,在实际应用中,我们发现深度学习算法在处理新领域的数据时,往往需要大量的标注样本才能取得较好的效果。

而由于获取标注样本通常非常耗时耗力,迁移学习和领域自适应就成为了解决这一问题的重要方法。

迁移学习是指在一个任务中学到的知识如何应用在另一个任务上的过程。

深度学习中的迁移学习则更加关注如何将已经训练好的模型应用到新的任务上。

这种方法通过利用已有模型中学到的知识,减少新任务的训练时间和标注样本数量,提高模型的泛化性能。

迁移学习的思想源于认知科学和生物学领域的研究,人类在掌握一项新技能时,往往能够利用之前学到的知识和经验。

深度学习中的迁移学习一般可以分为两种类型:基于特征的迁移和基于模型的迁移。

基于特征的迁移是指利用已训练模型的底层特征提取能力,将其作为新任务的输入特征进行训练。

比如,在图像分类任务中,可以使用在大规模图像数据集上预训练的卷积神经网络(CNN)提取图像的低级特征,然后用这些特征来训练一个简单的分类器。

由于底层特征对于不同的任务有一定的共性,因此通过这种方式可以在新任务上取得不错的效果。

基于模型的迁移则更加直接,即将已训练模型的参数直接应用到新任务中,而不仅仅是特征。

这种方法在新任务和原任务之间存在一定的相似性时效果较好。

例如,在自然语言处理任务中,可以利用已经训练好的语言模型来初始化新任务的模型参数,然后通过微调的方式进一步优化模型。

除了迁移学习,另一个解决深度学习中数据稀缺问题的方法是领域自适应。

领域自适应是指将已有领域的知识迁移到新领域上,使得模型对新领域的数据具有更好的泛化能力。

在深度学习中,领域自适应可以通过调整网络结构、标注样本权重等方式来实现。

领域自适应的一个重要思想是最大化源领域和目标领域之间的相似性,同时最小化它们的差异。

这可以通过对抗性训练来实现,例如生成对抗网络(GAN)。

迁移学习10大经典算法

迁移学习10大经典算法在机器研究领域中,迁移研究是一种利用已学到的知识来解决新问题的方法。

迁移研究算法可以帮助我们将一个或多个已经训练好的模型的知识迁移到新的任务上,从而加快研究过程并提高性能。

以下是迁移研究领域中的10大经典算法:1. 预训练模型方法(Pre-trained models):通过在大规模数据集上进行预训练,然后将模型迁移到新任务上进行微调。

2. 领域自适应方法(Domain adaptation):通过将源领域的知识应用到目标领域上,解决领域差异导致的问题。

3. 迁移特征选择方法(Transfer feature selection):选择和目标任务相关的有效特征,减少特征维度,提高模型性能。

4. 迁移度量研究方法(Transfer metric learning):通过研究一个度量空间,使得源领域和目标领域之间的距离保持一致,从而实现知识迁移。

5. 多任务研究方法(Multi-task learning):通过同时研究多个相关任务的知识,提高模型的泛化能力。

6. 迁移深度卷积神经网络方法(Transfer deep convolutional neural networks):使用深度卷积神经网络进行特征提取,并迁移到新任务上进行训练。

7. 迁移增强研究方法(Transfer reinforcement learning):将已有的增强研究知识应用到新任务上,优化智能体的决策策略。

8. 迁移聚类方法(Transfer clustering):通过将已有的聚类信息应用到新数据上,实现对未标记数据的聚类。

9. 迁移样本选择方法(Transfer sample selection):通过选择源领域样本和目标领域样本的子集,减少迁移研究中的负迁移影响。

10. 迁移异构研究方法(Transfer heterogeneous learning):处理源领域和目标领域数据类型不一致的问题,例如将文本数据和图像数据进行迁移研究。

MATLAB深度学习模型的迁移学习技巧

MATLAB深度学习模型的迁移学习技巧深度学习模型的迁移学习是一种有效的方式,可以加快模型训练速度并提高模型性能。

在MATLAB中,我们可以利用迁移学习技巧来将已经训练好的模型应用于新的任务。

一、迁移学习的概念迁移学习是指通过利用已经训练好的模型在新任务上进行训练的技术。

传统的机器学习方法一般需要从头开始训练模型,但是深度学习模型具有大量的参数,需要大量的数据和计算资源进行训练。

而迁移学习可以利用已经训练好的模型的特征提取能力,将其迁移到新的任务上,从而减少训练时间和资源消耗。

二、迁移学习的应用场景迁移学习在深度学习领域有着广泛的应用。

例如,当我们需要训练一个图像分类模型时,可以使用已经在大规模图像数据上训练好的模型作为基础模型,然后通过微调或特征提取的方式将其应用到新的图像数据上。

另外,迁移学习也可以用于自然语言处理、语音识别等任务。

三、迁移学习的技巧1. 微调微调是指在迁移学习过程中,保持基础模型的大部分参数不变,只对少数层进行重新训练的方法。

这样可以利用基础模型在大规模数据上学习到的抽象特征,并在新任务上进行微调以适应新任务的特征。

在MATLAB中,可以使用`trainNetwork`函数来实现微调。

2. 特征提取特征提取是指在基础模型的顶层添加一个新的全连接层,然后只对这个新的层进行训练的方法。

这样可以利用基础模型已经学到的特征提取能力,将其应用于新任务。

在MATLAB中,可以使用`features`函数来提取基础模型的特征,并使用`trainNetwork`函数来训练新添加的全连接层。

3. 数据增强数据增强是指在训练过程中对输入数据进行一定的随机扰动,从而扩充训练数据量,增加模型的泛化性能。

在MATLAB中,可以使用`imageDataAugmenter`函数来实现数据增强,可以通过调整图像的旋转、平移、缩放等参数来生成更多的训练样本。

4. 迁移学习模型选择在迁移学习中,选择适合的基础模型非常重要。

深度迁移学习的方法与应用

深度迁移学习的方法与应用深度迁移学习是指通过利用源领域的知识来改善目标领域的学习性能。

在机器学习领域中,深度学习已经取得了巨大的成功,但是其中一个挑战是如何在数据量有限或者标记不足的情况下进行训练。

迁移学习通过将已经学习过的知识迁移到新任务中,可以有效地解决这个问题。

本文将介绍深度迁移学习的方法与应用。

一、迁移学习的基本概念迁移学习是指在某个任务上学习到的知识能够被迁移到其他相关的任务上,从而加速学习过程或者提高学习性能。

传统的迁移学习主要基于浅层的特征表示,而深度迁移学习则通过深度神经网络来实现特征表示的迁移。

深度迁移学习的核心思想是将深度神经网络的一些层或者特征提取器迁移到新任务中,以提高模型的学习能力。

二、深度迁移学习的方法1. 神经网络结构的迁移:深度迁移学习的一个常见方法是将源任务的神经网络结构迁移到目标任务中。

这可以通过调整网络的层数、节点数或者添加新的层来实现。

通过迁移源任务中的特征提取器,可以提高目标任务的性能。

2. 自适应迁移学习:自适应迁移学习是一种在特征空间上进行迁移的方法,它通过最小化源领域和目标领域之间的分布差异来实现。

可以通过最大均值差异化(MMD)来度量不同领域之间的分布差异,并使用该度量来调整模型。

3. 网络知识蒸馏:网络知识蒸馏是一种将源任务的知识通过训练一个新的模型来迁移到目标任务中的方法。

该方法通过将源任务模型的预测结果作为目标任务的训练标签,来帮助目标任务的训练。

三、深度迁移学习的应用深度迁移学习已经在各个领域取得了显著的应用效果。

以下是一些深度迁移学习的案例应用:1. 图像识别:深度迁移学习在图像识别任务中有广泛的应用。

通过将在大规模图像数据集上训练的模型迁移到新的目标任务上,可以显著提高图像识别的准确性。

2. 自然语言处理:在自然语言处理领域,深度迁移学习可以用于情感分析、机器翻译等任务。

通过迁移学习,可以利用已经学习过的语言模型来加快新任务的学习速度。

深度学习技术与迁移学习的关系解析

深度学习技术与迁移学习的关系解析深度学习技术和迁移学习都是机器学习领域中重要的研究方向,它们旨在通过利用大量数据和强大的计算能力,让计算机模仿人类的学习方式来解决各种复杂的问题。

虽然深度学习技术和迁移学习有一些相似之处,但它们在目标和方法上存在着一些区别。

深度学习技术是一种以人工神经网络为基础的机器学习方法,其目标是通过学习大量数据来构建具有多层抽象表示的模型。

深度学习技术属于无监督学习和自动特征学习的范畴,它能够提取高级特征并进行分类和预测。

深度学习技术在图像识别、语音识别、自然语言处理等领域取得了巨大的成功。

迁移学习旨在将从一个任务中学到的知识和经验应用到另一个相关任务中,以提高学习性能。

与深度学习技术不同,迁移学习更专注于在有限的标注样本和数据领域不匹配的情况下进行模型训练。

它通过将源领域的知识和经验转移到目标领域来实现模型的迁移。

深度学习技术和迁移学习之间存在着一些关系。

首先,深度学习技术可以作为迁移学习的底层模型。

通过在源领域上使用深度学习技术进行训练,可以提取出丰富的特征表示,然后将这些特征表示应用于目标领域中,从而加速目标任务的学习过程。

其次,迁移学习可以帮助深度学习技术在数据不足或领域不匹配的情况下提高性能。

由于深度学习技术需要大量的标注样本和数据来训练模型,但实际场景中往往难以获取足够的数据。

在这种情况下,可以通过迁移学习的方式,通过从源领域中获取的知识和经验来辅助目标任务的学习,从而克服数据不足的问题。

此外,深度学习技术和迁移学习可以结合使用,从而取得更好的效果。

例如,在源领域上使用深度学习技术进行训练,提取特征表示,然后使用迁移学习方法将这些特征表示应用于目标领域中进行模型的训练。

通过这种方式,可以充分利用深度学习技术的优势和迁移学习的能力,提高模型在目标任务上的性能。

综上所述,深度学习技术和迁移学习在机器学习领域中都占据重要的地位。

深度学习技术可以作为迁移学习的底层模型,通过提取丰富的特征表示来加速目标任务的学习过程。

深度学习中的迁移学习原理与应用

深度学习中的迁移学习原理与应用迁移学习是深度学习领域中一种重要的技术,它利用已经训练好的模型的知识和经验来解决新的任务,可以加快模型的训练速度、提高模型的性能,并且减少了对大量标记数据的依赖。

迁移学习的应用广泛,包括图像分类、目标检测、人脸识别等领域。

迁移学习的原理基于一个基本观点:不同任务之间存在一定的相似性。

因此,通过将已经训练好的模型的知识和特征应用到新的任务上,可以更快地收敛并取得更好的效果。

迁移学习可以分为三个主要部分:预训练模型、特征提取和微调。

首先,预训练模型指的是在大规模数据集上训练好的模型,如在ImageNet数据集上训练得到的ResNet、VGG等模型。

这些模型有着优秀的性能和丰富的特征表示能力,是迁移学习的基础。

通过使用预训练模型,我们可以将模型的初始化权重设为之前模型的参数,这样可以避免随机初始化的过程,加快模型的收敛速度。

其次,特征提取是指利用预训练模型,提取出输入数据的特征。

在迁移学习过程中,我们一般会将预训练模型的最后一层或几层去除,然后将新的数据输入到模型中进行前向传播,得到特征表示。

这些特征可以作为新的任务模型的输入,更好地表示数据的语义信息。

最后,微调是指在特征提取的基础上,对新的任务模型进行训练。

一般来说,我们通过在新的数据集上进行反向传播,更新模型的参数。

在微调过程中,我们可以冻结一部分或者全部的预训练模型的参数,只更新新模型的参数,这样可以避免因为新任务数据集的大小和特征空间与原始模型不一致而导致模型的性能下降。

迁移学习的应用非常广泛。

在图像分类中,通过将预训练模型的特征提取部分作为固定的特征提取器,然后在此基础上构建新的全连接层进行训练,可以将之前训练好的模型的特征表示迁移到新任务上,从而减少对大量标记数据的需求。

在目标检测中,可以利用预训练模型的特征提取能力,然后在此基础上进行微调,从而提高目标检测的准确性和效率。

在人脸识别中,可以通过迁移学习来训练一个人脸特征提取器,然后将此特征用于人脸识别任务,实现更高级别的应用,如人脸验证和人脸搜索。

深度学习中的迁移学习方法

深度学习中的迁移学习方法深度学习是一种机器学习方法,通过神经网络模型学习抽象的特征表示。

然而,训练一个有效的深度学习模型通常需要大量的数据和计算资源。

在现实世界中,数据往往是有限和昂贵的。

而迁移学习方法通过利用已有的知识和经验,可以在数据不充足的情况下,实现在新领域中进行有效的学习与预测。

迁移学习是一种将已学到的知识迁移到新的学习任务中的方法。

它的主要思想是,通过利用一个或多个源领域的数据和知识,来改善目标领域的学习性能。

具体而言,迁移学习可以通过以下几种方法来实现:1. 基于特征的迁移学习方法基于特征的迁移学习方法主要是利用源领域和目标领域的共享特征。

这种方法将两个领域中的数据映射到一个共享的特征空间中,然后通过训练一个目标领域的模型来进行学习和预测。

常见的方法包括主成分分析(PCA)、线性判别分析(LDA)等。

2. 基于模型的迁移学习方法基于模型的迁移学习方法是指在源领域上训练一个模型,然后将该模型迁移到目标领域上。

这种方法通常包括两个步骤:首先,在源领域上训练一个初始模型,然后通过微调(fine-tuning)或者固定某些层的权重来适应目标领域的数据。

常见的方法包括深度神经网络中的迁移学习、迁移动态贝叶斯网络等。

3. 基于关系的迁移学习方法基于关系的迁移学习方法主要是利用源领域和目标领域之间的关系来进行迁移学习。

这种方法可以通过计算源领域和目标领域之间的相似性或相关性来实现。

例如,可以通过计算源领域和目标领域之间的共享邻居来进行迁移学习。

在实际应用中,迁移学习方法已经取得了很多成功的应用。

比如,在计算机视觉领域中,通过将在大规模图像数据集上训练的模型迁移到小规模数据集上,可以实现在小规模数据集上的有效图像分类。

在自然语言处理领域中,可以通过将在一个任务上训练得到的模型迁移到另一个任务上,来提高在目标任务上的性能。

总结起来,深度学习中的迁移学习方法可以通过基于特征、模型或者关系来实现。

这些方法可以提高在目标领域上的学习性能和预测能力,特别是在数据有限的情况下。

深度学习技术中的迁移学习方法介绍与使用

深度学习技术中的迁移学习方法介绍与使用迁移学习是一种利用已有的模型知识来解决新问题的机器学习技术。

在深度学习领域,迁移学习已经成为研究热点,并在许多任务中取得了显著的成功。

本文将介绍深度学习技术中常用的迁移学习方法以及它们的使用。

1. 批量标准化迁移学习批量标准化是一种常用的神经网络训练技术,可以加速训练过程并增强模型的泛化能力。

在迁移学习中,批量标准化可用于微调已有的模型。

通过冻结低层的权重参数,只对高层进行微调,可以将已有模型的特征提取能力迁移到新任务中。

这种方法通常适用于新旧任务具有相似特征的情况。

2. 网络切割迁移学习网络切割是一种将已有模型切割成多个部分,针对新任务进行切片微调的方法。

通过这种方式,可以在不同层级上复用已有模型的特征提取能力。

通过将已有模型的中间层作为特征提取器,可以在新任务上得到更好的表现。

网络切割迁移学习适用于新旧任务的输入和输出空间不完全相同的情况。

3. 多任务学习迁移学习多任务学习是一种同时处理多个相关任务的技术。

在迁移学习中,多任务学习可以用于共享已有模型的知识。

通过将已有模型的部分权重参数共享给新任务,可以加速新任务的学习过程并提高泛化能力。

多任务学习迁移学习适用于新旧任务具有一定相关性的情况。

4. 预训练迁移学习预训练是一种在大规模数据集上训练模型的技术。

在迁移学习中,预训练可以用于提取通用特征,然后将这些特征迁移到新任务上。

通过在大规模数据集上进行预训练,可以获得更好的特征表示,并加快新任务的收敛速度。

预训练迁移学习适用于新旧任务之间存在较大差异的情况。

5. 生成对抗网络迁移学习生成对抗网络是一种通过两个神经网络之间的对抗训练来学习数据分布的方法。

在迁移学习中,生成对抗网络可以用于学习源领域和目标领域之间的映射关系。

通过将生成对抗网络应用于迁移学习,可以实现从源领域到目标领域的知识传递,提高目标领域上的性能。

在实际应用中,选择适合的迁移学习方法需要考虑多个因素,包括新旧任务的相似性、数据集的规模、模型的复杂性等。

深度学习技术中的多任务学习与迁移学习详解

深度学习技术中的多任务学习与迁移学习详解深度学习作为一种重要的机器学习方法,已经取得了在许多领域取得了显著的成果。

然而,在实际应用中,我们通常会面临许多种不同的任务,而这些任务之间可能存在着一些相关性。

为了更好地利用相关性信息和提升学习效果,多任务学习和迁移学习成为了研究热点。

多任务学习旨在同时学习多个相关任务,通过共享表示和共享知识来提高学习的效果。

与传统单任务学习相比,多任务学习可以更好地处理数据冗余、提高泛化能力和优化资源利用率。

在深度学习中,多任务学习通过共享底层神经网络的方式实现。

共享底层网络可以学习到数据的共享表示,即不同任务之间共享的有用特征。

这种共享特征的学习可以提高整个模型的泛化能力,充分利用各个任务之间的相关性。

迁移学习是指通过将已经学习到的知识或模型应用于新的领域或任务上,从而改善学习性能。

迁移学习的基本思想是通过将源领域的知识迁移到目标领域上,以减少目标领域上标注样本的需求。

在深度学习中,迁移学习可以通过微调预训练模型、使用特定的迁移层或设计适应性损失函数等方式来实现。

通过迁移学习,我们可以更好地解决数据不平衡、样本稀缺等问题,提高模型的泛化能力。

多任务学习与迁移学习在实际应用中有许多共同点。

首先,它们都可以通过共享底层网络来学习到相关任务或领域的共享表示。

共享表示的学习可以减少冗余信息、提高泛化能力,并且能够更好地适应新的任务或领域。

其次,它们都能够提高模型的资源利用率。

通过在多个任务或领域之间共享模型参数和学习过程,可以减少训练时间和计算成本,并提高模型的效率。

此外,多任务学习和迁移学习都需要合适的领域知识和领域适应策略。

通过合适的领域知识和适应性策略,可以更好地适应不同的任务和领域,提高模型的性能。

然而,多任务学习和迁移学习也存在一些差异。

在多任务学习中,多个任务之间通常是同时进行学习的,模型需要在任务之间进行权衡和平衡。

而在迁移学习中,通常是先在源任务或领域上进行学习,然后将已学到的知识迁移到目标任务或领域上。

深度学习中的迁移学习与领域自适应方法简介

深度学习中的迁移学习与领域自适应方法简介引言:在计算机视觉领域,迁移学习和领域自适应是两个重要的技术概念。

它们被广泛应用于解决深度学习网络在数据量不足或数据分布不匹配的情况下的挑战。

本文将介绍深度学习中的迁移学习和领域自适应方法,以及它们在实际应用中的意义和效果。

一、迁移学习的概念与原理迁移学习是指通过将已学习知识从一个任务或领域迁移到另一个任务或领域,以提升目标任务的性能。

其理论基础是源领域和目标领域之间的相似性。

在传统的机器学习方法中,迁移学习常通过调整特征表示或使用预训练的模型进行实现。

而在深度学习中,更常见的迁移学习方式是基于深度神经网络的迁移。

深度神经网络的迁移学习通常分为两种方式:特征提取器的迁移和模型微调。

特征提取器的迁移是指通过冻结预训练的模型的前几层,并将这些层作为特征提取器来提取源领域和目标领域的共享特征。

然后,可以使用这些共享特征作为输入来训练目标任务的特定分类器。

模型微调是指在预训练的模型基础上,对部分或全部网络参数进行微调,以适应目标任务的特征表示。

迁移学习的优势在于可以加速模型的训练过程,减少对大量标注数据的需求,同时提高目标任务的性能和泛化能力。

通过从一个任务中学到的知识,迁移到另一个任务上,可以充分利用已有知识的信息,提高模型对于新任务的理解和推理能力。

二、领域自适应的概念与方法领域自适应是迁移学习的一种特殊形式,主要解决源领域和目标领域分布上的差异问题。

在深度学习中,由于源领域和目标领域的数据分布不匹配,直接将源领域模型应用于目标领域往往会出现性能下降的情况。

因此,领域自适应方法被提出来解决这一问题。

领域自适应方法主要包括实例重加权、特征选择和特征映射等技术。

实例重加权是通过引入权重来调整源领域和目标领域的样本分布,从而减小源领域和目标领域之间的差异。

特征选择是在特征空间中选择具有较强判别能力的特征,以减小特征空间的差异。

特征映射是通过学习一个映射函数,将源领域和目标领域的特征映射到一个共享的空间中,使其在该空间中的分布保持一致。

掌握深度学习中的迁移学习和增量学习方法

掌握深度学习中的迁移学习和增量学习方法迁移学习和增量学习是深度学习领域中的两个重要方法,它们都是为了充分利用已有的知识并在新任务上取得更好的性能。

本文将分别介绍迁移学习和增量学习的基本概念、核心思想,以及它们在实际应用中的一些方法和技术。

同时,我们还将探讨迁移学习和增量学习在深度学习领域的最新研究进展和应用场景。

一、迁移学习1.迁移学习的基本概念迁移学习(Transfer Learning)是指在源领域和目标领域之间存在一定差异的情况下,通过利用源领域的知识来帮助目标领域的学习。

在机器学习和深度学习中,由于数据的稀缺性和标注的成本高昂,通常难以直接将学习到的模型应用到新的任务上。

而迁移学习则是通过利用源领域的大量数据和已有模型的知识,来加速目标领域的学习和提高性能。

2.迁移学习的核心思想迁移学习的核心思想是通过将源领域的知识迁移到目标领域上,从而取得更好的性能。

在深度学习中,迁移学习通常包括两个阶段:首先是在源领域上预训练一个模型,然后将该模型迁移到目标领域上进行微调。

通过这样的方式,迁移学习可以在目标领域上利用更少的数据和计算资源来取得更好的性能。

3.迁移学习的方法和技术在实际应用中,迁移学习有多种方法和技术,包括基于表示学习的迁移学习、基于特征选择的迁移学习、基于核方法的迁移学习等。

其中,表示学习是深度学习领域中常用的一种迁移学习方法,它通过学习数据的表示来提取有用的特征,并将这些特征迁移到目标领域上进行学习。

此外,迁移学习还可以通过对模型参数进行调整来实现知识的迁移,例如在目标领域上微调卷积神经网络的部分层。

4.迁移学习的研究和应用迁移学习在深度学习领域有着广泛的研究和应用。

例如,在计算机视觉领域,迁移学习被广泛应用于目标检测、图像分类、人脸识别等任务上,通过在大规模数据集上训练的模型,在小规模数据集上取得更好的性能。

在自然语言处理领域,迁移学习也常用于文本分类、命名实体识别等任务上,通过在大规模语料库上训练的语言模型,来提高目标任务的性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

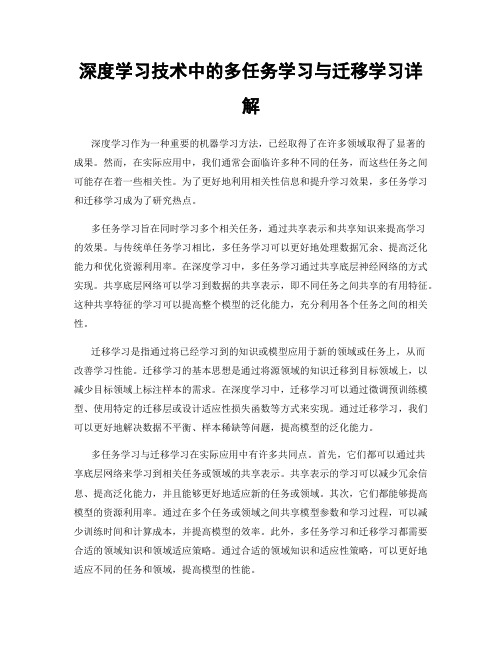

J 2 N N ( m ) ( m 1)T ( m ) ( m 1)T Pij ( Lij hi L ji h j ) (m) W Nk1 i 1 j 1 2 Nk2

Q ( L

i 1 j 1 Nt ij

N

N

( m ) ( m 1)T ij i

h

T

L h

( m ) ( m 1)T ji j

L(ijM ) ( hi( M ) h (j M ) ) ' ( zi( M ) )

M) L(ji ( h (j M ) hi( M ) ) ' ( z (j M ) )

zi( m ) W ( m ) hi( m 1) b ( m )

L L L

(m) ij (m) ji (M ) ti

(W (W

( m 1)T ( m 1)T Nt

L(ijm 1) ) ' ( zi( m ) )

m 1) L(ji ) ' ( z (jm ) ) (M ) tj

1 ( Nt 1 ( Ns (W (W

h

j 1 Ns j 1

1 Ns 1 Nt

(M ) ' (M ) h ) ( z ) sj ti j 1 Nt (M ) ' (M ) h ) ( z ) tj si j 1

2 ( m)

D

( m) ts

1 (Xt , X s ) Nt

f

i 1

Nt

( m)

1 ( xti ) Ns

f

i 1

Ns

( xsi )

2

We formulate DTML as the following optimization problem:

min J S (M )

f

(M ) c

Face Verification

Person ReIdentification

Person ReIdentification

Source domain

Target domain color and texture histograms color and texture histograms

Deep Transfer Metric Learning

Introduction

Problems

Metric learning

nonlinear relationship Linear feature space

explicit nonlinear mapping functions

kernel trick

DML

Enforce the marginal fisher analysis criterion on the output of all the training samples at the top layer:

M

min J S (M )

f

(M ) c

S

(M ) b

( W

m 1

Face Verification

Face Verification

LFW WDRef

LBP

DTML LBP

output

parameters:

0.1, 10, 0.1, w 1,

(1)

(1)

0, k1 5, k2 10, 0.2

Deep network with three layers (M = 2), and neural nodes from bottom to top layer are set as: 500→400→300. The nonlinear activation function:The tanh function

Deep learning

DSTML

For exploiting discriminative information from the output of all layers as much as well.

M 1 m 1

min JJ (M )

f

(M )

w h( J

( m) (M ) b

Person ReIdentification

Person ReIdentification

( m)

( m)

),

M

discriminative information from the output of all layers.

( m) 2 F

J

( m)

S

(M ) c

S

D

(M ) ts

(Xt , X s ) ( W

m 1

b

( m) 2 2

)

Then compute the gradient.

S

(M ) b

D

(M ) ts

(Xt , X s ) ( W

m 1

M

( m) 2 F

b

( m) 2 2

)

stochastic sub-gradient descent method

DMTL

the objective function J with respect to the parameters W and b are computed as follows:

descent algorithm as follows until convergence:

J W W (m) W J (m) (m) b b (m) b

(m) (m)

DMTL

STEP:

intra-class variations are minimized inter-class variations are maximized Transfer learning

) ) 2 W

( m)

1 2 ( Nt

L

i 1

( m ) ( m 1) ti ti

h

1 Ns

L

i 1

Ns

( m ) ( m 1)T si si

hations for all layers 1 ≤ m ≤ ℓ − 1 are computed as follows :

p( m )

For each pair of samples xi and x j , their distance metric is

d

2 f ( m)

( xi , x j ) f

( m)

( xi ) f

( m)

(xj )

2 2

Enforce the marginal fisher analysis criterion on the output of all the training samples at the top layer

DTML

output

parameters:

0.1, 10, 0.1, w(1) 1, (1) 0, k1 3, k2 10, 0.2

Deep network with three layers (M = 2), and neural nodes from bottom to top layer are set as: 200→200→100. The nonlinear activation function:The tanh function

DMTL

Given target domain data X t and source domain data X s , to reduce the distribution difference, we apply the Maximum Mean Discrepancy (MMD) criterion

is a nonlinear activation function which operates component-wisely.

For the first layer, we assume h

(0)

f

( m)

( x) h

( m)

(W h

x.

( m) ( m1)

b )R

( m)

Deep learning

learn feature representations

h, W, b

Deep Metric learning

DSTML

training and test samples DTML

same

Transfer learning

DTML

DML

DML

The nonlinear mapping function can be explicitly obtained:

Ns

M) L(si

(M ) h sj

L L

(m) ti (m)

( m 1)T ( m 1)T

( m) L(tim 1) ) ' ( zti )

L( m 1) ) ' ( z ( m ) )

DMTL

Then,

W

(m)

and b

(m)

can be updated by using the gradient

( m) 2 F

b

( m) 2 2

)

intra-class variations are minimized inter-class variations are maximized

N N 1 2 Sc( m ) = P d ij f ( m ) ( xi , x j ) Nk1 i 1 j 1 N N 1 (m) 2 Sb = Qij d f ( m ) ( xi , x j ) Nk2 i 1 j 1