谱聚类

谱聚类方法

谱聚类方法一、谱聚类的基本原理谱聚类(Spectral Clustering)是一种基于图论的聚类方法,通过研究样本数据的图形结构来进行聚类。

谱聚类方法的基本原理是将高维数据转换为低维数据,然后在低维空间中进行聚类。

它利用样本之间的相似性或距离信息,构建一个图模型(通常是相似度图或距离图),然后对图模型进行谱分解,得到一系列特征向量,最后在特征向量空间中进行聚类。

谱聚类的核心步骤是构建图模型和进行谱分解。

在构建图模型时,通常采用相似度矩阵或距离矩阵来表示样本之间的联系。

在谱分解时,通过对图模型的拉普拉斯矩阵进行特征分解,得到一系列特征向量,这些特征向量表示了样本数据的低维空间结构。

通过对特征向量空间进行聚类,可以将高维数据分为若干个类别。

二、谱聚类的优缺点1.优点(1)适用于高维数据:谱聚类方法能够有效地处理高维数据,因为它的核心步骤是将高维数据转换为低维数据,然后在低维空间中进行聚类。

这有助于克服高维数据带来的挑战。

(2)对噪声和异常值具有较强的鲁棒性:谱聚类方法在构建图模型时,会考虑到样本之间的相似性和距离信息,从而在一定程度上抑制了噪声和异常值的影响。

(3)适用于任意形状的聚类:谱聚类方法可以适用于任意形状的聚类,因为它的聚类结果是基于特征向量空间的,而特征向量空间可以捕捉到样本数据的全局结构。

2.缺点(1)计算复杂度高:谱聚类的计算复杂度相对较高。

构建图模型和进行谱分解都需要大量的计算。

在大规模数据集上,谱聚类的计算效率可能会成为问题。

(2)对相似度矩阵或距离矩阵的敏感性:谱聚类的结果会受到相似度矩阵或距离矩阵的影响。

如果相似度矩阵或距离矩阵不合理或不准确,可能会导致聚类结果不理想。

(3)对参数的敏感性:谱聚类的结果会受到参数的影响,如相似度度量方式、距离度量方式、图模型的构建方式等。

如果参数选择不当,可能会导致聚类效果不佳。

三、谱聚类的应用场景1.图像分割:谱聚类方法可以应用于图像分割,将图像中的像素点分为若干个类别,从而实现对图像的分割。

谱聚类算法 python

谱聚类算法 python谱聚类是一种基于图论的聚类算法,它通过构建数据的相似度矩阵和拉普拉斯矩阵来实现数据的聚类。

下面是谱聚类算法的Python实现参考内容。

1. 导入所需库和数据模块:```pythonimport numpy as npfrom sklearn.cluster import KMeansfrom sklearn.metrics import pairwise_distancesfrom sklearn.datasets import make_blobs```2. 定义谱聚类函数:```pythondef spectral_clustering(data, n_clusters, sigma=1):# 构建相似度矩阵similarity_matrix = pairwise_distances(data, metric='rbf', gamma=1.0/(2*sigma**2))# 构建拉普拉斯矩阵row_sums = np.sum(similarity_matrix, axis=1)laplacian_matrix = np.diag(row_sums) - similarity_matrix# 计算拉普拉斯矩阵的特征值和特征向量eigvals, eigvecs = np.linalg.eig(laplacian_matrix)# 根据特征值进行排序indices = np.argsort(eigvals)[:n_clusters]# 提取特征向量的前n_clusters个列向量eigvecs_selected = eigvecs[:, indices]# 使用K-means算法对特征向量进行聚类kmeans = KMeans(n_clusters=n_clusters)kmeans.fit(eigvecs_selected)labels = bels_return labels```3. 生成示例数据并调用谱聚类函数进行聚类:```pythondata, ground_truth = make_blobs(n_samples=100, centers=3, random_state=0)labels = spectral_clustering(data, n_clusters=3, sigma=1)print("聚类结果:", labels)```以上就是谱聚类算法的Python实现参考内容。

谱聚类算法

其中: assoc(A k , V )

i

Ak ,j V

w ij

Melia 指出Ncut 和MNcut 的差异之处仅在于所使用的 谱映射不同, 并且当k= 2 时, MNcut 与Ncut 等价。多路规 范割集准则在实际应用中合理有效, 但其优化问题通常难以 解决。

相似矩阵、度矩阵及Laplacian 矩阵

cut(A ,B )

i ,

w ij Aj B

通过最小化上述剪切值来划分图G, 这一划分准则被称 为最小割集准则。他们用这个准则对一些图像进行分割, 并 产生了较好的效果, 同时他们也注意到, 该准则容易出现歪 斜( 即偏向小区域) 分割。规范割集准则及比例割集准则均 可避免这种情况的发生。

谱聚类算法

根据不同的准则函数及谱映射方法, 谱聚类算法发展了很多

不同的具体实现方法, 但是都可以归纳为下面三个主要步骤 :

构建表示样本集的矩阵Z; 通过计算Z 的前k 个特征值与特征向量, 构建特征向量空间; 利用k-means 或其它经典聚类算法对特征向量空间中的特征向 量进行聚类。 上述步骤是谱聚类算法的一个框架, 在具体实现过程中,不同 的算法在数据集矩阵Z 的表示上存在着不同。例如根据2 way cut 的目标函数, Z= W; 根据随机游动关系, 则Z=D- 1W 等。划分准则一 般分为2 way 和k way, 本文根据所使用的划分准则, 将算法分为迭 代谱和多路谱两类, 并分别讨论了各类中典型的谱聚类算法。

可以看出Avcut 和Ncut 函数都表示无向图G 中边界损

失与分割区域相关性的比值之和, 因此最小化Avcut 与Ncut 目标函数都能产生较准确的划分。其共同缺点是倾向于欠 分割且易分割出只包含几个顶点的较小子图。文献通过实 验发现, 当把Normalized cut 和Average cut 准则分别用于同

谱聚类基本概念

谱聚类基本概念谱聚类(spectral clustering)是一种经典的无监督学习算法,用于将数据集分成若干个不相交的子集或簇。

它借助于数据集的相似性矩阵或图结构进行聚类。

谱聚类的基本概念包括以下几点:1. 相似性矩阵:相似性矩阵用于表示数据样本之间的相似程度。

它可以是一个对称的矩阵,矩阵的元素表示样本之间的相似度或距离。

2. 图拉普拉斯算子:图拉普拉斯算子是图结构中的一种特殊矩阵,用于表示图的拓扑结构。

它将相似性矩阵进行规范化,得到一个对称的拉普拉斯矩阵。

3. 特征值分解:通过对图拉普拉斯矩阵进行特征值分解,可以得到一组特征值和对应的特征向量。

这些特征向量可以用于表示样本在新的低维空间中的投影。

4. 谱聚类过程:谱聚类的过程主要包括以下几步:计算相似性矩阵,构造图拉普拉斯矩阵,对图拉普拉斯矩阵进行特征值分解,选择特征值对应的特征向量,对特征向量进行聚类。

总的来说,谱聚类通过图论的方法,将样本投影到低维空间,并利用聚类算法进行聚类,从而实现数据集的聚类分析。

它可以处理非线性、非凸以及具有复杂结构的数据。

当进行谱聚类时,可以根据需要采用不同的相似度度量方法,比如欧氏距离、余弦相似度等。

具体的相似性度量方式取决于数据的特征和聚类的目标。

另外,在特征值分解时,通常选择特征值较小的前k个特征向量作为投影空间的基,这样可以将数据映射到一个低维空间。

通过对这些特征向量进行聚类,可以得到最终的聚类结果。

需要注意的是,谱聚类算法在大数据集上的计算量较大,因为它涉及到计算相似性矩阵和特征值分解等操作。

为了提高算法的效率,可以通过一些近似计算方法来加速计算,比如使用局部近似算法(Local Approximation Algorithm)或随机近似算法(Randomized Approximation Algorithm)。

总的来说,谱聚类是一种基于图论和线性代数的聚类方法,通过将数据映射到低维空间并进行聚类分析,可以有效地处理复杂的数据结构。

谱聚类应用

谱聚类是一种非线性聚类方法,广泛应用于数据挖掘、图像分析、计算机视觉等领域。

其基本思想是将数据点映射到多维空间中,并在这个空间中找到相似性的图,通过图的信息设计聚类准则,最终实现聚类。

在具体应用中,谱聚类可以用于以下方面:

1. 文本聚类:将文本数据转化为图的形式,利用谱聚类方法对其进行聚类,可以实现文本的自动分类和聚类。

2. 图像分割:通过对图像进行谱聚类,可以将图像自动分割成多个区域,实现图像的分割和识别。

3. 流形学习:利用谱聚类方法可以将高维数据降维到低维空间中,从而实现流形的学习和可视化。

4. 生物信息学:谱聚类方法在生物信息学中有着广泛的应用,可以用于基因组学、蛋白质结构预测等方面。

5. 社交网络分析:通过对社交网络进行谱聚类,可以发现社交群体和社区,从而分析用户行为和兴趣。

谱聚类方法具有广泛的应用前景,可以在许多领域中发挥其优势。

谱聚类算法综述

谱聚类算法综述一、本文概述谱聚类算法是一种基于图理论的机器学习技术,它在数据分析和模式识别中发挥着重要作用。

本文旨在对谱聚类算法进行全面的综述,从理论基础、算法流程、应用领域以及最新进展等多个方面进行深入的探讨。

我们将简要介绍谱聚类算法的基本概念和原理,包括图论基础、拉普拉斯矩阵、特征值分解等关键知识点。

然后,我们将详细阐述谱聚类算法的基本流程和主要步骤,包括数据预处理、构建相似度矩阵、计算拉普拉斯矩阵、求解特征向量和聚类等。

接下来,我们将重点分析谱聚类算法在不同领域中的应用,如图像处理、社交网络分析、机器学习等,并探讨其在这些领域中取得的成果和优势。

我们还将对谱聚类算法的性能进行评估,包括其时间复杂度、空间复杂度以及聚类效果等方面。

我们将对谱聚类算法的最新研究进展进行综述,包括新的算法模型、优化方法以及应用领域的拓展等方面。

通过对这些最新进展的梳理和总结,我们可以更好地了解谱聚类算法的发展趋势和未来研究方向。

本文旨在对谱聚类算法进行全面的综述和分析,为读者提供一个清晰、系统的认识框架,同时也为该领域的研究者提供有价值的参考和启示。

二、谱聚类算法的基本原理谱聚类算法是一种基于图理论的聚类方法,它通过将数据点视为图中的节点,数据点之间的相似性视为节点之间的边的权重,从而构建出一个加权无向图。

谱聚类的基本原理在于利用图的拉普拉斯矩阵(Laplacian Matrix)的特征向量来进行聚类。

构建相似度矩阵:需要计算数据点之间的相似度,这通常通过核函数(如高斯核函数)来实现,从而构建出一个相似度矩阵。

构建图的拉普拉斯矩阵:根据相似度矩阵,可以构建出图的度矩阵和邻接矩阵,进而得到图的拉普拉斯矩阵。

拉普拉斯矩阵是相似度矩阵和度矩阵之差,它反映了数据点之间的局部结构信息。

求解拉普拉斯矩阵的特征向量:对拉普拉斯矩阵进行特征分解,得到其特征向量。

这些特征向量构成了一个新的低维空间,在这个空间中,相似的数据点更接近,不相似的数据点更远。

谱聚类算法实现

谱聚类算法实现谱聚类(Spectral Clustering)是一种基于图论的聚类算法。

它的主要思想是将数据集转化为一个邻接矩阵,并基于该矩阵进行谱分析,从而将数据划分成不同的聚类。

谱聚类算法的实现步骤如下:1. 构建相似度矩阵:对于给定的数据集,计算任意两个样本之间的相似度,并构建相似度矩阵。

相似度可以采用不同的度量方式,如欧氏距离、高斯核函数等。

2. 构建拉普拉斯矩阵:将相似度矩阵转化为拉普拉斯矩阵,常用的有标准化拉普拉斯矩阵和非标准化拉普拉斯矩阵。

3. 特征值分解:对拉普拉斯矩阵进行特征值分解,得到特征值和对应的特征向量。

4. 选择特征向量:根据特征值的大小选择前k个特征向量,其中k为聚类的个数。

5. 聚类:将选取的特征向量作为新的数据集,使用传统聚类算法(如k-means)对其进行聚类。

下面是一个简单的Python实现示例:```pythonimport numpy as npfrom sklearn.cluster import KMeansdef spectral_clustering(data, k):# 构建相似度矩阵similarity_matrix = compute_similarity_matrix(data)# 构建拉普拉斯矩阵laplacian_matrix = compute_laplacian_matrix(similarity_matrix)# 特征值分解eigenvalues, eigenvectors = np.linalg.eig(laplacian_matrix)# 选择特征向量indices = np.argsort(eigenvalues)[:k]selected_eigenvectors = eigenvectors[:, indices]# 聚类kmeans = KMeans(n_clusters=k)kmeans.fit(selected_eigenvectors)labels = bels_return labels# 计算相似度矩阵def compute_similarity_matrix(data):# 这里假设使用欧氏距离作为相似度度量方式similarity_matrix = np.zeros((len(data), len(data)))for i in range(len(data)):for j in range(i+1, len(data)):distance = np.sqrt(np.sum((data[i] - data[j]) ** 2))similarity = np.exp(-distance / 2)similarity_matrix[i, j] = similarity_matrix[j, i] = similarity return similarity_matrix# 构建拉普拉斯矩阵def compute_laplacian_matrix(similarity_matrix):degree_matrix = np.diag(np.sum(similarity_matrix, axis=1))laplacian_matrix = degree_matrix - similarity_matrixreturn laplacian_matrix```以上是谱聚类算法的一种简单实现方法,实际应用中还可以根据具体情况进行适当调整和改进。

谱聚类和kmeans关系

谱聚类和kmeans关系

谱聚类和kmeans是聚类问题中两个常用的算法。

虽然它们都可以用于聚类分析,但它们之间还是有一些差异的,具体如下:

1. 聚类方法

K-means是一种硬聚类方法,即每个样本只能属于一个聚类中心。

而谱聚类是一种软聚类方法,它可以实现集群属性的模糊化,即每个数据点都可能属于多个组。

2. 聚类效果

通常情况下,谱聚类的聚类效果会更好,而 K-means 往往会偏向于形状简单的聚类结果。

在复杂数据集中,谱聚类往往优于K-means。

3. 对异常值的影响

K-means对异常值比较敏感。

如果有噪音数据存在于聚类样本中,很容易导致聚类结果偏离真实数据结构。

而谱聚类通过度量样本之间的相似度来聚类,对于异常值比较容忍。

4. 计算复杂度

K-means时间复杂度一般比谱聚类低。

对于大规模数据集合,K-means 具有更为优秀的算法复杂度。

总之,K-means和谱聚类是两种不同的聚类方法,各有特点。

在选择合适的方法时,需根据现实应用情况综合评估,选择最适合的算法。

谱聚类算法的matlab代码

谱聚类算法的matlab代码谱聚类是一种用于无监督分类和聚类的算法,它可以根据数据之间的相似性将数据分为不同的类别。

在谱聚类中,数据点被表示为一个图的节点,相似性被表示为边的权重,然后将这个图转换为拉普拉斯矩阵,通过对拉普拉斯矩阵进行谱分解得到数据的特征向量,最终将数据点根据特征向量进行划分。

以下是谱聚类算法的matlab代码:1. 载入数据首先,需要从文件中读取数据,并将其转换为矩阵形式。

```matlabdata = dlmread('data.txt'); % 读取数据```2. 构建相似度矩阵在谱聚类中,需要根据数据点之间的相似度构建一个相似度矩阵。

可以使用高斯核函数计算数据点之间的相似度,并将相似度作为矩阵的元素。

```matlabsigma = 1; % 高斯核函数的参数n = size(data, 1); % 数据点的数量W = zeros(n, n); % 相似度矩阵for i=1:nfor j=1:nd = norm(data(i,:) - data(j,:))^2;W(i,j) = exp(-d/(2*sigma^2));endend```3. 构建拉普拉斯矩阵根据相似度矩阵,可以构建拉普拉斯矩阵。

拉普拉斯矩阵可以分为未归一化拉普拉斯矩阵、对称归一化拉普拉斯矩阵和随机游走归一化拉普拉斯矩阵三种形式,具体使用哪种形式可以根据实际情况进行选择。

```matlabD = diag(sum(W, 2)); % 度矩阵L = D - W; % 拉普拉斯矩阵```4. 求解特征值和特征向量通过对拉普拉斯矩阵进行谱分解,可以得到特征值和特征向量。

```matlab[V, ~] = eig(L); % 求解拉普拉斯矩阵的特征向量和特征值```5. 对特征向量进行归一化和降维通常情况下,只需要保留前k个特征向量,并对这些特征向量进行归一化和降维。

```matlabk = 2; % 保留的特征向量数量U = V(:, 1:k); % 选择前k个特征向量U = normc(U); % 对特征向量进行归一化```6. 对数据进行聚类最后,可以使用K-means算法对数据进行聚类。

谱聚类算法讲解ppt课件

sij xi KNN ( x j ) and x j KNN ( xi )

10

Spectral Clustering 谱聚类

谱聚类基础一:图-邻接矩阵

(3)全连接法:

通过核函数定义边权重,常用的有多项式核函数,

高斯核函数和Sigmoid核函数。使用高斯核函数构建邻接

1 1

Rcut(G1 , G2 ) Cut (G1 , G2 )

n1 n2

n1、n 2划分到子图1和子图2的顶点个数

Rcut (G1 , G2 )

1 1

w

ij

n2

iG1 , jG2 n1

(n1 n2 ) 2

wij

量的相似矩阵S

邻接矩阵W。

6

Spectral Clustering 谱聚类

谱聚类基础一:图-邻接矩阵

构建邻接矩阵 W 主要有三种方法 :

•

-近邻法

•

K近邻法

• 全连接法

7

Spectral Clustering 谱聚类

谱聚类基础一:图-邻接矩阵

(1) -近邻法:

设置一个距离阈值

,然后用欧式距离

2

27

Spectral Clustering 谱聚类

(2) Ratio Cut

令

qi

二分类:

n1

n2 n

n2

n1n

i G1

= 1

i G2

Rcut (G1 , G2 )

w q q

2

iG1 , jG2

谱聚类 簇的选择

谱聚类是一种基于图论的聚类方法,它通过构建和操作数据点之间的相似性图来发现数据的聚类结构。

在谱聚类中,簇的选择通常取决于图中的连通性和节点的权重。

首先,谱聚类通过构建相似性图来表达数据点之间的相似性关系。

图中的每个节点表示一个数据点,每条边表示两个数据点之间的相似性。

边的权重通常由相似性度量决定,例如高斯核函数或余弦相似性等。

接下来,谱聚类通过迭代过程来选择簇的数量。

在每次迭代中,算法将图中的边按照权重进行排序,并选择前k个边进行聚类。

这个k值通常由用户预先设定,也可以通过交叉验证来确定。

在选择簇的数量时,需要考虑图中的连通性和节点的权重。

一般来说,如果一个数据点与多个其他数据点相似,那么它应该属于一个独立的簇。

此外,如果一个数据点与其他数据点的相似性非常高,那么它们也应该被分到同一个簇中。

因此,簇的数量应该根据图的连通性和节点的权重来合理选择。

总之,谱聚类中的簇选择是一个迭代过程,它通过构建和操作相似性图来发现数据的聚类结构。

在选择簇的数量时,需要考虑图的连通性和节点的权重,以便得到更准确和可靠的聚类结果。

谱聚类算法 分型

谱聚类算法分型

谱聚类算法是一种有效的数据挖掘算法,用于从大规模的数据集中形成聚类。

它的工作原理是对用户提供的数据集进行聚类,形成不同的簇,其中一个簇表示相似的点,从而找出呈现规律性的存在。

谱聚类算法最初是由斯坦福大学的朱利安•贝德里姆和其他同事开发的,其优势是比经典聚类算法具有更好的效率和更低的计算量,因此被广泛用于大规模数据聚类和分析,尤其是解决大数据问题。

分型算法是一种常用的数据挖掘算法,用于分类和分析数据。

主要作用是发现隐含在数据集中的模式和规律,可以将相关联的数据点分组入不同类别。

分型算法是一种基于统计学的分类技术,它可以将训练数据归类为一组典型类,以对未知实例进行分类和预测。

它能够从大量的实例中自动构建决策规则,尤其是在分析复杂的实例时,其应用是比较有效的。

谱聚类和pca的关系

谱聚类和pca的关系

谱聚类和PCA都是常用的数据降维方法,但是它们的思路和实现方式

有很大的区别。

下面将详细介绍谱聚类和PCA的关系。

一、谱聚类的基本思想

谱聚类是一种基于谱分析的聚类算法,它的基本思想是将数据集看作

一个图,根据节点之间的相似性构建出一个邻接矩阵,然后通过对邻

接矩阵进行特征分解,得到特征向量,最后将特征向量作为新的数据集,采用其他聚类算法进行聚类。

二、PCA的基本思想

PCA是一种基于矩阵分解的降维算法,它的基本思想是将高维数据通

过线性变换映射到低维空间中,使得映射后的数据能够最大程度地保

留原始数据的信息。

PCA的核心是通过对数据协方差矩阵的特征分解,得到数据集的主成分,将数据集在主成分方向上进行投影,实现降维。

三、谱聚类和PCA的关系

1. 原理基础不同

谱聚类依赖于图论的基础,而PCA则是一种基于矩阵分解的算法,两者的原理基础不同。

2. 应用场景不同

谱聚类通常应用在图像分割、社交网络等领域,而PCA适合处理具有强相关性的高维数据,例如图像处理、金融分析等领域。

3. 实现方法不同

谱聚类采用的是特征分解实现降维,而PCA则是通过矩阵分解实现降维,两者的实现方式不同。

4. 目的不同

谱聚类的目的是将数据划分成不同的簇,而PCA的目的是降低数据维度并且保留尽可能多的信息。

综上所述,谱聚类和PCA虽然都是数据降维方法,但是它们的原理基础、应用场景、实现方法和目的都存在较大的区别。

在实际应用中,应根据具体的场景和需要选择合适的降维算法。

谱聚类算法(Spectral Clustering)原理分析

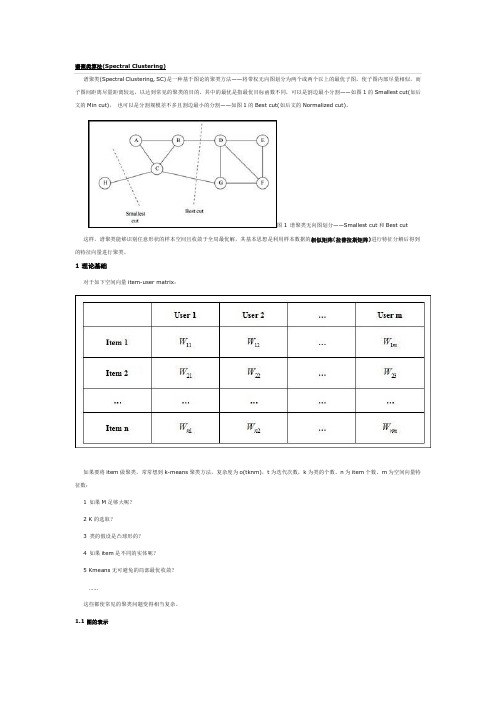

谱聚类算法(Spectral Clustering)谱聚类(Spectral Clustering, SC)是一种基于图论的聚类方法——将带权无向图划分为两个或两个以上的最优子图,使子图内部尽量相似,而子图间距离尽量距离较远,以达到常见的聚类的目的。

其中的最优是指最优目标函数不同,可以是割边最小分割——如图1的Smallest cut(如后文的Min cut),也可以是分割规模差不多且割边最小的分割——如图1的Best cut(如后文的Normalized cut)。

图1 谱聚类无向图划分——Smallest cut和Best cut 这样,谱聚类能够识别任意形状的样本空间且收敛于全局最优解,其基本思想是利用样本数据的相似矩阵(拉普拉斯矩阵)进行特征分解后得到的特征向量进行聚类。

1 理论基础对于如下空间向量item-user matrix:如果要将item做聚类,常常想到k-means聚类方法,复杂度为o(tknm),t为迭代次数,k为类的个数、n为item个数、m为空间向量特征数:1 如果M足够大呢?2 K的选取?3 类的假设是凸球形的?4 如果item是不同的实体呢?5 Kmeans无可避免的局部最优收敛?……这些都使常见的聚类问题变得相当复杂。

1.1 图的表示如果我们计算出item与item之间的相似度,便可以得到一个只有item的相似矩阵,进一步,将item看成了Graph(G)中Vertex(V),歌曲之间的相似度看成G中的Edge(E),这样便得到我们常见的图的概念。

对于图的表示(如图2),常用的有:邻接矩阵:E,e ij表示v i和v i的边的权值,E为对称矩阵,对角线上元素为0,如图2-2。

Laplacian矩阵:L = D – E,其中d i (行或列元素的和),如图2-3。

图2 图的表示1.2 特征值与L矩阵先考虑一种最优化图像分割方法,以二分为例,将图cut为S和T两部分,等价于如下损失函数cut(S, T),如公式1所示,即最小(砍掉的边的加权和)。

谱聚类详细入门级介绍

6

0.0 0.0 0.0 0.7 0.8 0.0

拉普拉斯矩阵L=D-W

1

2

3

4

5

6

1

1.5 0.0 0.0 0.0 0.0 0. 0

2

0.0 1.6 0.0 0.0 0.0 0.0

3

0.0 0.0 1.6 0.0 0.0 0.0

4

0.0 0.0 0.0 1.7 0.0 0.0

5

0.0 0.0 0.0 0.0 1.7 0.0

123456 1 1.5 0.0 0.0 0.0 0.0 0. 0 2 0.0 1.6 0.0 0.0 0.0 0.0 3 0.0 0.0 1.6 0.0 0.0 0.0 4 0.0 0.0 0.0 1.7 0.0 0.0 5 0.0 0.0 0.0 0.0 1.7 0.0 6 0.0 0.0 0.0 0.0 0.0 1.5

Ratio cut

Cu(G t 1,G2)n11

1 n2

Ncut

Cu(G t 1,G2)d11

1 d2

顶点数

权重和

1、同子图内所有点相似度高 2、不同子图的点相似度低

Minimum Cut、Ratio cut只考虑了1个要求

Ncut考虑了上面2个要求

Spectral Clustering 谱聚类 Unnormalized Spectral Clustering步骤

Spectral Clustering 谱聚类 Minimum Cut方法

0.7

2

7

0.6

0.6

1

0.3

3

0.2 0.2

ห้องสมุดไป่ตู้

5

0.

0.

8

8

谱聚类(spectralclustering)原理总结

谱聚类(spectralclustering)原理总结 谱聚类(spectral clustering)是⼴泛使⽤的聚类算法,⽐起传统的K-Means算法,谱聚类对数据分布的适应性更强,聚类效果也很优秀,同时聚类的计算量也⼩很多,更加难能可贵的是实现起来也不复杂。

在处理实际的聚类问题时,个⼈认为谱聚类是应该⾸先考虑的⼏种算法之⼀。

下⾯我们就对谱聚类的算法原理做⼀个总结。

1. 谱聚类概述 谱聚类是从图论中演化出来的算法,后来在聚类中得到了⼴泛的应⽤。

它的主要思想是把所有的数据看做空间中的点,这些点之间可以⽤边连接起来。

距离较远的两个点之间的边权重值较低,⽽距离较近的两个点之间的边权重值较⾼,通过对所有数据点组成的图进⾏切图,让切图后不同的⼦图间边权重和尽可能的低,⽽⼦图内的边权重和尽可能的⾼,从⽽达到聚类的⽬的。

乍⼀看,这个算法原理的确简单,但是要完全理解这个算法的话,需要对图论中的⽆向图,线性代数和矩阵分析都有⼀定的了解。

下⾯我们就从这些需要的基础知识开始,⼀步步学习谱聚类。

2. 谱聚类基础之⼀:⽆向权重图 由于谱聚类是基于图论的,因此我们⾸先温习下图的概念。

对于⼀个图G,我们⼀般⽤点的集合V和边的集合E来描述。

即为G(V,E)。

其中V即为我们数据集⾥⾯所有的点(v_1, v_2,...v_n)。

对于V中的任意两个点,可以有边连接,也可以没有边连接。

我们定义权重w_{ij}为点v_i和点v_j之间的权重。

由于我们是⽆向图,所以w_{ij} = w_{ji}。

对于有边连接的两个点v_i和v_j,w_{ij} > 0,对于没有边连接的两个点v_i和v_j,w_{ij} = 0。

对于图中的任意⼀个点v_i,它的度d_i定义为和它相连的所有边的权重之和,即d_i = \sum\limits_{j=1}^{n}w_{ij} 利⽤每个点度的定义,我们可以得到⼀个nxn的度矩阵D,它是⼀个对⾓矩阵,只有主对⾓线有值,对应第i⾏的第i个点的度数,定义如下:\mathbf{D} = \left( \begin{array}{ccc} d_1 & \ldots & \ldots \\ \ldots & d_2 & \ldots \\ \vdots & \vdots & \ddots \\ \ldots & \ldots & d_n\end{array} \right) 利⽤所有点之间的权重值,我们可以得到图的邻接矩阵W,它也是⼀个nxn的矩阵,第i⾏的第j个值对应我们的权重w_{ij}。

谱聚类的解读

谱聚类的解读

谱聚类是一种基于图论的聚类方法,通过对样本数据的拉普拉斯矩阵的特征向量进行聚类,从而达到对样本数据聚类的目的。

谱聚类可以将高维空间的数据映射

到低维,然后在低维空间用其它聚类算法(如KMeans,c-均值聚类)进行聚类。

谱聚类的思想是将样本看作顶点,样本间的相似度看作带权的边,从而将聚类问题转为图分割问题:找到一种图分割的方法使得连接不同组的边的权重尽可能低(这意味着组间相似度要尽可能低),组内的边的权重尽可能高(这意味着组内相似度要尽可能高)。

谱聚类的优势在于它可以处理复杂的形状和数据结构,而且可以很好地处理噪声和异常值。

此外,谱聚类还可以发现非凸形状的数据群集,并且对于非线性数据的聚类效果也较好。

然而,谱聚类也有一些局限性,例如它对参数的选择很敏感,可能会受到数据规模和数据分布的影响。

总之,谱聚类是一种基于图论的聚类方法,通过对样本数据的拉普拉斯矩阵的特征向量进行聚类,从而达到对样本数据聚类的目的。

它可以处理复杂的形状和数据结构,而且可以很好地处理噪声和异常值。

谱聚类的原理

谱聚类的原理

“哇,这道数学题好难啊!”我正和小伙伴们一起做作业,突然发出了这样的感叹。

大家都凑过来,看着我面前的题目发愁。

这时候,老师走了过来,笑着说:“别着急,遇到难题要慢慢思考。

就像科学家们研究那些复杂的原理一样,只要用心,总能找到解决办法。

”

嘿,你们知道谱聚类吗?这可是个超厉害的东西呢!谱聚类就像是一个神奇的魔法师,能把一堆乱七八糟的东西整理得井井有条。

谱聚类的结构呢,有一些关键的部件。

比如说,有个像指南针一样的东西,能帮我们找到方向,这个在谱聚类里呢,就像是一个重要的公式,它能告诉我们怎么把不同的东西分类。

还有呢,就像我们玩拼图有不同的小块,谱聚类也有一些小块,这些小块可以理解为数据点。

它们组合在一起,通过那个神奇的公式,就能把相似的东西放在一起啦。

谱聚类的主要技术和工作原理是啥呢?哎呀,这就好比我们分水果。

有苹果、香蕉、橘子啥的,我们一看就知道苹果是苹果,香蕉是香蕉。

谱聚类也是这样,它会看这些数据点的特点,然后把相似的放在一起。

它会计算这些数据点之间的距离,近的就放在一起,远的就分开。

就像我们和好朋友走得近,和不认识的人离得远一样。

那谱聚类在生活中有啥用呢?有一次,我和妈妈去超市买东西。

超市里的商品可多啦,有吃的、用的、玩的。

这时候,超市的工作人员就像会谱聚类魔法一样,把同类的商品放在一起。

这样我们找东西就方便多啦!如果没有谱聚类这种方法,那超市不就乱成一锅粥了吗?我们找东西得找半天,多麻烦呀!

谱聚类真的好厉害呀!它能让我们的生活变得更方便。

我觉得谱聚类就像一个超级英雄,默默地为我们的生活带来便利。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

谱聚类

七月算法邹博

2015年11月15日

9月机器学习班2/21

谱和谱聚类

☐方阵作为线性算子,它的所有特征值的全体统称方阵的谱。

⏹方阵的谱半径为最大的特征值

⏹矩阵A 的谱半径:(A T A)的最大特征值

☐谱聚类是一种基于图论的聚类方法,通过对样本数据的拉普拉斯矩阵的特征向量进行聚类,从而达到对样本数据聚类的目的。

9月机器学习班3/21

谱分析的整体过程

☐给定一组数据x 1,x 2,...x n ,记任意两个点之间的相似度(“距离”的减函数)为s ij =<xi,xj>,形成相似度图(similarity graph):G=(V,E) 。

如果x i 和x j 之间的相似度s ij 大于一定的阈值,那么,两个点是连接的,权值记做s ij 。

☐接下来,可以用相似度图来解决样本数据的聚类问题:找到图的一个划分,形成若干个组(Group),使得不同组之间有较低的权值,组内有较高的权值。

9月机器学习班4/21

若干概念

☐无向图G=(V,E)

☐邻接矩阵

☐顶点的度di →度矩阵D (对角阵)

9月机器学习班5/21

若干概念

☐子图A 的指示向量

☐A 和B 是图G 的不相交子图,则定义子图的连接权:

9月机器学习班6/21

相似度图G 的建立方法

☐全连接图

⏹高斯相似度函数:距离越大,相似度越小

☐ε近邻图

⏹给定参数ε

⏹思考:如何选择ε?

☐图G 的权值的均值

☐图G 的最小生成树的最大边

☐k 近邻图(k-nearest neighbor graph)

⏹若vi 的k 最近邻包含vj ,vj 的k 最近邻不一定包含vi :有向图⏹忽略方向的图,往往简称“k 近邻图”

⏹两者都满足才连接的图,称作“互k 近邻图(mutual)”

9月机器学习班

7/21

相似度图G 的举例

9月机器学习班8/21

权值比较

☐ε近邻图:ε=0.3,“月牙部分”非常紧的连接了,但“高斯部

分”很多都没连接。

当数据有不同的“密度”时,往往发生这种问题。

☐k 近邻图:可以解决数据存在不同密度时有些无法连接的问题,

甚至低密度的“高斯部分”与高密度的“月牙部分”也能够连接。

同时,虽然两个“月牙部分”的距离比较近,但k 近邻还可以把它们区分开。

☐互k 近邻图:它趋向于连接相同密度的部分,而不连接不同密度

的部分。

这种性质介于ε近邻图和k 近邻图之间。

如果需要聚类不同的密度,这个性质非常有用。

☐全连接图:使用高斯相似度函数可以很好的建立权值矩阵。

但缺点是建立的矩阵不是稀疏的。

☐总结:首先尝试使用k 近邻图。

9月机器学习班9/21

拉普拉斯矩阵及其性质

☐拉普拉斯矩阵:L = D –W

☐L 是对称半正定矩阵;

☐L 的最小特征值是0,相应的特征向量是☐L 有n 个非负实特征值

9月机器学习班10/21拉普拉斯矩阵的定义

☐计算点之间的邻接相似度矩阵W ⏹若两个点的相似度值越大,表示这两个点越相似;⏹同时,定义w ij =0表示v i ,v j 两个点没有任何相似性(无穷远)☐W 的第i 行元素的和为v i 的度。

形成顶点度对角阵D

⏹d ii 表示第i 个点的度

⏹除主对角线元素,D 其他位置为0☐未正则的拉普拉斯矩阵:L=D-W ☐正则拉普拉斯矩阵⏹对称拉普拉斯矩阵

⏹随机游走拉普拉斯矩阵

☐Random walk

9月机器学习班11/21

谱聚类算法:未正则拉普拉斯矩阵☐输入:n 个点{p i },簇的数目k

⏹

计算n ×n 的相似度矩阵W 和度矩阵D ;⏹

计算拉普拉斯矩阵L=D-W ;⏹

计算L 的前k 个特征向量u 1,u 2,...,u k ;⏹

将k 个列向量u 1,u 2,...,u k 组成矩阵U ,U ∈R n ×k ;⏹

对于i=1,2,...,n,令y i ∈R k 是U 的第i 行的向量;⏹使用k-means 算法将点(y i )i=1,2,...,n 聚类成簇

C 1,C 2,...C k ;

⏹输出簇A 1,A 2,...A k ,其中,Ai={j|y j ∈Ci}

9月机器学习班12/21

谱聚类算法:随机游走拉普拉斯矩阵☐输入:n 个点{p i },簇的数目k

⏹

计算n ×n 的相似度矩阵W 和度矩阵D ;⏹

计算正则拉普拉斯矩阵L rw =D -1(D-W);⏹

计算L rw 的前k 个特征向量u 1,u 2,...,u k ;⏹

将k 个列向量u 1,u 2,...,u k 组成矩阵U ,U ∈R n ×k ;⏹

对于i=1,2,...,n,令y i ∈R k 是U 的第i 行的向量;⏹使用k-means 算法将点(y i )i=1,2,...,n 聚类成簇

C 1,C 2,...C k ;

⏹输出簇A 1,A 2,...A k ,其中,Ai={j|y j ∈Ci}

9月机器学习班13/21

谱聚类算法:对称拉普拉斯矩阵☐输入:n 个点{p i },簇的数目k

⏹

计算n ×n 的相似度矩阵W 和度矩阵D ;⏹

计算正则拉普拉斯矩阵L sym =D -1/2(D-W) D -1/2;⏹

计算L sym 的前k 个特征向量u 1,u 2,...,u k ;⏹

将k 个列向量u 1,u 2,...,u k 组成矩阵U ,U ∈R n ×k ;⏹

对于i=1,2,...,n,令y i ∈R k 是U 的第i 行的向量;⏹

对于i=1,2,...,n,将y i ∈R k 依次单位化,使得|y i |=1;⏹

使用k-means 算法将点(y i )i=1,2,...,n 聚类成簇C 1,C 2,...C k ;

⏹输出簇A 1,A 2,...A k ,其中,Ai={j|y j ∈Ci}

9月机器学习班14/21

一个实例

9月机器学习班15/21

Code

9月机器学习班16/21

聚类效果

9月机器学习班17/21

聚类失败的情况

9月机器学习班18/21

进一步思考

☐谱聚类中的K ,如何确定?

⏹考察计算得到的各个特征值λ:选择k ,使得λ1, λ2,…,λk 很小,而λk+1相对比较大。

☐最后一步的K-Means ,作用是什么?

⏹事实上,目标函数是关于子图划分指示向量的函数,该向量的值根据子图划分确定,是离散的若干值。

但由于问题是NP 的,转换成求连续实数域上的解,最后再用K-Means 的办法离散化。

⏹可以用其他方法代替。

如使用超平面,或者使用k 个特征向量张成的子空间达到同样的目的。

☐未正则拉普拉斯矩阵、对称拉普拉斯矩阵、随机游走拉普拉斯矩阵,首选哪一个?

⏹随机游走拉普拉斯矩阵

☐拉普拉斯矩阵除了通过切割图的方法,可以通过随机游走、扰动论等理论来解释。

9月机器学习班19/21

随机游走和拉普拉斯矩阵的关系

☐图论中的随机游走是一个随机过程,它从一个顶点跳转到另外一个顶点。

谱聚类即找到图的一个划分,使得随机游走在相同的簇中停留而几乎不会游走到其他簇。

☐

转移矩阵:从顶点vi 跳转到顶点vj 的概率正比于边的权值wij

9月机器学习班20/21我们在这里

☐/

⏹视频/课程/社区

☐七月题库APP:Android/iOS

⏹/

☐微博

⏹@研究者July

⏹@七月题库

⏹@邹博_机器学习

☐微信公众号

⏹julyedu

9月机器学习班21/21感谢大家!恳请大家批评指正!。