第四章一维搜索法

3.3 一维搜索方法 (一维优化)

并令: h 2h

x3 x 2 h ,求 y3 f ( x3 )

重复上述步骤,直到函数值出现“高-低-高”为止。

4. 若在步骤2中,出现 y1 y 2 (图a虚线),则应作后退运算: 令:h h0 置换:x3 x1 y 3 y1 ; x1 x2 y1 y2 ;x2 x3 y2 y3 再令:h 2h

2 2 2 2 ( x2 x3 ) f1 ( x3 x12 ) f 2 ( x12 x2 ) f 3 b ( x1 x2 )( x2 x3 )( x3 x1 )

教材中,c的表达式缺-号

c

( x3 x2 ) x2 x3 f1 ( x1 x3 ) x1 x3 f 2 ( x2 x1 ) x1 x2 f 3 ( x1 x2 )( x2 x3 )( x3 x1 )

入口

x

(0),ε

X

(1)=x(0)-f/x(0)/f//x(0)

∣f/x(1)∣≤ε 或∣x(1)-x(0)∣≤ε ?

x

(*):=x (1)

x

(0):=x (1)

出口

4 3 2 例: 试用牛顿法求 f ( x) 1 x 2 x 2 x 7 x 8 4 3 值,已知探索区间为[a,b]=[3,4],ε=0.05。

4、牛顿法的特点 优点:收敛速度较快 缺点: 1)计算f’ 、f’’,计算工作量大。 2)用数值微分计算f’ 、f’’时,舍入误差会影响收敛速度。 3)x0与 x不能离太远,否则会发散或收敛于非极小点。 与0.618法比较: 0.618 法:1)收敛慢 2)对函数要求不严格 牛顿法正好相反。

5、牛顿法的框图

x3 x 2 h

3. 若 y 2 y1 ,应作前进运算(图a实线):

一维搜索的最优方法(黄金分割法)

( 1 )= ( 2 )=0.264, f1=-1.125

新点 ( 2 )=a 0.618( b a )=0.354, f 2=f ( ( 2 ) ) =-1.103 (4) 比较函数值,缩短搜索区间 f1 f 2 a 0.118, b ( 2 ) 0.354 判断迭代终止条件: b - a 0.354 0.118 0.236 继续缩短

区间为[a, b] [-0. 5,0.5],取迭代精度=0.15。

解:(1) 在初始区间[a, b]内取点并计算函数值。

( 1 )=b 0.618( b a )= 0.118, f1=f ( ( 1 ) ) =-0.854 ( 2 )=a 0.618( b a )=0.118,

( 1 )=b 0.618( b a ) ( 2 )=a 0.618( b a )

计算f ( ( 1 ) )和f ( ( 2 ) ),令f ( ( 1 ) ) f1 , f ( ( 2 ) ) f 2

( 2 ) 比较函数值,缩小搜索区间 a. f1 f 2 ,则丢掉区间( ( 2 ) ,b ] 部分,取[ a , ( 2 ) ]为 新区间[ a1 , b1 ],在计算中作置换:

(2)+h (3)。计算( ),令( ) f3 f f

(3) (3)

(1) 若f 3 f1,则[a,b]=[(3) ,(2)],停止计算。 (2) 若f 3 f1,则 2h h,(2) (1),f 2 f1,

(3) (2),f 3 f 2 (2) h (3),计算( ),令( ) f3 , f f

h 2 1 2 1= 2=1,

2= 3=2 , 3= 2 h=4

第4章 一维搜索法

三、单谷区间与单谷函数

由于以后要介绍的一些维搜索方法,主要 适用于问题(4.3)在搜索区间中只有唯一的最 优解的情况,为此,我们再给出下面单谷区间 与单谷函数概念.

三、单谷区间与单谷函数

由于以后要介绍的一些维搜索方法,主要适 用于问题(4.3)在搜索区间中只有唯一的最优 解的情况,为此,我们再给出下面单谷区间与 单谷函数概念. 定义4.2 ,闭区间 [a, b] ⊂ R1.若存在 定义4.2 设 ϕ : R1 → R1 * ϕ( t * ∈ [a, b],使得ϕ (t ) [a, t ]上严格递减, t ) 在 点 在 [t * , b上严格递增,则称 [a, b] 是函数 ϕ (t ) 的单谷区 ] 单谷区 单谷函数. 间,ϕ (t ) 是 [a, b] 上单谷函数 单谷函数 由定义4.2易知,一个区间是某函数的单谷区间 意味着,在该区间中函数

0≤t ≤t max

0≤t ≤t max

min ϕ (t )

若存在闭区间 [a, b] ⊂ [0, + ∞)([a, b] ⊂ [0, t max ]) , 使 t * ∈ [ a, b,则称 [a, b] 是问题(4.3)的搜索区间. ] 定义4.1简言之,一个一维最优化问题的搜索区间, 就是包含该问题最优解的一个闭区间.通常,在进行 一维搜索时,一般要先确定出问题的一个搜索区间, 然后再此区间中进行搜索求解.

第四章 一维搜索法

由第一章关于求解最优化问题概述中我们知道, 从已知迭代点 出发按照基本迭代格式 X k ∈ Rn X k +1 = X k + t k Pk 来求解最优化问题,其关键在于如何构造一个 搜索方向 和确定一个步长 R n ,使下 Pk ∈ X k +1 tk ∈ 一迭代点 R 1 处的目标函数值下降, 即 f ( X k +1.现在我们来讨论,当搜索 ) < f (X k ) 方向 已经确定的情况下,如何来确定步长 ? Pk tk 步长因子的选取有多种方法,如取步长为常数, 但这样选取的步长并不最好,如何选取最好步 长呢?实际计算通常采用一维搜索来确定最优 步长.

常用一维搜索算法

无约束优化:不对定义域或值域做任何限制的情况下,求解目标函数的最小值。

这是因为实际应用中,许多情形被抽象为函数形式后均为凸函数,对于凸函数来说局部最小值点即为全局最小值点,因此只要能求得这类函数的一个最小值点,该点一定为全局最小值。

(直接法:又称数值方法,它只需计算目标函数驻点的函数数值,而不是求其倒数,如坐标轮换法,单纯型法等。

间接法:又称解析法,是应用数学极值理论的解析方法。

首先计算出目标函数的一阶或一阶、二阶导数,然后根据梯度及海赛矩阵提供的信息,构造何种算法,从而间接地求出目标函数的最优解,如牛顿法、最速下降法共轭梯度法及变尺度法。

)在优化算法中保证整体收敛的重要方法就是线搜索法与信赖域法,这两种算法既相似又有所不同。

根据不同的线搜索准则就延伸出不同的线搜索算法,譬如比较常见和经典的最速下降法,牛顿法,拟牛顿法以及共辄梯度法等。

一维搜索又称线性搜索(Line Search),就是指单变量函数的最优化,它是多变量函数最优化的基础,是求解无约束非线性规划问题的基本方法之一。

一维搜索技术既可独立的用于求解单变量最优化问题,同时又是求解多变量最优化问题常用的手段,虽然求解单变量最优化问题相对比较简单,但其中也贯穿了求解最优化问题的基本思想。

由于一维搜索的使用频率较高,因此努力提高求解单变量问题算法的计算效率具有重要的实际意义。

在多变量函数的最优化中,迭代格式X k+1=X k+a k d k其关键就是构造搜索方向d k和步长因子a k设Φ(a)=f(x k+ad k)这样从凡出发,沿搜索方向d k,确定步长因子a k,使Φ(a)<Φ(0)的问题就是关于步长因子a的一维搜索问题。

其主要结构可作如下概括:首先确定包含问题最优解的搜索区间,然后采用某种分割技术或插值方法缩小这个区间,进行搜索求解。

一维搜索通常分为精确的和不精确的两类。

如果求得a k使目标函数沿方向d k达到极小,即使得f (x k+a k d k)=min f (x k+ ad k) ( a>0)则称这样的一维搜索为最优一维搜索,或精确一维搜索,a k叫最优步长因子;如果选取a k使目标函数f得到可接受的下降量,即使得下降量f (x k)一f (x k+a k d k)>0是用户可接受的,则称这样的一维搜索为近似一维搜索,或不精确一维搜索,或可接受一维搜索。

《一维搜索方法》课件

1

原理

根据斐波那契数列生成黄金分割比例,用于确定搜索范围的分割点。

2

思路

根据斐波那契数列的值,确定左右指针在搜索范围内的位置,直到找到最接近目 标值的点。

3

优缺点

迭代次数逐渐趋近于黄金分割点,但对搜索范围要求较高。

黄金分割法搜索方法的原理和思路

1

原理

将搜索范围按黄金分割点分割,选择较小的一部分作为新的搜索范围。

2

思路

通过反复按黄金分割点计算和调整搜索范围,逐步逼近最接近目标值的点。

3

优缺点

迭代次数相对较少,但需要较复杂的计算公式。

三分搜索方法的原理和思路

1

原理

将搜索范围分割为三等份,并判断目标值位于左、中、右三个部分,逐步缩小搜索范 围。

2

思路

根据目标值与分割点的大小关系,决定下一步搜索的范围,直到找到最接近目标值的 点。

3

优缺点

对于非单调函数,能更快地找到目标值,但需要较多的判断。

多点搜索方法的原理和思路

1

原理

同时使用多个起始点进行搜索,通过不断比较找到最接近目标值的点。

2

思路

根据多个起始点的初始值和搜索步长,逐步调整并比较得到最优解。

3

优缺点

相比于单点搜索,能更准确地找到目标值,但需要同时处理多个起始点的迭代。

2

思路

从起始点开始,依次向右增加或向左减小搜索范围,直到找到最接近目标值的点。

3

优缺点

简单易懂,但需要较多的迭代次数。

二分搜索方法的原理和思路

1

原理

将搜索范围一分为二,并判断目标值位于左半部分还是右半部分,逐步缩小搜索 范围。

2

思路

《一维搜索方法》课件

02

线性搜索

线性搜索的定义

线性搜索是一种基本的搜索算法,它 从列表的第一个元素开始,逐个检查 每个元素,直到找到目标元素或遍历 完整个列表。

在线性搜索过程中,我们假设列表中 的元素是按顺序排列的,并且我们不 知道目标元素的确切位置,只知道它 存在于列表中。

线性搜索的步骤

初始化

选择一个起始位置,通常为列表的第一个元素。

抛物线搜索的步骤

3. 比较中间元素与目标值

2. 计算当前区间的中间元 素。

1. 初始化当前搜索区间为 整个数组。

01

03 02

抛物线搜索的步骤

01 如果中间元素等于目标值,返回该位置。

02

如果目标值小于中间元素,将左半部分区 间作为新的当前区间。

03

如果目标值大于中间元素,将右半部分区 间作为新的当前区间。

04

4. 重复步骤2和3,直到找到目标值或当前 区间为空。

抛物线搜索的时间复杂度

最坏情况下,抛物线搜索的时间复杂度为O(n),其中n为数 组长度。

平均情况下,由于每次比较都可以将搜索区间缩小一半,因 此时间复杂度为O(log n)。

THANKS

THANK YOU FOR YOUR WATCHING

的单峰函数。

一维搜索方法的重要性

解决实际问题

一维搜索方法广泛应用于各种实 际问题中,如参数优化、函数逼 近、插值等。

算法基础

一维搜索方法是许多算法的基础 ,如梯度下降法、牛顿法等都需 要用到一维搜索方法来寻找迭代 步长。

理论分析

一维搜索方法在数学分析中也有 重要应用,如中值定理、单调函 数性质等都需要用到一维搜索方 法。

常用的一维搜索方法

线性搜索

一维搜索-最优化方法

止 ; 否则 , ������0 = ������1 ,转(2) 。

例题:用切线法求Ψ(t) =������2-5t+2 , 在定义域 t ∈ ( 0 , 10 ) 上的极小点 , 要求 ε = 0.2 。

切线法(Newton法)

设Ψ(t)是区间(a , b)上的二次可微的单谷函数,������∗ 是 Ψ(t) 在 (a , b)上的极小值点, ������������ 是 ������∗ 的一个近似点。 目标 函数Ψ(t) 的一阶导数为������ = Ψ’(t) ,过点 (������������, Ψ’(������������) ) 作导函数 Ψ’(t) 的图像的切线,则此切线的方程为

在实践工作中,应根据问题的具体特点以及工作条 件来选用相应的合适算法。不过,从以往的实践中 来看,0.618法和对分法使用的更多一些。

可望达到上述的最小值,

所以有 c-a = b-c , 即 c = 0.5(b-a)

对分法的步骤

设单谷函数 Ψ(t)存在导函数Ψ’(t),极小值点的初始搜索 区间为(a。,b。),要求极小值点的近似值 ������ҧ 与精确极小值 点 t* 的最大绝对误差 ������ − ������ ∗ ҧ 不超过 ε 。

⑴ 令 a=a。 , b=b。;

⑵ 令 c = 0.5(b-a),计算Ψ’(c);

⑶ 若 Ψ’(c)ຫໍສະໝຸດ <0 ,令 a=c , 转到⑷

若 Ψ’(c)>0 ,令 b=c ,转到⑷

维搜索

四、切线法

当函数f(X(k)+S(k))在搜索 区间内存在连续一阶导数, 且二阶导数大于零时,可用 切线来逼近曲线,以求得最 优步长*——切线法。

在搜索区间[a,b]内选取初始点(0) ,过曲线上的对应 点[(0),f’((0)) ]作曲线的切线,方程:

二.黄金分割法(0.618法)

区间内的两个中间插入点

x1 a 1 b a

x2 a b a

2 1

二.黄金分割法(0.618法)

1

2

5 1 0 618 2 x1 a 0 382b a x2 a 0 618b a

②采用缩小区间或插值逼近的方法逐步得到最优步 长和一维极小点。

一、区间估计

在搜索区间内,被搜索的函数必须是凸性函数 (单 峰函数 )—— 在函数极小点左侧,函数值严格下降; 在函数极小点右侧,函数值严格上升。 进退算法 基本思想:

“进一步,退两步”

进退算法程序框图

二.黄金分割法(0.618法)

MATLAB简介

矩阵的行列式值: d=det(A) 矩阵的逆矩阵: X=inv(A) 向量的模: x=norm(g)

2

F ( X ) 156 52 27

§3 一维搜索

从点X(k)出发,在方向S(k)上的一维搜索用数学式表 达为

min f X

k

S

k

f X

k

k S

k

X k 1 X k k S k

一维搜索分两步进行: ①在方向S(k)上确定一个包含极小点的初始区间;

线搜索算法_一维搜索

k 1 k搜索成功 , 步骤3:若 , 转步骤4;否则,搜索失败,

转步骤5。

步骤4: k : k 1 ,

停止迭代 。

h : 2h, k k 1 转步骤 2。

步骤5:反向搜索,若 k 0, 令 h h ,转步骤2;否则

一、精确一维搜索—初始区间 例 1:利用进退法求函数 f ( x) x3 2 x 1 的搜索区间, 1 1 取初始点 ,步长 x h . 2 2 解: 1 15 1 1 f ( x) f ( ) , f ( x h) f ( ) f (0) 1, 2 8 2 2 因为f ( x) f ( x h),搜索成功,步长加倍; 1 1 计算 f ( x h+2h) f ( x 3h) f ( 3 ) f (1) 0, 2 2 搜索成功,步长加倍; 因为f ( x h) f ( x 3h),

一、精确一维搜索—初始区间 确定初始区间的方法---进退法 ① 已知搜索起点和初始步长; ② 然后从起点开始以初始步长向前试探,如果函数值 变大,则改变步长方向; ③ 如果函数值下降,则维持原来的试探方向,并将步 长加倍。

一、精确一维搜索—初始区间

进退法算法流程

步骤1:选取初始点 x∈R , 初始步长 h > 0 及精度ε> 0,计算 0 f ( x). 并记 k : 0 步骤2:令 k 1 k h , 计算 k 1 f (k 1 ).

一、一维搜索—分类 非精确的一维搜索:通过计算少量的函数值,得到一 步长 k ,使得后续迭代点 xk 1 x k k d k 满足

f ( xk 1 ) f ( xk ) ,即使目标函数要“充分”下降。

Goldstein准则 Armijo准则 Wolfe准则

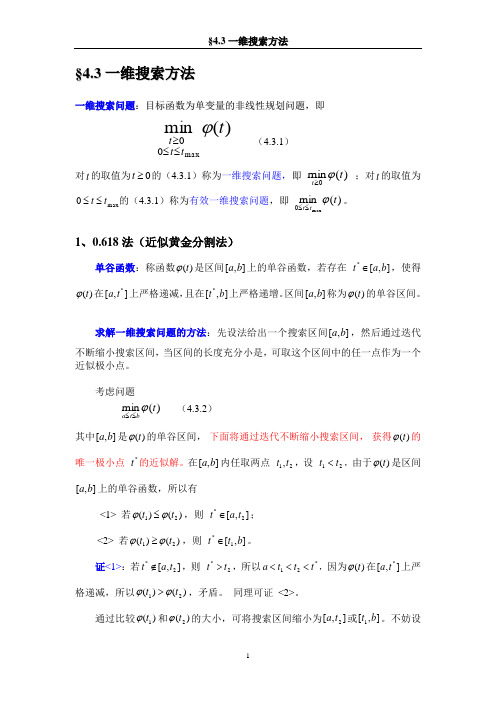

§4.3 一维搜索方法

§4.3 一维搜索方法一维搜索问题:目标函数为单变量的非线性规划问题,即)(min max00t t t t ϕ≤≤≥ (4.3.1)对t 的取值为0≥t 的(4.3.1)称为一维搜索问题,即 )(min 0t t ϕ≥ ;对t 的取值为max 0t t ≤≤的(4.3.1)称为有效一维搜索问题,即 )(minmax0t t t ϕ≤≤。

1、0.618法(近似黄金分割法)单谷函数:称函数)(t ϕ是区间],[b a 上的单谷函数,若存在 ],[*b a t ∈,使得)(t ϕ在],[*t a 上严格递减,且在],[*b t 上严格递增。

区间],[b a 称为)(t ϕ的单谷区间。

求解一维搜索问题的方法:先设法给出一个搜索区间],[b a ,然后通过迭代不断缩小搜索区间,当区间的长度充分小是,可取这个区间中的任一点作为一个近似极小点。

考虑问题)(min t bt a ϕ≤≤ (4.3.2)其中],[b a 是)(t ϕ的单谷区间, 下面将通过迭代不断缩小搜索区间, 获得)(t ϕ的唯一极小点 *t 的近似解。

在],[b a 内任取两点 21,t t ,设 21t t <,由于)(t ϕ是区间],[b a 上的单谷函数,所以有<1> 若)()(21t t ϕϕ≤,则 ],[2*t a t ∈;<2> 若)()(21t t ϕϕ≥,则 ],[1*b t t ∈。

证<1>:若],[2*t a t ∉,则 2*t t >,所以*21t t t a <<<,因为)(t ϕ在],[*t a 上严格递减,所以)()(21t t ϕϕ>,矛盾。

同理可证 <2>。

通过比较)(1t ϕ和)(2t ϕ的大小,可将搜索区间缩小为],[2t a 或],[1b t 。

不妨设为],[2t a ,则在],[2t a 只需另找一个点 2t ',比较 1t 和2t '的目标函数值,又可以进一步缩小搜索区间。

一维搜索

xk 2 xk 1 , ( xk 2) ( xk 1 )

xk 2 是新搜索区间 [ak 1, bk 1] 的黄金分割点的对称点。

(2)计算保留试点的对称点——新搜索区间黄金分割点:

xk 2 ak 1 0.618 bk 1 ak 1), ( 及 算 ( xk 2). 计

(k ) 则在 x 附近可用 (x) 来近似 f (x)

1 f ( x ( k ) )( x x ( k ) ) 2 2

22

3.5.3 牛顿法

因此,可用 (x) 的极小点来近似 f (x) 的极小点。故求 (x)的驻 点 x ( k 1) : 令 ( x) 0 ,得

(3.5.19) 以 (x)的驻点 x ( k 1)作为 f (x) 在 x (k ) 附近的极小点的k+1级估计值。 同理,如果在 x ( k 1)点将 f (x)作二阶泰勒展开。在 x ( k 1)点 附近用二阶泰勒多项式近似 f (x) ,可得

( x1)及 ( x1 )

并令:k:=0.

ak 1 ak , bk 1 xk 1

9

(3.5.10)

b0 a 0

3.5.1 黄金分割法

1 (ak 1 bk 1) 为近似极小点, (* ) 2 则计算新的一对试点:

*

为近似极小值,否

(1)保留试点的计算

f ( x) f ( x

(k )

) f ( x

(k ) 2

(k )

)(x x

(k )

1 ) f ( x ( k ) )(x x ( k ) ) 2 2

O( x x

)

记 ( x) f ( x ( k ) ) f ( x ( k ) )( x x ( k ) )

一维搜索插值法

外

-

推

法

程

序

框

图

二、区间消去法原理

由外推法确定搜索区间[a,b]后,在区间 内插入两点a1和b1(a<a1<b1<b),计算 插入点的函数值,并比较其大小,确定消去 的区间,从而得到缩短的搜索区间,依次类 推,最后即可得到理论最小点的近似解。

•基本思想

取原函数极小点的一个近似点,在近似点附近用二次函数 (泰勒展开并保留到二次项)逼近原函数,以逼近函数的极 小点作为原极小点的新近似点,依此类推,直到近似点满足控 制误差为止,取最后的近似点作为原函数的极小点。

•迭代公式

•几何解释

特 点

收敛速度快 计算工作量大 对初始点的选择

黄 金 分 割 法 的 程 序 框 图

第四节 一维搜索的插值法

1、插值方法与试探方法的比较

2、函数逼近法

将搜索区间内的若干试验点的函数值构造的 低次多项式(二次多项式)作为函数的近似 表达式,用这个多项式的极值作为原函数的 极值点的近似点。 3、二次多项式逼近原函数的方法

牛顿法和抛物线法

一、牛顿法(切线法)

采用点距准则(前后两个插值点的距离不 超过误差限):

初始搜索区间[2,8],迭代精度ε=0.01, 收敛条件: |ap-a2|<ε。

1.计算初始点及其函数值 2.计算插值点

3.判断收敛条件

4.缩短搜索区间

5.重新计算插值点 6.判断收敛条件,得最优解

二 次 插 值 法 程 序 框 图

补充说明——区间端点换名方法:

2、运用区间消去法,求极小点 。

一、确定初始搜索区间的外推法(进退法) 正向搜索外推法

第四章一维搜索(补充)解析

黄金分割法适用于单谷函数。

2020/8/11

Southeast University 东南大学

的极小点。

2020/8/11

Southeast University 东南大学

3

从理论上讲, k 应满足:

d

d k 0.

求解 k 近似值的方法主要可分为两类:一类为区间收缩法;一类为函数逼近法。

区间收缩法(试探法):按某种方式找试探点,通过一系列试探点来确定极小点。 黄金分割法、Fibonacci法、进退法——试探法

5

4.2.1 单谷函数及其性质

定义 4.2.1 设函数 :R1 R2 ,闭区间 a0 ,b0 R1,若存在点 * a0 ,b0 ,使

在 a0 ,* 上严格递减,在 *,b0 上严格递增,则称 为 a0 ,b0 上的单谷函数, a0 ,b0

为 的单谷区间,见下图。

O a0

*

b0

即都可使函数值下降。即 pk 是下降方向,这里 0 0 ,max 如果仔细分析,可看出,

当 0 ,k 时,函数 f xk pk 是下降的;当 k ,max 时,函数 f xk pk 是上升的,称这样的函数为单谷函数。因此若记 f xk pk ,则 k 是一元函数

函数逼近法(插值法):用某种较简单的曲线逼近本来的函数曲线,通过求逼近 函数的极小点来估计目标函数的极小点。

牛顿法、割线法、抛物线法、三次插值法、有理插值法——函数逼近法

2020/8/11

Southeast University 东南大学

1 sun 第4章 非线性规划02-一维搜索教程

Ludong University

16

牛顿法的计算步骤:

给定初始点 t1 ,控制误差 ,并令k=1。 1)计算 f tk

2)求 3)若

f tk

tk tk 1 tk tk

tk 1 tk

* t tk 1 ,停止计算, 则求得近似解

第四章 非线性规划

基本概念 凸函数和凸规划

一维搜索方法

无约束最优化方法 约束最优化方法

0.618法(黄金分割法) Newton 法

2018/10/6

Ludong University

5

一维搜索方法

一维搜索问题又称为线性搜索问题,它是指目 标函数为单变量函数的非线性规划问题,它是多 变量函数最优化的基础。 按照求解问题的不同原则,算法分为两类: 精确一维搜索及非精确一维搜索。

Ludong University 19

2018/10/6

3.Newton’s Method

If we want to minimize g(x), we should find a point xk+1 such that

g‘(xk+1) = f ‘(xk)+f ‘‘(xk)(xk+1−xk)=0, i.e. xk+1= xk − f ‘(xk) / f ‘‘(xk).

f(x)

14.2 14.190028 14.189996 14.189996 14.189996

f'(x)

-0.25 -0.01372 -4.7E-05 -5.4E-10 0

f''(x)

3.25 2.902098 2.882374 2.882307 2.882307

机械优化设计方法第四章 一维搜索

一、消去法 的基本原理 消去法的基 本思路是:逐步 缩小搜索区间, 直至最小点存在 的范围达到允许 的误差范围为止。 设一元函数 f(α)如图4-8所 示,起始搜索区 间为[a,b],α* 为所要寻求的函 数的极小点。

4-3 黄金分割法பைடு நூலகம்

在搜索区间[a,b]内任取两点α(1)与α(2),且a<α(1)<α(2)<b, 计算函数f(α(1))与f(α(2))。当将f(α(1))与f(α(2))进行比较时,可 能的猜况有下列三种: (1) f(α(1))<f(α(2)):如图4-8(a)、(b)所示,这种情况下。 可丢掉[α(2),b]部分。而最小点α*必在区间[a,α(2)]内。 (2) f(α(1))>f(α(2)):如图4-8(c)、(d)所示,这种情况下, 可丢掉[a,α(1)]部分,而最小点α*必在区间[α(1),b]内。 (3) f(α(1))=f(α(2)):如图4-8(e)所示,这种情况下,不论 丢掉[a,α(1)]还是丢掉[α(2) ,b],最小点α*必在留下的部分内。 因此,只要在搜索区间内任取两点,计算它们的函数值 并加以比较之后,总可以把搜索的区间缩小。这就是消去 法的基本原理。

对于第(1)、(2)两种情况,经过缩小的区间内都保存了一 个点的函数值,即f(α(1))或f(α(2)),只要再取一个点α(3) ,计 算函数值f(α(3))并进行比较,就可以再次缩短区间进行序 列消去。但对于第(3)情况,区间[α(1),α(2)]中没有已知点的 函数值,若再次缩短区间必须计算两个点的函数值。为了 简化迭代程序,可以把第(3)种情况合并到前面(1)、(2)两 种情况之一中去,例如可以把上述三种情况合并为下述两 种情况: (1) 若f(α(1))≤f(α(2)),取区间[a,α(2)] (2) 若f(α(1))>f(α(2)),取区间[α(1),b]。 这样做虽然对于原第(3)种情况所取的区间扩大了,但在 进一步搜索时每次只要计算一个点,和第(1)、(2)种情况 一致,简化了迭代程序。

最优化方法-一维搜索法

搜索区间及其确定方法

• 加步探索法算法的计算步骤: • (1) 选取初始数据.选取初始点 t0 [0, ) (或 t0 [0, tmax ]),

计算0 (t0 ), 给出初始步长h0 0, 加步系数 1,令 k 0 • (2) 比较目标函数值.令 tk 1 tk hk计算 k1 (tk1) ,

方向 Pk 之间应满足

f (Xk1)T Pk 0

4.2

• 事实上,设 (t) f ( X k tPk ), 对 t 求导有

(t) f (X k tPk )T Pk

• 令 '(t) 0, 即 f (X k tPk )T Pk 0 所以 f (X k1)T Pk 0

这一准则对于定义域上的凸函数是完全正确的.若是非凸函数,有 可能导致误把驻点作为最优点。 对于约束优化问题,不同的优化方法有各自的终止准则.

• 定义3.3 当一个算法用于n元正定二次函数求最优 解时,可以从任意初始点出发,至多经过n步迭 代求出最优解,就称此算法具有二次终止性。

• 如果算法具有二次终止性,则认为算法比较好。 • 二次终止性仅仅是判断一个算法优劣的衡量标准

存在

,且

,则称[t1 t2]是函数(t)

的最优解 的一个搜索区间。

搜索区间及其确定方法

•单峰区间和单峰函数有如下有用的性质: •定理3.1 设 : R1 R1, [a, b] 是的单峰区间,任取

t1, t2 [a, b] 并且 t2 t1 . (1)若有 (t2 ) (t1) ,则 [a, t1 ]是(t) 的单峰区间. (2)若有 (t2 ) (t1) ,则[t2 , b]是(t)的单峰区间.

一维搜索的最优方法(黄金分割法)

05 黄金分割法的应用举例

在函数优化中的应用

一元函数优化

黄金分割法可用于一元函数的极值求解,通过不断缩小搜索区间来逼近最优解。

多元函数优化的辅助手段

在多元函数优化中,黄金分割法可作为辅助手段,用于一维搜索或线搜索过程。

在工程问题中的应用

结构设计优化

在结构设计中,黄金分割法可用于寻 找最优的结构参数,如梁、柱的截面 尺寸等,以实现结构性能和经济性的 平衡。

二分法每次迭代将搜索区间减半,而黄金分割法每次迭代将搜索区间缩小为原来的约 0.618倍。在收敛速度上,二分法通常比黄金分割法更快。但二分法要求函数在搜索区间 内连续且单调,而黄金分割法则没有这样的限制。

与牛顿法相比

牛顿法是一种基于导数信息的搜索方法,具有较快的收敛速度。但在一维搜索问题中,当 导数信息不可用或难以获取时,黄金分割法则更为适用。此外,牛顿法对初始点的选择较 为敏感,而黄金分割法则相对稳健。

解决一维搜索问题的方法有多种,其中黄金分割法是一种较为常用且有效的方法。

黄金分割法简介

黄金分割法是一种通过不断缩小搜索 区间来逼近函数极小值点的方法。

黄金分割法具有简单、快速、稳定等 优点,适用于单峰函数的一维搜索问 题。

它在每次迭代中,通过比较区间两个 端点处的函数值,来确定下一步的搜 索区间。

黄金分割点

在一条线段上,按照黄金分割比 例将线段分割成两部分,分割点

即为黄金分割点。

函数图像

对于一元函数,可以将其图像视 为一条曲线。黄金分割法通过不 断在曲线上选取试探点来逼近最

优解。

搜索区间缩小

每次迭代后,根据试探点的函数 值比较结果,将搜索区间缩小,

使得下一步的搜索更加精确。

黄金分割法的算法步骤

一维搜索方法

一维搜索方法:(方法比较)“成功—失败”法、二分法、0.618法(黄金分割法)、牛顿法、二次插值法、D.S.C法、Powell法、D.S.C—Powell组合法。

1、“成功—失败”法:主要思想:从一点出发,按一定的步长搜索新点,若成功,加大步长继续搜索,否则,缩短步长小步后退。

此方法可以求最优解所在区间,称为“搜索区间”。

2、二分法:主要思想:区间[a,b]的中间值x0,判断f(x)的导数在三个点处的值,舍去一部分区间再求f(x)的极小值。

3、0.618法:等比例收缩原则,每次留下来的区间长度是上次留下来的区间长度的w倍。

以及对称原则、去坏留好原则。

W=0.6184、牛顿法:基本思想:在极小值点附近用目标函数的二阶泰勒多项式近似代替目标函数,从而求得目标函数的极小值点的近似值。

5、二次插值法:牛顿法是在x k附近的目标函数用泰勒多项式近似代替,而此法是将f(x)用二次插值多项式p(x)近似代替。

把p(x)的极小值点作为f(x)极小值点的代替,从来求得函数的极小值。

6、D.S.C法:主要思想:利用成功—失败法寻找靠近极小值点的三点,进行二次插值。

优点是:收敛速度快,且不要求函数可微。

7、Powell法:基本思想:在搜索方向开始得到三点x0,x1,x2后,作二次插值,求得最小值x,在四点中去坏留好,在余下的三点中再作二次插值……8、D.S.C—Powell组合法:几种方法比较:D.S.C—Powell组合法是非常好的一种方法,它比任何一个单个方法都好D.S.C—Powell组合法与0.618法比较:D.S.C—Powell法中函数值的计算要比黄金分割法少得多,一般来讲它优于黄金分割法。

但:D.S.C—Powell法不一定能收敛到最优解。

最速下降法与修正牛顿法:对于正定二次函数,牛顿法一步可以求得最优解,对于非二次函数,牛顿法并不能保证有限次求得其最优解,但由于目标函数在极小值的附近近似于二次函数,故当初始点靠近极小值时,牛顿法收敛的速度比较快。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第四章 一维搜索法由第一章关于求解最优化问题概述中我们知道,从已知迭代点n k R X ∈出发按照基本迭代公式k k k k P t X X +=+1来求解最优化问题,其关键在于如何构造一个搜索方向n k R P ∈和确定一个步长1R t k ∈,使下一迭代点1+k X 处的目标函数值下降,即)()(1k k X f X f <+.现在我们来讨论,当搜索方向k P 已经确定的情况下,如何来确定步长k t ?步长因子的选取有多种方法,如取步长为常数,但这样选取的步长并不最好,如何选取最好步长呢?实际计算通常采用一维搜索来确定最优步长.对无约束最优化问题)(min X f nRX ∈, 当已知迭代点k X 和下降方向k P 时,要确定适当的步长k t 使=+)(1k X f)(k k k P t X f +比)(k X f 有所下降,即相当于对于参变量t 的函数)()(k k tP X f t +=ϕ要在区间],0[∞+上选取k t t =使)()(1k k X f X f <+,即)0()()()(ϕϕ=<+=k k k k k X f P t X f t .由于这种从已知点k X 出发,沿某一下降的探索方向k P 来确定步长k t 的问题,实质上是单变量函数()t ϕ关于变量t 的一维搜索选取问题,故通常叫做一维搜索.按这种方法确定的步长k t 又称为最优步长,这种方法的优点是,它使目标函数值在搜索方向上下降得最多.今后为了简便起见,我们用记号)(1k k k P X ls X ,=+(4.1)表示从点k X 出发沿k P 方向对目标函数)(X f 作直线搜索所得到的极小点是1+k X .其中l 和s 分别是Linear search (直线搜索)两词的词首.在目标函数)(X f 已确定的条件下(4.1)等价于如下两式:⎪⎩⎪⎨⎧+==+=++kk k k tk k t k k k P t X X t tP X f P t X f 1)(min )(min )(,ϕ 下面进一步解释迭代点k k k k P t X X +=+1的空间位置.容易证明,若从k X 出发,沿k P 方向进行一维搜索得极小点k k k k P t X X +=+1,则该点1+=k X X 处的梯度方向)(1+∇k X f 与搜索方向k P 之间应满足0)(1=∇+k T k P X f . (4.2)事实上,设)()(k k tP X f t +=ϕ,对t 求导有k T k k P tP X f t )()(+∇='ϕ. 令0)('=t ϕ,即0)(=+∇k T k k P tP X f ,所以0)(1=∇+k T k P X f .式(4.2)的几何意义是明显的.从某一点k X 出发沿k P 方向对目标函数)(X f 作直线搜索,所得到的极小点为1+k X .式(4.2)指出,梯度)(1+∇k X f 必与搜索方向k P 正交.又因为)(1+∇k X f 与目标函数过点1+k X 的等值面)()(1+=k X f X f 正交,所以进一步看到,搜索方向k P 与这个等值面在点1+k X 处相切(如图4.1所示). §4.1 搜索区间及其确定方法一、搜索区间设一维最优化问题为)(m in max0t t t ϕ≤≤. (4.3)为了求解问题(4.3),我们引入如下的搜索区间概念.定义4.1 设])0[)(0[max **11t t t R R ,,,:∈∞+∈→ϕ,并且 )(min )(max0*t t t t ϕϕ≤≤=,若存在闭区间])0[])([0[][max t b a b a ,,,,⊂∞+⊂使][*b a t ,∈,则称][b a ,是问题(4.3)的搜索区间.简言之,一个一维最优化问题的搜索区间,就是包含该问题最优解的一个闭区间.通常,在进行一维搜索时,一般要先确定出问题的一个搜索区间,然后在此区间中进行搜索求解.二、加步探索法下面,介绍一个确定问题(4.3)的搜索区间的简单方法.这个方法的思想是:先选定一个初始点])0[)(0[max 00t t t ,或,∈⊂∞+∈和初始步长00>h .然后,沿着t 轴的正方向探索前进一个步长,得到新点00h t +.若目标函数在新点处的值是下降了,即)()(000t h t ϕϕ<+,则下一步就从新点00h t +出发加大步长,再向前探索.若目标函数在新点处的 函数值上升,即)()(000t h t ϕϕ>+,则下一步仍以0t 为出发点以原步长开始向t 轴的负方向同样探索.当达到目标函数上升的点时,就停止探索,这时便得到问题(4.3)的一个搜索区间.这种以加大步长进行探索来寻找探索区间的方法叫做加步探索法.加步探索法算法的计算步骤:(1) 选取初始数据.选取初始点])0[)(0[max 00t t t ,或,∈⊂∞+∈,计算)(00t ϕϕ=.给出初始步长00>h ,加步系数1α>,令0=k .(2) 比较目标函数值.令k k k h t t +=+1,计算)(11++=k k t ϕϕ,若k k ϕϕ<+1,转(3).否则转(4).(3)加大探索步长.令k k h h α=+1,同时,令k t t =,1+=k k t t ,1k k ϕϕ+=,1k k =+,转(2).(4) 反向探索.若0=k ,转换探索方向,令1,+=-=k k k t t h h ,转(2).否则,停止迭代,令图4.111min{}max{}k k a t t b t t ++==,,,输出][b a ,. 加步探索法算法的流程图如图4.2所示。

在加步探索法中,一般建议2=α.若能估计问题(4.3)的最优解的大体位置的话,初始点0t 要尽量取接近于问题(4.3)的最优解.在具体运用上述加步探索法时,有时还要考虑一些细节问题.例如,当探索得到新点处的目标函数值和出发点处相同时,以及初始步长应如何选取等,都需作适当处理.三、单谷区间与单谷函数由于以后要介绍的一些维搜索方法,主要适用于问题(4.3)在搜索区间中只有唯一的最优解的情况,为此,我们再给出下面单谷区间与单谷函数概念.定义 4.2 设11R R →:ϕ,闭区间1][R b a ⊂,.若存在点][*b a t ,∈,使得)(t ϕ在][*t a ,上严格递减,()t ϕ在][*b t ,上严格递增,则称][b a ,是函数)(t ϕ的单谷区间,)(t ϕ是][b a ,上单谷函数.图4.2由定义4.2易知,一个区间是某函数的单谷区间意味着,在该区间中函数只有一个“凹谷”(极小值).例如,图4.3中的][b a ,是)(t ϕ的单谷区间,也即)(t ϕ是][b a ,上的单谷函数.图4.4中的][b a ,不是)(t ϕ的单谷区间,即)(t ϕ不是][b a ,上的单谷函数. 另外,从定义4.2还可知,某区间上的单谷函数在该区间上不一定是连续函数,而凸函数在所给区间上必然是单谷函数(如图4.3所示).由定义4.1和定义4.2知,函数)(t ϕ的单谷区间总是相应问题(4.3)的一个搜索区间(如图4.3所示),但反之不然(如图4.4所示).图4.3图4.4单谷区间和单谷函数有如下有用的性质:定理4.1 设][11b a R R ,,:→ϕ是)(t ϕ的单谷区间,任取][21b a t t ,,∈并且12t t <. (1)若有)()(12t t ϕϕ≤,则][1t a ,是)(t ϕ的单谷区间. (2)若有)()(12t t ϕϕ≥,则][2b t ,是)(t ϕ的单谷区间. 证明略.定理4.1说明,经过函数值的比较可以把单谷区间缩短为一个较小的单谷区间.换句话说,利用这个定理可以把搜索区间无限缩小,从而求出极小点.以下介绍的几种,一维搜索方法都是利用这个定理通过不断地缩短搜索区间的长度,来求得一维最优化问题的近似最优解.§4.2 对分法一、对分法基本原理求解一维最优化问题min ()t ϕ一般可先确定它的一个有限搜索区间][b a ,,把问题化为求解问题)(min t b t a ϕ≤≤,然后通过不断缩短区间],[b a 的长度,最后求得最优解.设11R R →:ϕ在已获得的搜索区间][b a ,内具有连续的一阶导数.因为)(t ϕ在][b a ,上可微,故)(t ϕ在][b a ,上连续,由此知)(t ϕ在][b a ,上有最小值. 令0)(='t ϕ,总可求得极小点*t .不妨设)(t ϕ在)(*t a ,上是单减函数;在)(*b t ,上是单增函数.所以)(*t a t ,∈时,0)(<'t ϕ,故0)(<'a ϕ;当)(*b t t ,∈时,0)(>'t ϕ,亦即0)(>'b ϕ.对分法的原理如图4.5所示.二、对分法迭代步骤已知)(t ϕ,)(t ϕ'表达式,终止限ε.(1) 确定初始搜索区间],[b a ,要求'()0'(a b ϕϕ<>,.(2) 计算],[b a 的中点)(21b ac +=.(3) 若0)(<'c ϕ,则c a =,转(4);若0)(='c ϕ,则c t =*,转(5);若0)(>'c ϕ,则c b =,转(4).图4.5(4) 若ε<-||b a ,则)(21*b a t +=,转(5);否则转(2).(5) 打印*t ,结束.对分法的计算流程如图4.6所示.三、对分法有关说明对分法每次迭代都取区间的中点.若这点的导数值小于零,说明0)(='t ϕ的根位于右半区间中(如图4.5所示),因此去掉左半区间;若中点导数值大于零,则去掉右半区间;若中点导数值正好等于零,则该点就是极小点.因为每次迭代都使原区间缩短一半,所以称为对分法或二分法.§4.3 Newton 切线法一、Newton 切线法基本原理设11:R R →ϕ在已获得的搜索区间][b a ,内具有连续二阶导数,求)(min t bt a ϕ≤≤.因为)(t ϕ在][b a ,上可微,故)(t ϕ在][b a ,上有最小值,令0)(='t ϕ. 下面不妨设在区间][b a ,中经过k 次迭代已求得方程0)(='t ϕ的一个近似根k t .过))(,(k k t t ϕ'作曲线)(t y ϕ'=的切线,其方程是))(()(k k k t t t t y -''='-ϕϕ.(4.4)然后用这条切线与横轴交点的横坐标1+k t 作为根的新的近似(如图 4.7所示).它可由方程(4.4)在令0=y 的解出来,即)()(1k k k k t t t t ϕϕ'''-=+.这就是Newton 切线法迭代公式.二、Newton 切线法迭代步骤已知)(t ϕ,)(t ϕ'表达式,终止限ε.(1) 确定初始搜索区间],[b a ,要求'()0'(a b ϕϕ<>,.(2) 选定0t .(3) 计算000'()/"()t t t t ϕϕ=-.(4) 若ε≥-||0t t ,则t t =0,转(3);否则转(5). (5) 打印()t t ϕ,,结束.Newton 切线法的计算流程如图4.8所示.三、Newton 切线法有关说明这种方法如果初始点选得适当,收敛速度很快,通常经过几次迭代就可以得到满足一般精度要求的结果,但是它也有缺点.第一,需要求二阶导数.如果在多维最优化问题的一维搜索中使用这种方法,就要涉及Hesse 矩阵,一般是难于求出的.第二,当曲线)(t y ϕ'=在],[b a 上有较复杂的弯曲时,这种方法也往往失效.如图4.9所示的迭代:210t t t →→,结果2t 跳出],[b a .迭代或者发散,或者找到的根并不是我们想要的结果.第三,即使曲线比较正常,在],[b a 中或者上凹或者下凹,初始点的选取也必须适当.在图 4.10(a )的情况下,曲线上凹,应选点b 作为初始点;而在图4.10(b )的情况下,曲线下凹,应选点a 为初始点.否则都可能失败.图4.7图4.9图4.8图4.10§4.4 黄金分割法一、黄金分割法基本原理要介绍黄金分割法有必要回顾一下古老的黄金分割问题.所谓黄金分割就是将一线段分为二段时,要求整段长L 与较长段x 的比值正好等于较长段x 与较短段x L -的比值(如图4.11所示),即x L xx L -=.于是有022=-+L Lx x ,解出其正根L L x 618.0215≈-=.由此可见长段的长度应为全长的0.618倍,而短段的长度应为全长的0.382倍.因为古代的人们认为按0.618的比率来分割线段是最协调,胜似黄金,故称之为黄金分割.图4.11用黄金分割法进行一维搜索,其基本思想是在单谷区间][b a ,内适当插入两点21t t ,,由此把区间][b a ,分为三段,然后再通过比较这两点函数值大小,就可以确定是删去最左段还是最右段,或者同时删去左右两段保留中间段.如此继续下去可将单谷区间无限缩小.二、黄金分割法迭代步骤现在提出一个问题,就在][b a ,上如何选取二点21t t ,使得迭代次数最小而区间缩短最快?要解决这个问题,人们想到对区间][b a ,选二点21t t ,等价于将区间长度a b -进行黄金分割,也就是将第一个搜索点1t 取在][b a ,的0.618处,第二个搜索点2t 取成1t 的对称点即][b a ,的0.382处(如图4.12所示),亦即)(618.01a b a t -+=, )(382.02a b a t -+=.计算)(1t ϕ与)(2t ϕ的值,并根据)(1t ϕ与)(2t ϕ的值的大小关系分情况讨论:(1) 若)()(21t t ϕϕ<,说明1t 是好点,于是把区间][2t a ,划掉,保留][2b t ,,则][2b t ,内有一保留点1t ,置新的区间][][211b t b a ,,=; (2)若)()(21t t ϕϕ>,说明2t 是好点,于是应将][1b t ,划掉,保留][1t a ,,则][1t a ,内有保留点2t ,置新的区间][][111t a b a ,,=. (3)若)()(21t t ϕϕ=,则应具体分析,看极小点可能在哪一边再决定取舍.在一般情况下,可同时划掉][2t a ,和][1b t ,,仅保留中间的][12t t ,,置新的区间][][1211t t b a ,,=. 接下来是在留下的区间][11b a ,内找好点.重复上面的步骤,直到搜索区间][i i b a ,小于给定的允许误差0>ε为止.这样就得到黄金分割法迭代算法:已知)(t ϕ,常数β=0.382,终止限ε.(1)确定)(t ϕ的初始搜索区间][b a ,. (2)计算)()(222t a b a t ϕϕβ=-+=,.(3)计算1211()t a b t t ϕϕ=+-=,. (4) 若ε<-||21t t ,则打印221*t t t +=,结束;否则转(5).(5) 判别是否满足21ϕϕ≤:若满足,则置12122ϕϕ===,,t t t a ,然后转(3);否则,置)()(22221211t a b t t t t b ϕϕβαϕϕ=-+====,,,,,然后转(4).黄金分割法算法流程如图4.13所示.三、黄金分割法有关说明黄金分割法是通过所选试点的函数值而逐步缩短单谷区间来搜索最优点*t .该方法适用于单谷区间],[b a 上的任何函数,甚至可以是不连续函数,因此这种算法属于直接法,适用相当广泛.图4.12§4.5 抛物线插值法一、抛物线插值法基本原理 考虑一维搜索问题)(min 21t t t t ϕ≤≤,假设其中)(t ϕ是定义在区间][21t t ,上的单谷函数.首先用试探法在][21t t ,上找一点0t ,使之满足)()()()(0201t t t t ϕϕϕϕ≥≥,.通过目标函数曲线上的三个点))(())(())((220011t t t t t t ϕϕϕ,,,,,,作它的二次拟合曲线(如图4.14所示)2210)(t a t a a t P ++=.)图4.13图4.14 由于上述三个点既是目标函数曲线)(t ϕ上的点,又是二次拟合曲线)(t P 上的点,故有方程组⎪⎩⎪⎨⎧=++==++==++=.,,)()()()()()(222221020202010012121101t t a t a a t P t t a t a a t P t t a t a a t P ϕϕϕ(4.5)将方程组(4.5)中的0a 消去,得 22110210102210220202()()()()()()()()a t t a t t t t a t t a t t t t ϕϕϕϕ⎧-+-=-⎪⎨-+-=-⎪⎩,. (4.6)从方程组(4.6)可解出待定系数))()(()()()()()()(1220012202102122122201t t t t t t t t t t t t t t t a ----+-+-=ϕϕϕ, (4.7)))()(()()()()()()(1220012010121202t t t t t t t t t t t t t t t a ----+-+-=ϕϕϕ. (4.8)对于二次拟合函数2210)(t a t a a t P ++=,我们很容易求得它的极小值点.令0)(=dt t dP ,即0221=+t a a ,从中解出212a a t -= (4.9)即为二次拟合函数)(t P 的极小值点.将式(4.7)与式(4.8)代入式(4.9)得.)()()()()()()()()()()()(21220101212022021021221222021t t t t t t t t t t t t t t t t t t a a t ϕϕϕϕϕϕ-+-+--+-+-=-= (4.10)用区间],[21t t 上二次拟合函数)(t P 的这个极小值点t 作为目标函数)(t ϕ在该区间极小值点的一个估计值.若t 和0t 已充分接近,即对给定的允许误差0>ε使ε<-||0t t(4.11) 成立时,t 就可被看作是)(t ϕ在区间][21t t ,内近似最优解;否则应缩短区间,按照)(t ϕ值保持两头大、中间小的原则构成新的三点,继续上述过程,直至不等式(4.11)成立为止.二、抛物线插值法迭代步骤下面具体介绍一下缩短区间,构成新三点的方法.由式(4.15)得到的点t ,在区间],[21t t 内既可能在点0t 的左侧(即0t t <),又可能在0t 的右侧(即0t t >),分别对应这两种情形比较)(t ϕ和)(0t ϕ的大小,又有)()(0t t ϕϕ<,)()(0t t ϕϕ>及)()(0t t ϕϕ=等三种情形,故共有如下六种情况(如图4.15与图4.16所示):(1)对于图 4.15(a )的情况:因)()(0t t ϕϕ<,所以相对0t 来说t 是好点,故划掉区间],[20t t ,保留],[01t t 为新区间,故置)()(0202t t t t ϕϕ==,,00()()t t t t ϕϕ==,,1t 保持不变;(2)对于图4.15(b )的情况:因)()(0t t ϕϕ>,所以相对t 来说0t 是好点,故划掉],[1t t ,保留],[2t t 为新区间,故置11()()t t t t ϕϕ==,,0t 与2t 保持不变; (3)对于图4.15(c )的情况:因)()(0t t ϕϕ<,所以相对0t 来说t 是好点,故划掉],[01t t ,保留],[20t t 为新区间,故置10100()()t t t t t t ϕϕ===,,,0()()t t ϕϕ=,2t 保持不变;(4)对于图4.15(d )的情况:因)()(0t t ϕϕ>,所以相对t 来说0t 是好点,故划掉],[2t t 保留],[1t t ,故置22()()t t t t ϕϕ==,,0t 与1t 保持不变.(5)对于图4.16(a )的情况:一般同时划掉],[1t t 及],[20t t 仅留中间的],[0t t ,故置t t =1,1()()t t ϕϕ=,02t t =,20()()t t ϕϕ=,2210t t t +=,⎪⎭⎫ ⎝⎛+=2)(210t t t ϕϕ; (6)对于图4.16(b )的情况:一般同时划掉],[01t t 及],[2t t ,仅留中间],[0t t ,故置01t t =,10()()t t ϕϕ=,t t =2,2()()t t ϕϕ=, 2210t t t += ,⎪⎭⎫ ⎝⎛+=2)(210t t t ϕϕ. 通过上述讨论,我们可直接给抛物线插值法的迭代流程图(图4.17).三、抛物线插值法有关说明抛物线插值法是多项式逼近法的一种.所谓多项式逼近,是利用目标函数在若干点的函数值或导数值等信息,构成一个与目标函数相接近的低次插值多项式,用该多项式的最优解作为目标函数的近似最优解.图4.15 图4.16。