标准BP算法及改进的BP算法应用

标准BP算法及改进的BP算法标准BP算法及改进的BP算法应用(1)

➢ 隐含层神经元数

➢ 初始权值的选取 ➢ 学习速率 ➢ 期望误差的选取

22

2020/3/6

网络的层数

理论上已经证明:具有偏差和至少一个S型隐含层 加上一个线性输出层的网络,能够逼近任何有理函 数

定理:

增加层数主要可以进一步的降低误差,提高精度, 但同时也使网络复杂化,从而增加了网络权值的训 练时间。

%输入向量P和目标向量T

P = -1:0.1:1

T = [-0.96 -0.577 -0.0729 0.377 0.641 0.66 0.461 0.1336 -0.201 -0.434 -0.5 -0.393 0.1647 0.0988 0.3072 0.396 0.3449 0.1816 -0.0312 -0.2183 -0.3201 ];

4.3 BP学习算法

假设输入为P,输入神经元有r个,隐含层内有s1个神经 元,激活函数为F1,输出层内有s2个神经元,对应的激 活函数为F2,输出为A,目标矢量为T

12

2020/3/6

4.3 BP学习算法

信息的正向传递

隐含层中第i个神经元的输出

输出层第k个神经元的输出

定义误差函数

13

4.4.2应用举例

1、用BP神经网络实现两类模式分类 p=[1 -1 -2 -4;2 1 1 0]; t=[0 1 1 0]; %创建BP网络和定义训练函数及参数 NodeNum=8;%隐含层节点数 TypeNum=1;%输出维数 Epochs=1000;%训练次数 TF1='logsig'; TF2='logsig';

D1=deltatan(A1,D2,W2);

[dWl,dBl]=learnbp(P,D1,lr);

BP算法及其改进应用

BP 算法及其改进应用0 引言神经网络(Neural Networks ,简称NN )是由大量的、简单的处理单元(简称为神经元)广泛的相互连接而成的复杂网络系统,它反映了人脑功能的许多基本特性,是一个高度复杂的非线性动力学系统。

神经网络具有大规模并行、分布式存储和处理、自组织、自适应和自学习能力,特别适合处理需要同时考虑许多因素和条件的、不精确和模糊的信息处理问题。

神经网络的发展与神经科学、数理科学、认知科学、计算机科学、人工智能、信息科学、控制论、机器人学、微电子学、心理学、光计算、分子生物学等有关,是一门新兴的边缘交叉学科。

1986年Rumelhart 和McCelland 等人提出并行分布处理(PDP )的理论,同时提出了多层网络的误差反向传播学习算法,简称BP 算法。

这种算法根据学习的误差大小,把学习的结果反馈到中间层次的隐单元,改变它的权系数矩阵,从而达到预期的学习目的,解决了多层网络的学习问题。

BP 算法从实践上证明神经网络的运算能力很强,可以完成许多学习任务,解决许多具体问题。

BP 网络是迄今为止最常用、最普通的网络。

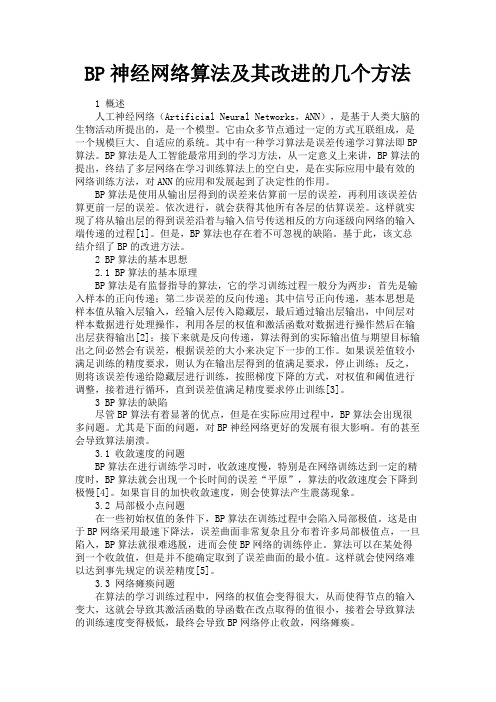

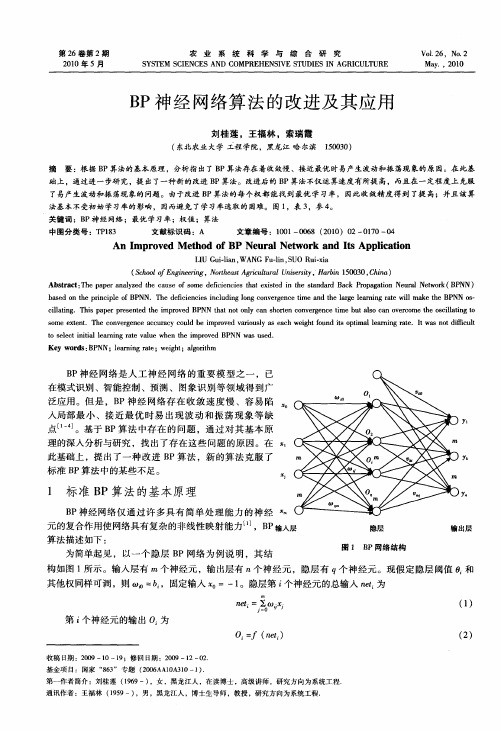

1 基于BP 算法的多层前馈模型1.1数学模型其网络结构如图1所示图1 BP 网络结构模型的数学表达如下:输入向量: T n i x x x x X ),...,,...,,(21= 隐层输出向量: T m j y y y y Y ),...,,...,,(21= 输出层输出向量: T l k o o o o O ),...,,...,,(21= 期望输出向量:T l k d d d d d ),...,,...,,(21=输入层到隐层之间的权值矩阵:),...,,...,,(21m J V V V V V = 隐层到输出层之间的权值矩阵:),...,,...,,(21l k W W W W W =1.2各层计算对于输出层:)(k k net f o = l k ,...,2,1=(1-1) ∑==mj j jk k y w net 0k ,...,2,1= (1-2)对于隐层: )(j j n e t f y = m j ,...,2,1= (1-3)∑==ni i ij jx v netm j ,...,2,1= (1-4)其中,(.)f 为单极性Sigmoid 函数xex f -+=11)(或双极性Sigmoid 函数xx ee xf --+-=11)(2 BP 学习算法2.1 网络误差与权值调整输出误差E 定义:2)(21o d E -=∑=-=lk k ko d 12)(21(1-5)将以上误差定义式展开至隐层:∑=-=lk k k net f d E 12)]([21∑∑==-=lk mj j jk k y w f d 120)]([21(1-6)进一步展开至输入层:∑∑==-=lk mj j jk k net f w f d E 120)]}([{21∑∑∑===-=lk m j n i i ij jk kx v f w f d 12)]}([{21(1-7)jk jk w E w ∂∂-=∆ηl k m j ,...,2,1;,...,1,0== (1-8)ijij v Ev ∂∂-=∆ηm j n i ,...,2,1;,...,1,0== (1-9)式中负号表示梯度下降,常数η∈(0,1)表示比例系数。

标准BP算法及改进的BP算法

自适应学习速率应用

P = -1:0.1:1 T = [-0.96 -0.577 -0.0729 0.377 0.641 0.66 [0.461 0.1336 -0.201 -0.434 -0.5 -0.393 -0.1647 0.0988 0.3072 0.396 0.3449 0.1816 -0.0312 0.2183 -0.3201 ]; [R,Q] = size(P); [S2,Q] = size(T); S1 = 5; [W1,B1] = rands(S1,R); [W2,B2] = rands(S2,S1);

10

2

Performance is 0.0199998, Goal is 0.02

10 Training-Blue Goal-Black

1

10

0

10

-1

10

-2

0

100

200

300 400 664 Epochs

500

600

采用动量法时的训练误差记录

1.3 自适应学习率调整法

在BP算法中,网络权值的调整取决于学习 BP算法中,网络权值的调整取决于学习 速率和梯度。在标准BP 速率和梯度。在标准BP 算法中,学习速率 是不变的。 而在自适应学习率调整法中,通常学习速 率的调整准则是:检查权值的修正是否真 正降低了误差函数,如果确实如此,则说 明所选的学习率小了,可对其增加一个量; 若不是则说明产生了过调,那么就应减小 学习速率的值。

标准BP算法及改进的 标准BP算法及改进的BP 算法及改进的BP 算法应用

1.1 标准的BP算法 标准的BP算法

BP标准的BP算法是基于梯度下降法,通过 BP标准的BP算法是基于梯度下降法,通过 计算目标函数对网络权值和阈值的梯度进 行修正。 X(k + 1 ) = X(k) - µ∆F( X(K) ) X(K)为由网络所有权值和阈值所形成的向 X(K)为由网络所有权值和阈值所形成的向 量; µ为学习速率; ∆F( X(K) )为目标函数的梯度; )为目标函数的梯度;

BP算法及BP改进算法

BP算法及BP改进算法BP算法通过不断调整网络的权重和偏置,以最小化网络输出与实际输出之间的误差。

算法包含两个主要步骤:前向传播和反向传播。

在前向传播阶段,输入信号通过神经网络的各个层,直至到达输出层。

每一层都对输入信号进行加权求和,并通过激活函数进行非线性映射,然后传递给下一层。

最终,网络将产生一个预测输出。

在反向传播阶段,算法计算输出误差,并根据该误差调整网络权重和偏置。

误差通过比较网络预测输出与实际输出之间的差异得到。

然后,误差从输出层向输入层反向传播,根据权重的贡献程度进行分配,并相应地更新权重和偏置。

尽管BP算法在训练神经网络方面非常成功,但也存在一些问题。

其中之一是局部极小值问题,即算法可能在梯度下降的过程中陷入一个局部最小值,并无法找到全局最小值。

为了解决这个问题,已经提出了一些BP的改进算法。

其中一种改进算法是Momentum算法。

Momentum算法在误差梯度的基础上引入了一个动量项,该项记录了前一次权重更新所带来的动量。

它可以帮助算法跳出局部最小值,并在梯度下降的过程中加速更新。

该算法通过在权重更新中添加当前梯度和上一次更新的动量的乘积,实现对网络优化的加速。

另一种改进算法是Adaptive Learning Rate算法。

传统的BP算法在每次权重更新中使用固定的学习率。

然而,不同的权重可能具有不同的学习速度要求。

Adaptive Learning Rate算法通过根据权重梯度的大小动态地调整学习率,以使网络能够更快地收敛。

还有一种改进算法是正则化算法,其中最常用的是L1和L2正则化。

正则化通过在误差函数中添加一个惩罚项,以限制权重的大小。

这有助于防止过拟合现象的发生,并提高网络的泛化能力。

除了这些改进算法,还有许多其他的技术被用于改进BP算法。

例如,一些算法结合了遗传算法和BP算法,以从初始权重的随机样本中找到最佳的。

还有一些算法,如RPROP和QuickProp,通过引入自适应的权重更新规则来加速训练过程。

最新 BP神经网络算法及其改进的几个方法-精品

BP神经网络算法及其改进的几个方法1 概述人工神经网络(Artificial Neural Networks,ANN),是基于人类大脑的生物活动所提出的,是一个模型。

它由众多节点通过一定的方式互联组成,是一个规模巨大、自适应的系统。

其中有一种学习算法是误差传递学习算法即BP 算法。

BP算法是人工智能最常用到的学习方法,从一定意义上来讲,BP算法的提出,终结了多层网络在学习训练算法上的空白史,是在实际应用中最有效的网络训练方法,对ANN的应用和发展起到了决定性的作用。

BP算法是使用从输出层得到的误差来估算前一层的误差,再利用该误差估算更前一层的误差。

依次进行,就会获得其他所有各层的估算误差。

这样就实现了将从输出层的得到误差沿着与输入信号传送相反的方向逐级向网络的输入端传递的过程[1]。

但是,BP算法也存在着不可忽视的缺陷。

基于此,该文总结介绍了BP的改进方法。

2 BP算法的基本思想2.1 BP算法的基本原理BP算法是有监督指导的算法,它的学习训练过程一般分为两步:首先是输入样本的正向传递;第二步误差的反向传递;其中信号正向传递,基本思想是样本值从输入层输入,经输入层传入隐藏层,最后通过输出层输出,中间层对样本数据进行处理操作,利用各层的权值和激活函数对数据进行操作然后在输出层获得输出[2];接下来就是反向传递,算法得到的实际输出值与期望目标输出之间必然会有误差,根据误差的大小来决定下一步的工作。

如果误差值较小满足训练的精度要求,则认为在输出层得到的值满足要求,停止训练;反之,则将该误差传递给隐藏层进行训练,按照梯度下降的方式,对权值和阈值进行调整,接着进行循环,直到误差值满足精度要求停止训练[3]。

3 BP算法的缺陷尽管BP算法有着显著的优点,但是在实际应用过程中,BP算法会出现很多问题。

尤其是下面的问题,对BP神经网络更好的发展有很大影响。

有的甚至会导致算法崩溃。

3.1 收敛速度的问题BP算法在进行训练学习时,收敛速度慢,特别是在网络训练达到一定的精度时,BP算法就会出现一个长时间的误差“平原”,算法的收敛速度会下降到极慢[4]。

标准BP算法及改进的BP算法课件

2. 计算网络的输出和误差。

动量项BP算法的流程和公式

01

3. 更新权重和偏置,同时考虑动 量项。

02

4. 重复执行步骤2和3,直到达到 预设的迭代次数或满足收敛条件 。

动量项BP算法的流程和公式

公式 1. 计算输出:`y = sigmoid(Wx + b)`

2. 计算误差:`E = d - y`

标准BP算法的优缺点

优点 适用于多类问题:标准BP算法可以解决回归和分类问题。

灵活性强:可以自由设计神经网络的架构和激活函数等元素。

标准BP算法的优缺点

• 自适应能力强:能够自适应地学习和调整权重和 偏置等参数。

标准BP算法的优缺点

01 02 03 04

缺点

易陷入局部最小值:标准BP算法使用梯度下降算法优化权重和偏置 ,可能会陷入局部最小值,导致无法获得全局最优解。

神经网络的基本元素

神经元是神经网络的基本元素,每个神经元接收输入信号,通过激 活函数进行非线性转换,并输出到其他神经元。

神经网络的结构

神经网络由输入层、隐藏层和输出层组成,每一层都包含若干个神 经元。

BP算法简介

BP算法的定义

BP算法是一种通过反向传播误差 来不断调整神经网络权重的训练

算法。

BP算法的原理

动量项BP算法的流程和公式

3. 更新权重:`W = W - α * E * x - β * ΔW`

ቤተ መጻሕፍቲ ባይዱ

4. 更新偏置:`b = b - α * E - β * Δb`

其中,α和β分别是学习率和动 量项系数,ΔW和Δb是上一次更

新的权重和偏置。

动量项BP算法的实例

BP神经网络算法的改进及在入侵检测中的应用

BP神经网络算法的改进及在入侵检测中的应用BP算法是神经网络众多算法中应用最为广泛的一种,它在函数逼近、模式识别、分类、数据压缩等领域有着更加广泛的应用。

针对BP算法的缺陷,提出了几点改进措施。

标签:BP神经网络;算法改进;入侵检测1 引言据统计有近90%的神经网络应用是基于BP算法的。

但它存在学习收敛速度慢、容易陷入局部极小点而无法得到全局最优解、对初始权值的选取很敏感等缺点。

针对此问题,目前国内外已有不少人对BP网络进行了大量的研究.本文在众人研究上,针对BP算法的缺陷,提出了几点改进措施。

2 改变误差函数由于等效误差分量δpl jk和δpl ij的大小和正负的变化对收敛速度存在影响,因为BP网络是误差逆向传播,δpl jk和δpl ij两者比较,δpl jk对收敛速度的影响更大,所以,可选取“信息熵”作为误差函数的定义。

E total=PP i=1n-1l=0t pl l×1Og pl yl+(1-t pl l)δpl l×1og(1-y pl l)(1)其中,δPl l=y pl l-t pl l3 连接权重的选择为避免学习过程中的振荡,Jcaillon等人曾强调限制连接权重的范围,将权重初值限制在[-0.5,0.5]区间内随机选取(一般将连接权重初值限制在[-5,5],也可加速收敛。

4 加入动量项这种措施又称为惯性校正法,其权值调整公式可用下式表示:Δw ij(t)=aΔw ij(t-1)+μδi(t)y j等式右端第二项是常规BP算法的修正量,δi(t)称为广义误差,yj为第j层神经元输出。

第一项称为动量项,a为动量系数,μ为学习率。

这种方法在加速收敛的同时,抑制了振荡。

综上,BP算法的改进策略都从不同程度上提高了算法的收敛速度,避免算法陷于局部极值。

5 入侵检测实验设计本实验对BackDoS,Buffer_Overflow,Guess_Passwd,Imap,IpsweepProbe5类经常出现的攻击进行基于改进算法和传统算法的对比识别实验,给出实验结果,对结果进行分析。

BP算法改进及在软件成本估算中的应用

BP算法改进及在软件成本估算中的应用周启超【摘要】Software cost estimation plays an important role in the software development process,which is an effective measure to control software progress and reduce software risk and ensure software quality. Software cost estimation is a complicated task,affected by many factors and uncertainties. According to the current situation of software costs are difficult to estimate,a study based on BP algorithm is car-ried out. Firstly,BP algorithm principle and mathematical representation is researched. Then,based on the analysis of existing problems on BP algorithm,the adaptive learning rate,the additional momentum methodand simulated annealing,and genetic algorithm are combined to improve it. Finally,the software cost estimation index system is established and the improved BP algorithm is used in software cost esti-mation. The results show that the improved BP algorithm has the advantages of accurate estimated result,saving manpower and material resources,reducing wasteof money,to accelerate software development progress and improve software quality with an important role.%软件成本估算在软件开发过程中扮演着重要角色,它是控制软件进度、降低软件风险和保证软件质量的有效措施。

BP算法机器学习中的应用

BP算法机器学习中的应用近年来,机器学习技术的发展已经成为了人工智能领域最为炙手可热的话题之一。

BP算法作为一种典型的人工神经网络算法,以其在多种机器学习领域具有的广泛应用而备受研究人员的关注。

本文将介绍BP算法在机器学习中的应用,包括BP算法的原理、BP算法在分类、预测、回归分析等领域的应用,并探讨BP算法的优缺点以及未来的发展方向。

一、BP算法的原理本质上而言,BP算法是一种使用反向传播算法进行训练的人工神经网络算法,其基本思想是利用前向传播的方式将输入数据通过神经元进行处理,并将处理后的数据反向传递到网络中间层及输入层的每一个神经元中进行调整,以达到最小化误差的目的。

BP算法的训练过程可以分为两个阶段:前向传播和反向传播。

在前向传播过程中,数据将从输入层一直传递到输出层,每一次传递都会经过一次运算和激活函数处理。

在反向传播过程中,误差将从输出层传回至输入层,并利用梯度下降进行权值更新,以使误差最小化。

在BP算法的训练过程中,训练数据将会反复的使用,直到网络的输出结果趋于稳定。

二、BP算法在分类问题中的应用在机器学习领域,BP算法被广泛应用于分类问题中。

在分类问题中,BP算法的主要目的就是通过利用已知数据集中的样本,来预测未知数据集中的样本所属的类别。

具体而言,BP算法可以通过训练样本来建立一个分类器,该分类器可以对未知数据进行分类。

在训练过程中,分类器会不断地进行反向传播,并根据误差进行权值的更新。

一旦分类器训练完成,就可以使用该分类器对新的未知数据集进行分类。

在实际应用中,BP算法已经成功地在多个领域中进行了分类,比如图像识别、语音识别、文本分类等领域。

三、BP算法在预测问题中的应用除了在分类问题中应用之外,BP算法还可以用于预测问题中。

预测问题主要是通过已知的数据来预测未来的数据。

BP算法在预测问题中的应用主要是通过学习训练数据中的模式来进行预测。

具体而言,BP算法可以使用训练数据中的历史记录来预测未来的趋势。

BP神经网络算法的改进及其应用

B P神经 网络 是 人 工 神 经 网 络 的 重 要 模 型 之 一 ,已 在模 式识 别 、智能 控制 、预测 、图象 识 别 等 领域 得 到 广

b s d o h r cp e o NN.T e d f in i si cu ig l n o v r e c i n h r e la n n ae w l ma e t e B NN O — a e n t ep n i l fBP i h e ce c e n l dn o g c n e g n e t i me a d t e l g r i g r t i k P S a e l h cl t g i ai .T i a e r s n e h mp o e N t a o n yc n s o e o v re c i u s a v r o e o cl t gt l n h sp p rp e e t d t e i r v d BP N h t to l a h a n c n eg n et n meb t o c n o e c met s i ai o l a h l n

泛应 用 。但 是 ,B P神 经 网络 存 在 收 敛 速 度 慢 、容 易 陷

入局 部 最 小 、接 近 最 优 时 易 出 现 波 动 和振 荡 现 象 等 缺 点 L 。基于 B l J P算 法 中存 在 的 问题 ,通 过对 其 基 本 原 理 的深入分 析与研 究 ,找 出了存 在 这些 问题 的原 因 。在 . 此基础 上 ,提 出 了一 种 改 进 B P算法 ,新 的 算 法 克 服 了 标准 B P算法 中 的某 些不 足 。

标准BP算法及改进的BP算法PPT教学课件

10

101

Training-Blue Goal-Black

100

-1

10

-2

10 0

1000

2000

3000 4000 7366 Epochs

5000

6000

7000

训练结束后的网络误差记录

2020/12/10

9

1.2 附加动量法

附加动量法使网络在修正权值时不仅考虑 误差在梯度上的作用,而且考虑在误差曲 面上变化趋势的影响;

在BP算法中,网络权值的调整取决于学习 速率和梯度。在标准BP 算法中,学习速率 是不变的。

而在自适应学习率调整法中,通常学习速 率的调整准则是:检查权值的修正是否真 正降低了误差函数,如果确实如此,则说 明所选的学习率小了,可对其增加一个量; 若不是则说明产生了过调,那么就应减小 学习速率的值。

2020/12/10

2020/12/10

2

标准的BP 算法虽然原理简单,实现方便, 但由于训练过程中为一较小的常数,因而 存在收敛速度慢和局部极小的问题。

对于复杂问题,训练过程需迭代几千、几 万次才能收敛到期望的精度。

因此,标准的BP 网络在很大程度上表现出 它的不实用性,特别是对实时性很强的系 统。为此就有了各种改进算法。

[R,Q] = size(P); [S2,Q] = size(T); S1 = 5; [W1,B1] = rands(S1,R); [W2,B2] = rands(S2,S1);

2020/12/10

12

net = newff( minmax(P), [5,1], {'tansig','purelin'},'traingdx' ); net.trainParam.epochs = 700; net.trainParam.mc = 0.95; net.trainParam.lr = 0.05; net.performFcn = 'sse'; net.trainParam.goal = 0.02; [net,tr] = train(net,P,T); Y = sim(net,P); plot(P,T,P,Y,’o’)

BP算法的改进及其应用的开题报告

BP算法的改进及其应用的开题报告一、研究背景BP算法是机器学习中最经典的算法之一,它具有广泛的应用,包括图像识别、语音识别、自然语言处理等多个领域。

然而,BP算法也存在一些问题,例如训练时间长、容易陷入局部极小点等,因此它需要进行改进。

近年来,研究者们提出了多种改进的BP算法,如自适应学习率BP 算法、共轭梯度BP算法、反向缩放算法等等。

这些算法在一定程度上解决了BP算法的缺陷并优化了性能。

二、研究目的本文旨在深入探究BP算法的改进,重点研究几种应用广泛的改进算法,并通过实验比较不同算法的性能差异,为实际应用提供参考。

三、研究内容(1)BP算法简介对BP算法原理、流程及其主要缺陷进行概述。

(2)自适应学习率BP算法详细介绍自适应学习率BP算法的原理,分析其如何解决BP算法的训练时间长、容易陷入局部极小点等问题,探讨其优缺点。

(3)共轭梯度BP算法介绍共轭梯度BP算法的基本原理,分析其如何避免BP算法中的病态问题,探讨其优缺点。

(4)反向缩放算法介绍反向缩放算法的基本原理,分析其如何解决BP算法中的权值初始化问题,探讨其优缺点。

(5)实验比较通过实验比较不同算法的性能差异,分析每种算法的适用场景。

四、研究意义该研究对于促进BP算法的发展和应用具有重要意义,对于提高机器学习算法的性能和应用效果具有重要参考价值。

同时,该研究也有助于深入理解网络神经网络的训练原理和优化算法的机制。

五、研究方法本研究方法主要涉及文献综述和实验比较两个方面。

文献综述方面,将对BP算法及其改进算法进行全面梳理,深入剖析算法原理和应用场景;实验比较方面,将通过各种实验,对不同算法的性能进行评估和比较。

研究方法采用理论分析和计算机模拟相结合的方式,充分发挥理论分析、计算实验相融合的优势。

BP学习算法的改进与应用

第19卷 第6期1999年12月北京理工大学学报Journal of Beijing Institute of T echno logy V o l .19 N o.6D ec .1999BP学习算法的改进与应用0李敏生 刘 斌(北京理工大学计算机科学与工程系,北京 100081)摘 要 目的 对BP 学习算法中存在的大量局部极小点以及收敛速度慢问题进行研究并提出相应的改进方案Ζ方法 采用类似模拟退火算法调整网络权值修改量Γ和动量项Α以及对学习样本进行按类划分Ζ结果 使用改进后的BP 算法对480个学习样本进行学习,识别率从70%提高到95%,学习时间从4h 下降到30m in 左右Ζ结论 算法的改进提高了识别率并降低了学习时间Ζ关键词 神经网络;软件模拟;模块化神经网络编程;局部极小分类号 T P 27312收稿日期:19981026 0部级预研项目1 BP 算法的改进B P 算法是目前应用较为广泛的一种神经网络算法模型Ζ该算法在层次型网络结构上采用误差逆传播学习方式[1,2],学习过程由正向传播和误差逆传播组成Ζ正向传播过程中,输入信号从输入层经隐层单元逐层传播,最后传向输出层,每1层神经元状态只影响下一层神经元状态Ζ如果在输出层不能得到期望的输出,则转入误差逆传播,将输出信号的误差沿原来的连接通路返回Ζ通过修改各层神经元的权值,使得误差信号最小,这是一种典型的全局逼近网络Ζ可以证明,含有足够多隐含层节点的3层B P 网络能够以任意精度逼近一个非线性函数ΖB P 算法的这种特性,使得该算法成为被广泛应用的神经网络算法模型Ζ但B P 算法本身存在局部极小点、收敛速度慢等问题Ζ作者经过对该算法软件的模拟分析,对B P 学习算法进行了改进Ζ111 学习过程收敛速度设训练样本集K ={r 1=(x 1,y 1),r 2=(x 2,y 2),…,r m =(x m ,y m )}ΖB P 算法是先对r 1进行学习,利用误差逆传对网络的权值和阈值进行调整,使调整后的网络对应关系满足f (x 1)=y 1(或向着这方向),设这时的网络参数为(w 1,Η1)Ζ然后,以(w 1,Η1)为基础对样本r 2=(x 2,y 2)进行学习,调整网络参数得到(w 2,Η2)满足f (x 2)=y 2(或向着这方向)Ζ但在一般情况下,(w 1,Η1)≠(w 2,Η2),故此时未必有f (x 1)=y 1成立ΖB P 算法的这种学习方法常会出现学新忘旧的现象,为此,B P 算法常采用反复循环学习,以期得到正确的解,当样本数量较大时,网络收敛的过程很长Ζ可以证明B P 算法的学习复杂性是样本规模的指数函数[3]Ζ固定i ,使C i 为所有使网络对应关系f (x i )=y i 的权和阈值(w ,Η)的集合Ζ令C i 1={C i 中,满足f (x i -1)=y i -1的(w ,Η)的全体}Ζ设C i 1与C i 的规模之比为a i Ζ作向量d =(d 2,d 3,…,d m ),其各分量定义为:若对样本r i 进行学习时,所求的(w ,Η)属于C i 1,则令d i =1,否则d i =0Ζ用B P 算法对样本进行逐一学习一轮后,可以得到对应的学习向量d αΖ显然,若学习成功,即所得到的网络对任意i 均满足f (x i )=y i ,则必要条件为d α=(1,1,...,1)Ζ而d α=(1,1, (1)的概率为P a i ,(2≤i ≤m )Ζ设a i <a <1,则d 值取(1,1,…,1)的概率小于a m -1Ζ也就是说,平均进行(1 a )m -1轮学习后,B P 算法至多有一轮成功,因此B P 算法的学习复杂性是样本规模的指数函数Ζ即当样本数量较大时,算法的收敛会变得非常困难,甚至不可达到Ζ因此,在应用B P 算法解决较大学习样本规模的问题中,如果事先能够根据样本(问题)的性质和关系将样本空间预分成较大的几类,每类分别采用一个B P 型神经网络算法进行学习,在运行时则根据样本的预分类性质选择合适的网络运行Ζ这样,可以大大缩短网络的学习时间Ζ其方法如图1所示Ζ最终运行网络的结构示于图2Ζ・・・图2运行网络示意图结果网络1网络n 网络i 分类器运行数据图1子网划分网络1BP 算法学习…网络2网络n …分类器子空间n 子空间1子空间2全体样本空间上述的分类方法就是神经网络模块化编程思想的体现(根据这个具体方法,需要解决的是(分类错误)的误差)[4,5]Ζ但神经网络模块化编程并不局限于这种分类,也包括如异种网络模块之间的其他复杂的控制连接情况Ζ112 学习算法的局部极小点B P 算法本质上是以误差平方和为目标函数,用梯度法求其最小值的算法,除非误差平方和函数是正定的,否则必然有局部极小点存在Ζ因此网络很可能进入局部极小点ΖB P 算法的权值调整规则为∃W ij (t )=Γ∆i (t )x j (t )+Α∃W ij (t ),式中 Γ为收敛系数(表示权值修改量);Α为动量项(确定过去的学习效果)Ζ当Γ和Α较大时,权值的修改量较大,学习速率较快,但有可能产生震荡;而Γ和Α较小时,权值的修改量小,学习速率较慢,但一般较为平稳Ζ在实际应用中,开始时Γ和Α取较大值,然后逐步减小,当迭代逼近解时,必须取很小的正数,即∃W ij (t )的调整量必须很小Ζ但是,如果网络此时陷入局部极小,而∃W ij (t )的调整量又很小时,则网络会陷入其中而无法逃逸,即经过长时间的学习,网络的误差(整体误差以及每个样本的误差)不能下降,造成网络收敛性能低Ζ为改善这种情况,作者提出一种类似于退火算法的修正方案[6],在网络误差较长时间未能下降时,使网络的权值修改量加大,以一定的概率使网络重新处于高收敛系数和动量项的方式下学习,经一段时间后又重新使收敛系数和动量项逐步减少,以期能使网络跳出局部极小,达到收敛Ζ其本质是使网络在长时间不能收敛时,加入随机扰动,改变网络的权值和阈值构成,使网络逃离局部极小Ζ修改后的B P 算法权值修改步骤如下:227北京理工大学学报第19卷 ①初始时将收敛系数Γ和动量项Α设置一较高的数值,视问题规模定为017~019;②随着学习次数的增加Γ和Α递减Ζ递减的规律根据问题的难易程度而定,问题较复杂的,则递减速度可以减慢;③当Γ和Α减至一定的程度(如<011)之后,网络经过较多次运行后,若仍未能达到收敛或网络误差仍未有较大程度的改善,则重新设置Γ和Α为较高值(015~017),运行次数一般为原运行次数的1 10或1 20Ζ然后转入②继续运行至结束Ζ2 应 用作者将改进后的B P 学习算法应用在弹目交会的飞机方位角的识别问题中[7]Ζ根据飞机的二维图像判断飞机的方位角Ζ输入层的个数是以图像的特征提取为基础而制定的,特征提取是利用飞机图像轮廓线的拐点[8],按前、中、后各取5个并加入图像的几何特征(图像面积、型心位置等)而得到Ζ如果用标准的B P 算法对问题进行学习,480个样本,学习5万次,耗时约6h ,而识别率仅为68%左右Ζ其总体误差e 曲线表示网络已经处于局部极小中,经长时间学习后,e 却丝毫没有下降的趋势Ζ如图3所示Ζ图3 标准BP学习算法误差曲线图4 初次正常学习误差曲线针对弹目交会飞机方位角识别问题,作者事先将480个样本按照图像面积分成两大类,分别用B P 神经网络进行学习,并在网络的学习过程中加入随机扰动,使网络能够尽量跳出局部极小点,则每部分学习4000次便基本达到收敛,识别率在93%左右,耗时约25m in ,取得了较好的效果Ζ其误差曲线以及扰动如图4~图6所示[8]Ζ如图4所示,系统学习约500次之后,处于局部极小中Ζ加入干扰以后系统的总体误差呈上升趋势,如图5所示Ζ然后使系统再次正常运行,使之越过图6所示的局部极小点,使整体误差更低Ζ该问题的运行网络框架结构如图2所示Ζ图5 干扰学习误差曲线图6 二次正常学习误差曲线327 第6期李敏生等:BP 学习算法的改进与应用3 结果与讨论采用改进的B P 网络学习算法的关键是如何划分原始样本数据,这本身也是一个样本空间识别问题Ζ如果事先对样本结构、特征、分布等信息不了解,很难由人工事先将样本分成类Ζ但可以采用其他的神经网络模型如A R T ,SOM 等自适应、自组织模型或模式识别的聚类算法对样本进行自动粗略分类,从而达到分而治之的目的Ζ另外,退火控制过程本身也是一个求概率过程,因此应注意退火技术的效率和问题本身的关系Ζ参考文献1 戴 葵Λ神经网络实现技术Λ长沙:国防科技大学出版社,19982 M edsker L R .H ybrid neural netw o rk and expert system .M assachusetts :K luw er A cadem icPublishers ,19943 张 铃,张 钹Λ神经网络中BP 算法的分析Λ模式识别与人工智能,1994,7(9):191~1954 Sk rzpek T .N eural netw o rk si m ulati on environm ents .M assachusetts :K luw er A cadem ic Pub 2lishers ,19935 李敏生,刘 斌,刘 浩Λ基于人工神经网络描述的编程Λ北京理工大学学报,1998,18(6):680~6846 康立山,谢 云Λ非数值并行算法——模拟退火算法Λ北京:科学出版社,19947 L ooney G G .Pattern recogniti on using neural netw o rk s .N ew Yo rk :O xfo rd U niversity P ress ,19978 王润生Λ图像理解Λ长沙:国防科技大学出版社,1995I m provem en t and Application of BP A lgor ith mL iM in sheng L iu B in(D epartm ent of Computer Science and Engineering ,Beijing Institute of T echno logy ,Beijing 100081)Abstract A i m To study the standard B P algo rithm ’s local m in i m a and learn ing speed p rob lem s and p ropo se the schem e fo r i m p rovem en t .M ethods M ethods of classifying sam p les w ere u sed and the analogy anneal w as app lied to adju st thenetw o rk’s w eigh t change rate (Γ)and m om en t (Α).Results R ecogn iti on rate of 480learn ing sam p les is increased from 70%to 95%,and learn ing hou rs of th is p rob lem decrease from 4h to 30m in o r so by u sing th is new algo rithm .Conclusion T he ca 2pacity of new B P learn ing algo rithm is greatly i m p roved .Key words neu ral netw o rk ;softw are si m u lati on ;m odel neu ral netw o rk p rogram 2m ing ;local m in i m a 427北京理工大学学报第19卷 。

BP网络算法及其改进

BP网络算法及其改进BP网络算法及其改进书上的一个例子,是要识别英文字符C、I、T。

则XC=(1,1,1,1,0,0,1,1,1),XI=(0,1,0,0,1,0,0,1,0),XT=(1,1,1,0,1,0,0, 1,0)。

1.标准BP算法网络图我就不画了。

输入层X=(x0,x1,x2,...xi,...,xn)隐藏层Y=(y0,y1,y2,...,yj,...,ym)x0=y0=-1输出层O=(o1,o2,...,ok,...,ol)期望输出D=(d1,d2,...,dk,...,dl)输入层到隐藏层的权重Vij隐藏层到输出层的权重Wjk对于输出层:净输入输出对于隐藏层:净输入输出变换函数f(x)采用单极形Sigmoid函数:函数具有性质:采用批训练法,误差是所有样本的均方误差和:显然误差E是网络权值W和V的函数,E分别对W和V求偏导得到E的梯度,要减小误差E,则权值W和V调整的方向就应该是误差梯度的反方向。

结合(1)式(2)式可得权值调整公式:上代码:首先从复旦语料库全体训练集中随机挑取360个训练样本(每类40个)作为神经网络的输入#/usr/bin/perlsrand();my $outf="/home/orisun/master/fudan_corpus/tc_ann.txt"; open OUT,">$outf" or die "Can't open file:$!";my $dir_prefix="/home/orisun/master/fudan_corpus/train_vec/"; my @cat=qw/C3-Art_ws C7-History_ws C11-Space_wsC19-Computer_ws C31-Enviornment_ws C32-Agriculture_ws C34-Economy_ws C38-Politics_ws C39-Sports_ws/;foreach(0..$#cat){$dir=$dir_prefix.$cat[$_];opendir(DIR,"$dir") or die "Can't open directory:$!";@files=grep {/^[^\.]/} readdir(DIR); #文件不能以.开头foreach(1..40){$index=rand($#files);print OUT $dir."/".$files[$index]."\n";}}close OUT;#include<iostream>#include<cmath>#include<cst dlib>#include<ctime>#include<cassert>using namespace std;const int dim=9; //样本向量的维度const int in_count=dim+1; //输入层节点数const int hidden_count=5; //隐藏层节点数const int out_count=3; //输出层节点数const int P=3; //样本数const int iter_lim=1500; //最大迭代次数const double Epsilon=0.03; //允许误差double Eta=0.2; //学习率double W[hidden_count][out_count]={0}; //从隐藏层到输出层的权值double V[in_count][hidden_count-1]={0}; //从输入层到隐藏层的权值/** * 单极性Sigmoid函数*/inline double sigmoid(double activation,double response){ double ex=-activation/response; return 1.0/(pow(M_E,ex)+1);}/** * 初始网络权值W和V,赋予[0,1]上的随机数*/void initParam(){ srand(time(0)); for(inti=0;i<hidden_count;++i){ for(intj=0;j<out_count;++j)W[i][j]=rand()/(double)RAND_MAX; } for(inti=0;i<in_count;++i){ for(intj=0;j<hidden_count-1;++j)V[i][j]=rand()/(double)RAND_MAX; }}void printWeight(){ cout<<"W="<<endl; for(inti=0;i<hidden_count;++i){ for(intj=0;j<out_count;++j)cout<<W[i][j]<<"\t"; cout<<endl; } cout<<"V="<<endl; for(inti=0;i<in_count;++i){ for(intj=0;j<hidden_count-1;++j)cout<<V[i][j]<<"\t";cout<<endl; }}/** * 给定输入,求网络的输出*/void getOutput(double (&input)[in_count],double(&Y)[hidden_count],double(&output)[out_count]){ assert(input[0]==-1);assert(Y[0]==-1); for(intj=1;j<hidden_count;++j){ double net=0.0; //隐藏层的净输入for(int i=0;i<in_count;++i)net+=input[i]*V[i][j]; Y[j]=sigmoid(net,1); //把净输入抛给S形函数,得到隐藏层的输出} for(intk=0;k<out_count;++k){ double net=0.0; //输出层的净输入for(int j=0;j<hidden_count;++j)net+=Y[j]*W[j][k]; output[k]=sigmoid(net,1); //把净输入抛给S形函数,得到输出层的输出//cout<<output[k]<<"\t"; }//cout<<endl;}/** * 批训练法根据样本总体误差调整权重W和V */void adjustWeight(double(&input)[P][in_count],double (&Y)[P][hidden_count], double (&output)[P][out_count],double(&D)[P][out_count]){ doubledelte_W[hidden_count][out_count]={0}; //数组必须显式地赋0,否则它的初始值是一个随机的数doubledelte_V[in_count][hidden_count]={0}; for(intj=0;j<hidden_count;++j){ for(intk=0;k<out_count;++k){ for(intp=0;p<P;++p){ delte_W[j][k]+=(D[p][k]-output[p][k])*output[p][k]*(1-output[p][k])*Y[p][j];} delte_W[j][k]*=Eta;W[j][k]+=delte_W[j][k]; } } for(inti=0;i<in_count;++i){ for(intj=0;j<hidden_count;++j){ for(intp=0;p<P;++p){ double tmp=0.0;for(intk=0;k<out_count;++k){ tmp+=(D[p][ k]-output[p][k])*output[p][k]*(1-output[p][k])*W[j][k];}delte_V[i][j]+=tmp*Y[p][j]*(1-Y[p][j])*input[p][i];} delte_V[i][j]*=Eta;V[i][j]+=delte_V[i][j]; } }}/** * 计算所有样本的均方误差和*/double getMSE(double(&output)[P][out_count],double(&D)[P][out_count]){ double error=0.0; for(int p=0;p<P;++p){ for(intk=0;k<out_count;++k){ error+=pow((D[p][k]-output[p][k]),2); } } error/=2; return error;}int main(){ initParam(); doubleX[P][in_count]={{-1,1,1,1,1,0,0,1,1,1}, //"C"{-1,0,1,0,0,1,0,0,1,0}, //"I"{-1,1,1,1,0,1,0,0,1,0}}; //"T" doubleD[P][out_count]={{1,0,0}, //"C"{0,1,0}, //"I"{0,0,1}}; //"T" doubleY[P][hidden_count]={{-1},{-1},{-1}}; doubleO[P][out_count]={0}; int iteration=iter_lim;//printWeight(); while(iteration-->0){ for(int p=0;p<P;++p) getOutput(X[p],Y[p],O[p]); double err=getMSE(O,D); cout<<"第"<<iter_lim-1-iteration<<"次迭代误差:"<<err<<endl; //printWeight();if(err<Epsilon){ //如果误差小于允许的误差,则退出迭代cout<<"误差小于允许误差,迭代退出。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

100

-1

10

-2

10 0

1000

2000

3000 4000 7366 Epochs

5000

训练结束后的网络误差记录

ቤተ መጻሕፍቲ ባይዱ6000

7000

1.2 附加动量法

附加动量法使网络在修正权值时不仅考虑 误差在梯度上的作用,而且考虑在误差曲 面上变化趋势的影响;

X( K+1 ) = Mc( X(K) – X(K – 1) ) – (1 Mc)µΔF(X(K)) 式中0 <= Mc <= 1 为动量因子; 附加动量法的实质是将最后一次权值变化 的影响通过一个动量因子来传递。

标准BP算法及改进的BP 算法应用

1.1 标准的BP算法

BP标准的BP算法是基于梯度下降法,通过 计算目标函数对网络权值和阈值的梯度进 行修正。

X(k + 1 ) = X(k) - µΔF( X(K) ) X(K)为由网络所有权值和阈值所形成的向 量; µ为学习速率; ΔF( X(K) )为目标函数的梯度;

P = -1:0.1:1 T = [-0.96 -0.577 -0.0729 0.377 0.641 0.66 0.461 0.1336 -0.201 -0.434 -0.5 -0.393 -0.1647 0.0988 0.3072 0.396 0.3449 0.1816 -0.0312 0.2183 -0.3201 ];

0.8

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

-1

-1 -0.8 -0.6 -0.4 -0.2

0

0.2 0.4 0.6 0.8

1

训练1000次的结果

0.8

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

-1

-1 -0.8 -0.6 -0.4 -0.2

0

0.2 0.4 0.6 0.8

标准的BP 算法虽然原理简单,实现方便, 但由于训练过程中为一较小的常数,因而 存在收敛速度慢和局部极小的问题。

对于复杂问题,训练过程需迭代几千、几 万次才能收敛到期望的精度。

因此,标准的BP 网络在很大程度上表现出 它的不实用性,特别是对实时性很强的系 统。为此就有了各种改进算法。

标准BP网络的应用

P = -1:0.1:1 T = [-0.96 -0.577 -0.0729 0.377 0.641 0.66 0.461 0.1336 -0.201 -0.434 -0.5 -0.393 -0.1647 0.0988 0.3072 0.396 0.3449 0.1816 -0.0312 0.2183 -0.3201 ];

当动量因子的取值为零时,权值的变化仅 是根据梯度下降法产生的。

当动量因子的取值为1时,新的权值变化为 最后一次权值的变化,而依梯度法产生的 变化部分则被忽略掉了。

为此当增加了动量项后,促使权值的调节 向着误差曲面底部的平均方向变化。可在 一定程度上解决局部极小问题,但收敛速 度仍然很慢。

附加动量法的应用

[R,Q] = size(P); [S2,Q] = size(T); S1 = 5; [W1,B1] = rands(S1,R); [W2,B2] = rands(S2,S1);

net = newff( minmax(P), [5,1], {'tansig','purelin'},'traingdx' ); net.trainParam.epochs = 700; net.trainParam.mc = 0.95; net.trainParam.lr = 0.05; net.performFcn = 'sse'; net.trainParam.goal = 0.02; [net,tr] = train(net,P,T); Y = sim(net,P); plot(P,T,P,Y,’o’)

P = -1:0.1:1 T = [-0.96 -0.577 -0.0729 0.377 0.641 0.66 0.461 0.1336 -0.201 -0.434 -0.5 -0.393 -0.1647 0.0988 0.3072 0.396 0.3449 0.1816 -0.0312 0.2183 -0.3201 ]; [R,Q] = size(P); [S2,Q] = size(T); S1 = 5; [W1,B1] = rands(S1,R); [W2,B2] = rands(S2,S1);

1

训练次3000次的结果

0.8 0.6 0.4 0.2

0 -0.2 -0.4 -0.6 -0.8

-1 -1 -0.8 -0.6 -0.4 -0.2 0 0.2 0.4 0.6 0.8 1

训练7366次的结果

Performance is 0.0199986, Goal is 0.02

2

10

101

Training-Blue Goal-Black

而在自适应学习率调整法中,通常学习速 率的调整准则是:检查权值的修正是否真 正降低了误差函数,如果确实如此,则说 明所选的学习率小了,可对其增加一个量; 若不是则说明产生了过调,那么就应减小 学习速率的值。

X(k + 1 ) = X(k) - µ(K)ΔF( X(K) )

通过调整学习率µ(K),从而可得到比标准的 BP算法更快的收敛速度。

Performance is 0.0199998, Goal is 0.02

2

10

1

10

Training-Blue Goal-Black

100

-1

10

-2

10 0

100

200

300

400

500

600

664 Epochs

采用动量法时的训练误差记录

1.3 自适应学习率调整法

在BP算法中,网络权值的调整取决于学习 速率和梯度。在标准BP 算法中,学习速率 是不变的。

[R,Q] = size(P); [S2,Q] = size(T); S1 = 5; [W1,B1] = rands(S1,R); [W2,B2] = rands(S2,S1);

net = newcf( minmax(P), [5,1], {'tansig','purelin'},'traingd' ); net.trainParam.epochs = 7000; net.performFcn = 'sse'; net.trainParam.goal = 0.02; [net,tr] = train(net,P,T); Y = sim(net,P); plot(P,T,P,Y,’o’)

因此,将附加动量法和自适应学习率调整 法两种策略结合起来,既可有效地抑制网 络陷入局部极小,又有利于缩短学习时间。

但上述两种改进方法都是在标准梯度下降 法基础上发展起来的,它们只利用了目标 函数对网络权值和阈值的一阶导数信息。 因此,当用于较复杂的问题时,也还存在 收敛速度不够快的问题。

自适应学习速率应用