支持向量机(SVM)的实现

机器学习SVM(支持向量机)实验报告

实验报告实验名称:机器学习:线性支持向量机算法实现学员: 张麻子学号: *********** 培养类型:硕士年级:专业:所属学院:计算机学院指导教员:****** 职称:副教授实验室:实验日期:ﻬ一、实验目得与要求实验目得:验证SVM(支持向量机)机器学习算法学习情况要求:自主完成。

二、实验内容与原理支持向量机(Support Vector Machine,SVM)得基本模型就是在特征空间上找到最佳得分离超平面使得训练集上正负样本间隔最大。

SVM就是用来解决二分类问题得有监督学习算法。

通过引入了核方法之后SVM也可以用来解决非线性问题。

但本次实验只针对线性二分类问题。

SVM算法分割原则:最小间距最大化,即找距离分割超平面最近得有效点距离超平面距离与最大。

对于线性问题:假设存在超平面可最优分割样本集为两类,则样本集到超平面距离为:需压求取:由于该问题为对偶问题,可变换为:可用拉格朗日乘数法求解。

但由于本实验中得数据集不可以完美得分为两类,即存在躁点。

可引入正则化参数C,用来调节模型得复杂度与训练误差。

作出对应得拉格朗日乘式:对应得KKT条件为:故得出需求解得对偶问题:本次实验使用python编译器,编写程序,数据集共有270个案例,挑选其中70%作为训练数据,剩下30%作为测试数据。

进行了两个实验,一个就是取C值为1,直接进行SVM训练;另外一个就是利用交叉验证方法,求取在前面情况下得最优C值.三、实验器材实验环境:windows7操作系统+python编译器。

四、实验数据(关键源码附后)实验数据:来自UCI机器学习数据库,以Heart Disease数据集为例。

五、操作方法与实验步骤1、选取C=1,训练比例7:3,利用python库sklearn下得SVM()函数进行训练,后对测试集进行测试;2、选取训练比例7:3,C=np、linspace(0、0001,1,30)}。

利用交叉验证方法求出C值得最优解。

《2024年模式识别中的支持向量机方法》范文

《模式识别中的支持向量机方法》篇一一、引言在当今的数据时代,模式识别已经成为了许多领域的重要工具。

而支持向量机(Support Vector Machine,SVM)则是模式识别领域中最为常用的算法之一。

其算法具有高精度、适应性强等优点,广泛运用于分类、回归以及聚类等多种场景中。

本文旨在全面而系统地探讨模式识别中支持向量机方法的理论基础和实施方法。

二、支持向量机的基本理论支持向量机(SVM)是一种监督学习模型,它的核心思想是在特征空间中寻找一个超平面,使得该超平面能够尽可能准确地划分正负样本。

这个超平面是通过最大化间隔(即两个类别之间的最小距离)来确定的。

1. 线性可分SVM对于线性可分的数据集,SVM通过寻找一个超平面来将数据集划分为两个类别。

这个超平面是唯一确定的,且能够使得两个类别之间的间隔最大化。

2. 非线性SVM对于非线性可分的数据集,SVM通过使用核函数将数据映射到高维空间,从而将非线性问题转化为线性问题。

常用的核函数包括多项式核函数、高斯径向基核函数等。

三、支持向量机的实现方法1. 训练阶段在训练阶段,SVM需要先构建一个优化问题,其目标是最小化正负样本的分类误差和最大化分类间隔。

这个优化问题通常可以通过求解一个二次规划问题得到最优解,也就是SVM的最优分类边界和各个向量的支持值(支持向量)。

2. 测试阶段在测试阶段,SVM将新的输入样本通过核函数映射到高维空间中,并利用训练阶段得到的分类边界对新的输入样本进行分类。

如果输入样本在正类一侧,则被分类为正类;反之,如果输入样本在负类一侧,则被分类为负类。

四、支持向量机的应用场景支持向量机(SVM)具有广泛的应用场景,包括但不限于:图像识别、文本分类、生物信息学、手写数字识别等。

其中,图像识别是SVM应用最为广泛的领域之一。

在图像识别中,SVM 可以有效地处理图像的局部特征和全局特征,从而实现高精度的图像分类和识别。

此外,SVM在文本分类和生物信息学等领域也取得了显著的应用成果。

spark算法实现——svm支持向量机

spark算法实现——svm⽀持向量机svm是⼀种分类算法,⼀般先分为两类,再向多类推⼴⼀⽣⼆,⼆⽣三,三⽣。

⼤致可分为:线性可分⽀持向量机硬间隔最⼤化hard margin maximization硬间隔⽀持向量机线性⽀持向量机软间隔最⼤化soft margin maximization软间隔⽀持向量机⾮线性⽀持向量机核函数kernel function基本概念:分割超平⾯设C和D为两不相交的凸集,则存在超平⾯P,P可以将C和D分离。

线性可分⽀持向量机SVM从线性可分情况下的最优分类⾯发展⽽来。

最优分类⾯就是要求分类线不但能将两类正确分开(训练错误率为0),且使分类间隔最⼤ 给定线性可分训练数据集,通过间隔最⼤化得到的分离超平⾯为相应的分类决策函数该决策函数称为线性可分⽀持向量机。

φ(x)是某个确定的特征空间转换函数,它的作⽤是将x映射到(更⾼的)维度。

线性⽀持向量机分类线能将两类分开(训练错误率⼤于0,存在个别样本点分错),且使分类间隔最⼤⾮线性⽀持向量机存在⾮线性分割超平⾯,讲样本分开sparkmllib代码实现package mllibimport org.apache.spark.mllib.classification.{SVMModel, SVMWithSGD}import beledPointimport org.apache.spark.mllib.util.MLUtilsimport org.apache.spark.rdd.RDDimport org.apache.spark.sql.SQLContextimport org.apache.spark.{SparkContext, SparkConf}//⼆分类object SVMwithSGD {def main(args: Array[String]) {val conf = new SparkConf().setAppName("test").setMaster("local")val sc = new SparkContext(conf)val sql = new SQLContext(sc);val data: RDD[LabeledPoint] = MLUtils.loadLibSVMFile(sc, "svm.txt")val splits = data.randomSplit(Array(0.6, 0.4), seed = 11L)val training = splits(0).cache()val test = splits(1)// data.foreach( x => println(x.toString()))// data.foreach( x => println(bel))data.foreach( x => println(x.features))val numIterations = 100val model: SVMModel = SVMWithSGD.train(training, numIterations)model.clearThreshold()//为了模型拿到评分不是处理过之后的分类结果val scoreAndLabels: RDD[(Double, Double)] = test.map { point => // ⼤于0 ⼩于0 两类val score = model.predict(point.features)(score, bel)}scoreAndLabels.foreach(println)}}评分>0表⽰样本点在分割⾯之上,<0表⽰在分割⾯之下。

支持向量机的基本原理

支持向量机的基本原理

支持向量机(Support Vector Machine, SVM)是一种二分类模型,其基本原理是找到一个最优的超平面来进行数据的划分。

其基本思想是将样本空间映射到高维特征空间,找到一个超平面使得正负样本之间的间隔最大化,从而实现分类。

具体来说,SVM的基本原理包括以下几个步骤:

1. 寻找最优超平面:将样本空间映射到高维特征空间,使得样本在特征空间中线性可分。

然后寻找一个超平面来最大化两个不同类别样本的间隔(也称为“分类间隔”)。

2. 构建优化问题:SVM通过解决一个凸二次规划问题来求解最优超平面。

该优化问题的目标是最大化分类间隔,同时限制样本的分类正确性。

3. 核函数技巧:在实际应用中,数据通常是非线性可分的。

通过引入核函数的技巧,可以将非线性问题转化为高维或无限维的线性问题。

常用的核函数有线性核、多项式核、高斯核等。

4. 寻找支持向量:在求解优化问题时,只有一部分样本点对于最优超平面的确定起到决定性作用,这些样本点被称为“支持向量”。

支持向量决定了超平面的位置。

5. 分类决策函数:在得到最优超平面后,可以通过计算样本点到超平面的距离来进行分类。

对于新的样本点,根据其距离超平面的远近来判断其所属类别。

支持向量机的基本原理可以简单概括为在高维特征空间中找到一个最优超平面,使得样本的分类间隔最大化。

通过引入核函数的技巧,SVM也可以处理非线性可分的问题。

支持向量机具有理论基础牢固、分类效果好等优点,在实际应用中得到了广泛的应用。

支持向量机原理SVMPPT课件

回归分析

除了分类问题,SVM也可以用于 回归分析,如预测股票价格、预 测天气等。通过训练模型,SVM

能够预测未知数据的输出值。

数据降维

SVM还可以用于数据降维,通过 找到数据的低维表示,降低数据

的复杂性,便于分析和理解。

02 支持向量机的基本原理

线性可分与不可分数据

线性可分数据

在二维空间中,如果存在一条直线, 使得该直线能够将两类样本完全分开 ,则称这些数据为线性可分数据。

支持向量机原理 svmppt课件

目录

CONTENTS

• 引言 • 支持向量机的基本原理 • 支持向量机的数学模型 • 支持向量机的优化问题 • 支持向量机的核函数 • 支持向量机的训练和预测 • 支持向量机的应用案例 • 总结与展望

01 引言

什么是支持向量机

定义

支持向量机(Support Vector Machine,简称SVM)是一种监督学习算法, 用于分类和回归分析。它通过找到一个超平面来分隔数据集,使得分隔后的两 类数据点到该平面的距离最远。

支持向量机的优势和局限性

01

对大规模数据集效 率较低

对于大规模数据集,支持向量机 可能需要较长时间进行训练和预 测。

02

核函数选择和参数 调整

核函数的选择和参数调整对支持 向量机的性能有很大影响,需要 仔细选择和调整。

03

对多分类问题处理 不够灵活

对于多分类问题,支持向量机通 常需要采用一对一或一对多的策 略进行处理,可能不够灵活。

图像识别

• 总结词:支持向量机用于图像识别,通过对图像特征的提取和分类,实现图像 的自动识别和分类。

• 详细描述:支持向量机在图像识别中发挥了重要作用,通过对图像特征的提取 和选择,将图像数据映射到高维空间,然后利用分类器将相似的图像归为同一 类别,不相似图像归为不同类别。

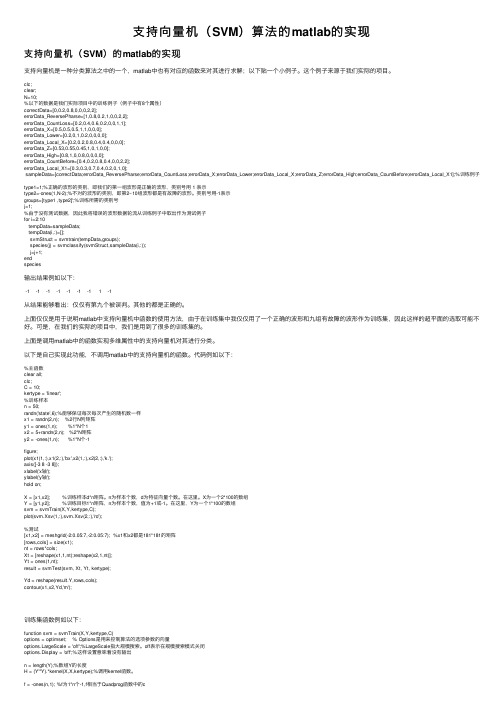

支持向量机(SVM)算法的matlab的实现

⽀持向量机(SVM)算法的matlab的实现⽀持向量机(SVM)的matlab的实现⽀持向量机是⼀种分类算法之中的⼀个,matlab中也有对应的函数来对其进⾏求解;以下贴⼀个⼩例⼦。

这个例⼦来源于我们实际的项⽬。

clc;clear;N=10;%以下的数据是我们实际项⽬中的训练例⼦(例⼦中有8个属性)correctData=[0,0.2,0.8,0,0,0,2,2];errorData_ReversePharse=[1,0.8,0.2,1,0,0,2,2];errorData_CountLoss=[0.2,0.4,0.6,0.2,0,0,1,1];errorData_X=[0.5,0.5,0.5,1,1,0,0,0];errorData_Lower=[0.2,0,1,0.2,0,0,0,0];errorData_Local_X=[0.2,0.2,0.8,0.4,0.4,0,0,0];errorData_Z=[0.53,0.55,0.45,1,0,1,0,0];errorData_High=[0.8,1,0,0.8,0,0,0,0];errorData_CountBefore=[0.4,0.2,0.8,0.4,0,0,2,2];errorData_Local_X1=[0.3,0.3,0.7,0.4,0.2,0,1,0];sampleData=[correctData;errorData_ReversePharse;errorData_CountLoss;errorData_X;errorData_Lower;errorData_Local_X;errorData_Z;errorData_High;errorData_CountBefore;errorData_Local_X1];%训练例⼦type1=1;%正确的波形的类别,即我们的第⼀组波形是正确的波形,类别号⽤ 1 表⽰type2=-ones(1,N-2);%不对的波形的类别,即第2~10组波形都是有故障的波形。

支持向量机SVM

(2)通过引入核函数,从而避免非线性映射的 显式表达式 由内积定义一个Mercer核:的问题

• 通过一个非线性映射,把样本空间映射到 一个高维乃至无穷维的特征空间,使非线 性问题在高维空间变成线性可解的问题, 并运用SVM方法求解线性问题,在求解的过 程中并不需要非线性映射,使问题简化。

(1)一个非线性映射到了一个高维的特 征空间,所以只需要将样本空间的线性 分类机中的X和Xi分别用 和 替换 就行,所以重新建立目标函数和约束条 件: 目标函数:Min 约束条件:

则离分类面最近的样本满足|g(x) ︱=1,再运用优化 理论及KKT等理论将求分类间隔最大的问题转化成 求w或w2 最小的问题。而要求所有分类面对所有样 本分类正确,就是要求满足: Yi[w ·xi+b]-1 ﹥0 因此满足公式且使w2最小的面就是最优分类面。 过两类样本中离分类面最近的点且平行于最优分类 面的超平面H1,H2上的训练样本就称作支持向量。

支持向量机(SVM)

1.支持向量机解决线性可分的情况

(1)最优划分超平面的确定 需要满足的条件: ①决策边界离两类数据尽可能远 ②最大化间隔m (2)解决办法:在n维空间里建立一个线性判别 总决策函数,以及分类面方程

• g(x)=sgn(wx+b) • wx+b=0

对上述函数进行归一化,使得所有样本满足|g(x) ︱ ﹥ ﹦1

图中红色和蓝色的点就是支持向量

求最优分类面问题转化成约束优化的问题: Min : 约束条件: 这是一个凸规划的问题,根据最优化理论,它存 在唯一全局最小解,由于满足KKT条件:

最后可得到最优分类函数为:

2.利用SVM解决线性不可分的问题

• 引入线性规划中的松弛变量,改变线性可分离 中的目标函数和约束条件,把线性不可分的问 题用线性可分离问题类似方法求解,建立线性 SVM模型。 于是在条件 中每一个样本点加入 一个松弛变量 (≥0),它是被错分样本点到 对应边界超平面的垂直距离。 当 Xi被正确分类时, 等于零;Xi被错分的偏差 越大, 值就越大。

支持向量机(SVM)原理详解

支持向量机(SVM)原理详解支持向量机(Support Vector Machine, SVM)是一种机器学习算法,用于二分类和多分类问题。

它的基本思想是寻找一个超平面,能够将不同类别的数据分隔开来,并且与最近的数据点之间的间隔最大。

一、原理概述:SVM的基本原理是将原始数据映射到高维空间中,使得在该空间中的数据能够线性可分,然后在高维空间中找到一个最优的超平面。

对于线性可分的情况,SVM通过最大化分类边界与最近数据点之间的距离,并将该距离定义为间隔,从而使分类边界具有更好的泛化能力。

二、如何确定最优超平面:1.线性可分的情况下:SVM寻找一个能够将不同类别的数据分开的最优超平面。

其中,最优超平面定义为具有最大间隔(margin)的超平面。

间隔被定义为超平面到最近数据点的距离。

SVM的目标是找到一个最大化间隔的超平面,并且这个超平面能够满足所有数据点的约束条件。

这可以通过求解一个凸二次规划问题来实现。

2.线性不可分的情况下:对于线性不可分的情况,可以使用一些技巧来将数据映射到高维空间中,使其线性可分。

这种方法被称为核技巧(kernel trick)。

核技巧允许在低维空间中计算高维空间的内积,从而避免了直接在高维空间中的计算复杂性。

核函数定义了两个向量之间的相似度。

使用核函数,SVM可以在高维空间中找到最优的超平面。

三、参数的选择:SVM中的参数有两个主要的方面:正则化参数C和核函数的选择。

1.正则化参数C控制了分类边界与数据点之间的权衡。

较大的C值将导致更少的间隔违规,增加将数据点分类正确的权重,可能会导致过拟合;而较小的C值将产生更宽松的分类边界,可能导致欠拟合。

2.核函数选择是SVM中重要的一步。

根据问题的特点选择合适的核函数能够更好地处理数据,常用的核函数有线性核函数、多项式核函数和高斯核函数等。

四、优缺点:SVM有以下几个优点:1.在灵活性和高扩展性方面表现出色,尤其是在高维数据集上。

2.具有良好的泛化能力,能够很好地处理样本数量较少的情况。

PythonSVM(支持向量机)实现方法完整示例

PythonSVM(⽀持向量机)实现⽅法完整⽰例本⽂实例讲述了Python SVM(⽀持向量机)实现⽅法。

分享给⼤家供⼤家参考,具体如下:运⾏环境Pyhton3numpy(科学计算包)matplotlib(画图所需,不画图可不必)计算过程st=>start: 开始e=>end: 结束op1=>operation: 读⼊数据op2=>operation: 格式化数据cond=>condition: 是否达到迭代次数op3=>operation: 寻找超平⾯分割最⼩间隔ccond=>conditon: 数据是否改变op4=>operation: 输出结果st->op1->op2->condcond(yes)->op4->econd(no)->op3啊,这markdown flow好难⽤,我决定就画到这吧=。

=输⼊样例/* testSet.txt */3.542485 1.977398 -13.018896 2.556416 -17.551510 -1.580030 12.114999 -0.004466 -18.127113 1.274372 17.108772 -0.986906 18.610639 2.046708 12.326297 0.265213 -13.634009 1.730537 -10.341367 -0.894998 -13.125951 0.293251 -12.123252 -0.783563 -10.887835 -2.797792 -17.139979 -2.329896 11.696414 -1.212496 -18.117032 0.623493 18.497162 -0.266649 14.658191 3.507396 -18.197181 1.545132 11.208047 0.213100 -11.928486 -0.321870 -12.175808 -0.014527 -17.886608 0.461755 13.223038 -0.552392 -13.628502 2.190585 -17.407860 -0.121961 17.286357 0.251077 12.301095 -0.533988 -1-0.232542 -0.547690 -13.457096 -0.082216 -13.023938 -0.057392 -18.015003 0.885325 18.991748 0.923154 17.916831 -1.781735 17.616862 -0.217958 12.450939 0.744967 -17.270337 -2.507834 11.749721 -0.961902 -11.803111 -0.176349 -18.804461 3.044301 11.231257 -0.568573 -12.074915 1.410550 -1-0.743036 -1.736103 -13.536555 3.964960 -18.410143 0.025606 17.382988 -0.478764 16.960661 -0.245353 18.234460 0.701868 18.168618 -0.903835 11.534187 -0.622492 -19.229518 2.066088 17.886242 0.191813 12.893743 -1.643468 -11.870457 -1.040420 -15.286862 -2.358286 16.080573 0.418886 12.544314 1.714165 -16.016004 -3.753712 10.926310 -0.564359 -10.870296 -0.109952 -12.369345 1.375695 -11.363782 -0.254082 -17.279460 -0.189572 11.896005 0.515080 -18.102154 -0.603875 12.529893 0.662657 -11.963874 -0.365233 -18.132048 0.785914 18.245938 0.372366 16.543888 0.433164 1-0.236713 -5.766721 -18.112593 0.295839 19.803425 1.495167 11.497407 -0.552916 -11.336267 -1.632889 -19.205805 -0.586480 11.966279 -1.840439 -18.398012 1.584918 17.239953 -1.764292 17.556201 0.241185 19.015509 0.345019 18.266085 -0.230977 18.545620 2.788799 19.295969 1.346332 12.404234 0.570278 -12.037772 0.021919 -11.727631 -0.453143 -11.979395 -0.050773 -18.092288 -1.372433 11.667645 0.239204 -19.854303 1.365116 17.921057 -1.327587 18.500757 1.492372 11.339746 -0.291183 -13.107511 0.758367 -12.609525 0.902979 -13.263585 1.367898 -12.912122 -0.202359 -11.731786 0.589096 -12.387003 1.573131 -1代码实现# -*- coding:utf-8 -*-#!python3__author__ = 'Wsine'from numpy import *import matplotlib.pyplot as pltimport operatorimport timedef loadDataSet(fileName):dataMat = []labelMat = []with open(fileName) as fr:for line in fr.readlines():lineArr = line.strip().split('\t')dataMat.append([float(lineArr[0]), float(lineArr[1])]) labelMat.append(float(lineArr[2]))return dataMat, labelMatdef selectJrand(i, m):j = iwhile (j == i):j = int(random.uniform(0, m))return jdef clipAlpha(aj, H, L):if aj > H:aj = Hif L > aj:aj = Lreturn ajclass optStruct:def __init__(self, dataMatIn, classLabels, C, toler):self.X = dataMatInbelMat = classLabelsself.C = Cself.tol = tolerself.m = shape(dataMatIn)[0]self.alphas = mat(zeros((self.m, 1)))self.b = 0self.eCache = mat(zeros((self.m, 2)))def calcEk(oS, k):fXk = float(multiply(oS.alphas, belMat).T * (oS.X * oS.X[k, :].T)) + oS.bEk = fXk - float(belMat[k])return Ekdef selectJ(i, oS, Ei):maxK = -1maxDeltaE = 0Ej = 0oS.eCache[i] = [1, Ei]validEcacheList = nonzero(oS.eCache[:, 0].A)[0]if (len(validEcacheList)) > 1:for k in validEcacheList:if k == i:continueEk = calcEk(oS, k)deltaE = abs(Ei - Ek)if (deltaE > maxDeltaE):maxK = kmaxDeltaE = deltaEEj = Ekreturn maxK, Ejelse:j = selectJrand(i, oS.m)Ej = calcEk(oS, j)return j, Ejdef updateEk(oS, k):Ek = calcEk(oS, k)oS.eCache[k] = [1, Ek]def innerL(i, oS):Ei = calcEk(oS, i)if ((belMat[i] * Ei < -oS.tol) and (oS.alphas[i] < oS.C)) or ((belMat[i] * Ei > oS.tol) and (oS.alphas[i] > 0)): j, Ej = selectJ(i, oS, Ei)alphaIold = oS.alphas[i].copy()alphaJold = oS.alphas[j].copy()if (belMat[i] != belMat[j]):L = max(0, oS.alphas[j] - oS.alphas[i])H = min(oS.C, oS.C + oS.alphas[j] - oS.alphas[i])else:L = max(0, oS.alphas[j] + oS.alphas[i] - oS.C)H = min(oS.C, oS.alphas[j] + oS.alphas[i])if (L == H):# print("L == H")return 0eta = 2.0 * oS.X[i, :] * oS.X[j, :].T - oS.X[i, :] * oS.X[i, :].T - oS.X[j, :] * oS.X[j, :].Tif eta >= 0:# print("eta >= 0")return 0oS.alphas[j] -= belMat[j] * (Ei - Ej) / etaoS.alphas[j] = clipAlpha(oS.alphas[j], H, L)updateEk(oS, j)if (abs(oS.alphas[j] - alphaJold) < 0.00001):# print("j not moving enough")return 0oS.alphas[i] += belMat[j] * belMat[i] * (alphaJold - oS.alphas[j])updateEk(oS, i)b1 = oS.b - Ei - belMat[i] * (oS.alphas[i] - alphaIold) * oS.X[i, :] * oS.X[i, :].T - belMat[j] * (oS.alphas[j] - alphaJold) * oS.X[i, :] * oS.X[j, :].T b2 = oS.b - Ei - belMat[i] * (oS.alphas[i] - alphaIold) * oS.X[i, :] * oS.X[j, :].T - belMat[j] * (oS.alphas[j] - alphaJold) * oS.X[j, :] * oS.X[j, :].T if (0 < oS.alphas[i]) and (oS.C > oS.alphas[i]):oS.b = b1elif (0 < oS.alphas[j]) and (oS.C > oS.alphas[j]):oS.b = b2else:oS.b = (b1 + b2) / 2.0return 1else:return 0def smoP(dataMatIn, classLabels, C, toler, maxIter, kTup=('lin', 0)):"""输⼊:数据集, 类别标签, 常数C, 容错率, 最⼤循环次数输出:⽬标b, 参数alphas"""oS = optStruct(mat(dataMatIn), mat(classLabels).transpose(), C, toler)iterr = 0entireSet = TruealphaPairsChanged = 0while (iterr < maxIter) and ((alphaPairsChanged > 0) or (entireSet)):alphaPairsChanged = 0if entireSet:for i in range(oS.m):alphaPairsChanged += innerL(i, oS)# print("fullSet, iter: %d i:%d, pairs changed %d" % (iterr, i, alphaPairsChanged))iterr += 1else:nonBoundIs = nonzero((oS.alphas.A > 0) * (oS.alphas.A < C))[0]for i in nonBoundIs:alphaPairsChanged += innerL(i, oS)# print("non-bound, iter: %d i:%d, pairs changed %d" % (iterr, i, alphaPairsChanged))iterr += 1if entireSet:entireSet = Falseelif (alphaPairsChanged == 0):entireSet = True# print("iteration number: %d" % iterr)return oS.b, oS.alphasdef calcWs(alphas, dataArr, classLabels):"""输⼊:alphas, 数据集, 类别标签输出:⽬标w"""X = mat(dataArr)labelMat = mat(classLabels).transpose()m, n = shape(X)w = zeros((n, 1))for i in range(m):w += multiply(alphas[i] * labelMat[i], X[i, :].T)return wdef plotFeature(dataMat, labelMat, weights, b):dataArr = array(dataMat)n = shape(dataArr)[0]xcord1 = []; ycord1 = []xcord2 = []; ycord2 = []for i in range(n):if int(labelMat[i]) == 1:xcord1.append(dataArr[i, 0])ycord1.append(dataArr[i, 1])else:xcord2.append(dataArr[i, 0])ycord2.append(dataArr[i, 1])fig = plt.figure()ax = fig.add_subplot(111)ax.scatter(xcord1, ycord1, s=30, c='red', marker='s')ax.scatter(xcord2, ycord2, s=30, c='green')x = arange(2, 7.0, 0.1)y = (-b[0, 0] * x) - 10 / linalg.norm(weights)ax.plot(x, y)plt.xlabel('X1'); plt.ylabel('X2')plt.show()def main():trainDataSet, trainLabel = loadDataSet('testSet.txt')b, alphas = smoP(trainDataSet, trainLabel, 0.6, 0.0001, 40)ws = calcWs(alphas, trainDataSet, trainLabel)print("ws = \n", ws)print("b = \n", b)plotFeature(trainDataSet, trainLabel, ws, b)if __name__ == '__main__':start = time.clock()main()end = time.clock()print('finish all in %s' % str(end - start))输出样例ws =[[ 0.65307162][-0.17196128]]b =[[-2.89901748]]finish all in 2.5683854014099112绘图⽅⾯还存在⼀些bug。

量子支持向量机代码的实现

量子支持向量机代码的实现量子机器学习是量子计算运用于机器学习的一种新兴的计算模式,其是在量子计算机上实现机器学习算法的一种方法。

量子计算利用量子比特和量子幺正操作来处理信息,符合纠缠和测量原则,因此可以在一定程度上加快和优化传统机器学习算法的运算速度和效果。

支持向量机(SVM)是机器学习领域中常用的分类算法之一,其目标是找到一个最佳的决策面来将数据集划分成不同的类别。

在传统计算机上,实现SVM算法的代码并不复杂,但是在量子计算机上实现SVM算法的过程却要复杂许多。

量子支持向量机(Q-SVM)是一种在量子计算机上执行的支持向量机算法,其具有显著的计算优势。

Q-SVM算法能够快速、准确地进行特征映射,从而对数据进行分类。

在实现Q-SVM算法时,需要借助到一些量子算法和统计学的概念,比如量子模拟、量子傅里叶变换和最小二乘等。

因此,在实现Q-SVM算法时需要掌握这些基本概念。

在本文中,我们主要探讨如何实现量子支持向量机的代码。

在实现Q-SVM算法的过程中,主要分为三个步骤:初始化、分类和重构。

具体步骤如下:1. 初始化在初始化过程中,首先需要对输入的数据进行量子特征映射,将数据转换为量子比特。

在进行量子特征映射的过程中,可以借助于量子傅里叶变换等量子算法来实现。

2. 分类在分类过程中,需要利用到量子门的操作,通过对量子比特的幺正操作,将数据映射到不同的类别。

同时,也需要利用到特定的量子算法进行优化和加速。

3. 重构在分类完成后,需要将量子比特重新转换为经典比特,得到最终的分类结果。

在这个过程中,需要利用到最小二乘等概念和工具,以加快重构的速度。

总体来说,实现量子支持向量机算法的代码比较复杂,需要掌握一些量子算法和统计学的概念,并且需要在传统计算机的基础上进行一定的改进和优化。

对于初学者来说,可以先尝试实现传统支持向量机算法的代码,并逐步过渡到量子支持向量机算法的实现。

对于从事量子机器学习研究的专业人员来说,也可以借助量子计算机和量子编程平台进行快速实现和迭代。

SVM支持向量机算法的详细推导详细到每个步骤值得

SVM支持向量机算法的详细推导详细到每个步骤值得SVM(Support Vector Machine,支持向量机)是一种用于二分类和回归问题的机器学习算法。

它的目标是找到一个最优的超平面来分离数据,并尽量使得不同类别的数据点离超平面的距离最大化。

以下是SVM算法的详细推导,包括每个步骤:1.准备数据集:2.选择合适的核函数:-SVM算法可以使用不同的核函数,如线性核、多项式核和高斯核等。

根据数据的特点和问题的需求,选择合适的核函数。

3.对数据进行标准化:-由于SVM算法对特征的尺度敏感,一般需要对数据进行标准化处理,使得每个特征的均值为0,方差为14.定义目标函数:-SVM算法的目标是找到一个最优的超平面,使得正负样本离超平面的距离最大化。

-目标函数的定义包括约束条件和目标函数本身。

5.引入松弛变量:-当数据不是线性可分时,引入松弛变量来容忍部分错误分类。

6.构造拉格朗日函数:-将目标函数和约束条件结合,构造拉格朗日函数。

7.对拉格朗日函数求偏导数:-将拉格朗日函数对权重和松弛变量求偏导数,得到一系列的约束条件。

8.求解对偶问题:-再将约束条件代入原最大化问题中,通过求解对偶问题来得到最优解。

9.计算分离超平面:-根据求解出的拉格朗日乘子,计算出最优分离超平面。

10.预测新样本:-使用训练得到的超平面,对新的样本进行预测分类。

11.优化模型:-对模型进行交叉验证等优化操作,以提高模型的泛化能力和预测准确率。

以上是SVM算法的详细推导过程。

该算法的关键在于通过优化拉格朗日函数来求解最优的分离超平面。

同时,SVM算法的应用领域非常广泛,在各种机器学习和数据挖掘问题中都有很好的表现。

支持向量机算法原理

支持向量机算法原理支持向量机算法(SupportVectorMachine,称SVM)是一种有效的机器学习算法,它可以解决分类和回归问题。

SVM是一种二类分类模型,它可以将新实例分配到两类中,正负类,或多类分类问题中的其他类别。

在数据分析中,SVM算法不仅可以解决分类问题,而且还可以解决回归问题。

SVM算法的基本原理是通过搜索最大化类间距,保证训练数据之间最大可分离性,进而找到最优超平面,完成分类任务。

SVM算法可以用来定义和解决各种回归和分类问题。

它的核心思想是通过计算支持向量和超平面来将训练数据划分成多个类别。

支持向量机算法可以通过以下步骤完成:1.首先,根据训练集的特征向量数据,SVM算法建立一个最优超平面的模型,该模型可以将训练数据分割成正类和负类;2.其次,确定最优超平面的距离函数及其支持向量;3.最后,根据支持向量来求解实例的分类结果,实现分类支持向量机算法的核心思想是找到使得类间距最大的超平面,从而使用最大空隙分割实例类。

为此,SVM会找到一个最优超平面,用于从训练数据中区分不同类别的实例,空隙就是超平面距离分类边界最远的两个样本点之间的距离,它反映了两个类别之间的分离程度,距离越大,分类器的泛化能力就越强。

SVM是一种有效的机器学习算法,它可以根据训练样本的特征来分析出相关的超平面,并将输入数据自动分类到相应的类别中,从而实现了分类任务。

SVM算法最大的优势之一是可以处理非线性可分问题,即数据不是简单的线性可分,而是非线性边界,而且也支持多分类。

它在特征空间中有一个可解释的模型,可以帮助理解分类的过程,它的运算速度快,且不需要太多的参数调整,一般地,一次训练就可以获得优良的模型,它也具有稳定性好,容忍噪声,可处理大量维度的特征,并且具有良好的性能。

另外,SVM存在一些不足之处,首先,SVM模型没有显式地输出类间概率,从而无法衡量样本属于某类别的概率。

其次,SVM是基于凸且仅支持二类分类,而不能解决多类分类问题。

支持向量机的实现

支持向量机的实现SVM的实现主要涉及以下几个步骤:1.数据预处理:首先,需要对数据进行预处理,包括数据清洗、特征选择和特征缩放。

数据清洗是指对数据进行处理,如去除缺失值或异常值。

特征选择是选择对分类任务有影响的特征。

特征缩放是对特征进行归一化,使得它们具有相似的尺度。

2.定义目标变量:SVM可以用于二元分类和多元分类问题。

对于二元分类问题,我们需要将目标变量转换为两个类别。

对于多元分类问题,可以使用一对一或一对多的方法。

3.寻找最优超平面:SVM的目标是寻找一个最优的超平面,将不同类别的数据点分开。

最优超平面的选择是通过最大化间隔来实现的,即最大化分类边界的宽度。

其中,分类边界由支持向量(离超平面最近的点)决定。

4.核函数选择:在一些情况下,数据可能不是线性可分的。

这时可以使用核函数将数据投射到高维空间,使其在高维空间可分。

常用的核函数有线性核、多项式核和高斯核。

5.超参数调整:SVM有一些超参数需要调整,例如正则化参数C和核函数的参数。

可以使用交叉验证或网格来确定最优的超参数值。

6.模型评估:使用测试数据集来评估训练好的SVM模型的性能。

常用的评估指标有准确率、精确率、召回率和F1得分。

SVM的实现可以使用各种编程语言和库。

在Python中,scikit-learn是一个常用的机器学习库,它提供了SVM的实现。

下面是一个使用scikit-learn库实现SVM的示例代码:```pythonfrom sklearn import svmfrom sklearn.model_selection import train_test_splitfrom sklearn.metrics import classification_reportfrom sklearn.preprocessing import StandardScaler#1.数据预处理#假设数据集已经加载为X和y,其中X是特征矩阵,y是目标变量#将数据集划分为训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=0)#特征缩放scaler = StandardScalerX_train = scaler.fit_transform(X_train)X_test = scaler.transform(X_test)#2.创建SVM模型model = svm.SVC(kernel='rbf', C=1.0, gamma='scale')#3.训练模型model.fit(X_train, y_train)#4.模型评估y_pred = model.predict(X_test)print(classification_report(y_test, y_pred))```在以上示例代码中,首先对数据进行预处理,包括划分训练集和测试集,并进行特征缩放。

Python中的支持向量机SVM的使用(有实例)

除了在Matlab中使用PRTools工具箱中的svm算法,Python中一样可以使用支持向量机做分类。

因为Python中的sklearn库也集成了SVM算法,本文的运行环境是Pycharm。

一、导入sklearn算法包Scikit-Learn库已经实现了所有基本机器学习的算法,具体使用详见官方文档说明:http://scikit-/stable/auto_examples/index.html#support-vector-machines。

skleran中集成了许多算法,其导入包的方式如下所示,逻辑回归:from sklearn.linear_model import LogisticRegression朴素贝叶斯:from sklearn.naive_bayes import GaussianNBK-近邻:from sklearn.neighbors import KNeighborsClassifier决策树:from sklearn.tree import DecisionTreeClassifier支持向量机:from sklearn import svm二、sklearn中svc的使用(1)使用numpy中的loadtxt读入数据文件loadtxt()的使用方法:fname:文件路径。

eg:C:/Dataset/iris.txt。

dtype:数据类型。

eg:float、str等。

delimiter:分隔符。

eg:‘,’。

converters:将数据列与转换函数进行映射的字典。

eg:{1:fun},含义是将第2列对应转换函数进行转换。

usecols:选取数据的列。

以Iris兰花数据集为例子:由于从UCI数据库中下载的Iris原始数据集的样子是这样的,前四列为特征列,第五列为类别列,分别有三种类别Iris-setosa, Iris-versicolor, Iris-virginica。

机器学习算法与Python实践之(四)支持向量机(SVM)实现 - zouxy09的专栏 - 博客频道 - CSDN

7月推荐文章汇总 得下载分

Android 精彩案例

【独具慧眼 推荐有礼】找出您心中的技术大牛

博文大赛获奖名单公布

关注社区微信

机器学习算法与Python实践之(四)支持向量机(SVM)实现

分类: 机器学习 C/C++编程

2013-12-13 00:12 8407人阅读 评论(15) 收藏 举报

机器学习算法与Python实践之(四)支持向量机(SVM)实现 zouxy09@

最里面语句的意思是固定除αi之外的所有αj(i不等于j),这时W可看作只是关于αi的函 数,那么直接对αi求导优化即可。这里我们进行最大化求导的顺序i是从1到m,可以通过更 改优化顺序来使W能够更快地增加并收敛。如果W在内循环中能够很快地达到最优,那么 坐标上升法会是一个很高效的求极值方法。

用个二维的例子来说明下坐标下降法:我们需要寻找f(x,y)=x2+xy+y2的最小值处的(x*, y*),也就是下图的F*点的地方。

Opencv是下载的源码 然后自己 编译的 运行tld时老是显示

假设要求解下面的优化问题:

capture devi...

机器学习中的范数规则化之(一)L0、L1与L2范数

xyy19920105: 博主大牛啊,这个

内容是挺充分的,只是有些东西

看的感觉有些不对啊.....望博主回 头没事多看看,改掉些...

/zouxy09

访问: 1164586次 积分: 10428分 排名: 第380名

原创: 108篇 转载: 11篇 译文: 1篇 评论: 1823条

个人简介 广州 华南理工大学 研二。 关注:机器学习、计算机视觉、 人机交互和人工智能等领域。 邮箱:zouxy09@ 微博:Erik-zou

多核支持向量机方法及实现技巧

多核支持向量机方法及实现技巧支持向量机(Support Vector Machine,SVM)是一种常用的机器学习方法,用于二分类和多分类问题。

它的主要思想是在高维空间中找到一个最优超平面,将不同类别的样本分开。

然而,随着数据量的增加和问题复杂度的提高,传统的SVM算法在计算效率和准确性方面面临一些挑战。

为了解决这些问题,多核支持向量机方法被提出并得到了广泛应用。

多核支持向量机(Multiple Kernel Support Vector Machine,MK-SVM)是一种改进的SVM方法,它通过引入多个核函数来提高分类器的性能。

核函数是SVM中的关键组成部分,它用于将数据从低维空间映射到高维空间,从而使得数据在高维空间中更容易分开。

传统的SVM通常使用线性核函数,但是对于复杂的非线性问题,线性核函数的表现可能不佳。

多核支持向量机通过使用多个核函数的组合,可以更好地适应不同类型的数据。

在多核支持向量机中,核函数的选择非常重要。

常用的核函数包括线性核函数、多项式核函数、高斯核函数等。

不同的核函数适用于不同的数据类型和问题。

例如,线性核函数适用于线性可分的问题,而高斯核函数适用于非线性问题。

在实际应用中,我们可以根据特定问题的性质和数据的特点选择最合适的核函数。

除了核函数的选择,多核支持向量机还需要考虑核函数的权重。

不同核函数对最终分类结果的贡献程度不同,因此需要对核函数进行加权。

权重的选择可以通过交叉验证等方法来确定。

在实现过程中,我们可以使用网格搜索等技术来寻找最优的核函数和权重组合。

另一个关键问题是多核支持向量机的训练和预测效率。

传统的SVM算法在处理大规模数据集时可能面临计算复杂度高的问题。

为了提高效率,可以使用一些优化技术,例如核矩阵近似、并行计算等。

核矩阵近似可以通过降低核矩阵的维度来减少计算量,而并行计算可以利用多核处理器的优势来加速计算过程。

此外,多核支持向量机还可以与其他机器学习方法结合,形成集成学习模型。

matlab中最简单的svm例子

在MATLAB中,最简单的SVM(支持向量机)例子可以通过以下步骤实现:1. 导入数据:首先,我们需要导入一些用于训练和测试的数据集。

这里我们使用MATLAB 内置的鸢尾花数据集。

```matlabload fisheriris; % 加载鸢尾花数据集X = meas; % 提取特征矩阵Y = species; % 提取标签向量```2. 划分训练集和测试集:我们将数据集划分为训练集和测试集,以便评估模型的性能。

```matlabcv = cvpartition(size(X,1),'HoldOut',0.5); % 划分训练集和测试集idx = cv.test; % 获取测试集的索引XTrain = X(~idx,:); % 提取训练集的特征矩阵YTrain = Y(~idx,:); % 提取训练集的标签向量XTest = X(idx,:); % 提取测试集的特征矩阵YTest = Y(idx,:); % 提取测试集的标签向量```3. 创建SVM模型:接下来,我们创建一个SVM模型,并设置相应的参数。

```matlabSVMModel = fitcsvm(XTrain,YTrain,'KernelFunction','linear'); % 创建线性核函数的SVM 模型```4. 预测和评估:最后,我们使用训练好的模型对测试集进行预测,并评估模型的性能。

```matlabYPred = predict(SVMModel,XTest); % 对测试集进行预测accuracy = sum(YPred == YTest)/length(YTest) * 100; % 计算准确率fprintf('Accuracy: %.2f%%', accuracy); % 输出准确率```这个例子展示了如何在MATLAB中使用最简单的SVM方法进行分类。

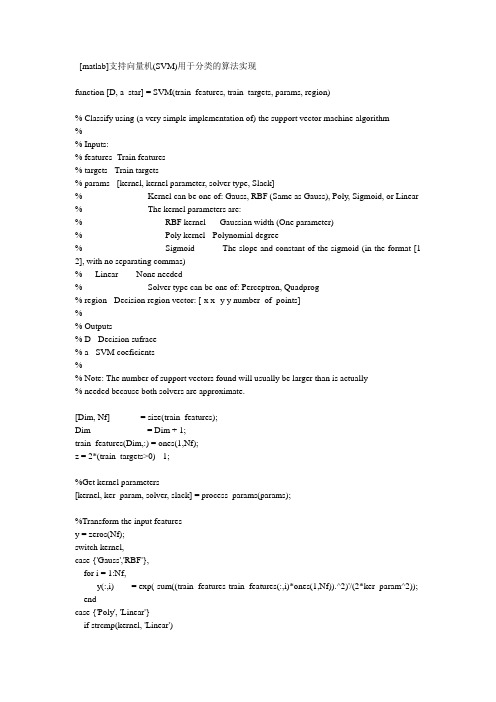

matlab支持向量机SVM用于分类的算法实现

[matlab]支持向量机(SVM)用于分类的算法实现function [D, a_star] = SVM(train_features, train_targets, params, region)% Classify using (a very simple implementation of) the support vector machine algorithm%% Inputs:% features- Train features% targets - Train targets% params - [kernel, kernel parameter, solver type, Slack]% Kernel can be one of: Gauss, RBF (Same as Gauss), Poly, Sigmoid, or Linear % The kernel parameters are:% RBF kernel - Gaussian width (One parameter)% Poly kernel - Polynomial degree% Sigmoid - The slope and constant of the sigmoid (in the format [1 2], with no separating commas)% Linear - None needed% Solver type can be one of: Perceptron, Quadprog% region - Decision region vector: [-x x -y y number_of_points]%% Outputs% D - Decision sufrace% a - SVM coeficients%% Note: The number of support vectors found will usually be larger than is actually% needed because both solvers are approximate.[Dim, Nf] = size(train_features);Dim = Dim + 1;train_features(Dim,:) = ones(1,Nf);z = 2*(train_targets>0) - 1;%Get kernel parameters[kernel, ker_param, solver, slack] = process_params(params);%Transform the input featuresy = zeros(Nf);switch kernel,case {'Gauss','RBF'},for i = 1:Nf,y(:,i) = exp(-sum((train_features-train_features(:,i)*ones(1,Nf)).^2)'/(2*ker_param^2)); endcase {'Poly', 'Linear'}if strcmp(kernel, 'Linear')ker_param = 1;endfor i = 1:Nf,y(:,i) = (train_features'*train_features(:,i) + 1).^ker_param;endcase 'Sigmoid'if (length(ker_param) ~= 2)error('This kernel needs two parameters to operate!')endfor i = 1:Nf,y(:,i) = tanh(train_features'*train_features(:,i)*ker_param(1)+ker_param(2)); endotherwiseerror('Unknown kernel. Can be Gauss, Linear, Poly, or Sigmoid.')end%Find the SVM coefficientsswitch solvercase 'Quadprog'%Quadratic programmingif ~isfinite(slack)alpha_star = quadprog((z'*z).*(y'*y), -ones(1, Nf), [], [], z, 0, 0)';elsealpha_star = quadprog((z'*z).*(y'*y), -ones(1, Nf), [], [], z, 0, 0, slack)'; enda_star = (alpha_star.*z)*y';%Find the biasin = find((alpha_star > 0) & (alpha_star < slack));if isempty(in),bias = 0;elseB = z(in) - a_star * y(:,in);bias = mean(B(in));endcase 'Perceptron'max_iter = 1e5;iter = 0;rate = 0.01;xi = ones(1,Nf)/Nf*slack;if ~isfinite(slack),slack = 0;end%Find a start pointprocessed_y = [y; ones(1,Nf)] .* (ones(Nf+1,1)*z);a_star = mean(processed_y')';while ((sum(sign(a_star'*processed_y+xi)~=1)>0) & (iter < max_iter))iter = iter + 1;if (iter/5000 == floor(iter/5000)),disp(['Working on iteration number ' num2str(iter)])end%Find the worse classified sample (That farthest from the border)dist = a_star'*processed_y+xi;[m, indice] = min(dist);a_star = a_star + rate*processed_y(:,indice);%Calculate the new slack vectorxi(indice) = xi(indice) + rate;xi = xi / sum(xi) * slack;endif (iter == max_iter),disp(['Maximum iteration (' num2str(max_iter) ') reached']);elsedisp(['Converged after ' num2str(iter) ' iterations.'])endbias = 0;a_star = a_star(1:Nf)';case 'Lagrangian'%Lagrangian SVM (See Mangasarian & Musicant, Lagrangian Support Vector Machines) tol = 1e-5;max_iter = 1e5;nu = 1/Nf;iter = 0;D = diag(z);alpha = 1.9/nu;e = ones(Nf,1);I = speye(Nf);Q = I/nu + D*y'*D;P = inv(Q);u = P*e;oldu = u + 1;while ((iter<max_iter) & (sum(sum((oldu-u).^2)) > tol)), iter = iter + 1;if (iter/5000 == floor(iter/5000)),disp(['Working on iteration number ' num2str(iter)]) endoldu = u;f = Q*u-1-alpha*u;u = P*(1+(abs(f)+f)/2);enda_star = y*D*u(1:Nf);bias = -e'*D*u;otherwiseerror('Unknown solver. Can be either Quadprog or Perceptron') end%Find support verctorssv = find(abs(a_star) > 1e-10);Nsv = length(sv);if isempty(sv),error('No support vectors found');elsedisp(['Found ' num2str(Nsv) ' support vectors'])end%Marginb = 1/sqrt(sum(a_star.^2));disp(['The margin is ' num2str(b)])%Now build the decision regionN = region(5);xx = linspace (region(1),region(2),N);yy = linspace (region(3),region(4),N);D = zeros(N);for j = 1:N,y = zeros(N,1);for i = 1:Nsv,data = [xx(j)*ones(1,N); yy; ones(1,N)];switch kernel,case {'Gauss','RBF'},y = y + a_star(i) * exp(-sum((data-train_features(:,sv(i))*ones(1,N)).^2)'/(2*ker_param^2));case {'Poly', 'Linear'}y = y + a_star(i) * (data'*train_features(:,sv(i))+1).^ker_param;case 'Sigmoid'y = y + a_star(i) * tanh(data'*train_features(:,sv(i))*ker_param(1)+ker_param(2));endendD(:,j) = (y + bias);end。

支持向量机算法在图像处理中的应用研究

支持向量机算法在图像处理中的应用研究随着数字技术的发展,图像处理已经成为许多领域必不可少的技术。

在图像处理中,如何有效地实现图像分类,一直是一个重要的研究方向。

支持向量机(Support Vector Machine,简称 SVM)是一种强大的模式识别方法,具有较高的分类精度和良好的泛化性能。

近年来,SVM算法在图像处理领域也得到广泛应用,取得了一定的研究成果。

本文将介绍SVM算法在图像处理中的应用研究,并探讨其实现方法及优势。

1. SVM算法简介SVM算法是一种特别适合于分类问题、以SVM为核心的机器学习算法。

它采用间隔最大化的策略,选取能够最大化类别间距离的最优分类超平面。

这种分类器具有较高的分类精度和泛化性能。

SVM的分类模型可以表示为:f(x) = sign(w*x + b)其中 w 和 b 分别为支持向量的权值和偏移量,x 为输入向量,f(x) 为预测值。

SVM算法的实现过程大致分为以下几步:(1) 数据预处理:对原始数据进行预处理,去掉噪声、缩放、归一化等。

(2) 特征提取:将图像转化成目标特征向量。

(3) 选择核函数:根据实际数据选择合适的核函数。

(4) 训练模型:根据样本数据训练SVM分类器模型。

(5) 预测:根据训练好的模型进行图像分类。

2. SVM算法在图像处理中的应用研究2.1 图像分类图像分类是指将图像分为不同的类别,是图像处理领域最基本的问题之一。

SVM算法可以用于解决不同类别的图像分类问题。

以人脸识别为例,要求将人脸图片按照人物进行分类。

首先需要对每幅人脸图像进行预处理和特征提取,然后使用SVM分类器进行分类,最终得到人脸图像的分类结果。

研究表明,使用SVM算法对车牌字符进行分类,分类准确率可以高达90%以上,远远超过了传统分类器的分类精度。

这说明SVM算法在图像分类中具有较高的分类精度和泛化性能。

2.2 目标检测目标检测是指在图像或视频中检测、定位目标的过程。

常见的目标检测,例如人脸、车辆检测,在多媒体信息处理、医学图像分析等领域中有着广泛的应用。

支持向量机(SVM)的实现

模式识别课程大作业报告—-支持向量机(SVM)的实现姓名:学号:专业:任课教师:研究生导师:内容摘要支持向量机是一种十分经典的分类方法,它不仅是模式识别学科中的重要内容,而且在图像处理领域中得到了广泛应用。

现在,很多图像检索、图像分类算法的实现都以支持向量机为基础.本次大作业的内容以开源计算机视觉库OpenCV为基础,编程实现支持向量机分类器,并对标准数据集进行测试,分别计算出训练样本的识别率和测试样本的识别率。

本报告的组织结构主要分为3大部分。

第一部分简述了支持向量机的原理;第二部分介绍了如何利用OpenCV来实现支持向量机分类器;第三部分给出在标准数据集上的测试结果.一、支持向量机原理概述在高维空间中的分类问题实际上是寻找一个超平面,将两类样本分开,这个超平面就叫做分类面.两类样本中离分类面最近的样本到分类面的距离称为分类间隔。

最优超平面指的是分类间隔最大的超平面。

支持向量机实质上提供了一种利用最优超平面进行分类的方法.由最优分类面可以确定两个与其平行的边界超平面。

通过拉格朗日法求解最优分类面,最终可以得出结论:实际决定最优分类面位置的只是那些离分类面最近的样本。

这些样本就被称为支持向量,它们可能只是训练样本中很少的一部分。

支持向量如图1所示。

图1图1中,H是最优分类面,H1和H2别是两个边界超平面。

实心样本就是支持向量。

由于最优超平面完全是由这些支持向量决定的,所以这种方法被称作支持向量机(SVM).以上是线性可分的情况,对于线性不可分问题,可以在错分样本上增加一个惩罚因子来干预最优分类面的确定。

这样一来,最优分类面不仅由离分类面最近的样本决定,还要由错分的样本决定。

这种情况下的支持向量就由两部分组成:一部分是边界支持向量;另一部分是错分支持向量。

对于非线性的分类问题,可以通过特征变换将非线性问题转化为新空间中的线性问题。

但是这样做的代价是会造成样本维数增加,进而导致计算量急剧增加,这就是所谓的“维度灾难".为了避免高维空间中的计算,可以引入核函数的概念。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

模式识别课程大作业报告——支持向量机(SVM)的实现姓名:学号:专业:任课教师:研究生导师:内容摘要支持向量机是一种十分经典的分类方法,它不仅是模式识别学科中的重要内容,而且在图像处理领域中得到了广泛应用。

现在,很多图像检索、图像分类算法的实现都以支持向量机为基础。

本次大作业的内容以开源计算机视觉库OpenCV为基础,编程实现支持向量机分类器,并对标准数据集进行测试,分别计算出训练样本的识别率和测试样本的识别率。

本报告的组织结构主要分为3大部分。

第一部分简述了支持向量机的原理;第二部分介绍了如何利用OpenCV来实现支持向量机分类器;第三部分给出在标准数据集上的测试结果。

一、支持向量机原理概述在高维空间中的分类问题实际上是寻找一个超平面,将两类样本分开,这个超平面就叫做分类面。

两类样本中离分类面最近的样本到分类面的距离称为分类间隔。

最优超平面指的是分类间隔最大的超平面。

支持向量机实质上提供了一种利用最优超平面进行分类的方法。

由最优分类面可以确定两个与其平行的边界超平面。

通过拉格朗日法求解最优分类面,最终可以得出结论:实际决定最优分类面位置的只是那些离分类面最近的样本。

这些样本就被称为支持向量,它们可能只是训练样本中很少的一部分。

支持向量如图1所示。

图1图1中,H是最优分类面,H1和H2别是两个边界超平面。

实心样本就是支持向量。

由于最优超平面完全是由这些支持向量决定的,所以这种方法被称作支持向量机(SVM)。

以上是线性可分的情况,对于线性不可分问题,可以在错分样本上增加一个惩罚因子来干预最优分类面的确定。

这样一来,最优分类面不仅由离分类面最近的样本决定,还要由错分的样本决定。

这种情况下的支持向量就由两部分组成:一部分是边界支持向量;另一部分是错分支持向量。

对于非线性的分类问题,可以通过特征变换将非线性问题转化为新空间中的线性问题。

但是这样做的代价是会造成样本维数增加,进而导致计算量急剧增加,这就是所谓的“维度灾难”。

为了避免高维空间中的计算,可以引入核函数的概念。

这样一来,无论变换后空间的维数有多高,这个新空间中的线性支持向量机求解都可以在原空间通过核函数来进行。

常用的核函数有多项式核、高斯核(径向基核)、Sigmoid函数。

二、支持向量机的实现OpenCV是开源计算机视觉库,它在图像处理领域得到了广泛应用。

OpenCV 中包含许多计算机视觉领域的经典算法,其中的机器学习代码部分就包含支持向量机的相关内容。

OpenCV中比较经典的机器学习示例是“手写字母分类”。

OpenCV中给出了用支持向量机实现该示例的代码。

本次大作业的任务是研究OpenCV中的支持向量机代码,然后将其改写为适用于所有数据库的通用程序,并用标准数据集对算法进行测试。

本实验中使用的OpenCV版本是2.4.4,实验平台为Visual Studio 2010软件平台。

OpenCV读取的输入数据格式为“.data”文件。

该文件记录了所有数据样本的特征向量和标签。

OpenCV自带的“letter-recognition”数据集是手写字母数据集。

其中共包含20000个样本,前16000个用来训练,后4000个用来测试。

样本是16维的特征向量。

每条样本在文件中按行存放。

每行共有17个字段,第1个字段是样本的标签,以字符形式给出;后面16个字段分别是样本的16个特征,以数字形式给出。

所有字段之间均以逗号分隔。

图2图2中展示了“.data”文件中样本的存储样式。

自行生成“.data”文件的过程十分简单。

只需要新建一个“.txt”文件,对其内容进行修改之后,直接把后缀改为“.data”即可。

在OpenCV给出的支持向量机示例程序中,可调参数大约有十多个,这些参数的调整比较复杂。

为了方便使用该程序,可以将其中重要的参数从程序段中挑选出来,并制作宏定义。

这些重要参数包括:总样本个数、用于训练的样本个数(总样本个数-训练样本个数=测试样本个数)、特征向量的维数、选取的核函数类型。

可调参数如图3所示:图3在更换新的数据集时,只需要在宏定义部分修改“PATH”后的路径即可,其他参数的修改也都在这里进行,无需再到代码段内进行修改。

其中,宏定义“KERNEL”用来确定SVM采用何种核函数。

执行程序后,可以显示出训练样本和测试样本的识别率。

通过将程序中分类数组的值输出,还可以在原有程序基础上添加显示测试样本标签的功能。

对“letter-recognition”数据集进行分类得到的结果如图4所示:图4图4展示了4000个测试样本标签和训练样本识别率以及测试样本识别率。

可以观察到训练样本的识别率为64.36%,测试样本的识别率为60.75%。

将图4中展示的测试样本标签与“.data”文件中的标签对比,可以直观地观察到哪个数据判断错误。

图5展示了程序输出的测试样本标签与“.data”文件中标签的对应关系。

(a) (b)图5观察图5可以发现,第一行字母P的识别是正确的,而第三行的预测出现了错误。

样本集中的数据为“O”,但支持向量机将其错分为“B”。

按上述方法可以一一对照测试样本的预测结果是否正确。

接下来,采用其他核函数进行分类。

图6展示的是径向基函数的分类效果。

图6观察图6可以看出,采用径向基函数可以获得极高的样本识别率,可达100%。

但是测试样本的识别率为51.25%,比起线性基函数有所下降,说明其泛化能力(即推广能力)有限。

测试表明,对于“letter-recognition”,采用多项式基函数和Sigmoid基函数分类的识别率更低,因此对此数据集的分类应该采用线性核函数。

三、标准数据集测试前一部分展示了OpenCV自带的“letter-recognition”数据集的测试效果。

为了测试编写的程序的通用性,接下来对其他标准数据集进行测试。

数据集可以从“/ml/”下载,这个网址上提供了上万个用于机器学习的数据集。

接下来分别展示“iris”数据集和“wine”数据集上的测试结果。

(1)“iris”数据集“iris”数据集是鸢尾花数据集。

其中共包含150个样本,每个样本是一个4维的特征向量,这4个特征分别是萼片长度、萼片宽度、花瓣长度和花瓣宽度。

数据的标签总共有三类:“S”代表刺芒野古草,“E”代表杂色鸢尾花,“I”代表维尔吉尼卡。

它们分别是三种不同的鸢尾花品种。

该数据集如图7所示:图7在本实验中,用前130个数据作为训练样本,后20个数据作为测试样本。

选定相应的参数如图8所示:图8图8中,选取核函数为线性核函数。

按照图8所示的参数执行程序,得到的结果如图9所示:图9由图9可知,对于“iris”数据集,训练样本的识别率为98.46%,测试样本的识别率为90.00%。

由数据可以看出,支持向量机对“iris”数据集的分类效果显然要优于“letter-recognition”数据集。

这可能和数据集本身有关,“iris”数据集特征的可分性更好。

接下来,变换核函数来观察分类效果。

图10是采用径向基核函数得到的结果。

图10图10中,训练样本的识别率比采用线性核函数时略有提升,但测试样本的识别率没有变化,因此可以认为采用径向基核函数与线性核函数的分类效果是基本相同的。

当采用Sigmoid函数进行分类时,分类效果显然要差很多。

该分类效果如图11所示。

图11图11中,训练样本和测试样本的识别率都很低,因此“iris”数据集显然不适合用Sigmoid函数进行分类。

以上实验结果表明,核函数的选取对于支持向量机的分类效果有至关重要的影响。

(2)“wine”数据集“wine”数据集是红酒数据集。

其中共包含178个样本,每个样本是一个13维的特征向量,其中包含酒精度、年份等特征。

数据的标签总共有三类:“M”、“H”、“L”。

它们分别代表三类不同的红酒。

该数据集如图12所示:图12本实验用前125个数据作为训练样本,后53个数据作为测试样本。

选定相应的参数如图13所示:2图13图13中,核函数选定为线性核函数。

按照上述参数设置执行程序,得到的结果如图14所示:图14由图14可得,对于“wine”数据集,训练样本的识别率为88.00%,测试样本的识别率为37.74%。

训练样本的识别率较高,但测试样本的识别率却较低。

这说明该学习过程的泛化能力较差。

这可能由于样本数量有限,支持向量机方法很难从这么有限的样本中训练出较为理想的分类器。

接下来,尝试采用其他核函数的分类效果。

结果发现,其他和函数的分类效果并没有线性核函数的分类效果好。

当采用径向基核函数时,训练样本的识别率可达100%,但测试样本的识别率变得非常低。

该结果如图15所示。

图15可见,对于“wine”数据集来讲,采用径向基核函数虽然能使训练样本识别率最高,但其泛化能力最差,因此对解决实际问题没有任何帮助。

综合比较上述结果,可以发现径向基函数在大多数情况下都可以获得较高的训练样本识别率,即经验风险很小。

但是,测试样本的识别率无法保证,对于某些数据集的泛化能力有限。

致谢今后,我会从事机器学习方向的研究。

模式识别课程的内容对我的专业方向有很大帮助,令我受益匪浅。

尤其是在本次大作业过程中,支持向量机的编程实现工作大大加深了我对支持向量机原理的理解,为我今后的研究工作打下了坚实基础。

模式识别课程的学习是我研究道路上的一个良好开端,具有十分重要的意义。

本学期的模式识别课程令我受益颇多。

在此,诚挚地感谢李建更老师的辛勤付出!附录:源程序代码#include "opencv2/core/core_c.h"#include "opencv2/ml/ml.hpp"#include <cstdio>#include <vector>/*******************设置文件路径********************/ #define PATH "./letter-recognition.data"/*******************设置样本个数********************/ #define SAMPLE 20000/*****************设置训练样本个数******************/ #define TRAIN 16000/*****************设置特征向量维数******************/ #define VECTOR 16/**************************************************//********************读取数据***********************/ static intread_num_class_data( const char* filename, int var_count,CvMat** data, CvMat** responses ) {const int M = 1024;FILE* f = fopen( filename, "rt" );CvMemStorage* storage;CvSeq* seq;char buf[M+2];float* el_ptr;CvSeqReader reader;int i, j;if( !f )return 0;el_ptr = new float[var_count+1];storage = cvCreateMemStorage();seq = cvCreateSeq( 0, sizeof(*seq), (var_count+1)*sizeof(float), storage );for(;;){char* ptr;if( !fgets( buf, M, f ) || !strchr( buf, ',' ) )break;el_ptr[0] = buf[0];ptr = buf+2;for( i = 1; i <= var_count; i++ ){int n = 0;sscanf( ptr, "%f%n", el_ptr + i, &n );ptr += n + 1;}if( i <= var_count )break;cvSeqPush( seq, el_ptr );}fclose(f);*data = cvCreateMat( seq->total, var_count, CV_32F );*responses = cvCreateMat( seq->total, 1, CV_32F );cvStartReadSeq( seq, &reader );for( i = 0; i < seq->total; i++ ){const float* sdata = (float*)reader.ptr + 1;float* ddata = data[0]->data.fl + var_count*i;float* dr = responses[0]->data.fl + i;for( j = 0; j < var_count; j++ )ddata[j] = sdata[j];*dr = sdata[-1];CV_NEXT_SEQ_ELEM( seq->elem_size, reader );}cvReleaseMemStorage( &storage );delete[] el_ptr;return 1;}/*********************支持向量机分类器*************************/ staticint build_svm_classifier( char* data_filename ){CvMat* data = 0;CvMat* responses = 0;CvMat train_data;int nsamples_all = 0, ntrain_samples = 0;int var_count;CvSVM svm;int ok = read_num_class_data( data_filename, VECTOR, &data, &responses );if( !ok ){printf( "无法读取数据库%s\n", data_filename );return -1;}/************************ SVM 参数***************************/ CvSVMParams param;param.kernel_type=CvSVM::LINEAR;param.svm_type=CvSVM::C_SVC;param.C=1;/**************************************************************/printf( "数据库%s 已经被加载\n", data_filename );nsamples_all = SAMPLE;ntrain_samples = TRAIN;var_count = data->cols;/************************训练分类器****************************/ printf( "正在训练SVM分类器...\n");cvGetRows( data, &train_data, 0, ntrain_samples );CvMat* train_resp = cvCreateMat( ntrain_samples, 1, CV_32FC1);for (int i = 0; i < ntrain_samples; i++)train_resp->data.fl[i] = responses->data.fl[i];svm.train(&train_data, train_resp, 0, 0, param);/**************************开始对测试样本分类***************************/ std::vector<float> _sample(var_count * (nsamples_all));CvMat sample = cvMat( nsamples_all , VECTOR, CV_32FC1, &_sample[0] );std::vector<float> true_results(nsamples_all );for (int j = 0; j < nsamples_all; j++){float *s = data->data.fl + j * var_count;for (int i = 0; i < var_count; i++){sample.data.fl[(j) * var_count + i] = s[i];}true_results[j] = responses->data.fl[j];}CvMat *result = cvCreateMat(1, nsamples_all, CV_32FC1);printf("分类中...\n");svm.predict(&sample, result);/**************************显示测试样本的标签**************************/ printf("测试样本的标签预测结果如下:\n");for (int i = ntrain_samples; i < nsamples_all ; i++){printf("测试样本%d=%c\n",i-ntrain_samples+1,char(result->data.fl[i]));}/**************************计算识别率**************************/ printf("/****显示识别率****/\n");//训练样本识别率int true_resp = 0;for (int i = 0; i < ntrain_samples; i++){if (result->data.fl[i] == true_results[i])true_resp++;}printf("训练样本识别率= %.2f%%\n", (float)true_resp / (ntrain_samples) * 100);//测试样本识别率true_resp = 0;for (int i = ntrain_samples; i < nsamples_all; i++){if (result->data.fl[i] == true_results[i])true_resp++;}printf("测试样本识别率= %.2f%%\n", (float)true_resp / (nsamples_all-ntrain_samples) * 100);cvReleaseMat( &train_resp );cvReleaseMat( &result );cvReleaseMat( &data );cvReleaseMat( &responses );return 0;}int main( int argc, char *argv[] ){char* filename_to_save = 0;char* filename_to_load = 0;char default_data_filename[] = PATH;char* data_filename = default_data_filename;int i;for( i = 1; i < argc; i++ ){if( strcmp(argv[i],"-data") == 0 ){i++;data_filename = argv[i];}else if( strcmp(argv[i],"-save") == 0 ){i++;filename_to_save = argv[i];}else if( strcmp(argv[i],"-load") == 0){i++;filename_to_load = argv[i];}elsebreak;}build_svm_classifier( data_filename );return 0;}。