谱聚类算法 算法简介

谱聚类方法

谱聚类方法一、谱聚类的基本原理谱聚类(Spectral Clustering)是一种基于图论的聚类方法,通过研究样本数据的图形结构来进行聚类。

谱聚类方法的基本原理是将高维数据转换为低维数据,然后在低维空间中进行聚类。

它利用样本之间的相似性或距离信息,构建一个图模型(通常是相似度图或距离图),然后对图模型进行谱分解,得到一系列特征向量,最后在特征向量空间中进行聚类。

谱聚类的核心步骤是构建图模型和进行谱分解。

在构建图模型时,通常采用相似度矩阵或距离矩阵来表示样本之间的联系。

在谱分解时,通过对图模型的拉普拉斯矩阵进行特征分解,得到一系列特征向量,这些特征向量表示了样本数据的低维空间结构。

通过对特征向量空间进行聚类,可以将高维数据分为若干个类别。

二、谱聚类的优缺点1.优点(1)适用于高维数据:谱聚类方法能够有效地处理高维数据,因为它的核心步骤是将高维数据转换为低维数据,然后在低维空间中进行聚类。

这有助于克服高维数据带来的挑战。

(2)对噪声和异常值具有较强的鲁棒性:谱聚类方法在构建图模型时,会考虑到样本之间的相似性和距离信息,从而在一定程度上抑制了噪声和异常值的影响。

(3)适用于任意形状的聚类:谱聚类方法可以适用于任意形状的聚类,因为它的聚类结果是基于特征向量空间的,而特征向量空间可以捕捉到样本数据的全局结构。

2.缺点(1)计算复杂度高:谱聚类的计算复杂度相对较高。

构建图模型和进行谱分解都需要大量的计算。

在大规模数据集上,谱聚类的计算效率可能会成为问题。

(2)对相似度矩阵或距离矩阵的敏感性:谱聚类的结果会受到相似度矩阵或距离矩阵的影响。

如果相似度矩阵或距离矩阵不合理或不准确,可能会导致聚类结果不理想。

(3)对参数的敏感性:谱聚类的结果会受到参数的影响,如相似度度量方式、距离度量方式、图模型的构建方式等。

如果参数选择不当,可能会导致聚类效果不佳。

三、谱聚类的应用场景1.图像分割:谱聚类方法可以应用于图像分割,将图像中的像素点分为若干个类别,从而实现对图像的分割。

常见的六大聚类算法

常见的六大聚类算法六大常见的聚类算法包括K-means聚类算法、层次聚类算法、DBSCAN 算法、OPTICS算法、谱聚类算法和高斯混合模型聚类算法。

1. K-means聚类算法:K-means聚类算法是一种基于距离的聚类算法,它通过最小化数据点与聚类中心之间的欧氏距离来划分数据点。

算法的步骤如下:a.随机选择K个聚类中心。

b.将每个数据点分配到距离最近的聚类中心。

c.更新聚类中心为选定聚类的平均值。

d.重复步骤b和c直到聚类中心不再改变或达到最大迭代次数。

2.层次聚类算法:层次聚类算法是一种自底向上或自顶向下递归地将数据划分成不同的聚类的方法。

它通过计算数据点之间的距离或相似度来判断它们是否应该被合并到同一个聚类中。

算法的步骤如下:a.初始化每个数据点为一个单独的聚类。

b.计算两个最近的聚类之间的距离或相似度。

c.合并两个最近的聚类,形成一个新的聚类。

d.重复步骤b和c直到所有数据点都被合并到一个聚类中。

3.DBSCAN算法:DBSCAN(Density-Based Spatial Clustering of Applicationswith Noise)算法是一种基于密度的聚类算法,它通过寻找具有足够密度的数据点来划分聚类。

算法的步骤如下:a.随机选择一个未被访问的数据点。

b.如果该数据点的密度达到预设的阈值,则将其归为一个聚类,同时将其相邻且密度达到阈值的数据点添加到聚类中。

c.重复步骤a和b直到所有数据点都被访问。

4.OPTICS算法:OPTICS(Ordering Points To Identify the Clustering Structure)算法是一种基于密度的聚类算法,它通过将数据点按照密度排序来划分聚类。

算法的步骤如下:a.计算每个数据点的可达距离和局部可达密度。

b.根据可达距离和局部可达密度排序所有数据点。

c.根据可达距离和阈值划分聚类。

d.重复步骤b和c直到所有数据点都被访问。

谱聚类算法——精选推荐

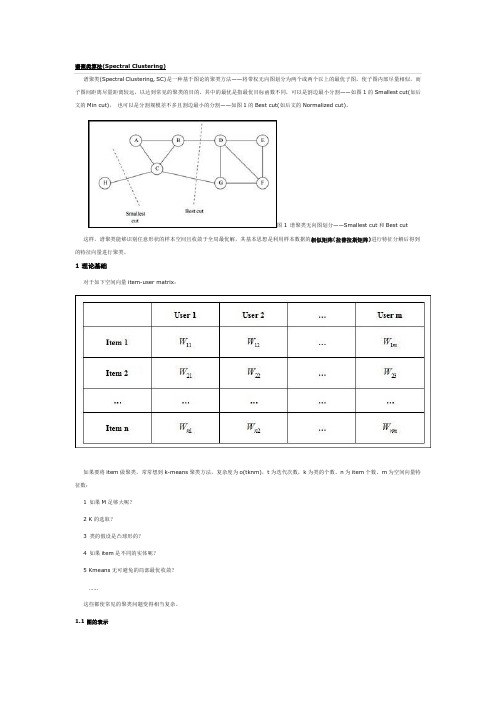

谱聚类算法转载⾃:1、问题描述 谱聚类(Spectral Clustering, SC)是⼀种基于图论的聚类⽅法——将带权⽆向图划分为两个或两个以上的最优⼦图(sub-Graph),使⼦图内部尽量相似,⽽⼦图间距离尽量距离较远,以达到常见的聚类的⽬的。

对于图的相关定义如下:对于⽆向图G = (V,E),V表⽰顶点集合,即样本集合,即⼀个顶点为⼀个样本;E表⽰边集合。

设样本数为n,即顶点数为n。

权重矩阵:W,为n*n的矩阵,其值w i,j为各边的权值,表⽰顶点 i,j(样本)之间的相似性。

对于任意w i,j = w j,i ,w i,i=0,即对⾓线上元素为0。

通常情况下,相似性⼩于某⼀阈值的两个顶点不相连,否则连接两顶点的边的权值为两个样本的相似性度量函数的值。

定义n*n的矩阵:D,其第 i ⾏,第 i 列的元素(对⾓线上)元素为W第 i ⾏所有元素的和,即 i 顶点与其他所有顶点的相似性之和。

将图G分割为⼦图G1,G2,所要断开的边的权重之和为损失函数:如下图给出⼀个六个样本所对应的图:此例中对应的损失函数为 w1,5 + w3,4 = 0.3。

谱聚类的⽬的就是找到⼀个较好的划分准则,将整个样本空间形成的图分成为各个⼦图(sub-Graph),⼀个⼦图即为⼀个类别。

根据分割⼦图的准则,可以将其分为不同的谱聚类(Minimum Cut、Ratio Cut and Normalized Cut等)。

讲具体算法之前,回顾⼀些线性代数有关的结论,不清楚的可以查阅相关资料:Ax = λx ,则λ为A的特征值,x为对应λ的特征向量。

对于实对称矩阵A,其特征向量正交。

即当i ≠ j时, <x i T,x j> = 0(<,>表⽰内积)。

对于正定矩阵,其所有特征值都⼤于0;对于半正定矩阵,其所有特征值都⼤于等于02、问题转化 ⾸先看看这个损失函数,对其进⾏如下变换:1、定义q i如下:当顶点 i 属于⼦图G1中时,q i = c1。

谱聚类算法

其中: assoc(A k , V )

i

Ak ,j V

w ij

Melia 指出Ncut 和MNcut 的差异之处仅在于所使用的 谱映射不同, 并且当k= 2 时, MNcut 与Ncut 等价。多路规 范割集准则在实际应用中合理有效, 但其优化问题通常难以 解决。

相似矩阵、度矩阵及Laplacian 矩阵

cut(A ,B )

i ,

w ij Aj B

通过最小化上述剪切值来划分图G, 这一划分准则被称 为最小割集准则。他们用这个准则对一些图像进行分割, 并 产生了较好的效果, 同时他们也注意到, 该准则容易出现歪 斜( 即偏向小区域) 分割。规范割集准则及比例割集准则均 可避免这种情况的发生。

谱聚类算法

根据不同的准则函数及谱映射方法, 谱聚类算法发展了很多

不同的具体实现方法, 但是都可以归纳为下面三个主要步骤 :

构建表示样本集的矩阵Z; 通过计算Z 的前k 个特征值与特征向量, 构建特征向量空间; 利用k-means 或其它经典聚类算法对特征向量空间中的特征向 量进行聚类。 上述步骤是谱聚类算法的一个框架, 在具体实现过程中,不同 的算法在数据集矩阵Z 的表示上存在着不同。例如根据2 way cut 的目标函数, Z= W; 根据随机游动关系, 则Z=D- 1W 等。划分准则一 般分为2 way 和k way, 本文根据所使用的划分准则, 将算法分为迭 代谱和多路谱两类, 并分别讨论了各类中典型的谱聚类算法。

可以看出Avcut 和Ncut 函数都表示无向图G 中边界损

失与分割区域相关性的比值之和, 因此最小化Avcut 与Ncut 目标函数都能产生较准确的划分。其共同缺点是倾向于欠 分割且易分割出只包含几个顶点的较小子图。文献通过实 验发现, 当把Normalized cut 和Average cut 准则分别用于同

数据分析知识:数据挖掘中的谱聚类算法

数据分析知识:数据挖掘中的谱聚类算法数据挖掘是从海量数据中提取有用的信息的一种技术,谱聚类算法是其中的一种经典算法。

本文将从以下几个方面介绍谱聚类算法:算法原理、流程步骤、应用场景、优缺点以及发展趋势。

一、算法原理谱聚类算法是一种基于图论的无监督聚类算法,其基本思想是将数据集看成是图的节点集合,通过图上的边连接不同的节点,将节点划分成不同的子集,从而实现聚类。

谱聚类算法的核心在于矩阵的特征值和特征向量。

假设有N个数据点集成一个矩阵X,每个数据点有m个特征,组成了一个m*N的矩阵。

首先,定义相似度矩阵W,其元素W(i,j)表示第i个数据点和第j个数据点的相似度。

W的计算可以采取欧式距离、余弦相似度、高斯核等方式。

其次,通过对相似度矩阵进行正则化处理,可以得到一个拉普拉斯矩阵L。

拉普拉斯矩阵L是一个对称半正定的矩阵,其用途是度量每个数据点与其他数据点之间的关联度。

接下来,求解拉普拉斯矩阵L的m个最小的非零特征值及其对应的特征向量u1,u2,...,um,并将其组成一个m*N的矩阵U。

特征向量的个数m是谱聚类算法的超参数,通常根据具体情况进行调整。

最后,对特征向量矩阵U进行聚类,将其划分为k个子集,即可完成谱聚类算法。

二、流程步骤谱聚类算法的流程可以归纳为以下几个步骤:1.构建相似度矩阵W2.对相似度矩阵进行正则化处理,得到拉普拉斯矩阵L3.求解拉普拉斯矩阵L的特征值和特征向量4.将特征向量矩阵U进行聚类5.输出聚类结果三、应用场景谱聚类算法广泛应用于社交网络分析、图像分割、文本聚类、机器学习等多个领域。

例如,在社交网络分析中,谱聚类可以将社交网络中的用户划分成不同的群体,从而便于研究用户间的关系;在图像分割中,谱聚类可以将图像像素点划分成不同的区域,从而得到清晰的图像轮廓。

四、优缺点优点:1.对数据分布没有先验要求2.可以有效地解决高维数据聚类问题3.对噪声数据有一定的容忍度4.支持并行化计算,适合于大规模数据集的处理缺点:1.超参数的选取比较困难2.对于纹理复杂、噪声较大、数据量较小的数据集,聚类效果可能不佳3.对于非凸形状的数据集,聚类效果可能不佳五、发展趋势随着数据量的不断增大和数据种类的不断增多,聚类算法的应用也越来越广泛。

谱聚类算法综述

谱聚类算法综述一、本文概述谱聚类算法是一种基于图理论的机器学习技术,它在数据分析和模式识别中发挥着重要作用。

本文旨在对谱聚类算法进行全面的综述,从理论基础、算法流程、应用领域以及最新进展等多个方面进行深入的探讨。

我们将简要介绍谱聚类算法的基本概念和原理,包括图论基础、拉普拉斯矩阵、特征值分解等关键知识点。

然后,我们将详细阐述谱聚类算法的基本流程和主要步骤,包括数据预处理、构建相似度矩阵、计算拉普拉斯矩阵、求解特征向量和聚类等。

接下来,我们将重点分析谱聚类算法在不同领域中的应用,如图像处理、社交网络分析、机器学习等,并探讨其在这些领域中取得的成果和优势。

我们还将对谱聚类算法的性能进行评估,包括其时间复杂度、空间复杂度以及聚类效果等方面。

我们将对谱聚类算法的最新研究进展进行综述,包括新的算法模型、优化方法以及应用领域的拓展等方面。

通过对这些最新进展的梳理和总结,我们可以更好地了解谱聚类算法的发展趋势和未来研究方向。

本文旨在对谱聚类算法进行全面的综述和分析,为读者提供一个清晰、系统的认识框架,同时也为该领域的研究者提供有价值的参考和启示。

二、谱聚类算法的基本原理谱聚类算法是一种基于图理论的聚类方法,它通过将数据点视为图中的节点,数据点之间的相似性视为节点之间的边的权重,从而构建出一个加权无向图。

谱聚类的基本原理在于利用图的拉普拉斯矩阵(Laplacian Matrix)的特征向量来进行聚类。

构建相似度矩阵:需要计算数据点之间的相似度,这通常通过核函数(如高斯核函数)来实现,从而构建出一个相似度矩阵。

构建图的拉普拉斯矩阵:根据相似度矩阵,可以构建出图的度矩阵和邻接矩阵,进而得到图的拉普拉斯矩阵。

拉普拉斯矩阵是相似度矩阵和度矩阵之差,它反映了数据点之间的局部结构信息。

求解拉普拉斯矩阵的特征向量:对拉普拉斯矩阵进行特征分解,得到其特征向量。

这些特征向量构成了一个新的低维空间,在这个空间中,相似的数据点更接近,不相似的数据点更远。

新聚类算法

新聚类算法引言聚类是一种无监督学习方法,用于将数据样本划分为相似的组或簇。

传统的聚类算法如K均值算法和层次聚类算法已经被广泛应用于各个领域。

然而,这些传统算法在处理大规模数据集和高维数据时面临挑战。

为了克服这些问题,研究人员不断提出新的聚类算法。

本文将介绍一些新的聚类算法,包括谱聚类、DBSCAN、OPTICS和MeanShift等。

这些算法通过引入新的思想和技术来改进传统的聚类方法。

1. 谱聚类谱聚类是一种基于图论的聚类方法,它通过构建数据样本之间的相似度矩阵,并对其进行特征分解来实现聚类。

谱聚类具有以下几个关键步骤:1.构建相似度矩阵:根据数据样本之间的相似度计算方法(如欧氏距离、余弦相似度等),构建一个N*N大小的相似度矩阵。

2.归一化相似度矩阵:对相似度矩阵进行归一化,使得每行之和为1。

3.特征分解:对归一化的相似度矩阵进行特征分解,得到特征向量和特征值。

4.K均值聚类:根据特征向量的前K个最大特征值对应的特征向量,将数据样本划分为K个簇。

谱聚类具有较好的性能和可扩展性,在处理高维数据和图像分割等领域取得了显著的成果。

2. DBSCANDBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法,它通过寻找数据样本周围密度较高的区域来实现聚类。

DBSCAN具有以下几个关键概念:1.核心对象:在给定半径ε内至少包含MinPts个样本点的样本被称为核心对象。

2.直接密度可达(Directly Density-Reachable):如果样本p在样本q的ε邻域内,并且q是一个核心对象,则p被认为是直接密度可达于q。

3.密度可达(Density-Reachable):如果存在一系列样本p1, p2, …, pn,其中pi+1是pi关于ε和MinPts直接密度可达的,则pn被认为是密度可达于p。

4.密度相连(Density-Connected):如果存在一个样本o,使得样本p和q都是关于ε和MinPts密度可达于o,则p和q被认为是密度相连的。

谱聚类算法

1)构建表示对象集的相似度矩阵W; 2)通过计算相似度矩阵或拉普拉斯矩阵的前k个特征值与特征向量,构建特征向量空间; 3)利用K-means或其它经典聚类算法对特征向量空间中的特征向量进行聚类。

谱聚类算法

计算机领域术语

01 算法步骤

03 典型的算法 05 面临的问题

目录

02 划分准则 04 算法的新进展

基本信息

谱聚类算法建立在谱图理论基础上,与传统的聚类算法相比,它具有能在任意形状的样本空间上聚类且收敛 于全局最优解的优点。

该算法首先根据给定的样本数据集定义一个描述成对数据点相似度的亲合矩阵,并且计算矩阵的特征值和特征 向量,然后选择合适的特征向量聚类不同的数据点。谱聚类算法最初用于计算机视觉、VLS I设计等领域,最近 才开始用于机器学习中,并迅速成为国际上机器学习领域的研究热点。

Ncut是一个很好的聚类目标函数。它的求解是一个NP难问题。传统的方法是宽松的谱松散方法。Xing与 Jordan[分析了对Ncut的半正定规划(SDP)模型。根据该模型,对Ncut提出了一个比谱松散更紧的下限。同时指 出了Ncut本身不能得到最优的聚类,但它可以通过不同的松散方法获得合理的聚类。

谱聚类方法不仅用于无监督学习中,也用于有约束的半监督学习中。Kamvar等人将PageRank的随机游动模 型运用到相似度矩阵中,根据已知样本的类别修正相似度矩阵。然后根据谱聚类算法获得聚类结果。

Cu等人分析了核k-means的方法,发现最小化核k-means的目标函数等同于一个由数据向量组成的Gram矩阵 的迹最大化问题。同时,迹最大化问题的松散解可以通过Gram矩阵的部分特征分解获得,首次用谱松散的方法获 得核k-means的目标函数的全局最优解。Dhillon在此基础上,又研究了加权核k-means的目标函数,将其与Ncut 目标函数建立,提出了一个可以单调递减Ncut值的新颖的加权核k-means算法。

谱聚类算法

.2谱聚类算法谱聚类算法和很多其他距离算法相比有很多优点,下文会详述此点,同样的,谱聚类也适合解决图切割问题。

谱聚类有个比较有趣的特性,即这个算法可以将图切割问题转换为求由图形成的矩阵的特征值和对应的特征向量问题,这样就把图切割问题转换为矩阵特征值求解及在其基础上的聚类问题。

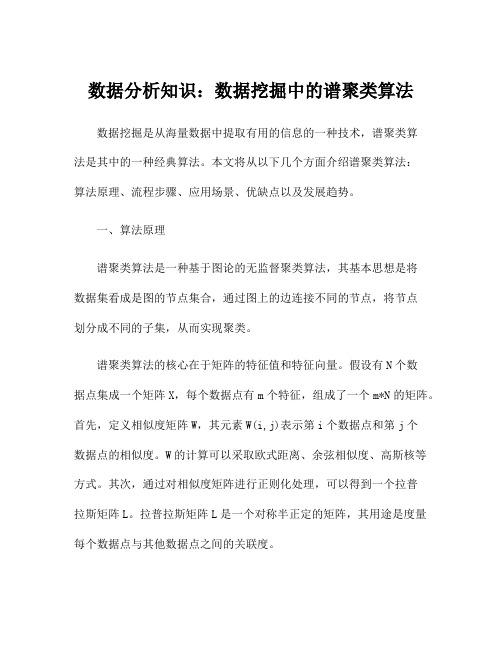

图2 谱聚类算法流程图2是利用谱聚类进行兴趣圈子挖掘的算法流程示意图,首先我们获得用户之间的互动数据,由于谱聚类只能处理无向图,而用户之间的互动数据是有向的,所以首先根据一定规则将有向图转换为无向图,之后就形成了所有用户的兴趣相似性图。

根据谱聚类算法要求,将这个相似性图转换为拉普拉斯矩阵,然后对这个矩阵求其前K个特征值及其对应的特征向量,求解前K个特征向量s1,s2,…,sk,组成矩阵S[n][k](n为用户编号),这样就将一个原本是n*n的矩阵转换为小很多的n*k矩阵,对S按行进行Kmeans聚类,每一行对应相似兴趣图中一个节点。

其最终聚类结果就是谱聚类最终的输出结果。

之所以采取谱聚类来解决这个问题,源于这个算法本身具有的一些优点,比如:1谱聚类具有坚实的理论基础:图谱理论2谱聚类不含凸球形数据分布的隐性假设,而常见的很多聚类算法比如KMeans, EM算法都存在这一假设。

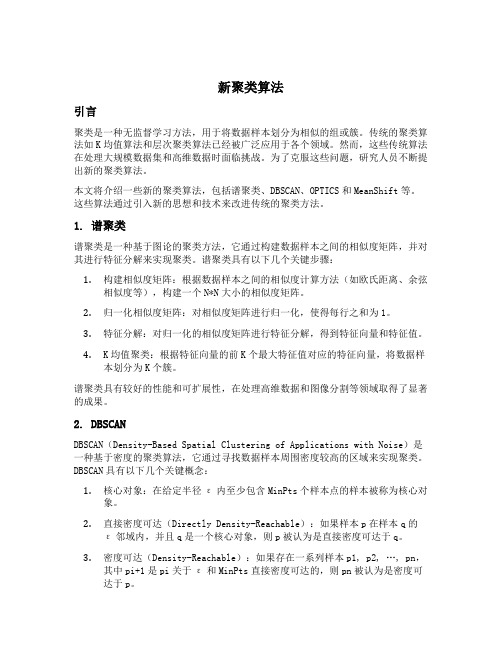

比如对于图3所示的例子中,谱聚类的聚类效果比较好。

图3 非凸球形数据由于谱聚类具备独特的优点,所以近来应用非常广泛(语音识别、文本挖掘等),但是谱聚类的计算复杂度还是较高,所以面对海量数据,如何能够快速计算是个问题。

为了能够处理上亿的海量数据,我们主要采取了两项措施来对原始算法进行改造,首先是利用MPI 平台构建分布式计算系统,对于这种计算密集型迭代式应用,通常hadoop平台被认为是不太合适的,所以通过构建MPI分布式平台来加快数据的分布以提升计算速度。

第二项主要改进措施是将谱聚类由平面型聚类(flat)改造为层次聚类(hierarchy),其基本思想也很简单,即通过多次谱聚类迭代,首先将一个巨大的图划分为较少数的密集子图,然后针对每个密集子图再次迭代使用谱聚类来递归地将其划分为较小的密集子图,通过几个层级的切割,也可以有效增加分布式计算效果并大大提快整体运行效率。

谱聚类算法讲解ppt课件

sij xi KNN ( x j ) and x j KNN ( xi )

10

Spectral Clustering 谱聚类

谱聚类基础一:图-邻接矩阵

(3)全连接法:

通过核函数定义边权重,常用的有多项式核函数,

高斯核函数和Sigmoid核函数。使用高斯核函数构建邻接

1 1

Rcut(G1 , G2 ) Cut (G1 , G2 )

n1 n2

n1、n 2划分到子图1和子图2的顶点个数

Rcut (G1 , G2 )

1 1

w

ij

n2

iG1 , jG2 n1

(n1 n2 ) 2

wij

量的相似矩阵S

邻接矩阵W。

6

Spectral Clustering 谱聚类

谱聚类基础一:图-邻接矩阵

构建邻接矩阵 W 主要有三种方法 :

•

-近邻法

•

K近邻法

• 全连接法

7

Spectral Clustering 谱聚类

谱聚类基础一:图-邻接矩阵

(1) -近邻法:

设置一个距离阈值

,然后用欧式距离

2

27

Spectral Clustering 谱聚类

(2) Ratio Cut

令

qi

二分类:

n1

n2 n

n2

n1n

i G1

= 1

i G2

Rcut (G1 , G2 )

w q q

2

iG1 , jG2

谱聚类算法 python

谱聚类算法 python谱聚类是一种基于图论的聚类算法,它通过将样本数据表示为图的形式,使用图的特征进行聚类。

谱聚类算法主要包括以下步骤:构建相似度矩阵、计算拉普拉斯矩阵、对拉普拉斯矩阵进行特征分解、k-means聚类。

下面是Python代码实现谱聚类算法的相关参考内容。

首先需要导入相关的库,包括numpy、sklearn、scipy等:```pythonimport numpy as npfrom sklearn.cluster import KMeansfrom scipy.spatial.distance import cdist```然后,定义谱聚类算法的函数:```pythondef spectral_clustering(X, n_clusters):# 构建相似度矩阵similarity_matrix = compute_similarity_matrix(X)# 计算拉普拉斯矩阵laplacian_matrix = compute_laplacian_matrix(similarity_matrix)# 对拉普拉斯矩阵进行特征分解eigenvalues, eigenvectors = np.linalg.eig(laplacian_matrix)# 选择最小的k个特征值对应的特征向量indices = np.argsort(eigenvalues)[:n_clusters]eigenvalues = eigenvalues[indices]eigenvectors = eigenvectors[:, indices]# 使用k-means进行聚类kmeans = KMeans(n_clusters=n_clusters)kmeans.fit(eigenvectors)labels = bels_return labels```接下来,需要定义计算相似度矩阵的函数:```pythondef compute_similarity_matrix(X):# 计算样本间的欧氏距离dist_matrix = cdist(X, X, metric='euclidean')# 根据欧氏距离计算相似度similarity_matrix = np.exp(-dist_matrix ** 2)return similarity_matrix```然后,定义计算拉普拉斯矩阵的函数:```pythondef compute_laplacian_matrix(similarity_matrix):# 计算度矩阵degree_matrix = np.diag(np.sum(similarity_matrix, axis=1))# 计算拉普拉斯矩阵laplacian_matrix = degree_matrix - similarity_matrixreturn laplacian_matrix```最后,可以使用上述函数进行谱聚类:```python# 生成样本数据X = np.random.rand(100, 2)# 调用谱聚类算法n_clusters = 3labels = spectral_clustering(X, n_clusters)```以上就是使用Python实现谱聚类算法的相关参考内容。

谱聚类算法

基本理论:

图划分准则:

谱聚类算法的思想来源于谱图划分理论 。假定将每个 数据样本看作图中的顶点V, 根据样本间的相似度将顶点间 的边E赋权重值W, 这样就得到一个基于样本相似度的无向 加权图G= (V, E) 。那么在图G 中, 就可将聚类问题转化为在 图G 上的图划分问题。基于图论的最优划分准则就是使划 分成的两个子图内部相似度最大, 子图之间的相似度最小。

如何处理特征向量: 在应用谱方法进行聚类问题的研究中, 用多 少个特征向量进行聚类, 如何选取、计算及使用这些特征向量

等问题均没有得到很好的理论解释, 这些都是未来急需解决的

问题。 如何自动确定聚类数目: 聚类数目的多少直接影响聚类的质量。

如何选取Laplacian 矩阵: 谱聚类算法所使用的Laplacian 矩阵有

或任意其它经典算法, 得到k 个聚类; 将数据点

y i划分到聚类j 中, 当且仅当Y 的第i行被划分到聚类j 中。

小结:

针对图谱的不同划分规则,都有相应的算法如PF、SM、 SLH、Mcut、NJW、MS算法,比较如下:

难点分析

如何构造相似矩阵W: 谱聚类算法中相似矩阵W的构由于尺度参

数R是人为选取的, 使得该函数带有一定的局限性。

Kannan 将该算法与SM 算法、KVV 算法进行了比较, 发现

Mcut 算法能够产生更加平衡的划分结果, 尤其当类间重叠较大时, 效果更为明显。

多路谱聚类算法

NJW 算法 Ng, Jordan 等人选取拉氏矩阵

Lsym的前k 个最大特征值对应的特征

向量, 使其在 R k 空间中构成与原数据一一对应的表述, 然后在 R k 空间中

x T (D W ) x y T (D W ) y x TWx y TWy

sklearn中的谱聚类算法

Sklearn(Scikit-learn)是一个基于Python的机器学习库,提供了许多常用的机器学习算法和工具。

谱聚类(Spectral Clustering)算法作为Sklearn库中的一个重要组成部分,是一种基于图论和谱理论的聚类算法,能够有效地处理非凸形状的数据集并对高维数据进行聚类分析。

本文将对Sklearn中的谱聚类算法进行深入探讨,并对其理论、实现细节和应用展开详细介绍。

一、谱聚类算法的理论基础谱聚类算法是一种基于图论和谱理论的聚类算法,其主要思想是将数据集表示为图的形式,利用图的谱分解来实现聚类分析。

在进行谱聚类之前,首先需要构建数据样本的相似度矩阵或者距离矩阵,并基于这个矩阵构建相应的图模型,常用的图模型包括ε-邻近图、全连接图等。

接下来,利用图的拉普拉斯矩阵进行特征分解,得到其特征向量,并通过对特征向量进行聚类操作,最终得到数据的聚类结构。

谱聚类算法的理论基础主要包括图论、谱图理论以及聚类理论等多个方面的知识,需要深入理解这些理论知识才能正确地运用谱聚类算法进行数据分析。

在Sklearn库中,谱聚类算法提供了丰富的参数设置和优化方法,能够灵活地适应不同数据情况和需求,是实现谱聚类算法的一个重要工具。

二、谱聚类算法的实现细节Sklearn中的谱聚类算法主要基于Python语言实现,其具体的实现细节涵盖了图模型构建、谱分解、特征向量聚类等多个方面。

在进行实际的数据分析时,需要关注谱聚类算法的几个关键参数,包括图模型的构建方法、相似度矩阵的计算方式、谱分解的方法、特征向量聚类的算法等。

图模型的构建方法是谱聚类算法中的一个关键步骤,常用的方法包括ε-邻近图、全连接图等,不同的方法会对聚类结果产生不同的影响,需要根据具体的数据情况选取合适的方法。

另外,相似度矩阵的计算方式也会影响到谱聚类的结果,可以选择基于距离的相似度计算方法或者基于核函数的相似度计算方法。

谱分解的方法通常包括最大化拉普拉斯特征值、最小化拉普拉斯特征值等多种方法,需要根据具体应用需求选择合适的方法。

谱聚类llr算法

谱聚类llr算法谱聚类(Spectral Clustering)是一种广泛应用于数据挖掘和模式识别领域的聚类算法,它基于谱图理论和图论的相关概念,通过将数据样本投影到低维度空间中进行聚类,能够有效地处理非线性和复杂的数据分布。

其中一种常用的谱聚类算法是局部线性嵌入谱聚类(Local Linear Embedding Spectral Clustering,简称LLR谱聚类)算法。

本文将详细介绍LLR谱聚类算法的原理和具体实现过程。

一、算法原理1. 构建相似度矩阵首先,根据给定的样本数据,我们需要计算每个样本之间的相似度。

常用的相似度度量方法有欧式距离、余弦相似度、高斯相似度等。

将相似度矩阵表示为W,其中W(i,j)代表第i个样本与第j个样本之间的相似度。

2. 构建拉普拉斯矩阵接下来,我们根据相似度矩阵W构建拉普拉斯矩阵L。

拉普拉斯矩阵有多种定义方式,比较常用的是归一化拉普拉斯矩阵。

归一化拉普拉斯矩阵L定义为L = D^(-1/2) * (D - W) * D^(-1/2),其中D为度矩阵,定义为D(i,i) = ∑W(i,j)。

3. 特征值分解对拉普拉斯矩阵L进行特征值分解,得到特征值和对应的特征向量。

将特征值按照从小到大的顺序排列,并选择其中的前K个特征值及对应的特征向量。

4. 归一化特征向量将选取的特征向量按列进行归一化,得到归一化特征向量。

5. K-means聚类将归一化特征向量作为输入数据,使用K-means聚类算法对样本数据进行聚类。

二、算法步骤LLR谱聚类算法的具体步骤如下:Step 1: 读取样本数据,计算相似度矩阵W。

Step 2: 构建拉普拉斯矩阵L。

Step 3: 对拉普拉斯矩阵L进行特征值分解,选择前K个特征值及对应的特征向量。

Step 4: 对选取的特征向量进行归一化。

Step 5: 将归一化特征向量作为输入数据,使用K-means聚类算法进行聚类。

三、算法优缺点LLR谱聚类算法具有以下的优点和缺点:优点:1. 能够有效地处理非线性和复杂的数据分布,具有较好的聚类效果。

谱聚类算法(Spectral Clustering)原理分析

谱聚类算法(Spectral Clustering)谱聚类(Spectral Clustering, SC)是一种基于图论的聚类方法——将带权无向图划分为两个或两个以上的最优子图,使子图内部尽量相似,而子图间距离尽量距离较远,以达到常见的聚类的目的。

其中的最优是指最优目标函数不同,可以是割边最小分割——如图1的Smallest cut(如后文的Min cut),也可以是分割规模差不多且割边最小的分割——如图1的Best cut(如后文的Normalized cut)。

图1 谱聚类无向图划分——Smallest cut和Best cut 这样,谱聚类能够识别任意形状的样本空间且收敛于全局最优解,其基本思想是利用样本数据的相似矩阵(拉普拉斯矩阵)进行特征分解后得到的特征向量进行聚类。

1 理论基础对于如下空间向量item-user matrix:如果要将item做聚类,常常想到k-means聚类方法,复杂度为o(tknm),t为迭代次数,k为类的个数、n为item个数、m为空间向量特征数:1 如果M足够大呢?2 K的选取?3 类的假设是凸球形的?4 如果item是不同的实体呢?5 Kmeans无可避免的局部最优收敛?……这些都使常见的聚类问题变得相当复杂。

1.1 图的表示如果我们计算出item与item之间的相似度,便可以得到一个只有item的相似矩阵,进一步,将item看成了Graph(G)中Vertex(V),歌曲之间的相似度看成G中的Edge(E),这样便得到我们常见的图的概念。

对于图的表示(如图2),常用的有:邻接矩阵:E,e ij表示v i和v i的边的权值,E为对称矩阵,对角线上元素为0,如图2-2。

Laplacian矩阵:L = D – E,其中d i (行或列元素的和),如图2-3。

图2 图的表示1.2 特征值与L矩阵先考虑一种最优化图像分割方法,以二分为例,将图cut为S和T两部分,等价于如下损失函数cut(S, T),如公式1所示,即最小(砍掉的边的加权和)。

谱聚类算法spectralclustering

4.2.1 基本k-means聚类算法

k-means聚类算法:

(1)从数据集D中任意选择k个对象作为初始簇中心; (2) repeat (3) for 数据集D中每个对象P do (4) 计算对象P到k个簇中心的距离 (5) 将对象P指派到与其最近(距离最短)的簇; (6) end for (7) 计算每个簇中对象的均值,做为新的簇的中心; (8) until k个簇的簇中心不再发生变化

K-means算法采用<k,mean>来表示一个簇

k-means聚类算法示例-1

例 4.1 对表4-1中二维数据,使用k-means算法将其划分为2个簇,

假设初始簇中心选为P7(4,5),P10(5,5)。 表4-1 k-means聚类过程示例数据集1 P1 x y 3 4 P2 3 6 P3 7 3 P4 4 7 P5 3 8 P6 8 5 P7 4 5 P8 4 1 P9 7 4 P10 5 5

(a) 大小不同的簇

(b) 形状不同的簇

图4.3 基于质心的划分方法不能识别的数据

4.2.2 二分k-means算法

二分K-means算法是基本k-means算法的直接扩充,基于 如下想法:为了得到k个簇,将所有点的集合分裂成两个 簇,从中选择一个继续分裂,如此重复直到产生k个簇。 算法详细描述如下: 初始化簇表,使之包含由所有的点组成的簇。 Repeat 从簇表中选取一个簇。 { 对选定的簇进行多次二分“试验” } For i=1 to 试验次数 do 使用基于基本k-means,二分选定的簇 End for 从二分试验中选择具有最小总SSE的两个簇。 将这两个簇添加到簇表中 Until 簇表中包含k个簇

图4-2 k-means算法聚类过程示例

通俗理解谱聚类算法

通俗理解谱聚类算法通俗理解谱聚类算法谱聚类(Spectral Clustering, SC)是⼀种基于图论的聚类⽅法。

将带权⽆向图划分为两个或两个以上的最优⼦图,使⼦图内部尽量相似,⽽⼦图间距离尽量距离较远,以达到常见的聚类的⽬的。

"带权⽆向图"这个词太学术了,我们换⼀种叫法,即:相似度矩阵。

假设我们有⼀个相似度矩阵,矩阵中存的是所有对象的两两相似度。

那么这个矩阵应该有如下性质:1. 矩阵为N * N,N为对象总数2. 矩阵对⾓线的值为0,⾃⼰和⾃⼰相似个⽑啊3. 矩阵为对称矩阵,及相似度是⽆向的我们将该矩阵记为:W。

谱聚类的任务就是根据这个相似度矩阵,将这⼀⼤堆对象,分成不同的⼩堆,⼩堆内部的对象彼此都很像,⼩堆之间则不像。

谱聚类本⾝也提供了好⼏种不同的分割(cut)⽅法,每种⽅法对应⼀种优化⽬标。

本⽂只介绍其中⽐较常见,也是⽐较实⽤,⽽且实现起来也⽐较经济的⼀种:Nomarlized cut.说⽩了,就是你最应该掌握和使⽤的⼀种,好了,进⼊正题。

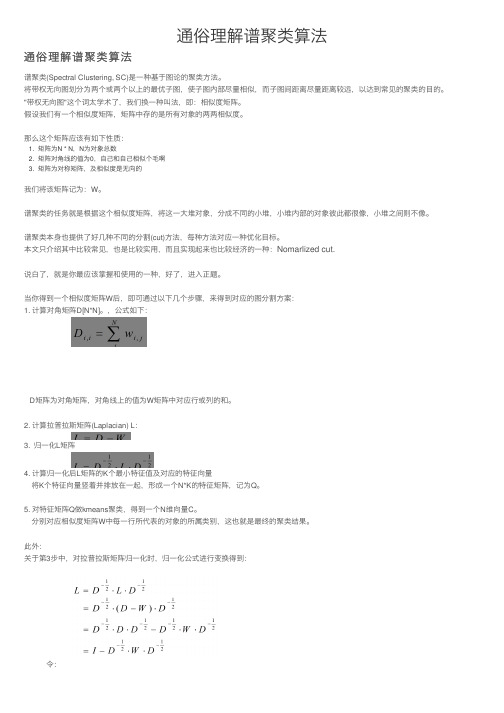

当你得到⼀个相似度矩阵W后,即可通过以下⼏个步骤,来得到对应的图分割⽅案:1. 计算对⾓矩阵D[N*N]。

,公式如下:D矩阵为对⾓矩阵,对⾓线上的值为W矩阵中对应⾏或列的和。

2. 计算拉普拉斯矩阵(Laplacian) L:3. 归⼀化L矩阵4. 计算归⼀化后L矩阵的K个最⼩特征值及对应的特征向量将K个特征向量竖着并排放在⼀起,形成⼀个N*K的特征矩阵,记为Q。

5. 对特征矩阵Q做kmeans聚类,得到⼀个N维向量C。

分别对应相似度矩阵W中每⼀⾏所代表的对象的所属类别,这也就是最终的聚类结果。

此外:关于第3步中,对拉普拉斯矩阵归⼀化时,归⼀化公式进⾏变换得到:令:则在第4步中,我们可以将求L 的K 个最⼩特征值及其对应的特征向量的问题,转化为求矩阵E 的K 个最⼤的特征值及其对应的特征向量。

---可以证明:L 的K 个最⼩特征值对应的特征向量,分别对应于E 的K 个最⼤的特征值对应的特征向量。

基于谱聚类算法的数据挖掘技术研究

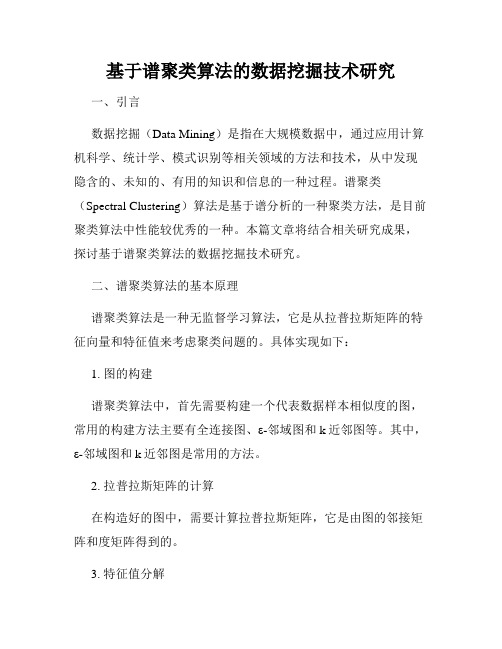

基于谱聚类算法的数据挖掘技术研究一、引言数据挖掘(Data Mining)是指在大规模数据中,通过应用计算机科学、统计学、模式识别等相关领域的方法和技术,从中发现隐含的、未知的、有用的知识和信息的一种过程。

谱聚类(Spectral Clustering)算法是基于谱分析的一种聚类方法,是目前聚类算法中性能较优秀的一种。

本篇文章将结合相关研究成果,探讨基于谱聚类算法的数据挖掘技术研究。

二、谱聚类算法的基本原理谱聚类算法是一种无监督学习算法,它是从拉普拉斯矩阵的特征向量和特征值来考虑聚类问题的。

具体实现如下:1. 图的构建谱聚类算法中,首先需要构建一个代表数据样本相似度的图,常用的构建方法主要有全连接图、ε-邻域图和k近邻图等。

其中,ε-邻域图和k近邻图是常用的方法。

2. 拉普拉斯矩阵的计算在构造好的图中,需要计算拉普拉斯矩阵,它是由图的邻接矩阵和度矩阵得到的。

3. 特征值分解计算得到拉普拉斯矩阵后,需要对其进行特征值分解,得到的特征向量即为样本点在谱空间下的坐标。

4. K-Means聚类将样本点的坐标作为输入,在谱空间下,采用K-Means聚类算法进行聚类,最终得到聚类结果。

三、基于谱聚类算法的数据挖掘技术应用研究在实际应用中,谱聚类算法可以用于解决各种数据挖掘任务,下面将以文本聚类、图像分割和社区发现为例,分别进行介绍。

1. 文本聚类文本聚类是将文本数据划分到不同的类别中,使得同一类别的文本数据具有相似性。

谱聚类算法可以用于文本聚类,主要步骤如下:(1)构建文档相似度矩阵(2)计算拉普拉斯矩阵(3)通过特征值分解得到特征向量(4)K-Means算法聚类在实际应用中,文本聚类可用于新闻聚类、文本分类等领域。

例如:对于新闻聚类,可以将相似的新闻聚在一起,使用户更方便地查看相关新闻。

2. 图像分割图像分割是将图像划分为若干个具有语义的区域,不同区域之间的分割线要具有明显的区分度。

谱聚类算法也可以用于图像分割,主要步骤如下:(1)构建图像相似度矩阵(2)计算拉普拉斯矩阵(3)通过特征值分解得到特征向量(4)K-Means算法聚类在实际应用中,图像分割主要用于计算机视觉领域中的医学影像分割、物体识别等任务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

谱聚类算法算法简介 谱聚类算法建立在谱图理论基础上,与传统的聚类算法相比,它具有能在任意形状的样本空间上聚类且收敛于全局最优解的优点。

该算法首先根据给定的样本数据集定义一个描述成对数据点相似度的亲合矩阵,并且计算矩阵的特征值和特征向量,然后选择合适的特征向量聚类不同的数据点。

谱聚类算法最初用于计算机视觉、VLS I 设计等领域,最近才开始用于机器学习中,并迅速成为国际上机器学习领域的研究热点。

谱聚类算法建立在图论中的谱图理论基础上,其本质是将聚类问题转化为图的最优划分问题,是一种点对聚类算法,对数据聚类具有很好的应用前景。

算法步骤 谱聚类算法将数据集中的每个对象看作是图的顶点V,将顶点间的相似度量化作为相应顶点连接边E的权值,这样就得到一个基于相似度的无向加权图G(V, E),于是聚类问题就可以转化为图的划分问题。

基于图论的最优划分准则就是使划分成的子图内部相似度最大,子图之间的相似度最小。

虽然根据不同的准则函数及谱映射方法,谱聚类算法有着不同的具体实现方法,但是这些实现方法都可以归纳为下面三个主要步骤: 1) 构建表示对象集的相似度矩阵W; 2) 通过计算相似度矩阵或拉普拉斯矩阵的前k个特征值与特征向量,构建特征向量空间; 3) 利用K-means或其它经典聚类算法对特征向量空间中的特征向量进行聚类。

上面的步骤只是谱聚类算法的一个总体框架,由于划分准则、相似度矩阵计算方法等因素的差别,具体的算法实现同样会有所差别,但其本质依然是图划分问题的连续放松形式。

划分准则 谱聚类算法将聚类问题就可以转化为图的划分问题之后,基于图论的划分准则的优劣直接影响到聚类结果的好坏。

常见的划分准则有Mini cut,Average cut,Normalized cut,Min-max cut,Ratio cut,MNcut等。

最小割集准则 在对图像分割中产生了较好的效果,但是该准则容易产生分割出只包含几个顶点的较小子图的歪斜分割现象。

规范割集准则 在2000年Shi和Malik根据谱图理论建立了2-way划分的规范割目标函数,此方法通过计算分割之后的连接边损失值在各个子图与所有顶点之间的连接边权重总值中所占比例之和来衡量划分的优劣。

比例割集准则 对于超大规模集成电路设计中的电路层次设计和分支划分问题,最大流最小割算法能够发现其中的类结构(clustering structure),但是在实际中该算法通常会产生规模非常不一致的电路分支;Kemighan-Lin算法采用固定参数的方式可以得到规模具有一定可比性的分支划分,由于电路中的分支倾向于自然结合的形成,所以通过预先设定分支规模进行划分的方法存在明显的局限。

针对以上的现象Wei和Cheng提出了比例割集准则。

平均割集准则 在计算机视觉中,图像原始像素条理有序地分组可以通过寻找场景结构图(Scene Structure Graph)中松散耦合的结点来完成,于是原始像素的聚合问题就转化为场景结构图的分割。

Sarkar和Soundararajan[62]提出了一种最小化两两分割之间相似度的计算方法并把它命名为平均割集准则。

最小最大割集准则 Mini cut准则容易出现分割出只包含几个顶点的较小子图的歪斜分割现象,Ratio cut和Normalized cut等在一定程度上可以避免这种现象,但是当类间重叠严重时歪斜分割现象仍旧会发生。

Chris Ding等人提出的基于Min-max cut的图划分方法充分体现了“子图内部相似度最大,子图之间的相似度最小”原则,能够产生比较平衡划分。

上述五种划分都是不断地将图划分为2个子图的反复迭代运算过程,当划分函数的最小值满足一定的条件时迭代过程便会终止,相应的函数可以称为2-way 划分函数。

多路规范割集准则 Meilă和Xu[64]认为可以同时把图划分为k个子图并于2004年提出了一种k-way规范割目标函数,而且对于参数k的选取问题也作了分析说明。

我们可以发现当k=2时,MNcut与Ncut两者是等价的。

典型的算法 根据谱聚类算法所使用的划分准则,可以把算法分为二路谱聚类算法和多路谱聚类算法,前者使用2-way划分准则而后者使用k-way划分准则。

二路谱聚类算法 PF算法。

Perona和Freeman提出用相似度矩阵W最大特征值所对应的特征向量进行聚类指出对于块对角相似矩阵,特征向量中非零值对应的点属于同一类,零值对应的点属于另外一类。

SM算法。

Meliă指出Ncut和MNcut的差异之处仅在于所使用的谱映射不同。

多路规范割集准则在实际应用中合理有效,但其优化问题通常难以解决。

Shi和Malik 认为第二小特征值对应的特征向量,即Fiedler向量包含了图的划分信息,根据启发式规则在此向量中寻找划分点i使在该点上得到的Ncut(A,B)值最小,最后把向量中的值与Ncut准则函数的最小值进行比较,大于等于该值的点划分为一类,小于该值的点则划分到另外一类。

SLH算法。

SLH重定位算法计算相似度矩阵W的前k个特征向量,参数k需要事先指定。

KVV算法。

根据启发式规则在Fiedler向量中寻找划分点i使在该点上得到的Rcut(A,B)值最小的划分点,与SM算法相似;不同之处仅在于SM算法是寻找使Ncut(A,B)值最小的划分点。

虽然在实际问题中KVV 算法存在运行速度相对较慢的缺陷,但是算法减少了过分割的可能性。

Mcut算法。

Ding根据谱图理论将最小最大割集准则函数的最优化问题转化为下式的第二小特征值的求解。

多路谱聚类算法 NJW算法。

Ng,Jordan等人选取拉普拉斯矩阵的前k个最大特征值对应的特征向量构造新的向量空间R,在这个新的空间内建起与原始数据的对应关系,然后进行聚类。

田铮和李小斌等人利用矩阵的扰动理论逐步分析了理想情形、分块情形和一般情形下权矩阵的谱和特征向量与聚类之间的关系[69]:顶点集合V的类内离散程度充分小而类间离散程度充分大时,V 中所有顶点可以划分成的数目与相似度矩阵W特征值中大于1的特征值的数目相等。

同时特征值的大小可以在一定程度上反映每一类所包含顶点的个数。

相似度矩阵W的前k个单位正交特征向量组成的矩阵X 的行向量之间的夹角可以用来计算两个顶点是否属于同一类,如果属于同一类,那么这对应的行向量接近于相互平行;反之对应的行向量接近于相互正交。

理想情况中,V中两个顶点属于同一类时,相应的行向量相互平行;属于不同的类,相应的行向量相互正交。

MS算法[70]。

Meilă把基于马尔可夫链随机游动过程的概率转移矩阵运用到相似度矩阵的构造中,研究了这种随机游动的概率转移矩阵的特征值和特征向量,在随机游动的框架下了对Ncut进行了概率解释。

该算法是用随机游动矩阵P的前k个非零特征值对应的特征向量构造矩阵,然后将矩阵中的行看成R空间中的点进行聚类,步骤与NJW算法相似。

MS算法在实际的图像分割中取得了良好的效果,但是度矩阵D中对角线元素值之间存在较大的差别时就会导致较差的聚类效果。

算法的新进展 Zha和Dhillon等人研究了基于二分图G=<X, Y, W>上的谱聚类,发现最小化目标函数可以等同于与二分图相关联的边权重矩阵的奇异值分解。

Meila和Shi将相似性解释为Markov链中的随机游动,分析了这种随机游动的概率转移矩阵P=DW的特征向量(W为相似度矩阵),并且利用随机游动对Ncut进行了概率的解释,提出了基于随机游动的新的算法。

同时,在这个解释框架下提出了多个特征相似矩阵组合下的谱聚类方法,在图像分割中取得了很不错的效果。

Cu等人分析了核k-means的方法,发现最小化核k-means的目标函数等同于一个由数据向量组成的Gram矩阵的迹最大化问题。

同时,迹最大化问题的松散解可以通过Gram矩阵的部分特征分解获得,首次用谱松散的方法获得核k-means的目标函数的全局最优解。

Dhillon[29]在此基础上,又研究了加权核k-means的目标函数,将其与Ncut目标函数建立联系,提出了一个可以单调递减Ncut值的新颖的加权核k-means算法。

Ncut是一个很好的聚类目标函数。

它的求解是一个NP难问题。

传统的方法是宽松的谱松散方法。

Xing与Jordan[分析了对Ncut的半正定规划(SDP)模型。

根据该模型,对Ncut提出了一个比谱松散更紧的下限。

同时指出了Ncut本身不能得到最优的聚类,但它可以通过不同的松散方法获得合理的聚类。

谱聚类方法不仅用于无监督学习中,也用于有约束的半监督学习中。

Kamvar等人将PageRank[32]的随机游动模型运用到相似度矩阵中,根据已知样本的类别修正相似度矩阵。

然后根据谱聚类算法获得聚类结果。

Bach与Jordan则是根据一个基于已知划分与Ncut谱松散结果的误差,提出了新的目标函数,通过最小化新的目标函数推出新的谱聚类算法。

王玲,薄列峰,焦李成认为在聚类搜索过程中充分利用先验信息会显著提高聚类算法的性能,并分析了在聚类过程中仅利用成对限制信息存在的不足,提出利用数据集本身固有空间一致性先验信息的具体方法。

在经典的谱聚类算法中同时引入两类先验信息的基础上提出一种密度敏感的半监督谱聚类算法,两类先验信息在指导聚类搜索的过程中能够起到相辅相成的作用,使得算法相对于仅利用成对限制信息的聚类算法在聚类性能上有了显著的提高。

王娜,李霞提出了一种基于监督信息特性的主动学习策略,找出同一类中距离相对较远的数据对象对和不同类中距离相对较近的数据对象对组成监督信息并将其引入谱聚类算法,构建新颖的主动半监督谱聚类算法,结果优于采用随机选取监督信息的谱聚类性能。

面临的问题 尽管谱聚类具有坚实的理论基础,相对于其它聚类方法具有许多优势,在实践中的应用领域在不断扩展,取得了不错的效果[38],但是它仍然需要改进,尤其在下述几个方面:如何构造相似度矩阵 如何创建相似度矩阵W,使其更加真实地反映数据点之间的近似关系,使得相近点之间的相似度更高,相异点之间的相似度更低,是谱聚类算法必须要解决的一个问题。

高斯相似函数是经典谱聚类算法中计算两点间相似度的常用方法,虽然该函数使原始的谱聚类算法取得了一些成功,但尺度参数σ的选取问题使该函数具有明显的局限性。

NJW算法[7]通过预先指定几个尺度参数σ的值,分别执行谱聚类,最后选取使聚类结果最好的σ作为参数,这种做法消除了尺度参数σ选取的人为因素,却增加了运算时间。

近年来,为了避免参数的选择问题,有学者提出在计算相似度时不使用高斯核函数。

如Gong 等人[41]借鉴Wang Fei和Zhang Changshui[42]在半监督中使用的方法,将每个点的k 近邻对该点进行线性近似表示时所占的权重作为两点间的相似度。