基于依赖分析的并行化验证策略

强化学习中的长期依赖与信用分配问题

强化学习中长期依赖和信用分配问题是一个重要而复杂的问题,涉及到强化学习算法的设计和实施。

以下是对这两个问题的简要解释和可能的解决方案:

1. 长期依赖:在强化学习中,长期依赖是指算法对过去行为的依赖,即过去的决策和环境反馈对未来的决策产生影响。

这可能导致学习过程中的循环依赖和模式适应,即算法可能会对特定的历史行为产生过度依赖,无法适应新的、无先例的环境。

解决方案:为了解决长期依赖问题,研究者们提出了许多策略,如时间差分强化学习(TD-RL)、策略梯度方法(PG)等。

这些方法通过引入时间差分进行更新,以减少对过去行为的过度依赖。

此外,模型化记忆结构如神经网络,也被用于记忆重要的历史行为以降低长期依赖的影响。

2. 信用分配:信用分配问题是强化学习中另一个重要问题。

当不同的环境状态有不同的奖励权重时,如果所有状态被视为等价或不可区分的,可能会导致某些状态得到过度奖励,而其他状态则被忽视。

这可能导致算法在某些状态下过度探索或过度利用,从而影响学习效果。

解决方案:为了解决信用分配问题,研究者们提出了许多策略,如基于策略的算法(如PPO)和价值导向的算法(如V-trace)。

这些方法通过将状态分类为不同类别并使用不同的奖励权重来分配信用,以解决信用分配问题。

此外,还可以使用探索和利用的平衡机制来避免过度探索或过度利用,并引入可解释性强的信任机制来调整信用分配。

综上所述,解决强化学习中的长期依赖和信用分配问题需要采用多种策略和技术。

通过不断探索和创新,研究者们正在努力提高强化学习的性能和可解释性,以适应各种复杂和动态的环境。

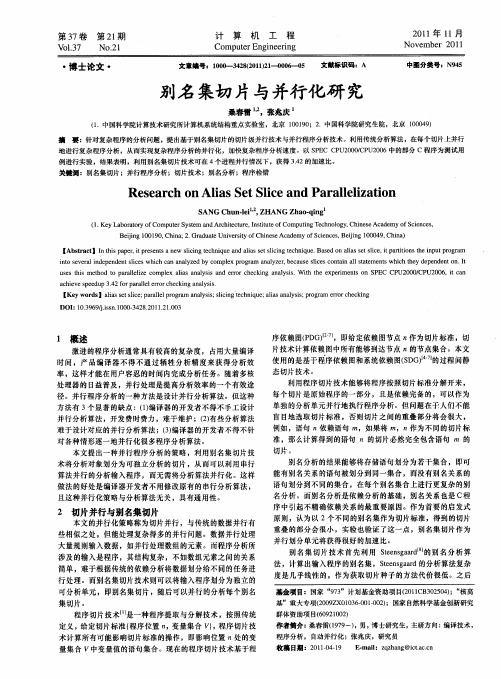

别名集切片与并行化研究

、 -7 bl3

・

计

算

机

工

程

21年 1 01 1月

No e e 2 v mb r 01 1

N O21 .

Co p t rEng n e i g m ue i e rn

博士论文 ・

文 编 1 o 3 8 o ) — 0 - 5 文 标 码: 章 号: 0 _ 4 ( l2 0 6 o 0 - 2 2 11 0 - 献 识 A

准 ,那么计算得到的语句 n的切片必然完全包含语句 m 的 切片 。

别名分析 的结果能够将存储语句划分为若干集 合 ,即可

能有 别名 关系的语句被划分到 同一集合 ,而没有别名关系的

语句 划分 到不 同的集合 ,在每个别名集合上进行更复杂的别

名分析。而别名分析是依赖分析 的基础 ,别名关系也是 C程

第 2 期 1

桑春雷 ,张 庆 : 别名集 切片 与并行化 研究

7

对 这些别名集按照指 向关系进行分组 ,并作为别名集 切片 的

如, 为检测文件未关闭错误, 计算文件 操作相关( p n fls) f e/coe o 的切 片 ,为 检测 未 释放 内存 作 为计 算 动态 内存 操作 相 关 ( l cf e的切片 ,本文需要计算多组别名集 的切片等。计 mal / e) o r 算不同的切片 ,切片种子不同 ,需要重新计算切片。但 S G D 却不 需要重建 ,S G反映的是程序 的内在属性 ,它们所表达 D 的语句之 间的依赖 关系 、参数或者全局变量之间的数据流关 系是程序 的固有属性 。因此 ,S G只需要计算一次,而被多 D 次切片使 用。本文 的切片技术首先计算程序的 S G,将 S D DG 存储到文件 内, 这样 , 每次切片都是利用 已经计 算好 的 S DG, 而不是重新计算 。后面的实验部分可 以看到 ,S G的构造时 D 间一般大于切片本身的时间 ,S DG存储重用技术能为切片技 术带来很大的效率提升。 后面 的实验也将说明 S G存储复 用 D 技术也能提高基于别名集切片的并行程序分析 的效率 。 322 副作 用信 息压缩技术 .. 函数 可能 使用 或者修 改某 些全局变 量 ,因此 ,在 构建 S G 时,要像处理参数一样处理全局变量 ,但 因为副作用信 D 息的不准确 ,需要处理 的全局变量个数远多于参数个数。因 此, 全局变量引入的 S G节点规模相当大 , D 这大大增加构建 S G 的时空开销 ,同时 因为 副作用分析不准确 ,这些节点带 D

多靶标基因并行检测技术为肿瘤个体化治疗提供新模式

多靶标基因并行检测技术为肿瘤个体化治疗提供新模式蔡贞;郑磊【摘要】Along with the development of human genomics and pharmacogenomics, the personalized diagnosis and treatment of cancer has translated from vision into reality. The occurrence and development of malignant tumors is a complicated biological process involving multiple genes and signaling pathways. Parallel detection technologies are capability of detection of multiple target genes simultaneously, which provide more comprehensive information for clinical doctors to make personalized treatment program. This article will briefly introduce the new developed multiple target genes parallel detection technology, liquidchip technology and next-generation sequencing technology and discuss the basic principles of quality control involved in these technologies.%随着人类基因组学和药物基因组学的发展,肿瘤个体化诊疗已由愿景变成了现实。

平行仿真技术的基本流程

平行仿真技术的基本流程平行仿真技术是一种用于加速仿真过程的技术,通过利用多个处理器或计算节点并行执行仿真任务,以提高仿真的效率和性能。

本文将详细描述平行仿真技术的基本流程的步骤和流程。

1. 问题分析和建模在进行平行仿真之前,首先需要对待仿真的问题进行分析和建模。

这包括确定仿真的目标、定义仿真模型、收集和整理仿真所需的数据等。

问题分析和建模的目的是明确仿真的目标和需求,为后续的平行仿真过程提供准确的输入和参数。

2. 并行化策略设计在进行平行仿真之前,需要设计并行化策略来将仿真任务分解为多个子任务,并确定每个子任务的执行顺序和依赖关系。

常用的并行化策略包括数据并行、任务并行和混合并行等。

•数据并行:将仿真任务的输入数据分割成多个子数据集,每个子数据集由一个处理器或计算节点处理,然后将各个子数据集的结果合并得到最终的仿真结果。

•任务并行:将仿真任务划分为多个子任务,每个子任务由一个处理器或计算节点处理,然后将各个子任务的结果合并得到最终的仿真结果。

•混合并行:将仿真任务同时进行数据并行和任务并行,以充分利用多个处理器或计算节点的计算资源。

选择合适的并行化策略需要考虑仿真任务的性质、计算资源的分布和可用性等因素。

3. 资源分配和任务调度在进行平行仿真之前,需要对计算资源进行分配和任务调度,以确保每个处理器或计算节点获得合适的任务和数据,并且任务的执行顺序和依赖关系得以满足。

资源分配和任务调度的目的是充分利用计算资源,提高仿真的效率和性能。

资源分配和任务调度可以根据任务的性质和计算资源的特点,采用不同的策略和算法。

常用的资源分配和任务调度算法包括贪心算法、遗传算法、蚁群算法等。

4. 数据通信和同步在进行平行仿真期间,不同的处理器或计算节点之间需要进行数据通信和同步,以实现子任务之间的数据传输和结果合并。

数据通信和同步的目的是确保各个子任务之间的数据一致性和正确性。

数据通信和同步可以通过消息传递接口或共享内存接口来实现。

mlpregressor 并行参数

MLPRegressor并行参数探究MLPRegressor是一种多层感知器神经网络模型,在机器学习领域应用广泛。

在实际应用中,其性能和效果受到多方面因素的影响,其中并行参数是其中一个重要的因素之一。

在本文中,我们将深入探讨MLPRegressor并行参数的影响,以及如何优化这些参数以提高模型性能。

1. MLPRegressor简介MLPRegressor是一种监督学习算法,常用于回归问题。

它由多个神经网络层组成,每个神经网络层包含多个神经元。

通过前向传播和反向传播的方式,模型能够学习到输入和输出之间的复杂映射关系,从而实现回归预测的功能。

2. 并行参数对性能的影响在MLPRegressor中,有多个参数可以进行调参优化,其中包括并行参数。

在Scikit-learn库中,MLPRegressor的solver参数可以设置为'adam'或'sgd',而其中的'adam' solver有一个并行参数n_iter_no_change,表示在判断没有进一步改善之前在训练数据上的最大迭代次数。

并行参数对MLPRegressor性能的影响主要表现在模型训练速度和收敛性上。

当并行参数设置合理时,能够加快模型的训练速度,同时提升模型的收敛性,使得模型更快地达到较好的拟合效果。

3. 优化并行参数要优化MLPRegressor的并行参数,可以通过交叉验证等方式来确定最佳的参数取值。

对于n_iter_no_change参数,可以通过设定不同的数值进行实验,观察模型在训练集和测试集上的性能表现,从而找到最佳的参数取值。

还可以尝试不同的solver参数,比较它们在不同并行参数下的性能差异,以及对模型的影响。

4. 个人观点和总结在实际应用中,MLPRegressor的并行参数对模型性能有着重要的影响。

通过合理地优化并行参数,可以提升模型的训练速度和收敛性,从而提高模型的预测效果。

《机器学习》(周志华)西瓜书读书笔记(完结)

《机器学习》(周志华)西⽠书读书笔记(完结)⼤部分基础概念知识已经在这篇博客中罗列,因此本⽂仅对感觉重要或不曾了解的知识点做摘记第1章绪论对于⼀个学习算法a,若它在某问题上⽐学习算法b好,则必然存在另⼀些问题,在那⾥b⽐a好.即"没有免费的午餐"定理(No FreeLunch Theorem,NFL).因此要谈论算法的相对优劣,必须要针对具体的学习问题第2章模型评估与选择m次n折交叉验证实际上进⾏了m*n次训练和测试可以⽤F1度量的⼀般形式Fβ来表达对查准率/查全率的偏好:偏差度量了学习算法的期望预测与真实结果的偏离程度,即学习算法本⾝的拟合能⼒,⽅差度量了同样⼤⼩的训练集的变动所导致的学习性能的变化,即数据扰动造成的影响.噪声表达了当前任务上任何学习算法所能达到的期望泛化误差的下界,即学习问题本⾝的难度.第3章线性模型线性判别分析(LDA)是⼀种经典的监督线性降维⽅法:设法将训练样例投影到⼀条直线上,使同类样例的投影点尽可能接近,异类样例的投影点尽可能远离.对新样本分类时根据投影点的位置来确定类别.多分类学习的分类器⼀般有以下三种策略:1. ⼀对⼀(OvO),N个类别产⽣N * (N - 1) / 2种分类器2. ⼀对多(OvR或称OvA),N个类别产⽣N - 1种分类器3. 多对多(MvM),如纠错输出码技术解决类别不平衡问题的三种⽅法:1. 过采样法,增加正例使正负例数⽬接近,如SMOTE:思想是合成新的少数类样本,合成的策略是对每个少数类样本a,从它的最近邻中随机选⼀个样本b,然后在a、b之间的连线上随机选⼀点作为新合成的少数类样本.2. ⽋采样法,减少负例使正负例数⽬接近,如EasyEnsemble:每次从⼤多数类中抽取和少数类数⽬差不多的重新组合,总共构成n个新的训练集,基于每个训练集训练出⼀个AdaBoost分类器(带阈值),最后结合之前训练分类器结果加权求和减去阈值确定最终分类类别.3. 再缩放法第4章决策树ID3决策树选择信息增益最⼤的属性来划分:1. 信息熵:2. 信息增益:C4.5决策树选择增益率⼤的属性来划分,因为信息增益准则对可取值数⽬较多的属性有所偏好.但增益率会偏好于可取值数⽬较少的属性,因此C4.5算法先找出信息增益⾼于平均⽔平的属性,再从中选择增益率最⾼的.另外,C4.5决策树采⽤⼆分法对连续值进⾏处理,使⽤时将划分阈值t作为参数,选择使信息增益最⼤的t划分属性.采⽤样本权值对缺失值进⾏处理,含有缺失值的样本同时划⼊所有结点中,但相应调整权重.1. 增益率:2. a的固有值:CART决策树则选择基尼指数最⼩的属性来划分,基尼系数反映了从数据集中随机抽取的两个样本类别不⼀致的概率,注意CART是⼆叉树,其余两种都为多叉树.1. 基尼值衡量的纯度:2. 基尼指数:剪枝是决策树对付过拟合的主要⼿段,分为预剪枝和后剪枝.1. 预剪枝对每个结点在划分前先进⾏估计,若该结点的划分不能带来决策树泛化性能提升,则停⽌划分.预剪枝基于"贪⼼"本质,所以有⽋拟合的风险.2. 后剪枝是先⽣成⼀棵完整的决策树,然后⾃底向上对⾮叶结点考察,若该结点替换为叶结点能带来决策树泛化性能提升,则将⼦树替换为叶结点.缺点是时间开销⼤.决策树所形成的分类边界是轴平⾏的,多变量决策树(斜决策树)的每⼀个⾮叶结点都是⼀个线性分类器,因此可以产⽣斜的划分边界.第5章神经⽹络误差逆传播算法(BP算法)是迄今为⽌最成功的神经⽹络学习算法.关键点在于通过计算误差不断逆向调整隐层神经元的连接权和阈值.标准BP算法每次仅针对⼀个训练样例更新,累积BP算法则根据训练集上的累积误差更新.缓解BP神经⽹络过拟合有两种常见策略:1. 早停:若训练集误差降低但验证集误差升⾼则停⽌训练.2. 正则化:在误差⽬标函数中增加⼀个描述⽹络复杂度的部分(较⼩的连接权和阈值将使神经⽹络较为平滑).跳出局部最⼩,寻找全局最⼩的常⽤⽅法:1. 以多组不同参数初始化多个神经⽹络,选择最接近全局最⼩的2. 模拟退⽕3. 随机梯度下降典型的深度学习模型就是很深层的神经⽹络.但是多隐层神经⽹络难以直接⽤经典算法进⾏训练,因为误差在多隐层内逆传播时往往会发散.⽆监督逐层训练(如深层信念⽹络,DBN)和权共享(如卷积神经⽹络,CNN)是常⽤的节省训练开销的策略.第6章⽀持向量机⽀持向量机中的原始样本空间不⼀定存在符合条件的超平⾯,但是如果原始空间是有限维,则总存在⼀个⾼维特征空间使样本线性可分.核函数就是⽤来简化计算⾼维特征空间中的内积的⼀种⽅法.核函数选择是⽀持向量机的最⼤变数.常⽤的核函数有线性核,多项式核,⾼斯核(RBF核),拉普拉斯核,Sigmoid核.对⽂本数据常⽤线性核,情况不明时可先尝试⾼斯核.软间隔是缓解⽀持向量机过拟合的主要⼿段,软间隔允许某些样本不满⾜约束.⽀持向量回归可以容忍预测输出f(x)和真实输出y之间存在ε的偏差,仅当偏差绝对值⼤于ε时才计算损失.⽀持向量机中许多规划问题都使⽤拉格朗⽇对偶算法求解,原因在于改变了算法复杂度.原问题的算法复杂度与样本维度有关,对偶问题的样本复杂度与样本数量有关.如果使⽤了升维的⽅法,则此时样本维度会远⼤于样本数量,在对偶问题下求解会更好.第7章贝叶斯分类基于贝叶斯公式来估计后验概率的困难在于类条件概率是所有属性上的联合概率,难以从有限的训练样本直接估计⽽得.因此朴素贝叶斯分类器采⽤了"属性条件独⽴性假设"来避开这个障碍.朴素贝叶斯分类器中为了避免其他属性携带的信息被训练集中未出现的属性值"抹去",在估计概率值时通常要进⾏"平滑",常⽤拉普拉斯修正.属性条件独⽴性假设在现实中往往很难成⽴,于是半朴素贝叶斯分类器采⽤"独依赖估计(ODE)",即假设每个属性在类别之外最多仅依赖于⼀个其他属性.在此基础上有SPODE,TAN,AODE等算法.贝叶斯⽹⼜称信念⽹,借助有向⽆环图来刻画属性之间的依赖关系,并⽤条件概率表来描述属性的联合概率分布.半朴素贝叶斯分类器是贝叶斯⽹的⼀种特例.EM(Expectation-Maximization)算法是常⽤的估计参数隐变量的⽅法.基本思想是:若参数θ已知,则可根据训练数据推断出最优隐变量Z的值(E);若Z的值已知,则可⽅便地对参数θ做极⼤似然估计(M).第8章集成学习集成学习先产⽣⼀组个体学习器,再⽤某种策略将它们结合起来.如果集成中只包含同种类型的个体学习器则叫同质集成,其中的个体学习器称为基学习器,相应的学习算法称为基学习算法.如果包含不同类型的个体学习器则叫异质集成,其中的学习器常称为组件学习器.要获得好的集成,个体学习器应"好⽽不同".即要有⼀定的准确性,并且要有多样性.⽬前的集成学习⽅法⼤致分为两⼤类:1. 序列化⽅法:个体学习器间存在强依赖关系,必须串⾏⽣成.2. 并⾏化⽅法:个体学习器间不存在强依赖关系,可同时⽣成.Boosting先从初始训练集训练出⼀个基学习器,再根据基学习器的表现对训练样本分布进⾏调整,使做错的训练样本在后续受到更多关注(给予更⼤的权重或重采样).然后基于调整后的样本分布来训练下⼀个基学习器;直到基学习器的数⽬达到指定值T之后,将这T个基学习器加权结合.Boosting主要关注降低偏差,因此能基于泛化性能相当弱的学习器构建出很强的集成.代表算法有AdaBoost.Bagging是并⾏式集成学习⽅法最著名的代表.它基于⾃助采样法,采样出T个含m个训练样本的采样集,基于每个采样集训练出⼀个基学习器,再将这些基学习器进⾏简单结合.在对预测输出进⾏结合时,常对分类任务使⽤投票法,对回归任务使⽤平均法.Bagging主要关注降低⽅差,因此在不剪枝决策树,神经⽹络等易受样本扰动的学习器上效⽤更明显.代表算法有随机森林.随机森林在以决策树为基学习器构建Bagging的基础上,进⼀步引⼊了随机属性选择.即先从属性集合(假定有d个属性)中随机选择⼀个包含k个属性的⼦集,再从这个⼦集中选择⼀个最优属性进⾏划分.当k=d时,基决策树与传统决策树相同.当k=1时,则随机选择⼀个属性⽤于划分.⼀般推荐k=log2d.学习器结合可能会从三个⽅⾯带来好处:1. 统计:可能有多个假设在训练集上达到同等性能,单学习器可能因误选⽽导致泛化性能不佳,结合多个学习器会减⼩这⼀风险.2. 计算:通过多次运⾏之后进⾏结合,降低陷⼊糟糕局部极⼩点的风险.3. 表⽰:结合多个学习器,相应的假设空间有所扩⼤,有可能学得更好的近似.结合策略:1. 平均法:对数值型输出,最常见的策略是平均法.⼀般⽽⾔,在个体学习器性能相差较⼤时使⽤加权平均法,性能相近时使⽤简单平均法.权重⼀般也是从训练数据中学习⽽得.2. 投票法:对分类任务来说,最常见的策略是投票法.⼜可细分为绝对多数投票法,相对多数投票法,加权投票法.绝对多数投票法允许"拒绝预测",若必须提供预测结果则退化为相对多数投票法.若基学习器的类型不同,则类概率值不能直接⽐较,需要将类概率输出转化为类标记输出后再投票.3. 学习法:当训练数据很多时,⼀种更强⼤的策略是通过另⼀个学习器来结合.Stacking是学习法的典型代表.我们把个体学习器称为初级学习器,⽤于结合的学习器称为次级学习器或元学习器.Stacking⽤初级学习器的输出作为样例输⼊特征,⽤初始样本的标记作为样例标记,然后⽤这个新数据集来训练次级学习器.⼀般⽤初级学习器的输出类概率作为次级学习器的输⼊属性,⽤多响应线性回归(Multi-response Linear Regression,MLR)作为次级学习算法效果较好.多样性增强常⽤的⽅法有:数据样本扰动,输⼊属性扰动,输出表⽰扰动,算法参数扰动.第9章聚类聚类既能作为⼀个找寻数据内在分布结构的单独过程,也可以作为其他学习任务的前驱过程.我们希望"物以类聚",也就是聚类结果的"簇内相似度"⾼且"簇间相似度"低.聚类性能度量⼤致有两类.⼀类是将聚类结果与参考模型进⾏⽐较,称为外部指标,常⽤的有JC,FMI,RI;另⼀类是直接考察聚类结果,称为内部指标,常⽤的有DBI,DI.有序属性距离计算最常⽤的是闵可夫斯基距离,当p=2时即欧⽒距离,当p=1时即曼哈顿距离.对⽆序属性可采⽤VDM(Value Difference Metric),将闵可夫斯基距离和VDM结合即可处理混合属性,当不同属性的重要性不同时可使⽤加权距离.我们基于某种形式的距离来定义相似度度量,但是⽤于相似度度量的距离未必⼀定要满⾜距离度量的基本性质,尤其是直递性.在现实任务中有必要通过距离度量学习来基于数据样本确定合适的距离计算式.原型聚类假设聚类结构能通过⼀组原型刻画.通常算法先对原型进⾏初始化,然后对原型进⾏迭代更新求解.常⽤的原型聚类算法有k均值算法,学习向量量化,⾼斯混合聚类.密度聚类假设聚类结构能通过样本分布的紧密程度确定.通常从样本密度的⾓度来考察样本之间的可连接性,并基于可连接样本不断扩展聚类簇.常⽤算法有DBSCAN层次聚类试图在不同层次对数据集进⾏划分,从⽽形成树形的聚类结构.代表算法有AGNES.第10章降维与度量学习懒惰学习在训练阶段只把样本保存起来,训练时间开销为零,待收到测试样本后再进⾏处理,如k近邻学习(kNN).急切学习则在训练阶段就对样本进⾏学习处理.若任意测试样本x附近任意⼩的δ距离范围内总能找到⼀个训练样本,即训练样本的采样密度⾜够⼤,或称为密采样,则最近邻分类器(1NN)的泛化错误率不超过贝叶斯最优分类器的错误率的两倍.在⾼维情形下出现的数据样本稀疏,距离计算困难等问题称为"维数灾难".处理⾼维数据的两⼤主流技术是降维和特征选择.降维亦称维数约简,即通过某种数学变换将原始⾼维属性空间转变为⼀个低维⼦空间.能进⾏降维的原因是与学习任务密切相关的或许仅仅是数据样本的某个低维分布,⽽不是原始⾼维空间的样本点.多维缩放是⼀种经典的降维⽅法.它使原始空间中样本之间的距离在低维空间中得以保持.主成分分析(PCA)是最常⽤的⼀种降维⽅法.如果要⽤⼀个超平⾯对所有样本进⾏恰当的表达,这个超平⾯应该具有最近重构性和最⼤可分性两种性质.基于这两种性质可以得到主成分分析的等价推导.PCA可以使样本的采样密度增⼤,同时在⼀定程度上起到去噪的效果.线性降维⽅法有可能丢失低维结构,因此要引⼊⾮线性降维.⼀种常⽤⽅法是基于核技巧对线性降维⽅法进⾏核化.如核主成分分析(KPCA).流形学习(manifold learning)是⼀类借鉴了拓扑流形概念的降维⽅法.流形在局部具有欧⽒空间性质.将低维流形嵌⼊到⾼维空间中,可以容易地在局部建⽴降维映射关系,再设法将局部映射关系推⼴到全局.常⽤的流形学习⽅法有等度量映射和局部线性嵌⼊等.对⾼维数据进⾏降维的主要⽬的是找到⼀个合适的低维空间.事实上,每个空间对应了在样本属性上定义的⼀个距离度量,度量学习直接尝试学习出⼀个合适的距离度量.常⽤⽅法有近邻成分分析(NCA).第11章特征选择与稀疏学习对当前学习任务有⽤的属性称为相关特征,没什么⽤的属性称为⽆关特征.从给定特征集合中选择出相关特征⼦集的过程称为特征选择.特征选择是⼀个重要的数据预处理过程.冗余特征是指包含的信息可以从其他特征中推演出来的特征.冗余特征在很多时候不起作⽤,但若某个冗余特征恰好对应了完成学习任务所需的中间概念,则该冗余特征反⽽是有益的.⼦集搜索:可以采⽤逐渐增加相关特征的前向搜索,每次在候选⼦集中加⼊⼀个特征,选取最优候选⼦集.也可以采⽤每次去掉⼀个⽆关特征的后向搜索.这些策略是贪⼼的,但是避免了穷举搜索产⽣的计算问题.⼦集评价:特征⼦集A确定了对数据集D的⼀个划分,样本标记信息Y对应着对D的真实划分,通过估算这两个划分的差异就能对A进⾏评价.可采⽤信息熵等⽅法.过滤式选择先对数据集进⾏特征选择,然后再训练学习器,特征选择过程与后续学习器⽆关.Relief(Relevant Features)是⼀种著名的过滤式选择⽅法.该⽅法设计了⼀个相关统计量来度量特征的重要性.包裹式选择直接把最终将要使⽤的学习器的性能作为特征⼦集的评价标准.因此产⽣的最终学习器的性能较好,但训练时的计算开销也更⼤.LVW(Las Vegas Wrapper)是⼀个典型的包裹式特征选择⽅法,它在拉斯维加斯⽅法框架下使⽤随机策略来进⾏⼦集搜索,并以最终分类器的误差为特征⼦集评价准则.嵌⼊式选择是将特征选择过程与学习器训练过程融为⼀体,两者在同⼀个优化过程中完成.例如正则化.L1正则化(Lasso)是指权值向量w中各个元素的绝对值之和.L1正则化趋向选择少量的特征,使其他特征尽可能为0,可以产⽣稀疏权值矩阵,即产⽣⼀个稀疏模型,可以⽤于特征选择.L1正则化是L0正则化的最优凸近似.L2正则化(Ridge)是指权值向量w中各个元素的平⽅和然后再求平⽅根.L2正则化趋向选择更多的特征,让这些特征尽可能接近0,可以防⽌模型过拟合(L1也可以).字典学习也叫稀疏编码,指的是为普通稠密表达的样本找到合适的字典,将样本转化为合适的稀疏表达形式,从⽽使学习任务得以简化,模型复杂度得以降低的过程.压缩感知关注的是利⽤信号本⾝的稀疏性,从部分观测样本中恢复原信号.分为感知测量和重构恢复两个阶段,其中重构恢复⽐较重要.可利⽤矩阵补全等⽅法来解决推荐系统之类的协同过滤(collaborative filtering)任务.由于第⼀次阅读,12章开始的内容仅作概念性了解.第12章计算学习理论计算学习理论研究的是关于通过计算来进⾏学习的理论,⽬的是分析学习任务的困难本质,为学习算法提供理论保证,并提供分析结果指导算法设计.计算学习理论中最基本的是概率近似正确(Probably Approximately Correct,PCA)学习理论.由此可以得到PAC辨识,PAC可学习,PAC学习算法,样本复杂度等概念.有限假设空间的可分情形都是PAC可学习的.对于不可分情形,可以得到不可知PAC可学习的概念,即在假设空间的所有假设中找到最好的⼀个.对⼆分类问题来说,假设空间中的假设对数据集中⽰例赋予标记的每种可能结果称为对数据集的⼀种对分.若假设空间能实现数据集上的所有对分,则称数据集能被假设空间打散.假设空间的VC维是能被假设空间打散的最⼤数据集的⼤⼩.算法的稳定性考察的是算法在输⼊发⽣变化时,输出是否会随之发⽣较⼤的变化.第13章半监督学习主动学习是指先⽤有标记样本训练⼀个模型,通过引⼊额外的专家知识,将部分未标记样本转变为有标记样本,每次都挑出对改善模型性能帮助⼤的样本,从⽽构建出⽐较强的模型.未标记样本虽未直接包含标记信息,但若它们与有标记样本是从同样的数据源独⽴同分布采样⽽来,则它们所包含的关于数据分布的信息对建模⼤有裨益.要利⽤未标记样本,需要有⼀些基本假设,如聚类假设,流形假设.半监督学习可进⼀步划分为纯半监督学习和直推学习.前者假定训练数据中的未标记样本并⾮待预测的数据,⽽后者则假定学习过程中所考虑的未标记样本恰是待预测数据.⽣成式⽅法是直接基于⽣成式模型的⽅法.此类⽅法假设所有数据都是由同⼀个潜在的模型⽣成的.这个假设使得我们能通过潜在模型的参数将未标记数据与学习⽬标联系起来.半监督⽀持向量机(S3VM)是⽀持向量机在半监督学习上的推⼴.S3VM试图找到能将两类有标记样本分开,且穿过数据低密度区域的划分超平⾯.除此之外,还有图半监督学习,基于分歧的⽅法(如协同训练),半监督聚类等学习⽅法.第14章概率图模型机器学习最重要的任务,是根据⼀些已观察到的证据来对感兴趣的未知变量进⾏估计和推测.⽣成式模型考虑联合分布P(Y,R,O),判别式模型考虑条件分布P(Y,R|O).概率图模型是⼀类⽤图来表达变量相关关系的概率模型.若变量间存在显式的因果关系,常使⽤贝叶斯⽹.若变量间存在相关性但难以获取显式的因果关系,常使⽤马尔可夫⽹.隐马尔可夫模型(Hidden Markov Model,HMM)是结构最简单的动态贝叶斯⽹.主要⽤于时序数据建模,在语⾳识别,⾃然语⾔处理等领域有⼴泛应⽤.隐马尔可夫模型中有状态变量(隐变量)和观测变量两组变量.马尔可夫链:系统下⼀时刻的状态仅有当前状态决定,不依赖于以往的任何状态.马尔可夫随机场(Markov Random Field,MRF)是典型的马尔可夫⽹.每⼀个结点表⽰⼀个或⼀组变量,结点之间的边表⽰两个变量之间的依赖关系.条件随机场是判别式模型,可看作给定观测值的马尔可夫随机场.概率图模型的推断⽅法⼤致分为两类.第⼀类是精确推断,代表性⽅法有变量消去和信念传播.第⼆类是近似推断,可⼤致分为采样(如MCMC采样)和使⽤确定性近似完成近似推断(如变分推断).第15章规则学习规则学习是指从训练数据中学习出⼀组能⽤于对未见⽰例进⾏判别的规则.规则学习具有较好的可解释性,能使⽤户直观地对判别过程有所了解.规则学习的⽬标是产⽣⼀个能覆盖尽可能多的样例的规则集,最直接的做法是序贯覆盖,即逐条归纳:每学到⼀条规则,就将该规则覆盖的训练样例去除.常采⽤⾃顶向下的⽣成-测试法.规则学习缓解过拟合的常见做法是剪枝,例如CN2,REP,IREP等算法.著名的规则学习算法RIPPER就是将剪枝与后处理优化相结合.命题规则难以处理对象之间的关系,因此要⽤⼀阶逻辑表⽰,并且要使⽤⼀阶规则学习.它能更容易地引⼊领域知识.著名算法有FOIL(First-Order Inductive Learner)等.第16章强化学习强化学习的⽬的是要找到能使长期累积奖赏最⼤化的策略.在某种意义上可看作具有"延迟标记信息"的监督学习问题.每个动作的奖赏值往往来⾃于⼀个概率分布,因此强化学习会⾯临"探索-利⽤窘境",因此要在探索和利⽤中达成较好的折中.ε-贪⼼法在每次尝试时以ε的概率进⾏探索,以均匀概率随机选取⼀个动作.以1-ε的概率进⾏利⽤,选择当前平均奖赏最⾼的动作.Softmax算法则以较⾼的概率选取平均奖赏较⾼的动作.强化学习任务对应的马尔可夫决策过程四元组已知的情形称为模型已知.在已知模型的环境中学习称为"有模型学习".反之称为"免模型学习".从⼈类专家的决策过程范例中学习的过程称为模仿学习.。

基于数据依赖关系的程序自动并行化方法

Ba e n Da a De e d n e s d o t p n e I Li

( oeeo o p t c ne n eh o g , inU i rt,C a ghn10 1 ,C ia C lg C m u r i c dTcnl y Jl nv sy h ncu 30 2 hn ) l f e S e ‘a o i ei

p o a sa r g ms wa mpr v d wh n t e s ra r g a u n p r le . r o e e h e ilp o r msr n i a al1

Ke y wor ds:mi d e g a u a i a all a i lc d l r n l rt p r l ;b sc bo k;pa allr c g iin;daa d p n n e y e r le e o n to t e e de c

Ab t c :I iw o a g u e fs r lh r a e p o r ms u r n i g e c e t n a h g ・ ef r n e s r t n ve fa lr e n mb r o e i e i g r g a n u n n f in l o ih p r ma c a a t i y o

第4 8卷

第 1 期

IC验证工程师招聘笔试题与参考答案(某大型国企)2024年

2024年招聘IC验证工程师笔试题与参考答案(某大型国企)(答案在后面)一、单项选择题(本大题有10小题,每小题2分,共20分)1、以下关于数字电路中CMOS电路的特点,描述错误的是:A、功耗低B、抗干扰能力强C、工作速度慢D、易于集成2、在数字电路设计中,以下哪种电路结构可以实现基本逻辑门的功能?A、与门B、或门C、非门D、异或门3、题干:在集成电路验证过程中,以下哪个说法是正确的?A. 验证环境应该尽可能简单,以确保验证的准确性B. 验证环境应该尽可能复杂,以模拟真实应用场景C. 验证环境应介于简单和复杂之间,以确保验证效率和准确性D. 验证环境的复杂程度由验证团队的主观意愿决定4、题干:以下关于Verilog语言中initial块和always块的说法,哪个是正确的?A. initial块和always块都是顺序执行,initial块在仿真开始时执行一次,always块在每个仿真时间步长开始时执行一次B. initial块和always块都是顺序执行,initial块在仿真开始时执行一次,always块在仿真结束时执行一次C. initial块是顺序执行,在仿真开始时执行一次;always块是并行执行,在每个仿真时间步长开始时执行一次D. initial块是并行执行,在仿真开始时执行一次;always块是顺序执行,在每个仿真时间步长开始时执行一次5、在IC验证流程中,以下哪个阶段不属于功能验证阶段?A. 初始环境搭建B. 测试用例开发C. 验证环境搭建D. 仿真和调试6、以下哪种工具在IC验证中主要用于仿真和调试?A. UVMB. VCSC. VerilatorD. GDB7、在IC验证过程中,以下哪个术语用于描述验证环境中的测试案例?A. TestbenchB. Testbench CodeC. Testbench ModuleD. Testbench Stimulus8、以下哪种验证方法不依赖于模拟硬件或软件,而是使用实际硬件进行验证?A. Simulation-based VerificationB. FPGA-based VerificationC. Formal VerificationD. Emulation-based Verification9、题目:在数字电路中,以下哪种触发器在时钟信号的上升沿触发?A. 主从触发器B. 同步触发器C. 异步触发器D. 边沿触发器 10、题目:在以下关于Verilog HDL的描述中,哪项是错误的?A. Verilog HDL支持硬件描述语言和测试语言B. Verilog HDL中,always块可以用来描述时序逻辑和组合逻辑C. Verilog HDL中,initial块通常用来初始化时序逻辑D. Verilog HDL中,task和function都可以被调用以执行特定功能二、多项选择题(本大题有10小题,每小题4分,共40分)1、以下哪些技术或工具是IC(集成电路)验证工程师在日常工作中所必须熟悉的?()A、Verilog/VHDLB、SystemVerilogC、UVM(Universal Verification Methodology)D、TLM(Transaction-Level Modeling)E、SPICE(Simulation Program with Integrated Circuit Emphasis)F、GDB(GNU Debugger)2、在IC验证过程中,以下哪些是验证工程师需要关注的验证阶段?()A、功能验证B、时序验证C、功耗验证D、安全验证E、兼容性验证F、性能验证3、以下哪些工具或技术是IC验证工程师在芯片设计验证过程中常用的?()A. SystemVerilogB. Verilog-AC. UVM(Universal Verification Methodology)D. waveform viewerE. DFT(Design-for-Test)4、在IC验证过程中,以下哪些步骤是验证工程师需要完成的?()A. 验证需求分析B. 验证环境搭建C. 验证计划制定D. 验证用例编写E. 验证结果分析5、以下哪些是IC验证工程师在验证过程中常用的验证方法?()A. 仿真验证B. 系统级验证C. 单元级验证D. 代码覆盖率分析E. 动态功耗分析6、以下哪些是UVM(Universal Verification Methodology)验证环境中常见的组件?()A. SequenceB. ScoreboardC. AgentD. DriverE. Monitor7、以下哪些是IC(集成电路)验证工程师在验证过程中需要关注的时序问题?()A. setup timeB. hold timeC. clock domain crossingD. metastabilityE. power integrity8、在IC验证过程中,以下哪些工具或技术被广泛用于提高验证效率?()A. UVM(Universal Verification Methodology)B. assertion-based verificationC. formal verificationD. coverage-driven verificationE. simulation acceleration9、以下哪些技术是IC验证工程师在工作中常用的验证方法?()A. 仿真验证B. 硬件加速验证C. 实验室测试D. 动态功耗分析 10、以下关于验证计划的描述,正确的是哪些?()A. 验证计划应包含验证目标、验证策略、验证环境等B. 验证计划应详细列出所有的验证用例和测试项C. 验证计划应根据项目进度动态调整D. 验证计划应确保验证过程的可追溯性三、判断题(本大题有10小题,每小题2分,共20分)1、IC验证工程师在验证过程中,只需关注设计规格书,无需考虑其他相关文档。

《2024年遗留代码的MapReduce并行化重构方法研究》范文

《遗留代码的MapReduce并行化重构方法研究》篇一一、引言随着信息技术的飞速发展,大数据处理已经成为各行业不可或缺的一部分。

MapReduce作为一种强大的并行计算框架,被广泛应用于大规模数据处理中。

然而,许多企业和组织面临着遗留代码的挑战,这些代码往往缺乏现代编程范式的优势,如并行化处理能力。

因此,如何将遗留代码与MapReduce框架相结合,实现并行化重构,成为了一个亟待解决的问题。

本文旨在研究遗留代码的MapReduce并行化重构方法,以提高数据处理效率和系统性能。

二、遗留代码的特点与挑战遗留代码通常具有以下特点:代码结构复杂、模块耦合度高、缺乏文档和注释、以及难以理解和维护等。

这些特点使得遗留代码在并行化重构过程中面临诸多挑战,如代码的可读性、可维护性、性能优化等。

此外,遗留代码中可能存在的数据依赖性和资源分配问题也是并行化重构的难点。

三、MapReduce框架及其优势MapReduce是一种基于分布式计算的编程模型,通过将任务分解为多个子任务(Map阶段和Reduce阶段),实现对大规模数据的并行处理。

MapReduce框架具有以下优势:1. 简单易用:通过编写简单的Map和Reduce函数,即可实现复杂的并行计算任务。

2. 高度可扩展性:MapReduce框架能够处理海量数据,具有高度的可扩展性。

3. 容错性强:MapReduce框架具有容错机制,能够在节点故障时保持计算的正确性。

四、遗留代码的MapReduce并行化重构方法针对遗留代码的并行化重构,本文提出以下方法:1. 代码分析与理解:首先对遗留代码进行详细的分析和理解,明确代码的功能、结构以及数据依赖关系。

这有助于确定哪些部分适合进行并行化重构。

2. 设计并行化方案:根据代码的特点和需求,设计合理的并行化方案。

这包括确定Map和Reduce阶段的划分、任务调度策略等。

3. 模块化改造:将遗留代码进行模块化改造,降低模块间的耦合度,提高代码的可读性和可维护性。

高性能计算中的任务分割与合并技巧(三)

高性能计算中的任务分割与合并技巧概述:在高性能计算领域,任务分割与合并是关键的环节之一。

如何高效地切分任务并合理地组合计算结果,对于提升计算性能具有重要意义。

本文将讨论一些任务分割与合并的技巧,以期为高性能计算的实践提供一些指导。

任务分割的三个关键因素:1. 任务复杂度分析在任务分割过程中,首要的一步是对任务进行复杂度分析。

这包括任务的输入输出规模、计算复杂度、并行化潜力等。

通过对任务的详细分析,可以确定适合切分的任务规模、优化计算流程等。

2. 任务切分策略选择任务切分策略的选择对于高性能计算的整体性能至关重要。

常见的任务切分策略有均匀切分、粒度切分和数据切分等。

在选择任务切分策略时,需结合任务特点、计算资源及通信开销等因素进行综合考虑。

3. 数据依赖性分析在任务分割中,对于具有数据依赖性的任务,需要特别注意数据传输的开销。

一方面,可以通过增加并行线程从而隐藏数据传输延迟;另一方面,可以通过通信优化等技术减小数据传输的开销,进而提升整体性能。

任务合并的两个关键因素:1. 结果合并策略选择当分割的任务完成后,需要将各个子任务的结果合并为最终结果。

根据任务的特点,可以选择串行合并、归并排序、局部合并再整体合并等不同的策略。

合理选择结果合并策略可以在减少计算开销的同时,保证结果的正确性。

2. 性能监测与优化在任务合并过程中,对计算性能进行实时监测与优化是必要的。

通过利用性能分析工具,可以定位并解决潜在性能瓶颈,提升任务合并的效率。

例如,可以通过优化数据传输、降低通信开销等手段来改进任务合并的性能。

案例分析:为了更好地理解任务分割与合并的实际应用,我们以物体检测算法为例进行分析。

物体检测是计算密集型的任务,通常需要耗费大量的计算资源。

在任务分割阶段,我们可以将图像按照区域进行划分,由不同的节点负责检测特定区域内的物体。

为了减小数据传输的开销,可以在切分时增加重叠区域,并利用数据存储技术优化数据传输。

在任务合并阶段,我们可以选择局部合并再整体合并的策略,以减少合并的计算开销。

基于模糊依赖度算法汽车故障诊断仿真研究

车原来设计规定 的功能 的现象 , 汽车故 障若按 照影 响汽车性 能 的情 况 , 一般可 以分 为功 能性故 障和 参数 性故 障 , 能故 功

汽车故障 的发生的几率 , 同时在此基础上 , 出了模糊依赖度最大化模型对 汽车故障进行诊 断的具体步骤 。理论 分析和仿 给

真证 明了将模糊依赖度最大化算法用于汽车故障诊断方面是 可行的和有效 的, 并能提高故障监测的可靠性 。 关键词 : 模糊依赖度 ; 汽车故障诊断 ; 最大化

中 图分 类 号 :P 0 T31 文 献 标 识 码 : A

ABS TRACT: h u o t ef u t e e t n a d d a n si c u a y p o lmsa e su i d a l d tcin a d d a — T e a tmo i a l d t ci n ig o t a c r c r b e r t d e .F u t ee t n ig v o c o n s f u o t et c n lg a eb e ef c so o l rb e ,a d i i d f c l frma y t d t n a l d a — o i o tmo i e h o o y h v e n t u f r p o lms n t s i u t o n r i o a f ut ig s a v h o w d f i a i l n s lo i ms t c u ae y d s rb h y tmsa d t e c mp e e ain h p b t e n t e c u e o e maf n — o i ag r h o a c r tl e c i e t e s mp o n h o lx r lt s i e w e h a s ft l c s t o h u t n,r s h n n fi r s s c sl c fa c r t ig o i. A n w f z y fu td a n ss ag r h o xmi e i o e u i g i a l e u h a a k o c u ae d a n s u s e u z a l ig o i loi m fma i z d — t e p n e c sp e e t d h l o tm ,b s d o zy r u h s tt e r ,f s o ti sa vb a in fu t a l s n — e d n e i r s n e .T ea g r h i a e n f z o g e o y i t ba n ir t a l s mp e ,a d U u h r o

基于分群策略的机群系统上Motif发现并行算法

统上设计一种 Moi发现并行投票算 法。实验结果表 明, t f 在保证 解精 度 的前提 下, 并行算 法获得 了良好 的加 速 , 该 执行效

率达到 9 % 以上 。 5

Abta t M oi dso eig i a mp ra tp o lm iifr tc. By dsrb t g e e l h uf r u s t h sr c: tf ic v r s n i o tn r be i bono mais n n itiu i v n y te s fi g o p Ot e n x

p o e s r n y a p yn h a a llf t rn n r ig t c n q e ,a p r l l o i g ag rt m o o i d s o e i g i r c s o s a d b p l i g t ep r l i e ig a d me g n e h i u s a a l t l o ih f rM tf ic v rn s e l ev n

i iig Gr u so h u trCo u ig S se D vdn o p n t eCl se mp tn y tms

李 锦, 钟 诚, 卿海军

L i,IO G C eg Q N I - I nZtN J h n , I C hi ̄ j

( 广西大学计算机与 电子信息学院 , 广西 南宁 5 0 0 ) 30 4

计一种确定性 的 Moi发现硬件并行算法 。 t f 机群计算系统具 有高性能 、 低成本和扩展性好等特 点。 本文采用均匀分配后 缀群 的策略 和并行 归并方法 , 在机 群 系统上设计与实现一个 Moi发现并行算法 。 t f

现有 助于决定序列 的功能 和阐明序列之 间的进化关 系 , 并 且 在识别 D NA序列 的调控信号 方面有着 重要的应用 。 文献 Ei 出一 种期 望最 大化算 法 , 交替 执行 E步 l提 它 骤( 求期望值) M 步骤 ( 大化 ) 和 最 。为 了能够从 没有 任何

并行工程

市场管理

进进

了 解 市 场

行 市 场 细

行 组 合

制定业 务策略 和计划

结合并 优化跨 业务部 门的业

分

务计划

分析

产品路标

OF 2

组合分析 组合管理

OF 1

OF1.1

项目任务

书? 是

否

管理业务计划,评估绩效

OF3.0

CPD

Concept Concept

Plan Plan

Develop Qualify Develop Qualify

模

竞争的剧烈 程度

子要素1: 来自客户/ 供应商的

压力

高、中、低

要素解释

提议的定义

对该要素的评分(高、中、低)应该反映该产品在市场 上的相对收入机会。针对所分析的每个市场,要对高、 中、低进行定义,而且每个产品线内部以及产品线之间 的定义必须保持一致

高:大于50亿人民币

中:10~50亿人民币 低:小于10亿人民币

PRTM(I2前身)创造了PACE (Product And Cycle-time Excellence,产品及生命周期优化法 ), 经IBM和很多公司的实践,CPD 已经成为一套重整企业产品开发模式的方法论,CPD强调以市场需求 作为产品开发的驱动力,将产品开发作为一项投资来管理。

CPD是流程、是技术、是方法,但归根到底它是一种研发文化形 式,是价值观,包括MBR、并行开发、团队、端到端等思想都是在目 前激烈竞争的市场环境下赢得客户的企业价值观的体现。

将与其它两个子要素 (直接/间接竞争和进 入的威胁)一起考 虑。根据对市场情况 的了解,将给出一个 高、中、低的定性评 估。

格以及/或者生产该产品所需的关键资源的话,来自供应

《针对并行待测行为测试的CPN模型化简方法》范文

《针对并行待测行为测试的CPN模型化简方法》篇一一、引言随着系统复杂性的增加,并行待测行为测试成为了确保系统性能和稳定性的关键环节。

CPN(Coloured Petri Nets,带颜色的Petri网)模型作为一种有效的建模和分析工具,被广泛应用于描述并发系统中的行为和交互。

然而,在面对复杂的并行待测行为时,CPN模型的规模和复杂性可能迅速增加,给模型的构建和分析带来挑战。

因此,本文提出了一种针对并行待测行为测试的CPN模型化简方法,旨在提高模型的易用性和分析效率。

二、CPN模型与并行待测行为CPN模型是一种描述并发系统中行为和交互的图形化建模工具。

它通过节点、有向边以及与之相关的颜色集、状态集和颜色变化规则等元素来描述系统的动态行为。

在并行待测行为测试中,CPN模型可以有效地表示不同待测行为的并行关系和交互过程。

然而,在处理复杂的并行待测行为时,CPN模型可能变得庞大而复杂,不利于理解和分析。

三、模型化简方法针对上述问题,本文提出了一种针对并行待测行为测试的CPN模型化简方法。

该方法主要包括以下几个步骤:1. 识别关键元素:首先,从CPN模型中识别出与待测行为紧密相关的关键元素,包括节点、有向边和颜色集等。

这些关键元素是模型化简的基础。

2. 删除冗余元素:根据关键元素的识别结果,删除与待测行为无关或冗余的元素,以简化模型结构。

3. 合并相似元素:对于具有相似行为的元素,可以进行合并操作,以减少模型的复杂度。

合并时需保证合并后的元素能够准确描述原有元素的并行关系和交互过程。

4. 优化颜色集:根据待测行为的特性,优化颜色集的设计,使得颜色集更加简洁明了,有助于理解模型的动态行为。

5. 验证化简后的模型:在完成模型化简后,需要对化简后的模型进行验证,确保其能够准确描述原模型的并行待测行为和交互过程。

四、方法应用与效果本文所提出的CPN模型化简方法在实际应用中取得了良好的效果。

以一个复杂的并行待测系统为例,通过应用该方法,成功将原始的CPN模型进行了化简,使得模型的规模和复杂性得到了显著降低。

《SF并行处理框架的设计与实现》范文

《SF并行处理框架的设计与实现》篇一一、引言随着信息技术的快速发展,数据规模和处理任务的复杂度逐渐提升,对处理效率的需求也随之提高。

传统的串行处理模式在面对大量数据处理时,效率低下,难以满足实际需求。

因此,并行处理框架的研发与应用显得尤为重要。

SF并行处理框架正是在这样的背景下应运而生,其设计目标在于提高数据处理效率,降低资源消耗,实现高效、快速的并行计算。

二、SF并行处理框架的设计1. 设计原则(1) 可扩展性:框架应具备良好的可扩展性,以适应不同规模的数据处理需求。

(2) 高效性:优化计算资源的使用,提高数据处理速度。

(3) 灵活性:支持多种数据源和算法,满足不同应用场景的需求。

2. 架构设计SF并行处理框架采用主从式架构,主要包括主节点和多个从节点。

主节点负责任务调度、资源分配和结果汇总等管理工作,从节点则负责具体的计算任务。

框架支持多种并行计算模式,包括数据并行、任务并行和混合并行,以满足不同类型的应用需求。

3. 功能模块(1) 数据预处理模块:对输入数据进行清洗、转换和格式化等预处理操作,以便于后续的计算分析。

(2) 任务调度模块:根据数据处理需求和系统资源状况,合理分配计算任务到各个从节点。

(3) 并行计算模块:从节点接收计算任务后,利用多线程、多进程等技术进行并行计算。

(4) 结果汇总模块:将各个从节点的计算结果进行汇总、整合,输出最终结果。

(5) 监控与日志模块:对框架的运行状态进行实时监控,记录日志信息,以便于问题定位和系统优化。

三、SF并行处理框架的实现1. 技术选型SF并行处理框架采用Java语言进行开发,利用JVM的并发特性实现多线程并行计算。

同时,采用分布式文件系统存储数据,以支持大规模数据的处理。

此外,还利用了消息队列、网络通信等技术实现节点间的数据传输和协同计算。

2. 关键技术实现(1) 任务调度算法:设计了一种基于优先级和负载均衡的任务调度算法,以保证计算任务的合理分配和系统的整体性能。

总结分析 部署

总结分析部署一、背景介绍在软件开发过程中,部署是指将软件系统从开发环境移植到生产环境的过程。

有效的部署流程和策略对于保证系统的稳定性和可靠性非常重要。

本文将对软件部署过程进行总结分析,并探讨一些优化策略。

二、部署流程1. 环境准备在开始部署之前,需要对部署环境进行准备。

这包括安装并配置运行环境、安装必要的依赖库和工具等。

同时,还需要评估生产环境的硬件设备和网络带宽是否满足系统运行的要求。

2. 编译和打包在部署之前,需要将源代码编译成可执行文件或者部署包。

对于编译型语言,如C++或Java,需要使用相应的编译工具进行编译。

对于脚本语言,如Python或Ruby,可以直接使用源代码进行部署。

同时,在编译完成后,还需要进行打包操作。

打包可以将可执行文件和依赖的资源文件打包成一个单独的部署包,便于传输和安装。

3. 部署到目标机器在将应用程序部署到目标机器之前,需要进行一系列的配置工作。

这包括设置系统环境变量、配置文件等,以确保应用程序能够正常运行。

部署可以采用手动部署和自动化部署两种方式。

手动部署需要人工操作,适用于简单的部署任务;自动化部署则可以通过脚本或工具来完成,适用于复杂的部署场景。

4. 测试和验证在部署完成后,需要对系统进行测试和验证,以确保系统在生产环境下正常运行。

这包括功能测试、性能测试、压力测试等。

在测试和验证过程中,我们需要关注系统的稳定性、性能和容错能力等方面。

通过适当的测试和验证,可以帮助我们发现潜在的问题和缺陷,并及时进行修复和优化。

三、部署优化策略1. 并行部署在进行部署时,可以采用并行部署的策略,将多个组件同时部署到目标机器上,以提高部署效率。

通过并行部署,可以最大程度地利用计算资源,减少部署所需的时间。

当进行并行部署时,需要注意目标机器的硬件资源是否足够支持并行部署。

如果硬件资源不足,可能导致部署过程中的资源竞争和性能下降。

2. 自动化部署自动化部署是一种高效的部署策略,可以通过脚本或工具来完成整个部署过程。

sdid原理

sdid原理

SDID(Semantic Dependency Infused Deep learning)是一种基于语义依存关系的深度学习模型。

它使用语义依存关系来帮助模型更好地理解句子中单词之间的关系。

通过将语义依存关系嵌入到深度学习模型中,SDID能够提高自然语言处理任务的性能。

SDID的核心思想是将句子中的每个单词表示为一个向量,并且考虑到单词之间的语义依存关系。

这些向量通过神经网络进行计算,从而得到模型的输出。

SDID使用了一种称为依存树的结构来表示句子中的语义依存关系。

依存树由单词节点和依存关系边组成,每个边都表示一个单词之间的依存关系。

SDID的训练过程包括两个步骤:依存关系的标注和模型的训练。

在标注过程中,人工标注者需要为每个句子中的单词标注其依存关系。

这些标注可以通过人工注释或自动标注器来获得。

在模型的训练过程中,SDID使用标注的依存关系来训练神经网络模型,以学习如何正确地预测句子中单词之间的依存关系。

SDID的应用广泛,包括句法分析、语义角色标注、命名实体识别等自然语言处理任务。

通过将语义依存关系嵌入到深度学习模型中,SDID能够更好地捕捉句子中单词之间的关系,从而提高自然语言处理任务的性能。

SDID是一种基于语义依存关系的深度学习模型,它能够帮助模型更

好地理解句子中单词之间的关系。

通过将语义依存关系嵌入到深度学习模型中,SDID能够提高自然语言处理任务的性能。

产品特性技术路线描述与实现依据

资料范本本资料为word版本,可以直接编辑和打印,感谢您的下载产品特性技术路线描述与实现依据地点:__________________时间:__________________说明:本资料适用于约定双方经过谈判,协商而共同承认,共同遵守的责任与义务,仅供参考,文档可直接下载或修改,不需要的部分可直接删除,使用时请详细阅读内容产品特性技术白皮书产品营销部编制:2009-8-1RG-SMP 2.X桌面管理/审计组件主要针对IT运维中PC桌面管理维护工作的平台型软件系统。

产品主要是以结合WMI、MBSA、SPI、PFI、FACF等多种技术,形成一套集中性的控制系统。

产品技术架构图如下:WMI、MBSA、SPI、PFI、FACF及各种Windows SDK进程管理策略网络访问策略外设使用策略桌面设置策略补丁更新策略日志管理策略操作系统平台:Windows 98、Windows NT、Windows 2000、Windows XP、Windows 2003、vista硬件及外设配置应用程序信息补丁安装信息桌面设置信息网络端口及流量各种PC性能阀值应用软件部署客户端调度程序服务器及数据库系统RG-SMP控制台创新点一:PFI(Process Fingerprint Identification,进程指纹技术)PFI是锐捷经过几年的技术研究,以及反复的验证,研发出的进程唯一性指纹技术,采用分析进程执行文件的PE格式,然后进行加密,生成一种类型的软件,在进程中的唯一标识性代码,RG-SMP 2.X桌面管理/审计组件通过这一代码,并预先设定一个PC的进程运行策略,从而根据策略判断,哪些进程是合法的,哪些是非法的,对于非法的则进行查杀。

这一技术经过了长时间的验证,能够避免PC使用者为了逃避管理而采取的更改权限、更改文件属性多种手段。

创新点二:FACF(File Access Control Filtering,文件访问过滤)FACF是锐捷基于操作系统内核,创建了一个对PC用户访问文件的过滤机制,这个过滤机制能够根据预先建立的规则,对于PC用户的磁盘进行读保护、写保护以及删除保护。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

证, 在验证过程 中,并行验证 完的控制结构直接触 发支持控制结构 , 无须等待其他操作 , 从而可 以提高程序验证的并行性 。此外,还给出 提取控制结构依 赖图算法和验证过程 调度算法 ,并用实验证明其正确性和高效性。

关奠诃 :H a 逻辑 ;依赖分析 ;并行验证 oe r

Pa a ll rfc to t a e y Ba e n De e d n eAn l ss r l i a i n S r t g s d 0 p n e c a y i e Ve i

第 3 卷 第 1 期 6 2

V1 o. 36

・

计

算

机

工

程

21 00年 6月

J n 0 0 u e2 1

No.2 J

Co p e m ut rEng ne r n i e ig

软件 技术 与数 据库 ・

文章编号:1 3 8 o02 6_ 2 文献标识 A o -4 ( 1)— o斗_ 0 22 1 o 码:

不一定能提高软件 的生产率 。所以如何提高验证效率是提高 软件 生产率的一个值得研究的方向。本文从程序控制结构的

依赖关系着手探讨验证效率 的提升问题。

鉴于 此,得到后文 的并行组织验证策 略,由此验证效率又得

到了进一步的提高 。

2 并行验证的Βιβλιοθήκη 织 显然 ,X ZS 语言的验证过程是顺序地按每一条验证 Y /E 规则进行验证。这种顺序验证方法制约 了验证工作 的效率 , 尤其在验证大型程序时愈发明显。所 以通过提高验证过程 的

中圈分类 P15 号i 31 T .

基 于依 赖 分析 的并行 化 验 证 策略

陶 荣 何 , 锫 ,黄道 昌

(.长沙理工大学计算机与通信工程学院,长沙 4 0 7 ;2 1 10 6 .武汉大学软件工程国家重点实验室 ,武汉 4 0 7 ) 30 2

摘

要: 提高验证过程的并行性是提高程序验证效率的重要手段之一。为此 , 出一种基于控制结构依 赖分析 的方法来组织程序 的并行验 提

ba e n t e d p n e c n l s so o to tu t r st r a i e i i r p s d I h r c s fv r i a o , h a a llv rf d c n r lsr cu e s d o h e e d n e a ay i f n r l r c u e o o g n z t sp o o e . n t ep o e so e i c t n t e p le e i o t tu t r c s f i r i e o C rg e he s p o t d c n r lsr cu e a d t e e i o n e o wa tf ro h ro e a i n ,S tc n e h nc h a a lls f r v rfc t n o n a ti g rt u p re o to tu t r , n h r s n e d t i o t e p r t s O i a n a e t e p r l im o e i a i f o e i o p o r ms Al o i ms a l a x e me t o xr c i g t e d p n e c i g a o o t t u t r s s h d l g o e f a i n p o e s n r g a . g rt h swe l se p r i n sf r e ta t e e d n e d a r m fc n r sr c u e , c e u i fv ri to r c s ,a d n h ol n i c d mo s ai g t erc r e t e sa d e ce c e a s n r d c d. e n t tn i o r c n s n f i n y a lo i to u e r h i r

[ yw r s Ke o d ]Ho elgcd p n ec a s ;aae e f a o r o a i; eed nea l i p l l r ct n n y s r l vi i i

程序验证尽管可以保证软件 的质量 ,但也十分费 时,并

繁琐 , 且是一顺序过程 ,尚未充分挖 掘其 中的并发构造特性。

T AO n HE e , Ro g , P i HUANG o c a g Da -h n ( . l g f o u n o 1 Col e C mp  ̄r dC mmu ia o E gn e n , h n s a ies yo S in ea dT c n lg , h n s a 1 0 6 e o a nc t n n ie r g C a g h Unv ri f ce c n e h oo y C a g h 4 0 7 ; i i t

2 Sa yL b r tr f o t r n ie r g Wu a ies y Wu a 3 0 2 . tt Ke a o aoyo f e S wae gn e n , h nUnv ri , h n4 0 7 ) E i t

[ s at n fh otn a soices e fcec f rga v r ct ni t fl eeo ep a e s S to hc Abt c]O eo e mp r t n raet i inyo o rm e f ai so ul dv lpt a l l m. oame dw ihi r t i a me t n he p i i o y h r li h s