最速下降法和牛顿法求最小值点的算法及结果代码

最速下降法 牛顿法

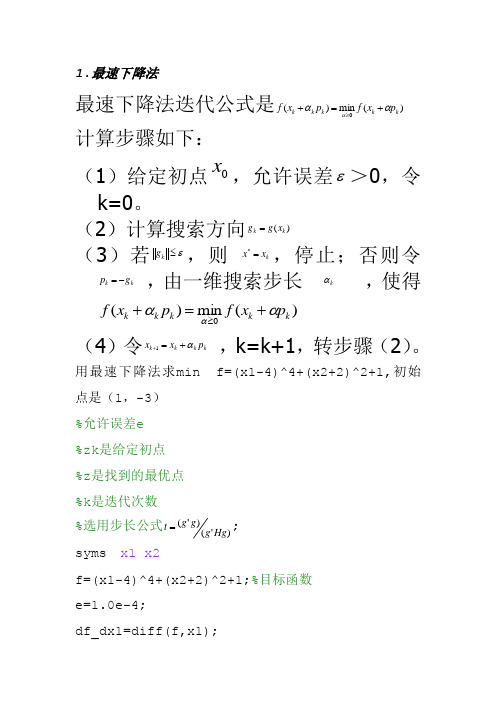

1.最速下降法最速下降法迭代公式是)(min )(0k k k k k p x f p x f ααα+=+≥ 计算步骤如下:(1)给定初点0x ,允许误差ε>0,令k=0。

(2)计算搜索方向)(k k x g g =(3)若ε≤k g ,则 kx x =*,停止;否则令k k g p -= ,由一维搜索步长 kα ,使得)(min )(0k k k k k p x f p x f ααα+=+≥(4)令k k k k p x x α+=+1 ,k=k+1,转步骤(2)。

用最速下降法求min f=(x1-4)^4+(x2+2)^2+1,初始点是(1,-3)%允许误差e%zk 是给定初点%z 是找到的最优点%k 是迭代次数%选用步长公式)'()'(Hg g g g t =;syms x1 x2f=(x1-4)^4+(x2+2)^2+1;%目标函数e=1.0e-4;df_dx1=diff(f,x1);df_dx2=diff(f,x2);f1=[df_dx1;df_dx2];flag=1;k=0;zk=[1;-3];while flagg=subs(f1,[x1;x2],zk); %梯度g(zk)norm_g=norm(g);if norm_g<=e%如果g的模小于允许误差,则已找到最优点 flag=0;z=zk;zuiyou_f=subs(f,[x1;x2],z);disp('极小点是')zdisp('最小值是')zuiyou_fdisp('迭代次数')kbreakelse%g的模不小于允许误差的情况 k=k+1;p=-g; %负梯度h=jacobian(f1);H=subs(h,[x1;x2],zk); %Hesse 矩阵 H (xk ) t=(g'*g)/(g'*H*g); %t 是搜索步长 zk=zk+t*p;endend2.牛顿法已知目标函数)(x f 及其梯度)(x g ,Hesse 矩阵)(x G ,终止限 ε 。

最优化马昌凤第三章作业

最优化方法及其Matlab程序设计习题作业暨实验报告学院:数学与信息科学学院班级:12级信计一班姓名:李明学号:49第三章 最速下降法和牛顿法一、上机问题与求解过程1、用最速下降法求212221216423),(x x x x x x f --+=的极小值。

解:仿照书上编写最速下降法程序如下:function [x,val,k]=grad(fun,gfun,x0)%功能:用最速下降法求解无约束化问题:min f(x)%输入:x0是初始点,fun,gfun分别是目标函数和梯度%输出:x,val分别是近似嘴有点和最优值,k是迭代次数maxk=5000;rho=;sigma=;%一开始选择时选择的rho和sibma选择的数据不够合理,此处我参照书上的数据编写数据k=0;epsilon=1e-5;while(k<maxk)g=feval(gfun,x0);%计算梯度d=-g;%计算搜索方向if(norm(d)<epsilon),break;endm=0;mk=0;while(m<20)%Armijo搜索if(feval(fun,x0+rho^m*d)<feval(fun,x0)+sigma*rho^m*g'*d)mk=m;break;%直接利用Armijo搜索公式,一开始的时候没有记住公式编写出现错误endm=m+1;endx0=x0+rho^mk*d;k=k+1;endx=x0;val=feval(fun,x0)%求得每一个的函数值然后仿照书上建立两个目标函数和梯度的M文件:function f=fun(x)f=3*x(1)^2+2*x(2)^2-4*x(1)-6*x(2);function g=gfun(x)g=[6*x(1)-4,4*x(2)-6]';选取初始点为']0,0[,调用函数程序,得出最小极值点为']6667.0[,极小值为8333500.1,,在界面框中输入的程序如下:.5[x,val,k]=grad('fun','gfun',x0)val =x =k =10从结果可以看出迭代次数为10次,如果选取不同的初值点则迭代次数不一样,但是极小值相同。

python编写牛顿法最速下降法

python编写牛顿法最速下降法牛顿法和最速下降法是数值优化中常用的两种方法,用于求解无约束非线性优化问题。

下面将分别介绍牛顿法和最速下降法的原理和具体实现。

一、牛顿法(Newton's method):牛顿法是一种迭代方法,通过使用函数的一、二阶导数来逼近函数的极小值或极大值。

其原理是在当前点处,构造函数的二阶泰勒展开式,并将其极小化,得到下一个迭代点。

具体公式如下:x(k+1) = x(k) - H^-1 * ∇f(x(k))其中,x(k)表示第k次迭代的点,∇f(x(k))表示函数f(x)在点x(k)的梯度,H是函数f(x)在点x(k)的Hessian矩阵。

牛顿法的关键在于求解Hessian矩阵的逆矩阵,可以通过求解线性方程组来实现。

牛顿法的优点是收敛速度快,在接近最优解附近时,收敛速度迅速。

但其缺点也比较明显,一是需要计算二阶导数,计算复杂度较高;二是Hessian矩阵可能不是正定的,导致迭代方向不收敛。

为了避免这些问题,有时可以引入修改的牛顿法,使用拟牛顿法来近似Hessian矩阵。

二、最速下降法(Steepest Descent):最速下降法是一种基于负梯度方向进行优化的方法,即在当前点处,朝着梯度的负方向进行迭代以找到函数的最小值点。

其公式如下:x(k+1) = x(k) - α * ∇f(x(k))其中,x(k)表示第k次迭代的点,∇f(x(k))表示函数f(x)在点x(k)的梯度,α是步长或学习率,用于控制每次迭代的步长大小。

最速下降法的优点是实现简单,不需要计算二阶导数,但由于每次迭代方向都是负梯度方向,可能导致收敛速度慢,特别是在接近最优解时。

为了提高收敛速度,可以使用线搜索等方法来选择合适的步长。

实际应用中,牛顿法和最速下降法常常结合使用,即先使用最速下降法迭代近似解,然后再使用牛顿法进行迭代优化,以提高计算效率和准确度。

三、牛顿法和最速下降法的实现:下面是使用Python实现牛顿法和最速下降法的示例代码:```import numpy as npdef newton_method(f, g, H, x0, epsilon=1e-6, max_iter=100):x = x0for _ in range(max_iter):gradient = g(x)if np.linalg.norm(gradient) < epsilon:return xhessian_inv = np.linalg.inv(H(x))x = x - np.dot(hessian_inv, gradient)return xdef steepest_descent(f, g, x0, alpha=0.01, epsilon=1e-6,max_iter=100):x = x0for _ in range(max_iter):gradient = g(x)if np.linalg.norm(gradient) < epsilon:return xx = x - alpha * gradientreturn x```上述代码中,newton_method函数实现了牛顿法,参数f表示目标函数,g表示梯度函数,H表示Hessian矩阵函数,x0表示初始点,epsilon表示迭代停止的梯度阈值,max_iter表示最大迭代次数。

python使用梯度下降和牛顿法寻找Rosenbrock函数最小值实例

python使⽤梯度下降和⽜顿法寻找Rosenbrock函数最⼩值实例Rosenbrock函数的定义如下:其函数图像如下:我分别使⽤梯度下降法和⽜顿法做了寻找Rosenbrock函数的实验。

梯度下降梯度下降的更新公式:图中蓝⾊的点为起点,橙⾊的曲线(实际上是折线)是寻找最⼩值点的轨迹,终点(最⼩值点)为 (1,1)(1,1)。

梯度下降⽤了约5000次才找到最⼩值点。

我选择的迭代步长α=0.002α=0.002,αα没有办法取的太⼤,当为0.003时就会发⽣振荡:⽜顿法⽜顿法的更新公式:Hessian矩阵中的每⼀个⼆阶偏导我是⽤⼿算算出来的。

⽜顿法只迭代了约5次就找到了函数的最⼩值点。

下⾯贴出两个实验的代码。

梯度下降:import numpy as npimport matplotlib.pyplot as pltfrom matplotlib import tickerdef f(x, y):return (1 - x) ** 2 + 100 * (y - x * x) ** 2def H(x, y):return np.matrix([[1200 * x * x - 400 * y + 2, -400 * x],[-400 * x, 200]])def grad(x, y):return np.matrix([[2 * x - 2 + 400 * x * (x * x - y)],[200 * (y - x * x)]])def delta_grad(x, y):g = grad(x, y)alpha = 0.002delta = alpha * greturn delta# ----- 绘制等⾼线 -----# 数据数⽬n = 256# 定义x, yx = np.linspace(-1, 1.1, n)y = np.linspace(-0.1, 1.1, n)# ⽣成⽹格数据X, Y = np.meshgrid(x, y)plt.figure()# 填充等⾼线的颜⾊, 8是等⾼线分为⼏部分plt.contourf(X, Y, f(X, Y), 5, alpha=0, cmap=plt.cm.hot)# 绘制等⾼线C = plt.contour(X, Y, f(X, Y), 8, locator=ticker.LogLocator(), colors='black', linewidth=0.01) # 绘制等⾼线数据plt.clabel(C, inline=True, fontsize=10)# ---------------------x = np.matrix([[-0.2],[0.4]])tol = 0.00001xv = [x[0, 0]]yv = [x[1, 0]]plt.plot(x[0, 0], x[1, 0], marker='o')for t in range(6000):delta = delta_grad(x[0, 0], x[1, 0])if abs(delta[0, 0]) < tol and abs(delta[1, 0]) < tol:breakx = x - deltaxv.append(x[0, 0])yv.append(x[1, 0])plt.plot(xv, yv, label='track')# plt.plot(xv, yv, label='track', marker='o')plt.xlabel('x')plt.ylabel('y')plt.title('Gradient for Rosenbrock Function')plt.legend()plt.show()⽜顿法:import numpy as npimport matplotlib.pyplot as pltfrom matplotlib import tickerdef f(x, y):return (1 - x) ** 2 + 100 * (y - x * x) ** 2def H(x, y):return np.matrix([[1200 * x * x - 400 * y + 2, -400 * x],[-400 * x, 200]])def grad(x, y):return np.matrix([[2 * x - 2 + 400 * x * (x * x - y)],[200 * (y - x * x)]])def delta_newton(x, y):alpha = 1.0delta = alpha * H(x, y).I * grad(x, y)return delta# ----- 绘制等⾼线 -----# 数据数⽬n = 256# 定义x, yx = np.linspace(-1, 1.1, n)y = np.linspace(-1, 1.1, n)# ⽣成⽹格数据X, Y = np.meshgrid(x, y)plt.figure()# 填充等⾼线的颜⾊, 8是等⾼线分为⼏部分plt.contourf(X, Y, f(X, Y), 5, alpha=0, cmap=plt.cm.hot)# 绘制等⾼线C = plt.contour(X, Y, f(X, Y), 8, locator=ticker.LogLocator(), colors='black', linewidth=0.01) # 绘制等⾼线数据plt.clabel(C, inline=True, fontsize=10)# ---------------------x = np.matrix([[-0.3],[0.4]])tol = 0.00001xv = [x[0, 0]]yv = [x[1, 0]]plt.plot(x[0, 0], x[1, 0], marker='o')for t in range(100):delta = delta_newton(x[0, 0], x[1, 0])if abs(delta[0, 0]) < tol and abs(delta[1, 0]) < tol:breakx = x - deltaxv.append(x[0, 0])yv.append(x[1, 0])plt.plot(xv, yv, label='track')# plt.plot(xv, yv, label='track', marker='o')plt.xlabel('x')plt.ylabel('y')plt.title('Newton\'s Method for Rosenbrock Function')plt.legend()plt.show()以上这篇python使⽤梯度下降和⽜顿法寻找Rosenbrock函数最⼩值实例就是⼩编分享给⼤家的全部内容了,希望能给⼤家⼀个参考,也希望⼤家多多⽀持。

机器学习算法系列最速下降法牛顿法拟牛顿法

机器学习算法系列最速下降法牛顿法拟牛顿法最速下降法(Gradient Descent)最速下降法是一种常用的优化算法,用于求解无约束的最小化问题。

其原理是通过不断迭代更新参数的方式来逼近最优解。

在最速下降法中,每次迭代的方向是当前位置的负梯度方向,即沿着目标函数下降最快的方向前进。

具体地,对于目标函数f(x),在当前位置x_k处的梯度为g_k=▽f(x_k),则下一次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-α*g_k其中,α 是一个称为学习率(learning rate)的参数,用于控制每次迭代的步长。

最速下降法的优点是简单易实现,收敛速度较快。

然而,它也有一些缺点。

首先,最速下降法的收敛速度依赖于学习率的选择,过小的学习率会导致收敛速度过慢,而过大的学习率可能会导致跳过最优解。

其次,最速下降法通常会在目标函数呈现弯曲或者高度相关的情况下表现不佳,很难快速收敛到最优解。

牛顿法(Newton's Method)牛顿法是一种通过二阶导数信息来优化的算法,可以更快地收敛到目标函数的最优解。

在牛顿法中,每次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-(H_k)^{-1}*▽f(x_k)其中,H_k是目标函数f(x)在当前位置x_k处的黑塞矩阵。

黑塞矩阵描述了目标函数的二阶导数信息,可以帮助更准确地估计参数的更新方向。

牛顿法的优点是收敛速度较快,特别是对于目标函数呈现弯曲或者高度相关的情况下,相较于最速下降法可以更快地达到最优解。

然而,牛顿法也有一些缺点。

首先,计算黑塞矩阵的代价较高,尤其是当参数较多时。

其次,黑塞矩阵可能不可逆或者计算代价较大,这时可以通过使用拟牛顿法来避免。

拟牛顿法(Quasi-Newton Method)拟牛顿法是一类基于牛顿法的优化算法,通过估计黑塞矩阵的逆来逼近最优解,从而避免了计算黑塞矩阵的代价较高的问题。

在拟牛顿法中,每次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-B_k*▽f(x_k)其中,B_k是一个对黑塞矩阵逆的估计。

牛顿方法及最速下降法的简化

牛顿方法及最速下降法的简化

最速下降法是梯度下降法和一维搜索的结合

梯度下降法采用一阶泰勒展开式对函数近似,然后将变量沿着负

梯度方向(下降最快的方向)移动一定的步长,目标函数就会一直

减小,直至接近极小值

f(x)≈f(x0)+∇f(x)(x−x0)d(k)=−∇f(x)x(k)+1=x(k)+λ

d(k)(1)(2)(3)

步长的确定。

让变量在负梯度方向走一段能让函数值最小的距离。

可通过求解下式得到(一般通过令其对λ求导为0直接求解或通

过一维搜索算法如试探法、函数逼近法迭代求解)。

λk=argminλ≥0f(x(k)+λd(k))

一阶收敛条件。

梯度的范数满足趋近于0的精度要求

对于二次函数(正定二次型),牛顿法具有一步收敛性

假设目标函数为二次型 f(x)=12xTQx−xTb

梯度为:∇f(x(0))=Qx(0)−b;海森矩阵为:∇2f(x(0))=Q

经过牛顿法一次迭代后,近似极值点为:x(1)=bQ

重新计算梯度:∇f(x(1))=Qx(1)−b=0 ,算法终止。

最速下降法和牛顿法

最速下降法和牛顿法【引言】在数学和计算机领域中,最速下降法和牛顿法都是经典的优化算法。

它们在不同的问题中有着不同的应用,但它们都是以误差最小化为目标,寻找最优解的算法。

本文将对这两个算法进行详细介绍,以帮助读者更好地理解它们的应用和优缺点。

【正文一:最速下降法】最速下降法,又称为梯度下降法,是一种基于梯度的优化算法。

在寻找某个函数的最小值时,最速下降法的思路是从任何一个点出发,按照函数梯度的反方向移动,直到到达最小值处为止。

因此,最速下降法的关键就是确定每一步移动的方向和步长。

最速下降法的优点是简单易懂,可以用于解决大多数的优化问题。

在逃避局部最优解的情况下,其效果非常好。

然而,最速下降法也有缺点。

由于只是按照梯度的反方向移动,可能会产生震荡现象,从而导致计算速度缓慢等问题。

【正文二:牛顿法】与最速下降法不同,牛顿法是一种利用二阶导数信息,在每个迭代步骤中更新预测的最优解的优化算法。

它可以更快地收敛于函数的极小值点。

在求解非线性方程组、多项式拟合和机器学习等问题时,牛顿法是一种有效的优化算法。

与最速下降法相比,牛顿法的优点是其快速收敛和高效性。

但是,缺点是它需要耗费更多的时间和计算能力来求解每一步迭代。

在某些情况下,由于Hessian矩阵可能不可逆或昂贵,因此此算法的实现可能具有挑战性。

【正文三:最速下降法 VS 牛顿法】最速下降法和牛顿法各有优缺点,它们在不同的问题中应用广泛。

在求解凸优化问题时,最速下降法的效果比较好,在处理大量数据时,牛顿法更加高效。

在实际应用中,可以根据具体问题的不同,选择合适的优化算法。

【结尾】综上所述,最速下降法和牛顿法是经典的优化算法,它们在各自的领域都有着广泛的应用。

两种算法都有其优点和缺点,要选择哪一种算法取决于具体问题和可行性的考虑。

本文的介绍,希望能够帮助读者更好地理解这两种算法,并在实际问题中正确应用它们。

0618法,最速下降法,牛顿法解方程最优解python

0618法,最速下降法,牛顿法解方程最优解python 以下是用Python实现上述三种方法解方程的示例代码: ```pythondef 0618(f, x0, n, A, b, m):"""使用0618法求解二阶线性方程的最优解:param f: 系数矩阵:param x0: 初始解向量:param n: 迭代次数:param A: 系数矩阵:param b: 方程的右侧向量:param m: 步长:return: 最优解向量"""# 初始化解向量x = A.eval(0)i = 0j = 0k = 0m0 = xwhile j < m:# 计算右侧矩阵A(i,j)Aij = A[i][j]if Aij == b:m0 = xbreakj += m# 计算迭代后解向量的变化newx = A[i][j] - A[i][k]if newx < 0:i += 1k += 1# 计算更新后的解向量if i == n and k == n:breakx = x - newxreturn xdef mosdef(f, x0, n, A, b):"""使用Mosdef算法求解二阶线性方程的最优解 :param f: 系数矩阵:param x0: 初始解向量:param n: 迭代次数:param A: 系数矩阵:param b: 方程的右侧向量 :return: 最优解向量"""x = A.eval(0)i = 0j = 0while j < n:# 计算f(x,i,j)F = f(x, i, j)if F == 0:break# 计算矩阵的行列式det = F.dot(A)if det < 0:i += 1j += melse:k = jm0 = xwhile k < m0 and k != i: m0 = x - A[i][k]k += mx = x - detreturn xdef 牛顿法(f, x0, n, A, b):"""使用牛顿法求解二阶线性方程的最优解:param f: 系数矩阵:param x0: 初始解向量:param n: 迭代次数:param A: 系数矩阵:param b: 方程的右侧向量:return: 最优解向量"""x = A.eval(0)i = 0j = 0while j < n:# 计算f(x,i,j)F = f(x, i, j)if F > 0:# 计算前一个方程的解向量和下一个方程的解向量的差 dx = F - bx = x0 + dx * (i - 1)else:# 计算前一个方程的解向量和下一个方程的解向量的和 dy = x - bx = x0 + dy * (j - 1)i += 1j += mreturn x```。

用Python实现最速下降法求极值的方法

⽤Python实现最速下降法求极值的⽅法对于⼀个多元函数,⽤最速下降法(⼜称梯度下降法)求其极⼩值的迭代格式为其中为负梯度⽅向,即最速下降⽅向,αkαk为搜索步长。

⼀般情况下,最优步长αkαk的确定要⽤到线性搜索技术,⽐如精确线性搜索,但是更常⽤的是不精确线性搜索,主要是Goldstein不精确线性搜索和Wolfe法线性搜索。

为了调⽤的⽅便,编写⼀个Python⽂件,⾥⾯存放线性搜索的⼦函数,命名为linesearch.py,这⾥先只编写了Goldstein线性搜索的函数,关于Goldstein原则,可以参看最优化课本。

线性搜索的代码如下(使⽤版本为Python3.3):'''线性搜索⼦函数'''import numpy as npimport randomdef goldsteinsearch(f,df,d,x,alpham,rho,t):flag=0a=0b=alphamfk=f(x)gk=df(x)phi0=fkdphi0=np.dot(gk,d)alpha=b*random.uniform(0,1)while(flag==0):newfk=f(x+alpha*d)phi=newfkif(phi-phi0<=rho*alpha*dphi0):if(phi-phi0>=(1-rho)*alpha*dphi0):flag=1else:a=alphab=bif(b<alpham):alpha=(a+b)/2else:alpha=t*alphaelse:a=ab=alphaalpha=(a+b)/2return alpha上述函数的输⼊参数主要包括⼀个多元函数f,其导数df,当前迭代点x和当前搜索⽅向d,返回值是根据Goldstein准则确定的搜索步长。

我们仍以Rosenbrock函数为例,即有于是可得函数的梯度为最速下降法的代码如下:"""最速下降法Rosenbrock函数函数 f(x)=100*(x(2)-x(1).^2).^2+(1-x(1)).^2梯度 g(x)=(-400*(x(2)-x(1)^2)*x(1)-2*(1-x(1)),200*(x(2)-x(1)^2))^(T)"""import numpy as npimport matplotlib.pyplot as pltimport randomimport linesearchfrom linesearch import goldsteinsearchdef rosenbrock(x):return 100*(x[1]-x[0]**2)**2+(1-x[0])**2def jacobian(x):return np.array([-400*x[0]*(x[1]-x[0]**2)-2*(1-x[0]),200*(x[1]-x[0]**2)])X1=np.arange(-1.5,1.5+0.05,0.05)X2=np.arange(-3.5,2+0.05,0.05)[x1,x2]=np.meshgrid(X1,X2)f=100*(x2-x1**2)**2+(1-x1)**2; # 给定的函数plt.contour(x1,x2,f,20) # 画出函数的20条轮廓线def steepest(x0):print('初始点为:')print(x0,'\n')imax = 20000W=np.zeros((2,imax))W[:,0] = x0i = 1x = x0grad = jacobian(x)delta = sum(grad**2) # 初始误差while i<imax and delta>10**(-5):p = -jacobian(x)x0=xalpha = goldsteinsearch(rosenbrock,jacobian,p,x,1,0.1,2)x = x + alpha*pW[:,i] = xgrad = jacobian(x)delta = sum(grad**2)i=i+1print("迭代次数为:",i)print("近似最优解为:")print(x,'\n')W=W[:,0:i] # 记录迭代点return Wx0 = np.array([-1.2,1])W=steepest(x0)plt.plot(W[0,:],W[1,:],'g*',W[0,:],W[1,:]) # 画出迭代点收敛的轨迹plt.show()为了实现不同⽂件中函数的调⽤,我们先⽤import函数导⼊了线性搜索的⼦函数,也就是下⾯的2⾏代码import linesearchfrom linesearch import goldsteinsearch当然,如果把定义goldsteinsearch函数的代码直接放到程序⾥⾯,就不需要这么⿇烦了,但是那样的话,不仅会使程序显得很长,⽽且不便于goldsteinsearch函数的重⽤。

007最速下降和牛顿法PPT文档37页

其中 A 是m*n的矩阵

function fval=opt_2(A) %直接调用约束优化函数fmincon [m n]=size(A);

[U,S,V] = svd(A); S11 = S(1,1); x=FMINCON((x) myfun_2(x,A,S11),ones(n+m),[],[],[],[],zeros(n+m),[]); fval = myfun_2(x,A,S11); fval = sqrt(fval);

[m n]=size(A); [U,S,V] = svd(A); S11 = S(1,1); x=fminunc((x) myfun_3(x,A,S11),ones(n+m)); fval = myfun_3(x,A,S11); fval = sqrt(fval);

function F = myfun_3(x,A,S11) [m n]=size(A); F=0; for i=1:m for j=1:n F = F+(A(i,j)-x(i)^2*S11*x(m+j)^2)^2; end end

m=10 n=20 残差 13.42 CPU 15.267s

function fval=opt_1(A) % 通过奇异值分解+投影

[U,S,V] = svd(A); u1=U(:,1); v1=V(:,1);

m=10 n=20 残差 13.60 CPU 0.001s

% 作奇异值分解, A = U*S*V' %取U第一列(对应最大奇异值) %取V第一列(对应最大奇异值)

针对二次函数

如何推广?

证明核心

Kantorovich不等式(Proof)

(x’x)2

4λn λ1 ≥

机器学习算法系列(25):最速下降法、牛顿法、拟牛顿法

作为指导。

3.2 DFP算法

DFP算法是以William C.Davidon、Roger Fletcher、Michael J.D.Powell三个人人的名字的首首字⺟母命 名的,它由Davidon于1959年年首首先提出,是最早的拟牛牛顿法。该算法的核心心是:通过迭代的方方

,求λ k,使 f(x ( k ) + λ kp k) = minλ ≥ 0 f(x ( k ) + λp k) 4. 置x ( k + 1 ) = x ( k ) + λ kp k,计算f(x ( k + 1 ) )当 | | f(x ( k + 1 ) ) − f(x ( k ) ) | | < ξ或 | | x ( k = 1 ) − x ( k ) | | < ξ,停止止迭代,令x ∗ = x ( k + 1 ) 5. 否则,置k = k + 1,转到步骤3。 当目目标函数是凸函数时,梯度下降法的解释全局最优解。一一般情况下,其解不不保证是全局最优 解。梯度下降法的收敛速度也未必是很快的。

3.1 拟牛牛顿条件

设经过k + 1次迭代后得到X k + 1,此时将目目标函数f(X)在X k + 1附近作泰勒勒展开,取二二阶近似,得到 1 f( X) ≈ f( X k + 1 ) + ∇ f( X k + 1 ) · ( X − X k + 1 ) + · ( X − X k + 1 ) T · ∇ 2 f( X k + 1 ) · ( X − X k + 1 ) 2 在两边同时作用用一一个梯度算子子 ∇ ,可得 ∇ f( X) ≈ ∇ f ( X k + 1 ) + H k + 1 · ( X − X k + 1 ) 取X = X k并整理理,可得 g k + 1 − g k ≈ H k + 1 · (X k + 1 − X k ) 若引入入记号s k = X k + 1 , y k = g k + 1 − g k则可以改写成

python牛顿法求函数最小值

python牛顿法求函数最小值牛顿法是一种求解方程根或最小值的方法,也被称为牛顿-拉弗森方法。

它使用函数的一阶和二阶导数来逼近函数的局部极小值点或者多项式的解。

在本文中,我们将探讨如何用Python实现牛顿法来求解函数的最小值。

先推荐一本学习Python的书籍:《Python编程快速上手-让繁琐工作自动化》牛顿法原理对于求解单个变量函数最小值的情况,牛顿法的原理可以简述如下:假设f(x)是要求解的函数,x0是初始值,假设我们已知f(x)的一阶和二阶导数,那么可以通过以下公式来随着迭代次数n的增加不断逼近x的最小值点:x(n+1) = x(n) - (f'(x(n)) / f''(x(n)))换句话说,我们可以得到一个关于x的方程,如下所示:f'(x) = 0通过不断迭代求解,x的值会趋近于f(x)的最小值点。

请注意,此方法的收敛性和初始值有很大关系,因此需要谨慎选择初始值,以免导致更新计算结果发散。

使用牛顿法求解函数最小值下面我们使用Python编写一个牛顿法收敛于目标函数最小值的例子。

此处我们将使用SciPy库中的optimize.newton函数,该函数使用Newton-Raphson方法求解单变量非线性方程的根(或最小值)。

首先,让我们定义函数f(x)。

在这个例子中我们将使用以下函数:f(x) = x^3 - 2x^2 + 2我们可以在Python中实现如下:def f(x):return x**3 - 2*x**2 + 2接下来,我们需要找到f(x)的一阶和二阶导数,这可以通过SymPy库来实现。

SymPy不仅可以求函数的导数,还可以将导数计算式子从字符串表示转换为Python表达式。

import sympy#定义符号xx = sympy.symbols('x')#定义函数f(x)fx = x**3 - 2*x**2 + 2#求f(x)的一阶和二阶导数f_prime = sympy.diff(fx, x, 1)f_second = sympy.diff(fx, x, 2)#打印函数对应的一阶和二阶导数print(f'f(x)的一阶导数为:{f_prime}')print(f'f(x)的二阶导数为:{f_second}')上面的输出应该显示:f(x)的一阶导数为:3*x**2 - 4*xf(x)的二阶导数为:6*x - 4现在我们已经有所有必要的信息,可以使用SciPy.optimize库的optimize.newton函数求解函数最小值了。

最优化算法最速下降法、牛顿法、拟牛顿法Python实现

最优化算法最速下降法、⽜顿法、拟⽜顿法Python实现---------------------------------------2020.9.23更新---------------------------------把 BFGS(x)改写了⼀下,变简洁了def BFGS(x): #拟⽜顿法epsilon, h, maxiter = 10**-5, 10**-5, 10**4Bk = np.eye(x.size)for iter1 in range(maxiter):grad = num_grad(x, h)if np.linalg.norm(grad) < epsilon:return xdk = -np.dot((np.linalg.inv(Bk)), grad)ak = linesearch(x, dk)x = x + dk*akyk = num_grad(x, h) -gradsk = ak*dkif np.dot(yk, sk) > 0:Bs = np.dot(Bk,sk)ys = np.dot(yk,sk)sBs = np.dot(np.dot(sk,Bk),sk)Bk = Bk - 1.0*Bs.reshape((n,1))*Bs/sBs + 1.0*yk.reshape((n,1))*yk/ysreturn x---------------------------------------2020.9.23更新---------------------------------只⽤到了numpy这⼀个库,只要安装有这个库应该都可以直接运⾏import numpy as npdef f(x): #⽬标函数x1 = x[0]x2 = x[1]y = 100*((x2 - x1**2)**2) + (x1-1)**2return ydef num_grad(x, h): #求梯度df = np.zeros(x.size)for i in range(x.size):x1, x2 = x.copy(), x.copy() #这⾥需要⽤到复制,⽽不能⽤赋值号(=),原因是Python⾥⾯=号只是取别名,不是复制(c/c++⾥⾯是)x1[i] = x[i] - hx2[i] = x[i] + hy1, y2 = f(x1), f(x2)df[i] = (y2-y1)/(2*h)return dfdef num_hess(x, h): #求hess矩阵hess = np.zeros((x.size, x.size))for i in range(x.size):x1 = x.copy()x1[i] = x[i] - hdf1 = num_grad(x1, h)x2 = x.copy()x2[i] = x[i] + hdf2 = num_grad(x2, h)d2f = (df2 - df1) / (2 * h)hess[i] = d2freturn hessdef linesearch(x, dk): #求步长ak = 1for i in range(20):newf, oldf = f(x + ak * dk), f(x)if newf < oldf:return akelse:ak = ak / 4 #迭代更新步长,步长可随意变换,保证newf⽐oldf⼩就可以了(如改为: ak=ak/2 也是可以的)return akdef steepest(x): #最速下降法epsilon, h, maxiter = 10**-5, 10**-5, 10**4for iter1 in range(maxiter):grad = num_grad(x, h)if np.linalg.norm(grad) < epsilon:return xdk = -gradak = linesearch(x, dk)x = x + ak * dkreturn xdef newTonFuction(x): #⽜顿法epsilon, h1, h2, maxiter = 10**-5, 10**-5, 10**-5, 10**4for iter1 in range(maxiter):grad = num_grad(x, h1)if np.linalg.norm(grad) < epsilon:return xhess = num_hess(x, h2)dk = -np.dot((np.linalg.inv(hess)), grad)x = x + dkreturn xdef BFGS(x): #拟⽜顿法epsilon, h, maxiter = 10**-5, 10**-5, 10**4Bk = np.eye(x.size)for iter1 in range(maxiter):grad = num_grad(x, h)if np.linalg.norm(grad) < epsilon:return xdk = -np.dot((np.linalg.inv(Bk)), grad)ak = linesearch(x, dk)x = x + dk*akyk = num_grad(x, h) -gradsk = ak*dkif np.dot(yk.reshape(1, grad.shape[0]), sk) > 0:'''第⼀种分步计算实现t0 = np.dot(Bk, sk)t1 = np.dot(t0.reshape(sk.shape[0], 1), sk.reshape(1, sk.shape[0]))temp0 = np.dot(t1, Bk)temp1 = np.dot(np.dot(sk.reshape(1, sk.shape[0]), Bk), sk)tmp0 = np.dot(yk.reshape(yk.shape[0], 1), yk.reshape(1, yk.shape[0]))tmp1 = np.dot(yk.reshape(1, yk.shape[0]), sk)Bk = Bk - temp0 / temp1 + tmp0 / tmp1'''#第⼆种直接写公式实现Bk = Bk - np.dot(np.dot(np.dot(Bk, sk).reshape(sk.shape[0], 1), sk.reshape(1, sk.shape[0])), Bk)/np.dot(np.dot(sk.reshape(1, sk.shape[0]), Bk), sk) + np.dot(yk.reshape(yk.shape[0], 1), yk.reshape(1, yk.shape[0])) / np.dot(yk.reshape(1, yreturn x#x0 = np.array([0.999960983973235, 0.999921911551354]) #初始解x0 = np.array([0.7, 0.9]) #初始解x = steepest(x0) #调⽤最速下降法print("最速下降法最后的解向量:",x)print("最速下降法最后的解:",f(x))print('')x = newTonFuction(x0) #调⽤⽜顿法print("⽜顿法最后的解向量:", x)print("⽜顿法最后的解:", f(x))print('')x = BFGS(x0) #调⽤拟⽜顿法print("拟⽜顿法最后的解向量:", x)print("拟⽜顿法最后的解:", f(x))print('')结果如下拟⽜顿法感觉弄⿇烦了,暂时也没想法改,先就这样吧。

最速下降法 C语言

1.最速下降法#include "stdio.h"#include "math.h"double fun1(double x1,double x2) /*定义函数fun1为目标函数*/ {double y;y=x1*x1-2*x1*x2+4*x2*x2+x1-3*x2;return y;}void main(){ double t, x1=1, x2=1,e=0.01, g[2], y, m;int k=1; /*定义起始点为x1=0,x2=1,并定义精度为e=0.01*/g[0]=2*x1-2*x2+1; /*目标函数对x1求偏导*/g[1]=(-2)*x1+8*x2-3; /*目标函数对x2求偏导*/ m=(sqrt(g[0]*g[0]+g[1]*g[1])); /*对g[0]*g[0]+g[1]*g[1]求开方,将值赋给m*/while(m>e&&k<=200) /*判断,当m>e时进行以下循环*/ { t=((2*g[1]-2*g[0])*x1+(2*g[0]-8*g[1])*x2-g[0]+3*g[1])/(4*g[0]*g[1]-2*g[0]*g[0 ]-8*g[1]*g[1]); /*根据梯度法(最速下降法),利用梯度和海赛矩阵*/x1=x1-g[0]*t; /*求步长t。

根据步长和梯度方向求出新的x1,x2*/x2=x2-g[1]*t;printf("迭代次数%d\n",k);printf("搜索方向-%f,-%f,负梯度的模%f,步长%f\n",g[0],g[1],m,t);printf("x的值%f,%f\n",x1,x2);g[0]=2*x1-2*x2+1;g[1]=(-2)*x1+8*x2-3;m=(sqrt(g[0]*g[0]+g[1]*g[1])); /*计算新的m*/printf("新的负梯度的模%f\n",m);k++;}y=fun1(x1,x2); /*当m不满足m>e的时候退出循环,并计算fun1,*/printf("分别输出x1,x2 %f,%f\n",x1,x2); /*将值赋给y,并输出。

工程优化目标函数的几种极值求解方法c++编程

目标函数极值求解的几种方法题目:分别用最速下降法,牛顿法,共轭梯度法,拟牛顿法求函数24232221)5(5)1()5(5)1(-+-+-+-=x x x x f 的最小值,初始点自拟。

一维搜索法:迭代下降算法大都具有一个共同点,这就是得到点()k x 后需要按某种规则确定一个方向()k d ,再从()k x 出发,沿方向()k d 在直线(或射线)上求目标函数的极小点,从而得到()k x 的后继点()1+k x ,重复以上做法,直至求得问题的解,这里所谓求目标函数在直线上的极小点,称为一维搜索。

一维搜索的方法很多,归纳起来大体可以分为两类,一类是试探法:采用这类方法,需要按某种方式找试探点,通过一系列的试探点来确定极小点。

另一类是函数逼近法或插值法:这类方法是用某种较简单的曲线逼近本来的函数曲线,通过求逼近函数的极小点来估计目标函数的极小点。

这里采用的是第一类试探法中的黄金分割法。

实现过程如下:⑴ 置初始区间[11,b a ]及精度要求L>0,计算试探点1λ和1μ,计算函数值()1λf 和()1μf ,计算公式是:()1111382.0a b a -+=λ,()1111618.0a b a -+=μ。

令k=1。

⑵ 若La b k k <-则停止计算。

否则,当()K f λ>()k f μ时,转步骤⑶;当()K f λ≤()k f μ时,转步骤⑷ 。

⑶ 置kk a λ=+1,kk b b =+1,kk μλ=+1,()1111618.0++++-+=k k k k a b a μ,计算函数值()1+k f μ,转⑸。

⑷ 置kk a a =+1,kk b μ=+1,kk μμ=+1,()1111382.0++++-+=k k k k a b a λ,计算函数值()1+k f λ,转⑸。

最速下降法实现原理描述:在求目标函数极小值问题时,总希望从一点出发,选择一个目标函数值下降最快的方向,以利于尽快达到极小点,正是基于这样一种愿望提出的最速下降法,并且经过一系列理论推导研究可知,负梯度方向为最速下降方向。