pca和KPCA的详细介绍与分析

数据分析知识:如何进行数据分析的核主成分分析

数据分析知识:如何进行数据分析的核主成分分析数据分析知识:如何进行数据分析的核主成分分析在进行数据分析的过程中,一项重要的任务就是降维,即从大量数据中提取出主要的特征。

核主成分分析(Kernel PCA)是一种有效的降维方法,通过它可以将高维的数据转化为低维的数据,并在不失去重要信息的前提下,更好地表达数据。

1. PCA与Kernel PCA的区别在介绍Kernel PCA之前,我们先来了解一下主成分分析(PCA)。

PCA是一种常用的降维方法,它通过对原始数据进行线性变换,将其转化为一组新的维度,使得在新的维度下,数据的方差尽可能地大。

在新的维度下,数据形成一个坐标系,每个坐标轴被称为主成分。

与PCA不同的是,Kernel PCA(以下简称KPCA)是一种非线性的方法。

KPCA可以将高维数据通过核函数映射到特征空间,并在特征空间中进行PCA,从而实现对数据的降维。

2. KPCA的基本原理KPCA的基本原理是通过非线性映射将原始数据映射到一个高维的特征空间(称为核空间),然后在该空间中进行PCA,得到新的成分,最后再将其映射回原始的数据空间。

与PCA相比,KPCA提供了更高的灵活性和表达能力。

具体地,设有一个n个数据点的样本集{xi},x是一个d维的向量,即x∈R^d。

首先在原始的数据空间中定义一个核函数,用于将原始数据点映射到一个新的特征空间。

核函数的作用在于,通过量化数据点之间的相似性,并将相似的点映射到特征空间中的相邻位置。

核函数可以选择多项式核函数、高斯核函数或sigmoid核函数等。

这里以高斯核函数为例:K(x,xi)=exp(−|| x−xi ||^2 / 2σ^2)其中,x和xi是原始数据点,K(x,xi)是将x和xi映射到特征空间的函数值,σ是高斯核函数的带宽参数。

映射后,我们得到的是一个在特征空间内的数据集{Φ(xi) },Φ(xi)是一个M维的向量。

在特征空间中,我们可以得到主成分和贡献率,就像在PCA中一样。

KPCA

4.KPCA在电子鼻系统中应用

传 感 器 阵 列 信 号 SVM 多 类 分 类 模 型

特 征 提 取

输出 分类结果

比较KPCA、PCA、ICA、原始特征

4.KPCA在电子鼻系统中应用

数据集 Number of samples in the subset HCHO C6H6 C7H8 Training set 156 Testing set 52 99 33 40 13 CO NH3 NO2 35 12 29 10 18 6

=Σ , X p )T ,记 E ( X ) u ,Cov(X )

Y1 a11 X1 a12 X 2 a1p X p a1T X T Y a X a X a X a 2 21 2 22 2 2p p 2 X Y a X a X a X a T X pp p p p p1 1 p2 2

(4)令Var (Y1 )= ,则 a1

a a Σa1 Σa1 a1

X 的协方差矩阵的特征值,a1 向量。则当 最大时,也即 Y1的方差达到最大,因此 对应的特征向量 a1就是第一主轴方向,称 Y1 a1T X 为第一主成分。

2.PCA原理分析

5.小结

PCA:

●

线性映射方法,忽略了数据之间高于2阶的相互关系

●

●

基于特征的维度

新特征是原有特征的线性叠加,物理意义明确

KPCA:

● ● ● ●

PCA的非线性扩展算法,采用非线性的方法抽取主成分 基于样本的维度(特征的数目为输入样本的维数) 新特征物理意义不明确 适合于解决非线性特征提取问题

5.小结

小结: 求解主成分的过程就是对原始矩阵的协方差矩阵进行特征 值分解,并将特征值从大到小进行排序,则前面的k个特征值 对应的特征向量就是最佳的k维投影方向。

PCA,K-PCA,ICA你真的知道吗?

PCA,K-PCA,ICA你真的知道吗?今天我们给大家介绍下PCA,K-PCA以及ICA之间有什么关系,同时在R语言如何实现这几个模型。

主成分分析(PCA),是一种常用的数据分析方法。

PCA通过线性变换将原始数据变换为一组各维度线性无关的表示,可用于取主成分(主要信息),摒弃冗余信息(次要信息),常用于高维数据的降维。

本质是将方差最大的方向作为主要特征,并且在各个正交方向上将数据“离相关”,也就是让它们在不同正交方向上没有相关性。

主要应用于高斯分布的线性数据的降维。

核主成分分析(K-PCA),是PCA的升级版主要是解决线性数据的限制,它可以将非线性可分的数据转换到一个适合对齐进行线性分类的新的低维子空间上。

其本质同PCA。

独立成分分析(ICA),指在只知道混合信号,而不知道源信号、噪声以及混合机制的情况下,分离或近似地分离出源信号的一种分析过程;是盲信号分析领域的一个强有力方法,也是求非高斯分布数据隐含因子的方法ICA与PCA区别:1)PCA是将原始数据降维并提取出不相关的属性,而ICA是将原始数据降维并提取出相互独立的属性。

2)PCA目的是找到这样一组分量表示,使得重构误差最小,即最能代表原事物的特征。

ICA的目的是找到这样一组分量表示,使得每个分量最大化独立,能够发现一些隐藏因素。

由此可见,ICA的条件比PCA更强些。

3)ICA要求找到最大独立的方向,各个成分是独立的;PCA要求找到最大方差的方向,各个成分是正交的。

4)ICA认为观测信号是若干个统计独立的分量的线性组合,ICA 要做的是一个解混过程。

而PCA是一个信息提取的过程,将原始数据降维,现已成为ICA将数据标准化的预处理步骤。

接下来我们介绍下这几种算法在R语言如何实现:1. PCA的实现需要安装包graphics,其中的核心函数是prcomp。

具体的操作步骤大家可以参考我们前期的教程《R语言之主成分分析》。

2. KPCA的实现需要安装包BKPC,其中的kPCA函数可以实现核主成分分析。

kpca算法的python实现

kpca算法的python实现kpca算法是一种非线性降维算法,它是基于核技巧的主成分分析方法。

本文将介绍kpca算法的原理和python实现。

我们来了解一下主成分分析(PCA)算法。

PCA是一种常用的线性降维算法,它通过寻找数据中的主要方向来减少数据的维度。

然而,PCA只适用于线性可分的数据,对于非线性数据效果不佳。

而kpca 算法则是通过引入核函数,将数据映射到高维空间中,从而使得原本线性不可分的数据在新的高维空间中线性可分。

具体来说,kpca算法的实现步骤如下:1. 计算核矩阵:首先,根据给定的核函数,计算原始数据的核矩阵。

核矩阵是一个对称的矩阵,它的元素是通过核函数计算得到的两个样本之间的相似度。

2. 中心化核矩阵:对核矩阵进行中心化操作,即将每一行和每一列的元素减去各自的均值,从而消除数据的平移影响。

3. 计算核矩阵的特征值和特征向量:通过对中心化的核矩阵进行特征值分解,得到核矩阵的特征值和对应的特征向量。

4. 选择主成分:根据特征值的大小,选择前k个最大的特征值和对应的特征向量作为主成分。

5. 降维:将原始数据投影到所选的主成分上,得到降维后的数据。

接下来,我们使用python实现kpca算法。

首先,我们需要导入所需的库:```pythonimport numpy as npfrom sklearn.decomposition import PCAfrom sklearn.preprocessing import StandardScaler```然后,我们定义一个kpca类,其中包含fit和transform两个方法:```pythonclass KPCA:def __init__(self, n_components=2, kernel='linear'):self.n_components = n_componentsself.kernel = kerneldef fit(self, X):# 计算核矩阵kernel_matrix = self._calculate_kernel_matrix(X)# 中心化核矩阵centered_kernel_matrix = self._center_kernel_matrix(kernel_matrix)# 计算核矩阵的特征值和特征向量eigenvalues, eigenvectors = self._calculate_eigen(centered_kernel_matrix)# 选择主成分ponents_ = eigenvectors[:, :self.n_components]return selfdef transform(self, X):# 计算核矩阵kernel_matrix = self._calculate_kernel_matrix(X)# 中心化核矩阵centered_kernel_matrix = self._center_kernel_matrix(kernel_matrix)# 将数据投影到主成分上return np.dot(centered_kernel_matrix, ponents_)def _calculate_kernel_matrix(self, X):# 计算核矩阵if self.kernel == 'linear':kernel_matrix = np.dot(X, X.T)elif self.kernel == 'rbf':sigma = 1.0pairwise_sq_dists = np.sum((X[:, np.newaxis] - X[np.newaxis, :]) ** 2, axis=-1)kernel_matrix = np.exp(-pairwise_sq_dists / (2 * sigma ** 2))else:raise ValueError("Invalid kernel.")return kernel_matrixdef _center_kernel_matrix(self, kernel_matrix):# 中心化核矩阵n_samples = kernel_matrix.shape[0]one_n = np.ones((n_samples, n_samples)) / n_samples centered_kernel_matrix = kernel_matrix - one_n.dot(kernel_matrix) - kernel_matrix.dot(one_n) + one_n.dot(kernel_matrix).dot(one_n)return centered_kernel_matrixdef _calculate_eigen(self, kernel_matrix):# 计算核矩阵的特征值和特征向量eigenvalues, eigenvectors = np.linalg.eigh(kernel_matrix)return eigenvalues[::-1], eigenvectors[:, ::-1]```在以上代码中,我们定义了一个KPCA类,其中包含了_fit_kernel_matrix、_center_kernel_matrix和_calculate_eigen三个私有方法。

pca和KPCA的基本介绍

n � m 常通(

n� m i

T

i x ix

1�i

�

n

n

1

� C

U 列 i 第的它�阵矩交正 n � n 个一是

i

U�中其

x

x

T

U � is

i

量矢据数入输将)2-2(式过通 ACP

换变积内的量向现实是础基的数函核 �

�

为数函射映的间空征特到间空据数�点本样的中间空据数为

j

x

和

i

x

设。换变

性线非的间之间空别类和、间空征特、间空据数了现实法方核�讲上质本从 。力能理处的据数性线非 了强增大大而从 �的杂复较比是往往射映性线非种这且�射映性线非了用采于由 �示所 1-3 图如�作操性线的应对行进间空征特在而进�间空征特到射 映间空据数由据数始原将射映性线非用采先首法方核 �看上程过作操体具从 。 量

R : � 射映对, H

n

�

1� n

�

F

� ) j x , ix ( K

j

d

d

间空 trebliH 个一在存� )

N , , 2 ,1 � i (

L

x , i x ( K 数函的

件条 recreM 足满且续连、称对意任对� )

d

R � ix

为据数间空入输设

假 �射映性线非的间空征特到间空入输由种一了现实是础基的法方核到虑考 。件条要充的数函核为成数函了出给)2-3(式 )2-3(

法方核 .1

析分分成主的核于基 章三第

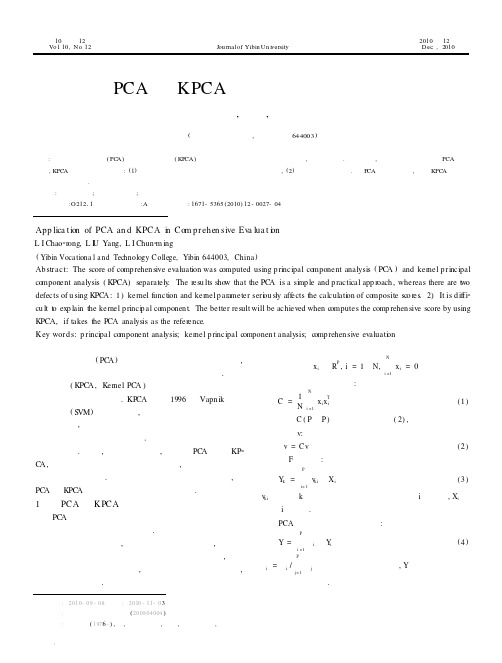

PCA与KPCA在综合评价中的应用

App lica t ion of PCA an d KPC A in C om pr ehen sive Eva lua t ion L I Chao2rong, L IU Yang, L I Chun2m ing ( Yibin Voca tiona l a nd Technology C ollege, Yibin 644003, China ) Ab stract: The score of comp rehen sive evaluation was computed using p rincipal component analysis ( PCA ) and kernel p rincipal component analysis ( KPCA) separately. The resu lts show that the PCA is a simp le and p ractical app roach , whereas there are two defects of u sing KPCA : 1 ) kernel function and kernel p arameter seriou sly affects the calculation of composite sco res. 2) It is d iffi2 cu lt to exp lain the kernel p rincip al componen t. The better result will be achieved when computes the comp rehen sive score by using KPCA, if takes the PCA analysis as the reference. K ey word s: p rincipal component analysis; kernel p rincipal componen t analysis; comp rehen sive evaluation

主成分分析(PCA)简介

主成分分析(PCA)简介1.什么(what)是主成分分析?主成分分析(Principal Component Analysis)又称主分量分析,是一种基于降维思想把多个变量化为少数几个主成分(即综合变量)的统计分析法。

主成分通常表示为原始变量的某种线性组合,能够反映原始变量的绝大部分信息,并具有最大的方差,通过保证主成分之间互不关联,使得这些主成分之间所包含的的信息互不重叠。

2.为什么(why)要用主成分分析?在实证问题研究中,为了全面、系统地分析问题,我们必须考虑众多影响因素。

因为每个变量都在不同程度上反映了所研究问题的某些信息,并且变量之间彼此有一定的相关性,因而所得的统计数据反映的信息在一定程度上有重叠。

在用统计方法研究多变量问题时,变量太多会增加计算量和增加分析问题的复杂性,人们希望在进行定量分析的过程中,涉及的变量较少,得到的信息量较多。

主成分分析正是适应这一要求产生的,是解决这类题的理想工具。

3.怎么(how)进行主成分分析?主成分分析的步骤(1)将观测数据标准化,并计算原始变量平均值以及样本协方差矩阵;(2)由相关系数矩阵得到特征值及各个主成分的方差贡献率、贡献率和累计、贡献率,并根据累计贡献率确定主成分保留的个数;(3)写出 m 个基本方程组(4)将各个样本的观测值代入主成分向量的表达式中计算各个主成分向量。

(5)计算原指标与主成分的相关系数即因子载荷,解释主成分的意义。

4.主成分分析的优缺点优点:①可消除评估指标之间的相关影响。

因为主成分分析法在对原始数据指标变量进行变换后形成了彼此相互独立的主成分,而且实践证明指标间相关程度越高,主成分分析效果越好。

②可减少指标选择的工作量,对于其他评估方法,由于难以消除评估指标间的相关影响,所以选择指标时要花费不少精力,而主成分分析法由于可以消除这种相关影响,所以在指标选择上相对容易些。

③主成分分析中各主成分是按方差大小依次排列顺序的,在分析问题时,可以舍弃一部分主成分,只取前面方差较大的几个主成分来代表原变量,从而减少了计算工作量。

pca分析

pca分析PCA(Principal Component Analysis,主成分分析)是一种常用的统计学方法,用于降低数据维度并提取最相关特征的技术。

在机器学习和数据挖掘领域,PCA被广泛应用于数据预处理、特征选择和可视化等方面。

本文将对PCA的原理和应用进行详细介绍。

PCA的核心思想是将高维数据转换为低维空间,同时最大程度地保留数据的信息。

通过将数据投影到最具信息量的方向,主成分分析能够减少数据之间的冗余和噪声,提取出最重要的特征。

首先,我们需要了解PCA中的一些基本概念。

数据集中的每个数据点可以看作是多维空间中的一个向量。

在进行PCA之前,需要对数据进行标准化处理,使得每个特征具有相同的尺度。

这是因为PCA是基于协方差矩阵的计算,尺度不同的特征会对结果产生不均衡的影响。

PCA的核心步骤包括计算特征的协方差矩阵、计算协方差矩阵的特征值和特征向量、选择主成分和投影数据。

首先,通过计算样本数据的协方差矩阵,可以获得数据特征之间的相关性。

然后,通过对协方差矩阵进行特征值分解,可以得到特征值和对应的特征向量。

特征值表征了数据在特征空间中的重要性,特征向量作为主成分,可以按照特征值的大小进行排序。

最后,选择前k个主成分并将数据投影到这些主成分上,完成数据降维的过程。

PCA的主要应用之一是数据预处理。

在处理大规模高维数据时,往往存在冗余信息和噪声干扰。

通过应用PCA,可以提取出最具信息量的特征,减少冗余信息和噪声对数据分析的影响。

这样可以提高后续的机器学习算法的准确性和效率。

特征选择是PCA的另一个重要应用。

在机器学习中,选择正确的特征对于构建有效的模型非常重要。

通过计算特征的方差或信息增益,可以评估特征的重要性。

PCA可以帮助我们找到最相关的特征,并进行进一步分析。

此外,PCA还可以用于数据可视化。

一般来说,高维数据很难直观地展示。

通过将数据投影到二维或三维空间,我们可以更清晰地观察数据之间的关系。

例如,在聚类分析中,采用PCA可以将数据集投影到指定维数的空间中,从而更容易发现数据中存在的分组结构。

PCA与KPCA简介

第二章 主成分分析1. 主成分分析的基本原理统计学上PCA 的定义为用几个较少的综合指标来代替原来较多的指标,而这些较少的综合指标既能尽多地反映原来较多指标的有用信息,且相互之间又是无关的。

作为一种建立在统计最优原则基础上的分析方法,主成分分析具有较长的发展历史。

在1901年,Pearson 首先将变换引入生物学领域,并重新对线性回归进行了分析,得出了变换的一种新形式。

Hotelling 于1933年则将其与心理测验学领域联系起来,把离散变量转变为无关联系数。

在概率论理论建立的同时,主成分分析又单独出现,由Karhunen 于1947年提出,随后Loeve 于1963年将其归纳总结。

因此,主成分分析也被称为K -L 变换[1]。

PCA 运算就是一种确定一个坐标系统的直交变换,在这个新的坐标系统下,变换数据点的方差沿新的坐标轴得到了最大化。

这些坐标轴经常被称为是主成分。

PCA 运算是一个利用了数据集的统计性质的特征空间变换,这种变换在无损或很少损失了数据集的信息的情况下降低了数据集的维数。

PCA 的基本原理如下:给定输入数据矩阵m n X ⨯ (通常m n >),它由一些中心化的样本数据1{}m i i x =构成,其中n i x R ∈且10m i i x==∑ (2-1)PCA 通过式(2-2)将输入数据矢量i x 变换为新的矢量T i i s U x = (2-2)其中:U 是一个n n ⨯正交矩阵,它的第i 列i U 是样本协方差矩阵11nT i i i C x x n ==∑ (2-3) 的第i 个本征矢量。

换句话说,PCA 首先求解如下的本征问题1,...,i i i u Cu i n λ= = (2-4)其中λ是C 的一个本征值,i u 是相应的本征矢量。

当仅利用前面的P 个本征矢量时(对应本征值按降序排列),得矩阵T S U X = 。

新的分量S 称为主分量[2]。

最大特征值λ对应的最大特征向量u 就是第一个主成分,这个特征向量就是数据有最大方差分布的方向。

PCA-过程能力(CPK)分析

过程能力的应用

▪ 过程能力指数代表了过程能力的高低,过程能力指数越大表明 对应的过程能力越高。一般说来对过程能力的评价标准为:

Cpk的取值范围

级别

过程能力的评价

Cpk≥1.67 1.67> Cpk≥1.33 1.33> Cpk≥1.0 1.0>Cpk≥0.67 0.67>Cpk

Ⅰ

过程能力较高

Ⅱ

过程能力充分

•影响过程质量的6个因素(6M)

—人员 —设备 —材料 —方法 —测量 —环境

• 6M导致的变异有两种

—随机性变异 —系统性变异

• 如果过程仅受随机性因素的影响,那么一般情况 下,过程质量特征值服从正态分布

PCA-过程能力(CPK)分析

过程能力分析的基本概念

99.73%

±3 过程能力=B= ±3= ±3S

PCA-过程能力(CPK)分析

过程能力分析的基本概念

▪ 过程能力是指过程的一致性,显然,过程的变 异是衡量过程质量特征值的一致性的指标

▪ 过程能力指数(CPK):指过程的加工质量满 足技术标准的程度。

▪ 两种变异: • 特定时点的本质或内在变异 • 一段时间内的变异

PCA-过程能力(CPK)分析

过程能力分析的基本概念

PCA-过程能力(CPK)分析

目录

▪ 过程能力分析的目的和步骤 ▪ 如何进行合理抽样 ▪ 过程稳定性分析 ▪ 过程数据正态性分析 ▪ CP/CPK的计算方法和应用方法 ▪ 属性型数据质量统计指标

PCA-过程能力(CPK)分析

过程稳定性分析

过程稳定的意义

一个稳定的过程仅存在随机性变异 通过稳定性可以检验是否存在系统性变异,如果存在 系统性变异,在进行PCA之前应剔除

主元分析(PCA)理论分析及应用

主元分析(PCA)理论分析及应用什么是PCA?PCA是Principal component analysis的缩写,中文翻译为主元分析。

它是一种对数据进行分析的技术,最重要的应用是对原有数据进行简化。

正如它的名字:主元分析,这种方法可以有效的找出数据中最“主要”的元素和结构,去除噪音和冗余,将原有的复杂数据降维,揭示隐藏在复杂数据背后的简单结构。

它的优点是简单,而且无参数限制,可以方便的应用与各个场合。

因此应用极其广泛,从神经科学到计算机图形学都有它的用武之地。

被誉为应用线形代数最价值的结果之一。

在以下的章节中,不仅有对PCA的比较直观的解释,同时也配有较为深入的分析。

首先将从一个简单的例子开始说明PCA应用的场合以及想法的由来,进行一个比较直观的解释;然后加入数学的严格推导,引入线形代数,进行问题的求解。

随后将揭示PCA与SVD(Singular Value Decomposition)之间的联系以及如何将之应用于真实世界。

最后将分析PCA理论模型的假设条件以及针对这些条件可能进行的改进。

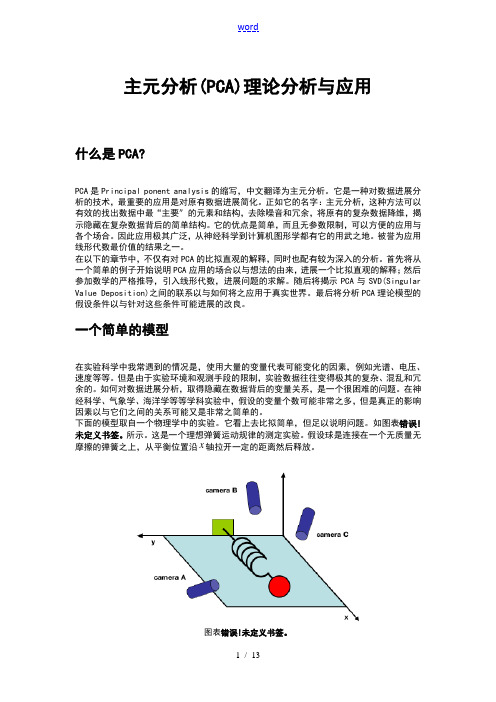

一个简单的模型在实验科学中我常遇到的情况是,使用大量的变量代表可能变化的因素,例如光谱、电压、速度等等。

但是由于实验环境和观测手段的限制,实验数据往往变得极其的复杂、混乱和冗余的。

如何对数据进行分析,取得隐藏在数据背后的变量关系,是一个很困难的问题。

在神经科学、气象学、海洋学等等学科实验中,假设的变量个数可能非常之多,但是真正的影响因素以及它们之间的关系可能又是非常之简单的。

下面的模型取自一个物理学中的实验。

它看上去比较简单,但足以说明问题。

如图表 1所示。

这是一个理想弹簧运动规律的测定实验。

假设球是连接在一个无质量无摩擦的弹簧之上,从平衡位置沿x轴拉开一定的距离然后释放。

图表 1对于一个具有先验知识的实验者来说,这个实验是非常容易的。

球的运动只是在x 轴向上发生,只需要记录下x 轴向上的运动序列并加以分析即可。

pca和kpca计算实例

pca和kpca计算实例PCA(主成分分析)和KPCA(核主成分分析)都是常用的数据分析方法,用于降维、特征提取等。

以下是PCA和KPCA的计算实例:PCA的计算实例:假设我们有一个二维数据集,数据集中的每个样本都有两个特征,分别是身高(cm)和体重(kg)。

我们想要通过PCA将这两个特征降维到一维。

1. 首先,我们将原始数据集中的所有样本按列组成一个2行N列的矩阵X,其中N是样本数量。

2. 然后,我们将矩阵X的每一行(代表一个属性字段)进行零均值化,即减去这一行的均值。

3. 接下来,我们计算协方差矩阵C = 1/N X X^T。

4. 然后,我们求出协方差矩阵C的特征值和特征向量。

5. 将特征向量按对应特征值大小从上到下按行排列成矩阵,取前k行组成矩阵P。

6. 最后,我们用矩阵P乘以原始数据矩阵X,得到降维到k维后的数据。

KPCA的计算实例:假设我们有一个二维数据集,数据集中的每个样本有两个特征,分别是身高(cm)和体重(kg)。

我们想要通过KPCA将这两个特征降维到一维。

1. 首先,我们将原始数据集中的所有样本按列组成一个2行N列的矩阵X,其中N是样本数量。

2. 然后,我们将矩阵X的每一行(代表一个属性字段)进行零均值化,即减去这一行的均值。

3. 接下来,我们计算核函数下的内积矩阵K = 1/N X X^T。

4. 然后,我们求出核函数下的内积矩阵K的特征值和特征向量。

5. 将特征向量按对应特征值大小从上到下按行排列成矩阵,取前k行组成矩阵P。

6. 最后,我们用矩阵P乘以原始数据矩阵X,得到降维到k维后的数据。

需要注意的是,在实际应用中,需要根据具体问题选择合适的核函数和参数。

同时,由于计算复杂度较高,PCA和KPCA都需要使用高效的算法和工具进行计算。

PCA (主成分分析)详解

一、简介PCA(Principal Components Analysis)即主成分分析,是图像处理中经常用到的降维方法,大家知道,我们在处理有关数字图像处理方面的问题时,比如经常用的图像的查询问题,在一个几万或者几百万甚至更大的数据库中查询一幅相近的图像。

这时,我们通常的方法是对图像库中的图片提取响应的特征,如颜色,纹理,sift,surf,vlad等等特征,然后将其保存,建立响应的数据索引,然后对要查询的图像提取相应的特征,与数据库中的图像特征对比,找出与之最近的图片。

这里,如果我们为了提高查询的准确率,通常会提取一些较为复杂的特征,如sift,surf等,一幅图像有很多个这种特征点,每个特征点又有一个相应的描述该特征点的128维的向量,设想如果一幅图像有300个这种特征点,那么该幅图像就有300*vector(128维)个,如果我们数据库中有一百万张图片,这个存储量是相当大的,建立索引也很耗时,如果我们对每个向量进行PCA处理,将其降维为64维,是不是很节约存储空间啊?对于学习图像处理的人来说,都知道PCA是降维的,但是,很多人不知道具体的原理,为此,我写这篇文章,来详细阐述一下PCA及其具体计算过程:二、PCA详解1、原始数据:为了方便,我们假定数据是二维的,借助网络上的一组数据,如下:x=[2.5, 0.5, 2.2, 1.9, 3.1, 2.3, 2, 1, 1.5, 1.1]Ty=[2.4, 0.7, 2.9, 2.2, 3.0, 2.7, 1.6, 1.1, 1.6, 0.9]T2、计算协方差矩阵什么是协方差矩阵?相信看这篇文章的人都学过数理统计,一些基本的常识都知道,但是,也许你很长时间不看了,都忘差不多了,为了方便大家更好的理解,这里先简单的回顾一下数理统计的相关知识,当然如果你知道协方差矩阵的求法你可以跳过这里。

(1)协方差矩阵:首先我们给你一个含有n个样本的集合,依次给出数理统计中的一些相关概念:均值:标准差:方差:既然我们都有这么多描述数据之间关系的统计量,为什么我们还要用协方差呢?我们应该注意到,标准差和方差一般是用来描述一维数据的,但现实生活我们常常遇到含有多维数据的数据集,最简单的大家上学时免不了要统计多个学科的考试成绩。

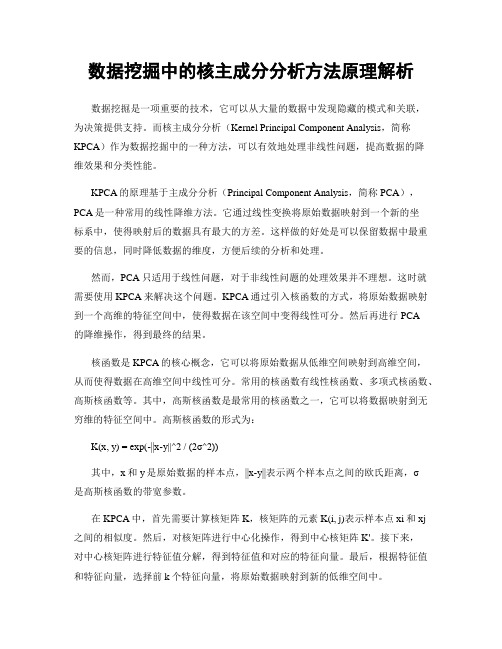

数据挖掘中的核主成分分析方法原理解析

数据挖掘中的核主成分分析方法原理解析数据挖掘是一项重要的技术,它可以从大量的数据中发现隐藏的模式和关联,为决策提供支持。

而核主成分分析(Kernel Principal Component Analysis,简称KPCA)作为数据挖掘中的一种方法,可以有效地处理非线性问题,提高数据的降维效果和分类性能。

KPCA的原理基于主成分分析(Principal Component Analysis,简称PCA),PCA是一种常用的线性降维方法。

它通过线性变换将原始数据映射到一个新的坐标系中,使得映射后的数据具有最大的方差。

这样做的好处是可以保留数据中最重要的信息,同时降低数据的维度,方便后续的分析和处理。

然而,PCA只适用于线性问题,对于非线性问题的处理效果并不理想。

这时就需要使用KPCA来解决这个问题。

KPCA通过引入核函数的方式,将原始数据映射到一个高维的特征空间中,使得数据在该空间中变得线性可分。

然后再进行PCA的降维操作,得到最终的结果。

核函数是KPCA的核心概念,它可以将原始数据从低维空间映射到高维空间,从而使得数据在高维空间中线性可分。

常用的核函数有线性核函数、多项式核函数、高斯核函数等。

其中,高斯核函数是最常用的核函数之一,它可以将数据映射到无穷维的特征空间中。

高斯核函数的形式为:K(x, y) = exp(-||x-y||^2 / (2σ^2))其中,x和y是原始数据的样本点,||x-y||表示两个样本点之间的欧氏距离,σ是高斯核函数的带宽参数。

在KPCA中,首先需要计算核矩阵K,核矩阵的元素K(i, j)表示样本点xi和xj之间的相似度。

然后,对核矩阵进行中心化操作,得到中心核矩阵K'。

接下来,对中心核矩阵进行特征值分解,得到特征值和对应的特征向量。

最后,根据特征值和特征向量,选择前k个特征向量,将原始数据映射到新的低维空间中。

KPCA的优点在于可以处理非线性问题,并且保留了数据中的重要信息。

PCA与KPCA简介

主成分分析1.主成分分析的基本原理统计学上PCA 的定义为用几个较少的综合指标来代替原来较多的指标,而这些较少的综合指标既能尽多地反映原来较多指标的有用信息,且相互之间又是无关的。

作为一种建立在统计最优原则基础上的分析方法,主成分分析具有较长的发展历史。

在1901年,Pearson 首先将变换引入生物学领域,并重新对线性回归进行了分析,得出了变换的一种新形式。

Hotelling 于1933年则将其与心理测验学领域联系起来,把离散变量转变为无关联系数。

在概率论理论建立的同时,主成分分析又单独出现,由Karhunen 于1947年提出,随后Loeve 于1963年将其归纳总结。

因此,主成分分析也被称为K-L 变换。

PCA 运算就是一种确定一个坐标系统的直交变换,在这个新的坐标系统下,变换数据点的方差沿新的坐标轴得到了最大化。

这些坐标轴经常被称为是主成分。

PCA 运算是一个利用了数据集的统计性质的特征空间变换,这种变换在无损或很少损失了数据集信息的情况下降低了数据集的维数。

PCA 的基本原理如下:给定输入数据矩阵m n X ⨯(通常m n >),它由一些中心化的样本数据1{}m i i x =构成,其中n i x R ∈且10m i i x==∑ (1-1)PCA 通过式(2-2)将输入数据矢量i x 变换为新的矢量T i i s U x = (1-2)其中:U 是一个n n ⨯正交矩阵,它的第i 列i U 是样本协方差矩阵11nT i i i C x x n ==∑(1-3) 的第i 个本征矢量。

换句话说,PCA 首先求解如下的本征问题1,...,i i i u Cu i n λ= = (1-4)其中λ是C 的一个本征值,i u 是相应的本征矢量。

当仅利用前面的P 个本征矢量时(对应本征值按降序排列),得矩阵T S U X =。

新的分量S 称为主分量。

最大特征值λ对应的最大特征向量u 就是第一个主成分,这个特征向量就是数据有最大方差分布的方向。

pca和KPCA的详细介绍与分析(全网最全,最经典)

第二章 主成分分析1. 主成分分析的基本原理统计学上PCA 的定义为用几个较少的综合指标来代替原来较多的指标,而这些较少的综合指标既能尽多地反映原来较多指标的有用信息,且相互之间又是无关的。

作为一种建立在统计最优原则基础上的分析方法,主成分分析具有较长的发展历史。

在1901年,Pearson 首先将变换引入生物学领域,并重新对线性回归进行了分析,得出了变换的一种新形式。

Hotelling 于1933年则将其与心理测验学领域联系起来,把离散变量转变为无关联系数。

在概率论理论建立的同时,主成分分析又单独出现,由Karhunen 于1947年提出,随后Loeve 于1963年将其归纳总结。

因此,主成分分析也被称为K-L 变换[1]。

PCA 运算就是一种确定一个坐标系统的直交变换,在这个新的坐标系统下,变换数据点的方差沿新的坐标轴得到了最大化。

这些坐标轴经常被称为是主成分。

PCA 运算是一个利用了数据集的统计性质的特征空间变换,这种变换在无损或很少损失了数据集的信息的情况下降低了数据集的维数。

PCA 的基本原理如下:给定输入数据矩阵m n X ⨯ (通常m n >),它由一些中心化的样本数据1{}m i i x =构成,其中n i x R ∈且10m i i x==∑ (2-1)PCA 通过式(2-2)将输入数据矢量i x 变换为新的矢量T i i s U x = (2-2)其中:U 是一个n n ⨯正交矩阵,它的第i 列i U 是样本协方差矩阵11nT i i i C x x n ==∑ (2-3)的第i 个本征矢量。

换句话说,PCA 首先求解如下的本征问题1,...,i i i u Cu i n λ= = (2-4)其中λ是C 的一个本征值,i u 是相应的本征矢量。

当仅利用前面的P 个本征矢量时(对应本征值按降序排列),得矩阵T S U X = 。

新的分量S 称为主分量[2]。

最大特征值λ对应的最大特征向量u 就是第一个主成分,这个特征向量就是数据有最大方差分布的方向。

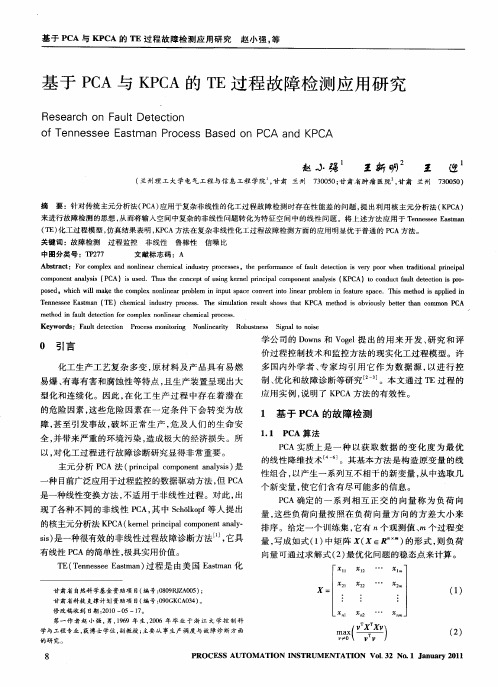

基于PCA与KPCA的TE过程故障检测应用研究

0 引言

化工生产工艺复 杂多变 , 材料及 产 品具 有易燃 原 易爆 、 有毒有害和腐蚀性等特点 , 且生产装置呈现 出大 型化 和连续化 。因此 , 化工生 产过程 中存在 着潜在 在

学 公 司 的 D w s V gl 出 的用 来 开 发 、 究 和 评 o n 和 oe 提 研 价 过 程 控 制 技 术 和 监 控 方法 的 现实 化工 过 程 模 型 。许 多 国 内外 学 者 、 家 均 引 用 它 作 为 数 据 源 , 进 行 控 专 以

关键 词 :故障检 测

过程监 控

非线性

鲁棒 性

信 噪比

中图分 类号 :T 2 7 P7

文 献标 志码 :A

Ab t a t: F rc mpe n o l e rc e c li u t rc se sr c o o lx a d n ni a h mia nd sr p o e ss,te p roma c ffutd tcin i e o r wh n ta i o a rn ia n y h ef r n e o a l ee to s v r p o e rd t n lp cp l y i i

p sd,w i lma etec mpe o l erpo lm p t pc o vr it l e rpo lm i etr p c .T i meh di a pi n oe hc wi k h o l n ni a rbe i i u aecn et no i a rbe nfauesae hs to p l di h l x n nn s n s e

主元 分 析 P A法 ( r cplc m o e ta a s ) C p n ia o p n n nl i 是 i ys

PCA和KPCA傻傻分不清楚?戳进来教你如何区分

PCA 和KPCA 傻傻分不清楚?戳进来教你如何区分

在格物汇之前的文章中,我们讨论了特征抽取的经典算法——主成分分析PCA 与线性判别分析LDA 的原理与应用场景。

PCA 是一种无监督的降维方法,寻找的是让数据方差最大的一种映射;LDA 是一种有监督的降维方法,寻找的是让数据分类效果最好的一种映射。

但是它们仍然有应用的局限性,今天我们就一起来了解下。

PCA 的局限性

我们先来回顾一下PCA 的降维原理:PCA 试图通过旋转找到新的正交基,满足这样的两条性质:

1、最近重构性:样本点到新映射的正交基距离足够接近。

2、最大可分性:记得我们在SVM 的核函数中曾经验证过,在低维空间计算(+1) 得到的结果与高维空间上计算

的结果相似,只是系数略有不同。

因此我们也可以在此应用核方法来计算。

我们在此定义核函数矩阵:

代入上面等式2,便可得到:

即。

主元分析报告(PCA)理论分析报告及的综述

主元分析(PCA)理论分析与应用什么是PCA?PCA是Principal ponent analysis的缩写,中文翻译为主元分析。

它是一种对数据进展分析的技术,最重要的应用是对原有数据进展简化。

正如它的名字:主元分析,这种方法可以有效的找出数据中最“主要〞的元素和结构,去除噪音和冗余,将原有的复杂数据降维,揭示隐藏在复杂数据背后的简单结构。

它的优点是简单,而且无参数限制,可以方便的应用与各个场合。

因此应用极其广泛,从神经科学到计算机图形学都有它的用武之地。

被誉为应用线形代数最价值的结果之一。

在以下的章节中,不仅有对PCA的比拟直观的解释,同时也配有较为深入的分析。

首先将从一个简单的例子开始说明PCA应用的场合以与想法的由来,进展一个比拟直观的解释;然后参加数学的严格推导,引入线形代数,进展问题的求解。

随后将揭示PCA与SVD(Singular Value Deposition)之间的联系以与如何将之应用于真实世界。

最后将分析PCA理论模型的假设条件以与针对这些条件可能进展的改良。

一个简单的模型在实验科学中我常遇到的情况是,使用大量的变量代表可能变化的因素,例如光谱、电压、速度等等。

但是由于实验环境和观测手段的限制,实验数据往往变得极其的复杂、混乱和冗余的。

如何对数据进展分析,取得隐藏在数据背后的变量关系,是一个很困难的问题。

在神经科学、气象学、海洋学等等学科实验中,假设的变量个数可能非常之多,但是真正的影响因素以与它们之间的关系可能又是非常之简单的。

下面的模型取自一个物理学中的实验。

它看上去比拟简单,但足以说明问题。

如图表错误!未定义书签。

所示。

这是一个理想弹簧运动规律的测定实验。

假设球是连接在一个无质量无摩擦的弹簧之上,从平衡位置沿x轴拉开一定的距离然后释放。

图表错误!未定义书签。

对于一个具有先验知识的实验者来说,这个实验是非常容易的。

球的运动只是在x 轴向上发生,只需要记录下x 轴向上的运动序列并加以分析即可。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第二章主成分分析1.主成分分析的基本原理统计学上PCA 的定义为用几个较少的综合指标来代替原来较多的指标,而这些较少的综合指标既能尽多地反映原来较多指标的有用信息,且相互之间又是无关的。

作为一种建立在统计最优原则基础上的分析方法,主成分分析具有较长的发展历史。

在1901年,Pearson 首先将变换引入生物学领域,并重新对线性回归进行了分析,得出了变换的一种新形式。

Hotelling 于1933年则将其与心理测验学领域联系起来,把离散变量转变为无关联系数。

在概率论理论建立的同时,主成分分析又单独出现,由Karhunen 于1947年提出,随后Loeve 于1963年将其归纳总结。

因此,主成分分析也被称为K-L 变换[1]。

PCA 运算就是一种确定一个坐标系统的直交变换,在这个新的坐标系统下,变换数据点的方差沿新的坐标轴得到了最大化。

这些坐标轴经常被称为是主成分。

PCA 运算是一个利用了数据集的统计性质的特征空间变换,这种变换在无损或很少损失了数据集的信息的情况下降低了数据集的维数。

PCA 的基本原理如下:给定输入数据矩阵m n X ⨯ (通常m n >),它由一些中心化的样本数据1{}m i i x =构成,其中n i x R ∈且10m i i x==∑ (2-1)PCA 通过式(2-2)将输入数据矢量i x 变换为新的矢量T i i s U x = (2-2)其中:U 是一个n n ⨯正交矩阵,它的第i 列i U 是样本协方差矩阵11nT i i i C x x n ==∑(2-3) 的第i 个本征矢量。

换句话说,PCA 首先求解如下的本征问题1,...,i i i u Cu i n λ= = (2-4)其中λ是C 的一个本征值,i u 是相应的本征矢量。

当仅利用前面的P 个本征矢量时(对应本征值按降序排列),得矩阵T S U X = 。

新的分量S 称为主分量[2]。

最大特征值λ对应的最大特征向量u 就是第一个主成分,这个特征向量就是数据有最大方差分布的方向。

第二主成分也就是第二大特征值对应的特征向量,数据点沿着这个方向方差有第二大变化,且这个特征向量与第一个是正交的。

实际过程中原始数据如果没有经过中心化,即式(2-1)不成立,则也可以对数据进行标准化处理。

即对每一个指标分量作标准化处理ij jij j A A X S -= (2-5)其中样本均值: 11mj ij i A A m ==∑(2-6) 样本标准差:j S = (2-7) 得到()ij m n X x ⨯=,接下来进行以上运算,这就是标准的PCA ,这种标准化方法有效的减少了数据量纲对数据提取的影响[3]。

2. 主成分分析的实现步骤基于上述主成分分析的基本原理,可以得出主成分分析的计算步骤如下所示:1、将所获得的n 个指标(每一指标有m 个样品)的一批数据写成一个(m n ⨯)维数据矩阵1111n m mn a a A a a ⎛⎫ ⎪= ⎪ ⎪⎝⎭. 2、对矩阵A 作标准化处理:即对每一个指标分量进行标准化处理,利用公式(2-5),从而得到()ij m n X x ⨯=。

3、由式(2-8)计算样本矩阵的相关系数矩阵1()1T ij n n R X X r m ⨯=⋅=-(2-8) 4、运用Jacobi 迭代方法计算R 的特征值1,...,n λλ,即对应的特征向量1,...,n v v 。

5、特征值按降序排序(通过选择排序)得''1...n λλ>>并对特征向量进行相应调整得''1,...,n v v 。

6、通过施密特正交化方法单位正交化特征向量,得到1,...,n αα。

7、计算特征值的累积贡献率1,...,n B B ,根据给定的提取效率p ,如果t B p ≥,则提取t 个主成分1,...,t αα。

8、计算已标准化的样本数据X 在提取出的特征向量上的投影Y X α=⋅,其中1(,...,)t ααα=。

所得的Y 即为进行特征提取后的数据也就是数据降维后的数据。

第三章基于核的主成分分析1.核方法作为一种由线性到非线性之间的桥梁,核方法的相关研究起源于20世纪初叶,其在模式识别中的应用至少可以追溯到1964年,然而直到最近几年,核方法的研究开始得到广泛的重视,从而相继提出了各种基于核方法的理论和方法。

核方法是一系列先进性数据处理技术的总称,其共同特点是这些数据处理方法都应用了核映射。

核函数方法的基本原理是通过非线性函数把输入空间映射到高维空间,在特征空间中进行数据处理,其关键在于通过引入核函数,把非线性变换后的特征空间内积运算转换为原始空间的核函数计算,从而大大简化了计算量[4]。

从具体操作过程上看,核方法首先采用非线性映射将原始数据由数据空间映射到特征空间,进而在特征空间进行对应的线性操作,如图3-1所示:由于采用了非线性映射,且这种非线性映射往往是比较复杂的,从而大大增强了非线性数据的处理能力。

从本质上讲,核方法实现了数据空间、特征空间、和类别空间之间的非线性变换。

设i x 和j x 为数据空间中的样本点,数据空间到特征空间的映射函数为Φ,核函数的基础是实现向量的内积变换(,)(,)()()i j i j i j x x K x x x x →=Φ⋅Φ (3-1)通常,非线性变换函数()Φ•相当复杂,而运算过程中实际用到的核函数(,)K ••则相对简单的多,这正是核方法迷人的地方。

图3-1 核方法框架示意图对于核函数必须满足Mercer 条件:对于任意给定的对称函数(,)i j K x x ,它是某个特征空间中的内积运算的充要条件是对于任意的不恒为0的函数()g x 满足2()g x dx <∞⎰,有(,)()()0K x y g x g y dxdy ≥⎰ (3-2) 式(3-2)给出了函数成为核函数的充要条件。

考虑到核方法的基础是实现了一种由输入空间到特征空间的非线性映射,假设输入空间数据为(1,2,,)L d i x R i N ∈=,对任意对称、连续且满足Mercer 条件的函数(,)i j K x x ,存在一个Hilbert 空间H ,对映射:L d R H Φ→有1(,)()()Fd i j n i j n K x x x x ==Φ⋅Φ∑(3-3)式中F d 是H 空间的维数。

常用的核函数有以下几种形式:线性核函数 (,)i i K x x x x =⋅(3-4)P 阶多项式核函数(,)[()1]p i i K x x x x =⋅+(3-5)高斯径向基函数(RBF )核函数 22(,)exp()i i x x K x x σ-=- (3-6)多层感知器核函数(,)tanh[()]i i K x x v x x c =⋅+(3-7)2. 基于核的主成分分析的基本原理假设12,,...,M x x x 为训练样本,用{}i x 表示输入空间。

KPCA 方法的基本思想是通过某种隐式方式将输入空间映射到某个高维空间(常称为特征空间),并且在特征空间中实现PCA [5,6] 。

假设相应的映射为Φ,其定义如下:()d F x x ξΦ→=Φ核函数通过映射Φ将隐式的实现点x 到F 的映射,并且由此映射而得的特征空间中数据满足中心化的条件,即1()0Mx μμ=Φ=∑ (3-8) 则特征空间中的协方差矩阵为:11()()M T C x x M μμμ==ΦΦ∑(3-9)现求C 的特征值0λ≥和特征向量\{0}V F ∈,C νλν=(3-10)即有(())(())v x C x ννλνΦ⋅=Φ⋅ (3-11)考虑到所有的特征向量可表示为12(),(),...,()M x x x ΦΦΦ的线性张成,即1()Mi i i v x α==Φ∑(3-12)则有1111((()()()()))(()())M M Mw w w x x x x x x M μνμνμμμαλ===Φ⋅ΦΦΦ=Φ⋅Φ∑∑∑ (3-13) 其中1,2,...,v M =。

定义M M ⨯维矩阵K:(()())K x x μνμν=Φ⋅Φ (3-14)则式子(3-13)可以简化为2M K K λαα= (3-15)显然满足M K λαα= (3-16)求解(3-16)就能得到特征值和特征向量,对于测试样本在特征向量空间k V 的投影为1(())()((),())Mkk i i i x x x να=⋅Φ=ΦΦ∑ (3-17) 将内积用核函数替换则有1(())()(,)Mkk i i i x K x x να=⋅Φ=∑ (3-18) 当(3-8)不成立时,需进行调整,11()()()Mvv x x x M μμ=Φ→Φ-Φ∑1,...,M μ= (3-19) 则核矩阵可修正为211,111()M M M w w w w w w K K K K K M M μνμνμνττ===→-++∑∑∑ (3-20) 3. 基于核的主成分分析的实现步骤基于上述KPCA 的基本原理,可得KPCA 的处理过程如下:1、将所获得的n 个指标(每一指标有m 个样品)的一批数据写成一个(m n ⨯)维数据矩阵1111n m mn a a A a a ⎛⎫ ⎪= ⎪ ⎪⎝⎭。

2、计算核矩阵,先选定高斯径向核函数中的参数,再由式(3-14),计算核矩阵K 。

3、通过(3-20)修正核矩阵得到KL 。

4、运用Jacobi 迭代方法计算KL 的特征值1,...,n λλ即对应的特征向量1,...,n v v 。

5、特征值按降序排序(通过选择排序)得''1...n λλ>>并对特征向量进行相应调整得''1,...,n v v 。

6 、通过施密特正交化方法单位正交化特征向量,得到1,...,n αα。

7、计算特征值的累积贡献率1,...,n B B ,根据给定的提取效率p ,如果t B p ≥,则提取t 个主分量1,...,t αα。

8、计算已修正的核矩阵X 在提取出的特征向量上的投影Y KL α=⋅,其中1(,...,)t ααα=。

所得的投影Y 即为数据经KPCA 降维后所得数据。

4. PCA 和KPCA 的比较主成分分析属于代数特征分析方法,是模式识别领域中一种经典的特征抽取和降维方法。

但是PCA 的缺点是需要很大的存储空间和计算复杂度。

如果原始空间的维数是n , PCA 需要分解一个n n ⨯的非稀疏矩阵。

因为PCA 是一种线性映射方法,降维后的表示是由线性映射生成的,它忽略了数据之间高于2阶的相互关系,所以抽取的特征并不是最优的,这在一定程度上影响了PCA 方法的效果[7]。

核主成分分析是线性PCA 的非线性扩展算法,它采用非线性的方法抽取主成分,即KPCA 是在通过映射函数Φ把原始向量映射到高维空间F ,在F 上进行PCA 分析[8]。