为VMwareESXi主机添加本地存储的过程注意事项

VMware ESX增外置存储卷操作

VMware ESX增外置存储卷操作虚拟化应用已经越来越普遍,但虚拟化环境带来更多的管理复杂性。

例如,虚拟机如何识别后端外置存储卷,并访问读取数据呢?本文将介绍,如何给VMware ESX新增外置存储卷的操作步骤以及实战心得。

给安装VMWARE ESX4.0服务器192.168.58.80生产机,额外有增加一块DS8700600G存储盘LUN。

个人电脑上运行VC Client访问192.168.58.80如下图选择右边窗口中“配置”页。

(点击上图可看大图)选择“硬件“中的“存储适配器”再右侧选择光纤卡“类型”列是“光纤通道”QLA2432,后面有该HBA卡的WWN:5001438000c30b16。

(点击上图可看大图)在下面的详细信息里查看是否识别新划出的盘。

没有识别可以点击如上图右侧“重新扫描”扫描完成右下信息栏里会有相对的信息提示扫描完成。

SAN ZONE,光纤通道都正常情况下,能识别出新划盘。

(点击上图可看大图)如下600G盘(点击上图可看大图)上面至此VMWARE已经正常识别出,新增加的存储LUN盘。

对于新增加的存储LUN盘VMWARE有两种方法处理。

一种是在之前已有,已经分配的LUN盘上扩展。

如下“存储器”选中一个,右击“属性“选择在”添加扩展”里选择新增的存储LUN.扩展现有的存储器。

扩展的LUN可以和之前的LUN是物理上不同的storage。

(点击上图可看大图)(点击上图可看大图)另外一种是选择“添加存储器“增加一个存储器。

(点击上图可看大图)(点击上图可看大图)本文由西安治疗白癜风最好的医院(/)网站负责人阿牧整理分享,转载请注明!。

为VMware ESXi主机添加本地存储的过程及注意事项-之3

为VMware ESXi主机添加本地存储的过程及注意事项-之3 3 为服务器添加存储及注意事项3.1退出维护模式并添加本地存储当主机再次进入VMware ESXi之后,使用vSphere Client登录vCenter Server,将置于维护模式的主机“退出维护模式”并添加本地存储,主要步骤如下。

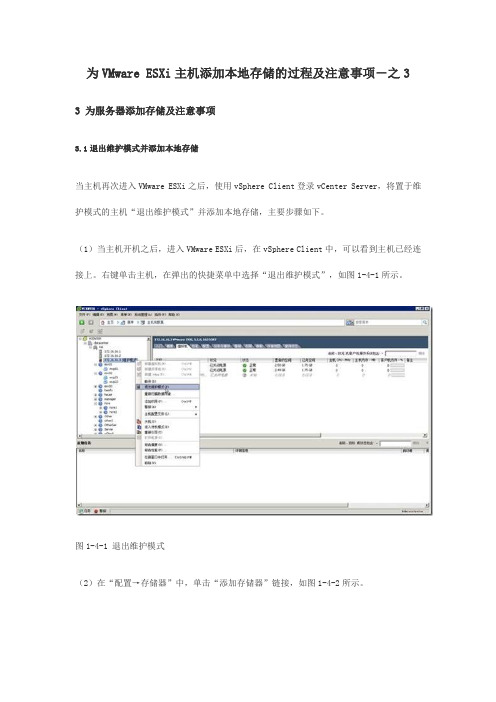

(1)当主机开机之后,进入VMware ESXi后,在vSphere Client中,可以看到主机已经连接上。

右键单击主机,在弹出的快捷菜单中选择“退出维护模式”,如图1-4-1所示。

图1-4-1 退出维护模式(2)在“配置→存储器”中,单击“添加存储器”链接,如图1-4-2所示。

图1-4-2 添加存储器(3)在“选择存储器类型”中选择“磁盘/LUN”,如图1-4-3所示。

图1-4-3 添加本地磁盘(4)在“选择磁盘/LUN”对话框中,在右侧会显示出当前可以添加的磁盘,并显示驱动器类型及容量,如图1-4-4所示,当前是6块1TB硬盘划分为RAID0,所以容量是2.73TB左右(3个1TB硬盘容量)。

图1-4-4 选择要添加的磁盘(5)在“文件系统版本”对话框,选择“VMFS-5”文件系统,只有VMFS-5文件系统才支持2TB以上大小,如图1-4-5所示。

图1-4-5 文件系统版本(6)在“当前磁盘布局”对话框,显示了当前磁盘所有可用空间的情况,当前硬盘为2.73TB,硬盘为空白,如图1-4-6所示。

图1-4-6 当前磁盘布局(7)在“属性”对话框中,指定数据存储的属性,在“输入数据存储名称”文本框中,输入要添加的数据存储名称,该名称将会添加在当前ESXi主机中。

在有多台主机时,要为存储规划统一的名称。

规划可以有多种方式,一般我是使用主机名+存储名+序号。

例如,这是在第2台ESXi主机上添加的第一个本地存储,则可以将名称命名为esx02-d1,如图1-4-7所示。

图1-4-7 命名存储(8)添加存储之后,在“配置→存储器”右侧可以看到添加的存储,如图1-4-8所示。

为VMware ESXi主机添加本地存储的过程及注意事项-之4

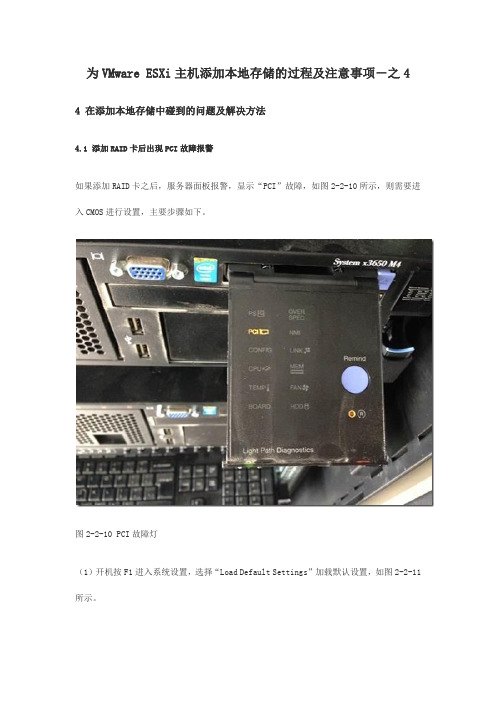

为VMware ESXi主机添加本地存储的过程及注意事项-之4 4 在添加本地存储中碰到的问题及解决方法4.1 添加RAID卡后出现PCI故障报警如果添加RAID卡之后,服务器面板报警,显示“PCI”故障,如图2-2-10所示,则需要进入CMOS进行设置,主要步骤如下。

图2-2-10 PCI故障灯(1)开机按F1进入系统设置,选择“Load Default Settings”加载默认设置,如图2-2-11所示。

图2-2-11 恢复默认设置(2)然后进入“System Settings”(系统设置)对话框,选择“Network”进入网卡设置,如图2-2-12所示。

图2-2-12 网络设置(3)在网络设置对话框中,选择“Network Boot Configuration”(网络启动配置),如图2-2-13所示。

图2-2-13 网卡启动配置(4)在“Network Boot Configuration”页中,将1、2、3网卡的PXE引导功能禁止(保留编号为0的网卡的PXE引导功能,用来安装系统)。

本例以配置标号为2的网卡为例。

移动光标到“MAC:40:F2:E9:XX:XX:XX Onboard PFA 6:0:2”按回车键,如图2-2-14所示。

图2-2-14 选择网卡(5)进入网卡配置页,在“PXE Mode”处按回车键,在弹出的对话框中选择“Disabled”,如图2-2-15所示。

图2-2-15 禁止PXE功能(6)设置之后如图2-2-16所示。

之后移动光标到“Save Changes”保存设置。

图2-2-16 保存设置之后参照(4)~(6)6设置,将标号为1、3的网卡也禁止PXE功能,并保存设置。

这些不一一介绍。

(7)之后返回“System Settings”,选择“Devices and I/O Ports”,如图2-2-17所示。

图2-2-17 设备与IO端口配置(8)在设备与端口配置页面,选择“Enable / Disable Adapter Option ROM Support”,如图2-2-18所示。

vmware esxi操作手册

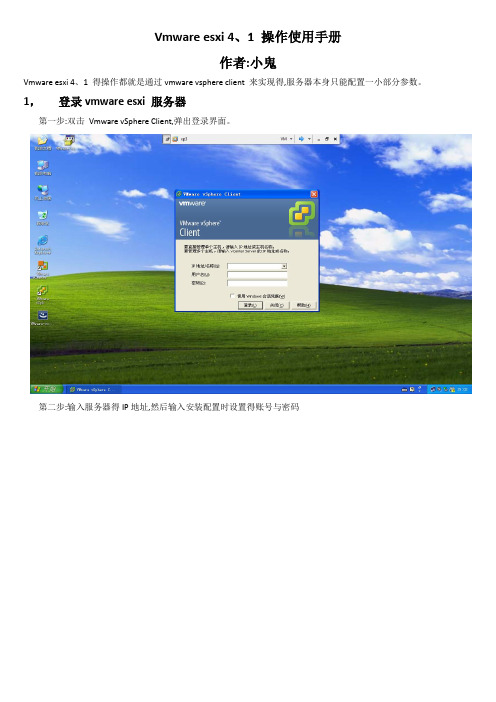

Vmware esxi 4、1 操作使用手册作者:小鬼Vmware esxi 4、1 得操作都就是通过vmware vsphere client 来实现得,服务器本身只能配置一小部分参数。

1,登录vmware esxi 服务器第一步:双击Vmware vSphere Client,弹出登录界面。

第二步:输入服务器得IP地址,然后输入安装配置时设置得账号与密码第三步:点忽略第四步:下图就就是成功登录服务器得界面2,注册激活(如上图,vmware esxi 4、1 需要注册) 第一步:点击清单第二步:点击配置,然后点击ESX Server 许可证类型右边得编辑第三步:选择向此主机分配新许可证密钥,然后点击输入密钥第四步:输入下载得时候申请到得license 5J43J0E29JK8A300TAHM090QQ 然后点确定第五步:再点一次确定之后出现下面界面,说明已经激活成功3,上传镜像文件(如果操作系统得安装文件不就是光盘得话,则需要做这一步,如果就是光盘得话,则不需要)第一步:在配置选项卡下面选择存储器选择我们得数据存储(datastore1)右键单击选择浏览数据存储第二步:在这一步,可以创建目录,也可直接放在根目录。

点击上传标志(将鼠标移动到标志会提示其功能),可选择将本地得操作系统镜像上传。

第三步:如图所示,正在上传文件第四步:如图所示,上传成功3,新建一台虚拟机第一步:右键单击服务器标识(IP地址),选择新建虚拟机第二步:选择自定义,点下一步第三步:输入新建虚拟机得名称,点下一步第四步:选择虚拟机文件得存储位置,点击下一步第五步:选择虚拟机版本7 ,点下一步第六步:选择安装系统得类型与版本,然后点下一步第七步:选择虚拟机处理器得个数,然后点下一步第八步:选择内存数量第九步:选择网卡,点下一步第十步:选择默认,直接点下一步第十一步:选择虚拟磁盘得类型,点一步、第十二步:选择磁盘容量,点下一步第十三步:默认,点下一步第十四步:点击完成第十五步:选择刚才创建得虚拟机,选择编辑虚拟机设置第十六步:选择CD/DVD 驱动器1,右边选择数据存储ISO文件,将启动时连接勾上第十七步:双击database1第十八步:选择要安装系统得ISO文件,点确定第十九步:删除不需要得,或没有得硬件第二十步:这里删除了软盘驱动器,点确定第二十一步:启动虚拟机第二十二步:点击控制台,这里就可以瞧到虚拟机得安装界面,系统得安装就与实体机安装一样了。

使用iSER协议在ESXi主机上挂载存储的方法

使用iSER协议在ESXi主机上挂载存储的方法随着数据存储需求的不断增长和技术的不断发展,企业对于存储解决方案的需求也越来越多样化。

iSER(iSCSI Extensions for RDMA)协议是一种适用于存储网络的高性能传输协议,结合了RDMA(Remote Direct Memory Access)技术和iSCSI协议,可以提供更高的传输速度和更低的延迟。

在ESXi主机上使用iSER协议挂载存储,可以大幅度提升存储性能和响应时间。

本文将介绍使用iSER协议在ESXi主机上挂载存储的详细步骤。

1. 确认硬件和软件支持在开始配置之前,首先需要确保ESXi主机的硬件和软件都支持iSER协议。

硬件方面,ESXi主机的网络适配器需要支持RDMA技术,通常使用的是以太网适配器,并且需要支持iSCSI功能。

对于软件支持,ESXi主机的版本需要是6.5或更高版本,因为iSER协议在ESXi 6.5中得到了原生支持。

2. 配置存储设备和iSCSI Target在ESXi主机上挂载存储之前,需要先配置存储设备和iSCSI Target,确保它们之间可以正常通信。

首先,在存储设备上启用iSCSI服务,并创建一个LUN(Logical Unit Number)作为存储空间。

然后,在iSCSI Target上创建一个iSCSI目标,将该LUN添加到目标中。

确保在配置过程中设置了正确的接入控制列表(ACL)以及授权用户,以确保ESXi主机可以通过iSCSI协议访问存储设备。

3. 配置ESXi主机在ESXi主机上进行如下配置:3.1 进入ESXi主机的管理界面,选择"Configuration",然后选择"Storage Adapters"。

在适配器列表中找到主机上的网络适配器,点击相应的适配器。

3.2 在网络适配器的属性页面,选择"Configure iSCSI",然后点击"Enabled"来启用iSCSI协议。

ESXI安装、硬盘扩容、U盘挂载

一、安装虚拟机1、虚拟机名称:如下所示2、硬盘分区规划1)Windows 系统盘C: 40G 其他盘100G左右内存1G-4G2)LINUX (Redhat 5)256G/:剩余空间swap:6G/tmp:5G/home:160G/boot 100M三、安装1、创建虚拟机2、安装windows操作系统挂在ISO镜像执行安装对系统资源进行划分,使用NTFS格式化后进行安装安装设备启动操作系统安装R2补丁配置IP地址、DNS后,查看远程连接是否已经打开,点击OK。

则配置完成。

Linux安装类似,不过需要设置分区,如上所示即可。

安装VMware tools在的平台上安装Redhat5企业版,无论指定IP或者DHCP获得IP都不能ping通安装操作请看此人博客安装后现象为:可以ping通机器本身地址,但是无法ping通内网地址和网关。

解决方案如下:1、检查配置信息#ifconfig修改对应网卡的网关的配置文件# vi /etc/sysconfig/network-scripts/ifcfg-eth0检查hosts配置#vi /etc/hosts开机不启动防火强#Chkconfig iptables off重启网络服务#/etc/network restart(Stop Start)2、重装操作系统通过模板复制、单独安装,多次尝试后发现故障依然。

3、reboot系统最后尝试发现,在系统reboot后,ping本机地址(安装操作系统的时候配置好系统IP)的过程中发现,IP地址有一段时间是可以ping通的。

但是当xend服务启动后,则网络不通。

如下图所示:4、关闭xend服务修改启动设置,指定xen使用的console的方法如下:a)确定系统版本,以便找到需要修改的启动项:# uname -rLinux 2.6.18从上面的输出,我们可以看出,现在系统版本是2.6.18-8。

b)找到相应的启动配置(对应版本2.6.18-8的那项配置),在/boot/grub/中会有如下的配置项:title Red Hat Enterprise Linux Server 2.6.18root (hd0,0)kernel /boot/2.6.18 module /boot/2.6.18 ro root=LABEL=/module /boot/2.6.18)添加“xencons”参数。

为VMware ESXi主机添加本地存储的过程及注意事项演示教学

为VMware ESXi主机添加本地存储的过程及注意事项在规划数据中心的时候,除了考虑当前的实际情况下,还要考虑将来二至三年的可能出现的问题。

但有的时候,虽然已经做了多种考虑,但在信息化实施的过程中,仍然会碰到问题,这时就需要管理员根据实际情况进行处理。

例如,在规划虚拟化数据中心的时候,作为群集中的虚拟化主机,一般不配置本地硬盘,而是采用共享存储,以实现系统的高可用性。

即时为服务器配置本地硬盘,一般也只是配置一个较小的磁盘,例如60~120GB的固态硬盘安装系统。

相信这是大多数虚拟化数据中心的选择与规划。

对于初期规划没有考虑配置本地存储的服务器,如果在后期需要在服务器安装大容量的存储,并且需要在现有业务不中断的情况下进行,应该怎么做?在添加本地存储中碰到问题怎么解决,本文将讨论这个问题。

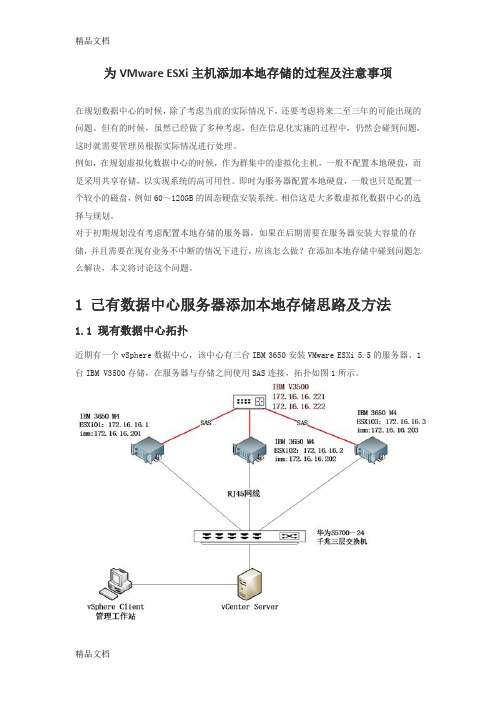

1 己有数据中心服务器添加本地存储思路及方法1.1 现有数据中心拓扑近期有一个vSphere数据中心,该中心有三台IBM 3650安装VMware ESXi 5.5的服务器、1台IBM V3500存储,在服务器与存储之间使用SAS连接,拓扑如图1所示。

图1 存储、服务器连接示意图这三台服务器原来本地没有配置硬盘,是使用的存储分配的空间用于系统及数据。

现在用户的需求是:为每台服务器添加6块硬盘,作为本地的存储。

因为这三台ESXi组成一个HA,并且已经有虚拟机运行,所以要求在添加本地硬盘的过程中,业务不能中断。

另外,由于在开始规划的时候,没有考虑为服务器添加本地硬盘,所以没有选择配置支持RAID5的RAID卡,故在添加本地硬盘时,需要一同添加RAID卡。

1.2解决思路及原理在VMware vSphere数据中心中,当所有的虚拟机运行在共享存储上、并且为vSphere数据中心配置了"群集"后,当群集中主机多于2台时,如果要对其中的主机进行维护,包括关机检修、添加配件等,可以将检修的主机置于"维护模式",此时该主机上运行的虚拟机会自动"迁移"到其他主机,然后可以重新启动或关闭处于"维护模式"的ESXi主机,在关机后可以为服务器添加硬件(例如添加RAID卡、添加硬盘、重新配置RAID卡)。

VMware虚拟化--ESXi安装时考虑因素

VMware虚拟化--ESXi安装时考虑因素虚拟化不仅仅是将服务器虚拟化了,同时包括了网络,存储等,所以在搭建虚拟化环境之前一定要规划好虚拟化的架构。

搭建虚拟化环境首先要解决几个问题:1. 安装ESXi的什么版本,是Installable还是Embedded版本?2. 采用哪种型号的硬件服务器?3. 使用哪种存储,采用哪种连接方式与服务器进行连接?FC-SAN,iSCSI-SAN4. ESXi网络架构如何设置?1. ESXi Installable还是Embedded版本ESXi Installable是传统的安装方式,可以安装到本地硬盘,FC-SAN,U盘等等设备上。

ESXi Embedded已经安装在服务器上的,这样可以节省了管理员的安装ESXi的时间。

2. 采用哪种型号的硬件服务器?在服务器选型的时候最好去官网的兼容性列表(HLC)查询下,查询地址:/resources/compatibility/search.php选择硬件服务器不单单要考虑兼容性,也要考虑机器的配置,比如CPU,内存,因为物理CPU和内存是和授权的费用息息相关的。

3. 使用哪种存储,采用哪种连接方式与服务器进行连接?使用哪种存储,以及存储与ESXi服务器的连接方式的选择同样总要,是采用FC,FCoE,iSCSI-SAN,NFS等都需要考虑。

在选择存储的时候,需要解决一下几个问题:a. 选择哪种存储才会与现有的存储和网络有较好的兼容性b. 选择的存储性能是否能满足需求c. 存储是否支持vSphere的高级功能4. ESXi网络架构如何设置?一般ESXi服务器都配置了6个网卡或更多,8个,10个,12个都可以;网卡都是一主一备的形式存在,ESXi的网络主要有一下几种类型:a. 管理网络端口,2张网卡,如果只用一张网卡则vsphere的高级功能可能会报警b. vMotion端口,2张网卡,vMotion的网络最少是千兆,万兆更佳,一般情况下会将vMotion端口和管理端口放在一起,公用两张网卡c. FT端口,2张网卡,如果想启用FT功能,则最好将FT的端口独立出来,FT的端口同样最少的千兆环境,万兆更佳d. iSCSI,NFS存储端口,2张网卡,对于使用iSCSI或者NFS协议的存储,可以单独分配2张网卡;同样最少是千兆环境,万兆更佳e. VM网络,2张网卡,在ESXi主机上运行的虚拟机也需要2张网卡,至少千兆环境这样如果将管理端口和vMotion端口使用同样的物理网卡,则服务器至少需要8张网卡,不过如果在有些环境因为划分的VLAN较多,所以可能考虑每个VLAN用独立的物理网卡,这样物理服务器的网卡就需要更多。

vCenter IP SAN连接存储 配置步骤

VMware IP-SAN 添加主机连接存储步骤环境:ESXI 5.5vCenter 5.5主机:Dell R730交换机:Dell N4032F存储:DELL EQL PS6210x磁盘阵列步骤:iDRAC又称为Integrated Dell Remote Access Controller,也就是集成戴尔远程控制卡F11 进入启动菜单选择进入bios启动菜单选择光驱启动前两个是光纤连接IP san 在这里注意,不要选择成管理网络配置IP配置IP和网关Enter确认ESC返回上层,提示是否应用,YPing一下ok网络通了vCenter中添加新的Host,IP 帐密。

提示是否信任,不重要,继续通过vCenter的授权给ESXI授权不启用锁定模式,启用后,只能通过现场,或者vcenter登录,防止别人直连esxi是否将虚拟机中资源与加入的集群合并,合并ok摘要,主机添加完成,下面任务条进行一会,ok,然后还会自动进行HA配置,稍等即好在vCenter--左栏选择主机,右边选择配置标签页,选择网络初始状态,这里因为在ESXI主机上配置时,网络中,只打开了只选择了一个管理网卡,所以只显示一个物理适配器。

这里是更改了一下ESXI的配置,选了两个管理网卡,其中一个没插网线,显示叉号点击右上角的“添加网络”,我们来给ipsan的数据传输建立专门的网络这里选择VMkernel把剩余两个非管理网卡选上,(就是在ESXI里没有没有选定的那两个,已经由光纤和ipsan交换机连接好了)这里可以一次选两个,但是有时出问题,可以一次先选一个后添加另一个网络标签:起个名字“将此端口组用于vMoton”选中此项,将来虚拟机之间才好热迁移,下一步设置好IPsan的IP确认完成完成后的图示,两个网卡,但是VMkernel端口还少一个,继续添加,这次点这个组右上方的属性点击添加跟之前一样VMKernel起名设置IP 选中用于vMonton好了两个VMkernel端口加好了,下一步把他们跟刚才的两个物理网卡对应起来点击上面的“网卡绑定”标签页,打勾“替代交换机故障切换顺序”将vmnic0,移动到活动适配器下面,将另一个,移动到“未用的适配器下面”对应哪一个不重要,重要的是要和另一个VMKernel端口的配置错开即可网络部分完成,下面配存储适配器首先右面点击“存储适配器”,点击右上角添加,添加一个ESXI默认的软件iSCSI适配器添加后,右键,属性,(入没启用勾选启用,然后进入属性配置页面)点击“网络配置”标签,添加刚才配置的VMKernel端口选择,添加(这张图是开始只添加了一个的时候截的,正常时候这里应该有两个可选的)下面两个端口组和适配器空着的,不能选添加好后是这个样子,当和存储连上的时候“路径状态”栏,将变由“未使用”变为“活动”然后点击动态发现页面(没图),在动态发现里,添加存储的iPsan地址,ok这个静态发现页面不用手动添加,和存储连上之后自动读取。

为VMware Esxi 选择合适的存储

如何为虚拟化选择合适的存储设备今无论是服务器虚拟化,还是桌面虚拟化逐渐侵占数据中心,随之市场占有率用户有足够的信心转为虚拟化技术,我自己亲身接触的客户很多都在筹备使用更多虚拟化资源取代已有的X86硬件架构,使资源能够更高效利用,但是问题来了?使用虚拟化(这里尤其指的是服务器虚拟化,桌面虚拟化)如果没有一台共享存储,那么虚拟化环境很多高级特性就无法使用,例如vSphere:vMotion,将运行中的虚拟机从一个主机迁移到另一个主机;Storage vMotion,将运行中的虚拟机的磁盘文件从一个vSphere数据存储迁移到另一个数据存储;存储分布式资源调度(SDRS),当vSphere数据存储运行缓慢(高延迟)或存储空间不足时,重新平衡虚拟机磁盘文件;vSphere高可用性,依靠此特性,当主机失效时,虚拟机可以自动在另一主机上启动;因此,我会说共享存储在虚拟化环境或者虚拟化集群占有很重要的位置,那么企业如何选择一台适合自己的存储呢?这将是博文内容的核心部分。

如果采购的存储无论是性能,还是容量各方面过剩,意味着降低投资回报率。

如果存储各方面,如稳定性,性能,容量在短时间内出现瓶颈,那么会影响整个业务系统,甚至造成安全隐患。

稍后我会按照八个方面来阐述自己一些卑微见解(排名不分先后)。

第一个方面NAS还是SAN?NAS能够提供更广泛的协议,除了提供给VMware NFS还可以把空间以CIFS,SMB,NFS协议提供给其它的业务系统,达到高效利用。

首先确认您的虚拟化产品是否支持NAS,并且在官方的厂商兼容性列表,vSphere,Hyper-V,KVM,Citrix 等等。

SAN属于独享的“块”结构设备,通俗来讲,前者是通过地址映射了一块空间,而SAN则是把一颗实体的设备映射给主机,我们甚至能够在设备管理器看到这颗磁盘驱动器,并且安装系统在这上面(SANboot),相同带宽,磁盘特征的情况下,块结构设备必然更快速。

VMware_ESXi4.1经典部署文档(原创)

VMware_ESXi4.1经典部署文档(原创)VMware ESXi 4.1经典部署文档铁锤作品详情步骤如下:1、VMware的安装配置1.1 安装前的注意事项1)VMware系统采用VMFS文件系统,最大文件大小以及虚拟机磁盘大小最大值都为2T,块大小可为1,2,4,8M,使用跨卷来增加VMFS的存储容量,最大可达64T。

由于以上的限制,对于服务器本机存储,分区大小应小于2T,esxi 4.1系统的安装分区分配20G空间即可。

2)ESXi 41只能安装在64位处理器+2G内存的机器上。

3)在BIOS里启用处理器的'Virtualization Technology'功能,可以提供性能。

4)下载安装ESXi4.1并输入免费申请的序列号后,再无时间限制,可以支持256 GB 的内存和四路虚拟CPU(四核),否则只能试用60天。

1.2安装 ESXi 4.1使用交互模式安装步骤:1)将 ESXi 4.1 Installable CD/DVD 插入 CD/DVD-ROM 驱动器。

2)重新启动计算机。

3)将 BIOS 设置为从 CD-ROM 设备引导。

4)在“欢迎使用”屏幕上,按 Enter 键继续安装。

5)阅读 VMware 最终用户许可协议,然后按 F11 接受该协议。

6)在“选择磁盘”屏幕中,选择要在其上安装 ESXi 4.1 的磁盘驱动器,然后按 Enter。

按 F1 可获取所选磁盘的相关信息。

注意:选择磁盘时,请勿依赖于列表中的磁盘顺序。

磁盘顺序由BIOS 确定,并可能顺序不当。

连续添加、移除驱动器的系统可能会出现这种问题。

如果选择的磁盘包含数据,则显示“确认磁盘选择”屏幕。

7)按 F11 开始安装。

8)安装完成后,取出安装 CD/DVD。

9)按 Enter 重新引导主机。

重新引导操作过程中,在磁盘上创建 VFAT 暂存分区和 VMFS 分区。

10)将首个引导设备设置为要在其上安装 ESXi 的驱动器(在步骤6 中)。

Vmware ESXi共享存储配置

Vmware ESXi共享存储配置在小型VMware环境当中,错误配置共享存储的情况并不少见。

花费一些时间来纠正这些错误可以在ESXi主机超过负载或者宕机时避免很多问题。

一个成功的vSphere部署需要包含三个基本部分:多个相同的ESXi服务器、共享存储和vCenter。

任何具有多个ESXi服务器的数据中心都应该使用共享存储,并且对于所有服务器集群都保证一直可用。

对于一些vSphere核心技术来说,比如vMotion、分布式资源调度(DRS)和高可用性(HA),共享存储是一个前提条件。

vMotion可以在不产生宕机时间的情况下,将一个运行中的虚拟机从一台ESXi主机迁移到另一台上。

DRS利用vMotion技术将虚拟机移动到其他的ESXi主机上,以避免产生CPU和内存不足的情况。

如果一台ESXi服务器发生故障,vSphere HA会在集群中的其他ESXi 主机上重启正在运行的虚拟机。

DRS和HA只能用于存放在共享存储上的虚拟机;不论是HA还是DRS迁移,虚拟机在存储上的位置都不会发生改变。

为了最大限度地发挥HA和DRS的作用,虚拟机使用的所有存储都必须对集群中的每一台ESXi服务器保证可用。

连续的共享存储使用的配置取决于存储网络类型:光纤通道(FC)、iSCSI还是网络文件系统(NFS)。

对于FC和iSCSI 存储,需要确保存储阵列对于每个ESXi主机都使用相同的逻辑单元号(LUN)。

一些阵列通过使用分组可以轻松实现这个需求,但是其他阵列就需要你为每个主机都单独进行配置。

对于FC,你需要将FC交换机配置在一致的分区当中,以使得所有的主机都能够找到阵列。

如果使用的是iSCSI,那么ESXi主机需要使用同样的发现设定、同样的动态发现IP地址列表。

如果使用的是NFS,那么大部分的设定都可以在ESXi服务器上完成。

确保在每个ESXi主机上都使用相同的NFS服务器主机名和共享路径。

如果一个ESXi主机使用NFS服务器的IP地址,另外一个使用主机名,而第三台ESXi主机使用全限定名,那么vCenter将认为它们使用的是不同的数据存储。

为VMware Esxi 选择合适的存储

如何为虚拟化选择合适的存储设备今无论是服务器虚拟化,还是桌面虚拟化逐渐侵占数据中心,随之市场占有率用户有足够的信心转为虚拟化技术,我自己亲身接触的客户很多都在筹备使用更多虚拟化资源取代已有的X86硬件架构,使资源能够更高效利用,但是问题来了?使用虚拟化(这里尤其指的是服务器虚拟化,桌面虚拟化)如果没有一台共享存储,那么虚拟化环境很多高级特性就无法使用,例如vSphere:vMotion,将运行中的虚拟机从一个主机迁移到另一个主机;Storage vMotion,将运行中的虚拟机的磁盘文件从一个vSphere数据存储迁移到另一个数据存储;存储分布式资源调度 (SDRS),当vSphere数据存储运行缓慢(高延迟)或存储空间不足时,重新平衡虚拟机磁盘文件;vSphere高可用性,依靠此特性,当主机失效时,虚拟机可以自动在另一主机上启动;因此,我会说共享存储在虚拟化环境或者虚拟化集群占有很重要的位置,那么企业如何选择一台适合自己的存储呢?这将是博文内容的核心部分。

如果采购的存储无论是性能,还是容量各方面过剩,意味着降低投资回报率。

如果存储各方面,如稳定性,性能,容量在短时间内出现瓶颈,那么会影响整个业务系统,甚至造成安全隐患。

稍后我会按照八个方面来阐述自己一些卑微见解(排名不分先后)。

第一个方面NAS还是SAN?NAS能够提供更广泛的协议,除了提供给VMware NFS还可以把空间以CIFS,SMB,NFS协议提供给其它的业务系统,达到高效利用。

首先确认您的虚拟化产品是否支持NAS,并且在官方的厂商兼容性列表,vSphere,Hyper-V,KVM,Citrix 等等。

SAN属于独享的“块”结构设备,通俗来讲,前者是通过地址映射了一块空间,而SAN则是把一颗实体的设备映射给主机,我们甚至能够在设备管理器看到这颗磁盘驱动器,并且安装系统在这上面(SAN boot),相同带宽,磁盘特征的情况下,块结构设备必然更快速。

vmware添加iscsi共享储存

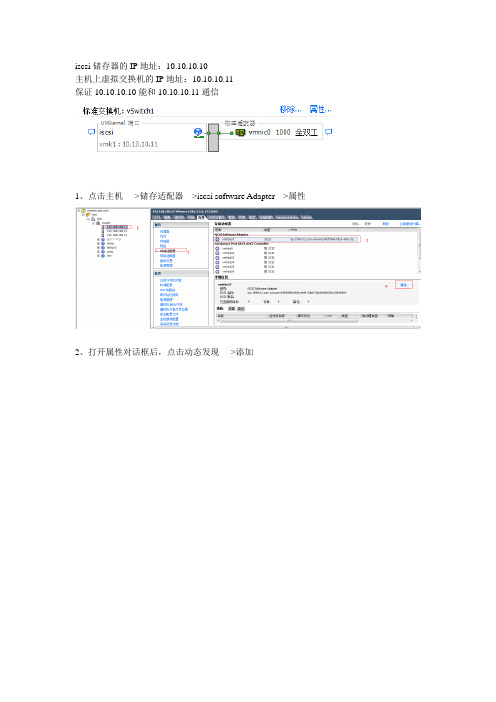

iscsi储存器的IP地址:10.10.10.10主机上虚拟交换机的IP地址:10.10.10.11保证10.10.10.10能和10.10.10.11通信1、点击主机---->储存适配器--->iscsi software Adapter--->属性2、打开属性对话框后,点击动态发现---->添加3、输入ISCSI服务器的IP地址,点击确定点击是,重新扫描说明:如果在“储存器”中没有找到可用的ISCSI存储,请检查前面的虚拟交换机的端口地址是否正确,以及在存储服务器中添加的ISCSI目标、卷、IP地址的对应关系是否正确,然后再次重新扫描iscsi设备。

4、添加储存。

点击主机--->储存器---->添加储存器输入存储器的名称,(在Vcenter中显示的名称)完成后,就可以在存储器中看到添加的存储。

创建虚拟机模板:window server 2003 与window xp 属于相同架构,创建模板的方法相同。

window server 2008 与window 7 、window Vista 属于相同架构,创建模板的方法相同。

部署window server 2003模板:1、安装window server 2003 系统2、安装完系统,安装VMware tools、安装常用软件(输入法、WinRAR),不要再模板中安装杀毒软件。

3、运行gpedit.msc或点击开始---管理工具----本地安全策略。

登录时不需要按CTL+ALT+DELETE就可以登录。

4、将window server 2003 中的support/tools 文件夹中deploy.cat展开后的结果复制到Vcenter的C:\Documents and Setting\All Users\Application Date\VMware VirtualCenter\sysgrep\srv2003 中设置虚拟机随主机一同启动在exsi虚拟机中使用U盘或其他外设1、将U盘插在主机上2、添加硬件设备3、添加USB控制器该类型最大允许在虚拟机中添加2个USB设备(2端口的USB设备)然后添加USB设备,从列表中选择可用的USB设备。

【免费下载】在esxi50u1中添加磁盘存储时出现错误

在esxi5.0u1中添加磁盘存储时出现错误问题描述:esxi系统是新安装的,原来的磁盘是使用SuperMicro X7DB8主板自带的RAID功能做的RAID5(开机过程中显示是2个2+1的RAID5阵列),在esxi5.0u1中添加磁盘存储时有3块盘添加成功,另3块盘不能添加,出现错误。

在esxi5.0u1中添加磁盘存储时出现错误:主机配置过程中出错。

在ESXi“172.16.11.18”上调用对象“ha-datastoresystem”的“HostDatastoreSystem.QueryVmfsDatastoreCreateOptions”失败。

在VC里添加磁盘存储时出现错误:在vCenter Server“”上调用对象“datastoreSystem-787”的“HostDatastoreSystem.QueryVmfsDatastoreCreateOptions”失败。

解决方案:详细看了日志没有特别明显的报错可能有2个方面一是磁盘的lun头有脏数据导致vmware不能识别头部需清理掉才好二是磁盘以前在vmware这边出现过PDL事件,意思是意外中断事故。

第一个原因解决方法:Checking for non-msdos disklabels and non-GPT partition table layoutsTo validate whether the target disk device contains an unsupported partition table layout:Changing the partition type in the ESX Service Console using the parted utilityThe command line utility parted can be used in the ESX Service Console to change the disk label and partitioning scheme for a specific device.Warning: This process will destroy data on the target device. The steps outlined here are potentially hazardous for your environment if they are not followed exactly. If you are not comfortable performing these steps, contact VMware Technical Support and work with them to resolve the issue.To change the label and partitioning scheme using parted:/vmfs/devices/disks/vml.0200030000600508b30093fcf0a05b5b8cc739002f4d 53413135313.Start the parted utility, specifying the disk device to be modified from step 2, using thecommand:# parted "/vmfs/devices/disks/DeviceName"4.At the (parted) prompt, display the current partition contents:printThe output appears similar to:Disk label type:gptNumber Start End Size File system Name Flags1 17.4kB 134MB 134MB Microsoft reserved partition msftres5.Review the output from the parted print command. Ensure that the disk device does notcontain important information, either used by an ESX/ESXi host, a virtual machine as an RDM, or a physical server.6.To destroy all pre-existing partitions on the device and change the disk label, run the command:mklabelCaution: This operation deletes all pre-existing partitions on the device. The changes take effect immediately. This results in data loss and cannot be reverted.7.At the "New disk label type? [label]" prompt, enter the label:msdos8.Repeat step 4 to validate that the partition table is blank, and the disk label has been changedto msdos.9.Exit parted using the command:quit10.Retry the storage operation that was failing initially. If this method fails, use the dd utilityinstead.Clearing partitioning information in ESXi using the DD utilityDue to differences between ESX classic and ESXi, the parted utility is not available in ESXi. These steps describe how to clear partitioning information for a LUN under ESXi.Warning: This process will destroy data on the target device. The steps outlined here are potentially hazardous for your environment if they are not followed exactly. If you are not comfortable performing these steps, contact VMware Technical Support and work with them to resolve the issue./vmfs/devices/disks/vml.0200030000600508b30093fcf0a05b5b8cc73900 2f4d5341313531e the fdisk command to obtain the exact size of the target disk device in bytes:# fdisk -l "/vmfs/devices/disks/DeviceName"The output appears similar to:Disk /vmfs/devices/disks/DeviceName: 536 MB, 429491220480bytes255 heads, 63 sectors/track, 52216 cylinders, total 838850040 sectorsUnits = sectors of 1 * 512 = 512 bytesDevice Boot Start End Blocks Id System/vmfs/devices/disks/DeviceName 1 128838850039 419424956 ee EFI GPTe the dd command to erase the first 34 sectors (34x512 bytes) of the disk device with zeros:# dd if=/dev/zero of="/vmfs/devices/disks/DeviceName" bs=512 count=34 conv=notruncCaution: This operation deletes the partition table and master boot record on the disk device. The changes take effect immediately. This results in data loss and cannot be reverted.5.The GPT partition scheme stores a backup of the partition table at the end of the disk device.Erase the last 34 sectors of the device as well:a.Determine the offset at which the last 34 sectors begins:b.c.(SizeInBytes/ 512) - 34 =SeekOffsetd.e.For example, using the values in step 3:f.g.(429491220480/ 512) - 34 =838850006e the dd command to erase the last 34 sectors of the disk, starting at the offsetfound in step 5a:i.j.# dd if=/dev/zero of="/vmfs/devices/disks/DeviceName" bs=512 count=34 seek=SeekOffset conv=notrunck.l.Caution: This operation deletes the partition table and master boot record on the disk device. The changes take effect immediately. This results in data loss and cannot bereverted.6.Depending on the original contents of the disk device, it may be necessary to erase a largeramount of data on the disk.7.Retry the storage operation.第二个原因解决方法:1.Run this command to see the world that has the device open for the LUN:#esxcli storage core device world list -d naa-idFor example:#esxcli storage core device world list -dnaa.6006016058201700354179be0c6fdf11You see output similar to:Device World ID Open Count World Name------------------------------------ -------- ---------- ----------naa.6006016058201700354179be0c6fdf11 2060 1 idle0If a VMFS volume is using the device indirectly, the world name includes the string idle0. If a virtual machine uses the device as an RDM, the virtual machine World ID is displayed. If any other process is using the raw device, the corresponding information is displayed.2.Run this command to list all virtual machines running on the ESXi 5.0 host and identify thevirtual machine registered on that LUN:#esxcli vm process list3.Run this command to kill the virtual machine World ID:#esxcli vm process kill --type=force --world-id World IDFor example:#esxcli vm process kill --type=force --world-id=121314.Rescan the storage using this command:#esxcfg-rescan -u vmhba#5.Run this command to see the device state:#esxcli storage core device list -d naa-id6.If the issue persists, reboot the ESXi 5.0 host where virtual machine was registered.。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

为VMware ESXi 主机添加本地存储的过程及注意事项在规划数据中心的时候, 除了考虑当前的实际情况下,还要考虑将来二至三年的可能出现的问题。

但有的时候,虽然已经做了多种考虑,但在信息化实施的过程中,仍然会碰到问题, 这时就需要管理员根据实际情况进行处理。

例如,在规划虚拟化数据中心的时候,作为群集中的虚拟化主机,一般不配置本地硬盘,而是采用共享存储,以实现系统的高可用性。

即时为服务器配置本地硬盘,一般也只是配置一个较小的磁盘,例如60〜120GB 的固态硬盘安装系统。

相信这是大多数虚拟化数据中心的选 择与规划。

对于初期规划没有考虑配置本地存储的服务器,如果在后期需要在服务器安装大容量的存 储,并且需要在现有业务不中断的情况下进行, 应该怎么做?在添加本地存储中碰到问题怎么解决,本文将讨论这个问题。

1己有数据中心服务器添加本地存储思路及方法1.1现有数据中心拓扑近期有一个 vSphere 数据中心,该中心有三台 IBM 3650安装 VMware ESXi 5.5的服务器、1图1 存储、服务器连接示意图台IBM V3500存储,在服务器与存储之间使用SAS 连接,拓扑如图1所示。

rm 3650 M4172.16- 311M 幽0删宙IZ2. IG L 16.2im lTO, Id IG. 203ESCiOh 172. 16 L& I im: 172. l(i 15 201172. JR年为貉700 24 千狂丄屋交搂肌vSphere Client 轉理E 作站这三台服务器原来本地没有配置硬盘,是使用的存储分配的空间用于系统及数据。

现在用户的需求是:为每台服务器添加6块硬盘,作为本地的存储。

因为这三台ESXi组成一个HA并且已经有虚拟机运行,所以要求在添加本地硬盘的过程中,业务不能中断。

另外,由于在开始规划的时候,没有考虑为服务器添加本地硬盘,所以没有选择配置支持RAID5的RAID卡,故在添加本地硬盘时,需要一同添加RAID卡。

1.2解决思路及原理在VMware vSphere数据中心中,当所有的虚拟机运行在共享存储上、并且为vSphere数据中心配置了”群集”后,当群集中主机多于2台时,如果要对其中的主机进行维护,包括关机检修、添加配件等,可以将检修的主机置于"维护模式”,此时该主机上运行的虚拟机会自动"迁移”到其他主机,然后可以重新启动或关闭处于"维护模式”的ESXi主机,在关机后可以为服务器添加硬件(例如添加RAID卡、添加硬盘、重新配置RAID卡)。

在本案例中,就使用这一功能,可以保证业务不中断的前提下,关闭虚拟化主机(安装了VMware ESXi 5.5系统),为主机添加RAID卡、本地硬盘,甚至为主机重新安装VMware ESXi 5.5系统并重新加入现有群集,都不会造成业务的中断。

主要步骤如下:(1)使用vSphere Client (或vSphere Web Client ),登录vCenter Server ,将其中一台主机,例如第1台主机置于”维护模式”,等该主机上的所有虚拟机,都迁移到其他主机上之后,关闭该主机。

(2)等主机关闭后,断开该主机电源。

拆开机箱,插入RAID卡。

(3)安装好硬盘,重新开机,进入RAID卡配置界面,为添加的硬盘,配置RAID。

配置完RAID之后,重新启动主机。

(4)重新进入VMwareESXi系统,将新添加的磁盘,添加到ESXi本地存储。

然后将当前主机退出”维护模式”。

(5)之后参照(1)〜(4)的步骤,将其他主机进入维护模式,关机,添加RAID卡、硬盘,并配置RAID,重新启动系统并退出维护模式,这些不一一介绍。

(6 )最后检查服务器、存储、及软件系统,没有故障之后,添加存储完成。

下面较为详细的介绍整个过程及注意事项。

1.3将主机进入维护模式使用vSphere Client将要维护的主机进入维护模式,之后关闭主机并断开电源,添加卡,打开RAID 电源、添加硬盘。

主要步骤如下。

(1)使用vSphere Client ,登录vCenter Server ,右击要维护的主机,在弹出的快捷菜单 中选择”进入维护模式”,如图1-1-1所示。

gJKlItEil - 口% 小ClLi ■■ ie 样槽・Wfflb »*» ^19^ HrH ■>■ »fr^IS R 席 H 于;V *■;呼图1-1-2 虚拟机正在迁移I 7Z.lfi.iU!EU(KS-UL. 3h?J»7An ITKMM 也E n mmt * m am MOB MMMI■tvatufi -aihf«n/Q hfeMPT P-XTf jg^■峠 R ^M MWt atiwJMv f'lH ① *W>1a g 岛T »CS CW J WwwllrvJWMT WT R 门"■心让j尅戰(PE z*rVBW” kAMsi 4X^1^ aFT 耳电■ d iVAMOUi3@MX I ^ I :趣屮:.鮭网 ZnfPd CW e 銅0«2XCMr也打*bu 曰開卄WIMflS* JWTPW»MS JW 肿™L2 ■ 2IFf賣童-t■負正正■正正孵C 呑沪柿&艮小迪亶纽匕号血如何.3 :THIJV£&・=4晶•口*AB -■nww^1 iiMmlOlt *AaftlGij* fWQ» 皿泊1, Htf 呦.dv5*A<MrM>*t .£9if 电崎口昭甘鼻口塌 片番MX 口 10 甘雅或也□甫 上fid 口傭AMiin图1-1-1进入维护模式(2)将主机置于维护模式后,当前主机上正在运行的虚拟机, 所示。

在迁移的过程中,当前正在运行的业务不会中断。

会迁移到其他主机,如图1-1-2 在"近期任务"中可以看到,虚拟机正在迁移到其他主机。

.w^rw • "Hl!旳 邸卜―M r«曲护”軒・」w* a 时単 u Q sB"Tg| I4< ・|>i«ten・・嶽•-中 M K 0TM! i H!阵吐1 j 总14471E I1LU ■ • HM 虫Id .1a« —fit T • vw«lAIM*■1■事abA Ai事Alfl 浄liw 4its ■< 1 1 ■- 暑xljl工zrmz-•!一土丄一 ■•号•♦科*-拿••*■1 4■・ PC?t at Ii4i hk a a BhUa<iHa>»«iid Wlfl■MW*狗Ww4d-»■ taW «I I |49tlJCiJ * 刖・轉.・»a ±kf H*・i H■ 1 ■K iw ・lUi!<*■>■ ■$ 4*14 HOIj^asaEli n-w e aSM ■li*ll J|-M 44 * ■1 «比力■ P qflr4 Qw 4 * 忖■■1 fi xN-a a4>JWAiiria dnw|iT jMKitXH K»H-J riKML"-Mi Wfpst 3rwirrwwm H irmrrtl謂 IBMamwi 护JI 出 卅理Kst 卑廿£iift:岂R1山二门 陥衲t 曲迦上! mww ttiizsZBW 0JI^|M>!|lLkUUI OMMl 诲 JW 3M4MH ld* 3i JI amiHtwii Ji叭"MT"二翊宾口 J1J3mtiklftlUlnZI ■W* 昨 N.^«3.%14 913-t: ::_■ judw. iwa rmdW-Ul科迦Cril*!ftill 出&«WAib^% pQBEQ^fJff Ciri^A*F-■ will » Qi<riMI 昭 |UU f .1 |Vh 04 IltfAJU"J^^OCL + ■aar* 1$ I hw^is -" ¥■**■*■» 1h^ii ■E JI I FA .i^*-■-4 ■^4l^t ■■! I UJ JW--VW*®JM^MUatdMbW.431 *8U- RAM^FiWT HMUE - frr?(3)当所有的虚拟机迁移到其他主机后(即使没有运行的虚拟机,也会从当前主机取消注 册,并在其他正在运行的主机上重新注册。

当然,保存在主机本地存储上的虚拟机例外), 当前主机进入"维护模式”,右击该主机名称,在弹出的快捷菜单中选择如图1-1-3所示。

在此选择”关机”,因为我们要关闭主机电源之后,安装新的肋护I ■栖wn 卜EV 呻v»f・B 牌\ O D l-B > I* * 9 l<-ta ■■-」图1-1-3主机进入维护模式2为服务器添加硬件并重新规划 RAID2.1添加RAID 卡及硬盘当主机关闭之后,拔下电源线,戴上 IBM 服务器随机带的防静电手套,打开服务器的机箱,在服务器机箱的右上角,插上RAID 缓存卡(实际上是一个缓存,用于IBM 3650 M4主板集成的Serve RAID-M5110e 的扩展。

标配是无缓存,可以支持 RAID0/1/10,在插上缓存时, 可升级支持RAID5/6)。

图1-1-4是我们要插的缓存卡,图 1-1-5是插入后的相片(在服务器的右上角位置)。

"关机”或"重新引导”,RAID 卡。

C-itwW■J 此lkM ・ O rfiHn* »J mOMH ij 黑0站碎IJ ・ 叮 9rj ■]・•■書J EMW TIE.呻*M w■VUP■ tf 更A ・lLUiw.KM 0孕處 9 tLMt 0 FPllf !ttJ"% bnYoC^t s: :cn>1UQQ3>w 0_<工寸丄丄®匹 ¥>!1<黑9丄丄®链接资料:这是本次要安装的硬盘,如图1-1-6所示。

本次安装的是1TB 2.5寸普通笔记本硬盘(可以用在服务器上)。

计划在每台服务器上安装6块硬盘。

图1-1-6要安装的硬盘在IBM 3650M4中,最多可以配16块2.5寸硬盘,其中只有8个硬盘位有接线底座,硬盘位标号为0〜7另8个硬盘位没有接线底府,如图1-1-7这是有硬盘接线底座的拍照截图。

在这个服务器上,实际上已经安装了一个120GB的固态硬盘,还剩下7个硬盘位。