LogExplorer教程

log4delphi使用及UDP上传日志扩展详解

log4delphi使用及UDP上传日志扩展详解log4delphi使用及UDP上传日志扩展详解作者:黄克涛时间:2013年4月17日Log4Delphi是一个开放源码项目,旨在制作用于Borland的Delphi高质量实用的日志套件,是基于Apache Software Foundation的log4j包。

虽然这个项目已随着delphi“过时”,它最后一次更新在2006年,但是他具有logging的一贯风格,对于还在使用delphi的同鞋们还是可以考虑一下的。

以下是我使用后,整理的一点资料及一个UDPSocket日志上传的扩展,仅供参考。

1下载及安装1.从/projects/log4delphi/files/下载0.8版本,解压到文件夹。

2.打开文件夹"...\log4delphi-0.8",新建一个文件夹"build";3.运行Delphi 7,打开组件包"log4delphi_D7_STD.dpk",位于"...\log4delphi-0.8\src\delphi"下,点击"Compile"和"Install"进行编译安装;4.菜单"Tools"→"Environment Options"→"Library"→"Library path",添加"...\log4delphi-0.8\build"目录(如果需要连接源代码,则再添加"...\log4delphi-0.8\src\delphi"和"...\log4delphi-0.8\src\delphi\util");安装包说明:bin/ 项目二进制文件(无用).build/ 项目编译文件目录(需要自行添加).docs/ 文档目录(无用).example/ 配置文件实例.lib/ 测试单元所需要包(无用).src/ Log4Delphi项目代码.2初次试用1.新建一个应用程序,保存当前工程。

log4日志的初始化流程

log4日志的初始化流程(最新版)目录1.log4 日志的概述2.log4 日志的初始化流程3.log4 日志的应用示例正文一、log4 日志的概述log4 是一款优秀的 Java 日志框架,其设计目标是为了提供简单易用、功能强大的日志记录功能。

相较于其他日志框架,log4 具有如下特点:1.提供了丰富的日志级别,如 DEBUG、INFO、WARN、ERROR 等,方便开发者根据需要选择合适的日志级别。

2.支持多种日志输出方式,如控制台输出、文件输出、远程输出等,满足不同场景的需求。

3.提供了灵活的配置方式,可以通过 XML 配置文件或注解进行配置。

二、log4 日志的初始化流程log4 的初始化流程主要分为以下几个步骤:1.加载配置文件:log4 首先会加载用户指定的配置文件(可以是 XML 文件或注解)。

如果配置文件不存在或无法加载,log4 会使用默认的配置。

2.解析配置文件:log4 会对配置文件进行解析,将配置信息转化为内部的数据结构。

如果配置文件有错误,log4 会抛出异常。

3.初始化 Appender:根据配置文件中的信息,log4 会创建对应的Appender 实例。

Appender 是 log4 中负责实际输出日志的组件,如控制台输出、文件输出等。

4.初始化 Logger:log4 会根据配置文件中的信息创建 Logger 实例。

Logger 是 log4 中负责记录日志的组件,它会将日志信息按照日志级别进行处理。

5.设置日志级别:log4 会根据配置文件中的信息设置 Logger 的日志级别。

如果配置文件中没有指定日志级别,log4 会使用默认的日志级别。

6.输出日志信息:当应用程序运行时,log4 会根据 Logger 的日志级别输出相应的日志信息。

三、log4 日志的应用示例以下是一个简单的 log4 应用示例:1.首先,需要在项目中引入 log4 的依赖。

[讲稿]LogExplore使用方法

![[讲稿]LogExplore使用方法](https://img.taocdn.com/s3/m/8a1a93150640be1e650e52ea551810a6f524c862.png)

LogExplore使用方法LogExplore使用方法:安装后打开log explorer file=>attach log file->选择服务器和登陆方式->connect->选择数据库->attach->左面对话框中browse->view log->就可以看到log记录,点击“View DDL Commands”里面就有很多drop table 命令点击下面的“undo”按钮是生成表结构的语句(createtable ....)点击下面的“Salvage”按钮是生成插入语句的(insertinto ...values....)(以上lynx1111提供)我是按照上述方法的“Salvage”来生成被删除表的Insert语句,实际上用这个方法生成的SQL脚本已经包含了CreateTable。

该过程速度大概用了8个小时,当时觉得慢,后来相比恢复过程,这个速度简直快的不行。

最大的表脚本生成后超过1G。

生成所有的SQL脚本后,防止万一,我将数据库停下,并把Date 文件夹的Log和.MDF文件拷出来(怕破坏LOG文件,没有使用数据库的备份方式备份),文件大小总共为5.7G此后开始进行正式的恢复工作。

新建一个数据库,先试着用SQL查询分析器运行了一个小表的脚本,完全没有问题。

但后来发现导入比较大的SQL脚本文件,查询分析器就报错了。

请教了realgz得知logExplorer本身对大脚本有良好支持,因此改用LogExplorer--》Run SQL Script 功能来运行脚本。

果然大文件也可以恢复了。

但开始运行后发现包含有ntext字段的表恢复起来异常缓慢,打开一个包含nText字段的表的恢复脚本发现里面使用writeText来写入数据。

恢复一个30万数据的表居然用了将近12小时的时间,而数据库中又有大量这样的表,为了加快数据,我又在几个机器上装了LogExplorer加入恢复过程,终于经过3天的时间,全部的表都搞的差不多了,不过恢复过程有少量的错误。

LogExplorer4.2+For+sql+server使用教程

数据库恢复神器--Log Explorer 4.2使用教程介绍Log Explorer主要用于对MSSQLServer的事务分析和数据恢复。

可以浏览日志、导出数据、恢复被修改或者删除的数据(包括执行过update,delete,drop和truncate语句的表格)。

一旦由于系统故障或者人为因素导致数据丢失,它能够提供在线快速的数据恢复,最大程度上保证恢复期间的其他事务不间断执行。

他可以支持SQLServer7.0和SQLServer2000以及SQLServer2005.提取标准数据库的日志文件或者备份文件中的信息。

软件下载地址:/c0ojf3kule主要功能:其中提供两个强大的工具:日志分析浏览,对象恢复。

具体功能如下:●日志文件浏览●数据库变更审查●计划和授权变更审查●将日志记录导出到文件或者数据库表●实时监控数据库事务●计算并统计负荷●通过有选择性的取消或者重做事务来恢复数据●恢复被截断或者删除表中的数据运行SQL脚本LogExplore包含两部分1、客户端软件2、服务器代理服务器端代理是保存在SQLServer主机中的一个只读存储过程,他的作用是接受客户端请求,读取在线事务日志块并通过网络传给客户端软件,由客户端软件来读取这些原始的数据块来完成Log Explore所提供的所有功能。

他依赖来的网络协议包括:1、Named Pipe:局域网中适用2、Tcp/Ip:广域网中适用数据库相关介绍事务日志(Transaction Log)SQLServer的每个数据库都包含事务日志,它以文件的形式存储,可以记录数据库的任何变化。

发生故障时SQLServer就是通过它来保证数据的完整性。

操作(Operation)操作是数据库中定义的"原子行为",每个操作都在日志文件中保存为一条记录。

它可以是用户直接输入的SQL语句,比如标准的insert 命令,日志文件中便会记录一条操作代码来标志这个insert操作。

Web Log Explorer半汉化及使用心得(913更新语言包+常见问题汇总)

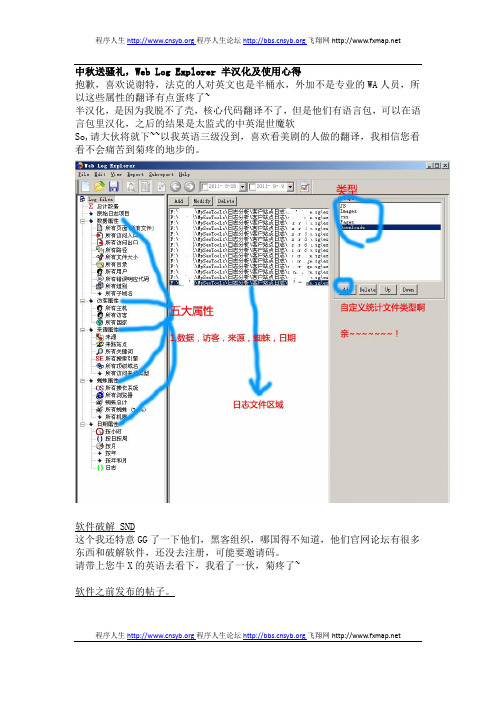

中秋送骚礼,Web Log Explorer 半汉化及使用心得抱歉,喜欢说谢特,法克的人对英文也是半桶水,外加不是专业的WA人员,所以这些属性的翻译有点蛋疼了~半汉化,是因为我脱不了壳,核心代码翻译不了,但是他们有语言包,可以在语言包里汉化,之后的结果是太监式的中英混世魔软So,请大伙将就下~~以我英语三级没到,喜欢看美剧的人做的翻译,我相信您看看不会痛苦到菊疼的地步的。

软件破解 SND这个我还特意GG了一下他们,黑客组织,哪国得不知道,他们官网论坛有很多东西和破解软件,还没去注册,可能要邀请码。

请带上您牛X的英语去看下,我看了一伙,菊疼了~软件之前发布的帖子。

这是之前几位论坛的胸低们发的贴,不是很多。

超强网站日志分析软件:Web Log Explorer 3.31破解版这个靠谱/thread-2420-1.html史上最牛日志分析软件,堪比光年日志分析软件史上最牛有点不靠谱,哥~~~/thread-3433-1.html本帖卖弄风骚,欢迎拍砖~~最近菊疼,前前后后托了3个多星期,今天完工,喜欢折腾就用呗,用爽就分享呗~至少我是怀着让大伙看着菊疼,翻译寻乐子的,中秋不管这贴有没有火了,都欢乐欢乐~~哈哈中文语言包,放到软件文件里,然后运行软件点View -Optoins - Language For 右边的... 之后选择中文语言包特征使用1,日志获取,本地,FTP可以选择本地导入,也可以选择服务器上批量拉稀式的下载~~~~~2,文件类型组别的统计及分类这个牛逼的,可以自定义很多文件类型的统计,在软件的右边,从中间开始扩散去看,自己定义文件类型去!~很全面滴~~五大常规日志属性-大杀器1,数据属性特别说明的是,访问路径,所有目录,所有文件类型,所有错误响应码。

访问路径这个数据导出后,还可以做转换路径统计哦,这个得看自己喜好了~这个路径功能不错所有目录目录,很清晰,很爽的说。

~~按自己目的挑目录做nofollow蜘蛛的引导~~~~ 所有文件类型所有错误响应码嘿嘿这个不错吧~~2,访客属性基本上没什么好说的,国家数据比较全。

loggenerator 使用指南

loggenerator 使用指南一、引言在计算机系统中,日志记录是非常重要的,它可以帮助我们追踪问题、分析系统性能以及监控系统运行状态。

而loggenerator 是一个强大的工具,它可以帮助我们生成各种类型的日志。

本文将为大家介绍如何使用 loggenerator,并提供一些实用的技巧和建议。

二、loggenerator 简介loggenerator 是一个开源的工具,它可以根据用户的需求生成各种类型的日志。

它支持自定义日志格式、日志级别、日志数量等参数,同时还能模拟各种场景下的日志记录,如登录日志、访问日志、异常日志等。

loggenerator 可以帮助我们快速生成大量的日志数据,用于测试和分析。

三、安装和配置1. 下载 loggenerator 工具包,并解压到任意目录。

2. 打开终端或命令行界面,进入 loggenerator 所在目录。

3. 执行命令 "chmod +x loggenerator",赋予执行权限。

4. 配置loggenerator 的参数,如日志格式、日志级别、日志数量等。

5. 运行 loggenerator,生成日志数据。

四、使用示例下面是一些常见的使用示例,供大家参考:1. 生成访问日志:loggenerator -f access.log -t "[$time_local] $request_method $request_uri $status" -n 100002. 生成异常日志:loggenerator -f error.log -t "[$time_local] $message" -n 1000 -l ERROR3. 生成登录日志:loggenerator -f login.log -t "[$time_local] $username 登录成功" -n 100 -l INFO4. 生成自定义日志:loggenerator -f custom.log -t "[$time_local] $custom_field" -n 1000五、常用参数说明1. -f, --file:指定生成的日志文件名。

关于记录log日志的几种方法

关于记录log⽇志的⼏种⽅法最近在记录⽇志的时候总结了⼏种⽅式:1.使⽤log4j2记录2.使⽤log4j记录3.使⽤logback配置,记录前使⽤private final Logger logger = LoggerFactory.getLogger(当前类名.class)⼀.使⽤log4j21.在pom.xml⽂件中引⼊依赖2.增加log4j2的配置⽂件(log4j2.xml)<?xml version="1.0" encoding="UTF-8"?><!--Configuration后⾯的status,这个⽤于设置log4j2⾃⾝内部的信息输出,可以不设置,当设置成trace时,可以看到log4j2内部各种详细输出--><!--monitorInterval:Log4j能够⾃动检测修改配置⽂件和重新配置本⾝,设置间隔秒数--><configuration monitorInterval="5"><!--⽇志级别以及优先级排序:OFF > FATAL > ERROR > WARN > INFO > DEBUG > TRACE > ALL--><!--变量配置--><Properties><!--格式化输出:%date表⽰⽇期,%thread表⽰线程名,%-5level:级别从左显⽰5个字符宽度%msg:⽇志消息,%n是换⾏符--><!--%logger{36} 表⽰ Logger 名字最长36个字符--><property name="LOG_PATTERN" value="%date{HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%n"/><!-- 定义⽇志存储的路径,不要配置相对路径 --><property name="FILE_PATH" value="/Users/King/Logs"/><property name="FILE_NAME" value="Mylog.log"/></Properties><appenders><console name="Console" target="SYSTEM_OUT"><!--输出⽇志的格式--><PatternLayout pattern="${LOG_PATTERN}"/><!--控制台只输出level及其以上级别的信息(onMatch),其他的直接拒绝(onMismatch)--><ThresholdFilter level="info" onMatch="ACCEPT" onMismatch="DENY"/></console><!--⽂件会打印出所有信息,这个log每次运⾏程序会⾃动清空,由append属性决定,适合临时测试⽤--><File name="Filelog" fileName="${FILE_PATH}/test.log" append="false"><PatternLayout pattern="${LOG_PATTERN}"/></File><!--这个会打印出所有的info及以下级别的信息,每次⼤⼩超过size,则这size⼤⼩的⽇志会⾃动存⼊按年份-⽉份建⽴的⽂件夹下⾯并进⾏压缩,作为存档--><RollingFile name="RollingFileInfo" fileName="${FILE_PATH}/info.log" filePattern="${FILE_PATH}/${FILE_NAME}-INFO-%d{yyyy-MM-dd}_%i.log.gz"> <!--控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch)--><ThresholdFilter level="info" onMatch="ACCEPT" onMismatch="DENY"/><PatternLayout pattern="${LOG_PATTERN}"/><Policies><!--interval属性⽤来指定多久滚动⼀次,默认是1 hour--><TimeBasedTriggeringPolicy interval="1"/><SizeBasedTriggeringPolicy size="10MB"/></Policies><!-- DefaultRolloverStrategy属性如不设置,则默认为最多同⼀⽂件夹下7个⽂件开始覆盖--><DefaultRolloverStrategy max="15"/></RollingFile><!-- 这个会打印出所有的warn及以下级别的信息,每次⼤⼩超过size,则这size⼤⼩的⽇志会⾃动存⼊按年份-⽉份建⽴的⽂件夹下⾯并进⾏压缩,作为存档--> <RollingFile name="RollingFileWarn" fileName="${FILE_PATH}/warn.log" filePattern="${FILE_PATH}/${FILE_NAME}-WARN-%d{yyyy-MM-dd}_%i.log.gz"> <!--控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch)--><ThresholdFilter level="warn" onMatch="ACCEPT" onMismatch="DENY"/><PatternLayout pattern="${LOG_PATTERN}"/><Policies><!--interval属性⽤来指定多久滚动⼀次,默认是1 hour--><TimeBasedTriggeringPolicy interval="1"/><SizeBasedTriggeringPolicy size="10MB"/></Policies><!-- DefaultRolloverStrategy属性如不设置,则默认为最多同⼀⽂件夹下7个⽂件开始覆盖--><DefaultRolloverStrategy max="15"/></RollingFile><!-- 这个会打印出所有的error及以下级别的信息,每次⼤⼩超过size,则这size⼤⼩的⽇志会⾃动存⼊按年份-⽉份建⽴的⽂件夹下⾯并进⾏压缩,作为存档--> <RollingFile name="RollingFileError" fileName="${FILE_PATH}/error.log" filePattern="${FILE_PATH}/${FILE_NAME}-ERROR-%d{yyyy-MM-dd}_%i.log.gz"> <!--控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch)--><ThresholdFilter level="error" onMatch="ACCEPT" onMismatch="DENY"/><PatternLayout pattern="${LOG_PATTERN}"/><Policies><!--interval属性⽤来指定多久滚动⼀次,默认是1 hour--><TimeBasedTriggeringPolicy interval="1"/><SizeBasedTriggeringPolicy size="10MB"/></Policies><!-- DefaultRolloverStrategy属性如不设置,则默认为最多同⼀⽂件夹下7个⽂件开始覆盖--><DefaultRolloverStrategy max="15"/></RollingFile></appenders><!--Logger节点⽤来单独指定⽇志的形式,⽐如要为指定包下的class指定不同的⽇志级别等。

apache log viewer使用方法-概述说明以及解释

apache log viewer使用方法-概述说明以及解释1.引言1.1 概述概述部分的内容:在现代世界中,计算机技术和互联网的迅猛发展使得网络日志(log)变得日益重要。

Apache是一个流行的开源Web服务器软件,其日志文件记录了访问服务器的详细信息,包括访问者的IP地址、访问时间、浏览器类型等等。

然而,阅读和分析这些日志文件是一项繁琐而耗时的任务。

为了帮助网络管理员和开发人员更好地理解和利用这些日志文件,出现了许多日志文件查看器工具,其中最为知名和实用的就是Apache Log Viewer。

Apache Log Viewer是一款简单易用且功能强大的工具,旨在帮助用户分析和解释Apache日志文件中的信息。

它提供了直观、交互式的界面,可以快速筛选和搜索日志文件的内容,并以可视化方式展示统计数据和图表。

使用Apache Log Viewer,用户可以轻松地监控网站访问情况、检测异常活动、识别潜在的安全威胁等。

本文将介绍如何使用Apache Log Viewer这个强大工具来分析和解读Apache日志文件。

接下来的章节将逐步介绍Apache Log Viewer的安装配置方法以及其主要功能和使用技巧。

通过本文的学习,读者将能够迅速上手并熟练使用Apache Log Viewer,从而提升对Apache日志的分析能力和效率。

继续阅读下一章节:2.正文- 2.1 Apache Log Viewer的介绍。

1.2文章结构文章结构是指文本的组织方式和内容安排。

在撰写一篇长文时,良好的文章结构可以帮助读者更好地理解和消化文章的内容。

文章结构应该合理有序,清晰明确,使读者能够迅速地找到所需的信息。

下面是关于Apache Log Viewer使用方法的文章结构部分的内容:1.2 文章结构文章将按照以下步骤和章节展开,以帮助读者全面了解Apache Log Viewer的使用方法:1.2.1 第一部分:Apache Log Viewer的概述本部分将对Apache Log Viewer进行简要介绍,包括其定义、功能和用途。

Windows Explorer日志收集方法

1.获取VxExplorer工具;a. 连接到VERITAS的FTP站点:# ftp 请参照如下内容输入用户名和口令进行登录:Connected to 220 ftp2 FTP server (Version w u-2.4.2-academ[BETA-18-VR13](1)Wed Feb 10 18:49:21 PST 1999) ready.Name (ftp:root): symsupport331 Guest login ok, send your complete e-mail address as password.Passw ord: iS*pp8rT1现在你已进入VERITAS的FTP服务器系统,所在位置是一个盲区("blind site"),它意味着用户如果以匿名的身份登录,就不能列出任何文件或目录,所以准确地执行如下步骤是十分重要的.b. 转换到/pub/support/vmtools目录下:ftp> cd /pub/support/vmtoolsc. 把FTP的传输模式设置为二进制ftp> bind. 下载vxexlorer工具包:ftp> get VxExplorer.zipe. 断开FTP连接:ftp> bye2. 执行vxexplrer工具a. 把下载的vxexplorer解压(如果vxexplorer工具已经通过VRTSspt软件包装在系统中,可跳过此步。

)到一个目录,运行,首先,输入由VERITAS售后提供的一个CASE号(可以通过拨打VERITAS技术支持电话获得),然后,自定义一个目录或使用缺省的/tmp目录来存放日志压缩文件。

之后,程序会自动收集,并对所收集的信息进行格式转换和压缩.请注意,这个过程可能会持续比较长的时间。

最后生成一个带主机名和Case ID 的 .cab文件。

在运行VRTSvxexplorer时,如果选择重新启动Volume Manager进程(Volume Manager Configuration Daemon),并不会破坏数据,数据访问也不会中断或挂起,但是,这个动作有可能引起一些配置管理操作的中断(如正在进行的subdisks的转换,plex的同步等).因此,任何有关Volume Manager配置的修改都必须在运行vxexplorer之前完成.3. 把vxexplorer的运行结果发送给VERITAS的技术支持中心。

ue explorer使用方法 -回复

ue explorer使用方法-回复UE Explorer使用方法指南引言:UE Explorer是一款功能强大的虚拟环境探索器,它为用户提供了一个交互式的三维界面,可以浏览、管理和编辑虚拟世界。

本文将详细介绍UE Explorer的使用方法,帮助用户高效地利用该软件进行虚拟环境的探索和操作。

第一部分:安装和启动UE Explorer(150-200字)首先,我们需要从官方网站下载UE Explorer安装包。

访问官网,找到下载页面,然后选择适合您操作系统的版本进行下载。

一旦下载完成,双击安装包运行安装程序,并按照提示进行安装。

安装完成后,您可以在开始菜单或桌面上找到UE Explorer的快捷方式。

双击快捷方式,软件将启动并加载所需的资源。

第二部分:界面和基本操作(500-700字)启动UE Explorer后,您将看到一个交互式的三维界面。

界面分为多个区域,包括主视窗、资源管理器、属性编辑器和命令栏等。

- 主视窗是UE Explorer的核心组件,它显示虚拟环境的三维内容。

您可以通过鼠标左键在主视窗中点击并拖动来改变视角,右键点击可以选中物体或进行其他操作。

滚动鼠标滚轮可以放大或缩小视图。

- 资源管理器显示当前虚拟环境的资源文件夹和文件,例如模型、纹理和声音等。

您可以通过点击文件夹来展开或折叠其内容,点击文件可以在属性编辑器中查看和修改相应的属性。

- 属性编辑器显示当前选中物体的属性。

当您在主视窗中选中一个物体时,其属性将在属性编辑器中显示。

您可以根据需要修改这些属性,例如位置、大小和材质等。

- 命令栏是用于执行特定操作的工具栏。

它包含常用的命令按钮,例如创建新物体、复制和粘贴物体等。

您可以通过单击按钮或按下相应的快捷键来执行这些操作。

除了上述基本操作外,UE Explorer还支持多种交互方式,例如点击和拖动、双击和右键菜单等。

用户可以根据需要选择最合适的操作方式,以便更高效地探索和操作虚拟环境。

进入log路径的方法

进入log路径的方法在软件开发过程中,log文件是非常重要的,它用于记录软件在运行中产生的各种信息,以便开发人员能够追踪和分析软件的运行状况。

在开发过程中,我们经常需要进入log路径来查看log文件,那么下面介绍几种方法。

方法一:通过命令行进入log路径1.打开命令行窗口:在Windows系统中,按下Win+R键,输入cmd,回车即可打开命令行窗口。

2.进入log路径:使用cd命令进入log文件所在的目录,例如:cd C:\Users\Administrator\Desktop\log。

3.查看log文件:使用dir命令查看该目录下的文件列表,找到需要查看的log文件,例如:dir /b log.txt。

4.使用文本编辑器查看log文件:使用notepad等文本编辑器打开log文件进行查看。

方法二:通过资源管理器进入log路径1.打开资源管理器:在Windows系统中,右键点击开始菜单,选择“文件资源管理器”即可打开资源管理器。

2.进入log路径:找到log文件所在的目录,双击进入该目录即可。

3.查看log文件:找到需要查看的log文件,双击打开即可使用文本编辑器查看。

方法三:通过IDE进入log路径1.打开IDE:使用集成开发环境(IDE)进行软件开发时,可以直接在IDE中进入log路径。

2.进入log路径:在IDE中打开项目,找到log文件所在的目录,双击进入该目录即可。

3.查看log文件:找到需要查看的log文件,双击打开即可使用文本编辑器查看。

方法四:通过远程登录进入log路径1.打开远程登录工具:使用远程登录工具(如:putty)进行远程登录。

2.输入登录信息:输入目标主机的IP地址和登录用户名、密码进行登录。

3.进入log路径:使用cd命令进入log文件所在的目录,例如:cd /var/log。

4.查看log文件:使用cat命令查看log文件,例如:cat syslog。

总结以上是进入log路径的几种方法,选择哪种方法取决于你的习惯和需求。

LogExplorer使用说明

Log Explorer使用说明一、介绍Log Explorer主要用于对MSSQLServer的事物分析和数据恢复。

你可以浏览日志、导出数据、恢复被修改或者删除的数据(包括执行过update,delete,drop 和truncate语句的表格)。

一旦由于系统故障或者人为因素导致数据丢失,它能够提供在线快速的数据恢复,最大程度上保证恢复期间的其他事物不间断执行。

他可以支持SQLServer7.0和SQLServer2000,提取标准数据库的日志文件或者备份文件中的信息。

其中提供两个强大的工具:日志分析浏览,对象恢复。

具体功能如下:➢日志文件浏览➢数据库变更审查➢计划和授权变更审查➢将日志记录导出到文件或者数据库表➢实时监控数据库事物➢计算并统计负荷➢通过有选择性的取消或者重做事物来恢复数据➢恢复被截断或者删除表中的数据➢运行SQL脚本二、安装LogExplore包含两部分:➢客户端软件➢服务器代理服务器端代理是保存在SQLServer主机中的一个只读存储过程,他的作用是接受客户端请求,读取在线事物日志块并通过网络传给客户端软件,由客户端软件来读取这些原始的数据块来完成Log Explore所提供的所有功能。

他依赖来的网络协议包括:➢Named Pipe:局域网中适用➢Tcp/Ip:广域网中适用此软件是C/S模式,在MSSQL服务器上安装服务端,客户端可以安装在需要的地方。

三、使用说明3.1连接数据库双击Log Explore,出现的软件界面点击左上框的Attach Log File,进入连接数据库界面注意:选择你需要查看的数据库名,以及选择是使用在线的日志还是使用备份的文件进行分析。

成功连接到数据库后,会出现一个警告,按确定。

3.2功能说明Log Summary:日志文件的概要信息。

Load Analysis:列出指定时间范围内的一些事物,用户和表载入的概要信息。

Filter Log Record:日志过滤设置。

log file highlighter 使用

文章主题:log file highlighter 使用1. log file highlighter 是一个用于高亮显示日志文件中特定关键词的工具,它能够帮助用户更快速、准确地定位和分析日志中的重要信息。

在本文中,我们将探讨 log file highlighter 的使用方法以及其在日常工作中的重要性。

2. log file highlighter 的使用方法1) 用户需要下载并安装 log file highlighter 工具,可以到官方全球信息湾或者软件商店进行下载安装。

2) 安装完成后,打开 log file highlighter,并选择要打开的日志文件。

3) 在工具的设置中,用户可以添加需要高亮显示的关键词,例如异常错误信息、特定业务关键词等。

4) 确定设置后,工具会自动对日志文件进行扫描,并在界面上以不同的颜色高亮显示出关键词,帮助用户轻松识别并分析重要信息。

3. log file highlighter 的重要性log file highlighter 能够大大提高日志分析的效率,让用户能够更快速、准确地定位到日志中的关键信息,从而加快故障定位和排查的速度。

在大型系统或者复杂业务场景下,日志文件往往非常庞大,要手动逐行分析将耗费大量时间和精力,而使用 log file highlighter 则可以快速定位到关键信息,提高工作效率。

4. 个人观点和使用体验在我的日常工作中,我经常需要处理各种日志文件来分析系统运行情况和排查问题。

使用了 log file highlighter 后,我发现工作效率得到了明显提高,能够更快速地定位到异常信息,并且不容易遗漏重要的日志记录。

我认为 log file highlighter 是一款非常实用的工具,能够有效提升工作效率和准确性。

5. 总结log file highlighter 是一款针对日志文件的高亮显示工具,能够帮助用户更快速、准确地定位和分析日志中的重要信息,提高工作效率。

loggenerator 使用指南

loggenerator 使用指南一、简介loggenerator 是一个用于生成日志文件的工具,可以帮助开发人员和系统管理员模拟生成各种类型的日志,以测试和评估日志管理系统的性能和可靠性。

本篇文章将为您介绍如何正确使用loggenerator 工具。

二、安装和配置1. 下载 loggenerator 工具并解压缩到指定目录。

2. 配置loggenerator 工具的参数,包括日志生成的数量、日志文件的大小、生成日志的频率等。

三、使用方法1. 打开命令行终端窗口,进入 loggenerator 工具所在的目录。

2. 输入命令loggenerator,按下回车键,即可开始生成日志文件。

3. 根据loggenerator 提示,选择需要生成的日志类型,例如系统日志、应用日志、安全日志等。

4. 根据loggenerator 提示,输入生成日志的数量、日志文件的大小、生成日志的频率等参数。

5. 等待 loggenerator 完成日志生成过程。

四、注意事项1. 在使用loggenerator 之前,请确保您已经了解日志管理系统的相关知识,并具备一定的日志分析和处理能力。

2. 请谨慎选择日志生成的数量和日志文件的大小,以免给系统带来过大的负担。

3. 在生成日志的过程中,请确保您的系统具备足够的存储空间,以防止日志文件过大导致系统磁盘空间不足。

4. loggenerator 工具仅用于模拟生成日志,不具备实际的日志收集和分析功能,您还需要使用其他工具来完成这些任务。

五、常见问题解答1. Q: loggenerator 工具可以生成哪些类型的日志?A: loggenerator 工具可以生成系统日志、应用日志、安全日志等多种类型的日志。

2. Q: loggenerator 工具是否支持自定义日志格式?A: 是的,loggenerator 工具支持自定义日志格式,您可以根据实际需求进行配置。

3. Q: loggenerator 工具是否支持多线程生成日志?A: 是的,loggenerator 工具支持多线程生成日志,可以提高生成效率。

LOG工具及驱动安装操作说明_Android 5.1

展讯9830平台LOG工具驱动安装操作说明◆外场测试完整的log抓取:使用CHANNELSERVER工具连接Logel_for_TD保存arm log和DSPLOGGER保存DSP log,SLOG(不勾选modem)保存SLOG,总计3份LOG,SLOG通过Log4Android2PCv2.3.4工具导出。

(如果因为特殊原因,SLOG无法通过工具导出,可以通过T卡直接把SLOG拷贝到PC)。

外场测试务必勾选CAP LOG。

◆注意事项:开始抓取LOG前手机、PC的时间需要调节到当前系统时间,精确在3秒内。

发现异常后,在30秒之后再开始保存log,避免出现异常马上断开导致log信息打印不全。

1、驱动安装及环境配置1.1 安装DriverCoding驱动时,双击“install.exe”依次点击下一步、完成。

2、SLOG抓取说明2.1将Log4Android2PCv2.3.4压缩包解压到不带空格的文件目录,手机开启USB调试;注:Log4Android2PCv2.3.4文件夹建议存放在“D盘根目录”,放的路径比较深或有中文目录的文件夹,发现会概率性弹掉2.2抓取Slog,需保证SD卡有足够的空间。

当Android、ARM、DSP都抓取时,一般一小时抓取约300M左右log,建议SD卡达到8G或者8G以上。

2.3如果Logel工具和Slog都打开时,需关闭Slog中的Modem log开关,通过PC端在线抓取Modem log2.4拨号盘输入*#*#83781#*#*->DEBUG&LOG->Slog点击右上角的设置菜单后进入Modem Log Settings设置项,Log输出方式设置为PC抓取,开启ARM Log、CP2 Log、CAP Log,DSP options设置为ARM COM_DEBUG;如下图设置。

2.5返回上层,进入Slog UI->勾选Android Log,如下图设置。

loglog使用方法

loglog使用方法使用loglog进行数据可视化分析一、简介loglog是一种常用的数据可视化工具,它可以帮助我们更好地理解数据的分布和趋势,特别是对于呈现指数增长的数据非常有用。

在本文中,我们将介绍loglog的使用方法,以及一些常见的应用场景和技巧。

二、安装和准备工作首先,我们需要安装Python的科学计算库matplotlib。

在命令行中输入以下命令进行安装:pip install matplotlib安装完成后,我们可以导入matplotlib并设置loglog作为默认的数据可视化模式:import matplotlib.pyplot as pltplt.xscale('log')plt.yscale('log')三、绘制简单的loglog图为了演示loglog的使用方法,让我们创建一个简单的示例。

假设我们有一个数列,它的每个元素都是前一个元素的2倍。

我们可以使用numpy 库生成这个数列:import numpy as npdata = np.logspace(start=1, stop=10, num=100, base=2)接下来,我们可以使用loglog函数绘制这个数列的loglog图:plt.loglog(data)plt.show()运行以上代码,我们将看到一个loglog图形窗口弹出,展示了数据的分布情况。

在log-log坐标系下,数据点的位置将根据其值进行相应的调整。

四、添加标签和标题在loglog图中,我们通常需要添加标签和标题以帮助读者更好地理解和解释数据。

我们可以通过调用plt.xlabel()、plt.ylabel()和plt.title()函数来添加这些元素:plt.loglog(data)plt.xlabel('Index')plt.ylabel('Value')plt.title('Log-Log Plot')plt.show()使用这些函数,我们可以在图中添加X轴和Y轴的标签,并在图的顶部添加一个标题。

loguru用法详解

loguru用法详解Loguru是一个Python的日志库,提供了简单、快速和灵活的日志记录功能。

以下是Loguru的用法详解:1.安装Loguru:可以通过pip安装Loguru,使用以下命令进行安装:pip install loguru2.导入Loguru模块:在Python脚本中,使用以下代码导入Loguru模块:pythonfrom loguru import logger3.创建日志记录器对象:使用logger关键字创建一个日志记录器对象。

例如:pythonlogger = logger.create("my_logger")4.记录日志:使用logger对象的方法来记录不同级别的日志。

Loguru支持以下级别的日志:debug、info、warning、error和critical。

例如,使用以下代码记录debug级别的日志:pythonlogger.debug("This is a debug message")5.配置日志输出:Loguru支持将日志输出到不同的目标,如控制台、文件等。

可以使用logger.add()方法添加输出目标。

例如,将日志输出到控制台:pythonlogger.add(sys.stdout)也可以将日志输出到文件,例如:pythonlogger.add("my_log_file.log")6.配置日志格式:Loguru允许自定义日志格式,以便更好地呈现日志信息。

可以使用logger.add()方法的format参数来设置日志格式。

例如:pythonlogger.add(sys.stdout, format="{time} {level} {message}")7.日志旋转:Loguru支持日志旋转,以便在日志文件达到一定大小时自动切割日志文件。

可以使用logger.add()方法的rotation参数来配置日志旋转。

log parser的用法

log parser的用法Log Parser的用法Log Parser是一款实用性较强的日志分析工具,主要用于处理生成的各类日志文件,在Windows平台下有广泛的应用,可以通过LogParser查询、分析和格式化各种日志文件,包括IIS日志、事件日志、XML日志、CSV等格式的数据。

以下是Log Parser的用法:1.安装Log Parser首先需要在Windows系统中安装Log Parser,可以从微软官网下载最新版本的Log Parser。

安装完成后,可以使用命令行界面或者运行Log Parser Studio来使用它的核心功能。

2.查询日志文件Log Parser支持查询各种格式的日志文件,比如IIS日志文件。

例如,查询IIS的日志文件。

以下是基本语法:```sqlLogParser.exe -i:iisw3c "SELECT TOP 10 date, time, c-ip, cs-method, cs-uri-stem, sc-status FROM ex*.log"```3.处理日志文件Log Parser提供了丰富的日志文件处理功能,可以非常方便地进行各种操作,比如对日志文件进行排序、筛选、统计、分组等。

例如,统计访问IP地址最多的前10个IP地址:```sqlLogParser "SELECT TOP 10 COUNT(c-ip),c-ip AS Address FROMex*.log GROUP BY c-ip Order By COUNT(*) DESC" -i:iisw3c -o:datagrid```4.格式化日志文件Log Parser还可以将日志文件导出成CSV、XML、HTML等格式,方便进行操作和分析。

例如,将IIS的日志文件导出为CSV格式:```sqlLogParser "SELECT TO_LOCALTIME(TO_TIMESTAMP(date, time)), s-ip, cs-method, cs-uri-stem, sc-status INTOC:\Logs\results.csv FROM ex*.log" -i:IISW3C -o:CSV```总结通过Log Parser的功能,可以轻松处理各种格式的日志文件,理解现有的日志中所包含的信息,并进行有效地查询和分析,这对于运维人员和开发人员来说是一种非常实用的工具。

LogExplorer教程

数据库恢复神器--Log Explorer 4.2使用教程介绍Log Explorer主要用于对MSSQLServer的事务分析和数据恢复。

可以浏览日志、导出数据、恢复被修改或者删除的数据(包括执行过update,delete,drop和truncate语句的表格)。

一旦由于系统故障或者人为因素导致数据丢失,它能够提供在线快速的数据恢复,最大程度上保证恢复期间的其他事务不间断执行。

他可以支持SQLServer7.0和SQLServer2000以及SQLServer2005.提取标准数据库的日志文件或者备份文件中的信息。

软件下载地址:/c0ojf3kule主要功能:其中提供两个强大的工具:日志分析浏览,对象恢复。

具体功能如下:●日志文件浏览●数据库变更审查●计划和授权变更审查●将日志记录导出到文件或者数据库表●实时监控数据库事务●计算并统计负荷●通过有选择性的取消或者重做事务来恢复数据●恢复被截断或者删除表中的数据运行SQL脚本LogExplore包含两部分1、客户端软件2、服务器代理服务器端代理是保存在SQLServer主机中的一个只读存储过程,他的作用是接受客户端请求,读取在线事务日志块并通过网络传给客户端软件,由客户端软件来读取这些原始的数据块来完成Log Explore所提供的所有功能。

他依赖来的网络协议包括:1、Named Pipe:局域网中适用2、Tcp/Ip:广域网中适用数据库相关介绍事务日志(Transaction Log)SQLServer的每个数据库都包含事务日志,它以文件的形式存储,可以记录数据库的任何变化。

发生故障时SQLServer就是通过它来保证数据的完整性。

操作(Operation)操作是数据库中定义的"原子行为",每个操作都在日志文件中保存为一条记录。

它可以是用户直接输入的SQL语句,比如标准的insert 命令,日志文件中便会记录一条操作代码来标志这个insert操作。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

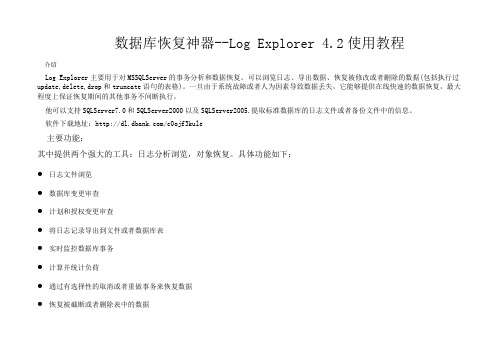

数据库恢复神器--Log Explorer 4.2使用教程介绍

Log Explorer主要用于对MSSQLServer的事务分析和数据恢复。

可以浏览日志、导出数据、恢复被修改或者删除的数据(包括执行过update,delete,drop和truncate语句的表格)。

一旦由于系统故障或者人为因素导致数据丢失,它能够提供在线快速的数据恢复,最大程度上保证恢复期间的其他事务不间断执行。

他可以支持SQLServer7.0和SQLServer2000以及SQLServer2005.提取标准数据库的日志文件或者备份文件中的信息。

软件下载地址:/c0ojf3kule

主要功能:

其中提供两个强大的工具:日志分析浏览,对象恢复。

具体功能如下:

●日志文件浏览

●数据库变更审查

●计划和授权变更审查

●将日志记录导出到文件或者数据库表

●实时监控数据库事务

●计算并统计负荷

●通过有选择性的取消或者重做事务来恢复数据

●恢复被截断或者删除表中的数据

运行SQL脚本

LogExplore包含两部分

1、客户端软件

2、服务器代理

服务器端代理是保存在SQLServer主机中的一个只读存储过程,他的作用是接受客户端请求,读取在线事务日志块并通过网络传给客户端软件,由客户端软件来读取这些原始的数据块来完成Log Explore所提供的所有功能。

他依赖来的网络协议包括:

1、Named Pipe:局域网中适用

2、Tcp/Ip:广域网中适用

数据库相关介绍

事务日志(Transaction Log)

SQLServer的每个数据库都包含事务日志,它以文件的形式存储,可以记录数据库的任何变化。

发生故障时SQLServer就是通过它来保证数据的完整性。

操作(Operation)

操作是数据库中定义的"原子行为",每个操作都在日志文件中保存为一条记录。

它可以是用户直接输入的SQL语句,比如标准的insert 命令,日志文件中便会记录一条操作代码来标志这个insert操作。

事务(Transaction)

事务是一系列操作组成的序列。

他可以理解为直观的不可分割的一笔业务,可以执行成功或者失败。

典型的事务比如由应用程序发出的具有开启-提交功能的一组SQL语句。

不同的事务靠事务Id号(transaction ID)来区分,具有相同ID的事务记录的日志也相同。

在线事务日志(Online Transaction Log)

在线事务日志是指当前活动数据库所用的日志。

可以通过如下命令来确定其对应文件

Select * from SYSFILES

他的文件后缀名一般是.LDF

离线事务日志(Offline Transaction Log)

离线事务日志是指非活动数据库所用的日志。

当其数据库处于关闭(ShutDown)才状态下可以进行复制备份操作。

他的结果同在线事务日志完全相同。

备份文件

备份文件是保存食物日志备份的文件,通常管理员通过运行SQL语句或者企业管理器来生成该文件。

备份文件的内部结构和事务日志不同,他采用称为MTF的格式来保存数据。

一个备份文件可以包含一个日志的多组备份,甚至包括多个数据库的混合备份.

一、Log Explorer的安装

运行安装包内Intel文件夹内的Setup.exe文件,如图1-1

图1-1

可以选择安装客户端和服务器端,服务器端必选安装在服务器上。

点击【下一步】如图1-2

图1-2 输入注册码,点击【下一步】如图1-3

图1-3 选择安装位置,点击【下一步】如图1-4

图1-4

选择要安装服务器端的计算机,点击【下一步】进行安装。

完成后依次点击【开始】→【程序】→【Lumigent】→【Log Explorer for SQL Server】→【Log Explorer】打开Log Explorer如图1-5

图1-5

点击左边菜单栏中的【附加日志文件】或者点击【文件】→【附加日志文件】打开连接数据库窗口,如图1-6

图1-6

选择要连接的数据库及登录方式(数据库需安装Log Explorer服务器端),然后点击【连接】连接成功后湖出现选择数据库界面,如图1-6

图1-6

选择要连接的数据库,然后选择要打开的日志,可以使用在线日志也可以使用备份日志文件,点【附加】附加成功后会出现如图1-7界面

图1-7

一、删除的恢复操作:

先通过SQL语句在test数据库中新建一个表,此时表为8495行,如图2-1。

执行delete语句进行删除,删除109行如图2-2

图2-1

打开log explorer,并连接到test数据库,打开查看日志拉到最下面可以看到刚才删除操作的信息如图2-3

右键单击该行选择撤销事务,会生成撤销事务的脚本,如图2-4.复制该脚本到查询分析器中,并执行结果如图2-5、2-6,数据完整的恢复了

图2-4

图2-5

图2-6 用上述方法同样可以恢复UPDATE,和INSERT引起的数据库改变

二、数据库表删除的恢复操作

执行如下删除语句如图3-1

图3-1打开【查看DDL命令】点击【刷新】图标如图3-2

图3-2

找到删除表的记录并单击选定,然后点击下面的【挽救】成功后会显示如图3-3界面

图3-3

然后将通过【运行SQL命令】功能执行该脚本,成功执行后(失败为0)在查询分析器中就可以查到刚删除的表已经完全恢复如图3-4,3-5。

图3-4

图3-5

也可以通过【从备份恢复表】的功能来找回删除的表,在输入表名和选择备份的文件后点击【创建】就可生成恢复被删除表的脚本如图3-6

图3-6

log explorer使用的几个问题

1、对数据库做了完全差异和日志备份

备份时选用了删除事务日志中不活动的条目

再用Log explorer打试图看日志时

提示No log recorders found that match the filter,would you like to view unfiltered data

选择yes 就看不到刚才的记录了

如果不选用了删除事务日志中不活动的条目

再用Log explorer打试图看日志时,就能看到原来的日志

2、修改了其中一个表中的部分数据,此时用Log explorer看日志,可以作日志恢复

3、然后恢复备份,(注意:恢复是断开log explorer与数据库的连接,或连接到其他数据上,

否则会出现数据库正在使用无法恢复)

恢复完后,再打开log explorer 提示No log recorders found that match the filter,would you like to view unfiltered data 选择yes 就看不到刚才在2中修改的日志记录,所以无法做恢复.

4、撤销UPDATE操作时生成的脚本是先删除更新的行然后再插入,所以要把跟该表相关的所有约束用nocheck暂时关闭后再执行脚本

5、数据的恢复越早越好这个软件的可靠性还是很高的,我试过update九万行数据,它都完全的把修改过的给撤销回来了

6、误删除表时用【查看DDL命令】中的【挽救】功能比其他方法更方便些

7、数据库较大时查询和恢复会很慢

8、数据无价,操作需谨慎!

每个日志记录包含一个操作代码,操作代码表示日志的操作

FORMAT_PAGE--写新分配数据页的表头

INSET_ROWS--在用户表或系统表插入行

DELETE_ROWS-从表里删除行

MODIFY_ROW--使用Update命令更新行

MODIFY_HEADER--SQLSERVER分配新数据页,初始化页表头MODIFY_COLUMNS--使用Update命令更新行

DELTA_SYSIND--SYSINDEXES系统表被修改

DELETE_SPLIT--行移动到新物理页,并从原物理页删除这些行FILE_HDR_MODIF--SQLSERVER增长数据文件大小

BEGIN_XACT--启动一个事务

COMMIT_XACT--提交一个事务

ABORT_XACT--回滚一个事务

MARK_SAVEPOINT--程序发布'SAVE TRANSACTION'命令

MARK_DLL--表结构被修改

BEGIN_CKPT--启动一个检查点

XACT_CKPT--在执行检查点时打开事务

END_CKPT--执行完检查点

SORT_BEGIN--创建索引时执行排序。