K_近邻分类算法的研究及实现

基于K近邻的分类算法研究

基于K近邻的分类算法研究K近邻(K-Nearest Neighbors)算法是一种常见的分类算法,它基于样本的特征相似性进行分类。

该算法的基本思想是,对于一个新的样本点,根据其与已知样本的距离,找出距离最近的K个已知样本,然后通过对这K个样本的分类情况进行统计,来对新样本进行分类。

K近邻算法的主要优点是简单、易于理解和实现,同时具有较好的分类效果。

然而,K近邻算法也存在一些缺点,包括计算复杂度高、对离群点敏感等。

因此,在应用K近邻算法时需要注意调整参数,并在数据预处理中去除异常值。

K近邻算法的步骤如下:1.计算样本之间的相似度:通常使用欧几里得距离或曼哈顿距离来计算样本之间的相似度。

样本间距离越小,相似度越高。

2.选择K值:K值是指在计算距离最近的K个样本时所选择的集合大小。

选择一个合适的K值非常重要,不同的K值会对分类结果产生影响。

3.找出K个最近的样本:根据已有样本与新样本的距离计算结果,找出距离最近的K个样本点,可以使用排序算法(如快速排序)来实现。

4.统计K个样本中的类别:统计在K个最近的样本中各个类别出现的频率,选择出现次数最多的类别作为新样本的类别。

5.进行分类:将新样本分类到出现频率最高的类别中。

K近邻算法的性能受到两个主要因素的影响:距离度量和K值的选择。

合适的距离度量方式和K值的选择能够显著提高算法的分类准确性。

然而,在处理大规模数据时,K近邻算法的计算复杂度较高,因为它需要对每个测试样本计算其与所有训练样本之间的距离。

为了降低计算复杂度,可以采用一些优化方法,如KD树、Ball树等。

在实际应用中,K近邻算法被广泛应用于文本分类、图像识别、推荐系统等领域。

例如,在推荐系统中,可以根据用户的兴趣领域和已有用户的行为数据,找出与一些用户兴趣相似的K个邻居用户推荐相应的商品。

总之,K近邻算法是一种简单、易于理解和实现的分类算法,它通过寻找样本之间的相似性来进行分类。

然而,该算法也存在一些缺点,需要在实际应用中合理调整参数,并对数据进行预处理,以提高分类效果。

k-近邻算法梳理(从原理到示例)

k-近邻算法梳理(从原理到⽰例)https:///kun_csdn/article/details/88919091k-近邻算法是⼀个有监督的机器学习算法,k-近邻算法也被称为knn算法,可以解决分类问题。

也可以解决回归问题。

本⽂主要内容整理为如下:knn算法的原理、优缺点及参数k取值对算法性能的影响;使⽤knn算法处理分类问题的⽰例;使⽤knn算法解决回归问题的⽰例;使⽤knn算法进⾏糖尿病检测的⽰例;1 算法原理knn算法的核⼼思想是未标记样本的类别,由距离其最近的k个邻居投票来决定。

具体的,假设我们有⼀个已标记好的数据集。

此时有⼀个未标记的数据样本,我们的任务是预测出这个数据样本所属的类别。

knn的原理是,计算待标记样本和数据集中每个样本的距离,取距离最近的k个样本。

待标记的样本所属类别就由这k个距离最近的样本投票产⽣。

假设X_test为待标记的样本,X_train为已标记的数据集,算法原理的伪代码如下:遍历X_train中的所有样本,计算每个样本与X_test的距离,并把距离保存在Distance数组中。

对Distance数组进⾏排序,取距离最近的k个点,记为X_knn。

在X_knn中统计每个类别的个数,即class0在X_knn中有⼏个样本,class1在X_knn中有⼏个样本等。

待标记样本的类别,就是在X_knn中样本个数最多的那个类别。

1.1 算法优缺点优点:准确性⾼,对异常值和噪声有较⾼的容忍度。

缺点:计算量较⼤,对内存的需求也较⼤。

1.2 算法参数其算法参数是k,参数选择需要根据数据来决定。

k值越⼤,模型的偏差越⼤,对噪声数据越不敏感,当k值很⼤时,可能造成⽋拟合;k值越⼩,模型的⽅差就会越⼤,当k值太⼩,就会造成过拟合。

1.3 变种knn算法有⼀些变种,其中之⼀是可以增加邻居的权重。

默认情况下,在计算距离时,都是使⽤相同权重。

实际上,可以针对不同的邻居指定不同的距离权重,如距离越近权重越⾼。

K近邻分类算法范文

K近邻分类算法范文K近邻(K Nearest Neighbors,KNN)分类算法是一种基本的机器学习算法,用于解决分类问题。

它是一种非参数算法,可以用于处理离散和连续型特征的数据集。

本文将详细介绍KNN算法的原理、步骤和算法的优缺点。

一、KNN算法原理1.计算距离:对于新样本,需要与训练集中每个样本计算距离。

常用的距离度量方法有欧式距离、曼哈顿距离和闵可夫斯基距离等。

2.选择K个最近邻居:根据距离选择K个最近邻居。

K的选择是一个重要参数,通常通过交叉验证来确定。

4.输出分类结果:将新样本标记为投票结果的类别。

二、KNN算法步骤KNN算法的步骤如下:1.数据预处理:对训练集进行数据预处理,包括特征标准化、缺失值处理和离散特征转换等。

2.特征选择:通过统计分析、特征重要性评估等方法选择合适的特征。

3.计算距离:对于新样本,计算它与训练集中每个样本的距离。

4.选择最近邻:根据距离选择K个最近邻居。

6.进行预测:将新样本标记为投票结果的类别。

7.模型评估:使用评估指标(如准确率、召回率和F1分数等)评估模型性能。

三、KNN算法的优缺点KNN算法具有以下优点:1.简单易理解:KNN算法的原理直观简单,易于理解和实现。

2.无假设:KNN算法不需要对数据做任何假设,适用于多种类型的数据。

3.非参数模型:KNN算法是一种非参数学习算法,不对数据分布做任何假设,适用于复杂的数据集。

KNN算法也有以下缺点:1.计算复杂度高:KNN算法需要计算新样本与训练集中所有样本的距离,计算复杂度较高,尤其是在大数据集上。

2.内存开销大:KNN算法需要保存整个训练集,占用内存较大。

3.对数据特征缩放敏感:KNN算法对特征缩放敏感,如果特征尺度不同,可能会导致距离计算不准确。

四、总结KNN算法是一种简单而有效的分类算法,适用于多种类型的数据。

通过计算新样本与训练集中所有样本的距离,并选择最近的K个邻居进行投票决策,可以得到新样本的分类结果。

机器学习经典分类算法——k-近邻算法(附python实现代码及数据集)

机器学习经典分类算法——k-近邻算法(附python实现代码及数据集)⽬录⼯作原理存在⼀个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每⼀数据与所属分类的对应关系。

输⼊没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进⾏⽐较,然后算法提取样本集中特征最相似数据(最近邻)的分类特征。

⼀般来说,我们只选择样本数据集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不⼤于20的整数。

最后选择k个最相似数据中出现次数最多的分类,作为新数据的分类。

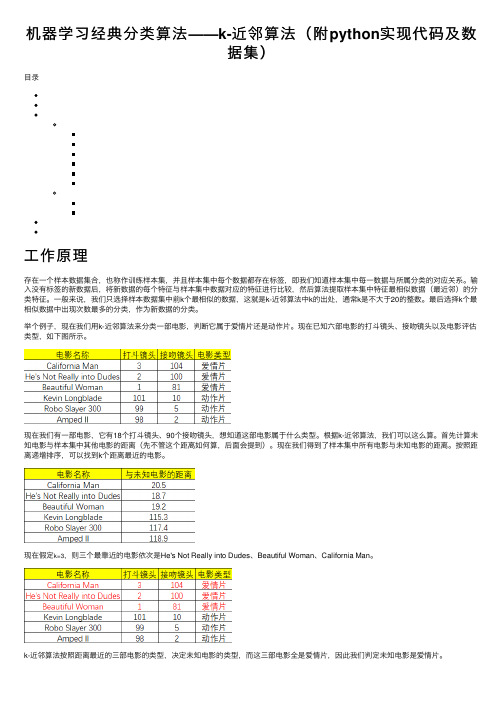

举个例⼦,现在我们⽤k-近邻算法来分类⼀部电影,判断它属于爱情⽚还是动作⽚。

现在已知六部电影的打⽃镜头、接吻镜头以及电影评估类型,如下图所⽰。

现在我们有⼀部电影,它有18个打⽃镜头、90个接吻镜头,想知道这部电影属于什么类型。

根据k-近邻算法,我们可以这么算。

⾸先计算未知电影与样本集中其他电影的距离(先不管这个距离如何算,后⾯会提到)。

现在我们得到了样本集中所有电影与未知电影的距离。

按照距离递增排序,可以找到k个距离最近的电影。

现在假定k=3,则三个最靠近的电影依次是He's Not Really into Dudes、Beautiful Woman、California Man。

python实现⾸先编写⼀个⽤于创建数据集和标签的函数,要注意的是该函数在实际⽤途上没有多⼤意义,仅⽤于测试代码。

def createDataSet():group = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]])labels = ['A','A','B','B']return group, labels然后是函数classify0(),该函数的功能是使⽤k-近邻算法将每组数据划分到某个类中,其伪代码如下:对未知类别属性的数据集中的每个点依次执⾏以下操作:(1)计算已知类别数据集中的点与当前点之间的距离;(2)按照距离递增次序排序;(3)选取与当前点距离最⼩的k个点;(4)确定前k个点所在类别的出现频率;(5)返回前k个点出现频率最⾼的类别作为当前点的预测分类。

K-近邻算法

K-近邻算法目录一、K-近邻算法优缺点二、K.近邻算法工作原理及示例三、K-近邻算法的一般流程四、准备:使用Python导入数据通实施kNN分类算法六、示例L改进约会网站的配对结果七:示例2:手写识别系统K-近邻算法优缺点简单地说,K.近邻算法(又称KNN)采用测量不同特征值之间的距离方法进行分类。

其优缺点及适用数据范围如下:优点:精度高、对异常值不敏感、无数据输入假定。

缺点:计算复杂度高、空间复杂度高。

适用数据罐;数值型和标称型。

示例:手写识别系统3.测试算法:之前我们将数据处理成分类器可以识别的格式,现在我们将这些数据输入到分类器,检测分类器的执行效果。

def handwritingClassTest():hwLabels=[]trainingFileList=listdirCtrainingDigits*)#获取目录中的文件内容存储于列表中m=len(trainingFileList)trainingMat=zeros((m,1024))for i in range(m):fileNameStr二traininTFileList【ilfileStr二fileNameStr・split(?H01tftake off・txta trainingMat[i/]=i mg2vector('tra i n i ng Digits/%s,%fileNameStr)dassNumStr二int(fileStr・split(''HOI)#从文件名解析分类数字hwLabels.append(classNumStr)testFileList=listdir('testDigits')iterate through the test seterrorCount=0.0mTest=len(testFileList)for i in range(mTest):fileNameStr=testFileList[i]fileStr=fileNameStr.split('.')[O]#take off.txtclassNumStr=int(fileStr.split('_')vectorUnderTest=img2vector('testDigits/%s'%fileNameStr)classifierResult=classify Of^ectorUnderTest,trainingMat,hwLabels,3)print"the classifier came back with:%d,the real answer is:%d"%(classifierResult,classNumStr)if(classifierResult!=classNumStr):errorCount+=1.0print"\nthe total number of errors is:%d"%errorCountprint”\nthe total error rate is:%f"%(errorCount/float(mTest))示例:手写识别系统(2)上述代码所示的自包含函数handwritingClassTest。

k-近邻分类算法

k-近邻分类算法K近邻分类算法是一种基于实例的分类算法,它的主要思想是通过计算每个样本点与其周围的k个最近邻点的距离来确定该点的类别。

该算法主要应用于分类问题中,并且在实际应用过程中具有很好的可用性、易实现性和理解性。

算法原理算法首先通过确定k值来确定分类的邻域大小,以及根据k值的选择来确定分类的准确性和鲁棒性。

之后通过计算每个样本点与其邻域内k个最近邻点之间的距离来确定该样本点所属的分类。

具体流程如下:1.确定数据集中的k值和距离度量标准;2.对于每个待分类的样本点,计算与其邻域中k个最近邻点之间的距离;3.根据邻域中k个最近邻点的类别来确定该样本点所属的类别;4.重复步骤2和3,直到所有待分类的样本点均被分类完毕;5.给出分类结果。

距离度量标准在k-近邻分类算法中,距离度量标准是非常重要的,因为它决定了样本点之间距离的计算方式。

目前常见的距离度量标准有欧式距离、曼哈顿距离和切比雪夫距离。

欧式距离:$d=\sqrt{{\sum_{i=1}^{n}{(x_i-y_i)^2}}}$优缺点1.基于实例,不需要对数据进行任何假设和理论分析;2.算法的可预测性高,具有很好的分类性能;3.没有过拟合的现象,可以对复杂的数据集进行分类;4.整体而言,k-近邻分类算法非常容易理解和实现。

1.计算量比较大,对于大型数据集而言,算法的效率较低;2.对于高维数据集而言,容易出现维数灾难问题,即算法的效果会逐渐降低;3.容易受到异常值的影响,且在分类决策区域方面可能存在不连续的问题。

应用场景k-近邻分类算法广泛应用于模式识别、数据挖掘和生物信息学等领域,特别适合处理较小的数据集。

目前该算法已被应用于医疗诊断、电子商务、物联网等领域,既可以用于分类问题,也可以用于回归问题。

同时,对于分类问题而言,该算法并不适用于类别数比较多或类别间存在相互交叉的情况。

因此,在实际应用过程中,应根据具体情况来选择算法,以达到最佳的分类效果。

人工智能实验-k-近邻算法

k-近邻算法一、 实验题目1. kNN 代码实现-AB 分类采用测量不同特征值之间的距离方法进行分类,用所给的函数创建具有两个特征与一个标签类型的数据作 为训练集,编写 classify0 函数对所给的数据进行 AB 分类。

2. k-近邻算法改进约会网站的配对效果k-近邻算法改进约会网站的配对效果通过收集的一些约会网站的数据信息,对匹配对象的归类:不喜欢的人、魅力一般的人、极具魅力的人。

数据中包含了 3 种特征:每年获得的飞行常客里程数、玩视频游戏所耗时间百分比、每周消费的冰淇淋公升数二、 实验代码1. kNN 代码实现-AB 分类kNN from http.client import ImproperConnectionStatefrom numpy import ∗ from collections importCounter import operator def createDataSet():group = array([[1.0, 1.1], [1.0, 1.0], [0, 0], [0, 0.1]])labels = [’A ’, ’A ’, ’B’, ’B’] return group, labelsdef classify0(inX, group, labels, k = 3):res1 = (inX − group)∗∗2 dist =res1[:,0] + res1[:,1] dic = argsort(dist) dic = dic[0:k:1] newdic = [] for i in range (k): newdic.append(labels[dic[i]]) c = Counter(newdic).most_common(1) return c[0][0] tests import kNN group, lables = kNN.createDataSet() print (’分类结果’) print (’[0,0] %c’ %(kNN.classify0([0, 0], group, lables, k = 3))) print (’[0.8,0.7] %c’ %(kNN.classify0([0.8, 0.7], group, lables, k = 3)))2.k-近邻算法改进约会网站的配对效果1 2 3 4 5 67 8 910111213141516171819 1 2 3 4 5import pandas as pdimport kNNfrom sklearn.model_selection import train_test_splitdf = pd.read_table(’datingTestSet2.txt’,sep=’\s+’, names = [’A ’, ’B’, ’C’, ’Y’])# 对特征进行归一化处理df2 = df.iloc[:, :3] df2 =(df2−df2.mean())/df2.std() lable=df.iloc[:,3:4] df2.loc[:, ’Y’] =lable# 对数据集进行测试集和训练集划分,90%作为训练集,10%作为测试集X_train, X_test, Y_train, Y_test = train_test_split(df2.iloc[:, :3], df2.Y, train_size=.90)# 将DataFrame 格式转化为numpy 格式处理 group = X_train.values label =Y_train.values length =len (X_test) X_test.iloc[0:1,:]# res 以储存测试结果res = []# 设置错误正确数count 以计算正确率Tnum = 0 Fnum = 0 for iin range (length):inX = X_test.iloc[i:i+1 , :].values res.append(kNN.classify0(inX,group, label, k = 3)) if (kNN.classify0(inX, group, label, k = 3) ==Y_test.values[i]):Tnum += 1 else :Fnum += 1res1 = pd.DataFrame(data = res, columns=[’TestResult’])Y_test.reset_index(inplace=True,drop=True)res1.loc[:, ’OriginTest’] = Y_testprint (’前20个数据测试结果和原数据比较’) print (’−−−−−−−−−−−−−−−−−−−−−——−−−−’) print (res1.head(20))print (’−−−−−−−−−−−−−−−−−−−−−——−−−−’) print (’正确率%.2f%%’ %(100∗Tnum/(Tnum+Fnum))) 三、 实验结果及分析1. kNN 代码实现-AB 分类分类结果[0, 0] B[0.8, 0.7] A2. k-近邻算法改进约会网站的配对效果1 2 3 45 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 2526 27 28 29 3031 32 33 3435363738 1 2 3前20个数据测试结果和原数据比较−−−−−−−−−−−−−−−−−−−−−——−−−TestResult OriginTest0 2 2 1 3 3 2 1 3 3 2 2 4 2 2 5 3 3 6 3 3 7 2 2 8 1 1 9 1 1 10 1 1 11 3 3 12 2 2 13 2 2 14 1 1 15 2 2 16 1 1 17 2 2 18 1 1 19 3 3−−−−−−−−−−−−−−−−−−−−−——−−− 正确率97.00%从实验结果可以看出,通过 k-近邻算法改进后的约会网站的配对效果比较显著,多次随机划分测试集和训练集后发现正确率基本可以达到 90% 以上。

k近邻算法实现红酒数据集分类

K近邻算法实现红酒数据集分类一、引言随着数据科学和机器学习的发展,分类算法在许多领域都得到了广泛的应用。

其中,K近邻算法(KNN,K-Nearest Neighbors)是一种简单且有效的分类算法,它基于实例的学习,通过测量不同数据点之间的距离进行分类。

红酒数据集是一个常用的分类任务,用于测试各种分类算法的性能。

本文将探讨如何使用K近邻算法对红酒数据集进行分类。

二、方法论1.数据预处理:首先,我们需要对红酒数据集进行预处理,包括缺失值填充、异常值处理、特征缩放等步骤,以保证数据的质量和一致性。

2.KNN算法原理:KNN算法是一种基于实例的学习,它通过测量不同数据点之间的距离进行分类。

在KNN中,我们选择距离最近的K个邻居,并根据这些邻居的类别进行投票,多数投票决定该数据的类别。

3.实现流程:首先,我们需要将数据集分成训练集和测试集。

然后,使用训练集对KNN算法进行训练,并确定最佳的K值。

最后,使用测试集对算法进行测试,评估其分类性能。

4.性能评估:使用准确率、召回率、F1分数等指标对KNN算法在红酒数据集上的分类性能进行评估。

三、红酒数据集红酒数据集是一个常用的分类任务,它包含了178个样本,每个样本有13个特征(如醇类、苹果酸、柠檬酸等)和一个标签(表示葡萄酒的种类)。

目标是通过分析葡萄酒的特征,将其分为三个类别:红葡萄酒、白葡萄酒和其他类型的葡萄酒。

四、KNN算法KNN算法是一种基于实例的学习,它通过测量不同数据点之间的距离进行分类。

具体来说,对于一个新的样本,KNN算法会在训练集中找到与该样本距离最近的K个邻居,并根据这些邻居的类别进行投票,多数投票决定该样本的类别。

在KNN中,我们通常使用欧氏距离或曼哈顿距离来测量不同数据点之间的距离。

五、实现与结果分析1.数据预处理:首先,我们对红酒数据集进行预处理,处理缺失值和异常值,并进行特征缩放。

这一步的目的是保证数据的质量和一致性,以提高分类的性能。

近邻分类算法设计与实现

近邻分类算法设计与实现近邻分类算法是一种基本的监督学习算法,它通过计算待分类样本与训练样本之间的距离来确定其类别。

在本文中,我们将探讨近邻分类算法的设计原理和实现方法。

一、算法原理近邻分类算法的核心思想是“近朱者赤,近墨者黑”,即认为待分类样本的类别与其最近的训练样本的类别相同。

基于此思想,近邻分类算法的设计原理如下:1. 计算距离:首先,需要定义样本之间的距离度量方式。

常用的度量方法包括欧氏距离、曼哈顿距离和余弦相似度等。

根据具体问题的特点选择合适的距离度量方法。

2. 选择邻居:对于每个待分类样本,计算其与训练样本的距离,并选择距离最近的K个样本作为其邻居。

K是一个预先设定的参数,通常通过交叉验证来确定。

3. 确定类别:根据K个邻居的类别,通过投票或加权投票的方式来确定待分类样本的类别。

投票方式可以是简单多数表决,也可以根据邻居与待分类样本的距离进行加权。

二、算法实现近邻分类算法的实现主要包括以下几个步骤:1. 数据预处理:对原始数据进行预处理,包括数据清洗、特征选择、特征缩放等。

这些步骤旨在提高分类算法的准确性和效率。

2. 计算距离:根据选择的距离度量方法,计算待分类样本与训练样本之间的距离。

这里可以使用循环遍历的方式逐个计算距离,也可以使用向量化计算的方式提高计算效率。

3. 选择邻居:根据计算得到的距离,选择距离最近的K个邻居。

这里可以使用排序算法来对距离进行排序,然后选择前K个邻居。

4. 确定类别:根据K个邻居的类别,通过投票或加权投票的方式来确定待分类样本的类别。

投票方式可以使用循环遍历的方式统计每个类别的票数,也可以使用numpy库中的函数来实现。

5. 模型评估:使用测试集对分类模型进行评估,计算分类准确率、精确率、召回率等指标。

根据评估结果,可以调整模型参数或选择其他分类算法。

三、算法优化为了提高近邻分类算法的性能,可以考虑以下优化方法:1. 基于KD树的近邻搜索:KD树是一种二叉树结构,可以用于加速近邻搜索过程。

k近邻算法的原理和实现过程

k近邻算法的原理和实现过程

k近邻算法是一种基本的分类和回归算法,它的原理和实现过程如下:

原理:

1. 确定一个样本的k个最近的邻居,即选取与该样本距离最近的k个样本。

2. 根据这k个最近邻居的标签进行投票或者加权,确定该样本的预测标签。

如果

是分类问题,那么选取票数最多的标签作为预测标签;如果是回归问题,那么选

取k个最近邻居的标签的平均值作为预测标签。

实现过程:

1. 准备数据集:收集已知样本和其对应的标签。

2. 确定距离度量准则:选择合适的距离度量准则来度量样本间的距离,例如欧氏

距离、曼哈顿距离等。

3. 选择合适的k值:根据问题的要求选择适当的k值。

4. 计算样本之间的距离:对于每个未知样本,计算它与已知样本之间的距离,选

择k个最近邻居。

5. 统计k个最近邻居的标签:对于分类问题,统计k个最近邻居的标签的出现次数,并选择出现次数最多的标签作为预测标签;对于回归问题,计算k个最近邻

居的标签的平均数作为预测标签。

6. 将样本进行分类或预测:根据预测标签将未知样本进行分类或预测。

需要注意的是,在实际应用中,可以采取一些优化措施来提高k近邻算法的效率,比如使用kd树来加速最近邻搜索过程。

还可以对特征进行归一化处理,以避免

某些特征的权重过大对距离计算的影响。

k近邻分类

k近邻分类k近邻(k-Nearest Neighbors,简称k-NN)是一种常用的监督机器学习算法,常用于分类任务。

它基于一个简单而直观的假设:相似的样本有着相似的标签。

k-NN分类算法会根据输入样本的特征与训练数据集中的样本进行比较,并找出k个最相似的训练样本。

然后,通过这k个样本的标签来确定输入样本的标签。

k-NN分类算法的实现非常简单。

下面我将介绍k-NN算法的工作原理及步骤,以及一些相关的考虑事项。

1. 距离度量:k-NN算法在找出与输入样本最相似的k个样本时,需要通过某种距离度量方法来衡量样本之间的差异。

欧式距离是最常用的度量方法,但也可以使用曼哈顿距离、切比雪夫距离等。

2. 特征选择:在使用k-NN算法之前,需要选择合适的特征来描述样本。

选择合适的特征对分类性能至关重要,因此需要深入理解问题和数据集,以确定最能表征样本的特征。

3. 数据预处理:在应用k-NN算法之前,需要进行数据预处理。

这包括去除重复、缺失或错误的数据,以及对数据进行归一化或标准化操作,以确保输入数据的质量和可比性。

4. 确定k值:在使用k-NN算法时,需要确定k值,即选择最相似的k个样本。

k值的选择直接影响到分类结果。

通常,k值过小会导致模型过于敏感,容易受到噪声的影响;k值过大则可能忽略了样本间的细微差异。

因此,k值的选择需要综合考虑问题的复杂度和数据集的规模。

5. 处理不平衡数据集:在实际应用中,数据集往往存在样本类别之间数量不平衡的情况。

这会导致k-NN算法对多数类别样本的分类效果较好,而对少数类别样本的分类效果较差。

可以采用过采样、欠采样等数据处理方式来解决这个问题。

6. 选择合适的距离度量方法:除了欧式距离等经典的度量方法外,还可以选择其他的距离度量方法来适应不同类型的数据和问题。

尽管k-NN算法在实现上非常简单,但在应用过程中还是需要考虑一些问题。

1. 计算复杂度:k-NN算法的计算复杂度随着训练集的规模线性增长,对于大规模数据集来说,计算开销会很大。

k近邻算法的原理和实现过程 -回复

k近邻算法的原理和实现过程-回复k近邻算法的原理和实现过程。

引言:k近邻算法(k-nearest neighbors, KNN)是一种简单而又常用的机器学习算法。

它属于一种“懒惰学习”方法,也称为基于实例学习。

k近邻算法不需要显式的训练过程,而是通过计算测试样本与训练样本之间的距离,根据距离的近远来判断测试样本的分类。

本文将一步一步地介绍k 近邻算法的原理和实现过程。

第一部分:k近邻算法的原理1.1 简介k近邻算法采用邻近点之间的相似性来进行分类或回归预测。

它的核心思想是“近朱者赤,近墨者黑”,即将待分类的样本赋予与其邻近样本相同的标签。

在进行分类时,k近邻算法通过计算目标样本与训练样本之间的距离,然后选择距离最近的k个样本来进行投票,根据投票结果决定目标样本的分类。

1.2 算法步骤k近邻算法的核心步骤包括以下几个步骤:(1)计算距离:根据不同的距离度量方法(如欧氏距离、曼哈顿距离等),计算目标样本与训练样本之间的距离。

(2)选择邻居:根据距离计算结果,选择距离最近的k个样本作为邻居。

(3)投票机制:根据邻居样本的标签(分类问题)或者邻居样本的数值(回归问题),利用投票或者加权投票的方式来确定目标样本的分类或者预测数值。

(4)分类或回归:根据投票结果确定目标样本的分类或回归预测。

第二部分:k近邻算法的实现过程2.1 数据预处理k近邻算法对数据的预处理工作非常重要,包括数据清洗、特征选择、特征缩放等。

首先,对数据进行清洗,剔除异常值和缺失值。

然后,选择对分类有影响的特征进行特征选择。

最后,对特征进行缩放,以保证不同特征之间的单位不同造成的影响。

2.2 构建模型构建k近邻算法的模型需要选择合适的距离度量方法和合适的k值。

常用的距离度量方法包括欧氏距离、曼哈顿距离、闵可夫斯基距离等。

在选择k值时,一般通过交叉验证的方式来确定最优的k值。

2.3 预测在进行预测时,首先计算测试样本与训练样本之间的距离。

然后,根据距离的近远选择距离最近的k个样本作为邻居。

k近邻算法以及实例

【机器学习】k-近邻算法以及算法实例时间 2015-01-26 14:31:00 博客园-原创精华区原文/jtianwen2014/p/4249003.html主题算法数据挖掘机器学习中常常要用到分类算法,在诸多的分类算法中有一种算法名为k-近邻算法,也称为kNN算法。

一、kNN算法的工作原理二、适用情况三、算法实例及讲解---1.收集数据---2.准备数据---3.设计算法分析数据---4.测试算法一、kNN算法的工作原理官方解释:存在一个样本数据集,也称作训练样本集,并且样本中每个数据都存在标签,即我们知道样本集中每一数据与所属分类的对应关系,输入没有标签的新数据后,将新数据的每个特征与样本集中的数据对应的特征进行比较,然后算法提取样本集中特征最相似的数据(最近邻)的分类标签。

一般来说,我们只选择样本集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不大于20的整数,最后,选择k个最相似的数据中出现次数最多的分类,作为新数据的分类。

我的理解:k-近邻算法就是根据“新数据的分类取决于它的邻居”进行的,比如邻居中大多数都是退伍军人,那么这个人也极有可能是退伍军人。

而算法的目的就是先找出它的邻居,然后分析这几位邻居大多数的分类,极有可能就是它本省的分类。

二、适用情况优点:精度高,对异常数据不敏感(你的类别是由邻居中的大多数决定的,一个异常邻居并不能影响太大),无数据输入假定;缺点:计算发杂度高(需要计算新的数据点与样本集中每个数据的“距离”,以判断是否是前k个邻居),空间复杂度高(巨大的矩阵);适用数据范围:数值型(目标变量可以从无限的数值集合中取值)和标称型(目标变量只有在有限目标集中取值)。

三、算法实例及讲解例子中的案例摘《机器学习实战》一书中的,代码例子是用python编写的(需要matplotlib和numpy库),不过重在算法,只要算法明白了,用其他语言都是可以写出来的:海伦一直使用在线约会网站寻找合适自己的约会对象。

k-nearestneighbork最近邻分类算法

k-nearestneighbork最近邻分类算法k-最近邻(K-Nearest Neighbors, KNN)是一种常用的分类算法,它通过计算待分类样本点与已知样本点之间的距离,将待分类样本点归属于距离最近的k个样本点中出现次数最多的类别。

在选择k个最近邻样本点后,KNN算法会统计这k个样本点中每个类别出现的次数,并将待分类样本点归属于出现次数最多的类别。

如果k取值为1,则待分类样本点将直接归属于与其距离最近的样本点的类别。

KNN算法的优点之一是它的简单性。

相对于其他复杂的分类算法,KNN算法的实现非常直观,不需要过多的参数调节和特定假设的前提条件。

此外,KNN算法还能够处理多类别问题,并且可以适应不同类别数据的分布。

然而,KNN算法也存在一些不足之处。

首先,KNN算法的计算复杂度较高,特别是在处理大规模数据集时。

其次,KNN算法对样本点的密度分布较为敏感,当样本点的分布不均匀时,KNN算法会产生较大的误差。

为了改进KNN算法的性能,可以采取一些技术手段。

一种常见的方法是对样本点进行归一化处理,以消除不同属性之间的量纲差异。

此外,还可以通过特征选择和降维等方法减少数据集的维度,从而减少计算复杂度。

另外,使用适当的距离度量标准,如欧氏距离、曼哈顿距离和闵可夫斯基距离等,也能够提高KNN算法的性能。

在实际应用中,KNN算法广泛应用于分类和回归问题。

KNN算法在图像识别、手写数字识别、推荐系统以及生物信息学等领域都取得了良好的效果。

此外,KNN算法还可以与其他机器学习算法相结合,形成集成学习方法,提高分类性能。

总之,KNN算法是一种简单有效的分类算法,它通过计算待分类样本点与已知样本点之间的距离,将待分类样本点归属于距离最近的k个样本点中出现次数最多的类别。

尽管KNN算法存在一些不足,但通过合适的预处理和选择合适的距离度量标准,可以提高KNN算法的性能。

在实际应用中,KNN算法在多个领域都取得了很好的效果。

【机器学习】一文搞懂K近邻算法(KNN),附带多个实现案例

【机器学习】⼀⽂搞懂K近邻算法(KNN),附带多个实现案例【机器学习】⼀⽂搞懂K近邻算法(KNN),附带多个实现案例⼀、KNN回顾kk k 近邻学习是⼀种常⽤的监督学习⽅法,⽐如:判断⼀个⼈的⼈品,只需要观察与他来往最密切的⼏个⼈的⼈品好坏就可以得出,即“近朱者⾚,近墨者⿊”。

⼆、KNN三要素1、K值的选择对于K值的选择,⼀般根据样本分布选择⼀个较⼩的值,然后通过交叉验证来选择⼀个⽐较合适的最终值;当选择⽐较⼩的K值的时候,表⽰使⽤较⼩领域中的样本进⾏预测,训练误差会减⼩,但是会导致模型变得复杂,容易导致过拟合;当选择较⼤的K值的时候,表⽰使⽤较⼤领域中的样本进⾏预测,训练误差会增⼤,同时会使模型变得简单,容易导致⽋拟合;2、距离度量⼀般使⽤欧⼏⾥德距离关于距离度量,还有其他⽅式3、决策规则KNNKNN KNN在做回归和分类的主要区别在于最后做预测时的决策⽅式不同:(1)分类预测规则:⼀般采⽤多数表决法或者加权多数表决法假设图中 “?”表⽰待预测样本,红⾊圆表⽰⼀类,蓝⾊⽅块表⽰⼀类,2和3表⽰到待预测样本的距离1. 多数表决法:2. 加权多数表决法:(2)回归预测规则:⼀般采⽤平均值法或者加权平均值法假设上图中的2和3表⽰邻近样本的⽬标属性值(标签值),此时没有类别,只有属性值1. 平均值法1. 加权平均值法图中,双箭头线上的数表⽰到待预测样本的距离三、⼿写kk k近邻算法实现kNN分类算法的伪代码:对未知类别属性的数据集中的每个点依次执⾏⼀下操作:(1)计算已知类别数据集中的点与当前点之间的距离(2)按照距离递增次序排序(3)选取与当前点距离最⼩的k个点(4)确定前k个点所在类别的出现频数(5)返回当前k个点出现频数最⾼的类别作为当前点的预测分类欧⽒距离公式:d=∑mi=1(xi−yi)2−−−−−−−−−−−−√d = \sqrt{\sum_{i=1}^m(x_i - y_i)^2}d=i=1∑m(xi−yi)2例如求点(1,0,0,1)(1,0,0,1)(1,0,0,1)和(7,6,9,4)(7,6,9,4)(7,6,9,4)之间的距离:(7−1)2+(6−0)2+(9−0)2+(4−1)2−−−−−−−−−−−−−−−−−−−−−−−−−−−−−−−√\sqrt{(7-1)^2+(6-0)^2+(9-0)^2+(4-1)^2}(7−1)2+(6−0)2+(9−0)2+(4−1)2以上算法的实现是⽤于分类的,决策规则使⽤了多数表决法;此算法通过改变决策规则,同样可以⽤于回归。

基于K近邻的分类算法研究

基于K近邻的分类算法研究K近邻算法是一种基于实例的学习方法。

其原理非常简单,可以用以下步骤概括:1.选择一个合适的距离度量标准,常用的有欧式距离、曼哈顿距离等。

2.依据给定的训练数据集,计算待分类样本与每个训练样本之间的距离。

3.选取与待分类样本距离最近的K个训练样本。

K近邻算法的优点包括:1.简单、易于理解和实现。

2.对于非线性的数据边界具有很好的效果。

3.算法的预测准确度相对较高。

然而,K近邻算法也存在一些缺点:1.计算开销较大。

每次分类都需要计算待分类样本与所有训练样本之间的距离,当数据集较大时,计算开销会显著增加。

2.对于高维数据,由于所谓的“维数灾难”,K近邻算法的表现可能不佳。

3.K值的选择对算法的结果影响较大,选择不合理的K值可能导致分类错误。

在实际应用中,基于K近邻的分类算法也存在一些问题:1.数据预处理问题:对于连续型的特征数据,需要进行归一化或标准化处理,以保证各特征对距离计算的影响相等。

2.缺失值处理问题:如果待分类样本或训练样本存在缺失值,需要通过合适的方法进行处理,如填充缺失值或删除包含缺失值的样本。

3.分类不平衡问题:当一些类别的样本数量较少时,K近邻算法容易受到该类别的影响,导致分类结果偏向该类别。

为了进一步提高K近邻算法的性能,可以采用以下方法:1.特征选择:通过选择有效的特征子集,可以减少不必要的特征维度,从而提高算法的效率和准确度。

2.特征权重:对于不同特征,可以给予不同的权重,以提高算法对关键特征的重视程度。

3.距离权重:对于不同样本的距离,可以给予不同的权重,以提高与待分类样本更相似的训练样本的影响力。

总之,基于K近邻的分类算法是一种简单且有效的方法,尤其适用于特征维度较低且数据样本分布不平衡的情况。

然而,在实际应用中需要注意处理数据的预处理、缺失值和数据不平衡等问题,以提高算法的性能和准确度。

同时,也可以通过特征选择、特征权重和距离权重等方法来进一步提高算法的效果。

毕业论文:基于k近邻法的分类器的研究与实现

基于K-近邻法的分类器的研究与实现摘要模式识别的目的就是对未知的样本,判断它所在的类别。

人类的模式识别能力使得人们可以很好的认识周围的环境并与之交流,如果计算机也具有类似的能力,那么其智能程度将会大大提高,可以发挥更大的功能,更好的为人类服务。

本文的研究课题就属于计算机模式识别领域。

分类器是模式识别系统的重要组成部分;也是机器学习的重要研究领域。

本文主要研究对象是KNN分类方法,运用K近邻法(K Nearest Neighbor)对数据进行分类,并对分类结果进行比较研究。

本文的研究工作主要探讨基于K-近邻法的分类器的实现,主要集中在K-近邻法的理论分析,算法实现。

本文首先介绍了数据挖掘的目的、意义及现状,阐述了K-近邻算法在数据挖掘中的地位和作用,然后对K-近邻法进行了详细的研究与分析,并且实现基于K-近邻法的分类器。

本设计采用SQL Server 数据库系统和c#.net开发工具进行分析研究。

关键词:模式识别;数据挖掘;机器学习; K-近邻法;分类器THE RESEARCH & ACHIEVE OF CLASSIFIER BASED ON THE K-NEAREST NEIGHBOR ALGORITHMABSTRACTThe purpose of pattern recognition is judge it in the category for the unknown sample. The pattern recognition capabilities of human can make it a good understanding of the environment around and exchange with them, If the computer also has a similar capability, its smart level will greatly improve ,the level they can play a greater role and better service to humanity. This research on the subject is a kind of computer pattern recognition.Classifier is an important component part in pattern recognition system;it is also an important research in the area of machine learning.This paper mainly targets KNN classification methods, using k-nearest neighbor for data classification, and compared the results.This article research on the achieve of classifier based on the k-nearest neighbor algorithm.Mainly concentrated in the k-nearest-neighbor theoretical analysis and algorithm .First of all,I introduce the purpose、meaning and recent development of data mining.and expatiate the status and function of k- nearest neighbour in this field.then research and analysis to the k-nearest-neighbor detailed and achieve the classifier based on k-nearest-neighbor.I design this program with SQL Server database system and c #. net development tools for analysis and study.Key words:pattern recognition; data mining, machine learning; k nearest neighbour; classifier目录1绪论 (1)1.1 课题背景及目的 (1)1.2 国内外研究状况 (2)1.3 课题研究方法 (2)1.4 论文构成及研究内容 (3)2 分类器概述 (4)2.1 分类器概念 (4)2.2 分类器构造方法 (4)2.3 近邻分类器的分类原理 (5)3K-近邻法的研究与分析 (8)3.1 KNN概念 (8)3.2 K-近邻法算法研究 (9)3.2.1 K-近邻算法数学模型 (9)3.2.2 K-近邻法研究方法 (9)3.2.3 KNN算法需要解决的问题 (10)4 K-近邻法的分类器的设计与编程实现 (12)4.1 开发环境的选择 (12)4.1.1 数据库系统选择 (12)4.1.2 开发语言的选择 (12)4.2 程序设计实现 (14)4.2.1 界面设计 (14)4.2.2 功能模块设计 (15)4.2.3 数据库连接 (17)4.2.4程序运行与调试 (19)4.3 程序实现结果与分析 (20)5 结论 (21)参考文献 (22)致谢 (23)附录源程序代码 (24)附件1开题报告 (35)附件2英文原文及翻译 (40)1绪论模式识别或者通俗一点讲自动分类的基本方法有两大类,一类是将特征空间划分成决策域,这就要确定判别函数或确定分界面方程。

k最近邻算法实验报告 (2)

}

map_it++;

}

cout<<"The test data belongs to the "<<label<<" label"<<endl;

}

int main()

{

tData testData[colLen];

int k ;

cout<<"please input the k value : "<<endl;

类图如上图所示,KNN类的成员变量描述如下:

dataSet:tData型二维数组,用于训练的数据集;

k:int型,从k个最近的元素中,找类标号对应的数目的最大值,归类;

labels:tLable型一维数组,类标签;

map_index_dist:map<int,double>型,记录测试点到各点的距离;

}

fin>>labels[i];

}

}

/*

* calculate the distance between test data and dataSet[i]

*/

double KNN:: get_distance(tData *d1,tData *d2)

{

double sum = 0;

for(int i=0;i<colLen;i++)

{

//transform the map_index_dis to vec_index_dis

vector<PAIR> vec_index_dis( map_index_dis.begin(),map_index_dis.end() );

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

间复杂度为 O(nlogn), 所以整个训练阶段的时间 复杂度为 O(mn+nlogn), 进而得到一个结论: 分 类的效率主要取决于数据库的大小。

参考文献

[1]Hand.D 著.张银奎等译; 数据挖掘原理[M]. 北 2003,4. 京:机械工业出版社, [2]邵峰晶, 于忠清 . 数据挖掘原理与算法 [M]. 北 京:中国水利水电出版社, 2003. [3]韩家炜译.数据挖掘[J].概念与技术, 2000.

类算法的研究及实现

王建伟

摘

1

张 璞

2

(1、 华北水利水电学院信息工程学院, 河南 郑州 450046

2、 河南职业技术学院, 河南 郑州 450000 )

要 :k- 近邻 (KNN) 算法是一种基本的基于实例的学习分类算法, 被广泛用于数据挖掘中。它分为学习过程和训练过程两个阶段。在学习

责任编辑 : 胡明月

-45-

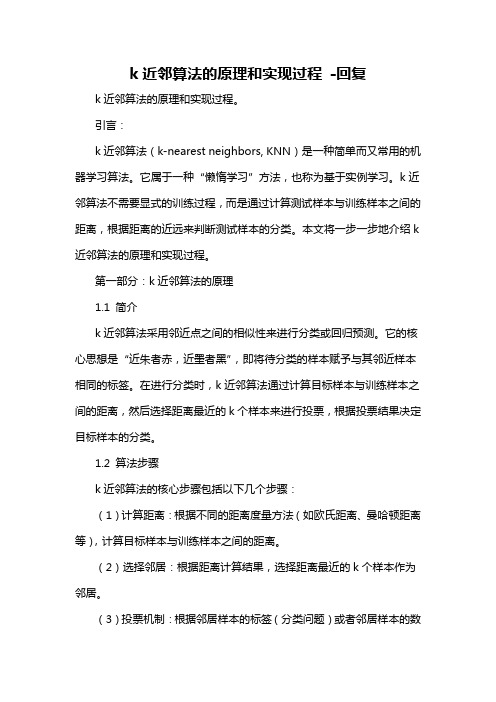

表1

1 2 3 4 5 6 7 8 9 10

85 377% 77 83% 82 547% 73 585% 98 585% 1 90 094% 91 038% 89 623% 78 774% 86 745%

14 623% 22 17% 17 453% 26 415% 1 4151% 0 9 9057% 8 9623% 10 377% 21 226% 13 255%

一系列的相似的 阶段, 该算法除进行已知数据的简单存储之外不进行其它的操作, 而在学习阶段进行绝大多数的计算。每当遇到新的查询实例时, 实例就从存储器中取出, 并用来分类新的查询实例。 关键词 :k- 近邻; KNN ; 分类; 数据挖掘 1 概述 分类问题是数据挖掘邻域研究的一个基 本的问题, 给定一批具有类标记的训练实例, 分 类器被构造并被用于预测待分类实例的类标 一个实例 X 用一个 m 维的属性向量 记。通常, <x1,x2, · · · ,xm> 来表示, 其中 xi 表示实例 X 的第 i 个属性值。令 C 表示实例的类标记,则实例 X 的类标记可表示为 C(x)。KNN 算法作为一种基 本的基于实例的分类算法,由于它的有效 、 简 单、高鲁棒性而被广泛的应用于数据挖掘领域 来解决分类问题。 2 KNN 算法 KNN 算法假定所有的实例对应于 m 维的 实例间的距离是根据标准 欧氏空间 Rm 中的点, 的欧氏距离来度量的,假设有欧氏空间中的两 个实例 a 和 b,则 a、 b 之间的欧氏距离可以表 示为如下: 。 若对实例 X 进行分类时, KNN 将距离实例 X 最近, 即: 欧氏 距离最小的 k 个实例的最普遍的类标记作为预 测值赋给实例 X, 用公式表示如下: , 其中, y ( · · · k ) 为 X 的 k 个近 i i=1,2 C 为 c 所有取值的集合, δ 函数定义如下: 邻, δ (c,c(yi))=1 (c=c(yi)) 且 δ (c,c(yi))=0 (c ≠c(yi))。 由此可见 KNN 算法是一种典型的消极学习算 法, 在训练阶段仅仅简单存储所有的训练实例, 而所有的计算都延迟到训练阶段进行, 即: 对于 未分类的实例分类时,对每一个实例都构建一 个分类模型, 一次建模一次使用。 KNN 分类算法的实现主要可描述为如下: 2.1 训练阶段: 训练数据的存储, 主要包括 训练数据的离散化, 数据的读取, 数据的存储三 个方面。数据的离散化主要是针对数据的 m 维 属性, 对每个属性要进行单独的离散化, 并将离 散化后的数据写入一个表中,以为下一步的数 据读取做准备;数据的读取和存储主要是将表 中数据读入数组存储以便于程序执行处理。需 要说明的是为了确定分类的效果将离散后的数 据分成了十份, 用以进行十重交叉测试试验。 2.2 分类阶段:在这一阶段主要是将上一 阶段处理完毕的数据进行八重交叉测试试验, a.选取一数据作为待分类实例, 具体步骤如下: 计算此实例与其它实例的欧氏距离。b.比较各 个距离的大小, 选取最近邻的 K 个实例; c.查看 上步中 K 个实例的分类标记, 采用多数表决的 d. 应用十重交叉 方式确定待分类实例的类别; 测试试验方法, 重复以上各步骤。 3 结论与性能分析 K 取 2, 3, 4, 5, 6, 7, 8, 9, 10 分 别 做 了 测 试, 发现 K=8 时, 效果最好。最近距离矩阵选择 (K=8 ) 结论如表 1: 欧氏距离。经过程序执行 另外, K 的取值不同, 分类效果明显不同。

当 K 增大时, 分类效果可能会相对较好, 但并 不完全是这样的。例如: 当 K=10 时, KNN 分类 86.6509%。 分类效果不如 K=8 的平均正确率为: 时的分类效果。 经过试验测试后可见, KNN 分类算法的主 要时间消耗在于:对于一个待分类的实例 (m 维 ) , 都要计算它与数据库 (大小为 n ) 中所有数 据的距离, 同时还要对产生的距离进行排序, 其 中计算距离的时间复杂度为 O(mn), 排序的时