量子粒子群算法 程序

量子行为粒子群优化算法-中文版

Ii

粒子状态

X = <xi0,xi1,…,xin-1> P = <pi0,pi1,…,pin-1> V = <vi0,vi1,…,vin-1> x_fitness = ? p_fitness = ?

2. 粒子群优化算法的迭代方程 粒子按下列方程进行进化

速度方程

vid(t)=w*vid(t-1)+c1*rand()*(pid-xid(t-1))+c2*rand()*(pgdxid(t-1))

位置方程

xid(t)=xid(t-1)+vid(t)

xid –第i个粒子当前位置的第d维. vid –第i个粒子的当前速度的第d维. Pid –第i个粒子目前最优位置的第d维. Pgd – 群体最优位置的第d维. c1, c2 –加速因子. w - 惯性因子.

被成功的应用到各种优化问题中 在PSO 算法中,包含n个个体的群体在各自的搜索 方向上直接或间接的交互信息

:每个粒子(个体)包含:

3个向量:

• X向量记录了粒子在搜索空间的当前位置 • P向量记录了粒子所找到的当前最优解的位置 • V向量包含了粒子在不受干扰的情况下位置的改变 • X适应值记录了x向量的适应值 • P适应值记录了p向量的适应值

25

20

Pid pbest

15

粒子群优化算法

Vid(t-1) v(k)

图示

v(k+1)

10

Vid(t)

5

Pgd gbest

5

10

15

20

25

3. 粒子群优化算法的群体收搜策略

在粒子群优化算法中,粒子不会消失.

每个粒子被看成是在整个收搜空间收搜并记录最优值的 个体.

高斯量子行为粒子群优化(gqpso)算法

高斯量子行为粒子裙优化(GQPSO)算法是一种基于量子行为的进化优化算法,它结合了粒子裙优化(PSO)算法和量子计算的特点,能够有效地解决复杂优化问题。

本文将从以下几个方面介绍GQPSO算法的原理、特点和应用,希望能够为读者提供深入的了解。

一、GQPSO算法的原理GQPSO算法是基于粒子裙优化算法和量子计算的原理而提出的,它采用了一种全新的粒子编码和演化方式,通过模拟粒子在量子力学中的行为进行搜索和优化。

GQPSO算法的原理如下:1. 量子位表示在GQPSO算法中,每个粒子被表示为一个量子位,根据其在搜索空间中的位置,每个粒子的量子位可以被编码为一个二进制字符串。

这种量子位表示方式能够更好地描述粒子的位置和速度,从而更好地指导搜索过程。

2. 高斯量子演化GQPSO算法通过高斯量子演化来更新粒子的量子位和速度,其中包括量子位的变换和速度的更新。

在高斯量子演化过程中,粒子会受到适应性函数的约束,从而导致不断演化、搜索和优化。

3. 适应性函数GQPSO算法中使用的适应性函数通常是目标函数或者问题的评价函数,它能够帮助粒子判断当前位置的优劣,并指导其向更优的位置演化。

适应性函数的选择对于算法的性能至关重要。

二、GQPSO算法的特点GQPSO算法相比于传统的优化算法有着独特的特点和优势,主要表现在以下几个方面:1. 全局搜索能力强GQPSO算法通过量子位表示和高斯量子演化,能够有效地克服传统算法在全局搜索能力上的不足,更好地发挥粒子裙优化算法的优势,从而在复杂优化问题中取得更好的效果。

2. 收敛速度快GQPSO算法利用了量子行为的特性,能够更快地收敛到全局最优解,从而大大提高了算法的搜索效率和优化能力。

在实际应用中,GQPSO 算法往往能够在较短的时间内找到较优的解。

3. 对高维问题有较好的适应性GQPSO算法对于高维优化问题的适应性较强,能够有效地应对复杂的实际问题,从而满足实际应用的需求。

这一特点使得GQPSO算法在实际工程和科研中有着广泛的应用前景。

matlab中调用量子粒子群优化算法__理论说明

matlab中调用量子粒子群优化算法理论说明1. 引言1.1 概述本文将介绍在MATLAB中调用量子粒子群优化算法的理论说明。

量子粒子群优化算法是一种启发式搜索算法,利用了经典的粒子群优化算法和量子力学概念,能够有效地解决许多实际问题。

本文将从算法原理、算法流程、参数调节方法等方面对量子粒子群优化算法进行介绍,并重点探讨如何在MATLAB中调用和使用这一算法。

1.2 文章结构本文共分为5个部分,除了引言,还包括量子粒子群优化算法的介绍、MATLAB 中的实现、实验结果与讨论以及结论与未来展望。

首先,我们将详细介绍量子粒子群优化算法的原理和流程,并讨论其相关参数的调节方法。

接下来,我们会简要介绍MATLAB中的优化工具箱,并指导读者如何调用和使用其中的量子粒子群优化函数。

随后,我们将通过案例分析展示该算法在解决实际问题上的应用效果,并进行结果对比分析和讨论。

最后,我们将总结主要研究成果并提出改进方向建议,并探讨未来研究方向和展望。

1.3 目的本文的目的是帮助读者了解量子粒子群优化算法以及如何在MATLAB中调用和使用该算法。

通过本文的阅读,读者将能够掌握量子粒子群优化算法的原理和流程,并具备使用MATLAB工具箱进行实际问题求解的能力。

此外,我们还将通过案例分析和结果讨论,展示该算法在实际问题中的有效性和可行性,并为其改进提出建议。

最后,在结论部分,我们将总结文章内容并提出未来研究方向供读者参考。

2. 量子粒子群优化算法介绍:2.1 量子粒子群优化算法原理量子粒子群优化算法(Quantum Particle Swarm Optimization,简称QPSO)是一种基于群体智能的全局优化算法。

该算法的原理基于典型的粒子群优化算法(Particle Swarm Optimization,简称PSO),同时引入了量子力学中的概念和思想。

在传统的PSO中,每个粒子代表一个搜索解,并通过不断更新自己的位置和速度来寻找全局最优解。

量子行为粒子群优化算法-中文版

量子行为粒子群优化

02

算法的实现过程

初始化阶段

01

02

03

初始化粒子群

在解空间中随机初始化一 组粒子,每个粒子代表一 个潜在的解。

初始化粒子速度

为每个粒子随机分配一个 速度,用于控制其位置的 变化。

初始化粒子位置

根据问题的约束条件和目 标函数,为每个粒子随机 分配一个初始位置。

更新阶段

计算适应度值

量子行为粒子群优化算法的基本原理

• 量子行为粒子群优化算法的基本原理是:每个粒子被视为一 个量子比特,其状态由波函数表示。粒子通过不断更新自己 的位置和速度来搜索解空间,同时通过与其它粒子的信息共 享和协作来不断逼近最优解。在更新过程中,粒子不仅受到 自身经验和群体最佳位置的影响,还受到量子旋转门和量子 测量等量子操作的作用,从而在解空间中实现全局搜索和局 部搜索的平衡。

THANKS.

组合优化问题

组合优化问题是指在一组可行解中寻 找最优解的问题,如旅行商问题、背 包问题、图着色问题等。

量子行为粒子群优化算法能够处理这 类问题,通过粒子间的信息共享和协 作,寻找最优解或近似最优解。

机器学习与数据挖掘

在机器学习和数据挖掘领域,量子行为粒子群优化算法可用 于特征选择、模型参数优化和超参数调整等方面。

算法在实际问题中的应用前景

组合优化问题

量子行为粒子群优化算法在求解组合优化问题方面具有优 势,如旅行商问题、背包问题等,有望在实际生产、物流 等领域得到广泛应用。

机器学习与数据挖掘

量子行为粒子群优化算法可用于特征选择、模型参数优化 等方面,为机器学习和数据挖掘提供新的思路和方法。

控制系统优化

在控制系统的参数优化和控制器设计中,量子行为粒子群 优化算法具有潜在的应用价值,有助于提高控制系统的性 能和稳定性。

粒子群优化算法 程序

粒子群优化算法程序粒子群优化算法(Particle Swarm Optimization, PSO)是一种基于群体智能的优化算法,它模拟了鸟群或鱼群等生物群体的行为,用于解决各种优化问题。

下面我将从程序实现的角度来介绍粒子群优化算法。

首先,粒子群优化算法的程序实现需要考虑以下几个关键步骤:1. 初始化粒子群,定义粒子的数量、搜索空间的范围、每个粒子的初始位置和速度等参数。

2. 计算适应度,根据问题的特定适应度函数,计算每个粒子的适应度值,以确定其在搜索空间中的位置。

3. 更新粒子的速度和位置,根据粒子的当前位置和速度,以及粒子群的最优位置,更新每个粒子的速度和位置。

4. 更新全局最优位置,根据所有粒子的适应度值,更新全局最优位置。

5. 终止条件,设置终止条件,如最大迭代次数或达到特定的适应度阈值。

基于以上步骤,可以编写粒子群优化算法的程序。

下面是一个简单的伪代码示例:python.# 初始化粒子群。

def initialize_particles(num_particles, search_space):particles = []for _ in range(num_particles):particle = {。

'position':generate_random_position(search_space),。

'velocity':generate_random_velocity(search_space),。

'best_position': None,。

'fitness': None.}。

particles.append(particle)。

return particles.# 计算适应度。

def calculate_fitness(particle):# 根据特定问题的适应度函数计算适应度值。

particle['fitness'] =evaluate_fitness(particle['position'])。

matlab量子粒群实例

matlab量子粒群实例关于matlab量子粒子群优化算法的实例应用引言:量子粒子群优化算法(Quantum Particle Swarm Optimization, QPSO)是由中国黑龙江大学的李瑞霞教授等人于2002年提出的一种全局优化算法,它基于粒子群优化算法(Particle Swarm Optimization, PSO)的思想,并引入了量子行走的概念。

相对于传统的PSO算法,QPSO在搜索能力、收敛速度和全局最优性等方面具有明显的优势。

而MATLAB是一种功能强大的科学计算软件工具箱,常被用于数值计算、数据分析和绘图等领域。

本文将以MATLAB 量子粒子群优化算法的实例应用为主题,介绍其具体实现过程。

正文:1. 简介QPSO算法QPSO是一种模拟自然进化过程的全局优化算法,其中的粒子代表了可能的解,在问题的搜索空间中进行信息传递和状态更新。

QPSO与PSO算法最大的不同在于利用量子行走的概念,在位置更新步骤引入量子旋转操作,以增强粒子的搜索能力。

QPSO算法的主要步骤包括初始化种群、量子旋转、位置更新和适应度评估等。

2. 初始化种群在MATLAB中,可以通过创建一个矩阵来表示粒子,并为粒子的位置初始化一个随机值。

例如,若问题的维度为D,种群的规模为N,则可以创建一个大小为N * D的矩阵,其中每一行表示一个粒子,每一列表示粒子在每个维度的位置。

3. 量子旋转量子旋转是QPSO算法的核心步骤,它用于增强粒子的搜索能力。

在MATLAB中,可以通过使用rand函数产生一个0到1的随机数,并与角度theta相乘,然后使用acos函数计算出旋转角度。

最后,将旋转角度应用到原始的位置向量中,得到旋转后的位置向量。

旋转前后的更新公式如下:旋转前:NewX = X + R * (Pbest - X) + R * (Gbest - X)旋转后:NewX = X + (R * cos(theta) * (Pbest - X)) + (R *sin(theta) * (Gbest - X))其中,NewX表示旋转后的位置向量,X表示旋转前的位置向量,Pbest表示粒子历史最佳位置向量,Gbest表示种群最佳位置向量,R为旋转因子。

优化算法-粒子群优化算法

步骤四:对于粒子的每一维,根据式(1)计算得到一个随机点 的位置。

步骤五:根据式(2)计算粒子的新的位置。

步骤六:判断是否满足终止条件。

粒子群优化算法

PSO算法在组合优化问题中的应用

典型的组合优化问题:TSP

粒子群优化算法

量子行为粒子群优化算法的基本模型

群智能中个体的差异是有限的,不是趋向于无穷大的。群体的聚 集性是由相互学习的特点决定的。

个体的学习有以下特点: 追随性:学习群体中最优的知识

记忆性:受自身经验知识的束缚

创造性:使个体远离现有知识

粒子群优化算法

聚集性在力学中,用粒子的束缚态来描述。产生束缚态的原因是 在粒子运动的中心存在某种吸引势场,为此可以建立一个量子化 的吸引势场来束缚粒子(个体)以使群体具有聚集态。

描述为: 给定n 个城市和两两城市之间的距离, 求一条访问各城市

一次且仅一次的最短路线. TSP 是著名的组合优化问题, 是NP难题, 常被用来验证智能启发式算法的有效性。

vid (t 1) wvid (t) c1r1 pid (t) xid (t) c2r2( pgd (t) xid (t))

xid (t 1) xid (t) vid (t 1)

粒子群优化算法

w 惯性权重 可以是正常数,也可以是以时间为变量的线性或非线性

正数。

粒子群优化算法

通常动态权重可以获得比固定值更好的寻优结果,动态权重可以在 pso搜索过程中呈线性变化,也可以根据pso性能的某个测度函数 而动态改变,目前采用的是shi建议的随时间线性递减权值策略。

粒子群优化算法

量子粒子群算法的公式

量子粒子群算法的公式量子粒子群算法(Quantum Particle Swarm Optimization,QPSO)是一种元启发式优化算法,它结合了粒子群优化算法和量子计算的概念。

其公式可以用以下方式表示:1. 初始化量子粒子的位置和速度:\( x_i^0 = rand(x_{\text{min}}, x_{\text{max}}) \)。

\( v_i^0 = rand(-|x_{\text{max}}-x_{\text{min}}|, |x_{\text{max}}-x_{\text{min}}|) \)。

2. 计算适应度:\( f_i^0 = f(x_i^0) \)。

3. 更新量子粒子的位置和速度:\( x_i^{t+1} = x_i^t + v_i^t \)。

\( v_i^{t+1} = \frac{1}{2} \left( \frac{1}{N}\sum_{j=1}^{N} \frac{1}{\sqrt{1 + \frac{(x_i^tx_j^t)^2}{\lambda^2}}} \right)^2 v_i^t \)。

其中,\( x_i^t \) 表示第 \( i \) 个粒子在第 \( t \) 代的位置,\( v_i^t \) 表示第 \( i \) 个粒子在第 \( t \) 代的速度,\( f(x_i^t) \) 表示第 \( i \) 个粒子在位置 \( x_i^t \) 的适应度,\( x_{\text{min}} \) 和 \( x_{\text{max}} \) 分别表示搜索空间的最小值和最大值,\( N \) 表示粒子群中粒子的数量,\( \lambda \) 是一个常数。

以上公式描述了量子粒子群算法的基本过程,通过不断迭代更新粒子的位置和速度,以及根据适应度函数进行优化,最终寻找到最优解。

这种算法结合了经典粒子群优化算法和量子力学的概念,具有较强的全局搜索能力和收敛速度。

粒子群算法步骤

粒子群算法(Particle Swarm Optimization,PSO)是一种基于群体智能的优化算法,用于解决优化问题。

下面是粒子群算法的一般步骤:1. 初始化参数:- 定义问题的适应度函数。

- 设置群体规模(粒子数量)和迭代次数。

- 随机初始化每个粒子的位置和速度。

- 设置每个粒子的个体最佳位置和整个群体的全局最佳位置。

2. 迭代优化:- 对于每个粒子:- 根据当前位置和速度更新粒子的新速度。

- 根据新速度更新粒子的新位置。

- 根据新位置计算适应度函数值。

- 更新粒子的个体最佳位置和整个群体的全局最佳位置。

- 结束条件判断:达到预设的迭代次数或满足特定的停止条件。

3. 输出结果:- 输出全局最佳位置对应的解作为优化问题的最优解。

在更新粒子的速度和位置时,通常使用以下公式:速度更新:v(t+1) = w * v(t) + c1 * r1 * (pbest - x(t)) + c2 * r2 * (gbest - x(t))位置更新:x(t+1) = x(t) + v(t+1)其中:- v(t) 是粒子在时间t 的速度。

- x(t) 是粒子在时间t 的位置。

- w 是惯性权重,用于平衡粒子的历史速度和当前速度的影响。

- c1 和c2 是加速因子,控制个体和全局最佳位置对粒子速度的影响。

- r1 和r2 是随机数,用于引入随机性。

- pbest 是粒子的个体最佳位置。

- gbest 是整个群体的全局最佳位置。

以上是粒子群算法的基本步骤,您可以根据具体的优化问题进行调整和扩展。

写出基本的粒子群算法,并用球形函数验证。

写出基本的粒子群算法,并用球形函数验证。

粒子群算法是一种经典的群体智能算法,通过模拟鸟群捕食过程中群体的协同行为,寻找最优解。

其基本思想是将问题的解看作空间中的一个粒子,并通过考虑粒子周围的信息和个体最优解来更新粒子的位置,以找到全局最优解。

本文将介绍基本的粒子群算法,并通过验证球形函数的方式对算法进行测试。

基本的粒子群算法的步骤如下:1.初始化粒子群:随机生成一定数量的粒子,并给每个粒子分配一个随机的初速度和位置。

同时,记录每个粒子的历史最优位置和历史最优适应度。

2.计算粒子的适应度:根据问题的适应度函数,计算每个粒子当前位置的适应度。

3.更新粒子的速度和位置:根据粒子的历史最优位置和全局最优位置来更新粒子的速度和位置。

设第i个粒子的当前速度为Vi,当前位置为Xi,历史最优位置为Pi,全局最优位置为Pg,学习因子为c1和c2,速度更新公式为:Vi(t+1) = w * Vi(t) + c1 * rand() * (Pi - Xi) + c2 * rand() * (Pg - Xi)位置更新公式为:Xi(t+1) = Xi(t) + Vi(t+1)其中,w为惯性因子,rand()为0到1的随机数。

4.更新粒子的历史最优位置:比较粒子当前位置的适应度与其历史最优适应度,如果当前适应度更优,则更新历史最优位置。

5.更新全局最优位置:将当前适应度最优的粒子位置作为全局最优位置。

6.终止条件判断:如果满足终止条件(如达到最大迭代次数或适应度满足要求),则停止算法;否则,回到步骤2。

接下来,我们使用球形函数作为问题的适应度函数对粒子群算法进行验证。

球形函数(Sphere Function)是优化问题中常用的测试函数之一,其计算公式为:f(x) = x1^2 + x2^2 + x3^2 + ... + xn^2其中,n为变量的维度。

首先,我们需要确定算法的参数,包括粒子数量、迭代次数、惯性因子w、学习因子c1和c2的取值等。

协同量子粒子群

协同量子粒子群协同量子粒子群(Cooperative Quantum Particle Swarm Optimization,Co-QPSO)是一种基于粒子群算法(PSO)和量子计算的协同优化算法。

该算法利用群体智能和量子力学的特性,对多维复杂问题进行优化。

粒子群算法是一种基于群体智能的优化算法,其核心思想是通过模拟群体中粒子的行为,来寻找问题的最优解。

每个粒子都代表一个解,根据当前的位置和速度,不断更新解的位置并逐步接近最优解。

然而,传统的PSO算法存在着陷入局部最优的风险。

量子计算是一种新的计算范式,其基于量子力学的特性来进行计算,可以在某些情况下将传统计算机无法处理的问题进行快速解决。

量子计算的特点之一是量子态的叠加和纠缠,这使得量子计算具有高度的并行性和计算效率。

协同量子粒子群算法将粒子群算法和量子计算相结合,采用了两个量子门(量子 NOT 门和量子 CNOT 门)来模拟量子行为。

采用量子进化算法(Quantum-inspired Evolutionary Algorithm,QEA)来进行优化,同时引入思维领袖群体(Cognitive Leadership),并将所有位置精度转换成二进制代码表示。

协同量子粒子群算法的主要步骤如下:1. 群体初始化。

随机生成一组个体,并将其位置转换成二进制表示。

2. 适应值评估。

利用适应度函数来评估每个个体的适应度。

3. 量子门应用。

采用两个量子门来模拟量子行为,并将其应用于二进制编码的位置和速度。

4. 群体协同。

利用思维领袖群体来进行更新,并保留历史最优位置。

5. 约束处理。

对每个个体的位置进行处理,确保其满足约束条件。

6. 终止条件检验。

如果达到了终止条件,则输出历史最优解,否则转到步骤2。

协同量子粒子群算法具有很好的全局搜索能力和收敛速度,尤其在求解高维、多目标、非线性等问题方面具有一定优势。

但由于其涉及到量子计算的复杂性,需要更多的计算资源和专业知识支持,因此在实际应用上的局限性和难度也相对较高。

多目标量子粒子群算法

多目标量子粒子群算法多目标量子粒子群算法(Multiple-Objective Quantum Particle Swarm Optimization,简称MOQPSO)是一种基于粒子群算法(Particle Swarm Optimization,简称PSO)和量子计算理论的多目标优化算法。

PSO算法是一种通过模拟鸟群觅食行为寻找全局最优解的群体智能算法,而量子计算理论是一种可以有效地处理多目标优化问题的算法。

MOQPSO 将这两种算法进行了融合,能够更好地处理多目标问题。

MOQPSO的思想源自于粒子群算法的优点,在保持其良好的全局能力的同时,引入了量子计算的特性,使其更适用于多目标优化问题。

MOQPSO 的基本框架与PSO类似,由一群粒子构成,每个粒子代表一组解,首先根据粒子自身的位置和速度进行更新,然后通过量子力学的规则进行相应的量子旋转,最终得到粒子的新位置。

MOQPSO的优势主要体现在处理多目标优化问题上。

传统的单目标优化算法只能得到一个最优解,无法解决多个冲突的目标同时优化的问题。

而MOQPSO能够在同一次迭代中得到多个解,这些解在目标空间中近似地均匀分布,并构成一个解集,称为Pareto前沿。

Pareto前沿中的每个解都是在不同程度上有效地优化了目标函数。

通过选择此解集中的一些解作为最终的解决方案,决策者可以根据自己的需求在不同的目标之间进行权衡和取舍。

MOQPSO的具体实现需要解决两个核心问题:量子旋转过程和粒子位置更新过程。

量子旋转过程是MOQPSO与传统PSO算法的主要区别,通过引入量子旋转的方式,可以实现在目标空间中的跳跃性,从而更好地探索和利用目标空间中的有用信息。

具体来说,通过量子门操作对粒子的位置进行控制,使其在适应度函数的梯度方向上进行。

而粒子位置的更新过程则与传统PSO算法类似,通过更新粒子的速度和位置,使其向全局最优解和个体最优解靠拢。

在实际应用中,MOQPSO可用于解决各种多目标优化问题,如工程设计、生产规划和组合优化等。

粒子群算法基本流程

粒子群算法基本流程粒子群算法(Particle Swarm Optimization, PSO)是一种基于自然界群体智能现象的优化算法,常用于解决各种优化问题,如函数优化、组合优化、机器学习等。

本文将详细介绍粒子群算法的基本流程,包括初始化、适应度评价、移动、更新等环节,希望能对读者理解该算法提供一定的帮助。

一、算法介绍粒子群算法最初由Kennedy和Eberhart于1995年提出 [1],其基本思想来源于鸟群觅食行为。

在野外觅食时,鸟群中的鸟会根据所找到的食物数量来确定自己下一步的移动方向。

PSO算法中的“粒子”类似于鸟群中的鸟,它们以个体和群体为导向,通过速度和位置的调整来进行优化搜索。

PSO算法的目标是寻找最优解,通常是最小化或最大化一个函数的值,可表示为:f(x)=\sum_{i=1}^n{f_i(x)}x 是 n 维实数向量,f_i(x) 表示第 i 个函数。

寻找最优解的目标就是在 x 的搜索空间中寻找函数 f(x) 的全局最优解或局部最优解。

二、基本流程粒子群算法的基本流程如下:1. 初始化:随机生成一群粒子,每个粒子的位置和速度都是随机的。

2. 适应度评价:计算每个粒子的适应度值,也就是函数 f(x) 所对应的值,用来表示该粒子所处的位置的优劣程度。

3. 移动:根据当前位置和速度,移动粒子到新的位置。

4. 更新:根据历史上最好的粒子位置和当前最好的粒子位置,更新每个粒子的历史最好位置和当前最好位置,并更新全局最优位置。

5. 终止:当满足一定的终止条件时,停止迭代,并输出最终的粒子位置和最优解。

下文将分别对各环节进行详细介绍。

三、初始化在PSO算法中,粒子的位置和速度都是随机的。

对于每个粒子,需要随机生成一个 n 维实数向量表示其位置,一个同维度的实数向量表示其速度。

可以采用如下方法进行初始化:1. 对于每一个维度,随机生成一个实数范围内的数值,表示该维度上的位置和速度。

2. 在满足约束条件的前提下,生成一个可行解,作为初始化的位置。

粒子群算法的基本流程

粒子群算法的基本流程粒子群算法(Particle Swarm Optimization,PSO)是一种模拟鸟群觅食行为的优化算法,通过模拟鸟群中个体之间的协作和信息共享,寻找最优解。

它最早由美国社会心理学家Kennedy和Eberhart于1995年提出,被广泛应用于各个领域的优化问题。

粒子群算法的基本流程可以分为初始化、迭代更新和停止准则三个步骤。

1. 初始化在粒子群算法中,需要初始化一组粒子,每个粒子代表问题的一个解。

粒子的位置表示解的搜索空间中的一个点,粒子的速度表示解的搜索方向和速度。

初始化时,需要给每个粒子随机分配一个位置和速度,并记录每个粒子的历史最佳位置和全局最佳位置。

2. 迭代更新在每一次迭代中,需要更新每个粒子的位置和速度,以及更新每个粒子的历史最佳位置和全局最佳位置。

2.1 更新粒子的速度粒子的速度更新公式为:v(t+1) = w * v(t) + c1 * rand() * (pbest - x(t)) + c2 * rand() * (gbest - x(t))其中 v(t+1) 表示粒子在下一次迭代中的速度,v(t) 表示粒子当前的速度,w 是惯性权重,c1 和 c2 是加速因子,rand() 是一个介于0和1之间的随机数,pbest 表示粒子的历史最佳位置,gbest 表示全局最佳位置,x(t) 表示粒子当前的位置。

2.2 更新粒子的位置粒子的位置更新公式为:x(t+1) = x(t) + v(t+1)其中x(t+1) 表示粒子在下一次迭代中的位置,x(t) 表示粒子当前的位置,v(t+1) 表示粒子在下一次迭代中的速度。

2.3 更新粒子的历史最佳位置和全局最佳位置在每次迭代中,需要根据当前位置和历史最佳位置来更新粒子的历史最佳位置。

同时,需要根据所有粒子的历史最佳位置来更新全局最佳位置。

3. 停止准则迭代更新的过程会持续进行,直到满足停止准则为止。

常见的停止准则有达到最大迭代次数、目标函数值收敛等。

量子粒子群算法程序

量子粒子群算法程序量子粒子群算法(Quantum Particle Swarm Optimization, QPSO)是一种基于量子行为的优化算法。

在传统的粒子群算法中,粒子的位置和速度的更新是通过随机数和全局最优解进行调整的。

而在QPSO中,粒子的位置和速度的更新是通过量子数学的原理进行调整的。

QPSO算法的本质是将经典粒子群算法与量子力学的概念相结合,并通过量子门操作等手段来更新状态。

QPSO算法的基本思想是将问题的解空间量子化,并使用粒子的位置来表示量子态的量子数。

每个粒子的位置都是一个量子态,而位置的变化则是通过量子门操作来实现的。

QPSO将问题的解空间划分为多个量子态,每个粒子代表一个量子态,通过相互之间量子门操作的方式,实现量子态的变化和演化。

QPSO算法的流程如下:1.初始化粒子群。

包括粒子的位置、速度、适应度等参数的初始化。

2.计算每个粒子的适应度,并设置全局最优解。

3.计算每个粒子的相对概率,确定量子门的概率分布。

4.通过量子门操作,更新粒子的位置和速度。

5.更新全局最优解。

6.判断是否满足停止条件,如果满足则输出最优解,否则返回第3步。

QPSO算法相比传统的粒子群算法具有以下几点优势:1.增强了能力。

通过引入量子门操作,粒子的位置和速度的更新采用了概率性的方式,从而增加了解空间的能力。

2.加速了收敛速度。

相比传统的粒子群算法,QPSO通过量子门操作来更新粒子的位置和速度,可以更快地得到全局最优解。

3.提高了算法的鲁棒性。

QPSO通过量子态的变化和演化来更新粒子的位置和速度,避免了传统粒子群算法中容易陷入局部最优解的问题。

QPSO算法在应用中具有广泛的适用性,特别适用于复杂问题的优化。

比如在图像处理、数据挖掘、机器学习等领域,QPSO算法已经得到了广泛的应用。

总结起来,QPSO算法是基于量子力学原理的一种优化算法,通过量子门操作来更新粒子的位置和速度。

相比传统的粒子群算法,QPSO算法具有更强的能力、更快的收敛速度和更好的鲁棒性。

6种粒子群算法程序(完整版)

程序1当22111c c ,5.12212c c ,2.1w 。

a)%主函数源程序(main.m )%------基本粒子群算法(particle swarm optimization )%------名称:基本粒子群算法%------初始格式化clear all;%清除所有变量clc;%清屏format long;%将数据显示为长整形科学计数%------给定初始条条件------------------ N=40;%3初始化群体个数D=10;%初始化群体维数T=100;%初始化群体最迭代次数c11=2;%学习因子1c21=2;%学习因子2c12=1.5;c22=1.5;w=1.2;%惯性权重eps=10^(-6);%设置精度(在已知最小值的时候用)%------初始化种群个体(限定位置和速度)------------x=zeros(N,D);v=zeros(N,D);for i=1:Nfor j=1:Dx(i,j)=randn;%随机初始化位置v(i,j)=randn;%随机初始化速度endend%------显示群位置----------------------figure(1)for j=1:Dif (rem(D,2)>0)subplot((D+1)/2,2,j)elsesubplot(D/2,2,j)endplot(x(:,j),'b*');grid onxlabel('粒子')ylabel('初始位置')tInfo=strcat('第',char(j+48),'维');if(j>9)tInfo=strcat('第',char(floor(j/10)+48),char(rem(j,10)+48),'维');endtitle(tInfo)end%------显示种群速度figure(2)for j=1:Dif(rem(D,2)>0)subplot((D+1)/2,2,j)elsesubplot(D/2,2,j)endplot(x(:,j),'b*');grid onxlabel('粒子')ylabel('初始速度')tInfo=strcat('第,char(j+48),'维');if(j>9)tInfo=strcat('第',char(floor(j/10)+48), char(rem(j,10)+48),'维);endtitle(tInfo)endfigure(3)%第一个图subplot(1,2,1)%------初始化种群个体(在此限定速度和位置)------------x1=x;v1=v;%------初始化个体最优位置和最优值---p1=x1;pbest1=ones(N,1);for i=1:Npbest1(i)=fitness(x1(i,:),D);end%------初始化全局最优位置和最优值---------------g1=1000*ones(1,D);gbest1=1000;for i=1:Nif(pbest1(i)<gbest1)g1=p1(i,:);gbest1=pbest1(i);endendgb1=ones(1,T);%-----浸入主循环,按照公式依次迭代直到满足精度或者迭代次数---for i=1:Tfor j=1:Nif (fitness(x1(j,:),D)<pbest1(j))p1(j,:)=x1(j,:);pbest1(j)=fitness(x1(j,:),D);endif(pbest1(j)<gbest1)g1=p1(j,:);gbest1=pbest1(j);endv1(j,:)=w*v1(j,:)+c11*rand*(p1(j,:)-x1(j,:))+c21*rand*(g1-x1(j,:)); x1(j,:)=x1(j,:)+v1(j,:);endgb1(i)=gbest1;endplot(gb1)TempStr=sprintf('c1= %g ,c2=%g',c11,c21);title(TempStr);xlabel('迭代次数');ylabel('适应度值');%第二个图subplot(1,2,2)%-----初始化种群个体(在此限定速度和位置)------------x2=x;v2=v;%-----初始化种群个体最有位置和最优解-----------p2=x2;pbest2=ones(N,1);for i=1:Npbest2(i)=fitness(x2(i,:),D);end%-----初始化种全局最有位置和最优解------g2=1000*ones(1,D);gbest2=1000;for i=1:Nif(pbest2(i)<gbest2)g2=p2(i,:);gbest2=pbest2(i);endendgb2=ones(1,T);%------浸入主循环,按照公式依次迭代直到满足精度或者迭代次数---for i=1:Tfor j=1:Nif (fitness(x2(j,:),D)<pbest2(j))p2(j,:)=x2(j,:);pbest2(j)=fitness(x2(j,:),D);endif(pbest2(j)<gbest2)g2=p2(j,:);gbest2=pbest2(j);endv2(j,:)=w*v2(j,:)+c12*rand*(p2(j,:)-x2(j,:))+c22*rand*(g2-x2(j,:)); x2(j,:)=x2(j,:)+v2(j,:);endgb2(i)=gbest2;endplot(gb2)TempStr=sprintf('c1= %g ,c2=%g',c12,c22);title(TempStr);xlabel('迭代次数');ylabel('适应度值');b )适应度函数%适应度函数(fitness.m )function result=fitness(x,D)sum=0;for i=1:Dsum=sum+x(i)^2;endresult=sum;程序2当22111c c 于2.1,2,02212w c c 对比a)%主函数源程序(main.m )%------基本粒子群算法(particle swarm optimization )%------名称:基本粒子群算法%------初始格式化clear all;%清除所有变量clc;%清屏format long;%将数据显示为长整形科学计数%------给定初始条条件------------------ N=40;%3初始化群体个数D=10;%初始化群体维数T=100;%初始化群体最迭代次数c11=2;%学习因子1c21=2; %学习因子2。

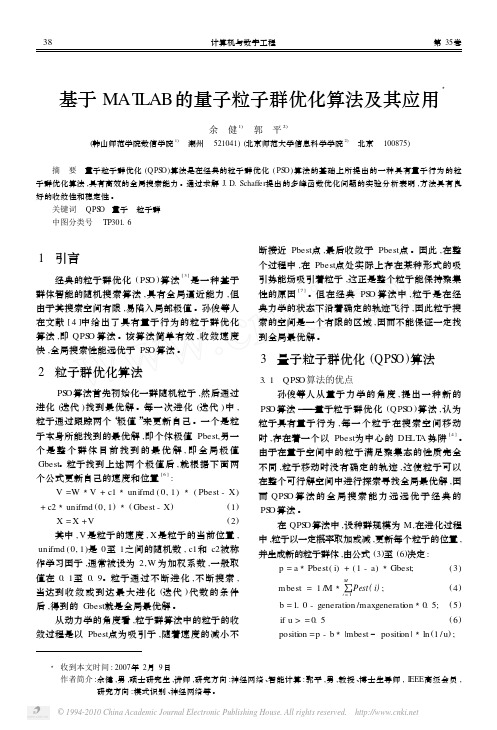

基于MATLAB的量子粒子群优化算法及其应用

end 其中 , b为收缩扩张因子 。 3. 2. 4 主程序 QPSO 算法具体实现步骤如下 : (1)确定种群规模 M 和粒子维数 D ,初始化粒 子群体 、Pbest和 Gbest; (2)根据目标函数计算每一个粒子的适应度 ; ( 3 )根据其适应度 ,更新个体最优位置 Pbest

( i)和群体最优位置 Gbest; (4)根据公式 (3)至 (6)以一定概率取加或减 ,

3. 2. 3 更新粒子的位置 粒子的位置的更新是基于公式 ( 3 )至 ( 6 ) ,下

面给出其实现的伪代码 :

a = unifrnd (0, 1) ; u = unifrnd (0, 1) ; b = 1. 0 - 当前代数 /最大代数 3 0. 5;

p = a3 Pbest ( i, : ) + (1 - a) 3 Gbest;

m in f ( x1, x2) =

0.

5

+

sin2 [ 1. 0 + 0.

x21 + x22 - 0. 5 001 ( x21 + x22 )

]2

(7)

s. t. - 100≤xi ≤100

它的全局极小点是 (0, 0 ) ,而在距全局极小点大约

3. 14范围内凹陷部有无数多的局部极小点 ,一般

算法很难搜索到全局最小点 。

3 收到本文时间 : 2007年 2月 9日 作者简介 :余健 ,男 ,硕士研究生 ,讲师 ,研究方向 :神经网络 、智能计算 :郭平 ,男 ,教授 、博士生导师 , IEEE高级会员 , 研究方向 :模式识别 、神经网络等 。

© 1994-2010 China Academic Journal Electronic Publishing House. All rights reserved.

matlab量子粒群实例 -回复

matlab量子粒群实例-回复如何使用MATLAB实现量子粒子群算法。

量子粒子群算法(Quantum Particle Swarm Optimization,QPSO)是一种基于量子力学的优化算法,它模拟了量子粒子在高维空间中的搜索和迁移行为。

这种算法可以用于求解复杂的优化问题,如神经网络训练、组合优化问题等。

本文将介绍如何使用MATLAB实现量子粒子群算法,并给出一个具体的实例。

第一步,导入数据和设置参数在使用MATLAB实现量子粒子群算法之前,我们首先需要导入待优化的数据,并设置算法的相关参数。

在本文的实例中,我们将优化一个简单的函数,即f(x) = x^2,目标是寻找使函数取得最小值的x。

导入数据x_min = -5; 自变量的最小值x_max = 5; 自变量的最大值n = 50; 群体中粒子的个数max_iters = 100; 最大迭代次数设置算法的参数omega = 0.5; 惯性权重c1 = 2.0; 个体认知参数c2 = 2.0; 群体认知参数第二步,初始化粒子的位置和速度在QPSO算法中,每个粒子都有自己的位置和速度。

位置表示粒子在搜索空间中的位置,速度表示粒子在搜索空间中的运动方向和速度大小。

在初始化阶段,我们随机生成粒子的位置和速度,并计算粒子的适应度。

初始化粒子的位置和速度x = x_min + (x_max - x_min) * rand(n, 1); 随机生成位置v = (x_max - x_min) * rand(n, 1); 随机生成速度计算粒子的适应度f = x.^2;第三步,更新粒子的位置和速度QPSO算法通过更新粒子的位置和速度来搜索更好的解。

在每次迭代中,我们根据粒子的位置和速度的公式来更新它们的值。

for iter = 1:max_iters更新粒子的速度v = omega * v + c1 * rand(n, 1) .* (x - x_personal_best) + c2 * rand(n, 1) .* (x_global_best - x);更新粒子的位置x = x + v;限制粒子的位置在搜索空间内x(x < x_min) = x_min;x(x > x_max) = x_max;更新粒子的适应度f = x.^2;更新个体最优解和群体最优解[f_personal_best, idx_personal_best] = min(f);x_personal_best = x(idx_personal_best);[f_global_best, idx_global_best] = min(f_personal_best);x_global_best = x_personal_best(idx_global_best);end第四步,输出结果在每次迭代中,我们可以输出当前得到的最优解和适应度值。

简述粒子群算法的主要流程

简述粒子群算法的主要流程下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!粒子群优化算法(Particle Swarm Optimization, PSO)是由Kennedy和Eberhart于1995年提出的一种基于群体智能的优化工具。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

%---------程序正文-------------------clear all;close all;%---------变量部分-------------------popsize=50; %种群规模vartotal=2; %变量个数inertia=0.5; %惯性因子selfw=2.0; %自身因子globalw=2.0; %全局因子mutatep=0.05; %变异概率maxgen=500; %限定代数%---------数组部分-----------------------varrange(1,1)=-512; %第一变量最小值varrange(1,2)=512; %第一变量最大值varrange(2,1)=-512; %第二变量最小值varrange(2,2)=512; %第二变量最大值%---------粒子位置初始化-----------------for i=1:1:popsizefor j=1:1:vartotalangle(i,j)=2*pi*rand;chrom(i,1,j)=cos(angle(i,j)); %第i个粒子(量子染色体)的幅角余弦chrom(i,2,j)=sin(angle(i,j)); %第i个粒子(量子染色体)的幅角正弦selfangle(i,j)=2*pi*rand;selfchrom(i,1,j)=cos(angle(i,j));%第i个粒子自身最优位置的幅角余弦selfchrom(i,2,j)=sin(angle(i,j));%第i个粒子自身最优位置的幅角正弦dangle(i,j)=0;endend1%---------解空间变换------------------------for i=1:1:popsizefor j=1:1:2for k=1:1:vartotalchromx(i,j,k)=0.5*(varrange(k,2)*(1+chrom(i,j,k))+varrange(k,1)*(1-chrom(i,j,k)));selfchromx(i,j,k)=0.5*(varrange(k,2)*(1+selfchrom(i,j,k))+varrange(k,1)*(1-selfchrom(i,j,k)));endendend1%---------计算适应度----------------------------for i=1:1:popsizefor j=1:1:2fitness(i,j)=-chromx(i,j,1)*sin((abs(chromx(i,j,2)+1-chromx(i,j,1)))^0.5)*cos((abs(chromx(i,j,2)+1+c hromx(i,j,1)))^0.5)-(chromx(i,j,2)+1)*cos((abs(chromx(i,j,2)+1-chromx(i,j,1)))^0.5)*sin((abs(chromx(i,j,2)+1+chromx(i ,j,1)))^0.5);selffitness(i,j)=-selfchromx(i,j,1)*sin((abs(selfchromx(i,j,2)+1-selfchromx(i,j,1)))^0.5)*cos((abs(self chromx(i,j,2)+1+selfchromx(i,j,1)))^0.5)-(selfchromx(i,j,2)+1)*cos((abs(selfchromx(i,j,2)+1-selfchromx(i,j,1)))^0.5)*sin((abs(selfchromx(i,j, 2)+1+selfchromx(i,j,1)))^0.5);endend%---------适应度统计------------------------------minfit=fitness(1,1);if fitness(1,1)>fitness(1,2)minfit=fitness(1,2);endmaxfit=fitness(1,2);bestchain=2;if fitness(1,1)>fitness(1,2);maxfit=fitness(1,1);bestchain=1;endminfitindex=1;maxfitindex=1;avgfit=(fitness(1,1)+fitness(1,2))/(2*popsize);for i=2:1:popsizefor j=1:1:2if minfit>fitness(i,j)minfit=fitness(i,j);minfitindex=i;endif maxfit<fitness(i,j)maxfit=fitness(i,j);maxfitindex=i;bestchain=j;endavgfit=avgfit+fitness(i,j)/(2*popsize);endend%---------初始化全局最优解--------------------------gloangle(1,:)=angle(maxfitindex,:); %获得全局最优相位glochrom(1,:,:)=chrom(maxfitindex,:,:); %初始化全局最优位置glochromx(1,:,:)=chromx(maxfitindex,:,:); %初始化全局最优位置glofit=fitness(maxfitindex,bestchain); %获得全局最大适应度%---------程序主循环开始----------------------------for gen=1:1:maxgen%---------粒子位置移动------------------------------for i=1:1:popsizefor j=1:1:vartotalt1=selfangle(i,j)-angle(i,j);if t1<-pit1=t1+2*pi;endif t1>pit1=t1-2*pi;endt2=gloangle(1,j)-angle(i,j);if t2<-pit2=t2+2*pi;endif t2>pit2=t2-2*pi;enddangle(i,j)=inertia*dangle(i,j)+selfw*rand*t1+globalw*rand*t2;angle(i,j)=angle(i,j)+dangle(i,j); %移动后的相位chrom(i,1,j)=cos(angle(i,j)); %移动后的位置chrom(i,2,j)=sin(angle(i,j)); %移动后的位置%解空间变换chromx(i,1,j)=0.5*(varrange(j,2)*(1+chrom(i,1,j))+varrange(j,1)*(1-chrom(i,1,j)));chromx(i,2,j)=0.5*(varrange(j,2)*(1+chrom(i,2,j))+varrange(j,1)*(1-chrom(i,2,j)));endfor j=1:1:2fitness(i,j)=-chromx(i,j,1)*sin((abs(chromx(i,j,2)+1-chromx(i,j,1)))^0.5)*cos((abs(chromx(i,j,2)+1+c hromx(i,j,1)))^0.5)-(chromx(i,j,2)+1)*cos((abs(chromx(i,j,2)+1-chromx(i,j,1)))^0.5)*sin((abs(chromx(i,j,2)+1+chromx(i ,j,1)))^0.5);%计算适应度endend%---------粒子位置变异------------------------for i=1:1:popsizefor j=1:1:vartotalif rand<mutatepangle(i,j)=pi/2-angle(i,j); %变异后的相位chrom(i,1,j)=cos(angle(i,j)); %变异后的位置chrom(i,2,j)=sin(angle(i,j)); %变异后的位置%解空间变换chromx(i,1,j)=0.5*(varrange(j,2)*(1+chrom(i,1,j))+varrange(j,1)*(1-chrom(i,1,j)));chromx(i,2,j)=0.5*(varrange(j,2)*(1+chrom(i,2,j))+varrange(j,1)*(1-chrom(i,2,j)));endendfor j=1:1:2fitness(i,j)=-chromx(i,j,1)*sin((abs(chromx(i,j,2)+1-chromx(i,j,1)))^0.5)*cos((abs(chromx(i,j,2)+1+c hromx(i,j,1)))^0.5)-(chromx(i,j,2)+1)*cos((abs(chromx(i,j,2)+1-chromx(i,j,1)))^0.5)*sin((abs(chromx(i,j,2)+1+chromx(i ,j,1)))^0.5);%计算适应度endend%---------统计适应度----------------------------minfit=fitness(1,1);if fitness(1,1)>fitness(1,2)minfit=fitness(1,2);endmaxfit=fitness(1,2);bestchain=2;if fitness(1,1)>fitness(1,2)maxfit=fitness(1,1);bestchain=1;endminfitindex=1;maxfitindex=1;avgfit=(fitness(1,1)+fitness(1,2))/(2*popsize);for i=2:1:popsizefor j=1:1:2if minfit>fitness(i,j)minfit=fitness(i,j);minfitindex=i;endif maxfit<fitness(i,j)maxfit=fitness(i,j);maxfitindex=i;bestchain=j;endavgfit=avgfit+fitness(i,j)/(2*popsize);endend%---------更新自身最优位置---------------------for i=1:1:popsizet1=fitness(i,1);if t1<fitness(i,2)t1=fitness(i,2);endt2=selffitness(i,1);if t2<selffitness(i,2)t2=selffitness(i,2);endif t1>t2selfangle(i,:)=angle(i,:);selfchrom(i,:,:)=chrom(i,:,:);selfchromx(i,:,:)=chromx(i,:,:);selffitness(i,:)=fitness(i,:);endend%---------更新全局最优位置--------------------if glofit<fitness(maxfitindex,bestchain)gloangle(1,:)=angle(maxfitindex,:); %获得全局最优相位glochrom(1,:,:)=chrom(maxfitindex,:,:); %初始化全局最优位置glochromx(1,:,:)=chromx(maxfitindex,:,:); %初始化全局最优位置glofit=fitness(maxfitindex,bestchain); %获得全局最大适应度end%---------记录结果----------------------------iteration(gen)=genresult(gen)=glofitif result(gen)>511break;end %511.7077end%---------程序主循环结束-------------------------bestresult=glofit;iterationstep=gen;bestresultiterationstepfigure(1)plot(iteration,result)。