解决多元线性回归中多重共线性问题的方法分析

多元回归分析中的多重共线性及其解决方法

多元回归分析中的多重共线性及其解决方法在多元回归分析中,多重共线性是一个常见的问题,特别是在自变量之间存在高度相关性的情况下。

多重共线性指的是自变量之间存在线性相关性,这会造成回归模型的稳定性和可靠性下降,使得解释变量的效果难以准确估计。

本文将介绍多重共线性的原因及其解决方法。

一、多重共线性的原因多重共线性常常发生在自变量之间存在高度相关性的情况下,其主要原因有以下几点:1. 样本数据的问题:样本数据中可能存在过多的冗余信息,或者样本数据的分布不均匀,导致变量之间的相关性增加。

2. 选择自变量的问题:在构建回归模型时,选择了过多具有相似解释作用的自变量,这会增加自变量之间的相关性。

3. 数据采集的问题:数据采集过程中可能存在误差或者不完整数据,导致变量之间的相关性增加。

二、多重共线性的影响多重共线性会对多元回归模型的解释变量产生不良影响,主要表现在以下几个方面:1. 回归系数的不稳定性:多重共线性使得回归系数的估计不稳定,难以准确反映各个自变量对因变量的影响。

2. 系数估计值的无效性:多重共线性会导致回归系数估计偏离其真实值,使得对因变量的解释变得不可靠。

3. 预测的不准确性:多重共线性使得模型的解释能力下降,导致对未知数据的预测不准确。

三、多重共线性的解决方法针对多重共线性问题,我们可以采取以下几种方法来解决:1. 剔除相关变量:通过计算自变量之间的相关系数,发现高度相关的变量,选择其中一个作为代表,将其他相关变量剔除。

2. 主成分分析:主成分分析是一种降维技术,可以通过线性变换将原始自变量转化为一组互不相关的主成分,从而降低多重共线性造成的影响。

3. 岭回归:岭回归是一种改良的最小二乘法估计方法,通过在回归模型中加入一个惩罚项,使得回归系数的估计更加稳定。

4. 方差膨胀因子(VIF):VIF可以用来检测自变量之间的相关性程度,若某个自变量的VIF值大于10,则表明该自变量存在较高的共线性,需要进行处理。

多重共线性的解决方法之——岭回归与LASSO

多重共线性的解决⽅法之——岭回归与LASSO 多元线性回归模型的最⼩⼆乘估计结果为如果存在较强的共线性,即中各列向量之间存在较强的相关性,会导致的从⽽引起对⾓线上的值很⼤并且不⼀样的样本也会导致参数估计值变化⾮常⼤。

即参数估计量的⽅差也增⼤,对参数的估计会不准确。

因此,是否可以删除掉⼀些相关性较强的变量呢?如果p个变量之间具有较强的相关性,那么⼜应当删除哪⼏个是⽐较好的呢?本⽂介绍两种⽅法能够判断如何对具有多重共线性的模型进⾏变量剔除。

即岭回归和LASSO(注:LASSO是在岭回归的基础上发展的)思想:既然共线性会导致参数估计值变得⾮常⼤,那么给最⼩⼆乘的⽬标函数加上基础上加上⼀个对的惩罚函数最⼩化新的⽬标函数的时候便也需要同时考虑到值的⼤⼩,不能过⼤。

在惩罚函数上加上系数k随着k增⼤,共线性的影响将越来越⼩。

在不断增⼤惩罚函数系数的过程中,画下估计参数(k)的变化情况,即为岭迹。

通过岭迹的形状来判断我们是否要剔除掉该参数(例如:岭迹波动很⼤,说明该变量参数有共线性)。

步骤:1. 对数据做标准化,从⽽⽅便以后对(k)的岭迹的⽐较,否则不同变量的参数⼤⼩没有⽐较性。

2. 构建惩罚函数,对不同的k,画出岭迹图。

3. 根据岭迹图,选择剔除掉哪些变量。

岭回归的⽬标函数式中,t为的函数。

越⼤,t越⼩(这⾥就是k)如上图中,相切点便是岭回归得出来的解。

是岭回归的⼏何意义。

可以看出,岭回归就是要控制的变化范围,弱化共线性对⼤⼩的影响。

解得的岭回归的估计结果为:岭回归的性质由岭回归的⽬标函数可以看出,惩罚函数的系数 (或者k)越⼤,⽬标函数中惩罚函数所占的重要性越⾼。

从⽽估计参数也就越⼩了。

我们称系数 (或者k)为岭参数。

因为岭参数不是唯⼀的,所以我们得到的岭回归估计实际是回归参数的⼀个估计族。

例如下表中:岭迹图将上表中回归估计参数与岭回归参数k之间的变化关系⽤⼀张图来表⽰,便是岭迹图当不存在奇异性是,岭迹应该是稳定地逐渐趋于0当存在奇异性时,由岭回归的参数估计结果可以看出来,刚开始k不够⼤时,奇异性并没有得到太⼤的改变,所以随着k的变化,回归的估计参数震动很⼤,当k⾜够⼤时,奇异性的影响逐渐减少,从⽽估计参数的值变的逐渐稳定。

多元线性回归模型常见问题及解决方法

上述即为加权最小二乘法,其中权数 为1 。

f ( X ji )

普通最小二乘法只是加权最小二乘法中权数恒 取1的一种特例,加权最小二乘法具有比普通 最小二乘法更普遍的意义。

加权最小二乘法也称为广义最小二乘法 (Generalized Least Squares, GLS)。

加权最小二乘法的关键是寻找适当的权,或者

nR2~χ2

在大样本下,对统计量nR2进行相应的χ2检验。

若存在异方差性,表明 e%i2与解释变量的某种 组合有显著的相关性,这时往往有较大的可决 系数R2,并且某一参数的t检验值较大。

加权最小二乘法(WLS)

加权最小二乘法(Weighted Least Squares, WLS) 是对原模型加权,使之变成一个新的不存在异 方差性的模型,然后采用普通最小二乘法估计 其参数。

2

L k

f

1 (X

ji )

X ki

f

1 (X

ji

)

i

f

1 (X

ji )

X 2i

在新模型中,

2

Var

f

1 (X

ji

)

i

1

f (X ji )

Var(i )

1 f (X ji )

f (X ji ) 2

2

即满足同方差性,可用普通最小二乘法估计其 参数,得到参数β0,β1,…,βk的无偏、有效估计量。

序列相关性产生的原因

经济变量故有的惯性(物价指数,消费) 模型设定的偏误 数据的编造 (由已知数据生成)

(一)经济变量故有的惯性

消费函数模型:

回归分析中的多重共线性问题及解决方法(六)

回归分析中的多重共线性问题及解决方法回归分析是统计学中常用的一种分析方法,用于研究自变量与因变量之间的关系。

然而,在进行回归分析时,常常会遇到多重共线性的问题。

多重共线性指的是自变量之间存在高度相关性,这会导致回归系数估计不准确,模型预测能力下降,甚至使得结果产生误导。

本文将探讨回归分析中的多重共线性问题及解决方法。

多重共线性问题的产生多重共线性问题通常是由于自变量之间存在高度相关性所导致的。

当自变量之间存在线性相关关系时,回归模型的系数估计变得不稳定,可能会产生较大的标准误差,从而影响对因变量的预测能力。

多重共线性问题的影响多重共线性问题会使得回归系数的估计产生偏离,导致模型的稳定性下降。

此外,多重共线性还会对回归模型的解释能力产生影响,使得模型的可信度下降。

解决多重共线性的方法为了解决多重共线性问题,可以采取以下几种方法:1. 增加样本量增加样本量可以减少参数估计的方差,从而提高估计的精确度。

通过增加样本量,可以减轻多重共线性对参数估计的影响。

2. 删除相关自变量当自变量之间存在高度相关性时,可以考虑删除其中一个或多个相关自变量,以减轻多重共线性的影响。

通过删除相关自变量,可以减少模型的复杂性,提高模型的解释能力。

3. 合并相关自变量另一种解决多重共线性问题的方法是合并相关自变量。

通过将相关自变量进行合并或者构建新的自变量,可以降低自变量之间的相关性,从而减轻多重共线性的影响。

4. 使用主成分分析主成分分析是一种常用的多重共线性处理方法。

通过主成分分析,可以将相关自变量进行线性组合,从而得到一组新的无关自变量,使得回归模型的稳定性得到提高。

5. 使用正则化方法正则化方法是另一种处理多重共线性问题的有效手段。

通过对回归系数进行惩罚,可以有效地控制多重共线性对参数估计的影响,从而提高模型的稳定性。

结语多重共线性是回归分析中常见的问题,对回归模型的稳定性和预测能力都会产生负面影响。

因此,处理多重共线性问题是非常重要的。

多元回归公式多重共线性变量选择的计算方法

多元回归公式多重共线性变量选择的计算方法多元回归分析是一种常用的统计分析方法,用于研究多个自变量对因变量的影响关系。

然而,在多元回归分析中,可能会存在多个自变量之间的共线性问题,即自变量之间存在较高的线性相关性。

共线性会导致回归系数估计不准确,难以解释自变量的独立作用。

因此,选择合适的变量和解决多重共线性问题是进行多元回归分析的重要步骤。

为了解决多重共线性问题,研究者可以借助各种方法进行变量选择。

下面将介绍几种常用的计算方法。

1. 方差膨胀因子(VIF)法方差膨胀因子是用于判断多重共线性的常用指标。

它反映了每个自变量与其他自变量的线性关系程度。

计算VIF的方法是,对于第i个自变量,回归模型中除了自己以外的其他自变量作为解释变量进行回归分析,计算对应的R^2值。

然后,使用VIF=1/(1-R^2)计算方差膨胀因子。

通常,如果某个自变量的VIF值大于10,就表明存在高度共线性。

2. 特征值法特征值法是基于自变量矩阵的特征值和特征向量进行计算的方法。

首先,计算自变量矩阵的相关系数矩阵,然后对该矩阵进行特征值分解。

根据特征值的大小,可以判断出存在共线性的自变量。

如果某个特征值远大于其他特征值,就表明对应的自变量存在共线性。

3. 逐步回归法逐步回归法是一种逐步选择自变量的方法。

该方法分为前向选择和后向删除两个阶段。

在前向选择阶段,逐步添加自变量,每次选择与残差最相关的自变量加入模型。

在后向删除阶段,逐步删除对残差影响最小的自变量,直到模型中的自变量都显著。

4. 岭回归法岭回归法是一种通过加入正则化项来解决多重共线性问题的方法。

它通过控制正则化参数的大小,提高对共线性的抵抗能力。

岭回归法的核心是对回归系数进行缩减,使其趋近于零。

使用岭回归可以有效剔除共线性变量,得到更稳定的回归结果。

综上所述,多元回归公式多重共线性变量选择的计算方法有方差膨胀因子法、特征值法、逐步回归法和岭回归法等。

每种方法都有其特点和适用范围,研究者可以根据具体问题选择合适的方法进行变量选择,以获得可靠的回归结果。

回归分析中的多重共线性问题及解决方法(七)

回归分析是统计学中常用的一种方法,它用于研究自变量和因变量之间的关系。

然而,在实际应用中,经常会遇到多重共线性的问题,这给回归分析带来了一定的困难。

本文将讨论回归分析中的多重共线性问题及解决方法。

多重共线性是指独立自变量之间存在高度相关性的情况。

在回归分析中,当自变量之间存在多重共线性时,会导致回归系数估计不准确,标准误差增大,对因变量的预测能力降低,模型的解释能力受到影响。

因此,多重共线性是回归分析中需要重点关注和解决的问题之一。

解决多重共线性问题的方法有很多种,下面将介绍几种常用的方法。

一、增加样本量增加样本量是解决多重共线性问题的一种方法。

当样本量足够大时,即使自变量之间存在一定的相关性,也能够得到较为稳健的回归系数估计。

因此,可以通过增加样本量来减轻多重共线性对回归分析的影响。

二、使用主成分回归分析主成分回归分析是一种常用的处理多重共线性问题的方法。

主成分回归分析通过将原始自变量进行线性变换,得到一组新的主成分变量,这些主成分变量之间不存在相关性,从而避免了多重共线性问题。

然后,利用这些主成分变量进行回归分析,可以得到更为准确稳健的回归系数估计。

三、岭回归岭回归是一种经典的解决多重共线性问题的方法。

岭回归通过对回归系数施加惩罚项,从而减小回归系数的估计值,进而降低多重共线性对回归分析的影响。

岭回归的思想是在最小二乘估计的基础上加上一个惩罚项,通过调节惩罚项的系数来平衡拟合优度和模型的复杂度,从而得到更为稳健的回归系数估计。

四、逐步回归逐步回归是一种逐步选择自变量的方法,可以用来解决多重共线性问题。

逐步回归可以通过逐步引入或剔除自变量的方式,来得到一组最优的自变量组合,从而避免了多重共线性对回归系数估计的影响。

以上所述的方法都可以用来解决回归分析中的多重共线性问题。

在实际应用中,应该根据具体的情况选择合适的方法来处理多重共线性问题,从而得到准确可靠的回归分析结果。

总之,多重共线性是回归分析中需要重点关注的问题,通过合适的方法来处理多重共线性问题,可以得到更为准确稳健的回归系数估计,从而提高回归分析的预测能力和解释能力。

用主成分法解决多重共线性问题

用主成分法解决多重共线性问题一、多重共线性的表现线性回归模型中的解释变量之间由于存在精确相关关系或高度相关关系。

看似相互独立的指标本质上是相同的,是可以相互代替的,但是完全共线性的情况并不多见,一般出现的是在一定程度上的共线性,即近似共线性。

二、多重共线性的后果1.理论后果多重共线性是因为变量之间的相关程度比较高。

按布兰查德认为, 在计量经济学中, 多重共线性实质上是一个“微数缺测性”问题,就是说多重共线性其实是由样本容量太小所造成,当样本容量越小,多重共线性越严重。

多重共线性的理论主要后果:(1)完全共线性下参数估计量不存在;(2)近似共线性下OLS估计量非有效;(3)模型的预测功能失效;(4)参数估计量经济含义不合理2.现实后果(1)各个解释变量对指标最后结论影响很难精确鉴别;(2)置信区间比原本宽,使得接受假设的概率更大;(3)统计量不显著;(4)拟合优度的平方会很大;(5)OLS估计量及其标准误对数据微小的变化也会很敏感。

三、多重共线性产生的原因1.模型参数的选用不当,在我们建立模型时如果变量之间存在着高度的相关性2. 由于研究的经济变量随时间往往有共同的变化趋势,他们之间存在着共性。

例如当经济繁荣时,反映经济情况的指标有可能按着某种比例关系增长3. 滞后变量。

滞后变量的引入也会产生多重共线行,例如本期的消费水平除受本期的收入影响之外,还有可能受前期的收入影响,建立模型时,本期的收入水平就有可能和前期的收入水平存在着共线性。

四、多重共线性的识别1.方差扩大因子法( VIF)一般认为如果最大的VIF超过10,常常表示存在多重共线性。

2.容差容忍定法如果容差(tolerance)<=0.1,常常表示存在多重共线性。

3. 条件索引条件索引(condition index)>10,可以说明存在比较严重的共线性。

五、多重共线性的处理方法处理方法有多重增加样本容量、剔除因子法、PLS(偏最小二乘法)、岭回归法、主成分法。

多重共线性解决方法

多重共线性解决方法

多重共线性是指在回归模型中,自变量之间存在高度相关性的情况,这会导致模型的解释能力下降,系数估计不准确,模型的稳定性受到影响。

以下是一些解决多重共线性问题的方法:

1.增加样本量:通过增加样本量可以减少模型中的抽样误差,从而减轻多重共线性的影响。

2.删除冗余变量:通过剔除高度相关的自变量,可以降低共线性的程度。

可以使用相关性矩阵或者变量膨胀因子(VIF)来判断哪些自变量之间存在高相关性,并选择保留一个或几个相关性较为弱的变量。

3.主成分分析(PCA):主成分分析可以将高度相关的自变量转换成一组无关的主成分,从而降低共线性的影响。

可以选择保留其中的几个主成分作为新的自变量,代替原始的自变量。

4.岭回归(Ridge Regression):岭回归是在普通最小二乘法的基础上加入一个正则化项,通过缩小系数估计的幅度,减少共线性对系数估计的影响。

岭回归可以通过交叉验证选择合适的正则化参数。

5.套索回归(Lasso Regression):套索回归也是在普通最小二乘法的基础上加入一个正则化项,不同的是套索回归使用L1范数作为正则化项,可以将一些系

数估计缩减为零,从而实现变量选择的效果。

6.弹性网回归(Elastic Net Regression):弹性网回归是岭回归和套索回归的结合,同时使用L1和L2范数作为正则化项,可以在预测准确性和变量选择之间进行权衡。

以上方法可以根据具体问题的特点和需求选择合适的方法来解决多重共线性问题。

回归模型中多重共线性的情形及其处理

丫= 1+ 8人-4人+ 3为=1 + 8人-(3X2+ 2)+ 3为=7+ 8人-9%(1.5)在(1.4)中,X2的系数为12,表示丫与为成正比例关系,即正相关;而在(1.5)中,X2的系数为-9,表示丫与X?成负比例关系,即负相关。

如此看来,同一个方程丫= 1+ 4片+ 3X2变换出的两个等价方程,由于不同的因式分解和替换,导致两个方程两种表面上矛盾的结果。

实际上,根据X1 = 3为+ 2式中的X1与为的共线性,X1约相当于3X2, 在(1.4)减少了3人,即需要用9个X2来补偿;而在(1.5)增加了4人, 需要用12个X2来抵消,以便保证两个方程的等价性,这样一来使得(1.5)中为的系数变为了负数。

从上述分析看来,由于X i与勺的共线性,使得同一个方程有不同的表达形式,从而使得丫与为间的关系难以用系数解释。

2•对多重线性关系的初步估计与识别如果在实际应用中产生了如下情况之一,则可能是由于多重共线性的存在而造成的,需作进一步的分析诊断。

①增加(或减去)一个变量或增加(或剔除)一个观察值,回归系数发生了较大变化。

②实际经验中认为重要的自变量的回归系数检验不显著。

③回归系数的正负号与理论研究或经验相反。

④在相关矩阵中,自变量的相关系数较大。

⑤自变量回归系数可信区间范围较广等。

3•对多重共线性本质的认识多重共线性可分为完全多重共线性和近似多重共线性(或称高度相关性),现在我们集中讨论多重共线性的本质问题。

多重共线性普遍被认为是数据问题或者说是一种样本现象。

我们认为,这种普遍认识不够全面,对多重共线性本质的认识,至少可从以下几方面解解。

(3)检验解释变量相互之间的样本相关系数。

假设我们有三个解释变量X i、X2、X3,分别以「12、「13、「23 来表示X i 与X2、X i 与X3、X2与X3之间的两两相关系数。

假设r i2 = 0.90,表明X i与X2之间高度共线性,现在我们来看相关系数「12,3,这样一个系数我们定义为偏相关系数,它是在变量X3为常数的情况下,X i与X2之间的相关系数。

多元线性回归模型常见问题及解决方法

特点

03

04

05

适用于多个自变量对因 变量的影响研究;

适用于线性关系假设下 的数据;

可通过参数估计和模型 检验来评估模型的可靠 性和预测能力。

多元线性回归模型的应用场景

经济预测

用于预测股票价格、GDP等经济指标;

市场营销

用于分析消费者行为、预测销售额等;

医学研究

用于分析疾病风险因素、预测疾病发 病率等;

自相关问题

残差序列之间存在相关性,违 反了线性回归模型的独立性假 设。

异常值和离群点问题

异常值和离群点对回归模型的 拟合和预测精度产生影响。

解决方法的总结与评价

01

02

03

04

05

多重共线性的解 决方法

异方差性的解决 方法

自相关问题的解 决方法

解释变量的选择 异常值和离群点

方法

处理方法

如逐步回归、主成分回归 、岭回归和套索回归等。 这些方法在处理多重共线 性问题时各有优缺点,需 要根据具体问题和数据特 点选择合适的方法。

2. 稳健标准误

使用稳健标准误来纠正异方差性 对模型估计的影响。

总结词

异方差性是指模型残差在不同观 测点上的方差不相等,导致模型 估计失真。

3. 模型诊断检验

使用如White检验、BP检验等异 方差性检验方法来诊断异方差性 问题。

自相关问题

01

02

03

04

05

总结词

详细描述

1. 差分法

2. 广义最小二乘 3. 自相关图和偏

详细描述

例如,在时间序列数据中,如果一个观测值的残差 与前一个观测值的残差正相关,则会导致模型的预 测精度降低。

解决方法

回归分析中的多重共线性问题及解决方法(Ⅰ)

回归分析中的多重共线性问题及解决方法回归分析是统计学中常用的一种方法,用于研究自变量和因变量之间的关系。

然而,在实际应用中,我们经常会遇到多重共线性的问题,这会对回归系数的估计和模型的解释产生不良影响。

本文将就多重共线性问题及其解决方法展开探讨。

多重共线性指的是在回归模型中,自变量之间存在高度相关性的情况。

当自变量之间存在共线性时,回归系数的估计会变得不稳定,标准误差会增大,系数的显著性检验结果可能出现错误,同时模型的解释性也会受到影响。

因此,多重共线性是需要引起我们高度关注的问题。

多重共线性的存在主要有两个方面的原因。

一方面是样本误差的影响,当样本容量较小或者存在异常值时,容易导致自变量之间的相关性增强。

另一方面是自变量之间本身存在的相关性,这可能是由于自变量的选择不当或者研究对象的特性所致。

无论是哪一种原因,我们都需要采取相应的方法来解决多重共线性问题。

解决多重共线性问题的方法有多种途径,下面将分别从数据清洗、变量选择、正则化方法和主成分回归等方面进行探讨。

首先,对于数据清洗来说,我们需要对样本中的异常值进行识别和处理。

异常值的存在会扰乱自变量之间的关系,导致多重共线性的加剧。

因此,在进行回归分析之前,我们需要对数据进行严格的清洗,排除掉异常值对模型的影响。

其次,变量选择也是解决多重共线性问题的有效手段。

在回归分析中,不是所有的自变量都对因变量有显著的解释作用,因此我们可以通过逐步回归、岭回归等方法来筛选出对模型影响较大的自变量,从而减少多重共线性的影响。

另外,正则化方法也是解决多重共线性问题的重要途径。

岭回归、Lasso回归等方法可以通过对回归系数进行惩罚,来减少自变量之间的相关性对模型的影响。

这些方法在实际应用中得到了广泛的应用。

最后,主成分回归是另一种解决多重共线性的有效方法。

主成分回归通过将自变量进行主成分分解,从而减少自变量之间的相关性,提高回归模型的稳定性。

综上所述,回归分析中的多重共线性问题是一个不容忽视的难题,但是我们可以通过数据清洗、变量选择、正则化方法和主成分回归等多种手段来解决这一问题。

浅析多元线性回归中多重共线性问题的三种解决方法

浅析多元线性回归中多重共线性问题的三种解决方法

谢小韦

【期刊名称】《科技信息》

【年(卷),期】2009(000)028

【摘要】为了解决变量之间的多重共线性问题,本文提出了三种方法:岭回归、主成分回归和偏最小二乘回归.首先介绍了其基本思想和主要处理步骤,并通过具体实例验证出利用三种回归方法,可以消除多重共线性所带来的影响.最后,通过对结果的分析总结出三种方法的优劣.

【总页数】2页(P117-118)

【作者】谢小韦

【作者单位】南京铁道职业技术学院

【正文语种】中文

【中图分类】O1

【相关文献】

1.观测数据拟合分析中的多重共线性问题 [J], 杨杰;吴中如

2.改进SVM分类算法中多重共线性问题研究 [J], 冼广铭;齐德昱;方群;柯庆;曾碧卿;肖应旺

3.GDP预测模型中的多重共线性问题 [J], 杨振刚;郑更新

4.多元线性回归模型中处理多重共线性方法对比

——以人口迁移冲击教育资源模型为例 [J], 范圣岗;奚书静

5.局部线性估计中的多重共线性问题 [J], 吴相波;叶阿忠

因版权原因,仅展示原文概要,查看原文内容请购买。

多元线性回归分析

多元线性回归分析多元线性回归分析是一种常用的统计方法,用于研究多个自变量与因变量之间的关系。

它可以帮助我们理解多个因素对于一个目标变量的影响程度,同时也可以用于预测和解释因变量的变化。

本文将介绍多元线性回归的原理、应用和解读结果的方法。

在多元线性回归分析中,我们假设因变量与自变量之间存在线性关系。

具体而言,我们假设因变量是自变量的线性组合,加上一个误差项。

通过最小二乘法可以求得最佳拟合直线,从而获得自变量对因变量的影响。

多元线性回归分析的第一步是建立模型。

我们需要选择一个合适的因变量和若干个自变量,从而构建一个多元线性回归模型。

在选择自变量时,我们可以通过领域知识、经验和统计方法来确定。

同时,我们还需要确保自变量之间没有高度相关性,以避免多重共线性问题。

建立好模型之后,我们需要对数据进行拟合,从而确定回归系数。

回归系数代表了自变量对因变量的影响大小和方向。

通过最小二乘法可以求得使残差平方和最小的回归系数。

拟合好模型之后,我们还需要进行模型检验,以评估模型拟合的好坏。

模型检验包括对回归方程的显著性检验和对模型的拟合程度进行评估。

回归方程的显著性检验可以通过F检验来完成,判断回归方程是否显著。

而对模型的拟合程度进行评估可以通过判断决定系数R-squared的大小来完成。

解读多元线性回归结果时,首先需要看回归方程的显著性检验结果。

如果回归方程显著,说明至少一个自变量对因变量的影响是显著的。

接下来,可以观察回归系数的符号和大小,从中判断自变量对因变量的影响方向和相对大小。

此外,还可以通过计算标准化回归系数来比较不同自变量对因变量的相对重要性。

标准化回归系数表示自变量单位变化对因变量的单位变化的影响程度,可用于比较不同变量的重要性。

另外,决定系数R-squared可以用来评估模型对观测数据的拟合程度。

R-squared的取值范围在0到1之间,越接近1说明模型对数据的拟合越好。

但需要注意的是,R-squared并不能反映因果关系和预测能力。

多重共线性

注意:

较高的简单相关系数只是多重共线性存在的充分 条件,而不是必要条件。特别是在多于两个解释 变量的回归模型中,有时较低的简单相关系数也 可能存在多重共线性。因此,并不能简单地依据 相关系数进行多重共线性的准确判断。

[命令方式]COR 各个解释变量名 ,得两两简单相关

系数矩阵如下

X1

X2

X3

L Xk

x1i yi x12i

x2i yi x12i

x22i

r12

1 r122

由 得 ,则 X 2i kX1i x2i kx1i

x22i k 2 x1i x1i x2i x1i (kx1i ) k x12i

因此,ˆ1

x1i yi x22i x2i yi x1i x2i k 2 x1i yi x12i k 2 x1i yi x12i 0

性(perfect multicollinearity)即某一个解释变量可

以用其他解释变量的线性组合表示。

如果存在

λ1X1i+λ2X2i+…+λkXki+vi=0 i=1,2,…,n 其中λi不全为0,vi为随机误差项,则称为 近似共线 性(approximate multicollinearity)或不完全共线 性。

4 样本资料的限制

由于完全符合理论模型所要求的样本数据较难收 集,只能被动接受,而且只能获得一个有限范围观 察值,无法进行重复试验,如果解释变量个数大于 观测次数,就会出现过度拟合的模型。特定样本可 能存在某种程度的多重共线性。

如医疗研究中,可能只有少数病人,却要收集大 量变量的信息,这些变量之间就会出现相关性。

1、2已经失去了应有的偏回归系数经济含义, 甚至经常表现出似乎反常的现象:例如1本来应

如何解决多重共线性问题

如何解决多重共线性问题多重共线性是统计学中常见的问题,特别是在回归分析中。

它指的是自变量之间存在高度相关性,导致回归模型的稳定性和解释能力下降。

在实际应用中,解决多重共线性问题是非常重要的,下面将探讨一些常用的方法。

1. 数据收集和预处理在解决多重共线性问题之前,首先需要对数据进行收集和预处理。

数据的收集应该尽可能地多样化和全面,以避免自变量之间的相关性。

此外,还需要对数据进行清洗和转换,以确保数据的准确性和一致性。

2. 相关性分析在回归分析中,可以通过计算自变量之间的相关系数来评估它们之间的相关性。

常用的相关系数包括皮尔逊相关系数和斯皮尔曼相关系数。

如果发现自变量之间存在高度相关性,就需要考虑解决多重共线性问题。

3. 方差膨胀因子(VIF)方差膨胀因子是用来评估自变量之间共线性程度的指标。

它的计算方法是将每个自变量作为因变量,其他自变量作为自变量进行回归分析,然后计算回归系数的标准误差。

VIF越大,表示自变量之间的共线性越强。

一般来说,VIF大于10就表明存在严重的多重共线性问题。

4. 特征选择特征选择是解决多重共线性问题的一种常用方法。

通过选择与因变量相关性较高,但与其他自变量相关性较低的自变量,可以减少共线性的影响。

常用的特征选择方法包括逐步回归、岭回归和Lasso回归等。

5. 主成分分析(PCA)主成分分析是一种降维技术,可以将多个相关自变量转化为一组无关的主成分。

通过保留主成分的前几个,可以减少自变量之间的相关性,从而解决多重共线性问题。

但需要注意的是,主成分分析会损失部分信息,可能会影响模型的解释能力。

6. 岭回归和Lasso回归岭回归和Lasso回归是一种通过引入惩罚项来解决多重共线性问题的方法。

岭回归通过在最小二乘估计中添加一个L2正则化项,可以减小回归系数的估计值,从而减少共线性的影响。

Lasso回归则通过在最小二乘估计中添加一个L1正则化项,可以使得一些回归系数变为零,从而实现变量选择的效果。

多元线性回归模型中处理多重共线性方法对比

"共线性问题的改进与比对 )&$ 手动剔除变量 对两个 CKL值偏大的指标 /G %/0 进行剔除%得到多元回归 方程!

7ylm%J%(Gd%J'()/$ m%J%%'/) d%J%()/( d%J%%(/3 在手动剔除了 CKL值偏大的指标后%剩余四个变量做多元

回归拟 合 后 的 CKL值 均 呈 现 下 降 趋 势! CKL$ l3J0$0% CKL) l Gt3$3% CKL( l'JUU3% CKL3 l$0J)')% 并 且 此 模 型 的 统 计 量 =l %t%%%M) l%J'G' 表明方程有较好的显著性及对模型很好的解释 性$ 根据 /3 的 CKL值% 进 一 步 剔 除 /3 得 多 元 回 归 模 型! 7yl m%t%('d$J%%'/$ d%J%$)/) d%J%((/( %各系数均与正常逻辑相符$

44给出 ;与 7的回归方程 7yl%J%03d%J%$$;%再代入上表中

的载荷系数得 7yl%J%03 d%J%%'1(G/$ d%J%%'1'/) d%J%$%($U/( d %J%$%U)3/3 d%J%$%$G(/G d%J%$%0%3/0 $ 主成分回归虽然保留了 六个指标%但是明显的缺陷是 7y的下限为 %&%03$

L+$, >@T

对

应指

标

/&-

作为最终回归指

标之一%再将 /&-与其他指标两两组合对 7y做二元回归方程%并

记各二元回归方程对应 L值集合 {L$+), %L)+), %4%L+E)m,$ } 的最大

值为 L+>)@,T%若 L+>)@,T0S2+$%-m(, 则停止筛选%选对应的回归方程

多重共线性问题的几种解决方式

多重共线性问题的几种解决方式在多元线性回归模型经典假设中,其重要假定之一是回归模型的解释变量之间不存在线性关系,也就是说,解释变量X1,X2,……,X k中的任何一个都不能是其他解释变量的线性组合。

若是违背这一假定,即线性回归模型中某一个解释变量与其他解释变量间存在线性关系,就称线性回归模型中存在多重共线性。

多重共线性违背了解释变量间不相关的古典假设,将给普通最小二乘法带来严重后果。

这里,咱们总结了8个处置多重共线性问题的可用方式,大家在碰到多重共线性问题时可作参考:1、保留重要解释变量,去掉次要或可替代解释变量2、用相对数变量替代绝对数变量3、差分法4、慢慢回归分析5、主成份分析6、偏最小二乘回归7、岭回归8、增加样本容量这次咱们主要研究慢慢回归分析方式是如何处置多重共线性问题的。

慢慢回归分析方式的大体思想是通过相关系数r、拟合优度R2和标准误差三个方面综合判断一系列回归方程的好坏,从而取得最优回归方程。

具体方式分为两步:第一步,先将被解释变量y对每一个解释变量作简单回归:对每一个回归方程进行统计查验分析(相关系数r、拟合优度R2和标准误差),并结合经济理论分析选出最优回归方程,也称为大体回归方程。

第二步,将其他解释变量一一引入到大体回归方程中,成立一系列回归方程,按照每一个新加的解释变量的标准差和复相关系数来考察其对每一个回归系数的影响,一般按照如下标准进行分类判别:1.若是新引进的解释变量使R2取得提高,而其他参数回归系数在统计上和经济理论上仍然合理,则以为这个新引入的变量对回归模型是有利的,可以作为解释变量予以保留。

2.若是新引进的解释变量对R2改良不明显,对其他回归系数也没有多大影响,则没必要保留在回归模型中。

3.若是新引进的解释变量不仅改变了R2,而且对其他回归系数的数值或符号具有明显影响,则以为该解释变量为不利变量,引进后会使回归模型出现多重共线性问题。

不利变量未必是多余的,若是它可能对被解释变量是不可缺少的,则不能简单舍弃,而是应研究改善模型的形式,寻觅更符合实际的模型,从头进行估量。

解决多重共线性的方法

解决多重共线性的方法多重共线性是回归分析中常见的问题之一,指的是自变量之间存在高度相关关系,导致回归分析结果不准确、稳定性差。

解决多重共线性问题的主要方法有以下几种:1. 删除相关性较高的自变量:检查自变量之间的相关性,当相关系数大于0.7或0.8时,考虑删除其中一个自变量。

通常选择与因变量相关性更强的自变量作为模型的预测变量。

2. 增加样本量:多重共线性问题的一个原因是样本量较小,数据集中存在较少的观测点。

增加样本量可以减少误差,增强回归模型的稳定性。

3. 主成分分析(Principal Component Analysis, PCA):PCA是一种常用的降维方法,可以将高维的自变量空间转化为低维空间,去除自变量之间的相关性。

首先利用相关系数矩阵进行特征值分解,然后根据特征值大小选取主成分,最后通过线性变换将原始自变量转化为主成分。

4. 岭回归(Ridge Regression):岭回归是一种正则化方法,通过增加一个正则项(L2范数)来限制模型中系数的大小,从而减小共线性的影响。

岭回归可以在一定程度上缓解多重共线性问题,但会引入一定的偏差。

5. 奇异值分解(Singular Value Decomposition, SVD):奇异值分解是一种常用的矩阵分解方法,可以将自变量矩阵分解为三个矩阵的乘积,其中一个矩阵表示主成分。

通过去除奇异值较小的主成分,可以减少共线性问题。

6. 距离相关系数(Variance Inflation Factor, VIF):VIF用于度量自变量之间的相关性程度,计算每个自变量的VIF值,若VIF值大于10,则认为存在严重的多重共线性问题。

通过删除VIF值较高的自变量,可以解决多重共线性。

除了以上方法,还需注意以下问题:1. 尽量选择“经济学意义上的变量”作为自变量,避免冗余变量的引入。

2. 如果共线性问题严重,即使通过降维方法或者删除变量,仍然无法解决,可以考虑选择其他回归模型,如岭回归、Lasso回归等,这些模型在设计时已经考虑到了多重共线性问题。

多重共线性问题的定义和影响多重共线性问题的检验和解决方法

多重共线性问题的定义和影响多重共线性问题的检验和解决方法多重共线性问题的定义和影响,多重共线性问题的检验和解决方法多重共线性问题是指在统计分析中,使用多个解释变量来预测一个响应变量时,这些解释变量之间存在高度相关性的情况。

共线性是指两个或多个自变量之间存在线性相关性,而多重共线性则是指两个或多个自变量之间存在高度的线性相关性。

多重共线性问题会给数据分析带来一系列影响。

首先,多重共线性会导致统计分析不准确。

在回归分析中,多重共线性会降低解释变量的显著性和稳定性,使得回归系数估计的标准误差变大,从而降低模型的准确性。

其次,多重共线性会使得解释变量的效果被混淆。

如果多个解释变量之间存在高度的线性相关性,那么无法确定每个解释变量对响应变量的独立贡献,从而使得解释变量之间的效果被混淆。

此外,多重共线性还会导致解释变量的解释力度下降。

当解释变量之间存在高度的线性相关性时,其中一个解释变量的变化可以通过其他相关的解释变量来解释,从而降低了该解释变量对响应变量的独立解释力度。

为了检验和解决多重共线性问题,有几种方法可以采用。

首先,可以通过方差膨胀因子(VIF)来判断解释变量之间的相关性。

VIF是用来度量解释变量之间线性相关性强度的指标,其计算公式为:VIFi = 1 / (1 - R2i)其中,VIFi代表第i个解释变量的方差膨胀因子,R2i代表模型中除去第i个解释变量后,其他解释变量对第i个解释变量的线性回归拟合优度。

根据VIF的大小,可以判断解释变量之间是否存在多重共线性。

通常来说,如果某个解释变量的VIF大于10或15,那么可以认为该解释变量与其他解释变量存在显著的多重共线性问题。

其次,可以通过主成分分析(PCA)来降低多重共线性的影响。

PCA是一种降维技术,可以将高维的解释变量压缩成低维的主成分,从而减少解释变量之间的相关性。

通过PCA,可以得到一组新的解释变量,这些新的解释变量之间无相关性,并且能够保留原始解释变量的主要信息。

回归分析中的多重共线性问题及解决方法(八)

回归分析是统计学中的重要方法之一,它用来研究自变量与因变量之间的关系。

然而,在进行回归分析时,研究人员往往会遇到多重共线性的问题。

多重共线性是指自变量之间存在高度相关性的情况,这会导致回归系数估计不准确,甚至失去解释力。

本文将探讨回归分析中的多重共线性问题及解决方法。

1. 多重共线性问题的影响多重共线性问题会造成回归系数的估计不准确,导致参数估计的标准误较大,t统计量较小,从而影响回归模型的显著性检验。

此外,多重共线性还会导致回归系数的符号与理论预期相悖,使得模型的解释能力大大减弱。

2. 多重共线性问题的诊断为了解决回归分析中的多重共线性问题,首先需要进行诊断。

常用的诊断方法包括:方差膨胀因子(VIF)、特征根分析、条件数等。

其中,VIF是应用最为广泛的一种方法,它通过计算自变量之间的相关系数来判断是否存在多重共线性问题。

一般来说,如果自变量之间的相关系数较高(大于),则可以认为存在多重共线性问题。

3. 解决多重共线性的方法一旦发现回归分析中存在多重共线性问题,就需要采取相应的解决方法。

常用的解决方法包括:删除相关性较高的自变量、合并相关自变量、使用主成分回归等。

其中,删除相关自变量是最为直接的方法,但需要谨慎选择,以免丢失重要信息。

合并相关自变量则是将相关自变量进行线性组合,从而减少共线性的影响。

主成分回归则是通过将相关自变量进行主成分提取,来解决多重共线性问题。

这些方法各有优劣,需要根据具体情况来选择合适的方法。

4. 实例分析为了更好地理解多重共线性问题及解决方法,我们可以通过一个实例来进行分析。

假设我们要研究一个人的身高与体重之间的关系,我们选择了身高、体重和BMI指数作为自变量,而体脂率作为因变量。

通过回归分析,我们发现身高、体重和BMI指数之间存在较高的相关性,从而导致回归系数的估计不准确。

为了解决这一问题,我们可以采取合并相关自变量或主成分回归的方法,从而得到更为准确的回归系数估计。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

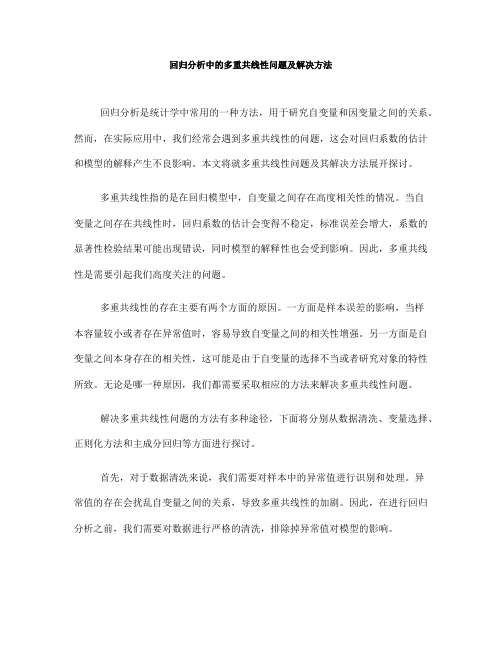

解决多元线性回归中多重共线性问题的方法分析谢小韦,印凡成河海大学理学院,南京 (210098)E-mail :xiexiaowei@摘 要:为了解决多元线性回归中自变量之间的多重共线性问题,常用的有三种方法: 岭回归、主成分回归和偏最小二乘回归。

本文以考察职工平均货币工资为例,利用三种方法的SAS 程序进行了回归分析,根据分析结果总结出三种方法的优缺点,结果表明如果能够使用定性分析和定量分析结合的方法确定一个合适的k 值,则岭回归可以很好地消除共线性影响;主成分回归和偏最小二乘回归采用成份提取的方法进行回归建模,由于偏最小二乘回归考虑到与因变量的关系,因而比主成分回归更具优越性。

关键词:多重共线性;岭回归;主成分回归;偏最小二乘回归1. 引言现代化的工农业生产、社会经济生活、科学研究等各个领域中,经常要对数据进行分析、拟合及预测,多元线性回归是常用的方法之一。

多元线性回归是研究多个自变量与一个因变量间是否存在线性关系,并用多元线性回归方程来表达这种关系,或者定量地刻画一个因变量与多个自变量间的线性依存关系。

在对实际问题的回归分析中,分析人员为避免遗漏重要的系统特征往往倾向于较周到地选取有关指标,但这些指标之间常有高度相关的现象,这便是多变量系统中的多重共线性现象。

在多元线性回归分析中,这种变量的多重相关性常会严重影响参数估计,扩大模型误差,破坏模型的稳健性,从而导致整体的拟合度很大,但个体参数估计值的t 统计量却很小,并且无法通过检验。

由于它的危害十分严重,存在却又十分的普遍,因此就要设法消除多重线性的不良影响。

常用的解决多元线性回归中多重共线性问题的模型主要有主成分回归、岭回归以及偏最小二乘回归。

三种方法采用不同的方法进行回归建模,决定了它们会产生不同的效果。

本文以统计职工平均货币工资为例,考察一组存在共线性的数据,运用SAS 程序对三种回归进行建模分析,并对结果进行比较,总结出它们的优势与局限,从而更好地指导我们解决实际问题。

2. 共线性诊断拟合多元线性回归时,自变量之间因存在线性关系或近似线性关系,隐蔽变量的显著性,增加参数估计的方差,导致产生一个不稳定的模型,因此共线性诊断的方法是基于自变量的观测数据构成的矩阵T x x 进行分析,使用各种反映自变量间相关性的指标。

共线性诊断常用统计量有方差膨胀因子VIF (或容限TOL )、条件指数和方差比例等。

一般认为:若VIF>10,说明模型中有很强的共线性关系;若条件指数值在10与30间为弱相关,在30与100间为中等相关,大于100为强相关;在大的条件指数中由方差比例超过0.5的自变量构成的变量子集就认为是相关变量集[1]。

3. 三种解决方法岭回归基本思想: 当出现多重共线性时,有0T X X ≈,从而使参数的1ˆ()T T X X X Y β−=很不稳定,出现不符合含义的估计值,给TX X 加上一个正常数矩阵(0)KI K >,则T X X KI +等于0的可能性就比TX X 的可能性要小得多,再用1ˆ()T T X X KI X Y β−=+来估计,ˆβ比用普通最小二乘估计的ˆβ要稳定得多。

主成分回归基本思想:观察n 个样本点,得到因变量y 和p 个自变量12,,,p x x x L 关系,设自变量0x = (12,,,p x x x L ) 间的相关数矩阵记为R 。

主成分回归方法完全撇开因变量y ,单独考虑对自变量集合做主成分提取。

其过程是:1) 求R 的前m 个非零特征值120m λλλ≥≥≥>L ,以及相应的特征向量12,,,m u u u L ;2) 求m 个主成分:0h h F X u = 1,2,,h m =L偏最小二乘回归的基本思想: 首先在自变量集中提取第一潜因子1t (1t 是 1,2,,mx x x L 的线性组合, 且尽可能多地提取原自变量集中的变异信息, 比如第一主成分);同时在因变量集中也提取第一潜因子1u ,并要求1t 与1u 相关程度达最大。

然后建立因变量Y 与1t 的回归,如果回归方程已达到满意的精度, 则算法终止。

否则继续第二轮潜在因子的提取, 直到能达到满的精度为止。

若最终对自变量集提取l 个潜因子12,,,l t t t L , 偏最小二乘回归将通过建立Y 与12,,,l t t t L 的回归式, 然后表示为Y 与原自变量的回归方程式[2]。

4. 实例分析全国单位大体分成三大类:国有单位,城镇集体单位和其他单位,考虑到职工的平均工资主要和这三类单位的工资有关,为了研究和分析我国职工的平均工资,需建立一个以职工平均工资为因变量,三类单位的工资为自变量的回归方程。

考察职工平均货币工资指数Y 与国有单位货币工资指数x1, 城镇集体单位货币工资指数x2, 其他单位货币工资指数x3等三个自变量有关。

现收集1991年至2005年共15年的数据,如表1所示。

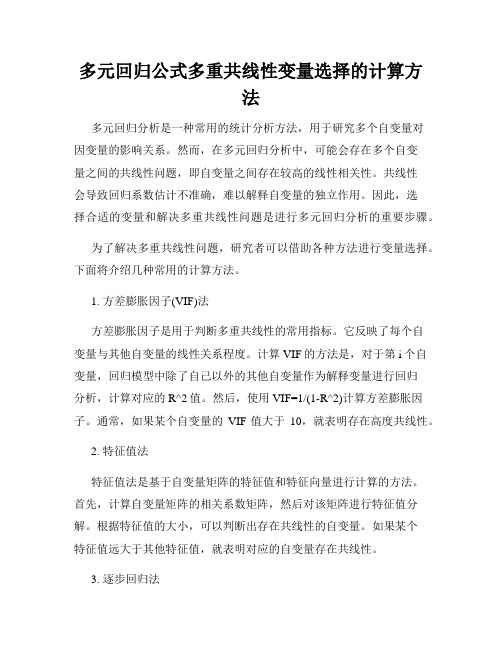

表1 职工货币工资指数Table 1 The index of staff’s monetary wage货 币 工 资 指 数 (上年=100) 年数 国有单位x1 城镇集体单位x2 其他单位x3 平均工资y1991 108.5 111.0 116.1 109.3 1992 116.2 113.0 114.4 115.9 1993 122.7 122.9 125.2 124.3 1994 135.8 125.2 126.9 134.6 1995 117.3 121.1 118.4 121.2 1996 111.6 109.4 110.7 112.9 1997 107.4 104.9 106.4 104.2 1998 106.1 102.5 97.7 106.6 1999 111.4 108.3 109.6 111.62000 111.8 108.5 111.8 112.3 2001 117.0 109.7 110.5 116.0 2002 115.1 111.6 108.8 114.3 2003 113.3 113.2 110.3 113.0 2004 114.8 113.1 111.6 114.1 2005 115.4 115.0 112.2 114.6运用SAS 程序对这组数据进行共线性诊断,输出结果见图1。

图 1 数据共线性诊断的部分结果Fig .1 Collinearity Diagnostics of the data (part)由图1的共线性诊断结果可以知最大条件指数132.46>100,说明4个自变量间有强相关性,与最大条件指数在一行的3个变量中有2个变量的方差比例都大于0.5,可见这4个变量是一个具有强相关的变量集。

由此得到回归方程为:8.3800.74910.34520.0143y x x x =−++−可以看到变量x3的系数为负,这与实际情况不符。

出现此现象的原因是变量x1与x2,x3,x4线性相关(121314(,)0.9756,(,)0.9207,(,)0.9268x x x x x x ρρρ===),此处也可看出这4个变量是多重相关的变量集。

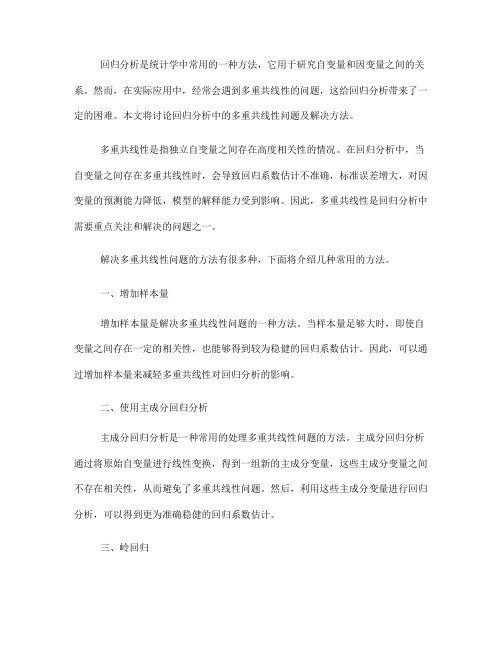

4.1 运用岭回归SAS 程序进行回归分析为了消除变量之间的多重共线性关系,用岭回归方法来建立回归方程产,并用SAS 程序进行岭回归分析,部分结果见图2、3,从岭迹图中可以看出,当0.02k ≥后,岭迹图趋于稳定。

图2 职工平均工资的岭迹图Fig. 2 Ridge mark chart of staff’s average wagek=的岭回归估计来建立岭回归方程,由图3可以写出岭回归方程式为:取0.02=−+++y x x x7.3120.70910.33820.0243图3 职工平均工资数据输出数据集(部分)Fig. 3 Output of staff’s average wage data (part)可以看出各个回归系数的方差膨胀因子均小于6,岭回归方差的均方根误差为1.37114,虽比普通最小二乘回归方程的均方根误差(1.35714)有所增大,但增加不多。

4.2 运用主成分回归SAS程序进行回归分析运用SAS程序可以得出删去第三个主成分后的主成分回归方程,结果见图4。

主成分回归方程为:=−+++y x x x7.7010.76710.27420.0333Fig. 4 Principal Component Regression’s result of staff’s average wage data可以看出各个回归系数的方差膨胀因子均小于3.5;主成分回归方程的均方根误差为1.30996,比普通最小二乘回归方程的均方根误差(1.35714)有所减小。

4.3 运用偏最小二乘回归SAS 程序进行回归分析最后,使用SAS 软件中得PLS 过程完成偏最小二乘回归分析,输出结果见图5。

图 5 职工平均工资数据偏最小二乘回归的结果Fig.5 Partial Least Square Regression’s result of staff’s average wage data由估计值可以写出标准化回归方程为0.74110.26020.0133yx x x =++%%%%,用原始变量可表示为7.9730.76110.30220.0133y x x x =−+++[3]。

偏最小二乘回归方程中回归系数的符号都是有意义的。

可知偏最小二乘回归方程的均方根误差为1.18075,比普通最小二乘回归方程的均方根误差(1.35714)有所减小,且比主成分回归方程的均方根误差为1.30996也有所减小。

由实例看出,对于这组数据的处理,三种方法中岭回归的效果相对较差,主成分回归次之,偏最小二乘回归的计算结果更为可靠。

5. 结论岭回归估计量的质量取决于k 值的选取,一般认为:在通过岭迹图和方差膨胀因子来选择k 值时,其判断方法是选择一个尽可能小的k 值,在这个较小的k 值上,岭迹图中回归系数已变得比较稳定,并且方差膨胀因子也变得足够小。

从上面的实例中可以看出岭回归的效果相对较差,这是由于k 值的确定存在一定的人为因素,所以在确定k 值的时候要把定性分析和定量分析有机的结合起来。

这样才能充分发挥岭回归的优点。

利用主成分回归的方法使主成分之间不再存在自相关现象,这就对解决多重相关性下的回归建模问题给出了某种希望。

这种成分提取的思路是十分可取的,但利用主成分进行的回归很多时候结果往往不够理想,原因在于,在上述成分提取过程中,完全没有考虑与因变量y 的联系。

这样所得到的第1 (或前几个) 主成分可能会对自变量系统有很强的概括能力,而对y 的解释能力却变得十分微弱。

偏最小二乘回归也采用成份提取的方式进行回归建模,但其思路与主成分回归却有很大的不同。