信息论与编码[第三章离散信道及其信道容量]山东大学期末考试知识点复习

信息论与编码理论-第3章信道容量-习题解答

信息论与编码理论-第3章信道容量-习题解答-071102(总11页)--本页仅作为文档封面,使用时请直接删除即可----内页可以根据需求调整合适字体及大小--第3章 信道容量习题解答3-1 设二进制对称信道的转移概率矩阵为2/31/31/32/3⎡⎤⎢⎥⎣⎦解: (1) 若12()3/4,()1/4P a P a ==,求(),(),(|),(|)H X H Y H X Y H Y X 和(;)I X Y 。

i i 2i=13311H(X)=p(a )log p(a )log()log()0.8113(/)4444bit -=-⨯-=∑符号111121*********j j j=132117p(b )=p(a )p(b |a )+p(a )p(b |a )=43431231125p(b )=p(a )p(b |a )+p(a )p(b |a )=4343127755H(Y)=p(b )log(b )=log()log()0.9799(/)12121212bit ⨯+⨯=⨯+⨯=---=∑符号22i j j i j i j i ,H(Y|X)=p(a ,b )logp(b |a )p(b |a )logp(b |a )2211log()log()0.9183(/)3333i jjbit -=-=-⨯-⨯=∑∑符号I(X;Y)=H(Y)H(Y|X)=0.97990.91830.0616(/)bit --=符号 H(X|Y)=H(X)I(X;Y)=0.81130.06160.7497(/bit --=符号)(2)求该信道的信道容量及其达到信道容量时的输入概率分布。

二进制对称信息的信道容量H(P)=-plog(p)-(1-p)log(1-p)1122C =1-H(P)=1+log()+log()=0.0817(bit/)3333符 BSC 信道达到信道容量时,输入为等概率分布,即:{,} 注意单位3-2 求下列三个信道的信道容量及其最佳的输入概率分布。

信息论与编码-复习

第6章 信道编码

计算:

对于循环码,已知(n,k)循环码 会求g(x),并根据g(x)求G, 例p191-192 6.3.3,p193 6.3.4 会求h(x)=(xn+1)/g(x),并根据h(x), 例p193 6.3.4 会求系统循环码码字:由G经过初等行变换得Gs, 再通过C=mGS得系统循环码码字

第4章 信息率失真函数

计算:

对于离散信源(如作业4.1(3)):

R(D)的计算、R(D)与D的关系图 只要求等概信源,对称失真的R(D),见P120 (4.2.50式) 关系图见P109 图4.1.1(注意区分离散和连续信源), 所取的点的纵坐标根据R(D)的计算式求得

第4章 信息率失真函数

计算:

会计算达到稳态时的状态概率分布(作业2.16(1))和 极限熵(作业2.16(2),2.17(2)和p48 例2.2.4);

给定状态转移概率,会画状态转移图,反之亦要求。

第二章 ——续

计算:

信源冗余度的计算(作业2.17(3)) 根据给出的离散信源,能够进行定长编码,求出码字。

掌握信源编码器的性能指标(编码效率η)及其与码 长(k)之间的关系。

第3章 信道容量

掌握离散无记忆信道的N次扩展信道的容量的求解

CN次扩展 NC单符号无记忆信道

无噪信道的容量:见作业3.14 应用连续信道的信道容量公式进行解题

连续信道的容量 所需的信号功率

S 如作业3.19,使用公式 C连续 B log 2 (1 ) N 注意:

C就是信号的传输速率 dB表示的信噪比在代入时要进行转换

能够通过分析电路的运行过程,得到生成的循环码字。 见课件

信息论与编码第三章

0.212 bit信/ 道符号

§3.2 单符号离散信道的信道容量

例3:求所给信道的信道容量 :

P

1/2 1/4

1/4 1/2

1/8 1/8

1/8 1/8

解:该信道为准对称信道(判,略) ⑴ 先求p(yj) :p(y0) =1/2×(1/2+1/4) =3/8=P(y1)

P(y2)=1/2×(1/8+1/8)=1/8= P(y3)

⑶ 强对称信道的最佳分布

n 1

与对称信道一样,当输入分布满足均匀分布时,使强

对称信道达到信道容量。

§3.2 单符号离散信道的信道容量

四、准对称信道的信道容量

⒈ 准对称信道的定义

❖ 信道转移阵满足行可排列的。 ❖ 信道转移阵列不可排列,但矩阵中的m列可分成互不

相交的s个子集,由子集组成的子阵则是行和列都是可 排列的。

⒉ 准对称信道的信道容量 定理:实现准对称离散无记忆信道容量的输入分布

是等概分布。 根据上述定理有:

§3.2 单符号离散信道的信道容量

C maxI(X;Y) I(X k;Y)

J- 1

j0 p (yjxi)l og1 K

p ( yjxi)

K 1

p ( yjxi)

i0

输入为均J1匀

分布→ 前提p

一、信道的表示法

⒈ 信道的矩阵表示法

一般简单的单符号离散信道的数学模型可以用概率空间[X, p(y|x), Y]来描述。

p(y1 x1) p(y2 x1) p(ym x1)

P

p(y1 x2)

p(y2 x2)

p(ym x2)

p

(

y1

xn)

p(y2 xn)

p(ym xn)

《信息论与编码》习题解答-第三章

第三章 信道容量-习题答案3.1 设二元对称信道的传递矩阵为⎥⎦⎤⎢⎣⎡3/23/13/13/2 (1) 若P(0) = 3/4, P(1) = 1/4,求H(X), H(X/Y), H(Y/X)和I(X;Y); (2) 求该信道的信道容量及其达到信道容量时的输入概率分布;解: 1)symbolbit Y X H X H Y X I symbol bit X Y H Y H X H Y X H X Y H Y H Y X H X H Y X I symbol bit y p Y H x y p x p x y p x p y x p y x p y p x y p x p x y p x p y x p y x p y p symbolbit x y p x y p x p X Y H symbolbit x p X H jj iji j i j i i i / 062.0749.0811.0)/()();(/ 749.0918.0980.0811.0)/()()()/()/()()/()();(/ 980.0)4167.0log 4167.05833.0log 5833.0()()(4167.032413143)/()()/()()()()(5833.031413243)/()()/()()()()(/ 918.0 10log )32lg 324131lg 314131lg 314332lg 3243( )/(log )/()()/(/ 811.0)41log 4143log 43()()(222221212221221211112111222=-==-==+-=+-=-=-==⨯+⨯-=-==⨯+⨯=+=+==⨯+⨯=+=+==⨯⨯+⨯+⨯+⨯-=-==⨯+⨯-=-=∑∑∑∑2)21)(/ 082.010log )32lg 3231lg 31(2log log );(max 222==⨯++=-==i mi x p symbolbit H m Y X I C3.2 解:(1)αα-==1)(,)(21x p x p⎥⎦⎤⎢⎣⎡=4/14/12/102/12/1P ,⎥⎦⎤⎢⎣⎡---=4/)1(4/)1(2/)1(02/12/1)(αααααj i y x P 4/)1()(,4/14/)(,2/1)(321αα-=+==y p y p y p接收端的不确定度:))1(41log()1(41)4141log()4141()2log(21)(αααα---++-=Y H)1log(41)1log(4123αααα---++-= (2))4log()1(41)4log()1(41)2log()1(210)2log(21)2log(21)|(ααααα-+-+-+++=X Y H α2123-= (3))|()();(X Y H Y H Y X I -=);(max )()(Y X C i x p =α,0)(=ααC d d,得到5/3=α 161.0)5/3();max(===C Y X C 3.3∑==⨯++=+=21919.001.0log 01.099.0log 99.02log log )log(j ij ij p p m C0.919*1000=919bit/s 3.4⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=εεεε-10-10001ij p2/1)()(0)(321===a p a p a p 0)(1=b p2/12/1)1(2/100)|()(),()(222=⨯+-⨯+⨯===∑∑εεi ii ii a b p a p b a p b p2/1-12/12/100)|()(),()(333=⨯+⨯+⨯===∑∑)(εεi ii ii a b p a p b a p b p)()|(log)|();(j i j ji j i b p a b p a b p Y a I ∑=0);(1=Y a Iεεεε2log )1(2log )1(0)()|(log)|();(222+--+==∑j j jj b p a b p a b p Y a I )1(2log )1(2log 0)()|(log)|();(333εεεε--++==∑j j jj b p a b p a b p Y a I当0=ε,1=C 当2/1=ε,0=C 3.5两个信道均为准对称DMC 信道设输入符号概率αα-==1)(,)(21a p a p , (1) 对于第一种信道的联合概率的矩阵为:⎥⎦⎤⎢⎣⎡---------)1(2)1)(1()1)((2)()1(αεαεαεεααεαεp p p p⎥⎦⎤⎢⎣⎡---)()1(εαεp p 3.6⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=2/1002/12/12/10002/12/10002/12/1P 121log 2121log 214log log )log(41=++=+=∑=ij j ij p p m C3.7解:(1)从已知条件可知:3,2,1,3/1)(==i x p i ,且转移概率⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡=0109101103103525110321)|(i j x y p ,则联合概率⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡==010330110110115215110161)()|(i i j ij x p x y p p ,因为:),()(∑=ij i j y x p y p ,可计算得到31)(1=y p ,21)(2=y p ,61)(3=y p499.16log 612log 213log 31)(=++=Y H(2)175.1910log 10310log 301310log 101310log10125log 1525log 151310log 1012log 61)|(log )()|(=+++++++=-=∑iji j j i x y p y x p X Y H (3)当接收为2y ,发送为2x 时正确,如果发送为1x 和3x 为错误,各自的概率为: 5/1)|(21=y x p ,5/1)|(22=y x p ,5/3)|(23=y x p 它的错误概率为:5/4)|()|(2321=+=y x p y x p p e(4)从接收端看到的平均错误概率为:===∑∑≠≠ji ij ji j i j e p y x p y p p )|()(收733.010/115/110/310/130/115/2=+++++(5)从发送端看到的平均错误概率为:===∑∑≠≠ji ij ji i j i e p x y p x p p )|()(发733.010/115/110/310/130/115/2=+++++(6)此信道不好,因为信源等概率分布,从转移信道来看,正确发送的概率11y x >-为0.5,有一半失真;22y x >-为0.3,严重失真;33y x >-为0,完全失真。

信息论与编码第三章复习 共42页

Department of Communication China Ji Liang University

8

(4) 信道参数

第

三

章

信 A. 二进制离散信道模型

道

与 B. 离散无记忆信道

信

道 容

C. 离散输入、连续输出信道

量 D. 波形信道

21.07.201 9

Department of Communication China Ji Liang University

24

第 信道疑义度 H(X/Y)=0, I(X;Y)= H(X) -H(X/Y)= H(X) 。

三

章 信道容量为:

信

道

与 信 道

C m p ( a x i x )I ( X ; Y ) m p ( a x i x )H ( X ) l o g 2 n

容

量

21.07.201 9

Department of Communication China Ji Liang University

这里n(t)代表加性噪声过程的一个样本函数。

21.07.201 9

Department of Communication China Ji Liang University

17

3.2离散单个符号信道及其容量

第

三

章 信

引言: 信道容量定义

道 与

3.2.1

无干扰离散信道

信 道 容

3.2.2

对称DMC信道

Department of Communication China Ji Liang University

3

(1)一般信道的数学模型

第

信息论基础第3章离散信道及其信道容量

《信息论基础》

3.6 多符号离散信道及其信道容量

【例】求图所示的二元无记忆离散对称信道的二次 扩展信道的信道容量。

【例】 已知两个独立的随机变量 X、Y 的分布律如下。

X P(x)

a1 0.5

a2 0.5

,

Y P( y)

b1 0.25

b2 b3 0.25 0.5

计算 H X , H Y , H XY , H X |Y , H Y | X , I X ;Y 。

《信息论基础》

3.4 信道容量的定义

I (ai ) 减去已知事件 bj 后对 ai 仍然存在的不确定性 I (ai | bj ) ,实际就是事件

bj 出现给出关于事件 ai 的信息量。

【例】 甲在一个16 16 的方格棋盘上随意放一枚棋

子,在乙看来棋子放入哪一个位置是不确定的。如果甲 告知乙棋子放入棋盘的行号,这时乙获得了多少信息 量?

《信息论基础》

第3章 离散信道及其信道容量

通信系统的基本功能是实现信息的传递,信道是信息 传递的通道,是信号传输的媒质。一般而言,信源发出的 消息,必须以适合于信道传输的信号形式经过信道的传输, 才能被信宿接收。

从信源的角度看,信源发出的每个符号承载的平均信 息量由信源熵来定量描述;而从信宿的角度看,信宿收到 的每个符号平均能提供多少信息量由平均互信息来定量描 述。在信息论中,信道问题主要研究在什么条件下,信道 能够可靠传输的信息量最大,即信道容量问题。

《信息论基础》

3.7 信源与信道的匹配

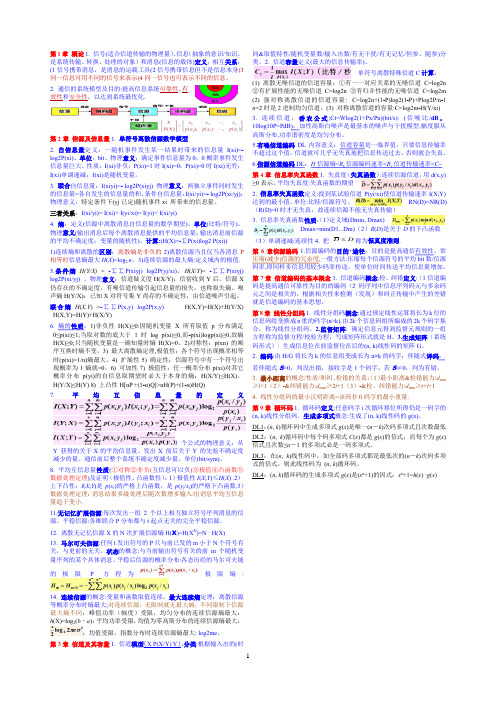

信息论与编码复习重点整理(1页版)

1第1章 概论1. 信号(适合信道传输的物理量)、信息(抽象的意识/知识,是系统传输、转换、处理的对象)和消息(信息的载体)定义;相互关系:(1信号携带消息,是消息的运载工具(2信号携带信息但不是信息本身(3同一信息可用不同的信号来表示(4同一信号也可表示不同的信息。

2. 通信的系统模型及目的:提高信息系统可靠性、有效性和安全性,以达到系统最优化.第2章 信源及信息量1. 单符号离散信源数学模型2. 自信息量定义:一随机事件发生某一结果时带来的信息量I(xi)=-log2P(xi)、单位:bit 、物理意义:确定事件信息量为0;0概率事件发生信息量巨大、性质:I(xi)非负;P(xi)=1时I(xi)=0;P(xi)=0时I(xi)无穷;I(xi)单调递减;I(xi)是随机变量。

3. 联合自信息量:I(xiyi)=- log2P(xiyj) 物理意义:两独立事件同时发生的信息量=各自发生的信息量的和、条件自信息量:I(xi/yi)=- log2P(xi/yj);物理意义:特定条件下(yj 已定)随机事件xi 所带来的信息量。

三者关系:I(xi/yi)= I(xi)+ I(yi/xi)= I(yi)+ I(xi/yi)4. 熵:定义(信源中离散消息自信息量的数学期望)、单位(比特/符号)、物理意义(输出消息后每个离散消息提供的平均信息量;输出消息前信源的平均不确定度;变量的随机性)、计算:(H(X)=-∑P(xi)log2 P(xi)) 1)连续熵和离散的区别:离散熵是非负的2)离散信源当且仅当各消息P相等时信息熵最大H (X )=log 2 n 。

3)连续信源的最大熵:定义域内的极值. 5.条件熵H(Y/X) = -∑∑P(xiyj) log2P(yj/xi),H (X /Y )= -∑∑P(xiyj) log2P(xi/yj) 、物理意义:信道疑义度H(X/Y):信宿收到Y 后,信源X 仍存在的不确定度,有噪信道传输引起信息量的损失,也称损失熵。

信息论与编码第三章

模

型

P<Y1=V1,Y2=V2…Yn=Vn/X=U1…X=Un>

n

Õ = p(YR = UR / X = uR )

决定DMC特点的条件概率P<yj/xi>可写成矩阵形 式

P = [ pij ]

3.2.1

转移概率矩阵

æ p( y0 / x0) p( y1 / x0)

数

ç

学 模

P

=

ç ç

p( y0 / x1)

数 即P<Y=0/X=1>=P<Y=1/X=0>=P

学

模 型

P<Y=1/X=1>=P<Y=0/X=0>=1-P

01

这种对称二进二出的

0 é P P ù 信道叫做二进制对称信

P=1

ê ëê

P

ú P ûú

道,简称BSC信道.

3.2.1

信道模型:

数 学 模

1-P

0

0

P

型

P

1

1

1-P

这种信道的输出符号仅与对应时刻输 入符号有关,与以前输入无关,故称此信道是 无记忆信道的.

3.1

信道分类:

信

道

1.有线信道和无线信道

分

类

有线信道:明线、对称电缆、同轴电

缆及

光缆等.

无线信道:地波传播、短波电离层反 射、

超短波或微波视距中继、

3.1

2.恒参信道和随参信道

信 道

恒参信道:信道的统计特性不随时间而变化.如明

分 线、对称电缆、同轴电缆、光缆、卫星中继信道

类

一般被视为恒参信道.

p0,Q - 1 ö ÷

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第三章离散信道及其信道容量3.1.1 信道的分类在信息论中,信道是传输信息的通道,是信息传输系统的重要组成部分之一。

信道的分类有:按照信道输入端或输出端的个数可分为单用户信道和多用户信道。

按照信道输出端有无信号反馈到输入端可分为有反馈信道和无反馈信道。

按照信道的统计参数是否随时间变化可分为时变参数信道和固定参数信道。

按照信道输入/输出信号取值幅度集合以及取值时间集合的离散性和连续性可分为离散信道(数字信道)和波形信道(模拟信道)。

按照信道输入/输出信号取值幅度集合的离散性和连续性(取值时间是离散的)可分为离散信道和连续信道。

按照信道输入/输出信号在取值时刻上是否有依赖关系可分为有记忆信道和无记忆信道。

按照信道输入信号与输出信号之间是否统计依赖关系可分为有噪信道和无噪(无干扰)信道。

3.1.2 离散信道的数字模型1.一般离散信道(多维离散信道)一般离散信道输入/输出信号取值幅度和取值时刻都是离散的平稳随机矢量。

其数学模型可用离散型概率空间[X,P(y|x),Y]来描述。

其中X=(X1X2…X N)为输入信号,Y= (Y1Y2…Y N)为输出信号。

X中X i∈A={a1,a2,…,a r},Y中Y i∈B={b1,b2,…,b s}。

又P(y|x)(x∈X,y∈Y)是信道的传递概率(转移概率),反映输入和输出信号之间统计依赖关系,并满足概率空间[X,P(y|x),Y]也可用图来描述。

2.基本离散信道(单符号离散信道)单符号离散信道是离散信道中最基本的信道,其信道输入/输出信号都是取值离散的单个随机变量。

数学模型是概率空间[X,P(y|x),Y],(或[X,P(b j|a i),Y]),其中X∈A={a1,a2,…,a r},Y∈B={b1,b2,…,b s),P(y|x)=P(b j|a i)(i=1,2,…,r;j=1,2,…,s)并满足概率空间[X,P(y|x),Y]也可用图来描述,如图3.1所示。

若将传递概率排列成矩阵形式,则称其为传递矩阵(或称信道矩阵)P,即3.无噪(无干扰信道)若离散信道[X,P(y|x),Y]满足若x与y是确定的一一对应关系(f为单值函数),则称为无噪无损信道。

若多个x与一个y为对应(多一对应)关系,则称为无噪有损信道。

若离散信道[X,P(y|x),Y]中P(y|x)不是0,1分布,则称为有噪信道。

在有噪信道中,有一类信道若其前向概率P(y|x)不是0,1分布,而后向概率P(x|y)是0,1分布,即y可以唯一确定x,则称为有噪无损信道。

有噪无损信道的充要条件是信道矩阵中每一列有一个也仅有一个非零元素。

4.离散无记忆信道若离散信道[X,P(y|x),Y]满足则称为无记忆信道(简记为DMC),否则为有记忆信道。

一般情况,离散无记忆信道的数学模型仍可用单符号的概率空间[X,P(y|x),Y]来描述。

5.离散无记忆信道的N次扩展信道离散无记忆信道[X,P(b j|a i),Y]的N次扩展信道的数学模型是[X N,P(βh|αk),Y N]其中X N=X=(X1X2…X N),Y N=Y=(Y1Y2…Y N),X i=X∈A={a1,a2,…,a r)(i=1,2,…,N),Y i=Y∈B={b1,b2,…,b s)(i=1,2,…,N)3.1.3 离散信道的平均互信息及其特性1.信道疑义度信道疑义度是在信道输出端接收到输出随机变量Y(或随机矢量Y)后,对输入端的随机变量X(或矢量X)尚存在的平均不确定性(尚存在的疑义)。

它也表示信号通过信道传输后所引起的信息损失,故又称为损失熵。

记为H(X|Y)(或H(X|Y),基本离散信道[X,P(y|x),Y]中2.互信息互信息是信道输出端接收到某消息y(或某消息序列y)后获得关于输入端某消息x(或某消息序列x)的信息量,记为I(x;y)[或I(x;y)],即3.平均互信息平均互信息是互信息在其概率空间中的数学期望,记为I(X;Y)(或I(X;Y)),得4.平均互信息的物理含义及与各类熵的关系(1)平均互信息与各类熵的关系I(X;Y)=H(X) - H(X|Y)=H(Y) - H(Y|X)=H(X)+H(Y) - H(XY)或I(X;Y)=H(X) - H(X|Y)=H(Y) - H(Y|X)=H(X)+H(Y) - H(XY)其中H(X)[或H(X)]是信道输入端信源的信息熵;H(Y)或[H(Y)]是信道输出端输出信源的信息熵;H(X|Y)[或H(X|Y)]是信道疑义度(损失熵);H(Y|X)[或H(Y|X)]是已知输入变量X(或矢量X)的条件下,对于随机变量Y(或矢量Y)尚存在的不确定义(疑义),称为噪声熵。

(2)平均互信息的物理含义·平均互信息表示接收到输出信号的前、后关于输入信号的平均不确定性的消除。

·平均互信息表示输入信号发出的前、后,关于输出信号的平均不确定性的消除。

·平均互信息表示信道的输出信号和输入信号之间相互提供的平均信息量。

·平均互信息是输入信号和输出信号之间统计依赖关系的信息量度。

·平均互信息表示信道中平均每个符号所能传送的信息量,就是信道的信息传输率R。

5.平均互信息的特性(1)非负性I(X;Y)≥0 或I(X;Y)≥0当且仅当X和Y(或X和Y)统计独立时,等式成立。

(2)极值性I(X;Y)≤min[H(X),H(Y)] 或I(X;Y)≤min[H(X),H(Y)]当且仅当H(X|Y)=0(或H(X|Y)=0)时I(X;Y)=H(X) 或I(X;Y)=H(X)当且仅当H(Y|X)=0(或H(Y|X)=0)时I(X;Y)=H(Y) 或I(X;Y)=H(Y)(3)交互性(对称性)I(X;Y)=I(Y;X) 或I(X;Y)=I(Y;X)(4)凸状性I(X;Y)[或I(X;Y)]是输入信源的概率分布P(x)(P(x))的上凸函数;I(X;Y)[或I(X;Y)]是信道传递概率P(y|x)(P(y|x))的下凸函数。

(5)不增性,即信息不增原理任何不涉及原信源的数据处理,都不会增加获得关于原信源的平均互信息,也称数据处理定理。

·若离散随机变量X→Y→Z形成马氏链,则I(X;Z)≤I(X;Y)·若离散随机矢量S→X→Y→Z,形成马氏链,则I(S;Z)≤I(X;Z)≤I(X;Y)6.I(X;Y)与I(X i;Y i)的关系I(X;Y)是两个离散随机矢量(随机序列)之间的平均互信息;而I(X i;Y i)是两序列中对应的离散随机变量之间的平均互信息。

若X=(X1X2…X N),Y=(Y1Y2…Y N)其中X i∈A={a1,a2,…,a r},Y i∈B={b l,b2,…,a r}且有x∈X,y∈Y,x i∈X i,y i∈Y i.则:3.1.4 多个随机变量之间的平均互信息1.平均条件互信息2.平均互信息离散随机变量X与随机矢量YZ之间的平均互信息为3.条件互信息与互信息的关系I(X;YZ)=I(X;Y)+I(X;Z|Y)=I(X;Z)+I(X;Y|Z)上述关系式易于推广到任意有限维的随机变量中。

3.1.5 离散信道的信道容量及其计算方法1.离散信道的信道容量离散无记忆信道[X,P(y|x),Y]的最大信息传输率称为此信道的信道容量,记为C,即相应的输入概率分布P(x)称为最佳输入分布。

其单位是比特/符号、奈特/符号或哈特/符号。

最佳输入分布不一定是唯一的,但最佳输出分布是唯一的。

它是单位时间内信道的最大信息传输速率。

2.信息容量的计算3.计算信道容量的方法(1)运用信道容量解的充要性对于一些简单、特殊的信道,可先估算出P(a i)(或P(b j)),然后用定理3.3来验证并求解。

(2)运用特殊信道的容量公式求解观察是否是特殊信道(无噪信道、无损信道、对称信道、准对称信道等),若是,就直接按照它们的容量公式来计算。

(3)运用r个方程求解若信道矩阵P是非奇异矩阵,并r=s,可用下列r个方程求解再由P(b j)求出最佳输入分布P(a i)。

若上述公式中对数选取其他单位时,则公式应作相应改变。

(必须解得的所有P(a i)≥0,其中i=1,2,…,r,否则解必在边界上,需重新计算。

)最后还可用迭代算法计算。

3.1.6 常见信道的平均互信息和信道容量1.无噪一一对应信道(无噪无损信道)I(X;Y)=H(X)=H(Y) ;C=log||A||其中||A||表示输入变量X的符号集A中符号的个数。

2.有噪无损信道(H(X|Y)=0)I(X;Y)=H(X)<H(Y) ;C=log||A||3.无噪有损信道(H(Y|X)=0)I(X;Y)=H(Y)<H(X) ;C=log||B||||B||表示输出变量Y的符号集B中符号的个数。

4.离散对称信道I(X;Y)=H(Y) - H(P的行矢量) ;C=log||B|| - H(P的行矢量)其中H(P的行矢量)表示信道矩阵P的行矢量的熵函数。

5.r元强对称信道C=logr - plog(r - 1) - H(p) (p是总错误传递概率)6.二元对称信道3.1.7 无记忆N次扩展信道的I(X;Y)和容量C N离散无记忆信道[X,P(b j|a i),Y]的N次扩展信道[X N,P(βh|αk),Y N]有I(X;Y)≤NI(X;Y);C N=NC其中I(X;Y)和C是离散无记忆信道的互信息及信道容量。

其最佳输入分布是信源X无记忆及每一分量X i各自达到最佳分布P(x)。

3.1.8 独立并联信道的互信息和信道容量3.1.9 串接信道互信息及信道容量3.1.10 信道剩余度信道剩余度=C - I(X;Y)信道相对剩余度=1 - I(X;Y)/C对于无损、对称等一类信道,可通过无失真信源编码使信道剩余度接近于零,使信源和信道达到匹配。