基于前后文n-gram模型的古汉语句子切分

古代文学论文范文精选3篇(全文)

古代文学论文范文精选3篇(全文)浅析古代文学论文写作古代文学论文一、研究者的阅读能力与层次:t1、阅读能力:t 学习和研究古代文学,首先要过的是文字关。

因为古代文学作品都是用古代汉语写成的,只有多方面掌握古代语言的文字、声韵、语法等知识,能够自如地阅读古文,才能真正读懂作品内容。

以广为流传的唐代诗人王勃《送杜少府之任蜀川》为例,(城阙辅三秦,风烟望五津。

与君离别意,同是宦游人。

海内存知已,天涯若比邻。

无为在歧路,儿女共沾巾。

)如果不明白其中的“城阙”“三秦”“五津”“宦游”“比邻”“歧路”“儿女”等字词的意思,是无法理解这首诗表现的内容的。

阅读能力还包括对作品内涵的领会能力。

譬如有时须了解等等,从社会需求的角度要有相应的对策:如果针对考研的学生,教师可以在课外找一些相关的历年考研试题,鉴赏作品同时,可以有针对性的提出来,使部分想考研的同学复习的时候也会有一定的偏重点。

还可以在自己的知识范围内,为学生提供一些有价值的参考书,以便学生接触到更多经典的研究著作,对拓宽自己的学术视野打下坚实的基础。

如果面对部分未来要教中学的同学,因为目前中学语文教学传统的模式存在问题,如何胜任初中文言文的教学及如何适应并改变中学的教学,在教学中也可渗透并涉猎到相关的内容。

还有很多同学毕业要从事其他的工作,如文化部门、企业、事业单位办公室治理文员、秘书工作,那教学时鉴赏作品的思维训练及领会精神内涵的层面训练、讲解作品中与当代社会人际交往的层面都对其走上工作岗位有一定的潜移默化的帮助。

《老残游记》这部小说教学目的的现代性,除了以上所言,体现的更多的是审美体验和现实意义。

ZG古代文学作品教学对策的构建任重而道远,不断的在教学中反思、总结经验,并回馈到教学当中,使课堂教学质量形成一个良性循环,需要全体教育者以科学合理的现代性教育观念为指导,以完善丰富的现代教学方法和内容为依托,运用到实际授课当中,使这门课程真正从传统走向现代。

基于NGram的无词典中文分词算法

㈩ …

z=

…

6

维普资讯

科 技 论 文

2 N rm 信 息 提 取 Ga

对 于任何 一篇 中文文档 , 除去天然 的分 词标 记 ( 点等 非汉字 字符 ) 都 是 长度不 等 标 , 的汉字序列 的集合 , 因此对文章 的处理 就是对 汉 字序 列 的处理 。在 一汉 字序 列里位 置相 邻 的 N个汉字 称为一个 N r N是 可变整 数 ) Ga m( 。例如 “ 中国人 民解放军 ” 这个字符 串 , 则 2 rm 分 别 为 : 国 , 人 , 民 , Ga 中 国 人 民解 , 放 , 军 ; Ga 分 别 为 : 国 人 , 人 民 , 民 解 放 3r m 中 国 人 解, 民解放 , 放军 ; 解 其他 的以此类 推 。 由此 可 以看 出, r 是单 个汉 字对 于 分词 并没 1G a m 有 太 大 的意 义 。所 以 我们 的 N rm 是 从 2开始 的 。 Ga 定义 1 同现率 f ( G a ) 一个 N r 在训 练语 料库 中出现 的次 数 , : r Nr 是 e m Ga m 例如 “ 中国” 这个 2 r 在训练语 料库 中出现的次数 为 3 0 那么 f ( Ga m 0, r 中国 ) 30 假设 用“ e =0; A B M N” 来 表 示 4个 汉 字 的序 列 。假 设 AB和 MN都 是 一 个 词 语 , 么 f ( 那 r AB)>f ( M) 及 f e r B 以 e r e (N M )>f ( M)。该 判断在 绝大多数 的情况 下是 成 立 的( 存在 交集歧 义 的情况下 存 r B e 在 在误差 ) 因为在大量真实语料里词语 出现 的次数肯定 比跨边界 的字 串出现 的次数要大 。 , 我 们 用 “ ” 表 示 8个 汉 字 的 序 列 。 现 在 为 了判 断 第 四个 位 置 ( A B C D JK L M 来 D 和 J 是 不 是 词 边 界 ( 设 边 界 用 记 ) 若 是 边 界 , 边 界 两 侧 NGa 的 同 现 率 应 该 比 ) 假 标 。 则 rm 跨 越边界 的 N r 的同现 率大。我们 应该检测边 界临 近的所 有 N r 。 Ga m Ga m

ngram语义编码

ngram语义编码通常指的是基于ngram模型的语义编码方法,主要用于自然语言处理领域。

在这种方法中,文本被分割成不同长度的N个连续项(通常是单词或字符),然后使用这些ngram来表示文本,并进行语义分析和编码。

具体来说,ngram语义编码可以分为以下几个步骤:

1. N-gram提取:将文本按照N个连续项进行切分,得到不同的N-gram序列。

例如,对于句子我爱自然语言处理,当N取2时,可以得到我爱、爱自然、自然语言、语言处理等2-gram 序列。

2. 特征表示:对于提取得到的N-gram序列,可以将其转换成向量表示,通常可以使用词袋模型(Bag of Words)或者TF-IDF等方法进行向量化表示。

3. 语义编码:使用机器学习或深度学习模型对得到的N-gram特征进行语义编码,以捕捉文本的语义信息。

这可能涉及到词嵌入(Word Embedding)或者更高级的语义模型。

4. 应用:进行文本分类、情感分析、信息检索等自然语言处理任务,利用N-gram语义编码来表征文本并进行相应的语义分析。

总的来说,N-gram语义编码是一种基于N-gram模型的文本表示和语义分析方法,可以用于从文本数据中提取语义信息并进行各种NLP任务。

ngram 分词个数

ngram 分词个数

N-gram 分词是一种文本处理技术,其中 N 代表分词的大小。

N-gram 将文本切分成长度为 N 的连续子序列。

常见的有 unigram(1-gram)、bigram(2-gram)、trigram(3-gram)等。

• Unigram(1-gram):

•将文本切分成单个词语。

例如,"Hello World" 变成 ["Hello", "World"]。

• Bigram(2-gram):

•将文本切分成两个词语的序列。

例如,"Hello World" 变成["Hello", "World"]。

• Trigram(3-gram):

•将文本切分成三个词语的序列。

例如,"Hello World" 变成["Hello", "World"]。

在实际应用中,根据任务的不同,可以选择不同大小的 N。

较小的 N 可能更关注局部上下文,而较大的 N 则可能更关注整体结构。

选择适当的 N 取决于具体的文本分析任务和文本的性质。

例如,在语言建模中,一般使用 bigram 或 trigram 进行建模,以考虑到相邻词语之间的关系。

在文本分类任务中,unigram 通常被用于构建特征,表示文本中单个词语的出现情况。

在实践中,可以通过调整 N 的大小来平衡对上下文信息的关注度。

更大的 N 可能提供更多的上下文信息,但也可能导致数据稀疏问题,特别是当训练数据有限时。

人工智能自然语言技术练习(试卷编号1111)

人工智能自然语言技术练习(试卷编号1111)1.[单选题]下列属于西文字符编码的是()A)ASCII码B)国标码C)GB13000D)GBK答案:A解析:2.[单选题]TextRank 是由哪个算法改进而来的A)FastTextB)TextCNNC)PageRankD)TF-IDF答案:C解析:3.[单选题]在NLP任务中,以下哪个可以提高模型精度A)ELMoB)Open AI’s GPTC)ULMFitD)One-Hot答案:B解析:Open AI的GPT能够通过使用Transformer模型的注意力机制(Attention Mechanism)来学习数据中的复杂模式,因此更适合于诸如语义相似性、阅读理解和常识推理之类的复杂用例。

4.[单选题]浅层句法分析方法大体分为两类,其一基于统计的方法,统计方法中不属于具有代表性的方法是A)基于HMM模型的方法B)Φ2统计方法C)互信息方法D)统计分组方法答案:D解析:5.[单选题]在NLP当中,像Bi-Gram和TriGram这样的模型都属于什么模型A)N-GramB)Seq2seq解析:6.[单选题]机器学习中关于SVM,以下说法错误的是A)L2正则项,作用是最大化分类间隔,使得分类器拥有更强的泛化能力B)Hinge 损失函数,作用是最小化经验分类错误C)分类间隔为1/||w||,||w||代表向量的模D)当参数C越小时,分类间隔越大,分类错误越多,趋于欠学习答案:C解析:7.[单选题]多分类问题一般用什么激活函数进行映射A)sigmoidB)tanhC)softmaxD)relu答案:C解析:8.[单选题]katz指数又称ADL指数,由难到易分为()类A)4B)5C)6D)7答案:C解析:9.[单选题]数据归一化通常和以下哪个选项中一起使用A)训练集的mini-batchB)测试集的mini-batchC)整个训练集D)整个测试集答案:A解析:10.[单选题]在TensorFlow框架中,如何正确的调用Adam优化器?A)tf.example.AdamOptimizerB)tf.train.AdamOptimizerC)tf.nn.AdamOptimizerD)tf.AdamOptimizer11.[单选题]朴素贝叶斯作为常用的方法,它是以( )为基础的分类方法。

基于前后文n-gram模型的古汉语句子切分

a c rc . s tep p r eet tea ae t o o f cu ( u y t et h lo i m t d c d a dt ers l h w ta ter c l a dt e c u a y At at h a e lcs h n l s f n u i s L n u) ots teag r h i r u e , n eut so t h e al n l , s c C t no h s h h

行 比较准确的预 测,从 而较好 地处理小规模 训练语 料的情 况 ,降低数 据稀疏对切分准确率 的影响。采 用 论语 对所提 出的算法进行 了句

子切分实验,达 到了 8 %的召回率和 5 %的准 确率 。 l 2

关健 诃 : —r nga m模 型 ;数据稀疏 ;平滑技术 ;基于前后文的 nga —r m模 型

中圈分类号: P9 T3

基 于 前后 文 n g a 模 型 的古 汉语 句子切 分 —r m

陈天 莹 ,陈 蓉 ,潘 璐璐 ,李 红军 ,于 中华

(. 】 四川大 学计 算机学 院,成都 6 0 6 ;2 西南科技大学计 算机 学院 ,绵阳 6 10 ) 10 4 . 202 摘 要 :提出了基于 前后文 n rm 模 型的古汉语句子切分算法 ,该算法能够在数据稀疏 的情 况下 ,通过收集上下文信息 ,对切分位 置进 —a g

( . p . fCompu e c e c , c u n Un v r i , e g u 61 0 4; 1 De t o trS i n e Si h a i e st Ch n d 6 y 0

2 De t o Co ue ce c , o twet ies yo S in ea dT c n lg , a y n 2 0 2 . p . f mp tr in e S uh s Unv ri f ce c n e h oo y Min a g6 1 0 ) S t

人工智能自然语言技术练习(习题卷9)

人工智能自然语言技术练习(习题卷9)说明:答案和解析在试卷最后第1部分:单项选择题,共45题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]如何理解NNLM这个模型,它是一个什么样的模型A)基于统计的语言模型B)基于神经网络的语言模型C)预训练模型D)编解码模型2.[单选题]文本文件中存储的其实并不是我们在编辑器里看到的一个个的字符,而是字符的()。

A)内码B)外码C)反码D)补码3.[单选题]数据可视化data visualization,导入_哪个包?A)A: sklearn.linear_modelB)B: sklearn.model_selectionC)C: matplotlib.pylabD)D: sklearn.metrics4.[单选题]dropout作为常用的函数,它能起到什么作用A)没有激活函数功能B)一种正则化方式C)一种图像特征处理算法D)一种语音处理算法5.[单选题]以下四个描述中,哪个选项正确的描述了XGBoost的基本核心思想A)训练出来一个一次函数图像去描述数据B)训练出来一个二次函数图像去描述数据C)不断地添加树,不断地进行特征分裂来生长一棵树,每次添加一个树,其实是学习一个新函数f(x),去拟合上次预测的残差。

D)不确定6.[单选题]下列关于 LSTM 说法不正确的是( )。

A)通过改进使 RNN 具备避免梯度消失的特性B)LSTM 只能够刻画出输入数据中的短距离的相关信息,不能够捕捉到具有较长时间间隔的依赖关系C)LSTM 神经网络模型使用门结构实现了对序列数据中的遗忘与记忆D)使用大量的文本序列数据对 LSTM 模型训练后,可以捕捉到文本间的依赖关系,训练好的模型就可以根据指定的文本生成后序的内容C)1D)x8.[单选题]以下不是语料库的三点基本认识的是A)语料库中存放的是在语言的实际使用中真实出现出的语言材料。

B)语料库是以电子计算机为载体承载语言知识的基本资源,并不等于语言知识。

古汉语自动句读与分词研究

古汉语自动句读与分词研究古汉语自动句读与分词研究摘要古汉语是中华民族的传统文化遗产,文化内涵丰富、美不胜收。

然而,对于古汉语的自动处理,由于其句读模糊、分词难度大等特点,一直是计算机领域的难点之一。

本文针对古汉语句读和分词问题,提出了一种基于深度学习的方法,即古汉语自动句读与分词模型。

该模型基于现有语料,并采用了卷积神经网络和长短时记忆网络,对古汉语进行了句读和分词处理。

实验结果表明,与传统的基于规则和特征的方法相比,该模型在古汉语句读和分词方面取得了更好的性能。

关键词:古汉语、句读、分词、深度学习、卷积神经网络、长短时记忆网络1. 引言根据《汉语大词典》的统计资料,古代汉语词汇量高达17万余个,其中涉及不同领域的专门词汇、方言词汇、虚词等等。

然而,古汉语的语言规范和语言习惯与现代汉语相比存在很大的差异,这给古汉语的处理和研究带来了巨大的挑战。

目前,比较成熟的对现代汉语进行句读和分词的方法,多采用基于隐马尔可夫模型(HMM)、最大熵模型(MaxEnt)、条件随机场(CRF)等方法。

然而,由于古代汉语的语言形式多种多样,具有较大的歧义性,这些传统方法的效果难以满足古代汉语的自动处理需要。

2. 古汉语自动句读与分词模型为了解决古汉语自动句读与分词的问题,本文提出了一种基于深度学习的方法,即古汉语自动句读与分词模型。

该模型目的在于能够自动地将古汉语文本进行句读和分词操作,从而为古汉语的进一步研究和应用提供支持。

具体地,该模型包括以下几个步骤:(1)文本预处理。

将古汉语文本进行分段、去除标点符号等预处理工作,以便后续的句读和分词处理。

(2)句读。

采用卷积神经网络(CNN)对文本进行句读操作,通过学习语言规范和语言习惯的特征,对古汉语文本进行句子切分,从而得到句子边界。

本文采用的卷积神经网络结构包括卷积层、池化层、全连接层等。

(3)分词。

采用长短时记忆网络(LSTM)对文本进行分词操作,通过学习词汇和上下文的语义关系,对每个句子进行分词处理。

词语特征词提取

词语特征词提取

词语特征是指在自然语言处理任务中,通过对文本进行分析和处理,提取出能够表示该文本内容或特点的关键词或短语。

常用的词语特征提取方法包括:

1. 词频统计:通过统计文本中每个词语出现的频率,选取出现频率较高的词语作为特征词。

常用的方法有词袋模型和TF-IDF。

2. N-gram模型:将文本切分为连续的N个词语片段,选取频率较高的片段作为特征词。

常用的N值有1、2、3。

3. 关键词提取:利用文本中词语的重要度或权重,选取权重较高的词语作为特征词。

常用的方法有TextRank和基于TF-IDF 的关键词提取。

4. 主题模型:通过建立主题模型,将文本表示为一组主题的分布,选取主题概率较高的词语作为特征词。

常用的主题模型有Latent Dirichlet Allocation (LDA)和Non-negative Matrix Factorization (NMF)。

5. 词性标注:将词语按照其词性分类,选取特定词性的词语作为特征词。

常用的词性标注工具有NLTK和Stanford NLP。

在实际应用中,可以根据具体任务的需求选择合适的特征提取方法。

rouge-lsum公式

rouge-lsum公式

Rouge-L是一种用于评估自动摘要质量的指标,而Rouge-LSUM

是Rouge-L的一个变种,用于评估自动摘要的性能。

Rouge-L是一种基于n-gram重叠的评估指标,它衡量了系统生

成的摘要与参考摘要之间的重叠程度。

Rouge-L计算的是系统生成

的摘要与参考摘要之间最长公共子序列的F1分数。

这个指标能够捕

捉到自动摘要与参考摘要之间的语义相似度,因此被广泛应用于自

动摘要系统的评估中。

Rouge-LSUM是Rouge-L的一个变种,它在计算Rouge-L时引入

了句子切分的考量。

具体来说,Rouge-LSUM考虑了句子边界的影响,使得在计算Rouge-L时更加符合自然语言的语法结构。

这样做的目

的是提高Rouge-L在自动摘要任务中的准确性,使其更好地反映自

动摘要系统的性能。

总的来说,Rouge-LSUM公式和Rouge-L类似,但在计算Rouge-

L时考虑了句子切分的影响,以更准确地评估自动摘要的质量。

这

种改进使得Rouge-LSUM在自动摘要评估中更加准确和可靠。

bm-marker animation类型-概述说明以及解释

结论

Word2vec是一种非常强大的词向量生成模型,它的工作原理基于Skip-gram模 型和神经网络。通过学习词的上下文关系,Word2vec能够生成具有丰富语义 信息的词向量,从而在文本处理、信息抽取和自然语言处理等领域得到广泛应 用。

然而,Word2vec也存在一些局限性。例如,它对训练语料库的规模和质量要 求较高,且训练时间较长。此外,虽然Word2vec能够捕捉到词之间的语义关 系,但它无法理解句子的语法结构和语序信息。为了解决这些问题,未来的研 究方向可以包括改进Word2vec的训练算法、结合其他语言学特征、以及探索 基于深度学习的词向量表示方法等。

Word2vec核心架构

Word2vec是一种基于神经网络的词向量表示方法,其主要由两部分组成: Skip-gram模型和Continuous Bag of Words(CBOW)模型。Skip-gram模型 通过预测上下文来学习词向量表示,而CBOW模型则通过预测当前词来学习上下 文向量表示。这两种模型都采用了负采样(negative sampling)技术,以高 效地训练大规模语料库。

Word2vபைடு நூலகம்c的核心架构及其应 用

目录

01 引言

03

Word2vec的应用场 景

02 Word2vec核心架构 04 参考内容

引言

随着人工智能和自然语言处理技术的快速发展,词向量表示作为其中的关键部 分,越来越受到研究者的。Word2vec是一种广泛使用的词向量表示方法,它 通过训练神经网络学习词表中的词向量表示,从而捕捉词义和语法信息。本次 演示将深入探讨Word2vec的核心架构及其应用场景,以期为相关领域的研究 和实践提供有益的参考。

2、在推荐系统中,Word2vec可以通过分析用户历史行为和项目属性,将它们 转换为向量表示,从而预测用户的兴趣和推荐相关项目。这种方法可以有效提 高推荐系统的准确性和用户满意度。

如何利用机器学习技术进行用户评论情感分析的文本特征提取

如何利用机器学习技术进行用户评论情感分析的文本特征提取随着互联网的普及和发展,越来越多的用户评论被发布在各种在线平台上,如社交媒体、电子商务网站和论坛等。

对这些用户评论进行情感分析可以帮助企业了解用户的意见和情感态度,以改进产品和服务,提高用户满意度。

利用机器学习技术进行用户评论情感分析的文本特征提取是实现这一目标的关键步骤之一。

在进行用户评论情感分析之前,首先需要对原始文本进行特征提取,将文本数据转化为能够被机器学习算法处理的数值型向量。

下面将介绍一些常用的文本特征提取方法。

1. 词袋模型(Bag of Words)词袋模型是一种简单而常用的文本特征提取方法。

它将每个文本看作是一个词语的集合,忽略词语之间的顺序和语法结构。

首先,将所有文本中出现的词语组成一个词表,然后通过计算每个文本中每个词语的出现次数或者频率来构建特征向量。

词袋模型可以帮助我们捕捉到不同文本之间的词频分布差异,但它忽略了词语顺序和上下文的信息。

2. TF-IDF(Term Frequency-Inverse Document Frequency)TF-IDF是一种常用的文本特征提取方法,它结合了词频(Term Frequency)和逆文档频率(Inverse Document Frequency)。

它衡量了词语在文本中的重要程度,通过计算每个词语在文档中的频率和在整个文档集合中的逆文档频率,来构建特征向量。

TF-IDF可以较好地捕捉重要和独特的词语。

3. Word2VecWord2Vec是一种基于神经网络的文本特征提取方法,它通过将词语映射为高维向量,将词语的语义信息编码为向量表示。

Word2Vec通过学习上下文信息来训练词向量,使得具有类似上下文的词语在向量空间中距离较近。

利用Word2Vec提取的词向量可以保留一定的语义信息,更好地捕捉词语之间的关联。

4. n-gram模型n-gram模型是一种基于词语序列的文本特征提取方法。

基于前后文n-gram模型的古汉语句子切分

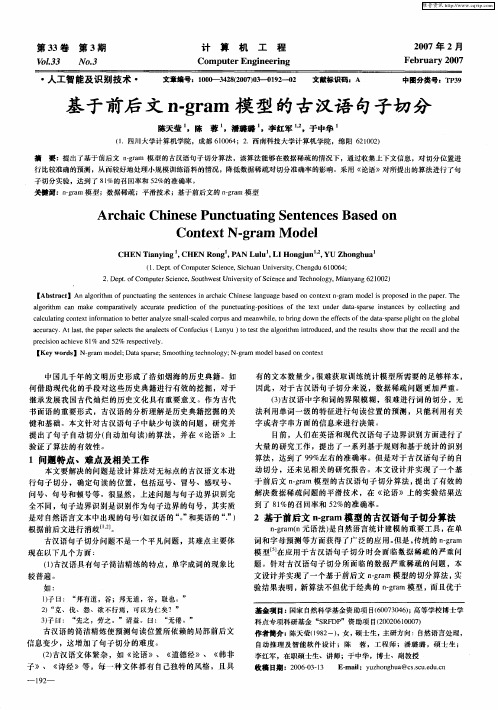

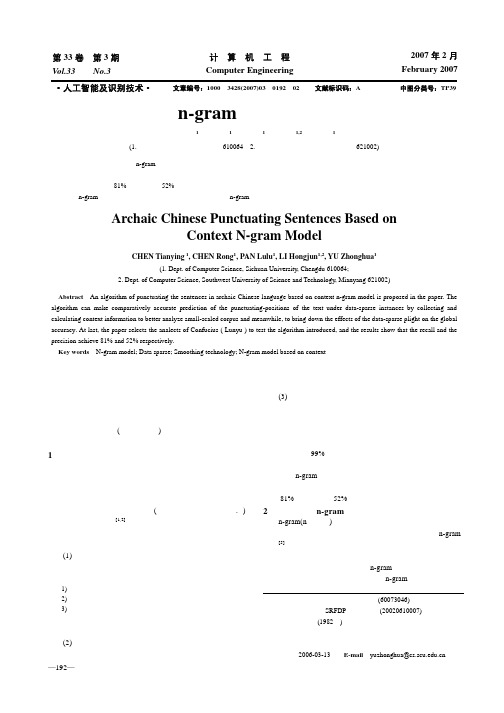

2007年2月February 2007—192— 计 算 机 工 程Computer Engineering 第33卷 第3期Vol.33 No.3 ·人工智能及识别技术·文章编号:1000—3428(2007)03—0192—02文献标识码:A中图分类号:TP39基于前后文n-gram 模型的古汉语句子切分陈天莹1,陈 蓉1,潘璐璐1,李红军1,2,于中华1(1. 四川大学计算机学院,成都610064;2. 西南科技大学计算机学院,绵阳 621002)摘 要:提出了基于前后文n-gram 模型的古汉语句子切分算法,该算法能够在数据稀疏的情况下,通过收集上下文信息,对切分位置进行比较准确的预测,从而较好地处理小规模训练语料的情况,降低数据稀疏对切分准确率的影响。

采用《论语》对所提出的算法进行了句子切分实验,达到了81%的召回率和52%的准确率。

关键词:n-gram 模型;数据稀疏;平滑技术;基于前后文的n-gram 模型Archaic Chinese Punctuating Sentences Based onContext N-gram ModelCHEN Tianying 1, CHEN Rong 1, PAN Lulu 1, LI Hongjun 1,2, YU Zhonghua 1(1. Dept. of Computer Science, Sichuan University, Chengdu 610064;2. Dept. of Computer Science, Southwest University of Science and Technology, Mianyang 621002)【Abstract 】An algorithm of punctuating the sentences in archaic Chinese language based on context n-gram model is proposed in the paper. The algorithm can make comparatively accurate prediction of the punctuating-positions of the text under data-sparse instances by collecting and calculating context information to better analyze small-scaled corpus and meanwhile, to bring down the effects of the data-sparse plight on the global accuracy. At last, the paper selects the analects of Confucius ( Lunyu ) to test the algorithm introduced, and the results show that the recall and the precision achieve 81% and 52% respectively.【Key words 】N-gram model; Data sparse; Smoothing technology; N-gram model based on context中国几千年的文明历史形成了浩如烟海的历史典籍。

林业古籍断句模式语料库建设方案探讨——以《树艺篇》为训练文本

揖Key words铱Forestry ancient books曰The pausing曰Corpus曰ShuY i Pian

古籍断句袁是古籍整理实践中重要的组成部分遥 通过标点原文袁能 够区分出原文字句段落袁厘清上下文关联袁从而引导读者理解内容遥 这 是非常有助于古籍的传播和阅读的遥 中国林业类古籍的整理主要功在 收集袁但其中仅有少量的文献被标点遥 那么如果希望更多的林业古籍 被有效利用袁就必须加大古籍整理的力度遥 中文信息处理技术的介入袁 提高了该领域的工作效率袁 这其中尤以自动化标点的实现最为紧要遥 目前已有不少这样的研究成果院有古籍断句的系统结构图以及基于模 式匹配的断句方法曰 有基于前后 n-gram 模型的古汉语断句算法和一 种可用于古文自动断句的以两个统计量互信息和测试差为特征的条 件随机场模型曰另外 2011 年国学网还开放了一个古籍断句评测系统遥

依靠科研项目袁通过大学生进行科技创新项目袁引导学生在农村 污水控制方面进行实验袁如畜禽污水处理尧农产品安全生产等袁提高学 生的创新能力遥 2.4 完善教学体系袁加强课程设计

自然语言的分词方法之N-gram语言模型

⾃然语⾔的分词⽅法之N-gram语⾔模型基于理解的分词⽅法其基本思想是在分词的同时进⾏句法、语义的分析,以此来处理歧义问题。

⽬前这种⽅法还处于实验状态基于统计的分词⽅法基本思路构建语⾔模型,对句⼦进⾏单词划分,划分结果运⽤统计⽅法计算概率,获取概率最⼤的分词⽅式N元语⾔模型(N-gram语⾔模型)设z为字串,w为划分的词串,s是⼀种划分。

该分词⽅法是以p(s)最⼤的分词结果作为结果。

由于每个词的概率都⼗分⼩,对于较长的字串,得到的每个结果的概率可能⼗分接近于0,计算机精度不够,会影响概率的⽐较,可通过⽐较概率的负对数来⽐较⼤⼩。

这种⽅法可发现所有的切分歧义,它的成功率很⼤程度取决于统计语⾔模型的精度和决策算法。

概率怎么得到,肯定是要有样本的,如果可以的话,以⼈类有史以来所有说过的话作为样本肯定是最好的,但这不可能实现。

对于p(s),根据条件概率公式,有p(s)=p(w1)p(w2|w1)⋯p(w n|w n−1,w n−2,⋯w1)这种计算⽅法对算⼒要求太⾼,对训练数据要求⼗分⼤,不太可能实现,因此考虑建⽴模型。

马尔可夫假设俄国数学家马尔可夫提出假设:任意⼀个词w i出现的概率只同它前⾯的⼀个词w i−1有关,这种假设称为马尔可夫假设。

即p(s)=p(w1)p(w2|w1)⋯p(w n|w n−1)这样求的⽅法就简单多了。

⽽当我们假设w i出现的概率和它前⾯的n个词有关,就被称为n元语⾔模型代码思路⽤DFS不难实现,⾸先找到⼀个可⾏的划分,再计算概率,保存最⼤概率的结果,DFS途中可适当剪枝。

//代码框架void _find (int cur)//找划分,cur表⽰当前为第⼏个词{if (cur==n+1) calc();//对当前结果计算概率并保存for (int i=cur;i<=n;++i)if (check(cur,i)){//如果从cur到i形成⼀个词add(cur,i);//将该词添加到当前划分_find(i+1);del();//删掉这个词}}与词性标注结合这种⽅法的基本思想是在考虑分词结果的概率的同时,还要考虑词性,⾃然语⾔的词性搭配是有规律的,将分词结果的词性搭配的概率也进⾏⽐较,从⽽反过来调整分词,可极⼤的提⾼结果的准确性。

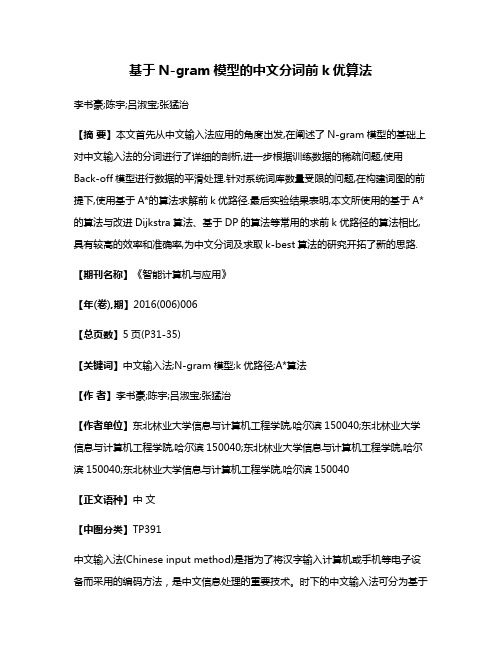

基于N-gram模型的中文分词前k优算法

基于N-gram模型的中文分词前k优算法李书豪;陈宇;吕淑宝;张猛治【摘要】本文首先从中文输入法应用的角度出发,在阐述了N-gram模型的基础上对中文输入法的分词进行了详细的剖析,进一步根据训练数据的稀疏问题,使用Back-off模型进行数据的平滑处理.针对系统词库数量受限的问题,在构建词图的前提下,使用基于A*的算法求解前k优路径.最后实验结果表明,本文所使用的基于A*的算法与改进Dijkstra算法、基于DP的算法等常用的求前k优路径的算法相比,具有较高的效率和准确率,为中文分词及求取k-best算法的研究开拓了新的思路.【期刊名称】《智能计算机与应用》【年(卷),期】2016(006)006【总页数】5页(P31-35)【关键词】中文输入法;N-gram模型;k优路径;A*算法【作者】李书豪;陈宇;吕淑宝;张猛治【作者单位】东北林业大学信息与计算机工程学院,哈尔滨150040;东北林业大学信息与计算机工程学院,哈尔滨150040;东北林业大学信息与计算机工程学院,哈尔滨150040;东北林业大学信息与计算机工程学院,哈尔滨150040【正文语种】中文【中图分类】TP391中文输入法(Chinese input method)是指为了将汉字输入计算机或手机等电子设备而采用的编码方法,是中文信息处理的重要技术。

时下的中文输入法可分为基于音标(Phonetic-based)和基于字形(Shape-based)两种类型[1],本文使用的方法则属于第一类。

一个具有整句输入功能的输入法主要包括着以下部分:首先是语言模型,语言模型将提供输入法其他部分所需要的信息;其次是输入处理(拼音流切分)[2],该部分把输入的拼音流切分为单个音节的序列,供音-字转换部分设计使用;最后是音-字转换部分,该部分将处理好的单音节序列转化为汉字编码进行结果输出。

其中,汉语的语言模型大体上可划定为基于字和基于词的这样2个研究进展方向。

基于上下文特征分类的评论长句切分方法

基于上下文特征分类的评论长句切分方法陈鸿;金培权;岳丽华;胡玉娟;殷凤梅【摘要】商品评论文本对消费者和商家的决策都有重要参考价值.用户在评论中使用的语言较为随意,语法结构不规则,给文本分析带来很大难度.正确的句子切分是文本信息抽取和挖掘工作的基础.为解决商品评论中用户省略标点情况下的句子切分问题,基于上下文特征,提出使用机器学习的方法对评论长句进行切分.根据大规模评论语料的统计特征选取候选句子切分点,对每一个候选句子切分点提取其上下文特征,并根据语料的统计特征,使用逻辑回归对候选切分点进行分类.实验结果表明,该方法能够有效解决商品评论中用户省略标点情况下的句子切分问题.【期刊名称】《计算机工程》【年(卷),期】2015(041)009【总页数】6页(P233-237,244)【关键词】句子切分;标点省略;机器学习;上下文特征;N元文法;逻辑回归【作者】陈鸿;金培权;岳丽华;胡玉娟;殷凤梅【作者单位】合肥师范学院公共计算机教学部,合肥230091;中国科学技术大学计算机科学与技术学院,合肥230027;中国科学技术大学计算机科学与技术学院,合肥230027;合肥师范学院公共计算机教学部,合肥230091;合肥师范学院公共计算机教学部,合肥230091【正文语种】中文【中图分类】TP311商品评论作为用户和用户以及用户和商家间的一种沟通工具,对用户和商家的决策都有重要的参考价值。

对商品评论的观点句识别、情感分析[1]等研究工作也进行了很长时间。

现有针对商品评论的研究工作在基于句子切分正确的基础上,即假设输入为经过切分并且正确切分的句子。

然而在很多电子商务网站上,用户的商品评论具有语言风格较为随意、语法结构不规则等特点,而其中一个重要方面就是标点符号的省略,例如:“这款彩电画质很好音效也很不错但是价格偏贵”,“衣服很漂亮价钱也很便宜很符合我的品味我很喜欢”。

第1个句子由3个子句组成(即“这款彩电画质很好”,“音效也很不错”和“但是价格偏高”),而第2个句子由4个子句组成(即“衣服很漂亮”,“价钱也很便宜”,“很符合我的口味”和“我很喜欢”)。

中文句子转换向量

中文句子转换向量1. 自然语言处理(Natural Language Processing,NLP)是一门研究人类语言与计算机之间交互的学科,其主要目标是让计算机能够理解、解释和生成人类语言。

2. 机器学习(Machine Learning)是一种通过数据训练模型来实现自动化学习和预测的方法。

在自然语言处理中,机器学习可以用于语言模型的训练和词性标注等任务。

3. 词向量(Word Embedding)是一种将词语映射到向量空间中的技术。

它能够将词语的语义信息编码为实数向量,从而方便计算机进行语义分析和处理。

4. Word2Vec是一种常用的词向量模型,它通过学习词语的上下文关系来生成词向量。

Word2Vec模型有两种实现方式,分别是CBOW和Skip-gram。

5. GLoVe(Global Vectors for Word Representation)是一种基于全局词频统计的词向量模型。

GLoVe模型通过分析词语共现矩阵来学习词向量,从而捕捉到词语之间的语义关系。

6. FastText是一种基于字符级别的词向量模型。

与传统的词向量模型不同,FastText将词语表示为字符n-gram的向量平均值,从而能够更好地处理未登录词和拼写错误。

7. 词向量的应用非常广泛,可以用于文本分类、信息检索、命名实体识别等任务。

通过将词语映射到向量空间,可以方便地计算词语之间的相似度、进行聚类等操作。

8. 除了词向量,句子向量(Sentence Embedding)也是自然语言处理中的重要技术。

句子向量可以将整个句子编码为一个向量,从而方便计算机进行句子级别的语义分析和处理。

9. 句子向量的生成方法有多种,例如将句子中的词向量进行平均、求和或拼接等操作。

另外,也可以使用预训练的句子向量模型,如InferSent、ELMo和BERT等。

10. InferSent是一种基于无监督学习的句子向量模型,它通过预测句子的下一个词来学习句子的语义表示。

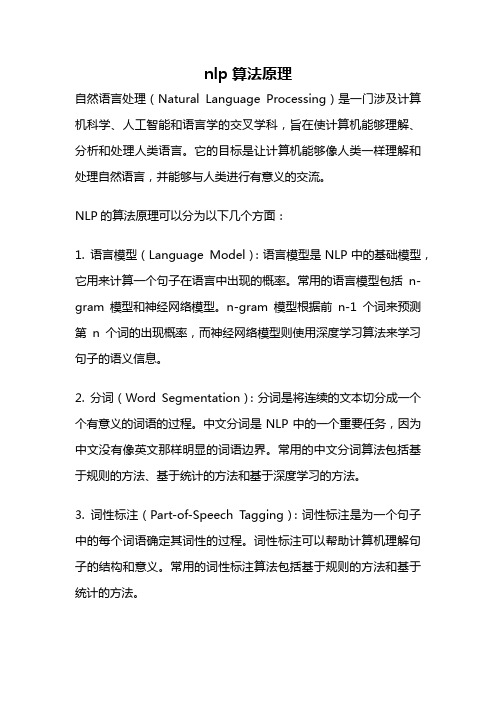

nlp算法原理

nlp算法原理自然语言处理(Natural Language Processing)是一门涉及计算机科学、人工智能和语言学的交叉学科,旨在使计算机能够理解、分析和处理人类语言。

它的目标是让计算机能够像人类一样理解和处理自然语言,并能够与人类进行有意义的交流。

NLP的算法原理可以分为以下几个方面:1. 语言模型(Language Model):语言模型是NLP中的基础模型,它用来计算一个句子在语言中出现的概率。

常用的语言模型包括n-gram模型和神经网络模型。

n-gram模型根据前n-1个词来预测第n个词的出现概率,而神经网络模型则使用深度学习算法来学习句子的语义信息。

2. 分词(Word Segmentation):分词是将连续的文本切分成一个个有意义的词语的过程。

中文分词是NLP中的一个重要任务,因为中文没有像英文那样明显的词语边界。

常用的中文分词算法包括基于规则的方法、基于统计的方法和基于深度学习的方法。

3. 词性标注(Part-of-Speech Tagging):词性标注是为一个句子中的每个词语确定其词性的过程。

词性标注可以帮助计算机理解句子的结构和意义。

常用的词性标注算法包括基于规则的方法和基于统计的方法。

4. 语法分析(Syntactic Parsing):语法分析是为一个句子建立其语法结构的过程。

语法分析可以帮助计算机理解句子的句法结构和语义关系。

常用的语法分析算法包括基于规则的方法、基于统计的方法和基于深度学习的方法。

5. 语义分析(Semantic Analysis):语义分析是为一个句子确定其语义信息的过程。

语义分析可以帮助计算机理解句子的意义和表达方式。

常用的语义分析算法包括基于规则的方法、基于统计的方法和基于深度学习的方法。

6. 机器翻译(Machine Translation):机器翻译是将一种语言的文本翻译成另一种语言的过程。

机器翻译可以帮助人们跨越语言障碍,实现不同语言之间的交流。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2007年2月February 2007—192— 计 算 机 工 程Computer Engineering 第33卷 第3期Vol.33 No.3 ·人工智能及识别技术·文章编号:1000—3428(2007)03—0192—02文献标识码:A中图分类号:TP39基于前后文n-gram 模型的古汉语句子切分陈天莹1,陈 蓉1,潘璐璐1,李红军1,2,于中华1(1. 四川大学计算机学院,成都610064;2. 西南科技大学计算机学院,绵阳 621002)摘 要:提出了基于前后文n-gram 模型的古汉语句子切分算法,该算法能够在数据稀疏的情况下,通过收集上下文信息,对切分位置进行比较准确的预测,从而较好地处理小规模训练语料的情况,降低数据稀疏对切分准确率的影响。

采用《论语》对所提出的算法进行了句子切分实验,达到了81%的召回率和52%的准确率。

关键词:n-gram 模型;数据稀疏;平滑技术;基于前后文的n-gram 模型Archaic Chinese Punctuating Sentences Based onContext N-gram ModelCHEN Tianying 1, CHEN Rong 1, PAN Lulu 1, LI Hongjun 1,2, YU Zhonghua 1(1. Dept. of Computer Science, Sichuan University, Chengdu 610064;2. Dept. of Computer Science, Southwest University of Science and Technology, Mianyang 621002)【Abstract 】An algorithm of punctuating the sentences in archaic Chinese language based on context n-gram model is proposed in the paper. The algorithm can make comparatively accurate prediction of the punctuating-positions of the text under data-sparse instances by collecting and calculating context information to better analyze small-scaled corpus and meanwhile, to bring down the effects of the data-sparse plight on the global accuracy. At last, the paper selects the analects of Confucius ( Lunyu ) to test the algorithm introduced, and the results show that the recall and the precision achieve 81% and 52% respectively.【Key words 】N-gram model; Data sparse; Smoothing technology; N-gram model based on context中国几千年的文明历史形成了浩如烟海的历史典籍。

如何借助现代化的手段对这些历史典籍进行有效的挖掘,对于继承发展我国古代灿烂的历史文化具有重要意义。

作为古代书面语的重要形式,古汉语的分析理解是历史典籍挖掘的关键和基础。

本文针对古汉语句子中缺少句读的问题,研究并提出了句子自动切分(自动加句读)的算法,并在《论语》上验证了算法的有效性。

1 问题特点、难点及相关工作本文要解决的问题是设计算法对无标点的古汉语文本进行句子切分,确定句读的位置,包括逗号、冒号、感叹号、问号、句号和顿号等。

很显然,上述问题与句子边界识别完全不同,句子边界识别是识别作为句子边界的句号,其实质是对自然语言文本中出现的句号(如汉语的“。

”和英语的“.”)根据前后文进行消歧[1,2]。

古汉语句子切分问题不是一个平凡问题,其难点主要体现在以下几个方面:(1)古汉语具有句子简洁精练的特点,单字成词的现象比较普遍。

如:1)子曰:“邦有道,谷;邦无道,谷,耻也。

” 2)“克、伐、怨、欲不行焉,可以为仁矣?” 3)子曰:“先之,劳之。

”请益。

曰:“无倦。

”古汉语的简洁精炼使预测句读位置所依赖的局部前后文信息变少,这增加了句子切分的难度。

(2)古汉语文体繁杂,如《论语》、《道德经》、《韩非子》、《诗经》等,每一种文体都有自己独特的风格,且具有的文本数量少,很难获取训练统计模型所需要的足够样本,因此,对于古汉语句子切分来说,数据稀疏问题更加严重。

(3)古汉语中字和词的界限模糊,很难进行词的切分,无法利用单词一级的特征进行句读位置的预测,只能利用有关字或者字串方面的信息来进行决策。

目前,人们在英语和现代汉语句子边界识别方面进行了大量的研究工作,提出了一系列基于规则和基于统计的识别算法,达到了99%左右的准确率。

但是对于古汉语句子的自动切分,还未见相关的研究报告。

本文设计并实现了一个基于前后文n-gram 模型的古汉语句子切分算法,提出了有效的解决数据稀疏问题的平滑技术,在《论语》上的实验结果达到了81%的召回率和52%的准确率。

2 基于前后文n-gram 模型的古汉语句子切分算法n-gram(n 元语法)是自然语言统计建模的重要工具,在单词和字母预测等方面获得了广泛的应用。

但是,传统的n-gram模型[5]在应用于古汉语句子切分时会面临数据稀疏的严重问题。

针对古汉语句子切分所面临的数据严重稀疏的问题,本文设计并实现了一个基于前后文n-gram 模型的切分算法,实验结果表明,新算法不但优于经典的n-gram 模型,而且优于基金项目:国家自然科学基金资助项目(60073046);高等学校博士学科点专项科研基金“SRFDP ”资助项目(20020610007)作者简介:陈天莹(1982-),女,硕士生,主研方向:自然语言处理,自动推理及智能软件设计;陈 蓉,工程师;潘璐璐,硕士生; 李红军,在职硕士生、讲师;于中华,博士、副教授收稿日期:2006-03-13 E-mail :yuzhonghua@现有的针对数据稀疏问题提出的各种平滑技术。

2.1 算法的基本思想设待切分的古汉语文本串为,其中为任意的汉字。

对于任意相邻的两个汉字,算法通过计算它们之间有句读的可能性度量和没有句读的概率12...n w w w i w 1i i w w +1(i i w w σ+•))1(i i w w σ+,然后比较和1()i i w w σ+•1(i i w w )σ+的大小关系来决定是否应该在和i w 1i w +之间加上句读。

当时,11()0()i i i i C w w C w w ++•>>且01()i i w w σ+•和1()i i w w σ+分别简单地定义为和,否则定义为1()i i C w w +•1(i i C w w +)11)1()()/()()/(i i i i i i w w C w C w C w C w σ+•=•+•++1+)) (1)11()[()/()()/()]i i i i i i w w C w C w C w C w d σ++=+++× (2)其中为训练语料中和之间存在句读的次数,为和之间不存在句读的次数,1(i i C w w +•i w 1i w +1()i i C w w +i w 1i w +(i C w +为后面不为句读的所有二元组出现的次数,i w 1()i C w ++为1i w +前面不为句读的所有二元组出现的次数,为后面接句读的二元组出现的次数,(i C w •))i w 1(i C w +•是句读后接1i w +的二元组出现的次数,d 为折扣因子。

引入折扣因子的目的是为了使和1()i i w w σ+•1(i i w w )σ+具有可比性,由于在一般情况下,,,因此()(i i C w C w +>•)1)i +1()(i C w C w ++>•()/()i i C w C w •+ ,d 的取值应该反映汉字和句读在语料库中分布的差异,即大约为1/L ,其中L 为训练语料中由句读隔开的汉字串的平均长度(汉字数)。

当111()/()()/()()/()i i i i i C w C w C w C w C w C w +++•<+++1i +()()i i w w w w 11i i σσ++•>时,确定和i w 1i w +之间有句读,否则没有句读。

在C w 时,简单地认定和之间没有句读。

1()0()0i i C w +==或100)i w 1i w +针对语料库规模小,数据严重稀疏的问题,式(1)和式(2)式在三元组频率为0时,将三元组频率的计算退化成二元组频率的计算,这样可以大大降低数据稀疏为决策带来的负面影响。

从式(1)、式(2)可以看出,在识别句子的切分位置时,不仅利用了句读可能出现位置的前邻接汉字,而且还利用后面临接的汉字信息,综合这种前后文信息来决策句读的位置。

2.2 算法描述图1给出了基于上述思想设计的古汉语句子切分算法。

IF i i+C(w )=0OR C(w )=0THEN 设定和1之间没有句读;iw i w+ELSE BEGINIF AND THEN1()i i C w w +•≠1()i i C w w +≠BEGIN11():(ii ii w w C w w σ++•=•;11():(i i i i w w C w w )σ++=;END ELSE BEGIN1():()/()()/(i i i i i i w w C w C w C w C w 11)σ+•=•+•++1+);11():[()/()()/()]i i i i i i w w C w C w C w C w d σ++=+++×;ENDIF 11()(i i i i w w w w σσ++>• THEN设定和之间没有句读;iw 1i w +ELSE 设定和之间有句读; i w 1i w +END继续处理下面两个汉字;图1 基于前后文n-gram 模型的古汉语句子切分很明显,算法采用的前后文n-gram 模型是传统n-gram 模型的变形和改进,以便充分利用前后文信息对句读的位置进行预测,并克服数据稀疏带来的问题。