基于中心点的聚类算法

聚类算法的原理

聚类算法的原理聚类算法是机器学习中一种常用的无监督学习算法,其主要目标是将相似的数据样本聚集在一起,并将不相似的数据样本分开。

聚类算法的原理可以总结为以下几个步骤:1. 初始化:选择聚类算法的初始聚类中心。

常见的初始化方法包括随机选择数据样本作为初始聚类中心、使用启发式初始化方法如k-means++等。

2. 距离度量:选择合适的距离度量方法来衡量数据样本之间的相似性。

常见的距离度量方法包括欧氏距离、曼哈顿距离、余弦相似度等。

3. 分配:根据距离度量,将每个数据样本分配给距离最近的聚类中心。

可以使用不同的分配策略,如硬分配(只将数据样本分配给距离最近的聚类中心)和软分配(根据距离权重分配数据样本给不同的聚类中心)。

4. 更新:根据分配的结果,更新聚类中心的位置。

可以使用不同的更新策略,如直接将聚类中心移动到分配给它的数据样本的平均位置。

5. 重复:不断迭代分配和更新的过程,直到达到某个停止条件。

常见的停止条件包括达到最大迭代次数、聚类中心不再发生变化等。

常用的聚类算法包括k-means算法、层次聚类算法和DBSCAN算法等。

k-means算法是一种基于距离度量的聚类算法。

它的主要思想是将数据划分为k 个簇,其中每个簇由一个聚类中心代表,目标是使得所有数据样本到其所属聚类中心的平均距离最小。

k-means算法的步骤如下:1. 随机选择k个样本作为初始聚类中心。

2. 对于每个数据样本,计算它与每个聚类中心之间的距离,将该样本分配给距离最近的聚类中心。

3. 更新每个聚类中心的位置,将其移动到分配给它的所有数据样本的平均位置。

4. 重复步骤2和步骤3,直到聚类中心不再发生变化或达到最大迭代次数。

层次聚类算法是一种基于距离度量和聚类间相似性的聚类算法。

它的主要思想是通过计算数据样本之间的距离或相似性,将相似的数据样本聚集在一起,形成一个层次化的聚类结构。

层次聚类算法的步骤如下:1. 将每个数据样本视为一个簇。

聚类算法:K-Means和DBSCAN的比较

聚类算法:K-Means和DBSCAN的比较K-Means和DBSCAN是两种常见的聚类算法,它们在数据挖掘和机器学习领域具有重要的应用价值。

本文将比较这两种算法的优缺点、适用场景等方面,以期帮助读者更好地理解它们的特点和区别。

1. K-Means算法K-Means算法是一种基于距离的聚类算法,它的基本思想是将数据集划分为K个簇,使得每个样本点都属于与其最近的簇。

具体来说,K-Means算法的工作流程如下:(1)随机初始化K个中心点;(2)将每个样本点分配到距离最近的中心点所对应的簇中;(3)更新每个簇的中心点,即将该簇内所有样本点的均值作为新的中心点;(4)重复执行步骤(2)和(3),直到中心点不再发生变化或达到迭代次数上限。

K-Means算法的优点包括实现简单、计算高效等,适用于数据量较大的情况。

但它也存在一些缺点,比如对初始中心点的选择敏感,容易陷入局部最优解,不适用于发现非凸簇等情况。

2. DBSCAN算法DBSCAN(Density-Based Spatial Clustering of Applications with Noise)算法是一种基于密度的聚类算法,它的核心思想是通过样本点的密度来发现聚类簇。

DBSCAN算法的具体步骤如下:(1)以任意顺序选择一个未访问的样本点;(2)计算该样本点的邻域内的样本点个数,若超过预设的阈值,则标记为核心点,否则标记为噪声点;(3)将与核心点密度相连的样本点放入同一个簇中,并继续递归地扩展该簇;(4)重复执行步骤(1)和(2),直到所有样本点都被访问为止。

DBSCAN算法的优点在于可以发现任意形状的簇,并且对噪声数据具有鲁棒性,不受初始参数的影响。

但它也存在一些局限性,比如对密度不同的簇难以处理,对参数的敏感性较强等。

3. K-Means和DBSCAN的比较K-Means和DBSCAN是两种不同的聚类算法,它们在很多方面存在明显的差异。

下面将分别从适用场景、对数据特点的适应性、算法复杂度等方面对它们进行比较。

kmean算法原理

kmean算法原理

k均值聚类算法(k-means)是一种常用的聚类分析算法,它的主要原理如下:

1. 初始化:首先选择k个初始中心点,可以是随机选择或者根据先验知识选择。

这些中心点将作为聚类的中心。

2. 分配样本:将每个样本点分配给距离最近的中心点所代表的聚类。

3. 更新中心点:重新计算每个聚类的中心点,即将每个聚类中的样本点的均值作为新的中心点。

4. 重复步骤2和步骤3,直到满足终止条件(如达到最大迭代次数或者中心点不再更新)。

5. 输出结果:得到k个聚类,每个聚类包含一组样本点,这些样本点在空间中相互靠近,并且与其他聚类的样本点相距较远。

k均值聚类算法的核心思想是通过最小化各个样本点与所属聚类中心点之间的距离来实现聚类。

在迭代过程中,不断更新中心点的位置,使得所有样本点尽可能地靠近自己所属的聚类中心。

最终的聚类结果取决于初始中心点的选择和更新中心点的策略。

需要注意的是,k均值聚类算法对离群点比较敏感,并且需要预先设定聚类数量k。

因此,在应用k均值聚类算法时,需要根据具体问题进行合理的调参和评估聚类结果的质量。

kmeans算法的原理

kmeans算法的原理

K-means算法是一种典型的基于划分的聚类算法,其原理是将数据集划分为K个簇,使得每个数据点都属于最近的簇,并且簇的中心是所有数据点的平均值。

K-means算法的原理可以分为以下几个步骤:

1. 初始化:选择要将数据集分成K个簇,并随机选择K个数据点作为初始簇中心。

2. 分配:将每个数据点分配到距离其最近的簇中心,每个数据点只能属于一个簇。

3. 更新:根据分配的数据点更新簇中心点,这是通过计算属于每个簇的数据点的平均值来实现的。

4. 重复:重复步骤2和3,直到簇中心点不再发生变化,或者达到预定的迭代次数。

K-means算法利用相似性度量方法来衡量数据集中所有数据之间的关系,将关系比较密切的数据划分到一个集合中。

该算法具有运算速度快,执行过程简单的优点,在很多大数据处理领域得到了广泛的应用。

以上是K-means算法的基本原理,可以咨询数学专业人士或查阅算法类书籍了解更多信息。

k-medoids聚类算法

k-medoids聚类算法**标题:深入解析K-Medoids聚类算法****引言:**K-Medoids聚类算法是一种有效的数据聚类方法,广泛应用于数据挖掘、模式识别和机器学习领域。

相比于K-Means算法,K-Medoids在处理离群点时更为鲁棒,因为它选择代表性的样本作为簇的中心,而不是简单地计算样本的均值。

本文将深入探讨K-Medoids聚类算法的原理、步骤以及应用领域,以帮助读者更好地理解和应用这一强大的聚类算法。

**1. K-Medoids聚类算法简介:**K-Medoids聚类算法是一种基于中心点的聚类方法,旨在将数据集分为预定数量的簇,使得每个簇的内部数据点之间的相似度较高,而不同簇之间的相似度较低。

与K-Means算法不同,K-Medoids使用实际数据点作为簇的中心,而非简单地计算数据点的均值。

**2. K-Medoids算法的工作原理:**K-Medoids算法的核心思想是选择每个簇的代表性样本,即簇的中心点,以最小化簇内部数据点与中心点之间的距离。

算法的工作步骤如下:- **初始化:** 随机选择k个数据点作为初始的簇中心。

- **簇分配:** 将每个数据点分配到最近的簇中心,形成k个簇。

- **中心更新:** 对于每个簇,选择一个新的中心,使得该簇内所有数据点到新中心的总距离最小。

- **收敛判定:** 重复簇分配和中心更新步骤,直到簇中心不再改变或改变微小,达到收敛。

**3. K-Medoids与K-Means的比较:**- **鲁棒性:** K-Medoids相比K-Means对离群点更为鲁棒,因为中心点是实际数据点,不受异常值的影响。

- **复杂度:** 由于K-Medoids需要计算中心点到所有其他数据点的距离,算法的复杂度相对较高,但在小规模数据集上表现良好。

- **收敛性:** K-Medoids的收敛性较差,且初始中心点的选择对结果影响较大。

**4. K-Medoids算法的改进和优化:**- **PAM算法:** Partitioning Around Medoids(PAM)是K-Medoids的经典算法,通过交换中心点与非中心点来优化簇的内部距离。

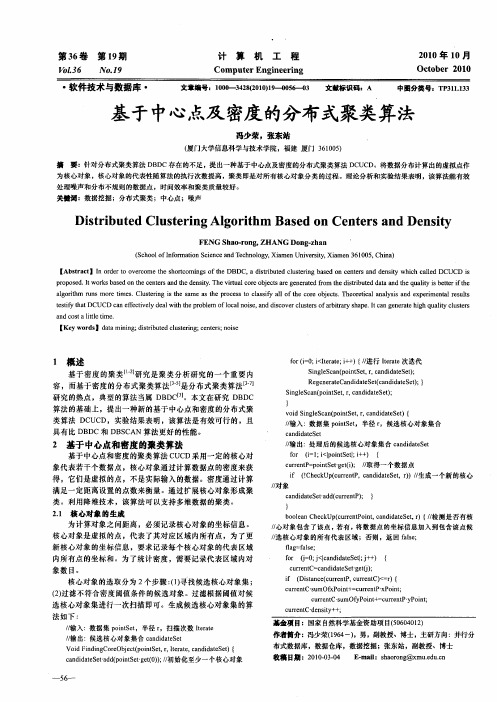

基于中心点及密度的分布式聚类算法

容 ,而基于密度 的分布式聚类算法[5 3] -是分布式聚类算法 _ J j

研 究的热点 ,典型 的算法当属 D D 。本文在研究 D D B CJ B C

算法 的基础上,提 出一种新 的基于 中心点和密度的分布式聚

类算法 DC D,实验结果表 明,该算法 是有效可行的 ,且 UC

po oe .t rsbsdo e e tra dte e s . h iu loe betae e ea df m e ir ue aa dh u lyib t rf e rp sdIwok ae nt nes ni T e r a cr jcs r nrt o t s i tddt e ai et t hc hd t n y vt o g e r h d tb n a t q t s e ih

2 基于中心点和密度的聚类算法

基于中心点和密度的聚类算法 C C U D采 用一定的核心对

, 出:处理后 的候选核心对象集合 cn i tSt / 输 ad a e de

o fr ( l il ite[i+ { i ;<p nSt + ) = o ; c r nP p ite‘ t) / ur t= onS t e( ; / e g i 取得一个数据点

具 有 比 D DC和 DB C N 算 法 更 好 的性 能 。 B SA

v i sn I cnp ite,,a dd tSt { od ige a(onStrcn iae e) s / / 输入 :数据集 p ite,半径 r onSt ,候选核心对象集合

c n iae e a dd tS t

中圈分类号: P113 T313 .

基于中・ 及 密度 的分布式聚类算法 点

冯少荣,张东站

聚类分析的数学原理

聚类分析的数学原理聚类分析是一种常用的数据分析方法,广泛应用于商业、工程、社会科学等领域。

它的主要作用是将一组数据分成若干个类别,使得同一类别内部的数据相似度高,而不同类别之间的相似度则较低。

聚类分析的数学原理主要包括距离度量、相似度计算、聚类算法等几个方面。

一、距离度量聚类分析中需要计算不同数据之间的距离,从而判断它们是否属于同一类别,因此距离度量是聚类分析的基础。

常用的距离度量方法有欧几里得距离和曼哈顿距离。

欧几里得距离是平面上两点之间的距离,也就是勾股定理的应用。

对于n维空间中两个点A(x1,x2,...,xn)和B(y1,y2,...,yn),欧几里得距离公式为:d(A,B) = sqrt((x1-y1)^2 + (x2-y2)^2 + ... +(xn-yn)^2)曼哈顿距离是指两点之间横向和纵向的距离之和,也就是在城市街区中走路的距离。

对于n维空间中两个点A(x1,x2,...,xn)和B(y1,y2,...,yn),曼哈顿距离公式为:d(A,B) = |x1-y1| + |x2-y2| + ... + |xn-yn|二、相似度计算相似度计算是聚类分析中的另一重要内容,用于判断两个数据之间的相似程度。

常用的相似度计算方法有余弦相似度和皮尔逊相关系数。

余弦相似度是衡量两个向量之间的相似程度的一种度量方式。

对于两个向量A和B,余弦相似度公式为:cos(A,B) = (A·B) / (|A||B|)其中“A·B”表示向量内积,而“|A|”和“|B|”分别表示向量A和B 的模长。

皮尔逊相关系数是一种统计学上的度量两个变量之间相关程度的方法。

对于两个变量A和B,皮尔逊相关系数公式为:r(A,B) = Cov(A,B) / (Sd(A)Sd(B))其中“Cov(A,B)”表示变量A和B的协方差,“Sd(A)”和“Sd(B)”分别表示变量A和B的标准差。

三、聚类算法聚类算法是聚类分析的核心,主要包括层次聚类和K均值聚类两种。

K-mediodsK中心点算法介绍

K-mediods(K中心点)算法介绍目录一、K-mediods算法介绍 (2)二、K-mediods算法优缺点 (2)三、K-mediods算法描述 (2)四、K-mediods算法举例 (3)一、K-mediods算法介绍a)话说,聚类算法可以被分为那么几种,比如基于划分方法的、基于层次方法的、基于密度方法的、基于网格方法的、基于模型方法的;K-mediods算法就是基于划分方法的一种聚类算法,确切的说,是对K-means算法的一种改进算法。

二、K-mediods算法优缺点a)K-mediods算法具有能够处理大型数据集,结果簇相当紧凑,并且簇与簇之间明显分明的优点,这一点和K-means算法相同。

b)同时,该算法也有K-means同样的缺点,如,必须事先确定类簇数和中心点,簇数和中心点的选择对结果影响很大;一般在获得一个局部最优的解后就停止了;对于除数值型以外的数据不适合;只适用于聚类结果为凸形的数据集等。

c)与K-means相比,K-mediods算法对于噪声不那么敏感,这样对于离群点就不会造成划分的结果偏差过大,少数数据不会造成重大影响。

d)K-mediods由于上述原因被认为是对K-means的改进,但由于按照中心点选择的方式进行计算,算法的时间复杂度也比K-means上升了O(n)。

三、K-mediods算法描述a)首先随机选取一组聚类样本作为中心点集b)每个中心点对应一个簇c)计算各样本点到各个中心点的距离(如欧几里德距离),将样本点放入距离中心点最短的那个簇中d)计算各簇中,距簇内各样本点距离的绝度误差最小的点,作为新的中心点e)如果新的中心点集与原中心点集相同,算法终止;如果新的中心点集与原中心点集不完全相同,返回b)四、K-mediods算法举例a)设有(A,B,C,D,E,F)一组样本b)随机选择B、E为中心点c)计算D和F到B的距离最近,A和C到E的距离最近,则B,D,F为簇X1,A,C,E为簇X2d)计算X1发现,D作为中心点的绝对误差最小,X2中依然是E作为中心点绝对误差最小e)重新以D、E作为中心点,重复c)、d)步骤后,不再变换,则簇划分确定。

k-medoids聚类算法

k-medoids聚类算法

k-medoids聚类算法又叫做PAM算法,是一种基于中心点的分组聚类算法,和k-means算法相似,其目的也是将样本划分为k个簇,每个簇都包含距离簇中心最近的样本点。

与k-means不同的是,k-medoids使用的是样本点而非均值点来作为簇的中心点,因此不受离群点的影响,在一定程度上提高了聚类的准确性。

k-medoids算法的步骤如下:

1. 随机选择k个样本作为初始中心点。

2. 将每个样本点分配到与其最近的中心点所在的簇中。

3. 计算每个簇中所有样本之间的距离和作为该簇的代价函数。

4. 针对每个簇中的每个样本,计算将该样本作为中心点后,该簇的代价函数。

5. 如果将当前簇的某个样本作为中心点可以降低该簇的代价函数,则将该样本作为新的中心点。

6. 重复执行步骤2至5,直到簇的中心点不再改变。

最终,k-medoids算法会得到k个簇,每个簇包含距离中心点最近的一些样本点。

通过对数据的分析,可以发现不同的簇之间具有明显的差异性,对于簇内相似性高、簇间相似性低的数据集,k-medoids 算法在实际应用中有着广泛的应用。

基因表达数据分析中聚类算法的使用教程与生物学意义解读

基因表达数据分析中聚类算法的使用教程与生物学意义解读基因表达数据分析是生物学研究中的重要环节之一,它可以帮助我们理解基因的功能及其在不同生理条件下的调控机制。

而聚类算法作为一种常用的数据分析方法,可以帮助我们对基因表达数据进行分类和分组,进而揭示出隐藏在数据中的生物学意义。

本文将介绍常见的聚类算法及其在基因表达数据分析中的应用,并解读其生物学意义。

聚类算法是一种无监督学习方法,通过将相似的样本归为一类,将不相似的样本归为不同类别,从而将数据集划分为多个簇。

在基因表达数据分析中,聚类算法可以帮助我们发现具有相似表达模式的基因及其可能的生物学功能。

常见的聚类算法包括层次聚类、k-means聚类和模糊C-均值聚类。

层次聚类是一种基于距离的聚类算法,它可以将样本逐步合并成不同规模的簇。

在基因表达数据分析中,我们可以使用层次聚类算法将基因按照其表达模式进行分组。

首先,我们需要选择一个相似性度量指标,如欧氏距离或相关系数,来衡量基因间的距离。

然后,使用层次聚类算法将基因逐步合并,直到形成最终的聚类结果。

通过观察聚类结果,我们可以发现具有相似表达模式的基因并对其进行功能注释和生物学意义解读。

k-means聚类是一种基于中心点的聚类算法,它根据样本与中心点的距离来划分簇。

在基因表达数据分析中,k-means聚类可以帮助我们将基因分为指定数量的簇。

首先,我们需要选择一个合适的k值,即簇的数量。

然后,根据基因间的相似性度量指标,如欧氏距离或相关系数,运用k-means聚类算法将基因划分为k个簇。

最后,我们可以通过分析聚类结果来揭示不同簇中基因的生物学意义,如同一簇中的基因可能具有相似的功能或参与相同的生物过程。

模糊C-均值聚类是一种基于模糊理论的聚类算法,它可将样本划分为多个簇,并对样本和簇的隶属度进行建模。

在基因表达数据分析中,模糊C-均值聚类可以帮助我们识别具有模糊表达模式的基因。

首先,我们需要选择合适的簇数和模糊隶属度的阈值。

K-mediods(K中心点算法)介绍

K-mediods(K中心点)算法介绍目录一、K-mediods算法介绍 (2)二、K-mediods算法优缺点 (2)三、K-mediods算法描述 (2)四、K-mediods算法举例 (3)一、K-mediods算法介绍a)话说,聚类算法可以被分为那么几种,比如基于划分方法的、基于层次方法的、基于密度方法的、基于网格方法的、基于模型方法的;K-mediods算法就是基于划分方法的一种聚类算法,确切的说,是对K-means算法的一种改进算法。

二、K-mediods算法优缺点a)K-mediods算法具有能够处理大型数据集,结果簇相当紧凑,并且簇与簇之间明显分明的优点,这一点和K-means算法相同。

b)同时,该算法也有K-means同样的缺点,如,必须事先确定类簇数和中心点,簇数和中心点的选择对结果影响很大;一般在获得一个局部最优的解后就停止了;对于除数值型以外的数据不适合;只适用于聚类结果为凸形的数据集等。

c)与K-means相比,K-mediods算法对于噪声不那么敏感,这样对于离群点就不会造成划分的结果偏差过大,少数数据不会造成重大影响。

d)K-mediods由于上述原因被认为是对K-means的改进,但由于按照中心点选择的方式进行计算,算法的时间复杂度也比K-means上升了O(n)。

三、K-mediods算法描述a)首先随机选取一组聚类样本作为中心点集b)每个中心点对应一个簇c)计算各样本点到各个中心点的距离(如欧几里德距离),将样本点放入距离中心点最短的那个簇中d)计算各簇中,距簇内各样本点距离的绝度误差最小的点,作为新的中心点e)如果新的中心点集与原中心点集相同,算法终止;如果新的中心点集与原中心点集不完全相同,返回b)四、K-mediods算法举例a)设有(A,B,C,D,E,F)一组样本b)随机选择B、E为中心点c)计算D和F到B的距离最近,A和C到E的距离最近,则B,D,F为簇X1,A,C,E为簇X2d)计算X1发现,D作为中心点的绝对误差最小,X2中依然是E作为中心点绝对误差最小e)重新以D、E作为中心点,重复c)、d)步骤后,不再变换,则簇划分确定。

划分聚类分析(K均值聚类、围绕中心点的划分PAM)

划分聚类分析(K均值聚类、围绕中⼼点的划分PAM)1 划分聚类分析1.1 K 均值聚类最常见的划分⽅法是K均值聚类分析。

从概念上讲,K均值算法如下:(1) 选择K个中⼼点(随机选择K⾏);(2) 把每个数据点分配到离它最近的中⼼点;(3) 重新计算每类中的点到该类中⼼点距离的平均值(也就说,得到长度为p的均值向量,这⾥的p是变量的个数);(4) 分配每个数据到它最近的中⼼点;(5) 重复步骤(3)和步骤(4)直到所有的观测值不再被分配或是达到最⼤的迭代次数(R把10次作为默认迭代次数)。

R软件使⽤Hartigan & Wong(1979)提出的有效算法,这种算法是把观测值分成k组并使得观测值到其指定的聚类中⼼的平⽅的总和为最⼩。

K均值聚类能处理⽐层次聚类更⼤的数据集。

在R中K均值的函数格式是kmeans(x,centers),这⾥x表⽰数值数据集(矩阵或数据框),centers是要提取的聚类数⽬。

函数返回类的成员、类中⼼、平⽅和(类内平⽅和、类间平⽅和、总平⽅和)和类⼤⼩。

由于K均值聚类在开始要随机选择k个中⼼点,在每次调⽤函数时可能获得不同的⽅案。

使⽤set.seed()函数可以保证结果是可复制的。

此外,聚类⽅法对初始中⼼值的选择也很敏感。

kmeans()函数有⼀个nstart选项尝试多种初始配置并输出最好的⼀个。

例如,加上nstart=25会⽣成25个初始配置。

通常推荐使⽤这种⽅法。

不像层次聚类⽅法,K均值聚类要求你事先确定要提取的聚类个数。

同样,NbClust包可以⽤来作为参考。

另外,在K均值聚类中,类中总的平⽅值对聚类数量的曲线可能是有帮助的。

可根据图中的弯曲选择适当的类的数量。

图像可以⽤下⾯的代码产⽣:wssplot<-function(data,nc=15,seed=123){wss<-(nrow(data)-1)*sum(apply(data, 2, var))for (i in 2:nc){set.seed(seed)wss[i]<-sum(kmeans(data,centers = i)$withiness)}plot(1:nc,wss,type="b",xlab="Number of Clusters",ylab="within groups sum of squares")}data参数是⽤来分析的数值数据,nc是要考虑的最⼤聚类个数,⽽seed是⼀个随机数种⼦。

基于优化初始中心点的K-means文本聚类算法

[ ]张磊. ML的优 [ B OL . S 6 X , D / ] C DN技术 中心 ,t :/ g , . ht / p

WZ c d . e/ r 7 8 5 / . s n n t ul 4 1 5 /

[ 3 a K,Mut 3 i A Jn r MN, l nP.D t i t i : ei y Fy J a c se n ar e n a u rg vw [ .A M C mpt uvy,9 93 () 25 8 I C o ui S res19 ,1 3 :6  ̄2 1 g n

Ab t a t K- a sa g rt m e mi a e t c l p i m ,i i s n i v O i i a t r i g c n i o L An i p o e l s r c me n l o i h t r n t s a l a t ao o mu t s e st e t n t l a t o d t r i i s n i m r v d a— g rt m s p o o e o ih i r p s d,c mp r d wih t e ta iin la g rt ms h r p s d ag r h c n g t i i a e t r t i h r o a e t h r d to a l o i h ,t e p o o e l o i m a e n t lc n e s wi h g e t i h

6 )重 复 上 述操 作 4 、 ) 至 得 到全 部 k个 中 )5 直 心点 。

示 , 于初 始化 中心 的优 化选 取算 法选 取 的 中心 点 基 如 图 2所 示 。 对 比两次 中心 点 的选 取结 果 , 出经 过 优化 算 得 法得 出 的中心 点均在 其类 簇 中 , 后期 迭 代 的次 数 在 较少 而且 不容 易 陷入局 部最优 。

Kmeans算法的K值和聚类中心的确定

Kmeans算法的K值和聚类中⼼的确定0 K-means算法简介K-means是最为经典的基于划分的聚类⽅法,是⼗⼤经典数据挖掘算法之⼀。

K-means算法的基本思想是:以空间中k个点为中⼼进⾏聚类,对最靠近他们的对象归类。

通过迭代的⽅法,逐次更新各聚类中⼼的值,直⾄得到最好的聚类结果。

算法过程如下:1)从N个⽂档随机选取K个⽂档作为2)对剩余的每个⽂档测量其到每个的距离,并把它归到最近的质⼼的类3)重新计算已经得到的各个类的4)迭代2~3步直⾄新的质⼼与原质⼼相等或⼩于指定阈值,算法结束参考Java代码public static Map<Integer, List<Integer>> kMeans(List<List<Double>> dataSet, int k,List<List<Double>> centerPointCp) {/*** 拷贝中⼼点,防⽌修改原始数据*/List<List<Double>> centerPoint = new ArrayList<List<Double>>();for(int i = 0; i < centerPointCp.size(); i++){List<Double> tmpCp = new ArrayList<Double>();for(int j = 0; j < centerPointCp.get(i).size(); j++){tmpCp.add(centerPointCp.get(i).get(j));}centerPoint.add(tmpCp);}int n = dataSet.size();int dim = dataSet.get(0).size();double[][] clusterAssment = new double[n][2];Boolean clusterChanged = true;while (clusterChanged) {clusterChanged = false;for (int i = 0; i < n; i++) {double minDist = Double.POSITIVE_INFINITY;int minIndex = -1;for (int j = 0; j < k; j++) {double distIC = PreData.distance(dataSet.get(i),centerPoint.get(j));if (distIC < minDist) {minDist = distIC;minIndex = j;}}if (clusterAssment[i][0] != minIndex) {clusterChanged = true;}clusterAssment[i][0] = minIndex;clusterAssment[i][1] = Math.pow(minDist, 2);}for (int i = 0; i < k; i++) {double[] tmp = new double[dim];int cnt = 0;for (int j = 0; j < n; j++) {if (i == clusterAssment[j][0]) {for (int m = 0; m < dim; m++) {tmp[m] += dataSet.get(j).get(m);}cnt += 1;}}if (cnt != 0) {for (int m = 0; m < dim; m++) {centerPoint.get(i).set(m, tmp[m] / cnt);}}}}//List<List<Double>>Map<Integer, List<Integer>> ret = new TreeMap<Integer, List<Integer>>();for(int i = 0; i < n; i++){for(int j = 0; j < k; j++){if(clusterAssment[i][0] == j){if(ret.containsKey(j)){ret.get(j).add(i);}else{List<Integer> tmp = new ArrayList<Integer>();tmp.add(i);ret.put(j, tmp);}break;}}}return ret;}View Code缺点:1 k-means算法容易收敛于局部最⼩值,基于此可以⽤⼆分K-均值(bisecting K-means)的算法。

聚类分析—K-means and K-medoids聚类要点

2018/10/5

在图像分割上的简单应用(续)

分割后的效果

注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。

2018/10/5

在图像分割上的简单应用(续)

例 2:

注:聚类中心个数为5,最大迭代次数为10。

2018/1Байду номын сангаас/5

k-平均聚类算法(续)

优点: 相对有效性: O(tkn),

其中 n 是对象数目, k 是簇数目, t 是迭代次数; 通常, k, t << n.

2018/10/5

PAM

PAM (Partitioning Around Medoids) (Kaufman and Rousseeuw, 1987)

是最早提出的k-中心点聚类算法 基本思想:

随机选择k个代表对象

反复地试图找出更好的代表对象: 分析所有可能的对象对,每个对 中的一个对象被看作是代表对象, 而另一个不是. 对可能的各种组合, 估算聚类结果的质量

2018/10/5

k-中心点聚类方法(续)

找聚类中的代表对象(中心点)

PAM (Partitioning Around Medoids, 1987)

首先为每个簇随意选择选择一个代表对象, 剩余的对象根 据其与代表对象的距离分配给最近的一个簇; 然后反复地 用非代表对象来替代代表对象,以改进聚类的质量 PAM 对于较小的数据集非常有效, 但不能很好地扩展到大 型数据集

k-平均值(MacQueen’67): 每个簇用该簇中对象的平均值来表示

k-中心点或 PAM (Partition around medoids) (Kaufman & Rousseeuw’87): 每个簇用接近聚类中心的一个对象来表示

kmeans聚类算法与熵聚类算法

K-means聚类算法与熵聚类算法是机器学习和数据挖掘领域常用的无监督学习方法。

它们都是通过对数据进行分组来寻找数据内在的结构和模式。

一、 K-means聚类算法的原理和流程1.1 K-means算法的原理K-means聚类算法是一种基于中心点的聚类算法。

它的基本思想是将数据集划分为K个簇,每个簇内的数据点与该簇的中心点具有最小的距离,而不同簇之间的数据点的距离较大。

K-means算法的目标是最小化簇内数据点与其对应中心点之间的距离之和。

1.2 K-means算法的流程K-means算法的流程大致可以分为以下几步:(1)初始化K个中心点,可以随机选择数据集中的K个样本作为中心点;(2)对每个样本,计算其与K个中心点的距离,并将其归类到距离最近的簇中;(3)更新每个簇的中心点,将其设置为该簇内所有样本的平均值;(4)重复步骤(2)和(3),直到簇内数据点的分配不再发生变化或达到预设的迭代次数。

1.3 K-means算法的优缺点K-means算法的优点包括简单易实现、计算效率高等。

但其也存在一些缺点,例如K值需事先确定、对初始中心点敏感等。

二、熵聚类算法的原理和流程2.1 熵聚类算法的原理熵聚类算法是一种基于信息论的聚类方法。

其基本思想是通过最小化簇内数据点的信息熵来进行聚类。

熵聚类算法可以分为两种:簇内熵最小化算法和簇间熵最大化算法。

2.2 簇内熵最小化算法簇内熵最小化算法的目标是使得每个簇内的数据点相似度较高,即簇内的数据点之间的差异较小。

这可以通过最小化每个簇的熵来实现。

2.3 簇间熵最大化算法簇间熵最大化算法的目标是使得不同簇之间的差异较大,即簇之间的数据点之间的差异较大。

这可以通过最大化不同簇之间的信息熵来实现。

2.4 熵聚类算法的流程熵聚类算法的流程主要包括以下几步:(1)计算簇内每个数据点的信息熵;(2)将数据点归类到信息熵最小的簇中;(3)重复步骤(1)和(2),直到满足停止条件。

2.5 熵聚类算法的优缺点熵聚类算法的优点包括不需要预先设定簇的个数、对初始值不敏感等。

PAM聚类算法的分析与实现

PAM聚类算法的分析与实现PAM(Partitioning Around Medoids)是一种基于对象之间的相似度或距离进行聚类的算法。

该算法由Kaufman和Rousseeuw于1987年提出,是一种基于中心点的聚类算法。

PAM聚类算法通过找到一组对象作为中心点(即medoids),将其他对象分配到与其最近的中心点,从而形成聚类。

1. 随机选择k个对象作为初始的medoids。

2. 对于每个对象,计算它与每个medoid的距离,并选择与之距离最近的medoid作为其所属的聚类。

3.对每个聚类计算其内部对象的距离之和,作为该聚类的代价函数。

4. 对于每个非medoid对象,分别尝试用其他非medoid对象作为替代medoid,并计算代价函数的变化。

5. 若替代medoid能够降低代价函数,将其作为新的medoid,并更新聚类。

6.重复步骤4和步骤5,直至代价函数不再改变或达到最大迭代次数。

下面是一个简单的PAM聚类算法的Python实现:```pythonimport numpy as npdef pam_clustering(data, k, max_iter=100):# 随机选择k个对象作为初始的medoidsmedoids = np.random.choice(len(data), k, replace=False)#创建聚类矩阵,记录每个对象所属的聚类clusters = np.zeros(len(data))for _ in range(max_iter):# 遍历每个对象,分配到与其最近的medoidfor i in range(len(data)):distances = np.linalg.norm(data[i] - data[medoids], axis=1) cluster = np.argmin(distances)clusters[i] = cluster#计算当前聚类的代价函数cost = np.sum(np.linalg.norm(data[i] -data[medoids[clusters[i]]], axis=1))# 查找可以降低代价函数的替代medoidfor i in range(len(data)):cluster = clusters[i]current_medoid = medoids[cluster]new_medoids = np.setdiff1d(medoids, current_medoid)distances = np.linalg.norm(data[i] - data[new_medoids], axis=1)new_cost = np.sum(np.linalg.norm(data[i] -data[new_medoids[np.argmin(distances)]], axis=1))if new_cost < cost:medoids[cluster] = new_medoids[np.argmin(distances)]clusters[i] = cluster#如果代价函数不再改变,停止迭代if np.sum(clusters != old_clusters) == 0:breakold_clusters = np.copy(clusters)return clusters#使用示例data = np.array([[1, 2], [2, 2], [3, 1], [6, 5], [7, 5], [8, 6]])k=2clusters = pam_clustering(data, k)print(clusters)```这个示例代码实现了PAM聚类算法,并使用二维数据集进行演示。

欧几里得聚类算法

欧几里得聚类算法欧几里得聚类算法(Euclidean Clustering Algorithm)是一种经典的聚类算法,主要用于将一组数据点分成多个类别。

该算法基于欧几里得距离(Euclidean Distance)的概念,在特征空间中度量数据点之间的相似性,并将相似的数据点分组。

1.初始化:选择合适的聚类数k和初始中心点。

k代表预先设定的聚类数量,初始中心点可以随机选择或者根据具体问题进行设定。

2.计算距离:对于每一个数据点,计算它与所有中心点之间的距离,常用的距离度量方法是欧几里得距离。

3.分配到最近中心点:将每个数据点分配给与其距离最近的中心点所代表的类别。

4.更新中心点:对于每一个类别,计算其中所有数据点的均值,作为新的中心点。

5.重复步骤2至4,直到达到停止条件。

停止条件可以是达到固定迭代次数,或者中心点不再发生变化。

经过若干次迭代后,欧几里得聚类算法最终会得到每个数据点属于的聚类类别。

该算法的时间复杂度为O(n*k*i*d),其中n表示数据点的数量,k表示聚类数量,i表示迭代次数,d表示特征的维度。

1.简单易用:算法原理简单,容易理解和实现。

2.聚类效果好:通过计算欧几里得距离,能够将相似的数据点聚集在一起,具有较高的聚类效果。

3.可扩展性强:算法适用于各种数据集和特征空间,具有较强的可扩展性。

然而,欧几里得聚类算法也存在一些缺点:1.对初始点的敏感性:初始中心点的选择对聚类结果有较大影响,不同的初始点可能会得到不同的聚类结果。

2.算法复杂度较高:由于要计算所有数据点之间的距离,算法的时间复杂度较高,特别是数据量较大时。

3.聚类数量需要预先设定:算法需要事先设定聚类的数量k,对于未知的数据集,难以事先确定合适的聚类数量。

为了解决欧几里得聚类算法的局限性,研究者们提出了很多改进的算法,如DBSCAN、K-means++等。

这些算法在欧几里得聚类算法的基础上,进一步考虑了数据点的密度或者引入了新的算法思想,提高了聚类的性能和效果。

一种基于PDS、TIE和PMI的快速PAM聚类算法

Abtat s c r

P M( a io i ru dMeod )l rh n fh oua - ei ls r gagrh ,hc a t n b s es A Prt nn A on dis ag i m i oeo ep plr m do c t i l i msw ihh s r gr ut s ti g ot s t k d u en ot so o n

Kewod y rs

Cutr gm tos P M lo tm S ac t t y P S P / I C m ua o o pei ls i e d A a rh erhs a g ( D / MITE) o ptt ncm l t en h gi re i xy 重 复计 算 。

a d c re t e swh n p o e sn a g a a es Ho v r P n o r cn s e r c si g l r e d ts t. we e , AM l s rn lo i m u f r fo h a y c mp t t n lb r e n l r e d t e cu t i g a g rt s f s rm e v o u ai a u d n i a g aa s t e h e o

P M 聚类的新算法。实验结果表 明 , A 相对于基 本 P M 聚 类算 法, 保持 相 同聚 类效果 的情况 下 , A 在 快速 P M 聚 类新算 法能够 减少 A 7 % ~9 % 的乘法计算量 , 可节省约 13以上的计算时 间。 0 0 并 / 关键 词 聚类方法 P M算 法 搜索策略 ( D / MITE 计算 复杂度 A P SP /P 的快 速 P M 聚 类 算 法 D 、I MI A

林建仁 陆佩忠

K中心点算法之PAM

K中⼼点算法之PAM⼀.PAM聚类算法:选⽤簇中位置最中⼼的对象,试图对n个对象给出k个划分;代表对象也被称为是中⼼点,其他对象则被称为⾮代表对象;最初随机选择k个对象作为中⼼点,该算法反复地⽤⾮代表对象来代替代表对象,试图找出更好的中⼼点,以改进聚类的质量;在每次迭代中,所有可能的对象对被分析,每个对中的⼀个对象是中⼼点,⽽另⼀个是⾮代表对象。

对可能的各种组合,估算聚类结果的质量;⼀个对象Oi可以被使最⼤平⽅-误差值减少的对象代替;在⼀次迭代中产⽣的最佳对象集合成为下次迭代的中⼼点。

对⽐kmeans:k-means是每次选簇的均值作为新的中⼼,迭代直到簇中对象分布不再变化。

其缺点是对于离群点是敏感的,因为⼀个具有很⼤极端值的对象会扭曲数据分布。

那么我们可以考虑新的簇中⼼不选择均值⽽是选择簇内的某个对象,只要使总的代价降低就可以。

kmedoids算法⽐kmenas对于噪声和孤⽴点更鲁棒,因为它最⼩化相异点对的和(minimizes a sum of pairwise dissimilarities )⽽不是欧式距离的平⽅和(sum of squared Euclidean distances.)。

⼀个中⼼点(medoid)可以这么定义:簇中某点的平均差异性在这⼀簇中所有点中最⼩。

⼆.算法描述:wiki上有对pam算法的解释,这⾥着重对维基百科的例⼦进⾏介绍:k-medoid聚类算法的最常见实现为Partitioning Around Medoids (PAM)算法,PAM利⽤了贪婪搜索,不⼀定可以找到最优解,但是⽐穷尽搜索更快。

输⼊:簇的数⽬k和包含n个对象的数据输出:k个簇,使得所有对象与其距离最近中⼼点的相异度总和最⼩1. 初始化:随机挑选n个点中的k个点作为中⼼点。

2. 将其余的点根据距离划分⾄这k个类别中。

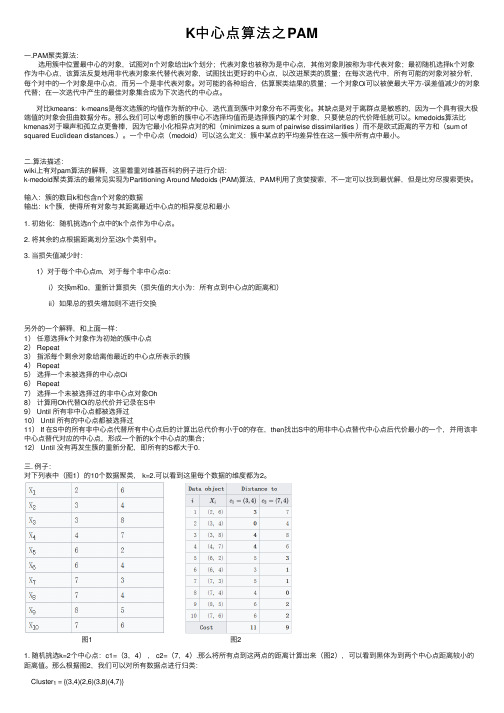

3. 当损失值减少时:1)对于每个中⼼点m,对于每个⾮中⼼点o:i)交换m和o,重新计算损失(损失值的⼤⼩为:所有点到中⼼点的距离和)ii)如果总的损失增加则不进⾏交换另外的⼀个解释,和上⾯⼀样:1)任意选择k个对象作为初始的簇中⼼点2) Repeat3)指派每个剩余对象给离他最近的中⼼点所表⽰的簇4) Repeat5)选择⼀个未被选择的中⼼点Oi6) Repeat7)选择⼀个未被选择过的⾮中⼼点对象Oh8)计算⽤Oh代替Oi的总代价并记录在S中9) Until 所有⾮中⼼点都被选择过10) Until 所有的中⼼点都被选择过11) If 在S中的所有⾮中⼼点代替所有中⼼点后的计算出总代价有⼩于0的存在,then找出S中的⽤⾮中⼼点替代中⼼点后代价最⼩的⼀个,并⽤该⾮中⼼点替代对应的中⼼点,形成⼀个新的k个中⼼点的集合;12) Until 没有再发⽣簇的重新分配,即所有的S都⼤于0.三. 例⼦:对下列表中(图1)的10个数据聚类, k=2.可以看到这⾥每个数据的维度都为2。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于中心点的聚类算法

1. 中心点聚类算法是一种常用的聚类算法,它的主要思想是将样本集合划分为若干个类别,并通过计算类别的中心点来表示每个类别。

在这个算法中,首先需要确定类别的个数,然后随机选择一些样本作为初始中心点。

接下来,通过计算其他样本与中心点的距离,将每个样本分配到最近的中心点所代表的类别中。

然后,更新每个类别的中心点位置,通过重新计算该类别中所有样本的平均值来得到新的中心点。

重复这个过程,直到中心点不再发生变化或达到预定的停止条件。

2. 中心点聚类算法有很多种不同的变体,其中最常见的就是k均值聚类算法。

k 均值聚类算法是基于中心点的聚类算法的一种特殊形式,它通过选择k个初始中心点来进行聚类,其中k代表了类别的个数。

在算法的初始阶段,通过随机选择k个样本作为初始中心点。

然后,通过计算其他样本与这k个中心点的距离,将每个样本分配到距离最近的中心点所代表的类别中。

接下来,更新每个类别的中心点位置,通过重新计算该类别中所有样本的平均值来得到新的中心点。

重复这个过程,直到中心点不再发生变化或达到预定的停止条件。

3. 中心点聚类算法的优点包括简单易实现、计算速度较快等。

它可以有效地将样本划分到不同的类别中,并且在某些数据集上取得很好的聚类效果。

另外,中心点聚类算法对于处理大规模数据集也较为适用。

然而,中心点聚类算法也存在一些缺点。

首先,对于离群点或者异常值比较敏感,可能会导致聚类结果不准确。

其次,中心点聚类算法需要预先确定类别的个数k,这个值的选择对于聚类结果

的影响较大。

而且,中心点聚类算法对于非凸形状的聚类结果表现不佳。

4. 在使用中心点聚类算法时,需要考虑一些关键问题。

首先是选择合适的距离度量方法,常用的距离度量方法有欧氏距离、曼哈顿距离等。

其次是选择合适的停止条件,通常可以根据中心点的变化程度或者算法迭代次数来确定停止条件。

另外,选择合适的初始中心点也对聚类结果有重要影响,一种常见的方法是通过随机选择样本作为初始中心点。

最后,需要进行算法的评估和结果的解释,可以使用一些聚类评估指标来评估聚类结果的质量,例如轮廓系数、Davies-Bouldin 指数等。

5. 综上所述,中心点聚类算法是一种常用的聚类算法,它通过计算类别的中心点来表示每个类别,并将样本分配到最近的中心点所代表的类别中。

其中最常见的变体是k均值聚类算法。

中心点聚类算法具有简单易实现、计算速度快等优点,但对离群点和异常值较为敏感,需要预先确定类别个数k,对于非凸形状的聚类结果表现不佳。

在使用中心点聚类算法时,需要选择合适的距离度量方法、停止条件和初始中心点,并进行算法评估和结果解释。