Optimistic Concurrency Control for Inverted Files in Text Databases

oracle 存储过程并发写法

oracle 存储过程并发写法在Oracle数据库中,并发是指多个用户或进程同时访问数据库的能力。

在并发环境下,存储过程的设计和实现需要考虑到并发性,以确保数据的一致性和安全性。

下面是一些常见的Oracle存储过程并发写法。

1.悲观并发控制(Pessimistic Concurrency Control)悲观并发控制是指在操作数据之前,事先假设其他用户或进程会对相同的数据进行修改,因此需要采取锁机制来保护数据。

在Oracle 中,可以使用行级锁来实现悲观并发控制。

在存储过程中,可以使用以下方法实现悲观并发控制:-使用SELECT ... FOR UPDATE语句,在读取数据时对数据进行加锁,防止其他用户并发修改。

-使用LOCK TABLE语句,对需要修改的表进行锁定,防止其他用户并发访问。

-使用排他锁(exclusive lock),只允许一个用户修改数据,其他用户需要等待锁释放。

悲观并发控制的缺点是会对性能产生一定的影响,因为需要等待锁的释放。

此外,如果锁的粒度过大,也会导致并发性下降。

2.乐观并发控制(Optimistic Concurrency Control)乐观并发控制是指在操作数据之前,并不主动加锁,而是在提交事务时检查数据是否被其他用户修改过。

在Oracle中,可以通过使用版本号或时间戳来实现乐观并发控制。

在存储过程中,可以使用以下方法实现乐观并发控制:-在表中添加一个版本号或时间戳字段,并在读取和更新数据时进行比较和更新。

-使用MERGE语句,在更新数据时同时检查数据是否被其他事务修改过。

乐观并发控制的优点是不需要加锁,对性能影响较小。

但是如果多个用户并发修改同一行数据,则可能发生冲突,需要进行冲突处理。

3.分段锁(Partition Locking)分段锁是指将数据分成多个段,并对每个段进行锁定,以实现高并发。

在Oracle中,可以通过使用分区(Partitioning)来实现分段锁。

程序员需要知道的缩写和专业名词

英文缩写API应用程序接口(英语:Application Programming Interface,简称:API),又称为应用编程接口,就是软件系统不同组成部分衔接的约定。

由于近年来软件的规模日益庞大,常常需要把复杂的系统划分成小的组成部分,编程接口的设计十分重要。

程序设计的实践中,编程接口的设计首先要使软件系统的职责得到合理划分。

良好的接口设计可以降低系统各部分的相互依赖,提高组成单元的内聚性,降低组成单元间的耦合程度,从而提高系统的维护性和扩展性。

ACIDACID,是指数据库管理系统(DBMS)在写入或更新资料的过程中,为保证事务(transaction)是正确可靠的,所必须具备的四个特性:原子性(atomicity,或称不可分割性)、一致性(consistency)、隔离性(isolation,又称独立性)、持久性(durability)。

AJAXAJAX即“Asynchronous JavaScript and XML”(异步的JavaScript 与XML 技术),指的是一套综合了多项技术的浏览器端网页开发技术。

CAS1.比较并交换(compare and swap, CAS),是原子操作的一种,可用于在多线程编程中实现不被打断的数据交换操作,从而避免多线程同时改写某一数据时由于执行顺序不确定性以及中断的不可预知性产生的数据不一致问题。

该操作通过将内存中的值与指定数据进行比较,当数值一样时将内存中的数据替换为新的值。

2.3.集中式认证服务(英语:Central Authentication Service,缩写CAS)是一种针对万维网的单点登录协议。

它的目的是允许一个用户访问多个应用程序,而只需提供一次凭证(如用户名和密码)。

它还允许web应用程序在没有获得用户的安全凭据(如密码)的情况下对用户进行身份验证。

“CAS”也指实现了该协议的软件包。

4.JPAJPA 是Java Persistence API 的简称,中文名Java 持久层API,是JDK 5.0 注解或XML 描述对象-关系表的映射关系,并将运行期的实体对象持久化到数据库中。

cas乐观锁原理

cas乐观锁原理Optimistic concurrency control, also known as optimistic locking, is a technique used in computer science to ensure data integrity in a multi-user environment. In this approach, the system allows multiple users to access and modify the same data concurrently, with the assumption that conflicts are rare.乐观锁原理,也称为乐观锁定,是计算机科学中用于在多用户环境中确保数据完整性的一种技术。

在这种方法中,系统允许多个用户同时访问和修改相同的数据,并假定冲突很少发生。

When a user wishes to update a piece of data, the system first checks if the data has been modified by any other user since it was last read. If no changes have occurred, the update is allowed to proceed. However, if the data has been modified in the meantime, the system will detect the conflict and prevent the update from being applied, requiring the user to refresh the data and reapply the changes.当用户希望更新一条数据时,系统首先检查自上次读取以来该数据是否已被其他用户修改。

TDSQL计算引擎研发工程师岗位面试题及答案(经典版)

TDSQL计算引擎研发工程师岗位面试题及答案1.介绍一下TDSQL计算引擎的基本工作原理。

回答:TDSQL是基于分布式计算框架的实时数据分析引擎,通过将SQL查询转化为分布式计算任务来实现快速数据分析。

在查询处理过程中,数据会被分片并在多个节点上并行处理,最终结果会被聚合返回。

2.请解释一下分布式计算中的数据分片和数据聚合。

回答:数据分片是将数据划分成小块,使得每个节点可以并行处理部分数据。

数据聚合是将多个节点处理的结果合并为最终的输出。

3.在TDSQL中,如何处理复杂的SQL查询,例如涉及多表连接和子查询的情况?回答:复杂的SQL查询需要经过优化器解析,优化和重写阶段。

TDSQL会根据数据分布情况决定是否将多表连接和子查询下推到各个节点进行处理,然后再将结果聚合。

4.请描述一下TDSQL的查询优化过程。

回答:查询优化过程包括查询解析、查询重写、查询优化以及物理计划生成等阶段。

解析器解析查询语句,重写器根据规则进行优化,优化器选择最优执行计划,执行引擎根据物理计划执行任务。

5.在TDSQL中,如何处理数据倾斜的情况?请举例说明。

回答:数据倾斜可能导致某些节点负载过重。

可以采用数据重分布、数据倾斜检测和动态负载均衡等方法来处理。

例如,可以将数据倾斜的表进行重新分片,或者在查询时通过动态调整任务分配来平衡负载。

6.请讨论一下TDSQL中的事务处理和并发控制。

回答:TDSQL支持分布式事务处理,通过协调者节点来保证事务的原子性、一致性、隔离性和持久性。

并发控制可以使用多版本并发控制(MVCC)来管理不同事务的访问。

7.如何确保TDSQL的查询结果的准确性和一致性?回答:TDSQL通过在分布式计算中引入数据同步和版本控制机制来确保查询结果的准确性和一致性。

每个节点在执行查询时,都会根据数据版本来保证结果的正确性。

8.请解释一下索引在TDSQL中的作用以及如何选择合适的索引。

回答:索引在TDSQL中用于加速查询,减少数据扫描的成本。

如何处理分布式数据库的并发冲突问题(系列三)

分布式数据库是当今大数据时代的重要组成部分,其能够将数据存储在不同的物理位置上,提供高可用性和可扩展性。

然而,与传统的中心化数据库相比,分布式数据库在面临并发读写操作时会引发一系列的冲突问题。

本文将探讨如何处理分布式数据库的并发冲突问题,以提供可靠且高性能的数据处理。

在分布式数据库中,多个节点同时执行读写操作可能导致数据在不同的节点上出现不一致的情况,这就是并发冲突。

为了解决这个问题,我们可以采用以下策略和技术。

第一,引入乐观并发控制(Optimistic Concurrency Control,OCC)机制。

这种机制采用了无锁的方式进行并发控制,首先在读取数据时对特定的数据项加上版本号,然后在写入数据时对数据项的版本号进行检查,如果版本号已经改变,则放弃当前的写入操作,否则执行写入。

这种机制能够提高分布式数据库的并发性能,减少了锁定操作所带来的额外开销。

第二,使用分布式事务管理器来处理并发冲突。

在分布式数据库系统中,事务的并发性是一个关键问题。

传统的ACID(原子性、一致性、隔离性和持久性)模型无法直接应用于分布式环境,因此需要引入分布式事务管理器来处理并发冲突。

通过分布式事务管理器的协调和控制,可以确保在不同节点上的事务能够正确地并发执行,避免数据不一致的问题。

第三,采用基于时间戳的并发控制机制。

时间戳是分布式数据库中用于标识事务提交的顺序的一种机制。

通过为每个事务分配一个唯一的时间戳,并在写入操作时对时间戳进行检查,可以确定事务提交的顺序,从而保证数据的一致性。

同时,时间戳机制还可以用于检测并发冲突,并采取相应的冲突处理策略,例如回滚或者等待。

第四,使用分布式锁机制来确保数据的一致性。

分布式锁是一种用于协调并发访问共享资源的机制,通过对数据项的读写操作进行加锁和释放锁来保证数据的一致性。

分布式锁可以在分布式环境中保证多个节点并发读写操作的顺序,避免并发冲突。

常见的分布式锁实现包括基于ZooKeeper和Redis的分布式锁。

sqlserver 2016 内存优化表用法

sqlserver 2016 内存优化表用法

SQL Server 2016引入了内存优化表(In-Memory OLTP),它是一种新的表类型,专门用于高性能内存处理。

内存优化表具有以下特点和用法:

1. 高性能:内存优化表存储在内存中,使用新的存储引擎,因此可以实现更快的数据访问速度和更高的并发性能。

2. 持久化:内存优化表提供了持久性选项,可以将数据保存在磁盘上,以防止服务器故障或重新启动时的数据丢失。

3. 非锁定访问:内存优化表使用乐观并发控制(Optimistic Concurrency Control)来避免锁定操作,从而提高并发性能。

4. 编程模型:内存优化表使用新的编程模型,包括内存优化表类型、存储过程和索引。

使用内存优化表的一般步骤如下:

1. 创建内存优化文件组:为了存储内存优化表,首先需要创建一个内存优化的文件组。

2. 创建内存优化表类型:类似于定义普通表的结构,首先需要定义内存优化表的表类型。

3. 创建内存优化表:使用已经定义的表类型创建具体的内存优

化表,可以定义索引和约束。

4. 迁移数据:将现有数据从普通表转移到内存优化表中,可以使用INSERT INTO SELECT语句或者存储过程完成。

5. 修改查询和存储过程:由于内存优化表使用新的存储引擎和编程模型,一些查询和存储过程可能需要进行修改。

6. 测试和性能优化:使用内存优化表之后,需要进行测试和性能优化,以确保获得预期的性能提升。

需要注意的是,内存优化表并不适合所有场景,其主要适用于对性能要求较高的事务处理和数据访问操作。

对于批量处理和大规模数据的分析查询,仍然可以使用传统的磁盘表。

乐观锁和悲观锁的区别

乐观锁和悲观锁的区别乐观锁在关系数据库管理系统⾥,乐观并发控制(⼜名”乐观锁”,Optimistic Concurrency Control,缩写”OCC”)是⼀种并发控制的⽅法。

它假设多⽤户并发的事务在处理时不会彼此互相影响,各事务能够在不产⽣锁的情况下处理各⾃影响的那部分数据。

在提交数据更新之前,每个事务会先检查在该事务读取数据后,有没有其他事务⼜修改了该数据。

如果其他事务有更新的话,正在提交的事务会进⾏回滚。

乐观事务控制最早是由孔祥重(H.T.Kung)教授提出。

乐观并发控制的阶段乐观并发控制的事务包括以下阶段:1. 读取:事务将数据读⼊缓存,这时系统会给事务分派⼀个时间戳。

2. 校验:事务执⾏完毕后,进⾏提交。

这时同步校验所有事务,如果事务所读取的数据在读取之后⼜被其他事务修改,则产⽣冲突,事务被中断回滚。

3. 写⼊:通过校验阶段后,将更新的数据写⼊数据库。

乐观并发控制多数⽤于数据争⽤不⼤、冲突较少的环境中,这种环境中,偶尔回滚事务的成本会低于读取数据时锁定数据的成本,因此可以获得⽐其他并发控制⽅法更⾼的吞吐量。

相对于悲观锁,在对数据库进⾏处理的时候,乐观锁并不会使⽤数据库提供的锁机制。

⼀般的实现乐观锁的⽅式就是记录数据版本。

数据版本,为数据增加的⼀个版本标识。

当读取数据时,将版本标识的值⼀同读出,数据每更新⼀次,同时对版本标识进⾏更新。

当我们提交更新的时候,判断数据库表对应记录的当前版本信息与第⼀次取出来的版本标识进⾏⽐对,如果数据库表当前版本号与第⼀次取出来的版本标识值相等,则予以更新,否则认为是过期数据。

实现数据版本有两种⽅式,第⼀种是使⽤版本号,第⼆种是使⽤时间戳。

使⽤版本号实现乐观锁使⽤版本号时,可以在数据初始化时指定⼀个版本号,每次对数据的更新操作都对版本号执⾏+1操作。

并判断当前版本号是不是该数据的最新的版本号。

使⽤版本号实现乐观锁使⽤版本号时,可以在数据初始化时指定⼀个版本号,每次对数据的更新操作都对版本号执⾏+1操作。

数据库事务处理中的读写冲突解决方法

数据库事务处理中的读写冲突解决方法在数据库管理系统中,事务是一组数据库操作的逻辑单元。

事务处理中,读写冲突是一个常见的问题,可能导致数据的不一致性和并发性能的降低。

为了解决这个问题,数据库系统采用了多种技术和策略。

本文将介绍一些常用的方法来解决数据库事务处理中的读写冲突。

1. 读写锁机制(Locking Mechanism)读写锁是一种用于控制对共享资源(如数据库记录)访问的机制。

在读写锁机制中,写操作互斥,即一个事务正在写入数据时,其他事务无法读写该数据;而读操作则允许并发,多个事务可以同时读取数据。

得益于读操作的并发性,读写锁机制一定程度上提高了系统的性能和并发性。

然而,这种机制也会带来死锁的风险,因此需要谨慎使用和管理。

2. 乐观并发控制(Optimistic Concurrency Control)乐观并发控制是一种处理读写冲突的方法,它基于一种乐观的假设,即并发事务之间很少会产生冲突。

在乐观并发控制中,事务在提交之前不会显式地锁定资源,而是在提交时进行冲突检测。

若发现冲突,事务将被回滚并重新执行。

乐观并发控制的优点是避免了大量显式锁对系统性能的影响,但它要求系统需要一定程度的冲突检测和重试机制来保证数据的一致性。

3. 悲观并发控制(Pessimistic Concurrency Control)与乐观并发控制相反,悲观并发控制是一种较保守的方法。

在悲观并发控制中,事务在读写数据之前会显式地锁定资源,直到事务完成操作才会释放锁。

这样其他事务在该数据上的读写操作将被阻塞,从而保证了数据的一致性。

悲观并发控制的缺点是阻塞其他事务的读写操作,降低了系统的并发性能。

4. 乐观锁(Optimistic Locking)乐观锁是基于乐观并发控制思想的一种具体实现方法。

它通过给数据添加一个版本号(或时间戳)来解决读写冲突。

在读操作时,如果事务发现版本号与自己记录的版本号不一致,说明数据被其他事务更新过,此时事务需要重新执行;而在写操作时,事务将会更新版本号。

事务处理中的读取一致性问题及解决方案

事务处理中的读取一致性问题及解决方案引言在日常生活中,我们经常遇到需要处理各种事务的场景,如购物、银行转账等。

而在这些事务处理过程中,数据的读取一致性问题是一项重要而又复杂的挑战。

本文将探讨事务处理中的读取一致性问题,并介绍解决方案。

一、读取一致性问题的定义与影响读取一致性是指当多个并发读操作同时发生时,用户获取到的数据应该是一致的。

然而,由于不同事务的执行顺序、并发度以及网络延迟等因素的影响,可能导致读取操作获取到的数据出现不一致性,进而造成数据的错误操作和不一致性。

读取一致性问题的产生主要有以下几个方面的影响:1. 数据冲突:当多个事务并发读取某一数据时,如果其中某个事务已经对该数据进行了修改,其他并发事务可能会读取到被修改之前的数据,从而导致数据的不一致。

2. 并发调度:多个事务并发执行时,可能存在不同的调度序列,从而导致读取操作的执行顺序与预期不符,进而导致数据的不一致。

3. 网络延迟:由于网络传输的延迟无法完全消除,当多个事务在不同的节点上执行时,数据的读取会受到网络延迟的影响,导致读取操作的结果不一致。

二、解决方案为了解决事务处理中的读取一致性问题,人们提出了一系列的解决方案,下面将分别介绍几种常用的解决方案。

1. 串行化串行化是最简单且最保守的解决方案。

该方案采用串行的方式执行事务,即每个事务依次执行,确保读取操作的一致性。

然而,串行化的弊端在于性能较低,不能充分利用多核处理器的并行计算能力。

2. 乐观并发控制(Optimistic Concurrency Control)乐观并发控制是一种乐观的并发控制策略,它假设事务之间的冲突很少发生。

在乐观并发控制中,读取操作会获得一个读取时的版本标记,而非直接对数据进行加锁。

在提交事务时,会检查该事务期间是否有其他事务修改了读取的数据,如果有,则回滚该事务并重新执行。

3. 悲观并发控制(Pessimistic Concurrency Control)悲观并发控制是一种悲观的并发控制策略,它假设事务之间的冲突会频繁发生。

数据库性能与并发控制的测试与评估方法

数据库性能与并发控制的测试与评估方法概述:数据库是现代信息系统中必不可少的组成部分,负责存储和管理大量的结构化数据。

随着用户数量和数据量的增加,数据库的性能和并发控制成为一个非常重要的问题。

本文将介绍数据库性能和并发控制的测试与评估方法,以帮助开发人员优化数据库系统的性能和并发能力。

一、数据库性能测试方法:1.负载测试:负载测试是一种评估数据库性能的方法,通过模拟实际运行环境中的并发用户访问数据库来测量数据库的性能。

负载测试可以通过增加并发访问用户数、请求的处理速度或者增加数据量来模拟高负载环境下的数据库性能。

2.基准测试:基准测试是一种对数据库系统进行基本性能测试的方法,通过运行一系列的标准测试用例来衡量数据库的性能。

基准测试的目标是确定数据库在正常工作负载下的性能表现,并记录下性能指标,以供后续测试和优化使用。

3.压力测试:压力测试是一种通过对数据库系统施加高负载的方法,来测试数据库在极限负载情况下的性能。

压力测试可以通过增加并发用户数、请求的处理速度或者增大数据量来模拟高负载场景,并检查系统的响应时间和稳定性。

二、数据库并发控制的评估方法:1.事务测试:事务是数据库中用于保持数据一致和完整性的机制,事务测试可以评估数据库在并发访问下事务的正确性和性能表现。

事务测试可以模拟并发事务的执行,观察并记录事务的执行结果、吞吐量和响应时间,以评估数据库的并发控制能力。

2.锁竞争测试:锁竞争是数据库并发控制中常见的问题之一,通过模拟并发访问下的锁竞争情况,可以评估数据库在高并发访问下锁竞争的表现,并检查数据库的死锁情况。

通过观察竞争锁的数量、持有锁的时间和死锁的发生频率,可以评估数据库的并发控制策略和性能。

3.并发控制算法测试:并发控制算法是数据库中用于解决并发访问冲突的关键技术,通过模拟不同的并发控制算法,可以评估数据库在不同并发控制策略下的表现。

通过观察并记录事务的提交时间、并发控制冲突的解决率和性能指标,可以评估不同并发控制算法的优劣。

浅谈数据库并发控制-锁和MVCC

浅谈数据库并发控制-锁和MVCC在学习⼏年编程之后,你会发现所有的问题都没有简单、快捷的解决⽅案,很多问题都需要权衡和妥协,⽽本⽂介绍的就是数据库在并发性能和可串⾏化之间做的权衡和妥协 -并发控制机制。

如果数据库中的所有事务都是串⾏执⾏的,那么它⾮常容易成为整个应⽤的性能瓶颈,虽然说没法⽔平扩展的节点在最后都会成为瓶颈,但是串⾏执⾏事务的数据库会加速这⼀过程;⽽并发(Concurrency)使⼀切事情的发⽣都有了可能,它能够解决⼀定的性能问题,但是它会带来更多诡异的错误。

引⼊了并发事务之后,如果不对事务的执⾏进⾏控制就会出现各种各样的问题,你可能没有享受到并发带来的性能提升就已经被各种奇怪的问题折磨的欲仙欲死了。

概述如何控制并发是数据库领域中⾮常重要的问题之⼀,不过到今天为⽌事务并发的控制已经有了很多成熟的解决⽅案,⽽这些⽅案的原理就是这篇⽂章想要介绍的内容,⽂章中会介绍最为常见的三种并发控制机制:分别是悲观并发控制、乐观并发控制和多版本并发控制,其中悲观并发控制其实是最常见的并发控制机制,也就是锁;⽽乐观并发控制其实也有另⼀个名字:乐观锁,乐观锁其实并不是⼀种真实存在的锁,我们会在⽂章后⾯的部分中具体介绍;最后就是多版本并发控制(MVCC)了,与前两者对⽴的命名不同,MVCC 可以与前两者中的任意⼀种机制结合使⽤,以提⾼数据库的读性能。

既然这篇⽂章介绍了不同的并发控制机制,那么⼀定会涉及到不同事务的并发,我们会通过⽰意图的⽅式分析各种机制是如何⼯作的。

悲观并发控制控制不同的事务对同⼀份数据的获取是保证数据库的⼀致性的最根本⽅法,如果我们能够让事务在同⼀时间对同⼀资源有着独占的能⼒,那么就可以保证操作同⼀资源的不同事务不会相互影响。

最简单的、应⽤最⼴的⽅法就是使⽤锁来解决,当事务需要对资源进⾏操作时需要先获得资源对应的锁,保证其他事务不会访问该资源后,在对资源进⾏各种操作;在悲观并发控制中,数据库程序对于数据被修改持悲观的态度,在数据处理的过程中都会被锁定,以此来解决竞争的问题。

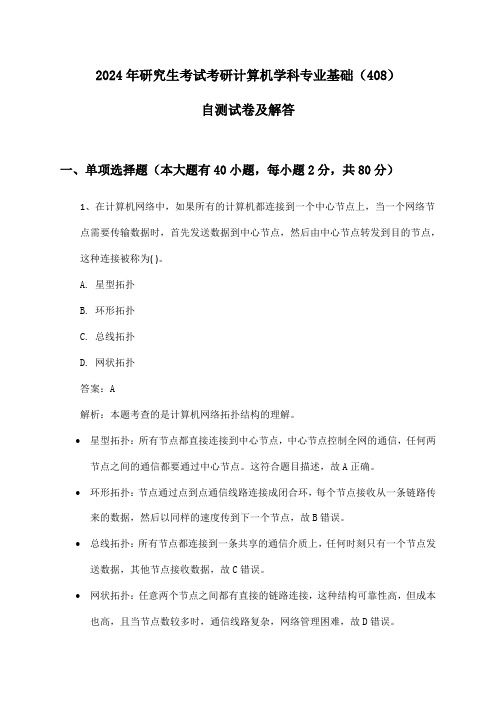

研究生考试考研计算机学科专业基础(408)2024年自测试卷及解答

2024年研究生考试考研计算机学科专业基础(408)自测试卷及解答一、单项选择题(本大题有40小题,每小题2分,共80分)1、在计算机网络中,如果所有的计算机都连接到一个中心节点上,当一个网络节点需要传输数据时,首先发送数据到中心节点,然后由中心节点转发到目的节点,这种连接被称为( )。

A. 星型拓扑B. 环形拓扑C. 总线拓扑D. 网状拓扑答案:A解析:本题考查的是计算机网络拓扑结构的理解。

•星型拓扑:所有节点都直接连接到中心节点,中心节点控制全网的通信,任何两节点之间的通信都要通过中心节点。

这符合题目描述,故A正确。

•环形拓扑:节点通过点到点通信线路连接成闭合环,每个节点接收从一条链路传来的数据,然后以同样的速度传到下一个节点,故B错误。

•总线拓扑:所有节点都连接到一条共享的通信介质上,任何时刻只有一个节点发送数据,其他节点接收数据,故C错误。

•网状拓扑:任意两个节点之间都有直接的链路连接,这种结构可靠性高,但成本也高,且当节点数较多时,通信线路复杂,网络管理困难,故D错误。

2、在操作系统的进程管理中,如果系统中有n个进程,则进程间可能出现的状态转换总数为( )。

(不考虑进程的终止状态)A. n(n-1)B. n^2C. 2n(n-1)D. n(n-1)/2答案:C解析:本题考查的是进程状态转换的理解。

在操作系统中,进程的状态转换主要包括以下几种:•就绪状态→ 运行状态•运行状态→ 就绪状态•运行状态→ 阻塞状态•阻塞状态→ 就绪状态对于n个进程,每个进程都可以从就绪状态转变为运行状态,也可以从运行状态转变为就绪状态或阻塞状态,反之亦然。

但是,由于进程间的状态转换是单向的(例如,一个进程不能直接从一个阻塞状态转移到另一个进程的阻塞状态),我们需要考虑的是每个进程与其他进程之间可能的状态转换。

对于每个进程,它都可以与剩下的n-1个进程进行状态转换(不考虑自身),且每个进程都有4种可能的状态转换(上述列出的四种)。

多线程更新mongodb一条记录

多线程更新mongodb一条记录多线程是一种并发编程的技术,它允许多个线程同时执行不同的任务,从而提高程序的执行效率。

在现代的应用程序中,数据库操作是非常常见的任务之一,而MongoDB作为一种高性能、可扩展的NoSQL 数据库,其更新操作在多线程环境下可能会面临一些问题。

在多线程环境下,同时进行数据库更新操作可能会导致数据不一致的问题。

为了解决这个问题,MongoDB提供了一种叫做乐观并发控制(Optimistic Concurrency Control,简称OCC)的机制。

OCC机制通过在记录中增加一个版本号字段来解决并发更新问题。

每次更新操作都会对当前记录的版本号进行检查,如果版本号匹配,则执行更新操作,否则认为该记录已经被其他线程修改过,更新操作将失败。

在多线程更新MongoDB记录时,需要考虑以下几个方面:1.数据一致性:因为多线程同时进行更新操作,可能会导致数据不一致的问题。

为了保证数据的一致性,可以使用乐观并发控制机制来避免多线程同时更新同一条记录。

2.并发性能:多线程并发更新能够提高程序的执行效率,但是如果线程数量过多,可能会导致数据库负载过大。

为了提高并发性能,可以使用连接池来管理数据库连接,从而减少连接的创建和销毁的开销。

3.锁竞争:多线程同时更新同一条记录时,可能会导致锁竞争的问题。

MongoDB使用乐观并发控制机制来避免锁竞争,但是如果线程数量过多,还是可能会导致锁竞争的问题。

为了减少锁竞争,可以使用分布式锁机制来控制对数据库记录的访问。

4.异常处理:在多线程更新数据库记录时,可能会发生一些意外情况,比如网络中断、数据库连接异常等。

为了避免这些异常对程序的影响,需要正确处理异常,保证程序的稳定运行。

为了更好地理解多线程更新MongoDB记录的过程,我们来看一个简单的示例:假设有一个用户表,包含了用户的姓名、年龄和邮箱等信息。

我们想要通过多线程的方式更新其中一条记录的邮箱信息。

事务并发一致性实现机制解析

事务并发一致性实现机制解析事务并发一致性是指在多个并发执行的事务中,保证数据的一致性。

在并发环境下,多个事务可能同时读取和修改相同的数据,如果不加以控制,就会出现数据不一致的问题。

因此,设计一种有效的事务并发一致性实现机制是非常重要的。

一、悲观并发控制(Pessimistic Concurrency Control)悲观并发控制是一种保守的并发控制方法,它假设事务间会产生冲突,并在事务执行之前通过加锁机制来确保并发操作的正确性。

常见的悲观并发控制实现机制包括:共享锁(Shared Lock)和排他锁(Exclusive Lock)。

共享锁允许多个事务同时读取同一份数据,而排他锁则需要独占某个数据项,其他事务无法同时读取或修改该数据项。

通过这样的锁机制,可以保证并发事务的读写操作不会相互干扰,从而保证数据的一致性。

然而,悲观并发控制在实际应用中存在一些问题。

首先,加锁会引入额外的开销,降低系统的性能。

其次,悲观并发控制无法避免所有的冲突,当多个事务同时等待获取锁时,可能会发生死锁。

二、乐观并发控制(Optimistic Concurrency Control)乐观并发控制是一种相对进取的并发控制方法,它假设事务间不会产生冲突,并在事务提交时进行冲突检测来确保数据的一致性。

常见的乐观并发控制实现机制包括:版本控制(Version Control)和时间戳控制(Timestamp Control)。

版本控制通过给数据项增加一个版本号来实现并发控制。

当事务读取到数据项时,会记录下当前版本号,并在提交时检测这个版本号是否发生变化。

如果变化了,则说明该数据项被其他事务修改过,当前事务需要进行回滚。

时间戳控制则是为每个事务分配一个唯一的时间戳,并为每个数据项维护一个读写时间戳。

当事务读取或修改数据项时,会记录下对应的时间戳。

在提交时,系统会比较每个数据项的时间戳,如果发现有其他事务在该数据项上有更新,则当前事务需要进行回滚。

可串行化调度的概念和方法

可串行化调度的概念和方法可串行化调度(serializability scheduling)是在并发控制中,对多个事务进行调度以保证事务之间的隔离性和一致性的重要概念之一。

在数据库系统中,每个事务都是由一组原子操作构成的,这些原子操作可以称为事务的“子操作”。

调度是在一定时间内,将多个事务的子操作交错执行的过程。

在实际应用中,由于事务之间的竞争和资源限制,可能会出现多个事务被阻塞或者出现死锁的情况。

此时就需要对事务进行调度,以保证各个事务之间的原子性、一致性和隔离性。

可串行化调度就是一种保证事务串行执行的调度方式。

要实现可串行化调度,需要根据不同的事务之间的互斥关系,将其转化为一个可调度图。

可调度图是一个有向图,其中每个节点是一个事务的子操作,每个边表示两个子操作之间的互斥关系。

如果可调度图是一个 DAG(有向无环图),则说明可串行化调度是可以实现的。

否则,需要通过增加锁或者放弃一些并发性来保证可调度性。

实现可串行化调度有以下几种方法:1. 两阶段锁协议(Two-Phase Locking Protocol):该协议将事务分为两个阶段:加锁阶段和解锁阶段。

加锁阶段需要先获取所有需要的锁,然后才能继续执行,解锁阶段则是释放所有持有的锁。

2. 时间戳协议(Timestamp Order Protocol):该协议将每个事务赋予一个时间戳,表示该事务的提交时间。

执行时,先根据时间戳对每个事务的子操作进行排序,然后按照排序后的顺序逐个执行。

如果发现有事务需要等待,就需要将其阻塞。

3. 乐观并发控制协议(Optimistic Concurrency Control Protocol):该协议假设事务之间不会发生冲突,先执行完所有操作,等到提交时再检查是否冲突,如果有冲突则进行回滚。

这种协议适用于读多写少的情况。

4. 多版本并发控制协议(Multiversion Concurrency Control Protocol):该协议为每个事务创建一个版本号,对于读操作,读取最新的可见版本,对于写操作,则将修改写入新版本并将事务指向新版本。

事务处理中的数据冲突与事务冲突解决(四)

事务处理中的数据冲突与事务冲突解决在现代的信息化社会中,数据的处理成为一项重要的工作。

而随着数据的量增加和复杂性的提高,事务冲突也随之增多。

事务冲突是指多个事务在对同一数据进行操作时,因为操作的同时性而引发的数据状态冲突问题。

本文将探讨事务处理中的数据冲突以及常见的解决方法。

首先,我们需要理解事务的概念。

事务是指对数据库进行读写操作的一组操作序列,它具有原子性、一致性、隔离性和持久性四个特性。

原子性指一个事务中的所有操作要么全部完成,要么全部不完成;一致性指事务在执行前后数据库的完整性约束不能被破坏;隔离性指多个事务并发执行时,每个事务的操作都不应该对其他事务可见;持久性指事务一旦提交,对数据库的修改就是永久性的。

当多个事务同时对同一个数据进行读写操作时,可能会产生数据冲突。

例如,一个事务要修改某个数据项,而另一个事务也要修改同一个数据项。

如果两个事务同时执行,则会造成数据的不一致。

为了解决这个问题,我们需要一些机制来使事务能够并发执行,同时保证数据的一致性。

一种常见的解决方法是使用锁机制。

锁机制可以分为共享锁和排他锁。

共享锁允许多个事务同时对同一个数据项进行读操作,但不允许写操作;排他锁则只允许一个事务对数据项进行写操作。

通过对数据项加锁,可以防止多个事务同时对数据进行修改,从而避免了数据冲突的问题。

然而,锁机制也会引入一些问题,比如死锁的发生。

当多个事务之间形成循环等待锁资源时,就会发生死锁,导致系统无法继续运行。

除了锁机制,还有一种解决方法是使用并发控制算法,如MVCC (Multi-Version Concurrency Control)算法。

MVCC算法通过为每个数据项维护多个版本,不同的事务可以同时读写不同的版本,从而提高了并发性能。

通过版本控制,可以避免多个事务同时对同一个数据进行修改,从而解决了事务冲突的问题。

但MVCC算法也会引入一些额外的存储开销,因为需要为每个数据项维护多个版本。

高性能分布式文件系统的数据一致性与冲突解决

高性能分布式文件系统的数据一致性与冲突解决在现代大规模计算环境中,分布式文件系统起着重要的作用。

在分布式系统中,数据一致性和冲突解决是关键问题,它们直接关系到系统的可靠性和性能。

本文将探讨高性能分布式文件系统中数据一致性的挑战以及冲突解决的方法。

一、数据一致性的挑战在分布式系统中,数据的一致性指的是多个副本之间数据是否保持相同的特性。

由于分布式系统中的多个节点相互独立且可能并发地进行读写操作,数据的一致性变得更加复杂。

以下是数据一致性所面临的主要挑战:1. 并发读写操作:多个节点同时对文件进行读写操作,可能导致不一致的数据状态。

例如,当两个节点同时向同一文件写入不同的数据时,如何保证最终的数据一致性成为了难题。

2. 数据副本的同步:在分布式系统中,为了提高可靠性和性能,数据通常会在多个节点上进行复制。

但是,当副本之间发生不一致时,如何进行同步以保证数据的一致性是一个需要解决的问题。

3. 故障处理:分布式系统中节点故障是常见的情况,当出现节点故障时,如何确保数据的一致性成为一项重要任务。

例如,在进行数据修复时,如何避免数据冲突和数据不一致等问题。

二、冲突解决的方法为了解决数据一致性的挑战,分布式文件系统采用了多种冲突解决的方法。

下面将介绍一些常见的方法:1. 乐观并发控制(Optimistic Concurrency Control,OCC):该方法认为冲突很少发生,因此允许并发读写操作,只在提交时进行数据一致性检查。

如果检查到冲突,则需要回滚事务并重试。

OCC适用于读操作较多的应用场景,因为读操作之间的冲突较少。

2. 悲观并发控制(Pessimistic Concurrency Control,PCC):与OCC相反,PCC认为冲突经常发生。

该方法在进行读写操作之前会对数据进行加锁,以确保数据的一致性。

然而,由于加锁会引入额外的开销,因此PCC会降低系统的性能和吞吐量。

3. 三阶段提交(Three-Phase Commit,3PC):3PC是一种经典的冲突解决协议,在分布式系统中被广泛使用。

如何处理数据库技术中的数据一致性问题(二)

数据一致性是在数据库技术中一个非常重要的问题,它关乎着数据的准确性和可靠性。

在大规模的数据存储和处理中,数据一致性问题常常出现,给系统的可靠性带来威胁。

本文将从不同角度探讨如何处理数据库技术中的数据一致性问题。

一、概述数据一致性是指在多个副本或节点上存储的数据保持相同的状态。

在一个分布式系统中,由于网络延迟、节点故障和并发操作等原因,数据在不同节点上可能出现不一致的情况。

解决数据一致性问题是数据库系统设计和实现的基础任务之一。

二、强一致性与弱一致性在处理数据一致性问题时,我们常常会遇到两种不同的一致性要求,即强一致性和弱一致性。

强一致性要求在任何时刻,所有副本或节点上的数据必须保持一致。

而弱一致性则允许在一段时间内数据不一致,但最终会达到一致的状态。

三、冲突处理与版本控制在分布式系统中,由于并发操作的存在,数据冲突是一个常见的问题。

当多个节点同时对同一数据进行操作时,可能会导致数据的不一致。

为了解决这个问题,可以采用冲突处理和版本控制的技术。

冲突处理的策略有很多种,比如乐观并发控制(Optimistic Concurrency Control)和悲观并发控制(Pessimistic Concurrency Control)。

乐观并发控制假设冲突发生的概率很低,允许多个节点同时操作数据,并在最后检测冲突并解决。

悲观并发控制则认为冲突发生的概率较高,会对数据进行锁定,保证同一时间只有一个节点可以对数据进行修改。

版本控制是一种常用的解决数据一致性的方法。

每当数据发生修改时,系统会为数据生成一个新的版本,并将历史版本保留下来。

当多个节点同时对数据进行修改时,系统会根据版本号来决定数据的更新顺序,保证数据一致性。

四、分布式事务在分布式系统中,处理事务一致性是一个复杂的问题。

当一个事务需要访问多个节点时,需要保证事务的一致性,即所有节点要么都成功执行事务,要么都不执行。

为了解决这个问题,可以采用分布式事务的技术。

optimistic例句

optimistic例句【释义】optimisticadj.乐观的,乐观主义的;(估计)过于乐观的,高估的【短语】1Optimistic concurrency control乐观并发控制;并发控制2Not optimistic不容乐观3optimistic concurrency开放式并发;乐观并行;线性最佳化;乐观并发控制4Optimistic Locking乐观锁;乐观锁定;开放式5Optimistic Lock乐观锁6Optimistic Time最乐观时间7Optimistic atmosphere美好的盼望;美妙的期望8be optimistic保持乐观的心态;乐天派;要乐观;乐观9Optimistic Striver乐观奔命者【例句】1He has an optimistic view of life.他乐观地看待人生。

2She felt light-hearted and optimistic.她感到无忧无虑,很乐观。

3The timetable was hopelessly optimistic.这个时间表过于乐观。

4We think you are being overly optimistic.我们认为你过于乐观了。

5My own reading of events is less optimistic.我本人对事态的看法不那么乐观。

6She's not very optimistic about the outcome of the talks.她对会谈的结果不太乐观。

7You will feel more buoyant and optimistic about the future than you have for a long time.对于未来,你会比很久以来所感受到的更加快活、乐观。

8When asked about the company's future,the director responded that he remained optimistic.问到公司的未来的时候,经理回答说他依然乐观。

Hive事务与ACID支持指南

Hive事务与ACID支持指南Hive是一个在Hadoop上构建的数据仓库基础设施,用于处理大规模的数据集。

在处理大数据时,保证数据的一致性和可靠性是非常重要的。

本文将重点介绍Hive事务的概念和ACID(原子性、一致性、隔离性和持久性)支持,并提供指南来帮助读者正确地使用Hive事务和ACID支持。

事务是指一组数据库操作的逻辑单元,这些操作要么全部成功执行,要么都不执行。

事务具有四个关键属性,即原子性、一致性、隔离性和持久性。

Hive从版本0.14开始引入了原生事务支持,使得用户可以在Hive中执行事务操作。

首先,让我们来了解一下Hive中事务的原子性支持。

原子性是指事务中的所有操作要么全部成功提交,要么全部回滚。

Hive使用了写前日志(Write Ahead Log, WAL)来实现原子性支持。

当用户执行一个事务时,所有事务相关的操作将会被写入WAL,以便在事务失败时进行回滚。

如果事务成功提交,相应的数据变更将永久写入磁盘。

其次,我们来看一下Hive中事务的一致性支持。

一致性是指事务在执行前后,数据库中的数据应该保持一致性状态。

Hive使用了乐观并发控制(Optimistic Concurrency Control, OCC)来保证一致性。

具体而言,Hive在事务提交之前会对数据进行预检查,以确保事务中的操作不会导致数据的冲突和破坏数据的一致性。

隔离性是指事务在并发执行时,执行结果与串行执行时的结果应该一致。

Hive默认使用了可重复读(Repeatable Read)级别的隔离性。

这意味着当一个事务正在访问某一数据时,其他事务无法修改这个数据。

这种隔离级别可以有效地解决并发访问数据可能导致的问题。

最后,持久性是指一旦事务成功提交,相应的数据变更应该永久写入磁盘并能够可靠地恢复。

Hive使用了Apache Hadoop的HDFS来存储数据,保障了数据的持久性和可靠性。

要正确使用Hive事务和ACID支持,以下的指南可以帮助您:1. 检查Hive版本:确保您正在使用的Hive版本是0.14及以上的版本,因为原生事务支持是从该版本开始引入的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

a significant number of index’s data items must be updated. Moreover, in applications based on natural language text it is expected that a fairly small subset of the index’s data items are the ones that are most referenced (those related to the most popular words of the particular language).

Optimistic Concurrency Control for Inverted Files in Text Databases

Mauricio Mar´ın ∗ Computing Department, University of Magallanes, Chile

ABSTRACT

Inverted files are frequently used as index data structures for very large text databases. Most applications of this data structure are for read-only query operations. However, the problem of introducing update operations has deserved little attention so far and yet it has important applications. In this paper we propose an optimistic concurrency control algorithm devised to handle mixes of update operations and read-only queries efficiently. We work on top of the BSP model of parallel computing and take advantage of a BSP Time Warp realization to formulate the proposed algorithm. We present a comparison with the traditional lock-based approach and the results show that optimism is particularly efficient in this case.

We compare an optimistic event-synchronization protocol used in both application domains with the twophases lock protocol which is commonly used in relational database management systems. We have adapted those protocols to the text database context. This is a quite extreme case since every time a document is added/removed

are solved by using an index data structure distributed on the P processors. We assume that the index is implemented using an inverted file which, as described in the next section, is composed of a vocabulary (set of terms) and a set of identifiers (inverted list) representing all the documents that contain at least one of the words that are members of the vocabulary. The inverted file data structure enables the efficient retrieval of all identifiers for which a given term appears in the respective documents.

Clients request service to one or more broker machines, which in turn distribute them evenly onto the P machines implementing the server. Requests are queries that

The bulk-synchronous parallel (BSP) model of computing [9, 14, 13, 12] has been proposed to enable the development of portable and cost-predictable software which achieves scalable performance across diverse parallel architectures. BSP is a distributed memory model with a well-defined structure that enables the prediction of running time. Unlike traditional models of parallel computing, the BSP model ensures portability at the very fundamental level by allowing algorithm design to be effected in a manner that is independent of the architecture of the parallel computer. Shared and distributed memory parallel computers are programmed in the same way as they are considered emulators of the more general bulk-synchronous parallel machine.

2. BSP server

We assume a server operating upon a set of P identical machines, each containing its own main and secondary memory. We treat secondary memory like the communication network. That is, we include an additional parameter D to represent the average cost of accessing the secondary memory. Its value can be easily determined by benchmark programs available on Unix systems. The textual database is evenly distributed over the P machines. If the whole database index is expected to fit on the P sized main memory, we just assume D = 1.

Keywords: Information Retrieval, Text Databases, Parallel Computing, Concurrency Control, BSP Computing, Synchronization Protocols.

1. Introduction

This paper is concerned with the synchronization of text database R/W query operations (transactions) running on a parallel distributed-memory environment which supports an architecture independent and cost predictable model of computation. The model of computation is the so-called bulk-synchronous parallel (BSP) model [14]. The text database is assumed to be distributed on P processors, and transactions are allowed to read/write data from/on any processor. Associated with the text database there is an “index” which is a data structure devised to speed-up the processing of queries. We use the classic inverted file [2] for this purpose. New text comes in the form of “documents” that are added to the database which also implies to update the index data structure. For the sake of simplicity we assume transactions composed of just one query operation be it a read-only or a write operation (actually this is most frequent type of transaction in text databases). Extension to two or more operations is straightforward.