图的遍历问题

图的遍历算法

1图的遍历问题在实践中常常遇到这样的问题:给定n个点,从任一点出发对所有的点访问一次并且只访问一次。

如果用图中的顶点表示这些点,图中的边表示可能的连接,那么这个问题就可以表示成图的遍历问题,即从某个顶点出发,沿着某条搜索路径对图中每个顶点各做一次且仅做一次访问。

图的遍历操作和树的遍历操作功能相似,是图的一种基本操作,图的许多其它操作都是建立在遍历操作的基础上。

由于图结构本身的复杂性,所以图的遍历操作也比较复杂,主要表现在以下几个方面:(1) 在图结构中,没有一个确定的首结点,图中任意一个顶点都可以作为第一个被访问的结点。

(2) 在非连通图中,从一个顶点出发,只能够访问它所在的连通分量上的所有顶点,因此,还需要考虑如何选取下一个出发点以访问图中其余的连通分量。

(3) 在图结构中,如果有回路存在,那么一个顶点被访问后,有可能沿回路又回到该顶点。

⑷在图结构中,一个顶点可以和其它多个顶点相连,当这样的顶点访问过后,存在如何选取下一个要访问的顶点的问题。

基于以上分析,图的遍历方法目前有深度优先搜索(DFS)和广度优先搜索(BFS)两种算法。

下面将介绍两种算法的实现思路,分析算法效率并编程实现。

1.1深度优先搜索算法深度优先搜索算法是树的先根遍历的推广,它的实现思想是:从图G的某个顶点V o出发,访问V o,然后选择一个与V o相邻且没被访问过的顶点V i访问,再从V i出发选择一个与V i相邻且未被访问的顶点V j进行访问,依次继续。

如果当前被访问过的顶点的所有邻接顶点都已被访问,贝U退回已被访问的顶点序列中最后一个拥有未被访问的相邻顶点的顶点W,从W出发按同样的方法向前遍历,直到图中所有顶点都被访问。

其递归算法如下:Boolean visited[MAX_VERTEX_NUM]; // 访问标志数组Status (*VisitFunc)(int v); //VisitFunc是访问函数,对图的每个顶点调用该函数void DFSTraverse (Graph G Status(*Visit)(i nt v)){VisitF unc = Visit;for(v=0; vvG.vex num; ++v)visited[v] = FALSE; //访问标志数组初始化for(v=0; v<G .vex num; ++v)if(!visited[v])DFS(G v); //对尚未访问的顶点调用DFS}void DFS(Graph G int v){ //从第v个顶点出发递归地深度优先遍历图Gvisited[v]=TRUE; VisitFunc(v); // 访问第v 个顶点for(w=FirstAdjVex(G ,v); w>=0;w=NextAdjVex(G ,v,w))//FirstAdjVex返回v的第一个邻接顶点,若顶点在G中没有邻接顶点,则返回空(0)。

数据结构实验报告图的遍历讲解

数据结构实验报告图的遍历讲解一、引言在数据结构实验中,图的遍历是一个重要的主题。

图是由顶点集合和边集合组成的一种数据结构,常用于描述网络、社交关系等复杂关系。

图的遍历是指按照一定的规则,挨次访问图中的所有顶点,以及与之相关联的边的过程。

本文将详细讲解图的遍历算法及其应用。

二、图的遍历算法1. 深度优先搜索(DFS)深度优先搜索是一种常用的图遍历算法,其基本思想是从一个顶点出发,沿着一条路径向来向下访问,直到无法继续为止,然后回溯到前一个顶点,再选择此外一条路径继续访问。

具体步骤如下:(1)选择一个起始顶点v,将其标记为已访问。

(2)从v出发,选择一个未被访问的邻接顶点w,将w标记为已访问,并将w入栈。

(3)如果不存在未被访问的邻接顶点,则出栈一个顶点,继续访问其它未被访问的邻接顶点。

(4)重复步骤(2)和(3),直到栈为空。

2. 广度优先搜索(BFS)广度优先搜索是另一种常用的图遍历算法,其基本思想是从一个顶点出发,挨次访问其所有邻接顶点,然后再挨次访问邻接顶点的邻接顶点,以此类推,直到访问完所有顶点。

具体步骤如下:(1)选择一个起始顶点v,将其标记为已访问,并将v入队。

(2)从队首取出一个顶点w,访问w的所有未被访问的邻接顶点,并将这些顶点标记为已访问,并将它们入队。

(3)重复步骤(2),直到队列为空。

三、图的遍历应用图的遍历算法在实际应用中有广泛的应用,下面介绍两个典型的应用场景。

1. 连通分量连通分量是指图中的一个子图,其中的任意两个顶点都是连通的,即存在一条路径可以从一个顶点到达另一个顶点。

图的遍历算法可以用来求解连通分量的个数及其具体的顶点集合。

具体步骤如下:(1)对图中的每一个顶点进行遍历,如果该顶点未被访问,则从该顶点开始进行深度优先搜索或者广度优先搜索,将访问到的顶点标记为已访问。

(2)重复步骤(1),直到所有顶点都被访问。

2. 最短路径最短路径是指图中两个顶点之间的最短路径,可以用图的遍历算法来求解。

图的遍历 实验报告

图的遍历实验报告一、引言图是一种非线性的数据结构,由一组节点(顶点)和节点之间的连线(边)组成。

图的遍历是指按照某种规则依次访问图中的每个节点,以便获取或处理节点中的信息。

图的遍历在计算机科学领域中有着广泛的应用,例如在社交网络中寻找关系紧密的人员,或者在地图中搜索最短路径等。

本实验旨在通过实际操作,掌握图的遍历算法。

在本实验中,我们将实现两种常见的图的遍历算法:深度优先搜索(DFS)和广度优先搜索(BFS),并比较它们的差异和适用场景。

二、实验目的1. 理解和掌握图的遍历算法的原理与实现;2. 比较深度优先搜索和广度优先搜索的差异;3. 掌握图的遍历算法在实际问题中的应用。

三、实验步骤实验材料1. 计算机;2. 编程环境(例如Python、Java等);3. 支持图操作的相关库(如NetworkX)。

实验流程1. 初始化图数据结构,创建节点和边;2. 实现深度优先搜索算法;3. 实现广度优先搜索算法;4. 比较两种算法的时间复杂度和空间复杂度;5. 比较两种算法的遍历顺序和适用场景;6. 在一个具体问题中应用图的遍历算法。

四、实验结果1. 深度优先搜索(DFS)深度优先搜索是一种通过探索图的深度来遍历节点的算法。

具体实现时,我们可以使用递归或栈来实现深度优先搜索。

算法的基本思想是从起始节点开始,选择一个相邻节点进行探索,直到达到最深的节点为止,然后返回上一个节点,再继续探索其他未被访问的节点。

2. 广度优先搜索(BFS)广度优先搜索是一种逐层遍历节点的算法。

具体实现时,我们可以使用队列来实现广度优先搜索。

算法的基本思想是从起始节点开始,依次遍历当前节点的所有相邻节点,并将这些相邻节点加入队列中,然后再依次遍历队列中的节点,直到队列为空。

3. 时间复杂度和空间复杂度深度优先搜索和广度优先搜索的时间复杂度和空间复杂度如下表所示:算法时间复杂度空间复杂度深度优先搜索O(V+E) O(V)广度优先搜索O(V+E) O(V)其中,V表示节点的数量,E表示边的数量。

图的遍历及生成树

• •邻接表的DFS算法

void DFS(ALGraph G, int v) { ArcNode *p;

visited[v] = 1; /*置已访问标记*/ printf("%d ", v); /*输出被访问顶点的编号*/ p = G.vertices[v].firstarc; /*p指向顶点v的第一个邻接点*/ while (p!=NULL) {

•v11

•v1,

•v2

•v3

•v2,

•v4,

•v5

•v8,

•v4

•v6

•v7

•v5,

•v3,

•v8

•v6,

•v7

•

•图的DFS算法一般描述

•int visited[MAXVEX]; //访问标志数组

•void DFSTraverse(Graph G)

•{ //对图G作深度优先遍历

• for( v=0; v<G.vexnum; ++v ) visited[v]=FALSE;

•} // DFS1

•G.arcs[v][j] =1

•有邻接点

•visited [n]=0

•未访问过

•

分析:

在遍历图时,对图中每个顶点至多调用一次DFS函数 ,因为一旦某个顶点被标志成已被访问,就不再从它出发 进行搜索。

因此,遍历图的过程实质上是对每个顶点查找其邻接 点的过程。其耗费的时间则取决于所采用的存储结构。 如果用邻接矩阵来表示图,遍历图中每一个顶点都要从 头扫描该顶点所在行,因此遍历全部顶点所需的时间为 O(n2)。 如果用邻接表来表示图,虽然有 2e 个表结点,但只需扫 描 e 个结点即可完成遍历,加上访问 n个头结点的时间, 因此遍历图的时间复杂度为O(n+e)。

《图的遍历》练习

写一个程序统计出共有多少颗珍珠肯定不会有中间重量。 【输入格式】

输入文件第 1 行包含两个用空格隔开的整数 N(1<=N<=99)和 M,且 N 为奇数,M 表示 对珍珠进行的比较次数,接下来的 M 行每行包含两个用空格隔开的整数 x 和 y,表示珍珠 x 比珍珠 y 重。 【输出格式】

输出文件仅一行,包含一个整数,表示不可能是中间重量的珍珠的总数 【样例输入】 54

《图的遍历》练习

【问题描述】

1、珍珠(bead)

有 n 颗形状和大小都一致的珍珠,它们的重量都不相同。n 为整数,所有的珍珠从 1 到 n 编号。你的任务是发现哪颗珍珠的重量刚好处于正中间。即在所有珍珠的重量重,该 珍珠的重量列(n+1)/2 位。下面给出将一对珍珠进行比较的办法:

给你一架天平用来比较珍珠的重量,我们可以比出两个珍珠哪个更重一些,在作出一 系列的比较后,我们可以将某些肯定不具备中间重量的珍珠拿走。

每一个栅栏连接两个顶点,顶点用 1 到 500 标号(虽然有的农场并没有 500 个顶点)。一 个顶点上可连接任意多(>=1)个栅栏。所有栅栏都是连通的(也就是你可以从任意一个栅栏到 达另外的所有栅栏)。

你的程序必须输出骑马的路径(用路上依次经过的顶点号码表示)。我们如果把输出的路 径看出是一个 500 进制的数,那么当存在多组解的情况下,输出 500 进制表示法中最小的一 个(也就是输出第一个数较小的,如果还有多组解,输出第二个数较小的...)。输入数据保证 至少有一个解。 【输入格式】

第 1 行:一个整数 F(1<=F<=1024),表示栅栏的数目。 第 2 到 F+1 行:每行两个整数 i,j(1<=i,j<=500),表示这条栅栏连接 i 与 j 号顶点。 【输出格式】 对于每组数据输出应当有 F+1 行,每行一个整数,依次表示路径经过的顶点号。注意数 据可能有多组解,但是只有上面题目要求的第一组解是认为正确的。 【样例输入】 9 12 23

图的遍历的实验报告

图的遍历的实验报告图的遍历的实验报告一、引言图是一种常见的数据结构,它由一组节点和连接这些节点的边组成。

图的遍历是指从图中的某个节点出发,按照一定的规则依次访问图中的所有节点。

图的遍历在许多实际问题中都有广泛的应用,例如社交网络分析、路线规划等。

本实验旨在通过实际操作,深入理解图的遍历算法的原理和应用。

二、实验目的1. 掌握图的遍历算法的基本原理;2. 实现图的深度优先搜索(DFS)和广度优先搜索(BFS)算法;3. 比较并分析DFS和BFS算法的时间复杂度和空间复杂度。

三、实验过程1. 实验环境本实验使用Python编程语言进行实验,使用了networkx库来构建和操作图。

2. 实验步骤(1)首先,我们使用networkx库创建一个包含10个节点的无向图,并添加边以建立节点之间的连接关系。

(2)接下来,我们实现深度优先搜索算法。

深度优先搜索从起始节点开始,依次访问与当前节点相邻的未访问过的节点,直到遍历完所有节点或无法继续访问为止。

(3)然后,我们实现广度优先搜索算法。

广度优先搜索从起始节点开始,先访问与当前节点相邻的所有未访问过的节点,然后再访问这些节点的相邻节点,依此类推,直到遍历完所有节点或无法继续访问为止。

(4)最后,我们比较并分析DFS和BFS算法的时间复杂度和空间复杂度。

四、实验结果经过实验,我们得到了如下结果:(1)DFS算法的时间复杂度为O(V+E),空间复杂度为O(V)。

(2)BFS算法的时间复杂度为O(V+E),空间复杂度为O(V)。

其中,V表示图中的节点数,E表示图中的边数。

五、实验分析通过对DFS和BFS算法的实验结果进行分析,我们可以得出以下结论:(1)DFS算法和BFS算法的时间复杂度都是线性的,与图中的节点数和边数呈正比关系。

(2)DFS算法和BFS算法的空间复杂度也都是线性的,与图中的节点数呈正比关系。

但是,DFS算法的空间复杂度比BFS算法小,因为DFS算法只需要保存当前路径上的节点,而BFS算法需要保存所有已访问过的节点。

图的遍历问题

HUNAN UNIVERSITY数据结构实验报告题目:图的遍历问题学生姓名梁天学生学号************专业班级计科1403指导老师夏艳日期2016.05.14背景网络蜘蛛即Web Spider,是一个很形象的名字。

把互联网比喻成一个蜘蛛网,那么Spider 就是在网上爬来爬去的蜘蛛。

网络蜘蛛是通过网页的链接地址来寻找网页,从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。

如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。

这样看来,网络蜘蛛就是一个爬行程序,一个抓取网页的程序。

在抓取网页的时候,网络蜘蛛一般有两种策略:广度优先和深度优先(如下面这张简单化的网页连接模型图所示,其中A为起点也就是蜘蛛索引的起点)。

深度优先顾名思义就是让网络蜘蛛尽量的在抓取网页时往网页更深层次的挖掘进去讲究的是深度!也泛指: 网络蜘蛛将会从起始页开始,一个链接一个链接跟踪下去,处理完这条线路之后再转入下一个起始页,继续跟踪链接! 则访问的节点顺序为==> A --> B --> E --> H --> I --> C --> D --> F --> K --> L --> G。

深度爬行的优点是:网络蜘蛛程序在设计的时候相对比较容易些;缺点是每次爬行一层总要向"蜘蛛老家" 数据库访问一下。

问问老总有必要还要爬下一层吗! 爬一层问一次.... 如果一个蜘蛛不管3721不断往下爬很可能迷路更有可能爬到国外的网站去,不仅增加了系统数据的复杂度更是增加的服务器的负担。

广度优先在这里的定义就是层爬行,即一层一层的爬行,按照层的分布与布局去索引处理与抓取网页。

则访问的节点顺序为==> A --> B --> C --> D --> E --> F --> G --> H --> I--> K --> L。

图的遍历算法实验报告

图的遍历算法实验报告图的遍历算法实验报告一、引言图是一种常用的数据结构,用于描述事物之间的关系。

在计算机科学中,图的遍历是一种重要的算法,用于查找和访问图中的所有节点。

本实验旨在探究图的遍历算法,并通过实验验证其正确性和效率。

二、实验目的1. 理解图的基本概念和遍历算法的原理;2. 实现图的遍历算法,并验证其正确性;3. 比较不同遍历算法的效率。

三、实验方法1. 实验环境:使用Python编程语言进行实验;2. 实验步骤:a. 构建图的数据结构,包括节点和边的定义;b. 实现深度优先搜索(DFS)算法;c. 实现广度优先搜索(BFS)算法;d. 验证算法的正确性,通过给定的图进行遍历;e. 比较DFS和BFS的效率,记录运行时间。

四、实验结果1. 图的构建:我们选择了一个简单的无向图作为实验对象,包含6个节点和7条边。

通过邻接矩阵表示图的关系。

```0 1 1 0 0 01 0 1 1 0 01 1 0 0 1 10 1 0 0 0 00 0 1 0 0 00 0 1 0 0 0```2. DFS遍历结果:从节点0开始,遍历结果为0-1-2-4-5-3。

3. BFS遍历结果:从节点0开始,遍历结果为0-1-2-3-4-5。

4. 算法效率比较:我们记录了DFS和BFS算法的运行时间。

经实验发现,在这个图的规模下,DFS算法的运行时间为0.001秒,BFS算法的运行时间为0.002秒。

可以看出,DFS算法相对于BFS算法具有更高的效率。

五、讨论与分析1. 图的遍历算法能够帮助我们了解图中的节点之间的关系,有助于分析和解决实际问题。

2. DFS算法和BFS算法都可以实现图的遍历,但其遍历顺序和效率有所不同。

DFS算法会优先访问深度较大的节点,而BFS算法会优先访问离起始节点最近的节点。

3. 在实验中,我们发现DFS算法相对于BFS算法具有更高的效率。

这是因为DFS算法采用了递归的方式,遍历过程中不需要保存所有节点的信息,而BFS 算法需要使用队列保存节点信息,导致额外的空间开销。

图的两种遍历

输入:

9 10 12 13 17 28 27 34 45 47 56 ram xy; var map:array[1..20,1..20] of integer; visited,q:array[1..100] of integer; //使用辅助队列Q和访问标志数组visited。 n,m,a,b,h,r,i,j:integer; procedure bfs(); //按广度优先非递归遍历图,n个顶点,编号为1..n。 var tmp:integer; begin while h<=r do begin tmp:=q[h]; //队头元素出队并置为tmp h:=h+1; write(tmp,' '); for j:=1 to n do if (map[tmp][j]=1) and (visited[j]=0) then //j为tmp的尚未访问的邻接顶点 begin visited[j]:=1;r:=r+1;q[r]:=j; end;//j入队列 end; end;

保证图中所有 顶点被访问

三、广(宽)度优先遍历

宽度优先遍历的基本思想为:

从图中某个顶点v0出发,访问此顶点。然后依次访问v0的 各个未被访问过的邻接结点,然后分别从这些邻接结点出发 宽度优先遍历图,直到图中所有和顶点v0连通的顶点都被访 问到。 若此时图中尚有顶点未被访问,则另选图中一个未曾被访 问的顶点作起始点,重复上述过程,直到图中所有顶点都被 访问到为止。

begin readln(n,m); for i:=1 to m do begin readln(a,b); map[a][b]:=1; map[b][a]:=1; end; for i:=1 to n do if visited[i]=0 then begin visited[i]:=1;work(i);end; end.

第7章-2-(7.3图的遍历)

v2 v3

2 v2

v1 v4

v5

3 V3

v1 v6

v7

4 V4 v2 v8

5 v5 6 v6 7 v7 8 v8

v2 v8 v3 v7 v3 v6 v4 v5

v,1

v,2

v1 v,4

v5

v1

v2

v,8

v4

v,5

v2

v8

v,3

v,6

v7

0

1 v1

v2 v3

2 v2

v1 v4

v5

3 V3

v1 v6

v7

v,6

v7

v2

v,8

v3

v,7

v4

v,5

v2

v8

v3

v6

0

1 v1

v2 v3

2 v2

v1 v4

v5

3 V3

v1 v6

v7

4 V4 v2 v8

5 v5 6 v6 7 v7 8 v8

v2 v8 v3 v7 v3 v6 v4 v5

v,1

v,2

v,3

v1 v,4

v5

v1

v,6

v7

v2

v,8

v3

v,7

v4

v,5

v3

3 V3

v1 v6

v7

4 V4 v2 v8

5 v5

v2 v8

v1 v,4

v5

v2

v,8

6 v6 7 v7 8 v8

v3 v7 v3 v6 v4 v5

v4

v,5

v2

v8

0

v,1

1 v1

v2 v3

2 v2

v1 v4

深度遍历和广度遍历例题

深度遍历和广度遍历例题深度遍历(Depth-First Search,DFS)和广度遍历(Breadth-First Search,BFS)是图遍历算法中常用的两种方法。

下面我将为你提供一个例题,并从多个角度进行全面的回答。

例题,给定一个无向图,使用深度遍历和广度遍历两种方法遍历该图,并输出遍历的结果。

首先,我们需要明确一下图的表示方式。

常用的图表示方法有邻接矩阵和邻接表,这里我们选择使用邻接表表示图。

假设我们有如下无向图:A./ \。

B---C.\ /。

D.邻接表表示如下:A: B, C.B: A, C, D.C: A, B, D.D: B, C.接下来,我们来进行深度遍历。

深度遍历的基本思想是从起始节点开始,尽可能深地访问每个节点,直到无法继续深入为止,然后回溯到上一个节点,继续访问其他未访问的节点。

从节点A开始进行深度遍历,访问顺序为A-B-C-D。

具体步骤如下:1. 将节点A标记为已访问。

2. 访问与节点A相邻的未被访问的节点,即节点B和节点C。

3. 选择其中一个节点(这里选择节点B),将其标记为已访问,并继续深度遍历该节点。

4. 对节点B进行相同的操作,访问与节点B相邻的未被访问的节点,即节点A、节点C和节点D。

5. 选择其中一个节点(这里选择节点C),将其标记为已访问,并继续深度遍历该节点。

6. 对节点C进行相同的操作,访问与节点C相邻的未被访问的节点,即节点A、节点B和节点D。

7. 选择其中一个节点(这里选择节点D),将其标记为已访问,并继续深度遍历该节点。

8. 由于节点D没有未被访问的相邻节点,回溯到节点C。

9. 由于节点C也没有未被访问的相邻节点,回溯到节点B。

10. 由于节点B还有一个未被访问的相邻节点(节点A),将其标记为已访问,并继续深度遍历该节点。

11. 由于节点A没有未被访问的相邻节点,回溯到节点B。

12. 由于节点B没有未被访问的相邻节点,回溯到节点A。

13. 完成深度遍历。

图的遍历算法实验报告

图的遍历算法实验报告

《图的遍历算法实验报告》

在计算机科学领域,图的遍历算法是一种重要的算法,它用于在图数据结构中

访问每个顶点和边。

图的遍历算法有两种常见的方法:深度优先搜索(DFS)

和广度优先搜索(BFS)。

在本实验中,我们将对这两种算法进行实验,并比较

它们的性能和应用场景。

首先,我们使用深度优先搜索算法对一个简单的无向图进行遍历。

通过实验结

果可以看出,DFS算法会首先访问一个顶点的所有邻居,然后再递归地访问每

个邻居的邻居,直到图中所有的顶点都被访问到。

这种算法在一些应用场景中

非常有效,比如寻找图中的连通分量或者寻找图中的环路。

接下来,我们使用广度优先搜索算法对同样的无向图进行遍历。

通过实验结果

可以看出,BFS算法会首先访问一个顶点的所有邻居,然后再按照距离递增的

顺序访问每个邻居的邻居。

这种算法在一些应用场景中也非常有效,比如寻找

图中的最短路径或者寻找图中的最小生成树。

通过对比实验结果,我们可以发现DFS和BFS算法各自的优势和劣势。

DFS算

法适合用于寻找图中的连通分量和环路,而BFS算法适合用于寻找最短路径和

最小生成树。

因此,在实际应用中,我们需要根据具体的需求来选择合适的算法。

总的来说,图的遍历算法是计算机科学中非常重要的算法之一,它在许多领域

都有着广泛的应用。

通过本次实验,我们对DFS和BFS算法有了更深入的了解,并且对它们的性能和应用场景有了更清晰的认识。

希望通过这篇实验报告,读

者们也能对图的遍历算法有更深入的理解和认识。

图的遍历(深度优先遍历和广度优先遍历)

遍历规则 从图中某结点v0出发,深度优先遍历(DFS: Depth First Search)图的规则为: 访问v0; 对v0的各个出点v01,v02,…,v0m,每次从它们中按一定方式(也可任选)选取一个未被访问过的结点,从该结点出发按深度优先遍历方式遍历。 然,因为我们没有规定对出点的遍历次序,所以,图的深度优先遍历结果一般不唯一。

20.2 深度优先遍历

例如,对图 20‑1给出的有向图与无向图,一些遍历结果(结点访问次序)为: 左图:从1出发:1,2,4,5;或1,5,2,4 从2出发:2,1,5,4;或2,4,1,5 右图:从a出发:a,b,c,d;或a,b,d,c; … …

A 如果不想让visited或top做为函数参数,也可以在函数中将其定义为static型量。但是,这样的程序是不可再入的,即函数再次被调用时,static型的量也不重新初始化,造成错误!

上面函数中的参数visited和top实质上是中间变量,只是为了避免在递归调用时重新初始化而放在参数表中,造成使用的不方便,为此,做个包装程序: long DFS1(int g[][CNST_NumNodes], long n, long v0, long *resu ) { char *visited; long top=0; visited = new char[n]; for (long i=0; i<n; i++) visited[i]=0; long num=DFS1( g, n, v0, visited, resu, top ); delete visited; return num; }

深度优先遍历非递归算法的一般性描述。

long DFS_NR(图g,结点v0)

单击此处可添加副标题

dfs和bfs题目整理和分类

DFS和BFS是图论中常用的两种遍历算法,它们在解决各种图论问题和编程竞赛中都有着重要的应用。

以下是对一些经典的DFS和BFS题目进行整理和分类。

一、DFS题目1. 树的遍历(1)给定一棵树,要求按照先序、中序、后序的方式遍历这棵树。

2. 深度优先搜索(1)给定一个有向图,从起点开始进行深度优先搜索,找出所有可达的节点。

(2)给定一个有向图,判断该图中是否存在环。

3. 拓扑排序(1)给定一个有向无环图,对图中的节点进行拓扑排序。

4. 连通分量(1)给定一个无向图,求图中的连通分量个数。

(2)给定一个无向图,求图中的每个连通分量包含的节点个数。

5. 非递归DFS(1)给定一个有向图,使用非递归的方式进行深度优先搜索。

二、BFS题目1. 广度优先搜索(1)给定一个有向图,从起点开始进行广度优先搜索,找出所有可达的节点。

(2)给定一个无向图,从起点开始进行广度优先搜索,找出所有可达的节点。

2. 最短路径(1)给定一个无向图,求从起点到终点的最短路径。

(2)给定一个有向图,求从起点到终点的最短路径。

3. 01矩阵(1)给定一个01矩阵,每个元素是0或1,求从左上角到右下角的最短路径长度。

4. 笛卡尔积(1)给定两个集合A和B,求它们的笛卡尔积。

5. 层次遍历(1)给定一棵树,使用广度优先搜索进行层次遍历。

以上是对一些常见的DFS和BFS题目进行整理和分类。

在解决这些问题时,可以根据具体情况选择合适的算法来进行求解,有效地应用DFS和BFS算法来解决实际问题。

希望以上内容对大家有所帮助。

对于DFS和BFS这两种遍历算法来说,在实际应用中有许多题目是可以通过它们来解决的。

下面继续介绍一些与DFS和BFS相关的经典问题及其解决方法。

6. 单词接龙(1)给定两个单词beginWord和endWord,以及一个字典,找出从beginWord到endWord的最短转换序列的长度。

每次转换只能改变一个字母,并且转换后的单词必须存在于字典中。

实验四 图的遍历算法

实验四图的遍历算法4.1.实验的问题与要求1.如何对给定图的每个顶点各做一次且仅做一次访问?有哪些方法可以实现图的遍历?2.如何用这些算法解决实际问题?3.熟练掌握图的基本存储方法4.熟练掌握图的两种搜索路径的遍历方法5.掌握有关图的操作算法并用高级语言实现4.2.实验的基本思想和基本原理和树的遍历类似,图的遍历也是从某个顶点出发,沿着某条搜索路径对图中每个顶点各做一次且仅做一次访问。

它是许多图的算法的基础。

遍历常用两种方法:深度优先搜索遍历;广度优先搜索遍历4.2.1 深度优先搜索(Depth-First Traversal)深度优先搜索是一种递归的过程,正如算法名称那样,深度优先搜索所遵循的搜索策略是尽可能“深”地搜索图。

在深度优先搜索中,对于最新发现的顶点,如果它还有以此为起点而未探测到的边,就沿此边继续下去。

当结点v的所有边都己被探寻过,搜索将回溯到发现结点v有那条边的始结点。

这一过程一直进行到已发现从源结点可达的所有结点为止。

如果还存在未被发现的结点,则选择其中一个作为源结点并重复以上过程,整个进程反复进行直到所有结点都被发现为止。

1.图的深度优先遍历的递归定义假设给定图G的初态是所有顶点均未曾访问过。

在G中任选一顶点v 为初始出发点(源点),则深度优先遍历可定义如下:首先访问出发点v,并将其标记为已访问过;然后依次从v出发搜索v的每个邻接点w。

若w未曾访问过,则以w为新的出发点继续进行深度优先遍历,直至图中所有和源点v有路径相通的顶点(亦称为从源点可达的顶点)均已被访问为止。

若此时图中仍有未访问的顶点,则另选一个尚未访问的顶点作为新的源点重复上述过程,直至图中所有顶点均已被访问为止。

图的深度优先遍历类似于树的前序遍历。

采用的搜索方法的特点是尽可能先对纵深方向进行搜索。

这种搜索方法称为深度优先搜索(Depth-First Search)。

相应地,用此方法遍历图就很自然地称之为图的深度优先遍历。

图的遍历:拓扑排序(+反向拓扑)

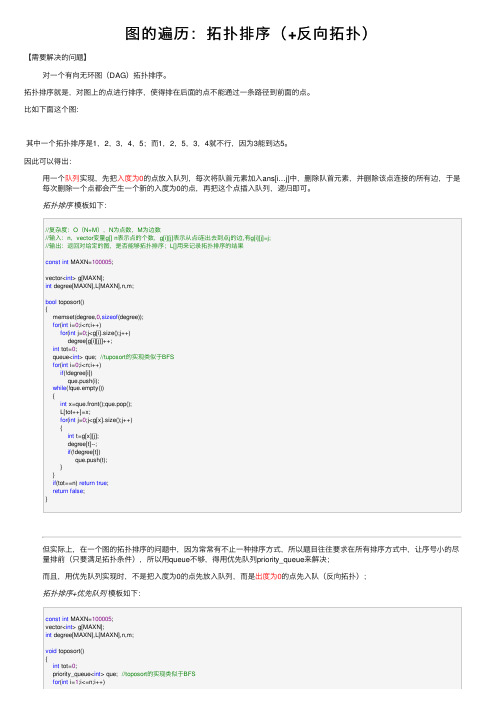

图的遍历:拓扑排序(+反向拓扑)【需要解决的问题】对⼀个有向⽆环图(DAG)拓扑排序。

拓扑排序就是,对图上的点进⾏排序,使得排在后⾯的点不能通过⼀条路径到前⾯的点。

⽐如下⾯这个图:其中⼀个拓扑排序是1,2,3,4,5;⽽1,2,5,3,4就不⾏,因为3能到达5。

因此可以得出:⽤⼀个队列实现,先把⼊度为0的点放⼊队列,每次将队⾸元素加⼊ans[i…j]中,删除队⾸元素,并删除该点连接的所有边,于是每次删除⼀个点都会产⽣⼀个新的⼊度为0的点,再把这个点插⼊队列,递归即可。

拓扑排序模板如下://复杂度:O(N+M),N为点数,M为边数//输⼊:n,vector变量g[] n表⽰点的个数,g[i][j]表⽰从点i连出去到点j的边,有g[i][j]=j;//输出:返回对给定的图,是否能够拓扑排序;L[]⽤来记录拓扑排序的结果const int MAXN=100005;vector<int> g[MAXN];int degree[MAXN],L[MAXN],n,m;bool toposort(){memset(degree,0,sizeof(degree));for(int i=0;i<n;i++)for(int j=0;j<g[i].size();j++)degree[g[i][j]]++;int tot=0;queue<int> que; //tuposort的实现类似于BFSfor(int i=0;i<n;i++)if(!degree[i])que.push(i);while(!que.empty()){int x=que.front();que.pop();L[tot++]=x;for(int j=0;j<g[x].size();j++){int t=g[x][j];degree[t]--;if(!degree[t])que.push(t);}}if(tot==n) return true;return false;}但实际上,在⼀个图的拓扑排序的问题中,因为常常有不⽌⼀种排序⽅式,所以题⽬往往要求在所有排序⽅式中,让序号⼩的尽量排前(只要满⾜拓扑条件),所以⽤queue不够,得⽤优先队列priority_queue来解决;⽽且,⽤优先队列实现时,不是把⼊度为0的点先放⼊队列,⽽是出度为0的点先⼊队(反向拓扑);拓扑排序+优先队列模板如下:const int MAXN=100005;vector<int> g[MAXN];int degree[MAXN],L[MAXN],n,m;void toposort(){int tot=0;priority_queue<int> que; //toposort的实现类似于BFSfor(int i=1;i<=n;i++)if(!degree[i])que.push(i);while(!que.empty()){int x=que.top();que.pop();L[tot++]=x;for(int j=0;j<g[x].size();j++){int t=g[x][j];degree[t]--;if(!degree[t])que.push(t);}}// if(tot==n) return true;// return false;}inline void init_input(int m){memset(degree,0,sizeof(degree)); memset(L,0,sizeof(L));memset(g,0,sizeof(g));for(int i=0;i<m;i++){scanf("%d %d",&a,&b);g[b].push_back(a);degree[a]++; //important}}。

图的遍历操作实验报告

图的遍历操作实验报告一、实验目的本次实验的主要目的是深入理解图的遍历操作的基本原理和方法,并通过实际编程实现,掌握图的深度优先遍历(DepthFirst Search,DFS)和广度优先遍历(BreadthFirst Search,BFS)算法,比较它们在不同类型图中的性能和应用场景。

二、实验环境本次实验使用的编程语言为 Python,开发环境为 PyCharm。

实验中使用的数据结构为邻接表来表示图。

三、实验原理(一)深度优先遍历深度优先遍历是一种递归的图遍历算法。

它从起始节点开始,沿着一条路径尽可能深地访问节点,直到无法继续,然后回溯到上一个未完全探索的节点,继续探索其他分支。

(二)广度优先遍历广度优先遍历则是一种逐层访问的算法。

它从起始节点开始,先访问起始节点的所有相邻节点,然后再依次访问这些相邻节点的相邻节点,以此类推,逐层展开。

四、实验步骤(一)数据准备首先,定义一个图的邻接表表示。

例如,对于一个简单的有向图,可以使用以下方式创建邻接表:```pythongraph ={'A':'B','C','B':'D','E','C':'F','D':,'E':,'F':}```(二)深度优先遍历算法实现```pythondef dfs(graph, start, visited=None):if visited is None:visited = set()visitedadd(start)print(start)for next_node in graphstart:if next_node not in visited:dfs(graph, next_node, visited)```(三)广度优先遍历算法实现```pythonfrom collections import deque def bfs(graph, start):visited ={start}queue = deque(start)while queue:node = queuepopleft()print(node)for next_node in graphnode:if next_node not in visited:visitedadd(next_node)queueappend(next_node)```(四)测试与分析分别使用深度优先遍历和广度优先遍历算法对上述示例图进行遍历,并记录遍历的顺序和时间开销。

深度优先遍历的练习题

深度优先遍历的练习题深度优先遍历的练习题深度优先遍历(Depth First Search,简称DFS)是一种常用的图遍历算法,它以深度优先的方式遍历图中的节点。

在这篇文章中,我们将通过一些练习题来巩固对深度优先遍历的理解和应用。

练习题一:岛屿数量给定一个由 '1'(陆地)和 '0'(水)组成的二维网格,计算岛屿的数量。

岛屿被水包围,通过水平或垂直方向上相邻的陆地连接而成。

假设所有的网格都是正方形且边长相等。

思路:我们可以使用深度优先遍历的方式来解决这个问题。

遍历整个二维网格,当遇到岛屿('1')时,将其周围的岛屿都标记为已访问,并递归地遍历它们的相邻节点。

每次遍历完一个岛屿后,岛屿数量加一。

练习题二:被围绕的区域给定一个二维的字符数组,其中包含 'X' 和 'O',将所有被 'X' 围绕的区域替换为 'O'。

被围绕的区域指的是所有不被 'X' 包围的 'O' 区域。

思路:我们可以使用深度优先遍历来解决这个问题。

首先,遍历整个二维数组的边界,当遇到'O' 时,将其标记为已访问,并递归地遍历其相邻节点。

在遍历完成后,我们将所有未被标记为已访问的 'O' 替换为 'X',即被围绕的区域。

练习题三:课程表现在你总共有 n 门课需要选,记为 0 到 n-1。

在选修某些课程之前需要一些先修课程。

给定课程总量以及它们的先决条件,判断是否可能完成所有课程的学习。

思路:我们可以将课程之间的先决条件看作是有向图中的边。

首先,我们需要构建这个有向图,并使用深度优先遍历来检测是否存在环。

如果存在环,则说明无法完成所有课程的学习;否则,可以完成所有课程的学习。

练习题四:单词搜索给定一个二维网格和一个单词,找出该单词是否存在于网格中。

离散数学中的图的遍历与最短路径

离散数学是数学的一个重要分支,研究离散结构与离散量的关系。

在离散数学当中,图是一个重要的概念,它用来描述事物之间的关系。

图的遍历与最短路径是图论中的两个重要问题,它们在计算机科学和网络通信等领域有广泛的应用。

图的遍历是指通过某种策略,按某个顺序访问图的所有节点。

在图的遍历过程中,我们需要使用一种数据结构来记录已经访问过的节点,并按照某种规则来选择下一个要访问的节点。

常用的图的遍历算法有深度优先搜索(DFS)和广度优先搜索(BFS)。

深度优先搜索是一种递归的搜索算法,它会首先访问一个节点的所有邻接节点,然后再依次递归访问这些节点的邻接节点,以此类推,直到没有未访问的邻接节点。

深度优先搜索能够完整地遍历图中的每个节点,并且可以用来解决一些需要遍历整个图的问题,例如判断图的连通性或寻找图的割点。

广度优先搜索是一种非递归的搜索算法,它从图的某个起始节点开始,先访问该节点的所有邻接节点,然后再依次访问这些邻接节点的邻接节点,以此类推,直到遍历完整个图。

广度优先搜索能够找到最短路径,因为它首先访问的是距离起始节点最近的节点,然后再访问离起始节点更远的节点。

因此,广度优先搜索常用于寻找最短路径或解决一些需要在有限步数内找到目标节点的问题。

最短路径是图论中的一个常见问题,它用于寻找两个节点之间最短的路径。

在有向图中,最短路径可以使用Dijkstra算法或Bellman-Ford算法来求解。

Dijkstra算法通过维护一个距离数组来记录起始节点到其他节点的距离,并通过选择路径距离最短的节点来更新距离数组,直到找到最短路径。

Bellman-Ford算法则利用动态规划的思想,通过多次循环来更新距离数组,直到没有更新为止。

在无向图或有向无环图中,最短路径可以使用广度优先搜索来求解。

广度优先搜索能够找到距离起始节点最近的节点,并且同时能够记录节点之间的路径。

因此,在广度优先搜索过程中,我们可以使用一个数组来记录节点之间的路径,并根据起始节点到目标节点的路径来回溯,从而找到最短路径。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

广度优先遍历: a b d h e c f g 深度优先遍历: a b c d e f g h

代码:

图的头文件: (队列头文件略) #include "队列.h" #include<iostream> using namespace std;

#define UNVISITED 0 #define VISITED 1

class Graph{ private:

int numVertex,numEdge; int **matrix; int *mark;

//find the location of vertex int LocalVer(char v) {

return (int)v-97; } //find the vertex char unLocalVer(int v) {

matrix[i][j] = 0; } int n(){ return numVertex; } int e(){ return numEdge; }

//return the neighbor of v int first(int v){

for (int i = 0; i < numVertex; i++) if (matrix[v][i] != 0) return i;

cout << "请输入顶点数和边数:"; cin >> n>>m; Graph g(n); Queue Q(n*5); cout << "输入"<<n<<"个顶点:"<< endl; for (int i = 0; i < n; i++) {

cout << "请输入顶点" << i << ":" << endl; cin >> g.local[i]; } for (int i = 0; i < m; i++) { char v1, v2; int wt; cout << "\n 请输入顶点两条边和他们的权值:"; cin >> v1 >> v2 >> wt; g.setEdge(v1,v2,wt); } cout << "\n 输出:\n 深度遍历:\n"; g.DFS(0); cout << "\n"; cout << "\n 输出:\n 广度遍历:\n"; g.BFS(0,Q); cout << "\n"; system("pause"); } 运行结果如下:

for (int i = 0; i < numVertex; i++) mark[i] = UNVISITED;

int v, w; Q.enqueue(start); setMark(start, VISITED); while (Q.length()!= 0) {

v = Q.dequeue(); print(v); for (w = first(v); w < n(); w = next(v, w)) if(getMark(w)==UNVISITED){

问题描述

若用有向网表示网页的链接网络,其中顶点表示某个网页,有向弧表示网页之间的链接关系。 试设计一个网络蜘蛛系统,分别以广度优先和深度优先的策略抓取网页。

基本要求

(1) (2)

首先输入顶点的数量,然后是各顶点对应的字母,再输入各条弧(权值都置 1)。 输出从首个顶点开始的广度优先遍历序列和深度先遍历序列。

HUNAN UNIVERSITY

课程实验报告

题 目 图的遍历问题

学生姓名

王家威

学生学号

201308070217

专 业 班 级 智能科学与技术 1302 班

指导老师

朱宁波

背景

网络蜘蛛即 Web Spider,是一个很形象的名字。把互联网比喻成一个蜘蛛网,那么 Spider 就是在网上爬来爬去的蜘蛛。网络蜘蛛是通过网页的链接地址来寻找网页,从网站某一个页 面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链 接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。如 果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓 取下来。这样看来,网络蜘蛛就是一个爬行程序,一个抓取网页的程序。 在抓取网页的时候,网络蜘蛛一般有两种策略:广度优先和深度优先(如下面这张简单化的 网页连接模型图所示,其中 A 为起点 也就是蜘蛛索引的起点)。

return numVertex;//if it is none,return n; }

//return the v's neihbor after w; int next(int v, int w){

for (int i = w + 1; i < numVertex; i++) if (matrix[v][i] != 0) return i;

bool isEdge(char v1, char v2){ int p = LocalVer(v1); int q = LocalVer(v2); return matrix[p][q] != 0;

}

int weight(char v1, char v2){ int p = LocalVer(v1); int q = LocalVer(v2); return matrix[p][q];

深度优先顾名思义就是让网络蜘蛛尽量的在抓取网页时往网页更深层次的挖掘进去 讲究的 是深度!也泛指: 网络蜘蛛将会从起始页开始,一个链接一个链接跟踪下去,处理完这条线 路之后再转入下一个起始页,继续跟踪链接! 则访问的节点顺序为==> A --> B --> E --> H --> I --> C --> D --> F --> K --> L --> G。深度爬行的优点是:网络蜘蛛程序在设计的时候相对比较容 易些;缺点是每次爬行一层总要向"蜘蛛老家" 数据库访问一下。问问老总有必要还要爬下 一层吗! 爬一层 问一次.... 如果一个蜘蛛不管 3721 不断往下爬 很可能迷路更有可能爬到 国外的网站去,不仅增加了系统数据的复杂度更是增加的服务器的负担。 广度优先在这里的定义就是层爬行,即一层一层的爬行, 按照层的分布与布局去索引处理 与抓取网页。则访问的节点顺序为==> A --> B --> C --> D --> E --> F --> G --> H --> I--> K --> L。广 度爬行的优点是对数据抓取更容易控制些,对服务器的负栽相应也明显减轻了许多。

return numVertex;//if it is none,return n; }

//set edge between v1 and v2 with wt(weight) void setEdge(char v1, char v2, int wt){

if (wt < 0){ cout << "It is an illegal weight value!\n"; system("pause"); exit(-1); } int p = LocalVer(v1); int q = LocalVer(v2); if (matrix[p][q] == 0)numEdge++;//if it is not the first setEdge,donnot add matrix[p][q] = wt; }

测试数据(以背景描述的图为例)

输入

输入顶点数和弧数:8 9 输入 8 个顶点. 输入顶点 0:a 输入顶点 1:b 输入顶点 2:c 输入顶点 3:d 输入顶点 4:e 输入顶点 5:f

输入顶点 6:g 输入顶点 7:h 输入 9 条弧. 输入弧 0:a b 1 输入弧 1:b d 1 输入弧 2:b e 1 输入弧 3:d h 1 输入弧 4:e h 1 输入弧 5:a c 1 输入弧 6:c f 1 输入弧 7:c g 1 输入弧 8:f g 1

matrix = (int **) new int *[numVertex]; for (int i = 0; i < numVertex; i++)

matrix [i]= new int [numVertex];

for (int i = 0; i < numVertex; i++) for (int j = 0; j < numVertex; j++)

delete[] matrix[i]; delete[] matrix; } void Init(int n) { numVertex = n; numEdge = 0; mark = new int[n]; local = new char[n];

for (int i = 0; i < numVertex; i++) mark[i] = UNVISITED;

setMark(w, VISITED); Q.enqueue(w);

}

}

} }; 源文件: #include "图.h" #include<iostream> using namespace std;

void main()

{ int n;//The num of Vertex int m;//The edge of it