数据中心冷源系统解决方案-SR-V2

数据中心常见的制冷方式__概述及解释说明

数据中心常见的制冷方式概述及解释说明1. 引言1.1 概述数据中心是现代社会不可或缺的基础设施,用于存储、处理和传输大量的数据。

然而,随着计算机和服务器的不断发展,它们所产生的热量也越来越多,对数据中心进行有效的制冷成为了一项迫切需要解决的问题。

各种制冷方式因此应运而生,以确保数据中心能够正常运行并保持理想的工作温度。

1.2 文章结构本文将首先对常见的数据中心制冷方式进行概述及解释说明。

然后在接下来的章节中详细介绍每种制冷方式的原理、应用以及优缺点,并进行比较与分析。

最后,文章将展望未来发展趋势并给出结论。

1.3 目的本文旨在提供关于数据中心常见制冷方式的全面介绍,并对每种方式进行详细解释说明。

读者可以通过本文了解到不同制冷方式之间的差异和适用场景,帮助其选择合适的方案来满足自己数据中心制冷需求。

同时,本文也为进一步研究和改进数据中心制冷技术提供了一定程度的参考。

2. 常见的制冷方式2.1 空调制冷方法空调制冷是目前使用最广泛的一种数据中心制冷方式。

它采用了压缩循环制冷系统,利用制冷剂进行热量的吸收和释放。

该方法通过将新鲜空气进入数据中心并经过过滤、降温后供应给设备以保持其正常工作温度。

在此过程中,空调系统将热量排出建筑物外部或转移到其他区域。

2.2 液冷制冷方法液冷制冷方法是另一种常见的数据中心制冷技术。

与空调制冷不同,液冷系统通过将液体直接引入数据中心设备或机架内部来实现散热。

这些液体可以是水或者具有良好热传导性能的液态金属(如液态铜)等。

利用此方法,数据中心可以更高效地移除设备产生的热量。

相较于空调制冷方式,液态散热具有更高的换热效率和更少的能量消耗。

2.3 相变材料制冷方法相变材料制冷是一种新兴而有潜力的数据中心制冷技术。

相变材料是一种可以在特定温度范围内完成相变(如固态到液态)的物质。

当相变材料吸收热量时,它会发生相变并储存大量的热能。

而当环境温度下降时,相变材料会释放储存的热量从而保持设备的正常工作温度。

数据中心冷却技术

数据中心冷却[1]:热回收数据中心热回收是对数据中心空调系统的余热进行收集并回收利用,进而达到能源高效利用,提升热经济性。

由于数据中心全年处在运行状态,产生的余热量大且品质稳定,但温度水平较低,使得热利用面临效益低下问题,故数据中心余热回收利用是一个值得探讨的挑战性问题。

目前,数据中心热回收技术主要是通过收集冷凝器产生的余热满足周围建筑的供暖和生活热水需求。

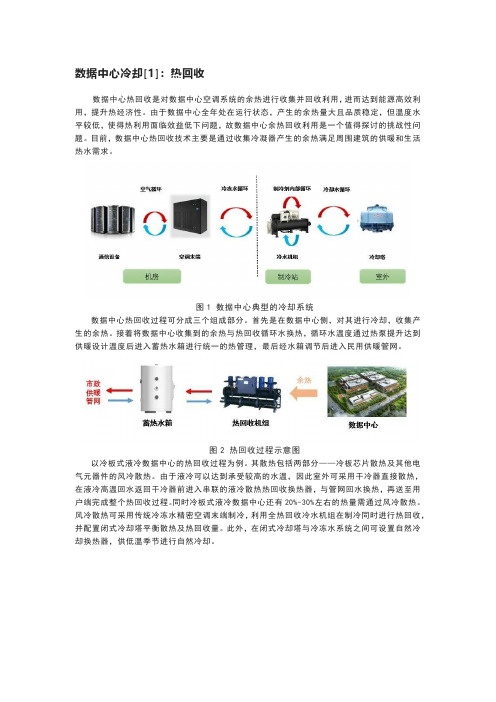

图1数据中心典型的冷却系统数据中心热回收过程可分成三个组成部分。

首先是在数据中心侧,对其进行冷却,收集产生的余热。

接着将数据中心收集到的余热与热回收循环水换热,循环水温度通过热泵提升达到供暖设计温度后进入蓄热水箱进行统一的热管理,最后经水箱调节后进入民用供暖管网。

图2热回收过程示意图以冷板式液冷数据中心的热回收过程为例。

其散热包括两部分——冷板芯片散热及其他电气元器件的风冷散热。

由于液冷可以达到承受较高的水温,因此室外可采用干冷器直接散热,在液冷高温回水返回干冷器前进入串联的液冷散热热回收换热器,与管网回水换热,再送至用户端完成整个热回收过程。

同时冷板式液冷数据中心还有20%-30%左右的热量需通过风冷散热。

风冷散热可采用传统冷冻水精密空调末端制冷,利用全热回收冷水机组在制冷同时进行热回收,并配置闭式冷却塔平衡散热及热回收量。

此外,在闭式冷却塔与冷冻水系统之间可设置自然冷却换热器,供低温季节进行自然冷却。

图3冷板式液冷数据中心热回收示意图在目前的数据中心中使用冷凝热回收,满足周围建筑供暖和生活热水已经有许多成功的案例,例如瑞典的斯德哥尔摩数据中心,其产生的热量可满足2万套现代住宅公寓的供暖;国内腾讯在天津滨海的数据中心,其产生的余热可满足5100多户居民的用热需求。

热回收技术在数据中心中的应用,能够有效解决因数据中心散热导致的热岛效应,同时提高能源利用效率。

相信随着热回收技术的发展,还会有更多不同的余热利用形式在数据中心得以成功应用。

数据中心冷却[2]:冰蓄冷冰蓄冷技术是一种利用夜间用电低谷时段,把冷量以冰的形式储存起来,在白天用电高峰时段将储存的冷量释放出来,通过“削峰填谷”的运作方式,提高能源利用效率,优化资源配置的制冷技术。

数据中心制冷技术的应用及发展V2 1

数据中心制冷技术的应用及发展摘要:本文简要回顾了数据中心制冷技术的发展历程,列举并分析了数据中心发展各个时期主流的制冷技术,例如:风冷直膨式系统、水冷系统、水侧自然冷却系统及风侧自然冷却系统等。

同时,分析了国内外数据中心制冷技术的应用差别及未来数据中心制冷技术的发展趋势。

关键词:数据中心;制冷;能效;机房;服务器Abstract This paper briefly reviews the development of data center cooling technology, enumerates and analyzes the cooling technologies in data center development period. The enumerated technologies includes direct expansionair-conditioning system, water side cooling system, water side free cooling system and air side free cooling system, etc. At the same time, the paper analyzes the difference of data center cooling technology application between the domestic and overseas as well as the tendency of data center cooling technology in the future. Key words data center; cooling; efficiency; computer room; server1前言随着云计算为核心的第四次信息技术革命的迅猛发展,信息资源已成为与能源和材料并列的人类三大要素之一。

数据中心冷板液冷系统的一次侧系统方案

数据中心冷板液冷系统的一次侧系统方案1基于冷板液冷方案的一次侧系统对于液冷二次侧末端不同的水温需求,液冷一次侧冷源可采用机械制冷系统和自然冷却系统。

机械制冷系统包括风冷冷冻水系统和水冷冷冻水系统,可提供12o C-18o C的中温冷冻水;自然冷却是在室外气象条件允许的情况下,利用室外空气的冷量而不需机械制冷的冷却过程,自然冷却系统可采用开式冷却塔、闭式冷却塔和干冷器等设备实现,可提供30℃以上的冷却水。

液冷一次侧冷源形式需结合二次侧末端水温需求和项目地室外环境情况确定。

1.1机械制冷系统・风冷冷冻水系统风冷冷冻水系统是冷冻水制备的一种方式,主要由风冷冷水机组、冷冻水泵及配套设施组成,其液态制冷剂在其蒸发器盘管内直接蒸发,实现对盘管外的冷冻水吸热而制冷,并通过风冷的方式冷却为液态。

风冷冷冻水系统不需要占用专门的机房且无需安装冷却塔及泵房,初期成本投入较低、运行方便,不需要专业人员维护,无冷却水系统,具备节水和降低维护费用等优点。

但风冷冷水机组一般装在室外,运维环境相对较为恶劣,维护性及可靠性均不如水冷冷水机组,并且风冷机组在夏季高温制冷效果较差,运行效率较低。

•水冷冷冻水系统水冷冷冻水系统是冷冻水制备的一种方式,主要由水冷冷水机组、冷冻水泵、冷却水泵、冷却塔及配套设施组成,其液态制冷剂在蒸发器盘管内直接蒸发,实现对盘管外的冷冻水吸热而制冷,并通过水冷的方式冷却为液态。

水冷冷冻水系统具有耗电量较低、全年制冷效果好、可靠性高和使用寿命长的优点。

但其需要专用机房、冷却塔、冷却水泵、冷冻水泵等设备,初投资较大,并且需要循环水,水资源消耗大,目机组本体和冷却设施需要维护,相较于风冷机组,其维护费用比较高。

1.2自然冷却系统∙开式冷却塔开式冷却塔经过将循环冷却水直接喷淋到冷却塔填料上,同时由风机带动冷却塔内气流流动,通过室外空气与冷却水之间的热质交换蒸发冷却循环水,冷却后的循环水在冷却塔底部出水(见图)。

开式冷却塔中循环冷却水与室外空气存在热质交换。

数据中心冷源群控系统分级标准的研究与应用

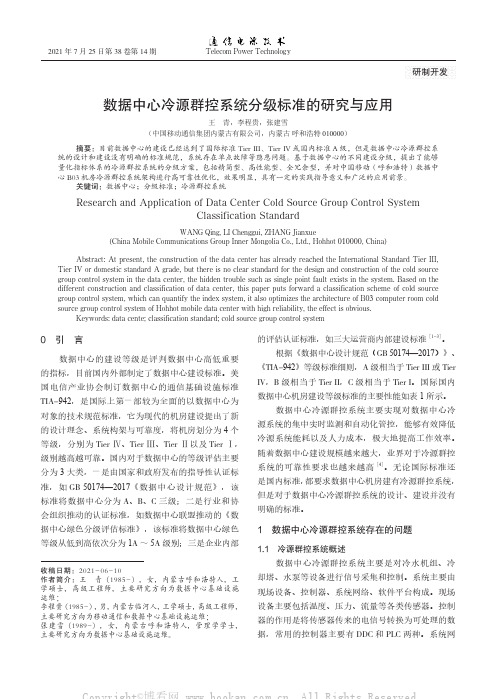

研制开发数据中心冷源群控系统分级标准的研究与应用王青,李程贵,张建雪(中国移动通信集团内蒙古有限公司,内蒙古目前数据中心的建设已经达到了国际标准Tier III、Tier IV级,但是数据中心冷源群控系统的设计和建设没有明确的标准规范,系统存在单点故障等隐患问题。

基于数据中心的不同建设分级,提出了能够量化指标体系的冷源群控系统的分级方案,包括精简型、高性能型、全冗余型,并对中国移动(呼和浩特)数据中机房冷源群控系统架构进行高可靠性优化,效果明显,具有一定的实践指导意义和广泛的应用前景。

数据中心;分级标准;冷源群控系统Research and Application of Data Center Cold Source Group Control SystemClassification StandardWANG Qing, LI Chenggui, ZHANG Jianxue(China Mobile Communications Group Inner Mongolia Co., Ltd., HohhotAbstract: At present, the construction of the data center has already reached the International Standard Tier III, Tier IV or domestic standard A grade, but there is no clear standard for the design and construction of the cold source络主要是用于构建现场控制器通网络。

软件平台提供人机操作界面等。

1.2 冷源群控系统问题目前数据中心冷源群控系统普遍存在两方面痛点问题。

1.2.1设计痛点国内大型数据中心大多按照国内标准A级或国际标准Tier Ⅳ或Tier Ⅲ的要求进行设计,但冷源群控系统没有相应的标准,各大数据中心通常是按照传统的楼宇控制系统进行设计。

某大型数据中心配套建筑冰蓄冷系统设计

设计应用某大型数据中心配套建筑冰蓄冷系统设计王桂坤中通服咨询设计研究院有限公司,江苏结合东莞某大型数据中心配套建筑,介绍了电力紧张地区的冰蓄冷系统设计。

集中冷源采用永磁同步变频离心式冰蓄冷双工况机组,运行模式为分量蓄冷模式,即冷水机组作为白天基本负载供冷,不足部分由冰蓄冷进行补充。

如此不仅使电力负荷削峰填谷,而且提高了冷水机组的制冷效率,大大降低了运行费用。

同时设备投资回收期短,为夏季电力紧张地区制冷系统设计提供了一种行之有效的解决方案。

冰蓄冷;分量蓄冷;削峰填谷;投资回收期Design of Ice Storage System for Supporting Buildings of a Large Data CenterWANG Guikun(China Information Consulting & Designing Institute Co., Ltd., NanjingAbstract: Combined with the supporting building of a large data center in Dongguan, the design of ice storage system in power shortage area is introduced. The centralized cold source adopts the permanent magnet synchronous frequency conversion centrifugal ice storage double working condition unit, and the operation mode is the component离心式冰蓄冷双工况机组、制冰装置、水源热泵机组、水泵、板式换热器以及软化水处理装置等均设置在研发办公楼地下室内。

室外管网采用双管制,根据空调蓄冷运行策略,冰蓄冷空调可选择全量冰蓄冷和分量冰蓄冷两种方案。

详解数据中心冷却方式及其工作原理

新型高效散热技术发展趋势

液体冷却技术

随着服务器功率密度的提高,传 统的风冷方式已无法满足高热流 密度芯片的散热需求,液体冷却 技术如浸没式冷却和冷板式冷却

等逐渐受到关注。

热管技术

热管利用工质的相变原理进行热 量传递,具有高效、可靠、无需 外部动力等优点,适用于高热流 密度和小型化数据中心的散热。

热电制冷技术

液体冷却优缺点分析

01

系统复杂性

液体冷却系统相比空气冷却系统更为复杂,需要更多的设备和管道来支

持冷却液的循环流动。

02

维护成本较高

液体冷却系统的维护成本相对较高,需要定期检查和更换冷却液,清洗

管道和设备等。

03

潜在泄漏风险

虽然现代液体冷却系统采用了高密封性的设计和高质量的材料,但仍存

在潜在的泄漏风险。一旦发生泄漏,可能会对数据中心设备造成损坏或

01

03

通过综合运用高效散热技术、智能化监控和运维管理 以及绿色环保理念,可以构建高效、可靠、绿色的数

据中心,为数字经济的可持续发展做出贡献。

04

绿色环保理念是数据中心发展的重要趋势,需要关注 可再生能源利用和废热回收技术等环保技术的应用。

THANKS 感谢观看

VS

评估方法

通过实验测试和数值模拟等手段,对双工 质冷却系统的性能进行评估和优化。

双工质冷却优缺点分析

优点

散热效率高,适用于高热流密度场景;节能 环保,符合绿色数据中心发展趋势。

缺点

系统复杂度高,维护成本较高;对工作环境 温度和湿度有一定要求。

05 冷却方式选择与设计考虑因素

数据中心规模与布局

工作流程

高温热源加热蒸发器中的低沸点工质,使其蒸发并吸收热量;蒸发的低沸点工质进入冷凝器,被冷却水或 空气冷却后凝结成液体,释放热量;同时,高沸点工质在冷凝器中吸收低沸点工质释放的热量并蒸发;高 沸点工质蒸汽进入压缩机,被压缩升温后回到蒸发器,完成一个循环。

联想 ThinkServer SR590 V2 服务器产品指南

Lenovo ThinkServer SR590 V2 Server产品指南注:*此指南适用于ThinkServer SR590 V2 如下机型(机型号码7D53CTO1WW在服务器右耳标签,及机箱后侧标签中标注) **文档中涉及retimer 支持的功能将在2022年支持,如需了解详情,请联系联想相关销售人员联想ThinkServer SR590 V2是一款理想的2路2U机架服务器,它强劲性能和经济性的完美结合适用于中小型企业,大企业及各行业对于服务器的关键需求,如产品的高可靠性、易管理和高安全性,以及可扩展性及灵活性。

SR590 V2 基于新的第三代英特尔 Xeon 可扩展处理器系列(代号为"Icelake")并支持新的英特尔 Optane 持久内存200 系列。

SR590 V2 可以很好的支持各种工作负载,如数据库、虚拟化和云计算、虚拟桌面基础设施(VDI)、基础设施安全、系统管理、企业应用程序、协作/电子邮件、流媒体、Web 等ThinkServer SR590 V2 24盘位图关键产品信息SR590 V2 服务器搭载第三代英特尔 Xeon 可扩展处理器并能充分发会其的优异功能,可支持最高 205W 最多36 核处理器并发挥其完整性能、支持3200 MHz 内存以及对 PCIe Gen 4.0 支持。

同时SR590 V2 是一款支持丰富配置的产品,可最多支持服务器前置及后置共 28个硬盘,以及服务器后部最多8个PCIe 标准插槽及一个OCP 3.0 插槽,用以确保客户可以灵活配置服务器以满足其不同工作负载的需要。

Click here to check for updates主要特性SR590 V2 服务器结合了性能和灵活性及经济型的平衡,是各种规模的企业的绝佳选择。

该服务器提供广泛的硬盘驱动器和插槽配置的不同选择。

它的出色的可靠性、可用性和可维修性和优异的设计可改善客户的业务环境,并有助于节省运营成本。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

服务、维修和维护

我们的客户包括近90%的世界最高建筑

哈利法塔 迪拜

台北 101大楼 台北

环球贸易广场 香港

紫峰大厦 南京

国际金融中心 广州

公主塔 迪拜

国际金融中心 二期 香港

麦加皇家钟楼 沙特阿拉伯

上海环球 金融中心 上海

双子塔 吉隆坡

威利斯大厦 芝加哥

特朗普大厦 芝加哥

阿尔哈姆拉塔 科威特

世界地标建筑之首选

数据中心系统解决方案

内容 I. 公司介绍 II. 冷源系统解决方案

I. 离心式冷水机组

II. 水冷变频螺杆 III. 风冷变频螺杆机组 IV. 冷源优化控制系统

III. 数据中心基础设施管理系统(DCFIM)

IV. 经典项目案例

2

公司介绍

3

江森自控

于1885年成立,超过127年历史 全球500强企业排名280位,2013年全球销售额427亿美元

800Ton

0.5

1400Ton

3 VSD 23C

0.4

0.3 500 1,000

+

1,500 Ton

2,000

+

2,500 +

3,000

32

VSD机组加减机点 机组最佳效率点

System Load (Tons) 3 units of 900 Tons

变频离心式冷水机组—节能性 2005年5月4日,约克品牌VSD因

工业设计标准,安全可靠

符合AHRI Standard 550/590认证 满足LEED EAc4认证要求

变频离心式冷水机组—节能性 常规空调项目

压力

32° C 37° C

压差/压头

12° C

7° C

焓

变频离心式冷水机组—节能性

ASHRAE TC 9.9规定的数据中心室内环境温度

变频离心式冷水机组—节能性

火灾探测

设施管理

冷水机

安防

在数据中心里冷水机房具有非常重要的节能需求 典型数据中心的能源分布 制冷站 能源分布 暖通空调系统 能源分布

Pumps 22% Chillers 64%

Towers 11%

数据中心 整体能源分布

Servers 30% PDU 6% UPS 15% Switches 2%

CRAC 18%

能源咨询

项目管理

17

数据中心客户的关注

统计来自数据中心动态报告--中国市场

能耗大,45%的电力用于机房制冷 7×24不间断运行 对温度变化非常敏感,要求不间断供冷

充足的备用供电设备 非正常断电后,须迅速恢复制冷,保证设定温度

扩展数据中心空间 扩展数据库空间,满足日益增长的需求 2012年,设施增长28%

Manufacturing & Engineering Base in Asia

亚洲技术研发和制造基地

中国无锡工厂 优秀工程技术中心, 中国北京 亚洲技术研发中心 中国无锡 优秀工程技术中心, 印度孟买 优秀工程技术中心 印度普那 工程技术中心 中国香港 印度普那工厂 亚洲零件产品中心 中国上海 亚洲学习发展中心 中国上海

ቤተ መጻሕፍቲ ባይዱ传统设计

以常规民用空调作为设计参考

优化设计

主要考虑显热负荷

冷水温度较低(一般不高于7℃),效 可根据设备工作特性适当提高冷冻水 率较差 出水温度 (一般为10-15° C,机组最 高可达20° C),冷冻水温度每提高1 低温送风,过渡除湿,造成能源浪费 ° C,机组效率提高2% 提高送风温度,减少不必要的除湿

能效和可持续性咨询

1,000位 LEED® 认证专家 500个分支机构,分布150多个国家

1883年,江森教授发明了世界 第一台恒温器。

建筑设施效益业务 您可能因为这些了解我们…

暖通空调 和楼宇自控产品 综合楼宇管理系统 工业和商用冷冻

暖通空调设备

家用空调和温控

由超过2000种高性能的 暖通空调、制冷设备、 楼控产品和服务所组成

Humidifier 7%

Chiller Plant 73%

HVAC 45%

Lighting 2%

20

离心式冷水机组

21

离心式冷水机组—概述

制冷量:250~1,100 TR (低压VSD); 1100~2,900 TR (中高压)

单级,高效,离心式压缩机 开式电机 环保制冷剂 HFC-134a 技术先进的OptiviewTM 控制中心 运行安静

《财富》世界500强

全美最大公司

247 248 249 250 251 252 253 254 255 256 西斯科公司 华特迪士尼公司 荷兰皇家阿霍德集团 德国大陆集团

《福布斯》2000

全球最大公司

276 277 278 279 280 281 282 283 284 285 Duke Energy US Legal and General Group UK Mitsubishi Electric Japan Husky Energy Canada

热备模式

100% 100% OFF

66% 66% 66%

31

变频离心式冷水机组—节能性

CSD VSD chiller performance 全变频 vs vs 定频机组性能比较图

0.9

0.8

定频机组加减机点 (贴近满载)

0.7

1 CSD 23C 2 CSD 23C

kW/ton

0.6

3 CSD 23C 1 VSD 23C 2 VSD 23C

机组能效kW/ton

降低冷却水温度

部分负载下效率更高

机组负荷

29

变频离心式冷水机组—节能性

制冷量:2546kW 蒸发器流量:576m3/h 蒸发器温差:3.8℃

电机功率:242kw

COP:10.5

30

变频离心式冷水机组—节能性

传统的控制方案:在开机时,让每台定速机组依 次上载至满负荷附近

满载加减机,使机组尽可能接近满负荷运行

世界一流的专家 在发展中市场,技术人员短缺

18

江森自控可提供各种产品和服务,解决这些后顾之忧

模块化中心机房 咨询/项目管理

楼宇自动化

空气侧产品

电力成本/效率(PUE) 提高功率密度 电力供应能力/质量 世界一流的专家

扩展数据中心空间

19

技术服务

显著提高机组能效

25

变频离心式冷水机组—节能性 降低冷凝器水温

温度

其他机组最低进水19 ℃ 冷凝器器

最小提升温度

12℃

减小压头

压缩机

YK冷却水最低进水12.8 ℃

6℃

减少压缩机做功

蒸发器(冷冻水出水7℃)

焓

降低机组能耗

变频离心式冷水机组—节能性

一般常规机组最低冷却水温允许值为18~21℃,为了保证机组安全运 行,必须保证冷却水温在较高温度运行,因此无法享受低冷却水温给 机组带来的节能效果。

; 未来趋势为绿色数据中心 电力成本/效率(PUE) 能源成本持续上升 44%的数据中心运营者关心能源成本

提高功率密度 新设备和虚拟化提高了功率密度 2012年,能源增长46%(设施增长28%)

/质量是在发展中市场必须考虑的因素 电力供应能力/质量 电力供应能力 46%的数据中心运营者关心电力供应能力

General Motors

Honda North America IBM

江森自控

Accenture plc Spectra Energy Corp. Campbell Soup Co. Nike, Inc. Freeport-McMoran Copper & Gold Inc.

江森自控

起亚汽车 英国葛兰素史克 高盛 瑞士信贷 中国人民保险集团股 份有限公司

常规模式

100%

100% OFF

66%

66% 66%

减少参与运行的泵和冷却塔的数量

全变频控制策略:智能控制VSD机组上载顺序, 使其运行在部分负荷

在低冷却水进水温度时,VSD机组上载的早期就将负载分 散到其他VSD机组,使所有机组运行在效率较好的部分负 荷 根据机组的数据来调节机组的运行顺序

江森自控

SEB Sweden Svenska Handelsbanken, Sweden Sasol South Africa Taiwan Semiconductor Taiwan Indian Oil India

江森自控

Johnson & Johnson Kroger Lockheed Martin Microsoft Procter & Gamble Toyota Motor NA Verizon Communications Wal-Mart Stores

在全球市场中的领导者地位,世界级安全和高效的工作环境

连续60年业绩稳健增长的财政记录、拥有健全的管理体系

全球网络

超过1,300家分支机构 员工超过162,000名 业务遍及150个国家

4

全球领导者 最佳企业公民

500

《企业社会责任杂志》

最佳企业公民

1

2 3 4 5 6 7 8 9 10

英法海底隧道 美国国会大厦 澳洲悉尼歌剧院

莫斯科克里姆林宫

10

美国军用潜艇

巴黎艾菲尔铁塔

亚洲地标建筑之首选

新加坡 UOB 广场

马来西亚吉隆坡城市中 心Kuala Lumpur

台湾台北101金融大厦

香港会展中心

泰国曼谷Royal Paradise

11

澳门会展中心

越南河内喜莱登酒店