Monte_Carlo与积分计算

Monte Carlo积分

Sample Mean Method

Start Set N : large integer

s1 = 0, s2 = 0

Loop N times

xn = (b-a) un + a yn = (xn)

s1 = s1 + yn , s2 = s2 + yn2 Estimate mean m’=s1/N Estimate variance V’ = s2/N – m’2 End

Monte Carlo method WINS, when d >> 3

第九章 Monte Carlo积分

Hit-or-Miss Method Sample Mean Method Variance Reduction Technique Variance Reduction using Rejection Technique

E ( M ) Np 2 ( M ) Np(1 P)

M ˆ ˆ E ( I ) E ph(b a) E h(b a) N h(b a) E ( M ) h(b a) p I N

ˆ ˆ 2 ( I ) 2 ph(b a) 2

Hit-or-Miss Method

I p : h(b - a)

So, if we can estimate p, we can estimate I:

ˆ ˆ I ph(b - a)

ˆ where p is our estimate of p

Hit-or-Miss Method

We can easily estimate p:

write this as

1 I 3 e dx 3E[e X ] 3 0

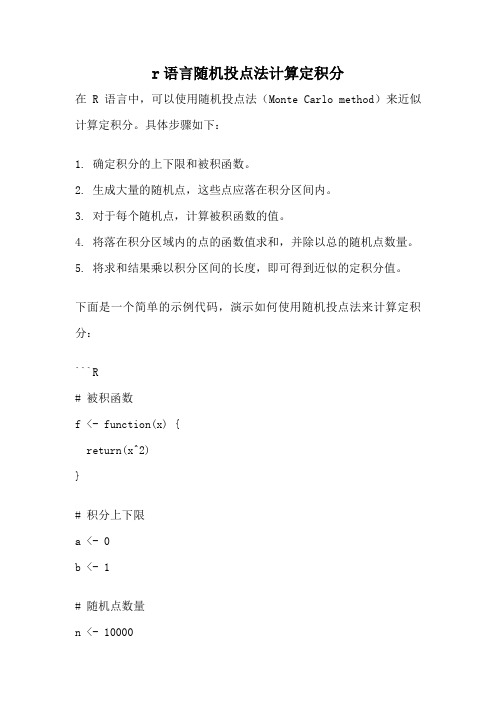

r语言随机投点法计算定积分

r语言随机投点法计算定积分

在R语言中,可以使用随机投点法(Monte Carlo method)来近似计算定积分。

具体步骤如下:

1. 确定积分的上下限和被积函数。

2. 生成大量的随机点,这些点应落在积分区间内。

3. 对于每个随机点,计算被积函数的值。

4. 将落在积分区域内的点的函数值求和,并除以总的随机点数量。

5. 将求和结果乘以积分区间的长度,即可得到近似的定积分值。

下面是一个简单的示例代码,演示如何使用随机投点法来计算定积分:

```R

# 被积函数

f <- function(x) {

return(x^2)

}

# 积分上下限

a <- 0

b <- 1

# 随机点数量

n <- 10000

# 生成随机点

x <- runif(n, a, b)

# 计算函数值

y <- f(x)

# 落在积分区域内的点的函数值求和

integral <- sum(y)

# 计算近似的定积分值

approx_integral <- (b - a) * integral / n

print(approx_integral)

```

在上述代码中,被积函数为f(x) = x^2,积分区间为[0, 1],随机生成了10000个落在积分区间内的随机点,然后计算这些随机点上的函数值,并求和,最后根据公式计算近似的定积分值。

蒙特卡罗方法在积分计算中的应用

1. 蒙特卡罗方法求积分

蒙特卡罗方法求积分的一般规则如下:任何一个 积分,都可看作某个随机变量的期望值,因此,可以 用这个随机变量的平均值来近似它。 蒙特卡洛方法的基本思想: 当问题可以抽象为某个确定的数学问题时,应当首先 建立一个恰当的概率模型,即确定某个随机事件A或随机 变量X,使得待求的解等于随机事件出现的概率或随机变 量的数学期望值。然后进行模拟实验,即重复多次地模拟 随机事件A或随机变量X。最后对随机实验结果进行统计平 均,求出A出现的频数或X的平均值作为问题的近似解。这 种方法也叫做间接蒙特卡洛模拟。

子程序FMTCL.FOR

SUBROUTINE FMTCL(A,B,F,S) DOUBLE PRECISION A,B,F,S,R,X,K REAL M,NRND1 F=1.0 M=10000.0 K=10000.0D0 S=0.0D0 IF (M+1.0.NE.1.0)THEN M=M-1.0 X=A+(B-A)*NRND1(R) S=S+F(X)/K GOTO 10 ENDIF S=S*(B-A) END

形参说明

N:整型变量,输入参数,积分的重数。 A,B: 均为双精度实型一维数组,长度为N,输入参数, 积分的下限值和上限值。 F:双精度实型函数子程序名,输入参数。用于计算被积函 数值f(x1,x2,…,xn)。在主程序中必须用外部语句及类型 说明语句对相应遥实参进行说明。 DOUBLE PRECISION FUNCTION F(N,X) 其中:X为双精度实型一维数组,长度为N ;用于存放N 个自变量值。 S:双精度实型变量,输出参数。返回积分值。

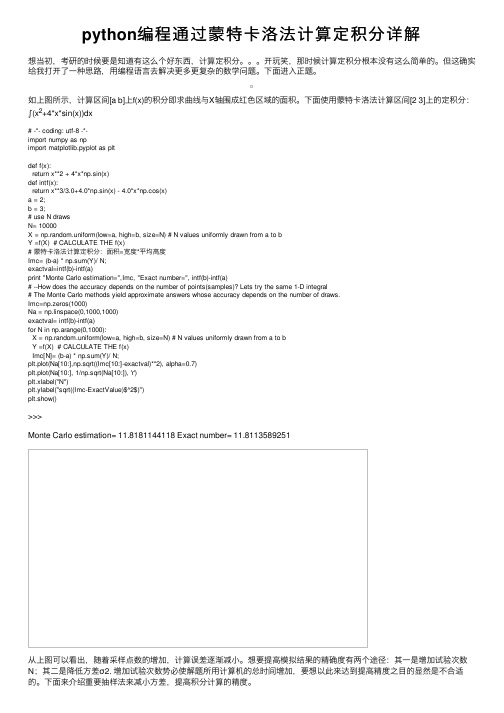

python编程通过蒙特卡洛法计算定积分详解

python编程通过蒙特卡洛法计算定积分详解想当初,考研的时候要是知道有这么个好东西,计算定积分。

开玩笑,那时候计算定积分根本没有这么简单的。

但这确实给我打开了⼀种思路,⽤编程语⾔去解决更多更复杂的数学问题。

下⾯进⼊正题。

如上图所⽰,计算区间[a b]上f(x)的积分即求曲线与X轴围成红⾊区域的⾯积。

下⾯使⽤蒙特卡洛法计算区间[2 3]上的定积分:∫(x2+4*x*sin(x))dx# -*- coding: utf-8 -*-import numpy as npimport matplotlib.pyplot as pltdef f(x):return x**2 + 4*x*np.sin(x)def intf(x):return x**3/3.0+4.0*np.sin(x) - 4.0*x*np.cos(x)a = 2;b = 3;# use N drawsN= 10000X = np.random.uniform(low=a, high=b, size=N) # N values uniformly drawn from a to bY =f(X) # CALCULATE THE f(x)# 蒙特卡洛法计算定积分:⾯积=宽度*平均⾼度Imc= (b-a) * np.sum(Y)/ N;exactval=intf(b)-intf(a)print "Monte Carlo estimation=",Imc, "Exact number=", intf(b)-intf(a)# --How does the accuracy depends on the number of points(samples)? Lets try the same 1-D integral# The Monte Carlo methods yield approximate answers whose accuracy depends on the number of draws.Imc=np.zeros(1000)Na = np.linspace(0,1000,1000)exactval= intf(b)-intf(a)for N in np.arange(0,1000):X = np.random.uniform(low=a, high=b, size=N) # N values uniformly drawn from a to bY =f(X) # CALCULATE THE f(x)Imc[N]= (b-a) * np.sum(Y)/ N;plt.plot(Na[10:],np.sqrt((Imc[10:]-exactval)**2), alpha=0.7)plt.plot(Na[10:], 1/np.sqrt(Na[10:]), 'r')plt.xlabel("N")plt.ylabel("sqrt((Imc-ExactValue)$^2$)")plt.show()>>>Monte Carlo estimation= 11.8181144118 Exact number= 11.8113589251从上图可以看出,随着采样点数的增加,计算误差逐渐减⼩。

用蒙特卡洛方法估计积分值

用蒙特卡洛方法估计积分值一.实验目的:1.初步了解蒙特卡洛算法及其用途2.利用蒙特卡洛算法计算积分值并与其真实之进行比较二.实验原理:做Monte Carlo 时,求解积分的一般形式是:X 为自变量,它应该是随机的,定义域为(x0, x1),f(x)为被积函数,ψ(x)是x 的概率密度。

Monte Carlo 步骤:1.依据概率分布ψ(x)不断生成随机数x, 并计算f(x)由于随机数性质,每次生成的x 的值都是不确定的,为区分起见,我们可以给生成的x 赋予下标。

如x i 表示生成的第i 个x 。

生成了多少个x ,就可以计算出多少个f(x)的值2.误差分析Monte Carlo 方法得到的结果是随机变量,因此,在给出点估计后,还需要给出此估计值的波动程度及区间估计。

严格的误差分析首先要从证明收敛性出发,再计算理论方差,最后用样本方差来替代理论方差。

三.实验内容:第一题 估计积分,并将估计值与真值进行比较(1).∫322dx x将被积函数展开成[2,3]上的均匀分布,1)(=x f x 2)(x x h =真值为6.3333程序内容运算结果(2)xdx x sin 20∫π将被积函数展开为[0,2π]上的均匀分布,π2)(=x f x ,x x x h sin 2)(π=真值为1程序内容运算结果(3)∫+∞−02dxe x将被积函数展开为(0, ∞+)上参数为2的卡方分布,f(x)=,ℎ()=2程序内容运算结果:第二题估计积分,并对误差进行估计(1).∫将被积函数展开为(0,1)均匀分布,f(x)=1,ℎ()=程序内容运算结果(2)∫√将被积函数展开为(0,10)上的均匀分布,f(x)=0.1,ℎ()=√ 程序内容四.实验总结:通过实验了解了概率论在值估计及生活中的运用。

通过对上面五个问题的求解知道,由于随机数的任意性,虽然计算机每次的运行结果都是不一样的,但是结果往往与理论值偏差不大。

用蒙特卡洛方法计算积分

用蒙特卡洛方法计算积分简介蒙特卡洛方法是一种通过随机抽样来计算数学问题的方法。

在计算积分时,蒙特卡洛方法可以提供一种简单而有效的解决方案。

方法步骤1. 确定积分范围:首先确定要计算的积分范围,并将其表示为一个多维的定积分。

2. 创建随机点:生成一组随机点,这些随机点需要在积分范围内均匀分布。

3. 判断点的位置:对于每个随机点,判断它是否在被积函数的曲线下方。

4. 计算积分值:计算在被积函数下方的点数与总随机点数的比例,并乘以积分范围的体积,得到积分的近似值。

优势和注意事项蒙特卡洛方法的优势在于其简单性和适用性广泛性。

然而,在使用蒙特卡洛方法进行积分计算时,需要注意以下几点:- 随机点的数量:随机点的数量越多,计算结果越精确,但计算时间也会增加。

- 积分范围的选择:选择合适的积分范围可以提高计算效率和准确性。

- 随机点的生成:生成随机点需要遵循均匀分布原则,以确保计算结果的准确性。

示例以下是使用蒙特卡洛方法计算积分的示例代码:import randomdef monte_carlo_integration(f, a, b, n):count = 0for _ in range(n):x = random.uniform(a, b)y = random.uniform(min(f(a), f(b)), max(f(a), f(b)))if 0 < y <= f(x):count += 1return count / n * (b - a) * (max(f(a), f(b)) - min(f(a), f(b)))def f(x):被积函数定义,根据实际情况修改return x**2a = 0 # 积分下限b = 1 # 积分上限n = # 随机点数量result = monte_carlo_integration(f, a, b, n)print("Approximate integral value:", result)注意:上述代码仅为示例,实际运行时请根据需要修改被积函数和参数。

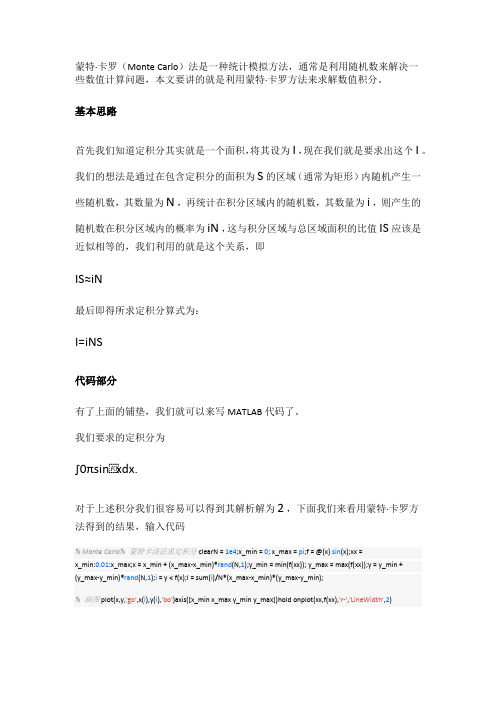

蒙特卡洛方法求定积分一

蒙特·卡罗(Monte Carlo)法是一种统计模拟方法,通常是利用随机数来解决一些数值计算问题,本文要讲的就是利用蒙特·卡罗方法来求解数值积分。

基本思路首先我们知道定积分其实就是一个面积,将其设为I,现在我们就是要求出这个I。

我们的想法是通过在包含定积分的面积为S的区域(通常为矩形)内随机产生一些随机数,其数量为N,再统计在积分区域内的随机数,其数量为i,则产生的随机数在积分区域内的概率为iN,这与积分区域与总区域面积的比值IS应该是近似相等的,我们利用的就是这个关系,即IS≈iN最后即得所求定积分算式为:I=iNS代码部分有了上面的铺垫,我们就可以来写MATLAB代码了。

我们要求的定积分为∫0πsinxdx.对于上述积分我们很容易可以得到其解析解为2,下面我们来看用蒙特·卡罗方法得到的结果,输入代码% Monte Carlo% 蒙特卡洛法求定积分clearN = 1e4;x_min = 0; x_max = pi;f = @(x) sin(x);xx =x_min:0.01:x_max;x = x_min + (x_max-x_min)*rand(N,1);y_min = min(f(xx)); y_max = max(f(xx));y = y_min +(y_max-y_min)*rand(N,1);i = y < f(x);I = sum(i)/N*(x_max-x_min)*(y_max-y_min);% 画图plot(x,y,'go',x(i),y(i),'bo')axis([x_min x_max y_min y_max])hold onplot(xx,f(xx),'r-','LineWidth',2)。

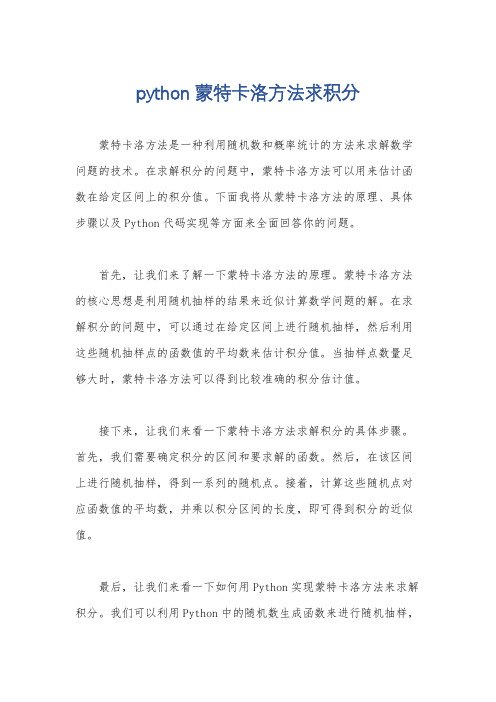

python蒙特卡洛方法求积分

python蒙特卡洛方法求积分蒙特卡洛方法是一种利用随机数和概率统计的方法来求解数学问题的技术。

在求解积分的问题中,蒙特卡洛方法可以用来估计函数在给定区间上的积分值。

下面我将从蒙特卡洛方法的原理、具体步骤以及Python代码实现等方面来全面回答你的问题。

首先,让我们来了解一下蒙特卡洛方法的原理。

蒙特卡洛方法的核心思想是利用随机抽样的结果来近似计算数学问题的解。

在求解积分的问题中,可以通过在给定区间上进行随机抽样,然后利用这些随机抽样点的函数值的平均数来估计积分值。

当抽样点数量足够大时,蒙特卡洛方法可以得到比较准确的积分估计值。

接下来,让我们来看一下蒙特卡洛方法求解积分的具体步骤。

首先,我们需要确定积分的区间和要求解的函数。

然后,在该区间上进行随机抽样,得到一系列的随机点。

接着,计算这些随机点对应函数值的平均数,并乘以积分区间的长度,即可得到积分的近似值。

最后,让我们来看一下如何用Python实现蒙特卡洛方法来求解积分。

我们可以利用Python中的随机数生成函数来进行随机抽样,然后计算函数值的平均数,并乘以积分区间的长度来得到积分的估计值。

下面是一个简单的示例代码:python.import random.def monte_carlo_integration(func, a, b, n):total = 0。

for _ in range(n):x = random.uniform(a, b)。

total += func(x)。

return (b a) total / n.# 示例,求解函数 f(x) = x^2 在区间 [0, 1] 上的积分。

def f(x):return x 2。

a = 0。

b = 1。

n = 1000000。

result = monte_carlo_integration(f, a, b, n)。

print("积分的估计值为,", result)。

在这个示例中,我们定义了一个名为monte_carlo_integration的函数来实现蒙特卡洛积分的方法。

蒙特卡洛方法与定积分计算

蒙特卡洛方法与定积分计算蒙特卡洛方法和定积分都是数学中常用的计算方法。

蒙特卡洛方法是一种基于随机数的统计计算方法,用于估计数值问题的解。

定积分则是一种通过将函数与自变量相乘并对其积分来计算曲线下的面积的方法。

本文将分别介绍蒙特卡洛方法和定积分的原理和应用,并比较两者的优劣。

蒙特卡洛方法是以蒙特卡洛赌场(Monte Carlo Casino)命名的一种计算方法,最早由美国科学家冯·诺依曼(John von Neumann)于20世纪40年代提出。

蒙特卡洛方法的基本思想是通过随机抽样和统计分析来估计数值问题的解。

具体而言,蒙特卡洛方法随机选择输入数据,并运行多次模拟来获取输出结果的分布情况。

通过对这些输出结果的统计分析,可以得到数值问题的解或近似解。

蒙特卡洛方法在很多领域都有广泛的应用。

其中最著名的应用之一是估计圆周率π的值。

通过在单位正方形内随机投点,并统计落在单位圆内的点的个数,可以得到一个π/4的近似值。

这是因为单位圆的面积为π,而单位正方形的面积为1,所以圆内点的比例即为π/4、通过增加抽样次数,可以得到更精确的π的近似值。

此外,蒙特卡洛方法还可以应用于金融建模、风险评估、物理模拟等领域。

定积分是微积分的一项基础概念,用于计算曲线下的面积。

定积分的计算公式为∫f(x)dx,其中f(x)表示被积函数,dx表示一个无限小的自变量增量。

定积分的计算过程可以看作是将函数与自变量相乘,并对其积分。

曲线下的面积即为定积分的值。

定积分可以通过几何方法、代数方法或数值计算方法等多种方式进行计算。

定积分在数学和物理学中有广泛的应用。

例如,通过计算函数曲线下的面积,可以得到函数的平均值、变化趋势、极值点等信息。

此外,定积分还可以用于求解一些平面图形或空间图形的面积、体积等几何问题。

在物理学中,定积分可以用于计算质点的位移、速度、加速度等运动参数,以及作用力、功等动力学参数。

比较蒙特卡洛方法和定积分,它们各自具有一些优势和劣势。

蒙特卡洛方法与定积分计算

蒙特卡洛方法与定积分计算By 邓一硕 @ 2010/03/08关键词:Monte-Carlo, 定积分, 模拟, 蒙特卡洛分类:统计计算作者信息:来自中央财经大学;统计学专业。

版权声明:本文版权归原作者所有,未经许可不得转载。

原文可能随时需要修改纰漏,全文复制转载会带来不必要的误导,若您想推荐给朋友阅读,敬请以负责的态度提供原文链接;点此查看如何在学术刊物中引用本文本文讲述一下蒙特卡洛模拟方法与定积分计算,首先从一个题目开始:设,用蒙特卡洛模拟法求定积分的值。

随机投点法设服从正方形上的均匀分布,则可知分别服从[0,1]上的均匀分布,且相互独立。

记事件,则的概率为即定积分的值就是事件出现的频率。

同时,由伯努利大数定律,我们可以用重复试验中出现的频率作为的估计值。

即将看成是正方形内的随机投点,用随机点落在区域中的频率作为定积分的近似值。

这种方法就叫随机投点法,具体做法如下:图1 随机投点法示意图1、首先产生服从上的均匀分布的个随机数(为随机投点个数,可以取很大,如)并将其配对。

2、对这对数据,记录满足不等式的个数,这就是事件发生的频数,由此可得事件发生的频率,则。

举一实例,譬如要计算,模拟次数时,R代码如下:n=10^4;x=runif(n);y=runif(n);f=function(x){exp(-x^2/2)/sqrt(2*pi)}mu_n=sum(y<f(x));J=mu_n/n;J模拟次数时,令,其余不变。

定积分的精确值和模拟值如下:表10.3413447 0.342 0.344 0.34187 0.341539 0.341302注:精确值用integrate(f,0,1)求得扩展如果你很细心,你会发现这个方法目前只适用于积分区间,且积分函数在区间上的取值也位于内的情况。

那么,对于一般区间上的定积分呢?一个很明显的思路,如果我们可以将与建立代数关系就可以了。

首先,做线性变换,令,此时,,。

用Monte Carlo方法计算定积分

机投点。若点落在 y f (x) 下方称为中的,否则成为不中,则点中的概率为:

p ,若进行了N 次投点,其中n 次中的,则得到 的一个估计 M (b a)

1

M (b a)

n N

。

其实施步骤为:

1)独立产生2N 个U(0,1)的随机数 ui , vi ,i 1, 2,..., N;

2)计算 xi a ui (b a), yi Mvi 和 f (xi ) ;

10

0.9431

11

0.8474

12

0.4438

13

0.4385

14

0.6692

15

0.9327

16

0.2334

17

0.2148

18

0.9569

19

0.4379

20

0.5157

则满足条件 yi f (xi ) 的 yi 个数 n=12,利用公式(1)得到,所求积分的估计值为

M (b a) n 12 1.885 N 20

关个方面的 Monte Carlo 的使用,特别是在对数值结果的精确的讨论。 Monte Carlo 理论的应用非常广泛,由于作者的知识水平,研究能力有限,

Monte Carlo 理论在各行各业中都有广泛使用,思想、理论等方面仍存在欠缺之

处,但这些都是以后的努力研究的方向,有侍继续发掘。

参考文献: [1]曲双石,王会娟;MonteCarlo 方法及其应用[J];统计教育;2009.1. [2]柴中林,银俊成;蒙特卡罗方法计算定积分的进一步讨论[J];应用数学与 计算数学学报。2008.第 1 期. [3]张韵华,奚梅成,陈效群;数值计算方法与算法[M];科学出版社 2006.第 2 版.

蒙特卡罗方法计算定积分

蒙特卡罗方法计算定积分蒙特卡罗方法(Monte Carlo Method)是一种通过运用随机数抽样,利用计算机模拟实验来求解复杂问题的方法。

主要是利用概率统计中大数定律来求解,它可以帮助我们在数学上求解积分,快速准确的进行估计,被用在金融学,计算物理学,经济学,数学统计,技术分析等诸多领域。

一、蒙特卡罗方法计算定积分1、估计问题定义:计算一个未知函数积分。

2、随机抽样:由蒙特卡罗定理,我们在总体样本里进行随机抽样,随机抽取的样本可用与能够准确估计积分的概率多样性。

首先,创建一个具有期望值的随机变量,即函数中的随机变量,有且只有一个。

3、抽样的选择:抽样的选择非常重要,随机抽样的样本数量要远大于正常的定积分计算过程中要求的样本数量。

4、统计估计:通过蒙特卡罗方法,估计积分就是所抽样本的函数值的平均值乘以定积分范围。

二、蒙特卡罗方法容易出现的问题1、抽样样本量不够:如果抽样样本量不够,结果会出现较大误差,蒙特卡罗方法所估计值将可能与实际结果存在较大偏差。

2、估计值不够稳定:蒙特卡罗方法产生的结果一般存在很大的变动,估计值的结果可能会出现很大的波动,如果这种情况发生,就要调整抽样数量来达到稳定的结果。

3、结果不精确:由于蒙特卡罗方法依赖于随机样本,对精确度的要求很高,如果抽样数量不够,很可能出现精度较差的情况。

三、蒙特卡罗方法计算定积分的优点1、随机变量可定义:由于蒙特卡罗方法是基于随机变量的,所以可以通过定义方法来求出任意函数的定积分。

2、结果准确:在合理的的抽样数量下,蒙特卡罗方法的估计结果都基本准确。

3、实用性强:蒙特卡罗方法不仅实用于算法应用,还可以用于复杂估计。

四、总结蒙特卡罗方法是一种基于随机变量的,主要用于求解数学和经济类问题的方法。

它具有计算定积分快速准确、估计值结果可靠、实用性强等优点,是复杂问题求解的重要工具。

但同时也存在诸如抽样数量不足、估计值不稳定和精度较低等问题,因此在使用时要醉倒,确保估计结果的准确性。

蒙特卡罗(MonteCarlo)方法算积分

蒙特卡罗(MonteCarlo)方法算积分❝蒙特卡罗(Monte Carlo)是摩纳哥最著名的一区,以豪华的赌场闻名于世,用它作为名字大概是因为随机性,就像赌博场里面的扔骰子的过程。

最早的「蒙特卡罗方法」是为了解决一些难求解的积分问题。

❞•「问题」•「蒙特卡洛方法」如果可以选择在的概率分布函数,则有:若在之间是均匀分布时,即,那么:这就是之前讲解的平均值法(点击跳转),另外随机投点法(点击跳转)也是「蒙特卡洛方法」. 一般均匀分布并不是好选择,因为如果在有不少点使得,那么这些点对的近似计算贡献很小,所以应尽可能少用这些点. 此时就需要采用「重要采样方法」选择合适的,从而提高精度,这部分内容我们后续会详细阐述,这次我们先分析「随机投点法」和「平均值法」的随机误差.•「误差分析」(1)「随机投点法」令且,则 iid . 由中心极限定理知:从而所以因此的随机误差为:.(2)「平均值法」由中心极限定理知:其中因此的随机误差为:,但其渐近方差更小.类似的,计算高维定积分的蒙特卡罗方法的随机误差也为,所以蒙特卡罗方法计算积分和维数关系不大,但数值积分则存在「维数诅咒」问题,这也是蒙特卡罗方法的「优势」.•「高维积分算例」「以下为Python代码」import numpy as npfrom scipy import integrate## (x1)^2(x2)^2(x3)^2 在 [0,1] 的积分a1,b1 = 0,1a2,b2 = 0,1a3,b3 = 0,1# 三重积分计算def f(x1,x2,x3):return x1**2 * x2**2 * x3**2I_exact, Error = integrate.tplquad(f,a1,b1,a2,b2,a3,b3)# 平均值法N = 10000x1_sample = a1 + (b1-a1)*np.random.rand(N)x2_sample = a2 + (b2-a2)*np.random.rand(N)x3_sample = a3 + (b3-a3)*np.random.rand(N)np.random.seed(1)h_x = f(x1_sample,x2_sample,x3_sample)I_approx_stat = (b3-a3)*(b2-a2)*(b1-a1)/N*np.sum(h_x)# 数值积分M = 200h1 = (b1-a1)/(M-1)h2 = (b2-a2)/(M-1)h3 = (b3-a3)/(M-1)x1 = np.linspace(a1,b1,M)x2 = np.linspace(a2,b2,M)x3 = np.linspace(a3,b3,M)x1_mesh, x2_mesh, x3_mesh = np.meshgrid(x1,x2,x3)I_approx_rec = np.sum( f(x1_mesh, x2_mesh, x3_mesh)*h1*h 2*h3 )print( '多重积分值:', I_exact )print( '\n平均值法结果:', I_approx_stat )print( '\n数值积分结果:', I_approx_rec )❝多重积分值:0.037037037037037035平均值法结果:0.03737256369148107数值积分结果:0.03788231093787493(大家可尝试画出:不同数量采样点对应的结果和真实值之间的关系图)❞。

MonteCarlo(蒙特卡洛算法)算法

用Monte Carlo 计算定积分

考虑积分

I

x 1exdx,

0

0.

假定随机变量具有密度函数

fX (x) ex,

则

I E( X 1).

用Monte Carlo 计算定积分-

2

2

T

T

Monte Carlo 模拟连续过程的欧式 期权定价-

均匀分布

R=unidrnd(N),-产生1到N间的均匀分布随 机数

R=unidrnd(N,n,m),产生1到N间的均匀分布 随机数矩阵

连续均匀分布

R=unifrnd(A,B) -产生(A,B)间的均匀分布随 机数

R=unifrnd(A,B,m,n)产生(A,B)间的均匀分布 随机数矩阵

Matlab 的随机数函数-

正态分布随机数

R=normrnd(mu,sigma) R=normrnd(mu,sigma,m) R=normrnd(mu,sigma,m,n)

特定分布随机数发生器 R=random(‘name’,A1,A2,A3,m,n)

例

a=random(‘Normal’,0,1,3,2) a=

基本思想和原理

基本思想:当所要求解的问题是某种事件出现 的概率,或者是某个随机变量的期望值时,它 们可以通过某种“试验”的方法,得到这种事 件出现的频率,或者这个随机变数的平均值, 并用它们作为问题的解。

原理:抓住事物运动的几何数量和几何特征, 利用数学方法来加以模拟,即进行一种数字模 拟实验。

实现从已知概率分布抽样

构造了概率模型以后, 按照这个概率分 布抽取随机变量 (或随机向量),这一 般可以直接由软件包调用,或抽取均匀 分布的随机数构造。这样,就成为实现 蒙特卡罗方法模拟实验的基本手段,这 也是蒙特卡罗方法被称为随机抽样的原 因。

蒙特卡洛(MonteCarlo)法求定积分

蒙特卡洛(MonteCarlo)法求定积分蒙特卡洛(Monte Carlo)法是⼀类随机算法的统称。

随着⼆⼗世纪电⼦计算机的出现,蒙特卡洛法已经在诸多领域展现出了超强的能⼒。

在机器学习和⾃然语⾔处理技术中,常常被⽤到的MCMC也是由此发展⽽来。

本⽂通过蒙特卡洛法最为常见的⼀种应⽤——求解定积分,来演⽰这类算法的核⼼思想。

⽆意识统计学家法则(Law of the unconscious statistician)这是本⽂后续会⽤到的⼀个定理。

作为⼀个预备知识,我们⾸先来介绍⼀下它。

先来看⼀下维基百科上给出的解释。

In probability theory and statistics, the law of the unconscious statistician (sometimes abbreviated LOTUS) is a theorem used to calculate the 期望值 of a function g(X)" role="presentation" style="position: relative;">g(X)g(X) of a 随机变量 X"role="presentation" style="position: relative;">XX when one knows the probability distribution of X" role="presentation" style="position: relative;">XX but one does not explicitly know the distribution of g(X)" role="presentation" style="position: relative;">g(X)g(X). The form of the law can depend on the form in which one states the probability distribution of the 随机变量 X"role="presentation" style="position: relative;">XX.If it is a discrete distribution and one knows its PMF function ƒX" role="presentation"style="position: relative;">ƒXƒX (but not ƒg(X)" role="presentation" style="position: relative;">ƒg(X)ƒg(X)), then the 期望值 of g(X)" role="presentation" style="position: relative;">g(X)g(X) isE[g(X)]=∑xg(x)fX(x)" role="presentation" style="position:relative;">E[g(X)]=∑xg(x)fX(x)E[g(X)]=∑xg(x)fX(x)where the sum is over all possible values x" role="presentation" style="position: relative;">xx of X" role="presentation" style="position: relative;">XX.If it is a continuous distribution and one knows its PDF function ƒX" role="presentation">ƒXƒX (but not ƒg(X)" role="presentation">ƒg(X)ƒg(X)), then the 期望值 of g(X)"role="presentation">g(X)g(X) isE[g(X)]=∫−∞∞g(x)fX(x)dx"role="presentation">E[g(X)]=∫∞−∞g(x)fX(x)dxE[g(X)]=∫−∞∞g(x)fX(x)dxLOTUS到底表达了⼀件什么事呢?它的意思是:已知随机变量X" role="presentation"style="position: relative;">XX的概率分布,但不知道g(X)" role="presentation" style="position: relative;">g(X)g(X)的分布,此时⽤LOTUS公式能计算出函数g(X)" role="presentation"style="position: relative;">g(X)g(X)的数学期望。

第八章 Monte Carlo积分

1. Hit-or-Miss Method

推广到多重积分:

1 2 d I g ( x )dx g ( x1 , x2 ,, xd )dx1dx2 dxd a a1 , a2 ,, ad b b1 , b2 ,, bd g ( x ) 0, h g Method

I Vd E[ g ( X )]

X 在积分域Vd上均匀分布

产生容量为n的X的随机样本Xi,并计算g(Xi),则根据大数定 理,当n足够大时

1 E[ g ( X )] n Vd I In n

g( X )

i 1 i

n

g( X )

2

2. Sample Mean Method 一维积分的情况:

1 I g ( x)dx (b a) g ( x) dx a a ba (b a) E[ g ( X )]

b b

(b a) ˆ I I n (b a) E[ g ( X )] n

2 In

n

where X1, X2, …, Xn are n independent unif(0,3)’s.

2. Sample Mean Method

Simulation Results:

Simulation

1

true = 19.08554, n=100,000

ˆ I

19.10724

2

3 4 5

ˆp ˆ h(b - a) I

ˆ is our estimate of p where p

1. Hit-or-Miss Method

We can easily estimate p:

throw N “uniform darts” at the rectangle

Monte Carlo方法及在计算积分和古典概率方面的应用

Monte Carlo方法及在计算积分和古典概率方面的应用王坤【摘要】介绍了Monte Carlo方法的思想,主要在定积分计算方面介绍了随机投点法和平均值法,并将其推广到二重积分、三重积分和多重积分情形,最后以棋手分奖金问题介绍了Monte Carlo方法在古典概率中的应用.分析了误差,介绍了减少误差的方法.给出这些方法的实例及其Mathematica实现程序.【期刊名称】《曲靖师范学院学报》【年(卷),期】2010(029)003【总页数】6页(P33-38)【关键词】Monte Carlo方法;积分计算;古典概率;模拟【作者】王坤【作者单位】曲靖师范学院,数学与信息科学学院,云南,曲靖,655011【正文语种】中文【中图分类】O242.2Monte Carlo方法,源于第二次世界大战美国关于研制原子弹的“曼哈顿计划”.该计划的主持人之一、数学家冯·诺伊曼用驰名世界的赌城——摩纳哥的Monte Carlo来命名这种方法,为它蒙上了一层神秘色彩.Monte Carlo方法的基本思想很早以前就被人们所发现和利用.早在17世纪,人们就知道用事件发生的“频率”来决定事件的“概率”.19世纪人们用投针试验的方法来确定圆周率.20世纪40年代电子计算机的出现,特别是近年来高速电子计算机的出现,使得数学方法在计算机上大量、快速地模拟这样的试验成为可能.Monte Carlo方法研究的问题大致可分为两种类型:一种是问题本身就是随机的,另一种本身属于确定性问题,但可以建立它的解与特定随机变量或随机过程的数字特征或分布函数之间的联系,因而也可用随机模拟方法解决.文[1~7]介绍了Monte Carlo方法的思想,但没有给出具体的实例及实现过程.本文介绍了Monte Carlo方法的思想,从计算定积分和古典概率两方面的应用进行研究,给出了实例及其Mathematica实现程序.1.1 Monte Carlo方法思想概述Monte Carlo方法,有时也称随机模拟(Random Simulation)方法或统计试验(Statistical Testing)方法.它的基本思想是:首先建立一个概率模型或随机过程,使它的参数等于问题的解;然后通过对模型或过程的观察、抽样来计算所求参数的统计特征;最后给出所求解的近似值,而解的精度可用估计值的标准误差来表示.假设所求的量 x是随机变量ζ的数学期望E(ζ),那么近似确定x的方法是对ζ进行重复抽样,产生相互独立的ζ值的序列ζ1,ζ2,…,ζN并计算其算术平均值:根据大数定理,当充分大时以概率1成立,即可用作为x的估计值.Monte Carlo方法以概率统计理论为基础,以随机抽样(随机变量的抽样)为手段,在很多方面有重要的应用.它的优点表现在3个方面:方法和程序的结构简单,易分析、易理解;收敛的概率性和收敛速度与问题的维数无关,很好的避免了维数问题;受问题条件限制的影响较小,很好的提高可行性.使用Monte Carlo方法的步骤如下:(1)构造或描述概率过程.对于本身就具有随机性质的问题,主要是正确地描述和模拟这个概率过程.对于本来不是随机性质的确定性问题,就必须事先构造一个人为的概率过程,使它的某些参量正好是所要求解问题的解(将不具有随机性质的问题,转化为随机性质的问题).(2)实现从已知概率分布中抽样.由于各种概率模型都可以看作是有各种各样的概率分布构成的,因此产生己知概率分布的随机变量,就成为实现Monte Carlo方法模拟试验的基本手段.(3)建立各种估计量.一般说来,构造了概率模型并能从中抽样后,即能实现模拟试验后,就要确定一个随机变量,作为所要求的问题的解的估计量.在Monte Carlo计算中,使用最多的是无偏估计.建立各种估计量,相当于对模拟试验的结果进行考察和登记,从中得到问题的解.1.2 Monte Carlo方法的可行性从Monte Carlo方法的基本思想可以得到它通常的做法,利用数学或物理方法产生[0,1]中均匀分布的随机数,再变换得到任意分布的随机数.随机数个数很大时,可以由大数定理求出事件的概率值.这种做法的可行性主要依据下面的事实:(1)如果随机变量ε的分布函数是F(x),由于 F(x)非降.对于任意的y(0<y<1),可以定义:F-1(y)=f{x:F(x)>y}作为 F(x)的反函数.我们考虑随机变量η=F(ζ)的分布,这里假定 F(x)是连续函数,则对于0≤x≤1有:即η=F(ζ)服从[0,1]上的均匀分布.(2)反之,如果服从[0,1]上的均匀分布,则对于任意的分布函数 F(x),令ζ=F-1(η),则: 因此ε是服从分布函数F(x)的随机变量.所以我们只要能够产生[0,1]中均匀分布的随机变量的子样,那么通过(2)式我们就可以得到任意分布函数 F(x)的随机变量的子样.再结合大数定理,就可以运用Monte Carlo方法进行随机模拟,解决一些实际的问题.2.1 随机投点法对于定积分为使计算机模拟简单起见,设 a,b有限,0≤f(x)≤M,令Ω ={(x,y)∶a≤x≤b,0≤y≤M},并设(X,Y)是在Ω上均匀分布的二维随机变量,其联合密度函数为是Ω中曲线y=f(x)下方的面积.假设我们向Ω中进行随机投点.若点落在y =f(x)下方(即 y<f(x))称为中的,否则称不中.则点中的概率为P= θ,若我们进行M(b-a) n次投点,其中 n0次中的.则可以得到θ的一个估计:该方法的具体计算步骤为:独立地产生2n个U(0,1)随机数ui,vi,i=1,…,n;计算xi=a +ui(b-a),yi=Mvi和f(xi);统计f(xi)≥yi的个数 n0;用(3)估计θ.例1 1777年,法国学者Buffon提出用试验方法求圆周率π的值.原理如下:假设平面上有无数条距离为1的等距平行线,现向该平面随机地投掷一根长度为l(l≤1)的针.则我们可以计算该针与任一平行线相交的概率.此处随机投针可以这样理解:针中心与最近的平行线间的距离 x均匀地分布在区间[0, 1/2]上,针与平行线间的夹角φ(不管相交与否)均匀地分布在区间[0,π]上(如图1).于是,针与线相交的充要条件是从而针线相交概率为:而由大数定律可以估计出针线相交的概率其中n为掷针次数,m为针线相交次数,从而圆周率其Mathematica实现语句见附录1.历史上曾有几位学者做过这样的试验,结果如表1所示.Buffon投针试验由于当时条件的落后,随机试验中误差比较大,精确度不高(Lazzarini的试验精度很高纯属巧合).2.2 样本平均值法对于积分设 g(x)是(a,b)上的一个密度函数,改写由矩法,若有 n个来自g(x)的观测值,则可给出θ的一个矩估计,这便是样本平均值法的基本原理.若a,b有限,可取设x,…,1该方法的具体计算步骤为:独立地产生 n个U(0,1)随机数u1,…,un;计算xi=a+ui(ba)和f(xi),i=1,…,n;用(5)估计θ.后面将给出一个例子说明此方法的应用. xn是来自U(a,b)的随机数,则θ的一个估计为方法1其中Ω0为 S维单位立方体,{0≤xi≤1,i =1,2,…,S},在Ω0上有:0≤g(x1,x2,…,xi)≤1.很明显.此时积分(5)可以看作为求S+1维空间长方体V:Ω0×[0,g(x1,x2,…,xs)]的体积.即:对于这种较为一般形式的多重积分计算问题,采用的还是随机投点.具体步骤如下:首先产生S+1个随机数ζi(i=1,2,…,S)及η,构造S+1维随机向量η),然后检验ε是否落后在V中,同理可以推论.检验η≤g(ζ1,ζ2,…,ζs)是否成立,如果在构成的N个随机向量ζ中,有m个随机向量落于V中,那么取作为积分的近似值,即如果积分区域及被积函数不满足上述条件,那么可以通过变换达到所希望的条件.其中积分区域Ω包含在K维多面体中,此多面体决定于 K个不等式ai≤xi≤bi(i=1,2,…,K).设函数f(x1,x2,…,xk)在Ω内连续且满足条件:0≤f(x1,x2,…,xk)≤M,N是在K+1维多面体Ωx[0,M]中均匀分布的随机质点的个数,n是在N个随机点之中落入以K维区域V为底以Z=f(x1,x2,…,xk)为顶之曲顶柱体内的随机点的个数.这里Ωx[0,M]表示由不等式ai≤xi≤bi(i =1,2,…,K)和0≤Z≤M决定的K+1维多面体.则 K重积分的Monte Carlo近似计算公式为:例2 在三维空间中,由三个圆柱面:x2+ y2=1,x2+z2=1,y2+z2=1围成一个立体,利用Monte Carlo方法求它的体积.分析:据题意,所求体积中考虑在空间Ω内随机的产生n个点,落在空间内有m个,则在Mathematica中模拟程序见附录2.在生产、生活中概率是用于描述不确定性事件发生的可能性的大小,对于一些比较简单的随机事件的概率计算问题,我们可以通过比较常用的概率计算公式进行准确计算.但是随着研究问题的深入和事件本身的复杂性,直接导致了概率计算的困难,甚至无法计算.但由于计算机技术的发展,近代发展起来的Monte Carlo方法在复杂的事件的概率计算中起了十分重要的作用.下面的例子说明了Monte Carlo方法在古典概率中的应用.例3 甲乙两位棋手棋艺相当,现他们在一项奖金为1000元的比赛中相遇,比赛为5局3胜制,已经进行了3局的比赛,结果为甲2胜1负,现因故要停止比赛,问应该如何分配这1000元比赛奖金才算公平?分析:平均分对甲欠公平,全归甲则对乙欠公平.合理的分法是按一定的比例分配.现在我们用计算机模拟两位棋手后面的比赛,就可以知道奖金分配方案.由于两位棋手的棋艺相当,可以假定他们在以下每局的比赛胜负的机会各半.Mathematica中函数产生随机数0或1,0与1出现的机会各占一半,可以用随机数1表示甲棋手胜,而随机数0表示乙胜.(也可以用[0,1]中的随机实数来模拟两人的胜负,随机数大于0.5表示甲胜,否则乙胜)连续模拟1000次(或更多次数)每次模拟到甲乙两方有一方胜了三局为止.按所说方案分配奖金,1000次模拟结束后,计算两棋手每次的平均奖金,就是该棋手应得的奖金.模拟结果:甲:750,乙:250(程序见附录1)最终以甲分到;乙分到即甲750元,乙250元.实际上,因为比赛只需进行两局.则可分出胜负.结果无非是以下4种情况之一:甲甲、甲乙、乙甲、乙乙.上面4种情况可看出,甲获胜的概率为乙获胜的概率为在Mathematica中模拟程序见附录3.5.1 收敛性蒙特卡罗方法是由随机变量 X的简单子样x1,x2,…,xn的算术平均值作为所求解的近似值.由大数定律可知,如x1,x2,…,xn独立同分布,且具有有限期望值(E(X)< ∞),则即随机变量X的简单子样的算术平均值,当子样数N充分大时,以概率1收敛于它的期望值 E(X).5.2 误差蒙特卡罗方法的近似值与真值的误差问题,概率论的中心极限定理给出了答案.该定理指出,如果随机变量序列X1,X2,…,XN独立同分布,且具有有限非零的方差σ2,即f(X)是 X的分布密度函数.则当N充分大时,有如下的近似式其中α称为置信度,1-α称为置信水平.这表明,不等式近似地以概率1-α成立,且误差收敛速度的阶为 O(N-1/2).通常,Monte Carlo方法的误差ε定义为上式中λα与置信度α是一一对应的,根据问题的要求确定出置信水平后,查标准正态分布表,就可以确定出λα.下面给出几个常用的α与λα的数值:关于蒙特卡罗方法的误差需说明两点:第一,蒙特卡罗方法的误差为概率误差,这与其他数值计算方法是有区别的.第二,误差中的均方差σ是未知的,必须使用其估计值来代替,在计算所求量的同时,可计算出例4 用平均值法估计圆周率π,并考虑置信度为5%,精度要求为0.01的情况下所需的试验次数.解:易知故考虑令 X~ U(0,1),令其期望值为因此其中xi是[0,1]区间上均匀分布的随机数.此时,α=0.05,Zα/2=1.96,ε=0.01/4,所以5.3 减小方差的各种技巧显然,当给定置信度α后,误差ε由σ和N决定.要减小ε,或者是增大 N,或者是减小方差σ2.在σ固定的情况下,要把精度提高一个数量级,试验次数N需增加两个数量级.因此,单纯增大N不是一个有效的办法.另一方面,如能减小估计的均方差σ,比如降低一半,那误差就减小一半,这相当于 N 增大4倍的效果.因此降低方差的各种技巧,引起了人们的普遍注意.一般来说,降低方差的技巧,往往会使观察一个子样的时间增加.在固定时间内,使观察的样本数减少.所以,一种方法的优劣,需要由方差和观察一个子样的费用(使用计算机的时间)两者来衡量.这就是蒙特卡罗方法中效率的概念,它定义为σ2c,其中c是观察一个子样的平均费用.显然σ2c越小,方法越有效.总的来说,增大样本n的值对计算机要求较高;减小方差的技巧都只具有指导思想上的意义.对于实际的计算问题,往往要求对涉及的随机变量有先验的了解,或者对发生的物理过程的性态有一定的认识.通过利用这些预知的信息采取相应的手段减小误差,提高精度.附录【相关文献】[1]徐钟济.蒙特卡罗方法[M].上海科学技术出版社, 1985:171~188.[2]茆诗松,王静龙,濮晓龙.高等数理统计[M].北京:高等教育出版社,2006:415~454.[3]周铁,徐树方,张平文,等.计算方法[M].吉林:清华大学出版社,2006:299~353.[4]李尚志,陈发来,张韵华,等.数学实验[M].北京:高等教育出版社,2004:23~30.[5]王岩.Monte Carlo方法应用研究[J].云南大学学报(自然科学版),2006,28(S1):23~26.[6]薛毅,陈立萍.统计建模与R软件[M].北京:清华大学出版社,2008:476~485.[7]杨自强.你也需要蒙特卡罗方法——提高应用水平的若干技巧[J].数理统计与管理,2007,27(2):355~376.。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

x

f ( x ) dx

x0

x0 h

f ( x ) dx

1 3

x0

h[ f ( x 0 ) 4 f ( x1 ) f ( x 2 )]

Monte Carlo method

E N

1 2

x1 x 0 x 2 x1 h

purely statistical, not rely on the dimension !

ˆ I z/2 s I ˆ

By the way…

Sample Mean Method

No one ever said that you have to use the uniform distribution Example:

b

I : x

a

1 /2

e

2x

dx

1

20

x

1 /2

2e

grid points add up quickly in high dimensions

bad choices of grid may misrepresent g(x)

第九章 Monte Carlo积分

Monte Carlo method can be used to compute

E ( M ) Np

2 ( M ) Np (1 P )

ˆ 2 ( Iˆ ) 2 p h ( b a ) 2 h (b a )

2 2

M ˆ ˆ E ( I ) E p h (b a ) E h (b a ) N h (b a ) N E ( M ) h (b a ) p I

Start Set N : large integer

s1 = 0, s2 = 0

Loop N times

xn = (b-a) un + a yn = (xn)

s1 = s1 + yn , s2 = s2 + yn2 Estimate mean m’=s1/N Estimate variance V’ = s2/N – m’2 End

Sample Mean Method

Simulation Results:

Simulation

1

true = 19.08554, n=100,000

ˆ I

19.10724

2

3 4 5

19.08260

18.97227 19.06814 19.13261

Don’t ever give an estimate without a confidence interval!

p : I h(b - a)

Hit-or-Miss Method

So, if we can estimate p, we can estimate I:

ˆ ˆ I ph(b - a)

ˆ where p is our estimate of p

Hit-or-Miss Method

We can easily estimate p:

ˆ Let I SM be the sample mean estimator of I

g(X1), g(X2), …, g(Xn) iid

Let Yi=g(Xi) for i=1,2,…,n Then

ˆ I (b - a) Y

and we can once again invoke the CLT.

For n “large enough” (n>30),

Sample Mean Method

Hit-or-Miss Method Sample Mean Method Variance Reduction Technique Variance Reduction using Rejection Technique

Importance Sampling Method

Sample Mean Method

2x

I[a, b](x) dx

1 2

EX

1 /2

I[a, b](X)

where X~exp(rate=2).

Sample Mean Method

Comparison of Hit-and-Miss and Sample Mean Monte Carlo

ˆ Let I HM be the hit-and-miss estimator of I

an approximation

ˆ I g(x i ) b a 2 (b - a) i 1 2 sI ˆ n n 1

n

Sample Mean Method

ˆ I (b - a)

g(X ) n

i i 1

1

n

X1, X2, …, Xn iid ->

This estimator is “unbiased”:

Sample Mean Method

1 n ˆ] E (b - a) E[I g(X i ) n i 1

(b - a)

b

E[g(X n

i 1

1

n

i

)]

b

(b - a)

g(x) b - a dx n

SM error

I

( b a ) 0 . 6745

V' N

Sample Mean Method

b

I g(x) dx

a

Write this as:

b b

I g(x) dx (b - a) g(x)

a a

1 b-a

dx

(b - a) Eg(X)

where X~unif(a,b)

I = (b-a) h (M/N)

End

Hit-or-Miss Method

Error Analysis of the Hit-or-Miss Method It is important to know how accurate the result of simulations are note that M is binomial(M,p)

Sample Mean Method

(b - a)

2

n 2 (b - a)

n

Var[g(X1 )]

(indent)

2

(b - a) n

a 2 b

g(x) E[g(X)]

2

b

1 b-a

dx

I 1 g(x) b - a b - a dx a

Sample Mean Method

Importance Sampling Method

Hit-or-Miss Method

• Evaluation of a definite integral

I

b

( x )dx

h

X X X X X X O

a

h ( x ) for any x

•Probability that a random point reside inside the area

第九章 Monte Carlo积分

Goal: Evaluate an integral:

b

I g(x) dx

a

Why use random methods? Computation by “deterministic quadrature” can become expensive and inaccurate.

M=0

h

X X X X X X O O O O O O O

Loop N times

Choose a point x in [a,b]

x ( b a ) u1 a y hu 2

a

Choose a point y in [0,h]

b

if [x,y] reside inside then M = M+1

2 ˆ I N(I, I ) ˆ

So, a confidence interval for I is roughly given by

ˆ I z/2 I ˆ

but since we don’t know I , we’ll have to be ˆ content with the further approximation:

Sample Mean Method

Example:

3

Ie answer is e3-1

19.08554)

write this as

3

I 3 e

0

x

1 3

dx 3E[e ]

where X~unif(0,3)

X

Sample Mean Method

Sample Mean Method

I (b - a) Eg(X)

where X~unif(a,b)

So, we will estimate I by estimating E[g(X)] with

ˆ E[g(X)]

g(X ) n

i i 1

1

n

where X1, X2, …, Xn is a random sample from the uniform(a,b) distribution.

Monte Carlo method WINS, when d >> 3

第九章 Monte Carlo积分

Hit-or-Miss Method Sample Mean Method Variance Reduction Technique Variance Reduction using Rejection Technique