人工神经网络-SVM-深度学习简介

人工神经网络教学课件

Hinton等人提出了深度学习的概念,使得神经网络的层次和参数数量大大增加,提高了模型的表示能力和泛化能力。

1997年

Bengio等人提出了卷积神经网络(CNN),用于图像识别和处理。

感知机模型:由输入层、隐藏层和输出层组成,通过权重和激活函数实现非线性映射,完成分类或识别任务。

人工神经网络的基本结构

人工神经网络教学课件

目录

CONTENTS

人工神经网络简介人工神经网络的基本结构常见的人工神经网络模型人工神经网络的训练与优化人工神经网络的应用场景人工神经网络的未来展望

人工神经网络简介

人工神经网络是一种模拟生物神经网络结构和功能的计算模型,由多个神经元相互连接而成,通过训练和学习来处理和识别数据。

适用于小样本数据集和高维数据集

支持向量机在小样本数据集和高维数据集上表现良好,因为它主要基于数据的内积运算,而不是计算输入空间中的距离。这使得它在文本分类、生物信息学等领域得到广泛应用。

核函数的选择对模型性能影响较大

支持向量机通过核函数将输入空间映射到高维特征空间,然后在这个空间中找到最优决策边界。不同的核函数会导致不同的决策边界,因此选择合适的核函数对模型性能至关重要。

总结词

自然语言处理是人工神经网络的另一个应用领域,通过训练神经网络理解和生成自然语言文本,实现文本分类、情感分析、机器翻译等功能。

自然语言处理是利用人工神经网络对自然语言文本进行分析、理解和生成,广泛应用于搜索引擎、智能问答、新闻推荐等领域。通过训练神经网络理解和生成自然语言文本,可以实现文本分类、情感分析、机器翻译等功能,提高自然语言处理的准确性和效率。

人工神经网络具有自适应性、非线性、并行处理和鲁棒性等特点,能够处理复杂的模式识别和预测问题。

深度学习(Deep Learning)综述及算法简介

Yoshua Bengio, Pascal Lamblin, Dan Popovici and Hugo Larochelle, Greedy Layer-Wise Training of Deep Networks, in J. Platt et al. (Eds), Advances in Neural Information Processing Systems 19 (NIPS 2006), pp. 153-160, MIT Press, 2007

The ICML 2009 Workshop on Learning Feature Hierarchies webpage has a list of references.

The LISA public wiki has a reading list and a bibliography.

Geoff Hinton has readings from last year’s NIPS tutorial.

对于表达sin(a^2+b/a)的流向图,可以通过一个有两个输入节点a和b的图表示,其中一个节点通过使用a和b作为输入(例如作为孩子)来表示b/a ;一个节点仅使用a 作为输入来表示平方;一个节点使用a^2 和b/a 作为输入来表示加法项(其值为a^2+b/a );最后一个输出节点利用一个单独的来自于加法节点的输入计算SIN的最长路径的长度。

传统的前馈神经网络能够被看做拥有等于层数的深度(比如对于输出层为隐层数加1)。SVMs有深度2(一个对应于核输出或者特征空间,另一个对应于所产生输出的线性混合)。

什么是人工智能常见的人工智能算法有哪些

什么是人工智能常见的人工智能算法有哪些人工智能(Artificial Intelligence,AI)已经成为当今科技领域的热点话题,其在各个领域的应用也越来越广泛。

而人工智能算法作为人工智能技术的核心,起到了决定性的作用。

本文将介绍人工智能的定义、常见的人工智能算法以及其应用领域。

一、人工智能的定义人工智能是指计算机系统具备类似人类智力的某些能力,能够感知、理解、学习和决策。

它通过模拟人类思维和智能能力的方式,实现像人类一样分析和解决问题的能力。

二、常见的人工智能算法1. 机器学习算法机器学习是人工智能领域的重要分支,旨在使计算机能够通过大量数据和经验,自动学习并改进性能。

常见的机器学习算法包括:- 监督学习(Supervised Learning):通过给定输入和期望的输出,训练算法来构建一个能够进行预测和分类的模型,如决策树算法、支持向量机(SVM)、神经网络等。

- 无监督学习(Unsupervised Learning):从未标记数据中学习模式和结构,对数据进行聚类、降维等处理,如聚类算法、主成分分析(PCA)等。

- 强化学习(Reinforcement Learning):利用奖惩机制,通过试错的方式来训练模型,使其逐步达到最佳性能,如Q学习、深度强化学习等。

2. 深度学习算法深度学习是机器学习的一种特殊形式,模仿人类大脑的神经网络。

它通过多个层次的神经元相互连接,进行特征提取和模式识别,能够处理海量的数据。

常见的深度学习算法包括:- 卷积神经网络(Convolutional Neural Network,CNN):主要用于图像和视频相关的任务,如图像分类、目标检测等。

- 循环神经网络(Recurrent Neural Network,RNN):适用于序列数据的处理,如自然语言处理、机器翻译等任务。

3. 自然语言处理算法自然语言处理(Natural Language Processing,NLP)是研究计算机与人类自然语言之间交互的领域。

人工智能算法工程师:深度学习与神经网络算法培训ppt

TensorFlow框架特点及使用方法

特点

TensorFlow是一个开源的深度学习框架,具有高度的灵活性 和可扩展性。它支持分布式训练,能够在多个GPU和CPU上 加速训练过程。TensorFlow还提供了丰富的API和工具,方 便用户进行模型开发和调试。

使用方法

使用TensorFlow进行深度学习需要先安装TensorFlow库,然 后通过编写Python代码来定义模型、加载数据、进行训练和 评估等操作。TensorFlow提供了高级的API,如Keras,可以 简化模型开发和训练过程。

PyTorch框架特点及使用方法

特点

PyTorch是一个轻量级的深度学习框架,具有简单易用的特点。它支持动态计算 图,使得模型开发和调试更加灵活。PyTorch还提供了GPU加速和分布式训练功 能,能够提高训练速度。

使用方法

使用PyTorch进行深度学习需要先安装PyTorch库,然后通过编写Python代码来 定义模型、加载数据、进行训练和评估等操作。PyTorch提供了高级的API,如 torch.nn和torch.optim,可以简化模型开发和训练过程。

模型可解释性不足

深度学习模型的可解释性一直是研究 难点。未来需要加强模型可解释性的 研究,以更好地理解模型的工作原理 。

THANKS。

将有更多创新方法被提出。

面临的挑战与解决方案探讨

数据隐私与安全

计算资源需求大

随着深度学习应用的广泛使用,数据 隐私和安全问题日益突出。需要采取 数据脱敏、加密等技术手段来保护用 户隐私。

深度学习模型的训练和推理需要大量 的计算资源,如高性能计算机、GPU 等。需要进一步优化算法和模型结构 ,以降低计算资源需求。

人工智能算法工程师:深度学习 与神经网络算法培训

专题技术总结范文

一、前言随着科技的不断发展,新技术、新应用层出不穷。

为了更好地把握技术发展趋势,提高自身技术能力,本人在过去的一段时间里,针对某一特定技术领域进行了深入研究。

现将这段时间的学习成果和技术总结如下:一、技术背景近年来,随着人工智能、大数据、云计算等技术的快速发展,我国在相关领域取得了举世瞩目的成果。

其中,深度学习作为一种重要的机器学习技术,在图像识别、自然语言处理等领域取得了显著的成果。

因此,本文以深度学习技术为研究对象,对其发展历程、原理、应用及未来趋势进行总结。

二、技术发展历程1. 人工神经网络阶段(20世纪50-60年代)人工神经网络是深度学习的起源,这一阶段主要研究如何通过人工构建神经网络来模拟人脑的智能行为。

然而,由于计算能力和算法的限制,这一阶段的神经网络性能有限。

2. 支持向量机阶段(20世纪90年代)为了提高神经网络的性能,研究人员开始尝试使用支持向量机(SVM)等算法来处理分类问题。

这一阶段,神经网络与SVM等算法相结合,在图像识别等领域取得了较好的效果。

3. 深度学习阶段(21世纪初至今)随着计算能力的提升和算法的改进,深度学习技术逐渐崭露头角。

以卷积神经网络(CNN)和循环神经网络(RNN)为代表的深度学习模型在图像识别、自然语言处理等领域取得了突破性进展。

三、技术原理深度学习技术主要包括以下几个核心概念:1. 神经网络:神经网络是深度学习的基础,由多个神经元组成,每个神经元负责处理一部分输入数据,并通过权重连接形成网络。

2. 激活函数:激活函数用于引入非线性因素,使神经网络具备非线性映射能力。

3. 损失函数:损失函数用于衡量模型预测结果与真实值之间的差距,是优化神经网络参数的关键。

4. 反向传播算法:反向传播算法是一种用于优化神经网络参数的算法,通过计算损失函数对网络参数的梯度,实现参数的调整。

四、技术应用深度学习技术在各个领域得到了广泛应用,以下列举几个典型应用:1. 图像识别:深度学习在图像识别领域取得了显著成果,如人脸识别、物体检测等。

支持向量机与人工神经网络的对比与选择

支持向量机与人工神经网络的对比与选择在机器学习领域中,支持向量机(Support Vector Machine,SVM)和人工神经网络(Artificial Neural Network,ANN)是两种常见的分类算法。

它们都具有各自的优势和适用场景,本文将对它们进行对比与选择。

支持向量机是一种基于统计学习理论的二分类模型。

它的核心思想是通过找到一个最优超平面,将不同类别的样本分隔开。

SVM能够处理高维特征空间中的非线性问题,并且对于小样本集合具有较好的泛化能力。

其数学基础是凸优化理论和统计学习理论,因此在理论上具有较强的支撑。

人工神经网络是一种模拟生物神经网络的计算模型,它由大量的神经元和连接它们的权值组成。

ANN通过学习样本的输入和输出之间的关系,构建一个复杂的非线性映射模型。

它具有较强的自适应性和容错性,在处理大规模数据集和复杂问题时表现出色。

在对比两者时,首先需要考虑数据集的特点和问题的复杂度。

如果数据集具有较高的维度和复杂的非线性关系,SVM通常能够提供较好的分类效果。

而ANN在处理大规模数据集和复杂问题时更具优势,尤其是在图像识别、语音识别等领域有着广泛的应用。

其次,对于训练时间和计算资源的要求也需要考虑。

SVM的训练时间较短,尤其是在小样本集合上表现出色。

而ANN的训练时间较长,尤其是在大规模数据集上需要较多的计算资源。

因此,在资源受限的情况下,SVM可能是更好的选择。

此外,对于模型的解释性和可解释性要求也是选择的考虑因素之一。

SVM通过支持向量和超平面的概念,能够直观地解释模型的决策过程。

而ANN的结构较为复杂,很难进行直观的解释。

因此,在需要对模型进行解释和理解的场景下,SVM可能更适合。

最后,还需要考虑算法的实现和应用的成熟度。

SVM作为一种经典的机器学习算法,已经有了成熟的理论和实现,有很多开源的工具包可供使用。

而ANN的应用相对较新,尤其是在深度学习领域,仍然存在一些挑战和问题需要解决。

《计算机视觉》教学课件 第08章1-神经网络和深度学习1

• 输入特征

➢添加了两个表示中间值的“隐藏层” ➢将输出表示为输入的函数并进行简化时

• 只是获得输入的另一个加权和

➢仍然是一个线性模型

• 无法解决非线性问题

2024/7/13

41

神经网络基本概念 – 非线性问题

➢“非线性”意味着无法使用形式为“b + w1x1 + w2x2”的模型准确预测标签

2024/7/13

28

C ONTENTS

01

引言

02 神经网络和深度学习简史

03

神经网络基本概念

04

深度学习基本概念

05

使用和训练神经网络

深度学习之前

2024/7/13

30

神经网络基本概念 – 生物神经网络

➢生物神经网络

• 一般指生物的大脑神经元、细胞、触点等组成的网络 • 用于产生生物的意识 • 帮助生物进行思考和行动

2024/7/13

16

神经网络和深度学习简史

➢1982年

• 著名物理学家John Hopfield发明了Hopfield神经网络

2024/7/13

17

神经网络和深度学习简史

➢Hopfield神经网络是一种结合存储系统和二元系统的循环神经网络

• 可以模拟人类的记忆 • 根据激活函数的选取不同,有连续型和离散型两种类型,分别用于优化计算和联想记忆 • 容易陷入局部最小值的缺陷,该算法并未在当时引起很大的轰动

2024/7/13

27

神经网络和深度学习简史

➢2016-2017年

• Google的AlphaGo • 4:1的比分战胜了国际顶尖围棋高手李世石 • 随后战胜了一众高手 • AlphaGo升级版AlphaGo Zero • “从零开始”、“无师自通”的学习模式 • 以100:0的比分轻而易举打败了之前的AlphaGo

人工智能的算法模型

人工智能的算法模型人工智能的算法模型在近几年发展非常迅速,涵盖了诸多领域,包括机器学习、深度学习、神经网络等。

这些算法模型的发展使得人工智能能够实现更多复杂的任务,如图像识别、语音识别、自然语言处理等。

下面将介绍几种常见的人工智能算法模型。

一、机器学习算法模型1. K近邻算法(K-Nearest Neighbors,KNN):KNN是一种非参数的分类和回归算法,它通过在特征空间中寻找最近的K个邻居,利用它们的标签或者属性进行分类或回归预测。

2. 决策树算法(Decision Tree):决策树是一种基于树状结构的分类方法,它通过对特征进行逐步分割,生成一棵树,从而对样本进行分类。

3. 支持向量机算法(Support Vector Machine,SVM):SVM是一种二分类算法,它通过将数据映射到高维空间中,找到一个最优超平面,将样本分为不同的类别。

4. 朴素贝叶斯算法(Naive Bayes):朴素贝叶斯算法是一种基于贝叶斯定理的分类算法,它假设特征之间独立,并利用贝叶斯准则进行分类。

5. 随机森林算法(Random Forest):随机森林是一种基于集成学习的分类和回归算法,它通过多个决策树的投票结果进行分类或回归预测。

二、深度学习算法模型1. 人工神经网络(Artificial Neural Network,ANN):ANN是一种受到生物神经网络启发的模型,它通过模拟神经元之间的连接关系,进行模式识别和模式生成。

2. 卷积神经网络(Convolutional Neural Network,CNN):CNN是一种专门用于处理二维图像数据的神经网络模型,它通过卷积、池化和全连接等操作,提取图像特征并实现分类或回归任务。

3. 循环神经网络(Recurrent Neural Network,RNN):RNN 是一种具有反馈机制的神经网络模型,它能够处理序列数据,通过记忆先前的状态信息,对后续的输入进行预测或分类。

大数据技术之深度学习

CNN样例

AlexNet

在ImageNet举办的大规模图像识别比赛ILSVRC2012中分类比赛中,Hinton的学 生Alex搭建了一个8层的CNN,最终top-5的漏报率是16%,抛离而第二名的27% 整整有11个百分点。

包括5个卷积层,和3个全连接层,最后一个softmax分类器

卷积神经网络

存在的问题:

1.由于网络参数增多,导致了严重的过拟合现象

2.在训练过程中,梯度消失,导致前面的网络得不到训练,网络难以收敛。

解决方案:

1.共享权值:卷积层的卷积核权值共享,大大减少了网络中参数的数量级。

2.加大数据量:一个是通过众包的方式来增加样本的量级,比如,目前ImageNet已经有了120万的 带标注的图片数据。另一个是通过对已有的样本进行随机截取、局部扰动、小角度扭动等方法,来 倍增已有的样本数。

3.对 算方法如下:

的各个层,第 层的第 个节点的残差计

神经网络

反向传播算法(Backpropagation algorithm)

将上式中的

与

的关系替换为 与

的关系,就可以得到:

反向传播

4. 我们要计算的偏导数求解如下:

典型深度网络

稀疏编码

输入 码值 重构

编码

解码

错误

样本 参数编码 参数基

CIFAR-10

50,000

10,000

32*32

分类

10类

CIFAR-100

50,000

Байду номын сангаас

10,000

32*32

分类

100类(精确) 20 类(粗糙) 8类 0~9手写字体 10类

LabelMe MNIST STL-10

深度学习知识:深度学习与传统机器学习的比较分析

深度学习知识:深度学习与传统机器学习的比较分析深度学习和传统机器学习是两种不同的机器学习方法。

传统机器学习方法包括支持向量机(SVM)、决策树、朴素贝叶斯、K-最近邻等,而深度学习是一种基于人工神经网络的机器学习方法。

本文将对深度学习和传统机器学习进行比较分析,比较它们在算法原理、特征提取、数据需求、应用领域等方面的差异。

算法原理传统机器学习算法是基于特征工程的方法,需要先对原始数据进行特征提取,然后使用分类、回归等算法进行模型训练。

而深度学习算法是基于多层神经网络的方法,通过多层非线性变换来学习数据的特征表示。

深度学习算法一般包括多层卷积神经网络(CNN)、循环神经网络(RNN)等,可以自动学习数据的特征表示,并在大规模数据上取得很好的表现。

特征提取传统机器学习方法需要人工进行特征提取,需要根据领域知识和经验来选择合适的特征。

这种方法需要大量的专业知识和经验,且很难处理高维、非线性的数据。

而深度学习方法可以自动学习数据的特征表示,无需人工提取特征,大大减少了特征工程的工作量,且对高维、非线性数据有较好的适应性。

数据需求传统机器学习方法通常需要大量的标记数据来进行训练,特别是在监督学习任务中。

这种方式会导致数据稀缺的问题,尤其是在一些领域知识不充分的情况下。

而深度学习方法可以通过大规模的未标记数据进行预训练,然后通过微调的方式来进行监督学习,从而减少了对标记数据的需求,提高了模型的泛化能力。

应用领域传统机器学习方法在一些领域有着良好的应用效果,如文本分类、图像识别、推荐系统等。

但在处理复杂、高维、非线性的数据时,传统方法往往表现不佳。

而深度学习方法在这些领域取得了很好的表现,如语音识别、自然语言处理、计算机视觉等。

深度学习方法的广泛应用使得它成为当前研究的热点之一。

总结综上所述,深度学习和传统机器学习在算法原理、特征提取、数据需求、应用领域等方面存在明显的差异。

传统机器学习需要人工进行特征提取,对标记数据的需求较大,难以处理高维、非线性数据;而深度学习方法可以自动学习数据的特征表示,通过大规模的未标记数据进行预训练,在处理复杂、高维、非线性数据时具有优势。

人工神经网络.pdf

y(t )(w(t − 1) ∗ x(t )) > 0 . y(t )(w(t − 1) ∗ x(t )) ≤ 0

( x (t ) 分错)

控制收敛速度的参数

5.1 感知机

学习算法收敛性:

对线性可分的数据有下面的定理。

定理(Novikoff):假设训练数据有界 x(i ) ≤ D, 两类样本的最大边界距离(maximal margin)为 2ρ (线性SVM)。则当学习速度参数η = 1 时, 2 次更新就会收敛。 D 感知机学习算法至多做

x2

x1 0 0 1 1

A

B

B

A

x1

5.2 多层感知机

解决XOR问题

x2

A

B

B

A

x1

5.2 多层感知机

两层神经网络解决XOR问题的真值表

第一层

x1 0 0 1 1

x2 0 1 0 1

y1 0 1 1 1

y2 0 0 0 1

第二 层 B(0) A(1) A(1) B(0)

y2

B

BLeabharlann Ay15.2 多层感知机

5.2 多层感知机

例: (XOR问题)

问题的提出以及重要性:

1956-1958年Rosenblatt提出感知机,是为了实现 另一种形式(模拟)的计算机。与数字计算机形 成鲜明对照。 数字计算机是用逻辑门电路实现的。逻辑门电路 的设计:AND, OR, NOT; 实际上,数字计算机的所有逻辑电路都是用XOR 门实现的。

MLPs具有一致逼近能力,因此可以学习这个函 数,也就解决了XOR问题。后面要讲到的RBF网 络也是一致逼近子,也可以解决XOR问题。

简述深度学习的概念

简述深度学习的概念深度学习(Deep Learning,DL)是指多层的人工神经网络和训练它的方法。

一层神经网络会把大量矩阵数字作为输入,通过非线性激活方法取权重,再产生另一个数据集合作为输出。

这就像生物神经大脑的工作机理一样,通过合适的矩阵数量,多层组织链接一起,形成神经网络“大脑”进行精准复杂的处理,就像人们识别物体标注图片一样。

深度学习是从机器学习中的人工神经网络发展出来的新领域。

早期所谓的“深度”是指超过一层的神经网络。

但随着深度学习的快速发展,其内涵已经超出了传统的多层神经网络,甚至机器学习的范畴,逐渐朝着人工智能的方向快速发展。

深度学习的基本思想假设我们有一个系统S,它有n层(S1,…Sn),它的输入是I,输出是O,形象地表示为:I =>S1=>S2=>…..=>Sn => O,如果输出O等于输入I,即输入I经过这个系统变化之后没有任何的信息损失,保持了不变,这意味着输入I经过每一层Si都没有任何的信息损失,即在任何一层Si,它都是原有信息(即输入I)的另外一种表示。

现在回到我们的主题Deep Learning,我们需要自动地学习特征,假设我们有一堆输入I(如一堆图像或者文本),假设我们设计了一个系统S (有n层),我们通过调整系统中参数,使得它的输出仍然是输入I,那么我们就可以自动地获取得到输入I的一系列层次特征,即S1,…, Sn。

对于深度学习来说,其思想就是对堆叠多个层,也就是说这一层的输出作为下一层的输入。

通过这种方式,就可以实现对输入信息进行分级表达了。

另外,前面是假设输出严格地等于输入,这个限制太严格,我们可以略微地放松这个限制,例如我们只要使得输入与输出的差别尽可能地小即可,这个放松会导致另外一类不同的Deep Learning方法。

上述就是Deep Learning的基本思想。

深度学习和浅层学习浅层学习是机器学习的第一次浪潮。

20世纪80年代末期,用于人工神经网络的反向传播算法(也叫Back Propagation算法或者BP算法)的发明,给机器学习带来了希望,掀起了基于统计模型的机器学习热潮。

人工神经网络

人工神经网络模型

人工单神经元模型:

➢(3) 一个非线性激活函数,起非线性映射作用,并将

神经元的输出幅度限制在一定范围内(比如(0,1)或 者(-1,+1)).

人工神经网络模型

人工单神经元模型:(常见的几类激活函数)

硬极限函数:

hardlims(x)=

1

1

x0 x0

线性函数:

purelin(x) x

对数S形函数:

log

si

g

(

x)

1

1 e

x

双曲正切S形函数:

tan si

g(x)

ex ex

ex ex

人工神经网络模型

前面的例子:

p1

w1

p2 w2

n

∑

a

f

p3

w3

b

其中 W w1 w2 w3 为权值向量, b 为偏置值,

或称为激励值; f 为激活函数,在前面的例子中采用

的激活函数为:

f

(

x)

1

1

x0 x0

14

人工神经网络模型

单神经元结构

p1

W1

p2

p3

∑n f a

…

pR

WR

R

n piwi b

i 1

W w1 w2

b 1

a f (n)

wR 为权值向量

人工神经网络模型

多神经元结构

p1

W1,1

p2 p3

∑

n1

1 b1

∑

n2

1 b2

f a1 f a2

… …

…

pR

Ws,R

R

ni p j wi, j bi j 1

机器学习的常见模型

机器学习任务中常见的方法有:决策树学习,关联规则学习,人工神经网络,深度学习,归纳逻辑设计,支持向量机,聚类,贝叶斯网络,强化学习,表示学习,相似度和度量学习,稀疏字典学习,遗传算法等。

一、决策树学习决策树学习就是根据数据的属性采用树状结构建立的一种决策模型,可以用此模型解决分类和回归问题。

常见的算法包括CART,ID3,C4.5等。

可以根据数据集来构建一颗决策树,他的重要任务就是根据数据中所蕴含的知识信息并提取出一系列的规则,这些规则就是树结构的创建过程。

决策树算法主要是指决策树进行创建中进行树分裂(划分数据集)的时候选取最优特征的算法,他的主要目的就是要选取一个特征能够将分开的数据集尽量的规整,也就是尽可能的纯。

最大的原则就是:将无序的数据变得更加有序。

常用的三个方法:信息增益增益比率基尼不纯度1、信息增益这里涉及到了信息论的一些概念:某个时间的信息量,信息熵,信息增益等。

a、某事件的信息量:这个事件发生的概率的负对数b、信息熵就是平均而言,一个事件发生得到的信息量大小,也就是信息量的期望值c、信息增益将一组数据集进行划分后,数据的信息熵会发生变化,我们可以通过使用信息熵的计算公式分别计算被划分的子数据集的信息熵并计算他们的平均值(期望值)来作为分割后的数据集的信息熵。

新的信息熵相比未划分数据的信息熵的减小值就是信息增益了。

假设我们将数据集D划分成k份D1,D2,...,Dk,则划分后的信息熵为:信息增益就是就两个信息熵的差值2、增益比率增益比率是信息增益方法的一种扩展,是为了克服信息增益带来的弱泛化的缺陷。

因为按照信息增益的选择,总是会倾向于选择分支多的属性,这样会使得每个子集的信息熵最小。

例如给每个数据添加独一无二的ID值特征,则按照这个ID值进行分类是获得信息增益最大的,这样每个自己中的信息熵都是0,但是这样的分类没有任何意义,没有任何泛化能力,类似于过拟合。

因此可以引入一个分裂信息找到一个更合适的衡量数据划分的标准,即增益比率。

支持向量机与深度学习的比较与选择

支持向量机与深度学习的比较与选择在机器学习领域中,支持向量机(Support Vector Machine,SVM)和深度学习(Deep Learning)是两个备受关注的算法。

它们在不同的问题上表现出色,但也有各自的优缺点。

本文将对支持向量机和深度学习进行比较,并探讨如何选择适合的算法。

一、支持向量机支持向量机是一种监督学习算法,主要用于分类和回归问题。

它的核心思想是找到一个最优超平面,将不同类别的样本分开。

SVM在处理小样本和高维数据时表现出色,具有较好的泛化能力。

SVM的优点之一是可以通过选择不同的核函数来适应不同的数据分布。

线性核函数适用于线性可分的问题,而非线性核函数如高斯核函数可以处理非线性问题。

这种灵活性使得SVM在处理复杂数据时具有较强的适应能力。

然而,SVM也存在一些缺点。

首先,SVM在处理大规模数据时的计算复杂度较高,训练时间较长。

其次,SVM对参数的选择较为敏感,需要进行调参来获得最佳结果。

此外,SVM对数据的噪声和异常值较为敏感,容易产生过拟合问题。

二、深度学习深度学习是一种基于人工神经网络的机器学习方法,通过多层次的神经网络模拟人脑的工作原理。

它在图像识别、语音识别、自然语言处理等领域取得了重大突破。

深度学习的优点之一是可以自动学习特征表示。

传统机器学习算法需要手动提取特征,而深度学习可以通过多层次的网络结构自动学习到更高级别的特征表示。

这种端到端的学习方式使得深度学习在处理复杂任务时更加有效。

此外,深度学习还具有较好的并行计算能力。

由于深度学习模型的并行性质,可以利用GPU等硬件设备来加速计算,提高训练和推理的效率。

然而,深度学习也存在一些挑战。

首先,深度学习模型通常需要大量的数据进行训练,对于数据量较小的问题可能会出现过拟合的情况。

其次,深度学习模型的可解释性较差,难以解释模型的决策过程。

此外,深度学习的训练过程较为复杂,需要较高的计算资源和时间成本。

三、比较与选择在选择支持向量机和深度学习时,需要考虑问题的特点和实际需求。

AI人工智能的 种常用算法

AI人工智能的种常用算法AI人工智能的几种常用算法人工智能(Artificial Intelligence,简称AI)是指通过一系列的算法和技术使计算机系统能够模拟人类智能行为的技术领域。

在AI的发展过程中,算法起到了非常重要的作用,它们是实现人工智能的核心。

本文将介绍几种常用的AI算法,包括监督学习算法、无监督学习算法、强化学习算法和深度学习算法。

1. 监督学习算法监督学习是指给定一组输入和对应的输出,通过学习建立输入到输出的映射关系。

其中,最常用的监督学习算法包括决策树、支持向量机(Support Vector Machine,SVM)和朴素贝叶斯(Naive Bayes)算法。

决策树是一种基于树形结构的分类模型,通过一系列的问题和判断条件将数据分类到不同的类别。

支持向量机是一种二分类模型,通过寻找最大间隔超平面来实现分类。

朴素贝叶斯算法基于贝叶斯定理和特征条件独立假设,通过计算后验概率进行分类。

2. 无监督学习算法无监督学习是指给定一组输入,通过学习发现其中的隐藏结构和模式。

最常用的无监督学习算法包括聚类算法和关联规则挖掘算法。

聚类算法用于将相似的数据样本分为多个组或簇,常用的聚类算法有K均值聚类和层次聚类。

关联规则挖掘算法用于发现数据中不同项之间的相关性,常用的算法有Apriori算法和FP-Growth算法。

3. 强化学习算法强化学习是一种学习智能体如何在环境中采取行动以使其获得最大回报的方法。

最常用的强化学习算法是Q-learning和深度强化学习。

Q-learning是一种基于价值迭代的算法,用于找到最佳策略使得智能体获得最大回报。

而深度强化学习将神经网络和强化学习相结合,通过神经网络来近似价值函数,实现对复杂环境中的决策。

4. 深度学习算法深度学习是一种基于多层神经网络的机器学习算法,通过多层次的特征提取和抽象来进行模式识别和预测。

最常用的深度学习算法包括卷积神经网络(Convolutional Neural Network,CNN)和循环神经网络(Recurrent Neural Network,RNN)。

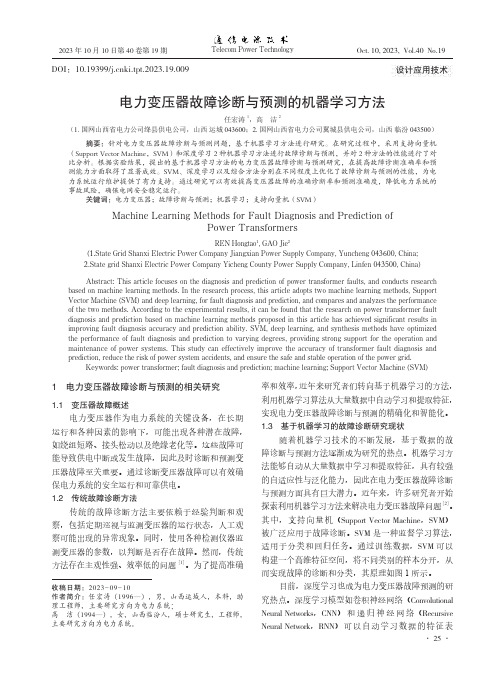

电力变压器故障诊断与预测的机器学习方法

设计应用技术电力变压器故障诊断与预测的机器学习方法任宏涛1,高洁2运城043600;2.国网山西省电力公司翼城县供电公司,山西针对电力变压器故障诊断与预测问题,基于机器学习方法进行研究。

在研究过程中,采用支持向量机2种机器学习方法进行故障诊断与预测,并对比分析。

根据实验结果,提出的基于机器学习方法的电力变压器故障诊断与预测研究,在提高故障诊断准确率和预测能力方面取得了显著成效。

SVM、深度学习以及综合方法分别在不同程度上优化了故障诊断与预测的性能,为电力系统运行维护提供了有力支持。

通过研究可以有效提高变压器故障的准确诊断率和预测准确度,降低电力系统的电力变压器;故障诊断与预测;机器学习;支持向量机(SVM)Machine Learning Methods for Fault Diagnosis and Prediction ofPower TransformersREN Hongtao1, GAO Jie2.State Grid Shanxi Electric Power Company Jiangxian Power Supply Company, Yuncheng.State grid Shanxi Electric Power Company Yicheng County Power Supply Company, LinfenTelecom Power Technology26 示,对于复杂的电力变压器故障预测任务具有较好的图1 SVM 的原理2 数据收集与预处理2.1 数据来源与采集在本研究中,电力变压器故障诊断与预测所需的数据主要来自2个方面,分别是传感器数据和历史故障记录。

为了监测变压器的运行状态,文章采集了多个传感器的数据,包括电流传感器、温度传感器以及振动传感器等。

这些传感器被安置在变压器的不同部位,实时监测关键参数的变化,从而形成了大量的实时监测数据[3]。

同时,可以从电力系统运维数据库中获取了变压器的历史故障记录。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人脑和CPU

神经细胞利用电-化学过程交换信号。输入信号来自另一 些神经细胞。这些神经细胞的轴突末梢(也就是终端)和 本神经细胞的树突相遇形成突触(synapse),信号就从 树突上的突触进入ห้องสมุดไป่ตู้细胞。信号在大脑中实际怎样传输是 一个相当复杂的过程,但就我们而言,重要的是把它看成 和现代的计算机一样,利用一系列的0和1来进行操作。就 是说,大脑的神经细胞也只有两种状态:兴奋(fire)和 不兴奋(即抑制)。发射信号的强度不变,变化的仅仅是 频率。神经细胞利用一种我们还不知道的方法,把所有从 树突上突触进来的信号进行相加,如果全部信号的总和超 过某个阀值,就会激发神经细胞进入兴奋(fire)状态, 这时就会有一个电信号通过轴突发送出去给其他神经细胞。 如果信号总和没有达到阀值,神经细胞就不会兴奋起来。

神经网络及SVM简介

一、 神经网络发展历史

1.背景知识 以冯· 诺依曼型计算机为中心的信息处理技术的高 速发展,使得计算机在当今的信息化社会中起着十分重 要的作用。但是,当用它来解决某些人工智能问题时却 遇到了很大的困难。 例如,一个人可以很容易地识别他人的脸孔,但计 算机则很难做到这一点。 大脑是由生物神经元构成的巨型网络,它在本质上 不同于计算机,是一种大规模的并行处理系统,它具有 学习、联想记忆、综合等能力,并有巧妙的信息处理方 法。 人工神经网络来源于对人脑实际神经网络的模拟

就是把神经细胞原有的阶跃式输 出曲线钝化为一光滑曲线

BP神经网络

BP神经网络计算

BP神经网络

Rumelhart,McClelland于1985年提出了BP网络的误差反向后传BP(Back Propagation)学习算法

David Rumelhart

J. McClelland

BP神经网络是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广 泛的神经网络模型之一。它的学习规则是使用最速下降法,通过反向传播来 不断调整网络的权值和阈值,使网络的误差平方和最小。

2016/4/22

隐层数

一般认为,增加隐层数可以降低网络误差(也有文献认为不一定 能有效降低),提高精度,但也使网络复杂化,从而增加了网络的 训练时间和出现“过拟合”现象。 Hornik等早已证明:若输入层和输出层采用线性转换函数,隐层采 用Sigmoid转换函数,则含一个隐层的MLP网络能够以任意精度逼近 任何有理函数。显然,这是一个存在性结论。在设计BP网络时可参 考这一点,应优先考虑3层BP网络(即有1个隐层)。

一般地,靠增加隐层节点数来获得较低的误差,其训练效果要比增 加隐层数更容易实现。

隐层节点数

在BP 网络中,隐层节点数的选择非常重要,它不仅对建立的神经 网络模型的性能影响很大,而且是训练时出现“过拟合”的直接原因, 但是目前理论上还没有一种科学的和普遍的确定方法。

目前多数文献中提出的确定隐层节点数的计算公式都是针对训练样 本任意多的情况。 事实上,各种计算公式得到的隐层节点数有时相差几倍甚至上百倍。 确定隐层节点数的最基本原则是:在满足精度要求的前提下取尽可能 紧凑的结构,即取尽可能少的隐层节点数。 研究表明,隐层节点数不仅与输入/输出层的节点数有关,更与需解 决的问题的复杂程度和转换函数的型式以及样本数据的特性等因素有 关。

n y(t ) f wi xi (t ) i 1

xn

wn

人工神经网络

激励函数的基本作用

控制输入对输出的激活; 对输入、输出进行函数转换; 将可能无限域的输入变换成指定的有限范围内的输出。

激励函数类型

阈值函数 线性函数 非线性函数

2016/4/22

学习规则

19

BP算法是由两部分组成,信息的正向传递与误差 的反向传播

正向传播过程中,输入信息从输入层经隐含层逐层计 算传向输出层,每一层神经元的状态只影响下一层神 经元的状态 如果在输出层未得到期望的输出,则计算输出层的误 差变化值,然后转向反向传播,通过网络将误差信号 沿原来的连接通路反传回来修改各层神经元的权值直 至达到期望目标

2.什么是人工神经网络 人工神经网络(Artificial Neural Netwroks,简称 ANN)是对人类大脑系统的一种仿真,简单地讲,它是 一个数学模型,可以用电子线路来实现,也可以用计算 机程序来模拟,是人工智能研究的一种方法。 实际上它是由大量的、功能比较简单的形式神经元 互相连接而构成的复杂网络系统,用它可以模拟大脑的 许多基本功能和简单的思维方式。尽管它还不是大脑的 完美元缺的模型,但它可以通过学习来获取外部的知识 并存贮在网络内,可以解决计算机不易处理的难题,特 别是语音和图像的识别、理解、知识的处理、组合优化 计算和智能控制等一系列本质上是非计算的问题。

Sigmoid函数

人工神经网络

Sigmoid函数

• S型函数具有非线性放 大系数功能,可以把输 入从负无穷大到正无穷 大的信号,变换成-1到 l之间输出 • 对较大的输入信号,放 大系数较小;而对较小 的输入信号,放大系数 则较大 • 采用S型激活函数可以 处理和逼近非线性输入 /输出关系

人脑和CPU

CPU 只具备一个功能 就是二进制加法运算

人脑的特点

处理信息的效率极高

人脑 100hz,10G个核 CPU i7 3.0 Ghz,4个核

能实现无监督的学习

对损伤有冗余性(tolerance)

善于归纳推广

人工神经网络

一个人工神经网络(Artificial neural network,简称ANN)就是要在当代数字计算 机现有规模的约束下,来模拟这种大量的并 行性,并在实现这一工作时,使它能显示许 多和生物学大脑相类似的特性。

2. 常见训练函数

函数名 traingd traingdm traingdx trainrp

FR共轭梯度法

PR共轭梯度法 PB共轭梯度法 标量共轭梯度法

功能 梯度下降法 势能修正法 自调整学习效率法 恢复BP法 trainbfg trainoss trainlm trainbr

函数名 traincgf traincgp traincgb trainscg

3.几个发展阶段 第一次热潮(40-60年代未) 1943年,美国心理学家W.McCulloch和数学家 W.Pitts在提出了一个简单的神经元模型,即MP模型。 1958年,F.Rosenblatt等研制出了感知机 (Perceptron)。 低潮(70-80年代初)

第二次热潮 1982年,美国物理学家J.J.Hopfield提出Hopfield 模型,它是一个互联的非线性动力学网络他解决问题的 方法是一种反复运算的动态过程,这是符号逻辑处理方法 所不具备的性质. 1987年首届国际ANN大会在圣地亚哥 召开,国际ANN联合会成立,创办了多种ANN国际刊物。 1990年12月,北京召开首届学术会议。 第三次热潮 GPU 大数据 新方法 深度学习理论

4. 可修改参数 除了需要输入A,B,{C},’trainfun’外,还有些默认的参数可 修改,如下表

参数名 net.trainParam.goal net.trainParam.epochs net.trainParam.show net.trainParam.lr net.trainParam.mc 功能 目标函数设定值 最大迭代次数 显示中间结果的周期 整批学习的学习效率 势能学习规则traingdm的势能率 缺省值 0 100 25 0.01 0.9

学习规则

18

BP算法属于δ算法,是一种监督式的学习算法

主要思想

对于q个输入学习样本:P1,P2,…,Pq,已知与其对应的 输出样本为:T1,T2,…,Tq

使网络输出层的误差平方和达到最小

用网络的实际输出A1,A2,…,Aq, 与目标矢量T1,T2,…,Tq 之间的误差修改其权值,使Am与期望的Tm,(m=l,…,q) 尽可能接近

应用实例

Matlab命令 net = newff ( A, B, {C}, ’trainfun’ ) 参数说明 A是一个 n × 2的矩阵,第 i 行元素为输入信号 x i 的最 小值和最大值; B为一 k 维行向量,其元素为各隐层节点数; C为一k 维字符串行向量,每一分量为对应层神经元的激 励函数; trainfun为学习规则采用的训练函数(常见训练函数如下 表)。

人脑和CPU

动物 蜗牛

蜜蜂 蜂雀 老鼠

神经细胞的数目(数量级) 10,000 (=10^4)

100,000 (=10^5) 10,000,000 (=10^7) 100,000,000 (=10^8)

人类 大象

10,000,000,000 (=10^10) 100,000,000,000 (=10^11)

X为n×M矩阵,为输入数据矩阵,M为样本的组数。Y为 m×M矩阵,为输出数据矩阵。

数据泛化

什么是数据泛化?

用经过训练的网络对于不是样本集的输入,计算出相应 的输出。 训练结束后,对新的输入点数据X2,调用sim函数进行泛 化,得出这些输入点处的输出矩阵Y2. Y2=sim(net,X2)

例1 由下面的语句生成一组数据 x 和 y,用神经网络进 行数据拟合 x=0:.1:10; y=0.12*exp(-0.213*x)+0.54*exp(-0.17*x).*sin(1.23*x); 可知(x, y)是曲线 y 0.12e0.213 x 0.54e0.17 x sin(1.23x) 上的点。 x=0:.1:10; y=0.12*exp(-0.213*x)+0.54*exp(-0.17*x).*sin(1.23*x); net=newff([0,10],[5,1],{'tansig','tansig'}); 0.6 net.trainParam.epochs=1000; 0.4 net=train(net,x,y); x0=0.05:.1:10; 0.2 figure(1) 0 y1=sim(net,x0); -0.2 plot(x,y,'o', x0,y1,'r')