MicroDistPro视觉对位系统算法

无源毫米波成像改进POCS超分辨率算法

取 有 效 后 处理 措 施 增 强 分 辨 率 。提 出 了一 种 改进 的 P C O S超 分 辨 率 算 法 , 算 法结 合 了 Wi e 滤 波 器 复 原 该 e r n 算 法和 凸 集投 影 ( OC ) 法 的优 点 , 用 W i e 滤 波 复 原 算 法 恢 复 图像 通 带 内的 低 频 分 量 , 用 P C P S算 使 e r n 运 O S算

A b t a t The sr c : pr e oblm of oo r s l in a q r d m a i t pa sv m ilm e e w a e m a ng p r e o uto of c uie i ge n he s ie li t r v i gi

( c o l f Elcr ncE g n e ig, n v r i f E eto i S in ea d S h o e to i n i ern U i e s y o lcr nc ce c n o t

T c n l g f C ia,C e g u 6 1 3 ,C ia eh o o yo h n hn d 1 7 1 hn )

g rt m m p o e h o v r e tr t n s c mp t t n l c r fii n h n P oi h i r v st ec n eg n aea d i o u a i a l mu h mo ee fce tt a OCS ag r h o y l o i m.Th t e ag rt m se sl mp e n e n r a i o a sv li t rwa e i g n . lo i h i a i i l me t d i e lt y me f rp s ie mi me e v ma i g l Ke r s p s i e mi i t r wa e i g n ; s p r r s l t n;POCS ag rt m ; i g e t r to y wo d : a sv l me e v ma i g l u e—eo ui o lo i h ma e r so a i n;

视觉对位贴合算法

视觉对位贴合算法一、概述视觉对位贴合算法是一种利用计算机视觉技术实现图像对齐的方法。

它主要应用于图像匹配、图像拼接、图像纠正等领域。

该算法通过对两幅或多幅图像进行特征点提取和匹配,最终实现图像的准确对齐。

二、基本原理1. 特征点提取特征点是指在一幅图像中比较明显的、不易变化的位置。

常见的特征点包括角点、边缘点和斑点等。

特征点提取是视觉对位贴合算法的第一步,其目的是从两幅或多幅图像中提取出相同或相似的特征点。

2. 特征点匹配特征点匹配是将两幅或多幅图像中的相同或相似特征点进行匹配,以确定它们之间的关系。

常见的特征点匹配算法包括暴力匹配算法和基于描述子的匹配算法。

3. 变换模型估计变换模型估计是通过已经匹配好的特征点,来确定两幅或多幅图像之间的变换关系。

常见的变换模型包括仿射变换、透视变换等。

4. 图像对齐图像对齐是将两幅或多幅图像进行准确的重合,使它们在相同的坐标系下,以便进行后续的处理。

常见的图像对齐算法包括基于特征点匹配的方法和基于全局优化的方法。

三、应用领域1. 图像匹配图像匹配是指在两幅或多幅图像中寻找相同或相似的目标。

视觉对位贴合算法可以通过特征点提取和匹配来实现图像匹配。

2. 图像拼接图像拼接是将多幅图像拼接成一幅完整的大型图像。

视觉对位贴合算法可以通过估计变换模型和进行全局优化来实现图像拼接。

3. 图像纠正图像纠正是指将倾斜、扭曲等形变后的图像恢复到原始状态。

视觉对位贴合算法可以通过估计仿射变换或透视变换来实现图像纠正。

四、发展趋势随着计算机硬件性能和计算机视觉技术的不断提升,视觉对位贴合算法也在不断发展。

未来的发展趋势包括:1. 深度学习技术的应用深度学习技术可以自动提取图像中的特征,并进行特征匹配和变换模型估计,从而实现更加精确的图像对齐。

2. 实时性的提高随着计算机硬件性能的不断提升,视觉对位贴合算法将可以在更短的时间内完成图像对齐任务。

3. 应用领域的拓展视觉对位贴合算法将会应用到更多领域,如三维重建、虚拟现实等。

机器视觉软件VisionPro使用入门技巧

机器视觉软件VisionPro使用入门技巧导语:机器视觉是人工智能正在快速发展的一个分支。

简单说来,机器视觉就是用机器代替人眼来做测量和判断。

机器视觉系统是通过机器视觉产品将被摄取目标转换成图像信号,传送给专用的图像处理系统,得到被摄目标的形态信息,根据像素分布和亮度、颜色等信息,转变成数字化信号;图像系统对这些信号进行各种运算来抽取目标的特征,进而根据判别的结果来控制现场的设备动作。

机器视觉是人工智能正在快速发展的一个分支。

简单说来,机器视觉就是用机器代替人眼来做测量和判断。

机器视觉系统是通过机器视觉产品将被摄取目标转换成图像信号,传送给专用的图像处理系统,得到被摄目标的形态信息,根据像素分布和亮度、颜色等信息,转变成数字化信号;图像系统对这些信号进行各种运算来抽取目标的特征,进而根据判别的结果来控制现场的设备动作。

那么,从上面关于机器视觉的表述来看,图像处理分析软件的作用就很重要了。

目前在工业领域,常用的机器视觉软件有Halcon、VisionPro、LabView、EVision、HexSight、SherLock等等。

这些软件各自有各自的特点,我们今天要给大家介绍的是由行业巨头企业康耐视公司推出的VisionPro软件。

软件简介康耐视公司(Cognex®)推出的VisionPro®系统组合了世界一流的机器视觉技术,具有快速而强大的应用系统开发能力。

VisionProQuickStart™利用拖放工具,以加速应用原型的开发。

这一成果在应用开发的整个周期内都可应用。

通过使用基于COM/ActiveX 的VisionPro机器视觉工具和VisualBasic®、VisualC++®等图形化编程环境,开发应用系统。

与MVS-8100™系列图像采集卡相配合,VisionPro使得制造商、系统集成商、工程师可以快速开发和配置出强大的机器视觉应用系统。

目前VisionPro最新版本已更新至9.2CR1版本,不过这些版本在使用时必须使用硬件加密狗才能正常使用。

解读无人机视觉计算技术

解读无人机视觉计算技术上周国外一个叫Percepto的无人机计算机视觉初创公司获得了百万美元的种子轮投资,投资方还非常有名,包括时代华纳的前CEORichardParsons,著名创投家、达拉斯小牛队老板MarkCuban,以及中国著名天使投资人等。

这家公司在3月份未获得投资前就已经在indiegogo上众筹,获得了Wired这种国外知名媒体的报道,赞美其为无人机赋予视觉自动跟踪拍摄,看到这样字眼记者马上想到了更早一些的Lily无人机,之前它的宣传片大伙的时候,有一幕镜头是它跟着滑雪的人追踪拍摄,所以说无人机视觉计算这个早就在国外有些苗头了,而且这些看似不经意不伟大的创新恰恰是中国创业者苦苦追求而缺失的东西。

但是真相往往来得很简单,单从无人机这个行当来说,外国棒子这么会创新,就是因为外国棒子天生比我们会玩,玩得时候稍不留神就出现惊天地泣鬼神的idea了,混迹科技行业多年的记者马上觉悟到,无人机计算视觉很有可能成为继无人机整机之后的下一波产业机会,就找到了国内的无人机视觉计算一枚创业者了解现在我们应该了解的信息。

怎么看无人机的视觉计算技术?简单地说,可以理解成用摄像头和传感器结合计算机模拟类似人眼和大脑的作用,来得到三维空间的距离,进而识别物体、判断物体的运动状态以及其它。

对于目前的无人机要做的来说,现在主要是距离感知,因为激光扫描仪的设备太贵太重,小型化、低成本的距离测量涉及到硬件传感器和软件算法的还好;另一类是目标检测的,包括检测、跟踪识别、导航和其它。

大部分都是基于这两类的整合扩展。

国内无人机计算视觉到什么阶段了?据我所知的,国内无人机计算视觉这块,能够演示出很酷炫的技术效果能传播的很快,但总的来说还在一个从实验室到市场转化的阶段,大家都在找结合点,除了用图像结合机器学习这个稳定性相对比较高,其它蛮多方法在实际运用的时候还是存在局限性,比如光照、遮挡。

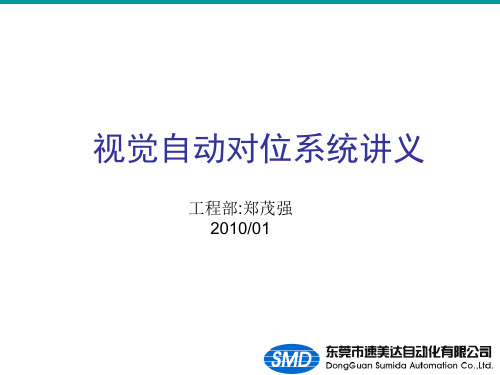

视觉自动对位系统讲义

视觉自动对位系统讲义工程部:郑茂强2010/01讲义要点一.视觉自动对位系统构成二.视觉自动对位系统选型三.视觉自动对位系统应用视觉自动对位通过CCD将图像采集到图像对位处理系统,再通过图像对位处理软件,算出偏移位置和角度,再传送给外部运动制器,进行位置纠正.对位前对位后视觉自动对位流程:运动平台已经能正常运行,CCD安装并正常成像根本平台类型(XYQ,UVW…),设置平台参数,做模板,对位精度等自学习(Calibration),算出平台与CCD之间的关系.拍目标拍对像对位,自动算出偏移距离和角度(脉冲数)根据对位得出的偏移脉冲值控制平台运动相机与镜头FV -aligne r XPe/P 3-800UNT(显示器)(PLC)(FV-Aligner ENG)(对位主机)运动控制器(运动控制平台)滚动球/鼠标/键盘(触摸屏人机界面)光源,棱镜(FV-Aligner UNT 直接控制驱动器)对位主机:目前公司代理的对位系统有:松下:A210(手动对位)PV310(自动对位)(详细资料见:松下选型手册P26-P27)FAST:带轴卡-FV2300-ENG 不带轴卡-FV2300-UNT (旧型为FV1100)FV-AlignerII(对位软件)FV1100FV2300PV310A210松下对位系统:摄像机A摄像机B操作手柄PV310算出两台摄像机所拍摄的对位标记的补正量使用UVW方式/XYθ方式的平台,进行对位位置控制精度在1μm以上(需要高精度移动平台)松下对位软件:使用高精度平台,位置控制PLC进行全自动对位.适应在线生产或生产线自动化程度比较高的场合. [操作说明]松下对位软件:[松下对位介绍.ppt]FAST对位系统:FV-1100FV-2300FV-aligner系列是一款多功能,高精度的定位型图像处理装置。

进行定位时,在相机读取的图像信息的基础上,自动计算出定位所需的XYθ移动量,然后通过控制一个三轴平台(或者四轴平台)的移动,实现对工件进行XYθ校正,从而达到精确对位的目的。

康耐视标定原理范文

康耐视标定原理范文首先,卷积是康耐视标定的核心操作。

卷积操作通过将输入图像与一个可学习的滤波器进行卷积运算来提取图像的局部特征。

滤波器的参数称为权重,它们通过反向传播算法进行优化。

通过卷积操作,康耐视标定可以有效地提取图像的边缘、纹理和颜色等特征。

在康耐视标定中,卷积操作是通过滑动一个固定大小的窗口在输入图像上进行的。

窗口每次向右或向下移动一个固定的距离,这个距离称为步长。

每个窗口下的图像块与滤波器进行卷积运算,并生成一个特征图。

这个过程可以通过下面的公式来表示:输出特征图=滤波器*输入图像块其中,*表示卷积运算。

为了保持特征图的大小与输入图像相同,康耐视标定通常会使用填充操作。

填充操作在输入图像的边界周围添加额外的像素,使得每个像素都有足够的周围像素可供卷积操作使用。

其次,池化是康耐视标定的另一个重要操作。

池化操作通过对特征图的特征进行降维和抽象来减少计算量,并提高模型的平移不变性。

常见的池化操作包括平均池化和最大池化。

平均池化将每个窗口下的特征图块的平均值作为输出特征,而最大池化则选择每个窗口下的特征图块的最大值作为输出特征。

池化操作通常是在卷积操作之后进行的。

输出特征=池化函数(输入特征)其中,池化函数可以是平均池化或最大池化。

除了卷积和池化操作,康耐视标定还包括其他一些重要的组件,如激活函数、批归一化和全连接层等。

激活函数用于引入非线性因素,批归一化可以提高模型的训练稳定性和泛化能力,全连接层用于将特征图转换为最终的分类结果。

总之,康耐视标定的原理是通过卷积和池化等操作来提取图像的特征,并通过学习一组参数来对图像进行分类。

它充分利用了卷积神经网络的局部感知性和共享权重的特点,能够对图像进行高效而准确的分类。

康耐视标定在计算机视觉领域具有广泛的应用,如图像识别、目标检测和语义分割等。

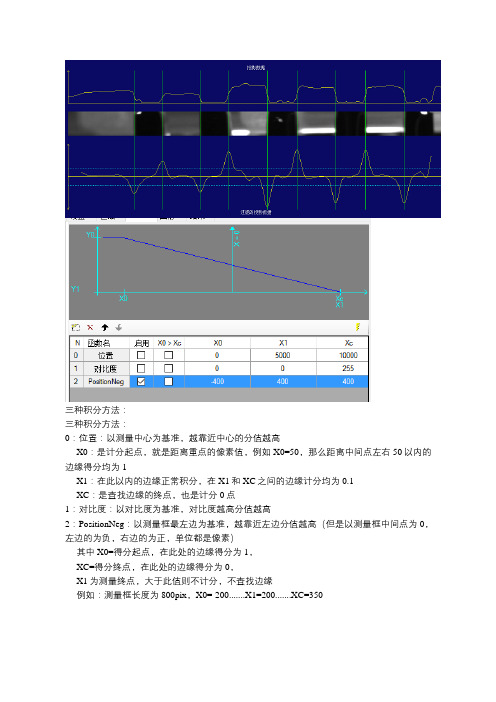

VisionPRO关于边缘计分原则

三种积分方法:

三种积分方法:

0:位置:以测量中心为基准,越靠近中心的分值越高

X0:是计分起点,就是距离重点的像素值,例如X0=50,那么距离中间点左右50以内的边缘得分均为1

X1:在此以内的边缘正常积分,在X1和XC之间的边缘计分均为0.1

XC:是查找边缘的终点,也是计分0点

1:对比度:以对比度为基准,对比度越高分值越高

2:PositionNeg:以测量框最左边为基准,越靠近左边分值越高(但是以测量框中间点为0,左边的为负,右边的为正,单位都是像素)

其中X0=得分起点,在此处的边缘得分为1,

XC=得分终点,在此处的边缘得分为0,

X1为测量终点,大于此值则不计分,不查找边缘

例如:测量框长度为800pix,X0=-200.......X1=200.......XC=350

那么:以测量框中点400的位置往左200(就是X0)开始计分,此处的边缘和此处左的边缘分值均为1,从此处到X1之间的边缘分值按照位置降低,但是当X1≠XC时,X1处的分值不为0,

但是X1以后,XC之前的边缘不计分并忽略边缘;。

深度解析:移动机器人的几种视觉算法

深度解析:移动机器人的几种视觉算法谈到移动机器人,大家第一印象可能是服务机器人,实际上无人驾驶汽车、可自主飞行的无人机等等都属于移动机器人范畴。

它们能和人一样能够在特定的环境下自由行走/飞行,都依赖于各自的定位导航、路径规划以及避障等功能,而视觉算法则是实现这些功能关键技术。

如果对移动机器人视觉算法进行拆解,你就会发现获取物体深度信息、定位导航以及壁障等都是基于不同的视觉算法,本文就带大家聊一聊几种不同但又必不可少的视觉算法组成。

本文作者陈子冲,系Segway Robot架构师和算法负责人。

移动机器人的视觉算法种类Q:实现定位导航、路径规划以及避障,那么这些过程中需要哪些算法的支持?谈起移动机器人,很多人想到的需求可能是这样的:“嘿,你能不能去那边帮我拿一杯热拿铁过来。

”这个听上去对普通人很简单的任务,在机器人的世界里,却充满了各种挑战。

为了完成这个任务,机器人首先需要载入周围环境的地图,精确定位自己在地图中的位置,然后根据地图进行路径规划控制自己完成移动。

而在移动的过程中,机器人还需要根据现场环境的三维深度信息,实时的躲避障碍物直至到达最终目标点。

在这一连串机器人的思考过程中,可以分解为如下几部分的视觉算法:1.深度信息提取2.视觉导航3.视觉避障后面我们会详细说这些算法,而这些算法的基础,是机器人脑袋上的视觉传感器。

视觉算法的基础:传感器Q:智能手机上的摄像头可以作为机器人的眼睛吗?所有视觉算法的基础说到底来自于机器人脑袋上的视觉传感器,就好比人的眼睛和夜间视力非常好的动物相比,表现出来的感知能力是完全不同的。

同样的,一个眼睛的动物对世界的感知能力也要差于两个眼睛的动物。

每个人手中的智能手机摄像头其实就可以作为机器人的眼睛,当下非常流行的Pokeman Go游戏就使用了计算机视觉技术来达成AR 的效果。

像上图画的那样,一个智能手机中摄像头模组,其内部包含如下几个重要的组件:镜头,IR filter,CMOS sensor。

机器视觉技术架构及常用算法简析

机器视觉技术架构及常用算法简析■文/任成浙江宇视科技有限公司近年来中国城市级视频管理系统发展迅速,技术向高清化、大数据化方向发展,导致数据量急剧增长,如何充分发挥价值并进行合理应用成为视频行业新的难题。

随着云计算、大数据、机器视觉技术的快速发展,视频数据的图像分析成为解决难题的最佳方案。

机器分析包括图像的编码和解码、运动目标的结构化信息、视频浓缩、知识库结果比对等应用。

通过分析机动车、非机动车的结构化(对于车辆,如车型车款、车身颜色、车牌识别等;对于非机动车,如二轮、三轮、骑车人性别等)与半结构化信息(可用于以图搜图的向量信息),可广泛应用于交通、大型园区等行业。

当前智能技术不断开发,所需的输入端图像采集的高清化和硬件芯片载体的不断进步,机器视觉技术逐渐从实验室走向社会,一、机器视觉技术实现架构机器视觉基于视图智能分析的经典流程分为四个步骤。

图像解码还原:从视频流中解码还原出图像数据。

目标检测分类:从图像中检测到运动目标,对其进行分类(机动车、非机动车等),选择最佳位置拍摄,上传至数据库。

真正进入实战使用阶段。

摘要信息提取:对最佳位置处的目标进行结构化、半结构化信息提取,上传至大数据以供检索使用。

目标检索:根据不用的业务需求选择结构化检索以及半结构化检索(以图搜图)。

1.机器视觉的发展历程机器视觉分析在学术界有各个阶段的阐述,在AloT行业更重视非配合式的情况下,2021.1-2-6应圍豆-37frontier technology・冃彷占技术随着深度学习的突破,机器视觉以及图像处理的研究可重新划分为两大阶段。

第一阶段:传统技术研究。

(1)提出不同的目标检测及跟踪算法,包括帧差、光流、前背景建模等。

(2)利用新的特征表示,包括meanshift、camshift等。

(3)深入分析和研究影响目标属性识别的因素,包括光照、角度等。

基于传统技术的目标跟踪以及特征识别技术,受各种影响因素干扰,只能在部分特定的场景使用,对于复杂场景未能达到实战要求。

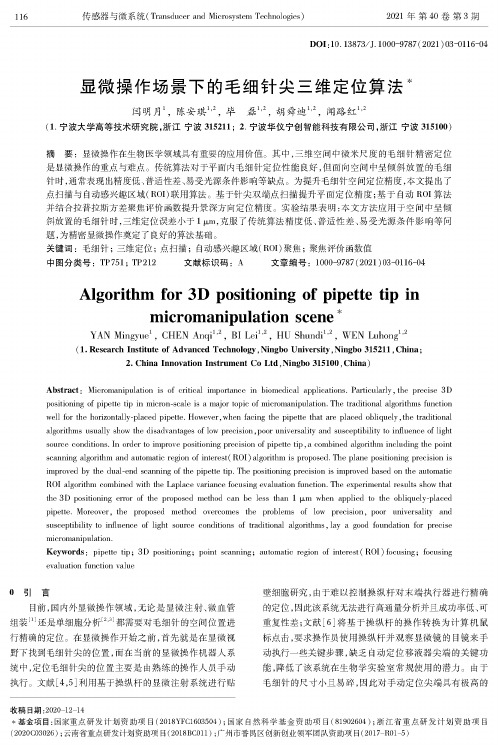

显微操作场景下的毛细针尖三维定位算法

116传感器与微系统(Transducer and MicrosystemTechnologies)2021年第40卷第3期D O I:10.13873/J.1000-9787(2021)03-0116-04显微操作场景下的毛细针尖三维定位算法$闫明月1陈安琪12,毕磊12,胡舜迪12,闻路红12(1.宁波大学高等技术研究院,浙江宁波315211;2.宁波华仪宁创智能科技有限公司,浙江宁波315100)摘要:显微操作在生物医学领域具有重要的应用价值。

其中,三维空间中微米尺度的毛细针精密定位是显微操作的重点与难点。

传统算法对于平面内毛细针定位性能良好,但面向空间中呈倾斜放置的毛细针时,通常表现出精度低、普适性差、易受光源条件影响等缺点。

为提升毛细针空间定位精度,本文提出了点扫描与自动感兴趣区域(R0I)联用算法。

基于针尖双端点扫描提升平面定位精度;基于自动R0I算法并结合拉普拉斯方差聚焦评价函数提升景深方向定位精度。

实验结果表明:本文方法应用于空间中呈倾斜放置的毛细针时,三维定位误差小于1p m,克服了传统算法精度低、普适性差、易受光源条件影响等问题,为精密显微操作奠定了良好的算法基础。

关键词:毛细针;三维定位;点扫描;自动感兴趣区域(R0I)聚焦;聚焦评价函数值中图分类号:T P751;T P212 文献标识码:A文章编号:1000-9787(2021)03-0116-04A l g o r i t l i m f o r3D p o s i t i o n i n g o f p i p e t t e t i p i nm i c r o m a n i])u l a t i o n s c e n e **Y A N M i n g y u e1,C H E N A n q i1’2,BI Lei1’2,H U S h u n d i1’2,W E N L u h o n g1’2(1.R esearch Institute of A dvanced Technology,Ningbo U niversity,Ningbo 315211,C hina ;2. C hina Innovation Instrum ent Co L td,N ingbo 315100,C hina)A b strac t:Micromanipulation i s of critical importance in biomedical applications. Particularly ’ the precise 3Dpositioning of pipette tip in micron-scale is a major topic of micromanipulati well for the horizontally-placed pipette. However,when facing the pipette that are placed obliquely,the traditionalalgorithms usually show the disadvantages of low precision,poor universality and suscep source conditions. In order to improve positioning precision of pipette tip’a combined algorithm including the pointscanning algorithm and automatic region of interest( R0I) algorithm is proposed. The plane positioning precision isimproved by the dual-end scanning of the pipette tip. The positioning precision is imp R0I algorithm combined with the Laplace variance focusing evaluation function. The experimental results show thatthe 3D positioning error of the proposed method can be less than 1 |xm when applied to the obliquely-placedpipette. Moreover’ the proposed method overcomes the problems of low precision’ poor universality andsusceptibility to influence of light source conditions of traditional algorithms ’ lay a good foundation for precisemicromanipulation.K eyw ords:pipette tip;3D positioning;point scanning;automatic region of interest( R0I) focusing;focusingevaluation function value〇引言目前,国内外显微操作领域,无论是显微注射、微血管 组装[1]还是单细胞分析[2'3]都需要对毛细针的空间位置进 行精确的定位。

机器视觉对位贴合原理与应用场景

机器视觉对位贴合原理与应用场景1. 引言机器视觉对位贴合是指使用计算机视觉技术对两个或多个物体进行对位和贴合的过程。

对位贴合的主要目的是通过计算机视觉算法的帮助,使得物体的位置和姿态能够准确地与目标位置和姿态匹配,从而实现精确的对位贴合。

机器视觉对位贴合技术在工业制造、机器人操作、医疗影像、虚拟现实等领域具有广泛的应用。

2. 基本原理机器视觉对位贴合的基本原理是通过摄像机获取物体的图像,并使用计算机视觉算法对图像进行处理和分析,从而得到物体的位置和姿态信息。

常用的机器视觉对位贴合算法包括特征提取、特征匹配、姿态估计和优化等步骤。

2.1 特征提取特征提取是机器视觉对位贴合的第一步。

在这一步中,计算机视觉算法通过分析图像中的像素信息,提取出物体的特征点或特征区域。

常用的特征包括边缘、角点、纹理等。

特征提取的目的是将物体的图像信息转化为计算机可以处理的数字数据。

2.2 特征匹配特征匹配是机器视觉对位贴合的核心步骤。

在这一步中,计算机视觉算法将提取到的特征与目标特征进行匹配,以确定物体在目标位置的位置和姿态。

特征匹配的目的是找到图像中的特征点或特征区域与目标位置的对应关系。

常用的特征匹配算法包括最近邻匹配、RANSAC(随机抽样一致性)算法等。

最近邻匹配算法通过计算特征点之间的距离,找到最相似的特征点。

RANSAC算法则通过随机选择一些特征点,计算其对应的变换模型,然后通过计算模型的一致性来确定最佳的匹配。

2.3 姿态估计姿态估计是机器视觉对位贴合的关键步骤。

在这一步中,计算机视觉算法利用特征匹配得到的物体的位置和姿态信息,通过数学模型计算出物体在目标位置的精确姿态。

常用的姿态估计算法包括透视变换、仿射变换、三维重建等。

透视变换是一种常用的姿态估计算法,通过计算物体在图像中的四个角点与目标位置的对应关系,确定物体的位置和姿态。

仿射变换则是一种常用的近似姿态估计算法,通过计算物体在图像中的三个点与目标位置的对应关系,确定物体的位置和姿态。

小杨说事-基于海康机器视觉算法平台的对位贴合项目个人理解

都说“纸上得来终觉浅,绝知此事要躬行”,可惜咱没这条件呀,没项目咱也不能干坐着呀,那咱发挥主观能动性,咱不是学机械的么,还好还记得一点CAD的知识,今天小杨说事,咱就“纸上谈兵”,用CAD结合公司的视觉算法平台VisionMaster来说说相机映射和对位贴合的事,如果有错误的地方,还请各位自动化前辈多多指教,毕竟网上的关于这个知识太少了。

实际的生产过程中,我们常常会碰到这样的情况,机械手从工位一吸着对象到工位二进行贴合,但是工位二我们不方便执行标定,通常的做法是在工位一执行一次标定流程,然后使用两点映射或者四点映射把工位二的相机坐标映射到工位一的相机一中。

说起来很轻松,咱没实战过呀,但是咱可以模拟呀,说干就干,咱开始动手吧。

如上图所示,咱们为了验证一般性,把机械手坐标系,工位一的相机1坐标系,工位二的相机2坐标系画的夸张一些,但是在CAD图上我们是通过旋转的方式来改变两个相机的坐标系和机械手坐标系的夹角的,事先是知道相机1坐标系X轴和相机2坐标系X轴和机械手坐标系X轴的夹角分别是10°和45°。

当然关于单像素精度,这里是采用一比一的方式,因为现实成像比这个更复杂,为了方便描述而已,不影响咱的用户体验。

现实场景中,咱一般碰到的都是机械手末端吸盘和末端中心不共轴的情况,那这边咱就选用最通用的12点标定来求出这个旋转中心,啥,你不知道什么是不共轴,啥是旋转中心,那你out了,赶紧看看这个博主的博客,人家讲的很详细,地址如下:https:///KayChanGEEK/article/details/73878994看完了那咱继续,吸盘吸着带MARK点的标定板,在相机视野里面平移9次,旋转3次,当然尽量贴近实际对象所在的平面,移动范围尽量覆盖实际对象可能出现的范围。

以X方向每次平移640.3044,Y方向每次平移389.3736,角度每次旋转30°,使用海康的算法平台呢,咱一般使用相对坐标系,尽量不使用绝对坐标系。

视觉与惯导组合的精确定位方法

视觉与惯导组合的精确定位方法

视觉与惯导组合的精确定位方法是将视觉信息与惯性导航系统(即惯性测量单元)的测量结果进行融合,以提高位置和姿态的精确度。

该方法的基本思想是利用视觉信息来校正惯导系统的误差,从而实现更准确的定位和导航。

具体而言,视觉与惯导组合的精确定位方法包括以下步骤:

1. 视觉图像获取:通过视觉传感器(如摄像头)获取场景图像。

2. 特征提取与匹配:从视觉图像中提取出有意义的特征点,并与已知地图或先前测量结果进行特征匹配,以获得相对位置和姿态信息。

3. 三维重建:利用特征点的视差(即在不同视图中的像素偏移量)和相机参数,将特征点从图像空间映射到三维空间,并重建出场景的三维结构。

4. 姿态估计:根据特征点的位置关系和三维结构,估计出相机的姿态(即旋转矩阵或四元数),包括方向和角度。

5. 运动估计:通过惯性导航系统获取相机的线性加速度和角速度信息,从而估计出相机的运动(即平移矩阵或速度向量)。

6. 视觉与惯导融合:通过滤波器(如卡尔曼滤波器)或优化算法(如扩展卡尔曼滤波器或粒子滤波器)将视觉测量结果和惯导测量结果进行融合,得到更准确的位置和姿态估计结果。

7. 循环更新:根据新的视觉测量数据和惯导测量数据,不断迭代更新位置和姿态估计结果,以实现实时精确定位。

视觉与惯导组合的精确定位方法可以应用于无人机、自动驾驶车辆、机器人等领域,能够在没有GPS定位或GPS不可用的环境下实现精确的定位和导航。

高分辨digital micrograph 使用方法

高分辨d i g i t a l m i c r o g r a p h使用方

法

-CAL-FENGHAI.-(YICAI)-Company One1

选中虚线方框,按住Alt健,在需要进行变换的区域拉出一个正方形

然后点击

Process,选择FFT即可,或者在画出上图中的红色方框后按Ctrl+F即可得到

这个软件还可以直接测量条纹间距

首先可以将图片放大(视条纹清晰与否),放大工具使用红色区域中的工具,然后点击图片即可。

然后选中ROL Tools中的第二个工具(虚线),上图中的第二个方框。

然后对着图中的标尺,从起点到末端拉一条直线,尽量与标尺一样长短(见下图)。

之后选择 Analyze 菜单中的 Calibrate,会弹出一个对话框,

将对话框中的数字改成标尺的

数字如10 , Units中选择 nm。

然后用刚才的虚线工具,画一条与条纹尽量垂直的直线,

可以取10个或者20个条纹,取平均值。

直线的长度显示在Control面板中的L项。

Control面板可在 Window菜单中调取出来,调取出来后,该面板显示在软件的左下方。

可以取10个或者20个条纹,取平均值。

microv原理(二)

microv原理(二)MicroV原理什么是MicroVMicroV是一种创新的技术原理,它革新了传统的视觉图像处理方法。

通过将感知和理解整合,并运用人工智能的算法,MicroV能够实现高效、准确和智能的图像处理。

下面将从几个方面解释MicroV的原理。

MicroV原理的基础MicroV的核心是深度学习和计算机视觉技术。

深度学习是一种机器学习技术,它可以通过大量的数据集来训练模型,以实现对图像、声音和文本等信息的理解和识别。

计算机视觉技术则涉及图像处理、目标检测和图像识别等方面的方法与算法。

MicroV的处理流程MicroV的处理流程可以分为以下几个步骤:1.图像采集:通过摄像头或其他设备采集图像数据,并将其输入到MicroV系统中。

2.图像预处理:首先对图像进行预处理,包括去噪、色彩校正和图像增强等操作,以提高图像的质量和可识别性。

3.特征提取:MicroV会利用深度学习的方法,提取图像中的特征信息。

这些特征可以包括边缘信息、纹理信息和颜色信息等。

4.目标检测:通过比对提取到的特征信息和事先训练好的模型,MicroV可以准确地检测和定位图像中的目标物体,如人脸、车辆或其他物体等。

5.图像识别:在目标检测的基础上,MicroV还可以通过图像识别的技术,对目标物体进行分类和识别。

它可以根据之前训练得到的模型,把目标物体分类为不同的类别,如动物、植物或商品等。

6.输出结果:最后,MicroV会将处理后的结果以可视化的方式呈现出来。

它可以显示目标物体的位置、分类结果或其他所需的信息,以便用户进行进一步的分析和判断。

MicroV的优势和应用MicroV不仅在图像处理领域具有广泛的应用,还能够推动其他相关领域的发展。

以下是MicroV的一些优势和应用:•高效性:MicroV利用深度学习和计算机视觉的方法,能够在短时间内处理大量的图像数据,并可以实时性地输出结果。

•准确性:通过训练模型和特征提取,MicroV可以非常准确地检测和识别图像中的目标物体,从而提高了识别的准确性。

视觉对位贴合算法

视觉对位贴合算法简介视觉对位贴合算法是指通过分析和处理图像数据,实现将两幅或多幅图像进行对准和贴合的技术。

在计算机视觉领域,这是一个重要的任务,它可以应用于图像拼接、图像配准、目标跟踪、增强现实等众多应用中。

目标与挑战视觉对位贴合算法的目标是使得多幅图像在空间上对齐,使它们在相同位置上具有相似的外观和几何特征。

然而,由于图像存在尺度、旋转、平移、畸变等方面的差异,对位贴合算法面临一些挑战:1.尺度不一致:图像之间可能存在尺度差异,在对位贴合时需要克服这种差异,使得图像在相同尺度下对应点的位置匹配准确。

2.旋转和平移变换:图像可能被旋转或平移,这会导致图像中的特征点位置的变化。

对位贴合算法需要能够检测和估计这些变换,并进行相应的调整。

3.畸变校正:图像可能存在畸变,例如镜头畸变或透视畸变。

对位贴合算法需要能够校正这些畸变,以保证对位的准确性。

常用方法为了解决上述挑战,研究者们提出了许多视觉对位贴合算法。

以下是一些常用方法的简要介绍:特征点匹配特征点匹配是一种常见的对位贴合方法,它通过在图像中提取特征点,并进行特征描述,然后通过计算特征点之间的相似性来进行匹配。

常用的特征点包括SIFT、SURF和ORB等。

1.特征点提取:在每幅图像中,使用特定的算法提取特征点,例如SIFT算法可以提取出图像中的关键点,并计算出它们的特征描述子。

2.特征点匹配:通过对位差值计算、比较特征描述子之间的相似性来进行特征点的匹配。

可以使用RANSAC算法进行去除错误匹配。

3.对位与贴合:利用匹配的特征点之间的几何变换关系,通过使用最小二乘法或其他优化方法,计算出图像之间的变换参数,进而进行对位与贴合。

直接法直接法是一种直接利用图像亮度值进行对位贴合的方法,它通过最小化图像之间的亮度差异来进行对齐。

主要有两种方法:灰度对位和彩色对位。

1.灰度对位:将图像转换为灰度图像,然后使用亮度误差或其他相似度度量方法来计算图像之间的差异。

上下相机贴合对位计算公式

上下相机贴合对位计算公式相机贴合对位计算是一种用于确定两个相机之间的相对位置关系的计算方法。

在计算机视觉领域中,相机贴合对位计算被广泛运用于虚拟现实、增强现实、立体视觉以及机器人导航等众多应用中。

相机贴合对位计算的基本原理是通过对两个相机捕捉的图像进行特征点匹配,然后利用匹配的特征点计算相机之间的位姿变换关系。

在这个过程中,首先需要对两幅图像进行特征提取,一般常用的特征包括角点、边缘、SIFT特征等。

然后,通过匹配这些特征点,可以得到两个相机之间的对应点对。

接下来,利用这些对应点对进行位姿计算,最终可以得到相机的旋转矩阵和平移向量。

在进行相机贴合对位计算时,一般会采用一些优化算法来提高计算的精度和效率。

其中,常用的算法包括RANSAC、PnP等。

RANSAC算法可以去除一部分错误的特征点匹配,从而得到更准确的相机位姿。

而PnP算法则是一种基于3D-2D点对的位姿计算方法,可以通过最小化重投影误差来求解相机的旋转矩阵和平移向量。

相机贴合对位计算在现实世界中有着广泛的应用。

例如,在虚拟现实中,为了实现更加逼真的虚拟场景,需要将虚拟物体与现实世界进行精准对位,相机贴合对位计算可以帮助实现这一目标。

在增强现实中,通过对相机和真实环境进行对位,可以将虚拟信息与真实环境结合,从而为用户提供更加沉浸式的增强现实体验。

此外,在机器人导航中,相机贴合对位计算也起到了至关重要的作用。

机器人需要准确地感知周围环境,通过计算相机与目标之间的位姿关系,可以实现机器人的精确导航和操作。

相机贴合对位计算在机器人自主驾驶、无人机导航等领域具有广阔的应用前景。

总之,相机贴合对位计算是一种重要的计算机视觉技术,通过从图像中提取特征点、匹配对应点对并计算相机位姿,可以实现相机和现实世界的精准对位。

相机贴合对位计算的广泛应用将推动虚拟现实、增强现实和机器人导航等领域的快速发展,为我们的生活增添更多的智能和便利。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

系统共两颗相机;左边相机从下往上拍整个手表盖板,搜索圆心为中心,圆上一点为角度;右边相机从上往下拍整个手表液晶模组,同样搜索圆心为中心,圆上一点为角度;计算目标与对象的偏差,执行对位

10. 单目双Mark映射对位应用

系统共两颗相机;左边相机从上往下拍翻转平台整个产品,搜索整个产品外轮廓定出产品中心XY和角度;右边相机从上往下拍对位平台整个产品,搜索整个产品外轮廓定出产品中心XY和角度;计算目标与对象的偏差,执行对位

4.三Mark自对位

系统共三颗相机; 三相机小视野抓取产品上三个Mark , 计算与设定标准位置的偏差,执行对位

5.四Mark自对位

系统共四颗相机;四 相机小视野抓取产品上四个Mark , 计算与设定标准位置的偏差,执行对位

6.四Mark转换对位

系统共四颗相机;左边2颗相机从上往下拍上料平台上产品2个角点, 定出产品中心XY和角度;右边2颗相机从上往下拍对位平台上产品2个角点,定出产品中心XY和角度;计算目标与对象的偏差, 执行对位

MicroDistPro应用领域

印刷机(丝网印刷、钢板印刷等)

钻孔机(PCB等)

切割机(晶片、陶瓷、玻璃等)

曝光机( LCD、PCB等 )

贴合机( TAB、ACF、FPC、LCD、COG等)

点胶机

机械手智能装配

1.单目双/三/四Mark自对位

系统共一颗相机;相机从上往下拍对位平台上整个产品,通过抓取双/三/四Mark; 计算与设定标准位置的偏差,执行对位

MicroDistPro对位系统构成

MicroDistPro视觉对位系统由视觉控制器 、图像采集系统、数字光源控制模块、MicroDistPro系统软件等构成。

支持多种机器人及运动平台

MicroDistPro支持各种主流运动平台 ,快速搭建你的对位系统。

Delta机械手4轴SCARA6轴SCARA

XYθ平台UVW平台

11. 单相机对位(相机移动拍照)

相机安装在一个X方向的轴上,产品在平台上不移动,相机移动拍照产品的两个Mark 点,由于只能做一次对位, 主要用于产品的上下料及预对位。

标准附件-视觉控制器

控制器型号

处理速度

尺寸

相机分辨率

相机数量

中

130万~500万

8

中

130万-500万

2-5

中

130万-1200万

Micro

MicroDistPro视觉对位系统是双翌光电科技专门针对高精度对位需求而自主研发的产品,MicroDistPro视觉对位系统助您快速构建机械手智能装配、机城手上下料、全贴合、偏光片贴合、丝网印刷、CO G 、F O G 、组装、玻璃切割等行业应用。系统操作简单易用、应用广泛、以及强大的兼容性, 是您理想的选择。

2.单目四/六/八Mark映射对位

系统共两颗相机;左边相机从上往下拍上料平台上整个产品,通过抓取二/三/四个Mark计算产品中心XY和角度;右边相机从上往下拍对位平台上整个产品, 通过抓取二/三/四个Mark计算产品中心XY和角度; 计算目标与对象的偏差, 执行对位

3.双Mark自对位

系统共两颗相机;两相机小视野抓取产品上两个Mark , 计算与设定标准位置的偏差,执行对位

2-3

订购信息

应用案例

7.六Mark转换对位

系统共六颗相机;左边3颗相机从上往下拍对位平台上产品3个角点,定出产品中心XY角度;右边3颗相机从上往下拍翻转平台上产品3个角点,定出产品中心XY和角度;计算目标与对象的偏差,执行对位

8.八Mark转换对位

系统共八颗相机;左边4颗相机从上往下拍上料平台上产品4个角点,定出产品中心XY和角度;右边4颗相机从上往下拍对位平台上产品4个角点,定出产品中心XY和角度;计算目标与对象的偏差,执行对位