随机变量独立性的性质

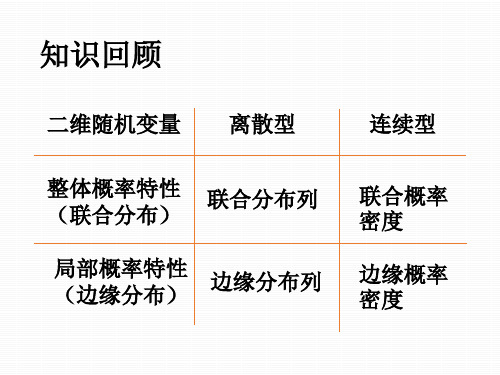

随机变量的独立性

P{ X = 0} = 1 p , P{ Z = 0} = 2 p(1 p) ,

P{ X = 0, Z = 0} = P{ X = 0, X + Y = 1}

= P{ X = 0, Y = 1} = P{ X = 0} P{Y = 1} = p(1 p ) .

2 p(1 p ) 2 = p(1 p ) , p = 0.5 . 令

1 ,若X + Y为偶数, Z= 0 ,若X + Y为奇数. 取何值时, 和 相互独立 相互独立? 问p取何值时,X和Z相互独立? 取何值时

解 首先求出Z的概率分布: 首先求出 的概率分布: 的概率分布

P{ Z = 0} = P{ X + Y = 1}

因为X和 因为 和Y 相互独立

= P{ X = 0, Y = 1} + P{ X = 1, Y = 0}

1 α= . 6

2 β = . 9

5

又由分布律的性质,有 又由分布律的性质 有

1 1 1 1 α + + + +β + =1 9 18 3 9

7 α+β = 18

假设随机变量X和 相互独立 相互独立, 例3 假设随机变量 和Y相互独立,都服从参数为 p(0<p<1)的0-1分布,随机变量 分布, ( ) 分布

f (x, y) = f X ( x) fY ( y) 成立,所以 相互独立.8 成立,所以X,Y相互独立 相互独立.

例5 设(X,Y )的联合密度函数为 ,

8 xy 0 ≤ x ≤ y , 0 ≤ y ≤ 1 f ( x, y) = , 其它 0

1

y

y= x

是否相互独立? 问X与Y是否相互独立? 与 是否相互独立 的边缘密度分别为 解 X,Y的边缘密度分别为

随机变量独立性判断随机变量的独立性和相关性

随机变量独立性判断随机变量的独立性和相关性随机变量的独立性和相关性是概率论和数理统计中的重要概念。

在实际问题中,我们经常需要判断随机变量之间是否相互独立或者相关。

本文将介绍如何判断随机变量的独立性和相关性。

一、什么是随机变量的独立性和相关性随机变量的独立性和相关性描述了随机变量之间的关系。

独立性:若两个随机变量X和Y的联合分布等于各自的边缘分布之积,即P(X=x, Y=y) = P(X=x)P(Y=y),则称X和Y独立。

相关性:若两个随机变量X和Y之间存在某种依赖关系,即它们的联合分布和边缘分布不相等,称X和Y相关。

二、判断随机变量的独立性和相关性的方法1. 统计方法利用样本数据进行统计分析,可以判断随机变量的独立性和相关性。

对于两个随机变量X和Y,如果它们的样本相关系数接近于0,可以认为X和Y近似独立;如果样本相关系数接近于1或-1,可以认为X和Y相关。

2. 图形方法通过绘制散点图可以直观地观察随机变量的相关性。

对于两个随机变量X和Y,如果它们的散点图呈现出线性关系,则可以认为X和Y相关;如果散点图呈现出无规律的分布,则可以认为X和Y近似独立。

3. 利用协方差和相关系数判断协方差和相关系数是判断随机变量相关性的重要指标。

协方差衡量了两个随机变量之间的线性相关性,若协方差为0,则可以认为两个随机变量不相关。

相关系数除了衡量两个随机变量的线性相关性,还可以衡量非线性相关性,相关系数的范围在-1至1之间,绝对值越接近1表示相关性越强,绝对值越接近0表示独立性越强。

三、应用举例1. 抛硬币问题假设一次抛硬币,X表示正面次数,Y表示反面次数。

在这个例子中,X和Y的取值只能是0或1,它们的联合分布如下:P(X=0, Y=0) = 1/2P(X=1, Y=0) = 1/2P(X=0, Y=1) = 1/2P(X=1, Y=1) = 1/2可以看出,X和Y的联合分布等于各自的边缘分布之积,即P(X=x, Y=y) = P(X=x)P(Y=y),因此X和Y是独立的。

2-2-3随机变量的独立性,条件分布

x

FX Y ( x y) pX Y ( x y) d x

x

[ p(x, y)

pY ( y)]d x.

y

FY X ( y x) pY X ( y x) d y

y

[ p(x, y)

pX (x)]d y.

备份题

例1 设

(X,Y )

~

p( x,

y)

Cy(1 0,

x),

0 x 1,0 其 它.

则称X和Y相互独立.

例1 已知 ( X ,Y ) 的分布律为

( X ,Y ) (1,1) (1,2) (1,3) (2,1) (2,2)

111 1

pij

6

9 18

3

(1) 求与应满足的条件;

(2) 若 X 与 Y 相互独立,求 与 的值.

(2,3)

解 将 ( X ,Y ) 的分布律改写为

Y X

1

1

1

6

1

2

3

p• j P{Y yj } 1 2

2 1 9

1

9

3 pi• P{ X xi }

1

1

18

3

1

3

1

18

2

3

(1)由分布律的性质知

0,

0,

2

3

1,

故与应满足的条件是 : 0, 0 且 1 .

3

(2) 因为 X 与 Y 相互独立, 所以有

pij pi• p• j , (i 1,2; j 1,2,3)

xe(x y)dy xe x

0

x>0

pY ( y) 0 xe( x y)dx e y

y >0

即:

3.4 随机变量的独立性

第2页

3.4 随机变量独立性

可以证明如下结论: (1)若 (X,Y)是连续型r.v ,则上述独立性的定义等价于:

对任意的 x, y, 有

f ( x , y ) f X ( x ) fY ( y )

第6页

3.4 随机变量独立性

例3.4.1

1.

P( X P( X P( X P( X

X ,Y 具有分布律右图,则:

1, Y 0) 1 6 P( X 1) P(Y 0) 2, Y 0) 1 6 P( X 2) P(Y 0) 1, Y 1) 2 6 P( X 1) P(Y 1) 2, Y 1) 2 6 P( X 2) P(Y 1)

p ij p i p j

离散型随机变量的联合分布列等于其边缘分布列的乘积

P { X x i | Y y j } p i , , P { Y y j | X x i } p j

任一变量的条件分布列等于其边缘分布列

要判断 X 和 Y 不独立,只需找到 X, Y 的一对取值(xi,yj),使得 P{X xi , Y y j } P{X xi }P{Y y j }.

P( X1 x1i1 )

i2 ,i3 ,in

P( X1 x1i1 , X 2 x2i2 ,, X n xnin )

P( X1 x1i1 , X 2 x2i2 )

f X1 ( x1 )

i3 ,i4 ,in

P( X1 x1i1 , X 2 x2i2 ,, X n xnin )

3.4多维随机变量的独立性

P ( X xi , Y y j ) P ( X xi ) P (Y y j )

则称X和Y相互独立.

例1

Y 0 2/9 0 1/9 1/3 1 1/9 2/9 0 1/ 3 2 0 1/9 2/9 1/3

X

0 1 2

p

X i

pi

1/3 1/3 1/3

p j

例2

Y

若X,Y具有联合分布率

xe ( x y ) , x 0, y 0 f (x, y) f X ( x) fY ( y) f ( x, y ) 故X,Y 独立 0 , 其它

问X和Y是否独立?

解:f X ( x )

0

xe

( x y )

dy xe x , x>0

y

fY ( y) xe

3. 若 (X,Y)是连续型r.v ,则上述独立性的 定义等价于: 对任意的 x, y, 有

f ( x, y) f X ( x) fY ( y)

几乎处处成立,则称X,Y相互独立 .

这里“几乎处处 成立”的含义是: 在平面上除去面 积为0的集合外, 处处成立.

例3

设(X,Y)的概率密度为

一切x, y, 均有

15 45 60

y

x

xy

x

=1/2

1 dy ]dx 1800

40

10

0

15

45

x

1 [60 30 2(10 30 30 30 / 2)] 1800

解二:P(| X-Y| 5) 1 dxdy 1800 | x y | 5

y

60

40

随机变量的独立性

目 录 前一页

( 1,1 ) G 1

后一页

X

退 出

例4 已知二维随机变量( X , Y )的概率密度为:

8 xy, 0 y x 1; f ( x, y ) = 0 , 其他.

问 X , Y 是否相互独立? 解: f X ( x ) =

f ( x, y ) dy

Y ( 1,1 ) G 1

目 录

前一页

后一页

退 出

等价条件: 1. X与 Y 相互独立 F (x , y ) = F X (x )FY ( y ) 2. (离散型)X与Y相互独立 = X P{ = xi ,Y = y j } P{ = xi } P{ = y j } X Y

3. (连续型)X与Y相互独立 f (x , y ) = f X (x ) fY (y ) 在平面上除去“面积”为0 的集合外成 立。

0

X

退 出

fY ( y ) = f ( x, y )dx

1 6 xy 2dx , y 1 0 0 = 0, 其他

3 y 2 , 0 y 1 = 0 , 其他

在区域G中,f X ( x) fY ( y ) = f ( x, y )

Y

X 与 Y 相互独立

目 录 前一页 后一页

x 8 xydy ,0 x 1 0 = 0 , 其他 4 x 3 ,0 x 1 = , 其他 0

0

X

退 出

4 y(1 y 2 ),0 y 1 fY ( y )= , 其他 0

记 G={(x, y ) 0 y x 1}

6 xy 2 , 0 x 1,0 y 1; f ( x, y ) = 0 , 其他.

随机变量的独立性和相关性

随机变量的独立性和相关性随机变量是概率论和数理统计中的重要概念,用于描述随机事件和随机现象的数值特征。

研究随机变量之间的关系对于深入理解概率和统计学的基本原理至关重要。

在这篇文章中,我们将探讨随机变量的独立性和相关性。

一、独立性独立性是指两个或多个随机变量之间的关系,即一个随机变量的取值对另一个随机变量的取值没有任何影响。

如果两个随机变量X和Y 是独立的,那么它们满足以下条件:P(X=x, Y=y) = P(X=x) * P(Y=y)其中P(X=x, Y=y)表示X等于x,Y等于y的概率,P(X=x)和P(Y=y)分别表示X等于x的概率和Y等于y的概率。

换句话说,当两个随机变量独立时,它们的联合概率等于各自的边缘概率的乘积。

独立性的意义在于可以简化概率计算。

如果X和Y是独立的,那么我们可以通过独立事件的性质计算它们的联合概率。

此外,独立性还可以应用于贝叶斯定理、条件概率和协方差等相关概念的推导与计算。

二、相关性相关性是指两个随机变量之间存在某种程度的关联或依赖关系。

如果两个随机变量X和Y相关,那么它们的取值是彼此依赖的,即当X的取值发生变化时,Y的取值也会随之变化。

在统计学中,相关性通过协方差和相关系数来度量。

协方差描述了两个随机变量之间的总体关系,定义为:cov(X,Y) = E[(X - E(X))(Y - E(Y))]其中cov(X,Y)表示X和Y的协方差,E(X)和E(Y)分别表示X和Y的期望(均值)。

协方差的数值可以为负、零或正,分别表示负相关、无相关或正相关。

相关系数是协方差的标准化形式,用于度量两个随机变量之间的线性相关程度。

相关系数的取值范围在-1和1之间,越接近-1或1表示相关性越强,越接近0表示相关性越弱或不存在。

三、独立性与相关性的区别独立性和相关性是两个不同的概念。

独立性是指两个或多个随机变量之间的独立关系,即一个变量的取值对另一个变量的取值没有影响。

相关性是指两个随机变量之间存在某种关联或依赖关系,即一个变量的取值会随着另一个变量的取值而变化。

随机变量的独立性与相关性

随机变量的独立性与相关性随机变量是概率论和统计学中非常重要的概念,它描述了一种具有不确定性的数值变化过程。

在实际应用中,我们经常需要分析随机变量之间的关系,以便更好地理解和应对不确定性。

一、独立性的概念与性质独立性是指两个或多个随机变量之间的关系,在给定其他随机变量的取值时并不影响彼此的概率分布。

具体来说,对于随机变量X 和Y,如果其联合概率分布可以拆解为 X 和 Y 的边缘概率分布的乘积形式,即 P(X,Y) = P(X) * P(Y),则称 X 和 Y 是独立的。

独立性具有以下性质:1. 互斥事件的独立性:如果事件 A 和事件 B 是互斥的,即同时发生的概率为零,那么 A 和 B 是独立的。

这可以通过检验P(A∩B) = P(A) * P(B) 来判断。

2. 集合独立性:对于任意多个事件,如果它们两两独立,那么它们是集合独立的。

也就是说,对于事件集合 {A1, A2, ..., An},如果对于任意的i ≠ j,有P(Ai∩Aj) = P(Ai) * P(Aj),则它们是集合独立的。

3. 独立性的性质传递:如果事件 A 和事件 B 是独立的,事件 B 和事件 C 也是独立的,则事件 A 和事件 C 是独立的。

这可以通过检验P(A∩B∩C) = P(A) * P(B) * P(C) 来判断。

二、相关性的概念与性质相关性描述了两个随机变量之间的线性关系。

具体来说,对于随机变量 X 和 Y,它们之间的相关性可以通过协方差和相关系数来度量。

1. 协方差:协方差用于度量两个随机变量的总体误差。

设 X 和 Y是两个随机变量,它们的期望分别为μx 和μy,协方差定义为 Cov(X,Y) = E[(X-μx)(Y-μy)]。

2. 相关系数:相关系数是协方差的标准化形式,它的取值范围在 -1 到 1 之间。

设 X 和 Y 是两个随机变量,它们的标准差分别为σx 和σy,则相关系数定义为Corr(X,Y) = Cov(X,Y) / (σx * σy)。

概率论与数理统计-第3章-第4讲-随机变量的独立性

1, (x, y) G

f (x, y) 0,

其它.

1

2x

02 随机变量的独立性

例题 设二维离散型随机变量 X, Y 的联合分布律为

应用

Y X

1

1

1 6

2

3

1

1

9

18

2

1 3

试确定常数 , 使得随机变量 X 与Y 相互独立.

02

随机变量的独立性 由表,可得随机变量 X 与Y 的边缘分布律为

P{XY Y 0} P{( X 1)Y 0}

P{X 1 0,Y 0} P{X 1 0,Y 0}

P(X ) P(X ) 1

2

P{X 1}P{Y 0} P{X 1}P{Y 0} 1111 1

22 22 2

第4讲 随机变量的独立性

本节我们学习了二维随机变量的独立性, 后续会推广到更多维. 随机变量的独立性在概率论和数理统计中会发挥重要的作用.

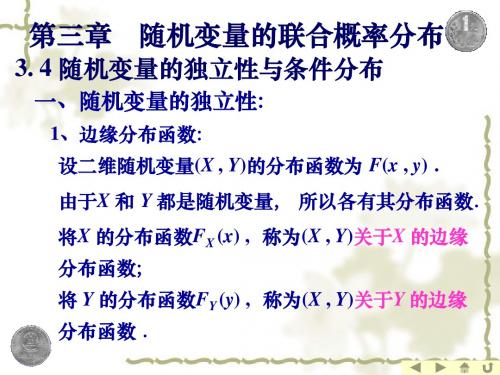

用分布函数表示, 即 设 X,Y 是两个随机变量, 若对任意的x, y, 有 F ( x, y) FX (x)FY ( y)

则称 X, Y 相互独立 .

它表明, 两个随机变量相互独立时, 联合分布函数等于两个 边缘分布函数的乘积 .

01 两个随机变量独立的定义

离散型

X与Y 独立

对一切 i , j 有

01 两个随机变量独立的定义 两个随机变量独立的定义

设 X,Y是两个随机变量, 若对任意的x,y ,有 P ( X x,Y y) P( X x)P(Y y)

则称X,Y相互独立 .

如何判断

两事件A, B独立的定义是: 若 P(AB)=P(A)P(B)则称事件A, B独立 .

01 两个随机变量独立的定义

随机变量的独立性

f (x, y)

fX

(

x)

fY

(

y)

1 4

e

x 2

y

0

x 0, y 0 其他

P( X 2Y )

dx

1

e

x

2

y

dy

0

x/2 4

1 x x e 2 e 4 dx

1 e

3x 4

dx

2

02

02

3

两个随机变量函数的分布

• 随机变量函数的分布:

• 已知随机变量X的分布,如何求随机变量 Y=g(X)的分布

Fmax (z) (F (z))n Fmin (z) 1 [1 F (z)]n

例:设X与Y 独立,均服从U (0, 1), 分别求M max( X ,Y ), N min( X ,Y )的概率密度。

0, x 0

解:X、Y的分布函数F ( x)

x,

0

x

1

1, x 1

0, x 0

例:设X与Y 独立,且 X, Y 等可能地取值 0和1. (1)求 U = max(X, Y) 的分布列. (2)求V = X+Y的分布列.

解: X 0 1 p 1/2 1/2

Y0 1 P 1/2 1/2

(1) U = max(X, Y) 的取值为: 0, 1

P(U=0) = P(X=0, Y=0) = P(X=0)P(Y=0) =1/4

Fmin (z) P( N z) 1 P( N z) 1 P( X z,Y z) 1 P( X z)P(Y z)

即 Fmin (z) 1 (1 FX (z))(1 FY (z))

推广:

设X1, X2 ,, Xn是n个相互独立的随机变量,它们的分布函数分别

高等数学3.4 随机变量的独立性与条件分布

2 3/15 3/15

0 1

(2) 由( X , Y ) 的联合分布律知 X 的边缘分布为 X P 0 1/15 1 10/15

由条件分布定义可知

P Y = 0 X = 0 = P Y = 1 X = 0 = P Y = 2 X = 0 =

P X = 0 , Y = 0 P X = 0 P X = 0 , Y = 1 P X = 0 P X = 0 , Y = 2 P X = 0

Y P

1 1/2

2 1/9 +α

3 1/18 +β

若X 与 Y 相互独立, 则有 1 = P X = 1, Y = 2 = P X= 1 9 1 1 = ( + ) 3 9 1 = P X = 1, Y= 3 = P X =1 18 1 1 = ( + ) 3 18

Y P = 2

dt

=

同理

x R

fY ( y ) =

( y 2 )2 exp , 2 2 2 2 2 1

y R

若 = 0 , 则对于任意实数 x 与 y 都有 f ( x, y ) = f X ( x )fY ( y ) 因此 X 与 Y 是相互独立的 . 反之, 若 X 与Y 相互独立, 则对于任意实数 x与 y 都有 f ( x, y ) = f X ( x )fY ( y ) 若取 x = 1 , y = 2 , 则有

1 2

2

2 2 ( x ) ( x ) 2 2 1 1 + 2 2 1 1

y 2 ( x 1 ) x 1 1 = 2 2 1 2 1 2(1 ) 2

2

所以( X , Y )关于X的边缘密度为

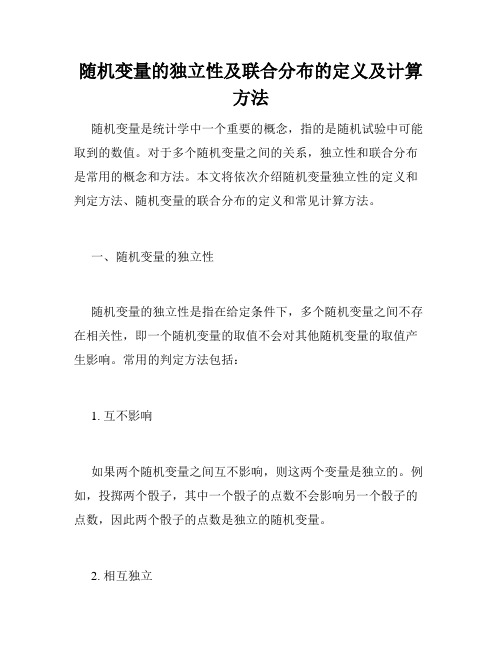

随机变量的独立性及联合分布的定义及计算方法

随机变量的独立性及联合分布的定义及计算方法随机变量是统计学中一个重要的概念,指的是随机试验中可能取到的数值。

对于多个随机变量之间的关系,独立性和联合分布是常用的概念和方法。

本文将依次介绍随机变量独立性的定义和判定方法、随机变量的联合分布的定义和常见计算方法。

一、随机变量的独立性随机变量的独立性是指在给定条件下,多个随机变量之间不存在相关性,即一个随机变量的取值不会对其他随机变量的取值产生影响。

常用的判定方法包括:1. 互不影响如果两个随机变量之间互不影响,则这两个变量是独立的。

例如,投掷两个骰子,其中一个骰子的点数不会影响另一个骰子的点数,因此两个骰子的点数是独立的随机变量。

2. 相互独立如果多个随机变量之间的任意两个变量都是独立的,则这些随机变量是相互独立的。

例如,投掷三个骰子,每个骰子的点数都是独立的随机变量,因此三个骰子的点数是相互独立的随机变量。

3. 独立性定义下的概率乘法公式对于两个独立的随机变量X和Y,它们同时取到某个值的概率等于它们各自取到这个值的概率的乘积。

即P(X=x,Y=y)=P(X=x)P(Y=y)。

该公式也适用于多个独立的随机变量。

二、随机变量的联合分布多个随机变量的联合分布是指这些随机变量取值组合所对应的概率分布函数。

常用的计算方法包括:1. 联合分布函数对于两个随机变量X和Y,它们的联合分布函数定义为F(x,y)=P(X<=x,Y<=y)。

该函数可以用来计算任意两个随机变量的联合分布。

对于多个随机变量,联合分布函数的定义相应地拓展。

2. 联合概率密度函数对于连续型随机变量,它们的联合概率密度函数可以通过对应的联合分布函数求导得到。

即f(x,y)=∂^2 F(x,y)/∂x∂y。

该函数可以用来计算任意两个连续型随机变量的联合分布。

对于多个连续型随机变量,联合概率密度函数的定义相应地拓展。

3. 边缘分布和条件分布对于联合分布中的任意一个随机变量,我们都可以将它的概率分布函数单独计算出来,称为边缘分布。

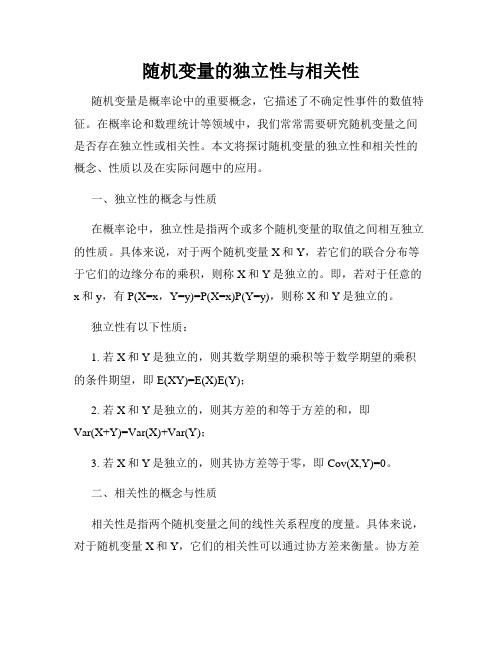

随机变量的独立性与相关性

随机变量的独立性与相关性随机变量的独立性与相关性是概率论和数理统计中重要的概念。

独立性是指两个或多个随机变量的取值之间没有相互影响的关系,而相关性则描述了随机变量之间的线性关系程度。

本文将分别介绍随机变量的独立性和相关性的定义、性质以及其在实际问题中的应用。

一、随机变量的独立性在概率论中,独立性是指两个或多个随机变量在任意条件下都是互相独立的。

具体而言,对于随机变量X和Y,如果对于任意的实数a 和b,满足以下等式:P(X ≤ a, Y ≤ b) = P(X ≤ a) · P(Y ≤ b),则称X和Y是独立的。

其中,P(X ≤ a, Y ≤ b)表示事件{X ≤ a}和{Y ≤ b}同时发生的概率。

独立性是一种极为重要的性质,它使得概率计算更加简化。

在实际问题中,我们可以利用独立性假设来简化分析,提高计算的效率。

例如,在投掷硬币的实验中,每一次投掷的结果都是独立的,因此可以通过简单的概率计算来确定投掷n次后获得正面朝上的次数。

二、随机变量的相关性相关性是指随机变量之间的线性关系程度。

对于两个随机变量X和Y,其相关性可以通过协方差或相关系数来衡量。

1. 协方差随机变量X和Y的协方差定义为:Cov(X, Y) = E[(X - E(X))(Y - E(Y))],其中,E(X)和E(Y)分别表示X和Y的期望值。

协方差可以看作是X与Y共同变动的程度。

如果Cov(X, Y) = 0,则称X和Y是不相关的。

如果Cov(X, Y) > 0,则X和Y是正相关的;如果Cov(X, Y) < 0,则X和Y是负相关的。

2. 相关系数相关系数是协方差的归一化形式,可以消除量纲的影响。

随机变量X和Y的相关系数定义为:ρ(X, Y) = Cov(X, Y) / (σ(X)σ(Y)),其中,σ(X)和σ(Y)分别表示X和Y的标准差。

相关系数的取值范围在-1到1之间,且满足如下性质:若ρ(X, Y) = 0,则X和Y不相关;若ρ(X, Y) > 0,则X和Y正相关;若ρ(X, Y) < 0,则X和Y负相关。

随机变量的独立性与相关性

随机变量的独立性与相关性随机变量是概率论中的重要概念,它描述了不确定性事件的数值特征。

在概率论和数理统计等领域中,我们常常需要研究随机变量之间是否存在独立性或相关性。

本文将探讨随机变量的独立性和相关性的概念、性质以及在实际问题中的应用。

一、独立性的概念与性质在概率论中,独立性是指两个或多个随机变量的取值之间相互独立的性质。

具体来说,对于两个随机变量X和Y,若它们的联合分布等于它们的边缘分布的乘积,则称X和Y是独立的。

即,若对于任意的x和y,有P(X=x,Y=y)=P(X=x)P(Y=y),则称X和Y是独立的。

独立性有以下性质:1. 若X和Y是独立的,则其数学期望的乘积等于数学期望的乘积的条件期望,即E(XY)=E(X)E(Y);2. 若X和Y是独立的,则其方差的和等于方差的和,即Var(X+Y)=Var(X)+Var(Y);3. 若X和Y是独立的,则其协方差等于零,即Cov(X,Y)=0。

二、相关性的概念与性质相关性是指两个随机变量之间的线性关系程度的度量。

具体来说,对于随机变量X和Y,它们的相关性可以通过协方差来衡量。

协方差Cov(X,Y)反映了X和Y的变动方向是否一致,其具体定义为Cov(X,Y)=E[(X-E(X))(Y-E(Y))]。

相关性有以下性质:1. 相关性的取值范围为[-1, 1],当相关性为1时,表示X和Y之间存在完全正相关关系,当相关性为-1时,表示X和Y之间存在完全负相关关系,当相关性为0时,表示X和Y之间不存在线性关系;2. 相关性不具有传递性,即若X与Y相关,Y与Z相关,不能得出X与Z相关的结论;3. 对于函数变换,相关性具有保持不变的性质,即如果X和Y相关,则g(X)和h(Y)也相关,其中g和h为任意函数。

三、独立性与相关性的区别与联系独立性和相关性都是描述随机变量之间关系的概念,但两者有本质的区别。

独立性是一种较强的关系,表示两个随机变量之间的完全独立,不受彼此影响。

随机变量的独立性

1

1 2

P (U 0 , V 1) P ( X Y , X 2 Y ) 0

G

O 1 2 x

(U,V)的联合分布律和边缘分布律为 V

U

0 1/4 1/4

1/2

1 0 1/2

1/2

pi• 1/4 3/4

0 1

p•j

经检验, pij≠pi• •p•j

所以,U和V不是相互独立的。

随机变量X与Y是相互独立的充要条件是事件(X≤x)与 事件(Y≤y)相互独立。

• 定理1 随机变量X,Y相互独立的充分必要条件 是X所生成的任何事件与Y所生成的任何事件相 互独立。即,对任意的实数集A,B有:

P { X A , Y B } P { X A } P { X B}

定理2 如果随机变量X,Y相互独立, 则对任意函数g1(x), g2(y)有 g1(X), g2(Y)相互独立

例3.17 设二维随机变量(X,Y) f ( x, y ) 具有概率密度函数 (1)求X,Y的边缘概率密度;

15 x 2 y 0

y

0 x y 1 其它

(2)问X与Y是否相互独立?

1

解

f X (x)

f ( x , y ) dy

15 2 4 (x x ) 2 0 0 x 1 其它

P (U 0 , V 0 ) P ( X Y , X 2 Y ) P ( X Y )

1 1

( x, y ) G ( x, y ) G

0

x y

f ( x , y ) dxdy

dx 2 dy

0 x

1

随机变量的独立性和相关性

随机变量的独立性和相关性引言在概率论和统计学中,随机变量的独立性和相关性是两个重要的概念。

随机变量是指具有随机特性的变量,独立性和相关性描述了随机变量之间的关系。

本文将介绍随机变量的独立性和相关性的概念以及它们的性质和重要性。

独立性随机变量的独立性是指当一个随机变量的取值不受另一个随机变量的取值影响时,两个随机变量是独立的。

具体来说,对于两个随机变量X和Y,如果它们的联合概率分布可以分解为它们各自的边缘概率分布的乘积,即P(X=x, Y=y) = P(X=x)P(Y=y),那么X和Y是独立的。

独立性的性质:- 独立性是对称的,即如果X和Y独立,则Y和X也独立。

- 独立性是传递的,即如果X和Y独立,Y和Z独立,则X和Z独立。

独立性的重要性:独立性在概率论和统计学中具有重要的应用,例如:- 在概率计算和推导中,独立性假设可以简化问题的复杂性。

- 在统计推断中,独立性假设可以用来进行参数估计和假设检验。

相关性随机变量的相关性是指随机变量之间的线性关系程度。

具体来说,对于两个随机变量X和Y,它们的相关性可以通过协方差和相关系数来度量。

协方差(covariance)是衡量两个随机变量之间的相关性的统计量,定义为两个随机变量的乘积的期望与两个随机变量各自的期望的乘积的差值。

协方差的值可以为正、负或零,分别表示正相关、负相关或无相关。

相关系数(correlation coefficient)是协方差标准化后的值,用于度量两个随机变量之间的线性关系程度。

相关系数的取值范围为-1到1,取得负值表示负相关,取得正值表示正相关,取得0表示无相关。

相关性的性质:- 相关性也是对称的,即X和Y的相关系数等于Y和X的相关系数。

- 相关性不一定表示因果关系,只是表示两个随机变量之间的线性关系程度。

相关性的重要性:相关性在统计分析和模型建立中具有重要的应用,例如:- 可以用相关系数判断两个随机变量之间是否存在线性关系。

- 可以用相关分析来探索随机变量之间的相互作用和影响程度。

随机变量的独立性

定义3. 7 设X 和Y 为两个随机变量,若对于任意的x 和y 有 P{X x,Y y} P{X x}P{Y y},

则称X 和Y 是相互独立的( Mutually independent )。

若二维随机变量( X , Y )的分布函数为 F (x,y) ,其边缘分

布函数分别为FX (x)和FY (y),则上述独立性条件等价于对所有x 和y 有

fY

(

y)

e y,y

0,

0, 其他。

求X 和Y 的联合概率密

度 f (x,y) 。

解 由X 和Y 相互独立可知

f (x,y) fX (x) fY ( y)

e(xy),x 0,y 0,

0,其他。

概率学与数理统计

F (x,y) FX (x)FY ( y) 。

(3.13)

1. 对于二维离散型随机变量,上述独立性条件等价于对于

( X , Y )的任何可能取的值 (xi,y j ) 有

P{X x,Y y} P{X xi}P{Y y j}。

(3.14)

2. 对于二维连续型随机变量,独立性条件的等价形式是对

一切x 和y 有

f (x,y) fX (x) fY ( y) ,

(3.15)

这里, f (x,y)为( X , Y )的概率密度函数,而 fX (x) 和 fY ( y)

分别是边缘概率密度函数。

如在例3.7中,(1)有放回摸球时,X 与Y 是相互独立的;而

(2)无放回摸球时,X 与Y 不是相互独立的。

π

1 y2,1 0,

y 1, 其他。

可见在圆域 x2 y2 1 上,f (x,y) fX (x) fY ( y) ,故X 和Y 不相

互独立。

概率论与数理统计 4.4 随机变量的独立性

0

1

9

6

0

25 25

6

4

1

25 25

P{ X1

0,

X2

0}

66 10 10

9 25

类似可得其余三个联合概率(见上表)。

再讨论边缘分布

(1)不放回抽取

X2 X1

0

1

pi•

1

4

3

0

3 15

5

4

2

2

1

15 15

5

p• j

3

2

5

5

X1 0

1

3

2

P

5

5

X2 0

1

P3

2

5

5

(2)有放回抽取

X2 X1

0

1

pi•

P(X xi ,Y y j ) P(X xi )P(Y y j )

即

pij pi. p. j

则称 X 和Y 相互独立.

二、例题

概率论

例1 设(X,Y)的概率密度为

xe( x y) , x 0, y 0

f (x, y)

0, 其它

问X和Y是否独立?

解

fX (x)

xe( x y)dy xe x ,

直接求面积

40

P(X <Y) =P(X >Y) =1/2

10

0 15

概率论

x y 5 xy5

45

x

xy

45

x

例3:设( X ,Y )服从二维正态分布,则X与Y相互独立 的充要条件是 0.

证明 : 先证充分性

若

1 0, f ( x, y)

21 2

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

议随机变量独立性及其应用作者:张利荣 指导老师:桂春燕摘要 随机变量的独立性是概率论中的一个重要概念.本文首先介绍了随机变量独立性的定义,随机变量独立性的性质,然后对离散型随机变量和连续型随机变量的独立性分别给出了不同的判别方法,从而针对不同的问题运用相应的判别方法进行判定,除此还通过随机变量独立性的性质及其判别方法得出了一些相关的推论,并对其应用进行了举例说明.关键词 离散型随机变量 连续型随机变量 独立性 联合分布1 引言概率统计是研究随机现象中数量规律的一门数学学科,它是近代数学的重要分支,理论严谨、应用广泛,并且与其他学科互相渗透结合.概率论是对随机现象统计规律演绎的研究,由于随机现象的普遍性,使得其具有极其广泛的应用,特别是在科学技术、工农业生产等方面.独立性是概率统计中最基本的概念之一,无论在理论研究还是在实际应用中都具有特别重要的意义.概率论和数理统计已有的成果大部分都是在某种独立性的前提下才得到的.因而随机变量独立性的研究倍受重视.随机变量独立性的研究一直经历着缓慢的发展过程.进入二十世纪九十年代后,随机变量独立性判定的研究进入了一个新的阶段.关于这方面的著作、文献逐渐多了起来,如文献[2]中毛纲源对随机变量独立性的判定进行了分析并举例说明;文献[7]中明杰秀等对二维随机变量独立性的判定及其应用等相关内容进行了论述.本文将在此基础上对随机变量独立性做一下详细、全面的论述,重点介绍离散型随机变量和连续型随机变量独立性的判定方法,并对随机变量的独立性的应用进行举例说明.2 随机变量独立性的定义定义]1[ 设),(Y X 为二维随机变量,若对于任意的实数y x ,,事件{}x X ≤与{}y Y ≤相互独立,即()()()y Y P x X P y Y x X P ≤⋅≤=≤≤, ,)1(则称X 与Y 相互独立.若()y x F ,为X 与Y 的联合分布函数,()x F X 、()y F Y 分别是X 与Y 的边缘分布函数,则)1(式等价于()()()y F x F y x F Y X ⋅=,.3 随机变量独立性的性质及其判别方法3.1 离散型随机变量独立性的判定判别法一定理1 设二维离散型随机变量()Y X ,的联合分布列为()j i ij y Y x X P p ===,, () ,2,1;2,1==j i ,X 的边分缘布列是()i i x X P p ==⋅,() ,2,1=i ,Y 的边缘分布列是()j j y Y P p ==⋅,() ,2,1=j ,则X 和Y 相互独立的充要条件为:对所有的取值()j i y x ,有() ,2,1;,2,1,==⋅=⋅⋅j i p p p j i ij .证明 充分性:若() ,2,1,,2,1,==⋅=⋅⋅j i p p p j i ij ,因为()Y X ,是二维离散型随机变量,所以对任意的y x ,有()(),,()()()()i j i j i j i j ij i j x x y yij i jx x y yx xy yi j x xy yp P X x Y y P X x Y y p p p P X x P Y y P X x P Y y ≤≤⋅⋅≤≤≤≤≤≤=≤≤=====⋅====≤≤∑∑∑∑∑∑∑∑即X 和Y 相互独立.必要性:若X 和Y 相互独立,不妨设123123,i j x x x x y y y y <<<<<<<<<<,则对任意y x ,,有()()()y Y P x X P y Y x X P ≤⋅≤=≤≤,.当11,y y x x ==时,有()()()1111,y Y P x X P y Y x X P ≤⋅≤=≤≤,即()()()1111,y Y P x X P y Y x X P =⋅====,亦即1111⋅⋅⋅=p p p . )2(如此进行下去,最后可得() ,2,1,11=⋅=⋅⋅j p p p j j .如此下去,最后得出.() ,2,1,,2,1,==⋅=⋅⋅j i p p p j i ij .由此定理得证.例1 设随机变量X 和Y 相互独立,并且有{}{}p Y P X P ====11,{}==0X P {}q p Y P =-==10,10<<p ,定义随机变量ζ为⎩⎨⎧++=.0,1为奇数若,为偶数;若Y X Y X ζ 问当p 取何值时,X 和ζ相互独立?解 由于{}{}{}0,01,11======Y X Y X ζ, {}{}{}0,11,00======Y X Y X ζ,所以{}{}{}{}2111,11,1p Y P X P Y X P X P ==⋅=======ζ,{}{}{}{}pq Y P X P Y X P X P ==⋅=======010,10,1ζ, {}{}{}{}2000,01,0q Y P X P Y X P X P ==⋅=======ζ,{}{}{}{}pq Y P X P Y X P X P ==⋅=======101,00,0ζ.由此得()ζ,X 的联合分布列及其边缘分布列如表1所示.表 11j p ⋅ 0pq 2q q 1pq2pp⋅i ppq 222q p +1为使X 和ζ相互独立,有ζX()()2222222,,2,.pqq pq p q q q pqp pq p q p p =⎧⎪+=⎪⎨=⎪⎪+=⎩ 由于10<<p ,故方程组的解为21=p ,即当21=p 时,X 和ζ相互独立.判别法二:设()Y X ,是二维离散型的随机变量,它的联合概率分布列为()j i ij y Y x X P p ===,, () ,2,1,=j i 可以用下表所示表 21y2yj y1x 11p12p j p 1 2x 21p22pj p 2i x 1i p2i pij p且∑∑=≥ijijij pp 1,0,矩阵⎪⎪⎪⎪⎪⎪⎭⎫⎝⎛=ij i i j j p p p p p p p p p A 212222111211称为()Y X ,的联合概率分布矩阵,其行向量记为()() ,2,1,,,,,21==i p p p a ij i i i ,记()Y X ,的联合分布列()A Y X ~,.引理]7[ 设1α是非零向量,1α和2α线性相关,则2α可由1α线性表出.证明 因为1α和2α线性相关,所以存在不全为零的两个数1λ和2λ,使得YX02211=+ααλλ,又因为1α是非零向量,如果02=λ,则01=λ,则02≠λ,所以1212ααλλ-=, 即2α可由1α线性表出.定理2 若()A Y X ~,,则X 与Y 相互独立的充要条件是联合概率矩阵的任意两个行向量(或列向量)线性相关.证明 充分性:若A 中任意的两个行向量线性相关,由∑∑=≥ijijij pp 1,0,则A 中至少有一个元素不为零,即至少有一个非零行向量,不妨设1α是非零向量,由引理可知,2α,3α ,,i α都可以由1α线性表示,则() ,2,1,1==i k i i αα,11=k ,且⎪⎪⎪⎪⎪⎪⎭⎫⎝⎛=j i i i j jp k p k p k p k p k p k p k p k p k A 112111212211211121111, 这里() ,2,1,,1=⋅=j i p k p j i ij ,且111∑∑∑∑∑∑===ijijj i ji ijijp k p k p .又由于X ,Y 的边缘分布分别为:()∑∑===jj i jij i p k p x X P 1,()∑∑∑⋅====ii j ij i iij j k p p k p y Y P 11,因此()()),,(1111j i jiij j i iij jj i iij jij j i y Y x X P k p p k k p p k p p y Y P x X P ===⋅=⋅===⋅=∑∑∑∑∑∑即X 与Y 相互独立.必要性:若X 与Y 相互独立,由j i ij p p p ⋅⋅=,则A 中的任意两个行向量可写为()() ,,,,,,,,2121j m j m m m m p p p p p p p p p p ⋅⋅⋅⋅⋅⋅⋅⋅⋅⋅==α,()() ,,,,,,,,2121j n j n n n n p p p p p p p p p p ⋅⋅⋅⋅⋅⋅⋅⋅⋅⋅==α,显然m α与n α线性相关.推论1 若()A Y X ~,,则X 与Y 相互独立的充要条件是矩阵A 的任意两行(或两列)对应元素成比例.推论2 若()A Y X ~,,则X 与Y 不相互独立的充要条件是存在矩阵A 的任意两个行向量(或列向量)线性无关.推论3 若()A Y X ~,,则X 与Y 不相互独立的充要条件是存在矩阵A 的任意两行(或两列)对应元素不成比例.推论4 若()A Y X ~,,则X 与Y 相互独立的充要条件是矩阵A 的秩为1. 推论5 若()A Y X ~,,则X 与Y 不相互独立的充要条件是矩阵A 的秩大于1. 推论6 若()A Y X ~,中有某个0=ij P ,但元素ij P 所在的行与列的所有元素不全为零,则X 与Y 不相互独立.例2 从一只装有三个黑球和二个白球的口袋中取球两次,每次去一个球,设⎩⎨⎧=.,1;,0第一次取出黑球第一次取出白球X ⎩⎨⎧=.,1;,0第二次取出黑球第二次取出白球Y分别在放回抽样和不放回抽样的试验条件下写出二维随机变量()Y X ,的联合分布列,并判别X 与Y 的相互独立性.解 1)放回抽样:二维随机变量()Y X ,的联合分布列为:表 31254 256 1256 259 且⎪⎪⎭⎫ ⎝⎛→⎪⎪⎭⎫ ⎝⎛→⎪⎪⎪⎪⎭⎫ ⎝⎛=00329664259256256254A , 因此()1=A r ,故X 与Y 相互独立.2)不放回抽样:二维随机变量()Y X ,的联合分布列为:YX表 41202 206 1206 206 且⎪⎪⎭⎫ ⎝⎛→⎪⎪⎭⎫ ⎝⎛→⎪⎪⎪⎪⎭⎫ ⎝⎛=10316662206206206202A , 因此()12>=A r , 所以X 与X 不相互独立.3.2 连续型随机变量独立性的判定判别法一:定理3 设()Y X ,是二维连续型随机变量,若它们的联合密度函数和边缘分布函数分别为()()()y f x f y x f Y X ,,,,并且都是除面积为零的区域外的连续函数,则X 和Y 相互独立的充要条件为:除面积为零的区域外,恒有()()()y f x f y x f Y X ⋅=,.证明 充分性:设()()()y f x f y x f Y X ⋅=,,则对任意的实数y x ,,有()()()()⎰⎰⎰⎰∞-∞-∞-∞-==xy x yY X u v v f u f u v v u f y x f d d d d ,,()()()()y f x f v v f u u f Y X y Y xX ==⎰⎰∞-∞-d d .所以,X 和Y 相互独立.必要性:设X 和Y 相互独立,则有()()()()()⎰⎰⎰⎰∞-∞∞-∞==yY X YXx y v v f u u f y f x f u v v u f d d d d ,x--()()⎰⎰∞-∞-=x yY X u v u f u f d d .因为上式对任意的y x ,都成立,于是有()()()y f x f y x f Y X ⋅=,,综上,定理得证.例3]1[ 若()Y X ,的联合密度函数为()⎩⎨⎧≤≤≤≤=其他,,0;10,0,8,y y x xy y x f问X 和Y 是否相互独立?解 先分别求X 和Y 的边缘密度函数:YX当0<x 或1>x 时,()0=x f X .当10≤≤x 时,有()3144d 8x x y xy x f xX -==⎰.因此()⎩⎨⎧≤≤-=.,0;10,443其他x x x x f X 当0<y 或1>y 时,()0=y f Y .当10≤≤y 时,()3048y dx xy y f yY ==⎰.因此()⎩⎨⎧≤≤=.,0;10,43其他y y y f Y很明显,()()()y f x f y x f Y X ≠,,所以X 和Y 不相互独立.判别法二定理]2[4 设),(Y X 是连续型随机变量, 其联合密度函数为⎩⎨⎧≤≤≤≤=.,0;,),,(),(其他d y c b x a y x f y x F 则随机变量相互独立的充要条件为(i) 存在连续函数)(),(y g x h 使)()(),(y g x h y x f =. (ii)d c b a 、、、 是分别与y x 、 无关的常数.证明 充分性: 首先分别求随机变量),(Y X 对y x 、 的边缘密度函数.⎰⎰⎰⎰⎰⎰∞∞-∞∞-======b abaY d cdcX dx x h y g dx y g x h dx y x F y f dy y g x h dy y g x h dy y x F x f .)()()()(),()(,)()()()(),()(d c b a 、、、是分别与y x 、 无关的常数, 所以上式积分中的结果⎰d c dy y g )( 与⎰ba dx x h )(是分别与y x 、 无关的常数, 分别记为B A 、 进一步由联合密度函数的性质,有(,)()()()()()()()()()()(,)b dbdacacX Y bdacf x y dxdy h xg y dxdyf x f y h xg y ABh x g y h x dx g y dyf x y =====⎰⎰⎰⎰⎰⎰即)()(),(y f x f y x f Y X = 故Y X ,相互独立.必要性: 若Y X , 相互独立, 有)()(),(y f x f y x f Y X =, ,,d y c b x a ≤≤≤≤取)()(),()(y g y f x h x f Y X ==, 则有)()(),(y g x h y x f =, 所以定理中的条件1) 成立. 以下用反证法证明,若d c b a 、、、中至少有一个是与x 或y 有关的函数,不妨设)(y a a =,由于)()(x h x f X = 是关于x 的边缘密度函数, 必有1)(=⎰dx x f b aX , 而)()(y Ag dx x f baX =⎰是一个与y 有关的不恒为1的y 的函数, 与前述结果矛盾.因此必有a 与y 无关,进一步可得d c b a 、、、都应与y 无关, 从而必要性得以证明.推论1 定理4 的条件中如果c a 、 有一个或两个都趋于d b 、,∞- 中有一个或两个都趋于∞+,则定理的结果也成立.推论2 若上述定理的条件成立, 则)(x h 与)(x f X 呈正比例关系,)(y g 与)(y f Y 呈正比例关系.在n 维连续型随机变量场合, 我们有定理5 设),,,(21n X X X 是连续型随机变量, 其联合密度函数为),,,(21n x x x f , 满足n i b x a x x x f i i i n ,,2,1,,0),,,(21 =≤≤> 则随机变量n X X X ,,,21 相互独立的充要条件为(i) 存在连续函数n i x h i i ,,2,1),( =, 满足∏==ni iin x h x x x f 121)(),,,( .(ii))1(,n i b a i i ≤≤ 均为与n x x x ,,,21 无关的实常数.证明 充分性: 设),,,(21n x x x f 满足条件(i)与(ii) , 则可求得)1(n i X i ≤≤ 的边缘分布函数为1112121111()(,,,)()()()(),,i n nj jX i n nb b n n na ab i i j j j i i i a j i nf x f x x x dx dx dx h x h x dx dx h x h x dx a x b +∞+∞-∞-∞≤≠≤===≤≤⎰⎰⎰⎰∏⎰而当[]i i i b a x ,∉时, n i x f i X i ,,2,1,0)( ==. 又因其中)1(,n i b a i i ≤≤均为与n x x x ,,,21 无关的实常数, 故上述积分j j b a j dx x h jj)(⎰,n j ,,2,1 = 分别是与n x x x ,,,21 无关的实常数, 故记为,,,2,1,)(n j dx x h A j j b a j j jj==⎰则当)1(n i b x a i i i ≤≤≤≤ 时, 有112111221121))(,,,())(()()()()()(21-=-=∏∏==n ni i n n ni i n n n X X X A x x x f A x h x h x h x f x f x f n其中n n b a n b a b a ni i dx x h dx x h dx x h A nn)()()(22211112211⎰⎰⎰∏== ,而n n b b a a ,,,,,11 与n x x x ,,,21 无关, 故(1) 式可合并为n 重积分, 即1),,,()()(212121111111122===⎰⎰⎰⎰⎰∏=nb a b a n nn n b a b a b a ni i dx dx dx x x x f dx dx dx x h x h A n nnn故),,,()()()(212121n n X X X x x x f x f x f x f n =,即n X X X ,,,21 相互独立.必要性: 设n X X X ,,,21 相互独立, 则有)()()(),,,(212121n X X X n x f x f x f x x x f n =成立.此时只须取n i x f x h i X i i i ,,2,1),()( ==, 故条件(i) 成立.现假定条件(ii) 不成立, 则)1(,n i b a i i ≤≤中至少有一个是与n x x x ,,,21 有关的函数, 不妨设),,,(2111n x x x a a =, 由于)()(1111x h x f X = 是关于1X 的边缘密度函数, 则必有.1)()(1111111111==⎰⎰b a X b a dx x f dx x h而此时),,,()(21),,,(1112111n b x x x a X x x x Ag dx x f n =⎰是关于n x x x ,,,21 的函数, 并非恒等于1. 这于上式相矛盾, 因而必有1a 与n x x x ,,,21 无关. 同理证得)1(,n i b a i i ≤≤均与n x x x ,,,21 无关. 从而条件(ii) 满足. 必要性得证. 由上述连续型随机变量的定理4及其对应的推论进行判别X 与Y 的独立性,该定理的方便之处在于不需要求边缘分布函数,故用此方法判别连续型随机变量的独立性比较容易. 例4 设()Y X ,的联合密度函数为()2222122,,0;,220,.x ny n n n y e x y f x y n π+--⎧⎛⎫⎪ ⎪⎪⎝⎭⎪-∞<<+∞<<+∞=⎨⎛⎫Γ ⎪⎪⎝⎭⎪⎪⎩其他 讨论Y X ,的独立性.解 令()()2222122222x nny n n h x e g y y e n π---⎛⎫ ⎪⎝⎭==⋅⎛⎫Γ ⎪⎝⎭,, 则有()()()y g x h y x f ⋅=,,又因为∞→=∞→∞→d c b a ,0,,,由推论7可知Y X ,相互独立.4 随机变量独立性的应用 应用一 由离散型随机变量的独立性及其边缘分布列,求其联合分布列.例5 n 重贝努里试验中,若令i X 表示第i 次试验中事件A 出现的次数).,,2,1(n i =请写出),,,(21n X X X 的联合分布列.解 ),,2,1(.,0,1n i A i A i X i =⎩⎨⎧=不出现次试验第出现;次试验第令 其分布列为 ).,,2,1)(1,0()(1n i x q p x X P i x x i i i i ====-由试验的独立性知,n X X X ,,,21 相互独立,得出),,,(21n X X X 的联合分布列为).1,0(),,,(112211=∑∑======-i x n x n n x q p x X x X x X P n i in i i应用二 利用离散型随机变量的独立性确定分布中的参数.例6 设二维随机变量),(Y X 的联合分布律为 1x 2x 3x1ya 91 cY X2y 91 b 31 若X 与Y 相互独立,求参数c b a 、、的值.解 由随机变量的独立性及联合分布律的基本性质:⎪⎪⎩⎪⎪⎨⎧==⨯====≥⋅⋅∑∑),2,1;,2,1(;1),2,1;,2,1(0 j i p p p p j i p j i ij i j ij ij 得出X 与Y 的边缘分布律: 1x 2x 3x j P ⋅1y a 91 c 911++=⋅c a p 2y 91 b 31 31912++=⋅b p ⋅i p 911+=⋅a p 912+=⋅b p 313+=⋅c p ∑∑===31311i j ij p从而解得⎪⎪⎪⎩⎪⎪⎪⎨⎧===6192181c b a 注意 求出c b a 、、后,要验证它们对任意j i ,是否均满足.j i ij p p p ⋅⋅⨯=若不满足,则所求参数不符合要求,舍去.通过验证上面所求得的c b a 、、的值均满足条件,故上面c b a 、、的值为所求.应用三 利用连续型随机变量的独立性求常用分布函数的联合概率密度.例7 设随机变量X 和Y 相互独立,并且X 服从),(2σμN ,Y 在],[b b -上服从均匀分布,求),(Y X 的联合概率密度函数.解 因为X 和Y 相互独立,所以 )()(),(y f x f y x f Y X =.又);(,21)(222)(+∞<<-∞=--x e x f x X σμσπYX⎪⎩⎪⎨⎧≤≤-=.,0,,21)(其他b y b b y f Y 得:,2121),(222)(σμσπ--⋅=x e b y x f其中.,b y b x ≤≤-∞<<∞-当b y >时,.0),(=y x f应用四 随机变量的独立性与实际生活相结合例8 一负责人到达办公室的时间均匀分布在12~8时,他的秘书到达办公室的时间均匀分布在9~7时,设他们到达的时间相互独立求他们到达办公室的时间相差不超过5分钟的概率.解 如图所示,设负责人和他秘书到达办公室的时间分别记为X 和Y ,则X 和Y 的概率密度分别为⎪⎩⎪⎨⎧<<=⎪⎩⎪⎨⎧<<=.,0;97,21)(.,0;128,41)(其他其他y y f x x f Y X由于X 和Y 相互独立,得),(Y X 的概率密度为⎪⎩⎪⎨⎧<<<<==.,0;97,128,81)()(),(其他y x y f x f y x f Y XG G S dxdy y x f Y X P ⨯==⎭⎬⎫⎩⎨⎧≤-⎰⎰81),(121 而61'=-=∆∆C AB ABC G S S S . 于是 48181121=⨯=⎭⎬⎫⎩⎨⎧≤-G S Y X P1所以他们到达办公室的时间之差不超过5分钟的概率是.48结束语本论文在随机变量独立性定义的基础上讨论了随机变量独立性的性质,并分别对离散型随机变量和连续型随机变量用多种方法进行判定,最后通过随机变量独立性的相关应用说明其在生活中的重要性,从而让人们更深入的认识概率论的思想和方法,更好的解决我们身边的实际问题.除此之外,随机变量的独立性还可以和其他数学分支紧密结合,以便很好地解决数学问题.参考文献[1] 缪铨生.概率论与数理统计[M].上海:华东师范大学出版社,2006.[2]毛纲源.概率论与数理统计解题方法技巧归纳[M].武汉:华中理工大学出版社.1999.[3]魏宗舒等.概率论与数理统计教程[M].北京:高等教育出版社,1983.[4]王梓坤.概率论基础及其应用[M].北京:科学出版社,1997.[5]严士健等.概率论与数理统计[M].北京:北京师范大学出版社,1998.[6]钟开莱著.吴让泉译.概率论教程[M].上海:上海科技出版社.[7]明杰秀等.二维随机变量独立性的判定及其应用[J].高等函授学报(自然科学版),2011.[8] Rick Durrett.Probability Theory and Examples[M].S pringer-verlag Berlin Heidelberg,New Y ork,2005.About independent random variables and its applicationAuthor: Zhang Lirong Supervisor: Gui ChunyanAbstract The independence of the random variables is an important concept in probability theory.The paper first introduces the definition and the nature of independent random variables,then it gives different discriminant methods of the independence of the discrete random variable and continuous random variable,according to the different problems using the method to determine the corresponding discriminant,in addition ,it also gets some relevant inference by the nature and the determination of the independence of random variables,at last it gives some examples of its application.Keywords Discrete random variables Continuous random variables Independence Joint distribution。