《并行程序设计导论》 第四章PPT

并行程序设计导论第四章课后题答案(2024)

2024/1/29

1

目录

2024/1/29

• 课后题概述与解题思路 • 并行计算基本概念回顾 • 数据并行和任务并行编程技巧 • 同步与通信机制在并行程序中的应用 • 性能评价与调试方法分享 • 实例分析:典型课后题解答过程展示

2

01 课后题概述与解题思路

2024/1/29

并行化设计

将程序中的可并行部分进行并行处理,利用多核CPU或分布式系统的 计算能力提高程序性能。

数据结构优化

根据问题的特点选择合适的数据结构,以减少内存占用和提高数据访 问效率。

代码优化

通过编译器优化选项、内联函数、减少函数调用等手段提高代码执行 效率。

22

06 实例分析:典型课后题解 答过程展示

并行性能优化

通过分析并行程序的性能瓶颈,采用合适的优化策略,如减少通信 开销、提高缓存利用率等,提高并行程序的执行效率。

14

04 同步与通信机制在并行程 序中的应用

2024/1/29

15

同步机制原理及作用

2024/1/29

同步机制原理

通过设定同步点或同步操作,确保并 行程序中的各个进程或线程在关键点 上达到一致状态,避免数据竞争和结 果不确定性。

重点复习并行程序设计的基本概念、原理和方法,理解并掌握相关术语和定义。通过对比和分析选项,找出 正确答案。

简答题

在理解基本概念的基础上,结合实际应用场景和问题背景,进行深入分析和思考。注意答案的条理性和逻辑 性,尽量用简洁明了的语言进行表述。

编程题

首先明确题目要求和目标,设计合理的算法和数据结构。在编写代码时,注意并行化策略的选择和实现,以 及同步和通信机制的处理。最后对程序进行测试和调试,确保正确性和性能。

2024年度并行程序设计导论PPT课件

根据实际需求,选择其他 适合并行计算的实验项目 。

30

并行程序设计实验指导与注意事项

理解并行计算原理

在进行实验前,需要充分了解并行计算的原理和 基本概念。

调试与性能分析

学会使用调试器和性能分析工具,对并行程序进 行调试和性能分析。

ABCD

2024/2/2

熟悉并行编程模型

掌握常见的并行编程模型,如OpenMP、MPI 等,并根据实验需求选择合适的模型。

访问延迟和带宽瓶颈。

通信优化

减少不必要的通信开销,采用高效的 通信协议和算法,优化消息传递和数 据传输过程。

算法并行化优化

针对特定算法进行并行化优化,如矩 阵运算、排序算法等,提高算法的并 行执行效率。

21

并行程序调试与优化案例

案例一

案例二

案例三

案例四

MPI并行程序调试与优 化,通过TotalView工 具对MPI程序进行调试 ,发现并解决死锁、消 息不同步等问题,结合 性能分析工具找到性能 瓶颈并进行优化。

19

并行程序性能分析工具

Gprof

GNU的性能分析工具,可以分析 程序的函数调用关系、执行时间

、CPU占用率等性能指标。

NVIDIA Nsight

一款开源的内存管理和线程错误 检测工具,也可用于性能分析,

如Cachegrind可以模拟CPU缓 存进行性能分析。

2024/2/2

Valgrind

Intel推出的性能分析工具,可以 对并行程序进行深度性能分析, 包括热点分析、内存访问模式分 析等。

软件环境

安装并行程序设计所需的操作系统、 编译器、调试器和性能分析工具。

2024/2/2

29

(2024年)并行计算第并行算法的设计ppt课件

运用并行计算技术加速基因序列的比对和分析,促进生物医学研究 的发展。

28

工程仿真领域

01

流体动力学仿真

通过并行算法模拟流体的运动状 态,以优化飞行器、汽车等交通 工具的设计。

02

03

结构力学仿真

电磁场仿真

利用并行计算技术对建筑物、桥 梁等结构进行力学分析和优化, 提高工程安全性。

运用并行算法模拟电磁场的分布 和传播,以改进电子设备和通信 系统的性能。

高速互联网络

用于连接处理器和存储器,提供高带宽和低延迟 的数据传输,保证并行计算的效率。

2024/3/26

5

并行计算的软件支持

并行编程模型

包括消息传递模型、数据并行模型和 共享内存模型等,为并行计算提供抽 象的编程接口。

并行编程语言

如MPI、OpenMP、CUDA等,这些 语言提供对并行硬件的直接支持,使 程序员能够方便地编写并行程序。

2024/3/26

并行最长公共子序列算法

通过并行处理多个子序列的比较和合并操作,加速 最长公共子序列的求解过程。

并行最短编辑距离算法

将编辑距离的计算过程拆分成多个步骤,每 个步骤可以在多个处理单元上并行执行,从 而加快计算速度。

18

04

现代并行算法设计

2024/3/26

19

分布式并行算法

2024/3/26

11

并行算法的性能评价

加速比

衡量并行算法相对于串行算法的速度提升程度。

效率

衡量并行算法在给定资源下的性能表现。

2024/3/26

12

并行算法的性能评价

• 可扩展性:衡量并行算法在增加处理单元 数量时的性能提升能力。

2024版年度《并行程序设计导论》第四章

•并行计算基础•并行算法设计•并行编程模型与语言目录•并行程序性能优化•并行程序调试与性能分析•总结与展望并行计算概念及特点并行计算概念并行计算是指在同一时间内,使用多个计算资源(如处理器、核心、计算机等)同时执行多个计算任务的过程。

并行计算特点并行计算的主要特点包括同时性、独立性、加速比和可扩展性等。

其中,同时性指多个任务在同一时间内执行;独立性指各个任务之间互不干扰;加速比指并行计算相对于串行计算的加速效果;可扩展性指并行计算系统能够方便地增加计算资源以提高计算能力。

多核处理器集群系统分布式共享内存系统任务并行数据并行流水线并行并行算法特点并行算法分类与特点常见并行算法介绍如并行快速排序、归并排序等,提高排序速度。

如并行广度优先搜索、最短路径算法等,用于图论问题的求解。

如矩阵乘法、矩阵分解等,加速线性代数计算。

如并行蒙特卡洛方法、并行有限元方法等,应用于科学计算领域。

并行排序算法并行图算法并行矩阵运算并行数值计算并行算法性能评价加速比效率可扩展性复杂度分析共享内存编程模型原理及特点常用同步机制典型应用01 02 03原理及特点常用通信方式典型应用消息传递编程模型OpenMP 存并行编程的了简单的并行循环、分段、任务等构造,以及丰富的同步和互斥机制。

用于多核、多线程等共享内存环境,可以方便地实现并行化。

OpenMP MPI 编程的标准接口,提供了丰富的通信函数和同步机制。

MPI 系统等环境,可以实现大规模并行计算。

MPI CUDA 一种并行计算平台和编程模型,支持CUDA 程接口和扩展库,可以方便地实现应用程序。

CUDA 除了上述三种常见的并行编程语言外,还有许多其他语言和工具支持并行编程,如Fortran 这些语言和工具各有特点,可以根据具体应用场景选择合适的编程语言和工具。

其他语言并行编程语言介绍针对特定问题选择合适的并行算法,通过减少计算量、提高计算效率来优化性能。

算法选择与优化数据结构与存储优化编译优化技术运行时优化技术合理设计数据结构,减少数据冗余和访问冲突,提高数据存储和访问效率。

并行计算机体系结构PPT课件

17

二、Amdahl定律

*基本思想:优化某部件所获得的系统性能的改善程度,取 决于该部件被使用的频率,或所占总执行时间的比例

S T0

p

Te

1

(1

fe

)

fe re

*举例:某功能处理时间占系统时间的40%,将其处理速度加

快10倍后,整个系统性能提高多少? Sp

10

解—已知fe=0.4,re=10,利

23

*特点:吞吐率与I/O软硬件组织方式及OS有很大关系; 能够反映软硬件系统对多任务的响应能力

*提高吞吐率方法: 流水化--使多个作业流水处理; 并行处理--给每个PE分配多个作业,各PE相互协调

3、利用率 *定义:利用率=持续性能÷峰值性能 *特点:不直接表示系统性能,与前两种指标有密切关系; 对系统性能优化及结构改进起着至关重要的作用!

A系统 B系统

得到性能可扩放性曲线 1

n

影响因素—结构、处理器数、问题规模、存储系统等

25

二、性能评价与比较

1、评价技术

(1)分析技术 *思路:在一定假设条件下,计算机系统参数与性能指标间

存在着某种函数关系,按其工作负载的驱动条件列出方程,用 数学方法求解后评价

*发展:从脱离实际的假设发展到近似求解 近似求解算法—聚合法、均值分析法、扩散法等

2

二、参考教材

1、并行计算机体系结构,陈国良等著,高等教育出版社, ISBN 7-04—11558-1,2002.9

2、并行计算机体系结构,David E.Culler等著,李晓明等译, 机械工业出版社,ISBN 7-111-07888-8,2002.10

3、可扩展并行计算—技术、结构与编程,黄铠、徐志伟著,陆 鑫达等译,机械工业出版社,2000.5

并行程序设计导论.ppt

SPMD类型的MPI程序 myprog.c

#include “mpi.h” int foo int i; {…} main(argc,argv) int argc; char *argv[ ]; { int i, tmp, sum=0, group_size,my_rank,N; MPI_Init(&argc,&argv); 消息标志 MPI_Comm_size(MPI_COMM_WORLD,&group_size); MPI_Comm_rank(MPI_COMM_WORLD,&my_rank); if (my_rank==0) { printf(“Enter N:”); scanf(“%d”,&N); for (i=1;i<group_size;i++) MPI_send(&N,1,MPI_INT,i,i,MPI_COMM_WORLD); 目的进程 for (i=my_rank;i<N;i=i+group_size ) sum=sum+foo(i); for (i=1;i<group_size;i++) { MPI_Recv(&tmp,1,MPI_INT,i,i,MPI_COMM_WORLD,&status); sum=sum+tmp; } 源进程 结构指针 printf(“\n The result=%d”,sum); } else { MPI_Recv(&N,1,MPI_INT,0,i,MPI_COMM_WORLD,&status); for (i=my_rank;i<N;i=i+group_size ) sum=sum+foo(i); MPI_Send(&sum,1,MPI_INT,0,i,MPI_COMM_WORLD); } MPI_Finalize(); }

2024版并行程序设计精品公开课件

ABCD

读者写者问题

通过读写锁、信号量等机制实现读者和写者之间 的同步与通信,并避免读写冲突。

进程池管理

通过信号量、进程间通信等机制实现进程池的管 理,包括进程的创建、销毁、调度等。

04 并行编程模型与框架介绍

OpenMP编程模型

加速比

同一任务在单处理器系统和并行 处理器系统上执行消耗的时间的 比率。

效率

加速比与处理器个数的比值,反 映了并行系统的利用率。

可扩展性

并行程序在不同规模的并行系统 上执行时,能否保持相近的加速

比和效率。

02 并行算法设计原则与策略

设计原则

分治原则

将大问题分解为小问题,独立求解后合并结 果。

减少通信

05 并行程序性能优化技术探 讨

性能优化策略概述

识别并行性

将可并行执行的任务划分出来,提高程序执行效率。

减少通信开销

合理设计并行算法和数据结构,降低进程间通信开销。

利用局部性原理

优化数据访问模式,提高数据访问的局部性,减少缓存失效。

迭代优化

通过反复测试、分析和调整,找到性能瓶颈并进行优化。

负载均衡技术实现方法

开启编译器优化选项

使用编译器提供的优化选项,如 O2、O3等,自动进行代码优化。

矢量化优化

利用编译器提供的矢量化优化功能, 将循环中的标量操作转换为矢量操 作。

考虑目标平台特性

针对目标平台的特性选择合适的编 译器和优化选项。

谨慎使用编译器自动并行化

编译器自动并行化可能引入额外的 开销和复杂性,需谨慎使用。

THANKS FOR WATCHING

MPI基础PPT课件

2020/9/28

10

4.2 6个基本函数组成的MPI子集

▪ 消息发送:MPI_Send函数用于发送一个消息到目标进 程。

▪ int MPI_Send(void *buf, int count, MPI_Datatype dataytpe, int dest, int tag, MPI_Comm comm)

现代密码学理论与实践之五

2020/9/28

13

4.3 MPI消息(数据类型)

▪ MPI的消息类型分为两种:预定义类型和派生数据类型 (Derived Data Type)

▪ 预定义数据类型:MPI支持异构计算(Heterogeneous Computing),它指在不同计算机系统上运行程序,每 台计算可能有不同生产厂商,不同操作系统。

现代密码学理论与实践之五

2020/9/28

6

4.2 6个基本函数组成的MPI子集

#include "mpi.h" /*MPI头函数,提供了MPI函数和数据类型定义*/ int main( int argc, char** argv ) { int rank, size, tag=1; int senddata,recvdata; MPI_Status status; MPI_Init(&argc, &argv); /*MPI的初始化函数*/ MPI_Comm_rank(MPI_COMM_WORLD, &rank); /*该进程编号*/ MPI_Comm_size(MPI_COMM_WORLD, &size); /*总进程数目*/

现代密码学理论与实践之五

2020/9/28

7

4.2 6个基本函数组成的MPI子集

(2024年)并行程序设计导论课件

03

并行策略调整

04

根据程序特点和性能瓶颈,选择 合适的并行策略,如任务并行、 数据并行或混合并行等。

案例分析

结合具体案例,分析性能瓶颈的 来源,并给出相应的优化策略和 实现方法。例如,针对矩阵乘法 运算的性能优化,可以采用分块 矩阵乘法算法,并结合OpenMP 并行框架实现并行计算。

2024/3/26

GPU拥有成千上万的核心,能够实现大规模并行处理 ,加速计算密集型任务。

高带宽内存访问

GPU采用高速显存,提供高带宽内存访问,使得数据 传输更加高效。

优化的浮点运算

GPU针对单精度和双精度浮点运算进行优化,适用于 科学计算、图形渲染等领域。

2024/3/26

25

CUDA编程模型简介

CUDA编程模型概述

并行矩阵运算

03

如矩阵乘法、矩阵转置等,通过并行处理矩阵中的元素来实现

高性能计算。

10

03

并行编程模型与语言

2024/3/26

11

共享内存编程模型

原理

多个线程或进程共享同一块内存空间,通过 读写共享变量实现通信和同步。

缺点

存在数据一致性和同步问题,需要采用锁等 机制进行控制。

2024/3/26

优点

日志分析

记录程序运行过程中的关键事件和时间戳,通过分析日志找出性 能瓶颈。

可视化工具

利用可视化工具,如性能图表、火焰图等,直观地展示程序性能 瓶颈。

30

优化策略与案例分析

01 算法优化

针对程序中计算密集型的部分 ,采用更高效的算法或并行算 法进行优化。

02 数据结构优化

调整数据结构以适应并行计算 的需求,减少数据访问冲突和 通信开销。

课件并行程序设计chapter-2024鲜版

性能测试工具

如HPC Challenge Benchmark Suite、 PAPI等,用于评估并行 程序的性能表现。

2024/3/28

24

06

并行程序设计案例分析

2024/3/28

25

矩阵乘法并行化案例

2024/3/28

问题描述 矩阵乘法是计算科学中的常见问题,其计算量大且难以通 过简单的串行计算实现高效处理。

数据局部性优化

通过合理安排数据在内存中的布局,减少处理器访问数据的延迟。例如, 利用缓存预取、数据重排等技术,提高数据的局部性访问效率。

2024/3/28

03

并行算法设计

针对特定问题,设计高效的并行算法。通过选择合适的并行计算模型

(如MPI、OpenMP等),并结合问题特点进行算法优化,可以提高并

行程序的性能。

14

CUDA

2024/3/28

01

CUDA(Compute Unified Device Architecture)是 NVIDIA推出的并行计算平台和API,主要用于GPU加速计算。

02

CUDA使用C/C语言进行编程,通过扩展的语法和库函数来 实现并行化。

03

CUDA程序由主机代码和设备代码组成,主机代码运行在 CPU上,设备代码运行在GPU上,两者通过CUDA运行时库 进行交互。

数据管理

在并行计算中,数据的管理和访问是一个重要问题。需要考 虑如何有效地存储和访问数据、如何处理数据依赖和冲突等 问题。

并行编程模型

选择合适的并行编程模型对于并行程序设计的成功至关重要。 不同的并行编程模型有不同的优缺点,需要根据具体问题和 计算环境进行选择。

2024/3/28

性能优化

计算机科学与程序设计导论PPT第4章操作系统

通过用户名和密码等方式验证用 户身份,确保只有授权用户才能

访问系统资源。

访问控制机制

根据用户的身份和权限,限制其 对系统资源的访问和操作,防止 未经授权的访问和破坏。

加密机制

通过对数据和文件进行加密,确 保数据在传输和存储过程中的安 全性,防止数据泄露和篡改。

安全审计机制

记录和监控用户对系统资源的访 问和操作,以便及时发现和处理

03

文件管理

支持文件的存储、访问、修改和保护等操作, 提供文件共享和保密措施。

05

02

处理机管理

分配和控制处理机资源,实现多道程序并发 执行。

04

设备管理

管理和控制计算机的所有硬件设备, 提供设备驱动程序和接口。

06

用户接口

提供命令接口、程序接口和图形接口,方便用 户使用计算机。

操作系统的历史与发展

05

设备管理

设备驱动程序

设备驱动程序的概念

设备驱动程序是操作系统中与 硬件设备交互的软件程序,它 充当了操作系统和硬件设备之

间的接口。

设备驱动程序的作用

设备驱动程序使得操作系统能 够识别、控制和管理硬件设备, 从而实现设备的输入/输出操

作。

设备驱动程序的分类

根据设备类型的不同,设备驱 动程序可分为字符设备驱动程 序、块设备驱动程序和网络设

计算机科学与程序设计导论 PPT第4章操作系统

目录

• 操作系统概述 • 进程管理 • 内存管理 • 文件系统 • 设备管理 • 操作系统安全

01

操作系统概述

操作系统的定义与功能

定义

操作系统是一组控制和管理计算机软硬件资源、 合理组织计算机工作流程以及方便用户使用的

《并行程序设计导论》一些笔记与思考

《并行程序设计导论》一些笔记与思考一、教学内容本节课的教学内容来自于《并行程序设计导论》第四章,主要介绍并行算法的基本概念、设计方法和评价准则。

具体内容包括:并行算法的分类、并行算法的性能评价、并行算法的开发和优化技巧。

二、教学目标1. 使学生了解并行算法的概念,理解其与串行算法的区别;2. 培养学生掌握并行算法的设计方法,提高其算法设计能力;3. 帮助学生掌握并行算法的性能评价准则,培养学生分析并解决并行计算问题的能力。

三、教学难点与重点重点:并行算法的概念、设计方法和性能评价准则;难点:并行算法的开发和优化技巧。

四、教具与学具准备教具:多媒体教学设备;学具:笔记本电脑、学习资料。

五、教学过程1. 实践情景引入:通过介绍一些典型的并行计算应用场景,如天气模拟、分子动力学模拟等,引发学生对并行算法的兴趣。

2. 知识讲解:讲解并行算法的概念,通过对比串行算法,使学生理解并行算法的特点和优势;介绍并行算法的设计方法,如并行分解、数据并行、任务并行等;讲解并行算法的性能评价准则,如加速比、效率等。

3. 例题讲解:通过具体的并行算法案例,如矩阵乘法、归并排序等,讲解并行算法的具体设计和实现方法。

4. 随堂练习:让学生根据所学内容,尝试设计一个简单的并行算法,并分析其性能。

5. 课堂讨论:引导学生探讨并行算法的优化技巧,分享彼此的学习心得和感悟。

六、板书设计并行算法:概念设计方法:并行分解、数据并行、任务并行等性能评价:加速比、效率等并行算法开发与优化:开发技巧:代码的可扩展性、负载均衡等优化技巧:并行算法的改进、算法的并行性分析等七、作业设计1. 作业题目:设计一个并行版本的矩阵乘法算法,并分析其性能。

2. 答案:略。

八、课后反思及拓展延伸课后反思:本节课通过引入实践情景,让学生了解了并行算法的概念和设计方法,通过例题讲解和随堂练习,使学生掌握了并行算法的具体实现。

课堂讨论环节,学生积极参与,分享了自己的学习心得和感悟。

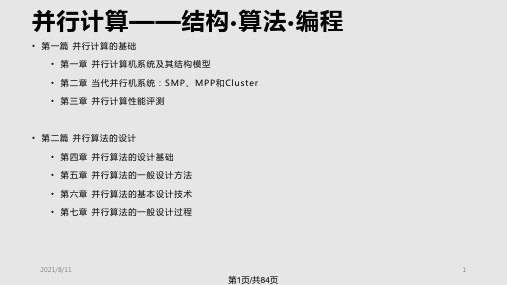

并行计算概述PPT课件

• 第一篇 并行计算的基础 • 第一章 并行计算机系统及其结构模型 • 第二章 当代并行机系统:SMP、MPP和Cluster • 第三章 并行计算性能评测

• 第二篇 并行算法的设计 • 第四章 并行算法的设计基础 • 第五章 并行算法的一般设计方法 • 第六章 并行算法的基本设计技术 • 第七章 并行算法的一盘

桥

系统 I

节点 2

节点 N

SAN(e.g.Myrinet)

I/O总 线 ,系 统 总 线

接口

LAN(e.g.以 太 网 ,FDDI)

系统 II

2021/8/11

15

第15页/共84页

网络性能指标

• 节点度(Node Degree):射入或射出一个节点的边数。在单向网络中, 入射和出射边之和称为节点度。

2

N / 2向)

4

2( N 1)

N

4

N 1

2N

4

2 N/2

2N

3 2loN g 1

1

非

N 1

是

N

非

2(N N)

非

2N

是

2N

非

N 1

星形

2

N N 1

超立方

N 2n

n

n

非 N / 2

是

N/2

N 1 nN/ 2

立方环

Nk2k

3

2k1k/2 N/(2k)

是

3N/ 2

2021/8/11

24

第24页/共84页

动态互连网络 (1)

1100

1110 1101

1111

0010

0011

1010

并行程序设计导论(2024)

编译时通过任务划分和调度实现负载平衡。

3

动态负载均衡

运行时监测负载并根据需要迁移任务。

2024/1/29

18

负载均衡与性能评估指标

01

性能评估指标

用于衡量并行算法和程序性能的标 准。

效率

加速比与处理器数量的比值,衡量 并行化的效果。

03

2024/1/29

02

加速比

并行执行相对于串行执行的速度提 升。

并行程序设计导论

2024/1/29

1

目录

2024/1/29

• 并行计算概述 • 并行计算硬件基础 • 并行程序设计语言与模型 • 并行算法设计策略与优化方法 • 典型并行算法案例剖析 • 并行程序设计实践与挑战

2

01

并行计算概述

2024/1/29

3

并行计算定义与特点

定义

并行计算是指同时使用多种计算资源解决 计算问题的过程,其主要目的是快速解决 大型且复杂的计算问题。

可扩展性

随着处理器数量的增加,性能提升 的能力。

04

19

05

典型并行算法案例剖析

2024/1/29

20

矩阵运算并行化方法

2024/1/29

分块矩阵并行计算

01

将大型矩阵分割成若干个小块,分配给不同的处理单元进行并

行计算,最后再将结果合并。

矩阵向量乘法并行化

02

利用矩阵和向量的乘法运算可以并行化的特点,将矩阵按行或

20世纪90年代至今,随着计算机网络 、分布式系统、GPU等技术的飞速发 展,并行计算进入了一个全新的时代 。

中期阶段

20世纪60年代至80年代,随着计算机

硬件技术的进步,如多处理器系统、

《并行程序设计导论》第四章

并行程序设计导论第四章:并行算法的设计与分析并行算法是并行程序设计的核心,它直接影响着程序的性能和效率。

本章将介绍并行算法的设计方法,分析并行算法的性能,并探讨如何评估并行算法的效率。

一、并行算法的设计方法1.分治法分治法是一种常见的并行算法设计方法,它将问题分解成若干个子问题,分别解决后再合并结果。

分治法的关键在于子问题的划分和结果的合并。

在并行计算中,分治法可以充分利用多核处理器的并行性,提高程序的执行效率。

2.流水线法流水线法是一种将计算过程分解成多个阶段,每个阶段由不同的处理器并行执行的算法设计方法。

在流水线法中,数据在各个阶段之间流动,每个阶段只处理部分数据。

这种方法可以充分利用处理器的计算能力,提高程序的执行效率。

3.数据并行法数据并行法是一种将数据分解成多个部分,每个部分由不同的处理器并行处理的算法设计方法。

在数据并行法中,每个处理器处理相同的数据结构,执行相同的操作。

这种方法可以充分利用处理器的计算能力,提高程序的执行效率。

二、并行算法的性能分析1.时间复杂度时间复杂度是衡量算法性能的一个重要指标,它表示算法执行时间与输入规模之间的关系。

在并行算法中,时间复杂度通常表示为多个处理器执行时间的总和。

对于一个并行算法,我们希望其时间复杂度尽可能低,以提高程序的执行效率。

2.加速比加速比是衡量并行算法性能的另一个重要指标,它表示并行算法执行时间与最优串行算法执行时间的比值。

加速比越高,说明并行算法的性能越好。

在实际应用中,我们希望并行算法的加速比尽可能接近处理器的核心数量。

3.可扩展性可扩展性是衡量并行算法性能的另一个重要指标,它表示算法在增加处理器数量时的性能变化。

对于一个好的并行算法,我们希望其在增加处理器数量时,性能能够得到有效提升。

三、并行算法的效率评估1.性能模型性能模型是一种用于评估并行算法效率的工具,它将算法的性能与处理器数量、数据规模等因素联系起来。

通过性能模型,我们可以预测并行算法在不同条件下的性能表现,为算法设计和优化提供依据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2

A Shared Memory System

Copyright © 2010, Elsevier Inc. All rights Reserved

3

Processes and Threads

Copyright © 2010, Elsevier Inc. All rights Reserved

4

POSIX® Threads

Also known as Pthreads. A standard for Unix-like operating systems. A library that can be linked with C programs. Specifies an application programming interface (API) for multi-threaded programming.

Copyright © 2010, Elsevier Inc. All rights Reserved

14

One object for each thread.

pthread_t objects

Opaque The actual data that they store is systemspecific. Their data members aren’t directly accessible to user code. However, the Pthreads standard guarantees that a pthread_t object does store enough information to uniquely identify the thread with which it’s associated.

Copyright © 2010, Elsevier Inc. All rights Reserved

8

Hello World! (3)

Copyright © 2010, Elsevier Inc. All rights Reserved

9

Compiling a Pthread program

gcc −g −Wall −o pth_hello pth_hello . c −lpthread

Copyright © 2010, Elsevier Inc. All rights Reserved

22

Using 3 Pthreads

thread 0

general case

Copyright © 2010, Elsevier Inc. All rights Reserved

23

Pthreads matrix-vector multiplication

19

Stopping the Threads

We call the function pthread_join once for each thread. A single call to pthread_join will wait for the thread associated with the pthread_t object to complete.

17

Function started by pthread_create

Prototype: void* thread_function ( void* args_p ) ; Void* can be cast to any pointer type in C.

So args_p can point to a list containing one or more values needed by thread_function. Similarly, the return value of thread_function can point to a list of one or more values.

Copyright © 2010, Elsevier Inc. All rights Reserved

11

Global variables

Can introduce subtle and confusing bugs! Limit use of global variables to situations in which they’re really needed.

We won’t be using, so we just pass NULL. Allocate before calling.

Copyright © 2010, Elsevier Inc. All rights Reserved

16

A closer look (2)

int pthread_create ( pthread_t* thread_p /* out */ , const pthread_attr_t* attr_p /* in */ , void* (*start_routine ) ( void ) /* in */ , void* arg_p /* in */ ) ;

An Introduction to Parallel Programming

Peter Pacheco

Chapter 4 Shared Memory Programming with Pthreads

Copyright © 2010, Elsevier Inc. All rights Reserved

26

Using a dual core processor

Note that as we increase n, the estimate with one thread gets better and better.

Copyright © 2010, Elsevier Inc. All rights Reserved

Copyright © 2010, Elsevier Inc. All rights Reserved

24

CRITICAL SECTIONS

Copyright © 2010, Elsevier Inc. All rights Reserved

25

Estimating π

Copyright © 2010, Elsevier Inc. All rights Reserved

Copyright © 2010, Elsevier Inc. All rTOR MULTIPLICATION IN PTHREADS

Copyright © 2010, Elsevier Inc. All rights Reserved

21

Serial pseudo-code

Copyright © 2010, Elsevier Inc. All rights Reserved

5

Caveat

The Pthreads API is only available on POSIXR systems — Linux, MacOS X, Solaris, HPUX, …

Copyright © 2010, Elsevier Inc. All rights Reserved

Copyright © 2010, Elsevier Inc. All rights Reserved

15

A closer look (1)

int pthread_create ( pthread_t* thread_p /* out */ , const pthread_attr_t* attr_p /* in */ , void* (*start_routine ) ( void ) /* in */ , void* arg_p /* in */ ) ;

1

# Chapter Subtitle

Roadmap

Problems programming shared memory systems. Controlling access to a critical section. Thread synchronization. Programming with POSIX threads. Mutexes. Producer-consumer synchronization and semaphores. Barriers and condition variables. Read-write locks. Thread safety.

Copyright © 2010, Elsevier Inc. All rights Reserved

18

Running the Threads

Main thread forks and joins two threads.

Copyright © 2010, Elsevier Inc. All rights Reserved

Hello from the main thread Hello from thread 0 of 1

. / pth_hello 4

Hello from the main thread Hello from thread 0 of 4 Hello from thread 1 of 4 Hello from thread 2 of 4 Hello from thread 3 of 4

link in the Pthreads library

Copyright © 2010, Elsevier Inc. All rights Reserved

10

Running a Pthreads program