一种基于多边形柱面全景图的虚拟漫游新方法

基于WebGL的虚拟场景漫游系统设计与实现

基于WebGL的虚拟场景漫游系统设计与实现随着计算机技术的不断发展,虚拟现实技术已经在很多领域得到应用,例如游戏、教育、医疗等。

其中,虚拟场景漫游系统是比较受欢迎的一种应用。

本文将介绍一种基于WebGL的虚拟场景漫游系统的设计与实现。

一、WebGL的基本概念WebGL是一种在浏览器中实现3D图形的技术。

它可以让开发者使用JavaScript语言来创建复杂的3D图形,实现虚拟现实等应用。

WebGL的核心技术是OpenGL,它是一种跨平台的3D图形API。

WebGL利用JavaScript代码与OpenGL交互,可以在浏览器中实现3D图形渲染。

二、虚拟场景漫游系统的设计思路虚拟场景漫游系统的实现主要分为三个部分:场景设计、场景渲染和用户交互。

1. 场景设计场景设计是虚拟场景漫游系统的基础,它需要实现以下功能:(1)场景建模:使用3D建模软件(例如Blender、Maya等)进行场景建模,将场景中的物体建模成3D模型。

(2)场景导入:将3D模型导入到WebGL中,通过JavaScript 控制场景中的模型运动和交互。

(3)贴图处理:将场景中的贴图进行处理,使得在WebGL中呈现质量较高的视觉效果。

2. 场景渲染场景渲染是虚拟场景漫游系统的核心,它需要实现以下功能:(1)渲染引擎:使用WebGL的渲染引擎,将场景中的3D模型渲染成2D图像。

(2)光照处理:通过光照处理,使得场景中的物体呈现逼真的光影效果。

(3)特效处理:为场景添加特效(如雾化、镜面反射等),增强场景的视觉效果。

3. 用户交互用户交互是虚拟场景漫游系统的重要部分,它需要实现以下功能:(1)摄像头控制:通过键盘或鼠标控制摄像头的位置和方向,实现场景的漫游。

(2)交互元素:在场景中添加交互元素,例如按钮、触发器等,实现特定功能(如打开门、触发动画等)。

(3)界面设计:为用户提供一个友好的交互界面,让用户能够方便地控制场景。

三、系统实现本文采用THREE.js作为WebGL框架,实现了一个简单的虚拟场景漫游系统。

基于VR技术的实景漫游系统设计与实现

基于VR技术的实景漫游系统设计与实现摘要随着VR技术的不断发展和普及,利用VR技术进行实景漫游已经成为一种新的体验模式。

本文基于VR技术设计并实现了一种实景漫游系统,该系统可以为用户提供一个沉浸式的虚拟环境,用户可以通过VR设备进行实景漫游。

本文主要介绍了VR技术的基本概念,并对实景漫游系统的设计与实现进行了详细的介绍,包括系统的架构设计、场景构建、用户交互等方面。

最后通过实验验证了系统的可行性和有效性。

关键词:VR技术;实景漫游;系统设计;系统实现;用户交互AbstractWith the continuous development and popularization of VR technology, using VR technology for real-scene roaming has become a new experience mode. Based on VR technology, this paper designs and implements a real-scene roaming system, which can provide users with an immersive virtual environment. Users can perform real-scene roaming through VR devices. This paper mainly introduces the basic concepts of VR technology, and provides a detailed introduction to the design and implementation of the real-scene roaming system, including system architecture design, scene construction, user interaction, and other aspects. Finally,the feasibility and effectiveness of the system were verified through experiments.Keywords: VR technology; Real-scene roaming; System design; System implementation; User interaction1. 引言随着VR技术的不断发展和普及,虚拟现实技术已经成为了当前最热门的技术之一。

基于全景图像的虚拟漫游系统研究

C eacm l hdb s gteR N A R n o a peC ness lgrh w i a ua n as r t np r t n a b co pi e yui A S C( ad m S m l o snu )a o t s n h i m, hl c clt gt nf ma o aa e el i r o i me r s

Re e r h o r u lNa i a i n S s e s d o Pa r m i ma e s a c n Vit a v g to y t m Ba e n no a c I g s

ZHAO .i ,XU n Yi1 . . Da

( . et f o ptr cec , otw s F r t n esy K mnn 5 24, hn ; 1 D p.o m ue ine S uh et oe r U i ri , u ig60 2 C ia C S sy v t 2 D p.o o p  ̄ c ne Y n a n e i ,K n n 5 0 1 C ia . e t f m u r i c , un nU v rt u mi 6 09 , h ) C Se i sy g n

成 图像拼 接后 , 过重投影算 法可以生成场景在不 同视 线方向上 的透视视 图, 通 让用户获得 身临其境的沉浸 感。 关键 词 : 虚拟 漫游;图像拼接 ; 特征 匹配 : 鲁棒 估计

基于图像变形的全景平滑漫游算法研究

基于图像变形的全景平滑漫游算法研究王松;朱正平;杨景玉;王阳萍【摘要】针对目前全景漫游系统在切换视点时产生跳跃感的问题,提出了一种基于图像变形的平滑漫游算法。

首先采用 SIFT 特征提取方法对过渡图像进行特征提取,同时采用图像区域划分的方法对特征点进行筛选,建立特征点集的映射关系;然后,构造特征点集的 Delaunay 三角剖分,在三角剖分的基础上,计算对应三角形区域的仿射变换参数;最后,对图像进行插值和生成中间过渡图像。

实验表明该方法实现了特征点集的自动对应,提高了全景漫游系统的交互性和沉浸感,算法实用、高效,对于有诸多不确定性因素的过渡图像有较好的自适应性。

%A practical,efficient smooth roaming algorithm based on image distortion for switching viewpoints in panoramic system is presented.The feature extraction method is presented by using SIFT method,the key points are filtered by using the method of dividing the region,and the map relation of key point set is established.Then,the Delaunay triangulation of feature point set is constructed and the affine transformation parameters of corresponding region on the basis of Delaunay triangulation are evaluated.Finally,the intermediate images after interpolating the ima-ges are produced for smoothly switching.The experiments show the problems above have been well resolved.The method implements the automation corresponding relation of feature point set and enhances the interactive and immersion of panoramic system.The result shows the method is practical and highly efficient,and it has better adaptive for the images influenced by some uncer-tain factors.【期刊名称】《兰州交通大学学报》【年(卷),期】2014(000)003【总页数】5页(P82-86)【关键词】全景漫游;SIFT;Delaunay三角剖分;图像变形【作者】王松;朱正平;杨景玉;王阳萍【作者单位】兰州交通大学电子与信息工程学院,甘肃兰州 730070;兰州城市学院信息工程学院,甘肃兰州 730070;兰州交通大学电子与信息工程学院,甘肃兰州 730070;兰州交通大学电子与信息工程学院,甘肃兰州 730070【正文语种】中文【中图分类】TP391自20世纪90年代以来,基于全景图像的漫游技术由于在场景绘制的真实感和绘制速度上具有很大优势,逐渐成为计算机图形学的研究热点[1-3].许多计算机视觉领域重要的国际会议,如ACM 的SIGGRAPH,IEEE 的CVPR 等,每年都发表与此相关的许多文章,提出了很多新的理论和方法,并应用到了多个领域.全景图的生成涉及一系列技术,其中基于图像配准与融合的图像拼接技术是全景图生成的关键技术,它直接影响着全景图生成效果的好坏[4-5].国内外学者在该领域做了大量的研究工作,也取得了许多研究成果.全景漫游系统的另一个关键技术是构造大范围的自由漫游虚拟实景空间.最早的虚拟实景空间系统是Quick Time VR,该系统以结点和链的形式将全景图像和虚拟对象进行组织,可以实现虚拟空间的漫游.但这种漫游不平滑,以跳跃的方式进行.Chen和Williams利用视图插值的方法,使得在不同视点处观察时能够保持视觉上的平滑过渡.但是这种插值方法需要知道场景的深度信息.张茂军等提出的纵平移图像平滑过渡技术是基于图像插值的方法计算中间图像,当图像差异较大时,仍存在沉浸感不足的问题.本文基于图像变形的思路,提出了基于图像变形的平滑漫游方法,该方法建立在两幅图像相似性基础上,在源图像和目标图像间构造特征映射关系,从而使这个问题得到一定的解决.1 全景平滑漫游研究现状全景漫游系统中,实现视点间平滑漫游的方法主要有两大类:一类是基于全光函数的方法,该方法首先对相机进行标定,在采集图像的基础上对场景进行精细建模,从而实现视点间的平滑过渡;另一类是基于图像变形的方法,传统的图像变形方法通过在采集图像上标定特征点,手工建立对应关系,然后基于图像变形生成中间过渡图像,从而实现视点间的平滑漫游[6].1.1 基于全光函数的方法全光函数可以看作是对于可视世界的精确建模.它等价于可视世界的全息表示.全光函数最早由Adelson 和Bergen提出,定义如式(1)所示.其中:(Vx,Vy,Vz)是视点在空间中的位置;θ是φ俯仰角和方位角;Vz表示光线的方向;λ 是光的波长;t表示时间.这个函数定义为在某一位置、某一视角、某一波长以及某一时刻,通过摄像机中心的光线强度.一般来说全光函数的获取是相当困难的,因为它的数据量远远地超出了当前计算机的处理能力.1.2 基于图像变形的方法采用视点插值和视图变形方法,是根据已知图像之间的对应点以及新视点的位置,计算出新的视图,从而使一幅数字图像光滑过渡到另一幅图像.这种方法是先对图像进行几何特征识别,从而提供图像中特征的几何形状转换以保证图像的几何特征的对应关系,然后再对色彩进行插值.其难点是已知图像与新视图之间的关系是非线性的,计算复杂.本文提出的算法思想基于图像变形的思想,对于自然景物图像很难提取到明确的几何特征,因此,在本文的算法中,没有对图像中的几何特征进行提取,而是提取特征点来建立两幅图像的特征映射关系,从而实现图像间的光滑漫游.2 基于图像变形的平滑漫游算法为了实现多视点间双向无间隙平滑漫游,在视点中心间建立双向空间链,并在采集部分中间过渡图像的基础上,通过图像变形技术和插值获得平滑的漫游过渡视觉效果.传统的图像变形方法通过在两幅图像上手工标定一些对应特征点来建立一个映射关系函数,然后通过把一幅图像的特征点逐渐移动到另一幅图像对应特征点的位置,再通过像素坐标和颜色插值来产生一系列过渡图像帧.传统方法的缺点是需要手工标定对应特征点,效率低,不能满足全景漫游系统制作的要求.本文提出的方法是,首先利用SIFT 特征点检测方法在2幅图像上分别检测特征点,得到2个特征点集;然后根据特征点在原始图像上的分块信息,建立特征点集的对应关系;最后,根据已建立的对应关系,利用传统的图像变形技术生成中间的过渡图像.算法总体流程如图1所示.图1 算法流程Fig.1 Flow of algorithm2.1 特征点提取SIFT 算法基于图像特征尺度选择的思想,建立图像的多尺度空间,在不同尺度下检测到同一个特征点,确定特征点位置的同时确定其所在尺度,以达到尺度抗缩放的目的,剔出一些对比度较低的点以及边缘响应点,并提取旋转不变特征描述符以达到抗仿射变换的目的[7-9].该算法主要包含4个步骤:1)尺度空间极值检测,找出潜在的兴趣点;2)关键点定位,剔出不稳定点;3)确定特征点的方向;4)提取关键点描述符.2.2 基于图像区域信息建立特征点对应关系将图像划分为n×n的区域,计算落在每个区域中部分点集的重心,选取距重心最近的点为候选特征点.如果区域中特征点集为空,则选取图像子块的重心点作为虚拟特征点加入特征点集.最后,根据特征点集的分布,建立相邻图像的特征点映射关系.之所以将图像划分为块,原因在于特征点位置在图像上分布越均匀,图像配准的效果越平滑.2.3 Delaunay三角剖分Delaunay三角剖分的目的在于将图像平面划分为多个不同的三角形区域,为后续的坐标变换做准备,以期达到尽可能好的变形效果[10-12].本文实现Delaunay 三角剖分算法是Bowyer-Watson算法,它是一种增进式的算法,算法过程如下:设P 是给定一个平面上的点集合P ={p1,p2,…,pn},它从P中每次选一点加入,接着搜寻目前的所有三角形中,哪一个三角形包含该点,然后对目前的三角化结果做调整来反应该点的加入.当P 中所有点都处理完成时,即完成P 的Delaunay三角剖分.在加入第一个点之前,此算法先初始化一个极大的三角形,让所有点落在其中,以此避免点被加入时没有三角形包含例外情况.通过Delaunay三角剖分得到特征点集的平面三角网,根据已建立的特征点集映射关系得到三角网的映射关系.2.4 图像插值和过渡图像生成原始图像到目标图像的映射通过逆向映射方法解决,即目标图像中的每个像素都是从原图像中采样得到的[13].采样时,为了使变化过程足够光滑,采用了双线性插值算法.双线性插值算法的插值原理是待插值像素点分别于周围四个像素点在水平和垂直方向做插值运算,得到的值即为插值像素点的颜色值.如图2所示,在水平和垂直方向分别有四个点Q11,Q12,Q21和Q22,它们组成了一个方形区域,点P为方形区域内部点,双线性插值算法是在水平和垂直两个方向上进行的,因此用双线性插值算法计算区域内点P 的灰度值,利用式(2)得到.图2 双线性插值Fig.2 Bilinear interpolation区域内部点P 的颜色值为g(u,v),u 和v 分别表示点P 的坐标,a1,a2,a3,a44个参数待定.利用图中4点所对应的颜色值g(x1,y1),g(x1,y2),g (x2,y1)和g(x2,y2)可以计算出4个待定参数的值.参数a1,a2,a3,a4的计算式分别如式(3)、式(4)、式(5)和式(6)所示.3 基于图像变形的平滑漫游算法仿真使用Visual C++2008 语言在Win7 环境下基于OpenCV 2.4.6 对本文提出的方法进行了实现.首先,选取过渡图像.过渡图像一般从相邻结点的路径图像中选取.第1步,使用SIFT 方法对两幅图像进行特征点提取.由于自然图像细节繁杂,所以提取的特征点较多.因此,第2步,需要对特征点进行过滤.第3步,对图像平面进行Delaunay三角化,这样才能在前后图像和中间过渡图像建立映射关系.第4步,通过插值算法和映射关系生成中间过渡图像.从SUN 图像数据库中选取了测试图像进行测试,其中一组测试结果如下文所示.选用的参考图像如图3所示:第1步,提取特征点.标有全部特征点位置信息的图像如图4所示.第2步,筛选特征点.标有筛选后的特征点位置信息的图像如图5所示.图3 参考图像Fig.3 Reference images图4 标有全部特征点位置的图像Fig.4 Images labeled all key points图5 标有筛选后的特征点位置信息的图像Fig.5 Images labeled filtered keypoints第3步,Delaunay三角剖分.根据筛选后的特征点位置信息,对原始图像进行Delaunay三角化,运算结果如图6所示.第4步,图像插值和生成过渡图像.根据对原始图像Delaunay三角化的结果,建立平均网格.从而实现前一幅图像到后一幅图像的对应关系.根据预先设置的过渡帧数,在图像插值的基础上,生成的六帧过渡图像如图7所示.实验的硬件环境:CPU 为Intel(R)Core(TM)i3 M380,内存为4 Gbyte.软件环境是操作系统Windows 7 Ultimate,开发工具为Visual Studio 2008,使用的OpenCV 是2.4.6.在做实验的过程中,选取了视点间的两幅图像进行实验.在实际制作全景图的过程中这一步也需要手工设置.在选取中间图像之后,提取特征点、筛选特征点、Delaunay三角剖分和过渡图像的生成都是在无需干预的情况下完成.在生成过渡图像时,需要预先设置过渡图像的帧数.一般选择6~10帧即可.从图3的实验结果可以看出,首先生成的过渡图像总体上与前一幅图像相似度较高,而最后生成的过渡图像与后一幅图像相似度较高.当将这些过渡图像逐帧显示时,就可以看到从前一幅图像光滑过渡到后一幅图像的视觉效果.算法对视点间的图像没有强制性要求,即使选择的图像质量不高,也能得到较为光滑的过渡图像.图6 Delaunay三角化后的图像Fig.6 Images of delaunay triangulation图7 生成的过渡图像Fig.7 Generated intermediate images4 结论由于自然图像结构复杂,层次丰富,细节性信息多,所以自然图像的平滑过渡是一个较难的问题.本文提出的基于图像变形的平滑漫游算法通过在两幅图像上提取特征点,从而挖掘图像深层次的细节信息,给后续的中间过渡图像的生成提供了很好的基础.另一方面,算法中考虑了图像的空间分布,保证特征点在图像平面分布均匀,从而也保留了图像的细节和轮廓信息,因此也避免了较大形变的产生.在生成过渡图像的过程中,引入了双线性插值算法,这也有效地保留了自然图像的原始信息和颜色信息.通过对实验结果观察、比较得出,本文提出的算法执行效率较高,能够适应全景漫游系统的实时制作性要求.另外,实验结果也能表明,该算法适用于自然图像,尤其是那些几何特征不明显,而图像细节又丰富的情形.【相关文献】[1]刘建成,崔杜武.基于全景图的多视点虚拟空间漫游技术[J].计算机工程,2004,30(1):153-154.[2]陈立栋,徐玮,包卫东,等.一种全景图像浏览器的设计与实现[J].小型微型计算机系统,2008,29(3):517-519.[3]Tsai V J D,Chang C T.Three-dimensional positioning from Google street view panoramas[J].Image Processing,IET,2013,7(3):229-239.[4]陈辉,龙爱群,彭玉华.由未标定手持相机拍摄的图片构造全景图[J].计算机学报,2009,32(2):329-335.[5]刘静怡,张剑清.多视点全景图与平滑漫游的研究实现[J].计算机工程,2009,35(12):187-191.[6]曾涛,戴余良,程刚,等.非跳跃式全景漫游算法及在X3D 下的实现[J].系统仿真技术,2008,20(4):268-271.[7]Lowe D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.[8]Jiang M Q,Liao Q W,Hong J X,et al.A sift-based method for image mosaic[C]//2010 3rd International Conference on Advanced Computer Theory andEngineering.Chengdu:IEEE Press,2010,6:423-427.[9]Wang W,Hong J,Tang Y P.Image matching for geomorphic measurement basedon SIFT and RANSAC methods[C]//Proc.on Computer Science and Software Engineering.Wuhan:IEEE Press,2008,2:317-320.[10]Zhang G M.An automatic method for image mosaic based on feature matching[C]//2011 International Conference on Electric Information and Control Engineering.Wuhan:IEEE Press,2011:3934-3937.[11]Chen R J,Gotsman C.Localizing the delaunay triangulation and its parallelimplementation[C]//2012 Ninth International Symposium on Voronoi Diagrams in Science and Engineering.New Brunswick:IEEE Press,2012:24-31.[12]Bhatt B parative study of triangulation based and feature based image morphing[J].Signal&Image Processing:An International Journal,2011,2(4):235-243.[13]刘然,朱庆生,张小云,等.一种用于视图合成的空洞填充算法[J].计算机应用研究,2009,26(8):3145-3148.。

基于图像绘制的虚拟现实的实现方法

基于图像绘制的虚拟现实的实现方法张菊【摘要】虚拟现实的实现方法有基于图形的和基于图像的.介绍了基于图像绘制的实现方法,并对这些方法做了介绍和比较.【期刊名称】《黑龙江科技信息》【年(卷),期】2010(000)034【总页数】1页(P107)【关键词】虚拟现实;图像绘制;全景图【作者】张菊【作者单位】辽宁省交通高等专科学校,辽宁,沈阳,110122【正文语种】中文虚拟现实技术包括沉浸式与非沉浸式虚拟现实技术。

通常沉浸式虚拟现实技术是主要依赖特殊硬件来实现的,而非沉浸式虚拟现实技术是依赖专门的软件来实现的。

采用非沉浸式虚拟现实技术较为经济实用。

尽管是借助键盘、鼠标、显示器等标准外设来营造一个窗口式的虚拟环境,但还是可以应用软件技术使其尽可能接近较理想的虚拟现实环境。

它可采用基于图形(几何建模)的方法或基于图像的方法实现。

由于基于传统的计算机图形学方法建立虚拟现实有明显的缺点,近年来出现了利用实际拍摄图像来建立虚拟现实环境的方法,即基于图像的建模和绘制技术。

基于图像的绘制方法是一种可实时生成真实感图像,且生成图像的质量独立于场景复杂度的方法。

它主要分为以下几类:Lippman制作的Movie-map[1]系统是最早的基于图像的绘制系统之一。

该系统还可以围绕固定的视点左右、上下的摇动镜头,或者将景物拉近、推远,Movie-map方法可以解释为基于表的方法,大多数基于图像的系统都具有这种类似数据库的结构。

导航电影是另一种电影图方法,它除了提供上述功能外,还可以实现参与者绕着场景中某个实体的经度和纬度方向观察。

图像变形技术(Image Morphing)是指如何有效的从两幅给定图像通过形状和色彩的2D插值产生中间图像,达到从一幅图像变形到另一幅图像的技术,美国斯坦福大学与威斯康星大学是这一领域的领先者。

该技术已广泛应用于影视特效。

Beier[2]提出了基于特征的变形,这种变形技术的优势在于操作者可灵活的定义特征对应关系,变形按照操作者的意图进行,但计算量以及在指定特征之外的区域无法控制。

基于图像的虚拟场景漫游技术研究(信息与通信工程专业优秀论文)

国防科学技术人学研究生院学位论文然后他用泛函求导方法导出高斯函数的一阶导数,此即为该最佳函数的最好近似,且有简便的计算方法。

在进行处理前,Canny算法先用高斯平滑滤波器来平滑图像用来除去噪声,即用高斯平滑滤波器与图像作卷积。

滤波的目的是为了消除噪声,因为图像中的噪声在图像傅旱叶变换中对应着高频部分,所以要在频域中削弱噪声的影响,就要设法减弱这部分的频率分量。

实际工作中,人们常常采用低通滤波器来实现。

然而大多数滤波器在降低噪声的同时也导致了边缘强度的损失(边缘也对应着高频部分)。

因此,需要在边缘与噪声之间作一个折衷,采用高斯平滑滤波器是一个较好的折衷方案。

增强边缘是将邻域(或局部)强度值有显著变化的点突出来,它一般通过计算梯度幅值来完成的,Canny分割算法采用一阶偏导的有限差分来计算梯度的幅值和方向。

对一个边缘来说,其一阶导数在边界处存在一个向上的阶跃或者其二阶导数过零点。

导数的计算对噪声很敏感,而一般的边缘检测也正是利用求导数来实现的。

在处理过程中,Canny算法还将经过一个非极大值抑制(NonmaximalSuppression)的过程。

最后,Canny算法将采用两个阈值来连接边缘。

非极大值抑制是为了保证边缘线被细化为一个象素的宽度,Canny算子采用边缘梯度方向的非极大抑制方法。

如果在45度和135度边缘方向的每边区域的狄度值是相同的,这种方法容易产生厚边缘。

如图2.1所示,其原因是这些边界象素点在边缘方向上没有邻接边界点。

我们可以用这种方法消除这种厚边缘,对边缘方向为45度和135度的象素点与它的水平或垂直方向的邻接边界点作比较,如果它的水平或垂直方向的邻接边界点也有同样的边缘方向,则删除它的邻接边界点,显然这种方法可以消除这种厚边缘。

鼬2.1135度厚边缘示意l璺I2.2.2边界线断点填充用Canny算子来提取图像的边界一个最大的优点就是很容易把边缘细化为单象素宽度,而且效果也较好,但是在边缘细化过程中在边界上容易产生断点,而且随高斯函数的口系数的不同及两个阈值参数的不同,产生的断点的个数与断点间隔长度也不同,因此我们必须对断点进行填充,国防科学技术入学研究生院学位论文圈2.4新算法实验结_聚图l(b)SUSAN酗2.5新算法实验结果幽2(a)Harris(b)SUSAN(c)newalgorithm图26新算法实验结果倒3(b)SUSAN(c)newalgorithm幽27新算法实验结果幽4国防科学技术人学研究生院学佟论文其中k为一个尺度因子系数。

虚拟现实技术在非物质文化遗产保护中的应用

虚拟现实技术在非物质文化遗产保护中的应用非物质文化遗产是反映人类民俗文化和生活方式存在和变化发展的“活化石”,它以一种独特的方式向世人诉说着人类自身的成长历程。

它在文化保护中的重要地位也逐渐受到各国人民的重视。

然而,非物质文化遗产作为一种极为特殊的文化载体,尤其是它“无形”的状态特征,为人们对它的宣传和保护带来了种种困难,传统的方法也显现出各种弊端。

本文将虚拟现实技术的优越特点应用于非物质文化遗产保护中,力求达到使非物质文化遗产在保护中有创新,创新中有特色的可持续发展目标。

【关键词】虚拟现实技术,非物质文化遗产保护,传统文化,可持续发展中国是世界著名的四大文明古国之一,悠久的历史和丰富的文化遗产向世界展现着先人所创造的辉煌。

近年来,国际上掀起了申请非物质文化遗产的热潮,特别是韩国江陵端午节申遗的成功让国人反思到:为什么我们拥有两千多年历史的端午节被韩国捷足先登了?为什么国内罕见的文物却陈列在国外博物馆内?甚至有德国人说,要看中国的浮雕到德国来;有日本人说,要看苗族服饰到日本来。

不可否认,中国文化遗产的所有权正在流失,许多珍贵的非物质文化被他国抢注,我们必须利用现代化保护手段,使文化主权得到应有的保护。

虚拟现实技术发展为非物质文化遗产的保护提供了更先进的技术与可能,以一种新颖的方式改变着非物质文化遗产保护的发展趋势。

一、非物质文化遗产的概念与保护难度对于非物质文化遗产的定义,联合国教科文组织自1989年以来至少做了五次修改。

中国由国务院颁布的《国家级非物质文化遗产代表作申报评定暂行办法》对非物质文化遗产作了这样的界定:“非物质文化遗产是指各族人民世代相承的,与群众生活密切相关的各种传统文化表现形式(如民俗活动、表演艺术、传统知识和技能以及与之相关的器具,实物和手工制品等)和文化空间。

其范围包括:第一,口头传统,包括作为文化载体的语言;第二,传统表演艺术;第三,风俗活动、礼仪、节庆;第四,有关自然界和宇宙的民间传统知识和实践;第五,传统手工艺技能;第六,与上述表现形式相关的文化空间。

基于三维全景视图的虚拟校园漫游导航系统

Vi r t u a l Ca mp u s Ro a mi n g Na v i g a t i o n S y s t e m Ba s e d o n T h r e e— —— — DI M ENS I ONAL P a n o r a mi c Vi e w S U R o n g ,L I S h e n g—l e , L I Ya n —l i n g

将校园地理信息 和其他校 园信息相 结合 , 实现校园漫游导航及信息 的浏览查询 , 并 可上 载到 计算机 网络 , 提供远程

用户访问。

关键词 : 全景图 ; 虚拟校 园 ; 三维 ; 导 航

中图分类号 : 1 1 P 3 9 1

文献标识码 : A

Hale Waihona Puke 文章编号 : 1 0 0 0— 2 3 2 4 ( 2 0 1 4 ) 0 1 — 0 1 0 3一 o 7

a n d o t h e r i n f o r ma t i o n wi t h v i tua r l r e a l i t y s c e n e, a n d a c h i e v e s r o a mi ng t h e c a mp u s l a nd s c a p e a nd i n f o m a r t i o n b r o ws i ng a n d q u e r y i n g,a n d b e up l o a d e d t o t h e c o mp u t e r n e t wo r k,p r o v i d e s a r e mo t e u s e r a c c e s s . Ke y wo r d s: P a n o r a mi c i ma g e; v i tu r a l c a mpu s ; t h r e e—d i me n s i o n a l ; n a v i g a t i o n

虚拟现实技术研究背景及国内外现状

虚拟现实技术研究背景及国内外现状1课题的研究背景目前,虚拟漫游技术在实现方法上可分为两种,主要是按照虚拟场景的构造方来区分,一种是传统的基于几何图形绘制(Graph——based Rendering,GBR)的虚拟漫游技术,另一种是新兴的基于图像绘制(Image——based Rendering,IBR)的虚拟漫游技术。

传统的漫游主要使用成熟的几何建模技术,通过手工方法实时建立场景的三维模型,这种方法需要花费大量时间建模,而且对硬件性能的要求很高,其漫游场景是由计算机根据一定的光照模型绘制的,色彩层次没有实际的自然景观丰富,带有明显的人工痕迹。

为此,近几年来国际上开始出现基于图像绘制技术来构造虚拟空间的方法,它利用照相机采集的离散图像或摄像机采集的连续视频作为基础数据,经过图像处理生成全景图并对其进行时间或空间的关联,从而建立起具有空间操纵能力的虚拟场景。

虚拟实景漫游是对现实世界中的景物虚拟漫游,与一般传统的或计算机动画的虚拟漫游相比,它具有以下特点:(l)一般的漫游对象往往是通过创作或设计想象出来的,以人工环境为主,而虚拟实景漫游的对象则是在现实世界中客观存在的;(2)一般的漫游环境中的视觉效果通常是由人工设计出来的,允许与实际情况不完全吻合,而虚拟实景漫游中的视觉效果则要求尽可能的与实际的视觉效果相一致,才能给人以身临其境的视觉感。

基于图像的虚拟现实系统具有场景逼真、交互方便和无需特殊的硬件等优点,目前已用于虚拟旅游和娱乐、虚拟训练、医疗领域和虚拟制造等方面,还可用于科学可视化和系统仿真等方面。

由此可以看出,基于图像的虚拟现实技术具有极大的应用前景和研究意义。

2 国内外研究现状虚拟现实技术的产生与发展,就虚拟实现本身而言,它主要设计到三个研究领域:1.通过计算机图形方式建立实施的三维视觉效果。

2.建立对虚拟世界的观察面。

3.使用虚拟现实技术加强诸如科学计算技术方面的应用。

目前,建立虚拟现实技术已引起了人们的普遍关注,目前,在国内外有许多政府部门,公司,大学,研究所正在致力于这方面的研究。

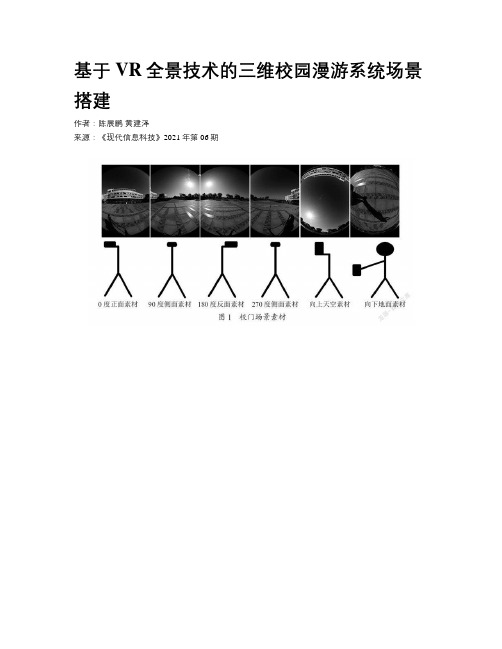

基于VR全景技术的三维校园漫游系统场景搭建

基于VR全景技术的三维校园漫游系统场景搭建作者:陈展鹏黄建泽来源:《现代信息科技》2021年第06期摘要:随着高科技和自媒体的快速发展,人们日益追求足不出户即可获得身临其境的生活体验,为满足技术提升所带来的用户对高效便捷的需求,使用户的参与感变强,文章以广州工商学院三水校区校园外景虚拟场景搭建为例,主要研究基于720云平台的全景制作流程和关键技术,全方位展示校园的特色。

通过硬件与软件的相互结合,使用全景拍摄、拼接、图像处理、优化、交互等技术,最终完成广州工商学院三维校园漫游系统的场景搭建工作。

关键词:全景图;虚拟场景;校园漫游;720云中图分类号:TP391.9 文献标识码:A 文章编号:2096-4706(2021)06-0087-05Scene Construction of 3D Virtual Campus Based on VR Panoramic Technology——Take Sanshui Campus of Guangzhou College of Technology and Business as an Example CHEN Zhanpeng,HUANG Jianze(Institute of Technology,Guangzhou College of Technology and Business,Foshan 528138,China)Abstract:With the rapid development of high technology and we media,people are increasingly pursuing to get immersive life experience without going out. In order to meet user’s demand for efficiency and convenience brought by technology upgrading,and make users have a stronger sense of participation. Taking the virtual scene construction of campus exterior view from Sanshui Campus of Guangzhou College of Technology and Business as an example,this paper mainly studies the panoramic production process and key technologies based on 720 cloud platform,and displays the characteristics of the campus in an all-round way. Through the combination of hardware and software,using panoramic shooting,mosaic,image processing,optimization,interaction and other technologies,the scene construction of 3D virtual campus of Guangzhou College of Technology and Business is completed finally.Keywords:panorama;virtual scene;virtual campus;720 cloud0 引言全景虚拟现实技术可以较好地展示目标场景,让人感受到虚拟影像中的三维立体空间关系,实现全方位浏览图像景色[1]。

基于虚拟现实的数字建筑漫游技术研究

基于虚拟现实的数字建筑漫游技术研究一、引言随着科技的不断进步,虚拟现实技术得到了越来越广泛的应用,不仅应用于娱乐领域,同时还开始在建筑、医疗等领域得到应用。

基于虚拟现实的数字建筑漫游技术正是其中的一种应用。

本文将介绍基于虚拟现实的数字建筑漫游技术的研究现状和未来发展趋势。

二、数字建筑漫游技术的特点数字建筑漫游技术是指通过虚拟现实技术,将真实建筑的信息数字化,并以三维的形态呈现出来。

这种技术不仅能够将建筑展示给观众,还能够让观众与建筑互动。

数字建筑漫游技术具有以下特点:1. 逼真度高。

通过虚拟现实技术的呈现方式,数字建筑漫游技术能够呈现出逼真的建筑信息,让观众仿佛置身于真实的建筑之中。

2. 互动性强。

数字建筑漫游技术能够让观众与建筑互动,探索各个角落,并了解建筑的细节。

3. 安全性高。

数字建筑漫游技术能够在安全的情况下,提供一个全方位的漫游体验,让观众尽情探索建筑的内部。

三、数字建筑漫游技术的应用数字建筑漫游技术具有广泛的应用前景,以下是数字建筑漫游技术的主要应用领域:1. 建筑设计。

数字建筑漫游技术能够帮助建筑师在实际建设之前,对建筑模型进行验证和调整,从而提高建筑设计的效率和准确性。

2. 建筑教育。

数字建筑漫游技术能够将建筑以全新的方式呈现给学生,让学生能够更加深入地了解建筑的结构和细节。

3. 建筑规划。

数字建筑漫游技术能够将城市的规划信息数字化,并以三维的形式进行呈现,提高规划效率和准确性。

4. 旅游观光。

数字建筑漫游技术能够将文化景点、博物馆等建筑进行数字化,并以三维的形式进行呈现,让游客能够更加深入地了解建筑的历史和文化。

四、数字建筑漫游技术的研究现状数字建筑漫游技术的研究已经得到了较多的关注。

以下是数字建筑漫游技术的研究现状:1. 数据采集。

数字建筑漫游技术需要通过数据采集将建筑信息数字化,这需要采用各种传感器和测量仪器进行数据采集。

2. 数据处理。

得到的原始数据需要处理,并转化为可以被虚拟现实引擎处理的格式。

全景图自动拼接算法研究及系统实现

摘要全景图是虚拟现实中一种重要的场景表示方法。

通常获得高质量的全景图需要使用昂贵的专用设备,而且拍摄时需要精确地校准摄像机。

从普通摄像机图像拼接是获得全景图的一种低成本而且比较灵活的方法。

采用普通照相机拍摄的照片可能出现图像扭曲、交叠和倾斜,照片之问可能有一定色差,因此,在图像的拼接和建立全景图方面难度大。

本文中主要是通过对多种图像拼接算法的研究,提出图像拼接改进算法,该算法能够在较宽松的条件下能够较准确地匹配两幅图像,实验证明该算法能够有效地拼接普通相机拍摄的照片,消除图像扭曲、交叠和倾斜对于图像拼接的影响。

同时,在实现柱面全景图时,为了不改变物体在自然界中的几何信息,也进行了柱面投影研究,实现柱面全景图。

最后使用vC++和OpenGL技术实现了图像拼接系统和柱面全景图浏览器,该系统能够自动拼接按照数字排序的序列照片。

柱面全景图浏览器可以通过鼠标和键艋方向键360”浏览全景图。

关键字:图像拼接;全景图:柱面全景图:柱面投影AbstractAsallimagerepresentationofvirtualenviroarnent,panoramahasimportantapplicationsinVirtual—Reality.Generally,togetapanoramawithhighquality,weneedsomespecial,expensiveandcarefullycalibratedequipment.ImageMosaicisaninexpensiveandflexibleapproachtogetpanoramawithasimplehand-heldcamera.Thephotostakenwithahand—heldcamerausuallyhavelargeperspectivedistortion,smalloverlap,brightnessdifference,smallconcentricerrorsandcamerarotations.Thesecharacteristicsmakebothimagealignmentandpanoramabuildingmoredifficultthanusingphotostakenbycamerascalibratedbyspecialequipment.Basedonstudyingmanyimagemosaicalgorithms,wepresentabetteronethatisabletoaccuratelystitchtwosimilarimagesautomaticallywiththelimitationofthephotos.Theresultfromthethevalidityofthealgorithm.Atthesametime,Istudythecylindricalexperimentshowsprojectionalgorithmsandimplementcylindricalpanoramicimage.Atlast.Iimplementanimage—mosaicsystemandapanoramabrowserwithVC++andOpenGL.ThissystemCanstitchaserialofphotosorderedbynumbers.ThepanoramabrowserCallbeenusedtobrowsecylindricalpanoramicimagewithin360。

基于虚拟现实技术的三维校园漫游系统设计与实现

第13期2023年7月无线互联科技Wireless Internet TechnologyNo.14July,2023作者简介:张玉婷(1980 ),女,江苏南京人,讲师,硕士;研究方向:数字媒体技术,虚拟现实技术㊂基于虚拟现实技术的三维校园漫游系统设计与实现张玉婷(金肯职业技术学院人工智能与信息工程学院,江苏南京210000)摘要:文章以金肯职业技术学院为例,通过3Ds Max 软件进行三维模型的创建,使用Photoshop 处理照片,Substance Painter 编辑材质贴图,再导出模型到Unreal Engine 4虚幻引擎中完成整个场景的搭建和运行㊂应用Unreal Engine 4自带的蓝图可视化脚本或者C ++语言,添加多样的人机交互,再连接到VR 设备,通过控制手柄,完成沉浸式的虚拟现实校园漫游系统㊂关键词:虚拟现实;漫游;Unreal Engine 4中图分类号:TP391㊀㊀文献标志码:A0㊀引言㊀㊀随着三维技术和虚拟现实技术的发展,现实场景的数字化可以更好㊁更便捷地展示特定的区域㊁场馆㊁风景㊂其科技性㊁艺术性和身临其境的观感,可以给人们提供跨越时间和空间的沉浸式体验㊂近年来,国内外各大高校一直努力进行硬件㊁软件的数字化㊁智能化㊁信息化的建设㊂在以往传统的校园场景三维建筑动画的基础上,融入新的虚拟现实技术,增加体验效果㊂本文以金肯职业技术学院为例,介绍基于虚拟现实技术的三维校园漫游系统的设计与实现㊂1㊀总体设计㊀㊀首先确定了应用虚拟现实技术实现三维校园漫游的方案㊂使用CAD㊁3ds max 制作三维模型,在三维软件中对建筑物㊁地形㊁实体对象进行模型的创建和优化㊁展开UV,再导出FBX 文件到Unreal Engine 4(以下简称 UE4 )中进行整合和搭建场景㊂在其中完成植被㊁灯光㊁材质㊁碰撞等设置㊂通过蓝图可视化脚本或者C ++语言,添加有趣㊁恰当的交互设计,最后与VR 硬件设备进行打包安装㊁测试发布,完成虚拟校园的三维漫游系统的设计与制作[1]㊂2㊀漫游系统的开发与实现2.1㊀数据采集㊀㊀真实场景的数字化还原要有准确的校园各场景建筑物分布信息㊂金肯学院有南㊁东㊁西3个校区,已有的CAD 图纸不完整㊂通过实地勘测与拍照结合的方式,采集㊁整理了地形图和建筑设计图等数据,绘制了校园内的各教学楼㊁体育馆㊁图书馆㊁宿舍区㊁食堂㊁办公楼㊁实训楼等区域分布图,划分出主干道和建筑小品的区域[2]㊂2.2㊀模型创建和导入㊀㊀在前期绘制的CAD 图纸的基础上,通过照片建模的方式,在三维软件3Ds Max 中,1ʒ1还原各主要建筑物的外观模型㊂由于整个场景数字化数据较大,因此在创建过程中,务必要做好模型面数的控制,及时优化㊁处理错漏面,最后导出为FBX 格式的文件㊂打开UE4,在新建项目中选择蓝图,选择第一人称,创建空白项目㊂点击导入命令按钮,将FBX 文件导入引擎中㊂第一次导入的时候,通常需要选择设置选项卡㊂可以根据系统要求设置 自动创建碰撞体 创建灯光UV 视图 合并模型 等项目内容㊂此外,还可以选择 新建材质 或者 导入纹理 来决定导入模型时,是否创建材质球和附带相关的材质素材㊂将地形㊁建筑物等模型依次导入后,UE4会对导入有问题的部分进行提醒,通常要一一查看模型㊁材质球㊁纹理贴图等效果是否需要修改㊂必要的时候,要返回到三维模型软件中进行调整㊂解决问题后,对各个文件进行分类整理,方便以后调取使用㊂2.3㊀材质贴图制作㊀㊀由于整个校园的建筑外立面设计独特㊁风格统一,系统采用了大量拍摄的实景照片,使用Photoshop 软件进行后期处理,Substance Painter 软件绘制纹理,作为建筑的贴图使用㊂此外,使用UE4虚幻引擎自带的材质系统为模型添加外观效果[3]㊂打开UE4虚幻引擎,在内容浏览器空白处单击鼠标右键,选择创建新材质㊂双击材质球,打开UE4的材质编辑器,在界面中空白位置按下数字键3,创建一个三维数组㊂点击Constant 色块可以设置具体的RGB 颜色㊂按住鼠标左键不松手,拖拽连接到基础颜色的节点上,完成材质颜色的创建㊂同样的原理,按住数字键1,创建一个一维数组,设置参数在0~1的任意数值,再拖拽到粗糙度或者高光度的节点上,就可以设置相对应的效果㊂之后返回场景中,将材质球附在模型上,就可以看到实际效果㊂漫游系统中,可以通过复制已有的材质球,在编辑器中修改其中的某些参数,来得到另一个新的材质㊂基础材质如图1所示㊂图1㊀基础材质在系统中,有些模型需要添加纹理贴图㊂可以在材质编辑器界面中,按住U 键的同时单击鼠标左键,就会创建新的节点纹理坐标㊂在其中导入处理好的贴图,将输出端连接到UV 引脚上㊂在左下角的界面中输入数量,可以调整贴图的比例以适应模型的大小㊂2.4㊀交互设计㊀㊀本系统设置了第一人称的视角,带上VR 眼镜之后,仿佛置身于现实场景中㊂参观者通过对手柄的控制,实现走㊁跑㊁跳跃㊁转向㊁瞬移等运动效果,模拟真实场景中人的基本运动动作㊂系统添加了对话系统㊂当人物走进特定的区域,或者点击场景中的某个道具,画面中会出现相关的校园介绍㊂为了增加参观者的体验感,这些内容以动态文字㊁动画视频结合的方式呈现,伴以适合的音乐,提升氛围感和视觉效果㊂系统设计了自动导航,默认情况下顺着设计好的路线进行漫游㊂通过右上角的同步小地图,体验者可以一目了然地掌握所在位置㊂同时,考虑到校区区域范围大,在制作系统时,设计了通过快捷键或者操作VR 设备配套的手柄,可以跳转到不同的校园区域,精准定位到各场景,实现空间的交互㊂为了添加趣味性,系统特地增加了一些交互小游戏㊂比如在漫游到湖心亭的时候,体验者通过手柄射线点击UI 界面上的按钮,开启材质贴图的样式和颜色的切换功能,欣赏由 一键换装 带来的春夏秋冬不同的风景㊂2.5㊀多视角角色的创建和切换㊀㊀高职院校各类实训室㊁工作室的建设,也体现学院的成果和特色㊂系统特意增加了室内漫游的内容,因此系统需要实现360ʎ室外场景自由旋转查看的功能和用于室内漫游的角色,以及两种角色相互切换控制权的设置㊂在UE4中选择蓝图类创建Pawn,创建一个能被操控的角色㊂在编辑界面中,添加组件里面新建弹簧臂组件㊂以这个点做一个牵制,以弹簧臂组件为父类,添加摄像机组件为子类,弹簧臂就能牵制摄像机进行360ʎ的旋转查看㊂接着点击弹簧臂组件,在细节面板中勾选使用Pawn 控制旋转,弹簧臂会跟着鼠标进行旋转㊂接下来,通过蓝图输入一些控制逻辑,来实现鼠标输入的事件㊂在事件列表界面中,输入Turn,调取 输入轴Turn ;再输入LookUp,调取 输入轴LookUp ㊂将 输入轴Turn 里面的Axis Value 连接关联的 添加控制器Yaw 输入 ,其中Yaw 设置的是Z 轴㊂将Lookup 连接关联的 添加控制器Pitch 输入 ,Pitch 对应的是Y 轴㊂设置完成之后,摄像机就可以跟随鼠标旋转㊂接着把蓝图类放置在场景中,调整位置㊁高度㊂可以通过调整摄像机的目标臂长度的数值,将视角调整得远或者近一些㊂设置完成回到场景,在细节面板中,自动控制玩家选择 玩家0 ㊂保存文件进行编译,查看设置效果㊂如果旋转生硬,可以在蓝图类中选择弹簧臂组件,启动摄像机旋转延迟㊂这样旋转角度时,就会更加丝滑自然㊂接下来继续创建第二个用于室内场景漫游的角色㊂在内容浏览器中单击鼠标右键,选择蓝图类,创建一个有碰撞的Actor 角色,用来模仿人在场景中真实漫游㊂先添加弹簧臂组件和摄像机㊂摄像机放在弹簧臂组件的子类里面,但弹簧臂长度要改成0,用来模拟人的头部旋转查看场景㊂在右侧的编辑面板中,勾选 使用Pawn 的控制旋转 ㊂在设置完Z 轴Y 轴坐标后,还需要设置角色前后左右的移动㊂在场景漫游角色的事件图表界面中,添加 输入轴Move Forward 和 输入轴Move Right ,再调出 获取控制旋转 ,在Return Value 右键引出 分割结构体引脚 ,使用Z 轴Yaw 创建旋转体,Return Value 中获取向前向量,再获取向右向量Add Movement,添加移动输入㊂系统已经封装好能够让角色移动的蓝图节点,只要传入对应的参数即可㊂设置完成之后,当按下键盘W,就会返回数字+1,按下S 就会返回数字-1,如果没有输入,就会返回数字0㊂有数值之后,角色就会移动㊂当按下W 键,传入的是+1,移动的方向就会参考向控制器正前方移动;当按下S 键,传入的是-1,向前的向量乘以-1,变成向后的向量,就会向后移动㊂同样的原理,按下A 键输入的是-1,向左移动;按下D 键输入的是+1,向右移动㊂将设置好的Actor 角色拖动到场景中编译测试㊂如果角色移动速度或快或慢,可以在Character Movement 组件中设置最大行走速度,改成适合的数值即可㊂最后,设置两个角色控制权的切换㊂为了能够快速地实现功能,可以把这些蓝图写在关卡蓝图里面㊂打开关卡蓝图界面,先创建两个自定义事件,一个是切换到场景漫游,另一个是切换到360度自由查看㊂接下来将两个蓝图类拖拽到关卡蓝图界面㊂新建 获取玩家控制器 节点,连接 使用混合设置视图目标 ,引脚连到 切换到场景漫游 ,再将 场景漫游角色 连接到New View Target,Bland Time(混合时间)设置成2.0㊂设置的效果是经过2s时间,将当前的画面,混合到新的画面㊂Bland Func(混合函数)选择 VT混合交叉缓动 ,就会有缓动效果㊂再用同样的方法,完成从另一个角色的跳转设置,实现2个镜头之间的混合㊂之后,在事件图表界面中输入F键㊁空格键和键盘,直接跳转到键盘事件,用FlipFlop制作一个流程控制㊂按下F走A,再按一下走B,再按一下再走A,往复循环的功能㊂实现由A引出切换到场景漫游,由B切换到360ʎ全景漫游㊂2.6㊀场景中播放视频㊀㊀为了更好地展示和介绍学院信息,系统在场景中设置了几处通过屏幕播放视频的组件㊂先提前制作好相关的mp4格式的视频文件㊂在内容文件夹里面创建新文件夹存储相关文件㊂在空白处单击鼠标右键,在弹出的快捷菜单中选择Media里面的Media Player㊂再次单击鼠标右键,在弹出的快捷菜单中选择创建蓝图类,选择Actor角色,命名之后双击打开编辑界面㊂在左侧的组件中选择Cube,调整尺寸大小,做成类似显示屏的模型,用来播放视频使用,再根据需求设置材质㊂在关卡蓝图中,调出Event BeginPlay事件㊂创建变量,选择Media Player中的Object Reference对象引用㊂在默认值中选择创建的Media Player㊂再将Media Player拖入编辑区,拖出引脚连接Open Source 打开源㊂在下方选择需要播放的视频㊂再将创建的Actor拖入场景,并编译保存㊂此时场景中可以播放视频画面,但缺少声音㊂这是因为这种播放视频的原理是将视频作为材质附在模型上㊂因此需要再设置声音㊂双击打开Actor编辑界面,在Cube组件中找出Media Sound组件㊂在编辑器的Media Player里面找到创建的播放器㊂再次编译,视频画面和声音都同步出现了㊂3 结语㊀㊀本系统使用了三维软件㊁虚幻引擎和VR设备,创建了校园的虚拟现实漫游系统,对现实场景数字化构建㊁虚拟交互体验,进行了实践操作㊂由于相关技术难度较大,更新换代较快,目前国内的研究还需要学习和补充一些国外的技术和思维㊂随着技术的发展,还会有更多的虚拟数字化应用,适用于更多不同的领域,拓展时间和空间的范围[4]㊂参考文献[1]叶玉萍.基于虚拟现实技术的三维校园漫游系统研究[J].电脑与信息技术,2020(28):14-16. [2]庄姗姗.基于虚拟现实技术的漫游校园VR系统的研究与开发[J].信息记录材料,2021(22):227-229. [3]苏雨晴,李彦雪,严进轩.虚拟现实技术在校园景观漫游中的应用研究[J].现代园艺,2022(7):121-123.[4]刘崧印,朱学芳,李川.基于VR技术的虚拟图书馆全景漫游系统的设计与实现[J].图书馆学研究, 2022(11):47-56.(编辑㊀沈㊀强)Design and implementation of3D campus roaming system based on virtual reality technologyZhang YutingSchool of Artificial Intelligence and Information Engineering Jinken College of Technology Nanjing210000 ChinaAbstract Taking JinKen Vocational and Technical College as an example the system uses3ds Max software to create a three-dimensional model uses Photoshop to process photos Substance Painter to process material maps and then exports the model to the Unreal Engine4virtual engine to complete the construction and operation of the entire scene. Apply Unreal Engine4 s own blueprint visualization script or C++language add various human-computer interactions and then connect to VR devices.Through the control handle complete an immersive virtual reality campus roaming system.Key words virtual reality roam Unreal Engine4。

一种基于多边形柱面全景图的虚拟漫游新方法

摘

要 : 出了一种基于图像绘制的多边形柱面全景 图的虚拟漫游方法。 提 利用普通

的手持相 机在 一 个多 边形 区域 内沿某一路 径拍 摄 并拼接 多幅全 图像插值来 实现整个 区域 内的平滑漫游。该方法具有采样简单、

虚 拟 场景真 实感 强 ,支持 连 续 大范 围漫游 的特点 。 关 键 词 :虚 拟 漫游 ;基 于 图像 的绘制 ;全 景 图;狭缝 图像

文 章 编 号 :1 0 - 182 1 )10 5 -7 0 30 5 (0 20 —0 60

中图分 类号 :T 9 . P3 1 4 文 献标识 码 :A

A ve e ho o i t lwa k hr ug i l g na n r m i os i s no lm t d f rv r ua l t o h usng po y o lpa o a c m a c

Wa gH iig, Q nKa u i n a n y i i a。 h

( . hn et Ifr ai d syD vl metB in 0 0 8C i ; 1C ia ne o nom tnI ut eeo n, eig104 , hn C rf o n r p j a 2D p r n f o p t c ne n ehooyTig u ie i , e ig10 8 , hn ) . eat t C m ue Si c d cn lg, s ha vrt B in 00 4C ia me o r e a T n Un sy j

随 着 三 维 图 形 图 像 的 绘 制 ( g . ae I eB sd ma R n eig BR 技 术 的发 展 , 虚 拟 现 实( iu l e dr ,I ) n Vr a t R ai , ) elyVR 技术 已经被 越来 越广 泛地 应用 ,它 可 t 以用 于虚 拟旅 游和 娱乐 ,例如 著名旅 游景 点和 博 物馆 的虚 拟游 览 ;也 可 以用 于虚 拟训 练 ,例如 飞 机和 车辆 驾驶 ,以及 虚拟 战场仿 真等 ;另外还 可

基于OSG的虚拟建筑漫游系统的设计与实现

基于OSG的虚拟建筑漫游系统的设计与实现摘要:为了实现建筑参观的真实感和沉浸感,该文结合虚拟现实技术的综合应用,使用sketchup建立建筑三维模型和室内景观三维模型,以目前性能较高的开源图形引擎osg(openscenegraph)作为支撑,在windows平台下利用visualstudio2008设计开发了虚拟建筑场景漫游系统。

系统采用高效的算法和优化的渲染技术实现了手动漫游和自动漫游的综合功能,利用多线程技术在多视口中观察图片并配以语音解说,同时增加了导航功能,使参观者在立体环境下体验逼真、直观的建筑漫游感受。

虚拟建筑漫游在建筑设计、城乡规划、室内装潢等建筑行业将带来全新的展示和营销方式。

关键词:虚拟现实;osg图形系统;自动漫游;多视口;立体显示中图分类号:tp391.9 文献标识码:b 文章编号:1009-3044(2013)14-3402-041 概述随着虚拟现实技术的迅速发展和各行业的需求,虚拟漫游技术已被广泛应用于游戏娱乐、建筑设计、制造模拟、旅游体验和航空航天等领域。

虚拟漫游因其沉浸感、交互性和构想性的特点,在建筑场景的设计和体验中已成为必备的工具与技术[1]。

国内一些机构利用先进的建筑建模和显示技术,开发出了基于各类平台的漫游系统,如故宫参观项目、西湖风景游览系统和世博会展馆漫游系统等,逼真性强,用户体验度高。

为了实现建筑和展览的虚拟参观,同时增强参观者的真实感和交互性,该文设计了基于osg的虚拟建筑场景漫游系统,并通过实例介绍系统的设计与开发过程。

该文采用sketchup软件和osg (openscenegraph)综合建模的方式来建立复杂庞大的建筑场景。

在建筑内部还有各类装饰模型,所以根据模型不同的复杂度和作用选择不同的建模方式。

对于场景数据的管理和用户交互的设置则充分利用osg图形引擎提供的接口和本文优化的各类算法,实现高效管理和快速响应。

osg是目前封装较好、性能较高的开源图形开发软件包,它使用可移植的ansi c++编写,并使用工业标准的opengl 底层渲染api。

基于虚拟现实的3D漫游系统设计与实现

基于虚拟现实的3D漫游系统设计与实现一、引言随着科技的不断发展,虚拟现实技术在不同领域得到了广泛应用,其中之一就是基于虚拟现实的3D漫游系统。

这种系统可以模拟出真实世界的环境,并通过虚拟现实设备使用户感受到真实的存在感。

本文将介绍基于虚拟现实的3D漫游系统的设计与实现。

二、系统架构基于虚拟现实的3D漫游系统主要由硬件和软件两部分构成。

硬件方面,需要使用虚拟现实设备,如头戴式显示器、手柄等。

软件方面,需要设计并实现漫游系统的各项功能,包括场景设计、交互设计等。

三、场景设计场景设计是3D漫游系统中至关重要的一环。

在设计场景时,首先需要确定场景的主题和背景,可以参考现实世界的场景,也可根据需求自行设计。

接下来,需要模型化场景中的各个物体,包括建筑、道路、植被等,形成一个真实的环境。

为了增加真实感,可以运用光影效果、纹理贴图等技术来渲染场景。

此外,还可以通过添加特效、音频等元素,提升用户的沉浸感。

四、交互设计在基于虚拟现实的3D漫游系统中,用户可以通过虚拟现实设备进行交互。

交互设计需要考虑用户与系统的互动方式,如通过手柄控制角色移动、通过头部动作控制视角等。

还需要设计用户与场景中物体的交互方式,如点击、拖动等操作。

为了提升用户体验,可以加入触觉反馈技术,使用户更加真实地感知虚拟环境中的物体。

五、系统实现系统实现是基于虚拟现实的3D漫游系统设计的最终目标。

在实现过程中,首先需要选择合适的开发工具和技术,如Unity引擎、Unreal Engine等。

这些工具和技术可以帮助开发者创建、编辑场景,并添加相应的脚本实现交互功能。

其次,需要对虚拟现实设备进行适配和配置,确保系统能够与设备完美配合。

最后,进行系统测试和优化,确保系统的稳定性和性能。

六、应用前景基于虚拟现实的3D漫游系统在各个领域都有广泛的应用前景。

在旅游领域,使用该系统可以让用户远离现实,感受到世界各地的美景;在游戏领域,可以提供更加沉浸式的体验,提升游戏的趣味性;在教育领域,可以模拟实际场景,帮助学生更好地理解知识;在医疗领域,可以提供虚拟手术训练等应用。

基于全景图的虚拟校园漫游系统研究与设计

2 1 图像 采样 .

续 重 叠量检 测操 作 , 以大大减 少运 算量 . 可 ]

柱 面全 景 图像 的生成 必 须 先使 用 数 码相 机 对 模型 实地拍 摄不 同场 景 照 片 , 对其 进 行 图像 采样 . 通常使 用 的图像 大部分 是采 用普 通相机 拍摄 的 , 拍 摄 时要 求尽 量保持 相机 的水平 , 免相机 镜 头在上 避 下 方 向上 偏转 过 大 ; 绕垂 直轴 旋 转 一 周 连续 拍 摄 ,

取 相 交 的特 征线 段 , 然后 对 图像 重叠 部分 的对 应 特

征线段 进 行 拼接 , 而实 现 图像 的拼 接. 进 ቤተ መጻሕፍቲ ባይዱ如 图 4所 示 , 交特 征线 段 匹配 是将 左边 图像 相 中的相 交 特征 线 段作 为模 板 , 右边 图像 中搜 索最 在

2 柱 面 全 景 图 虚 拟 校 园 漫 游 系统 设 计

本 文 采用 柱 面投 影 全 景拼 接 技 术进 行 虚 拟校 园场 景重 建及 漫游 , 实现 了一种 基 于 图像 绘制 的算 法. 作人 员利 用普 通 的相机在 基本 保持水 平 的情 工

用 基于 图像绘 制 的建 模 方 法 中 的柱 面 投 影 全景 图 技术 实现 对某虚 拟校 园漫 游 系统原 型设计 . 1 柱 面全 景 图技术 目前虚 拟场 景建模 方 法主要 有 3类 : 于几何 基

况 拍摄 场景 一 圈的照 片 , 使用该 算法 拼接 这些 照 在 片后 , 以对 虚 拟 场 景 进 行 水 平 3 0 旋 转 无 死 角 可 6。 的全 景 图像 漫游. 系统 设计 模型 如 图 1 本 .

图 像拼接

} —J _ . _ 图像融合 —

图 1 柱 面 全 景 图 设 计 模 型

基于柱状全景图的空间漫游视图拟合算法

(h a ete cdmy eig h n L e c nr &C e iaFb r n i e n C . t, eig10 2 C n) C i T xi A ae B in C og e Mah e n l j i y h m cl i E g er g o LdB in 0 5 h a e n i , j 0 i

s i f ahp r o l p n rma c tdi u etx s T ei g rjcinta somaini ue aiete hpo c at f l a oa s o ae f r r e . h ma ep oe t n fr t sdt r l e a l no v e o r o s oe z h

柱面全景图象的一种实现方式

柱面全景图象的一种实现方式

唐琎;费耀平;杨安平;谷士文

【期刊名称】《小型微型计算机系统》

【年(卷),期】2002(023)011

【摘要】介绍了一种全景图象的建模和实现方式.考虑了图象旋转对拼接过程的影响,这有助于提高拼接质量.在立方体表面拼接成功了柱面全景图象.开发了能够浏览立方体表面的柱面全景图象的浏览器.

【总页数】3页(P1363-1365)

【作者】唐琎;费耀平;杨安平;谷士文

【作者单位】中南大学,铁道校区,湖南,长沙,410075;中南大学,铁道校区,湖南,长沙,410075;长沙电力学院,电力系,湖南,长沙,410077;中南大学,铁道校区,湖南,长沙,410075

【正文语种】中文

【中图分类】TP391

【相关文献】

1.一种多幅单视角图像的双投影柱面全景图生成算法 [J], 吕莉;樊棠怀;王鑫;黄陈蓉;樊飞燕

2.一种基于多边形柱面全景图的虚拟漫游新方法 [J], 王海颍;秦开怀

3.全方位全景图象的一种映射方式 [J], 唐王进;谷士文;费耀平;蔡宣平

4.360度柱面全景图象生成算法及其实现 [J], 钟力;张茂军

5.一种快速的柱面全景图像拼接算法 [J], 安然;张秀林;刘玉

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一种基于多边形柱面全景图的虚拟漫游新方法王海颍;秦开怀【摘要】提出了一种基于图像绘制的多边形柱面全景图的虚拟漫游方法.利用普通的手持相机在一个多边形区域内沿某一路径拍摄并拼接多幅全景图,通过基于SIFT 的特征点检测来计算深度,用狭缝图像插值来实现整个区域内的平滑漫游.该方法具有采样简单、虚拟场景真实感强,支持连续大范围漫游的特点.%A new method of virtual walkthrough using image-based rendering with polygonal panoramic mosaics is presented. First, we take pictures and get multiple panoramas with ordinary handhold camera along a route or in a square region. Second, we use SIFT feather points detection to get slim images with depth which can be used in interpolation for the rendering of new view point. The algorithm proposed in this method is very efficient for virtual walkthrough in the large outdoor scene. The construction and rendering process with multiple panoramas is easy to implement and the data capturing is simple without expensive equipments.【期刊名称】《图学学报》【年(卷),期】2012(033)001【总页数】7页(P56-62)【关键词】虚拟漫游;基于图像的绘制;全景图;狭缝图像【作者】王海颍;秦开怀【作者单位】中国电子信息产业发展研究院,北京100048;清华大学计算机系,北京100084【正文语种】中文【中图分类】TP391.4随着三维图形图像的绘制(Image-Based Rendering, IBR)技术的发展,虚拟现实(Virtual Reality, VR)技术已经被越来越广泛地应用,它可以用于虚拟旅游和娱乐,例如著名旅游景点和博物馆的虚拟游览;也可以用于虚拟训练,例如飞机和车辆驾驶,以及虚拟战场仿真等;另外还可以用于医疗领域和虚拟建筑漫游,等等。

基于图像的绘制是指利用一组预先得到的真实图像进行适当的处理或组合,完成复杂三维场景的真实再现[1]。

由于基于图像的虚拟现实系统具有场景逼真、交互方便、无需特殊硬件等优点,因此具有广阔的应用前景。

目前,随着基于图像的虚拟现实技术研究的不断深入,已经出现了一些相关的软件系统,其中最有代表性的是Apple公司的QuickTime VR系统[2],它采用环幕电影映像和全景图完成摄像机的旋转,并实现了一个全景开发环境,但是漫游显示只限于绕固定位置(视点)的俯、仰和水平旋转。

同心拼图[3]通过以同心圆切线方向的数据组织将无遮挡同心圆区域的光流场简化为3D。

全光拼图[4]可以看做是同心拼图的推广,它在一个没有障碍物的空间用全方位摄像机沿着构成规则网格的路径进行图像捕获,然后通过网络上前、后两个摄像机捕获到的参考图像来生成网格内新视点下的图像,这些方法都需要比较复杂的设备条件并有一定的场景限制。

本文提出一种新的多边形柱面全景图漫游方法,使用普通的手持相机沿着一个路径或区域拍摄并拼接多幅全景图,利用 SIFT特征点计算相对深度并使用一种简单有效的方法渲染出新视点下的视野图,实现在采集路径和区域内的平滑漫游。

本文各节内容组织如下:第1节介绍多边形柱面全景图的采集方法,第 2节介绍利用SIFT算子进行特征点检测从而得到狭缝深度图的方法,第3节介绍多基于多边形柱面全景图的渲染方法,包括视平面上各像素的计算和利用狭缝图像进行的插值处理,最后是实验结果和讨论。

在场景的虚拟漫游过程中,为了让用户能够在水平方向上任意移动,我们在一个多边形区域上的多个视点采集全景图,按照一定的规则排列并储存,我们称之为“多边形柱面全景图”。

对于一条马路,我们可以用图1中(a)的采集方法来获取路两旁的图像数据,图中圆圈中心为采集点,以此中心旋转360º拍摄一定数量的带有重合区域的图像;对一个更大区域(比如大型广场)进行采样,可以沿着如图1(b)所示的一个多边形路径拍摄/采集多个全景图像,实际上,对于这种路径的采集,在每一点上可以只采集区域外侧的180º或者270º全景图,便可满足观察视点在这一方形区域内漫游的要求。

图像采集工作完成以后,我们采用一种基于全局优化调整的方法[5]对每一点采集的图像进行配准和融合,生成在这个视点下的首尾无缝连接的360º柱面全景图,然后对每一个采集点的图像都进行同样的处理并存储,我们就得到了这一区域的多边形柱面全景图。

在漫游时,我们需要找出任一条光线对应于多边形柱面全景图中的哪一个(或哪几个)全景图,以及这条光线在对应全景图上的位置,这也就是下面要讨论的具体渲染算法。

狭缝图像是一种宽度只有一个像素的一列图像。

由于模拟人的运动时,视点主要在一个二维平面上运动,图像在水平方向上的变化速度要快于垂直方向上的变化速度,此外人眼对水平方向的图像变化也远远要比垂直方向变化敏感,所以作为一种简化,把垂直方向的一列像素结合在一起考虑,这就是狭缝图像(slit images)。

狭缝图像在许多IBR系统如同心拼图[3]、多投影中心图像(MCOP)[6]中得到应用。

如果将全景图中的一列或几列像素视为狭缝图像,并加上统一的深度信息,这样的全景图就称为深度狭缝图像全景拼图。

与没有深度概念的传统全景图不同,由于深度狭缝图像本身是对场景的一种近似表示,对深度的精度要求并不太高,因此我们可以将某些特征点的深度扩充为整个狭缝区域的深度,并将相邻区域间的深度进行线性插值,这样就将全景拼图中的每一条狭缝图像都赋予一个整体深度,使整个拼图由一组深度不等的“颜色柱”组成,如图2所示。

由于多边形柱面全景图的引入,使得深度提取成为可能。

对于同一个物体,在不同的两张全景图上,它们的位置应该是不同的。

根据这个位置关系,就能够确定出物体的相对深度。

图3表示了这样的情况,图中点P代表一个物体,它同时位于C1处和C2处所采集的全景图中。

假设我们可以在两张全景图C1和C2上找到该点的对应位置,我们就能够计算出它们对应的角度1θ和2θ。

设P点深度为H,则有其中,是拍摄这两处全景图位置之间的距离。

由上式,根据P点在全景图C1和C2上的对应位置就可以计算出P点的深度H。

计算相应图像位置的深度时,需要先找到两幅图像的对应点,这里我们采用SIFT 算法来提取特征点[7]。

图 4显示了SIFT的特征提取步骤。

由SIFT方法提取的两幅图像中对应的特征点,我们可以通过上节的计算方法算出相应点的相对深度。

为简化起见,我们再按照特征点的分布,将全景图分割成相应宽度的狭缝图像,各条狭缝图像的整体深度就是所含特征点的深度,并把这个深度信息存储下来以供今后的计算使用。

至此,图像预处理工作就结束了,我们得到了带有场景深度的多边形柱面全景图数据。

图5给出了两个不同视点图像下SIFT特征提取和对应点匹配的例子。

在传统基于图像的漫游中,为了克服只能在固定视点观察的缺陷,常使用多个柱面全景图进行场景浏览[8]。

但是这种情况下全景图之间没有过渡关系,观察者只能从一个视点“跳”到另一个视点进行浏览。

因此,我们基于在固定视点采集拼接的全景图像,通过深度计算和狭缝图像插值的方法来合成漫游区域内任意视点的视野图像,从而支持一定范围内的场景平滑漫游。

当漫游视点在如图6(a)所示的位置时,可以由相邻的两幅全景图上相应的点得到视平面上每一像素的颜色值。

通过上一节介绍的多边形柱面全景图深度狭缝图像的计算,已经得到了全景图上任意一点的深度值Z,因此我们可以通过如图6(b)所示的几何关系求出新视点下视平面上每一点的像素颜色值,具体的计算步骤如下:1)把视平面坐标转换成世界坐标系(XYZ)下的坐标值:假设最终生成的视平面图像(图6中蓝色直线是该平面在 xy平面上的投影)大小为W×H,对于视平面上的任意一点,设其坐标为(w, h)。

注意,这个坐标是相对于视平面的,我们需要把它转化为图中的XYZ坐标系下的坐标。

我们首先求出视平面在XY平面上的投影中点的坐标(Xf, Yf, Zf)其中, f为焦距,即视点到视平面的距离,θ为视线与水平方向的夹角。

则视平面上坐标为(w, h)的点(如图6中粉红色点)在XYZ坐标系下的坐标为2)找出视平面上该点在物体平面的对应位置:由上节深度狭缝图像的获取原理可知,各个物体的深度可以看作一个分段函数(如图6(b)中蓝灰色分段平面)。

因此,我们从视点向视平面上的这个点发出一条射线,可以计算出这个射线与分段平面的交点。

3)找出对应的全景图:多边形柱面全景图的视点全部位于y轴上,因此要找出对应的全景图,首先需要计算第2步提到的射线与y轴的交点。

设交点的纵坐标值为 Y c,可求出因此,只需要在所有全景图中查找离 Yc最近的一个(需要插值的情况,则查找最近的两个)即可。

4)根据在Xh平面上的一点计算对应全景图上的位置:我们再次转化一个坐标系,那么对于一个点 ),,( pppZYX ,其角度那么,对应全景图的狭缝图位置即可以表示为:中, PW 表示全景图的宽度。

而该点对应此列的像素可以由比例关系确定。

至此,我们就从视平面上的一点,找到了全景图上对应的一个像素。

对视平面上的每一个点重复这个过程,就完成了一个视平面图像的绘制。

上面的算法对于视野图的每一个像素进行计算,因此最终结果应是精确的,但由于处理的像素点会很多,而对每一个像素点都要涉及到求交运算,导致最终渲染速度不能达到实时漫游的要求。

我们在前面第1节已经介绍过柱面全景图在垂直方向是没有形变的,因此我们采用下面的狭缝图像方法,避免垂直方向的计算从而提高计算速度,具体方法如下:1)按照上节介绍的方法计算视线与平面Xh的交点(Xh, Yh),设为点P。

注意,这里没有计算Zh的值。

2)按照上面介绍的方法找出对应的全景图编号,设该全景图坐标为(Xi, Yi)。

3)根据Xh和Yh的值可以得到对应全景图上的狭缝位置。

4)将该狭缝图像按照一定比例进行缩放,该比例值为缩放以后即可作为当前视野图的一个狭缝图像。