样本均值算法

大数据常用的算法

大数据常用的算法一、引言随着大数据时代的到来,大数据分析已经成为各个行业的重要组成部份。

而在大数据分析过程中,算法的选择和应用起着至关重要的作用。

本文将介绍大数据常用的算法,包括聚类算法、分类算法、关联规则挖掘算法和推荐算法。

二、聚类算法1. K均值算法K均值算法是一种常用的聚类算法,它将数据集划分为K个簇,每一个簇都具有相似的特征。

算法的步骤如下:a. 随机选择K个初始聚类中心;b. 根据欧氏距离计算每一个样本与聚类中心的距离,并将样本分配到距离最近的簇;c. 更新聚类中心,将每一个簇的中心点更新为该簇内所有样本的均值;d. 重复步骤b和c,直到聚类中心再也不改变或者达到最大迭代次数。

2. DBSCAN算法DBSCAN算法是一种基于密度的聚类算法,它将数据集划分为若干个密度相连的簇。

算法的步骤如下:a. 随机选择一个未被访问的样本点;b. 以该样本点为中心,找出其邻域内的所有样本点;c. 如果该样本点的邻域内包含至少MinPts个样本点,则将其作为核心对象,并创建一个新的簇;d. 以核心对象的邻域内的样本点为中心,继续寻觅新的样本点,并将其加入到簇中;e. 重复步骤c和d,直到所有的样本点都被访问。

三、分类算法1. 决策树算法决策树算法是一种常用的分类算法,它通过构建树形结构来对数据进行分类。

算法的步骤如下:a. 选择一个最佳的属性作为根节点;b. 根据该属性的取值将数据集划分为若干个子集;c. 对每一个子集递归地重复步骤a和b,直到子集中的样本属于同一类别或者达到住手条件;d. 构建决策树。

2. 支持向量机算法支持向量机算法是一种常用的二分类算法,它通过在高维空间中找到一个最优超平面来进行分类。

算法的步骤如下:a. 将样本点映射到高维空间;b. 在高维空间中找到一个最优超平面,使得正负样本点之间的间隔最大化;c. 根据超平面将样本进行分类。

四、关联规则挖掘算法1. Apriori算法Apriori算法是一种常用的关联规则挖掘算法,它通过挖掘频繁项集来发现数据集中的关联规则。

k均值算法的基本流程

k均值算法的基本流程

K均值( K-means)是一种常见的聚类算法,用于将数据集中的样本分成K个类别。

其基本流程如下:

1.选择K个初始聚类中心:(首先需要选择K个初始的聚类中心,这些中心可以是随机选择的数据点或者是手动指定的。

2.分配样本到最近的聚类中心:(对于每一个样本,计算其与K个聚类中心的距离,并将其分配到距离最近的聚类中心所代表的类别中。

3.更新聚类中心:(对于每一个类别,重新计算其所有样本的平均值 即新的聚类中心)。

4.重复步骤2和步骤3:(重复执行将样本分配到最近的聚类中心和更新聚类中心的步骤,直到满足停止条件( 例如,聚类中心不再发生变化,或达到预定的迭代次数)。

5.输出结果:(最终得到K个聚类中心和相应的类别,可以根据这些聚类中心将新的样本进行分类。

K均值算法主要的优点在于简单易懂、计算效率高,适用于大型数据集。

然而,K均值算法对初始聚类中心的选择敏感,可能会受到初始聚类中心的影响而陷入局部最优解。

因此,有时需要多次运行算法并比较结果来提高其准确性。

1/ 1。

k均值聚类算法的基本原理

k均值聚类算法的基本原理k均值聚类算法是一种常用的无监督学习算法,它可以将样本数据划分为多个簇,并且每个簇内的样本具有相似的特征。

该算法的基本原理是通过迭代计算来不断优化簇的中心点,使得每个样本点到所属簇的中心点的距离最小化。

我们需要确定要将样本数据划分成多少个簇,这个值记为k。

然后,从样本数据中随机选择k个样本作为初始的簇中心点。

接下来,对于每个样本点,计算其与各个簇中心点的距离,并将其归类到距离最近的簇中。

在归类完所有样本点之后,我们需要重新计算每个簇的中心点。

具体地,对于每个簇,我们计算该簇内所有样本点的均值,将其作为新的中心点。

然后,重复上述的步骤,直到簇的中心点不再改变或者达到了预定的迭代次数。

k均值聚类算法的优化目标是最小化样本点到所属簇的中心点的距离之和,也就是最小化簇内样本点的离散程度。

通过迭代计算,我们不断优化簇的中心点,使得簇内样本点的距离最小化。

然而,k均值聚类算法也存在一些局限性。

首先,我们需要事先确定簇的个数k,这对于实际问题可能不太容易得知。

其次,算法对于初始簇中心点的选择比较敏感,不同的初始选择可能导致不同的结果。

此外,k均值算法对于异常值比较敏感,可能会导致簇的中心点偏离实际情况。

为了克服这些局限性,研究者们提出了一些改进的方法。

例如,可以使用层次聚类算法来确定簇的个数k,从而避免了事先确定k的困扰。

此外,还可以使用其他的聚类算法来初始化簇中心点,例如DBSCAN算法。

另外,可以使用加权k均值聚类算法来减少异常值的影响。

k均值聚类算法是一种常用的无监督学习算法,通过迭代计算优化簇的中心点,将样本数据划分成多个簇。

虽然算法存在一些局限性,但通过改进方法可以克服这些问题,使得聚类结果更加准确。

在实际应用中,k均值聚类算法被广泛应用于数据挖掘、模式识别等领域,为我们提供了有效的数据分析工具。

Allan方差的算法

1.阿伦方差的定义,计算方法以及物理意义。

David AIlan于1966年提出了Allan方差,最初该方法是用于分析振荡器的相位和频率不稳定性,高稳定度振荡器的频率稳定度的时域表征目前均采用Allan方差。

由于陀螺等惯性传感器本身也具有振荡器的特征,因此该方法随后被广泛应用于各种惯性传感器的随机误差辨识中。

Allan方差的基本原理如下:设系统采样周期为τ,连续采样N 个数据点.Y(i),i=1,2,3…N。

对任意的时间r=mτ,m=1,2…N/2,由式(1)求该组时间内各点的均值序列Y(K),由式(2)求取差值序列D(K).Y(K)=1/M1()K MJ KY i+-=∑K=1,2…N-M+1 (1)D(K)=Y(K+M)-Y(K) K=1,2…N-2M+1 (2)普通AlIan方差的定义如式(3)。

其中<>表示取均值,σ=1,2,⋯,Round((N/m)-1)。

2ynσ(τ)=1/2<D((P-1)M+1)2 >(3)Allan方差反映了相邻两个采样段内平均频率差的起伏。

它的最大优点在于对各类噪声的幂律谱项都是收敛的;此外每组测量N一2,大大缩短了测量的时间。

交叠式Allan方差由式(4)计算:2ynσ(τ)=1/2<D(P)2> P=1,2…N-2M+1 (4)衡量陀螺精度的一个非常重要的指标是陀螺随机漂移(drift),又指偏置稳定性(bias stabil—ity)以及零偏稳定性,不同应用场合对陀螺的漂移精度提出不同的要求。

MEMS的随机误差具有慢时变、非平稳的特点,因而对其的辨识更适合采用Allan方差分析法。

然而由于在相同的置信水平之下,交叠式Allan方差分析方法比普通的Allan 方差具有更大的置信区间.所谓频率稳定度是指任何一台频率源在连续运行之后,在一段时期中能产生同一频率的程度,即频率随机起伏的程度。

造成频率起伏的根本原因是噪声对信号相位或频率调制的结果。

统计分析方法论:K-Means算法

K-Means课前准备下载Anaconda软件。

课堂主题本次课讲解K-Means聚类算法与算法的改进与优化。

课堂目标学习本次课,我们能够达到如下目标:熟知K-Means算法的原理与步骤。

熟知K-Means++算法的原理与初始化方式。

熟知Mini Batch K-Means算法的原理与步骤。

能够选择最佳的值。

知识要点聚类之前我们接触的算法,都是监督学习,即训练数据是包含我们要预测的结果(训练数据中是含有样本的标签)。

我们对含有标签的训练集建立模型,从而能够对未知标签的样本进行预测。

与监督学习对应的,聚类属于无监督学习,即训练数据中是不含有标签的。

聚类的目的是根据样本数据内部的特征,将数据划分为若干个类别,每个类别就是一个簇。

结果为,使得同一个簇内的数据,相似度较大,而不同簇内的数据,相似度较小。

聚类也称为“无监督的分类”。

其样本的相似性是根据距离来度量的。

K-Means算法算法步骤K-Mean算法,即均值算法,是最常见的一种聚类算法。

顾名思义,该算法会将数据集分为个簇,每个簇使用簇内所有样本的均值来表示,我们将该均值称为“质心”。

具体步骤如下:1. 从样本中选择个点作为初始质心。

2. 计算每个样本到各个质心的距离,将样本划分到距离最近的质心所对应的簇中。

3. 计算每个簇内所有样本的均值,并使用该均值更新簇的质心。

4. 重复步骤2与3,直到达到以下条件之一结束:质心的位置变化小于指定的阈值。

达到最大迭代次数。

过程演示下图给出了使用K-Means算法聚类的过程。

优化目标KMeans算法的目标就是选择合适的质心,使得在每个簇内,样本距离质心的距离尽可能的小。

这样就可以保证簇内样本具有较高的相似性。

我们可以使用最小化簇内误差平方和(within-cluster sum-of-squares )来作为优化算法的量化目标(目标函数),簇内误差平方和也称为簇惯性(inertia)。

:簇的数量。

:第个簇含有的样本数量。

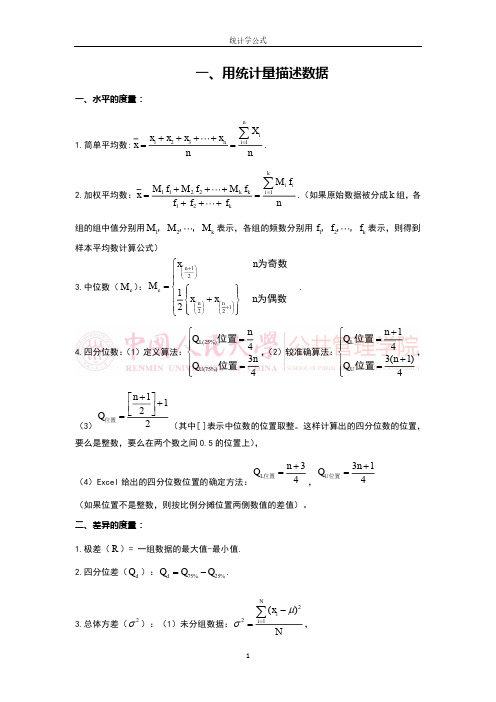

统计学公式

3

xi x 4 n(n 1) 3(n 1) 2 ( ) . s (n 1)(n 2)(n 3) (n 2)(n 3)

2

统计学公式

二、概率分布

一、度量事件发生的可能性:

1.事件 A 发生的概率: P ( A) 二、随机变量的概率分布:

统计学公式

一、用统计量描述数据

一、水平的度量:

x x2 x3 1.简单平均数: x 1 n

xn

X

i 1

n

i

n

.

k

M f M 2 f2 M k fk 2.加权平均数: x 1 1 f1 f 2 f k

M

i 1

i i

f

n

.(如果原始数据被分成 k 组,各

2

E2

.

四、假设检验

一、一个总体参数的检验

1.大样本的检验

(1)在大样本的情况下,样本均值的抽样分布近似服从正态分布,其抽样标准差为 /

2

n.

采用正态分布的检验统计量.设假设的总体均值为 0 ,当总体方差 已知时,总体均值检验 的统计量为: z

x 0

/ n

.

(2)当总体方差 未知时,可以采用样本方差 s 来代替,此时总体均值检验的统计量为:

组的组中值分别用 M1,M 2, ,M k 表示,各组的频数分别用 f1,f 2, ,f k 表示,则得到 样本平均数计算公式)

x n 1 2 3.中位数( M e ) : Me 1 x n x n 1 2 2 2

n

p ;

(1 )

K均值算法在医疗影像分析中的使用教程(七)

K均值算法在医疗影像分析中的使用教程医疗影像分析是医学影像学的一个重要领域,通过对医学影像进行分析和处理,可以帮助医生更好地诊断疾病、制定治疗方案。

K均值算法是一种常用的聚类算法,可以用于医疗影像分析中的图像分割和特征提取。

本文将介绍K均值算法在医疗影像分析中的使用方法和注意事项。

一、K均值算法简介K均值算法是一种基于距离的聚类算法,它将n个样本划分为k个不同的簇,使得簇内的样本之间的距离尽可能小,而簇间的距离尽可能大。

算法的基本思想是随机选择k个样本作为初始的聚类中心,然后将其他样本分配到最近的聚类中心,再根据分配的样本重新计算聚类中心,不断迭代直到收敛。

K均值算法的优点是简单易实现,计算复杂度低,适用于大规模数据集。

二、K均值算法在医疗影像分析中的应用在医疗影像分析中,K均值算法主要应用在图像分割和特征提取两个方面。

1. 图像分割医学影像通常包括X光片、CT扫描、MRI等多种类型,图像中包含的信息复杂多样,因此需要对图像进行分割,将感兴趣的目标从背景中分离出来。

K均值算法可以根据像素之间的相似性将图像分成若干个簇,从而实现图像的分割。

在图像分割的过程中,选择合适的距离度量方法和聚类个数是至关重要的,这需要根据具体的医学影像和分析目的来确定。

2. 特征提取医学影像中蕴含着丰富的信息,如肿瘤的形状、纹理、密度等特征,这些特征对于疾病的诊断和治疗具有重要意义。

K均值算法可以帮助提取这些特征,将影像中的像素点聚类成若干个簇,然后计算每个簇的中心点作为该簇的特征表示。

通过特征提取,医生可以更好地理解影像中包含的信息,从而更准确地做出诊断和治疗方案。

三、K均值算法在医疗影像分析中的使用教程1. 数据准备在使用K均值算法进行医疗影像分析之前,首先需要准备好医学影像数据。

这些数据可能包括X光片、CT扫描、MRI等各种类型的影像,需要确保数据的质量和完整性。

此外,还需要对影像数据进行预处理,如去噪、增强等操作,以便更好地适应K均值算法的需求。

噪声估计算法范文

噪声估计算法范文噪声估计是指对信号的噪声进行估计和分析的过程。

在信号处理和通信系统中,噪声是不可避免的,能够准确估计噪声的能力对于系统的性能有重要影响。

噪声估计算法是一种用于从观测信号中估计出噪声特性的数学方法。

下面将介绍几种常用的噪声估计算法。

1.均值法均值法是一种简单常用的噪声估计算法。

该方法假设观测信号的样本均值等于信号加噪声的均值,通过计算观测信号的样本均值来估计噪声均值。

然而,均值法需要样本数较多且信号和噪声具有相同的均值分布才能获得较准确的噪声估计结果。

2.自相关法自相关法是一种基于信号的自相关函数进行噪声估计的方法。

该方法假设信号的自相关函数是原始信号自相关函数与噪声自相关函数的叠加。

通过计算观测信号的自相关函数并提取出噪声自相关函数的部分,可以估计噪声的统计特性。

自相关法不需要对信号和噪声的统计特性进行假设,因此适用范围更广。

3.计算机模拟法计算机模拟法是一种通过计算机模拟信号和噪声的统计特性来得到噪声估计的方法。

该方法通常需要知道信号和噪声的概率密度函数和相关系数,通过生成符合统计特性的信号和噪声样本,并对它们进行相关性分析来估计噪声。

计算机模拟法的优势在于可以适用于各种类型的信号和噪声,但需要事先了解信号和噪声的统计特性。

4.周期图法周期图法是一种基于频谱分析的噪声估计方法。

该方法通过将观测信号变换到频域,并利用信号的频谱特性估计出噪声的统计特性。

周期图法通过计算频谱密度估计或者谐波分析来提取出噪声的频谱特性,从而得到噪声估计结果。

该方法对信号和噪声的频域特性要求较高,适用于对宽带信号进行噪声估计。

5.最小二乘法最小二乘法是一种通过最小化观测信号和估计信号之间的误差平方和来估计噪声的方法。

该方法假设观测信号是由信号和噪声叠加而成,通过选择合适的权重来减小估计误差,进而得到噪声估计结果。

最小二乘法在估计精度和计算复杂度之间达到了较好的平衡,适用于不同类型的噪声估计问题。

综上所述,噪声估计是一项重要的信号处理和通信系统中的任务。

t检验的工作原理和在Python中的实现

t检验的工作原理和在Python中的实现t检验(t-test)是一种常用的统计方法,用于比较两个独立样本或相关样本的均值是否存在显著差异。

它的工作原理基于样本均值的差异和样本方差的比较。

在t-test中,我们假设两组样本的总体方差未知但相等。

然后,我们计算两组样本的均值差异,并对比差异与误差范围的相对大小。

算法如下:1.零假设(H0):两个样本的均值相等,即差异为零。

2. 计算两组样本的平均值(mean1和mean2),以及样本方差(var1和var2)。

3. 计算合并标准误差(standard error):SE = sqrt(var1/n1 + var2/n2),其中,n1和n2分别是两组样本的大小。

4. 计算t值:t = (mean1 - mean2) / SE。

5. 根据自由度(df = n1 + n2 - 2)和所选择的显著性水平(通常为0.05),查找t分布的临界值(t_critical)。

6. 判断t值是否大于t_critical,如果是,则拒绝零假设,接受备择假设(H1);否则,接受零假设。

在Python中,我们可以使用统计库statsmodels或者SciPy来实现t-test。

以下是使用statsmodels库的示例代码:```pythonimport statsmodels.api as smimport pandas as pd#创建两组样本数据group1 = [1, 2, 3, 4, 5]group2 = [6, 7, 8, 9, 10]# 将数据转换为DataFrame格式data = pd.DataFrame({"group1": group1, "group2": group2})# 执行t-testresult = sm.stats.ttest_ind(data["group1"], data["group2"]) #输出t值和p值print("t值:", result[0])print("p值:", result[1])```在上述代码中,我们首先创建了两组样本数据,并将它们转换为DataFrame格式。

K-MEANS算法(K均值算法)

k-means 算法一.算法简介k -means 算法,也被称为k -平均或k -均值,是一种得到最广泛使用的聚类算法. 它是将各个聚类子集内的所有数据样本的均值作为该聚类的代表点,算法的主要思想是通过迭代过程把数据集划分为不同的类别,使得评价聚类性能的准如此函数达到最优,从而使生成的每个聚类内紧凑,类间独立.这一算法不适合处理离散型属性,但是对于连续型具有较好的聚类效果.二.划分聚类方法对数据集进展聚类时包括如下三个要点:〔1〕选定某种距离作为数据样本间的相似性度量k-means 聚类算法不适合处理离散型属性,对连续型属性比拟适合.因此在计算数据样本之间的距离时,可以根据实际需要选择欧式距离、曼哈顿距离或者明考斯距离中的一种来作为算法的相似性度量,其中最常用的是欧式距离.下面我给大家具体介绍一下欧式距离.假设给定的数据集 ,X 中的样本用d 个描述属性A 1,A 2…A d 来表示,并且d 个描述属性都是连续型属性.数据样本x i =<x i1,x i2,…x id >, x j =<x j1,x j2,…x jd >其中,x i1,x i2,…x id 和x j1,x j2,…x jd 分别是样本x i 和x j 对应d 个描述属性A 1,A 2,…A d 的具体取值.样本xi 和xj 之间的相似度通常用它们之间的距离d<x i ,x j >来表示,距离越小,样本x i 和x j 越相似,差异度越小;距离越大,样本x i 和x j 越不相似,差异度越大.欧式距离公式如下: 〔2k-means 聚类算法使用误差平方和准如此函数来评价聚类性能.给定数据集X,其中只包含描述属性,不包含类别属性.假设X 包含k 个聚类子集X 1,X 2,…X K ;{}|1,2,...,m X x m total ==(),i j d x x =各个聚类子集中的样本数量分别为n 1,n 2,…,n k ;各个聚类子集的均值代表点〔也称聚类中心〕分别为m 1,m 2,…,m k .如此误差平方和准如此函数公式为:〔3〕相似度的计算根据一个簇中对象的平均值来进展. 1) 将所有对象随机分配到k 个非空的簇中.2) 计算每个簇的平均值,并用该平均值代表相应的簇. 3) 根据每个对象与各个簇中心的距离,分配给最近的簇.4) 然后转2〕,重新计算每个簇的平均值.这个过程不断重复直到满足某个准如此函数才停止.三.算法描述1. 为中心向量c 1, c 2, …, c k 初始化k 个种子2. 分组:a) 将样本分配给距离其最近的中心向量b) 由样本构造不相交〔 non-overlapping 〕的聚类 3. 确定中心:a) 用各个聚类的中心向量作为新的中心 4. 重复分组和确定中心的步骤,直至算法收敛四.算法流程输入:簇的数目k 和包含n 个对象的数据库. 输出:k 个簇,使平方误差准如此最小. 算法步骤:1.为每个聚类确定一个初始聚类中心,这样就有K 个初始聚类中心.2.将样本集中的样本按照最小距离原如此分配到最邻近聚类3.使用每个聚类中的样本均值作为新的聚类中心. 5.完毕,得到K 个聚类21ikii p X E p m =∈=-∑∑五.算法举例数据对象集合S 见表1,作为一个聚类分析的二维样本,要求的簇的数量k=2.<1>选择 , 为初始的簇中心,即 , <2>对剩余的每个对象,根据其与各个簇中心的距离,将它赋给最近的簇.对 : 显然 ,故将 分配给 对于 : 因为 ,所以将 分配给 对于 : 因为 ,所以将 分配给 更新,得到新簇 和 计算平方误差准如此,单个方差为总体平均方差是:〔3〕计算新的簇的中心.重复〔2〕和〔3〕,得到O 1分配给C 1;O 2分配给C 2,O 3分配给C 2,O 4分配给C 2,O 5分配给C 1.更新,得到新簇 和 . 中心为 , . 单个方差分别为总体平均误差是: 由上可以看出,第一次迭代后,总体平均误差值52.25~25.65,显著减小.由于在两次迭代中,簇中心不变,所以停止迭代过程,算法停止.六.k -means 算法的性能分析6.1 k -means 算法的优缺点 主要优点:()10,2O ()20,0O ()110,2M O ==()220,0M O ==3O ()13,2.5d M O ==()23, 1.5d M O ==()()2313,,d M O d M O ≤3O 2C 4O ()14,d M O ==()24,5d M O ==()()2414,,d M O d M O ≤4O 2c 5O ()15,5d M O ==()25,d M O ==()()1525,,d M O d M O ≤5O 1C {}115,C O O ={}2234,,C O O O =122527.2552.25E E E =+=+=()()()()2,5.2222,2501=++=M {}115,C O O ={}2234,,C O O O =()2,5.21=M ()2 2.17,0M =()())(()222210 2.522 2.552212.5E ⎡⎤⎤⎡=-+-+-+-=⎣⎣⎦⎦1212.513.1525.65E E E =+=+=1.是解决聚类问题的一种经典算法,简单、快速.2.对处理大数据集,该算法是相对可伸缩和高效率的.因为它的复杂度是0 <n kt > , 其中, n 是所有对象的数目, k 是簇的数目, t 是迭代的次数.通常k < <n 且t < <n .3.当结果簇是密集的,而簇与簇之间区别明显时, 它的效果较好.主要缺点1.在簇的平均值被定义的情况下才能使用,这对于处理符号属性的数据不适用.2.必须事先给出k〔要生成的簇的数目〕,而且对初值敏感,对于不同的初始值,可能会导致不同结果.3.它对于"躁声〞和孤立点数据是敏感的,少量的该类数据能够对平均值产生极大的影响.针对K-Means算法对于不同的初始值,可能会导致不同结果.解决方法:1.多设置一些不同的初值,比照最后的运算结果〕一直到结果趋于稳定完毕,比拟耗时和浪费资源2.很多时候,事先并不知道给定的数据集应该分成多少个类别才最适宜.这也是 K-means 算法的一个不足.有的算法是通过类的自动合并和分裂,得到较为合理的类型数目 K,例如 ISODATA 算法.3. 所谓的gapstatistics〔 Gap统计模型〕6.2 ISODATA算法1.K-均值算法通常适合于分类数目的聚类,而ISODATA算法如此更加灵活;2.从算法角度看, ISODATA算法与K-均值算法相似,聚类中心都是通过样本均值的迭代运算来决定的;3.ISODATA算法参加了一些试探步骤,并且可以结合成人机交互的结构,使其能利用中间结果所取得的经验更好地进展分类.主要是在选代过程中可将一类一分为二,亦可能二类合二为一,即"自组织〞,这种算法具有启发式的特点. :1.考虑了类别的合并与分裂,因而有了自我调整类别数的能力.合并主要发生在某一类内样本个数太少的情况,或两类聚类中心之间距离太小的情况.为此设有最小类内样本数限制,以与类间中心距离参数 .假如出现两类聚类中心距离小于的情况,可考虑将此两类合并.分裂如此主要发生在某一类别的某分量出现类内方差过大的现象,因而宜分裂成两个类别,以维持合理的类内方差.给出一个对类内分量方差的限制参数 ,用以决定是否需要将某一类分裂成两类.2.由于算法有自我调整的能力,因而需要设置假如干个控制用参数,如聚类数期望值K、每次迭代允许合并的最大聚类对数L、与允许迭代次数I等.✓选择某些初始值.可选不同的参数指标,也可在迭代过程中人为修改,以将N 个模式样本按指标分配到各个聚类中心中去.✓计算各类中诸样本的距离指标函数.✓〔3〕~〔5〕按给定的要求,将前一次获得的聚类集进展分裂和合并处理〔〔4〕为分裂处理,〔5〕为合并处理〕,从而获得新的聚类中心.✓重新进展迭代运算,计算各项指标,判断聚类结果是否符合要求.经过屡次迭代后,假如结果收敛,如此运算完毕.6.3 k-means算法初始中心的选取对算法的影响棋盘格数据集<Checkerboard data set>仅使用其中486个正类数据,并将数据变换到[-1,1]之间,分布情况如如下图所示:原始数据初始聚类中心均在中心附近初始聚类中心在平面内随机选取七.k-means算法的改良方法7.1 k-means算法的改良方法——k-mode 算法◆k-modes 算法:实现对离散数据的快速聚类,保存了k-means算法的效率同时将k-means的应用X围扩大到离散数据.◆K-modes算法是按照k-means算法的核心内容进展修改,针对分类属性的度量和更新质心的问题而改良.具体如下:1.度量记录之间的相关性D的计算公式是比拟两记录之间,属性一样为0,不同为1.并所有相加.因此D越大,即他的不相关程度越强〔与欧式距离代表的意义是一样的〕;2.更新modes,使用一个簇的每个属性出现频率最大的那个属性值作为代表簇的属性值.7.2 k-means算法的改良方法——k-prototype算法◆k-Prototype算法:可以对离散与数值属性两种混合的数据进展聚类,在k-prototype中定义了一个对数值与离散属性都计算的相异性度量标准.◆K-Prototype算法是结合K-Means与K-modes算法,针对混合属性的,解决2个核心问题如下:1.度量具有混合属性的方法是,数值属性采用K-means方法得到P1,分类属性采用K-modes方法P2,那么D=P1+a*P2,a是权重,如果觉得分类属性重要,如此增加a,否如此减少a,a=0时即只有数值属性2.更新一个簇的中心的方法,方法是结合K-Means与K-modes的更新方法.7.3 k-means算法的改良方法——k-中心点算法k-中心点算法:k -means算法对于孤立点是敏感的.为了解决这个问题,不采用簇中的平均值作为参照点,可以选用簇中位置最中心的对象,即中心点作为参照点.这样划分方法仍然是基于最小化所有对象与其参照点之间的相异度之和的原如此来执行的.八.K-means算法在图像分割上的简单应用例1:图片:一只遥望大海的小狗;此图为100 x 100像素的JPG图片,每个像素可以表示为三维向量〔分别对应JPEG图像中的红色、绿色和蓝色通道〕;将图片分割为适宜的背景区域〔三个〕和前景区域〔小狗〕;1.使用K-means算法对图像进展分割.分割后的效果〔注:最大迭代次数为20次,需运行屡次才有可能得到较好的效果.〕例2:注:聚类中心个数为5,最大迭代次数为10.聚类中心个数为3〔程序如下〕clcclearticRGB= imread <'test5.jpg'>; %读入像img=rgb2gray<RGB>;[m,n]=size<img>;subplot<2,2,1>,imshow<img>;title<' 图一原图像'>subplot<2,2,2>,imhist<img>;title<' 图二原图像的灰度直方图'>hold off;img=double<img>;for i=1:200c1<1>=25;c2<1>=125;c3<1>=200;%选择三个初始聚类中心r=abs<img-c1<i>>;g=abs<img-c2<i>>;b=abs<img-c3<i>>;%计算各像素灰度与聚类中心的距离r_g=r-g;g_b=g-b;r_b=r-b;n_r=find<r_g<=0&r_b<=0>;%寻找最小的聚类中心n_g=find<r_g>0&g_b<=0>;%寻找中间的一个聚类中心n_b=find<g_b>0&r_b>0>;%寻找最大的聚类中心i=i+1;c1<i>=sum<img<n_r>>/length<n_r>;%将所有低灰度求和取平均,作为下一个低灰度中心c2<i>=sum<img<n_g>>/length<n_g>;%将所有低灰度求和取平均,作为下一个中间灰度中心c3<i>=sum<img<n_b>>/length<n_b>;%将所有低灰度求和取平均,作为下一个高灰度中心d1<i>=abs<c1<i>-c1<i-1>>;d2<i>=abs<c2<i>-c2<i-1>>;d3<i>=abs<c3<i>-c3<i-1>>;if d1<i><=0.001&&d2<i><=0.001&&d3<i><=0.001R=c1<i>;G=c2<i>;B=c3<i>;k=i;break;endendRGBimg=uint8<img>;img<find<img<R>>=0;img<find<img>R&img<G>>=128;img<find<img>G>>=255;tocsubplot<2,2,3>,imshow<img>;title<' 图三聚类后的图像'>subplot<2,2,4>,imhist<img>;title<' 图四聚类后的图像直方图'>。

K均值算法

K均值算法

K均值算法

K均值算法是一种聚类算法,把样本分配到离它最近的类中心所属的类,类中心由属于这个类的所有样本确定。

k均值算法是一种无监督的聚类算法。

算法将每个样本分配到离它最近的那个类中心所代表的类,而类中心的确定又依赖于样本的分配方案。

在实现时,先随机初始化每个类的类中心,然后计算样本与每个类的中心的距离,将其分配到最近的那个类,然后根据这种分配方案重新计算每个类的中心。

这也是一种分阶段优化的策略。

与k近邻算法一样,这里也依赖于样本之间的距离,因此需要定义距离的计算方式,最常用的是欧氏距离,也可以采用其他距离定义。

算法在实现时要考虑下面几个问题:

1.类中心向量的初始化。

一般采用随机初始化。

最简单的是Forgy 算法,它从样本集中随机选择k个样本作为初始类中心。

第二种方案是随机划分,它将所有样本随机的分配给k个类中的一个,然后按照这种分配方案计算各个类的类中心向量。

2.参数k的设定。

可以根据先验知识人工指定一个值,或者由算法自己确定。

3.迭代终止的判定规则。

一般做法是计算本次迭代后的类中心和上一次迭代时的类中心之间的距离,如果小于指定阈值,则算法终止。

K-means算法详解

算法实例

O x y

1

2 3 4 5Βιβλιοθήκη 00 1.5 5 5

2

0 0 0 2

数据对象集合S见表1,作为一个聚类分析的二 维样本,要求的簇的数量k=2。 O (1)选择 O1 0,2 , 2 0,0 为初始的簇中心, 即 M 1 O1 0,2 , M 2 O2 0,0 。 (2)对剩余的每个对象,根据其与各个簇中心的 距离,将它赋给最近的簇。 对 O3 : 2 2

0 5

0 5

2

2 2

2

2

5

29

1

5

5

2

0 2

• 因为 d M 1 , O 5 d M 2 , O 5 所以将 O 5分配给 C

• 更新,得到新簇

E1 0 0

2 2

C1 O1 ,O5

和

2

C 2 O 2 , O 3 , O 4

xi1,xi2,„xid和xj1,xj2,„xjd分别是样本xi和xj对应d个描 述属性A1,A2,„Ad的具体取值。 • 样本xi和xj之间的相似度通常用它们之间的距离d(xi,xj) 来表示,距离越小,样本xi和xj越相似,差异度越小;距

离越大,样本xi和xj越不相似,差异度越大。

欧式距离公式如下:

d xi , x j

x

d k 1

ik

x jk

2

平均误差准则函数

• K-means聚类算法使用误差平方和准则函数来评价聚类 性能。给定数据集X,其中只包含描述属性,不包含类别

属性。假设X包含k个聚类子集X1,X2,„XK;各个聚类子集

中的样本数量分别为n1,n2,„,nk;各个聚类子集的均值代 表点(也称聚类中心)分别为m1,m2,„,mk。 • 误差平方和准则函数公式为:

均值偏移聚类算法原理

均值偏移聚类算法原理

1.随机选择一个样本点作为初始中心点。

2.根据指定的邻域半径,找出距离中心点在该半径范围内的所有样本点。

3.计算这些样本点的质心,作为新的中心点。

4.重复步骤2和3,直到中心点不再移动为止。

在均值偏移聚类算法中,核心是计算样本点的质心,即通过对每个样本点在邻域半径内进行加权平均,得到新的中心点。

样本点的权重是根据其与中心点的距离进行分配的,距离越近的样本点权重越大。

整个算法的流程如下:

1.初始化半径参数和阈值参数。

2.选择一个样本点作为初始中心点。

3.根据邻域半径找出距离中心点在该半径范围内的所有样本点。

4.计算这些样本点的质心。

5.计算新的中心点与原中心点的距离,如果距离小于阈值,则停止迭代,否则将新的中心点作为当前中心点,返回步骤3

6.将那些距离小于邻域半径的样本点归为同一个簇。

7.选择一个未归类的样本点作为新的中心点,重复步骤3到步骤6,直到所有样本点都被归类。

总体来说,均值偏移聚类算法是一种简单有效的密度聚类算法,通过

寻找样本点密度最大的区域来确定簇的中心点和边界。

它的原理相对简单,但需要调节一些参数,例如邻域半径和阈值,以获得最佳的聚类结果。

K均值算法在数据挖掘中的应用方法(五)

K均值算法在数据挖掘中的应用方法数据挖掘是一门利用各种算法和技术,从大规模数据中发现隐藏的模式、关系和信息的学科。

而K均值算法作为一种常用的聚类算法,在数据挖掘中有着广泛的应用。

本文将从K均值算法的原理、应用方法和优缺点等方面进行探讨。

K均值算法的原理K均值算法是一种基于距离的聚类算法。

其原理是将数据集中的样本划分为K个簇,使得簇内的样本相似度尽可能高,而簇间的样本相似度尽可能低。

具体来说,算法首先随机选择K个初始中心点,然后将每个样本点分配到与之最近的中心点所对应的簇中。

接着,根据新的簇分配情况,更新每个簇的中心点,直到簇分配不再变化为止。

K均值算法的应用方法K均值算法在数据挖掘中的应用方法主要包括以下几个步骤:1. 数据预处理:首先需要对原始数据进行清洗、去噪和归一化等预处理工作,以便提高算法的准确性和效率。

2. 选择K值:在应用K均值算法时,需要事先确定要划分的簇的个数K。

通常可以通过肘部法则、轮廓系数等方法来选择合适的K值。

3. 初始化中心点:随机选择K个初始中心点,可以是随机选择K个样本作为初始中心点,也可以根据某种启发式方法选择初始中心点。

4. 分配样本到簇:根据样本与各个中心点的距离,将每个样本分配到与之最近的中心点所对应的簇中。

5. 更新中心点:根据新的簇分配情况,更新每个簇的中心点,通常是取该簇中所有样本的均值作为新的中心点。

6. 迭代更新:重复进行簇分配和中心点更新的过程,直到簇分配不再变化或达到最大迭代次数为止。

K均值算法的优缺点K均值算法作为一种简单且易于实现的聚类算法,具有以下优点:1. 算法简单:K均值算法的原理和步骤相对简单,易于理解和实现。

2. 效率高:在处理大规模数据集时,K均值算法具有较高的计算效率。

3. 聚类效果好:对于各个簇的形状和密度差异较大的数据集,K均值算法通常能够取得较好的聚类效果。

然而,K均值算法也存在一些缺点:1. 对初始中心点敏感:K均值算法对初始中心点的选择较为敏感,不同的初始中心点可能导致不同的聚类结果。

基于样本空间分布密度的初始聚类中心优化K-均值算法

较远 的数据 对 象作 为初 始聚 类 中心 , 实现 K 均值 聚类 。U I 器学 习数 据库数 据集 以及 随机 生成的 带有噪 声 点 一 C机

的人 工模 拟数 据 集的 实验 测试 证 明, 算法 不仅具有 很好 的聚 类效果 , 本 而且运行 时 间短 , 对噪 声数据 有很 强的抗

第2 9卷第 3期 21 0 2年 3月

计 算 机 应 用 研 究

Ap l a i n Re e r h o mp t r p i t s a c fCo u e s c o

V0 . 9 No 3 12 .

Ma . 2 1 r 02

基 于样 本 空 间分 布 密 度 的初 始 聚 类 中心 优 化 K 均值 算 法 术 一

摘

要 :针对 传统 K 均值 聚 类算 法对初 始聚类 中心敏 感 、 一 现有初 始 聚类 中心 优化 算 法缺 乏客 观性 , 出一 种基 提

于样本 空 间分布 密度的初 始聚 类 中心优 化 K均值 算 法。该 算法利 用数 据 集样 本 的空 间分 布信 息定 义数 据 对 象 一

的 密度 , 并根据 整个数 据 集的 空间信 息定 义 了数据 对 象的邻 域 ; 在此 基 础上 选择 位 于数 据 集样 本 密集 区且 相距

谢娟英 , 郭文娟 谢 维信 , , 高新波

(.陕西师 范大 学 计 算机 科 学学 院, 1 西安 706 ; .西安 电子科技 大 学 电子 工程 学院 ,西安 707 ;. 102 2 10 13 深圳

大学 信 息 工程 学院 A R国 家重 点 实验 室,深圳 5 8 6 ) T 1 0 0

文献标 志码 :A

文 章编 号 :10 —65 2 1 )30 8—5 0 139 (0 2 0—880

如何利用K均值算法进行网络行为分析(Ⅱ)

K均值算法是一种常用的聚类算法,可以用来对网络行为进行分析。

网络行为分析是指通过对网络流量的监测和分析,来识别网络中的异常行为、发现潜在的威胁、改善网络性能等。

本文将介绍如何利用K均值算法进行网络行为分析,并探讨其在实际应用中的意义和局限性。

一、K均值算法简介K均值算法是一种基于距离的聚类算法,其核心思想是将样本划分为K个簇,使得同一簇内的样本之间的距离尽可能小,不同簇之间的样本之间的距离尽可能大。

具体而言,K均值算法的过程如下:1. 随机初始化K个簇的中心点;2. 将每个样本点分配到距离最近的簇中;3. 根据分配给每个簇的样本点,重新计算每个簇的中心点;4. 重复步骤2和3,直到簇的中心点不再发生变化或者变化很小。

K均值算法通过迭代的方式,将样本点划分为K个簇,并且使得同一簇内的样本之间的距离尽可能小,不同簇之间的样本之间的距离尽可能大。

二、利用K均值算法进行网络行为分析在网络行为分析中,可以利用K均值算法对网络流量数据进行聚类分析,以发现网络中的异常行为。

具体而言,可以将网络流量数据中的特征作为样本点,利用K均值算法将流量数据分为不同的簇。

通过对不同簇的流量数据进行分析,可以发现异常行为,如DDoS攻击、僵尸网络等。

另外,利用K均值算法还可以对网络用户的行为进行分析。

通过将用户在网络上的行为数据作为样本点,利用K均值算法将用户分为不同的簇,可以发现用户之间的行为模式差异,识别异常用户,改善用户体验等。

三、K均值算法在网络行为分析中的意义利用K均值算法进行网络行为分析,可以帮助网络管理员快速发现网络中的异常行为,提高网络安全性。

通过对异常行为的及时发现和处理,可以减少网络攻击对系统造成的影响,保护网络安全。

另外,利用K均值算法进行网络用户行为分析,可以帮助企业了解用户的行为模式,为用户提供个性化的服务,提高用户满意度。

同时,还可以通过对用户行为的分析,发现潜在的安全威胁,加强对用户数据的保护。

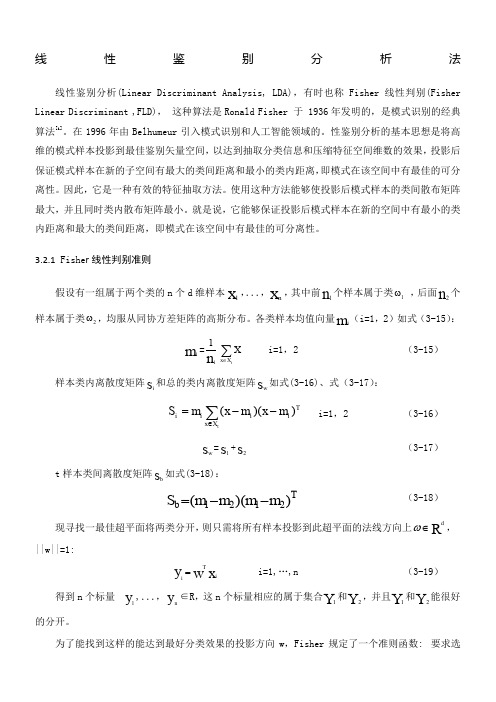

LDA算法详解

线性鉴别分析法线性鉴别分析(Linear Discriminant Analysis, LDA),有时也称Fisher 线性判别(Fisher Linear Discriminant ,FLD), 这种算法是Ronald Fisher 于 1936年发明的,是模式识别的经典算法[i]。

在1996年由Belhumeur 引入模式识别和人工智能领域的。

性鉴别分析的基本思想是将高维的模式样本投影到最佳鉴别矢量空间,以达到抽取分类信息和压缩特征空间维数的效果,投影后保证模式样本在新的子空间有最大的类间距离和最小的类内距离,即模式在该空间中有最佳的可分离性。

因此,它是一种有效的特征抽取方法。

使用这种方法能够使投影后模式样本的类间散布矩阵最大,并且同时类内散布矩阵最小。

就是说,它能够保证投影后模式样本在新的空间中有最小的类内距离和最大的类间距离,即模式在该空间中有最佳的可分离性。

3.2.1 Fishe r 线性判别准则假设有一组属于两个类的n 个d 维样本x 1,...,x n,其中前n 1个样本属于类1ω ,后面n 2个样本属于类2ω,均服从同协方差矩阵的高斯分布。

各类样本均值向量m i (i=1,2)如式(3-15):m i =ni 1∑∈tX x X i=1,2 (3-15)样本类内离散度矩阵s i 和总的类内离散度矩阵s w 如式(3-16)、式(3-17):TiX x i ii m x m x m S t)()(--=∑∈ i=1,2 (3-16) s w=s 1+s2(3-17)t 样本类间离散度矩阵s b 如式(3-18):Tb m m m m S ))((2121--= (3-18)现寻找一最佳超平面将两类分开,则只需将所有样本投影到此超平面的法线方向上∈ωR d,||w||=1:x w y iTi= i=1,…,n (3-19)得到n 个标量y 1,...,y n∈R ,这n 个标量相应的属于集合Y 1和Y 2,并且Y 1和Y 2能很好的分开。

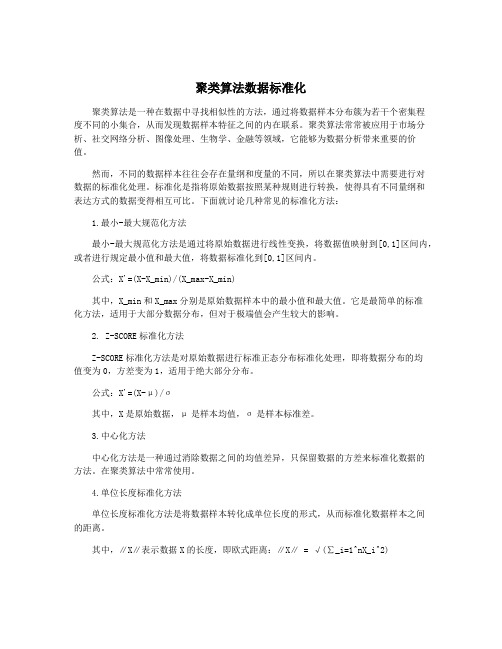

聚类算法数据标准化

聚类算法数据标准化聚类算法是一种在数据中寻找相似性的方法,通过将数据样本分布簇为若干个密集程度不同的小集合,从而发现数据样本特征之间的内在联系。

聚类算法常常被应用于市场分析、社交网络分析、图像处理、生物学、金融等领域,它能够为数据分析带来重要的价值。

然而,不同的数据样本往往会存在量纲和度量的不同,所以在聚类算法中需要进行对数据的标准化处理。

标准化是指将原始数据按照某种规则进行转换,使得具有不同量纲和表达方式的数据变得相互可比。

下面就讨论几种常见的标准化方法:1.最小-最大规范化方法最小-最大规范化方法是通过将原始数据进行线性变换,将数据值映射到[0,1]区间内,或者进行规定最小值和最大值,将数据标准化到[0,1]区间内。

公式:X'=(X-X_min)/(X_max-X_min)其中,X_min和X_max分别是原始数据样本中的最小值和最大值。

它是最简单的标准化方法,适用于大部分数据分布,但对于极端值会产生较大的影响。

2. Z-SCORE标准化方法Z-SCORE标准化方法是对原始数据进行标准正态分布标准化处理,即将数据分布的均值变为0,方差变为1,适用于绝大部分分布。

公式:X'=(X-μ)/σ其中,X是原始数据,μ是样本均值,σ是样本标准差。

3.中心化方法中心化方法是一种通过消除数据之间的均值差异,只保留数据的方差来标准化数据的方法。

在聚类算法中常常使用。

4.单位长度标准化方法单位长度标准化方法是将数据样本转化成单位长度的形式,从而标准化数据样本之间的距离。

其中,∥X∥表示数据X的长度,即欧式距离:∥X∥ = √(∑_i=1^nX_i^2)上述的四种方法并不是绝对适用于所有数据类型的情况,需要根据实际数据情况和算法要求的标准化方法进行选择。

在聚类算法中,标准化的目的主要是减少在不同维度上的权重差异,衡量数据样本之间的“距离”的公平性,提高算法效率和准确度,使得特征之间的距离计算更加合理。

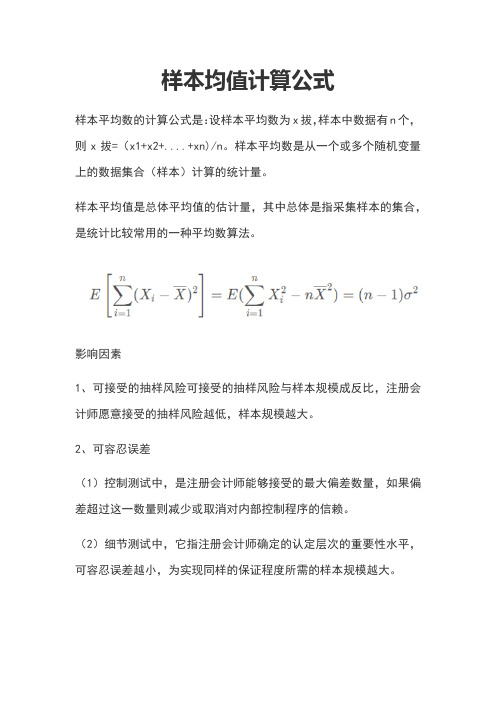

样本均值计算公式

样本均值计算公式

样本平均数的计算公式是:设样本平均数为x拔,样本中数据有n个,则x拔=(x1+x2+....+xn)/n。

样本平均数是从一个或多个随机变量上的数据集合(样本)计算的统计量。

样本平均值是总体平均值的估计量,其中总体是指采集样本的集合,是统计比较常用的一种平均数算法。

影响因素

1、可接受的抽样风险可接受的抽样风险与样本规模成反比,注册会计师愿意接受的抽样风险越低,样本规模越大。

2、可容忍误差

(1)控制测试中,是注册会计师能够接受的最大偏差数量,如果偏差超过这一数量则减少或取消对内部控制程序的信赖。

(2)细节测试中,它指注册会计师确定的认定层次的重要性水平,可容忍误差越小,为实现同样的保证程度所需的样本规模越大。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2 The Sample Average Approximation Method

2. Optimizing the expected recourse costs. Even if the expected recourse cost function could be evaluated or approximated easily, the stochastic programming problem (1) involves optimizing this function over the firststage decisions. It is well known that value functions of integer programs are highly non-convex and discontinuous. Consequently this optimization problem poses severe computational difficulties.

765 Ferst Drive, Atlanta, GA 30332

February 5, 2002

Abstract This paper develops a solution strategy for two-stage stochastic programs with integer recourse. The proposed methodology relies on approximating the underlying stochastic program via sampling, and solving the approximate problem via a specialized optimization algorithm. We show that the proposed scheme will produce an optimal solution to the true problem with probability approaching one exponentially fast as the sample size is increased. For fixed sample size, we describe statistical and deterministic bounding techniques to validate the quality of a candidate optimal solution. Preliminary computational experience with the method is reported.

∗Supported in part by the National Science Foundation under Grant No. DMII-0099726. †Supported in part by the National Science Foundation under Grant No. s paper, we propose a solution strategy for a class of two-stage stochastic programs with integer recourse that addresses the above difficulties. In the proposed approach, the expected recourse cost function in (1) is replaced by a sample average approximation, and the corresponding optimization problem is solved using a specialized algorithm for non-convex optimization. It has been shown in [27], that a solution to this sample average approximation (SAA) problem converges to a solution of the true problem as the sample size tends

2

to infinity. Here, we analyze the rate of convergence of the SAA solutions for stochastic programs with integer recourse. We also describe statistical and deterministic bounding techniques to estimate the near optimality of a candidate solution. Finally, some preliminary computational results are presented.

Keywords: Stochastic programming, integer recourse, sample average approximation, branch and bound.

1 Introduction

In the two-stage stochastic programming approach for optimization under uncertainty, the decision variables are partitioned into two sets. The first stage variables are those that have to be decided before the actual realization of the uncertain parameters becomes available. Subsequently, once the random events have presented themselves, further design or operational policy improvements can be made by selecting, at a certain cost, the values of the second stage or recourse variables. The objective is to choose the first stage variables in a way that the sum of first stage costs and the expected value of the random second stage or recourse costs is minimized.

This paper is concerned with two-stage stochastic programs where the recourse is fixed, i.e., the matrix W is constant (not random), and the recourse variables are restricted to be integers, i.e., Y ⊆ Zn2 in (2). Such problems find applications in production planning [10, 17, 6], scheduling [9, 33, 4], routing [31, 14, 15], location [16], capacity expansion [3], electricity production [32, 8], environmental control [21], and finance [11].

The two key sources of difficulty in solving stochastic programs with integer recourse are:

1. Exact evaluation of the expected recourse costs. For a given first-stage decision and a realization of the random data, the recourse costs are computed via solving an integer program. Thus, for continuous distribution of the uncertain parameters, the exact evaluation of the expected recourse costs would require the multi-dimensional integration of integer programming value functions, which is practically impossible. Even for discrete distributions, an exact computation of the expectation would require solving the integer recourse problem for all possible realizations of the uncertain parameters and may be computationally prohibitive.

The Sample Average Approximation Method for Stochastic Programs with Integer Recourse

Shabbir Ahmed∗ and Alexander Shapiro†

School of Industrial & Systems Engineering Georgia Institute of Technology

1