K-MEANS(K均值聚类算法-C均值算法)

kmeans色彩聚类算法

kmeans色彩聚类算法

K均值(K-means)色彩聚类算法是一种常见的无监督学习算法,用于将图像中的像素分组成具有相似颜色的集群。

该算法基于最小

化集群内部方差的原则,通过迭代寻找最优的集群中心来实现聚类。

首先,算法随机初始化K个集群中心(K为预先设定的参数),然后将每个像素分配到最接近的集群中心。

接下来,更新集群中心

为集群内所有像素的平均值,然后重新分配像素直到达到收敛条件。

最终,得到K个集群,每个集群代表一种颜色,图像中的像素根据

它们与集群中心的距离被归类到不同的集群中。

K均值色彩聚类算法的优点是简单且易于实现,对于大型数据

集也具有较高的效率。

然而,该算法也存在一些缺点,例如对初始

集群中心的选择敏感,可能收敛于局部最优解,对噪声和异常值敏

感等。

在实际应用中,K均值色彩聚类算法常被用于图像压缩、图像

分割以及图像检索等领域。

同时,为了提高算法的鲁棒性和效果,

通常会结合其他技术和方法,如颜色直方图、特征提取等。

此外,

还有一些改进的K均值算法,如加权K均值、谱聚类等,用于解决

K均值算法的局限性。

总之,K均值色彩聚类算法是一种常用的图像处理算法,通过对图像像素进行聚类,实现了图像的颜色分组和压缩,具有广泛的应用前景和研究价值。

kmeans的聚类算法

kmeans的聚类算法K-means是一种常见的聚类算法,它可以将数据集划分为K个簇,每个簇包含相似的数据点。

在本文中,我们将详细介绍K-means算法的原理、步骤和应用。

一、K-means算法原理K-means算法基于以下两个假设:1. 每个簇的中心是该簇内所有点的平均值。

2. 每个点都属于距离其最近的中心所在的簇。

基于这两个假设,K-means算法通过迭代寻找最佳中心来实现聚类。

具体来说,该算法包括以下步骤:二、K-means算法步骤1. 随机选择k个数据点作为初始质心。

2. 将每个数据点分配到距离其最近的质心所在的簇。

3. 计算每个簇内所有数据点的平均值,并将其作为新质心。

4. 重复步骤2和3直到质心不再变化或达到预定迭代次数。

三、K-means算法应用1. 数据挖掘:将大量数据分成几组可以帮助我们发现其中隐含的规律2. 图像分割:将图像分成几个部分,每个部分可以看做是一个簇,从而实现图像的分割。

3. 生物学:通过对生物数据进行聚类可以帮助我们理解生物之间的相似性和差异性。

四、K-means算法优缺点1. 优点:(1)简单易懂,易于实现。

(2)计算效率高,适用于大规模数据集。

(3)结果可解释性强。

2. 缺点:(1)需要预先设定簇数K。

(2)对初始质心的选择敏感,可能会陷入局部最优解。

(3)无法处理非球形簇和噪声数据。

五、K-means算法改进1. K-means++:改进了初始质心的选择方法,能够更好地避免陷入局部最优解。

2. Mini-batch K-means:通过随机抽样来加快计算速度,在保证精度的同时降低了计算复杂度。

K-means算法是一种常见的聚类算法,它通过迭代寻找最佳中心来实现聚类。

该算法应用广泛,但也存在一些缺点。

针对这些缺点,我们可以采用改进方法来提高其效果。

K-均值聚类算法

4.重复分组和确定中心的步骤,直至算法收敛;

2.算法实现

输入:簇的数目k和包含n个对象的数据库。 输出:k个簇,使平方误差准则最小。

算法步骤:

1.为每个聚类确定一个初始聚类中心,这样就有K 个初始 聚类中心。

2.将样本集中的样本按照最小距离原则分配到最邻近聚类

给定数据集X,其中只包含描述属性,不包含 类别属性。假设X包含k个聚类子集X1,X2,„XK;各 个聚类子集中的样本数量分别为n1,n2,„,nk;各个 聚类子集的均值代表点(也称聚类中心)分别为m1, m2,„,mk。

3.算法实例

则误差平方和准则函数公式为:

k

2

E p mi

i 1 pX i

单个方差分别为

E1 0 2.52 2 22 2.5 52 2 22 12.5 E2 13.15

总体平均误差是: E E1 E2 12.5 13.15 25.65 由上可以看出,第一次迭代后,总体平均误差值52.25~25.65, 显著减小。由于在两次迭代中,簇中心不变,所以停止迭代过程, 算法停止。

示为三维向量(分别对应JPEG图像中的红色、绿色 和蓝色通道) ; 3. 将图片分割为合适的背景区域(三个)和前景区域 (小狗); 4. 使用K-means算法对图像进行分割。

2 015/8/8

Hale Waihona Puke 分割后的效果注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。

2 015/8/8

例2:

2 015/8/8

Ox y 102 200 3 1.5 0 450 552

数据对象集合S见表1,作为一个 聚类分析的二维样本,要求的簇的数 量k=2。

k均值聚类算法 理想簇数

k均值聚类算法简介k均值聚类算法(k-means clustering algorithm)是一种常用的无监督学习算法,用于将一组数据划分为k个簇(cluster)。

该算法的目标是将数据点划分到离其最近的簇中,使得同一簇内的数据点相似度较高,不同簇之间的数据点相似度较低。

k均值聚类算法是一种迭代算法,通过迭代更新簇心(cluster center)的位置来不断优化聚类结果。

算法步骤k均值聚类算法的步骤如下:1.初始化:随机选择k个数据点作为初始簇心。

2.分配:对于每个数据点,计算其与各个簇心之间的距离,并将其分配到距离最近的簇中。

3.更新:对于每个簇,计算其内部数据点的均值,并将该均值作为新的簇心。

4.重复步骤2和步骤3,直到簇心不再发生变化或达到预定的迭代次数。

理想簇数的确定确定合适的簇数对于k均值聚类算法的结果具有重要影响。

如果簇数过小,可能导致聚类结果不够细致;如果簇数过大,可能导致聚类结果过于细致,甚至每个数据点都成为一个簇。

以下是一些常用的方法来确定理想簇数:1. 肘部法则(Elbow Method)肘部法则是一种基于簇内平方和(SSE)的方法。

SSE是指每个簇内数据点与其簇心之间距离的平方和。

随着簇数的增加,SSE会逐渐减小。

当簇数增加到一定程度后,每个簇的增益会逐渐减小,形成一个肘部。

肘部对应的簇数被认为是理想簇数。

2. 轮廓系数(Silhouette Coefficient)轮廓系数是一种基于簇内相似度和簇间相异度的方法。

对于每个数据点,轮廓系数计算其与同簇内其他数据点的平均距离(a)和与最近簇内其他数据点的平均距离(b),然后计算其轮廓系数为(b-a)/max(a,b)。

轮廓系数的取值范围为[-1, 1],越接近1表示聚类效果越好。

通过计算不同簇数下的轮廓系数,找到最大的轮廓系数对应的簇数作为理想簇数。

3. Gap StatisticGap Statistic是一种基于随机模拟的方法。

简述k均值聚类算法的流程

简述k均值聚类算法的流程K均值聚类算法(K-meansClusteringAlgorithm,简称KMC)是一种基于数据集合分类的机器学习算法,在当今的机器学习领域中,KMC算法是分类,建模和发现深度结构常用的机器学习算法之一。

它通过将各种数据点分为K个聚类,来获得数据特征,从而方便对数据进行分析。

KMC算法的核心流程可以分成四步:第一步:划分K个中心点。

首先,在给定数据集中选择K个点作为聚类的中心,这些点称为中心点,可以是任意的点或者选择某个算法来选择随机的中心点;第二步:计算每个点到中心点的距离。

计算每个点和K个中心点之间的距离,并把此计算结果存储为K维数组,即K维数组;第三步:根据每个点到K个中心点的距离,将每一个点划分到离它最近的中心点的聚类中;第四步:重新计算中心点的坐标,重新计算每个聚类的中心点,以当前的聚类项的坐标为新的中心点,重复上述的第二步和第三步,如此反复,直到聚类不再发生变化为止,这就是KMC算法的核心思想。

KMC算法是一种基于数据集应用算法,旨在快速将数据集中的数据进行分类、建模和发现数据深层次结构的机器学习算法。

它的核心流程特别简单,以选择K个中心点为起点,计算每个点到K个中心点的距离,将每个点划分至离它最近的中心点的聚类中,重新计算中心点的坐标,直到聚类不再发生变化,此过程可以十分有效地为用户提供相关建模和发现数据深层次结构的机器学习算法。

KMC算法的应用非常广泛,有两个重要的场景,一个是用于文本摘要,另一个是用于推荐系统,用于文本摘要时,KMC算法会将文章中的信息做聚类分析,将聚类结果作为文摘;而在推荐系统中,KMC 算法可以将用户的操作行为聚类,根据用户行为的分类特征,可以对用户进行推荐。

KMC算法可以说是一种令人不可思议的算法,它的简易性和效率在当今的机器学习领域中非常受重视,它的优势是可以以简单的方式快速实现结果,为机器学习中分类、建模和发现深度结构提供了很多便利。

K-means聚类算法

K-means聚类算法1. 概述K-means聚类算法也称k均值聚类算法,是集简单和经典于⼀⾝的基于距离的聚类算法。

它采⽤距离作为相似性的评价指标,即认为两个对象的距离越近,其相似度就越⼤。

该算法认为类簇是由距离靠近的对象组成的,因此把得到紧凑且独⽴的簇作为最终⽬标。

2. 算法核⼼思想K-means聚类算法是⼀种迭代求解的聚类分析算法,其步骤是随机选取K个对象作为初始的聚类中⼼,然后计算每个对象与各个种⼦聚类中⼼之间的距离,把每个对象分配给距离它最近的聚类中⼼。

聚类中⼼以及分配给它们的对象就代表⼀个聚类。

每分配⼀个样本,聚类的聚类中⼼会根据聚类中现有的对象被重新计算。

这个过程将不断重复直到满⾜某个终⽌条件。

终⽌条件可以是没有(或最⼩数⽬)对象被重新分配给不同的聚类,没有(或最⼩数⽬)聚类中⼼再发⽣变化,误差平⽅和局部最⼩。

3. 算法实现步骤1、⾸先确定⼀个k值,即我们希望将数据集经过聚类得到k个集合。

2、从数据集中随机选择k个数据点作为质⼼。

3、对数据集中每⼀个点,计算其与每⼀个质⼼的距离(如欧式距离),离哪个质⼼近,就划分到那个质⼼所属的集合。

4、把所有数据归好集合后,⼀共有k个集合。

然后重新计算每个集合的质⼼。

5、如果新计算出来的质⼼和原来的质⼼之间的距离⼩于某⼀个设置的阈值(表⽰重新计算的质⼼的位置变化不⼤,趋于稳定,或者说收敛),我们可以认为聚类已经达到期望的结果,算法终⽌。

6、如果新质⼼和原质⼼距离变化很⼤,需要迭代3~5步骤。

4. 算法步骤图解上图a表达了初始的数据集,假设k=2。

在图b中,我们随机选择了两个k类所对应的类别质⼼,即图中的红⾊质⼼和蓝⾊质⼼,然后分别求样本中所有点到这两个质⼼的距离,并标记每个样本的类别为和该样本距离最⼩的质⼼的类别,如图c所⽰,经过计算样本和红⾊质⼼和蓝⾊质⼼的距离,我们得到了所有样本点的第⼀轮迭代后的类别。

此时我们对我们当前标记为红⾊和蓝⾊的点分别求其新的质⼼,如图d所⽰,新的红⾊质⼼和蓝⾊质⼼的位置已经发⽣了变动。

聚类分割算法

聚类分割算法聚类分割算法是一类常用于将数据集划分成具有相似特征的子集的方法。

这些算法主要用于无监督学习,即在没有先验标签的情况下,自动发现数据集内在的模式。

以下是一些常见的聚类分割算法:1. K均值聚类(K-Means Clustering):- K均值是最常见的聚类算法之一。

它将数据集分为K个簇,每个簇由其质心表示。

算法的目标是使每个数据点到其所属簇的质心的距离最小化。

2. 层次聚类(Hierarchical Clustering):-层次聚类根据数据点之间的相似性构建树状结构。

可以通过聚合或分割来创建簇。

分为凝聚式层次聚类(自底向上)和分裂式层次聚类(自顶向下)。

3. DBSCAN(Density-Based Spatial Clustering of Applications with Noise):- DBSCAN基于密度的聚类算法,能够发现具有足够密度的区域,并将稀疏区域视为噪声。

它不需要预先指定簇的数量。

4. Mean Shift聚类:- Mean Shift是一种基于梯度上升的聚类算法。

它通过不断迭代调整数据点的位置,使其移向密度最大的区域,从而找到簇的中心。

5. OPTICS(Ordering Points To Identify the Clustering Structure):- OPTICS是一种基于密度的聚类算法,类似于DBSCAN,但允许在数据集中存在不同密度的区域,并通过产生一系列密度相关的点来表示簇。

6. 谱聚类(Spectral Clustering):-谱聚类利用数据集的谱信息,通过将数据投影到低维子空间来执行聚类。

它在处理非凸形状的簇和图分割问题时效果较好。

7. 模糊聚类(Fuzzy Clustering):-模糊聚类考虑了数据点与簇的隶属度,而不是将每个数据点硬性地分配到一个簇。

模糊c均值(FCM)是模糊聚类的一个典型算法。

这只是聚类分割算法的一小部分,每个算法都有其适用的场景和限制。

k均值聚类算法

k均值聚类算法k均值聚类算法是一种无监督学习算法,它可以将数据点根据它们的特征值聚类在一起,而无需人工指定聚类的数量。

该算法的核心思想是将数据集划分为k个最相似的子集,其中每个子集都有着特定的平均属性值。

每次迭代,该算法都会重新确定代表性点并对数据进行聚类,直到算法达到最优解。

k均值聚类算法的原理k均值聚类算法的核心原理是通过将每个数据点与其最接近的“代表性点”(或称“中心点”)相比较,并将该数据点归类到与它最接近的聚类中。

该算法从一个初始参考点开始,通过重复迭代不断改变和更新中心点,从而得到最佳聚类结果。

k均值聚类算法和K-Means算法k均值聚类算法由Macqueen发明,而K-Means算法是由Stuart Lloyd在1957年提出的,它们有一些共同之处,但是也有不同之处。

K-Means算法是k均值聚类算法的一个变体,它的核心思想也是将数据点分组,只不过它在聚类的时候会把数据点看作是k个球,通过把每个数据点看作是球上的一个点,来进行聚类。

此外,K-Means算法和k均值聚类算法在求解过程中也是不同的。

K-Means算法在每次迭代中都只更新中心点,而k均值聚类算法在每次迭代中更新代表性点,而不仅仅是中心点。

k均值聚类算法的优点k均值聚类算法有很多优点,其中最重要的一个就是可以自动确定聚类的数量,这样就可以省去人工指定聚类数量的过程,另外,该算法运行速度还是相对较快的。

此外,它还可以处理大量的数据,因此,可以用来处理大规模的数据集,而且它可以有效处理离群点,即使其中有一些特异的数据也可以正确聚类,这是其它聚类算法所不具备的优势。

k均值聚类算法的缺点k均值聚类算法也有一些缺点,其中最主要的一个就是它受到初始代表性点的影响过大,也就是说,如果从初始状态开始的聚类结果不好,那么它就可能会得到一个偏离最终结果的结果。

另外,该算法也不能处理变化性数据,因为它会选择那些经常出现的数据为代表性点,忽略掉一些变化的数据,所以它不能很好的处理变化性数据。

K-means算法详解

算法实例

O x y

1

2 3 4 5Βιβλιοθήκη 00 1.5 5 5

2

0 0 0 2

数据对象集合S见表1,作为一个聚类分析的二 维样本,要求的簇的数量k=2。 O (1)选择 O1 0,2 , 2 0,0 为初始的簇中心, 即 M 1 O1 0,2 , M 2 O2 0,0 。 (2)对剩余的每个对象,根据其与各个簇中心的 距离,将它赋给最近的簇。 对 O3 : 2 2

0 5

0 5

2

2 2

2

2

5

29

1

5

5

2

0 2

• 因为 d M 1 , O 5 d M 2 , O 5 所以将 O 5分配给 C

• 更新,得到新簇

E1 0 0

2 2

C1 O1 ,O5

和

2

C 2 O 2 , O 3 , O 4

xi1,xi2,„xid和xj1,xj2,„xjd分别是样本xi和xj对应d个描 述属性A1,A2,„Ad的具体取值。 • 样本xi和xj之间的相似度通常用它们之间的距离d(xi,xj) 来表示,距离越小,样本xi和xj越相似,差异度越小;距

离越大,样本xi和xj越不相似,差异度越大。

欧式距离公式如下:

d xi , x j

x

d k 1

ik

x jk

2

平均误差准则函数

• K-means聚类算法使用误差平方和准则函数来评价聚类 性能。给定数据集X,其中只包含描述属性,不包含类别

属性。假设X包含k个聚类子集X1,X2,„XK;各个聚类子集

中的样本数量分别为n1,n2,„,nk;各个聚类子集的均值代 表点(也称聚类中心)分别为m1,m2,„,mk。 • 误差平方和准则函数公式为:

kmeans算法公式

kmeans算法公式K均值聚类算法(K-means clustering algorithm)是一种常用的无监督学习算法,用于将一组数据点划分为K个不同的组或聚类。

该算法的目标是最小化数据点与其所属聚类中心之间的平方距离。

算法步骤如下:1. 随机选择K个数据点作为初始聚类中心。

2. 将每个数据点分配给距离最近的聚类中心。

3. 更新每个聚类中心的位置,将其设为该聚类中所有点的均值。

4. 重复步骤2和3,直到聚类中心不再改变或达到最大迭代次数。

具体而言,K均值算法可用以下公式表示:1. 选择K个聚类中心:C = {c1, c2, ..., ck}其中,ci表示第i个聚类中心。

2. 分配数据点到最近的聚类中心:使用欧氏距离作为度量衡量数据点xi与聚类中心cj之间的距离:dist(xi, cj) = sqrt((xi1 - cj1)^2 + (xi2 - cj2)^2 + ... + (xid - cjd)^2)其中,d表示数据点的维度。

将每个数据点xi分配给最近的聚类中心:ci = arg minj(dist(xi, cj))3. 更新聚类中心的位置:计算每个聚类中心包含的数据点的均值,作为新的聚类中心的位置。

cj = (1/|ci|) * sum(xi)其中,|ci|表示聚类中心ci包含的数据点数量,sum(xi)表示所有聚类中心ci包含的数据点xi的和。

4. 重复步骤2和3,直到聚类中心不再改变或达到最大迭代次数。

K均值算法的优点是简单而高效,适用于大规模数据集。

然而,它也存在一些限制,比如对初始聚类中心的敏感性和对数据点分布的假设(即聚类簇的凸性)。

此外,当数据点的维度较高时,K均值算法的性能可能下降。

参考内容:- Christopher M. Bishop, "Pattern Recognition and Machine Learning". Springer, 2006.- Richard O. Duda, Peter E. Hart, David G. Stork, "Pattern Classification". Wiley, 2001.- Machine Learning, Tom Mitchell, "Machine Learning". McGraw-Hill, 1997.- Kevin P. Murphy, "Machine Learning: A Probabilistic Perspective". MIT Press, 2012.- Sebastian Raschka, Vahid Mirjalili, "Python Machine Learning". Packt Publishing, 2017.这些参考内容提供了对K均值算法的详细解释、数学推导和实际应用示例,对于深入理解和使用该算法非常有帮助。

K-Means聚类算法

K-Means聚类算法K-Means聚类算法是一种常用的无监督学习算法,在数据挖掘、图像处理、信号处理等领域有广泛的应用。

聚类算法是将相似的对象归为一类,不同的类之间尽可能的不相似。

K-Means聚类算法是一种基于距离测量的算法,它将数据点分为K个簇,每个簇的中心点与相应的数据点之间的距离最小。

1.初始化K个簇的中心点。

2.将每个数据点分配到离它最近的簇中。

3.计算每个簇的新中心点。

4.重复步骤2和3,直到簇的中心点不再发生变化或达到预定的循环次数。

在算法中,K是指聚类的簇数,每个簇的中心点是从数据点中随机选择的。

在第二个步骤中,每个数据点会被分配到离它最近的簇中,这一步是K-Means聚类算法最重要的一步。

在第三个步骤中,每个簇的新中心点是通过计算该簇中所有数据点的平均值得到的。

1.简单易懂:K-Means聚类算法实现简单,易于理解。

2.计算速度快:该算法的时间复杂度为O(K*n*I),其中n是数据点的数量,I是迭代次数,因此算法速度较快。

3.可用于大规模数据:K-Means聚类算法可以处理大规模的数据集。

1.对初始值敏感:算法中随机选择簇的中心点,这会影响聚类结果。

如果初始值不理想,聚类结果可能会很糟糕。

2.需要指定簇数:需要事先指定簇的数量K,这对于有些问题来说可能是一个难点。

3.对数据分布的要求较高:K-Means聚类算法对数据分布的要求较高,如果数据分布不太符合预期,聚类结果可能会非常差。

在实际应用中,K-Means聚类算法可以用于数据挖掘、模式识别、图像分割等领域。

例如,在图像处理中,可以使用K-Means聚类算法将像素分为不同的颜色组。

在信号处理中,可以使用K-Means聚类算法将信号分为不同的频段组。

实际应用中,需要根据具体问题来选择聚类算法。

k均值聚类算法的

k均值聚类算法的【原创版】目录1.K 均值聚类算法的基本概念2.K 均值聚类算法的具体步骤3.K 均值聚类算法的优缺点4.K 均值聚类算法的应用实例正文一、K 均值聚类算法的基本概念K 均值聚类算法(K-means Clustering Algorithm)是一种基于划分的聚类方法,其目标是将数据集划分为 K 个聚类,使得每个聚类内部的数据点之间的距离最小,而不同聚类之间的数据点之间的距离最大。

二、K 均值聚类算法的具体步骤1.随机选择 K 个数据点作为初始聚类中心。

2.对于数据集中的每一个数据点,计算其与各个聚类中心的距离,并将其归入距离最近的聚类。

3.根据上一步的结果,更新每个聚类的中心(数据点的均值)。

4.重复步骤 2 和 3,直到聚类中心的变化小于某个阈值或达到迭代次数限制。

三、K 均值聚类算法的优缺点优点:1.K 均值聚类算法简单易懂,易于实现。

2.对于大规模数据集,K 均值聚类算法的计算复杂度较低,主要为O(n^2),其中 n 为数据点的数量。

缺点:1.K 均值聚类算法需要预先设定聚类数量 K,这在实际应用中往往比较困难。

2.K 均值聚类算法容易受到初始聚类中心的影响,导致局部最优解。

3.K 均值聚类算法对于离群点和簇形状的识别能力较弱。

四、K 均值聚类算法的应用实例K 均值聚类算法在实际应用中广泛使用,例如在图像处理、文本分类、客户分群等方面都有应用。

其中,图像处理是 K 均值聚类算法应用最为广泛的领域之一,可以用于图像的压缩、特征提取等。

而在文本分类中,K 均值聚类算法可以用于对文本进行分类,例如对新闻进行分类,对用户的评论进行分类等。

KMEANSK均值聚类算法C均值算法

KMEANSK均值聚类算法C均值算法K-means和C-means是两种常用的均值聚类算法。

它们都是通过计算数据点之间的距离来将数据划分为不同的簇。

K-means算法的基本思想是先随机选择K个初始聚类中心,然后迭代地将数据点分配到最近的聚类中心,并更新聚类中心的位置,直到聚类中心不再发生变化或达到预设的迭代次数。

具体步骤如下:1.随机选择K个初始聚类中心。

2.对每个数据点,计算其到每个聚类中心的距离,将其分配到距离最近的聚类中心的簇。

3.更新每个聚类中心的位置为该簇中所有数据点的均值。

4.重复步骤2和3,直到聚类中心不再发生变化或达到预设的迭代次数。

K-means算法的优点是简单易懂,计算复杂度较低。

但缺点是需要事先确定聚类的数量K,并且对初始聚类中心的选择比较敏感,可能会陷入局部最优解。

C-means算法是一种模糊聚类算法,与K-means算法类似,但每个数据点可以属于多个簇,而不是只属于一个确定的簇。

C-means算法引入了一个模糊权重因子,用于描述数据点与每个聚类中心的相似程度。

具体步骤如下:1.随机选择C个初始聚类中心。

2.对每个数据点,计算其与每个聚类中心的相似度,并计算出属于每个聚类中心的隶属度。

3.更新每个聚类中心的位置为该簇中所有数据点的加权均值,其中权重为隶属度的指数。

4.重复步骤2和3,直到聚类中心不再发生变化或达到预设的迭代次数。

C-means算法的优点是可以更灵活地表示数据点与聚类中心之间的关系,并且对于模糊性较强的数据集有更好的效果。

但缺点是计算复杂度较高,且需要事先确定聚类的数量C和模糊权重因子。

在实际应用中,K-means和C-means算法经常用于数据挖掘、模式识别和图像分割等领域。

它们都有各自的优缺点,需要根据具体问题的需求选择合适的算法。

此外,还可以通过改进算法的初始值选择、距离度量和迭代停止条件等方面来提高聚类的效果。

数据分析中的聚类分析与聚类算法比较

数据分析中的聚类分析与聚类算法比较在数据分析领域,聚类分析是一种常见的技术,用于将一组数据对象划分为相似的组或簇。

通过聚类分析,我们可以发现数据集中的隐藏模式、相似性和特征,并帮助我们更好地理解数据。

本文将比较几种常见的聚类算法,并探讨它们的优势和劣势。

聚类算法是一种无监督学习方法,它可以自动发现数据集中的结构,并将相似的数据点归为一组。

在聚类分析中,有许多不同的算法可供选择,如K均值聚类、层次聚类、DBSCAN和高斯混合模型等。

下面将对这些算法进行比较。

1. K均值聚类算法(K-means):K均值聚类算法是最常用的聚类算法之一。

它通过将数据分为预先定义的K个簇来进行聚类。

该算法的主要优势在于简单和快速,适用于大规模数据集。

然而,K均值算法对于初始聚类中心的选择非常敏感,并且对于非凸形状的簇分割效果较差。

2. 层次聚类算法(Hierarchical clustering):层次聚类算法是一种自上而下或自下而上的聚类方法。

这种方法通过计算对象之间的相似性将数据逐渐合并或拆分成不同的簇。

其优势在于可以生成层次结构和树状图,可以更好地理解数据之间的关系。

然而,由于计算复杂度高,处理大规模数据集时效率低下。

3. DBSCAN算法(Density-Based Spatial Clustering of Applications with Noise):DBSCAN算法是一种基于密度的聚类算法,可以发现任意形状和任意大小的簇。

它通过计算数据点周围的密度来划分簇,并可以自动处理噪声和异常值。

它的优势在于不需要预设簇的数量和形状,对数据集中的离群值鲁棒性较强。

然而,该算法对于数据密度分布不均匀或者维数较高的数据集效果较差。

4. 高斯混合模型(Gaussian Mixture Model,GMM):高斯混合模型是一种使用多个高斯分布来对数据进行建模的方法。

每个高斯分布表示一个簇,在训练过程中通过最大似然估计来估计模型参数。

k均值聚类(k-meansclustering)

k均值聚类(k-meansclustering)k均值聚类(k-means clustering)算法思想起源于1957年Hugo Steinhaus[1],1967年由J.MacQueen在[2]第⼀次使⽤的,标准算法是由Stuart Lloyd在1957年第⼀次实现的,并在1982年发布[3]。

简单讲,k-means clustering是⼀个根据数据的特征将数据分类为k组的算法。

k是⼀个正整数。

分组是根据原始数据与聚类中⼼(cluster centroid)的距离的平⽅最⼩来分配到对应的组中。

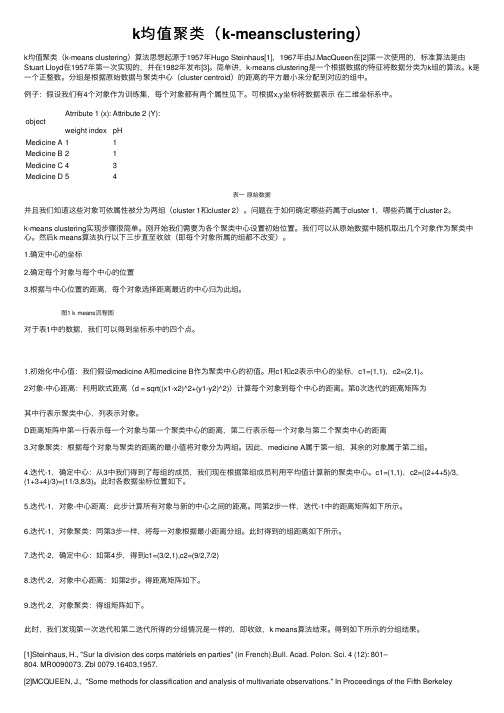

例⼦:假设我们有4个对象作为训练集,每个对象都有两个属性见下。

可根据x,y坐标将数据表⽰在⼆维坐标系中。

object Atrribute 1 (x):weight indexAttribute 2 (Y):pHMedicine A11Medicine B21Medicine C43Medicine D54表⼀原始数据并且我们知道这些对象可依属性被分为两组(cluster 1和cluster 2)。

问题在于如何确定哪些药属于cluster 1,哪些药属于cluster 2。

k-means clustering实现步骤很简单。

刚开始我们需要为各个聚类中⼼设置初始位置。

我们可以从原始数据中随机取出⼏个对象作为聚类中⼼。

然后k means算法执⾏以下三步直⾄收敛(即每个对象所属的组都不改变)。

1.确定中⼼的坐标2.确定每个对象与每个中⼼的位置3.根据与中⼼位置的距离,每个对象选择距离最近的中⼼归为此组。

图1 k means流程图对于表1中的数据,我们可以得到坐标系中的四个点。

1.初始化中⼼值:我们假设medicine A和medicine B作为聚类中⼼的初值。

⽤c1和c2表⽰中⼼的坐标,c1=(1,1),c2=(2,1)。

2对象-中⼼距离:利⽤欧式距离(d = sqrt((x1-x2)^2+(y1-y2)^2))计算每个对象到每个中⼼的距离。

k-means 法

k-means 法k-means法是一种常用的聚类分析方法,它能够将一组数据划分为若干个具有相似特征的簇。

在本文中,我们将介绍k-means法的原理、应用场景以及算法的实现步骤。

让我们来了解一下k-means法的原理。

k-means法的核心思想是通过不断迭代的方式,将数据集划分为k个簇,使得每个样本点与其所属簇的中心点(即质心)的距离最小化。

具体而言,k-means法的步骤如下:1. 随机选择k个初始质心,可以是数据集中的k个样本点或者通过其他方法选择。

2. 将每个样本点分配到与其最近的质心所属的簇。

3. 计算每个簇的新质心,即该簇中所有样本点的平均值。

4. 重复步骤2和步骤3,直到质心不再发生变化或者达到最大迭代次数。

k-means法的应用场景非常广泛。

例如,在市场营销中,可以根据消费者的购买行为数据将其划分为若干个簇,从而实现精准营销;在医学领域,可以根据患者的病历资料将其划分为不同的簇,以便进行个性化治疗等。

接下来,我们将详细介绍k-means法的实现步骤。

首先,我们需要确定k的值,即要将数据集划分为几个簇。

这可以根据实际应用需求和经验来确定,也可以通过一些评估指标(如轮廓系数)来自动选择。

然后,我们需要选择初始质心。

一种常用的方法是随机选择k个样本点作为初始质心,但这可能导致聚类结果不稳定。

因此,还可以使用其他方法来选择初始质心,如k-means++算法。

接下来,我们根据质心与样本点之间的距离,将每个样本点分配到与其最近的质心所属的簇。

这可以通过计算欧氏距离、曼哈顿距离或余弦相似度等来实现。

然后,我们计算每个簇的新质心,即该簇中所有样本点的平均值。

这一步骤可以帮助我们不断优化簇的划分结果,使得每个簇内的样本点更加相似。

我们重复以上步骤,直到质心不再发生变化或者达到最大迭代次数。

这样,我们就得到了最终的聚类结果。

需要注意的是,k-means法的结果可能会受到初始质心的选择和迭代次数的影响。

K-均值聚类算法2类

samp1(n1)=samp(i);

cl1=cl1+samp(i);n1=n1+1;

c11=cl1/n1;

else

samp2(n2)=samp(i);

cl2=cl2+samp(i);n2=n2+1;

c22=cl2/n2;

end

end

if c11==c1 && c22==c2

在聚类分析中,K-均值聚类算法(k-means algorithm)是无监督分类中的一种基本方法,其也称为C-均值算法,其基本思想是:通过迭代的方法,逐次更新各聚类中心的值,直至得到最好的聚类结果。

假设要把样本集分为c个类别,算法如下:

(1)适当选择c个类的初始中心;

(2)在第k次迭代中,对任意一个样本,求其到c个中心的距离,将该样本归到距离最短的中心所在的类,

t=1;

end

cl1=c11;cl2=c22;

c1=c11;c2=c22;

end %samp1,samp2为聚类的结果。

初始中心值这里采用均值的办法,也可以根据问题的性质,用经验的方法来确定,或者将样本集随机分成c类,计算每类的均值。

k-均值算法需要事先知道分类的数量,这是其不足之处。

n1=0;n2=0;

c1=0.0;

c1=double(c1); cຫໍສະໝຸດ =c1; for i=1:l

if samp(i)<th0

c1=c1+samp(i);n1=n1+1;

else

c2=c2+samp(i);n2=n2+1;

end

end

c1=c1/n1;c2=c2/n2; %初始聚类中心

7种常用的聚类方法

7种常用的聚类方法聚类是一种常用的数据挖掘算法,它的目的是将大量数据中的对象以类的形式进行分类。

在机器学习领域,聚类有着广泛的应用,本文将介绍7种常用的聚类方法,并针对其优势与劣势进行介绍。

第一种聚类方法是K均值(K-means)聚类。

K均值聚类是最常用的聚类算法之一,它利用数据对象之间的距离来划分聚类,通过不断重新计算距离,最终形成最佳聚类。

K均值聚类具有算法简单,分类速度快等优点,但同时具有聚类结果较为粗糙等劣势。

第二种聚类方法是层次聚类。

层次聚类是一种根据样本间的相似性对对象进行划分的方法,它首先把每个样本看做一个类,然后不断地把相似的类合并,直到满足某一条件为止。

层次聚类的优点是可以有效地进行大规模的数据分析,分析结果比较准确,在给定的聚类数目里能够得到最优结果,但是层次聚类的运行时间较长,且无法处理数据缺失等问题。

第三种聚类方法是模糊c均值聚类(FCM)。

模糊c均值聚类是基于K均值聚类的一种改进算法,它允许每一个数据对象同时属于多个不同的类。

FCM可以解决K均值聚类的不确定性和模糊性问题,具有可以提高分类准确性,可以处理非球形类等优势,但同时具有复杂度高,难以精确参数等劣势。

第四种聚类方法是基于密度的聚类(DBSCAN)。

DBSCAN可以有效地将数据点按照其密度划分为不同的类,它将空间距离和密度作为划分数据点的方式,把低密度区域划分为噪声点,把具有较高密度的区域划分为聚类,DBSCAN具有算法简单,可以识别异常点的优点,但同时需要用户设置一个密度阈值,而且难以处理数据缺失等问题。

第五种聚类方法是基于分布的聚类(GMM)。

GMM是一种概率模型,它利用一个混合参数模型来表达数据的分布,其中每一个组分表示一个聚类类别。

GMM有着较高的准确度,处理多分量分布,不需要自行调整参数等优点,但同时具有计算量大,对运行环境要求较高等劣势。

第六种聚类方法是平衡迭代聚类(BIRCH)。

BIRCH是一种基于树结构的聚类算法,其目的是通过构建CF树来细分由大量数据点组成的类,BIRCH的优势在于其运行速度较快,能够处理大规模的数据,但同时具有聚类结果与K均值聚类结果相比较模糊,计算空间要求较高等劣势。

聚类分析(C均值,K均值)

3. 计算各聚类的参数,删除、合并或分裂一些聚类;

C-均值法

1.算法简介 C-均值是一种得到最广泛使用的聚类算法。 它是将各个聚类子集内的所有数据样本的均 值作为该聚类的代表点,算法的主要思想是 通过迭代过程把数据集划分为不同的类别, 使得评价聚类性能的准则函数达到最优,从 而使生成的每个聚类内紧凑,类间独立。这 一算法不适合处理离散型属性,但是对于连 续型具有较好的聚类效果。

3聚类的算法 (1)根据相似性阈值和最小距离原则的简单聚 类方法 (2)按最小距离原则不断进行两类合并的原则 (谱系聚类法) (3)依据准则函数动态聚类法(C-均值法、 ISODATA法)

算法比较 在(1)和(2)的算法中它们一个共同特点 是:某个模式一旦分划到某一类中之后,在后 续的算法中就不会改变。在(2)中,类心一 旦选定,在后续算法中也不会改变。基于这些 特点使得算法(1)(2)效果不会太理想。

算法描述

1.初始化中心向量c1, c2, … 2. 分组: 将样本分配给距离其最近的中心向量, 由这些样本构造不相交( non-overlapping ) 的聚类 3. 确定中心:用各个聚类的中心向量作为新 的中心 4. 重复分组和确定中心的步骤,直至算法收 敛

算法步骤

1.为每个聚类确定一个初始聚类中心,这样就 有C 个初始聚类中心。 2.将样本集中的样本按照最小距离原则分配到 最邻近聚类 3.使用每个聚类中的样本均值作为新的聚类中 心。 4.重复步骤2.3直到聚类中心不再变化。 5.结束,得到C个聚类

聚类分析

1.简介 聚类分析是基于对象集客观存在着若干个 自然类、每个自然类中个体的某些属性都具有 较强的相似性而建立的一种数据描述方法。从 原理上讲,它是将给定的一些模式分成若干组, 对于所选定的属性和特征,每组的各模式是相 似的,而与其他组的模式差别很大。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

• 算法描述

1. 为中心向量c1, c2, …, ck初始化k个种子 2. 分组: 将样本分配给距离其最近的中心向量 由这些样本构造不相交( non-overlapping ) 的聚类 3. 确定中心: 用各个聚类的中心向量作为新的中心 4. 重复分组和确定中心的步骤,直至算法收敛

算法 k-means算法 输入:簇的数目k和包含n个对象的数据库。 输出:k个簇,使平方误差准则最小。 算法步骤: 1.为每个聚类确定一个初始聚类中心,这样就有K 个 初始聚类中心。 2.将样本集中的样本按照最小距离原则分配到最邻 近聚类 3.使用每个聚类中的样本均值作为新的聚类中心。 4.重复步骤2.3直到聚类中心不再变化。 5.结束,得到K个聚类

d M 1 , O3

d M 2 , O3

0 1.52 2 02

0 1.52 0 02

2.5

1.5

显然 d M 2 , O3 d M 1 , O3 ,故将O3分配给C 2

• 对于

O4

: d M 1 , O4

d xi , x j

x

d k 1

ik

x jk

2

• (2)选择评价聚类性能的准则函数 k-means聚类算法使用误差平方和准则函数来 评价聚类性能。给定数据集X,其中只包含描述属 性,不包含类别属性。假设X包含k个聚类子集 X1,X2,…XK;各个聚类子集中的样本数量分别为n1, n2,…,nk;各个聚类子集的均值代表点(也称聚类中 心)分别为m1,m2,…,mk。则误差平方和准则函数 公式为: 2

分割后的效果

注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。

2016/12/9

在图像分割上的简单应用

例 2:

注:聚类中心个数为5,最大迭代次数为10。

2016/12/9

E

k i 1 p X i

p mi

•

• • •

•

(3)相似度的计算根据一个簇中对象的平均值

来进行。 (1)将所有对象随机分配到k个非空的簇中。 (2)计算每个簇的平均值,并用该平均值代表相 应的簇。 (3)根据每个对象与各个簇中心的距离,分配给 最近的簇。 (4)然后转(2),重新计算每个簇的平均值。 这个过程不断重复直到满足某个准则函数才停止 。

将样本分配给距离它们最近的中心向量,并使目 标函数值减小 n 2

i 1

j{1, 2 ,..., k }

min || x i p j ||

更新簇平均值

1 xi Ci

k

ቤተ መጻሕፍቲ ባይዱ

xCi

x

计算准则函数E

E i 1 xC x xi

i

2

2016/12/9

K-means聚类算法

划分聚类方法对数据集进行聚类时包括如下 三个要点: • (1)选定某种距离作为数据样本间的相似性度 量 上面讲到,k-means聚类算法不适合处理离散型 属性,对连续型属性比较适合。因此在计算数据样 本之间的距离时,可以根据实际需要选择欧式距离 、曼哈顿距离或者明考斯距离中的一种来作为算法 的相似性度量,其中最常用的是欧式距离。下面我 给大家具体介绍一下欧式距离。

例 1:

1. 2. 3. 4. 图片:一只遥望大海的小狗; 此图为100 x 100像素的JPG图片,每个像素可以表示为三维向量(分别对应 JPEG图像中的红色、绿色和蓝色通道) ; 将图片分割为合适的背景区域(三个)和前景区域(小狗); 使用K-means算法对图像进行分割。

2016/12/9

在图像分割上的简单应用

d M 2 , O4

0 5 2 0 29

2 2

2 2

O 1 2 4 5

x 0 0 5 5

y 2 0 0 0 2

0 5 0 0 5 • 因为 d M 2 , O4 d M 1 , O4 所以将 O4 分配给 c2 2 2 O d M , O 0 5 2 2 5 • 对于 : 1 5

主要缺点

在簇的平均值被定义的情况下才能使用,这对于处理符号属性的数据 不适用。 必须事先给出k(要生成的簇的数目),而且对初值敏感,对于不同的 初始值,可能会导致不同结果。

k-means算法的改进方法——k-prototype算法

k-Prototype算法:可以对离散与数值属性两种混合的数据 进行聚类,在k-prototype中定义了一个对数值与离散属性都 计算的相异性度量标准。 K-Prototype算法是结合K-Means与K-modes算法,针对 混合属性的,解决2个核心问题如下: 1.度量具有混合属性的方法是,数值属性采用K-means方法 得到P1,分类属性采用K-modes方法P2,那么D=P1+a*P2, a是权重,如果觉得分类属性重要,则增加a,否则减少a, a=0时即只有数值属性 2.更新一个簇的中心的方法,方法是结合K-Means与Kmodes的更新方法。

由上可以看出,第一次迭代后,总体平均误差值52.25~25.65, 显著减小。由于在两次迭代中,簇中心不变,所以停止迭代过程, 算法停止。

k-means算法的性能分析

主要优点:

是解决聚类问题的一种经典算法,简单、快速。 对处理大数据集,该算法是相对可伸缩和高效率的。因为它的复杂度 是0 (n k t ) , 其中, n 是所有对象的数目, k 是簇的数目, t 是迭代的次数。 通常k < <n 且t < <n 。 当结果簇是密集的,而簇与簇之间区别明显时, 它的效果较好。

例子

O x y

1

2 3 4 5

0

0 1.5 5 5

2

0 0 0 2

数据对象集合S见表1,作为一个聚类分析的二维 样本,要求的簇的数量k=2。 O2 0,0 为初始的簇中心, (1)选择 O1 0,2 , 即 M 1 O1 0,2 , M 2 O2 0,0 。 (2)对剩余的每个对象,根据其与各个簇中心的距 离,将它赋给最近的簇。 对 O3 :

假设给定的数据集 X xm | m 1,2,..., total,X中 的样本用d个描述属性A1,A2…Ad来表示,并且d个描 述属性都是连续型属性。数据样本 xi=(xi1,xi2,…xid), xj=(xj1,xj2,…xjd)其中, xi1,xi2,…xid和xj1,xj2,…xjd分别是样本xi和xj对应d 个描述属性A1,A2,…Ad的具体取值。样本xi和xj之 间的相似度通常用它们之间的距离d(xi,xj)来表示 ,距离越小,样本xi和xj越相似,差异度越小;距 离越大,样本xi和xj越不相似,差异度越大。 欧式距离公式如下:

算法简介

• k-means算法,也被称为k-平均或k-均 值,是一种得到最广泛使用的聚类算法。 它是将各个聚类子集内的所有数据样本 的均值作为该聚类的代表点,算法的主 要思想是通过迭代过程把数据集划分为 不同的类别,使得评价聚类性能的准则 函数达到最优,从而使生成的每个聚类 内紧凑,类间独立。这一算法不适合处 理离散型属性,但是对于连续型具有较 好的聚类效果。

M 2 0 1.5 5 3, 0 0 0 3 2.17,0

1

2 4 5

0

0 5 5

2

0 0 2

3 1.5 0

M 1 0 5 2, 2 2 2 2.5,2

重复(2)和(3),得到O1分配给C1;O2分配给C2,O3分配 给C2 ,O4分配给C2,O5分配给C1。更新,得到新簇 C1 O1 , O5 ,

。

和 C 2 O2 , O3 , O4 。 中心为 M 1 2.5,2 , M 2 2.17,0 。

单个方差分别为 2 2 2 2 E1 0 2.5 2 2 2.5 5 2 2 12.5 E 2 13.15 总体平均误差是: E E1 E 2 12.5 13.15 25.65

k-means算法的改进方法——k-中心点算法

k-中心点算法:k -means算法对于孤立点是敏感的。为 了解决这个问题,不采用簇中的平均值作为参照点,可以 选用簇中位置最中心的对象,即中心点作为参照点。这样 划分方法仍然是基于最小化所有对象与其参照点之间的相 异度之和的原则来执行的。

K-means算法在图像分割上的简单应用

5

3 1.5

d M 2 , O5

0 5

2

0 2

2

29

1

• 因为

d M 1 , O5 d M 2 , O5

所以将 O5 分配给 C

C1 O1 , O5 和 C2 O2 , O3 , O4 • 更新,得到新簇 • 计算平方误差准则,单个方差为

E1 0 0 2 2 0 5 2 2 25

2 2 2 2

M 1 O1 0,2

E 2 27.25

M 2 O2 0,0

O

x

y

总体平均方差是: E E1 E 2 25 27.25 52.25 (3)计算新的簇的中心。